大语言模型系列 - Transformer

1. 简介

1.1. 概述

大语言模型Transformer是一种由谷歌公司提出的基于注意力机制的神经网络模型,它在自然语言处理(NLP)领域取得了显著成就,并逐渐被应用于其他领域如语音识别、计算机视觉和强化学习等。

1.2. 学习资源

以下是一些学习大语言模型Transformer的资源地址:

-

Google AI博客:https://ai.googleblog.com/2017/06/transformer-novel-neural-network.html

这篇博客文章由Google AI的科学家撰写,详细介绍了Transformer模型的工作原理和应用场景。 -

Transformer模型论文:https://arxiv.org/abs/1706.0376

这篇论文详细介绍了Transformer模型的架构、训练方法和实验结果等信息。 -

Transformer模型教程:https://towardsdatascience.com/a-transformer-tutorial-the-attention-mechanism-explained-21ef42e31f

这篇教程详细介绍了Transformer模型的原理和实现方法,并提供了Python代码实现。 -

Transformer模型在线课程:https://www.coursera.org/learn/transformers-in-nlp

这是一门由Google Cloud提供的在线课程,详细介绍了Transformer模型在自然语言处理领域的应用和实现方法。 -

Transformer模型开源代码:https://github.com/huggingface/transformers

这是一个由Hugging Face团队维护的开源代码库,提供了多种预训练的Transformer模型和相关的代码示例。 -

Transformer模型学术论文资源:https://paperswithcode.com/topic/transformer

这是一个提供多种Transformer模型相关学术论文和代码资源的网站,可以用于查找和学习Transformer模型的最新研究成果。 -

Transformer模型中文资料:https://zh.nature.com/articles/s41598-019-50387-6

这篇中文资料详细介绍了Transformer模型的工作原理和应用场景,并提供了一些有趣的案例分析。

以上是一些学习大语言模型Transformer的资源地址,希望能够帮助你更好地理解和应用Transformer模型。

2. 优缺点

2.1. 优点

- 更好的并行性能:能够在所有位置同时计算,加速训练和推理过程。

- 能够处理长序列:通过自注意力机制捕捉长距离依赖关系。

- 更好的性能表现:在自然语言处理等领域取得了显著成果。

2.2. 缺点

- 计算复杂度较高:需要更多的计算资源,如GPU等。

- 对小数据集表现可能不佳:需要较大的数据集来训练以获得良好性能。

- 可解释性不如传统模型:由于使用了自注意力机制,难以解释每个位置的重要性。

3. 详细说明

3.1. 模型原理

3.1.1. 基本结构

大语言模型Transformer的基本结构主要包括以下几个部分:

-

输入编码器(Input Encoder):输入编码器将输入数据(例如文本或语音信号)转换为一系列向量,以便模型能够对其进行处理。常见的输入编码器包括Word Embedding层和位置编码器(Position Embedding layer)。

-

编码器(Encoder):编码器是Transformer模型的核心组件,它通过多头自注意力机制(Multi-Head Self-Attention Mechanism)对输入向量进行处理,从而提取出输入数据的特征表示。编码器通常包含多个层次(Layer),每个层次都包含一个自注意力机制和一个前馈网络(Feed-Forward Network),并且在每个层次之间都会使用残差连接和层归一化(Layer Normalization)等技术来提高模型的稳定性和性能。

-

解码器(Decoder):解码器与编码器类似,也是通过多头自注意力机制和前馈网络等技术来提取输入数据的特征表示。但是,解码器与编码器的一个主要区别在于,解码器还包括一个注意力机制,它能够对编码器的输出进行处理,从而实现对输入数据的解码和生成。解码器同样包含多个层次,每个层次也都包含自注意力机制、前馈网络、残差连接和层归一化等技术。

-

输出层(Output Layer):输出层将解码器的输出转换为最终的预测结果,例如在机器翻译任务中,输出层将解码器的输出转换为目标语言的句子。

-

注意力机制(Attention Mechanism):注意力机制是Transformer模型的关键组件,它能够帮助模型在处理输入数据时,更加灵活和有效地关注到输入数据的不同部分。注意力机制主要包括自注意力机制(Self-Attention Mechanism)和多头注意力机制(Multi-Head Attention Mechanism)等技术,它们能够帮助模型在处理长距离依赖关系等问题时,取得更好的效果。

-

残差连接(Residual Connection):残余连接是一种在深度神经网络中常用的技术,它能够在模型的深层次之间引入额外的连接,从而帮助模型更好地学习和泛化。在Transformer模型中,残余连接通常在每个层次之间的自注意力机制和前馈网络等组件之间进行连接。

以上是大语言模型Transformer的基本结构和关键组件的详细说明,希望这些信息能够帮助你更好地理解和应用Transformer模型。

3.1.2. 自注意力机制

自注意力机制(Self-Attention Mechanism)是Transformer模型的核心组件之一,它能够帮助模型在处理输入数据时,更加灵活和有效地关注到输入数据的不同部分。自注意力机制通过对输入数据的不同部分进行加权求和等方式,来计算它们之间的注意力得分,并将这些得分用于生成模型的输出结果,以下是关于Transformer自注意力机制的详细说明:

-

自注意力机制的定义:自注意力机制是一种在Transformer模型中广泛使用的技术,它能够帮助模型在处理输入数据时,更加灵活和有效地关注到输入数据的不同部分。自注意力机制通过对输入数据的不同部分进行加权求和等方式,来计算它们之间的注意力得分,并将这些得分用于生成模型的输出结果。

-

自注意力机制的计算过程:自注意力机制的计算过程主要包括以下几个步骤:

-

将输入数据分成三个不同的部分,分别称为查询(Query)、键(Key)和值(Value)。这三个部分可以看作是输入数据的不同方面或维度,它们共同构成了模型的输入表示。

-

对查询、键和值进行线性变换,从而将它们转换成不同的向量表示。这些线性变换通常由一些可学习的参数矩阵和偏置向量等组件构成。

-

计算查询和键之间的点积,从而得到它们之间的注意力得分。这些注意力得分反映了输入数据的不同部分之间的相关性和依赖关系。

-

对注意力得分进行归一化处理,从而得到它们之间的权重分布。这些权重分布可以看作是模型在处理输入数据时所关注的不同部分的相对重要性。

-

将权重分布与值进行加权求和,从而得到模型的输出表示。这个输出表示可以看作是输入数据的不同部分经过加权平均后的结果,它能够反映出输入数据的重要特征和模式。

- 自注意力机制的应用场景:自注意力机制在Transformer模型中具有广泛的应用场景,例如在编码器和解码器之间的通信和协作中,自注意力机制可以帮助模型更好地理解输入数据的含义和上下文信息,并生成更加准确和有意义的输出结果。此外,自注意力机制还可以应用于其他领域和任务,例如图像识别、物体检测和视觉分割等。

3.1.3. 多头注意力机制:

多头注意力机制(Multi-Head Attention Mechanism)是在自注意力机制的基础上发展而来的一种技术,它能够在多个不同的子空间中对输入数据进行处理,从而帮助模型更好地捕捉到输入数据的复杂特征和模式。多头注意力机制通过对输入数据进行多次自注意力机制计算,并将这些计算结果进行合并和融合等方式,来生成模型的输出结果。以下是关于Transformer多头注意力机制的详细说明:

-

多头注意力机制的定义:多头注意力机制是在自注意力机制的基础上发展而来的一种技术,它能够在多个不同的子空间中对输入数据进行处理,从而帮助模型更好地捕捉到输入数据的复杂特征和模式。多头注意力机制通过对输入数据进行多次自注意力机制计算,并将这些计算结果进行合并和融合等方式,来生成模型的输出结果。

-

多头注意力机制的计算过程:多头注意力机制的计算过程主要包括以下几个步骤:

-

将输入数据分成多个不同的子空间,每个子空间都可以看作是输入数据的一个不同的方面或维度。

-

对每个子空间中的输入数据进行自注意力机制计算,从而得到每个子空间中的输出表示。这些自注意力机制计算可以并行进行,从而提高模型的计算效率和性能。

-

将每个子空间中的输出表示进行合并和融合等方式,来生成模型的最终输出结果。这些合并和融合操作可以是简单的拼接、加权求和或其他更复杂的运算方式。

-

对生成的最终输出结果进行后续处理,例如使用全连接层或其他神经网络组件进行分类、回归或其他任务。

- 多头注意力机制的应用场景:多头注意力机制在Transformer模型中具有广泛的应用场景,例如在编码器和解码器之间的通信和协作中,多头注意力机制可以帮助模型更好地理解输入数据的含义和上下文信息,并生成更加准确和有意义的输出结果。此外,多头注意力机制还可以应用于其他领域和任务,例如图像识别、物体检测和视觉分割等。

3.1.4. 编码器-解码器架构

编码器-解码器架构(Encoder-Decoder Architecture)是Transformer模型的另一种核心技术,它能够在编码器和解码器之间建立起一种有效的沟通和协作机制。编码器-解码器架构通过对编码器的输出进行处理和解码,来生成模型的最终输出结果。在编码器-解码器架构中,编码器和解码器通常会采用类似的结构和组件,从而保证模型在整个处理过程中具有一致性和稳定性。以下是关于Transformer编码器-解码器架构的详细说明:

-

编码器-解码器架构的定义:编码器-解码器架构是一种在Transformer模型中广泛使用的技术,它能够在编码器和解码器之间建立起一种高效的沟通和协作机制,从而帮助模型更好地处理和生成文本数据。编码器-解码器架构主要包括两个主要的组件:编码器(Encoder)和解码器(Decoder)。

-

编码器-解码器架构的编码器组件:编码器组件是Transformer模型中的一个重要组成部分,它主要负责对输入数据进行编码和处理,从而生成一种更加紧凑和高效的表示形式。编码器组件通常由多个层次(Layer)组成,每个层次都包含一个自注意力机制和一个前馈网络(Feed-Forward Network),并且在每个层次之间都会使用残差连接(Residual Connections)和层归一化(Layer Normalization)等技术来提高模型的稳定性和性能。

-

编码器-解码器架构的解码器组件:解码器组件是Transformer模型中的另一个重要组成部分,它主要负责对编码器组件的输出结果进行解码和处理,从而生成模型的最终输出结果。解码器组件通常由多个层次组成,每个层次都包含一个自注意力机制、一个前馈网络、一个编码器-解码器注意力机制(Encoder-Decoder Attention Mechanism)和一个输出层(Output Layer),并且在每个层次之间都会使用残差连接和层归一化等技术来提高模型的稳定性和性能。

-

编码器-解码器架构的应用场景:编码器-解码器架构在Transformer模型中具有广泛的应用场景,例如在机器翻译、文本摘要和聊天机器人等领域中,编码器-解码器架构可以帮助模型更好地理解输入数据的含义和上下文信息,并生成更加准确和有意义的输出结果。此外,编码器-解码器架构还可以应用于其他领域和任务,例如图像识别、物体检测和视觉分割等。

3.1.5. 残差连接

残差连接(Residual Connections)是一种在深度神经网络中常用的技术,它能够在模型的深层次之间引入额外的连接,从而帮助模型更好地学习和泛化。在Transformer模型中,残差连接通常在每个层次之间的自注意力机制和前馈网络等组件之间进行连接。以下是关于Transformer残余连接的详细说明:

-

残差连接的定义:残余连接是一种在深度神经网络中常用的技术,它能够在模型的深层次之间引入额外的连接,从而帮助模型更好地学习和泛化。残余连接通常在神经网络的每一层之间进行连接,从而使得模型的每一层都能够直接访问到前面的所有层的输出结果。

-

残余连接的计算过程:残差连接的计算过程主要包括以下几个步骤:

-

在神经网络的每一层之间引入额外的连接,这些连接通常由一些可学习的参数矩阵和偏置向量等组件构成。

-

对这些连接进行归一化处理,从而使得模型的每一层都能够更加稳定和有效地学习和泛化。

-

在模型的每一层之间使用残差连接,从而使得模型的每一层都能够直接访问到前面的所有层的输出结果。这些残差连接可以在模型的训练过程中自动学习和调整,从而使得模型能够更好地适应和泛化到新的数据和场景中。

- 残余连接的应用场景:残余连接在Transformer模型中具有广泛的应用场景,例如在编码器和解码器之间的通信和协作中,残余连接可以帮助模型更好地理解和利用输入数据的特征和模式,从而生成更加准确和有意义的输出结果。此外,残余连接还可以应用于其他领域和任务,例如图像识别、物体检测和视觉分割等。

3.1.6. 层归一化

层归一化(Layer Normalization)是一种在深度神经网络中常用的技术,它能够在模型的不同层之间实现一种有效的规范化和标准化机制。在Transformer模型中,层归一化通常在每个层之间的自注意力机制和前馈网络等组件之间进行应用,从而帮助模型更好地学习和泛化。以下是关于Transformer层归一化技术的详细说明:

-

层归一化的定义:层归一化是一种在深度神经网络中常用的技术,它能够在模型的不同层之间实现一种有效的规范化和标准化机制。层归一化通常在神经网络的每一层之间进行连接,从而使得模型的每一层都能够更加稳定和有效地学习和泛化。

-

层归一化的计算过程:层归一化的计算过程主要包括以下几个步骤:

-

对神经网络的每一层的输出结果进行归一化处理,从而使得这些输出结果的分布更加稳定和规范。

-

使用归一化处理后的输出结果来更新神经网络的参数,从而使得模型能够更加稳定和有效地学习和泛化。

-

在模型的训练过程中,层归一化技术可以自动学习和调整,从而使得模型能够更好地适应和泛化到新的数据和场景中。

- 层归一化的应用场景:层归一化技术在Transformer模型中具有广泛的应用场景,例如在编码器和解码器之间的通信和协作中,层归一化可以帮助模型更好地理解和利用输入数据的特征和模式,从而生成更加准确和有意义的输出结果。此外,层归一化技术还可以应用于其他领域和任务,例如图像识别、物体检测和视觉分割等。

3.1.7. 位置编码

由于Transformer模型没有使用循环结构或卷积操作,因此需要一种方式来引入序列中元素的位置信息。位置编码是一种用于表示元素位置的技术,通常是一个与嵌入向量维度相同的矩阵。常见的位置编码方法包括使用三角函数或学习得到的参数,用于将位置信息融入到输入序列的表示中。以下是关于Transformer位置编码的详细说明:

-

位置编码的定义:位置编码是一种在Transformer模型中广泛使用的技术,它能够在模型的编码器和解码器之间建立起一种有效的沟通和协作机制,从而帮助模型更好地处理和生成文本数据。位置编码通常是对输入数据的每个元素(例如每个单词或每个字符)进行编码,从而使得模型能够更好地理解和利用输入数据的序列信息和上下文信息。

-

位置编码的计算过程:位置编码的计算过程主要包括以下几个步骤:

-

对输入数据的每个元素进行编码,通常使用位置编码矩阵(Positional Enco

相关文章:

大语言模型系列 - Transformer

1. 简介 1.1. 概述 大语言模型Transformer是一种由谷歌公司提出的基于注意力机制的神经网络模型,它在自然语言处理(NLP)领域取得了显著成就,并逐渐被应用于其他领域如语音识别、计算机视觉和强化学习等。 1.2. 学习资源 以下是一些学习大语言模型Transformer的资源地址…...

Java面试之操作系统

1、冯诺依曼模型 运算器、控制器、存储器、输入设备、输出设备 32位和64位CPU最主要区别是一次性能计算多少字节数据,如果计算的数额不超过 32 位数字的情况下,32 位和 64 位 CPU 之间没什么区别的,只有当计算超过 32 位数字的情况下&#…...

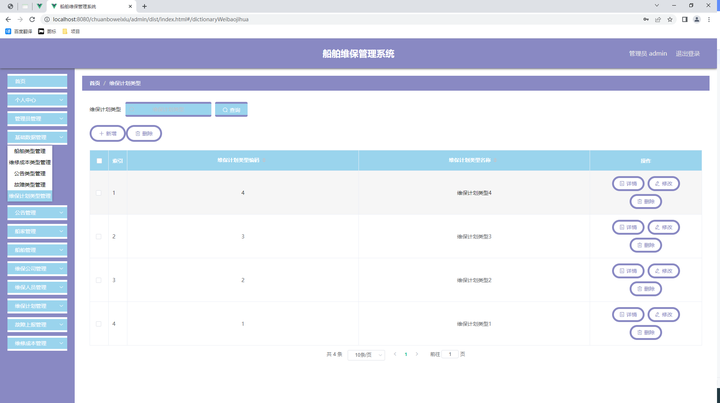

springboot船舶维保管理系统--论文源码调试讲解

第二章 相关技术 本次开发船舶维保管理系统使用的是Vue进行程序开发,船舶维保管理系统的数据信息选择MySQL数据库进行存放。 2.1 VUE介绍 Vue (读音 /vjuː/,类似于 view) 是一套用于构建用户界面的渐进式框架。与其它大型框架不同的是,Vue…...

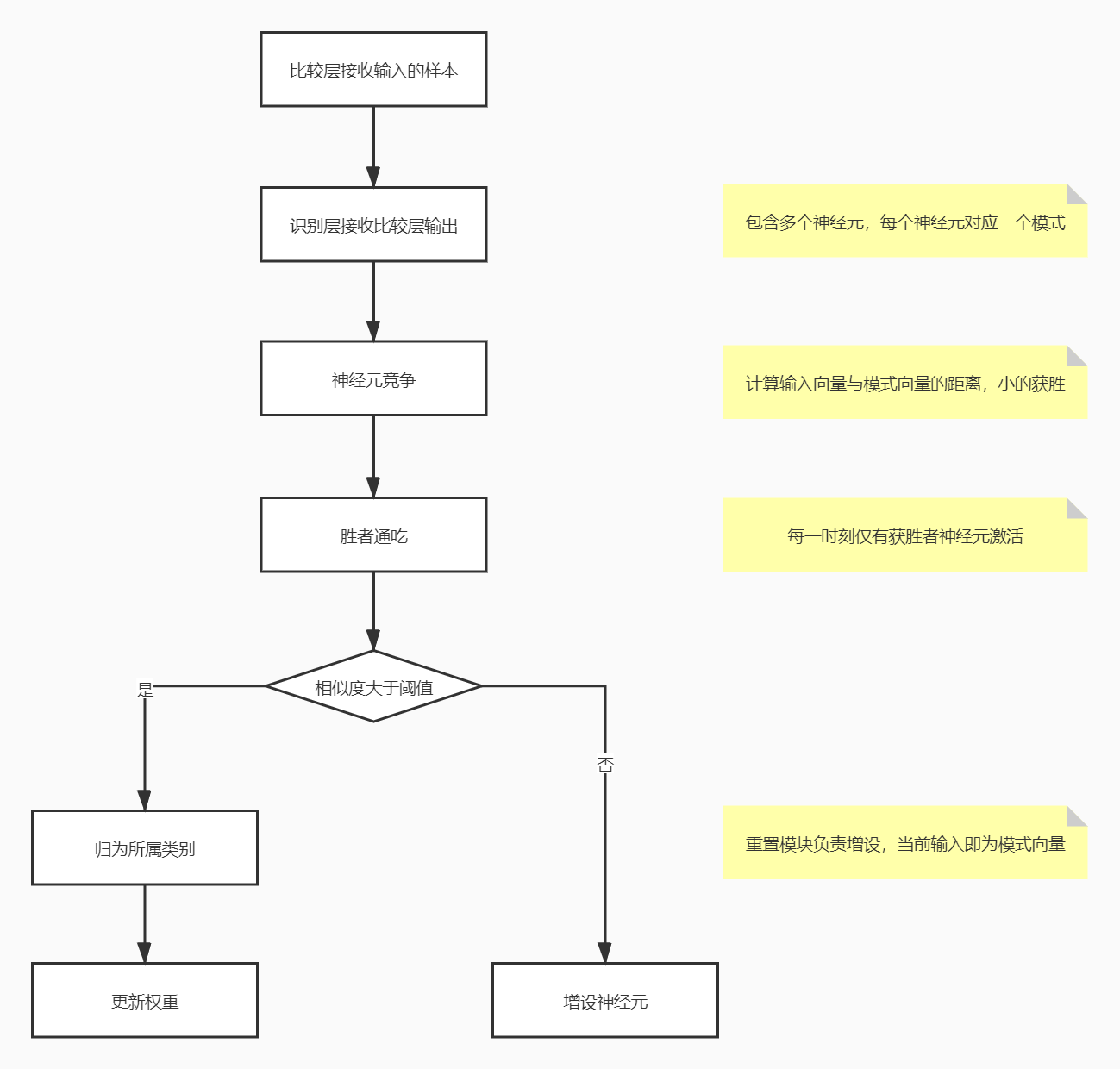

【机器学习西瓜书学习笔记——神经网络】

机器学习西瓜书学习笔记【第五章】 第五章 神经网络5.1神经元模型5.2 感知机与多层网络学习感知机学习率成本/损失函数梯度下降 5.3 BP神经网络(误差逆传播)5.4 全局最小与局部极小5.5 其他常见神经网络RBF网络RBF 与 BP 最重要的区别 ART网络 第五章 神…...

安装 electron 报错解决

1. 报错 大概率由镜像问题导致 2. 解决 2.1 打开 npm 配置 npm config edit 2.2 添加配置 registryhttps://registry.npmmirror.comelectron_mirrorhttps://cdn.npmmirror.com/binaries/electron/electron_builder_binaries_mirrorhttps://npmmirror.com/mirrors/electron…...

【Material-UI】Icon Button 组件详解

文章目录 一、基础用法1. 禁用状态 二、大小(Sizes)1. 小尺寸(Small)2. 大尺寸(Large) 三、颜色(Colors)1. 主题颜色2. 自定义颜色 四、高级用法和最佳实践1. 无障碍性(A…...

51单片机-第七节-DS1302实时时钟

一、DS1302介绍: 实时时钟芯片,可对年,月,日,周,时,分,秒计时,是一种集成电路。 二、DS1302原理: 1.寄存器定义: Command:操作模式…...

Java毕业设计 基于SSM和Vue的图书馆座位预约系统小程序

Java毕业设计 基于SSM和Vue的图书馆座位预约系统小程序 这篇博文将介绍一个基于SSM框架和Vue开发的图书馆座位预约系统微信小程序,适合用于Java毕业设计。 功能介绍 用户 登录 注册 首页 图片轮播 关于我们 公告信息 图书馆信息 图书馆详情 预约选座 收藏 …...

【C++11】:lambda表达式function包装器

目录 前言一,可变参数模板1.1 简单认识1.2 STL容器中的empalce系列相关接口 二,lambda表达式2.1 lambda表达式语法2.2 探索lambda底层 三,包装器3.1 function包装器3.2 bind 四,类的新功能4.1 默认成员函数4.2 关键字default4.3 关…...

[io]进程间通信 -有名、无名管道 区别

有名管道和无名管道的区别 无名管道有名管道 使用场景 亲缘关系进程不相关的任意进程特点 1.固定读端fd[0]写端fd[1] 2.文件IO进行操作 3.不支持lseek()操作 4.数据存储在内核空间 1.文件系统中存在管道文件 2.文件IO操作 3.不支持lseek 4.先进先出 5.数…...

pywinauto:Windows桌面应用自动化测试(七)

前言 上一篇文章地址: pywinauto:Windows桌面应用自动化测试(六)-CSDN博客 下一篇文章地址: 暂无 一、实战常用方法 1、通过Desktop快速获取窗口 通过之前章节我们了解到控制应用的方法为Application࿰…...

RGB++是什么;UTXO是什么;Nervos网络;CKB区块链;

目录 RGB++是什么,简单举例说明 RGB++简介 举例说明 UTXO是什么 定义 功能与特点 使用方式 优缺点 结论 CKB区块链 一、基础属性 二、技术特点 三、经济模型 四、应用场景 Nervos网络 一、网络架构 二、技术特点 三、经济模型 四、应用场景 五、未来展望 …...

轻闪PDF v2.14.9 解锁版下载与安装教程 (全能PDF转换器)

前言 轻闪PDF(原傲软PDF编辑软件)是一款操作简单的全能PDF转换器,轻松实现PDF转换为Word,Excel或其他格式,以及PDF压缩,合并和图片文字识别OCR等功能.这款pdf编辑转换软件几乎支持所有常见文档格式,一键完成PDF与其他文档互相转换,并含有PDF合并,压缩,图片文字识别OCR等增值功…...

、每个表的执行次数)

mysql 5.7 解析binlog日志,并统计每个类型语句(insert、update、delete)、每个表的执行次数

1、mysqlbinlog工具 使用mysqlbinlog工具将文件中执行语句解析至某个文件中。 /usr/local/mnt/mysql/bin/mysqlbinlog --base64-outputDECODE-ROWS -v /usr/local/mnt/mysql/log/mysql-bin.017278 > binlog017278.sql --base64-outputDECODE-ROWS 参数: 这个…...

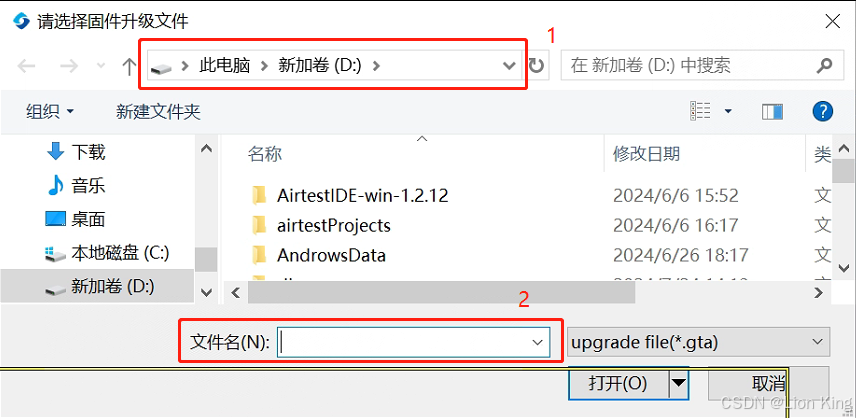

MySQL案例:MHA实现主备切换(主从架构)万字详解

目录 MHA 概念 MHA的组成 特点 案例介绍 (1)案例需求 (2)案例实现思路 (3)案例拓扑图 (4)案例环境 案例步骤 基本环境配置 关闭防火墙和内核安全机制 安装数据库 授权…...

81.SAP ME - SAP SMGW Getway Monitor

目录 1.起因 2.SMGW Displaying Logged On Clients Displaying Remote Gateways Display and Control Existing Connections Deleting a Connection Displaying Gateway Release Information Displaying Parameters and Attributes of the Gateway Change Gateway Pa…...

)

SAPUI5基础知识24 - 如何向manifest.json中添加模型(小结)

1. 背景 在上一篇博客中,我们总结了SAPUI5中模型的各种类型,并通过代码给出了实例化这些模型的方式。 其实,在SAPUI5中,我们可以通过在manifest.json 中添加模型配置,简化模型的初始化过程,并确保模型在应…...

操作系统---文件管理

一、系统调用(系统API) 什么是系统调用 由操作系统向应用程序提供的程序接口信息,本质上就是应用程序与操作系统之间交互的接口。 操作系统的主要功能是为了管理硬件资源和为应用软件的开发人员提供一个良好的环境,使得应用程序…...

C语言指针详解(三)目录版

C语言指针详解(三)目录版 1、字符指针变量1.1、字符指针变量的一般应用1.2、常量字符串1.3、常量字符串与普通字符串的区别1.3.1 常量字符串的不可修改性1.3.2 常量字符串的存储 2、数组指针变量2.1、数组指针变量定义2.2、数组指针变量的初始化 3、二维…...

【AI资讯早报】AI科技前沿资讯概览:2024年8月6日早报

【AI资讯早报,感知未来】AI科技前沿资讯概览,涵盖了行业大会、技术创新、应用场景、行业动态等多个方面,全面展现了AI领域的最新发展动态和未来趋势。 1.【图像生成技术再突破】Midjourney V6.1震撼发布,人像生成质量跃上新台阶 …...

TDengine 快速体验(Docker 镜像方式)

简介 TDengine 可以通过安装包、Docker 镜像 及云服务快速体验 TDengine 的功能,本节首先介绍如何通过 Docker 快速体验 TDengine,然后介绍如何在 Docker 环境下体验 TDengine 的写入和查询功能。如果你不熟悉 Docker,请使用 安装包的方式快…...

stm32G473的flash模式是单bank还是双bank?

今天突然有人stm32G473的flash模式是单bank还是双bank?由于时间太久,我真忘记了。搜搜发现,还真有人和我一样。见下面的链接:https://shequ.stmicroelectronics.cn/forum.php?modviewthread&tid644563 根据STM32G4系列参考手…...

反向工程与模型迁移:打造未来商品详情API的可持续创新体系

在电商行业蓬勃发展的当下,商品详情API作为连接电商平台与开发者、商家及用户的关键纽带,其重要性日益凸显。传统商品详情API主要聚焦于商品基本信息(如名称、价格、库存等)的获取与展示,已难以满足市场对个性化、智能…...

DockerHub与私有镜像仓库在容器化中的应用与管理

哈喽,大家好,我是左手python! Docker Hub的应用与管理 Docker Hub的基本概念与使用方法 Docker Hub是Docker官方提供的一个公共镜像仓库,用户可以在其中找到各种操作系统、软件和应用的镜像。开发者可以通过Docker Hub轻松获取所…...

电脑插入多块移动硬盘后经常出现卡顿和蓝屏

当电脑在插入多块移动硬盘后频繁出现卡顿和蓝屏问题时,可能涉及硬件资源冲突、驱动兼容性、供电不足或系统设置等多方面原因。以下是逐步排查和解决方案: 1. 检查电源供电问题 问题原因:多块移动硬盘同时运行可能导致USB接口供电不足&#x…...

微服务商城-商品微服务

数据表 CREATE TABLE product (id bigint(20) UNSIGNED NOT NULL AUTO_INCREMENT COMMENT 商品id,cateid smallint(6) UNSIGNED NOT NULL DEFAULT 0 COMMENT 类别Id,name varchar(100) NOT NULL DEFAULT COMMENT 商品名称,subtitle varchar(200) NOT NULL DEFAULT COMMENT 商…...

Robots.txt 文件

什么是robots.txt? robots.txt 是一个位于网站根目录下的文本文件(如:https://example.com/robots.txt),它用于指导网络爬虫(如搜索引擎的蜘蛛程序)如何抓取该网站的内容。这个文件遵循 Robots…...

leetcodeSQL解题:3564. 季节性销售分析

leetcodeSQL解题:3564. 季节性销售分析 题目: 表:sales ---------------------- | Column Name | Type | ---------------------- | sale_id | int | | product_id | int | | sale_date | date | | quantity | int | | price | decimal | -…...

九天毕昇深度学习平台 | 如何安装库?

pip install 库名 -i https://pypi.tuna.tsinghua.edu.cn/simple --user 举个例子: 报错 ModuleNotFoundError: No module named torch 那么我需要安装 torch pip install torch -i https://pypi.tuna.tsinghua.edu.cn/simple --user pip install 库名&#x…...

Linux C语言网络编程详细入门教程:如何一步步实现TCP服务端与客户端通信

文章目录 Linux C语言网络编程详细入门教程:如何一步步实现TCP服务端与客户端通信前言一、网络通信基础概念二、服务端与客户端的完整流程图解三、每一步的详细讲解和代码示例1. 创建Socket(服务端和客户端都要)2. 绑定本地地址和端口&#x…...