大模型算法面试题(二十)

本系列收纳各种大模型面试题及答案。

1、描述Encoder和Decoder中Attention机制的不同之处

Encoder和Decoder中的Attention机制在自然语言处理(NLP)和序列到序列(Seq2Seq)模型中扮演着重要角色,它们虽然都利用了Attention机制,但在具体实现和应用上存在一些不同之处。以下是对两者中Attention机制不同之处的详细描述:

1. 功能与目的

- Encoder中的Attention:

- 功能:在Encoder阶段,Attention机制主要用于处理输入序列,以便更好地捕捉序列内部的依赖关系和重要信息。

- 目的:通过为输入序列中的不同部分分配不同的注意力权重,Encoder能够生成更加丰富和具有表达力的中间表示(context vectors),这些表示将作为Decoder的输入。

- Decoder中的Attention:

- 功能:在Decoder阶段,Attention机制则用于在生成输出序列时,根据当前解码状态和编码器的输出,动态地选择性地关注输入序列的不同部分。

- 目的:通过动态地调整对输入序列的注意力,Decoder能够更准确地生成与输入序列相对应的输出序列。

2. 实现方式

- Encoder中的Attention(以Self-Attention为例):

- 在Self-Attention中,Encoder会处理输入序列,计算序列内部各个元素之间的相关性,并据此生成加权后的表示。这种机制允许Encoder在处理长序列时,捕捉到更远距离的元素之间的依赖关系。

- 实现上,通常使用多头注意力(Multi-Head Attention)来并行处理不同子空间的信息,从而增强模型的表示能力。

- Decoder中的Attention(包括Encoder-Decoder Attention和Self-Attention):

- Encoder-Decoder Attention:Decoder在生成输出序列时,会利用Encoder的输出作为上下文信息。通过计算Decoder当前状态与Encoder输出之间的相关性,Decoder能够动态地选择性地关注输入序列的不同部分。

- Self-Attention:在Decoder内部,也会使用Self-Attention来捕捉生成序列内部已经生成的元素之间的依赖关系。这有助于Decoder在生成下一个元素时,考虑到之前已经生成的所有元素。

3. 注意力权重的计算

- 在Encoder和Decoder中,Attention权重的计算都是基于某种形式的相似度或相关性度量。然而,由于它们处理的数据和目的不同,具体的计算方式可能会有所差异。

- 例如,在Encoder的Self-Attention中,权重可能基于输入序列内部元素之间的相似度;而在Decoder的Encoder-Decoder Attention中,权重则可能基于Decoder当前状态与Encoder输出之间的相似度。

4. 应用场景

- Encoder中的Attention机制广泛应用于各种需要处理序列数据的NLP任务中,如文本分类、命名实体识别等。

- Decoder中的Attention机制则更多地应用于生成式任务中,如机器翻译、文本摘要等,其中需要根据输入序列动态地生成输出序列。

综上所述,Encoder和Decoder中的Attention机制在功能、实现方式、注意力权重的计算以及应用场景等方面都存在不同之处。这些不同之处使得Attention机制能够在不同的NLP任务中发挥重要作用。

2、Transformer采用Inference流程进行Training的问题?

Transformer模型在训练(Training)和推理(Inference)过程中存在关键差异。如果错误地采用推理流程进行训练,可能会遇到以下几个问题:

1. 遮蔽(Masking)问题

- 推理中的遮蔽:在推理过程中,解码器的自注意力通常使用遮蔽来防止未来词的信息流入当前词,实现自回归特性。

- 训练中的遮蔽:训练时,如果也使用这种遮蔽,将导致模型无法学习到词之间的依赖关系,因为训练数据中的词是同时给出的。训练时,编码器同时接收整个输入序列,而解码器则是自回归地生成序列,每次生成一个词并将其反馈到解码器的下一个时间步。

2. 梯度反向传播问题

- 推理流程的单向性:推理是一个单向的过程,没有反向的路径来传递梯度。

- 训练中的梯度计算:在训练中,需要通过反向传播算法来计算梯度,并更新模型的权重。如果采用推理流程进行训练,将无法进行梯度的反向传播,从而无法进行模型的优化。

3. 层间信息流动问题

- Transformer模型的学习需求:Transformer模型需要学习词之间的依赖关系,这要求编码器和解码器的层之间需要有信息流动来捕捉这些依赖性。

- 推理流程的影响:如果采用推理流程进行训练,层间的信息流动将被打断,影响模型学习长距离依赖的能力。

4. 计算资源利用问题

- 推理流程的优化方向:推理流程通常针对单个样本或小批量样本进行优化。

- 训练流程的需求:训练流程可能需要处理大规模的批量数据。采用推理流程进行训练可能导致计算资源的低效利用。

5. 模型参数更新问题

- 训练中的参数更新:在训练过程中,模型的参数需要不断更新以最小化损失函数。

- 推理流程的限制:推理过程中不涉及参数的调整,因此如果按照推理流程进行训练,模型参数将不会更新。

6. 损失函数计算与优化问题

- 训练中的损失函数:训练过程中需要计算损失函数,并使用优化器(如SGD或Adam)来更新模型参数。

- 推理流程的缺失:推理流程中不包含计算损失函数和使用优化器更新模型参数的步骤,因此无法进行模型的优化。

综上所述,如果在训练Transformer模型时错误地采用推理流程,将导致模型无法学习词之间的依赖关系,影响梯度的计算和反向传播,降低模型的学习能力和最终性能。因此,在训练过程中应确保使用正确的训练流程。

3、Transformer的Matrix Dimensions为何是3D的?

Transformer模型的Matrix Dimensions(矩阵维度)是3D的,这与其处理序列数据的方式和内部机制密切相关。以下是详细解释:

一、3D矩阵维度的具体含义

在Transformer模型中,3D矩阵维度通常代表了以下三个维度:

-

序列长度(Sequence Length):这是矩阵的第一个维度,表示序列中元素(如单词或字符)的数量。对于输入序列,这个长度可以变化,取决于具体任务和输入数据。

-

嵌入维度(Embedding Dimension):这是矩阵的第二个维度,表示每个元素(单词或字符)被嵌入到高维空间后的向量维度。嵌入维度是模型设计中的一个超参数,用于控制嵌入向量的表达能力。

-

批量大小(Batch Size):这是矩阵的第三个维度,表示在一次训练迭代中同时处理的序列数量。批量大小的选择会影响模型的训练效率和稳定性。

二、为何是3D的

-

适应序列处理:Transformer模型是为了处理序列数据而设计的,如文本、语音等。3D矩阵维度能够灵活地表示不同长度的序列,并允许模型在训练过程中同时处理多个序列,从而提高数据利用率和训练效率。

-

特征表示:嵌入维度使得每个序列元素都能被表示为一个高维向量,这些向量能够捕捉元素之间的语义关系和上下文信息。这种表示方式有助于模型更好地理解和处理序列数据。

-

多头注意力机制:Transformer模型中的多头注意力机制是其核心组成部分之一。3D矩阵维度使得模型能够同时处理多个序列的多个头部(head)的注意力权重,从而在不同子空间上捕捉序列内部的依赖关系。

三、总结

综上所述,Transformer模型的Matrix Dimensions是3D的,这主要是为了适应序列处理、特征表示和多头注意力机制的需要。这种设计使得模型能够灵活地处理不同长度的序列,并在每个序列位置捕获丰富的特征和注意力模式。同时,批量大小的存在也提高了模型的训练效率和稳定性。

4、描述Transformer进行Training的全生命周期的在Decoder中是如何进行Embedding的。

在Transformer模型中,Decoder的Embedding过程与Encoder类似,但也有所不同,特别是在处理序列生成任务(如机器翻译)时。以下是Transformer在Training全生命周期中Decoder进行Embedding的详细过程:

1. 输入文本预处理

- 令牌化(Tokenization):首先,将输入文本(对于Decoder来说,可能是目标语言的文本或者是在训练过程中的部分生成序列)转换为一系列令牌(tokens)。这些令牌可以是单词、子词(subwords)或字符等。

- 词汇表映射:将每个令牌映射到一个唯一的整数索引,这些索引对应于Transformer模型训练时使用的词汇表。

2. Embedding层

- 词嵌入(Word Embedding):将每个令牌的索引通过Embedding层转换为一个固定维度的向量。这个向量捕捉了令牌的语义信息。在Transformer中,通常使用预训练的词嵌入或者与模型一起训练的词嵌入。

- 位置嵌入(Positional Encoding):由于Transformer不像RNN那样具有内置的序列顺序处理能力,因此需要引入位置嵌入来表示每个令牌在序列中的位置。位置嵌入与词嵌入具有相同的维度,并通过某种方式(如正弦和余弦函数)计算得到,然后加到词嵌入向量上。

3. Decoder的输入表示

- 起始符号:在Decoder的输入序列开始时,通常会添加一个特殊的起始符号(如"<s>"或"<start>"),以指示序列的开始。这个起始符号也会被转换为相应的嵌入向量。

- 掩码(Masking):在训练过程中,为了模拟自回归生成过程,Decoder需要对未来的令牌进行掩码处理。这意味着,在生成某个令牌时,模型只能看到该令牌之前的所有令牌,而不能看到之后的令牌。这通过修改注意力权重矩阵来实现,将未来令牌对应的注意力权重设置为0。

4. 自注意力机制(Self-Attention)

- Query、Key、Value的生成:Decoder的输入嵌入向量(包括词嵌入、位置嵌入和可能的掩码处理)被送入自注意力层。在自注意力层中,输入向量首先通过线性变换生成Query、Key和Value三个矩阵。

- 注意力分数的计算:然后,使用Query和Key矩阵计算注意力分数,这些分数表示了序列中不同位置之间的相关性。

- 加权和:最后,使用softmax函数对注意力分数进行归一化,并将归一化后的分数与Value矩阵相乘,得到加权和,即考虑了序列内部依赖关系的输出向量。

5. 前馈神经网络(Feed-Forward Neural Network)

- Decoder的自注意力层之后通常是一个前馈神经网络,它包含两个线性变换层和一个激活函数(如ReLU)。前馈神经网络进一步处理自注意力层的输出,并生成最终的隐藏状态。

6. 残差连接和层归一化

- 在每个子层(包括自注意力层和前馈神经网络层)之后,Transformer都会添加残差连接和层归一化,以加速训练过程并提高模型的稳定性。

7. 输出表示

- Decoder的最终输出表示通常用于生成下一个令牌的预测。在生成任务中,这通常涉及将隐藏状态通过一个线性层和softmax函数,以产生下一个令牌的概率分布。

综上所述,Transformer在Training全生命周期中Decoder的Embedding过程是一个复杂的序列处理任务,它结合了词嵌入、位置嵌入、自注意力机制、前馈神经网络以及残差连接和层归一化等多个组件。

5、描述Training和Inference时Masking在Transformer使用Attention机制的地方的功能和数学实现。

在Transformer模型中,Masking在Training和Inference时用于Attention机制,主要目的是控制模型在处理序列时的信息流动,以防止信息泄露和过度依赖。以下是Masking在Training和Inference时使用的功能和数学实现的详细描述:

一、Training时的Masking

1. 功能

- Padding Mask:在自然语言处理任务中,输入序列的长度通常是不一致的。为了统一处理,较短的序列会被填充(padding)到与最长序列相同的长度。Padding Mask用于在Attention机制中屏蔽掉这些填充部分,使得模型不会在这些无意义的位置上产生注意力。

- Sequence Mask(也称为Causal Mask):在Decoder中,为了防止模型看到未来位置的信息,需要使用Sequence Mask。这种Mask将当前位置之后的所有位置的注意力权重设置为0(或非常小的负数,如-inf,以便在softmax后接近于0),从而确保模型只能基于当前和之前的信息进行预测。

2. 数学实现

- Padding Mask:通常,Padding Mask是一个与输入序列长度相同的向量,其中非填充位置为1,填充位置为0。在计算Attention分数之前,将这个Mask与Attention分数矩阵相乘,以屏蔽掉填充部分的注意力。

- Sequence Mask:Sequence Mask是一个下三角矩阵(对于Decoder的自注意力而言),其中对角线及以上位置为1,对角线以下位置为0(或-inf)。这个Mask与Attention分数矩阵相乘,以确保模型在生成第n个词时,只能看到前n-1个词的信息。

二、Inference时的Masking

1. 功能

- 在Inference时,Masking主要用于Decoder的自注意力机制中,以确保模型只能基于已经生成的序列部分进行预测。这与Training时的Sequence Mask功能相同,但应用场景略有不同,因为Inference时输入序列是逐步生成的。

2. 数学实现

- 在Inference过程中,每次生成一个新的词时,都会更新Sequence Mask。这个Mask是一个动态生成的下三角矩阵,其大小与当前已生成的序列长度相同。然后,将这个Mask与Attention分数矩阵相乘,以确保模型在生成下一个词时,只能看到当前及之前的词。

注意事项

- Masking的实现方式可能因不同的Transformer变体或框架而异。上述描述是基于标准的Transformer模型结构。

- 在实际实现中,为了计算效率,通常会使用广播机制或扩展Mask矩阵的维度来与Attention分数矩阵进行运算。

- 对于某些任务(如文本生成),在Inference时还需要使用Beam Search或Greedy Search等策略来生成最终的输出序列。在这些策略中,Masking同样起着关键作用,以确保模型能够逐步生成合理的序列。

总的来说,Masking在Transformer模型中的Attention机制中扮演着重要角色,它通过控制信息流动来确保模型能够正确地处理序列数据并生成合理的输出。

相关文章:

大模型算法面试题(二十)

本系列收纳各种大模型面试题及答案。 1、描述Encoder和Decoder中Attention机制的不同之处 Encoder和Decoder中的Attention机制在自然语言处理(NLP)和序列到序列(Seq2Seq)模型中扮演着重要角色,它们虽然都利用了Attent…...

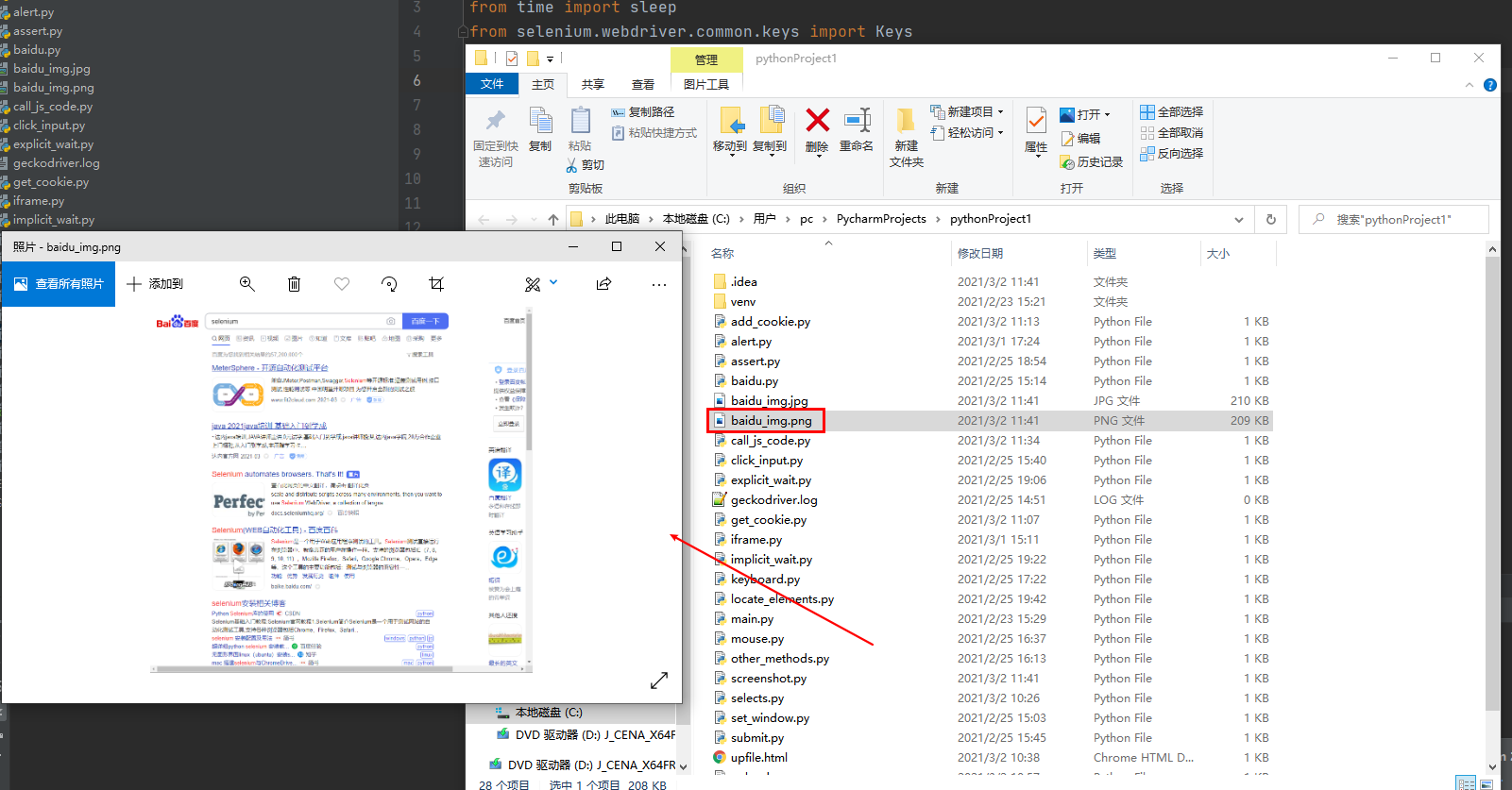

2024最新最全面的Selenium 3.0 + Python自动化测试框架

文档说明 Selenium是一个用于Web应用程序自动化测试的工具。Selenium测试直接运行在浏览器中,就像真正的用户在操作一样。 Selenium测试的主要功能包括: 测试与浏览器的兼容性:测试应用程序是否能很好的工作在不同的浏览器和操作系统之上。…...

海运中的甩柜是怎么回事❓怎么才能避免❓

什么是甩柜? 甩柜又叫甩箱,是指集装箱船在起运离港时,船公司没有将此前计划装船的集装箱装运上船,导致部分货物滞留港口。多出现在海运旺季。 为什么会甩柜? 甩箱是集装箱物流中常见的事件,主要因为承运…...

Win11+docker+gpu+vscode+pytorch配置anomalib(2)

在上一篇文章中,我在Win11上通过Docker配置了pytorch,并顺利调用了GPU。在这篇文章中,我将继续完成anomalib的配置。 anomalib是一个非常完善的异常检测框架,我希望通过它来学习经典异常检测算法,并且测试这些算法在我自己的数据集上的效果。 步骤如下: 1. 从docker Hub上…...

AI在招聘市场趋势分析中的应用

一、引言 在数字化、智能化的时代背景下,人工智能(AI)技术正逐步渗透到各行各业,其中招聘市场也不例外。AI技术的运用不仅极大地提高了招聘的效率和精准度,还在招聘市场趋势分析方面展现出巨大的潜力。本文旨在探讨AI在…...

AMEYA360:太阳诱电应对 165℃的叠层金属类功率电感器实现商品化!

太阳诱电株式会社实现了可以满足车载被动部件认定的可靠性试验规格“AEC-Q200”的叠层金属类功率电感器 MCOIL™“LACNF2012KKTR24MAB”(2.0x1.25x1.0mm,高度为最大值)等 4 个产品的商品化。通过本公司独有的金属类材料和叠层工艺的提高,在叠层金属类功率…...

Nginx进阶-常见配置(三)

nginx 变量 Nginx的配置文件使用的语法的就是一门微型的编程语言。既然是编程语言,一般也就少不了“变量”这种东西。 Nginx配置文件使用的语法主要包括以下几个方面: (1)配置块 (Block Directives): Nginx配置文件由多个嵌套的…...

开源协作式书签管理器推荐

不知道有没有人和我一样,不怎么爱用app,反而喜欢保留用古老的浏览器浏览新闻和知识的习惯。那么归档网页和书签一定是你非常头疼的事情。 推荐一款开源软件:Linkwarden ,这是一款独立的开源协作式书签管理器。 Linkwarden 允许用户收集、组…...

【线性代数】【二】2.2极大线性无关组与向量空间的基

文章目录 前言一、极大线性无关组二、向量空间的基三、向量维数与向量空间维数总结 前言 上一篇中我们介绍了向量空间的概念,并且学习了对任意给出的一组向量,如果构造一个向量空间。本文将更加细致的去分析张成一个向量空间,具有哪些性质。…...

STM32常见的下载方式有三种

经过对比,推荐使用 SWD下载,只需要一个仿真器(如jLINK、ST LINK、 CMSIS DAP 等),比较方便。 不推荐使用串口下载(速度慢、无法仿真和调试)和 JTAG 下载(占用 IO 多)。...

RK3568-npu模型转换推理

1. rknn-toolkit2-1.4.0进行模型转换和模型推理 1.1 虚拟机转换和模拟器推理(要求ubuntu18+python3.6) sudo apt-get install python3 python3-dev python3-pip sudo apt-get install libxslt1-dev zlib1g-dev libglib2.0 libsm6 libgl1-mesa-glx libprotobuf-dev gcc cd ~…...

《C语言程序设计 第4版》笔记和代码 第十二章 数据体和数据结构基础

12.1从基本数据类型到抽象数据类型 1 所有的程序设计语言都不能将所有复杂数据对象作为其基本数据类型,因此需要允许用户自定义数据类型,在C语言中,就存在构造数据类型(复合数据类型)。 2 结构体是构造数据类型的一种…...

学习记录——day26 进程间的通信 无名管道 无名管道 信号通信 特殊的信号处理

目录 一、进程间通信引入 二、无名管道 1、无名管道相关概念 2、无名管道的API接口函数 pipe(int pipefd[2]); 3、管道通信的特点 4、管道的读写特点 三、有名管道 1、有名管道:有名字的管道文件,其他进程可以调用 2、可以用于亲缘进程间的通信&…...

WHAT - xmlhttprequest vs fetch vs wretch

目录 前言1. XMLHttpRequest (XHR)2. fetch3. wretch总结 fetch1. 简洁性和易用性2. 错误处理3. 默认行为和功能扩展4. 请求和响应的处理5. 跨域请求和 CORS6. 现代 Web 开发需求 fetch vs xhr 代码示例使用 XMLHttpRequest使用 fetch代码对比 前言 根据标题我们可以知道今天主…...

吴恩达老师机器学习作业-ex7(聚类)

导入库,读取数据,查看数据类型等进行分析,可视化数据 import matplotlib.pyplot as plt import numpy as np import scipy.io as sio#读取数据 path "./ex7data2.mat" data sio.loadmat(path) # print(type(data)) # print(data…...

lombok 驼峰命名缺陷,导致后台获取参数为null的解决办法

1.问题: 下面是我定义一个请求类的属性,采用Lombok注解,自动构建get和set方法。 Schema(description "父组织编码", requiredMode Schema.RequiredMode.REQUIRED) private String pOrgCode; 遇到这种命名,你会发现在…...

【dockerpython】亲测有效!适合新手!docker创建conda镜像+容器使用(挂载、端口映射、gpu使用)+云镜像仓库教程

文章目录 docker基本概念简介配置镜像加速源创建conda镜像1. 写 Dockerfile文件2. 创建镜像3. 创建容器并测试 容器的使用1. wsl挂载2. 端口映射3. 补充-gpu 云镜像仓库使用1. 登录2. 将本地镜像上传至云镜像仓库3. 从云镜像仓库下载镜像到本地 docker基本概念简介 简单来讲&a…...

矩阵,求矩阵秩、逆矩阵

求矩阵秩的方法: 高斯消元法:通过行变换将矩阵化为行阶梯形矩阵,然后数非零行的数量。LU分解:通过分解矩阵成上下三角矩阵,计算非零对角元素的数量。SVD分解:通过奇异值分解,计算非零奇异值的数…...

指针和const

const int* ptr,int* const ptr,const int* const ptr 这三种指针定义有什么区别?用法有什么不同? 指向的地址是否可变指向的地址上存储的内容是否可变const属性const int* ptr可改变不可改*ptr具有const属性int* const pts不可改…...

基于C#调用文心一言大模型制作桌面软件(可改装接口)

目录 开发前的准备账号注册应用创建应用接入 开始开发创建项目设计界面使用 AK,SK 生成鉴权签名窗体代码 百度智能云千帆大模型平台什么是百度智能云千帆大模型平台模型更新记录 开发前的准备 账号注册 访问百度智能云平台,通过百度账号登录或手机号验证…...

VB.net复制Ntag213卡写入UID

本示例使用的发卡器:https://item.taobao.com/item.htm?ftt&id615391857885 一、读取旧Ntag卡的UID和数据 Private Sub Button15_Click(sender As Object, e As EventArgs) Handles Button15.Click轻松读卡技术支持:网站:Dim i, j As IntegerDim cardidhex, …...

《从零掌握MIPI CSI-2: 协议精解与FPGA摄像头开发实战》-- CSI-2 协议详细解析 (一)

CSI-2 协议详细解析 (一) 1. CSI-2层定义(CSI-2 Layer Definitions) 分层结构 :CSI-2协议分为6层: 物理层(PHY Layer) : 定义电气特性、时钟机制和传输介质(导线&#…...

【Redis技术进阶之路】「原理分析系列开篇」分析客户端和服务端网络诵信交互实现(服务端执行命令请求的过程 - 初始化服务器)

服务端执行命令请求的过程 【专栏简介】【技术大纲】【专栏目标】【目标人群】1. Redis爱好者与社区成员2. 后端开发和系统架构师3. 计算机专业的本科生及研究生 初始化服务器1. 初始化服务器状态结构初始化RedisServer变量 2. 加载相关系统配置和用户配置参数定制化配置参数案…...

工程地质软件市场:发展现状、趋势与策略建议

一、引言 在工程建设领域,准确把握地质条件是确保项目顺利推进和安全运营的关键。工程地质软件作为处理、分析、模拟和展示工程地质数据的重要工具,正发挥着日益重要的作用。它凭借强大的数据处理能力、三维建模功能、空间分析工具和可视化展示手段&…...

linux 错误码总结

1,错误码的概念与作用 在Linux系统中,错误码是系统调用或库函数在执行失败时返回的特定数值,用于指示具体的错误类型。这些错误码通过全局变量errno来存储和传递,errno由操作系统维护,保存最近一次发生的错误信息。值得注意的是,errno的值在每次系统调用或函数调用失败时…...

《基于Apache Flink的流处理》笔记

思维导图 1-3 章 4-7章 8-11 章 参考资料 源码: https://github.com/streaming-with-flink 博客 https://flink.apache.org/bloghttps://www.ververica.com/blog 聚会及会议 https://flink-forward.orghttps://www.meetup.com/topics/apache-flink https://n…...

工业自动化时代的精准装配革新:迁移科技3D视觉系统如何重塑机器人定位装配

AI3D视觉的工业赋能者 迁移科技成立于2017年,作为行业领先的3D工业相机及视觉系统供应商,累计完成数亿元融资。其核心技术覆盖硬件设计、算法优化及软件集成,通过稳定、易用、高回报的AI3D视觉系统,为汽车、新能源、金属制造等行…...

使用 Streamlit 构建支持主流大模型与 Ollama 的轻量级统一平台

🎯 使用 Streamlit 构建支持主流大模型与 Ollama 的轻量级统一平台 📌 项目背景 随着大语言模型(LLM)的广泛应用,开发者常面临多个挑战: 各大模型(OpenAI、Claude、Gemini、Ollama)接口风格不统一;缺乏一个统一平台进行模型调用与测试;本地模型 Ollama 的集成与前…...

初探Service服务发现机制

1.Service简介 Service是将运行在一组Pod上的应用程序发布为网络服务的抽象方法。 主要功能:服务发现和负载均衡。 Service类型的包括ClusterIP类型、NodePort类型、LoadBalancer类型、ExternalName类型 2.Endpoints简介 Endpoints是一种Kubernetes资源…...

PAN/FPN

import torch import torch.nn as nn import torch.nn.functional as F import mathclass LowResQueryHighResKVAttention(nn.Module):"""方案 1: 低分辨率特征 (Query) 查询高分辨率特征 (Key, Value).输出分辨率与低分辨率输入相同。"""def __…...