Flink + Kafka 实现通用流式数据处理详解

Flink + Kafka 实现通用流式数据处理详解

在大数据时代,实时数据处理和分析成为企业快速响应市场变化、提高业务效率和优化决策的关键技术。Apache Flink和Apache Kafka作为两个重要的开源项目,在数据流处理领域具有广泛的应用。本文将深入探讨Flink和Kafka的关系、它们在数据流处理中的应用,并提供一些最佳实践和实际案例。

一、Flink与Kafka的基本概念

1. Apache Flink

Apache Flink是一个流处理框架,用于处理大量实时数据。它支持数据流和数据集两种操作模式,可以处理批量数据和流式数据。Flink提供了一种高效的、可扩展的、可靠的流处理解决方案,适用于各种应用场景,如实时分析、事件驱动应用、数据流处理等。

- 数据流(DataStream):Flink中的基本概念,表示一种连续的数据序列。数据流中的数据元素按照时间顺序排列,可以被处理、转换和聚合。

- 数据集(Dataset):Flink中的另一个基本概念,表示一种有限的数据序列。数据集中的数据元素可以被操作、计算和查询。

- 操作符(Operator):Flink中的操作符负责对数据流和数据集进行处理,可以实现各种数据转换、聚合、分区等功能。

- 分区(Partition):Flink中的数据分区是一种分布式策略,用于将数据流和数据集划分为多个部分,以实现并行处理和负载均衡。

- 检查点(Checkpoint):Flink中的检查点是一种容错机制,用于保证流处理任务的可靠性。通过检查点,Flink可以在故障发生时恢复任务状态,保证数据的一致性和完整性。

2. Apache Kafka

Apache Kafka是一个分布式消息系统,用于构建实时数据流管道和流式处理系统。Kafka可以处理大量高速数据,并提供有效的数据持久化和分布式消息传递功能。Kafka被广泛应用于日志收集、实时数据分析、流式计算等领域。

- Topic:Kafka中的Topic是一种分区的抽象概念,表示一组相关的分区,用于存储和传输数据。

- Partition:Kafka中的Partition是Topic的基本单位,表示一组连续的数据块,用于实现数据的分布式存储和并行处理。

- Producer:Kafka中的Producer是一种生产者组件,用于将数据发送到Topic中的Partition。

- Consumer:Kafka中的Consumer是一种消费者组件,用于从Topic中读取数据。

- Broker:Kafka中的Broker是一种服务器组件,用于存储和管理Topic和Partition,负责接收Producer发送的数据,并提供Consumer读取数据的接口。

二、Flink与Kafka的关系

Flink和Kafka之间的关系主要体现在以下几个方面:

- 数据源和接收器:Flink可以将数据源(如Kafka主题)作为流源,并将处理结果发送到数据接收器(如Kafka主题)。

- 实时数据处理:Flink可以与Kafka一起实现实时数据处理和分析,例如将Kafka中的数据流处理并输出到另一个Kafka主题。

- 分布式协同:Flink和Kafka都是分布式系统,它们可以通过各种协议和接口进行协同工作,例如Flink可以将数据写入Kafka主题,并从Kafka主题中读取数据。

具体来说,Flink可以作为Kafka的消费者,从Kafka中读取数据,并进行流处理。同时,Flink也可以将处理结果写入Kafka,实现数据的持久化和分布式传输。因此,Flink和Kafka在数据流处理中具有很高的兼容性和可扩展性。

三、Flink与Kafka的数据流处理操作

1. Flink数据流操作

Flink数据流操作主要包括以下步骤:

- 数据源(Source):Flink需要从某个数据源读取数据,如Kafka、文件、socket等。数据源可以生成数据流或数据集。

- 数据转换(Transformation):Flink可以对数据流和数据集进行各种转换操作,如映射、筛选、连接、聚合等。这些操作可以实现数据的过滤、计算、分组等功能。

- 数据接收(Sink):Flink需要将处理结果写入某个数据接收器,如Kafka、文件、socket等。数据接收器可以将处理结果存储或传输到其他系统。

2. Kafka数据接收和发送

Kafka数据接收和发送主要包括以下步骤:

- 数据生产(Produce):Kafka Producer需要将数据发送到Kafka Topic中的Partition。生产者需要指定Topic和Partition,以及数据格式和编码方式。

- 数据消费(Consume):Kafka Consumer需要从Kafka Topic中读取数据。消费者需要指定Topic和Partition,以及数据格式和编码方式。

- 数据持久化(Persistence):Kafka可以将数据持久化到磁盘上,实现数据的持久化和可靠性。

3. Flink与Kafka的数据流处理

Flink与Kafka的数据流处理主要涉及到以下步骤:

- Flink从Kafka读取数据:Flink可以作为Kafka的消费者,从Kafka中读取数据,并将读取到的数据转换为Flink数据流。

- Flink对数据流进行处理:Flink可以对读取到的数据流进行各种处理操作,如映射、筛选、连接、聚合等。这些操作可以实现数据的过滤、计算、分组等功能。

- Flink将处理结果写入Kafka:Flink可以将处理结果写入Kafka,实现数据的持久化和分布式传输。

四、Flink与Kafka集成的核心算法原理和数学模型公式

在Flink和Kafka之间进行数据流处理时,主要涉及到以下算法原理和数学模型公式:

-

数据分区数(Partition):Flink和Kafka中的数据分区数可以通过公式计算,但具体的计算公式在参考资料中并未明确给出。一般来说,分区数的选择需要根据数据的规模、处理能力和系统的要求来确定。

-

数据流速度(Throughput)和吞吐量(Throughput):这些数据流特性可以通过具体的性能指标来衡量,但同样没有给出具体的计算公式。在实际应用中,可以通过监控和调优系统来提高数据流速度和吞吐量。

五、Flink与Kafka集成的具体最佳实践和代码实例

1. 最佳实践

- 数据一致性:在Flink和Kafka之间进行数据同步时,需要确保数据的一致性。这可以通过Flink的检查点机制和Kafka的副本机制来实现。

- 配置和调优:Flink和Kafka的配置和调优是提高系统性能的关键。需要根据具体的应用场景和数据特性来调整系统的参数和配置。

- 容错性:Flink和Kafka都具有容错机制,可以保证数据处理的稳定性和可靠性。在实际应用中,需要充分利用这些机制来提高系统的容错能力。

2. 代码实例

以下是一个简单的Flink与Kafka集成的示例代码:

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import java.util.Properties;public class FlinkKafkaConsumerExample {public static void main(String[] args) throws Exception {// 设置执行环境StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();// 设置Kafka消费者组ID和主题String groupId = "flink-kafka-consumer-group";String topic = "test-topic";// 设置Kafka消费者配置Properties properties = new Properties();properties.setProperty("bootstrap.servers", "localhost:9092");properties.setProperty("group.id", groupId);// 创建Kafka消费者FlinkKafkaConsumer<String> kafkaConsumer = new FlinkKafkaConsumer<>(topic,new SimpleStringSchema(),properties);// 添加Kafka消费者为数据源DataStream<String> stream = env.addSource(kafkaConsumer);// 简单的数据处理(将输入字符串拆分为单词)DataStream<String> words = stream.flatMap(value -> {for (String word : value.split(" ")) {yield word;}});// 将处理后的数据打印到控制台words.print();// 启动作业env.execute("Flink Kafka Consumer Job");}

}

在这个示例中,Flink从Kafka主题中读取数据,将输入字符串拆分为单词,并将处理后的数据打印到控制台。这个简单的示例展示了Flink与Kafka集成的基本流程和关键步骤。

六、Flink与Kafka集成的实际应用场景

Flink与Kafka的集成在多个领域都有广泛的应用场景,如:

- 物联网:通过Kafka收集设备产生的数据,并使用Flink进行实时处理和分析。

- 电商:通过Kafka捕获用户行为日志,并使用Flink进行实时推荐和个性化展示。

- 金融:通过Kafka传输交易数据,并使用Flink进行实时分析和监控。

- 日志系统:Kafka常用于日志聚合和存储,而Flink可以用于日志的实时分析和处理。

七、总结

Flink和Kafka作为大数据处理领域的两个重要工具,各自具有独特的优势和特点。Flink以其高效流处理能力著称,而Kafka则在消息队列系统中占有一席之地。将Flink与Kafka集成,可以实现强大的实时数据处理和分析功能。通过充分发挥两者的优势和特点,可以构建出高效、可靠和可扩展的大数据处理平台。随着技术的不断进步和发展,Flink与Kafka集成将在更多领域发挥重要作用,推动大数据技术的应用和发展。

相关文章:

Flink + Kafka 实现通用流式数据处理详解

Flink Kafka 实现通用流式数据处理详解 在大数据时代,实时数据处理和分析成为企业快速响应市场变化、提高业务效率和优化决策的关键技术。Apache Flink和Apache Kafka作为两个重要的开源项目,在数据流处理领域具有广泛的应用。本文将深入探讨Flink和Ka…...

Docker常用命令汇总

一、Docker基础命令 启动docker:systemctl start docker关闭docker:systemctl stop docker重启docker:systemctl restart dockerdocker设置随服务启动而自启动:systemctl enable docker查看docker 运行状态:systemctl…...

【Java笔记】0-为什么学习Java

呃,当然是为了找个Java的开发工作 当然是由于Java使用的人多和它天生自带的优点了~ 主要优点有以下几点: 简单性 C语法纯净版,没有头文件、指针运算、不用分配内存 面向对象 重点放在对象与其接口上,接近人的逻辑 可移植性 …...

海外云手机是什么?对外贸电商有什么帮助?

在外贸电商领域,流量引流已成为卖家们关注的核心问题。越来越多的卖家开始利用海外云手机,通过TikTok等社交平台吸引流量,以推动商品在海外市场的销售。那么,海外云手机到底是什么?它又能为外贸电商卖家提供哪些支持呢…...

【找到了】有人知道怎么在本地用记事本方式打开Linux文本文件吗?

就类似这种,我输入一个什么命令打开文件,就能在命令窗口上弹出一个编辑器来编辑文件。只记得好像有参数-e啥的。 命令行里面如何打开文本编辑器? () 在linux命令行terminal上使用gedit直接就可以打开文本文件 那么在…...

docker 安装postgresql

前提:准备好postgresql镜像,如:镜像地址/postgres:15.8 使用docker安装posgresql: 1.docker pull 镜像地址/postgres:15.8 2.docker run -d --namepostgres -p 5432:5432 -v postgres-volume:/var/lib/postgresql/data -e PO…...

2004至2023中国分省统计面板数据-最新出炉_附下载链接

中国各省绿色税收相关数据(2007-2022年)概述 下载链接-点它👉👉👉:中国分省统计面板数据(2004-2023)-最新出炉.zip 资源介绍 绿色税收主要是指以保护环境、合理开发利用自然资源、…...

【算法】排序算法总结

文章目录 内排序一、插入排序1.1 直接插入排序1.2 折半插入排序1.3 希尔排序 二、选择排序2.1 简单选择排序2.2 堆排序 三、交换排序3.1 冒泡排序3.2 快速排序Hoare版挖坑法快速排序前后指针法快速排序的非递归 四、归并排序递归版本非递归版本 五、基数排序六、计数排序内排序…...

双11来了,云计算优惠大集合

京东云 2C2G强烈推荐 连接直达...

13. MapReduce自定义OutputFormat

一. OutputFormat简介 OutputFormat是MapReduce输出的基类,所有MapReduce输出都实现了OutputFormat接口,它接收ReduceTask产生的数据,然后将结果按照指定格式输出。 在MapReduce中,如果不指定,默认使用的是TextOutpu…...

Javase——正则表达式

正则表达式的相关使用 public static void main(String[] args) {//校验QQ号 System.out.println("3602222222".matches("[1-9][0-9]{4,}"));// 校验18位身份证号 System.out.println("11050220240830901X".matches("^([0-9]){7,18}…...

云原生文件系统之JuiceFS

JuiceFS 是一个分布式文件系统,专门为云原生环境设计,支持大规模数据存储和处理,特别适用于处理对象存储和大数据应用。JuiceFS 将元数据和数据分离,元数据保存在数据库中,而文件数据则存储在对象存储中,提…...

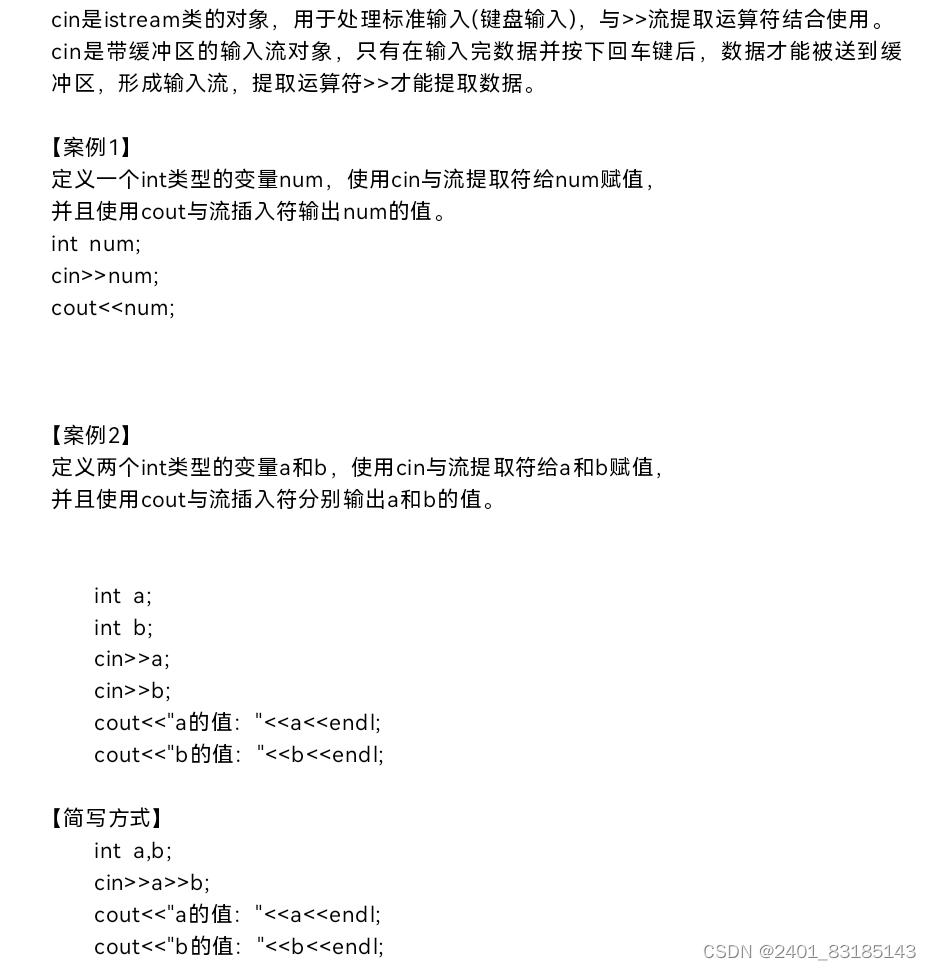

C++:输入和输出

一 . DEV C的下载和安装 二 . 第一个C程序 三 . 输出流 四 . 初始的数据类型 3.1、整型变量 3.2、双精度浮点数变量 3.3、字符型变量 3.4、字符串变量 3.5、无符号整型变量 五、输入流...

vue的路由的两种模式 hash与history 详细讲解

文章目录 1. Hash 模式工作原理优点缺点使用示例 2. History 模式工作原理优点缺点服务器配置示例使用示例 总结 Vue Router 是 Vue.js 的官方路由管理器,它支持多种路由模式,其中最常用的两种是 hash 模式和 history 模式。下面我们详细讲解这两种模式的…...

【Linux操作系统】进程间通信之匿名管道与命名管道

目录 一、进程间通信的目的:二、进程间通信的种类三、什么是管道四、匿名管道(共同祖先的进程之间)1.匿名管道的使用2.匿名管道举例3.匿名管道的原理4.管道特点5.管道的读写规则1. 当管道内没有数据可读时2.当管道满的时候3.管道端被关闭4.数…...

慢sql优化和Explain解析

要想程序跑的快,sql优化不可懈怠!今日来总结一下常用的慢sql的分析和优化的方法。 1、慢sql的执行分析: 大家都知道分析一个sql语句执行效率的方法是用explain关键词: 举例:sql:select * from test where bussiness_…...

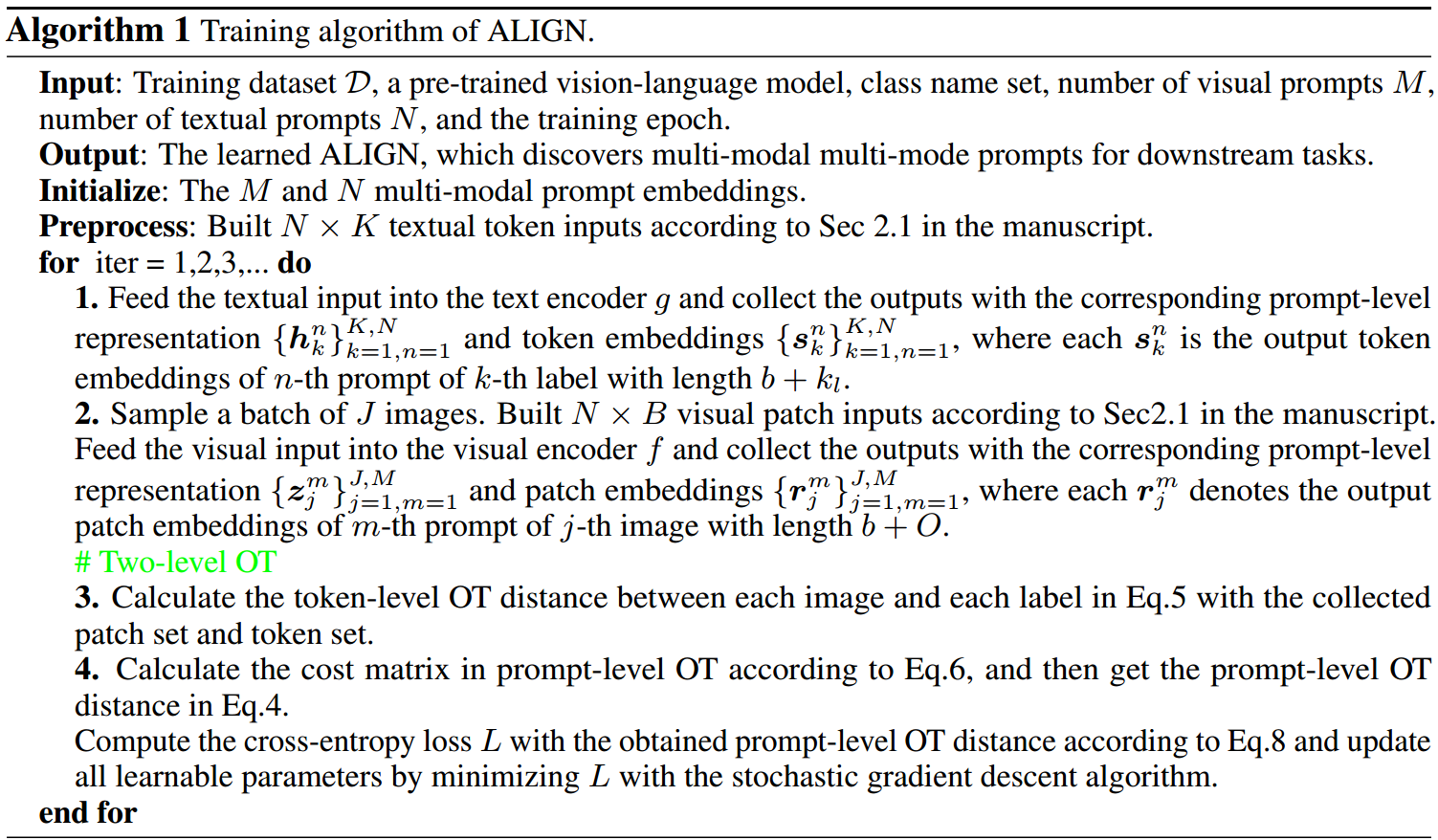

ALIGN_ Tuning Multi-mode Token-level Prompt Alignment across Modalities

文章汇总 当前的问题 目前的工作集中于单模提示发现,即一种模态只有一个提示,这可能不足以代表一个类[17]。这个问题在多模态提示学习中更为严重,因为视觉和文本概念及其对齐都需要推断。此外,仅用全局特征来表示图像和标记是不…...

【Java SE】代码注释

代码注释 注释(comment)是用于说明解释程序的文字,注释的作用在于提高代码的阅读性(可读性)。Java中的注释类型包括3种,分别是: 单行注释多行注释文档注释 ❤️ 单行注释 基本格式ÿ…...

如何在算家云搭建Llama3-Factory(智能对话)

一、Llama3-Factory 简介 当地时间 4 月 18 日,Meta 在官网上宣布公布了旗下最新大模型 Llama 3。目前,Llama 3 已经开放了 80 亿(8B)和 700 亿(70B)两个小参数版本,上下文窗口为 8k。Llama3 是…...

操作数据表

创建表 创建表语法: CREATE TABLE table_name ( field1 datatype [COMMENT 注释内容], field2 datatype [COMMENT 注释内容], field3 datatype ); 注意: 1. 蓝色字体为关键字 2. CREATE TABLE 是创建数据表的固定关键字,表…...

MPNet:旋转机械轻量化故障诊断模型详解python代码复现

目录 一、问题背景与挑战 二、MPNet核心架构 2.1 多分支特征融合模块(MBFM) 2.2 残差注意力金字塔模块(RAPM) 2.2.1 空间金字塔注意力(SPA) 2.2.2 金字塔残差块(PRBlock) 2.3 分类器设计 三、关键技术突破 3.1 多尺度特征融合 3.2 轻量化设计策略 3.3 抗噪声…...

synchronized 学习

学习源: https://www.bilibili.com/video/BV1aJ411V763?spm_id_from333.788.videopod.episodes&vd_source32e1c41a9370911ab06d12fbc36c4ebc 1.应用场景 不超卖,也要考虑性能问题(场景) 2.常见面试问题: sync出…...

Debian系统简介

目录 Debian系统介绍 Debian版本介绍 Debian软件源介绍 软件包管理工具dpkg dpkg核心指令详解 安装软件包 卸载软件包 查询软件包状态 验证软件包完整性 手动处理依赖关系 dpkg vs apt Debian系统介绍 Debian 和 Ubuntu 都是基于 Debian内核 的 Linux 发行版ÿ…...

Java多线程实现之Callable接口深度解析

Java多线程实现之Callable接口深度解析 一、Callable接口概述1.1 接口定义1.2 与Runnable接口的对比1.3 Future接口与FutureTask类 二、Callable接口的基本使用方法2.1 传统方式实现Callable接口2.2 使用Lambda表达式简化Callable实现2.3 使用FutureTask类执行Callable任务 三、…...

DBAPI如何优雅的获取单条数据

API如何优雅的获取单条数据 案例一 对于查询类API,查询的是单条数据,比如根据主键ID查询用户信息,sql如下: select id, name, age from user where id #{id}API默认返回的数据格式是多条的,如下: {&qu…...

IoT/HCIP实验-3/LiteOS操作系统内核实验(任务、内存、信号量、CMSIS..)

文章目录 概述HelloWorld 工程C/C配置编译器主配置Makefile脚本烧录器主配置运行结果程序调用栈 任务管理实验实验结果osal 系统适配层osal_task_create 其他实验实验源码内存管理实验互斥锁实验信号量实验 CMISIS接口实验还是得JlINKCMSIS 简介LiteOS->CMSIS任务间消息交互…...

【Oracle】分区表

个人主页:Guiat 归属专栏:Oracle 文章目录 1. 分区表基础概述1.1 分区表的概念与优势1.2 分区类型概览1.3 分区表的工作原理 2. 范围分区 (RANGE Partitioning)2.1 基础范围分区2.1.1 按日期范围分区2.1.2 按数值范围分区 2.2 间隔分区 (INTERVAL Partit…...

)

Angular微前端架构:Module Federation + ngx-build-plus (Webpack)

以下是一个完整的 Angular 微前端示例,其中使用的是 Module Federation 和 npx-build-plus 实现了主应用(Shell)与子应用(Remote)的集成。 🛠️ 项目结构 angular-mf/ ├── shell-app/ # 主应用&…...

虚拟电厂发展三大趋势:市场化、技术主导、车网互联

市场化:从政策驱动到多元盈利 政策全面赋能 2025年4月,国家发改委、能源局发布《关于加快推进虚拟电厂发展的指导意见》,首次明确虚拟电厂为“独立市场主体”,提出硬性目标:2027年全国调节能力≥2000万千瓦࿰…...

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。 尽管 VLMs 取得了显著进展,机器人仍难以胜任复杂的长时程任务(如家具装配),主要受限于人…...