【人工智能】10分钟解读-深入浅出大语言模型(LLM)——从ChatGPT到未来AI的演进

文章目录

- 一、前言

- 二、GPT模型的发展历程

- 2.1 自然语言处理的局限

- 2.2 机器学习的崛起

- 2.3 深度学习的兴起

- 2.3.1 神经网络的训练

- 2.3.2 神经网络面临的挑战

- 2.4 Transformer的革命性突破

- 2.4.1 Transformer的核心组成

- 2.4.2 Transformer的优势

- 2.5 GPT模型的诞生与发展

- 2.5.1 GPT的核心特点

- 2.5.2 GPT模型的迭代与升级

- 三、大语言模型时代的到来

- 3.1 LLM的定义与特征

- 3.2 LLM对AI发展的影响

- 四、揭开大语言模型(LLM)的面纱

- 4.1 什么是LLM

- 4.2 LLM的构成特点

- 4.2.1 Transformer架构在LLM中的应用

- 4.2.2 预训练-微调机制

- 4.2.3 生成式能力

- 4.3 LLM的工作原理

- 4.3.1 预训练阶段

- 4.3.2 微调阶段

- 五、LLM的应用场景

- 5.1 RAG场景(检索增强生成)

- 5.1.1 LLM存在的问题

- 5.1.2 什么是RAG

- 5.1.3 RAG的应用

- 5.2 AIGC场景(人工智能生成内容)

- 5.2.1 文本生成

- 5.2.2 代码编写

- 5.2.3 多模态生成

- 六、LLM的挑战与未来发展

- 6.1 模型偏见与伦理问题

- 6.2 计算成本与资源消耗

- 6.3 知识更新与保持

- 6.4 多语言与跨文化理解

- 七、总结

- 更多文章

一、前言

2022年底,OpenAI推出的聊天机器人ChatGPT一经上线,便迅速引发了全球范围内的热议与追捧。仅在上线五天内,注册用户便突破了百万大关。ChatGPT的成功不仅展示了大语言模型(LLM)的强大能力,也标志着人类正式迈入了一个全新的人工智能时代。

本文将以ChatGPT为切入点,回顾GPT模型的发展历程,深入解析大语言模型(LLM)的构成及其工作原理。同时,我们将涵盖自然语言处理(NLP)、深度学习、Transformer等相关知识,帮助读者全面了解LLM及其在AI领域中的重要地位。

二、GPT模型的发展历程

2.1 自然语言处理的局限

自然语言处理(Natural Language Processing,简称NLP)作为人工智能的重要分支,旨在使计算机能够理解、处理和生成自然语言。然而,传统的NLP方法主要依赖于规则和统计模型,这导致了诸多局限性。例如:

- 语境理解不足:传统模型在处理复杂语境时,往往难以理解句子间的深层次关联。

- 生成能力有限:生成的文本缺乏多样性和自然流畅性,通常显得生硬和模板化。

- 特征依赖性强:传统方法依赖于手工提取特征,难以自动学习语言的深层次表示。

在ChatGPT出现之前,尽管市场上已有许多智能聊天工具,但它们大多只能完成简单、模板化的对话,难以应对复杂的交流需求。这些局限性促使研究人员不断探索新的方法以突破传统NLP的瓶颈。

2.2 机器学习的崛起

随着机器学习(Machine Learning,简称ML)的不断发展,NLP领域迎来了新的契机。机器学习通过无监督和有监督学习方法,从大规模数据中提取模式和规律,显著提升了计算机处理自然语言的能力。主要进展包括:

- 统计模型:如朴素贝叶斯、支持向量机(SVM)等,开始在文本分类、情感分析等任务中发挥作用。

- 词向量表示:Word2Vec、GloVe等模型引入了词嵌入,将离散的词表示为连续的向量,捕捉词之间的语义关系。

尽管机器学习方法在传统NLP任务如文本分类、命名实体识别等方面取得了显著进展,但在处理复杂语言任务时仍面临诸多挑战:

- 特征提取依赖人工:需要领域专家手工设计特征,耗时耗力且难以覆盖所有语言现象。

- 模型泛化能力有限:难以在不同任务或领域间迁移,泛化能力不足。

2.3 深度学习的兴起

深度学习(Deep Learning,简称DL)作为机器学习的一个子领域,通过构建多层神经网络,模拟人脑的工作方式,使得计算机能够更高效地处理和理解复杂数据。在NLP领域,深度学习模型如循环神经网络(RNN)和卷积神经网络(CNN)等的应用,带来了突破性的进展。这些模型通过海量数据的训练,能够提取出更高级别的语义特征,显著提升了语言理解和生成的准确性与灵活性。

2.3.1 神经网络的训练

深度学习依赖于有监督学习,通过提供大量标注数据,训练神经网络以完成特定任务。例如:

- 面部识别:神经网络通过处理数百万张标注过的人脸图像,学习识别不同的面部特征。

- 机器翻译:通过大量的双语语料,训练网络实现从一种语言到另一种语言的自动翻译。

在NLP中,神经网络通过大量文本数据的训练,学习语言的结构和语义。例如,长短期记忆网络(LSTM)和门控循环单元(GRU)被广泛应用于生成和理解任务中。

2.3.2 神经网络面临的挑战

尽管神经网络在多个领域取得了成功,但在NLP任务中依然面临一些挑战:

- 记忆长度:传统神经网络在处理长序列时,信息容易衰减,导致对远距离依赖关系的捕捉不足。

- 并行性:序列数据的逐步处理方式限制了并行计算的效率,影响了训练速度。

- 长距离依赖性:在处理长文本时,梯度消失和梯度爆炸问题使得模型难以有效学习长距离的语义关系。

这些挑战促使研究人员不断改进网络结构,寻求更高效、更具表达能力的模型。

2.4 Transformer的革命性突破

2017年,Google在论文《Attention is All You Need》中提出了Transformer模型,彻底改变了NLP领域的格局。Transformer引入了自注意力机制(Self-Attention)和位置编码(Positional Encoding),解决了传统神经网络在处理长序列数据时的诸多问题。其高度的并行性和强大的长距离依赖捕捉能力,使得Transformer在语言建模、机器翻译等任务中取得了卓越的表现。

2.4.1 Transformer的核心组成

- 自注意力机制(Self-Attention):允许模型在处理中每个词时,关注序列中所有其他词的重要性,从而捕捉全局信息。

- 多头注意力(Multi-Head Attention):通过并行多个注意力头,捕捉不同子空间的特征,增强模型的表达能力。

- 前馈神经网络(Feed-Forward Neural Network):在每个注意力层之后,进行非线性变换,提升模型的非线性表示能力。

- 位置编码(Positional Encoding):通过添加位置信息,帮助模型理解词语在序列中的顺序。

2.4.2 Transformer的优势

- 并行计算:不同于RNN的逐步处理方式,Transformer可以并行处理序列中的所有词,提高了训练效率。

- 捕捉长距离依赖:自注意力机制使得模型能够直接访问序列中任意位置的信息,解决了RNN在长序列处理中记忆衰减的问题。

- 模块化设计:Transformer由多个相同的编码器和解码器层堆叠而成,具有高度的可扩展性和灵活性。

Transformer的成功不仅推动了NLP技术的发展,也为后续的大量基于深度学习的语言模型奠定了基础,如BERT、GPT等,进一步推动了NLP技术的进步。

2.5 GPT模型的诞生与发展

在深度学习和Transformer技术的推动下,OpenAI于2018年推出了GPT(Generative Pre-trained Transformer)模型。GPT通过大规模的无监督预训练,结合有监督的微调机制,成为生成式语言模型的代表,进一步提升了自然语言生成的能力。2022年末,基于GPT模型的ChatGPT正式上线,迅速获得了全球范围内的关注与认可。

2.5.1 GPT的核心特点

GPT模型具有以下三个核心特点:

- Transformer架构:GPT基于Transformer架构,实现了高效的并行计算和长距离依赖关系的捕捉。

- 预训练-微调机制:GPT首先在海量未标注文本上进行无监督预训练,随后在特定任务上进行有监督微调,使模型具备了强大的通用性和适应性。

- 生成式能力:与双向模型BERT不同,GPT采用单向语言模型的预训练方法,使其在文本生成任务中表现尤为出色。

2.5.2 GPT模型的迭代与升级

GPT模型自诞生以来,经历了多个版本的迭代,每一代都在参数规模和性能上实现了显著提升:

- GPT-1:发布于2018年,拥有1.17亿参数,证明了预训练-微调框架在语言模型中的有效性。

- GPT-2:发布于2019年,参数规模增至15亿,展示了更强的生成能力,但因担忧滥用风险,初期未完全公开。

- GPT-3:发布于2020年,拥有1750亿参数,进一步提升了语言生成的质量和多样性,被广泛应用于各种生成任务中。

- GPT-4:发布于2023年,参数规模超过GPT-3的10倍,具备更强的理解和生成能力,虽然训练成本高昂,但在各项任务中表现卓越。

随着技术的不断进步,GPT模型不仅在参数规模上不断增长,其架构和训练方法也在不断优化,推动了自然语言处理技术的前沿发展。

三、大语言模型时代的到来

GPT模型的成功,开启了大语言模型(Large Language Model,简称LLM)时代。LLM通过大规模的预训练,结合海量参数,显著提升了语言理解与生成的能力,推动了生成式人工智能(Artificial Intelligence Generated Content,简称AIGC)的快速发展。这一时代不仅见证了语言模型在各类NLP任务中的突破,也为AI在更多实际应用场景中的落地提供了坚实基础。

3.1 LLM的定义与特征

LLM指的是具有数十亿甚至上千亿参数的语言模型,通常基于深度学习架构(如Transformer)。其主要特征包括:

- 大规模参数:数十亿至上千亿的参数量,使模型具备强大的表达和学习能力。

- 海量语料预训练:在海量未标注文本上进行预训练,掌握广泛的语言知识和语义信息。

- 广泛的适应性:通过微调,可以适应多种具体任务,如文本生成、翻译、对话系统等。

3.2 LLM对AI发展的影响

- 提升自然语言理解和生成能力:LLM在语法、语义理解和上下文关联方面表现出色,能够生成连贯、自然的文本。

- 推动多模态AI的发展:结合其他生成模型,LLM可以与图像、音频等多模态数据融合,推动多模态AI的发展。

- 加速AI在各行业的应用:从客服、内容创作到代码生成,LLM的应用前景广泛,助力各行业实现智能化转型。

四、揭开大语言模型(LLM)的面纱

4.1 什么是LLM

大语言模型(LLM,Large Language Model)是一种基于深度学习的语言模型,通常拥有数十亿甚至上千亿的参数。LLM通过对海量未标注文本的预训练,掌握了丰富的语言知识和语义信息,具备强大的语言理解和生成能力。在特定任务上,LLM可通过微调适应不同的应用场景,从而实现多样化的NLP功能。

LLM的名称解释:

- Large(大型):表示该模型具有大量的参数和语料,结构复杂庞大。

- Language(语言):表示该模型用于自然语言处理任务,能够处理和生成多种语言文本。

- Model(模型):表示该模型是基于深度学习构建的神经网络模型,通常基于Transformer架构。

4.2 LLM的构成特点

LLM主要由以下几个关键组成部分构成:

- Transformer架构:利用自注意力机制和位置编码处理序列数据,具备高度的并行性和长距离依赖捕捉能力。

- 预训练-微调机制:通过大规模无监督预训练获取通用语言知识,再通过有监督微调适应特定任务需求。

- 生成式能力:具备强大的文本生成能力,能够根据输入生成连贯、自然的文本内容。

4.2.1 Transformer架构在LLM中的应用

Transformer架构在LLM中扮演着核心角色,其主要组件包括:

-

输入嵌入(Input Embedding):将原始文本转化为向量表示,通过词嵌入(Word Embedding)和位置编码(Positional Encoding)实现。

import torch.nn as nnclass InputEmbedding(nn.Module):def __init__(self, vocab_size, embed_size, max_length):super(InputEmbedding, self).__init__()self.token_embedding = nn.Embedding(vocab_size, embed_size)self.position_embedding = nn.Embedding(max_length, embed_size)def forward(self, x):positions = torch.arange(0, x.size(1)).unsqueeze(0).expand_as(x)return self.token_embedding(x) + self.position_embedding(positions) -

编码器(Encoder):由多层自注意力机制和前馈神经网络组成,负责提取输入文本的深层语义特征。

-

解码器(Decoder):生成目标文本,通过自注意力机制和编码-解码注意力机制,实现高质量的文本生成。

关键技术详解:

-

自注意力机制(Self-Attention):计算序列中每个词与其他词的相似度,生成加权表示。

A t t e n t i o n ( Q , K , V ) = s o f t m a x ( Q K T d k ) V Attention(Q, K, V) = softmax\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中,( Q )、( K )、( V ) 分别为查询(Query)、键(Key)、值(Value)的矩阵。

-

多头注意力(Multi-Head Attention):并行计算多个注意力头,捕捉不同子空间的特征。

M u l t i H e a d ( Q , K , V ) = C o n c a t ( h e a d 1 , … , h e a d h ) W O MultiHead(Q, K, V) = Concat(head_1, \dots, head_h)W^O MultiHead(Q,K,V)=Concat(head1,…,headh)WO

其中,( head_i = Attention(QW_i^Q, KW_i^K, VW_i^V) )。

-

前馈神经网络(Feed-Forward Neural Network):对每个位置的表示进行非线性变换,通常包含两个线性变换和一个激活函数。

F F N ( x ) = m a x ( 0 , x W 1 + b 1 ) W 2 + b 2 FFN(x) = max(0, xW_1 + b_1)W_2 + b_2 FFN(x)=max(0,xW1+b1)W2+b2

-

位置编码(Positional Encoding):通过正弦和余弦函数为每个位置生成独特的编码,注入序列位置信息。

P E ( p o s , 2 i ) = s i n ( p o s 1000 0 2 i d m o d e l ) PE_{(pos, 2i)} = sin\left(\frac{pos}{10000^{\frac{2i}{d_{model}}}}\right) PE(pos,2i)=sin(10000dmodel2ipos)

P E ( p o s , 2 i + 1 ) = c o s ( p o s 1000 0 2 i d m o d e l ) PE_{(pos, 2i+1)} = cos\left(\frac{pos}{10000^{\frac{2i}{d_{model}}}}\right) PE(pos,2i+1)=cos(10000dmodel2ipos)

4.2.2 预训练-微调机制

LLM的训练过程分为两个阶段:

-

预训练阶段:在大规模未标注文本上进行训练,学习语言的基本模式和结构。常用的预训练任务包括:

- 语言模型任务(Language Modeling):预测句子中的下一个词或掩盖词。GPT采用自回归模型,通过预测下一个词进行训练。

- 掩码语言模型(Masked Language Modeling,MLM):如BERT,通过掩盖部分词语,训练模型预测被掩盖的词。

-

微调阶段:在特定任务的有标注数据上进行训练,优化模型参数,使其更好地适应具体应用需求。常见的微调任务包括:

- 文本分类

- 命名实体识别

- 机器翻译

- 问答系统

预训练与微调的结合使得LLM既具备强大的通用性,又能够在具体任务上表现出色。

4.2.3 生成式能力

LLM的生成式能力使其能够在多种任务中表现出色,包括但不限于:

- 文本生成:根据输入提示生成连贯的段落或文章。

- 对话系统:模拟人类对话,提供自然流畅的交流体验。

- 代码生成:根据自然语言描述生成相应的代码片段。

- 多模态生成:结合图像、音频等多种模态,实现综合内容生成。

4.3 LLM的工作原理

LLM的工作过程主要分为预训练和微调两个阶段:

4.3.1 预训练阶段

在预训练阶段,LLM在海量文本数据上进行无监督学习,掌握语言的基本规律和模式。预训练通常采用自监督学习的方法,通过设计任务让模型自动学习。例如,GPT模型通过自回归的方式,逐词预测下一个词,从而学习语言的结构和语义。

预训练的关键步骤:

- 数据准备:收集并清洗海量未标注文本数据,确保数据的多样性和覆盖面。

- 模型训练:使用分布式计算资源,训练具有数十亿参数的模型,优化目标是最大化下一个词的预测概率。

- 知识积累:通过长时间的训练,模型逐步积累语言知识和语义理解能力。

4.3.2 微调阶段

预训练完成后,LLM在特定任务的有标注数据上进行微调。通过在特定任务上的有监督学习,模型进一步优化参数,使其更好地适应具体应用需求。

微调的关键步骤:

- 任务定义:明确具体任务,如文本分类、命名实体识别、机器翻译等。

- 数据准备:收集并标注与任务相关的数据,确保数据的质量和覆盖面。

- 模型微调:在预训练模型的基础上,使用特定任务的数据进行有监督训练,调整模型参数以提高任务性能。

- 评估与优化:通过验证集评估模型性能,进行必要的参数调整和优化,确保模型在实际应用中的表现。

通过预训练和微调相结合,LLM不仅具备了广泛的语言理解能力,还能够在特定任务上展现出色的性能。

五、LLM的应用场景

大语言模型(LLM)凭借其强大的语言理解和生成能力,在多个领域展现出了广泛的应用前景。以下是主要的应用场景:

5.1 RAG场景(检索增强生成)

尽管LLM具备强大的生成能力,但在某些情况下,如处理最新信息或特定领域知识时,可能会遇到知识更新不及时或数据源不足的问题。引入RAG(Retrieval-Augmented Generation)技术,可以有效解决这些问题。

5.1.1 LLM存在的问题

LLM在实际应用中可能面临以下两个主要问题:

- 时效性不及时:LLM依赖于训练时的语料,语料的时效性决定了LLM回答的正确性。例如,GPT-4的训练数据截止到2023年10月,对于之后发生的事件,模型无法提供准确的信息。

- 数据源不充足:如果某个领域的语料数据不足,LLM在该领域的表现可能不佳,无法回答相关问题或生成高质量的内容。

5.1.2 什么是RAG

RAG(Retrieval-Augmented Generation)是一种结合了检索和生成的方法,用于自然语言处理任务。其核心思路是将检索到的相关信息作为上下文输入LLM,辅助生成更准确和相关的内容。

RAG的工作流程:

-

检索阶段(Retrieval):

- 目标:从大型知识库或文档集合中检索与当前任务相关的文本片段或文档。

- 方法:采用向量检索技术(如FAISS、Annoy),通过将查询和文档编码为向量,计算相似度,检索相关性最高的文本。

- 示例:用户提问“最新的iPhone型号是什么?”,系统通过检索获取相关的最新iPhone信息。

-

生成阶段(Generation):

- 目标:利用检索到的文本作为上下文,生成符合逻辑和相关性的回答或内容。

- 方法:将检索到的文本与用户的输入一起作为LLM的输入,指导模型生成相关内容。

- 示例:基于检索到的最新iPhone型号信息,生成详细的描述和功能介绍。

-

调整阶段(Adjustment):

- 目标:根据用户反馈或特定需求,对生成的内容进行进一步优化和调整。

- 方法:使用后处理技术,如纠错、风格调整,或根据规则进行内容筛选。

- 示例:根据用户要求调整回答的详细程度或语气,确保生成内容符合预期。

5.1.3 RAG的应用

RAG技术广泛应用于以下场景:

- 智能问答系统:通过检索相关文档,提供准确和详细的回答。

- 文档摘要生成:检索相关段落,生成简明扼要的摘要。

- 实时信息查询:结合最新数据,提供时效性强的回答,如新闻查询、股票行情等。

RAG的实现示例:

大模型聚集地-ChatMoss & ChatGPT中文版

from transformers import AutoTokenizer, AutoModelForSeq2SeqLM

import faiss

import numpy as np# 加载检索模型和生成模型

retriever_tokenizer = AutoTokenizer.from_pretrained("facebook/dpr-bert-base-retriever")

retriever_model = AutoModelForSeq2SeqLM.from_pretrained("facebook/dpr-bert-base-retriever")

generator_tokenizer = AutoTokenizer.from_pretrained("gpt-4")

generator_model = AutoModelForSeq2SeqLM.from_pretrained("gpt-4")# 构建向量索引

index = faiss.IndexFlatL2(768) # 假设使用768维的向量

corpus_embeddings = np.load("corpus_embeddings.npy") # 预先计算好的语料库向量

index.add(corpus_embeddings)def retrieve(query, top_k=5):query_embedding = retriever_model.encode(query)distances, indices = index.search(np.array([query_embedding]), top_k)return [corpus[i] for i in indices[0]]def generate_response(query):retrieved_docs = retrieve(query)context = " ".join(retrieved_docs)input_text = f"Question: {query}\nContext: {context}\nAnswer:"inputs = generator_tokenizer.encode(input_text, return_tensors="pt")outputs = generator_model.generate(inputs, max_length=200)return generator_tokenizer.decode(outputs[0], skip_special_tokens=True)# 用户提问示例

response = generate_response("最新的iPhone型号是什么?")

print(response)

5.2 AIGC场景(人工智能生成内容)

AIGC(Artificial Intelligence Generated Content)涵盖了多种内容生成任务,包括文本生成、图片生成、代码编写、视频制作、语音合成等。LLM在AIGC中的应用,极大地推动了内容创作的自动化与智能化。

5.2.1 文本生成

LLM能够根据输入提示,自动生成高质量的文章、故事、新闻报道等,广泛应用于内容创作、新闻写作、自动摘要等领域。

应用示例:

- 内容创作:根据主题自动生成博客文章或技术文档。

- 新闻写作:基于数据自动生成新闻报道,提高新闻生产效率。

- 自动摘要:对长篇文章进行摘要,提取关键信息。

from transformers import GPT2LMHeadModel, GPT2Tokenizer# 加载模型和tokenizer

model_name = "gpt2-large"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)def generate_text(prompt, max_length=200):inputs = tokenizer.encode(prompt, return_tensors="pt")outputs = model.generate(inputs, max_length=max_length, num_return_sequences=1, no_repeat_ngram_size=2)return tokenizer.decode(outputs[0], skip_special_tokens=True)# 生成示例

prompt = "在未来的人工智能时代,"

generated_text = generate_text(prompt)

print(generated_text)

5.2.2 代码编写

通过理解自然语言描述,LLM可以生成相应的代码片段,辅助程序员进行代码编写和调试,提高开发效率。

应用示例:

- 自动补全:根据开发者输入的函数名称或注释,生成相应的代码实现。

- 代码翻译:将一种编程语言的代码转换为另一种语言。

- 错误修复:根据错误提示,生成修复代码。

大模型聚集地-ChatMoss & ChatGPT中文版

from transformers import CodexModel, CodexTokenizer# 假设使用OpenAI的Codex模型

model_name = "code-davinci-002"

tokenizer = CodexTokenizer.from_pretrained(model_name)

model = CodexModel.from_pretrained(model_name)def generate_code(description, max_length=150):prompt = f"# {description}\n"inputs = tokenizer.encode(prompt, return_tensors="pt")outputs = model.generate(inputs, max_length=max_length, num_return_sequences=1, temperature=0.5)return tokenizer.decode(outputs[0], skip_special_tokens=True)# 生成示例

description = "计算两个数的最大公约数"

generated_code = generate_code(description)

print(generated_code)

5.2.3 多模态生成

结合其他生成模型,LLM能够实现文字、图片、音视频的综合生成,应用于多媒体内容创作、虚拟现实等前沿领域。

应用示例:

- 文本生成图像:根据文字描述生成对应的图像内容。

- 视频脚本生成:根据文字描述自动生成视频脚本和分镜头设计。

- 语音合成:将文本内容转换为自然流畅的语音。

大模型聚集地-ChatMoss & ChatGPT中文版

# 示例:文本生成图像

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

import torch# 加载模型和处理器

model = CLIPModel.from_pretrained("openai/CLIP-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/CLIP-vit-base-patch32")def generate_image(text):inputs = processor(text=[text], return_tensors="pt", padding=True)outputs = model.get_text_features(**inputs)# 由于CLIP是用于对齐图像和文本的,实际图像生成需要结合生成模型,如DALL·E# 此处仅作为示例,生成过程复杂,此处省略return "图像生成需要使用专门的生成模型,如DALL·E"# 生成示例

text = "一只在草地上奔跑的棕色狗"

image = generate_image(text)

print(image)

六、LLM的挑战与未来发展

尽管LLM在多个领域展现出了巨大的潜力,但其发展过程中也面临诸多挑战和问题,需要持续关注和解决。

6.1 模型偏见与伦理问题

LLM在训练过程中依赖于海量的互联网文本,这些文本中可能包含各种偏见和不当内容,导致模型生成的输出也存在相应的偏见和问题。具体表现包括:

- 性别、种族偏见:模型可能生成带有性别、种族偏见的内容。

- 虚假信息:模型可能生成看似合理但实际上不准确或虚假的信息。

- 隐私泄露:模型可能泄露训练数据中的敏感信息。

解决方法:

- 数据清洗与过滤:在训练前对数据进行严格的清洗和过滤,减少有害内容的输入。

- 偏见检测与纠正:开发偏见检测工具,及时发现和纠正模型输出中的偏见。

- 伦理规范制定:制定并遵守AI伦理规范,确保模型的开发和应用符合法律和道德标准。

6.2 计算成本与资源消耗

训练和部署LLM需要大量的计算资源和高昂的成本。随着模型规模的不断扩大,资源消耗问题愈发突出,具体表现包括:

- 高昂的训练成本:大规模模型的训练需要大量的计算资源和时间,造成高昂的经济成本。

- 环境影响:大量计算资源的消耗也带来了显著的碳排放,增加了环境负担。

解决方法:

- 模型压缩与优化:通过剪枝、量化、知识蒸馏等技术,压缩模型规模,降低计算需求。

- 高效的分布式训练:优化分布式训练算法,提高计算效率,减少训练时间。

- 绿色AI:采用节能环保的计算设备和数据中心,降低能源消耗和碳排放。

6.3 知识更新与保持

LLM的知识截止于训练时的语料,对于之后发生的事件或新知识无法及时掌握。这限制了模型在一些需要最新信息的应用场景中的效果。

解决方法:

- 动态更新机制:定期更新模型的训练数据,确保模型能够掌握最新的信息和知识。

- 结合外部知识库:通过与外部知识库或实时数据源结合,弥补模型知识的更新滞后。

- 增量学习:采用增量学习方法,逐步更新模型参数,融入新知识而不遗忘旧知识。

6.4 多语言与跨文化理解

当前大多数LLM主要针对英语和少数几种主流语言,其他语言的支持和理解能力相对较弱,存在多语言和跨文化理解的局限性。

解决方法:

- 多语言训练:在训练过程中引入更多的多语言语料,提高模型对不同语言的理解和生成能力。

- 跨文化数据融合:结合不同文化背景的数据,增强模型的跨文化理解能力。

- 社区协作:鼓励全球社区参与多语言数据的收集和模型的训练,提升多语言模型的覆盖面和质量。

七、总结

更多文章

【VScode】中文版ChatGPT编程工具-CodeMoss!教程+示例+快捷键

【VScode】VSCode中的智能编程利器,全面揭秘ChatMoss & ChatGPT中文版

本文通过回顾GPT模型的发展历程,深入解析了大语言模型(LLM)的构成及其工作原理,探讨了LLM在RAG和AIGC等多个应用场景中的广泛应用。我们还分析了LLM面临的挑战,如模型偏见、计算成本、知识更新和多语言理解等,并提出了相应的解决方法。

随着技术的不断进步,LLM将继续引领自然语言处理和人工智能领域的创新,为未来的研究和实际应用开辟更多可能。从ChatGPT的成功到LLM时代的到来,人工智能技术正在以前所未有的速度发展,赋能各行各业。未来,随着更强大的模型和更丰富的数据的涌现,LLM将在更多领域展现其潜力,推动社会的智能化进程。

相关文章:

【人工智能】10分钟解读-深入浅出大语言模型(LLM)——从ChatGPT到未来AI的演进

文章目录 一、前言二、GPT模型的发展历程2.1 自然语言处理的局限2.2 机器学习的崛起2.3 深度学习的兴起2.3.1 神经网络的训练2.3.2 神经网络面临的挑战 2.4 Transformer的革命性突破2.4.1 Transformer的核心组成2.4.2 Transformer的优势 2.5 GPT模型的诞生与发展2.5.1 GPT的核心…...

「QT」几何数据类 之 QPointF 浮点型点类

✨博客主页何曾参静谧的博客📌文章专栏「QT」QT5程序设计📚全部专栏「VS」Visual Studio「C/C」C/C程序设计「UG/NX」BlockUI集合「Win」Windows程序设计「DSA」数据结构与算法「UG/NX」NX二次开发「QT」QT5程序设计「File」数据文件格式「PK」Parasolid…...

可能是全网第一个MySQL Workbench插件编写技巧

引言 应公司要求,数据库的敏感数据在写入到数据库中要进行加密,但是在测试环境查询数据的时候要手动解密,很不方便,有的时候数据比较多,解密比较麻烦。遂研究了一下如何通过 MySQL Workbench 的插件来实现查询数据一键…...

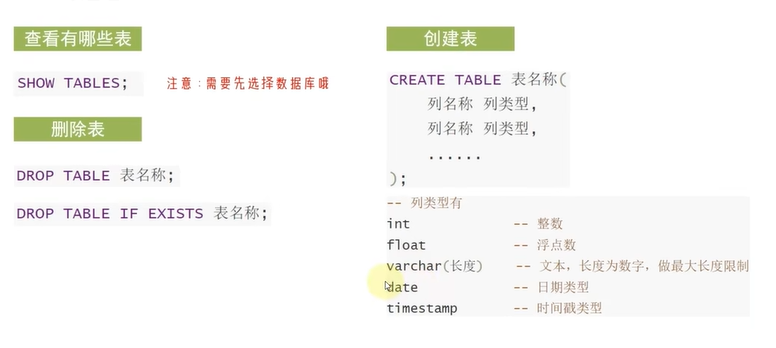

D62【python 接口自动化学习】- python基础之数据库

day62 SQL 基础 学习日期:20241108 学习目标:MySQL数据库-- 131 SQL基础和DDL 学习笔记: SQL的概述 SQL语言的分类 SQL的语法特征 DDL - 库管理 DDL - 表管理 总结 SQL是结构化查询语言,用于操作数据库,通用于绝大…...

探索美赛:从准备到挑战的详细指南

前言 美国大学生数学建模竞赛(MCM/ICM),简称“美赛”,是全球规模最大的数学建模竞赛之一。它鼓励参赛者通过数学建模来解决现实世界中的复杂问题,广受世界各地大学生的欢迎。本文将详细介绍美赛的全过程,从…...

IP地址查询——IP归属地离线库

自从网络监管部门将现实IP地址列入监管条例,IP地址的离线库变成网络企业发展业务的不可或缺的一部分,那么IP地址离线库是什么,又能够给我们带来什么呢? 什么是IP地址离线库? IP地址离线库是IP地址服务商将通过各种合…...

“倒时差”用英语怎么说?生活英语口语学习柯桥外语培训

“倒时差”用英语怎么说? “倒时差”,这个让无数旅人闻之色变的词汇,在英语中对应的正是“Jet Lag”。"Jet" 指的是喷气式飞机,而 "lag" 指的是落后或延迟。这个短语形象地描述了当人们乘坐喷气式飞机快速穿…...

Linux入门攻坚——37、Linux防火墙-iptables-3

私网地址访问公网地址的问题,请求时,目标地址是公网地址,可以在公网路由器中进行路由,但是响应报文的目的地址是私网地址,此时在公网路由器上就会出现问题。公网地址访问私网地址的问题,需要先访问一个公网…...

微服务架构面试内容整理-安全性-Spring Security

Spring Security 是 Spring 框架中用于实现认证和授权的安全模块,它提供了全面的安全解决方案,可以帮助开发者保护 Web 应用、微服务和 API 免受常见的安全攻击。以下是 Spring Security 的主要特点、工作原理和使用场景: 主要特点 1. 身份认证与授权: 提供多种认证方式,…...

新的服务器Centos7.6 安装基础的环境配置(新服务器可直接粘贴使用配置)

常见的基础服务器配置之Centos命令 正常来说都是安装一个docker基本上很多问题都可以解决了,我基本上都是通过docker去管理一些容器如:mysql、redis、mongoDB等之类的镜像,还有一些中间件如kafka。下面就安装一个 docker 和 nginx 的相关配置…...

深度学习:广播机制

广播机制(Broadcasting)是 PyTorch(以及其他深度学习框架如 NumPy)中的一种强大功能,它允许不同形状的张量进行逐元素操作,而不需要显式地扩展张量的维度。广播机制通过自动扩展较小的张量来匹配较大张量的…...

音视频入门基础:FLV专题(25)——通过FFprobe显示FLV文件每个packet的信息

音视频入门基础:FLV专题系列文章: 音视频入门基础:FLV专题(1)——FLV官方文档下载 音视频入门基础:FLV专题(2)——使用FFmpeg命令生成flv文件 音视频入门基础:FLV专题…...

Openstack7--安装消息队列服务RabbitMQ

只需要在控制节点安装 安装RabbitMQ yum -y install rabbitmq-server 启动RabbitMQ并设置开机自启 systemctl start rabbitmq-server;systemctl enable rabbitmq-server 创建 rabbitmq 用户 并设置密码为 000000 rabbitmqctl add_user rabbitmq 000000 如果你不慎创错了…...

)

day55 图论章节刷题Part07([53.寻宝]prim算法、kruskal算法)

前言:使用最小生成树的方法解决将所有节点连接起来所需的最小路径问题。 prim算法 Prim算法是一种贪心算法,从任意一个顶点开始构建最小生成树。每次选择当前已加入生成树的顶点中,距离最近的尚未加入生成树的顶点,直到所有顶点…...

LeetCode 93-复制 IP地址

题目链接:LeetCode93 欢迎留言交流,每天都会回消息。 class Solution {//定义结果集,返回最终结果List<String> rs new ArrayList<>();public List<String> restoreIpAddresses(String s) {//将字符串包装为可变长度的字…...

海底捞点单

单点锅底推荐: 番茄锅底通31 牛油麻辣通44 清汤麻辣备44 菌汤锅底通31 小吃&主食: 捞派捞面一黄金小馒头一茴香小油条 红糖枇杷一小酥肉 DIY锅底推荐: 1.寿喜锅:海鲜味酱4勺陈醋1勺蚝油2勺盐适量白糖7勺 芹菜1勺 2.麻辣锅底…...

It’s All About Your Sketch: Democratising Sketch Control in Diffusion Models

翻译: 摘要 本文揭示了草图在扩散模型中的潜力,解决了生成式人工智能中直接草图控制的虚假承诺。我们重要的是使这个过程更加普及,让业余的草图也能生成精确的图像,真正实现“你画的就是你得到的”。一项初步研究强调了这一研究的…...

Java基础-组件及事件处理(下)

(创作不易,感谢有你,你的支持,就是我前行的最大动力,如果看完对你有帮助,请留下您的足迹) 目录 面板组件 说明 常见组件 JScrollPane常用构造方法 JScrollPane设置面板滚动策略的方法 JScrollPane滚…...

npm list -g --depth=0(用来列出全局安装的所有 npm 软件包而不显示它们的依赖项)

您提供的命令 npm list -g --depth0 是在 Node Package Manager (npm) 的上下文中使用的,用来列出全局安装的所有 npm 软件包而不显示它们的依赖项。 这是它的运作方式: npm list -g --depth0-g: 指定列表应包括全局安装的软件包。--depth0: 限制树形结…...

深度学习:nn.Linear

nn.Linear 是 PyTorch 中的一个线性层(全连接层),用于将输入张量从一个维度空间映射到另一个维度空间。具体来说,nn.Linear 执行以下操作: outputinputweightTbias 其中: input 是输入张量。 weight 是权重…...

Golang 面试经典题:map 的 key 可以是什么类型?哪些不可以?

Golang 面试经典题:map 的 key 可以是什么类型?哪些不可以? 在 Golang 的面试中,map 类型的使用是一个常见的考点,其中对 key 类型的合法性 是一道常被提及的基础却很容易被忽视的问题。本文将带你深入理解 Golang 中…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

Mybatis逆向工程,动态创建实体类、条件扩展类、Mapper接口、Mapper.xml映射文件

今天呢,博主的学习进度也是步入了Java Mybatis 框架,目前正在逐步杨帆旗航。 那么接下来就给大家出一期有关 Mybatis 逆向工程的教学,希望能对大家有所帮助,也特别欢迎大家指点不足之处,小生很乐意接受正确的建议&…...

Python爬虫实战:研究feedparser库相关技术

1. 引言 1.1 研究背景与意义 在当今信息爆炸的时代,互联网上存在着海量的信息资源。RSS(Really Simple Syndication)作为一种标准化的信息聚合技术,被广泛用于网站内容的发布和订阅。通过 RSS,用户可以方便地获取网站更新的内容,而无需频繁访问各个网站。 然而,互联网…...

《用户共鸣指数(E)驱动品牌大模型种草:如何抢占大模型搜索结果情感高地》

在注意力分散、内容高度同质化的时代,情感连接已成为品牌破圈的关键通道。我们在服务大量品牌客户的过程中发现,消费者对内容的“有感”程度,正日益成为影响品牌传播效率与转化率的核心变量。在生成式AI驱动的内容生成与推荐环境中࿰…...

渲染学进阶内容——模型

最近在写模组的时候发现渲染器里面离不开模型的定义,在渲染的第二篇文章中简单的讲解了一下关于模型部分的内容,其实不管是方块还是方块实体,都离不开模型的内容 🧱 一、CubeListBuilder 功能解析 CubeListBuilder 是 Minecraft Java 版模型系统的核心构建器,用于动态创…...

)

postgresql|数据库|只读用户的创建和删除(备忘)

CREATE USER read_only WITH PASSWORD 密码 -- 连接到xxx数据库 \c xxx -- 授予对xxx数据库的只读权限 GRANT CONNECT ON DATABASE xxx TO read_only; GRANT USAGE ON SCHEMA public TO read_only; GRANT SELECT ON ALL TABLES IN SCHEMA public TO read_only; GRANT EXECUTE O…...

HTML前端开发:JavaScript 常用事件详解

作为前端开发的核心,JavaScript 事件是用户与网页交互的基础。以下是常见事件的详细说明和用法示例: 1. onclick - 点击事件 当元素被单击时触发(左键点击) button.onclick function() {alert("按钮被点击了!&…...

如何理解 IP 数据报中的 TTL?

目录 前言理解 前言 面试灵魂一问:说说对 IP 数据报中 TTL 的理解?我们都知道,IP 数据报由首部和数据两部分组成,首部又分为两部分:固定部分和可变部分,共占 20 字节,而即将讨论的 TTL 就位于首…...

Chromium 136 编译指南 Windows篇:depot_tools 配置与源码获取(二)

引言 工欲善其事,必先利其器。在完成了 Visual Studio 2022 和 Windows SDK 的安装后,我们即将接触到 Chromium 开发生态中最核心的工具——depot_tools。这个由 Google 精心打造的工具集,就像是连接开发者与 Chromium 庞大代码库的智能桥梁…...