Kafka-创建topic源码

一、命令创建topic

kafka-topics --create --topic quickstart-events --bootstrap-server cdh1:9092 --partitions 2 --replication-factor 2

二、kafka-topics脚本

exec $(dirname $0)/kafka-run-class.sh org.apache.kafka.tools.TopicCommand "$@"脚本中指定了处理它的主类:TopicCommand

三、TopicCommand

public abstract class TopicCommand {public static void main(String... args) {Exit.exit(mainNoExit(args));}private static int mainNoExit(String... args) {try {execute(args);return 0;} catch (Throwable e) {return 1;}}static void execute(String... args) throws Exception {//解析命令行参数TopicCommandOptions opts = new TopicCommandOptions(args);//创建TopicServiceTopicService topicService = new TopicService(opts.commandConfig(), opts.bootstrapServer());try {if (opts.hasCreateOption()) {//这是处理topic创建的,我们主要分析它topicService.createTopic(opts);} else if (opts.hasAlterOption()) {//更高topic逻辑topicService.alterTopic(opts);} else if (opts.hasListOption()) {//获取topictopicService.listTopics(opts);} else if (opts.hasDescribeOption()) {//topi相关描述信息topicService.describeTopic(opts);} else if (opts.hasDeleteOption()) {//删除topictopicService.deleteTopic(opts);}}catch(...){...}finally {topicService.close();}}public static class TopicService implements AutoCloseable {public void createTopic(TopicCommandOptions opts) throws Exception {CommandTopicPartition topic = new CommandTopicPartition(opts);if (Topic.hasCollisionChars(topic.name)) {//由于度量名称的限制,带有句点(“.”)或下划线(“_”)的主题可能会发生冲突。为了避免问题,最好使用其中之一,但不要两者都使用System.out.println(".........");}createTopic(topic);}public void createTopic(CommandTopicPartition topic) throws Exception {if (topic.replicationFactor.filter(rf -> rf > Short.MAX_VALUE || rf < 1).isPresent()) {//复制因子必须介于1和“+Short.MAX_VALUE+”之间throw new IllegalArgumentException("...");}if (topic.partitions.filter(p -> p < 1).isPresent()) {//分区必须大于0throw new IllegalArgumentException("...");}try {NewTopic newTopic;//取决于创建 topic 时 是否指定了 replica-assignmentif (topic.hasReplicaAssignment()) {newTopic = new NewTopic(topic.name, topic.replicaAssignment);} else {newTopic = new NewTopic(topic.name, topic.partitions, topic.replicationFactor.map(Integer::shortValue));}//给topic设置参数Map<String, String> configsMap = topic.configsToAdd.stringPropertyNames().stream().collect(Collectors.toMap(name -> name, name -> topic.configsToAdd.getProperty(name)));newTopic.configs(configsMap);//批量创建topicCreateTopicsResult createResult = adminClient.createTopics(Collections.singleton(newTopic),new CreateTopicsOptions().retryOnQuotaViolation(false));//等待所有topic都创建成功createResult.all().get();System.out.println("Created topic " + topic.name + ".");} catch (ExecutionException e) {//......}}}}TopicCommandOptions中有对创建topic所有参数的解读,我们下面来详细看下这些参数

四、创建Topic参数

bootstrap-server

必选项:连接Kafka server用

command-config

包含要传递给Admin Client的配置的属性文件。这仅与--bootstrap-server选项一起使用,用于描述和更改broker配置

list

列出所有可用的topic

create

创建一个新的topic

delete

删除一个topic

alter

更改分区数量和副本分配,通过--alter更新现有主题的配置

describe

列出给定topic的详细信息

topic

要创建、更改、描述或删除的主题。它还接受正则表达式,但--create选项除外。将主题名称放在双引号中,并使用“\\”前缀转义正则表达式符号;例如 \"test\\.topic\"

topic-id

仅与用于描述主题的--bootstrap-server选项一起使用

config

正在创建的主题的主题配置覆盖。

delete-config

要删除现有主题的主题配置覆盖

partitions

正在创建或更改的主题的分区数量(警告:如果为具有键的主题增加分区,则分区逻辑或消息顺序将受到影响)。如果未提供用于,则为集群默认值

replication-factor

正在创建的主题中每个分区的复制因子。如果未提供,则为群集默认值

replica-assignment

正在创建或更改的topic的手动分区到broker分配列表

under-replicated-partitions

如果在描述主题时设置,则仅在复制分区下显示

unavailable-partitions

如果在描述主题时设置,则仅显示其leader不可用的分区

under-min-isr-partitions

如果在描述主题时设置,则仅显示isr计数 < 配置的最小值的分区。

at-min-isr-partitions

如果在描述主题时设置,则仅显示isr计数 = 配置的最小值的分区

topics-with-overrides

如果在描述主题时设置,则仅显示已覆盖配置的topic

if-exists

如果在更改、删除或描述主题时设置,则仅当主题存在时才会执行该操作

if-not-exists

如果在创建主题时设置,则仅当主题不存在时才会执行该操作。

exclude-internal

运行list或describe命令时排除内部topic。默认情况下,内部topic将被列出

partition-size-limit-per-response

一个DescribeTopicPartitions响应中包含的最大分区大小

五、AdminClient

从第二步的源码中看到最终将topic的创建交给了AdminClient来完成,下面我们继续往下分析

1、创建

在TopicService的构造方法中创建的AdminClient

它是Kafka的管理客户端,支持管理和检查topic、broker、配置和ACL。

AdminClient的创建用到了bootstrap.servers,它里面有连接KafkaServer的host:port列表。

bootstrap.servers配置仅用于发现群集中的broker,然后AdminClient将根据需要连接到这些broker。因此,只包括两个或三个经纪人地址就足以应对broker不可用的风险。

TopicService topicService = new TopicService(opts.commandConfig(), opts.bootstrapServer()); public static class TopicService implements AutoCloseable {private final Admin adminClient;public TopicService(Properties commandConfig, Optional<String> bootstrapServer) {this.adminClient = createAdminClient(commandConfig, bootstrapServer);}private static Admin createAdminClient(Properties commandConfig, Optional<String> bootstrapServer) {if (bootstrapServer.isPresent()) {commandConfig.put(AdminClientConfig.BOOTSTRAP_SERVERS_CONFIG, bootstrapServer.get());}return Admin.create(commandConfig);}}2、交由子类KafkaAdminClient处理

public class KafkaAdminClient extends AdminClient {private final AdminClientRunnable runnable;//创建一批topicpublic CreateTopicsResult createTopics(final Collection<NewTopic> newTopics,final CreateTopicsOptions options) {final Map<String, KafkaFutureImpl<TopicMetadataAndConfig>> topicFutures = new HashMap<>(newTopics.size());final CreatableTopicCollection topics = new CreatableTopicCollection();for (NewTopic newTopic : newTopics) {//判断名字是否符合规范if (topicNameIsUnrepresentable(newTopic.name())) {KafkaFutureImpl<TopicMetadataAndConfig> future = new KafkaFutureImpl<>();future.completeExceptionally(new InvalidTopicException("The given topic name '" +newTopic.name() + "' cannot be represented in a request."));topicFutures.put(newTopic.name(), future);} else if (!topicFutures.containsKey(newTopic.name())) {//topicFutures 装的是还没有创建的 topicnametopicFutures.put(newTopic.name(), new KafkaFutureImpl<>());topics.add(newTopic.convertToCreatableTopic());}}if (!topics.isEmpty()) {final long now = time.milliseconds();final long deadline = calcDeadlineMs(now, options.timeoutMs());//里面封装了 ApiKeys.CREATE_TOPICS 请求final Call call = getCreateTopicsCall(options, topicFutures, topics,Collections.emptyMap(), now, deadline);//实现了Runnable接口runnable.call(call, now);}return new CreateTopicsResult(new HashMap<>(topicFutures));}

}从这里我们看到,这里会用一个线程向broker发送ApiKeys.CREATE_TOPICS 请求。下面我们来看broker端怎么处理topics的创建请求的。按照我们之前的经验,要去看KafkaApis中对应ApiKeys.CREATE_TOPICS的处理逻辑

class KafkaApis(...){request.header.apiKey match {//....case ApiKeys.CREATE_TOPICS => maybeForwardToController(request, handleCreateTopicsRequest)case ApiKeys.DELETE_TOPICS => maybeForwardToController(request, handleDeleteTopicsRequest)case ApiKeys.CREATE_ACLS => maybeForwardToController(request, handleCreateAcls)case ApiKeys.DELETE_ACLS => maybeForwardToController(request, handleDeleteAcls)case ApiKeys.CREATE_PARTITIONS => maybeForwardToController(request, handleCreatePartitionsRequest)case ApiKeys.ELECT_LEADERS => maybeForwardToController(request, handleElectLeaders)//.....}

}六、CREATE_TOPICS的处理逻辑

从KafkaApi中我们看到很多请求都调用了maybeForwardToController()方法来处理,但是传入的参数不同,从名称上我们可以猜测这些请求可能交由Controller来处理,回想下《Kafka-Controller角色需要做什么?》中当一个broker当选为Controller时第一件事就是注册监听器,去监听broker改变、topic改变、topic删除、isr改变等,并分别准备好了响应的处理逻辑。因此这里只要让topic发生改变就可以自动触发让Controller处理了。下面看下handleCreateTopicsRequest()中都做了什么?

1、获取ZooKeeper

val zkSupport = metadataSupport.requireZkOrThrow(KafkaApis.shouldAlwaysForward(request))2、判断集群当下是否有Controller

如果集群当下没有Controller,直接向客户端返回Errors.NOT_CONTROLLER错误。我们按照集群当下有Controller继续分析。

if (!zkSupport.controller.isActive) {//如果没有contorller,直接向客户端发送响应信息(集群当下没有controller),且这个时候时创建不了topic的,createTopicsRequest.data.topics.forEach { topic =>results.add(new CreatableTopicResult().setName(topic.name).setErrorCode(Errors.NOT_CONTROLLER.code))}sendResponseCallback(results)} else {//正常逻辑}3、检查topic名称

集群元数据topic是一个具有不同实现的内部topic。不应允许用户创建同名的topic。

if (topicNames.contains(Topic.CLUSTER_METADATA_TOPIC_NAME)) {//拒绝创建内部主题 __cluster_metadatainfo(s"Rejecting creation of internal topic ${Topic.CLUSTER_METADATA_TOPIC_NAME}")}topicNames.diff(Set(Topic.CLUSTER_METADATA_TOPIC_NAME))4、调用ZkAdminManager创建topic

zkSupport.adminManager.createTopics(createTopicsRequest.data.timeoutMs,createTopicsRequest.data.validateOnly,toCreate,authorizedForDescribeConfigs,controllerMutationQuota,handleCreateTopicsResults)}1、循环校验每个topic是否符合规则

1、topic是否已经存在

2、topic是否为null

3、numPartitions或replicationFactor和replicasAssignments都已设置。两者不能同时使用

2、确定分区分配列表

如果用户指定了列表,那么就直接用用户的,否则使用Kafka自己的分配策略(下篇博客分析)

val assignments = if (topic.assignments.isEmpty) {CoreUtils.replicaToBrokerAssignmentAsScala(AdminUtils.assignReplicasToBrokers(brokers.asJavaCollection, resolvedNumPartitions, resolvedReplicationFactor))} else {val assignments = new mutable.HashMap[Int, Seq[Int]]//注意:我们不会检查replicaAssignment是否包含未知的代理——与添加分区的情况不同,这遵循TopicCommand中的现有逻辑topic.assignments.forEach { assignment =>assignments(assignment.partitionIndex) = assignment.brokerIds.asScala.map(a => a: Int)}assignments}3、topics目录下创建指定的topic

//ConfigType.TOPIC : topics 目录

//topic :要创建的topic名称

zkClient.setOrCreateEntityConfigs(ConfigType.TOPIC, topic, config)4、topic目录下创建分区目录和对应信息

writeTopicPartitionAssignment(topic, partitionReplicaAssignment.map { case (k, v) => k -> ReplicaAssignment(v) },isUpdate = false, usesTopicId)5、创建对应的元数据

CreatePartitionsMetadata(topic.name, assignments.keySet)七、Controller端处理逻辑

我们找到TopicChange对应的处理逻辑

override def process(event: ControllerEvent): Unit = {try {event match {case TopicChange =>processTopicChange()//......}}}private def processTopicChange(): Unit = {if (!isActive) return//从 brokers/topics/目录下获取所有的topicval topics = zkClient.getAllTopicsInCluster(true)//从controllerContext 获取当下缓存中所有的 topic//两者相减获取 新增加的 topicval newTopics = topics -- controllerContext.allTopics// 获取删除的topic (既topics目录没有,但是缓存中有)val deletedTopics = controllerContext.allTopics.diff(topics)//设置新的topic到缓存controllerContext.setAllTopics(topics)//检测zk中 每个topic 目录的变化registerPartitionModificationsHandlers(newTopics.toSeq)//现在要添加分区和副本了,也就是从topic下获取 topic_id、adding_replicas、removing_replicas、partitions 信息val addedPartitionReplicaAssignment = zkClient.getReplicaAssignmentAndTopicIdForTopics(newTopics)deletedTopics.foreach(controllerContext.removeTopic)processTopicIds(addedPartitionReplicaAssignment)addedPartitionReplicaAssignment.foreach { case TopicIdReplicaAssignment(_, _, newAssignments) =>newAssignments.foreach { case (topicAndPartition, newReplicaAssignment) =>//controllerContext 的缓存中 更新分区、副本、leder信息controllerContext.updatePartitionFullReplicaAssignment(topicAndPartition, newReplicaAssignment)}}info(s"New topics: [$newTopics], deleted topics: [$deletedTopics], new partition replica assignment " +s"[$addedPartitionReplicaAssignment]")if (addedPartitionReplicaAssignment.nonEmpty) {val partitionAssignments = addedPartitionReplicaAssignment.map { case TopicIdReplicaAssignment(_, _, partitionsReplicas) => partitionsReplicas.keySet }.reduce((s1, s2) => s1.union(s2))//更高topic下的分区、副本为可用状态 OnlineReplica//此时 往topic 生产数据就ok了 onNewPartitionCreation(partitionAssignments)}}从源码中我们可以看到,Controller这端会不断的将新的topic以及其下的topic_id、adding_replicas、removing_replicas、partitions 信息加载到缓存,并使用它们的状态机将它们更新至可用状态。并剔除掉删除的topic。始终保持,当向topic生产数据时,它这里都时最新的状态。

相关文章:

Kafka-创建topic源码

一、命令创建topic kafka-topics --create --topic quickstart-events --bootstrap-server cdh1:9092 --partitions 2 --replication-factor 2 二、kafka-topics脚本 exec $(dirname $0)/kafka-run-class.sh org.apache.kafka.tools.TopicCommand "$" 脚本中指定了…...

【网络安全】(一) 0成本添加访问级监控

互联网的安全感这个概念源于阿里。顾名思义,让互联网的用户对于web产品能够产生足够的信任和依赖。特别是涉及到用户资金交易的站点,一次严重的用户资料泄露就可以彻底毁掉你的品牌。 然而当前阶段除了bat大部分互联网行业的企业对于网络安全给的重视都…...

【Three.js基础学习】26. Animated galaxy

前言 shaders实现星系 课程回顾 使用顶点着色器为每个粒子设置动画 a属性 , u制服 ,v变化 像素比:window.devicePixelRatio 自动从渲染器检索像素比 renderer.getPixelRatio() 如何尺寸衰减, 放大缩小视角时,粒子都是同…...

vscode使用ssh配置docker容器环境

1 创建容器,并映射主机和容器的指定ssh服务端口 2 进入容器 docker exec -it <容器ID> /bin/bash 3在容器中安装ssh服务 apt-get update apt-get install openssh-server 接着修改ssh文件信息,将容器的10008端口暴露出来允许root用户使用ssh登录 vim /…...

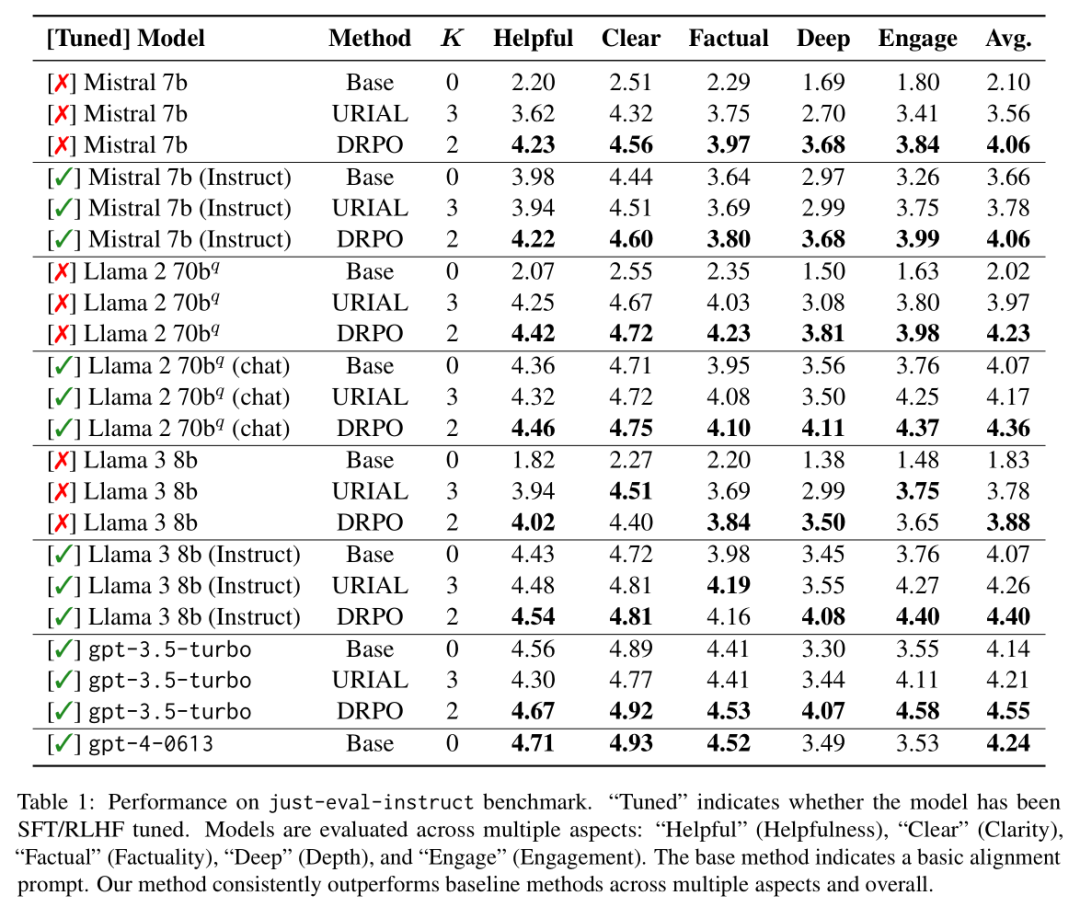

NLP论文速读(EMNLP 2024)|动态奖励与提示优化来帮助语言模型的进行自我对齐

论文速读|Dynamic Rewarding with Prompt Optimization Enables Tuning-free Self-Alignment of Language Models 论文信息: 简介: 本文讨论的背景是大型语言模型(LLMs)的自我对齐问题。传统的LLMs对齐方法依赖于昂贵的训练和人类偏好注释&am…...

【LeetCode】167. 两数之和 II - 输入有序数组

描述 给定一个下标从 1 开始的整数数组numbers,该数组已按非递减顺序排列,请从数组中找出满足相加之和等于目标数target的两个数。如果这两个数分别是numbers[index1]和numbers[index2],返回整数数组[index1, index2]。 只存在唯一答案&#…...

)

Getx:GetxController依赖管理02,Binding绑定全局控制器(懒加载Controller)

在使用GetX 状态管理器的时候,如果每个页面都手动实例化一个控制器就太麻烦了, Binding 的作用就是所有需要进行状态管理的控制器进行统一初始化 创建全局控制器Binding import package:get/get.dart; import ../controllers/counter.dart; // 同上一篇内…...

leetcode 找不同

389. 找不同 已解答 简单 相关标签 相关企业 给定两个字符串 s 和 t ,它们只包含小写字母。 字符串 t 由字符串 s 随机重排,然后在随机位置添加一个字母。 请找出在 t 中被添加的字母。 示例 1: 输入:s "abcd"…...

2025 - 生信信息学 - GEO数据分析 - RF分析(随机森林)

GEO数据分析 - RF分析(随机森林) 01 准备数据文件 #install.packages("randomForest")#引用包 library(randomForest) set.seed(123456)inputFile"diffGeneExp.txt" #输入文件 setwd("/Users/wangyang/Desktop/BCBM/02ra…...

Matlab深度学习(四)——AlexNet卷积神经网络

网络搭建参考:手撕 CNN 经典网络之 AlexNet(理论篇)-CSDN博客 在实际工程应用中,构建并训练一个大规模的卷积神经网络是比较复杂的,需要大量的数据以及高性能的硬件。如果通过训练好的典型网络稍加改进…...

etcd defrag

场景 prometheus监控告警,告警信息如下 etcd cluster "kube-etcd": database size in use on instance xx is 33.45% of the actual allocated disk space, please run defragmentation (e.g. etcdctl defrag) to retrieve the unused fragmented disk space.处理…...

golang语言整合jwt+gin框架实现token

1.下载jwt go get -u github.com/dgrijalva/jwt-go2.新建生成token和解析token文件 2.1 新建common文件夹和jwtConfig文件夹 新建jwtconfig.go文件 2.2 jwtconfig.go文件代码 /* Time : 2021/8/2 下午3:03 Author : mrxuexi File : main Software: GoLand */ package jwtC…...

数据治理、数据素养和数据质量管理:文献综述

注意:这并不是正式发表的论文,只是一篇用来交作业的文章 摘要 随着数据时代的到来,数据治理、数据素养和数据质量管理成为组织数据管理中的三大核心概念。本文基于相关研究与实践,对这三个领域进行全面综述,探讨它…...

【Linux】用户和用户组管理

管理用户 1.添加用户账号——useradd命令 【实例2-1-1】 按系统默认配置添加指定用户账号st和stu。 # 添加用户账号st [rootlocalhost ~]# useradd st # 添加用户账号stu [rootlocalhost ~]# useradd stu【实例2-1-2】添加用户账号stu01,UID为1004&am…...

游戏引擎学习第16天

视频参考:https://www.bilibili.com/video/BV1mEUCY8EiC/ 这些字幕讨论了编译器警告的概念以及如何在编译过程中启用和处理警告。以下是字幕的内容摘要: 警告的定义:警告是编译器用来告诉你某些地方可能存在问题,尽管编译器不强制要求你修复…...

如何通过对敏捷实践的调整,帮助远程团队提升研发效能?

首先明确一点,最敏捷的做法就是不要远程团队或分布式团队,远程一定比不上面对面同一地点的模式,毕竟环境不同,就不要期望远程团队和本地团队具备相同的效能,甚至期望更高。 那么,无论何种原因,…...

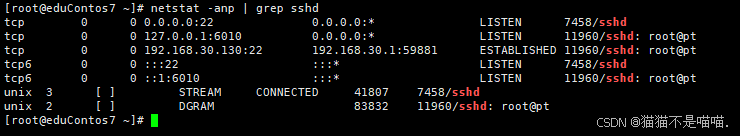

Ubuntu Linux使用前准备动作 配置SSH

在 Ubuntu 系统中配置 SSH 服务可以通过以下步骤进行: 1、安装ssh服务 1)打开终端(可以使用快捷键 Ctrl Alt T)。 2)运行以下命令安装 OpenSSH 服务器: sudo apt-get update:这一步是更新…...

疫情下的图书馆管理系统:Spring Boot技术

摘要 随着信息技术在管理上越来越深入而广泛的应用,管理信息系统的实施在技术上已逐步成熟。本文介绍了疫情下图书馆管理系统的开发全过程。通过分析疫情下图书馆管理系统管理的不足,创建了一个计算机管理疫情下图书馆管理系统的方案。文章介绍了疫情下图…...

vue3完整安装并创建项目

1、下载:https://npmmirror.com/mirrors/node/v18.19.0/node-v18.19.0-x64.msi 2、验证Nodejs是否安装成功(管理员身份运行cmd) node -v #查看nodejs的版本 v18.19.0npm -v #查看npm的版本 10.2.3 3、在D:\Program Files\nodejs路径下创建两…...

【Linux】Linux入门实操——进程管理(重点)

1. 概述 在 LINUX 中,每个执行的程序都称为一个进程。每一个进程都分配一个ID号(pid,进程号)。>windows > linux每个进程都可能以两种方式存在的。前台与后台,所谓前台进程就是用户目前的屏幕上可以进行操作的。后台进程则是实际在操作࿰…...

【JavaEE】-- HTTP

1. HTTP是什么? HTTP(全称为"超文本传输协议")是一种应用非常广泛的应用层协议,HTTP是基于TCP协议的一种应用层协议。 应用层协议:是计算机网络协议栈中最高层的协议,它定义了运行在不同主机上…...

循环冗余码校验CRC码 算法步骤+详细实例计算

通信过程:(白话解释) 我们将原始待发送的消息称为 M M M,依据发送接收消息双方约定的生成多项式 G ( x ) G(x) G(x)(意思就是 G ( x ) G(x) G(x) 是已知的)࿰…...

【大模型RAG】Docker 一键部署 Milvus 完整攻略

本文概要 Milvus 2.5 Stand-alone 版可通过 Docker 在几分钟内完成安装;只需暴露 19530(gRPC)与 9091(HTTP/WebUI)两个端口,即可让本地电脑通过 PyMilvus 或浏览器访问远程 Linux 服务器上的 Milvus。下面…...

django filter 统计数量 按属性去重

在Django中,如果你想要根据某个属性对查询集进行去重并统计数量,你可以使用values()方法配合annotate()方法来实现。这里有两种常见的方法来完成这个需求: 方法1:使用annotate()和Count 假设你有一个模型Item,并且你想…...

华为OD机试-食堂供餐-二分法

import java.util.Arrays; import java.util.Scanner;public class DemoTest3 {public static void main(String[] args) {Scanner in new Scanner(System.in);// 注意 hasNext 和 hasNextLine 的区别while (in.hasNextLine()) { // 注意 while 处理多个 caseint a in.nextIn…...

C# 类和继承(抽象类)

抽象类 抽象类是指设计为被继承的类。抽象类只能被用作其他类的基类。 不能创建抽象类的实例。抽象类使用abstract修饰符声明。 抽象类可以包含抽象成员或普通的非抽象成员。抽象类的成员可以是抽象成员和普通带 实现的成员的任意组合。抽象类自己可以派生自另一个抽象类。例…...

PL0语法,分析器实现!

简介 PL/0 是一种简单的编程语言,通常用于教学编译原理。它的语法结构清晰,功能包括常量定义、变量声明、过程(子程序)定义以及基本的控制结构(如条件语句和循环语句)。 PL/0 语法规范 PL/0 是一种教学用的小型编程语言,由 Niklaus Wirth 设计,用于展示编译原理的核…...

土地利用/土地覆盖遥感解译与基于CLUE模型未来变化情景预测;从基础到高级,涵盖ArcGIS数据处理、ENVI遥感解译与CLUE模型情景模拟等

🔍 土地利用/土地覆盖数据是生态、环境和气象等诸多领域模型的关键输入参数。通过遥感影像解译技术,可以精准获取历史或当前任何一个区域的土地利用/土地覆盖情况。这些数据不仅能够用于评估区域生态环境的变化趋势,还能有效评价重大生态工程…...

【论文阅读28】-CNN-BiLSTM-Attention-(2024)

本文把滑坡位移序列拆开、筛优质因子,再用 CNN-BiLSTM-Attention 来动态预测每个子序列,最后重构出总位移,预测效果超越传统模型。 文章目录 1 引言2 方法2.1 位移时间序列加性模型2.2 变分模态分解 (VMD) 具体步骤2.3.1 样本熵(S…...

IP如何挑?2025年海外专线IP如何购买?

你花了时间和预算买了IP,结果IP质量不佳,项目效率低下不说,还可能带来莫名的网络问题,是不是太闹心了?尤其是在面对海外专线IP时,到底怎么才能买到适合自己的呢?所以,挑IP绝对是个技…...