kubeadm安装K8s高可用集群之集群初始化及master/node节点加入calico网络插件安装

系列文章目录

1.kubeadm安装K8s高可用集群之基础环境配置

2.kubeadm安装K8s集群之高可用组件keepalived+nginx及kubeadm部署

3.kubeadm安装K8s高可用集群之集群初始化及master/node节点加入集群calico网络插件安装

kubeadm安装K8s高可用集群之集群初始化及master/node节点加入calico网络插件安装

- 1.设置集群kubeadm-config配置文件

- 2.安装calico网络插件

- 3.其他master节点加入集群

- 4.node节点加入命令

1.设置集群kubeadm-config配置文件

- 输入命令获取默认的kubeadm-config.yaml,然后再做出调整;

kubeadm config print init-defaults > kubeadm-config.yaml

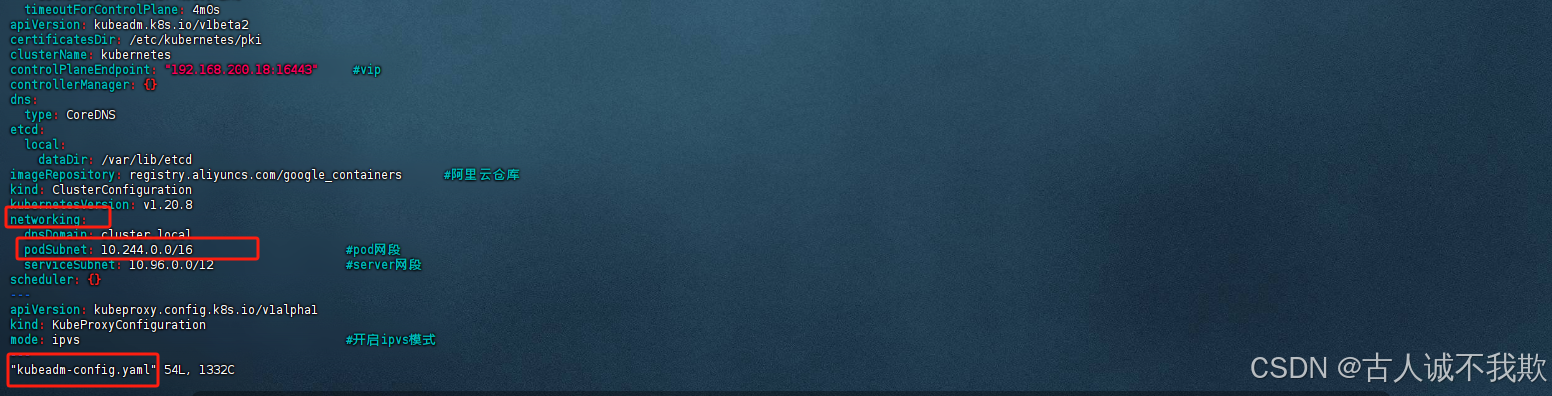

- 输入命令对默认文件的内容进行覆盖,调整后的kubeadm-config.yaml文件的内容如下:

提示:请根据注释和实际情况的需要,对配置中必要的内容进行调整;

cat > kubeadm-config.yaml <<EOF

apiVersion: kubeadm.k8s.io/v1beta2

bootstrapTokens:

- groups:- system:bootstrappers:kubeadm:default-node-tokentoken: abcdef.0123456789abcdef #设置tokenttl: 24h0m0susages:- signing- authentication

kind: InitConfiguration

localAPIEndpoint:advertiseAddress: 192.168.0.105bindPort: 6443

nodeRegistration:criSocket: /var/run/dockershim.sockname: k8s01-m1 #设置节点名字hoststaints:- effect: NoSchedulekey: node-role.kubernetes.io/master

---

apiServer:certSANs:- k8s01-m1 #设置master节点1的hosts,请根据实际情况调整;- k8s02-m2 #设置master节点2的hosts,请根据实际情况调整;- 192.168.0.105 #设置master节点1的ip,请根据实际情况调整;- 192.168.0.106 #设置master节点2的ip,,请根据实际情况调整;- 192.168.200.18 #设置vip地址,请根据实际情况调整;- 127.0.0.1extraArgs:authorization-mode: Node,RBACtimeoutForControlPlane: 4m0s

apiVersion: kubeadm.k8s.io/v1beta2

certificatesDir: /etc/kubernetes/pki

clusterName: kubernetes

controlPlaneEndpoint: "192.168.200.18:16443" #设置vip地址,即设置的虚拟ip+nginx监听的端口;

controllerManager: {}

dns:type: CoreDNS

etcd:local:dataDir: /var/lib/etcd

imageRepository: registry.aliyuncs.com/google_containers #修改为阿里云仓库;

kind: ClusterConfiguration

kubernetesVersion: v1.20.8 #设置需要安装的kubernetes版本;

networking:dnsDomain: cluster.localpodSubnet: 10.244.0.0/16 #设置pod的网段;serviceSubnet: 10.96.0.0/12 #server的网段;

scheduler: {}

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs #开启ipvs模式

---

EOF

可以选择将修改的配置加载为新的配置,执行以下命令,执行命令后会生成一个new.yaml文件;

kubeadm config migrate --old-config kubeadm-config.yaml --new-config new.yaml

- 拉取配置文件中设置的相关镜像

kubeadm config images pull --config kubeadm-config.yaml

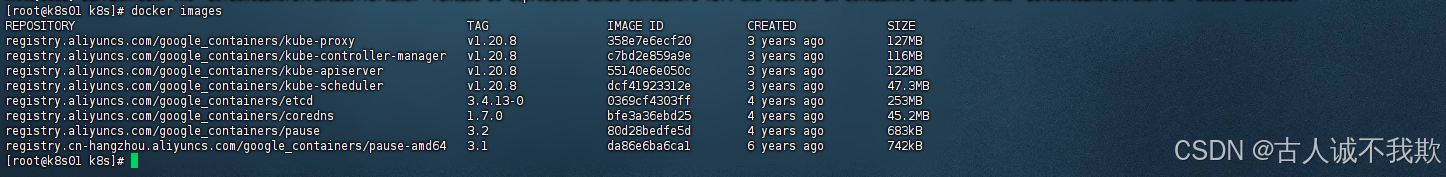

可以执行命令查看拉取的镜像:docker images

如图:

注意:以上步骤,所有的节点都需要执行;

- 接下来只需要执行命令初始化集群即可

kubeadm init --config kubeadm-config.yaml --upload-certs

注意:

1.只有主节点master1执行kubeadm init初始化;

2.其他master、node节点无需执行,待主节点初始化完成后kubeadm join命令即可;

提示:如果集群初始化失败,可以执行命令,进行重置调整后再次初始化

kubeadm reset -f

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

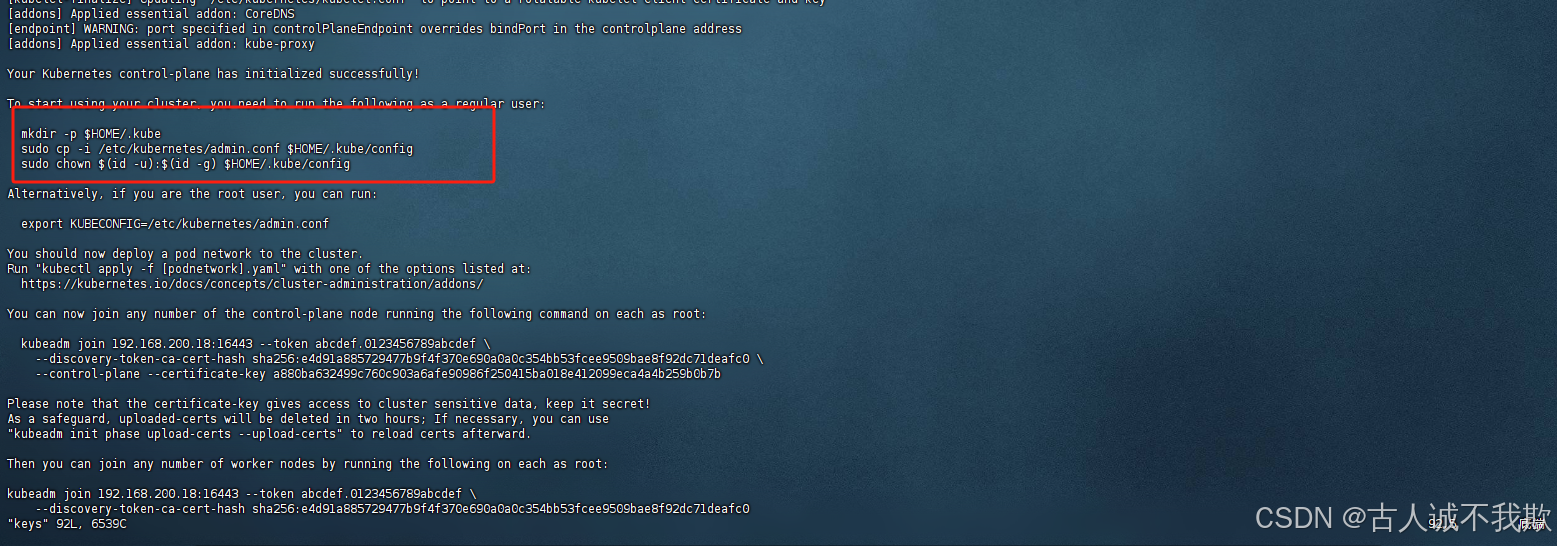

初始化成功可以看到以下内容:

- 然后根据日志提示进行kubectl进行授权执行以下命令,并将下方的这些内容记录一下后面节点加入集群时需要用到;

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

有时候可能会出现权限、环境变量的问题:

权限问题给文件赋予权限即可:chmod 755 $HOME/.kube/config;

环境变量问题,配置以下环境变量即可:export KUBECONFIG=$HOME/.kube/config;

可以输入命令查看po的状态,因为没安装网络插件的原因,有的po是起不来的;

kubectl get po -n kube-system

2.安装calico网络插件

- 主节点安装网络插件即可,其他节点在加入集群后会自动拉取网络插件相关的po;

首先需要在官网下载一个配置文件,执行命令如下:

curl https://docs.projectcalico.org/archive/v3.18/manifests/calico.yaml -O

注意:我这里是安装的3.18版本,calico官网有说明,calico可适用的对应k8s版本,请根据实际版本情况选择版本安装;

- 文件下载好后,我们需要对calico.yaml文件进行修改;

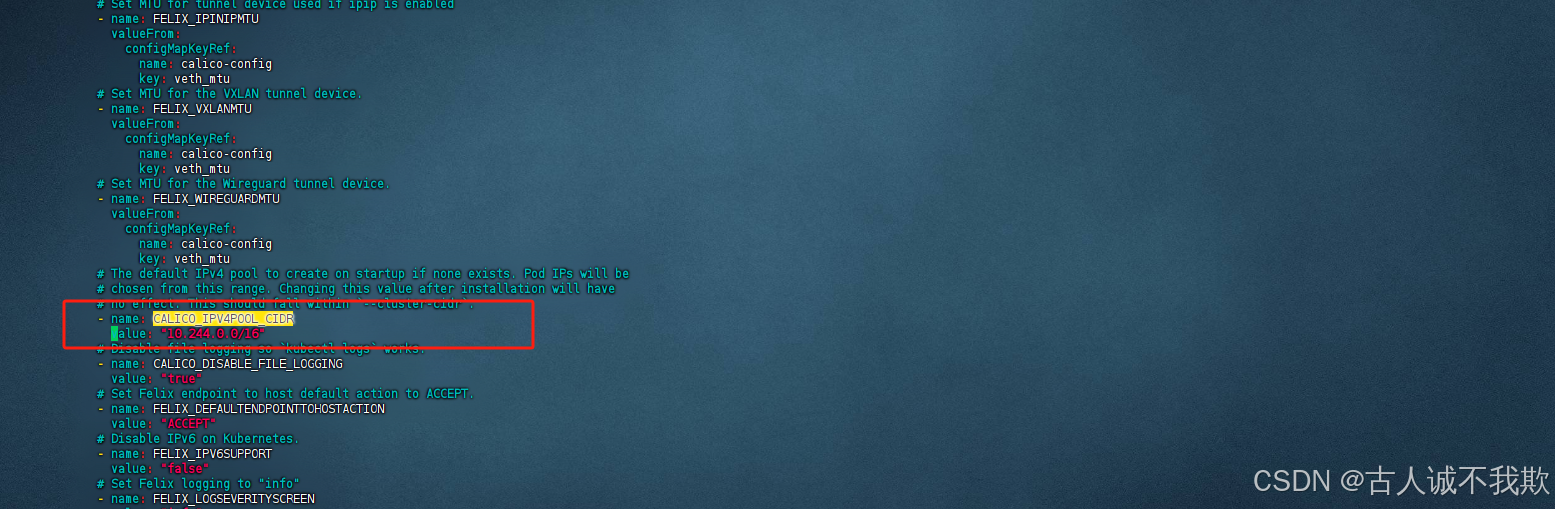

搜索CALICO_IPV4POOL_CIDR关键字,其中name和value参数默认是注释掉的,将注释放开,并将value的值改成与kubeadm-config.yam中的networking -- podSubnet中的ip一致;即与集群设置的pod的虚拟网段ip保持一致;

注意:修改时注意格式;

- name: CALICO_IPV4POOL_CIDRvalue: "10.244.0.0/16" #与集群设置的pod的虚拟网段ip保持一致;

如图我这里的pod网段是10.244.0.0

calico.yaml中同样改为对应的

- 然后执行命令进行部署

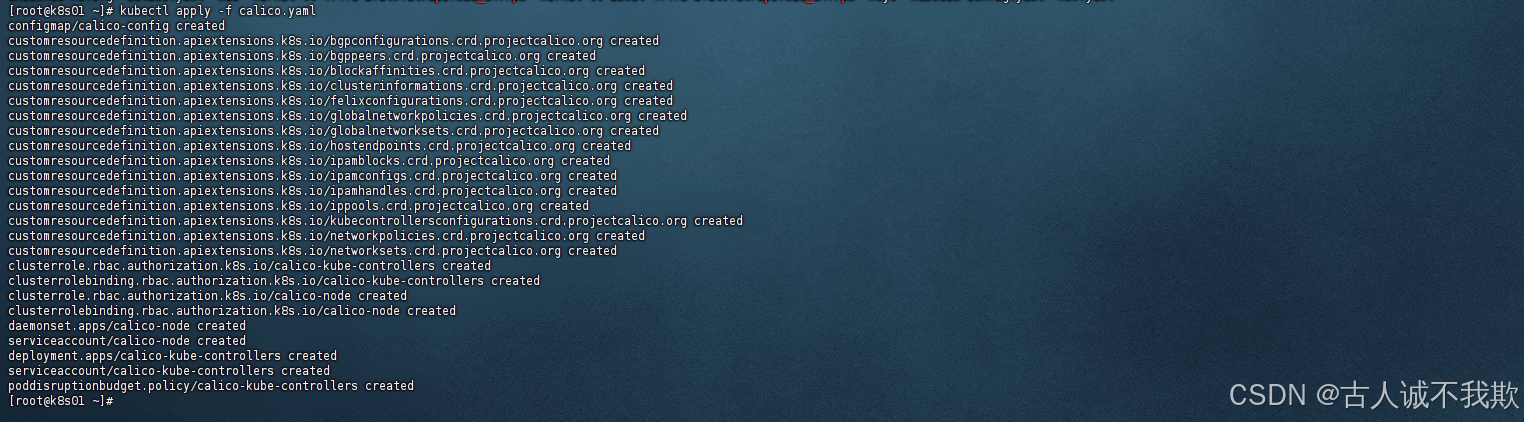

kubectl apply -f calico.yaml

如图部署成功!

注意:网络不好镜像可能会拉不下来

可以输入命令查看po的名称:kubectl get po -n kube-system

根据名字查看状态不正确的po报错的原因如:kubectl describe pod -n kube-system calico-node-q6ksq

如果是因为拉取失败的话可以尝试手动拉取对应镜像如:docker pull docker.io/calico/cni:v3.18.6

如图:查找calico对应的node名称

查看报错原因:

3.其他master节点加入集群

- 创建证书存放目录并上传证书

在需要加入集群的新master节点中创建证书存放目录;

mkdir -p /etc/kubernetes/pki/etcd && mkdir -p ~/.kube/

然后把主节点master1节点的证书拷贝到master2上;

scp -r /etc/kubernetes/pki/ca.* root@k8s02-m2:/etc/kubernetes/pki/

scp -r /etc/kubernetes/pki/sa.* root@k8s02-m2:/etc/kubernetes/pki/

scp -r /etc/kubernetes/pki/front-proxy-ca.* root@k8s02-m2:/etc/kubernetes/pki

scp -r /etc/kubernetes/pki/etcd/ca.* root@k8s02-m2:/etc/kubernetes/pki/etcd

scp -r /etc/kubernetes/admin.conf root@k8s02-m2:/etc/kubernetes/

- 验证网络是否畅通

在新节点上验证负载均衡的网络地址是否畅通;

#ip端口修改为实际的ip端口

curl -k https://192.168.200.18:16443

如果网络畅通则可以直接执行第3步,输入命令执行进行加入命令,如果网络连接不通,则需要进行排查;如我这里由于前面设置的 vip地址controlPlaneEndpoint: "192.168.200.18:16443"与主机不在同一个网络,除了主节点外,其他节点无法直接访问,需要添加路由才行;

临时添加路由:(不推荐,此方法机器重启后就会失效,适合用来临时测试)

首先查看节点是否有vip对应的路由

ip route

不存在则加一条

#192.168.200.0/24,".0/24"后面几位不变前面3位和你的vip地址相同即可

#192.168.0.1是主机实际的默认网关

#ens32是主机、网卡名

ip route add 192.168.200.0/24 dev 192.168.0.1 dev ens32

刷新缓存后,再次查询是否加入成功

ip neigh flush all

ip route

成功添加后,测试一下网络是否正常,正常则可执行第3步加入集群;

#ip端口修改为实际的ip端口

curl -k https://192.168.200.18:16443

永久添加路由:(推荐使用,机器重启后不会失效)

编辑/etc/rc.local文件并添加内容

vim /etc/rc.local

在文件中插入以下内容

#192.168.200.0/24,".0/24"后面几位不变前面3位和你的vip地址相同即可

#192.168.0.1是主机实际的默认网关

#ens32是主机、网卡名

ip route add 192.168.200.0/24 dev 192.168.0.1 dev ens32

给文件添加执行权限,并设置为开机自启,后启动服务;

chmod +x /etc/rc.d/rc.local

systemctl enable rc-local

systemctl start rc-local

将机器重启验证路由是否自动添加了

reboot

#清除缓存

ip neigh flush all

#查看路由表中是否添加

ip route

成功添加后,测试一下网络是否正常,正常则可执行第3步加入集群;

#ip端口修改为实际的ip端口

curl -k https://192.168.200.18:16443

-

加入节点命令

-

首先我们在主节点查看是否存在证书;

kubectl get secret -n kube-system | grep kubeadm-certs

如果不存在则执行命令创建一个证书,并获取新的加入集群的命令;

kubeadm init phase upload-certs --upload-certs

获取新的加入集群的命令

kubeadm token create --print-join-command

- 存在证书则,直接执行,主机节点初始化时给出的命令,进行加入集群;

kubeadm join 192.168.200.18:16443 --token abcdef.0123456789abcdef \--discovery-token-ca-cert-hash sha256:b396cdc01129c9e9d03c072d3b65536164a6a1a23a80bed4305452603012ea3b \--control-plane --certificate-key d9742f79ef7a216dbe2aca5ebf34d0dd12a9ad46fe735dcca199984f2e1408b7

注意:加入集群,master和node的命令是一样的都是

kubeadm join,区别在于--control-plane参数,有该参数则是,加入master节点,没有则是加入node节点;

成功加入集群后根据日志提示进行kubectl进行授权执行以下命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

加入成功!

可以输入命令查看节点是否加入成功;

kubectl get node

通过命令查看新增主机上的po状态是否正常

kubectl get po -n kube-system

查看某po的详情,日志

kubectl describe pod -n kube-system poNmae

4.node节点加入命令

node节点的加入很简单只需要安装了kubeadm、kubectl、kubelet即可执行kubeadm join命令;同master差不多,唯一的区别是不需要--control-plane参数;

注意:node节点加入集群不需要

--control-plane参数

设置的vip不和主机ip在同一个网段时,需要手动添加路由规则,添加方法参考上文的master节点加入;

- node节点加入集群

建议先测以下网络是否畅通;

#ip端口修改为实际的ip端口

curl -k https://192.168.200.18:16443

网络正常,则直接执行命令加入即可;

kubeadm join 192.168.200.18:16443 --token abcdef.0123456789abcdef \--discovery-token-ca-cert-hash sha256:b396cdc01129c9e9d03c072d3b65536164a6a1a23a80bed4305452603012ea3b

- 忘记命令处理方法

如果不记得加入的命令了,可以执行以下命令,获取新的加入集群的命令;

kubeadm token create --print-join-command

- 重置node节点

提示:如果加入集群失败,则可以进行重置;

输入命令重置

kubeadm reset -f

重置完成后,根据日志提示删除以下文件;

rm -rf /etc/cni/net.d

rm -rf $HOME/.kube/config

rm -rf /etc/kubernetes/kubelet.conf

清除iptables中所有规则后重新加载配置,再次输入命令进入加入集群即可;

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

systemctl daemon-reload

相关文章:

kubeadm安装K8s高可用集群之集群初始化及master/node节点加入calico网络插件安装

系列文章目录 1.kubeadm安装K8s高可用集群之基础环境配置 2.kubeadm安装K8s集群之高可用组件keepalivednginx及kubeadm部署 3.kubeadm安装K8s高可用集群之集群初始化及master/node节点加入集群calico网络插件安装 kubeadm安装K8s高可用集群之集群初始化及master/node节点加入ca…...

游戏何如防抓包

游戏抓包是指在游戏中,通过抓包工具捕获和分析游戏客户端与服务器之间传输的封包数据的过程。抓包工具可实现拦截、篡改、重发、丢弃游戏的上下行数据包,市面上常见的抓包工具有WPE、Fiddler和Charles Proxy等。 抓包工具有两种实现方式,一类…...

【LeetCode】每日一题 2024_12_19 找到稳定山的下标(模拟)

前言 每天和你一起刷 LeetCode 每日一题~ 最近力扣的每日一题出的比较烂,难度过山车,导致近期的更新都三天打鱼,两天断更了 . . . LeetCode 启动! 题目:找到稳定山的下标 代码与解题思路 先读题:最重要…...

运维 mysql、redis 、RocketMQ性能排查

MySQL查看数据库连接数 1. SHOW STATUS命令-查询当前的连接数 MySQL 提供了一个 SHOW STATUS 命令,可以用来查看服务器的状态信息,包括当前的连接数。 SHOW STATUS LIKE Threads_connected;这个命令会返回当前连接到服务器的线程数,即当前…...

[SAP ABAP] 将内表数据转换为HTML格式

从sflight数据库表中检索航班信息,并将这些信息转换成HTML格式,然后下载或显示在前端 开发步骤 ① 自定义一个数据类型 ty_sflight 来存储航班信息 ② 声明内表和工作区变量,用于存储表头、字段、HTML内容和航班详细信息以及创建字段目录lt…...

LLM大语言模型私有化部署-使用Dify与Qwen2.5打造专属知识库

背景 Dify 是一款开源的大语言模型(LLM) 应用开发平台。其直观的界面结合了 AI 工作流、 RAG 管道、 Agent 、模型管理、可观测性功能等,让您可以快速从原型到生产。相比 LangChain 这类有着锤子、钉子的工具箱开发库, Dify 提供了更接近生产需要的完整…...

使用C语言连接MySQL

在C语言中连接MySQL数据库,通常需要使用MySQL提供的C API。以下是使用C语言连接MySQL数据库的基本步骤和示例代码: 步骤 1: 安装MySQL C API 首先,确保你的系统上安装了MySQL数据库,并且安装了MySQL C API库。在大多数Linux发行版…...

PyTorch 2.0 以下版本中设置默认使用 GPU 的方法

PyTorch 2.0 以下版本中设置默认使用 GPU 的方法 在 PyTorch 2.0以下版本中,默认情况下仍然是使用 CPU 进行计算,除非明确指定使用 GPU。在 PyTorch 2.0 以下版本中,虽然没有 torch.set_default_device 的便捷方法,但可以通过显式…...

信号槽【QT】

文章目录 对象树字符集信号槽QT坐标系信号与槽connect自定义槽自定义信号disconnect 对象树 #ifndef MYLABEL_H #define MYLABEL_H#include<QLabel> class MyLabel : public QLabel { public:// 构造函数使用带 QWidget* 版本的.// 确保对象能够加到对象树上MyLabel(QWi…...

【UE5 C++课程系列笔记】10——动态单播/多播的基本使用

目录 概念 申明动态委托 一、DECLARE_DYNAMIC_DELEGATE 二、DECLARE_DYNAMIC_MULTICAST_DELEGATE 绑定动态委托 一、BindDynamic 二、AddDynamic 三、RemoveDynamic 执行动态委托 一、Execute 二、ExecuteIfBound 三、IsBound 四、Broadcast 动态单播使用示…...

点击展示大图预览

原文链接在table表格里能够实现,点击里面的图片实现大图预览的效果; 一、先安装viewer — 使用npm安装 npm install v-viewer --save二、在main.js中引入 import Viewer from v-viewer //点击图片大图预览 import viewerjs/dist/viewer.css Vue.use(…...

【C++】分书问题:深入解析、回溯法高级应用与理论拓展

博客主页: [小ᶻ☡꙳ᵃⁱᵍᶜ꙳] 本文专栏: C 文章目录 💯前言💯题目描述💯思路与算法回溯法理论基础 💯代码实现与解析完整代码代码关键步骤解析 💯时间复杂度与空间复杂度分析💯理论拓展&…...

java开发入门学习五-流程控制

流程控制语句 if, if...else, if..else if..else 与前端相同 略 switch case 与前端不同的是case不能使用表达式,使用表达式会报错 class TestSwitch {public static void main(String[] args) {// switch 表达式只能是特定的数据类型…...

【FFmpeg 教程 一】截图

本章使用 ffmpeg 实现观影中经常会用到的功能,截图。 以下给出两种方式。 课程需具备的基础能力:Python 1. 使用 subprocess 调用 FFmpeg 命令 import subprocess def extract_frame(video_path, output_image_path, timestamp"00:00:05")&qu…...

北邮,成电计算机考研怎么选?

#总结结论: 基于当前提供的24考研复录数据,从报考性价比角度,建议25考研的同学优先选择北邮计算机学硕。主要原因是:相比成电,北邮计算机学硕的目标分数更低,录取率更高,而且北邮的地理位置优势明显。对于…...

深入了解京东API接口:如何高效获取商品详情与SKU信息

在当今数字化时代,电商平台的数据接口成为了连接商家与消费者的桥梁。京东作为国内领先的电商平台,其API接口为开发者提供了丰富的商品信息获取途径。本文将深入探讨如何使用京东API接口高效获取商品详情与SKU信息,并附上简短而实用的代码示例…...

C++常见内存泄漏案例分析以及解决方案

C 常见内存泄漏案例分析以及解决方案 1. 分配与释放不匹配 在动态内存管理中,使用new操作符分配的内存必须通过delete操作符显式释放。若未遵循这一规则,将导致内存泄漏。例如: int *p new int; p new int; // 错误:未释放先…...

[LeetCode-Python版]206. 反转链表(迭代+递归两种解法)

题目 给你单链表的头节点 head ,请你反转链表,并返回反转后的链表。 示例 1: 输入:head [1,2,3,4,5] 输出:[5,4,3,2,1] 示例 2: 输入:head [1,2] 输出:[2,1] 示例 3࿱…...

70 mysql 中事务的隔离级别

前言 mysql 隔离级别有四种 未提交读, 已提交读, 可重复度, 序列化执行 然后不同的隔离级别存在不同的问题 未提交读存在 脏读, 不可重复度, 幻觉读 等问题 已提交读存在 不可重复度, 幻觉读 等问题 可重复读存在 幻觉读 等问题 序列化执行 没有以上问题 然后 我们这里…...

C语言二叉树

1.思维导图 树 二叉树 2.将链式队列重新实现一遍 linkqueue.c #include"linkqueue.h" linkqueuePtr create() {linkqueuePtr L(linkqueuePtr)malloc(sizeof(linkqueue));if(NULLL){printf("队列创建失败\n");return NULL;}L->head(nodePtr)malloc(si…...

利用最小二乘法找圆心和半径

#include <iostream> #include <vector> #include <cmath> #include <Eigen/Dense> // 需安装Eigen库用于矩阵运算 // 定义点结构 struct Point { double x, y; Point(double x_, double y_) : x(x_), y(y_) {} }; // 最小二乘法求圆心和半径 …...

【JVM】- 内存结构

引言 JVM:Java Virtual Machine 定义:Java虚拟机,Java二进制字节码的运行环境好处: 一次编写,到处运行自动内存管理,垃圾回收的功能数组下标越界检查(会抛异常,不会覆盖到其他代码…...

Java-41 深入浅出 Spring - 声明式事务的支持 事务配置 XML模式 XML+注解模式

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

ServerTrust 并非唯一

NSURLAuthenticationMethodServerTrust 只是 authenticationMethod 的冰山一角 要理解 NSURLAuthenticationMethodServerTrust, 首先要明白它只是 authenticationMethod 的选项之一, 并非唯一 1 先厘清概念 点说明authenticationMethodURLAuthenticationChallenge.protectionS…...

《基于Apache Flink的流处理》笔记

思维导图 1-3 章 4-7章 8-11 章 参考资料 源码: https://github.com/streaming-with-flink 博客 https://flink.apache.org/bloghttps://www.ververica.com/blog 聚会及会议 https://flink-forward.orghttps://www.meetup.com/topics/apache-flink https://n…...

【论文阅读28】-CNN-BiLSTM-Attention-(2024)

本文把滑坡位移序列拆开、筛优质因子,再用 CNN-BiLSTM-Attention 来动态预测每个子序列,最后重构出总位移,预测效果超越传统模型。 文章目录 1 引言2 方法2.1 位移时间序列加性模型2.2 变分模态分解 (VMD) 具体步骤2.3.1 样本熵(S…...

视频行为标注工具BehaviLabel(源码+使用介绍+Windows.Exe版本)

前言: 最近在做行为检测相关的模型,用的是时空图卷积网络(STGCN),但原有kinetic-400数据集数据质量较低,需要进行细粒度的标注,同时粗略搜了下已有开源工具基本都集中于图像分割这块,…...

LINUX 69 FTP 客服管理系统 man 5 /etc/vsftpd/vsftpd.conf

FTP 客服管理系统 实现kefu123登录,不允许匿名访问,kefu只能访问/data/kefu目录,不能查看其他目录 创建账号密码 useradd kefu echo 123|passwd -stdin kefu [rootcode caozx26420]# echo 123|passwd --stdin kefu 更改用户 kefu 的密码…...

脑机新手指南(七):OpenBCI_GUI:从环境搭建到数据可视化(上)

一、OpenBCI_GUI 项目概述 (一)项目背景与目标 OpenBCI 是一个开源的脑电信号采集硬件平台,其配套的 OpenBCI_GUI 则是专为该硬件设计的图形化界面工具。对于研究人员、开发者和学生而言,首次接触 OpenBCI 设备时,往…...

根目录0xa0属性对应的Ntfs!_SCB中的FileObject是什么时候被建立的----NTFS源代码分析--重要

根目录0xa0属性对应的Ntfs!_SCB中的FileObject是什么时候被建立的 第一部分: 0: kd> g Breakpoint 9 hit Ntfs!ReadIndexBuffer: f7173886 55 push ebp 0: kd> kc # 00 Ntfs!ReadIndexBuffer 01 Ntfs!FindFirstIndexEntry 02 Ntfs!NtfsUpda…...