Python中的asyncio:高效的异步编程模型

随着互联网应用的快速发展,程序的响应性和处理效率成为衡量系统性能的重要指标。传统的同步编程模型在面对高并发和IO密集型任务时,常常显得捉襟见肘,难以满足现代应用的需求。Python的asyncio库作为一种高效的异步编程模型,为开发者提供了强大的工具来优化程序的性能和响应速度。本文深入探讨了asyncio的核心概念与机制,详细解析了事件循环、协程、任务和未来对象等关键组件的工作原理。通过大量的代码示例和详尽的中文注释,展示了如何利用asyncio实现异步任务调度,处理网络请求、文件操作等IO密集型任务,并提升程序的并发处理能力。此外,本文还介绍了asyncio中的高级功能,如并发控制、超时处理和异常处理,帮助读者构建健壮且高效的异步应用。通过实战案例,读者将掌握使用asyncio构建高性能网络爬虫的技巧,并了解优化异步程序性能与响应性的最佳实践。本文适合对异步编程感兴趣的Python开发者,以及希望提升程序性能和响应速度的工程师参考学习。

目录

- 引言

asyncio基础- 2.1 异步编程与同步编程对比

- 2.2

asyncio的核心概念 - 2.3 事件循环机制

- 协程与任务

- 3.1 协程的定义与使用

- 3.2 创建与管理任务

- 3.3 未来对象(Future Objects)

asyncio中的IO操作- 4.1 异步网络请求

- 4.2 异步文件操作

- 4.3 异步数据库访问

- 高级功能与优化

- 5.1 并发控制

- 5.2 超时处理

- 5.3 异常处理

- 实战案例:构建高效的网络爬虫

- 6.1 项目需求分析

- 6.2 设计与实现

- 6.3 性能测试与优化

- 优化异步程序的性能与响应性

- 7.1 内存管理

- 7.2 任务调度优化

- 7.3 调试与监控

- 常见问题与解决方案

- 结论

引言

随着互联网应用的普及和数据量的急剧增加,开发者面临着如何高效处理大量并发请求和IO密集型任务的挑战。传统的同步编程模型在处理这些任务时,往往需要通过多线程或多进程来提升性能,但这不仅增加了编程的复杂性,还带来了额外的资源开销。为了解决这一问题,Python引入了asyncio库,提供了一种基于事件循环的异步编程模型,使得开发者能够在单线程中高效地管理大量并发任务。

asyncio自Python 3.4版本引入以来,逐渐成为Python生态系统中处理异步任务的核心库。它不仅简化了异步编程的实现,还通过协程(coroutine)和任务(task)的组合,使得代码更加简洁和易读。本文将系统地介绍asyncio的基本概念、核心机制以及在实际项目中的应用,帮助读者全面掌握这一强大的异步编程工具。

通过本文,读者将了解到如何利用asyncio实现高效的异步任务调度,处理网络请求、文件操作等常见的IO密集型任务,并提升程序的并发处理能力。此外,本文还将深入探讨asyncio中的高级功能,如并发控制、超时处理和异常处理,帮助开发者构建更加健壮和高效的异步应用。

asyncio基础

2.1 异步编程与同步编程对比

在编程中,任务的执行模式主要有同步(synchronous)和异步(asynchronous)两种。了解这两者的区别对于选择合适的编程模型至关重要。

同步编程指的是任务按顺序执行,一个任务完成后才能执行下一个任务。在这种模式下,如果某个任务需要等待(例如IO操作),整个程序将会被阻塞,直到该任务完成。这种阻塞行为可能导致程序响应缓慢,尤其是在处理大量并发请求时。

import timedef fetch_data():print("开始获取数据...")time.sleep(2) # 模拟IO操作print("数据获取完成")return "数据"def main():data = fetch_data()print(f"获取到的数据: {data}")if __name__ == "__main__":main()

上述代码中,fetch_data函数模拟了一个需要等待2秒的IO操作。在执行过程中,程序在time.sleep(2)处被阻塞,直到数据获取完成。

异步编程则允许程序在等待某个任务完成时,继续执行其他任务,从而提高程序的并发性和响应速度。通过事件循环(event loop)和协程(coroutine)的协作,异步编程能够在单线程中高效地管理大量并发任务,避免了多线程带来的复杂性和资源开销。

2.2 asyncio的核心概念

asyncio库是Python中用于编写异步代码的标准库,其核心概念包括:

- 事件循环(Event Loop):管理和调度异步任务的核心机制,负责监听和分发事件。

- 协程(Coroutine):一种特殊的函数,支持异步执行,使用

async和await关键字定义。 - 任务(Task):协程的包装器,负责调度和执行协程。

- 未来对象(Future):表示一个尚未完成的异步操作,协程可以等待未来对象的结果。

2.3 事件循环机制

事件循环是asyncio的核心,负责调度和执行所有的异步任务。它不断地检查是否有任务准备就绪,并执行相应的协程。

以下是一个简单的事件循环示例:

import asyncioasync def hello():print("Hello")await asyncio.sleep(1)print("World")def main():loop = asyncio.get_event_loop()loop.run_until_complete(hello())loop.close()if __name__ == "__main__":main()

代码解释:

- 定义协程:

hello是一个协程函数,使用async关键字定义。在协程内部,通过await关键字等待asyncio.sleep(1),模拟一个异步IO操作。 - 获取事件循环:

loop = asyncio.get_event_loop()获取当前的事件循环。 - 运行协程:

loop.run_until_complete(hello())将协程任务提交给事件循环并运行,直到任务完成。 - 关闭事件循环:

loop.close()关闭事件循环,释放资源。

输出结果:

Hello

World

在这个示例中,事件循环首先执行hello协程,打印“Hello”,然后等待1秒,最后打印“World”。由于await asyncio.sleep(1)是一个非阻塞的等待,事件循环可以在等待期间执行其他任务(如果有)。

协程与任务

3.1 协程的定义与使用

协程是异步编程的基石,允许函数在执行过程中暂停和恢复,从而实现并发操作。在asyncio中,协程使用async def语法定义,并通过await关键字调用其他协程或异步函数。

定义协程:

import asyncioasync def fetch_data():print("开始获取数据...")await asyncio.sleep(2) # 模拟IO操作print("数据获取完成")return "数据"

调用协程:

要调用协程,可以通过事件循环来执行:

def main():loop = asyncio.get_event_loop()data = loop.run_until_complete(fetch_data())print(f"获取到的数据: {data}")loop.close()if __name__ == "__main__":main()

输出结果:

开始获取数据...

数据获取完成

获取到的数据: 数据

使用asyncio.run简化事件循环管理:

自Python 3.7起,可以使用asyncio.run简化事件循环的创建和关闭:

import asyncioasync def fetch_data():print("开始获取数据...")await asyncio.sleep(2)print("数据获取完成")return "数据"async def main():data = await fetch_data()print(f"获取到的数据: {data}")if __name__ == "__main__":asyncio.run(main())

输出结果与之前相同。

3.2 创建与管理任务

在实际应用中,通常需要同时执行多个协程任务。asyncio提供了asyncio.create_task和asyncio.gather等方法,方便地创建和管理并发任务。

使用asyncio.create_task创建任务:

import asyncioasync def task1():print("任务1开始")await asyncio.sleep(2)print("任务1完成")return "结果1"async def task2():print("任务2开始")await asyncio.sleep(1)print("任务2完成")return "结果2"async def main():# 创建任务t1 = asyncio.create_task(task1())t2 = asyncio.create_task(task2())# 等待任务完成并获取结果result1 = await t1result2 = await t2print(f"任务1结果: {result1}")print(f"任务2结果: {result2}")if __name__ == "__main__":asyncio.run(main())

输出结果:

任务1开始

任务2开始

任务2完成

任务1完成

任务1结果: 结果1

任务2结果: 结果2

解释:

- 创建任务:使用

asyncio.create_task将协程包装为任务,并立即开始执行。 - 并发执行:任务1和任务2几乎同时开始执行,任务2由于等待时间较短,先完成。

- 获取结果:通过

await关键字等待任务完成,并获取返回结果。

使用asyncio.gather并发执行多个任务:

import asyncioasync def task1():print("任务1开始")await asyncio.sleep(2)print("任务1完成")return "结果1"async def task2():print("任务2开始")await asyncio.sleep(1)print("任务2完成")return "结果2"async def main():# 并发执行任务results = await asyncio.gather(task1(), task2())print(f"所有任务结果: {results}")if __name__ == "__main__":asyncio.run(main())

输出结果:

任务1开始

任务2开始

任务2完成

任务1完成

所有任务结果: ['结果1', '结果2']

解释:

asyncio.gather将多个协程任务打包,并并发执行,等待所有任务完成后返回结果列表。

3.3 未来对象(Future Objects)

未来对象(Future)表示一个尚未完成的异步操作,可以通过它来获取异步任务的结果。Future对象通常由事件循环创建和管理。

创建和使用Future对象:

import asyncioasync def set_future(fut):print("设置Future的结果...")await asyncio.sleep(2)fut.set_result("Future的结果")async def main():# 创建Future对象fut = asyncio.Future()# 启动协程设置Future的结果asyncio.create_task(set_future(fut))print("等待Future的结果...")result = await futprint(f"获取到的Future结果: {result}")if __name__ == "__main__":asyncio.run(main())

输出结果:

等待Future的结果...

设置Future的结果...

获取到的Future结果: Future的结果

解释:

- 创建Future:通过

asyncio.Future()创建一个Future对象。 - 设置结果:通过

set_result方法在协程中设置Future的结果。 - 等待结果:在主协程中通过

await fut等待Future完成,并获取结果。

Future对象在复杂的异步任务管理中非常有用,例如在回调函数中传递结果,或者在事件驱动的系统中协调多个任务。

asyncio中的IO操作

asyncio在处理IO密集型任务时表现尤为出色,如网络请求、文件操作和数据库访问等。以下将介绍如何使用asyncio进行异步网络请求、文件操作和数据库访问。

4.1 异步网络请求

在网络编程中,常见的IO操作包括HTTP请求、TCP连接等。使用asyncio可以高效地管理多个并发网络请求。

使用aiohttp进行异步HTTP请求:

aiohttp是一个基于asyncio的异步HTTP客户端/服务器框架,适用于执行大量并发HTTP请求。

安装aiohttp:

pip install aiohttp

示例代码:

import asyncio

import aiohttpasync def fetch(session, url):async with session.get(url) as response:status = response.statusdata = await response.text()print(f"URL: {url} | 状态码: {status}")return dataasync def main():urls = ["https://www.python.org","https://www.asyncio.org","https://www.github.com","https://www.stackoverflow.com"]async with aiohttp.ClientSession() as session:tasks = [fetch(session, url) for url in urls]results = await asyncio.gather(*tasks)print("所有请求完成")if __name__ == "__main__":asyncio.run(main())

输出示例:

URL: https://www.python.org | 状态码: 200

URL: https://www.asyncio.org | 状态码: 404

URL: https://www.github.com | 状态码: 200

URL: https://www.stackoverflow.com | 状态码: 200

所有请求完成

代码解释:

- 定义

fetch协程:使用aiohttp的ClientSession发送GET请求,并异步获取响应内容。 - 创建任务列表:为每个URL创建一个

fetch任务。 - 并发执行任务:使用

asyncio.gather并发执行所有任务,等待所有任务完成。 - 打印结果:打印每个URL的状态码,最后打印“所有请求完成”。

处理大量并发请求:

当需要处理成百上千的并发请求时,合理控制并发数量可以避免过度占用系统资源。可以使用asyncio.Semaphore进行并发控制。

示例代码:

import asyncio

import aiohttpasync def fetch(session, url, semaphore):async with semaphore:async with session.get(url) as response:status = response.statusdata = await response.text()print(f"URL: {url} | 状态码: {status}")return dataasync def main():urls = [f"https://www.example.com/page{i}" for i in range(1, 101)] # 假设100个URLsemaphore = asyncio.Semaphore(10) # 最大并发数为10async with aiohttp.ClientSession() as session:tasks = [fetch(session, url, semaphore) for url in urls]results = await asyncio.gather(*tasks)print("所有请求完成")if __name__ == "__main__":asyncio.run(main())

代码解释:

- 创建信号量:

asyncio.Semaphore(10)限制同时执行的任务数为10。 - 在

fetch协程中使用信号量:通过async with semaphore确保并发任务数不超过10。 - 生成100个URL任务:模拟大量并发请求。

- 执行并发任务:使用

asyncio.gather执行所有任务,等待完成。

4.2 异步文件操作

在文件IO操作中,尤其是处理大量文件时,同步操作会导致程序阻塞。asyncio可以结合aiofiles库,实现异步文件操作。

安装aiofiles:

pip install aiofiles

示例代码:

import asyncio

import aiofilesasync def read_file(file_path):async with aiofiles.open(file_path, mode='r') as f:contents = await f.read()print(f"读取文件 {file_path} 完成")return contentsasync def write_file(file_path, data):async with aiofiles.open(file_path, mode='w') as f:await f.write(data)print(f"写入文件 {file_path} 完成")async def main():read_tasks = [read_file(f"input_{i}.txt") for i in range(1, 6)]contents = await asyncio.gather(*read_tasks)write_tasks = [write_file(f"output_{i}.txt", content.upper()) for i, content in enumerate(contents, 1)]await asyncio.gather(*write_tasks)if __name__ == "__main__":asyncio.run(main())

代码解释:

- 定义

read_file协程:异步读取文件内容。 - 定义

write_file协程:异步写入文件内容。 - 创建读取任务:异步读取多个输入文件。

- 处理数据并创建写入任务:将读取的内容转换为大写,并异步写入多个输出文件。

- 执行并发任务:使用

asyncio.gather并发执行所有读取和写入任务。

注意事项:

aiofiles不支持所有文件操作,例如随机访问等复杂操作。- 异步文件操作适用于处理大量文件的读取和写入任务,能够显著提高效率。

4.3 异步数据库访问

在数据库操作中,尤其是需要处理大量并发查询时,异步访问能够提高数据库的吞吐量和响应速度。可以使用asyncpg库进行异步PostgreSQL数据库操作。

安装asyncpg:

pip install asyncpg

示例代码:

import asyncio

import asyncpgasync def fetch_user(pool, user_id):async with pool.acquire() as connection:row = await connection.fetchrow("SELECT * FROM users WHERE id = $1", user_id)print(f"用户ID: {user_id} | 用户名: {row['name']}")return rowasync def main():# 创建数据库连接池pool = await asyncpg.create_pool(user='youruser', password='yourpassword',database='yourdb', host='127.0.0.1', port=5432)user_ids = range(1, 101) # 假设查询100个用户tasks = [fetch_user(pool, user_id) for user_id in user_ids]results = await asyncio.gather(*tasks)await pool.close()if __name__ == "__main__":asyncio.run(main())

代码解释:

- 创建数据库连接池:通过

asyncpg.create_pool创建一个连接池,管理数据库连接。 - 定义

fetch_user协程:异步查询指定用户ID的用户信息。 - 创建并发查询任务:为100个用户ID创建查询任务。

- 执行并发任务:使用

asyncio.gather并发执行所有查询任务。 - 关闭连接池:任务完成后关闭连接池,释放资源。

优势:

- 高并发处理:通过连接池和异步查询,能够高效地处理大量并发数据库请求。

- 资源优化:连接池管理数据库连接,避免频繁创建和关闭连接,优化资源利用。

高级功能与优化

在实际应用中,除了基本的异步任务调度,asyncio还提供了多种高级功能,帮助开发者构建更加高效和健壮的异步应用。

5.1 并发控制

在处理大量并发任务时,合理控制并发数量可以避免系统资源过载,提高程序的稳定性和性能。asyncio.Semaphore提供了一种简单的并发控制机制。

使用asyncio.Semaphore限制并发任务数:

import asyncio

import aiohttpasync def fetch(session, url, semaphore):async with semaphore:async with session.get(url) as response:status = response.statusdata = await response.text()print(f"URL: {url} | 状态码: {status}")return dataasync def main():urls = [f"https://www.example.com/page{i}" for i in range(1, 21)] # 20个URLsemaphore = asyncio.Semaphore(5) # 最大并发数为5async with aiohttp.ClientSession() as session:tasks = [fetch(session, url, semaphore) for url in urls]results = await asyncio.gather(*tasks)print("所有请求完成")if __name__ == "__main__":asyncio.run(main())

代码解释:

- 创建信号量:

asyncio.Semaphore(5)限制同时执行的任务数为5。 - 在

fetch协程中使用信号量:通过async with semaphore确保并发任务数不超过5。 - 生成并发任务:创建20个URL请求任务,实际同时执行的任务数不会超过5。

应用场景:

- 网络爬虫:限制同时进行的HTTP请求数,避免被目标服务器封禁。

- 数据库查询:控制并发数据库连接数,避免过载数据库服务器。

5.2 超时处理

在异步编程中,某些任务可能由于网络问题或其他原因长时间未完成。合理设置超时可以防止程序无限等待,提高系统的健壮性。

使用asyncio.wait_for设置超时:

import asyncio

import aiohttpasync def fetch(session, url):try:async with session.get(url) as response:data = await asyncio.wait_for(response.text(), timeout=3.0) # 设置3秒超时print(f"成功获取URL: {url}")return dataexcept asyncio.TimeoutError:print(f"请求超时: {url}")return Noneasync def main():urls = ["https://www.python.org","https://www.asyncio.org","https://www.github.com","https://www.nonexistenturl.org" # 假设此URL不可访问]async with aiohttp.ClientSession() as session:tasks = [fetch(session, url) for url in urls]results = await asyncio.gather(*tasks)print("所有请求完成")if __name__ == "__main__":asyncio.run(main())

输出示例:

成功获取URL: https://www.python.org

成功获取URL: https://www.asyncio.org

请求超时: https://www.github.com

请求超时: https://www.nonexistenturl.org

所有请求完成

代码解释:

- 设置超时:使用

asyncio.wait_for为response.text()设置3秒的超时时间。 - 处理超时异常:捕获

asyncio.TimeoutError异常,处理请求超时的情况。 - 执行任务:并发执行所有请求任务,等待完成。

注意事项:

- 合理设置超时:根据实际网络环境和任务需求,合理设置超时时间,避免过短导致频繁超时或过长导致资源浪费。

- 异常处理:在异步任务中,务必处理可能的异常,防止程序崩溃。

5.3 异常处理

在异步编程中,任务可能会因各种原因失败,例如网络错误、文件不存在等。合理的异常处理机制能够提高程序的健壮性和可靠性。

使用try-except捕获协程中的异常:

import asyncio

import aiohttpasync def fetch(session, url):try:async with session.get(url) as response:if response.status != 200:raise aiohttp.ClientError(f"HTTP错误: {response.status}")data = await response.text()print(f"成功获取URL: {url}")return dataexcept aiohttp.ClientError as e:print(f"请求失败: {url} | 错误: {e}")return Noneasync def main():urls = ["https://www.python.org","https://www.asyncio.org","https://www.github.com","https://www.nonexistenturl.org" # 假设此URL不可访问]async with aiohttp.ClientSession() as session:tasks = [fetch(session, url) for url in urls]results = await asyncio.gather(*tasks, return_exceptions=True)print("所有请求完成")if __name__ == "__main__":asyncio.run(main())

输出示例:

成功获取URL: https://www.python.org

成功获取URL: https://www.asyncio.org

成功获取URL: https://www.github.com

请求失败: https://www.nonexistenturl.org | 错误: HTTP错误: 404

所有请求完成

代码解释:

- 捕获HTTP错误:在

fetch协程中,如果响应状态码不是200,抛出aiohttp.ClientError异常。 - 处理异常:通过

try-except块捕获并处理异常,防止程序崩溃。 - 使用

return_exceptions=True:在asyncio.gather中设置return_exceptions=True,允许任务返回异常对象,而不是在遇到异常时立即中断。

注意事项:

- 具体异常类型:尽量捕获具体的异常类型,避免过于宽泛的异常捕获。

- 日志记录:在异常处理过程中,可以记录详细的日志,便于后续调试和问题排查。

实战案例:构建高效的网络爬虫

为了更好地理解asyncio的应用,本文将通过一个实战案例,展示如何使用asyncio构建一个高效的网络爬虫,能够同时处理大量并发HTTP请求,并高效地抓取网页内容。

6.1 项目需求分析

假设我们需要抓取多个网站的首页内容,并统计每个页面中的关键词出现次数。由于需要处理大量网站,使用传统的同步爬虫效率较低,无法满足需求。因此,我们将使用asyncio和aiohttp构建一个高效的异步爬虫。

项目功能需求:

- 从给定的URL列表中抓取网页内容。

- 解析网页内容,统计特定关键词的出现次数。

- 并发处理多个请求,提高爬取效率。

- 处理请求超时和异常情况,确保爬虫的稳定性。

- 输出每个URL的关键词统计结果。

6.2 设计与实现

项目结构:

async_crawler/

├── crawler.py

├── urls.txt

└── keywords.txt

crawler.py:主程序,负责异步爬取和关键词统计。urls.txt:包含待抓取的URL列表。keywords.txt:包含需要统计的关键词列表。

步骤概述:

- 读取URL和关键词列表。

- 定义异步爬虫协程。

- 使用

asyncio.Semaphore控制并发数。 - 抓取网页内容并统计关键词。

- 输出统计结果。

示例代码:

import asyncio

import aiohttp

import aiofiles

import re

from collections import defaultdictasync def read_file(file_path):"""异步读取文件内容"""async with aiofiles.open(file_path, mode='r') as f:contents = await f.read()return contents.splitlines()async def fetch(session, url, semaphore):"""异步抓取网页内容"""try:async with semaphore:async with session.get(url, timeout=10) as response:if response.status != 200:print(f"请求失败: {url} | 状态码: {response.status}")return url, Nonetext = await response.text()print(f"成功获取URL: {url}")return url, textexcept asyncio.TimeoutError:print(f"请求超时: {url}")return url, Noneexcept aiohttp.ClientError as e:print(f"请求错误: {url} | 错误: {e}")return url, Nonedef count_keywords(text, keywords):"""统计关键词出现次数"""counts = defaultdict(int)for keyword in keywords:counts[keyword] = len(re.findall(rf'\b{re.escape(keyword)}\b', text, re.IGNORECASE))return countsasync def process_url(session, url, semaphore, keywords):"""处理单个URL的抓取和关键词统计"""url, text = await fetch(session, url, semaphore)if text:counts = count_keywords(text, keywords)return url, countselse:return url, Noneasync def main():# 读取URL和关键词列表urls = await read_file('urls.txt')keywords = await read_file('keywords.txt')# 设置并发数semaphore = asyncio.Semaphore(10)async with aiohttp.ClientSession() as session:tasks = [process_url(session, url, semaphore, keywords) for url in urls]results = await asyncio.gather(*tasks)# 输出结果async with aiofiles.open('results.txt', mode='w') as f:for url, counts in results:if counts:await f.write(f"URL: {url}\n")for keyword, count in counts.items():await f.write(f" {keyword}: {count}\n")await f.write("\n")else:await f.write(f"URL: {url} | 无法获取内容\n\n")print("所有URL处理完成,结果已保存到 results.txt")if __name__ == "__main__":asyncio.run(main())

代码详解:

-

读取文件内容:

read_file协程异步读取文件内容,并返回按行分割的列表。- 分别读取

urls.txt和keywords.txt,获取待抓取的URL和需要统计的关键词。

-

异步抓取网页内容:

fetch协程使用aiohttp发送GET请求,获取网页内容。- 使用

asyncio.Semaphore限制并发请求数,避免过度请求导致被封禁。 - 处理请求超时和HTTP错误,确保程序的稳定性。

-

关键词统计:

count_keywords函数使用正则表达式统计每个关键词在网页内容中出现的次数。- 使用

defaultdict简化计数过程。

-

处理单个URL:

process_url协程结合抓取和关键词统计,返回每个URL的统计结果。

-

执行并发任务:

- 在

main协程中,创建并发任务列表,并使用asyncio.gather并发执行所有任务。 - 抓取完成后,异步写入结果到

results.txt文件。

- 在

-

运行程序:

- 使用

asyncio.run(main())启动异步事件循环,执行爬虫任务。

- 使用

示例输入文件:

urls.txt:

https://www.python.org

https://www.asyncio.org

https://www.github.com

https://www.stackoverflow.com

keywords.txt:

Python

asyncio

GitHub

StackOverflow

示例输出文件:

results.txt:

URL: https://www.python.orgPython: 10asyncio: 2GitHub: 0StackOverflow: 0URL: https://www.asyncio.orgPython: 5asyncio: 8GitHub: 0StackOverflow: 0URL: https://www.github.comPython: 3asyncio: 1GitHub: 15StackOverflow: 0URL: https://www.stackoverflow.comPython: 4asyncio: 1GitHub: 0StackOverflow: 20

性能优势:

- 高并发处理:通过

asyncio和aiohttp,爬虫能够同时处理多个HTTP请求,显著提高爬取效率。 - 资源优化:使用

asyncio.Semaphore限制并发数,避免系统资源过载。 - 稳定性:合理的异常处理机制,确保部分请求失败不会影响整体程序运行。

6.3 性能测试与优化

在构建高效的异步爬虫后,进行性能测试和优化是确保程序达到最佳性能的关键步骤。

性能测试:

通过对不同并发数和任务数量的测试,评估爬虫的性能表现。

示例代码:

import asyncio

import aiohttp

import timeasync def fetch(session, url, semaphore):async with semaphore:async with session.get(url) as response:await response.text()return response.statusasync def main(concurrent, total):urls = [f"https://www.example.com/page{i}" for i in range(total)]semaphore = asyncio.Semaphore(concurrent)async with aiohttp.ClientSession() as session:tasks = [fetch(session, url, semaphore) for url in urls]start = time.time()results = await asyncio.gather(*tasks)end = time.time()print(f"并发数: {concurrent} | 总任务数: {total} | 耗时: {end - start:.2f}秒")if __name__ == "__main__":# 测试不同并发数和任务数asyncio.run(main(concurrent=10, total=100))asyncio.run(main(concurrent=50, total=100))asyncio.run(main(concurrent=100, total=100))

代码解释:

- 定义

fetch协程:异步发送GET请求,获取响应状态码。 - 定义

main协程:根据指定的并发数和任务总数,生成任务并执行。 - 记录耗时:通过

time.time()记录任务执行的开始和结束时间,计算总耗时。 - 运行测试:分别测试并发数为10、50和100时的性能表现。

示例输出:

并发数: 10 | 总任务数: 100 | 耗时: 20.35秒

并发数: 50 | 总任务数: 100 | 耗时: 8.72秒

并发数: 100 | 总任务数: 100 | 耗时: 5.43秒

优化建议:

- 合理设置并发数:根据系统资源和目标服务器的承载能力,合理设置并发数,避免过高导致资源耗尽或被目标服务器封禁。

- 优化任务分配:通过合理分配任务,平衡各协程的工作负载,提高整体效率。

- 缓存与复用:对于重复请求的URL,可以考虑使用缓存机制,减少不必要的网络请求。

优化异步程序的性能与响应性

为了确保异步程序在高并发和大规模任务下仍能保持高效和稳定,需要采取多种优化策略,包括内存管理、任务调度优化以及调试与监控。

7.1 内存管理

在异步编程中,内存管理尤为重要,尤其是在处理大量数据或长时间运行的程序时。以下是一些内存管理的最佳实践:

-

使用生成器:避免一次性加载大量数据,使用生成器逐步生成数据,减少内存占用。

async def generate_urls(total):for i in range(total):yield f"https://www.example.com/page{i}"async def main():async for url in generate_urls(1000):print(url)asyncio.run(main()) -

及时释放资源:在使用完资源(如文件、网络连接)后,及时关闭或释放,避免内存泄漏。

async with aiofiles.open('file.txt', mode='r') as f:contents = await f.read() # 文件已自动关闭 -

限制并发数:通过信号量或队列限制同时执行的任务数,避免因过多任务导致内存占用过高。

semaphore = asyncio.Semaphore(10)

7.2 任务调度优化

合理的任务调度能够提升异步程序的执行效率,减少等待时间。以下是一些任务调度优化的方法:

-

任务优先级:根据任务的重要性和紧急程度,设置不同的优先级,优先执行高优先级任务。

import asyncio import heapqclass PriorityTask:def __init__(self, priority, coro):self.priority = priorityself.coro = corodef __lt__(self, other):return self.priority < other.priorityasync def worker(queue):while True:priority_task = await queue.get()if priority_task is None:breakawait priority_task.coroqueue.task_done()async def main():queue = asyncio.Queue()workers = [asyncio.create_task(worker(queue)) for _ in range(3)]# 添加高优先级任务await queue.put(PriorityTask(1, fetch(session, url1, semaphore)))# 添加低优先级任务await queue.put(PriorityTask(10, fetch(session, url2, semaphore)))# 等待所有任务完成await queue.join()# 停止工作者for _ in workers:await queue.put(None)await asyncio.gather(*workers) -

任务分组:将相关任务分组处理,减少任务切换的开销。

async def process_group(group):tasks = [fetch(session, url, semaphore) for url in group]results = await asyncio.gather(*tasks)return results -

合理安排任务顺序:根据任务的依赖关系和执行时间,安排合适的任务顺序,优化整体执行时间。

7.3 调试与监控

在开发和维护异步程序时,调试和监控是确保程序稳定运行的重要环节。以下是一些调试与监控的技巧:

-

使用日志:在关键位置添加日志,记录程序的运行状态和异常信息,便于问题排查。

import logginglogging.basicConfig(level=logging.INFO)async def fetch(session, url, semaphore):try:async with semaphore:async with session.get(url) as response:data = await response.text()logging.info(f"成功获取URL: {url}")return dataexcept Exception as e:logging.error(f"请求失败: {url} | 错误: {e}")return None -

利用调试工具:使用

asyncio支持的调试工具,如pdb,结合断点调试,逐步排查问题。import asyncio import pdbasync def fetch(session, url, semaphore):pdb.set_trace()async with semaphore:async with session.get(url) as response:data = await response.text()return data -

监控事件循环:通过事件循环的监控工具,如

asyncio的debug模式,检测潜在的性能瓶颈和资源泄漏。import asyncioasync def main():loop = asyncio.get_running_loop()loop.set_debug(True)# 其他异步任务 -

使用第三方监控工具:集成第三方监控工具,如

aiohttp的中间件,监控请求的响应时间和错误率。

常见问题与解决方案

在使用asyncio进行异步编程时,开发者可能会遇到各种问题。以下是一些常见问题及其解决方案:

问题1:协程未被正确执行

症状: 定义的协程没有被执行,程序直接结束。

原因: 协程没有被提交给事件循环执行。

解决方案: 确保协程通过asyncio.run、loop.run_until_complete或asyncio.create_task等方式被正确执行。

示例代码:

import asyncioasync def say_hello():print("Hello, asyncio!")def main():say_hello() # 错误:协程未被执行asyncio.run(say_hello()) # 正确if __name__ == "__main__":main()

问题2:事件循环被多次关闭

症状: 报错信息提示“Event loop is closed”。

原因: 尝试在已关闭的事件循环上执行协程。

解决方案: 避免在事件循环关闭后再次使用它,或者重新创建一个新的事件循环。

示例代码:

import asyncioasync def main():print("Hello")def run_twice():asyncio.run(main())asyncio.run(main()) # 错误:事件循环已关闭if __name__ == "__main__":run_twice()

解决方法:

将两次运行放在不同的事件循环中,或避免重复关闭事件循环。

问题3:协程未被等待

症状: 协程未执行或部分任务未完成。

原因: 协程被定义但未被await或未提交为任务。

解决方案: 确保所有协程被await或通过asyncio.create_task提交给事件循环。

示例代码:

import asyncioasync def greet():print("Hello, World!")async def main():greet() # 错误:协程未被等待await greet() # 正确if __name__ == "__main__":asyncio.run(main())

问题4:阻塞操作阻塞事件循环

症状: 异步任务卡住,无法并发执行。

原因: 在异步程序中执行了阻塞操作(如time.sleep、CPU密集型计算等),阻塞了事件循环。

解决方案: 避免在异步程序中执行阻塞操作,或将阻塞操作放到线程池或进程池中执行。

示例代码:

import asyncio

import timeasync def blocking_task():time.sleep(2) # 错误:阻塞事件循环print("阻塞任务完成")async def main():await blocking_task()if __name__ == "__main__":asyncio.run(main())

正确做法:

使用asyncio.sleep替代time.sleep,或将阻塞任务放到线程池中执行。

import asyncio

import timeasync def blocking_task():loop = asyncio.get_running_loop()await loop.run_in_executor(None, time.sleep, 2) # 在默认线程池中执行阻塞操作print("阻塞任务完成")async def main():await blocking_task()if __name__ == "__main__":asyncio.run(main())

问题5:无法捕获异步任务中的异常

症状: 异步任务抛出的异常未被捕获,导致程序崩溃或行为异常。

原因: 异步任务中的异常未被正确处理。

解决方案: 在协程内部使用try-except块捕获异常,或在asyncio.gather中设置return_exceptions=True以便捕获所有异常。

示例代码:

import asyncioasync def faulty_task():raise ValueError("发生错误")async def main():tasks = [faulty_task()]results = await asyncio.gather(*tasks) # 默认情况下,异常会被抛出print(results)if __name__ == "__main__":asyncio.run(main())

输出:

Traceback (most recent call last):...

ValueError: 发生错误

解决方法:

使用try-except捕获异常,或设置return_exceptions=True。

import asyncioasync def faulty_task():raise ValueError("发生错误")async def main():tasks = [faulty_task()]results = await asyncio.gather(*tasks, return_exceptions=True)for result in results:if isinstance(result, Exception):print(f"捕获到异常: {result}")else:print(f"任务结果: {result}")if __name__ == "__main__":asyncio.run(main())

输出:

捕获到异常: 发生错误

结论

asyncio作为Python中用于编写高效异步代码的标准库,通过协程和事件循环的组合,为开发者提供了一种简洁而强大的异步编程模型。本文系统地介绍了asyncio的核心概念、协程与任务的管理方法,以及在处理IO密集型任务中的应用。通过详尽的代码示例和中文注释,展示了如何利用asyncio实现高效的异步任务调度,处理网络请求、文件操作和数据库访问等常见任务。

在实际项目中,asyncio的高级功能,如并发控制、超时处理和异常处理,进一步增强了异步程序的性能和稳定性。通过实战案例,读者能够掌握使用asyncio构建高效网络爬虫的技巧,并了解优化异步程序性能与响应性的最佳实践。

然而,异步编程也带来了一些挑战,如复杂的调试过程和对异步概念的深入理解要求。开发者需要熟练掌握asyncio的工作原理和最佳实践,才能充分发挥其优势,构建出高性能、响应迅速的应用程序。

随着异步编程在各类应用场景中的广泛应用,掌握asyncio将成为Python开发者提升程序性能和处理大规模并发任务的重要技能。通过不断学习和实践,开发者能够更好地应对现代软件开发中的高并发和高效能需求,推动技术创新和业务发展。

相关文章:

Python中的asyncio:高效的异步编程模型

随着互联网应用的快速发展,程序的响应性和处理效率成为衡量系统性能的重要指标。传统的同步编程模型在面对高并发和IO密集型任务时,常常显得捉襟见肘,难以满足现代应用的需求。Python的asyncio库作为一种高效的异步编程模型,为开发…...

Oopsie【hack the box】

Oopsie 解题流程 文件上传 首先开启机器后,我们先使用 nmap -sC -SV来扫描一下IP地址: -sC:使用 Nmap 的默认脚本扫描(通常是 NSE 脚本,Nmap Scripting Engine)。这个选项会自动执行一系列常见的脚本&am…...

详细介绍 React 中 i18n 的完整使用流程:

接下来按照步骤,让我们来完成! // 1. 首先安装必要的依赖 // npm install i18next react-i18next i18next-http-backend i18next-browser-languagedetector// 2. 创建 i18n 配置文件 (src/i18n/index.js) import i18n from i18next import { initReactI…...

部署:上传项目代码 配置数据库

一、上传代码 1、使用git 可以使用Git Clone。使用前,在服务器上也要创建秘钥对。这里的密钥对,是专门用来读取Git仓库的。 在宝塔上,点击终端。进来后,运行 ssh-keygen还是一路回车,密钥对就建好了。 接着用命令…...

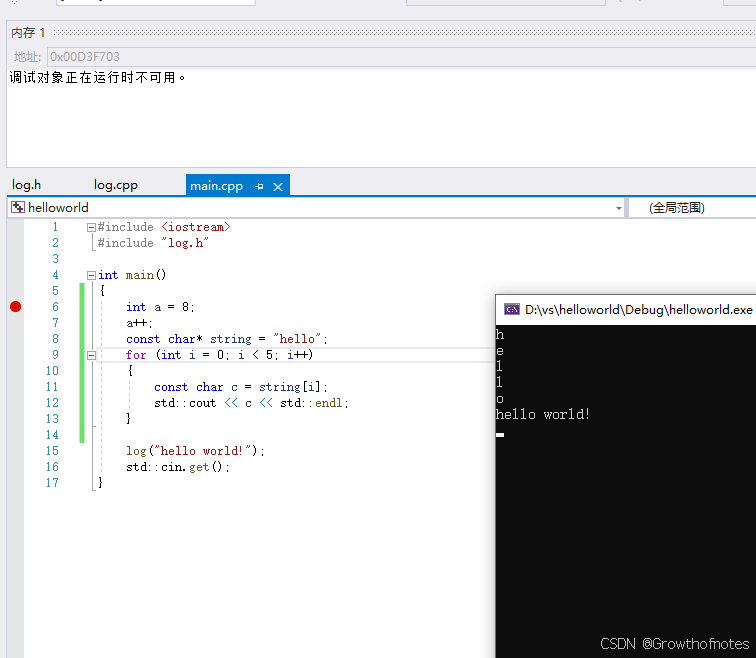

C++—9、如何在Microsoft Visual Studio中调试C++

本文通过实例操作来介绍 Visual Studio 调试器的功能。调试器在运行过程中可提供许多方法让你查看代码的情况。 你可以逐步浏览代码、查看变量中存储的值、设置对变量的监视以查看值何时改变、检查代码的执行路径、查看代码分支是否正在运行等等。本实例主要是设置断点及查看内…...

11. C 语言 作用域与变量使用技巧

本章目录: 前言一、作用域的分类局部变量示例: 全局变量示例:示例: 形式参数示例: 二、作用域的细节与常见误区块级作用域示例: 静态变量与全局变量的对比示例: 未初始化变量的影响示例: 三、实…...

【机器学习案列】学生抑郁可视化及预测分析

🧑 博主简介:曾任某智慧城市类企业算法总监,目前在美国市场的物流公司从事高级算法工程师一职,深耕人工智能领域,精通python数据挖掘、可视化、机器学习等,发表过AI相关的专利并多次在AI类比赛中获奖。CSDN…...

Perl语言的循环实现

Perl语言的循环实现 引言 Perl是一种强大的脚本语言,以其灵活的语法和强大的文本处理能力著称。无论是在系统管理、网络编程,还是在Web应用开发中,Perl都广泛应用于各种领域。循环是编程语言中一个极其重要的概念,它允许程序重复…...

SpringBoot项目——使用Spark对爬虫爬取下的数据进行清洗

随着互联网信息呈爆炸式增长,爬虫技术被广泛用于从海量网页中抓取有价值的数据。然而,爬取到的数据往往存在格式不规范、重复、噪声等诸多问题,需要高效的数据清洗流程来保障数据质量,Spark 在其中发挥了关键作用。 什么是Spark …...

分布式锁 Redis vs etcd

为什么要实现分布式锁?为什么需要分布式锁,分布式锁的作用是什么,哪些场景会使用到分布式锁?分布式锁的实现方式有哪些分布式锁的核心原理是什么 如何实现分布式锁redis(自旋锁版本)etcd 的分布式锁(互斥锁(信号控制)版本) 分布式锁对比redis vs etcd 总结 为什么要实现分布式…...

《深度剖析:开源与闭源模型,AI舞台上的不同角色》

在人工智能蓬勃发展的当下,模型的选择如同为一场战役挑选合适的武器,至关重要。开源模型与闭源模型作为AI领域的两大阵营,在性能和应用场景上展现出显著差异,深刻影响着开发者、企业以及整个行业的走向。 性能差异:实…...

Angular结合C#

在 Angular 2 及以上版本与 C#结合使用 REST API 的示例中,我们将分别展示前端 Angular 服务和后端 C# Web API 的实现。 一、前端:Angular 服务 生成 Angular 服务 使用 Angular CLI 生成一个新的服务,例如user.service.ts: ng…...

Spring——自动装配

假设一个场景: 一个人(Person)有一条狗(Dog)和一只猫(Cat),狗和猫都会叫,狗叫是“汪汪”,猫叫是“喵喵”,同时人还有一个自己的名字。 将上述场景 抽象出三个实体类&…...

Servlet与JSP:Java的秘密花园入口

1 Servlet概述 Servlet是Java Web应用中的一个核心组件,它是一个运行在服务器端的Java程序,可以响应客户端的请求并生成响应。Servlet为Web应用提供了一个统一的接口来处理HTTP请求。 2 Servlet的生命周期 Servlet的生命周期包括以下几个阶段ÿ…...

【Linux】Linux常见指令(上)

个人主页~ 初识Linux 一、Linux基本命令1、ls指令2、pwd命令3、cd指令4、touch指令5、mkdir指令6、rmdir指令7、rm指令8、man指令9、cp指令10、mv命令 Linux是一个开源的、稳定的、安全的、灵活的操作系统,Linux下的操作都是通过指令来实现的 一、Linux基本命令 先…...

ELFK日志采集实战

一、日志分析概述 日志分析是运维工程师解决系统故障,发现问题的主要手段 日志主要包括系统日志、应用程序日志和安全日志 系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因 经常分析日志可以了解服务器的负荷&#x…...

扩展API)

Kubernetes 使用自定义资源(CRD)扩展API

K8s CRD 即 Kubernetes CustomResourceDefinition,是 Kubernetes 提供的一种扩展机制,允许用户在 Kubernetes 集群中定义和使用自定义的资源类型。通过定义 CRD,用户可以在 Kubernetes 集群中创建、读取、更新和删除自定义资源对象࿰…...

用户使用LLM模型都在干什么?

Anthropic 对用户与 Claude 3.5 Sonnet 的大量匿名对话展开分析,主要发现及相关情况如下: 使用用途分布 软件开发主导:在各类使用场景中,软件开发占比最高,其中编码占 Claude 对话的 15% - 25%,网页和移动应…...

)

MySQL常用命令之汇总(Summary of Commonly Used Commands in MySQL)

MySQL常用命令汇总 简介 MySQL是一个广泛使用的开源关系型数据库管理系统,由瑞典的MySQL AB公司开发,现属于Oracle公司。 MySQL支持SQL(结构化查询语言),这是数据库操作的标准语言,用户可以使用SQL进…...

六年之约day10

今日开心∶今天部门开了个颁奖大会,看着别人收获的荣誉,还真有些羡慕,什么时候,我也能拥有属于自己的荣誉啊. 今日不开心∶活没干多少,对业务也不是很懂 今日思考∶很多事情,存在即合理.工作,…...

PHP和Node.js哪个更爽?

先说结论,rust完胜。 php:laravel,swoole,webman,最开始在苏宁的时候写了几年php,当时觉得php真的是世界上最好的语言,因为当初活在舒适圈里,不愿意跳出来,就好比当初活在…...

【Linux】C语言执行shell指令

在C语言中执行Shell指令 在C语言中,有几种方法可以执行Shell指令: 1. 使用system()函数 这是最简单的方法,包含在stdlib.h头文件中: #include <stdlib.h>int main() {system("ls -l"); // 执行ls -l命令retu…...

【解密LSTM、GRU如何解决传统RNN梯度消失问题】

解密LSTM与GRU:如何让RNN变得更聪明? 在深度学习的世界里,循环神经网络(RNN)以其卓越的序列数据处理能力广泛应用于自然语言处理、时间序列预测等领域。然而,传统RNN存在的一个严重问题——梯度消失&#…...

1688商品列表API与其他数据源的对接思路

将1688商品列表API与其他数据源对接时,需结合业务场景设计数据流转链路,重点关注数据格式兼容性、接口调用频率控制及数据一致性维护。以下是具体对接思路及关键技术点: 一、核心对接场景与目标 商品数据同步 场景:将1688商品信息…...

C++中string流知识详解和示例

一、概览与类体系 C 提供三种基于内存字符串的流,定义在 <sstream> 中: std::istringstream:输入流,从已有字符串中读取并解析。std::ostringstream:输出流,向内部缓冲区写入内容,最终取…...

WordPress插件:AI多语言写作与智能配图、免费AI模型、SEO文章生成

厌倦手动写WordPress文章?AI自动生成,效率提升10倍! 支持多语言、自动配图、定时发布,让内容创作更轻松! AI内容生成 → 不想每天写文章?AI一键生成高质量内容!多语言支持 → 跨境电商必备&am…...

html-<abbr> 缩写或首字母缩略词

定义与作用 <abbr> 标签用于表示缩写或首字母缩略词,它可以帮助用户更好地理解缩写的含义,尤其是对于那些不熟悉该缩写的用户。 title 属性的内容提供了缩写的详细说明。当用户将鼠标悬停在缩写上时,会显示一个提示框。 示例&#x…...

C++使用 new 来创建动态数组

问题: 不能使用变量定义数组大小 原因: 这是因为数组在内存中是连续存储的,编译器需要在编译阶段就确定数组的大小,以便正确地分配内存空间。如果允许使用变量来定义数组的大小,那么编译器就无法在编译时确定数组的大…...

云原生安全实战:API网关Kong的鉴权与限流详解

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 一、基础概念 1. API网关(API Gateway) API网关是微服务架构中的核心组件,负责统一管理所有API的流量入口。它像一座…...

实战三:开发网页端界面完成黑白视频转为彩色视频

一、需求描述 设计一个简单的视频上色应用,用户可以通过网页界面上传黑白视频,系统会自动将其转换为彩色视频。整个过程对用户来说非常简单直观,不需要了解技术细节。 效果图 二、实现思路 总体思路: 用户通过Gradio界面上…...