DeepSeek-R1 大模型本地部署指南

文章目录

- 一、系统要求

- 硬件要求

- 软件环境

- 二、部署流程

- 1. 环境准备

- 2. 模型获取

- 3. 推理代码配置

- 4. 启动推理服务

- 三、优化方案

- 1. 显存优化技术

- 2. 性能加速方案

- 四、部署验证

- 健康检查脚本

- 预期输出特征

- 五、常见问题解决

- 1. CUDA内存不足

- 2. 分词器警告处理

- 3. 多GPU部署

- 六、安全合规建议

一、系统要求

硬件要求

部署前需确保硬件满足最低要求:NVIDIA显卡(RTX 3090及以上)、24GB显存、64GB内存及500GB固态存储。

| 资源类型 | 最低配置 | 推荐配置 |

|---|---|---|

| GPU | NVIDIA GTX 1080Ti | RTX 3090/A100(40GB+) |

| VRAM | 12GB | 24GB+ |

| 内存 | 32GB DDR4 | 64GB DDR4 |

| 存储 | 100GB SSD | 500GB NVMe SSD |

软件环境

软件环境需安装Ubuntu 22.04系统、CUDA 11.7+驱动、Python 3.9及PyTorch 2.1框架,建议使用conda创建独立虚拟环境,安装transformers、accelerate等核心依赖库,并配置Flash Attention等加速组件。

- CUDA 11.7+

- cuDNN 8.5+

- Python 3.8-3.10

- PyTorch 2.0+

二、部署流程

1. 环境准备

# 创建虚拟环境

conda create -n deepseek-r1 python=3.9 -y

conda activate deepseek-r1# 安装基础依赖

pip install torch==2.1.2+cu117 --extra-index-url https://download.pytorch.org/whl/cu117

pip install transformers==4.35.0 accelerate sentencepiece

2. 模型获取

通过官方授权获取模型访问权限后,使用Git LFS克隆HuggingFace仓库下载模型文件(约70GB)。下载完成后需进行SHA256哈希校验,确保模型完整性。模型目录应包含pytorch_model.bin主权重文件、tokenizer分词器及配置文件,部署前需确认文件结构完整。

通过官方渠道获取模型权重(需申请权限):

git lfs install

git clone https://huggingface.co/deepseek-ai/deepseek-r1-7b-base

3. 推理代码配置

编写基础推理脚本,使用AutoModelForCausalLM加载模型至GPU,通过tokenizer处理输入文本。生产环境建议集成FastAPI搭建RESTful服务,配置Gunicorn多进程管理,启用HTTPS加密通信。启动时需设置温度参数(temperature)、重复惩罚系数(repetition_penalty)等生成策略,平衡输出质量与多样性。

创建inference.py:

from transformers import AutoModelForCausalLM, AutoTokenizer

import torchmodel_path = "./deepseek-r1-7b-base"

device = "cuda" if torch.cuda.is_available() else "cpu"# 加载模型和分词器

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(model_path,torch_dtype=torch.bfloat16,device_map="auto"

)# 推理示例

prompt = "北京的著名景点有哪些?"

inputs = tokenizer(prompt, return_tensors="pt").to(device)outputs = model.generate(**inputs,max_new_tokens=500,temperature=0.7,do_sample=True

)print(tokenizer.decode(outputs[0], skip_special_tokens=True))

4. 启动推理服务

# 基础启动

python inference.py# 启用量化(节省显存)

python inference.py --load_in_4bit# API服务模式(需安装fastapi)

uvicorn api:app --port 8000

三、优化方案

1. 显存优化技术

| 技术 | 命令参数 | VRAM节省量 |

|---|---|---|

| 4-bit量化 | --load_in_4bit | 60% |

| 8-bit量化 | --load_in_8bit | 40% |

| 梯度检查点 | --use_gradient_checkpointing | 25% |

2. 性能加速方案

针对显存限制可采用4/8-bit量化技术,降低50%-75%显存占用。启用Flash Attention 2加速注意力计算,提升30%推理速度。多GPU环境使用Deepspeed进行分布式推理,通过TensorRT转换模型提升计算效率。同时配置显存分块加载机制,支持大文本生成场景。

# 使用Flash Attention 2

pip install flash-attn --no-build-isolation

model = AutoModelForCausalLM.from_pretrained(..., use_flash_attention_2=True)# 启用TensorRT加速

pip install transformers[torch-tensorrt]

model = torch_tensorrt.compile(model, inputs=...)

四、部署验证

健康检查脚本

import requestsAPI_ENDPOINT = "http://localhost:8000/generate"def health_check():test_payload = {"prompt": "你好","max_tokens": 50}response = requests.post(API_ENDPOINT, json=test_payload)return response.json()print("Service status:", health_check()["status"])

预期输出特征

- 响应时间:<5秒(首次加载除外)

- Token生成速度:>20 tokens/sec(3090)

- 显存占用波动范围:±5%

五、常见问题解决

1. CUDA内存不足

# 解决方案:启用分块加载

model = AutoModelForCausalLM.from_pretrained(...,device_map="auto",offload_folder="offload",offload_state_dict=True

)

2. 分词器警告处理

tokenizer = AutoTokenizer.from_pretrained(model_path,trust_remote_code=True,use_fast=False

)

3. 多GPU部署

# 指定GPU设备

CUDA_VISIBLE_DEVICES=0,1 python inference.py --tensor_parallel_size=2

六、安全合规建议

- 网络隔离:建议在内网环境部署

- 访问控制:配置API密钥认证

- 日志审计:记录所有推理请求

- 内容过滤:集成敏感词过滤模块

注意事项:

- 模型权重需从官方授权渠道获取

- 首次运行会自动下载分词器文件(约500MB)

- 建议使用NVIDIA驱动版本525.85+

- 完整部署流程耗时约30-60分钟(依赖网络速度)

相关文章:

DeepSeek-R1 大模型本地部署指南

文章目录 一、系统要求硬件要求软件环境 二、部署流程1. 环境准备2. 模型获取3. 推理代码配置4. 启动推理服务 三、优化方案1. 显存优化技术2. 性能加速方案 四、部署验证健康检查脚本预期输出特征 五、常见问题解决1. CUDA内存不足2. 分词器警告处理3. 多GPU部署 六、安全合规…...

在conda环境下,安装Pytorch和CUDA

系统 : Ubuntu20.04 显卡:NVIDIA GTX1650 显卡驱动已经装好(命令 nvidia-smi 查看显卡配置) (主要看一下第一行的参数,最大支持的CUDA版本为12.4 ) Aanconda 版本(安装指南)(似乎…...

Java里int和Integer的区别?

大家好,我是锋哥。今天分享关于【Java里int和Integer的区别?】面试题。希望对大家有帮助; Java里int和Integer的区别? 1000道 互联网大厂Java工程师 精选面试题-Java资源分享网 在 Java 中,int 和 Integer 都是用来表…...

【第13章:自监督学习与少样本学习—13.4 自监督学习与少样本学习的未来研究方向与挑战】

凌晨三点的实验室里,博士生小张盯着屏幕上的训练曲线——他设计的跨模态少样本学习模型在医疗影像诊断任务上突然出现了诡异的性能断崖。前一秒还在92%的准确率高位运行,下一秒就暴跌到47%。这个看似灾难性的现象,却意外揭开了自监督学习与少样本学习技术深藏的核心挑战… 一…...

【NLP】文本预处理

目录 一、文本处理的基本方法 1.1 分词 1.2 命名体实体识别 1.3 词性标注 二、文本张量的表示形式 2.1 one-hot编码 2.2 word2vec 模型 2.2.1 CBOW模式 2.2.2 skipgram模式 2.3 词嵌入word embedding 三、文本数据分析 3.1 标签数量分布 3.2 句子长度分布 3.3 词…...

deepseek r1从零搭建本地知识库10:嵌入模型和知识库建设

一、嵌入模型(Embedding Model)是什么? 1. 定义 嵌入模型是一种将文本、图像、音频等非结构化数据转化为**低维稠密向量(Dense Vector)**的算法模型,这些向量(通常几百到几千维)能够…...

Linux-文件IO

1.open函数 【1】基本概念和使用 #include <fcntl.h> int open(const char *pathname,int flags); int open(const char *pathname,int flags,mode_t mode); 功能: 打开或创建文件 参数: pathname //打开的文件名 f…...

3d pose 学习笔记2025

目录 champ nlf 3dpose 2025 55个关键点 推理代码: 要设置环境变量: 依赖项metrabs 渲染代码: tram4d 脚也不是特别好 GVHMR脚对不齐 推理代码: multiperson 2023年 genhmr还没开源: champ https://zhuanlan.zhihu.com/p/700326554 nlf 3dpose 2025 55个关键点…...

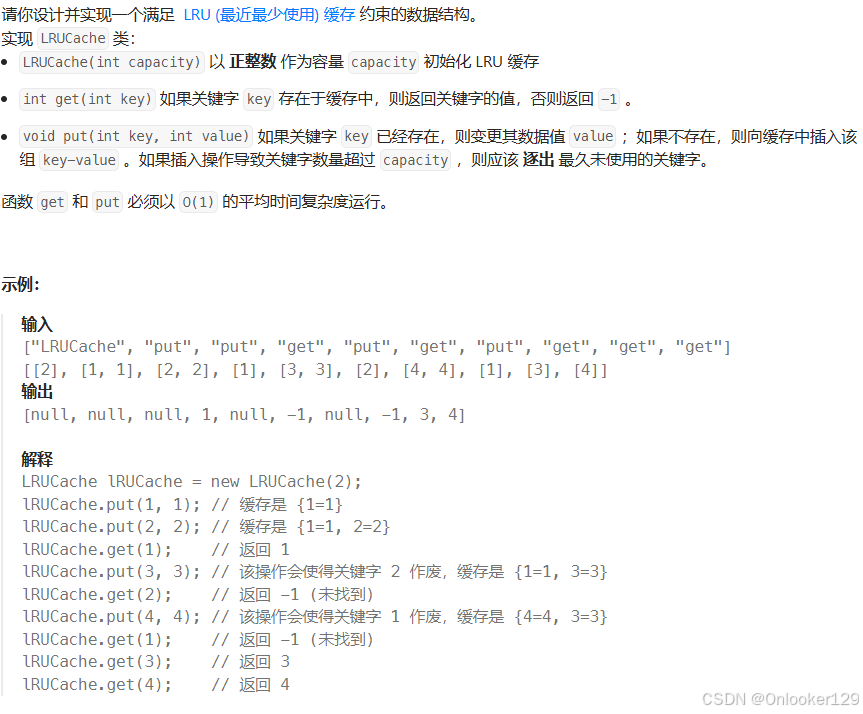

LC-随机链表的复制、排序链表、合并K个升序链表、LRU缓存

随机链表的复制 为了在 O(n) 时间复杂度内解决这个问题,并且使用 O(1) 的额外空间,可以利用以下技巧: 将新节点插入到原节点后面:我们可以将复制节点插入到原节点后面。例如,如果链表是 A -> B -> C,…...

静态页面在安卓端可以正常显示,但是在ios打开这个页面就需要刷新才能显示全图片

这个问题可能有几个原因导致,我来分析一下并给出解决方案: 首要问题是懒加载实现方式的兼容性问题。当前的懒加载实现可能在 iOS 上不够稳定。建议修改图片懒加载的实现方式: // 使用 Intersection Observer API 实现懒加载 function initLazyLoading() {const imageObserver…...

【ESP32指向鼠标】)

四元数如何用于 3D 旋转(代替欧拉角和旋转矩阵)【ESP32指向鼠标】

四元数如何用于 3D 旋转(代替欧拉角和旋转矩阵) 在三维空间中,物体的旋转可以用 欧拉角、旋转矩阵 或 四元数 来表示。 四元数相比于欧拉角和旋转矩阵有 计算更高效、避免万向锁、存储占用少 等优点,因此广泛用于 游戏开发、机器…...

JavaScript 内置对象-日期对象

在JavaScript中,处理日期和时间是一个常见的需求。无论是显示当前时间、计算两个日期之间的差异,还是格式化日期字符串,Date 对象都能提供强大的支持。本文将详细介绍 Date 对象的使用方法,包括创建日期实例、获取和设置日期值、以…...

本地大模型编程实战(19)RAG(Retrieval Augmented Generation,检索增强生成)(3)

文章目录 准备创建矢量数据库对象创建 LangGraph 链将检索步骤转化为工具定义节点构建图 见证效果qwen2.5llama3.1MFDoom/deepseek-r1-tool-calling:7b 总结代码参考 上一篇文章我们演练了一个 用 langgraph 实现的 RAG(Retrieval Augmented Generation,检索增强生成) 系统。本…...

DeepSeek与ChatGPT:AI语言模型的全面对决

DeepSeek与ChatGPT:AI语言模型的全面对决 引言:AI 语言模型的时代浪潮一、认识 DeepSeek 与 ChatGPT(一)DeepSeek:国产新星的崛起(二)ChatGPT:AI 界的开拓者 二、DeepSeek 与 ChatGP…...

2024年年终总结

2024年终于过去了,这绝对是我人生中最惨痛的一年!被小人欺骗、被庸人耽误、被自己蠢到!不由的让我想起了22年那次算命,算命先生说我十年低谷期,如果从15年进创业公司开始,24年是最后一年,果然应…...

利用 Valgrind 检测 C++ 内存泄露

Valgrind 是一款运行在 Linux 系统上的编程工具集,主要用于调试和分析程序的性能、内存使用等问题。其中最常用的工具是 Memcheck,它可以帮助检测 C 和 C 程序中的内存管理错误,如内存泄漏、使用未初始化的内存、越界访问等。 安装 这里我以…...

Python中的HTTP客户端库:httpx与request | python小知识

Python中的HTTP客户端库:httpx与request | python小知识 在Python中,发送HTTP请求和处理响应是网络编程的基础。requests和httpx是两个常用的HTTP库,它们都提供了简洁易用的API来发送HTTP请求。然而,httpx作为新一代的HTTP客户端…...

【Python】Python入门基础——环境搭建

学习Python,首先需要搭建一个本地开发环境,或是使用线上开发环境(各类练习网站),这里主要记录本地开发环境的配置。 目录: 一、下载和安装python解释器 官网下载地址:Download Python | Pytho…...

2025 pwn_A_childs_dream

文章目录 fc/sfc mesen下载和使用推荐 fc/sfc https://www.mesen.ca/docs/ mesen2安装,vscode安装zg 任天堂yyds w d 左右移动 u结束游戏 i崩溃或者卡死了 L暂停 D658地方有个flag 发现DEEE会使用他。且只有这个地方,maybe会输出flag,应…...

面试题整理:操作系统

文章目录 操作系统操作系统基础1. 操作系统的功能?2. 什么是用户态和内核态? 进程和线程1. 是什么?区别?2. ⭐线程间的同步的方式有哪些?3. PCB 是什么?包含哪些信息?4. 进程的状态有哪些&#…...

React 第五十五节 Router 中 useAsyncError的使用详解

前言 useAsyncError 是 React Router v6.4 引入的一个钩子,用于处理异步操作(如数据加载)中的错误。下面我将详细解释其用途并提供代码示例。 一、useAsyncError 用途 处理异步错误:捕获在 loader 或 action 中发生的异步错误替…...

MFC内存泄露

1、泄露代码示例 void X::SetApplicationBtn() {CMFCRibbonApplicationButton* pBtn GetApplicationButton();// 获取 Ribbon Bar 指针// 创建自定义按钮CCustomRibbonAppButton* pCustomButton new CCustomRibbonAppButton();pCustomButton->SetImage(IDB_BITMAP_Jdp26)…...

基于当前项目通过npm包形式暴露公共组件

1.package.sjon文件配置 其中xh-flowable就是暴露出去的npm包名 2.创建tpyes文件夹,并新增内容 3.创建package文件夹...

MMaDA: Multimodal Large Diffusion Language Models

CODE : https://github.com/Gen-Verse/MMaDA Abstract 我们介绍了一种新型的多模态扩散基础模型MMaDA,它被设计用于在文本推理、多模态理解和文本到图像生成等不同领域实现卓越的性能。该方法的特点是三个关键创新:(i) MMaDA采用统一的扩散架构…...

华硕a豆14 Air香氛版,美学与科技的馨香融合

在快节奏的现代生活中,我们渴望一个能激发创想、愉悦感官的工作与生活伙伴,它不仅是冰冷的科技工具,更能触动我们内心深处的细腻情感。正是在这样的期许下,华硕a豆14 Air香氛版翩然而至,它以一种前所未有的方式&#x…...

【从零开始学习JVM | 第四篇】类加载器和双亲委派机制(高频面试题)

前言: 双亲委派机制对于面试这块来说非常重要,在实际开发中也是经常遇见需要打破双亲委派的需求,今天我们一起来探索一下什么是双亲委派机制,在此之前我们先介绍一下类的加载器。 目录 编辑 前言: 类加载器 1. …...

ubuntu22.04有线网络无法连接,图标也没了

今天突然无法有线网络无法连接任何设备,并且图标都没了 错误案例 往上一顿搜索,试了很多博客都不行,比如 Ubuntu22.04右上角网络图标消失 最后解决的办法 下载网卡驱动,重新安装 操作步骤 查看自己网卡的型号 lspci | gre…...

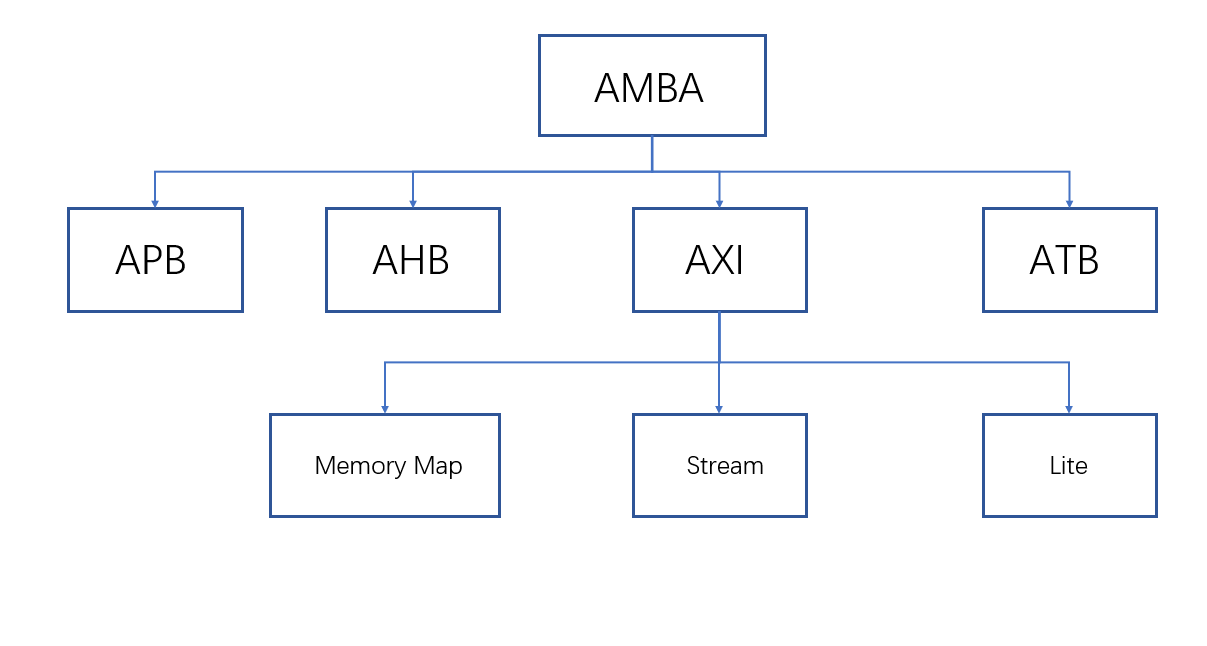

ZYNQ学习记录FPGA(一)ZYNQ简介

一、知识准备 1.一些术语,缩写和概念: 1)ZYNQ全称:ZYNQ7000 All Pgrammable SoC 2)SoC:system on chips(片上系统),对比集成电路的SoB(system on board) 3)ARM:处理器…...

Redis上篇--知识点总结

Redis上篇–解析 本文大部分知识整理自网上,在正文结束后都会附上参考地址。如果想要深入或者详细学习可以通过文末链接跳转学习。 1. 基本介绍 Redis 是一个开源的、高性能的 内存键值数据库,Redis 的键值对中的 key 就是字符串对象,而 val…...

基于Uniapp的HarmonyOS 5.0体育应用开发攻略

一、技术架构设计 1.混合开发框架选型 (1)使用Uniapp 3.8版本支持ArkTS编译 (2)通过uni-harmony插件调用原生能力 (3)分层架构设计: graph TDA[UI层] -->|Vue语法| B(Uniapp框架)B --&g…...