Python爬虫系列教程之第十四篇:爬虫项目部署、调度与监控系统

大家好,欢迎继续关注本系列爬虫教程!

在前面的文章中,我们已经详细讲解了如何构建爬虫、如何处理反爬、如何实现分布式爬虫以及如何使用 Scrapy 框架开发高效的爬虫项目。随着项目规模的不断扩大,如何将爬虫项目稳定部署到生产环境、如何合理调度任务以及如何实时监控爬虫的运行状态就变得尤为重要。本篇博客将从以下几个方面进行讲解:

- 为什么需要部署、调度与监控系统

- 常用的任务调度方案及其实现

- 爬虫监控与自动重启策略

- 部署建议与集成监控工具

通过本文,你将了解如何构建一个完善的爬虫项目生产体系,确保爬虫在大规模数据抓取任务中保持高效、稳定和健壮。

1. 部署、调度与监控系统的重要性

在生产环境中,爬虫项目往往需要持续长时间运行,并定时抓取数据。单纯依靠手动启动与管理不仅效率低下,还可能在遇到网络波动、目标网站异常或爬虫自身异常时导致任务中断。因此,构建一套完善的部署、调度与监控系统尤为关键,其主要优势包括:

- 自动化调度:定时启动爬虫任务,避免人工干预,确保数据更新及时。

- 容错与自动重启:在爬虫出现异常或进程意外退出时,系统能够自动检测并重启任务。

- 实时监控:通过日志、告警与监控平台,实时掌握爬虫运行状态,及时发现并处理问题。

- 高效资源利用:合理调度任务,分散请求压力,降低目标网站封禁风险,同时提高数据抓取效率。

2. 任务调度方案及实现

在实际生产环境中,有多种任务调度工具可以选择,例如 Cron、Celery、Airflow 以及 APScheduler 等。针对爬虫任务,我们通常需要轻量级且易于配置的调度器。这里我们以 APScheduler 为例,介绍如何实现简单的爬虫任务调度。

2.1 APScheduler简介

APScheduler(Advanced Python Scheduler)是一个基于 Python 的轻量级任务调度器,支持定时执行任务。它提供了多种调度方式,包括间隔调度、定时调度和 Cron 表达式调度,能够满足绝大多数爬虫任务的调度需求。

2.2 示例:使用APScheduler调度爬虫任务

下面的代码示例演示如何利用 APScheduler 定时执行一个简单的爬虫任务。代码中包含详细的中文注释,便于大家理解每一步的作用。

from apscheduler.schedulers.blocking import BlockingScheduler

import requests

import logging

import time# 配置日志记录:将调度器和爬虫任务的日志输出到控制台

logging.basicConfig(level=logging.INFO,format='%(asctime)s - %(levelname)s - %(message)s'

)def crawl_task():"""定义爬虫任务函数:模拟发送HTTP请求并记录返回数据的长度"""try:# 目标URL(此处以示例网站为例)url = "https://www.example.com"# 发送HTTP GET请求,并设置超时时间为10秒response = requests.get(url, timeout=10)# 如果响应状态码不是200,将抛出异常response.raise_for_status()# 记录成功抓取的信息logging.info(f"成功抓取页面: {url} - 数据长度: {len(response.text)}")except Exception as e:# 捕获异常并记录错误日志logging.error(f"爬虫任务执行异常: {e}")if __name__ == '__main__':# 创建BlockingScheduler调度器,适合在单机环境下调度任务scheduler = BlockingScheduler()# 添加任务:每隔1分钟执行一次crawl_task函数scheduler.add_job(crawl_task, 'interval', minutes=1)logging.info("启动爬虫任务调度器...")try:# 启动调度器,将一直阻塞等待任务调度scheduler.start()except (KeyboardInterrupt, SystemExit):logging.info("爬虫调度器已停止")

2.3 代码说明

- 调度器创建:通过

BlockingScheduler创建一个阻塞调度器,适合在单进程中调度任务。 - 任务添加:使用

add_job方法将crawl_task函数添加到调度器中,设定以间隔1分钟执行。 - 日志记录:借助

logging模块记录任务调度和爬虫运行的信息,便于监控和调试。 - 异常捕获:在任务执行过程中,通过

try...except捕获异常,确保调度器不会因为单个任务失败而中断。

3. 爬虫监控与自动重启

在长时间运行的爬虫项目中,进程意外退出、内存泄漏或网络故障都可能导致爬虫中断。为了解决这一问题,我们需要构建一套自动监控与重启系统。常用的方案包括:

- Supervisor 或 systemd:通过系统级工具监控爬虫进程,并在进程退出时自动重启。

- 自定义监控脚本:利用 Python 编写监控脚本,定期检测爬虫进程状态,并在异常时自动重启。

3.1 使用 Supervisor 管理爬虫进程

Supervisor 是一款进程管理工具,能够监控并自动重启进程。配置 Supervisor 非常简单,只需创建一个配置文件,例如 crawler.conf:

[program:crawler]

command=python /path/to/your/crawler.py

directory=/path/to/your/project

autostart=true

autorestart=true

stderr_logfile=/path/to/your/logs/crawler.err.log

stdout_logfile=/path/to/your/logs/crawler.out.log

通过 Supervisor 启动和管理爬虫进程,能够确保在爬虫意外退出时自动重启,提高项目的可靠性。

3.2 自定义监控脚本示例

如果希望在应用层面实现简单的监控和自动重启,可以使用 Python 的 psutil 和 subprocess 模块编写监控脚本。下面的示例代码演示了如何检查指定的爬虫进程是否在运行,若未运行则自动重启该进程。

注意:请确保已安装

psutil模块,可通过pip install psutil安装。

import psutil

import subprocess

import time

import logging# 配置日志记录,记录监控脚本运行情况

logging.basicConfig(level=logging.INFO,format='%(asctime)s - %(levelname)s - %(message)s'

)def is_crawler_running(process_name="crawler.py"):"""检查是否有包含 process_name 的爬虫进程正在运行:param process_name: 要检查的进程名称或关键字:return: True 如果进程正在运行,否则返回 False"""for proc in psutil.process_iter(['pid', 'name', 'cmdline']):try:# 检查进程命令行中是否包含指定的进程名称if process_name in ' '.join(proc.info['cmdline']):return Trueexcept Exception as e:logging.error(f"检查进程时发生异常: {e}")return Falsedef start_crawler():"""启动爬虫进程"""logging.info("启动爬虫进程...")# 使用subprocess启动爬虫,注意替换脚本路径subprocess.Popen(["python", "crawler.py"])if __name__ == '__main__':# 定义监控间隔,单位为秒monitor_interval = 30logging.info("启动爬虫监控系统...")while True:if not is_crawler_running():logging.warning("爬虫进程未运行,尝试重启...")start_crawler()else:logging.info("爬虫进程运行正常")# 每隔monitor_interval秒检查一次time.sleep(monitor_interval)

3.3 代码说明

- 进程检测:通过

psutil.process_iter遍历当前所有进程,并检查命令行中是否包含指定的爬虫脚本名称。 - 自动重启:如果检测到爬虫进程未运行,则调用

subprocess.Popen启动爬虫。 - 日志记录:整个监控流程均使用

logging模块记录运行信息,便于后续问题排查。

4. 部署建议与监控工具集成

在实际生产中,除了上述调度和监控脚本外,还可以结合以下工具和技术提升爬虫项目的稳定性和管理效率:

4.1 Docker化部署

- 容器化:将爬虫项目封装成 Docker 镜像,使得项目在不同环境下运行时配置一致,便于扩展和维护。

- Docker Compose:使用 Compose 文件管理多个容器(例如爬虫、Redis、数据库、监控工具等),构建完整的数据采集与处理系统。

4.2 集成监控平台

- Prometheus & Grafana:通过 Prometheus 采集爬虫的运行指标(如请求成功率、响应时间、内存使用等),并使用 Grafana 构建实时监控面板。

- ELK Stack:利用 Elasticsearch、Logstash 与 Kibana 对爬虫日志进行集中管理和分析,快速定位问题。

4.3 使用系统级服务管理

- systemd:在 Linux 系统中,通过 systemd 编写服务单元文件管理爬虫进程,实现开机自启、异常重启及日志管理。

- Supervisor:前文提到的 Supervisor 也是一个优秀的进程管理工具,适用于多进程环境的监控与自动重启。

5. 实践案例总结

在本篇博客中,我们详细讲解了爬虫项目从部署、任务调度到运行监控的全过程。主要内容包括:

-

部署与调度:

- 介绍了使用 APScheduler 实现定时任务调度的基本方法,确保爬虫任务能按照预定间隔自动执行。

- 讨论了使用 Cron、Celery、Airflow 等工具的优势,并推荐在轻量级场景下使用 APScheduler。

-

监控与自动重启:

- 讲解了如何利用系统级工具(如 Supervisor、systemd)或编写自定义监控脚本来检测爬虫进程状态,确保爬虫在异常退出时能自动重启。

- 提供了基于 Python 的监控脚本示例,通过 psutil 模块检测进程状态,并利用 subprocess 模块启动爬虫进程。

-

部署建议与工具集成:

- 提出了将爬虫项目 Docker 化的部署建议,便于环境统一和扩展。

- 介绍了如何结合 Prometheus、Grafana、ELK Stack 等监控工具,实现对爬虫运行指标和日志的实时监控与分析。

通过上述部署、调度与监控系统的构建,我们不仅能保证爬虫任务的持续稳定运行,还可以在出现异常时快速响应,及时修复问题。这对于需要长时间、大规模数据抓取的爬虫项目来说至关重要。

6. 总结与展望

构建一个高效、稳定的爬虫生产体系,不仅仅是编写高质量的爬虫代码,更需要关注任务调度、自动监控与异常处理等环节。本文从任务调度、自动重启、日志记录等多个角度,详细介绍了如何构建完善的爬虫项目部署与监控系统,为生产环境下的爬虫项目提供了实用的解决方案。

在未来的工作中,你可以尝试将本文介绍的技术与现有的监控平台(如 Prometheus、Grafana)进行深度集成,进一步提升爬虫项目的自动化管理和故障预警能力。同时,结合 Docker 和 Kubernetes 等容器编排工具,实现爬虫项目的弹性扩展与高可用部署,将使整个数据采集系统更具竞争力。

希望本篇博客能够为你在生产环境中部署和管理爬虫项目提供有价值的参考和帮助。如果你有任何问题或建议,欢迎在评论区留言讨论,也请点赞、收藏并分享给更多的朋友!我们下篇博客再见!

相关文章:

Python爬虫系列教程之第十四篇:爬虫项目部署、调度与监控系统

大家好,欢迎继续关注本系列爬虫教程! 在前面的文章中,我们已经详细讲解了如何构建爬虫、如何处理反爬、如何实现分布式爬虫以及如何使用 Scrapy 框架开发高效的爬虫项目。随着项目规模的不断扩大,如何将爬虫项目稳定部署到生产环境…...

线程与进程的深入解析及 Linux 线程编程

在操作系统中,进程和线程是进行并发执行的两种基本单位。理解它们的区别和各自的特点,能够帮助开发者更好地进行多任务编程,提高程序的并发性能。本文将探讨进程和线程的基础概念,及其在 Linux 系统中的实现方式,并介绍…...

在ubuntu上用Python的openpyxl模块操作Excel的案例

文章目录 安装模块读取Excel数据库取数匹配数据和更新Excel数据 在Ubuntu系统的环境下基本职能借助Python的openpyxl模块实现对Excel数据的操作。 安装模块 本次需要用到的模块需要提前安装(如果没有的话) pip3 install openpyxl pip3 install pymysql在操作前,需…...

【OS安装与使用】part6-ubuntu 22.04+CUDA 12.4运行MARL算法(多智能体强化学习)

文章目录 一、待解决问题1.1 问题描述1.2 解决方法 二、方法详述2.1 必要说明2.2 应用步骤2.2.1 下载源码并安装2.2.2 安装缺失的依赖项2.2.3 训练执行MAPPO算法实例 三、疑问四、总结 一、待解决问题 1.1 问题描述 已配置好基础的运行环境,尝试运行MARL算法。 1…...

】解锁Python多进程爬虫:高效数据抓取秘籍)

【Python爬虫(35)】解锁Python多进程爬虫:高效数据抓取秘籍

【Python爬虫】专栏简介:本专栏是 Python 爬虫领域的集大成之作,共 100 章节。从 Python 基础语法、爬虫入门知识讲起,深入探讨反爬虫、多线程、分布式等进阶技术。以大量实例为支撑,覆盖网页、图片、音频等各类数据爬取ÿ…...

HarmonyOS 开发套件 介绍 ——上篇

HarmonyOS 开发套件 介绍 ——上篇 在当今科技飞速发展的时代,操作系统作为智能设备的核心,其重要性不言而喻。而HarmonyOS,作为华为推出的全新操作系统,正以其独特的魅力和强大的功能,吸引着越来越多的开发者和用户的…...

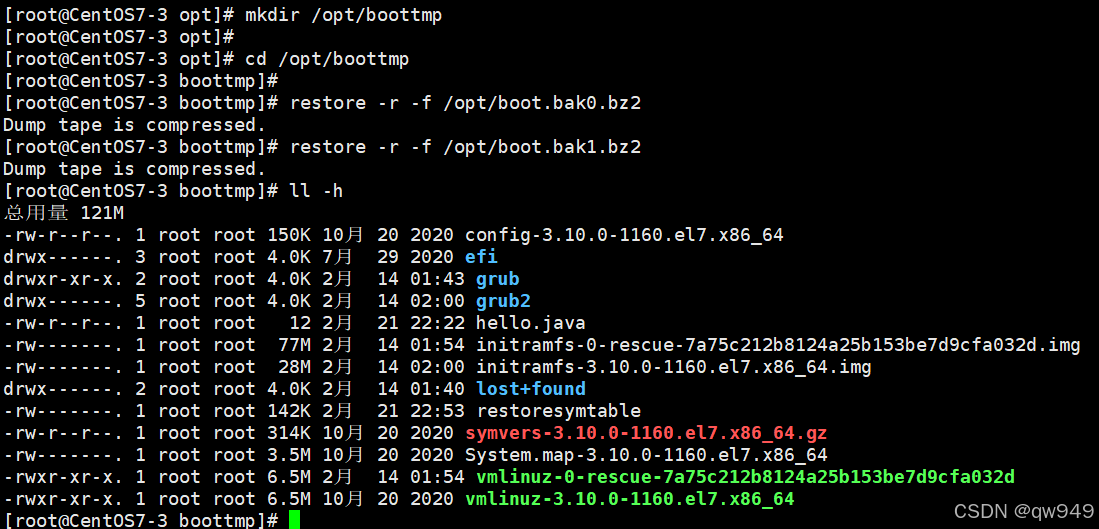

Linux 高级篇 日志管理、定制自己的Linux系统、备份与恢复

一、日志管理 (1)基本介绍 日志文件是重要的系统信息文件,记录了如用户登录、系统启动、系统安全、邮件及各种服务等相关重要系统事件在安全方面,日志也至关重要,它能记录系统日常发生的各类事情,可用于检…...

deepseek与其他大模型配合组合

DeepSeek与其他大模型的配合组合,展现了其在多个领域中的强大应用潜力和灵活性。以下是对DeepSeek与其他大模型配合组合的详细分析: 一、DeepSeek与华知大模型的组合 背景介绍: 华知大模型是同方知网与华为联手打造的,具备全学科…...

经验分享—WEB渗透测试中遇到加密内容的数据包该如何测试!

经验分享—WEB渗透测试中遇到加密内容的数据包该如何测试! 01 加解密的意义 现阶段的渗透测试让我发现越来越多的系统不只是在漏洞修补方面做了功夫,还对一些参数进行加密,干扰爬虫或者渗透测试的进行。 在我小白阶段看到下图这种加密方式…...

JUC并发—9.并发安全集合四

大纲 1.并发安全的数组列表CopyOnWriteArrayList 2.并发安全的链表队列ConcurrentLinkedQueue 3.并发编程中的阻塞队列概述 4.JUC的各种阻塞队列介绍 5.LinkedBlockingQueue的具体实现原理 6.基于两个队列实现的集群同步机制 4.JUC的各种阻塞队列介绍 (1)基于数组的阻塞…...

JSON格式,C语言自己实现,以及直接调用库函数(一)

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。以下为你提供不同场景下常见的 JSON 格式示例。 1. 简单对象 JSON 对象是由键值对组成,用花括号 {} 包裹&…...

MinkowskiEngine安装(CUDA11.8+torch2.0.1+RTX4070TI)

1、背景 1)因为项目要用这个库:MinkowskiEngine,Minkowski Engine — MinkowskiEngine 0.5.3 documentation 然后就用了之前安装好 MinkowskiEngine 的torch1.8.1,cuda11.1的环境。 2)自己的代码出现cuda不支持torch用gpu进行矩…...

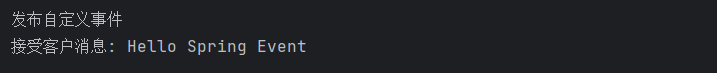

Spring监听器Listener

目录 1、Spring监听器简介 2、事件(Event) 3、监听器(Listener) 3、事件发布器 4、监听器使用 4.1、自定义事件 4.2、自定义监听器 4.3、发布事件 4.4、测试 4.5、使用注解方式监听 4.6、异步事件处理 5、总结 1、Spri…...

【深度学习在图像配准中的应用与挑战】

图像配准在深度学习中的解决方案越来越多,尤其是通过卷积神经网络(CNN)和生成对抗网络(GAN)等方法,可以显著提升图像配准的效果,尤其是在处理复杂的非刚性变换和大范围的图像差异时。 1. 基于深…...

使用 Docker-compose 部署 MySQL

使用 Docker Compose 部署 MySQL 本文将详细指导如何使用 docker-compose 部署 MySQL,包括基本配置、启动步骤、数据持久化以及一些高级选项。通过容器化部署 MySQL,你可以快速搭建一个隔离的数据库环境,适用于开发、测试或小型生产场景。 关…...

blender笔记2

一、物体贴地 物体->变换->对齐物体 ->对齐弹窗(对齐模式:反方,相对于:场景原点,对齐:z)。 之后可以设置原点->原点--3d游标 二、面上有阴影 在编辑模式下操作过后,物体面有阴影。 数据-&g…...

特殊符号_符号图案_特殊符号大全

特殊符号↑返回顶部 © ℗ ร ಗ ย ☫ ౖ ஃ ⁜ ☊ ☋ ❡ ๑ ి ▧ ◘ ▩ ▣ ◙ ▨ ۞ ۩ ಔ ృ ☎ ☏ ⍝ ⍦ ▤ ▥ ▦ ✠ @ ಓ ↂ ూ ☮ ி ﺴ ✈ ✉ ✁ ✎ ✐ 〄 # ‡ ☪ ⌚ ☢ ▪ ▫ ✆ ✑ ✒ ☌ ❢ ▬ ☍ □ ■ ؟ ‼ ‽ ☭ ✏ ⌨…...

Unity学习part4

1、ui界面的基础使用 ui可以在2d和矩形工具界面下操作,更方便,画布与游戏窗口的比例一般默认相同 如图所示,图片在画布上显示的位置和在游戏窗口上显示的位置是相同的 渲染模式:屏幕空间--覆盖,指画布覆盖在游戏物体渲…...

【AI绘画】大卫• 霍克尼风格——自然的魔法(一丹一世界)

大卫• 霍克尼,很喜欢这个老头,“艺术是一场战斗”。老先生零九年有了iphone,开始用iphone画画,一零年开始用ipad画画,用指头划拉,据说五分钟就能画一幅,每天早上随手画几幅送给身边的朋友。很c…...

MySQL日志undo log、redo log和binlog详解

MySQL 日志:undo log、redo log、binlog 有什么用? 一、前言 在MySQL数据库中,undo log、redo log和binlog这三种日志扮演着至关重要的角色,它们各自承担着不同的功能,共同保障了数据库的正常运行和数据的完整性。了解…...

谷歌浏览器插件

项目中有时候会用到插件 sync-cookie-extension1.0.0:开发环境同步测试 cookie 至 localhost,便于本地请求服务携带 cookie 参考地址:https://juejin.cn/post/7139354571712757767 里面有源码下载下来,加在到扩展即可使用FeHelp…...

Lombok 的 @Data 注解失效,未生成 getter/setter 方法引发的HTTP 406 错误

HTTP 状态码 406 (Not Acceptable) 和 500 (Internal Server Error) 是两类完全不同的错误,它们的含义、原因和解决方法都有显著区别。以下是详细对比: 1. HTTP 406 (Not Acceptable) 含义: 客户端请求的内容类型与服务器支持的内容类型不匹…...

)

Java 语言特性(面试系列1)

一、面向对象编程 1. 封装(Encapsulation) 定义:将数据(属性)和操作数据的方法绑定在一起,通过访问控制符(private、protected、public)隐藏内部实现细节。示例: public …...

C++:std::is_convertible

C++标志库中提供is_convertible,可以测试一种类型是否可以转换为另一只类型: template <class From, class To> struct is_convertible; 使用举例: #include <iostream> #include <string>using namespace std;struct A { }; struct B : A { };int main…...

大型活动交通拥堵治理的视觉算法应用

大型活动下智慧交通的视觉分析应用 一、背景与挑战 大型活动(如演唱会、马拉松赛事、高考中考等)期间,城市交通面临瞬时人流车流激增、传统摄像头模糊、交通拥堵识别滞后等问题。以演唱会为例,暖城商圈曾因观众集中离场导致周边…...

java调用dll出现unsatisfiedLinkError以及JNA和JNI的区别

UnsatisfiedLinkError 在对接硬件设备中,我们会遇到使用 java 调用 dll文件 的情况,此时大概率出现UnsatisfiedLinkError链接错误,原因可能有如下几种 类名错误包名错误方法名参数错误使用 JNI 协议调用,结果 dll 未实现 JNI 协…...

Android 之 kotlin 语言学习笔记三(Kotlin-Java 互操作)

参考官方文档:https://developer.android.google.cn/kotlin/interop?hlzh-cn 一、Java(供 Kotlin 使用) 1、不得使用硬关键字 不要使用 Kotlin 的任何硬关键字作为方法的名称 或字段。允许使用 Kotlin 的软关键字、修饰符关键字和特殊标识…...

智能分布式爬虫的数据处理流水线优化:基于深度强化学习的数据质量控制

在数字化浪潮席卷全球的今天,数据已成为企业和研究机构的核心资产。智能分布式爬虫作为高效的数据采集工具,在大规模数据获取中发挥着关键作用。然而,传统的数据处理流水线在面对复杂多变的网络环境和海量异构数据时,常出现数据质…...

在鸿蒙HarmonyOS 5中使用DevEco Studio实现企业微信功能

1. 开发环境准备 安装DevEco Studio 3.1: 从华为开发者官网下载最新版DevEco Studio安装HarmonyOS 5.0 SDK 项目配置: // module.json5 {"module": {"requestPermissions": [{"name": "ohos.permis…...

)

华为OD最新机试真题-数组组成的最小数字-OD统一考试(B卷)

题目描述 给定一个整型数组,请从该数组中选择3个元素 组成最小数字并输出 (如果数组长度小于3,则选择数组中所有元素来组成最小数字)。 输入描述 行用半角逗号分割的字符串记录的整型数组,0<数组长度<= 100,0<整数的取值范围<= 10000。 输出描述 由3个元素组成…...