【LLaMA-Factory】使用LoRa微调训练DeepSeek-R1-Distill-Qwen-7B

【LLaMA-Factory】使用LoRa微调训练DeepSeek-R1-Distill-Qwen-7B

- 本地环境说明

- 禁用开源驱动nouveau

- 安装nvidia-smi

- 安装Git环境

- 安装Anaconda(conda)环境

- 下载`DeepSeek-R1-Distill-Qwen-7B`模型

- 安装LLaMA-Factory

- 下载LLaMA-Factory

- 安装LLaMA-Factory依赖

- 修改环境变量

- 安装deepspeed

- Alpaca数据集准备

- lora配置文件准备

- 设置GPU个数

- 启动微调

- 查看微调时GPU情况

- 启动webui服务

- 对话

- 损失函数曲线

- 参考资料

本地环境说明

| 依赖 | 版本 |

|---|---|

| Linux | BigCloud Enterprise Linux 8.6 |

| GPU | NVIDIA Tesla T4 16G * 8 |

禁用开源驱动nouveau

如果不禁用开源驱动,直接安装nvidia-smi,会安装失败,在日志文件/var/log/nvidia-installer.log中会出现以下错误信息

ERROR: Unable to load the kernel module 'nvidia.ko'

- 查看

nouveau是否在运行,先输入指令

lsmod | grep nouveau

如果不出现一下的情况则已经禁用

nouveau 2334720 0

video 57344 1 nouveau

mxm_wmi 16384 1 nouveau

drm_kms_helper 262144 5 drm_vram_helper,ast,nouveau

ttm 114688 3 drm_vram_helper,drm_ttm_helper,nouveau

i2c_algo_bit 16384 3 igb,ast,nouveau

drm 614400 7 drm_kms_helper,drm_vram_helper,ast,drm_ttm_helper,ttm,nouveau

i2c_core 98304 9 drm_kms_helper,i2c_algo_bit,igb,ast,i2c_smbus,i2c_i801,ipmi_ssif,nouveau,drm

wmi 32768 2 mxm_wmi,nouveau

- 禁用

nouveau

# 如果文件不存在,就创建

sudo sh -c 'cat > /etc/modprobe.d/blacklist.conf << EOF

blacklist nouveau

options nouveau modeset=0

EOF'# 重新生成 initramfs

sudo dracut --force

# 重启机器

sudo reboot

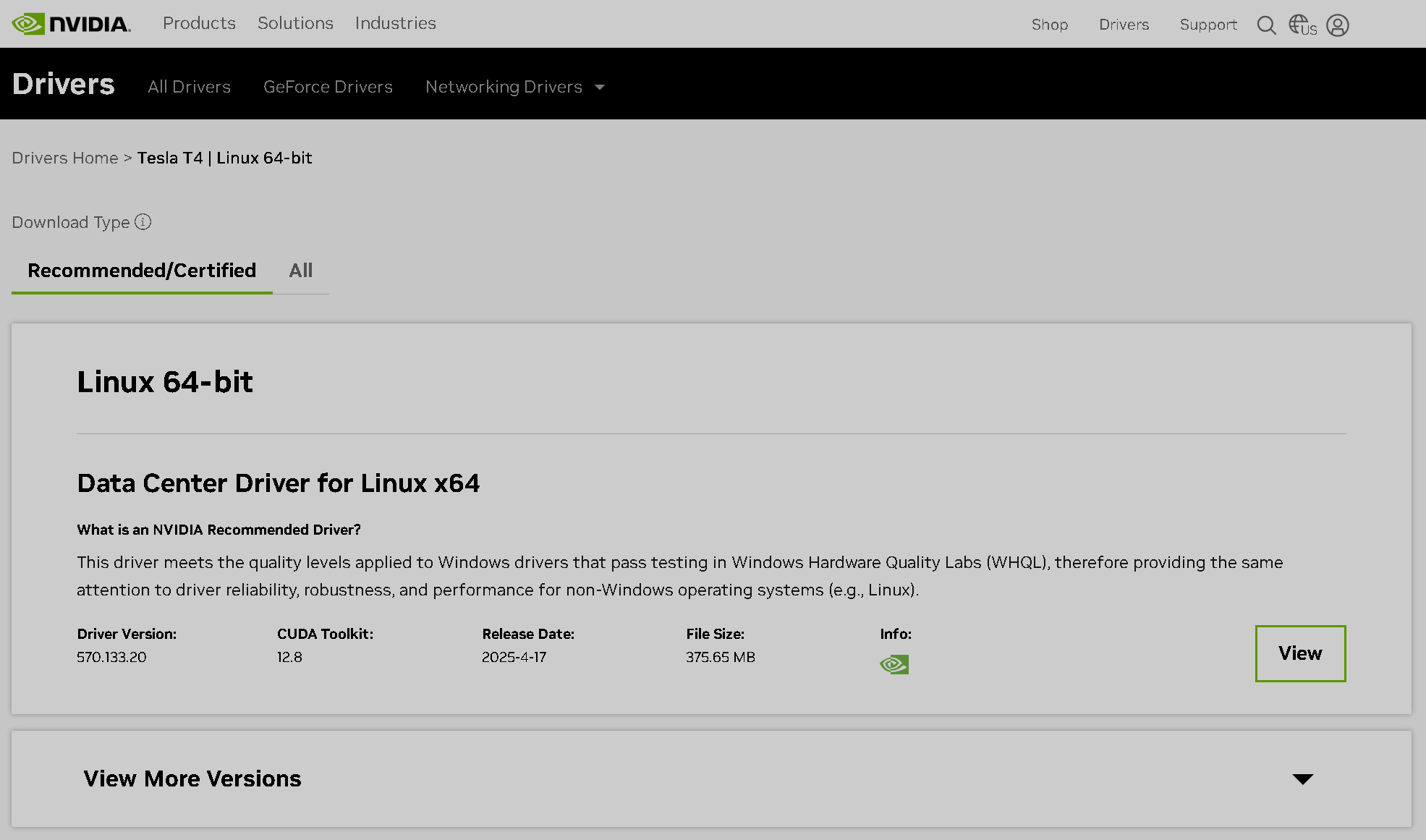

安装nvidia-smi

- 浏览器访问:

https://www.nvidia.com/en-us/drivers/需要梯子(科学上网),才能加载

Manual Driver Search - 填写驱动信息

- 驱动查询结果

- 驱动下载页面

- 下载驱动文件,得到

NVIDIA-Linux-x86_64-570.133.20.run,上传到Linux机器上不能复制下载地址,然后在机器上使用

wget命令直接下载,这样请求会返回403 - 安装驱动

- 必须使用

root权限安装- -no-x-check #安装驱动时关闭X服务

- -no-nouveau-check #安装驱动时禁用nouveau

- -no-opengl-files #只安装驱动文件,不安装OpenGL文件

- 安装的时候,出现内核模块类型选择,根据提示选择

NVIDIA Proprietary,使用左右键控制选择,然后回车

Multiple kernel module types are available for this system. Which would you like to use?NVIDIA Proprietary MIT/GPL

- 安装完运行命令确认驱动安装成功

nvidia-smi

显卡信息如下

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 570.133.20 Driver Version: 570.133.20 CUDA Version: 12.8 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 Tesla T4 Off | 00000000:3D:00.0 Off | 0 |

| N/A 51C P0 27W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 1 Tesla T4 Off | 00000000:3E:00.0 Off | 0 |

| N/A 54C P0 28W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 2 Tesla T4 Off | 00000000:40:00.0 Off | 0 |

| N/A 51C P0 27W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 3 Tesla T4 Off | 00000000:41:00.0 Off | 0 |

| N/A 48C P0 26W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 4 Tesla T4 Off | 00000000:B1:00.0 Off | 0 |

| N/A 47C P0 26W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 5 Tesla T4 Off | 00000000:B2:00.0 Off | 0 |

| N/A 53C P0 30W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 6 Tesla T4 Off | 00000000:B4:00.0 Off | 0 |

| N/A 56C P0 30W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 7 Tesla T4 Off | 00000000:B5:00.0 Off | 0 |

| N/A 55C P0 30W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------++-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| No running processes found |

+-----------------------------------------------------------------------------------------+

安装Git环境

安装git和git-lfs

sudo dnf install git git-lfs

安装Anaconda(conda)环境

- 下载页面:

https://www.anaconda.com/download/success

64-Bit (x86) Installer下载

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

- 安装

sudo sh Anaconda3-2024.10-1-Linux-x86_64.sh

- 会出现很多信息,一路

yes下去,观看文档用q跳过

Do you accept the license terms? [yes|no]

>>> yesAnaconda3 will now be installed into this location:

/root/anaconda3- Press ENTER to confirm the location- Press CTRL-C to abort the installation- Or specify a different location below

[/root/anaconda3] >>> /data/ProgramFiles/anaconda3You can undo this by running `conda init --reverse $SHELL`? [yes|no]

[no] >>> yes

- 设置环境变量

cat >> ~/.bash_profile << EOF

export ANACONDA3_HOME=/data/ProgramFiles/anaconda3

export CONDA_ENVS_PATH=\$ANACONDA3_HOME/envs

export PATH="\$ANACONDA3_HOME/bin:$PATH"

EOF

source ~/.bash_profile# 目录是使用root权限安装的,对目录进行授权

sudo chown -R tkyj.tkyj /data

- 查看

conda版本以验证是否安装成功

conda -V

- 配置镜像源

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --set show_channel_urls yes

下载DeepSeek-R1-Distill-Qwen-7B模型

- 魔搭社区:

https://modelscope.cn/models/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B

mkdir -pv /data/llm/models

cd /data/llm/models# 如果您希望跳过 lfs 大文件下载,可以使用如下命令

GIT_LFS_SKIP_SMUDGE=1 git clone https://www.modelscope.cn/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B.git

# 请确保lfs已经被正确安装

cd DeepSeek-R1-Distill-Qwen-7B

git lfs install

# 下载大文件

git lfs pull

安装LLaMA-Factory

- 软件要求

| Mandatory | Minimum | Recommend |

|---|---|---|

| python | 3.9 | 3.10 |

| torch | 2.0.0 | 2.6.0 |

| transformers | 4.45.0 | 4.50.0 |

| datasets | 2.16.0 | 3.2.0 |

| accelerate | 0.34.0 | 1.2.1 |

| peft | 0.14.0 | 0.15.1 |

| trl | 0.8.6 | 0.9.6 |

| Optional | Minimum | Recommend |

|---|---|---|

| CUDA | 11.6 | 12.2 |

| deepspeed | 0.10.0 | 0.16.4 |

| bitsandbytes | 0.39.0 | 0.43.1 |

| vllm | 0.4.3 | 0.8.2 |

| flash-attn | 2.5.6 | 2.7.2 |

- 硬件要求

| Method | Bits | 7B | 14B | 30B | 70B | xB |

|---|---|---|---|---|---|---|

Full (bf16 or fp16) | 32 | 120GB | 240GB | 600GB | 1200GB | 18xGB |

Full (pure_bf16) | 16 | 60GB | 120GB | 300GB | 600GB | 8xGB |

| Freeze/LoRA/GaLore/APOLLO/BAdam | 16 | 16GB | 32GB | 64GB | 160GB | 2xGB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | xGB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | x/2GB |

| QLoRA | 2 | 4GB | 8GB | 16GB | 24GB | x/4GB |

下载LLaMA-Factory

- 使用

git克隆项目

cd /data/ProgramFiles

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

安装LLaMA-Factory依赖

cd LLaMA-Factory

conda create --name llama_factory python=3.10

conda activate llama_factory

# 从torch官网匹配cuda 12.8版本

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128

pip install -e ".[torch,metrics]" -i https://pypi.tuna.tsinghua.edu.cn/simple# 验证安装

llamafactory-cli version

修改环境变量

方便每次登录终端自动切换到对应的Python环境

cat >> ~/.bash_profile << EOF

conda activate llama_factory

EOF

source ~/.bash_profile

安装deepspeed

单卡16G显存微调7B模型有点吃紧,可以使用deepspeed解决

# 查询cuda版本

conda search cuda -c nvidia

# 安装与nvidia-smi对应的版本(安装cuda是安装deepspeed的前置条件)

conda install cuda=12.8.1 -c nvidia

DS_BUILD_CPU_ADAM=1 pip3 install deepspeed==0.16.7

Alpaca数据集准备

alpaca示例格式

[{"instruction": "Invent a new word by combining two existing words.","input": "","output": "\"Chillax\" - a combination of the words \"chill\" and \"relax\". It means to calm down and unwind, enjoying oneself in a laidback manner."},{"instruction": "Transform the following sentence using a synonym: The car sped quickly.","input": "","output": "The car accelerated rapidly."}

- 修改

LLaMA-Factory/data/dataset_info.json,增加如下信息

"cmic_financial_apaca": {"file_name": "/data/llm/dataset/cmic_financial_apaca.json","columns": {"prompt": "instruction","query": "input","response": "output","system": "system"}

}

lora配置文件准备

- 备份原始文件

cd LLaMA-Factory/examples/train_lora

# 从原始文件复制一份新的出来

cp llama3_lora_sft.yaml ds_qwen7b_lora_sft.yaml

vi examples/train_lora/ds_qwen7b_lora_sft.yaml

- 修改

ds_qwen7b_lora_sft.yaml,主要修改如下字段model_name_or_pathdatasettemplatecutoff_lenmax_samplesoutput_dir

- 需要关注以下参数

model_name_or_path: 模型路径dataset: 数据集名称,对应上面声明的cmic_financial_apacatemplate: 模版cutoff_len: 控制输入序列的最大长度output_dir: 微调后权重保存路径gradient_accumulation_steps: 梯度累积的步数,GPU资源不足时需要减少该值num_train_epochs: 训练的轮数

ds_qwen7b_lora_sft.yaml完整内容如下

### model

model_name_or_path: /data/llm/models/DeepSeek-R1-Distill-Qwen-7B

trust_remote_code: true### method

stage: sft

do_train: true

finetuning_type: lora

lora_rank: 8

lora_target: all### dataset

dataset: cmic_financial_apaca

template: deepseek3

cutoff_len: 4096

max_samples: 4019

overwrite_cache: true

preprocessing_num_workers: 16

dataloader_num_workers: 4### output

output_dir: /data/llm/models/sft/DeepSeek-R1-Distill-Qwen-7B

logging_steps: 10

save_steps: 500

plot_loss: true

overwrite_output_dir: true

save_only_model: false

report_to: none # choices: [none, wandb, tensorboard, swanlab, mlflow]### train

per_device_train_batch_size: 1

gradient_accumulation_steps: 8

learning_rate: 1.0e-4

num_train_epochs: 1.0

lr_scheduler_type: cosine

warmup_ratio: 0.1

bf16: true

ddp_timeout: 180000000

resume_from_checkpoint: null### eval

#eval_dataset: alpaca_en_demo

val_size: 0.1

per_device_eval_batch_size: 1

eval_strategy: steps

eval_steps: 500

设置GPU个数

多卡并行时,设置GPU个数,修改: LLaMA-Factory/examples/accelerate/fsdp_config.yaml

num_processes: 8 # the number of GPUs in all nodes

启动微调

conda activate llama_factory# 后台运行

nohup llamafactory-cli train /data/ProgramFiles/LLaMA-Factory/examples/train_lora/ds_qwen7b_lora_sft.yaml > nohup.log 2>&1 &# 查看日志

tail -fn200 nohup.log

查看微调时GPU情况

运行命令: watch -n 0.5 nvidia-smi

Every 0.5s: nvidia-smi localhost.localdomain: Mon Apr 28 15:33:10 2025Mon Apr 28 15:33:14 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 570.133.20 Driver Version: 570.133.20 CUDA Version: |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 Tesla T4 Off | 00000000:3D:00.0 Off | 0 |

| N/A 39C P8 19W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 1 Tesla T4 Off | 00000000:3E:00.0 Off | 0 |

| N/A 40C P0 26W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 2 Tesla T4 Off | 00000000:40:00.0 Off | 0 |

| N/A 37C P0 26W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 3 Tesla T4 Off | 00000000:41:00.0 Off | 0 |

| N/A 37C P0 25W / 70W | 0MiB / 15360MiB | 4% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 4 Tesla T4 Off | 00000000:B1:00.0 Off | 0 |

| N/A 36C P8 13W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 5 Tesla T4 Off | 00000000:B2:00.0 Off | 0 |

| N/A 40C P8 15W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 6 Tesla T4 Off | 00000000:B4:00.0 Off | 0 |

| N/A 42C P8 15W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 7 Tesla T4 Off | 00000000:B5:00.0 Off | 0 |

| N/A 41C P8 11W / 70W | 0MiB / 15360MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------++-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| No running processes found |

+-----------------------------------------------------------------------------------------+

启动webui服务

# 关闭防火墙,方便访问web服务端口

sudo systemctl stop firewalldGRADIO_SHARE=1

nohup llamafactory-cli webui > webui.log 2>&1 &

tail -fn200 webui.log

对话

llamafactory-cli chat /data/ProgramFiles/LLaMA-Factory/examples/inference/ds_qwen7b_lora_sft.yaml

损失函数曲线

参考资料

- 开源模型应用落地-DeepSeek-R1-Distill-Qwen-7B-LoRA微调-LLaMA-Factory-单机单卡-V100(一)

- 保姆级零基础微调大模型(LLaMa-Factory,多卡版)

- LLaMA-Factory:手把手教你从零微调大模型!

- 大语言模型训练“参数”到底改怎么调???

相关文章:

【LLaMA-Factory】使用LoRa微调训练DeepSeek-R1-Distill-Qwen-7B

【LLaMA-Factory】使用LoRa微调训练DeepSeek-R1-Distill-Qwen-7B 本地环境说明禁用开源驱动nouveau安装nvidia-smi安装Git环境安装Anaconda(conda)环境下载DeepSeek-R1-Distill-Qwen-7B模型安装LLaMA-Factory下载LLaMA-Factory安装LLaMA-Factory依赖修改环境变量安装deepspeedA…...

sh脚本多卡顺序执行训练文件

常规的单机多卡训练脚本一般为 python -m torch.distributed.run --nproc_per_node 2 train.py 上述脚本采用 2 张显卡训练 采用sh脚本,单次顺序执行多个多卡训练文件 例如 train1.py train2.py 特点:在执行完 train1.py之后再执行train2.py文件 …...

使用lldb查看Rust不同类型的结构

目录 前言 正文 标量类型 复合类型——元组 复合类型——数组 函数 &str struct 可变数组vec Iter String Box Rc Arc RefCell Mutex RwLock Channel 总结 前言 笔者发现这个lldb挺好玩的,可以查看不同类型的结构,虽然这好像是C的东…...

【Linux】线程POSIX信号量

目录 1. 整体学习思维导图 2. 信号量的概念 3. 基本接口 4. 基于环形队列的生产者消费者模型(信号量) 1. 整体学习思维导图 2. 信号量的概念 POSIX信号量和SystemV信号量作用相同,都是用于同步操作,达到无冲突的访问共享资源目的。但 POSIX可以用于线…...

WPF中如何自定义控件

WPF自定义控件简化版:账户菜单按钮(AccountButton) 我们以**“账户菜单按钮”为例,用更清晰的架构实现一个支持标题显示、渐变背景、选中状态高亮**的自定义控件。以下是分步拆解: 一、控件核心功能 我们要做一个类似…...

大模型MCP更高效的通信:StreamableHTTP协议

随着大语言模型(LLMs)的飞速发展,模型与应用之间的通信效率和灵活性变得至关重要。Model Context Protocol (MCP) 作为专为模型交互设计的协议,一直在不断进化以满足日益增长的需求。近期,MCP引入了一个令人振奋的新特…...

防火墙在网络安全体系中的核心作用与原理

防火墙在网络安全体系中的核心作用与原理 一、核心作用解析 1. 访问控制中枢 功能维度实现方式典型场景黑白名单控制基于IP/端口/协议的规则过滤限制外部IP访问财务系统,仅开放VPN端口权限分级用户组策略映射(如AD集成)禁止普通员工访问核心…...

MySQL事务和JDBC中的事务操作

一、什么是事务 事务是数据库操作的最小逻辑单元,具有"全有或全无"的特性。以银行转账为例: 典型场景: 从A账户扣除1000元 向B账户增加1000元 这两个操作必须作为一个整体执行,要么全部成功,要么全部失败…...

每日脚本学习5.10 - XOR脚本

xor运算的简介 异或就是对于二进制的数据可以 进行同0异1 简单的演示 : 结果是 这个就是异或 异或的作用 1、比较两数是否相等 2、可以进行加密 加密就是需要key 明文 :0b010110 key : 0b1010001 这个时候就能进行加密 明文 ^ key密文 还有这个加密比…...

【编译原理】总结

核心 闭包,正则闭包 产生式(规则) 文法 G[S](,,P,S) 一组规则的集合 :非终结符 :终结符 P:产生式 S:开始符号 推导 归约 规范(最右ÿ…...

docker创建一个centOS容器安装软件(以宝塔为例)的详细步骤

备忘:后续偶尔忘记了docker虚拟机与宿主机的端口映射关系,来这里查看即可: docker run -d \ --name baota \ --privilegedtrue \ -p 8888:8888 \ -p 8880:80 \ -p 8443:443 \ -p 8820:20 \ -p 8821:21 \ -v /home/www:/www/wwwroot \ centos…...

OpenVLA:开源的视觉-语言-动作模型

1. 简介 让我们先来介绍一下什么是OpenVLA,在这里: https://openvla.github.io/ 可以看到他们的论文、数据、模型。 OpenVLA 是一个拥有 70亿参数的开源 **视觉-语言-动作(VLA)**模型。它是在 Open X-Embodiment 数据集 中的 97万…...

Matlab/Simulink的一些功能用法笔记(4)

水一篇帖子 01--MATLAB工作区的保护眼睛颜色设置 默认的工作区颜色为白色 在网上可以搜索一些保护眼睛的RGB颜色参数设置 在MATLAB中按如下设置: ①点击预设 ②点击颜色,点击背景色的三角标符号 ③点击更多颜色,找到RGB选项 ④填写颜色参数…...

【比赛真题解析】混合可乐

这次给大家分享一道比赛题:混合可乐。 洛谷链接:U561549 混合可乐 【题目描述】 Jimmy 最近沉迷于可乐中无法自拔。 为了调配出他心目中最完美的可乐,Jimmy买来了三瓶不同品牌的可乐,然后立马喝掉了一些(他实在是忍不住了),所以 第一瓶可口可乐最大容量为 a 升,剩余 …...

Elasticsearch:我们如何在全球范围内实现支付基础设施的现代化?

作者:来自 Elastic Kelly Manrique SWIFT 和 Elastic 如何应对基础设施复杂性、误报问题以及日益增长的合规要求。 金融服务公司在全球范围内管理实时支付方面面临前所未有的挑战。SWIFT(Society for Worldwide Interbank Financial Telecommunication -…...

matlab介绍while函数

MATLAB 中的 while 语句介绍 在 MATLAB 中,while 语句是一种循环结构,用于在满足特定条件时反复执行一段代码块。与 for 循环不同,while 循环的执行次数是动态的,取决于循环条件是否为真。 语法 while condition% 循环体代码 e…...

如何解决 PowerShell 显示 “此系统上禁用了脚本运行” 的问题

在 Windows 11 或 10 的 PowerShell 中运行脚本时,你可能会遇到一个错误,提示系统上禁用了脚本运行。这是一种安全功能,而不是系统问题,旨在防止可能有害的脚本自动运行。然而,如果你需要运行脚本来完成某些任务,或者你在系统上做了软件开发或测试的环境,那么你需要在 P…...

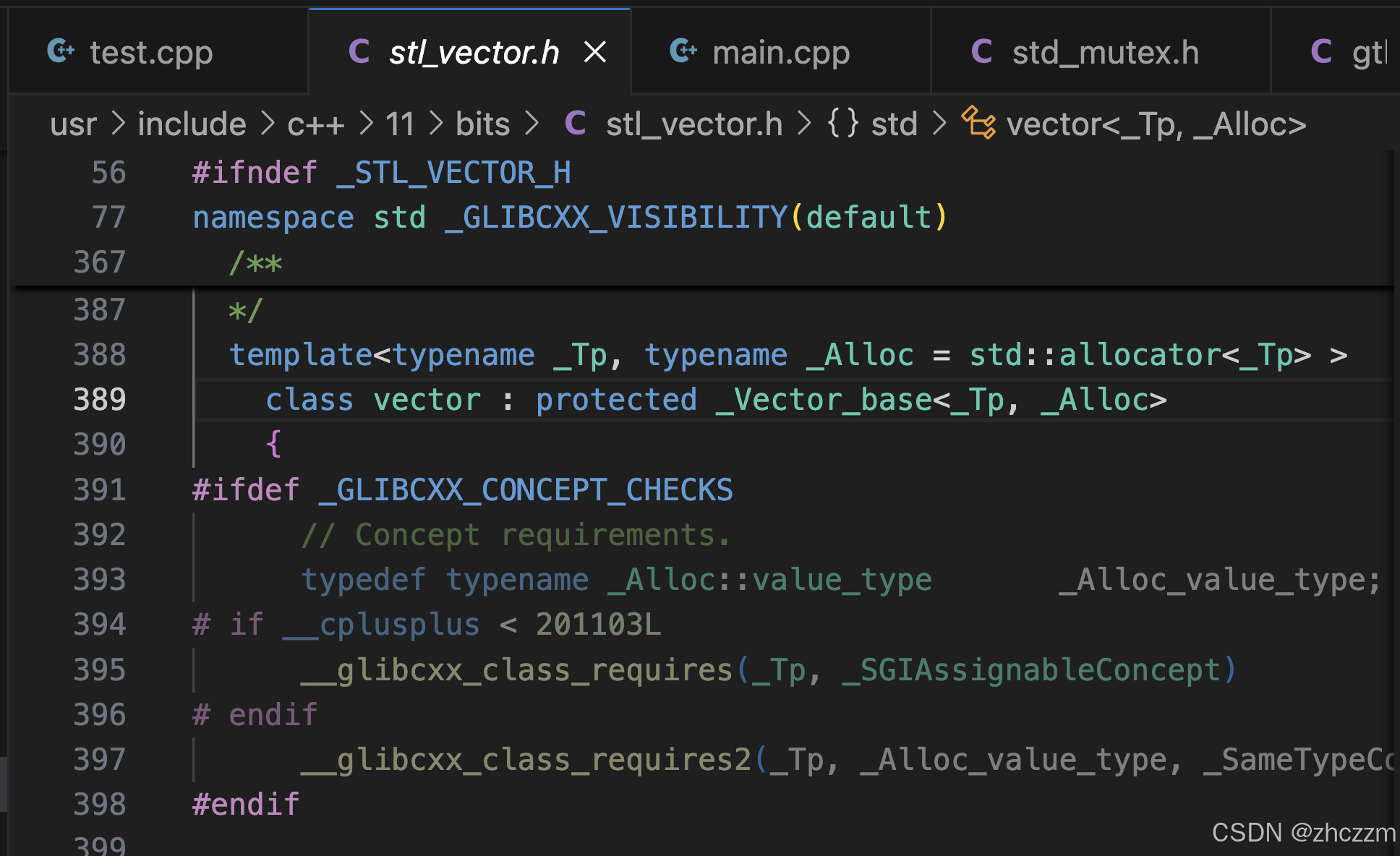

深入浅出之STL源码分析4_类模版

1.引言 我在上面的文章中讲解了vector的基本操作,然后提出了几个问题。 STL之vector基本操作-CSDN博客 1.刚才我提到了我的编译器版本是g 11.4.0,而我们要讲解的是STL(标准模板库),那么二者之间的关系是什么&#x…...

探索科技的前沿动态:科技爱好者周刊

探索科技的前沿动态:科技爱好者周刊 在信息爆炸的时代,我们每时每刻都被新技术、新理念包围。而如何在这纷繁复杂的信息中找到对自己有价值的内容,成了一大挑战。今天,我们要介绍的是一个宝贵的资源——科技爱好者周刊,它致力于为科技爱好者提供优质的科技资讯,每周五发…...

初学者入门指南:什么是网络拓扑结构?

初学者入门指南:什么是网络拓扑结构? 在构建或学习计算机网络时,一个绕不开的核心概念便是“网络拓扑结构”(Network Topology)。它决定了网络中各个设备如何连接、通信以及如何扩展。理解网络拓扑不仅有助于我们更清…...

在 Vue 3 中实现刮刮乐抽奖

🎉 在 Vue 3 中实现刮刮乐抽奖 当项目中需要做一些活动互动页时,需要实现刮刮乐,请看如下效果: 这里感谢github用户Choicc分享的组件,具体可点击传送门查看 1. 引入组件 将/src/components下ScratchCard.vue复制到自…...

Satori:元动作 + 内建搜索机制,让大模型实现超级推理能力

Satori:元动作 内建搜索机制,让大模型实现超级推理能力 论文大纲一、背景:LLM 推理增强的三类方法1. 基于大规模监督微调(SFT)的推理增强2. 借助外部机制在推理时进行搜索 (RLHF / 多模型 / 工具)3. 现有局限性总结 二…...

SDC命令详解:使用all_outputs命令进行查询

相关阅读 SDC命令详解https://blog.csdn.net/weixin_45791458/category_12931432.html all_outputs命令用于创建一个输出端口对象集合,关于设计对象和集合的更详细介绍,可以参考下面的博客。 Synopsys:设计对象https://chenzhang.blog.csdn…...

printf调试时候正常,运行时打印不出来

问题是在添加了 printf 功能后,程序独立运行时无法正常打印输出,而调试模式下正常。这表明问题可能与 printf 的重定向实现、标准库配置、或编译器相关设置有关。 解决: 原来是使用 Keil/IAR,printf可能需要启用 MicroLIB 或正确…...

解决 TimeoutError: [WinError 10060] 在 FramePack项目中连接 Hugging Face 超时的问题

#工作记录 以下是针对 TimeoutError: [WinError 10060] 的完整排查方案,适用于 FramePack项目中。 (一般该错误的发生原因请重点排查Hugging Face模型仓库受限需要登录的情形) FramePack项目参考资料 FramePack部署(从PyCharm解…...

分布式-Redis分布式锁

Redis实现分布式锁优点 (1)Redis有很高的性能; (2)Redis命令对此支持较好,实现起来比较方便 实现思路 (1)获取锁的时候,使用setnx加锁,并使用expire命令为锁…...

UniRepLknet助力YOLOv8:高效特征提取与目标检测性能优化

文章目录 一、引言二、UniRepLknet 的框架原理(一)架构概述(二)架构优势 三、UniRepLknet 在 YOLOv8 中的集成(一)集成方法(二)代码实例 四、实验与对比(一)对…...

自研时序大模型讲解(4月29日)直播回顾

4 月 29 日,清华团队揭秘:时序大模型如何让数据“活”起来线上直播圆满结束。清华大学软件学院博士生,IoTDB 原生机器学习引擎 AINode 研发同学刘雍在线上面向数千人次的时序数据分析人员与 AI 大模型行业关注者,就时序大模型的发…...

The Action Replay Process

Preface A commonly used inequality − x > ln ( 1 − x ) , 0 < x < 1 -x > \ln(1 - x), \quad 0 < x < 1 −x>ln(1−x),0<x<1 Proof: Let f ( x ) ln ( 1 − x ) x f(x) \ln(1 - x) x f(x)ln(1−x)x, for 0 < x < 1 0 < …...

k8s之ingress解释以及k8s创建业务的流程定义

matchLabels ingress Ingress 是反向代理规则,用来规定 HTTP/S 请求应该被转发到哪个 Service 上,比如根据请求中不同的 Host 和 url 路径让请求落到不同的 Service 上。 Ingress Controller 就是一个反向代理程序,它负责解析 Ingress 的反向…...