KubeMQ 深度实践:构建可扩展的 LLM 中台架构

文章简介

在 AI 应用开发中,集成 OpenAI、Anthropic Claude 等多大型语言模型(LLM)常面临 API 碎片化、请求路由复杂等挑战。本文将介绍如何通过 ** 消息代理(Message Broker)** 实现高效的 LLM 管理,以开源工具 KubeMQ 为例,演示从环境搭建、路由逻辑开发到高可用设计的全流程。通过这种架构,开发者可轻松实现模型扩展、负载均衡与故障容错,大幅提升多 LLM 应用的开发效率与稳定性。

一、多 LLM 集成的核心挑战与破局思路

1.1 传统集成方式的痛点

- API 协议碎片化:OpenAI 使用 REST API,Claude 支持 gRPC 与 HTTP 双协议,需为每个模型编写独立适配代码。

- 请求路由复杂:多模型场景下(如摘要用 Claude、代码生成用 GPT-4),客户端需硬编码路由逻辑,扩展性差。

- 高并发瓶颈:直接调用模型 API 易引发流量尖峰,导致超时或服务降级。

1.2 消息代理的破局价值

核心优势:

- 协议抽象层:统一不同模型的通信协议,客户端仅需与消息代理交互。

- 智能路由引擎:基于规则(如模型类型、请求内容)动态分配请求,支持 A/B 测试与模型权重配置。

- 异步处理能力:通过消息队列缓冲请求,削峰填谷,提升系统吞吐量。

- 弹性容错机制:自动重试失败请求,支持多模型冗余切换,保障服务可用性。

二、基于 KubeMQ 的 LLM 路由系统搭建

2.1 环境准备与依赖安装

必备工具:

- KubeMQ:开源消息代理,支持 gRPC/REST 协议与多语言 SDK(本文用 Python)。

- LangChain:简化 LLM 集成的开发框架,封装 OpenAI 与 Claude 的 API 细节。

- Docker:快速部署 KubeMQ 服务。

安装步骤:

-

拉取 KubeMQ 镜像:

docker run -d --rm \ -p 8080:8080 -p 50000:50000 -p 9090:9090 \ -e KUBEMQ_TOKEN="your-token" \ # 替换为KubeMQ官网申请的Token kubemq/kubemq-community:latest -

安装 Python 依赖:

pip install kubemq-cq langchain openai anthropic python-dotenv -

配置环境变量

(.env 文件):

OPENAI_API_KEY=sk-xxx # OpenAI API密钥 ANTHROPIC_API_KEY=claude-xxx # Claude API密钥

2.2 构建 LLM 路由服务器

核心逻辑:监听不同模型通道,解析请求并调用对应 LLM,返回处理结果。

# server.py

import time

from kubemq.cq import Client, QueryMessageReceived, QueryResponseMessage

from langchain.chat_models import ChatOpenAI

from langchain.llms import Anthropic

import os

from dotenv import load_dotenv

import threading load_dotenv() class LLMRouter: def __init__(self): # 初始化LLM客户端 self.openai_llm = ChatOpenAI( model_name="gpt-3.5-turbo", temperature=0.7 ) self.claude_llm = Anthropic( model="claude-3", max_tokens_to_sample=1024 ) # 连接KubeMQ self.client = Client(address="localhost:50000") def handle_query(self, request: QueryMessageReceived, model): """通用请求处理函数""" try: prompt = request.body.decode("utf-8") # 根据模型类型调用对应LLM if model == "openai": response = self.openai_llm.predict(prompt) elif model == "claude": response = self.claude_llm(prompt) # 构造响应 return QueryResponseMessage( query_received=request, body=response.encode("utf-8"), is_executed=True ) except Exception as e: return QueryResponseMessage( query_received=request, error=str(e), is_executed=False ) def run(self): # 订阅OpenAI通道 def subscribe_openai(): self.client.subscribe_to_queries( channel="openai-queue", on_receive_query_callback=lambda req: self.handle_query(req, "openai") ) # 订阅Claude通道 def subscribe_claude(): self.client.subscribe_to_queries( channel="claude-queue", on_receive_query_callback=lambda req: self.handle_query(req, "claude") ) # 启动多线程订阅 threading.Thread(target=subscribe_openai).start() threading.Thread(target=subscribe_claude).start() print("LLM路由器已启动,监听通道:openai-queue, claude-queue") time.sleep(1e9) # 保持进程运行 if __name__ == "__main__": router = LLMRouter() router.run()

代码解析:

- 模型初始化:使用 LangChain 封装的 LLM 客户端,支持模型参数(如 temperature)动态调整。

- 通道订阅:通过 KubeMQ 的

subscribe_to_queries方法监听指定通道,实现请求与模型的解耦。 - 错误处理:捕获 LLM 调用异常,返回包含错误信息的响应,便于客户端排查问题。

2.3 开发客户端应用

功能:向消息代理发送请求,指定目标模型并获取响应。

# client.py

from kubemq.cq import Client

import argparse class LLMConsumer: def __init__(self, broker_addr="localhost:50000"): self.client = Client(address=broker_addr) def send_prompt(self, prompt: str, model: str): """发送请求到指定模型通道""" channel = f"{model}-queue" # 通道名与模型绑定 response = self.client.send_query_request( QueryMessage( channel=channel, body=prompt.encode("utf-8"), timeout_in_seconds=60 # 长时请求支持 ) ) if response.is_error: raise RuntimeError(f"模型调用失败:{response.error}") return response.body.decode("utf-8") if __name__ == "__main__": parser = argparse.ArgumentParser() parser.add_argument("--prompt", required=True, help="输入查询内容") parser.add_argument("--model", choices=["openai", "claude"], required=True, help="选择模型") args = parser.parse_args() client = LLMConsumer() try: result = client.send_prompt(args.prompt, args.model) print(f"[{args.model.upper()}] 响应:{result}") except Exception as e: print(f"错误:{str(e)}")

使用示例:

python client.py --prompt "撰写Python冒泡排序代码" --model openai

# 输出:[OPENAI] 响应:以下是Python实现的冒泡排序代码... python client.py --prompt "分析用户评论情感" --model claude

# 输出:[CLAUDE] 响应:这条评论的情感倾向为积极,主要依据是...

三、进阶能力:构建高可用 LLM 路由系统

3.1 负载均衡与流量控制

场景:当单一模型实例无法处理高并发请求时,通过 KubeMQ 的队列机制实现请求分发。

配置步骤:

- 启动多个 LLM 服务实例,监听同一通道(如 “openai-queue”)。

- KubeMQ 自动将请求轮询分配至不同实例,实现负载均衡。

# 启动3个OpenAI服务实例

python server.py --model openai --instance 1 &

python server.py --model openai --instance 2 &

python server.py --model openai --instance 3 &

3.2 故障容错与动态切换

场景:当 OpenAI API 超时或限流时,自动切换至 Claude 处理请求。

实现逻辑:

# 客户端增加故障切换逻辑

class FaultTolerantClient: def send_with_fallback(self, prompt: str, primary: str, fallback: str): try: return self.send_prompt(prompt, primary) except Exception: print(f"主模型{primary}调用失败,切换至{fallback}") return self.send_prompt(prompt, fallback) # 使用示例

client = FaultTolerantClient()

response = client.send_with_fallback("生成营销文案", "openai", "claude")

3.3 REST API 兼容支持

场景:为不支持 gRPC 的客户端提供 REST 接口。

请求示例(curl):

curl -X POST http://localhost:9090/send/request \ -H "Content-Type: application/json" \ -d '{ "RequestTypeData": 2, "ClientID": "web-client", "Channel": "claude-queue", "BodyString": "翻译以下英文为中文:Hello, world!", "Timeout": 30000 }'

响应结果:

{ "Body": "你好,世界!", "IsError": false, "Error": null

}

四、生产环境最佳实践

4.1 安全增强

- 认证机制:通过 KubeMQ Token 验证客户端身份,结合 API 密钥白名单限制调用来源。

- 数据加密:在消息代理层启用 TLS 加密,防止 LLM 请求与响应被嗅探。

4.2 监控与日志

- 内置指标:通过 KubeMQ Dashboard 查看通道吞吐量、请求延迟、错误率等指标。

- 分布式追踪:集成 OpenTelemetry,追踪请求在客户端、消息代理、LLM 服务间的完整链路。

4.3 弹性扩展

- 容器化部署:使用 Kubernetes 编排 KubeMQ 与 LLM 服务,实现自动扩缩容。

- 多区域容灾:在不同云厂商(如 AWS、Azure)部署 LLM 实例,通过 KubeMQ 的跨集群同步功能实现异地灾备。

总结

通过消息代理构建 LLM 路由系统,可将多模型集成的复杂度从 O (n²) 降至 O (n),显著提升开发效率与系统稳定性。KubeMQ 作为开源工具,不仅提供了可靠的消息通信能力,还通过通道机制、负载均衡、容错策略等特性,为多 LLM 应用提供了一站式解决方案。未来,随着更多模型(如 Google Gemini、Meta Llama)的加入,这种松耦合架构将成为企业级 AI 应用的标配。开发者只需关注业务逻辑,而模型管理、流量调度等底层细节均可交由消息代理处理,真正实现 “一次开发,多模兼容” 的高效开发模式。

相关文章:

KubeMQ 深度实践:构建可扩展的 LLM 中台架构

文章简介 在 AI 应用开发中,集成 OpenAI、Anthropic Claude 等多大型语言模型(LLM)常面临 API 碎片化、请求路由复杂等挑战。本文将介绍如何通过 ** 消息代理(Message Broker)** 实现高效的 LLM 管理,以开…...

vueflow

自定义节点,自定义线,具体细节还未完善,实现效果: 1.安装vueflow 2.目录如下 3. index.vue <script setup> import { ref } from vue import { VueFlow, useVueFlow } from vue-flow/core import { Background } from vue-…...

LearnOpenGL-笔记-其十一

Normal Mapping 又到了介绍法线贴图的地方,我感觉我已经写了很多遍了... 法线贴图用最简单的话来介绍的话,就是通过修改贴图对应物体表面的法线来修改光照效果,从而在不修改物体实际几何形状的前提下实现不同于物体几何形状的视觉效果。 因…...

@Docker Compose 部署 Prometheus

文章目录 Docker Compose 部署 Prometheus1. 环境准备2. 配置文件准备3. 编写 Docker Compose 文件4. 启动服务5. 验证部署6. 常用操作7. 生产环境增强建议8. 扩展监控对象 Docker Compose 部署 Prometheus 1. 环境准备 安装 Docker(版本 ≥ 20.10)和 …...

openppp2 -- 1.0.0.25225 优化多线接入运营商路由调配

本文涉及到的内容,涉及到上个发行版本相关内容,人们在阅读本文之前,建议应当详细阅读上个版本之中的VBGP技术相关的介绍。 openppp2 -- 1.0.0.25196 版本新增的VBGP技术-CSDN博客 我们知道在现代大型的 Internet 网络服务商,很多…...

二次封装 Vuex for Uniapp 微信小程序开发

作为高级前端开发工程师,我将为你提供一个针对 Uniapp Vue2 Vuex 的 Store 二次封装方案,使团队成员能够更便捷地使用和管理状态。 封装目标 模块化管理状态 简化调用方式 提供类型提示(在 Vue2 中尽可能实现) 便于维护和查…...

详细到用手撕transformer下半部分

之前我们讨论了如何实现 Transformer 的核心多头注意力机制,那么这期我们来完整地实现整个 Transformer 的编码器和解码器。 Transformer 架构最初由 Vaswani 等人在 2017 年的论文《Attention Is All You Need》中提出,专为序列到序列(seq2s…...

Spring Boot 整合 Spring Data JPA、strategy 的策略区别、什么是 Spring Data JPA

DAY29.2 Java核心基础 Spring Boot 整合 Spring Data JPA Spring Data JPA根据具体的数据库分为不同的子模块,无论是关系型数据库和非关系型数据库,Spring Data都提供了支持 Mysql:Spring Data JPA Redis:Spring Data Redis …...

Vue 3.0 中的路由导航守卫详解

1. 路由导航守卫 1.1. 全局前置守卫 Vue-Router 提供的导航守卫主要用来守卫路由的跳转或取消。它们可以植入到全局、单个路由或组件级别。 全局前置守卫可以使用 router.beforeEach 注册: const router createRouter({... });router.beforeEach((to, from) &g…...

【Sqoop基础】Sqoop生态集成:与HDFS、Hive、HBase等组件的协同关系深度解析

目录 1 Sqoop概述与大数据生态定位 2 Sqoop与HDFS的深度集成 2.1 技术实现原理 2.2 详细工作流程 2.3 性能优化实践 3 Sqoop与Hive的高效协同 3.1 集成架构设计 3.2 数据类型映射处理 3.3 案例演示 4 Sqoop与HBase的实时集成 4.1 数据模型转换挑战 4.2 详细集成流程…...

MySQL + CloudCanal + Iceberg + StarRocks 构建全栈数据服务

简述 在业务数据快速膨胀的今天,企业对 低成本存储 与 实时查询分析能力 的需求愈发迫切。 本文将带你实战构建一条 MySQL 到 Iceberg 的数据链路,借助 CloudCanal 快速完成数据迁移与同步,并使用 StarRocks 完成数据查询等操作,…...

MSVC支持但是Clang会报错的C++行为

MSVC的非标 目的友元别名模板类显式特例化的命名空间限制 目的 因为在使用clang进行ast分析msvc项目的时候,出现了爆红现象,了解到msvc会有一些不严格按照c标准但是允许的语法,在这点上clang就很严格,所以本文以clang为基准&…...

截屏精灵:轻松截屏,高效编辑

在移动互联网时代,截图已经成为我们日常使用手机时的一项基本操作。无论是记录重要信息、分享有趣内容,还是进行学习和工作,一款好用的截图工具都能极大地提升我们的效率。截屏精灵就是这样一款功能强大、操作简单的截图工具,它不…...

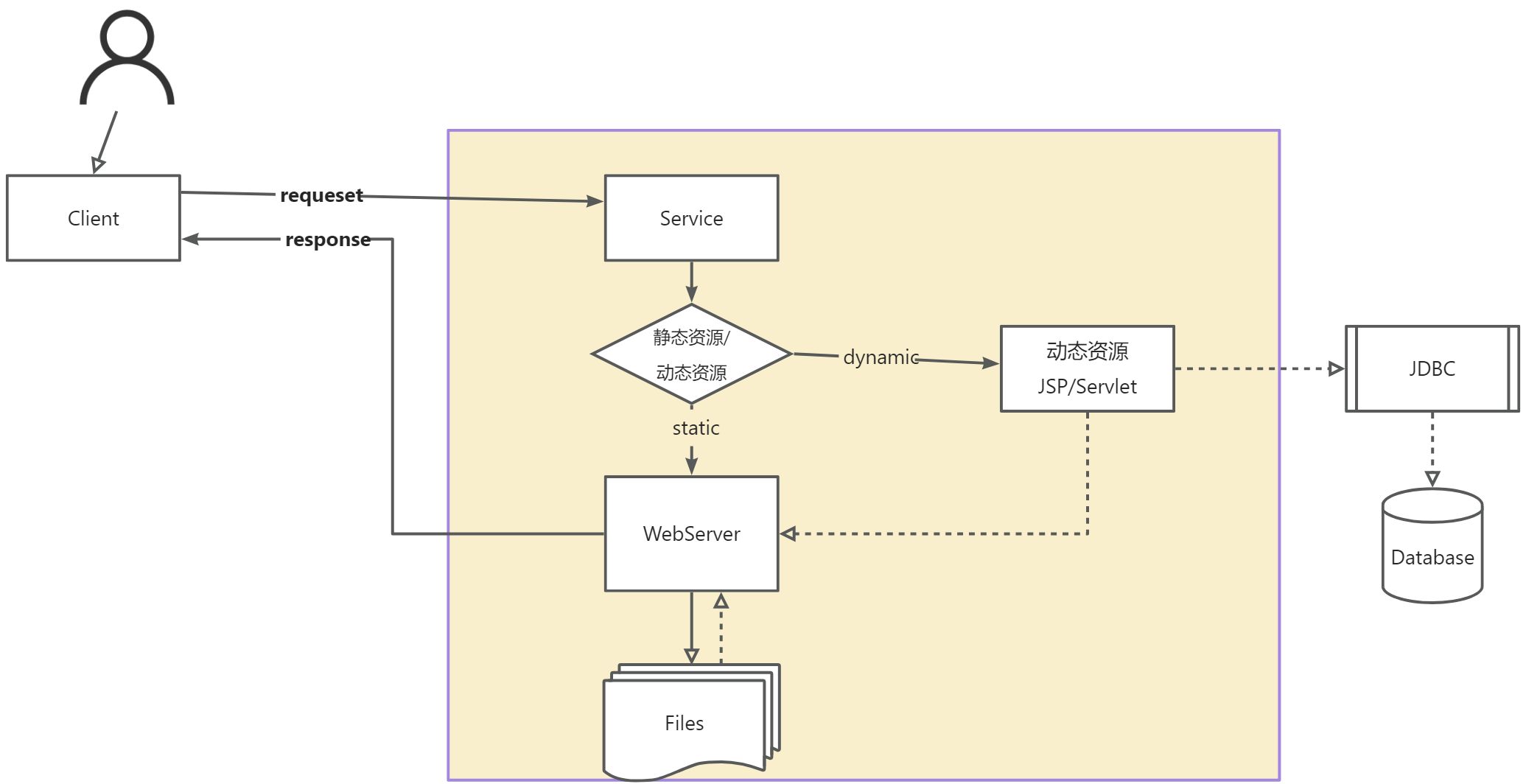

【JavaWeb】基本概念、web服务器、Tomcat、HTTP协议

目录 1. 基本概念1.1 基本概念1.2 web应用程序1.3 静态web1.4 动态web 2. web服务器3. tomcat详解3.1 安装3.2 启动3.3 配置3.3.1 配置启动的端口号3.3.2 配置主机的名称3.3.3 其他常用配置项日志配置数据源配置安全配置 3.4 发布一个网站 4. Http协议4.1 什么是http4.2 http的…...

黑马程序员C++核心编程笔记--4 类和对象--封装

C面向对象三大特征:封装、继承、多态 C认为万事万物皆对象,对象有其属性和行为,具有相同性质的对象可以抽象称为类 4.1 封装 4.1.1 封装的意义 将属性和行为作为一个整体,表现生活中的事物将属性和行为加以权限控制 在设计类…...

Debian:自由操作系统的精神图腾与技术基石

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 ——解码Linux世界最纯粹的开源哲学 一、Debian的诞生:从个人实验到全球协作 1993年,一位名为Ian Murdock的程序员在开源社区的启…...

云计算Linux Rocky day02(安装Linux系统、设备表示方式、Linux基本操作)

云计算Linux Rocky day02(安装Linux系统、设备表示方式、Linux基本操作) 目录 云计算Linux Rocky day02(安装Linux系统、设备表示方式、Linux基本操作)1、虚拟机VMware安装Rocky2、Linux命令行3、Linux Rocky修改字体大小和背景颜…...

在 ODROID-H3+ 上安装 Win11 系统

在 ODROID-H3 上安装 Windows 11 系统。 以下是完整的步骤,包括 BIOS 设置、U 盘制作、安装和驱动处理,全程不保留之前的系统数据。 ✅ 准备工作 1. 准备一个 ≥8GB 的 USB 启动盘 用另一台电脑制作 Windows 11 安装盘。 👉 推荐工具&…...

)

Docker常用命令操作指南(一)

Docker常用命令操作指南-1 一、Docker镜像相关命令1.1 搜索镜像(docker search)1.2 拉取镜像(docker pull)1.3 查看本地镜像(docker images)1.4 删除镜像(docker rmi) 二、Docker容器…...

什么是 SQL 注入?如何防范?

什么是 SQL 注入?如何防范? 1. SQL 注入概述 1.1 基本定义 SQL 注入(SQL Injection)是一种通过将恶意SQL 语句插入到应用程序的输入参数中,从而欺骗服务器执行非预期SQL命令的攻击技术。攻击者可以利用此漏洞绕过认证、窃取数据甚至破坏数据库。 关键结论:SQL 注入是O…...

使用el-input数字校验,输入汉字之后校验取消不掉

先说说复现方式 本来input是只能输入数字的,然后你不小心输入了汉字,触发校验了,然后这时候,你发现校验取消不掉了 就这样了 咋办啊,你一看校验没错啊,各种number啥的也写了,发现没问题啊 <el-inputv…...

Docker容器启动失败的常见原因分析

我们在开发部署的时候,用 Docker 打包环境,理论上是“我装好了你就能跑”。但理想很丰满,现实往往一 docker run 下去就翻车了。 今天来盘点一下我实际工作中经常遇到的 Docker 容器启动失败的常见原因,顺便给点 debug 的小技巧&a…...

Java提取markdown中的表格

Java提取markdown中的表格 说明 这篇博文是一个舍近求远的操作,如果只需要要对markdown中的表格数据进行提取,完全可以通过正在表达式或者字符串切分来完成。但是鉴于学习的目的,这次采用了commonmark包中的工具来完成。具体实现过程如下 实…...

立志成为一名优秀测试开发工程师(第七天)——unittest框架的学习

目录 unittest框架的学习 一、测试类的编写 创建相关测试类cal.py、CountTest.py 二、常见断言方法 使用unittest单元测试框架编写测试用例CountTest.py 注意:执行的时候光标一定要放在括号后面,鼠标右键运行 三、对测试环境的初始化和清除模块…...

:营收阶段的核心指标与盈利模型优化——从数据到商业决策的落地)

精益数据分析(85/126):营收阶段的核心指标与盈利模型优化——从数据到商业决策的落地

精益数据分析(85/126):营收阶段的核心指标与盈利模型优化——从数据到商业决策的落地 c。 一、营收健康度的核心指标:投资回报率模型 (一)季度再发性营收增长率(QRR) 该指标衡量…...

论坛系统(4)

用户详情 获取用户信息 实现逻辑 ⽤⼾提交请求,服务器根据是否传⼊Id参数决定返回哪个⽤⼾的详情 1. 不传⽤⼾Id,返回当前登录⽤⼾的详情(从session获取) 2. 传⼊⽤⼾Id,返回指定Id的⽤⼾详情(根据用户id去查) 俩种方式获得用户信息 参…...

本地Markdown开源知识库选型指南

本地Markdown开源知识库选型指南 以下是几款优秀的本地Markdown开源知识库解决方案,适合不同需求场景: 1. Obsidian (非完全开源但免费) 特点:基于Markdown的本地优先知识管理,丰富的插件生态优势:双向链接、图形视…...

【.net core】SkiaSharp 如何在Linux上实现

1. 安装依赖库 首先需要安装 SkiaSharp 运行时依赖: # Ubuntu/Debian sudo apt-get update sudo apt-get install -y libfontconfig1 libfreetype6 libx11-6 libx11-xcb1 libxcb1 \libxcomposite1 libxcursor1 libxdamage1 libxi6 libxtst6 \libnss3 libcups2 lib…...

后端项目中静态文案国际化语言包构建选型

这是一个很关键的问题。在做国际化(i18n)时,不同语言包格式如 .resx、.properties 和 .json 都可用,但各自有适用场景、特性与限制,你在选择时可以根据你的开发语言、生态和维护成本权衡。 ✅ 一张对比表:.…...

前端面经 React常见的生命周期

初始化阶段 constructor state的初始化,防抖节流的绑定getDerivedStateFromProps 静态函数 当作纯函数使用 传入props和state,合并成一个新的statecomponentWillMount 组件如果有getDrivedStatefromprops不会执行 针对一些接口的预请求时使用rendercomp…...