三、kafka消费的全流程

五、多线程安全问题

1、多线程安全的定义

使用多线程访问一个资源,这个资源始终都能表现出正确的行为。

不被运行的环境影响、多线程可以交替访问、不需要任何额外的同步和协同。

2、Java实现多线程安全生产者

这里只是模拟多线程环境下使用生产者发送消息,其实没有做额外的线程安全操作,就是把生产者当成了一个公共资源,所有线程都可以访问这个生产者。

kafka默认客户端提供的生产者本身就是线程安全的,因为生产者发送消息只有一步操作,就是发送消息。只要消息进入消息缓冲区就可以发送给broker,不会出现消息重复发送。

package com.allwe.client.concurrent;import com.allwe.client.partitioner.MyPartitioner;

import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.common.serialization.StringSerializer;import java.util.Properties;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;/*** 生产者多线程安全 - 测试demo** @Author: AllWe* @Date: 2024/09/27/9:30*/

@Data

@Slf4j

public class ConcurrentProducerWorker {/*** 消息数量*/private static final int RECORD_COUNT = 1000;/*** 固定线程池 - 线程数等于CPU核数*/private static final ExecutorService executorService = Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors());/*** 发令枪*/private static final CountDownLatch countDownLatch = new CountDownLatch(RECORD_COUNT);/*** 生产者 - 这里让所有的线程都共享同一个生产者*/private static KafkaProducer<String, String> kafkaProducer;/*** 类初始化的时候 - 创建生产者实例*/static {// 设置属性Properties properties = new Properties();properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "127.0.0.1:9092");properties.put("key.serializer", StringSerializer.class);properties.put("value.serializer", StringSerializer.class);properties.put(ProducerConfig.PARTITIONER_CLASS_CONFIG, MyPartitioner.class);kafkaProducer = new KafkaProducer<>(properties);}/*** 启动器*/public static void main(String[] args) {try {// 循环创建消息for (int count = 0; count < RECORD_COUNT; count++) {ProducerRecord<String, String> record = new ProducerRecord<>("topic_6", "allwe", "allwe_" + count);executorService.submit(new ConcurrentProducer(record, kafkaProducer, countDownLatch));}countDownLatch.await();} catch (Exception e) {e.printStackTrace();} finally {// 关闭生产者连接kafkaProducer.close();// 释放线程池资源executorService.shutdown();}}

}

package com.allwe.client.concurrent;import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;import java.util.concurrent.CountDownLatch;/*** 生产者多线程安全 - 测试demo** @Author: AllWe* @Date: 2024/09/27/9:30*/

@Data

@Slf4j

public class ConcurrentProducer implements Runnable {/*** 消息体*/private ProducerRecord<String, String> record;/*** 生产者*/private KafkaProducer<String, String> producer;/*** 发令枪*/private CountDownLatch countDownLatch;public ConcurrentProducer(ProducerRecord<String, String> record, KafkaProducer<String, String> producer, CountDownLatch countDownLatch) {this.record = record;this.producer = producer;this.countDownLatch = countDownLatch;}@Overridepublic void run() {try {String name = Thread.currentThread().getName();producer.send(record, new ConcurrentCallBackImpl(name));countDownLatch.countDown();} catch (Exception e) {e.printStackTrace();}}

}

package com.allwe.client.concurrent;import cn.hutool.core.util.ObjectUtil;

import org.apache.kafka.clients.producer.Callback;

import org.apache.kafka.clients.producer.RecordMetadata;/*** 异步发送消息回调解析器** @Author: AllWe* @Date: 2024/09/27/9:30*/

public class ConcurrentCallBackImpl implements Callback {private String threadName;public ConcurrentCallBackImpl(String threadName) {this.threadName = threadName;}@Overridepublic void onCompletion(RecordMetadata recordMetadata, Exception e) {if (ObjectUtil.isNull(e)) {// 解析回调元数据System.out.println(threadName + "|-offset:" + recordMetadata.offset() + ",partition:" + recordMetadata.partition());} else {e.printStackTrace();}}

}

3、Java实现多线程安全消费者

kafka客户端提供的消费者不是多线程安全的,是因为消费者在消费消息的时候,需要有2步操作:取消息和ACK确认,在多线程场景下可能会出现:

① 线程1取到了消息,但是没来得及进行ACK确认。

② 线程2进来了,又消费了一次相同的消息。

③ 线程2提交ACK确认。

④ 线程1提交ACK确认。

这样就会产生重复消费,这个时候就需要对消费者进行额外处理。

有两个处理方案:

① 给消费过程加锁,但是会降低程序执行效率。

② 每一个线程都创建自己的消费者,只消费自己分区内的数据。

我写的demo是使用第二种办法。

package com.allwe.client.concurrent;import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;import java.time.Duration;

import java.util.Collections;

import java.util.Properties;/*** 线程安全消费者 - 测试demo** @Author: AllWe* @Date: 2024/09/27/12:19*/

@Data

@Slf4j

public class ConcurrentConsumer implements Runnable {/*** 消费者配置参数*/private Properties properties;/*** 群组id*/private String groupId;/*** 消费主题*/private String topicName;/*** 消费者实例*/private KafkaConsumer<String, String> consumer;public ConcurrentConsumer(Properties properties, String groupId, String topicName) {this.properties = properties;this.groupId = groupId;this.topicName = topicName;// 补充配置参数properties.put(ConsumerConfig.GROUP_ID_CONFIG, groupId);// 创建消费者实例 - 每一个线程都创建自己的消费者,避免共享相同的消费者实例consumer = new KafkaConsumer<>(properties);// 配置消费主题consumer.subscribe(Collections.singleton(topicName));}@Overridepublic void run() {try {String threadName = Thread.currentThread().getName();while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofSeconds(1));for (ConsumerRecord<String, String> record : records) {StringBuilder stringBuilder = new StringBuilder(threadName).append("|-");stringBuilder.append("partition:").append(record.partition());stringBuilder.append("offset:").append(record.offset());stringBuilder.append("key:").append(record.key());stringBuilder.append("value:").append(record.value());System.out.println(stringBuilder);}}} finally {consumer.close();}}

}

package com.allwe.client.concurrent;import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.common.serialization.StringDeserializer;import java.util.Properties;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;/*** 多线程安全消费者 - 测试demo** @Author: AllWe* @Date: 2024/09/27/12:34*/

@Data

@Slf4j

public class ConcurrentConsumerWorker {/*** 消费线程数*/private static final Integer THREAD_COUNT = 2;/*** 线程池 - 2个线程,别超过目标主题的分区数*/private static ExecutorService executorService = Executors.newFixedThreadPool(THREAD_COUNT);public static void main(String[] args) {// 消费者配置Properties properties = new Properties();properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "127.0.0.1:9092");properties.put("key.deserializer", StringDeserializer.class);properties.put("value.deserializer", StringDeserializer.class);properties.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest"); // 从头开始消费for (Integer i = 0; i < THREAD_COUNT; i++) {executorService.submit(new ConcurrentConsumer(properties, "allwe01", "topic_6"));}}

}

六、群组协调

1、群主

在每一个群组内部,都有一个【群主】。往往是第一个注册进入群组的消费者承担,它的职责是读取当前群组消费的主题,以及目标主题的分区信息。

群主节点的数据权限高于普通消费者,它可以获取全部消费者节点对应的分区信息。但是普通消费者节点只能看见本节点的分区信息。

2、消费者协调器

属于客户端,每个消费者群组内部都有一个消费者协调器,用于获取群主节点保存的分区信息,再协调群组内的其他消费者处理哪些主题和分区。

分配好任务后将配置信息推送给【组协调器】,组协调器再将消息发送给不同的消费者。

当群组内出现某个节点掉线、上线时,消费者协调器也会参与协调。

1、向【组协调器】发送入组请求。

2、发起同步组的请求 -- 由群组计算分配策略,确定消费者的分区划分,发送给组协调器。

3、心跳机制(与组协调器维持)。

4、提交ACK确认(发起已经提交的消费偏移量的请求)。

5、主动发起离组请求。

3、组协调器

属于kafka broker,主要负责以下功能:

1、处理申请加入群组的消费者,并且选举群主。

2、收到同步组的请求后,触发分区再均衡,同步新的分配方案。

3、心跳机制(与客户端维持),如果得知哪些客户端掉线了,触发分区再均衡机制。

4、管理消费者已经消费的偏移量,保存在主题【__consumer_offsets】,默认有50个分区。

4、新的消费者加入群组的处理流程

1、消费者客户端启动、重连,都会给组协调器发送一个入组请求(joinGroup请求)。

2、消费者客户端完成joinGroup后,消费者协调器向组协调器发起同步组请求(SyncGroup请求),获取新的分配方案。

3、入组后保持心跳(客户端控制参数:max.poll.interval.ms)。

4、消费者客户端掉线,触发离组处理。

5、消费者群组的信息存储在哪里

存储在__consumer_offsets文件中,groupName.hashCode() % 50,获取配置文件的编号。

七、分区再均衡

1、功能

针对单个消费者群组,对群组内的消费者负责的分区进行重新分配。

1、假设【主题α】有三个分区,分别是①、②、③。

2、进来两个消费者A、B。A负责分区①,B负责分区②③。

3、又进来一个消费者C,再均衡监听器就把分区③分配给C。

4、消费者C掉线,再均衡监听器把分区③分配给A或者B。

2、Java代码验证分区再均衡

package com.allwe.client.reBalance;import lombok.Data;

import org.apache.kafka.clients.consumer.ConsumerRebalanceListener;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.clients.consumer.OffsetAndMetadata;

import org.apache.kafka.common.TopicPartition;import java.util.Collection;

import java.util.Map;

import java.util.concurrent.ConcurrentHashMap;/*** 分区再均衡处理器** @Author: AllWe* @Date: 2024/10/17/8:05*/

@Data

public class ReBalanceHandler implements ConsumerRebalanceListener {// 记录每个分区的消费偏移量public final static ConcurrentHashMap<TopicPartition, Long> partitionOffsetMap = new ConcurrentHashMap<TopicPartition, Long>();private final Map<TopicPartition, OffsetAndMetadata> currOffsets;private final KafkaConsumer<String, String> consumer;public ReBalanceHandler(Map<TopicPartition, OffsetAndMetadata> currOffsets, KafkaConsumer<String, String> consumer) {this.currOffsets = currOffsets;this.consumer = consumer;}// 分区再均衡之前// 某一个消费者在让出分区之前,需要先将已消费的偏移量提交@Overridepublic void onPartitionsRevoked(Collection<TopicPartition> collection) {// 线程idfinal String id = Thread.currentThread().getId() + "";System.out.println(id + "-onPartitionsRevoked参数值为:" + collection);System.out.println(id + "-服务器准备分区再均衡,提交偏移量。当前偏移量为:" + currOffsets);//我们可以不使用consumer.commitSync(currOffsets);//提交偏移量到kafka,由我们自己维护*///开始事务//偏移量写入数据库System.out.println("分区偏移量表中:" + partitionOffsetMap);for (TopicPartition topicPartition : collection) {partitionOffsetMap.put(topicPartition, currOffsets.get(topicPartition).offset());}// 同步提交偏移量,等到成功后再往后执行consumer.commitSync(currOffsets);}// 分区再均衡之后// 新的消费者接管分区后,从上一次的偏移量开始消费@Overridepublic void onPartitionsAssigned(Collection<TopicPartition> collection) {// 线程idfinal String threadId = Thread.currentThread().getId() + "";System.out.println(threadId + "|-再均衡完成,onPartitionsAssigned参数值为:" + collection);System.out.println("分区偏移量表中:" + partitionOffsetMap);for (TopicPartition topicPartition : collection) {System.out.println(threadId + "-topicPartition" + topicPartition);// 取得接管分区之前的偏移量Long offset = partitionOffsetMap.get(topicPartition);if (offset == null) continue;consumer.seek(topicPartition, partitionOffsetMap.get(topicPartition));}}@Overridepublic void onPartitionsLost(Collection<TopicPartition> partitions) {ConsumerRebalanceListener.super.onPartitionsLost(partitions);}

}

package com.allwe.client.reBalance;import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.*;

import org.apache.kafka.common.TopicPartition;import java.time.Duration;

import java.util.Collections;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;/*** 线程安全消费者 - 测试demo** @Author: AllWe* @Date: 2024/09/27/12:19*/

@Data

@Slf4j

public class ConcurrentConsumer implements Runnable {/*** 消费者配置参数*/private Properties properties;/*** 群组id*/private String groupId;/*** 消费主题*/private String topicName;/*** 消费者实例*/private KafkaConsumer<String, String> consumer;/*** 记录分区消费者偏移量*/private final Map<TopicPartition, OffsetAndMetadata> currOffsets = new HashMap<>();public ConcurrentConsumer(Properties properties, String groupId, String topicName) {this.properties = properties;this.groupId = groupId;this.topicName = topicName;// 补充配置参数properties.put(ConsumerConfig.GROUP_ID_CONFIG, groupId);// 创建消费者实例 - 每一个线程都创建自己的消费者,避免共享相同的消费者实例consumer = new KafkaConsumer<>(properties);// 配置消费主题 - 配置再均衡监听器consumer.subscribe(Collections.singleton(topicName), new ReBalanceHandler(currOffsets,consumer));}@Overridepublic void run() {try {String threadName = Thread.currentThread().getName();Integer offset = 0;while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofSeconds(1));for (ConsumerRecord<String, String> record : records) {StringBuilder stringBuilder = new StringBuilder(threadName).append("|-");stringBuilder.append("partition:").append(record.partition());stringBuilder.append(",offset:").append(record.offset());stringBuilder.append(",key:").append(record.key());stringBuilder.append(",value:").append(record.value());System.out.println(stringBuilder);offset++;currOffsets.put(new TopicPartition(record.topic(), record.partition()), new OffsetAndMetadata(offset, "no"));}}} finally {consumer.close();}}

}

自定义一个再均衡监听器,消费者在订阅接口中指定这个监听器,即可自动执行监听器的任务。

// 配置消费主题 - 配置再均衡监听器

consumer.subscribe(Collections.singleton(topicName), new ReBalanceHandler(currOffsets,consumer));相关文章:

三、kafka消费的全流程

五、多线程安全问题 1、多线程安全的定义 使用多线程访问一个资源,这个资源始终都能表现出正确的行为。 不被运行的环境影响、多线程可以交替访问、不需要任何额外的同步和协同。 2、Java实现多线程安全生产者 这里只是模拟多线程环境下使用生产者发送消息&…...

商品模块中的多规格设计:实现方式与电商/ERP系统的架构对比

在商品管理系统中,多规格设计(Multi-Specification Product Design)是一个至关重要但又极具挑战性的领域。无论是面向消费者的电商系统,还是面向企业管理的ERP系统,对商品规格的处理方式直接影响库存管理、订单履约、数…...

动手学线性神经网络:从数学原理到代码实现)

(三)动手学线性神经网络:从数学原理到代码实现

1 线性回归 线性回归是一种基本的预测模型,用于根据输入特征预测连续的输出值。它是机器学习和深度学习中最简单的模型之一,但却是理解更复杂模型的基础。 1.1 线性回归的基本元素 概念理解: 线性回归假设输入特征和输出之间存在线性关系。…...

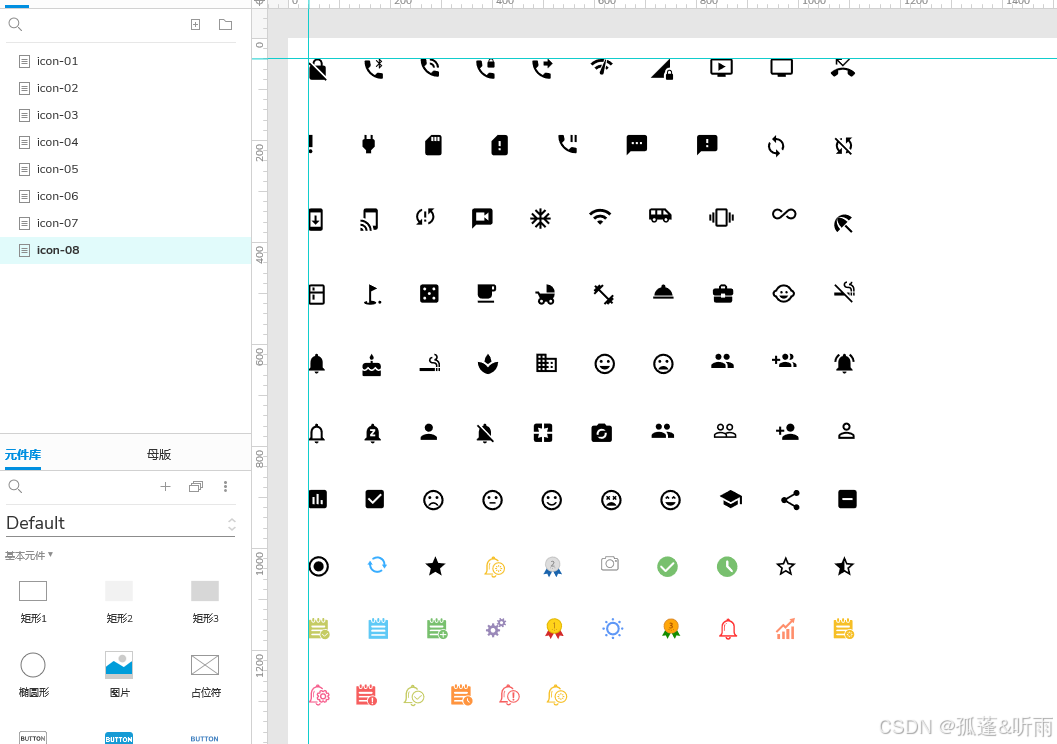

Axure形状类组件图标库(共8套)

点击下载《月下倚楼图标库(形状组件)》 原型效果:https://axhub.im/ax9/02043f78e1b4386f/#g1 摘要 本图标库集锦精心汇集了8套专为Axure设计的形状类图标资源,旨在为产品经理、UI/UX设计师以及开发人员提供丰富多样的设计素材,提升原型设计…...

20250530-C#知识:String与StringBuilder

String与StringBuilder string字符串在开发中经常被用到,不过在需要频繁对字符串进行增加和删除时,使用StringBuilder有利于提升效率。 1、String string是一种引用类型而非值类型(某些方面像值类型)使用“”进行两个string对象的…...

从 Docker 到 Containerd:Kubernetes 容器运行时迁移实战指南

一、背景 Kubernetes 自 v1.24 起移除了 dockershim,不再原生支持 Docker Engine,用户需迁移至受支持的 CRI 兼容运行时,如: Containerd(推荐,高性能、轻量级) CRI-O(专为 Kuberne…...

uniapp中view标签使用范围

不止用于微信小程序。兼容型号,是uniapp内置组件之一,在uniapp中进行了跨平台适配。支持所有uniapp的平台。如微信小程序、h5、app、支付宝小程序...

Celery 核心概念详解及示例

Celery 核心概念详解及示例 Celery 是一个简单、灵活且可靠的分布式系统,用于处理大量消息,提供对任务队列的操作,并支持任务的调度和异步执行。它常用于深度优化 Web 应用的性能和响应速度,通过将耗时的操作移到后台异步执行&am…...

欢乐熊大话蓝牙知识14:用 STM32 或 EFR32 实现 BLE 通信模块:从0到蓝牙,你也能搞!

🚀 用 STM32 或 EFR32 实现 BLE 通信模块:从0到蓝牙,你也能搞! “我能不能自己用 STM32 或 EFR32 实现一个 BLE 模块?” 答案当然是:能!还能很帅! 👨🏭 前…...

IDEA 在公司内网配置gitlab

赋值项目链接 HTTPS 将HTTP的链接 ip地址换成 内网地址 例如:https:172.16.100.18/...... 如果出现需要需要Token验证的情况: 参考:Idea2024中拉取代码时GitLab提示输入token的问题_gitlab token-CSDN博客...

黑马Java面试笔记之 微服务篇(业务)

一. 限流 你们项目中有没有做过限流?怎么做的? 为什么要限流呢? 一是并发的确大(突发流量) 二是防止用户恶意刷接口 限流的实现方式: Tomcat:可以设置最大连接数 可以通过maxThreads设置最大Tomcat连接数,实现限流,但是适用于单体架构 Nginx:漏桶算法网关,令牌桶算法自定…...

通过WiFi无线连接小米手机摄像头到电脑的方法

通过WiFi无线连接小米手机摄像头到电脑的方法 以下是基于Scrcpy和DroidCam两种工具的无线连接方案,需提前完成开发者模式与USB调试的开启(参考原教程步骤): 方法一:Scrcpy无线投屏(无需手机端安装…...

长短期记忆(LSTM)网络模型

一、概述 长短期记忆(Long Short-Term Memory,LSTM)网络是一种特殊的循环神经网络(RNN),专门设计用于解决传统 RNN 在处理长序列数据时面临的梯度消失 / 爆炸问题,能够有效捕捉长距离依赖关系。…...

深入理解 Linux 文件系统与日志文件分析

一、Linux 文件系统概述 1. 文件系统的基本概念 文件系统(File System)是操作系统用于管理和组织存储设备上数据的机制。它提供了一种结构,使得用户和应用程序能够方便地存储和访问数据。 2. Linux 文件系统结构 Linux 文件系统采用树状目…...

CSS3美化页面元素

1. 字体 <span>标签 字体样式⭐ 字体类型(font-family) 字体大小(font-size) 字体风格(font-style) 字体粗细(font-weight) 字体属性(font) 2. 文本 文…...

3-0 等级保护测评要求现行技术标准)

网络安全-等级保护(等保)3-0 等级保护测评要求现行技术标准

################################################################################ 第三章:测评要求、测评机构要求,最终目的是通过测评,所以我们将等保要求和测评相关要求一一对应形成表格。 GB/T 28448-2019 《信息安全技术 网络安全等…...

WPS 利用 宏 脚本拆分 Excel 多行文本到多行

文章目录 WPS 利用 宏 脚本拆分 Excel 多行文本到多行效果需求背景🛠 操作步骤代码实现代码详解使用场景注意事项总结 WPS 利用 宏 脚本拆分 Excel 多行文本到多行 在 Excel 工作表中,我们经常遇到一列中包含多行文本(用换行符分隔ÿ…...

R语言错误处理方法大全

在R语言的批量运行中,常需要自动跳过错误,继续向下运行。 1、使用 tryCatch() 捕获错误并返回占位符 # 示例:循环中跳过错误继续执行 results <- numeric(5) # 预分配结果向量for(i in 1:5) {# 用 tryCatch 包裹可能出错的代码results[…...

AI“实体化”革命:具身智能如何重构体育、工业与未来生活

近年来,人工智能(AI)技术的飞速发展正在重塑各行各业,而具身智能(Embodied AI)作为AI领域的重要分支,正逐渐从实验室走向现实应用。具身智能的核心在于让AI系统具备物理实体,能够与环…...

Opencv4 c++ 自用笔记 05 形态学操作

图像形态学主要获取物体的形状与位置信息。利用具有一定形态的结构元素度量和提取图像中的对应形状,达到对图像分析和识别的目的。操作主要包括腐蚀、膨胀、开运算和闭运算。 像素距离与连通域 图像形态学中,将不与其他区域链接的独立区域称为集合或者…...

DrissionPage 数据提取技巧全解析:从入门到实战

在当今数据驱动的时代,网页数据提取已成为自动化办公、市场分析和爬虫开发的核心技能。作为新一代网页自动化工具,DrissionPage 以其独特的双模式融合设计(Selenium Requests)脱颖而出。本文将结合官方文档与实战案例,…...

如何构建自适应架构的镜像

目标 我有一个服务叫xxx,一开始它运行在x86架构的机器上,所以最开始有个xxx:stable-amd64的镜像,后来它又需要运行在arm64架构的机器上,所以又重新打了个xxx:stable-arm64的镜像 但是对于安装脚本来说,我不希望我在拉…...

R语言基础| 创建数据集

在R语言中,有多种数据类型,用以存储和处理数据。每种数据类型都有其特定的用途和操作函数,使得R语言在处理各种数据分析任务时非常灵活和强大: 向量(Vector): 向量是R语言中最基本的数据类型,它…...

剑指offer15_数值的整数次方

数值的整数次方 实现函数 double Power(double base, int exponent) 题目要求 计算 base exponent \text{base}^{\text{exponent}} baseexponent: 不得使用库函数不需要考虑大数问题,绝对误差不超过 10 − 2 10^{-2} 10−2不会出现底数和指数同为 0…...

Centos7搭建zabbix6.0

此方法适用于zabbix6以上版本zabbix6.0前期环境准备:Lamp(linux httpd mysql8.0 php)mysql官网下载位置:https://dev.mysql.com/downloads/mysql/Zabbix源码包地址:https://www.zabbix.com/cn/download_sourcesZabbix6…...

使用Redis的四个常见问题及其解决方案

Redis 缓存穿透 定义:redis查询一个不存在的数据,导致每次都查询数据库 解决方案: 如果查询的数据为空,在redis对应的key缓存空数据,并设置短TTL。 因为缓存穿透通常是因为被恶意用不存在的查询参数进行压测攻击&…...

Docker 部署前后端分离项目

1.Docker 1.1 什么是 Docker ? Docker 是一种开源的 容器化平台,用于开发、部署和运行应用程序。它通过 容器(Container) 技术,将应用程序及其依赖项打包在一个轻量级、可移植的环境中,确保应用在不同计算…...

云游戏混合架构

云游戏混合架构通过整合本地计算资源与云端能力,形成了灵活且高性能的技术体系,其核心架构及技术特征可概括如下: 一、混合架构的典型模式 分层混合模式 前端应用部署于公有云(如渲染流化服务),后端逻辑…...

【小红书】API接口,获取笔记核心数据

小红书笔记核心数据API接口详解 - 深圳小于科技提供专业数据服务 深圳小于科技(官网:https://www.szlessthan.com)推出的小红书笔记核心数据API接口,为开发者提供精准的笔记互动数据分析能力,助力内容运营与商业决策。…...

会议室钥匙总丢失?换预约功能的智能门锁更安全

在企业日常运营中,会议室作为重要的沟通与协作场所,其管理效率与安全性直接影响着企业的运作顺畅度。然而,传统会议室管理方式中钥匙丢失、管理不便等问题频发,给企业带来了不少困扰。近期,某企业引入了启辰智慧预约系…...