ResNet50卷积神经网络输出数据形参分析-笔记

ResNet50卷积神经网络输出数据形参分析-笔记

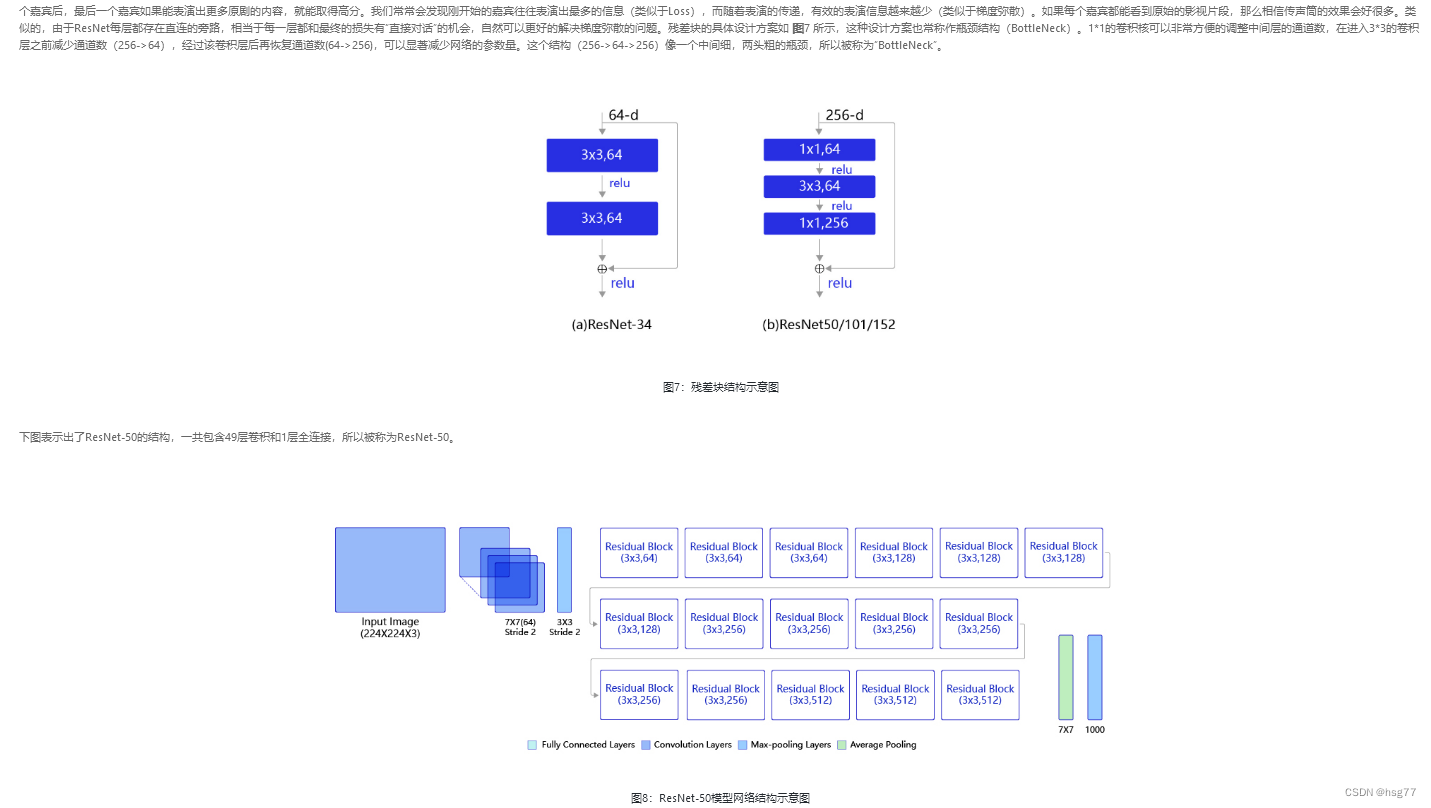

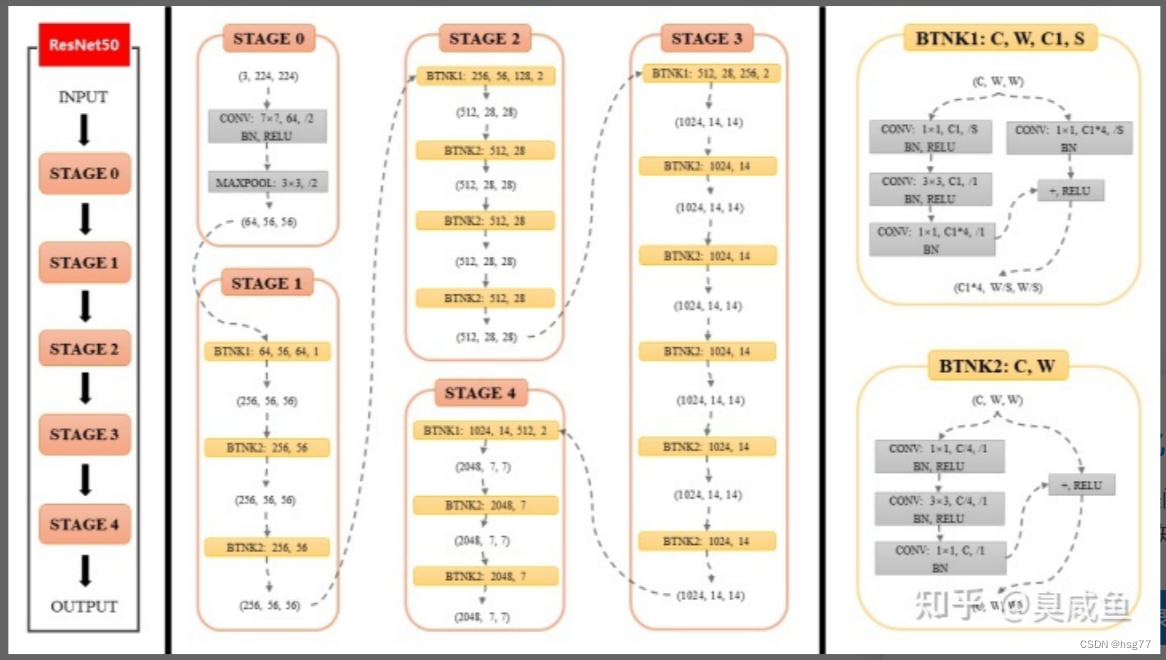

ResNet50包含多个模块,其中第2到第5个模块分别包含3、4、6、3个残差块

50=49个卷积(3+4+6+3)*3+1和一个全连接层

分析结果为:

输入数据形状:[10, 3, 224, 224]

最后输出结果:linear_0 [10, 1] [2048, 1] [1]

ResNet50包含多个模块,其中第2到第5个模块分别包含3、4、6、3个残差块

第1模块:7X7(64) 一个卷积

第2模块:3X3(64) 三个残差块=9个卷积

第3模块:3X3(128) 四个残差块=12个卷积

第4模块:3X3(256) 六个残差块=18个卷积

第5模块:3X3(512) 三个残差块=9个卷积

最后一个全连接层

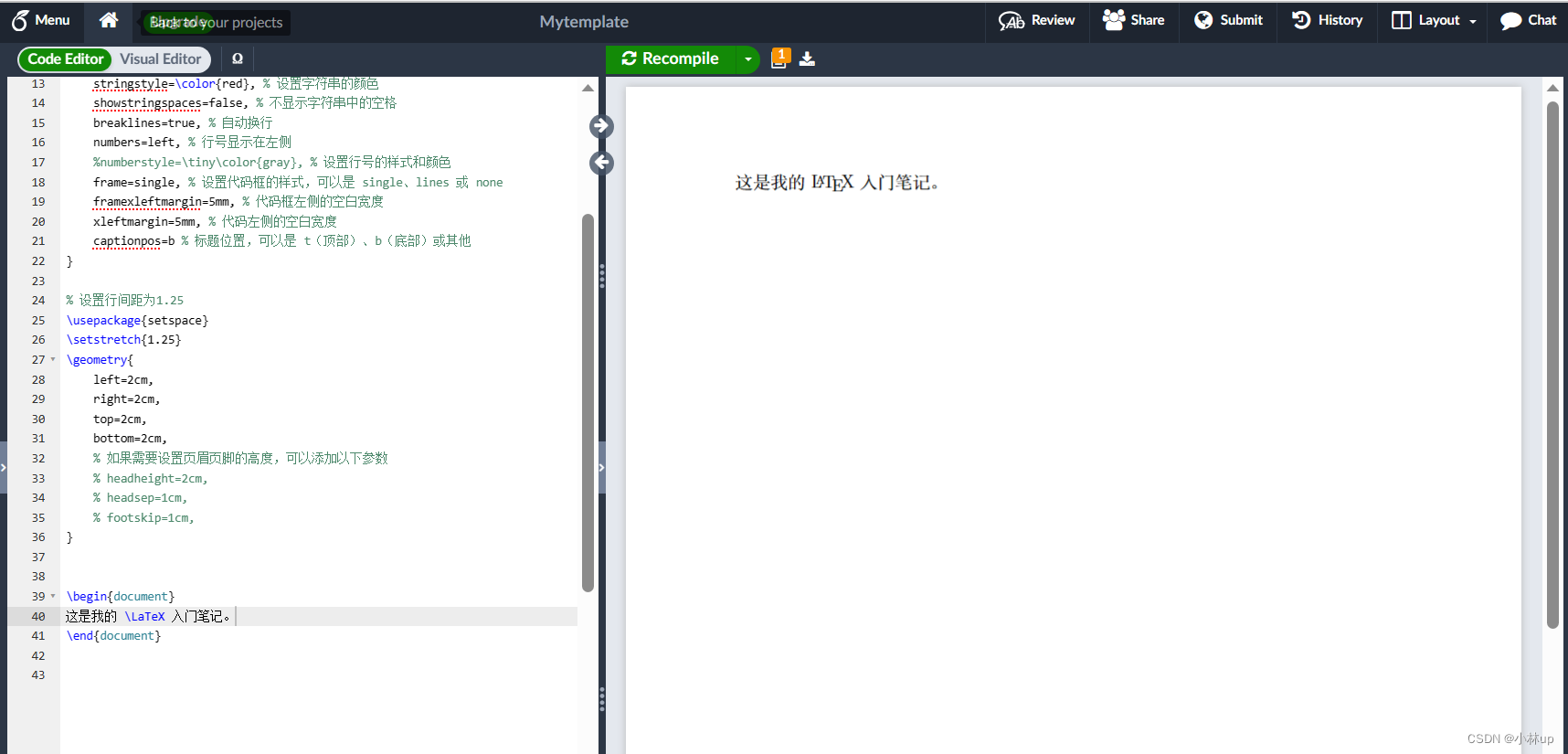

分析详细过程如下所示:

PS E:\project\python> & D:/ProgramData/Anaconda3/python.exe e:/project/python/PM/ResNet_PM_test.py

layers= 50

W0804 20:41:04.044713 18388 gpu_resources.cc:61] Please NOTE: device: 0, GPU Compute Capability: 6.1, Driver API Version: 12.2, Runtime API Version: 10.2

W0804 20:41:04.053730 18388 gpu_resources.cc:91] device: 0, cuDNN Version: 7.6.

block= 0 depth[block]= 3 Cout=256

bottleneck[ 256 64 False

bottleneck[ 256 64 True

bottleneck[ 256 64 True

create bnb 3

block= 1 depth[block]= 4 Cout=512

bottleneck[ 512 128 False

bottleneck[ 512 128 True

bottleneck[ 512 128 True

bottleneck[ 512 128 True

create bnb 4

block= 2 depth[block]= 6 Cout=1024

bottleneck[ 1024 256 False

bottleneck[ 1024 256 True

bottleneck[ 1024 256 True

bottleneck[ 1024 256 True

bottleneck[ 1024 256 True

bottleneck[ 1024 256 True

create bnb 6

block= 3 depth[block]= 3 Cout=2048

bottleneck[ 2048 512 False

bottleneck[ 2048 512 True

bottleneck[ 2048 512 True

create bnb 3

[10, 3, 224, 224]

conv2d_0 [10, 64, 112, 112] [64, 3, 7, 7] [ 64 ]

D:\ProgramData\Anaconda3\lib\site-packages\paddle\nn\layer\norm.py:712: UserWarning: When training, we now always track global mean and variance.warnings.warn(

conv_bn_layer_0 [10, 64, 112, 112]

maxpool2d: [10, 64, 56, 56]

======start bottleneckBlock:

#第二个模块 Cout=256 包括三个残差块bottleneckBlock

-----print bottleneckBlock: 0

conv2d_1 [10, 64, 56, 56] [64, 64, 1, 1] [ 64 ]

conv2d_2 [10, 64, 56, 56] [64, 64, 3, 3] [ 64 ]

conv2d_3 [10, 256, 56, 56] [256, 64, 1, 1] [ 256 ]

conv2d_4 [10, 256, 56, 56] [256, 64, 1, 1] [ 256 ]

end block: [10, 256, 56, 56]

-----print bottleneckBlock: 1

conv2d_5 [10, 64, 56, 56] [64, 256, 1, 1] [ 64 ]

conv2d_6 [10, 64, 56, 56] [64, 64, 3, 3] [ 64 ]

conv2d_7 [10, 256, 56, 56] [256, 64, 1, 1] [ 256 ]

end block: [10, 256, 56, 56]

-----print bottleneckBlock: 2

conv2d_8 [10, 64, 56, 56] [64, 256, 1, 1] [ 64 ]

conv2d_9 [10, 64, 56, 56] [64, 64, 3, 3] [ 64 ]

conv2d_10 [10, 256, 56, 56] [256, 64, 1, 1] [ 256 ]

end block: [10, 256, 56, 56]

#第三个模块 Cout=512 包括四个残差块bottleneckBlock

-----print bottleneckBlock: 3

conv2d_11 [10, 128, 56, 56] [128, 256, 1, 1] [ 128 ]

conv2d_12 [10, 128, 28, 28] [128, 128, 3, 3] [ 128 ]

conv2d_13 [10, 512, 28, 28] [512, 128, 1, 1] [ 512 ]

conv2d_14 [10, 512, 28, 28] [512, 256, 1, 1] [ 512 ]

end block: [10, 512, 28, 28]

-----print bottleneckBlock: 4

conv2d_15 [10, 128, 28, 28] [128, 512, 1, 1] [ 128 ]

conv2d_16 [10, 128, 28, 28] [128, 128, 3, 3] [ 128 ]

conv2d_17 [10, 512, 28, 28] [512, 128, 1, 1] [ 512 ]

end block: [10, 512, 28, 28]

-----print bottleneckBlock: 5

conv2d_18 [10, 128, 28, 28] [128, 512, 1, 1] [ 128 ]

conv2d_19 [10, 128, 28, 28] [128, 128, 3, 3] [ 128 ]

conv2d_20 [10, 512, 28, 28] [512, 128, 1, 1] [ 512 ]

end block: [10, 512, 28, 28]

-----print bottleneckBlock: 6

conv2d_21 [10, 128, 28, 28] [128, 512, 1, 1] [ 128 ]

conv2d_22 [10, 128, 28, 28] [128, 128, 3, 3] [ 128 ]

conv2d_23 [10, 512, 28, 28] [512, 128, 1, 1] [ 512 ]

end block: [10, 512, 28, 28]

#第四个模块 Cout=1024 包括六个残差块bottleneckBlock

-----print bottleneckBlock: 7

conv2d_24 [10, 256, 28, 28] [256, 512, 1, 1] [ 256 ]

conv2d_25 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_26 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

conv2d_27 [10, 1024, 14, 14] [1024, 512, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

-----print bottleneckBlock: 8

conv2d_28 [10, 256, 14, 14] [256, 1024, 1, 1] [ 256 ]

conv2d_29 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_30 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

-----print bottleneckBlock: 9

conv2d_31 [10, 256, 14, 14] [256, 1024, 1, 1] [ 256 ]

conv2d_32 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_33 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

-----print bottleneckBlock: 10

conv2d_34 [10, 256, 14, 14] [256, 1024, 1, 1] [ 256 ]

conv2d_35 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_36 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

-----print bottleneckBlock: 11

conv2d_37 [10, 256, 14, 14] [256, 1024, 1, 1] [ 256 ]

conv2d_38 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_39 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

-----print bottleneckBlock: 12

conv2d_40 [10, 256, 14, 14] [256, 1024, 1, 1] [ 256 ]

conv2d_41 [10, 256, 14, 14] [256, 256, 3, 3] [ 256 ]

conv2d_42 [10, 1024, 14, 14] [1024, 256, 1, 1] [ 1024 ]

end block: [10, 1024, 14, 14]

#第五个模块 Cout=2048 包括三个残差块bottleneckBlock

-----print bottleneckBlock: 13

conv2d_43 [10, 512, 14, 14] [512, 1024, 1, 1] [ 512 ]

conv2d_44 [10, 512, 7, 7] [512, 512, 3, 3] [ 512 ]

conv2d_45 [10, 2048, 7, 7] [2048, 512, 1, 1] [ 2048 ]

conv2d_46 [10, 2048, 7, 7] [2048, 1024, 1, 1] [ 2048 ]

end block: [10, 2048, 7, 7]

-----print bottleneckBlock: 14

conv2d_47 [10, 512, 7, 7] [512, 2048, 1, 1] [ 512 ]

conv2d_48 [10, 512, 7, 7] [512, 512, 3, 3] [ 512 ]

conv2d_49 [10, 2048, 7, 7] [2048, 512, 1, 1] [ 2048 ]

end block: [10, 2048, 7, 7]

-----print bottleneckBlock: 15

conv2d_50 [10, 512, 7, 7] [512, 2048, 1, 1] [ 512 ]

conv2d_51 [10, 512, 7, 7] [512, 512, 3, 3] [ 512 ]

conv2d_52 [10, 2048, 7, 7] [2048, 512, 1, 1] [ 2048 ]

end block: [10, 2048, 7, 7]

======end bottleneckBlock:

adaptive_avg_pool2d_0 [10, 2048, 1, 1]

y.shape= [10, 2048]

linear_0 [10, 1] [2048, 1] [1]

PS E:\project\python>

分析测试代码如下所示:

# -*- coding:utf-8 -*-# ResNet模型代码

import numpy as np

import paddle

import paddle.nn as nn

import paddle.nn.functional as Fdef printItem(item,x):# item是CNN类中的一个子层# 查看经过子层之后的输出数据形状try:x = item(x)except:x = paddle.reshape(x, [x.shape[0], -1])x = item(x) #print(len(item.parameters())) if len(item.parameters())==1: print(item.full_name(), x.shape,item.parameters()[0].shape,'[',item.parameters()[0].shape[0],']') #print(item)elif len(item.parameters())==2:# 查看卷积和全连接层的数据和参数的形状,# 其中item.parameters()[0]是权重参数w,item.parameters()[1]是偏置参数bprint(item.full_name(), x.shape, item.parameters()[0].shape, item.parameters()[1].shape)else:# 池化层没有参数print(item.full_name(), x.shape) return x; # ResNet中使用了BatchNorm层,在卷积层的后面加上BatchNorm以提升数值稳定性

# 定义卷积批归一化块 (包括一个卷积)

class ConvBNLayer(paddle.nn.Layer):def __init__(self,num_channels,num_filters,filter_size,stride=1,groups=1,act=None):"""num_channels, 卷积层的输入通道数num_filters, 卷积层的输出通道数stride, 卷积层的步幅groups, 分组卷积的组数,默认groups=1不使用分组卷积"""super(ConvBNLayer, self).__init__()# 创建卷积层self._conv = nn.Conv2D(in_channels=num_channels,out_channels=num_filters,kernel_size=filter_size,stride=stride,padding=(filter_size - 1) // 2,groups=groups,bias_attr=False)# 创建BatchNorm层self._batch_norm = paddle.nn.BatchNorm2D(num_filters)self.act = actdef forward_old(self, inputs):y = self._conv(inputs)y = self._batch_norm(y)if self.act == 'leaky':y = F.leaky_relu(x=y, negative_slope=0.1)elif self.act == 'relu':y = F.relu(x=y)return ydef forward(self, inputs):y=printItem(self._conv,inputs)#print('[',num_filters,num_channels,filter_size,filter_size)y = self._batch_norm(y)if self.act == 'leaky':y = F.leaky_relu(x=y, negative_slope=0.1)elif self.act == 'relu':y = F.relu(x=y)return y# 定义残差块 (包括三个卷积) 16*3=48

# 每个残差块会对输入图片做三次卷积,然后跟输入图片进行短接

# 如果残差块中第三次卷积输出特征图的形状与输入不一致,则对输入图片做1x1卷积,将其输出形状调整成一致

class BottleneckBlock(paddle.nn.Layer):def __init__(self,num_channels,num_filters,stride,shortcut=True):super(BottleneckBlock, self).__init__()# 创建第一个卷积层 1x1self.conv0 = ConvBNLayer(num_channels=num_channels,num_filters=num_filters,filter_size=1,act='relu')# 创建第二个卷积层 3x3self.conv1 = ConvBNLayer(num_channels=num_filters,num_filters=num_filters,filter_size=3,stride=stride,act='relu')# 创建第三个卷积 1x1,但输出通道数乘以4self.conv2 = ConvBNLayer(num_channels=num_filters,num_filters=num_filters * 4,filter_size=1,act=None)# 如果conv2的输出跟此残差块的输入数据形状一致,则shortcut=True# 否则shortcut = False,添加1个1x1的卷积作用在输入数据上,使其形状变成跟conv2一致if not shortcut:self.short = ConvBNLayer(num_channels=num_channels,num_filters=num_filters * 4,filter_size=1,stride=stride)self.shortcut = shortcutself._num_channels_out = num_filters * 4def forward_old(self, inputs):y = self.conv0(inputs)conv1 = self.conv1(y)conv2 = self.conv2(conv1)# 如果shortcut=True,直接将inputs跟conv2的输出相加# 否则需要对inputs进行一次卷积,将形状调整成跟conv2输出一致if self.shortcut:short = inputselse:short = self.short(inputs)y = paddle.add(x=short, y=conv2)y = F.relu(y)return ydef forward(self, inputs): y = self.conv0(inputs)#print('>>>>ConvBMLayer0.shape=',y.shape,self.conv0)conv1 = self.conv1(y)#print('>>>>ConvBMLayer1.shape=',conv1.shape)conv2 = self.conv2(conv1)#print('>>>>ConvBMLayer2.shape=',conv2.shape)# 如果shortcut=True,直接将inputs跟conv2的输出相加# 否则需要对inputs进行一次卷积,将形状调整成跟conv2输出一致if self.shortcut:short = inputselse:short = self.short(inputs)y = paddle.add(x=short, y=conv2)y = F.relu(y)return y # 定义ResNet模型

class ResNet(paddle.nn.Layer):def __init__(self, layers=50, class_dim=1):print('layers=',layers)"""layers, 网络层数,可以是50, 101或者152class_dim,分类标签的类别数"""super(ResNet, self).__init__()self.layers = layerssupported_layers = [50, 101, 152]assert layers in supported_layers, \"supported layers are {} but input layer is {}".format(supported_layers, layers)if layers == 50:#ResNet50包含多个模块,其中第2到第5个模块分别包含3、4、6、3个残差块depth = [3, 4, 6, 3]elif layers == 101:#ResNet101包含多个模块,其中第2到第5个模块分别包含3、4、23、3个残差块depth = [3, 4, 23, 3]elif layers == 152:#ResNet152包含多个模块,其中第2到第5个模块分别包含3、8、36、3个残差块depth = [3, 8, 36, 3]# 残差块中使用到的卷积的输出通道数num_filters = [64, 128, 256, 512]# ResNet的第一个模块,包含1个7x7卷积,后面跟着1个最大池化层self.conv = ConvBNLayer(num_channels=3,num_filters=64,filter_size=7,stride=2,act='relu')self.pool2d_max = nn.MaxPool2D(kernel_size=3,stride=2,padding=1)# ResNet的第二到第五个模块c2、c3、c4、c5self.bottleneck_block_list = []num_channels = 64for block in range(len(depth)): #4(0,1,2,3)shortcut = Falseprint('block=',block,'depth[block]=',depth[block])k=0for i in range(depth[block]): #depth = [3, 4, 6, 3]k+=1# c3、c4、c5将会在第一个残差块使用stride=2;其余所有残差块stride=1bottleneck_block = self.add_sublayer('bb_%d_%d' % (block, i),BottleneckBlock(num_channels=num_channels,num_filters=num_filters[block],stride=2 if i == 0 and block != 0 else 1, shortcut=shortcut))num_channels = bottleneck_block._num_channels_outself.bottleneck_block_list.append(bottleneck_block)print('bottleneck[',num_channels,num_filters[block],shortcut)shortcut = True; print('create bnb',k)# 在c5的输出特征图上使用全局池化self.pool2d_avg = paddle.nn.AdaptiveAvgPool2D(output_size=1)# stdv用来作为全连接层随机初始化参数的方差import mathstdv = 1.0 / math.sqrt(2048 * 1.0)# 创建全连接层,输出大小为类别数目,经过残差网络的卷积和全局池化后,# 卷积特征的维度是[B,2048,1,1],故最后一层全连接的输入维度是2048self.out = nn.Linear(in_features=2048, out_features=class_dim,weight_attr=paddle.ParamAttr(initializer=paddle.nn.initializer.Uniform(-stdv, stdv)))def forward(self, inputs):y = self.conv(inputs)y = self.pool2d_max(y)for bottleneck_block in self.bottleneck_block_list:y = bottleneck_block(y)y = self.pool2d_avg(y)y = paddle.reshape(y, [y.shape[0], -1])y = self.out(y)return ydef printStruct(self,inputs):y=paddle.to_tensor(inputs)print(y.shape)y=printItem(self.conv,y)y = self.pool2d_max(y)print("maxpool2d:",y.shape)print('======start bottleneckBlock:')i=0 for bottleneck_block in self.bottleneck_block_list: print('-----print bottleneckBlock:',i)y = bottleneck_block(y)print('end block:',y.shape)i+=1 print('======end bottleneckBlock:')y=printItem(self.pool2d_avg,y)y = paddle.reshape(y, [y.shape[0], -1])print('y.shape=',y.shape) y=printItem(self.out,y)return y# 创建模型

model = ResNet()

# 定义优化器

opt = paddle.optimizer.Momentum(learning_rate=0.001, momentum=0.9, parameters=model.parameters(), weight_decay=0.001)

# 启动训练过程

import PM

#PM.train_pm(model, opt)

## 输入数据形状是 [N, 3, H, W]

# 这里用np.random创建一个随机数组作为输入数据

x = np.random.randn(*[10,3,224,224])

x = x.astype('float32')

# 创建CNN类的实例,指定模型名称和分类的类别数目

#model = VGG(1)

#

model.printStruct(x)

#

训练源代码如下所示:

# -*- coding:utf-8 -*-# ResNet模型代码

import numpy as np

import paddle

import paddle.nn as nn

import paddle.nn.functional as F# ResNet中使用了BatchNorm层,在卷积层的后面加上BatchNorm以提升数值稳定性

# 定义卷积批归一化块 (包括一个卷积)

class ConvBNLayer(paddle.nn.Layer):def __init__(self,num_channels,num_filters,filter_size,stride=1,groups=1,act=None):"""num_channels, 卷积层的输入通道数num_filters, 卷积层的输出通道数stride, 卷积层的步幅groups, 分组卷积的组数,默认groups=1不使用分组卷积"""super(ConvBNLayer, self).__init__()# 创建卷积层self._conv = nn.Conv2D(in_channels=num_channels,out_channels=num_filters,kernel_size=filter_size,stride=stride,padding=(filter_size - 1) // 2,groups=groups,bias_attr=False)# 创建BatchNorm层self._batch_norm = paddle.nn.BatchNorm2D(num_filters)self.act = actdef forward(self, inputs):y = self._conv(inputs)y = self._batch_norm(y)if self.act == 'leaky':y = F.leaky_relu(x=y, negative_slope=0.1)elif self.act == 'relu':y = F.relu(x=y)return y# 定义残差块 (包括三个卷积)

# 每个残差块会对输入图片做三次卷积,然后跟输入图片进行短接

# 如果残差块中第三次卷积输出特征图的形状与输入不一致,则对输入图片做1x1卷积,将其输出形状调整成一致

class BottleneckBlock(paddle.nn.Layer):def __init__(self,num_channels,num_filters,stride,shortcut=True):super(BottleneckBlock, self).__init__()# 创建第一个卷积层 1x1self.conv0 = ConvBNLayer(num_channels=num_channels,num_filters=num_filters,filter_size=1,act='relu')# 创建第二个卷积层 3x3self.conv1 = ConvBNLayer(num_channels=num_filters,num_filters=num_filters,filter_size=3,stride=stride,act='relu')# 创建第三个卷积 1x1,但输出通道数乘以4self.conv2 = ConvBNLayer(num_channels=num_filters,num_filters=num_filters * 4,filter_size=1,act=None)# 如果conv2的输出跟此残差块的输入数据形状一致,则shortcut=True# 否则shortcut = False,添加1个1x1的卷积作用在输入数据上,使其形状变成跟conv2一致if not shortcut:self.short = ConvBNLayer(num_channels=num_channels,num_filters=num_filters * 4,filter_size=1,stride=stride)self.shortcut = shortcutself._num_channels_out = num_filters * 4def forward(self, inputs):y = self.conv0(inputs)conv1 = self.conv1(y)conv2 = self.conv2(conv1)# 如果shortcut=True,直接将inputs跟conv2的输出相加# 否则需要对inputs进行一次卷积,将形状调整成跟conv2输出一致if self.shortcut:short = inputselse:short = self.short(inputs)y = paddle.add(x=short, y=conv2)y = F.relu(y)return y# 定义ResNet模型

class ResNet(paddle.nn.Layer):def __init__(self, layers=50, class_dim=1):"""layers, 网络层数,可以是50, 101或者152class_dim,分类标签的类别数"""super(ResNet, self).__init__()self.layers = layerssupported_layers = [50, 101, 152]assert layers in supported_layers, \"supported layers are {} but input layer is {}".format(supported_layers, layers)if layers == 50:#ResNet50包含多个模块,其中第2到第5个模块分别包含3、4、6、3个残差块depth = [3, 4, 6, 3]elif layers == 101:#ResNet101包含多个模块,其中第2到第5个模块分别包含3、4、23、3个残差块depth = [3, 4, 23, 3]elif layers == 152:#ResNet152包含多个模块,其中第2到第5个模块分别包含3、8、36、3个残差块depth = [3, 8, 36, 3]# 残差块中使用到的卷积的输出通道数num_filters = [64, 128, 256, 512]# ResNet的第一个模块,包含1个7x7卷积,后面跟着1个最大池化层self.conv = ConvBNLayer(num_channels=3,num_filters=64,filter_size=7,stride=2,act='relu')self.pool2d_max = nn.MaxPool2D(kernel_size=3,stride=2,padding=1)# ResNet的第二到第五个模块c2、c3、c4、c5self.bottleneck_block_list = []num_channels = 64for block in range(len(depth)):shortcut = Falsefor i in range(depth[block]):# c3、c4、c5将会在第一个残差块使用stride=2;其余所有残差块stride=1bottleneck_block = self.add_sublayer('bb_%d_%d' % (block, i),BottleneckBlock(num_channels=num_channels,num_filters=num_filters[block],stride=2 if i == 0 and block != 0 else 1, shortcut=shortcut))num_channels = bottleneck_block._num_channels_outself.bottleneck_block_list.append(bottleneck_block)shortcut = True# 在c5的输出特征图上使用全局池化self.pool2d_avg = paddle.nn.AdaptiveAvgPool2D(output_size=1)# stdv用来作为全连接层随机初始化参数的方差import mathstdv = 1.0 / math.sqrt(2048 * 1.0)# 创建全连接层,输出大小为类别数目,经过残差网络的卷积和全局池化后,# 卷积特征的维度是[B,2048,1,1],故最后一层全连接的输入维度是2048self.out = nn.Linear(in_features=2048, out_features=class_dim,weight_attr=paddle.ParamAttr(initializer=paddle.nn.initializer.Uniform(-stdv, stdv)))def forward(self, inputs):y = self.conv(inputs)y = self.pool2d_max(y)for bottleneck_block in self.bottleneck_block_list:y = bottleneck_block(y)y = self.pool2d_avg(y)y = paddle.reshape(y, [y.shape[0], -1])y = self.out(y)return y

# 创建模型

model = ResNet() #=ResNet(50) =ResNet(101) =ResNet(152)

# 定义优化器

opt = paddle.optimizer.Momentum(learning_rate=0.001, momentum=0.9, parameters=model.parameters(), weight_decay=0.001)

# 启动训练过程

import PM

PM.train_pm(model, opt)

#

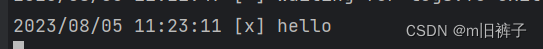

训练结果:

D:\ProgramData\Anaconda3\lib\site-packages\paddle\nn\layer\norm.py:712: UserWarning: When training, we now always track global mean and variance.warnings.warn(

epoch: 0, batch_id: 0, loss is: 0.7711

epoch: 0, batch_id: 20, loss is: 0.6860

[validation] accuracy/loss: 0.7700/0.4910

epoch: 1, batch_id: 0, loss is: 0.7769

epoch: 1, batch_id: 20, loss is: 0.6261

[validation] accuracy/loss: 0.8475/0.3368

epoch: 2, batch_id: 0, loss is: 0.4543

epoch: 2, batch_id: 20, loss is: 0.3392

[validation] accuracy/loss: 0.8950/0.2690

epoch: 3, batch_id: 0, loss is: 1.1716

epoch: 3, batch_id: 20, loss is: 0.0736

[validation] accuracy/loss: 0.8975/0.2387

epoch: 4, batch_id: 0, loss is: 0.0909

epoch: 4, batch_id: 20, loss is: 0.1900

[validation] accuracy/loss: 0.9375/0.2098

PS E:\project\python>

相关文章:

ResNet50卷积神经网络输出数据形参分析-笔记

ResNet50卷积神经网络输出数据形参分析-笔记 ResNet50包含多个模块,其中第2到第5个模块分别包含3、4、6、3个残差块 5049个卷积(3463)*31和一个全连接层 分析结果为: 输入数据形状:[10, 3, 224, 224] 最后输出结果:linear_0 [10,…...

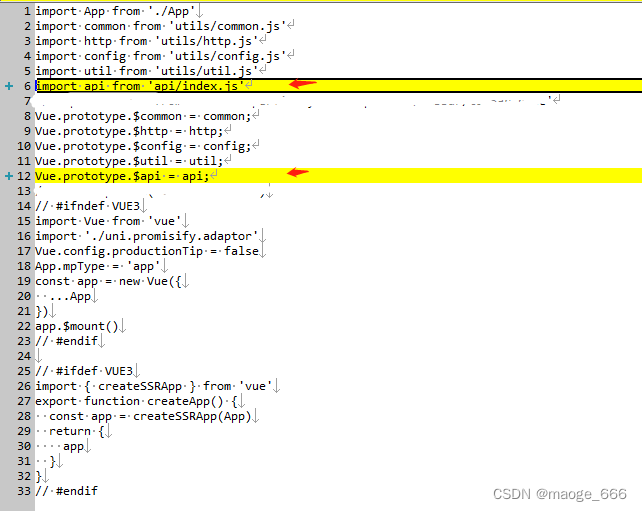

uniapp 微信小程序 封装公共的请求js(api版本)

一、新建api文件夹 在项目目录下创建api文件夹,内放files跟index.js文件夹,files文件夹内放每个页面对应的js请求接口 1、index.js /*** api接口的统一出口*/ const api {}; const requireComponent require.context(./files, false, /\.js$/) requi…...

格式化后数据恢复,教你3个实用方法!

“格式化后数据还能恢复吗?前几天因为我的电脑中了病毒,我不得不将它进行格式化操作。但是我电脑里有很多比较重要的文件,有什么方法可以帮我恢复电脑中的文件吗?求解答!” 格式化是一种比较常见的数据清除方法&#x…...

LaTex使用技巧21:设置中文环境、字体、行间距和页边距

我在Overleaf上编写我的中文LaTex,设置了中文环境,字体、行间距以及页间距,记录一下方便以后查询。 使用中文环境命令为: \usepackage{xeCJK}可以使用Overleaf上支持的中文字体Fonts for CJK Chinese,设置字体的命令…...

【RabbitMQ】golang客户端教程3——发布订阅(使用fanout交换器)

发布订阅 在上一个教程中,我们创建了一个工作队列。工作队列背后的假设是每个任务只传递给一个工人。在这一部分中,我们将做一些完全不同的事情——我们将向多个消费者传递一个消息。这就是所谓的“订阅/发布模式”。 为了说明这种模式,我们…...

图像处理学习笔记

图像处理的流程:获取图像-分割区域-特征提取。 嵌入式工业读码器 :包括DM码、QR码、vericode码 Blob分析与形态学 1.Blob区域是Blobs这一数据类型在halcon中的一种贴切的表达形式。 采集图像-区域分割,最后通过特征(如圆度、面积、…...

87端口无法访问-GoogleChrome非安全端口列表

以下为Google Chrome 默认非安全端口列表 平时我们服务器尽量不要开启这些端口,会产生访问不了的错误! 1, // tcpmux7, // echo9, // discard11, // systat13, // daytime15, // netstat17, // qotd19, // chargen20, // ftp data…...

pyautogui 配合 selenium 实现桌面坐标系定位元素坐标,模拟真实鼠标行为

pyautogui 配合 selenium 实现桌面坐标系定位元素坐标,模拟真实鼠标行为。 场景:当我需要点击某个元素,或者触发浏览器的自动填充账号密码时,自动化点击无效。但是想要模拟真实鼠标点击又需要元素的坐标通过pyautogui来实现。通过…...

c#设计模式-创建型模式 之 工厂模式

前言: 工厂模式(Factory Pattern)是一种常用的对象创建型设计模式。该模式的主要思想是提供一个创建对象的接口(也可以是抽象类、静态方法等),将实际创建对象的工作推迟到子类中进行。这样一来,…...

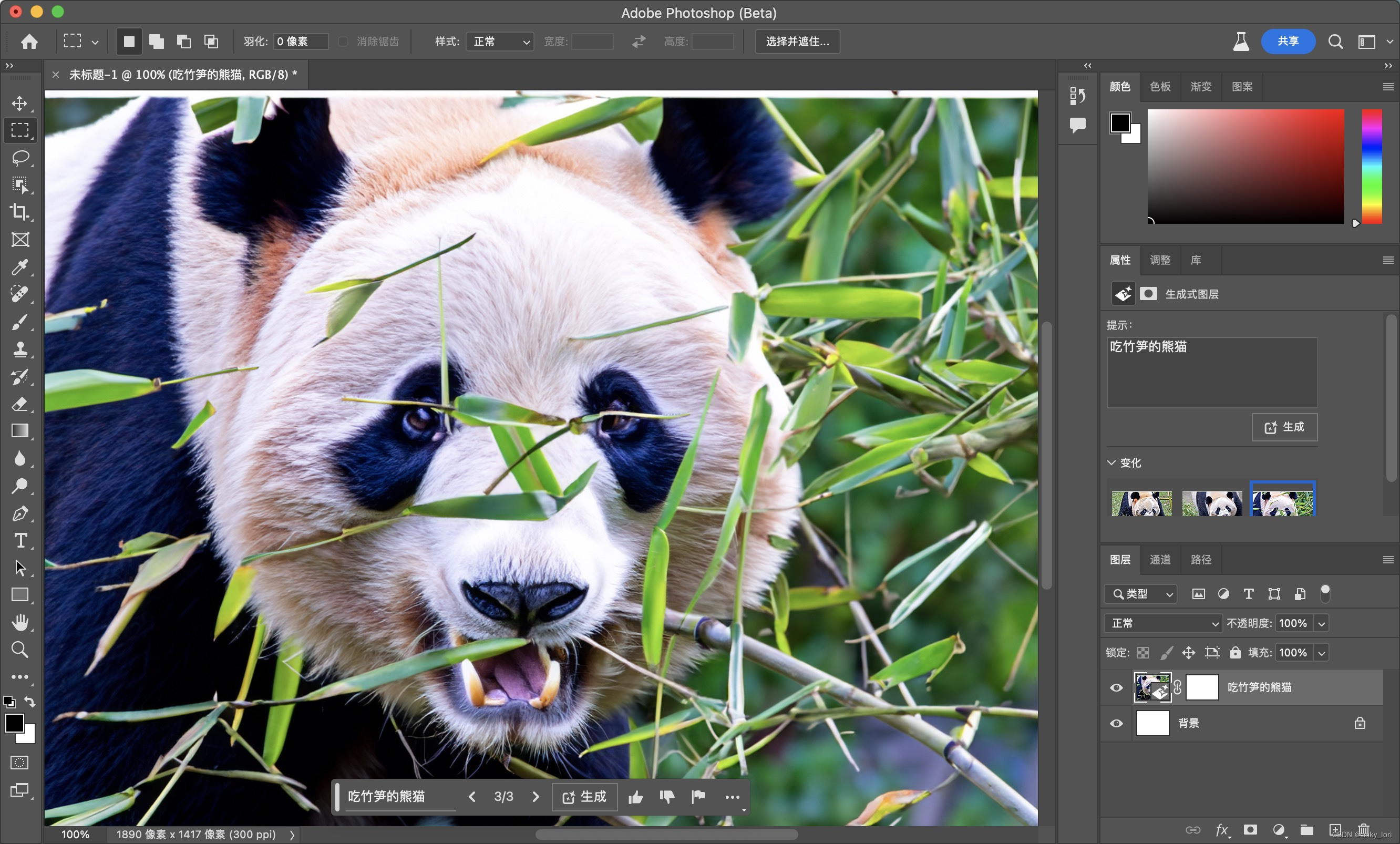

Photoshop 2023 25.0beta「Mac」

Photoshop 2023是一款专业图像处理软件,它主要用于图像编辑、合成和设计等方面。 Photoshop beta创新式填充的功能特色包括: 自动识别和删除对象:该功能可以自动识别图像中的对象,并用周围的图像填充空白部分,使图像看…...

机器学习基础07-模型选择01-利用scikit-learn 基于Pima 数据集对LogisticRegression算法进行评估

选择合适的模型是机器学习和深度学习中非常重要的一步,它直接影响到模型的性能和泛化能力。 “所有模型都是坏的,但有些模型是有用的”。建立模型之后就要去评 估模型,确定模型是否有用。模型评估是模型开发过程中不可或缺的一部 分ÿ…...

单片机实现动态内存管理

1.简介 多数传统的单片机并没有动态内存管理功能。单片机通常具有有限的存储资源,包括固定大小的静态RAM(SRAM)用于数据存储和寄存器用于特定功能。这些资源在编译时被分配并且在程序的整个生命周期中保持不变。 2.动态内存管理好处 灵活性和…...

(JS逆向专栏十一)某融平台网站登入RSA

声明: 本文章中所有内容仅供学习交流,严禁用于商业用途和非法用途,否则由此产生的一切后果均与作者无关,若有侵权,请联系我立即删除! 名称:点融 目标:登入参数 加密类型:RSA 目标网址:https://www.dianrong.com/accoun…...

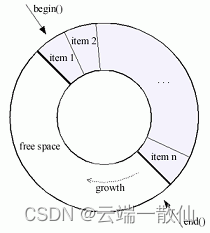

c++ boost circular_buffer

boost库中的 circular_buffer顾名思义是一个循环缓冲器,其 capcity是固定的当容量满了以后,插入一个元素时,会在容器的开头或结尾处删除一个元素。 circular_buffer为了效率考虑,使用了连续内存块保存元素 使用固定内存&#x…...

网络编程——端口

端口 一、端口概述 TCP/IP 协议采用端口标识通信的进程 用于区分一个系统里的多个进程 二、端口特点 1、对于同一个端口,在本同系统中对应着不同的进程 2、对于同一个系统,一个端口只能被一个进程拥有 3、一个进程拥有一个端口后,传输层送…...

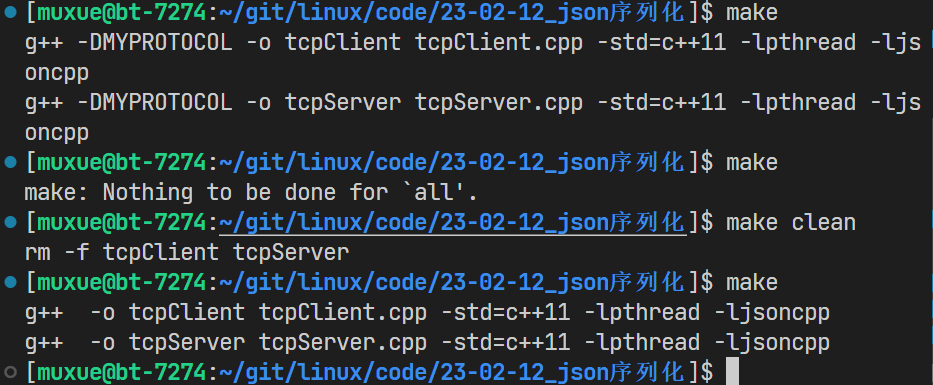

【网络】自定义协议 | 序列化和反序列化 | Jsoncpp

本文首发于 慕雪的寒舍 以tcpServer的计算器服务为例,实现用jsoncpp来进行序列化和反序列化 阅读本文之前,请先阅读 自定义协议 | 序列化和反序列化 | 以tcpServer为例 1.安装jsoncpp 我所用的系统是centos7.6,先用下面的命令查找相关的包 …...

PHP实践:用openssl打造安全可靠的API签名验证系统

🏆作者简介,黑夜开发者,全栈领域新星创作者✌,阿里云社区专家博主,2023年6月csdn上海赛道top4。 🏆数年电商行业从业经验,历任核心研发工程师,项目技术负责人。 🏆本文已…...

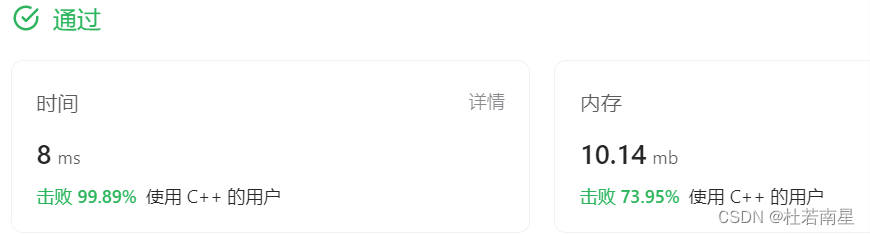

每天一道leetcode:剑指 Offer 50. 第一个只出现一次的字符(适合初学者)

今日份题目: 在字符串 s 中找出第一个只出现一次的字符。如果没有,返回一个单空格。 s 只包含小写字母。 示例1 输入:s "abaccdeff" 输出:b 示例2 输入:s "" 输出: 提示 0 …...

【第五章 flutter学习之flutter进阶组件-下篇】

文章目录 一、Scaffold属性二、TabBar三、路由四、AlertDialog、SimpleDialog、showM...五、PageView六、Key七、AnimatedList八、动画 一、Scaffold属性 Flutter Scaffold 是一个用于构建基本用户界面的布局组件。它提供了许多属性,使得开发者能够轻松地创建一个完…...

单元测试和集成测试有什么区别

单元测试和集成测试有什么区别 单元测试和集成测试是软件开发中的两个重要测试阶段,它们的主要区别如下: 目的: 单元测试:主要针对代码的最小可测试单元,通常是一个函数或方法,确保它按照预期工作。集成…...

Zustand 状态管理库:极简而强大的解决方案

Zustand 是一个轻量级、快速和可扩展的状态管理库,特别适合 React 应用。它以简洁的 API 和高效的性能解决了 Redux 等状态管理方案中的繁琐问题。 核心优势对比 基本使用指南 1. 创建 Store // store.js import create from zustandconst useStore create((set)…...

Rapidio门铃消息FIFO溢出机制

关于RapidIO门铃消息FIFO的溢出机制及其与中断抖动的关系,以下是深入解析: 门铃FIFO溢出的本质 在RapidIO系统中,门铃消息FIFO是硬件控制器内部的缓冲区,用于临时存储接收到的门铃消息(Doorbell Message)。…...

安宝特方案丨船舶智造的“AR+AI+作业标准化管理解决方案”(装配)

船舶制造装配管理现状:装配工作依赖人工经验,装配工人凭借长期实践积累的操作技巧完成零部件组装。企业通常制定了装配作业指导书,但在实际执行中,工人对指导书的理解和遵循程度参差不齐。 船舶装配过程中的挑战与需求 挑战 (1…...

Xela矩阵三轴触觉传感器的工作原理解析与应用场景

Xela矩阵三轴触觉传感器通过先进技术模拟人类触觉感知,帮助设备实现精确的力测量与位移监测。其核心功能基于磁性三维力测量与空间位移测量,能够捕捉多维触觉信息。该传感器的设计不仅提升了触觉感知的精度,还为机器人、医疗设备和制造业的智…...

【Post-process】【VBA】ETABS VBA FrameObj.GetNameList and write to EXCEL

ETABS API实战:导出框架元素数据到Excel 在结构工程师的日常工作中,经常需要从ETABS模型中提取框架元素信息进行后续分析。手动复制粘贴不仅耗时,还容易出错。今天我们来用简单的VBA代码实现自动化导出。 🎯 我们要实现什么? 一键点击,就能将ETABS中所有框架元素的基…...

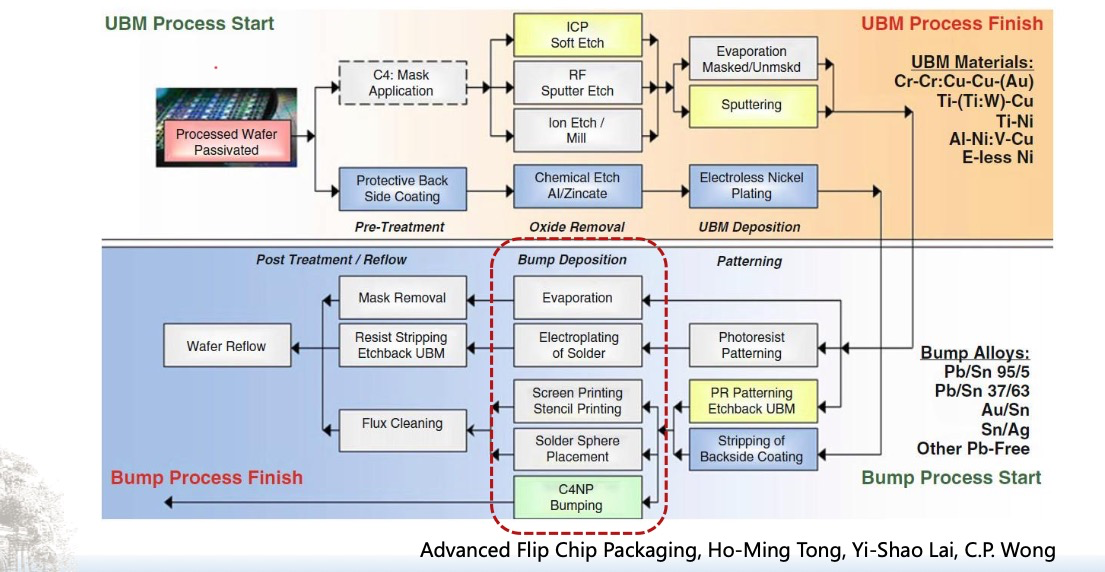

倒装芯片凸点成型工艺

UBM(Under Bump Metallization)与Bump(焊球)形成工艺流程。我们可以将整张流程图分为三大阶段来理解: 🔧 一、UBM(Under Bump Metallization)工艺流程(黄色区域ÿ…...

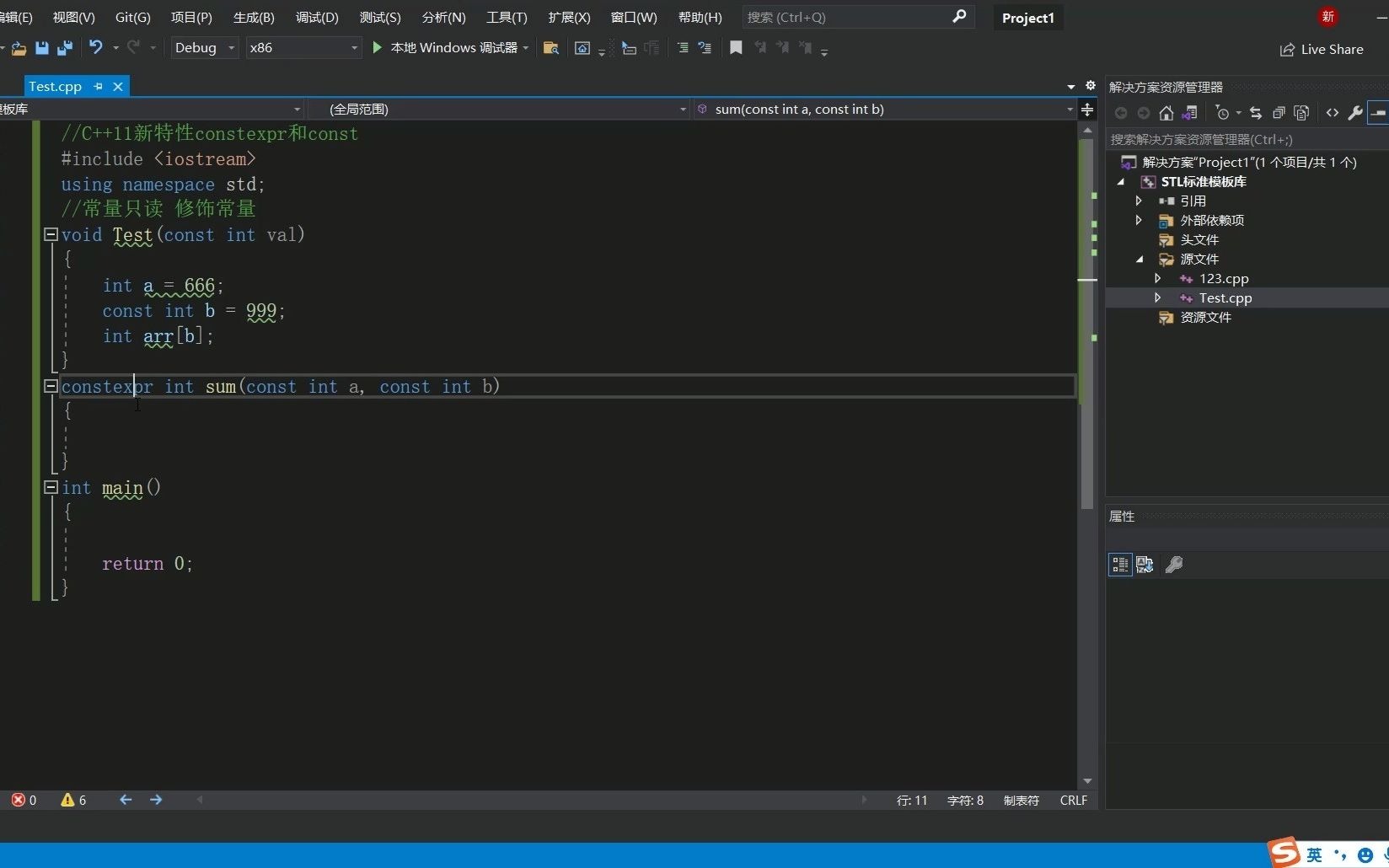

C++11 constexpr和字面类型:从入门到精通

文章目录 引言一、constexpr的基本概念与使用1.1 constexpr的定义与作用1.2 constexpr变量1.3 constexpr函数1.4 constexpr在类构造函数中的应用1.5 constexpr的优势 二、字面类型的基本概念与使用2.1 字面类型的定义与作用2.2 字面类型的应用场景2.2.1 常量定义2.2.2 模板参数…...

开疆智能Ethernet/IP转Modbus网关连接鸣志步进电机驱动器配置案例

在工业自动化控制系统中,常常会遇到不同品牌和通信协议的设备需要协同工作的情况。本案例中,客户现场采用了 罗克韦尔PLC,但需要控制的变频器仅支持 ModbusRTU 协议。为了实现PLC 对变频器的有效控制与监控,引入了开疆智能Etherne…...

记一次spark在docker本地启动报错

1,背景 在docker中部署spark服务和调用spark服务的微服务,微服务之间通过fegin调用 2,问题,docker容器中服务器来后,注册中心都有,调用服务也正常,但是调用spark启动任务后报错,报错…...

ubuntu系统 | docker+dify+ollama+deepseek搭建本地应用

1、docker 介绍与安装 docker安装:1、Ubuntu系统安装docker_ubuntu docker run-CSDN博客 docker介绍及镜像源配置:2、ubuntu系统docker介绍及镜像源和仓库配置-CSDN博客 docker常用命令:3、ubuntu系统docker常用命令-CSDN博客 docker compose安装:4、docker compose-CS…...