RocketMQ双主双从同步集群部署

🎈 作者:互联网-小啊宇

🎈 简介: CSDN 运维领域创作者、阿里云专家博主。目前从事 Kubernetes运维相关工作,擅长Linux系统运维、开源监控软件维护、Kubernetes容器技术、CI/CD持续集成、自动化运维、开源软件部署维护等领域。

🎈 博客首页:CSDN【互联网-小阿宇】 、阿里云【互联网-小阿宇】

🎈 欢迎小伙伴们点赞👍、收藏⭐、留言💬

RocketMQ双主双从同步集群部署

- 服务器环境:

- 双主双从同步集群部署:

- 一、安装JDK环境

- 1.1 上传安装包

- 1.2 解压安装包

- 1.3 编写环境变量文件

- 1.4 验证JDK版本

- 二、安装RocketMQ

- 1.1 解压安装包

- 1.2 【192.168.8.16】修改配置文件

- 1.3 【192.168.8.18】修改配置文件

- 1.4 关键配置详解:

- 1.5 启动两台服务器的nameServer

- 1.6 分别启动两台服务器的broker的节点

- 1.6.1 【192.168.8.16】启动a主节点、b从节点

- 1.6.2 【192.168.8.18】启动b主节点、a从节点

- 1.7 启动效果

- 1.8 常用启停命令:

- 三、rocketmq-dashboard 控制台部署

- 1.1 下载安装包到电脑主机编写application.yml配置文件

- 1.2 将rocketmq-dashboard-master打包

- 1.2.1 如果主机有java环境、maven环境的直接进行打包就行

- 1.2.2 linux安装maven进行打包

- 1.3 启动rocketmq-dashboard 控制台

- 1.4 开启鉴权登录

服务器环境:

| 服务器IP | 操作系统 | 备注 |

|---|---|---|

| 192.168.8.16 | Centos7.5 | JDK(1.8+)、RocketMQ(5.1.2) |

| 192.168.8.18 | Centos7.5 | JDK(1.8+)、RocketMQ(5.1.2) |

RocketMQ下载地址:https://rocketmq.apache.org/download/

双主双从同步集群部署:

| 服务器IP | broker名称 | 备注 |

|---|---|---|

| 192.168.8.16 | broker-a | a主节点 |

| 192.168.8.16 | broker-b-s | b从节点 |

| 192.168.8.18 | broker-b | b主节点 |

| 192.168.8.18 | broker-a-s | a从节点 |

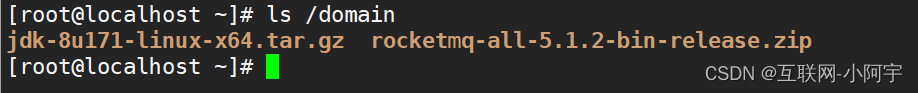

创建安装目录并存放安装包目录

mkdir /domain

关闭防火墙、沙盒

systemctl stop firewalld && systemctl disable firewalldvim /etc/selinux/config

#修改

ELINUX=disabled#重启

reboot

一、安装JDK环境

1.1 上传安装包

1.2 解压安装包

[root@localhost ~]# tar -zxf /domain/jdk-8u171-linux-x64.tar.gz -C /usr/local/

[root@localhost ~]# mv /usr/local/jdk1.8.0_171 /usr/local/java

1.3 编写环境变量文件

[root@localhost ~]# vim /etc/profile

#尾部添加

export JAVA_HOME=/usr/local/java

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

[root@localhost ~]# source /etc/profile

1.4 验证JDK版本

[root@localhost ~]# java -version

java version "1.8.0_171"

Java(TM) SE Runtime Environment (build 1.8.0_171-b11)

Java HotSpot(TM) 64-Bit Server VM (build 25.171-b11, mixed mode)

二、安装RocketMQ

1.1 解压安装包

unzip /domain/rocketmq-all-5.1.2-bin-release.zip -d /domain/

1.2 【192.168.8.16】修改配置文件

- 修改运行内存可编辑runserver.sh与runbroker.sh(

需要的修改,不需要跳过)

1、bin/runserver.shJAVA_OPT="${JAVA_OPT} -server -Xms520m -Xmx1g -Xmn128m -XX:metaspaceSize=120m -XX:MaxMetaspaceSize=320m"

2、bin/runnbroker.shJAVA_OPT="${JAVA_OPT} -server -Xms520m -Xmx1G -Xmn128m"

- 创建rocketMQ存储目录

mkdir /domain/rocketMQ

- 修改conf目录中2m-2s-sync目录中的配置文件

vim /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-a.properties

# 所属集群名字

brokerClusterName=test

# broker名字,注意此处不同的配置文件填写的不一样(按配置文件文件名来匹配)

brokerName=broker-a

# 0 表示Master, > 0 表示slave

brokerId=0

# 注册中心,可使用集群模式

namesrvAddr=192.168.8.16:9876;192.168.8.18:9876

# 在发送消息时,自动创建服务器不存在的Topic,默认创建的队列数

defaultTopicQueueNums=4

# 是否允许Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

# 是否允许Broker自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

# Broker 对外服务的监听端口

listenPort=10933

# 删除文件时间点,默认是凌晨4点

deleteWhen=04

# 文件保留时间,默认48小时

fileReservedTime=120

# commitLog每个文件的大小默认1G

# 附加:消息实际存储位置,和ConsumeQueue是mq的核心存储概念,之前搭建2m环境的时候创建在store下面,用于数据存储,consumequeue是一个逻辑的概念,消息过来之后,consumequeue并不是把消息所有保存起来,而是记录一个数据的位置,记录好之后再把消息存到commitlog文件里

mapedFileSizeCommitLog=1073741824

# ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

destroyMapedFileIntervalForcibly=120000

redeleteHangedFileInterval=120000

# 检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

# 存储路径

storePathRootDir=/domain/rocketMQ/store

# commitLog存储路径

storePathCommitLog=/domain/rocketMQ/commitlog

# 消费队列存储路径

storePathConsumeQueue=/domain/rocketMQ/consumequeue

# 消息索引存储路径

storePathIndex=/domain/rocketMQ/index

# checkpoint 文件存储路径

storeCheckpoint=/domain/rocketMQ/checkpoint

# abort 文件存储路径

abortFile=/domain/rocketMQ/abort

# 限制的消息大小

maxMessageSize=65536

flushCommitLogLeastPages=4

flushConsumeQueueLeastPages=2

flushCommitLogThoroughInterval=10000

flushConsumeQueueThoroughInterval=60000

# Broker 的角色

# ASYNC_MASTER 异步复制Master

# SYNC_MASTER 同步双写Master

# SLAVE

brokerRole=SYNC_MASTER

# 刷盘方式

# ASYNC_FLUSH 异步刷盘

# SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

checkTransactionMessageEnable=false

# 发消息线程池数量

sendMessageTreadPoolNums=128

# 拉消息线程池数量

pullMessageTreadPoolNums=128

- slave配置

cat /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-b-s.properties

# 所属集群名字

brokerClusterName=test

# broker名字,注意此处不同的配置文件填写的不一样(按配置文件文件名来匹配)

brokerName=broker-b-s

# 0 表示Master, > 0 表示slave

brokerId=1

# 注册中心,可使用集群模式

namesrvAddr=192.168.8.16:9876;192.168.8.18:9876

# 在发送消息时,自动创建服务器不存在的Topic,默认创建的队列数

defaultTopicQueueNums=4

# 是否允许Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

# 是否允许Broker自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

# Broker 对外服务的监听端口

listenPort=10900

# 删除文件时间点,默认是凌晨4点

deleteWhen=04

# 文件保留时间,默认48小时

fileReservedTime=120

# commitLog每个文件的大小默认1G

# 附加:消息实际存储位置,和ConsumeQueue是mq的核心存储概念,之前搭建2m环境的时候创建在store下面,用于数据存储,consumequeue是一个逻辑的概念,消息过来之后,consumequeue并不是把消息所有保存起来,而是记录一个数据的位置,记录好之后再把消息存到commitlog文件里

mapedFileSizeCommitLog=1073741824

# ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

destroyMapedFileIntervalForcibly=120000

redeleteHangedFileInterval=120000

# 检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

# 存储路径

storePathRootDir=/domain/rocketMQ/slave/store

# commitLog存储路径

storePathCommitLog=/domain/rocketMQ/slave/commitlog

# 消费队列存储路径

storePathConsumeQueue=/domain/rocketMQ/slave/consumequeue

# 消息索引存储路径

storePathIndex=/domain/rocketMQ/slave/index

# checkpoint 文件存储路径

storeCheckpoint=/domain/rocketMQ/slave/checkpoint

# abort 文件存储路径

abortFile=/domain/rocketMQ/slave/abort

# 限制的消息大小

maxMessageSize=65536

flushCommitLogLeastPages=4

flushConsumeQueueLeastPages=2

flushCommitLogThoroughInterval=10000

flushConsumeQueueThoroughInterval=60000

# Broker 的角色

# ASYNC_MASTER 异步复制Master

# SYNC_MASTER 同步双写Master

# SLAVE

brokerRole=SLAVE

# 刷盘方式

# ASYNC_FLUSH 异步刷盘

# SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

checkTransactionMessageEnable=false

# 发消息线程池数量

sendMessageTreadPoolNums=128

# 拉消息线程池数量

pullMessageTreadPoolNums=1281.3 【192.168.8.18】修改配置文件

与192.168.8.16的区别在于修改的文件名不同,我把详细配置一样放在下面

- 修改运行内存可编辑runserver.sh与runbroker.sh(

需要的修改,不需要跳过)

1、bin/runserver.shJAVA_OPT="${JAVA_OPT} -server -Xms520m -Xmx1g -Xmn128m -XX:metaspaceSize=120m -XX:MaxMetaspaceSize=320m"

2、bin/runnbroker.shJAVA_OPT="${JAVA_OPT} -server -Xms520m -Xmx1G -Xmn128m"

- 创建rocketMQ存储目录

mkdir /domain/rocketMQ

- 修改conf目录中2m-2s-sync目录中的配置文件

vim /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-b.properties

# 所属集群名字

brokerClusterName=test

# broker名字,注意此处不同的配置文件填写的不一样(按配置文件文件名来匹配)

brokerName=broker-b

# 0 表示Master, > 0 表示slave

brokerId=0

# 注册中心,可使用集群模式

namesrvAddr=192.168.8.16:9876;192.168.8.18:9876

# 在发送消息时,自动创建服务器不存在的Topic,默认创建的队列数

defaultTopicQueueNums=4

# 是否允许Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

# 是否允许Broker自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

# Broker 对外服务的监听端口

listenPort=10933

# 删除文件时间点,默认是凌晨4点

deleteWhen=04

# 文件保留时间,默认48小时

fileReservedTime=120

# commitLog每个文件的大小默认1G

# 附加:消息实际存储位置,和ConsumeQueue是mq的核心存储概念,之前搭建2m环境的时候创建在store下面,用于数据存储,consumequeue是一个逻辑的概念,消息过来之后,consumequeue并不是把消息所有保存起来,而是记录一个数据的位置,记录好之后再把消息存到commitlog文件里

mapedFileSizeCommitLog=1073741824

# ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

destroyMapedFileIntervalForcibly=120000

redeleteHangedFileInterval=120000

# 检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

# 存储路径

storePathRootDir=/domain/rocketMQ/store

# commitLog存储路径

storePathCommitLog=/domain/rocketMQ/commitlog

# 消费队列存储路径

storePathConsumeQueue=/domain/rocketMQ/consumequeue

# 消息索引存储路径

storePathIndex=/domain/rocketMQ/index

# checkpoint 文件存储路径

storeCheckpoint=/domain/rocketMQ/checkpoint

# abort 文件存储路径

abortFile=/domain/rocketMQ/abort

# 限制的消息大小

maxMessageSize=65536

flushCommitLogLeastPages=4

flushConsumeQueueLeastPages=2

flushCommitLogThoroughInterval=10000

flushConsumeQueueThoroughInterval=60000

# Broker 的角色

# ASYNC_MASTER 异步复制Master

# SYNC_MASTER 同步双写Master

# SLAVE

brokerRole=SYNC_MASTER

# 刷盘方式

# ASYNC_FLUSH 异步刷盘

# SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

checkTransactionMessageEnable=false

# 发消息线程池数量

sendMessageTreadPoolNums=128

# 拉消息线程池数量

pullMessageTreadPoolNums=128- slave配置

cat /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-a-s.properties

# 所属集群名字

brokerClusterName=test

# broker名字,注意此处不同的配置文件填写的不一样(按配置文件文件名来匹配)

brokerName=broker-a-s

# 0 表示Master, > 0 表示slave

brokerId=1

# 注册中心,可使用集群模式

namesrvAddr=192.168.8.16:9876;192.168.8.18:9876

# 在发送消息时,自动创建服务器不存在的Topic,默认创建的队列数

defaultTopicQueueNums=4

# 是否允许Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

# 是否允许Broker自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

# Broker 对外服务的监听端口

listenPort=10900

# 删除文件时间点,默认是凌晨4点

deleteWhen=04

# 文件保留时间,默认48小时

fileReservedTime=120

# commitLog每个文件的大小默认1G

# 附加:消息实际存储位置,和ConsumeQueue是mq的核心存储概念,之前搭建2m环境的时候创建在store下面,用于数据存储,consumequeue是一个逻辑的概念,消息过来之后,consumequeue并不是把消息所有保存起来,而是记录一个数据的位置,记录好之后再把消息存到commitlog文件里

mapedFileSizeCommitLog=1073741824

# ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

destroyMapedFileIntervalForcibly=120000

redeleteHangedFileInterval=120000

# 检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

# 存储路径

storePathRootDir=/domain/rocketMQ/slave/store

# commitLog存储路径

storePathCommitLog=/domain/rocketMQ/slave/commitlog

# 消费队列存储路径

storePathConsumeQueue=/domain/rocketMQ/slave/consumequeue

# 消息索引存储路径

storePathIndex=/domain/rocketMQ/slave/index

# checkpoint 文件存储路径

storeCheckpoint=/domain/rocketMQ/slave/checkpoint

# abort 文件存储路径

abortFile=/domain/rocketMQ/slave/abort

# 限制的消息大小

maxMessageSize=65536

flushCommitLogLeastPages=4

flushConsumeQueueLeastPages=2

flushCommitLogThoroughInterval=10000

flushConsumeQueueThoroughInterval=60000

# Broker 的角色

# ASYNC_MASTER 异步复制Master

# SYNC_MASTER 同步双写Master

# SLAVE

brokerRole=SLAVE

# 刷盘方式

# ASYNC_FLUSH 异步刷盘

# SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

checkTransactionMessageEnable=false

# 发消息线程池数量

sendMessageTreadPoolNums=128

# 拉消息线程池数量

pullMessageTreadPoolNums=128

1.4 关键配置详解:

brokerClusterName:只要是同一个集群里面的节点,都必须是这一个名称,可以自定义

brokerName:broker的名称,同一个broker的主从节点名称保持一致。

brokerId:broker的id标识。0:主节点,大于0都是从节点

namesrvAddr:nameSrv的注册中心地址,可以是集群模式,多个ip之间使用英文的;分隔

listenPort:监听端口,同一个ip地址下,端口不能保持一致,需修改

brokerRole:broker的角色,ASYNC_MASTER 异步复制Master,SYNC_MASTER 同步双写Master,SLAVE从节点专用。

flushDiskType:数据刷盘方式。ASYNC_FLUSH 异步刷盘,SYNC_FLUSH 同步刷盘

storePathRootDir=/usr/local/rocketMQ/store 存储路径

storePathCommitLog=/usr/local/rocketMQ/commitlog commitLog存储路径

storePathConsumeQueue=/usr/local/rocketMQ/consumequeue 消费队列存储路径

storePathIndex=/usr/local/rocketMQ/index消息索引存储路径

storeCheckpoint=/usr/local/rocketMQ/checkpoint checkpoint 文件存储路径

abortFile=/usr/local/rocketMQ/abort abort 文件存储路径

1.5 启动两台服务器的nameServer

cd /domain/rocketmq-all-5.1.2-bin-release/bin

nohup sh mqnamesrv -> namesrc.log 2>&1 &

1.6 分别启动两台服务器的broker的节点

1.6.1 【192.168.8.16】启动a主节点、b从节点

#a主节点

cd /domain/rocketmq-all-5.1.2-bin-release/bin

nohup sh mqbroker -c /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-a.properties -> broker-a.log 2>&1 &

#b从节点

cd /domain/rocketmq-all-5.1.2-bin-release/bin

nohup sh mqbroker -c /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-b-s.properties -> broker-b-s.log 2>&1 &

1.6.2 【192.168.8.18】启动b主节点、a从节点

#b主节点

cd /domain/rocketmq-all-5.1.2-bin-release/bin

nohup sh mqbroker -c /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-b.properties -> broker-b.log 2>&1 &

#a从节点

cd /domain/rocketmq-all-5.1.2-bin-release/bin

nohup sh mqbroker -c /domain/rocketmq-all-5.1.2-bin-release/conf/2m-2s-sync/broker-a-s.properties -> broker-a-s.log 2>&1 &

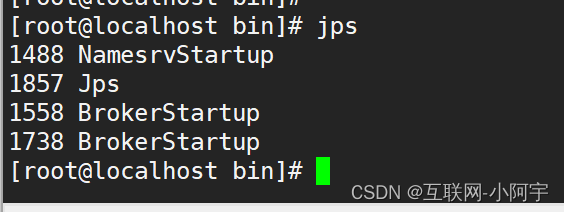

1.7 启动效果

两台都一样

1.8 常用启停命令:

sh mqshutdown broker 停止brokersh mqshutdown namesrv 停止namesrv

三、rocketmq-dashboard 控制台部署

下载地址:

https://github.com/apache/rocketmq-dashboard

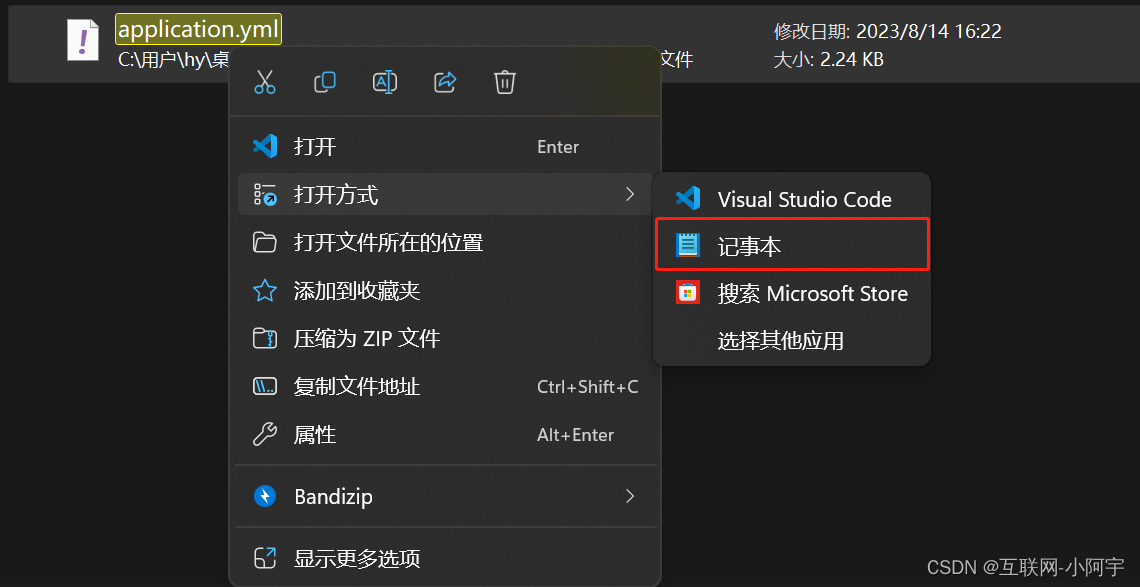

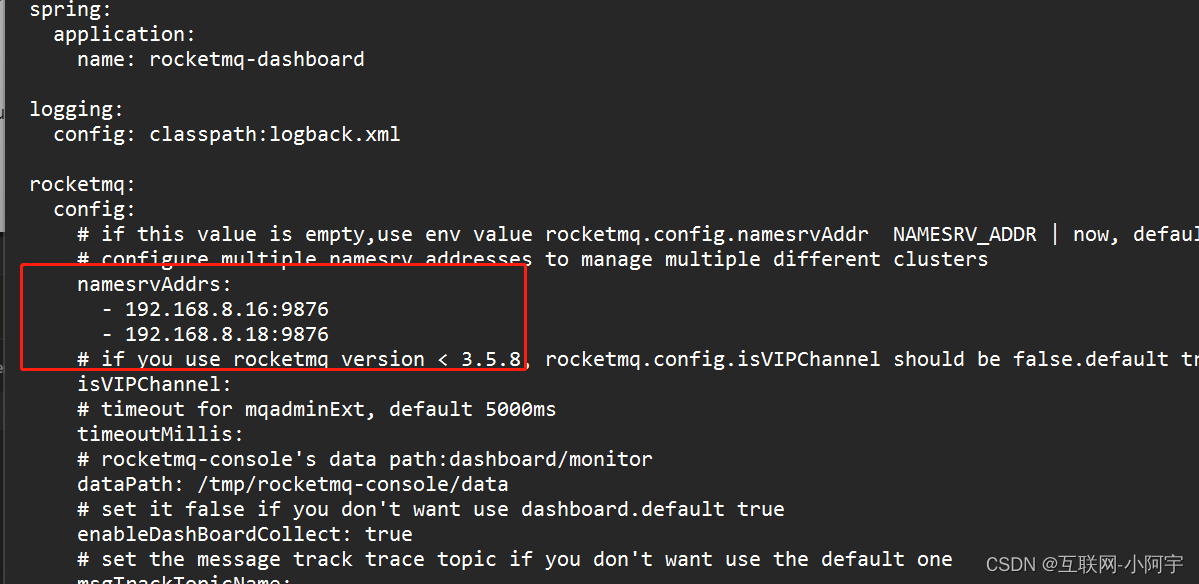

1.1 下载安装包到电脑主机编写application.yml配置文件

文件位置:rocketmq-dashboard-master\src\main\resources\application.yml

右键使用记事本打开

修改以下内容为节点IP

namesrvAddrs:- 192.168.8.16:9876- 192.168.8.18:9876

编辑完成后保存退出!

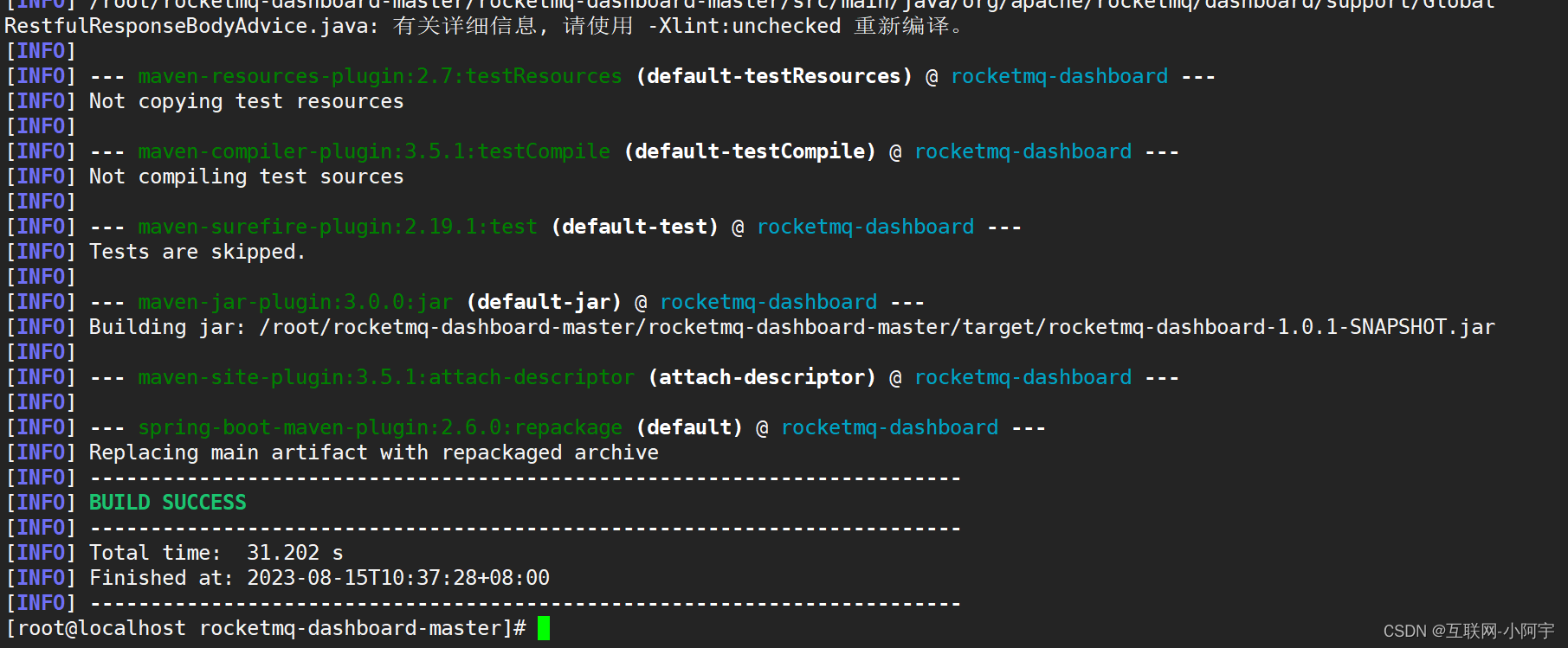

1.2 将rocketmq-dashboard-master打包

1.2.1 如果主机有java环境、maven环境的直接进行打包就行

在pom.xml同级目录操作命令

mvn clean package -Dmaven.test.skip=true

如果报错,根据报错原因进行解决:

- 有可能是maven的版本过低,进行升级即可

- 有可能用的自己的maven配置,部分依赖无法下载,通过指定项目本身pom.xml

mvn clean package -Dmaven.test.skip=true -f C:\Desktop\rocketmq-dashboard-master\rocketmq-dashboard-master\pom.xml

打包成功后将jar包上传到服务器

1.2.2 linux安装maven进行打包

Maven工具安装:http://t.csdn.cn/IIZVH

将修改过application.yml配置的目录上传到服务器

[root@localhost rocketmq-dashboard-master]# pwd

/root/rocketmq-dashboard-master/rocketmq-dashboard-master

[root@localhost rocketmq-dashboard-master]# ls

docs frontend LICENSE NOTICE package-lock.json pom.xml README.md src style target

maven打包

mvn clean package -Dmaven.test.skip=true -f pom.xml

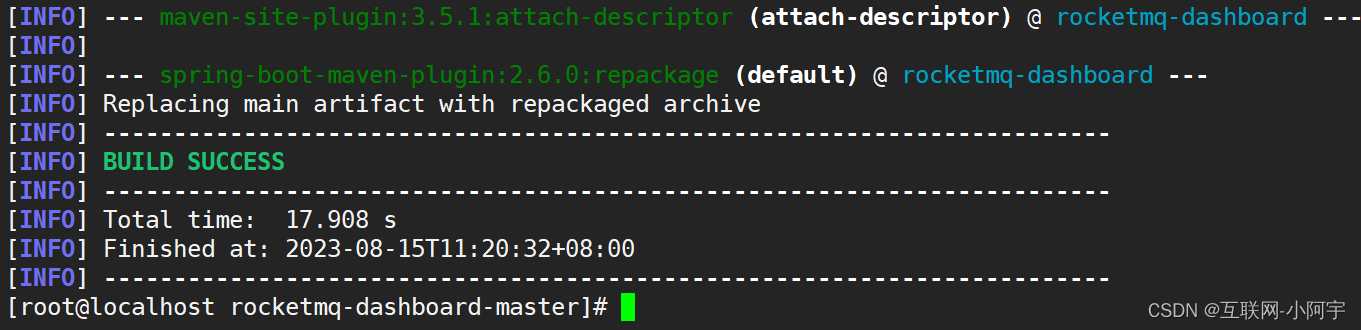

成功界面:

如果有报错可能是因为maven版本太低,通过yum -y install maven安装版本为Apache Maven 3.0.5,版本太低导致报错,进行升级即可

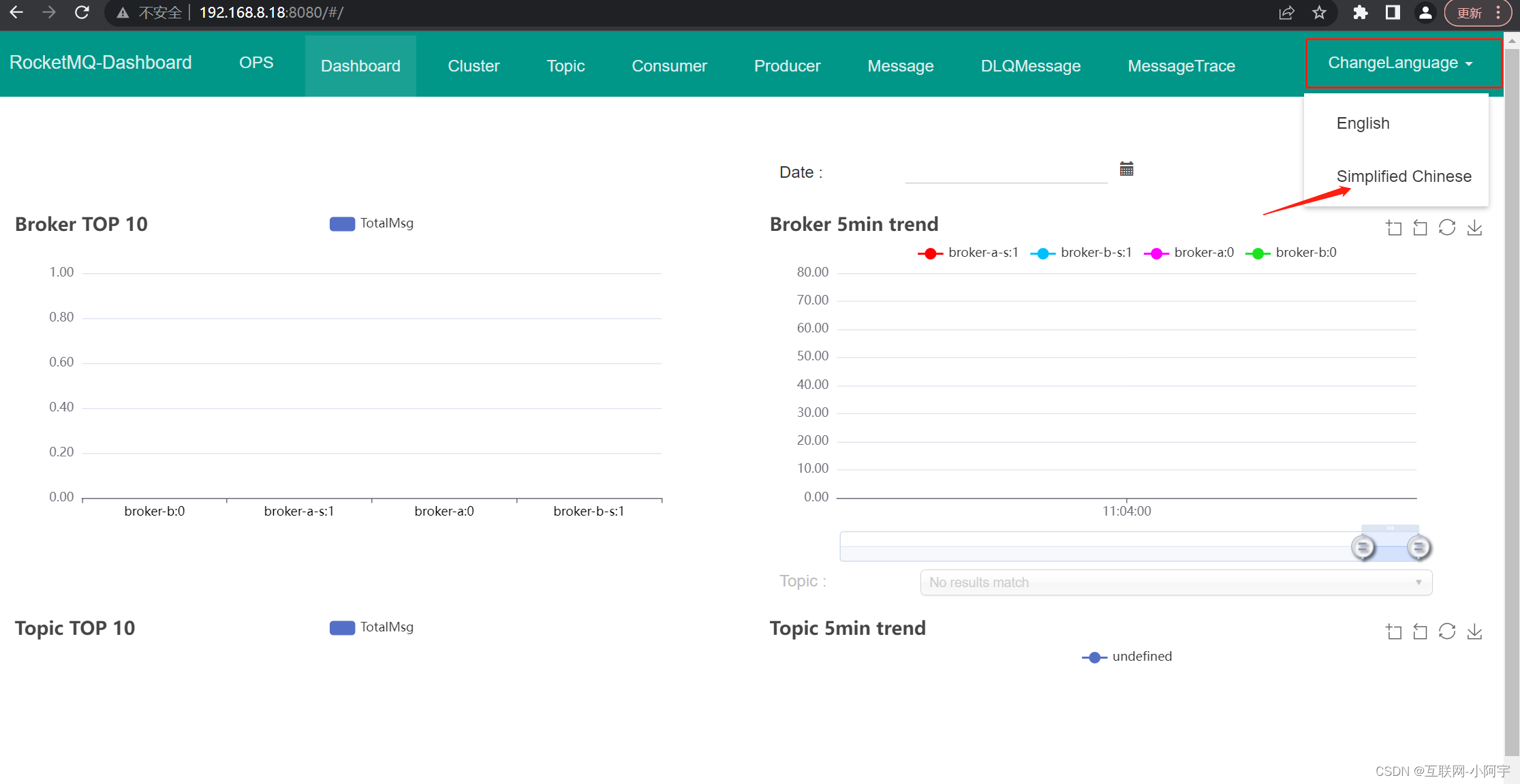

1.3 启动rocketmq-dashboard 控制台

cd /root/rocketmq-dashboard-master/rocketmq-dashboard-master/target

nohup java -jar rocketmq-dashboard-1.0.1-SNAPSHOT.jar -> dashboard.log 2>&1 &

查看日志成功启动:

关闭防火墙

方式一:建议测试环境

1、关闭防火墙。

systemctl stop firewalld

方式二:生产环境使用

1、开放指定的端口号:firewall-cmd --zone=public --add-port=8080/tcp --permanent

2、重启防火墙:firewall-cmd --reload

注意:使用方式二,就需要将nameServer 与 broker 的端口也需要开放出来。使用了那个端口就必须开放出来,否则会被防火墙给阻挡。

访问rocketmq-dashboard 控制台

访问http://ip:8080

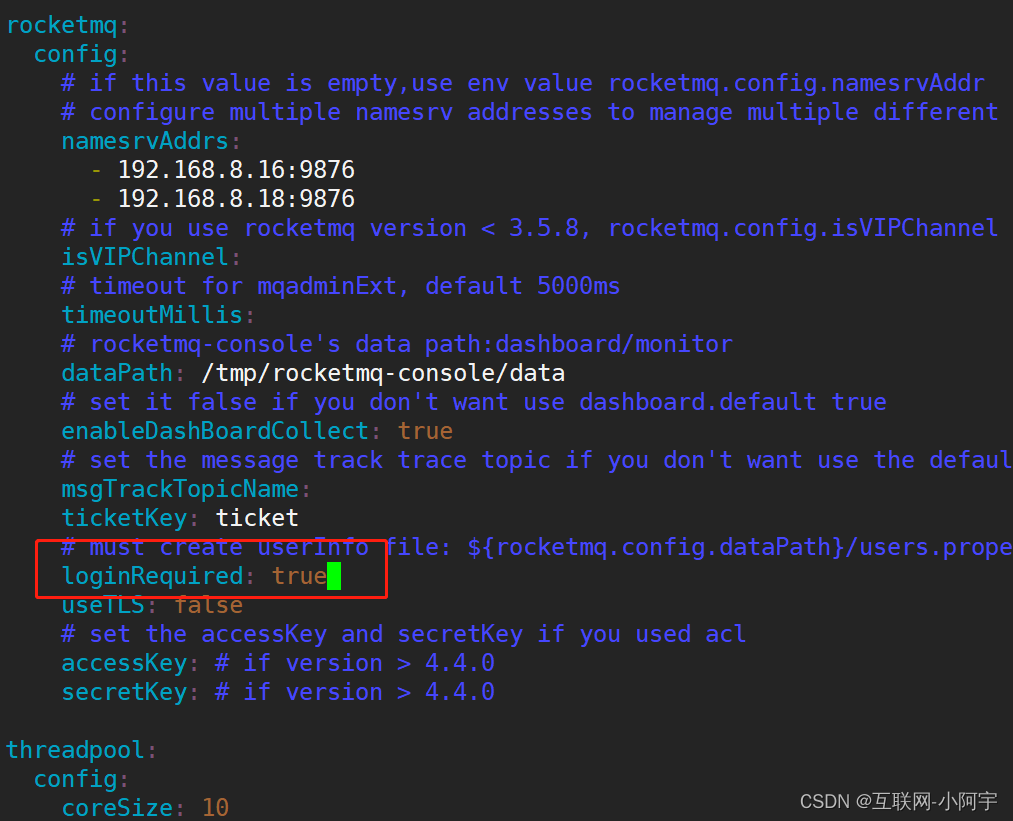

1.4 开启鉴权登录

对resource下的application.yml文件进行编辑

对resource下的user.properties修改

用户名=密码,角色:1、管理员 2、普通用户

重新打包

cd <pom.xml同级目录>

mvn clean package -Dmaven.test.skip=true -f pom.xml

运行rocketmq-dashboard 控制台

cd /root/rocketmq-dashboard-master/rocketmq-dashboard-master/target

访问rocketmq-dashboard 控制台

访问http://ip:8080

相关文章:

RocketMQ双主双从同步集群部署

🎈 作者:互联网-小啊宇 🎈 简介: CSDN 运维领域创作者、阿里云专家博主。目前从事 Kubernetes运维相关工作,擅长Linux系统运维、开源监控软件维护、Kubernetes容器技术、CI/CD持续集成、自动化运维、开源软件部署维护…...

分类预测 | MATLAB实现EVO-CNN多输入分类预测

分类预测 | MATLAB实现EVO-CNN多输入分类预测 目录 分类预测 | MATLAB实现EVO-CNN多输入分类预测预测效果基本介绍程序设计参考资料 预测效果 基本介绍 1.MATLAB实现EVO-CNN多输入分类预测 2.代码说明:量谷优化卷积神经网络的数据分类预测:要求于Matlab …...

DAY04_SpringMVC—SpringMVC简介PostMan和ApiFox工具使用SpringMVC请求与响应REST风格

目录 一 SpringMVC简介1 SpringMVC概述问题导入1.1 SpringMVC概述 2 入门案例问题导入2.0 回顾Servlet技术开发web程序流程2.1 使用SpringMVC技术开发web程序流程2.2 代码实现【第一步】创建web工程(Maven结构)【第二步】设置tomcat服务器,加…...

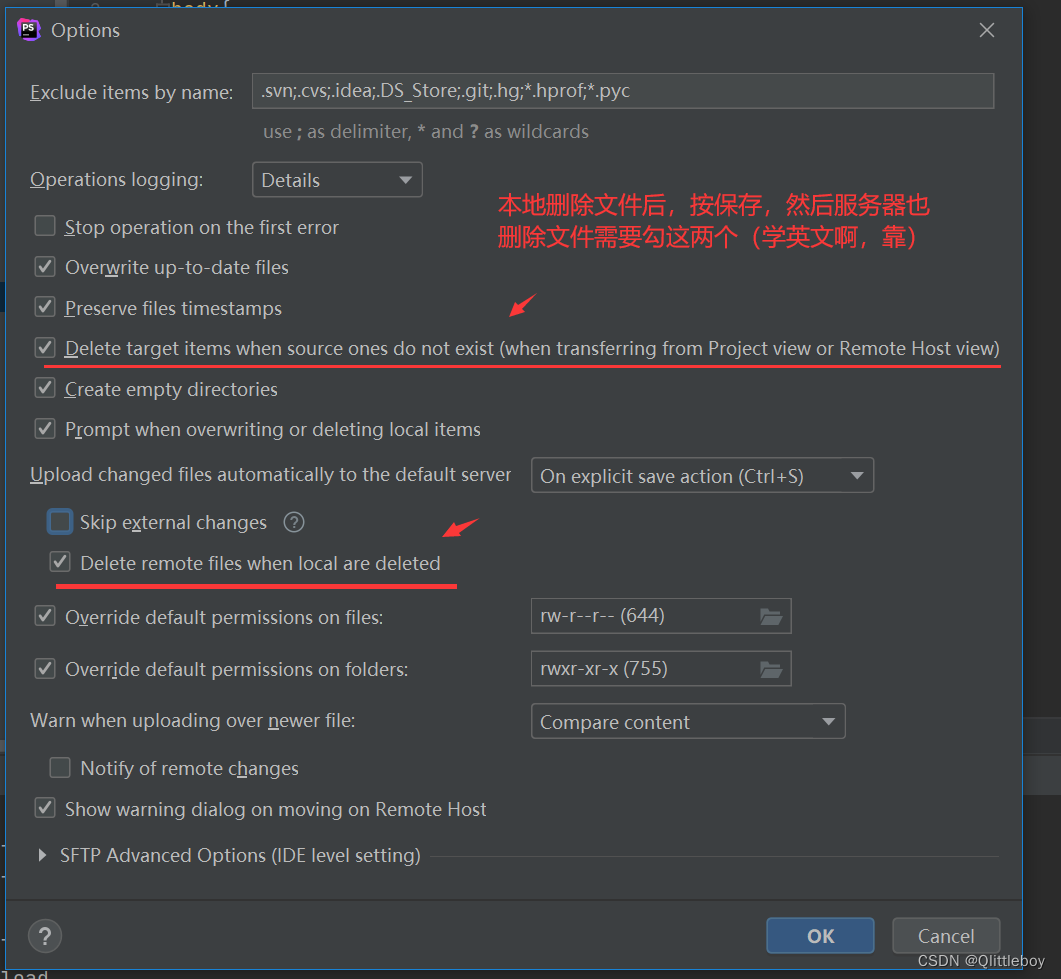

phpstorm配置ftp同步文件到服务器

这里的默认快捷键 不是 CtrlS ;需要设置快捷键,这里原来是save all操作时上传文件到服务器; ** 设置好快捷键后按 CtrlS就会同步文件(添加删除文件后保存,服务器也会同步) ** 搜索出save all 后…...

前端jd要求:了解一门后端开发语言优先 解决方案之Node.js

前端jd要求:了解一门后端开发语言优先 解决方案之Node.js 前言常见的后端开发语言一、什么是 Node.js二、学习 Node.js 的前置知识三、学习 Node.js 的步骤1、Node.js 的安装2、Node.js 的基本语法和 API模块导入和导出文件读写操作HTTP 服务器命令行参数 3、Node.j…...

)

什么是ServiceMesh(Istio一)

现在最火的后端架构无疑是微服务了,微服务将之前的单体应用拆分成了许多独立的服务应用,每个微服务都是独立的,好处自然很多,但是随着应用的越来越大,微服务暴露出来的问题也就随之而来了,微服务越来越多&a…...

【腾讯云 Cloud Studio 实战训练营】Hexo 框架 Butterfly 主题搭建个人博客

什么是Cloud Studio Cloud Studio 是基于浏览器的集成式开发环境(IDE),为开发者提供了一个永不间断的云端工作站。用户在使用 Cloud Studio 时无需安装,随时随地打开浏览器就能在线编程。 Hexo 博客成品展示 本人博客如下&…...

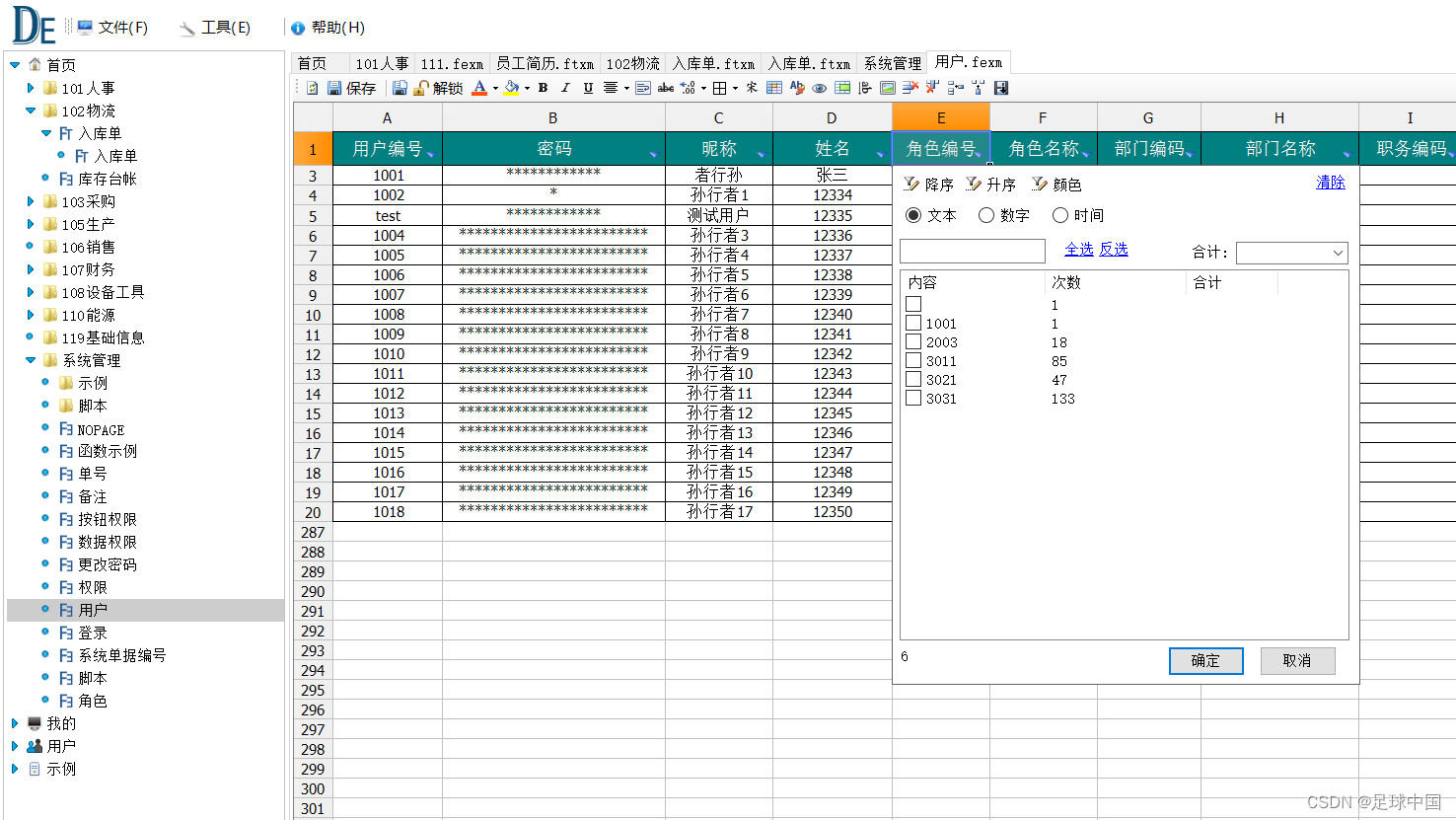

搭建Excel服务器

1、下载Excel服务器 下载地址 2、解压文件 3、打开服务器 4、服务器运行信息 5、连接测试 打开客户端 6、登录到服务器 默认账号 密码 admin 3 修改文件保存路径(服务器端点击配置) 7、客户端整体界面 8、配置权限 9、设计模板 10、其他用户登录就可以填写信息 11、用户&#…...

渗透测试成功的8个关键

渗透测试 (penetration test)并没有一个标准的定义,国外一些安全组织达成共识的通用说法是:渗透测试是通过模拟恶意黑客的攻击方法,来评估计算机网络系统安全的一种评估方法。这个过程包括对系统的任何弱点、技术缺陷或漏洞的主动分析&#x…...

【leetcode】链表part2

24. 两两交换链表中的节点 迭代方法 public static ListNode swapPairs(ListNode head) {// 输入:head [1,2,3,4]// 输出:[2,1,4,3]ListNode dummy new ListNode(0);dummy.next head;ListNode cur dummy;while (cur.next ! null && cur.ne…...

C#数据类型转换

目录 1.常用的数据类型: 编辑1.1别名概念例子: 输出结果: 2.数值类型之间的相互转换: 2.1举例: 编辑输出结果: 1.常用的数据类型: 1.1别名概念例子: 输出结果: 用GetType来获取数据类型的时候,就是指向System.Byte和System.Char这个…...

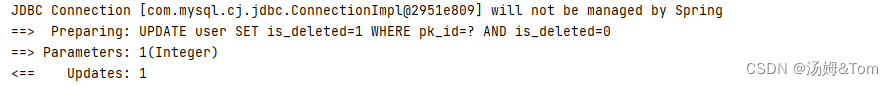

mybatis-plus逻辑删除的坑

一旦在逻辑字段上加了TableLogic逻辑删除的配置,并且使用mybatis-plus自带的方法时(如果自己用xml写SQL不会出现下面的情况) 查询、修改时会自动排除逻辑删除的数据 当使用mybatis-plus自带的查询方法时,就不用每次查询的时候跟…...

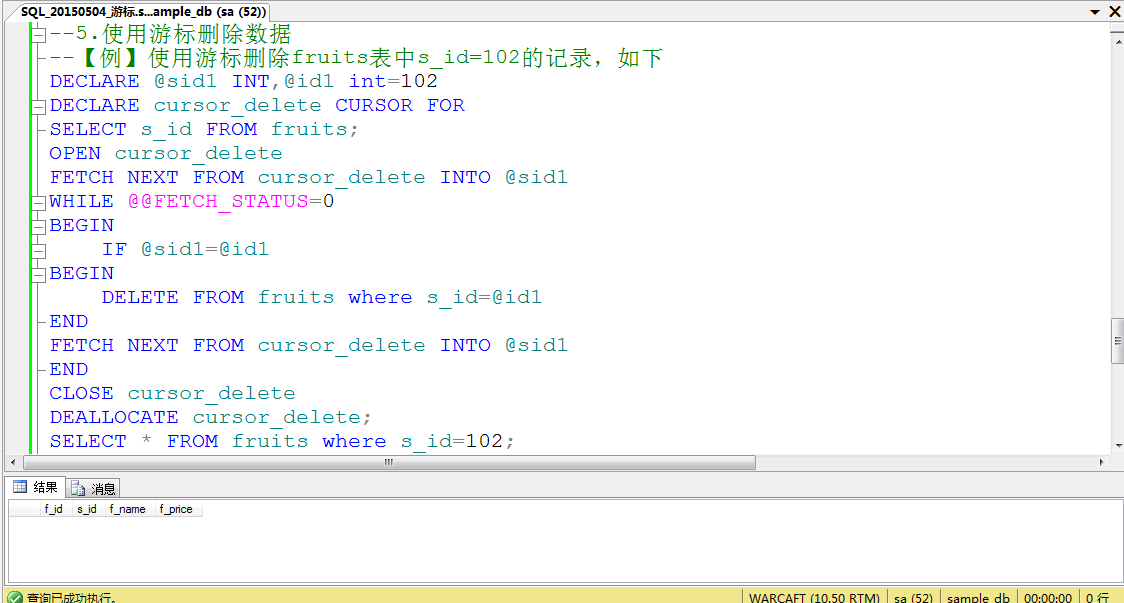

SQL Server基础之游标

一:认识游标 游标是SQL Server的一种数据访问机制,它允许用户访问单独的数据行。用户可以对每一行进行单独的处理,从而降低系统开销和潜在的阻隔情况,用户也可以使用这些数据生成的SQL代码并立即执行或输出。 1.游标的概念 游标是…...

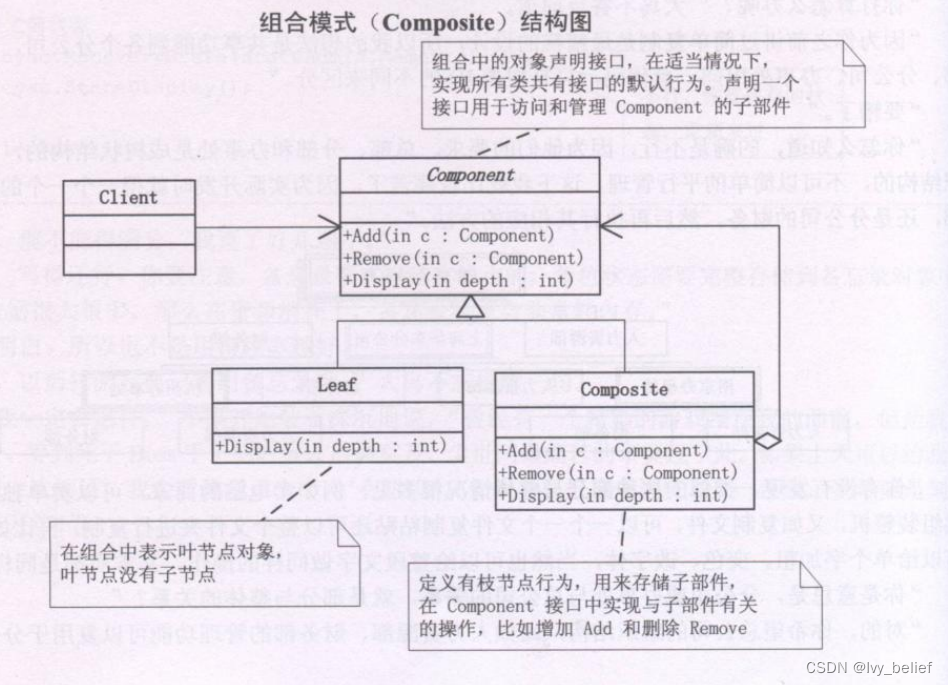

(二)结构型模式:4、组合模式(Composite Pattern)(C++实例)

目录 1、组合模式(Composite Pattern)含义 2、组合模式应用场景 3、组合模式的优缺点 4、组合模式的UML图学习 5、C实现组合模式的简单示例(公司的OA系统) 1、组合模式(Composite Pattern)含义 组合模…...

flask接口请求频率限制

pip install Flask-Limiter Flask-Limiter官方文档 基本使用 默认是用IP作为key进行计数的,你也可以自定义key,具体看官网 from flask import Flask from flask_limiter import Limiter from flask_limiter.util import get_remote_addressapp Flas…...

javaweb监听器和juery技术

监听servlet创建 package com.hspedu.listener;import javax.servlet.ServletContext; import javax.servlet.ServletContextEvent; import javax.servlet.ServletContextListener;/*** 老韩解读* 1. 当一个类实现了 ServletContextListener* 2. 该类就是一个监听器* 3. 该类可…...

C++并发多线程--std::unique_lock的使用

目录 1--std::unique_lock的使用 1-1--std::adopt_lock参数 1-2--std::try_to_lock参数 1-3--std::defer_lock参数 1-4--互斥量所有权转移 1--std::unique_lock的使用 常用成员函数: ① lock(): 加锁; ② unlock(): 解锁; ③ try_lock()…...

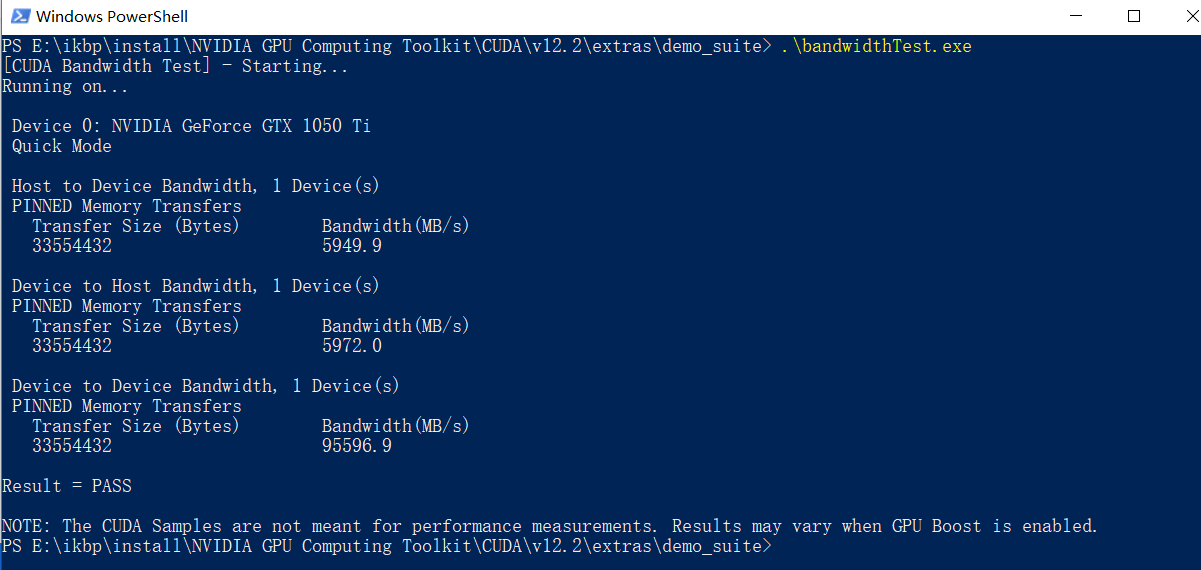

【ChatGLM】ChatGLM-6B模型Win+4GB显卡本地部署笔记

ChatGLM-6B是清华大学知识工程和数据挖掘小组发布的一个类似ChatGPT的开源对话机器人,由于该模型是经过约1T标识符的中英文训练,且大部分都是中文,因此十分适合国内使用。 预期环境 本机电脑备注: Win10专业版 32G内存256固态系统…...

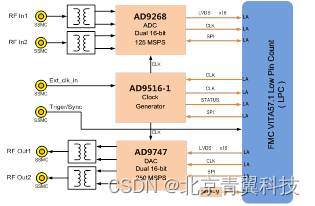

青翼科技自研2路250MSPS DA回放FMC子卡模块

FMC150_V30是一款基于VITA57.1规范的2路125MSPS采样率16位分辨率AD采集、2路250MSPS采样率16位分辨率DA回放FMC子卡模块。该模块遵循VITA57.1规范,可直接与符合VITA57.1规范的FPGA载卡配合使用,板卡ADC器件采用ADI公司的AD9268芯片,板卡DAC器…...

硬件产品经理:从入门到精通(新书发布)

目录 简介 新书 框架内容 相关课程 简介 在完成多款硬件产品从设计到推向市场的过程后。 笔者于2020年开始在产品领域平台输出硬件相关的内容。 在这个过程中经常会收到很多读者的留言,希望能推荐一些硬件相关的书籍或资料。 其实,笔者刚开始做硬…...

Linux应用开发之网络套接字编程(实例篇)

服务端与客户端单连接 服务端代码 #include <sys/socket.h> #include <sys/types.h> #include <netinet/in.h> #include <stdio.h> #include <stdlib.h> #include <string.h> #include <arpa/inet.h> #include <pthread.h> …...

利用ngx_stream_return_module构建简易 TCP/UDP 响应网关

一、模块概述 ngx_stream_return_module 提供了一个极简的指令: return <value>;在收到客户端连接后,立即将 <value> 写回并关闭连接。<value> 支持内嵌文本和内置变量(如 $time_iso8601、$remote_addr 等)&a…...

)

云计算——弹性云计算器(ECS)

弹性云服务器:ECS 概述 云计算重构了ICT系统,云计算平台厂商推出使得厂家能够主要关注应用管理而非平台管理的云平台,包含如下主要概念。 ECS(Elastic Cloud Server):即弹性云服务器,是云计算…...

基于距离变化能量开销动态调整的WSN低功耗拓扑控制开销算法matlab仿真

目录 1.程序功能描述 2.测试软件版本以及运行结果展示 3.核心程序 4.算法仿真参数 5.算法理论概述 6.参考文献 7.完整程序 1.程序功能描述 通过动态调整节点通信的能量开销,平衡网络负载,延长WSN生命周期。具体通过建立基于距离的能量消耗模型&am…...

最新SpringBoot+SpringCloud+Nacos微服务框架分享

文章目录 前言一、服务规划二、架构核心1.cloud的pom2.gateway的异常handler3.gateway的filter4、admin的pom5、admin的登录核心 三、code-helper分享总结 前言 最近有个活蛮赶的,根据Excel列的需求预估的工时直接打骨折,不要问我为什么,主要…...

)

【RockeMQ】第2节|RocketMQ快速实战以及核⼼概念详解(二)

升级Dledger高可用集群 一、主从架构的不足与Dledger的定位 主从架构缺陷 数据备份依赖Slave节点,但无自动故障转移能力,Master宕机后需人工切换,期间消息可能无法读取。Slave仅存储数据,无法主动升级为Master响应请求ÿ…...

ArcGIS Pro制作水平横向图例+多级标注

今天介绍下载ArcGIS Pro中如何设置水平横向图例。 之前我们介绍了ArcGIS的横向图例制作:ArcGIS横向、多列图例、顺序重排、符号居中、批量更改图例符号等等(ArcGIS出图图例8大技巧),那这次我们看看ArcGIS Pro如何更加快捷的操作。…...

Kafka入门-生产者

生产者 生产者发送流程: 延迟时间为0ms时,也就意味着每当有数据就会直接发送 异步发送API 异步发送和同步发送的不同在于:异步发送不需要等待结果,同步发送必须等待结果才能进行下一步发送。 普通异步发送 首先导入所需的k…...

站群服务器的应用场景都有哪些?

站群服务器主要是为了多个网站的托管和管理所设计的,可以通过集中管理和高效资源的分配,来支持多个独立的网站同时运行,让每一个网站都可以分配到独立的IP地址,避免出现IP关联的风险,用户还可以通过控制面板进行管理功…...

MySQL 8.0 事务全面讲解

以下是一个结合两次回答的 MySQL 8.0 事务全面讲解,涵盖了事务的核心概念、操作示例、失败回滚、隔离级别、事务性 DDL 和 XA 事务等内容,并修正了查看隔离级别的命令。 MySQL 8.0 事务全面讲解 一、事务的核心概念(ACID) 事务是…...