LLMs之Code:Code Llama的简介、安装、使用方法之详细攻略

LLMs之Code:Code Llama的简介、安装、使用方法之详细攻略

导读:2023年08月25日(北京时间),Meta发布了Code Llama,一个可以使用文本提示生成代码的大型语言模型(LLM)。Code Llama是最先进的公开可用的LLM代码任务,并有潜力使工作流程更快,更有效的为当前的开发人员和降低进入门槛的人正在学习代码。Code Llama有潜力作为一种生产力和教育工具来帮助程序员编写更健壮、文档更完善的软件。

Code Llama在Llama 2的基础上增强了编码能力。它可以从代码和自然语言提示(例如,“给我写一个输出斐波那契数列的函数。”)中生成代码和关于代码的自然语言。它也可以用于代码完成和调试。它支持许多当今最流行的语言,包括Python、c++、Java、PHP、Typescript (Javascript)、c#和Bash。

>> Code Llama是一个开源的、最先进的LLM,能够从代码和自然语言提示中生成代码和关于代码的自然语言。它专注于生成代码和理解自然语言代码说明,其性能优于当前公开的其他代码生成LLM,为编程带来支持,其开源训练方法有助于社区建立更多创新工具。

>> Code Llama有三个尺寸的版本,参数量分别为7B、13B和34B,并支持多种编程语言。它稳定支持了最高10万个token的上下文生成。这三个参数版本的Code Llama模型都使用了500B的代码tokens和代码相关数据进行训练。7B和13B版本的模型还经过了FIM(fill-in-the-middle)训练,可以将代码插入到现有代码中,支持开箱即用的代码补全等任务。不同的服务和延迟要求可以选择适合的模型版本。例如,7B模型适合在单个GPU上运行,而34B模型提供了更好的编码辅助和最佳结果,但速度较慢。对于低延迟任务,比如实时代码补全,较小的7B和13B模型速度更快。

>> Code Llama建立在Llama 2的基础上,并通过在代码特定数据集上进行进一步训练来提升编码能力。除了基础模型外,还有针对Python优化的Code Llama - Python和理解自然语言指令优化的Code Llama - Instruct版本。在代码生成基准测试中,Code Llama表现优于其他公开可用的代码专用语言模型,性能与ChatGPT相当。

目录

Code Llama的简介

1、《Code Llama: Open Foundation Models for Code》翻译与解读

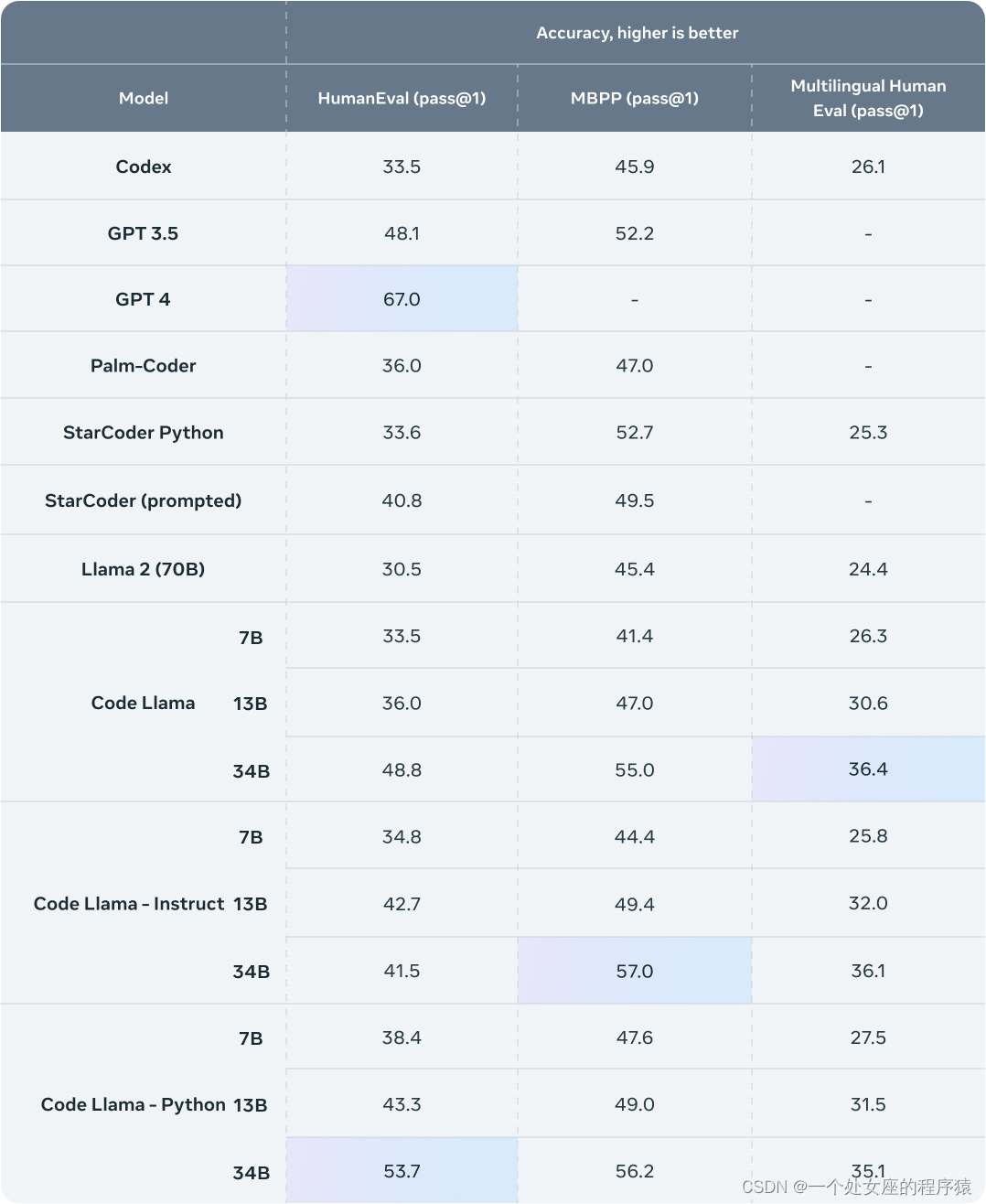

2、模型评估效果对比:HumanEval、MBPP、MHEval

3、基于Code Llama的衍生模型

(1)、Phind团队:Phind-CodeLlama-34B-v1、Phind-CodeLlama-34B-Python-v1

(2)、WizardLM团队:WizardCoder

Code Llama的安装

1、模型部署与推理

第1步,获取Meta 官网授权

第2步,sh脚本下载

第3步,模型推理

2、预训练

3、代码填充

4、微调指令模型

Code Llama的使用方法

Code Llama的简介

2023年08月25日,Meta发布了基于的Llama2用于专攻代码生成的基础模型 Code Llama。Code Llama 是基于 Llama 2 的一系列面向代码的大型语言模型,提供了在开放模型中领先的性能,填充能力,支持大型输入上下文,以及用于编程任务的零-shot指令跟随能力。

该项目提供多个版本以覆盖广泛的应用领域:基础模型(Code Llama),Python 专用模型(Code Llama - Python),以及指令跟随模型(Code Llama - Instruct),分别具有7B、13B和34B的参数。所有模型都是在16k标记的序列上进行训练的,并在最多100k标记的输入上显示出改进。7B和13B的 Code Llama 和 Code Llama - Instruct 变体支持基于周围内容的填充。

Code Llama 是通过对 Llama 2 进行代码的更高采样来进行微调开发的。与 Llama 2 一样,我们对模型的微调版本应用了相当大的安全措施。有关模型训练、架构和参数、评估、负责人工智能和安全的详细信息,请参阅我们的研究论文。由 Llama Materials 的代码生成功能生成的输出,包括 Code Llama,在内可能受第三方许可证的约束,包括但不限于开源许可证。

我们正在释放大型语言模型的强大能力,我们的最新版本 Code Llama 现在可以让个人、创作者、研究人员和各个规模的企业获得使用权限,以便他们可以负责地进行实验、创新和扩展他们的想法。此发布包括预训练和微调 Llama 语言模型的模型权重和初始代码,参数范围从7B到34B。该存储库旨在作为一个最小的示例,用于加载 Code Llama 模型并进行推理。

Code Llama 是一项带有潜在风险的新技术。到目前为止进行的测试未能覆盖所有情况。为了帮助开发人员应对这些风险,我们已创建了《负责任使用指南》。更多详细信息可以在我们的研究论文中找到。

GitHub官网:GitHub - facebookresearch/codellama: Inference code for CodeLlama models

论文地址:https://ai.meta.com/research/publications/code-llama-open-foundation-models-for-code/

官网文章:https://ai.meta.com/blog/code-llama-large-language-model-coding/

1、《Code Llama: Open Foundation Models for Code》翻译与解读

| 摘要 | 我们发布了Code Llama,这是一系列基于Llama 2的面向代码的大型语言模型,具有开放模型中最先进的性能、填充能力、支持大型输入上下文以及零-shot指令跟随能力,可用于编程任务。我们提供多种版本以覆盖广泛的应用领域:基础模型(Code Llama)、Python专用模型(Code Llama - Python)和指令跟随模型(Code Llama - Instruct),分别具有7B、13B和34B个参数。所有模型都是在16k个标记的序列上进行训练,并在最多100k个标记的输入上显示出改进效果。7B和13B的Code Llama和Code Llama - Instruct变种支持基于周围内容的填充。Code Llama在几个代码基准测试中达到了开放模型的最先进性能,分别在HumanEval和MBPP上获得了53%和55%的得分。值得注意的是,Code Llama - Python 7B在HumanEval和MBPP上的表现超过了Llama 2 70B,而我们的所有模型在MultiPL-E上都优于其他公开可用的模型。我们以宽松的许可证发布Code Llama,既允许研究使用,也允许商业使用。 |

| 结论 | 我们发布了一系列专注于代码的Llama 2模型,称为Code Llama,包含三个主要变种,我们以三种规模(7B、13B和34B个参数)发布:Code Llama、Code Llama - Python和Code Llama - Instruct。考虑到实际应用,我们训练了7B和13B的模型以支持填充,并让所有模型能够利用大型上下文。我们在推理中测试它们在最多100K个标记(图4a)的情况下的稳定性。大型上下文微调和填充在标准基准测试中(表10)的基于从左到右的代码生成基准测试中有一定的代价,这些测试都基于短序列(即函数级别)。尽管如此,我们的30B模型在标准Python完成基准测试中是公开模型中最先进的,而我们的其他模型与具有相似参数数量的模型相比具有竞争力。在多语言基准测试中,即使是我们最小的模型(Code Llama 7B)也优于其他任何公开模型。 Code Llama - Instruct模型经过训练,为Code Llama提供了零-shot指令能力。在这种进一步的微调中,我们在一定程度上提炼了Llama 2-Chat,不仅注重更直接的帮助(图5c),还努力提供更安全的模型供使用和部署(第4节)。遵循指令并过于安全可能会在评估中损失一些得分(例如表2中34B模型在HumanEval上的情况),如图14所示。需要进一步的工作让LLM能够理解上下文和指令中的细微差别。 |

2、模型评估效果对比:HumanEval、MBPP、MHEval

Code Llama表现优异

3、基于Code Llama的衍生模型

(1)、Phind团队:Phind-CodeLlama-34B-v1、Phind-CodeLlama-34B-Python-v1

Phind 团队利用内部Phind数据集调优CodeLlama-34B和CodeLlama-34B-Python模型,在HumanEval上超越GPT-4的表现。在该内部数据集上,两模型分别获得67.6%和69.5%的通过率,高于原始模型的48.8%和53.7% 。调优后模型Phind-CodeLlama-34B-v1和Phind-CodeLlama-34B-Python-v1在HumanEval上分别获得67.6%和69.5%的通过率。显然都超越了原始 GPT-4 的 67%。

| 时间 | 2023年8月27日(北京时间) |

| 作者 | Phind团队 |

| 地址 | 地址:https://www.phind.com/blog/code-llama-beats-gpt4 |

| 原文章 | 通过对CodeLlama-34B和CodeLlama-34B-Python进行微调,我们在内部的Phind数据集上取得了令人瞩目的成绩。CodeLlama-34B在HumanEval上的一次通过率为48.8%,而CodeLlama-34B-Python则为53.7%。根据OpenAI在三月份的官方技术报告,GPT-4的通过率为67%。为确保结果的有效性,我们对数据集应用了OpenAI的去污染方法。 昨天发布的CodeLlama模型在HumanEval上展现出了出色的性能。 >> Phind-CodeLlama-34B-v1在HumanEval上的一次通过率为67.6%。 >> Phind-CodeLlama-34B-Python-v1在HumanEval上的一次通过率为69.5%。 我们将这两个模型在一个拥有大约80,000个高质量编程问题和解决方案的专有数据集上进行了微调。与HumanEval在结构上不同的是,该数据集采用了指令-答案对而不是代码补全示例。 我们对Phind模型进行了两个时期的训练,总共约160,000个示例。我们没有使用LoRA,这两个模型都经过了本机的微调。我们使用DeepSpeed ZeRO 3和Flash Attention 2,在32个A100-80GB的GPU上进行训练,序列长度为4096个标记,训练时间为三个小时。 此外,我们还应用了OpenAI的去污染方法来确保结果的有效性,并且没有发现任何受污染的示例。该方法如下所示: >> 对于每个评估示例,我们随机抽样了三个50个字符的子字符串,如果示例少于50个字符,则使用整个示例。 >> 如果任何抽样的子字符串是处理过的训练示例的子字符串,则认为存在匹配。 有关去污染方法的更多信息,请参阅OpenAI技术报告附录C。下面是我们在微调模型中实现的一次通过率得分: >> Phind-CodeLlama-34B-v1在HumanEval上的一次通过率为67.6%。 >> Phind-CodeLlama-34B-Python-v1在HumanEval上的一次通过率为69.5%。 |

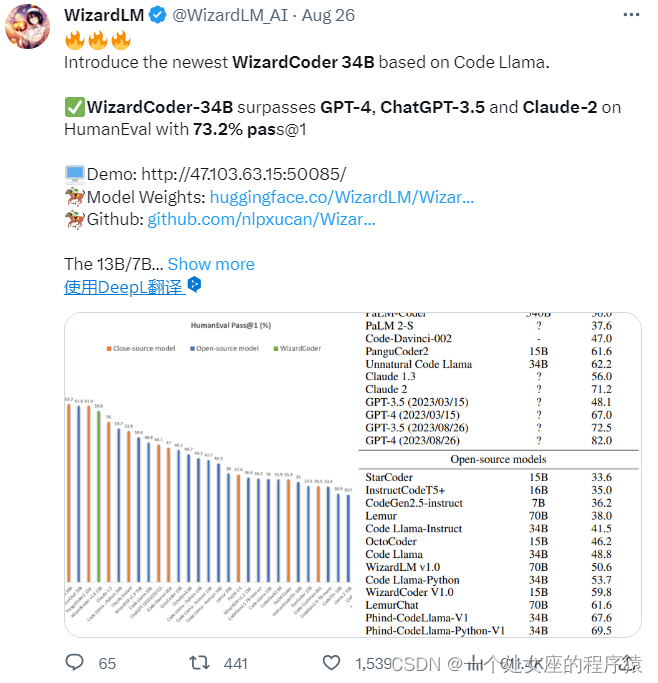

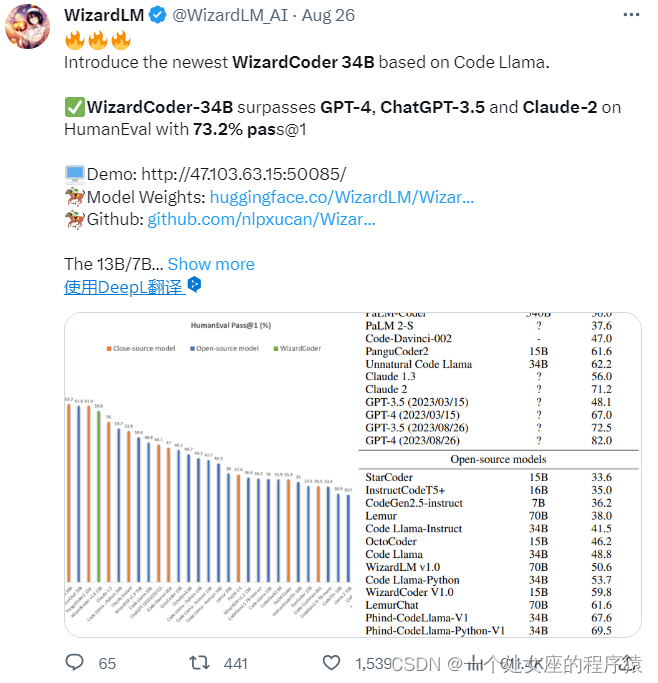

(2)、WizardLM团队:WizardCoder

WizardLM 团队发布了基于Code Llama的最新WizardCoder-34B。WizardCoder-34B在HumanEval上的一次通过率(pass@1)达到了惊人的 73.2%,超越了原始 GPT-4、ChatGPT-3.5 以及 Claude 2、Bard。

为了开发我们的WizardCoder模型,我们首先采用了Evol-Instruct方法,专门针对编码任务进行了适应。这包括将提示信息定制为与代码相关的指令领域。随后,我们使用新创建的指令跟随训练集对Code LLama的模型进行了微调,包括StarCoder或Code LLama。

| 时间 | 2023年8月27日(北京时间) |

| 作者 | WizardLM 团队 |

| 地址 | GitHub地址:https://github.com/nlpxucan/WizardLM/tree/main/WizardCoder 测试地址:WizardCoder-Python-34B-V1.0 |

Code Llama的安装

1、模型部署与推理

第1步,获取Meta 官网授权

为了下载模型权重和分词器,请访问 Meta AI 网站并接受我们的许可协议。

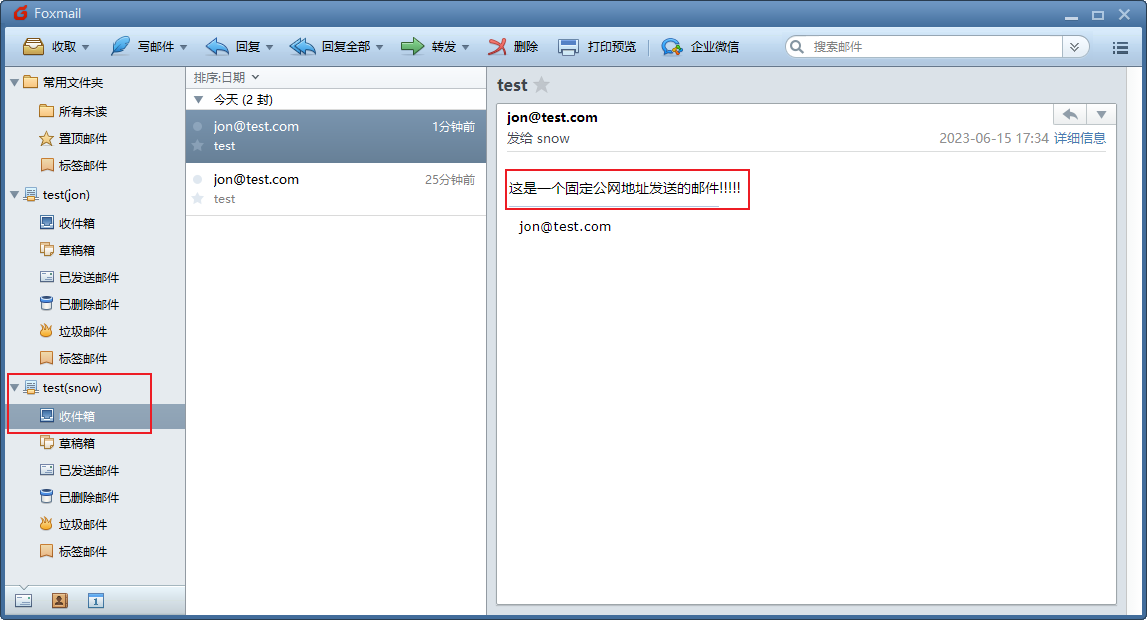

一旦您的请求获得批准,您将收到一封带有签名的电子邮件链接。

第2步,sh脚本下载

| 下载脚本 | 然后运行 download.sh 脚本,在提示时传递提供的 URL 开始下载。请确保复制 URL 文本本身,不要使用右键单击 URL 时的“复制链接地址”选项。如果复制的 URL 文本以 https://download.llamameta.net开头,则复制正确。如果复制的 URL 文本以 https://l.facebook.com开头,则复制错误。 |

| 先决条件 | 先决条件:确保您已安装 wget 和 md5sum。然后运行脚本:bash download.sh。 请注意,链接在24小时后和一定数量的下载后会过期。如果您开始看到诸如 403:Forbidden 的错误,您始终可以重新请求链接。 |

| 设置 | 在具有 PyTorch / CUDA 的 conda 环境中,克隆存储库并在顶级目录中运行: pip install -e . |

第3步,模型推理

不同的模型需要不同的模型并行(MP)值

| Model | MP |

| 7B | 1 |

| 13B | 2 |

| 34B | 4 |

所有模型都支持长达100,000标记的序列长度,但我们根据 max_seq_len 和 max_batch_size 值预先分配缓存。因此根据您的硬件和用例设置这些值。

2、预训练

Code Llama 和 Code Llama - Python 模型没有经过微调以遵循指令。它们应该通过提示来获取期望的答案,即提示的自然延续。请参考 example_completion.py 查看一些示例。为了说明,查看下面的命令,以使用 CodeLlama-7b 模型运行它(nproc_per_node 需要设置为 MP 值):

torchrun --nproc_per_node 1 example_completion.py

--ckpt_dir CodeLlama-7b/

--tokenizer_path CodeLlama-7b/tokenizer.model

--max_seq_len 128 --max_batch_size 4预训练的代码模型包括:Code Llama 模型 CodeLlama-7b、CodeLlama-13b、CodeLlama-34b,以及 Code Llama - Python 模型 CodeLlama-7b-Python、CodeLlama-13b-Python、CodeLlama-34b-Python。

3、代码填充

Code Llama 和 Code Llama - Instruct 7B 和 13B 模型能够根据周围上下文填充代码。

请参考 example_infilling.py 查看一些示例。可以使用以下命令运行 CodeLlama-7b 模型以进行填充(nproc_per_node 需要设置为 MP 值):

torchrun --nproc_per_node 1 example_infilling.py

--ckpt_dir CodeLlama-7b/

--tokenizer_path CodeLlama-7b/tokenizer.model

--max_seq_len 192 --max_batch_size 4预训练的填充模型包括:Code Llama 模型 CodeLlama-7b 和 CodeLlama-13b,以及 Code Llama - Instruct 模型 CodeLlama-7b-Instruct、CodeLlama-13b-Instruct。

4、微调指令模型

Code Llama - Instruct 模型经过微调以遵循指令。为了获得预期的特性和性能,需要遵循 chat_completion 中定义的特定格式,包括 INST 和 <<SYS>> 标签,BOS 和 EOS 标记,以及之间的空格和换行符(我们建议在输入上调用 strip() 以避免双空格)。

您还可以部署附加分类器,以过滤出被认为不安全的输入和输出。请参阅 llama-recipes 存储库,了解如何将安全检查器添加到推理代码的输入和输出中的示例。

使用 CodeLlama-7b-Instruct 的示例:

torchrun --nproc_per_node 1 example_instructions.py

--ckpt_dir CodeLlama-7b-Instruct/

--tokenizer_path CodeLlama-7b-Instruct/tokenizer.model

--max_seq_len 512 --max_batch_size 4经过微调的指令跟随模型包括:Code Llama - Instruct 模型 CodeLlama-7b-Instruct、CodeLlama-13b-Instruct、CodeLlama-34b-Instruct。

Code Llama的使用方法

更新中……

相关文章:

LLMs之Code:Code Llama的简介、安装、使用方法之详细攻略

LLMs之Code:Code Llama的简介、安装、使用方法之详细攻略 导读:2023年08月25日(北京时间),Meta发布了Code Llama,一个可以使用文本提示生成代码的大型语言模型(LLM)。Code Llama是最先进的公开可用的LLM代码任务,并有潜…...

[国产MCU]-W801开发实例-MQTT客户端通信

MQTT客户端通信 文章目录 MQTT客户端通信1、MQTT介绍2、W801的MQTT客户端相关API介绍3、代码实现本文将详细介绍如何在W801中使用MQTT协议通信。 1、MQTT介绍 MQTT 被称为消息队列遥测传输协议。它是一种轻量级消息传递协议,可通过简单的通信机制帮助资源受限的网络客户端。 …...

搭建个人hMailServer 邮件服务实现远程发送邮件

文章目录 1. 安装hMailServer2. 设置hMailServer3. 客户端安装添加账号4. 测试发送邮件5. 安装cpolar6. 创建公网地址7. 测试远程发送邮件8. 固定连接公网地址9. 测试固定远程地址发送邮件 hMailServer 是一个邮件服务器,通过它我们可以搭建自己的邮件服务,通过cpolar内网映射工…...

React的 虚拟DOM创建

React是一个流行的JavaScript库,用于构建用户界面。它通过使用虚拟DOM来提高性能和渲染速度。本文将详细介绍React的虚拟DOM的创建方式、用法和案例,以及相关代码和解释。 虚拟DOM是什么? 虚拟DOM是React的一个重要概念,它是一个…...

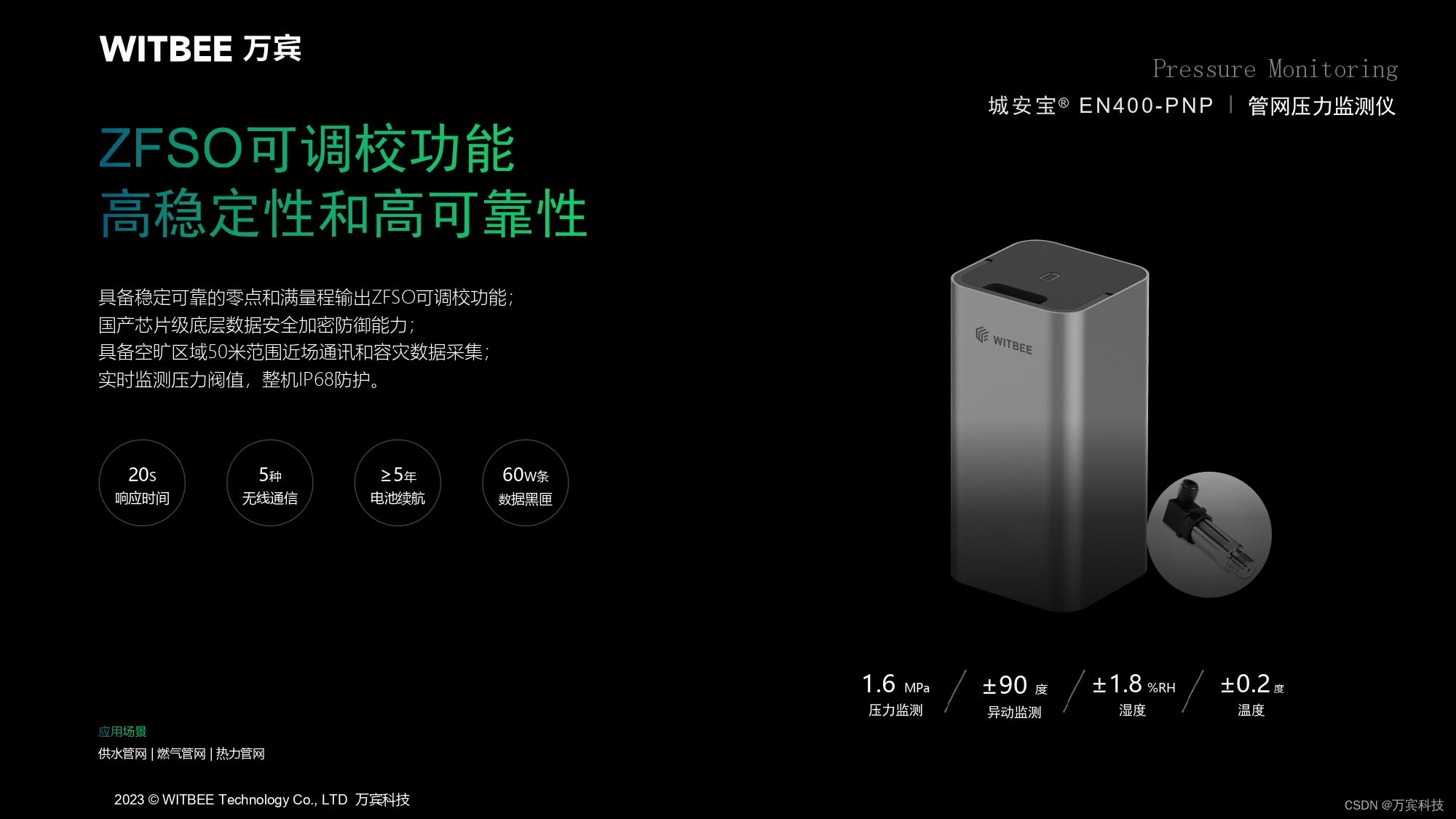

供热管网安全运行监测,提升供热管网安全性能

城市管网是城市的“生命线”之一,是城市赖以生存和发展的基础,在城市基础设施高质量发展中发挥着重要作用。供热管网作为城市生命线中连接供热管线与热用户的桥梁,担负着向企业和居民用户直接供热的重要职责。随着城市热力需求的急剧增加&…...

手写Mybatis:第14章-解析和使用ResultMap映射参数配置

文章目录 一、目标:ResultMap映射参数二、设计:ResultMap映射参数三、实现:ResultMap映射参数3.1 工程结构3.2 ResultMap映射参数类图3.3 添加类型处理器3.3.1 日期类型处理器3.3.2 类型处理器注册机 3.4 存放映射对象3.4.1 结果标志3.4.2 结…...

GE VME-7807RC-410001350-93007807-410001 K数字输入模块

通道数目: VME-7807RC-410001350-93007807-410001K 数字输入模块通常具有多个数字输入通道,可以同时监测多个数字信号。 输入类型: 这种模块通常用于监测数字信号,例如开关状态(ON/OFF)或计数器脉冲。 采…...

C++插入加密,替代加密

void 插入加密() {//缘由https://bbs.csdn.net/topics/396047473int n 1, j 0;char aa[60]{}, aaa[] "abcde";cin >> aa;while (j < 60 && (aa[j] - \0))cout << aa[j] << aaa[j % 5]; } void 插入加密() {//缘由https://bbs.csdn.n…...

Web前端开发概述

Web(World Wide Web,全球广域网)是指一种基于互联网的信息系统,通过超文本链接将全球各地的文档、图像、视频等资源相互关联起来,并通过Web浏览器进行交互浏览和访问。Web的发展使得人们可以方便地获取和共享各种类型的…...

Web自动化 —— Selenium元素定位与防踩坑

1. 基本元素定位一 from selenium import webdriver from selenium.webdriver.chrome.service import Service from selenium.webdriver.common.by import By # selenium Service("../../chromedriver.exe") # driver webdriver.Chrome(serviceService) # driver.…...

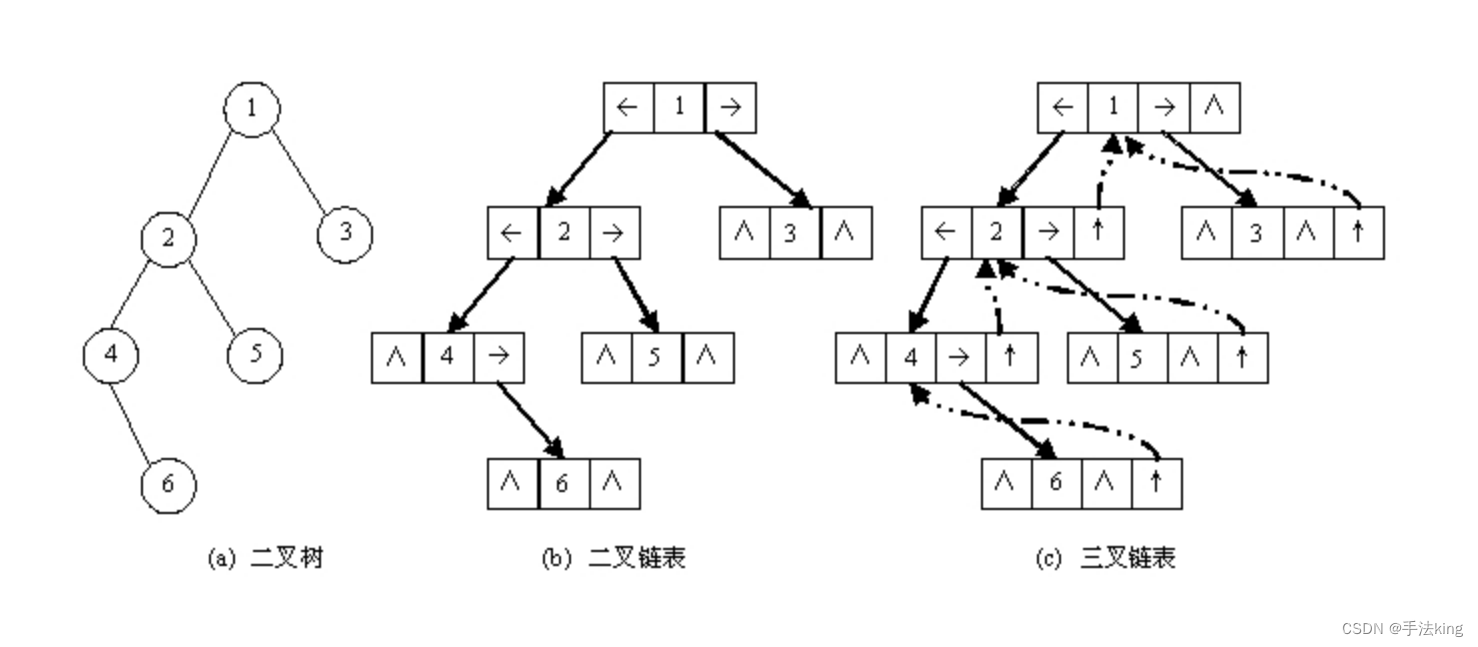

【数据结构】树和二叉树的概念及结构(一)

目录 一,树的概念及结构 1,树的定义 2,树结点的分类及关系 3,树的表示 二,二叉树的概念及结构 1,二叉树的定义 2,特殊的二叉树 3,二叉树的性质 4,二叉树的存储结构 1&…...

第三章 USB应用笔记之USB鼠标(以STM32 hal库为例)

第三章 USB应用笔记之USB鼠标(以STM32 hal库为例) 提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 第三章 USB应用笔记之USB鼠标(以STM32 hal库为例)前言一、STM32 U…...

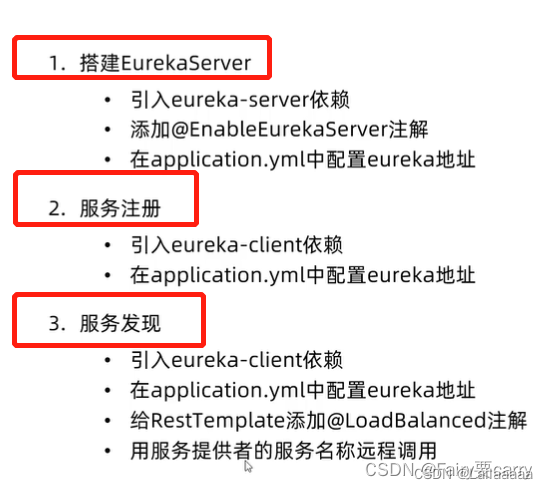

微服务01-基本介绍+注册中心EureKa

基本介绍 服务集群:一个请求由多个服务完成,服务接口暴露,以便于相互调用; 注册中心:每个服务的状态,需要进行维护,我们可以在注册中心进行监控维护服务; 配置中心:这些…...

【ES6】JavaScript中的异步编程:async和await

在JavaScript中,异步编程是一种处理长时间运行的操作的方法,这些操作包括读取文件、网络请求或处理大数据等。在传统的回调函数中,代码按照顺序执行,一旦遇到长时间运行的操作,就需要回调函数来处理结果。这使得代码变…...

51单片机热水器温度控制系统仿真设计( proteus仿真+程序+原理图+报告+讲解视频)

51单片机热水器温度控制系统仿真设计 1.主要功能:2.仿真3. 程序代码4. 原理图5. 设计报告6. 设计资料内容清单 &&下载链接 51单片机热水器温度控制系统仿真设计( proteus仿真程序原理图报告讲解视频) 仿真图proteus7.8及以上 程序编译器&#x…...

Spring Boot 配置文件加密

方式一:Spring Cloud Config 一、建立config server 1. build.gradle 文件中添加: plugins {id javaid org.springframework.boot version 2.7.0id io.spring.dependency-management version 1.0.11.RELEASE }ext {set(springCloudVersion, "202…...

【树形权限】树形列表权限互斥选择、el-tree设置禁用等等

需求:按照权限管理配置的数据权限树展开;点击查看按钮后进入其他指定机构选择弹窗为一树形结构 本文章对项目中出现得关键点进行总结。 一、实现如上树形列表 在 element 官方表格示例中,实现树形表格列表数据渲染,非常简单。只…...

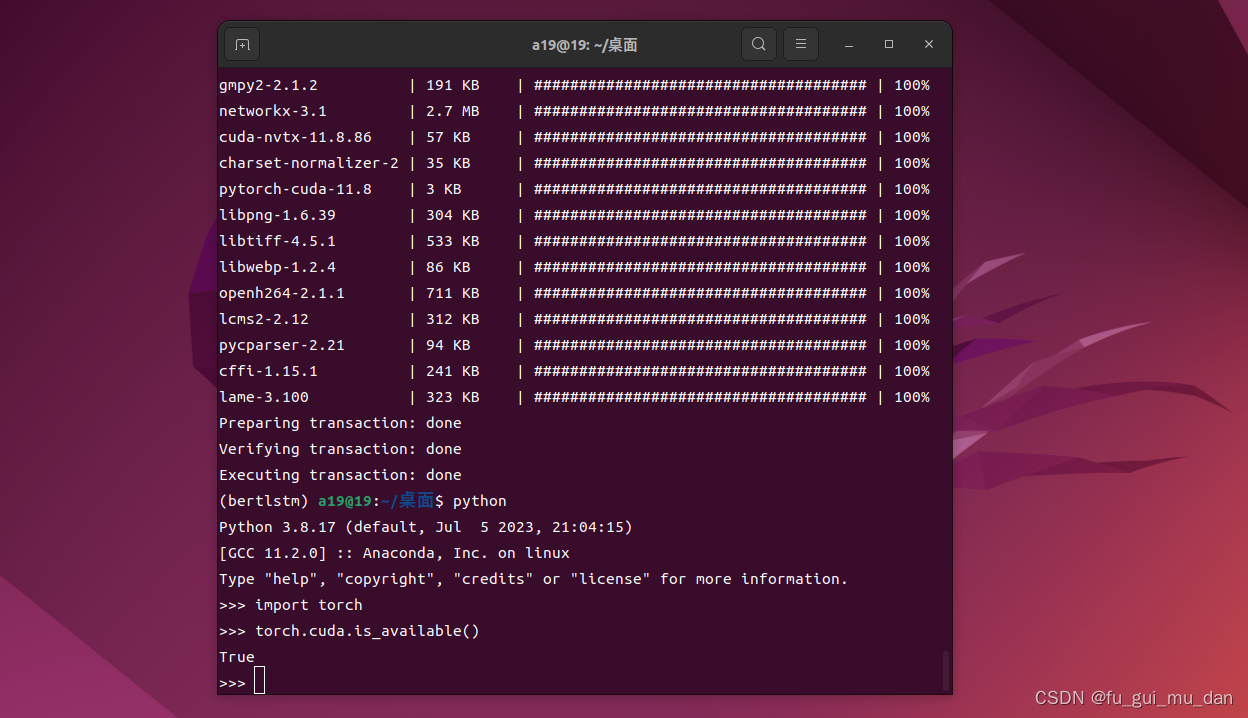

ubuntu 22.04安装cuda、cudnn、conda、pytorch

1、cuda 视频连接 https://www.bilibili.com/video/BV1bW4y197Mo/?spm_id_from333.999.0.0&vd_source3b42b36e44d271f58e90f86679d77db7cuda 11.8 https://developer.nvidia.com/cuda-toolkit-archive点击进入 https://developer.nvidia.com/cuda-11-8-0-download-arc…...

2023 最新前端面试题 (HTML 篇)

1. src 和 href 的区别 src 用于替换当前元素(引入),href 用于在当前文档和引用资源之间确立联系(引用) (1)src(source) 指向外部资源的位置,指向的内容将会嵌…...

华为云银河麒麟V10安装libmcrypt

本次安装是在华为云上执行。cpu是鲲鹏,操作系统是银河麒麟V10. 先下载安装包: wget http://downloads.sourceforge.net/mcrypt/libmcrypt-2.5.8.tar.gz 解包,进入目录中。 执行如下命令: ./configure make make install 执…...

Linux应用开发之网络套接字编程(实例篇)

服务端与客户端单连接 服务端代码 #include <sys/socket.h> #include <sys/types.h> #include <netinet/in.h> #include <stdio.h> #include <stdlib.h> #include <string.h> #include <arpa/inet.h> #include <pthread.h> …...

:OpenBCI_GUI:从环境搭建到数据可视化(下))

脑机新手指南(八):OpenBCI_GUI:从环境搭建到数据可视化(下)

一、数据处理与分析实战 (一)实时滤波与参数调整 基础滤波操作 60Hz 工频滤波:勾选界面右侧 “60Hz” 复选框,可有效抑制电网干扰(适用于北美地区,欧洲用户可调整为 50Hz)。 平滑处理&…...

)

React Native 导航系统实战(React Navigation)

导航系统实战(React Navigation) React Navigation 是 React Native 应用中最常用的导航库之一,它提供了多种导航模式,如堆栈导航(Stack Navigator)、标签导航(Tab Navigator)和抽屉…...

【力扣数据库知识手册笔记】索引

索引 索引的优缺点 优点1. 通过创建唯一性索引,可以保证数据库表中每一行数据的唯一性。2. 可以加快数据的检索速度(创建索引的主要原因)。3. 可以加速表和表之间的连接,实现数据的参考完整性。4. 可以在查询过程中,…...

Admin.Net中的消息通信SignalR解释

定义集线器接口 IOnlineUserHub public interface IOnlineUserHub {/// 在线用户列表Task OnlineUserList(OnlineUserList context);/// 强制下线Task ForceOffline(object context);/// 发布站内消息Task PublicNotice(SysNotice context);/// 接收消息Task ReceiveMessage(…...

剑指offer20_链表中环的入口节点

链表中环的入口节点 给定一个链表,若其中包含环,则输出环的入口节点。 若其中不包含环,则输出null。 数据范围 节点 val 值取值范围 [ 1 , 1000 ] [1,1000] [1,1000]。 节点 val 值各不相同。 链表长度 [ 0 , 500 ] [0,500] [0,500]。 …...

多种风格导航菜单 HTML 实现(附源码)

下面我将为您展示 6 种不同风格的导航菜单实现,每种都包含完整 HTML、CSS 和 JavaScript 代码。 1. 简约水平导航栏 <!DOCTYPE html> <html lang"zh-CN"> <head><meta charset"UTF-8"><meta name"viewport&qu…...

AI+无人机如何守护濒危物种?YOLOv8实现95%精准识别

【导读】 野生动物监测在理解和保护生态系统中发挥着至关重要的作用。然而,传统的野生动物观察方法往往耗时耗力、成本高昂且范围有限。无人机的出现为野生动物监测提供了有前景的替代方案,能够实现大范围覆盖并远程采集数据。尽管具备这些优势…...

C# 表达式和运算符(求值顺序)

求值顺序 表达式可以由许多嵌套的子表达式构成。子表达式的求值顺序可以使表达式的最终值发生 变化。 例如,已知表达式3*52,依照子表达式的求值顺序,有两种可能的结果,如图9-3所示。 如果乘法先执行,结果是17。如果5…...

「全栈技术解析」推客小程序系统开发:从架构设计到裂变增长的完整解决方案

在移动互联网营销竞争白热化的当下,推客小程序系统凭借其裂变传播、精准营销等特性,成为企业抢占市场的利器。本文将深度解析推客小程序系统开发的核心技术与实现路径,助力开发者打造具有市场竞争力的营销工具。 一、系统核心功能架构&…...