DataFrame窗口函数操作

文章最前: 我是Octopus,这个名字来源于我的中文名--章鱼;我热爱编程、热爱算法、热爱开源。所有源码在我的个人github ;这博客是记录我学习的点点滴滴,如果您对 Python、Java、AI、算法有兴趣,可以关注我的动态,一起学习,共同进步。

相关文章:

- PySpark 概述

- Spark连接快速入门

- Spark上使用pandas API快速入门

创建pyspark对象

import warnings

warnings.filterwarnings('ignore')

#import pandas as pd

#import numpy as np

from datetime import timedelta, date, datetime

import time

import gc

import os

import argparse

import sysfrom pyspark.sql import SparkSession, functions as fn

from pyspark.ml.feature import StringIndexer

from pyspark.ml.recommendation import ALS

from pyspark.sql.types import *

from pyspark import StorageLevel

spark = SparkSession \.builder \.appName("stockout_test") \.config("hive.exec.dynamic.partition.mode", "nonstrict") \.config("spark.sql.sources.partitionOverwriteMode", "dynamic")\.config("spark.driver.memory", '20g')\.config("spark.executor.memory", '40g')\.config("spark.yarn.executor.memoryOverhead", '1g')\.config("spark.executor.instances", 8)\.config("spark.executor.cores", 8)\.config("spark.kryoserializer.buffer.max", '128m')\.config("spark.yarn.queue", 'root.algo')\.config("spark.executorEnv.OMP_NUM_THREADS", 12)\.config("spark.executorEnv.ARROW_PRE_0_15_IPC_FORMAT", 1) \.config("spark.default.parallelism", 800)\.enableHiveSupport() \.getOrCreate()

spark.sql("set hive.exec.dynamic.partition.mode = nonstrict")

spark.sql("set hive.exec.dynamic.partition=true")

spark.sql("set spark.sql.autoBroadcastJoinThreshold=-1")创建DataFrame

employee_salary = [("zhangsan", "IT", 8000),("lisi", "IT", 7000),("wangwu", "IT", 7500),("zhaoliu", "ALGO", 10000),("qisan", "IT", 8000),("bajiu", "ALGO", 12000),("james", "ALGO", 11000),("wangzai", "INCREASE", 7000),("carter", "INCREASE", 8000),("kobe", "IT", 9000)]columns= ["name", "department", "salary"]

df = spark.createDataFrame(data = employee_salary, schema = columns)

df.show()+--------+----------+------+ | name|department|salary| +--------+----------+------+ |zhangsan| IT| 8000| | lisi| IT| 7000| | wangwu| IT| 7500| | zhaoliu| ALGO| 10000| | qisan| IT| 8000| | bajiu| ALGO| 12000| | james| ALGO| 11000| | wangzai| INCREASE| 7000| | carter| INCREASE| 8000| | kobe| IT| 9000| +--------+----------+------+

row_number()

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

df.withColumn("row_number", F.row_number().over(windowSpec)).show(truncate=False)+--------+----------+------+----------+ |name |department|salary|row_number| +--------+----------+------+----------+ |carter |INCREASE |8000 |1 | |wangzai |INCREASE |7000 |2 | |kobe |IT |9000 |1 | |zhangsan|IT |8000 |2 | |qisan |IT |8000 |3 | |wangwu |IT |7500 |4 | |lisi |IT |7000 |5 | |bajiu |ALGO |12000 |1 | |james |ALGO |11000 |2 | |zhaoliu |ALGO |10000 |3 | +--------+----------+------+----------+

Rank()

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

df.withColumn("rank",F.rank().over(windowSpec)).show(truncate=False)+--------+----------+------+----+ |name |department|salary|rank| +--------+----------+------+----+ |carter |INCREASE |8000 |1 | |wangzai |INCREASE |7000 |2 | |kobe |IT |9000 |1 | |qisan |IT |8000 |2 | |zhangsan|IT |8000 |2 | |wangwu |IT |7500 |4 | |lisi |IT |7000 |5 | |bajiu |ALGO |12000 |1 | |james |ALGO |11000 |2 | |zhaoliu |ALGO |10000 |3 | +--------+----------+------+----+

dense_rank()

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

df.withColumn("dense_rank",F.dense_rank().over(windowSpec)).show()+--------+----------+------+----------+ | name|department|salary|dense_rank| +--------+----------+------+----------+ | carter| INCREASE| 8000| 1| | wangzai| INCREASE| 7000| 2| | kobe| IT| 9000| 1| | qisan| IT| 8000| 2| |zhangsan| IT| 8000| 2| | wangwu| IT| 7500| 3| | lisi| IT| 7000| 4| | bajiu| ALGO| 12000| 1| | james| ALGO| 11000| 2| | zhaoliu| ALGO| 10000| 3| +--------+----------+------+----------+

lag()

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

df.withColumn("lag",F.lag("salary",1).over(windowSpec)).show()+--------+----------+------+-----+ | name|department|salary| lag| +--------+----------+------+-----+ | carter| INCREASE| 8000| null| | wangzai| INCREASE| 7000| 8000| | kobe| IT| 9000| null| |zhangsan| IT| 8000| 9000| | qisan| IT| 8000| 8000| | wangwu| IT| 7500| 8000| | lisi| IT| 7000| 7500| | bajiu| ALGO| 12000| null| | james| ALGO| 11000|12000| | zhaoliu| ALGO| 10000|11000| +--------+----------+------+-----+

lead()

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

df.withColumn("lead",F.lead("salary", 1).over(windowSpec)).show()+--------+----------+------+-----+ | name|department|salary| lead| +--------+----------+------+-----+ | carter| INCREASE| 8000| 7000| | wangzai| INCREASE| 7000| null| | kobe| IT| 9000| 8000| |zhangsan| IT| 8000| 8000| | qisan| IT| 8000| 7500| | wangwu| IT| 7500| 7000| | lisi| IT| 7000| null| | bajiu| ALGO| 12000|11000| | james| ALGO| 11000|10000| | zhaoliu| ALGO| 10000| null| +--------+----------+------+-----+

Aggregate Functions

from pyspark.sql.window import Window

import pyspark.sql.functions as FwindowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

windowSpecAgg = Window.partitionBy("department")df.withColumn("row", F.row_number().over(windowSpec)) \.withColumn("avg", F.avg("salary").over(windowSpecAgg)) \.withColumn("sum", F.sum("salary").over(windowSpecAgg)) \.withColumn("min", F.min("salary").over(windowSpecAgg)) \.withColumn("max", F.max("salary").over(windowSpecAgg)) \.withColumn("count", F.count("salary").over(windowSpecAgg)) \.withColumn("distinct_count", F.approx_count_distinct("salary").over(windowSpecAgg)) \.show()+--------+----------+------+---+-------+-----+-----+-----+-----+--------------+ | name|department|salary|row| avg| sum| min| max|count|distinct_count| +--------+----------+------+---+-------+-----+-----+-----+-----+--------------+ | carter| INCREASE| 8000| 1| 7500.0|15000| 7000| 8000| 2| 2| | wangzai| INCREASE| 7000| 2| 7500.0|15000| 7000| 8000| 2| 2| | kobe| IT| 9000| 1| 7900.0|39500| 7000| 9000| 5| 4| |zhangsan| IT| 8000| 2| 7900.0|39500| 7000| 9000| 5| 4| | qisan| IT| 8000| 3| 7900.0|39500| 7000| 9000| 5| 4| | wangwu| IT| 7500| 4| 7900.0|39500| 7000| 9000| 5| 4| | lisi| IT| 7000| 5| 7900.0|39500| 7000| 9000| 5| 4| | bajiu| ALGO| 12000| 1|11000.0|33000|10000|12000| 3| 3| | james| ALGO| 11000| 2|11000.0|33000|10000|12000| 3| 3| | zhaoliu| ALGO| 10000| 3|11000.0|33000|10000|12000| 3| 3| +--------+----------+------+---+-------+-----+-----+-----+-----+--------------+

from pyspark.sql.window import Window

import pyspark.sql.functions as F

# 需要注意的是 approx_count_distinct() 函数适用于窗函数的统计,

# 而在groupby中通常用countDistinct()来代替该函数,用来求组内不重复的数值的条数。

# approx_count_distinct()取的是近似的数值,不太准确,使用需注意 windowSpec = Window.partitionBy("department").orderBy(F.desc("salary"))

windowSpecAgg = Window.partitionBy("department")df.withColumn("row", F.row_number().over(windowSpec)) \.withColumn("avg", F.avg("salary").over(windowSpecAgg)) \.withColumn("sum", F.sum("salary").over(windowSpecAgg)) \.withColumn("min", F.min("salary").over(windowSpecAgg)) \.withColumn("max", F.max("salary").over(windowSpecAgg)) \.withColumn("count", F.count("salary").over(windowSpecAgg)) \.withColumn("distinct_count", F.approx_count_distinct("salary").over(windowSpecAgg)) \.where(F.col("row")==1).select("department","avg","sum","min","max","count","distinct_count") \.show()+----------+-------+-----+-----+-----+-----+--------------+ |department| avg| sum| min| max|count|distinct_count| +----------+-------+-----+-----+-----+-----+--------------+ | INCREASE| 7500.0|15000| 7000| 8000| 2| 2| | IT| 7900.0|39500| 7000| 9000| 5| 4| | ALGO|11000.0|33000|10000|12000| 3| 3| +----------+-------+-----+-----+-----+-----+--------------+

相关文章:

DataFrame窗口函数操作

文章最前: 我是Octopus,这个名字来源于我的中文名--章鱼;我热爱编程、热爱算法、热爱开源。所有源码在我的个人github ;这博客是记录我学习的点点滴滴,如果您对 Python、Java、AI、算法有兴趣,可以关注我的…...

【德哥说库系列】-RHEL8环境源码编译安装MySQL8.0

📢📢📢📣📣📣 哈喽!大家好,我是【IT邦德】,江湖人称jeames007,10余年DBA及大数据工作经验 一位上进心十足的【大数据领域博主】!😜&am…...

Sandboxie+Buster Sandbox Analyzer打造个人沙箱

一、运行环境和需要安装的软件 实验环境:win7_x32或win7_x64 用到的软件:WinPcap_4_1_3.exe、Sandboxie-3-70.exe、Buster Sandbox Analyzer 重点是Sandboxie必须是3.70版本。下载地址:https://github.com/sandboxie-plus/sandboxie-old/blo…...

源码解析flink的GenericWriteAheadSink为什么做不到精确一次输出

背景 GenericWriteAheadSink是可以用于几乎是精准一次输出的场景,为什么说是几乎精准一次呢?我们从源码的角度分析一下 GenericWriteAheadSink做不到精准一次输出的原因 首先我们看一下flink检查点完成后通知GenericWriteAheadSink开始进行分段的记录…...

)

C#经典十大排序算法(完结)

C#冒泡排序算法 简介 冒泡排序算法是一种基础的排序算法,它的实现原理比较简单。核心思想是通过相邻元素的比较和交换来将最大(或最小)的元素逐步"冒泡"到数列的末尾。 详细文章描述 https://mp.weixin.qq.com/s/z_LPZ6QUFNJcw…...

C/C++文件操作(细节满满,part2)

该文章上一篇:C/C文件操作(细节满满,part1)_仍有未知等待探索的博客-CSDN博客 个人主页:仍有未知等待探索_C语言疑难,数据结构,小项目-CSDN博客 专题分栏:C语言疑难_仍有未知等待探索的博客-CSDN博客 目录 …...

web前端面试-- 手写原生Javascript方法(new、Object.create)

web面试题 本人是一个web前端开发工程师,主要是vue框架,整理了一些面试题,今后也会一直更新,有好题目的同学欢迎评论区分享 ;-) web面试题专栏:点击此处 手动实现Object.create 通过Object.create&#…...

C++前缀和算法的应用:得到连续 K 个 1 的最少相邻交换次数 原理源码测试用例

本文涉及的基础知识点 C算法:前缀和、前缀乘积、前缀异或的原理、源码及测试用例 包括课程视频 滑动窗口 题目 给你一个整数数组 nums 和一个整数 k 。 nums 仅包含 0 和 1 。每一次移动,你可以选择 相邻 两个数字并将它们交换。 请你返回使 nums 中包…...

目标检测YOLO实战应用案例100讲-基于YOLOv5的航拍图像旋转目标检测

目录 前言 国内外研究历史与现状 目标检测技术的研究历史与现状...

H5前端开发——BOM

H5前端开发——BOM BOM(Browser Object Model)是指浏览器对象模型,它提供了一组对象和方法,用于与浏览器窗口进行交互。 通过 BOM 对象,开发人员可以操作浏览器窗口的行为和状态,实现与用户的交互和数据传…...

stable diffusion如何解决gradio外链无法开启的问题

问题确认 为了确认gradio开启不了是gradio库的问题还是stable diffusion的问题,可以先执行这样一段demo代码 import gradio as grdef greet(name):return "Hello " name "!"demo gr.Interface(fngreet, inputs"text", outputs&q…...

SpringMvc-面试用

一、SpringMvc常用注解 1、修饰在类的 RestController RequestMapping("/test")RestController是什么?其实是一个复合注解 Controller //其实就是Component ResponseBody //独立的注解 public interface RestController {}RequestMapping 也可以认…...

并发编程 # 3

文章目录 一、进程和线程的比较二、GIL全局解释器锁1.引入2.Python解释器的种类结论:在CPython解释其中,同一个进程下开启的多线程,同一时刻只能有一个线程执行,无法利用多核优势。得出结论:GIL锁就是保证在同一时刻只…...

ESP32C3 LuatOS TM1650①驱动测试

合宙TM1650驱动资料 TM1650.lua源码 引脚连接 TM1650ESP32C3SCLGPIO5SDAGPIO4 下载TM1650.lua源码,并以文件形式保存在项目文件夹中 驱动测试源码 --注意:因使用了sys.wait()所有api需要在协程中使用 -- 用法实例 PROJECT "ESP32C3_TM1650" VERSION …...

TCP为什么需要三次握手和四次挥手?

一、三次握手 三次握手(Three-way Handshake)其实就是指建立一个TCP连接时,需要客户端和服务器总共发送3个包 主要作用就是为了确认双方的接收能力和发送能力是否正常、指定自己的初始化序列号为后面的可靠性传送做准备 过程如下ÿ…...

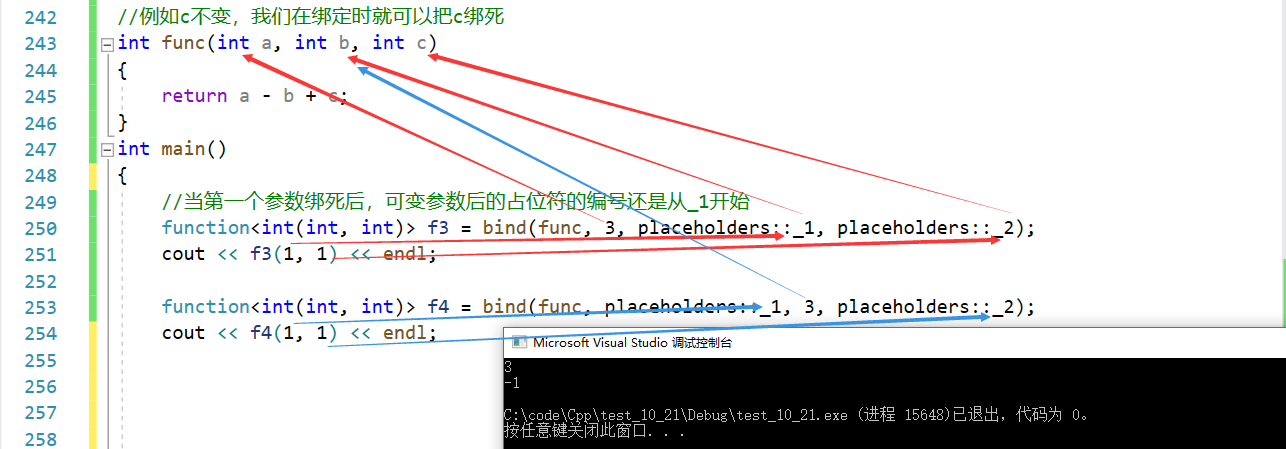

【C++】一些C++11特性

C特性 1. 列表初始化1.1 {}初始化1.2 initializer_list 2. 声明2.1 auto2.2 typeid2.3 decltype2.4 nullptr 3. STL3.1 新容器3.2 新接口 4. 右值引用5. 移动构造与移动赋值6. lambda表达式7. 可变参数模板8. 包装器9. bind 1. 列表初始化 1.1 {}初始化 C11支持所有内置类型和…...

leetcode 647. 回文子串、516. 最长回文子序列

647. 回文子串 给你一个字符串 s ,请你统计并返回这个字符串中 回文子串 的数目。 回文字符串 是正着读和倒过来读一样的字符串。 子字符串 是字符串中的由连续字符组成的一个序列。 具有不同开始位置或结束位置的子串,即使是由相同的字符组成&#…...

Vue Router 刷新当前页面

Vue项目, 在实际工作中, 有些时候需要在 加载完某些数据之后对当前页面进行刷新, 以期 onMounted 等生命周期函数, 或者 数据重新加载. 总之是期望页面可以重新加载一次. 目前总结有三种途径可实现以上需求: 一, reload 直接刷新页面 window.location.reload(); $router.go(…...

lstm 回归实战、 分类demo

预备知识 lstm 参数 输入、输出格式 nn.LSTM(input_dim,hidden_dim,num_layers); imput_dim 特征数 input:(样本数、seq, features_num) h0,c0 (num_layers,seq, hidden_num) output: (样本数、seq, hidden_dim) 再加一个全连接层,将 outpu…...

实践DDD模拟电商系统总结

目录 一、事件风暴 二、系统用例 三、领域上下文 四、架构设计 (一)六边形架构 (二)系统分层 五、系统实现 (一)项目结构 (二)提交订单功能实现 (三࿰…...

应用升级/灾备测试时使用guarantee 闪回点迅速回退

1.场景 应用要升级,当升级失败时,数据库回退到升级前. 要测试系统,测试完成后,数据库要回退到测试前。 相对于RMAN恢复需要很长时间, 数据库闪回只需要几分钟。 2.技术实现 数据库设置 2个db_recovery参数 创建guarantee闪回点,不需要开启数据库闪回。…...

【Go】3、Go语言进阶与依赖管理

前言 本系列文章参考自稀土掘金上的 【字节内部课】公开课,做自我学习总结整理。 Go语言并发编程 Go语言原生支持并发编程,它的核心机制是 Goroutine 协程、Channel 通道,并基于CSP(Communicating Sequential Processes࿰…...

华为云Flexus+DeepSeek征文|DeepSeek-V3/R1 商用服务开通全流程与本地部署搭建

华为云FlexusDeepSeek征文|DeepSeek-V3/R1 商用服务开通全流程与本地部署搭建 前言 如今大模型其性能出色,华为云 ModelArts Studio_MaaS大模型即服务平台华为云内置了大模型,能助力我们轻松驾驭 DeepSeek-V3/R1,本文中将分享如何…...

OPenCV CUDA模块图像处理-----对图像执行 均值漂移滤波(Mean Shift Filtering)函数meanShiftFiltering()

操作系统:ubuntu22.04 OpenCV版本:OpenCV4.9 IDE:Visual Studio Code 编程语言:C11 算法描述 在 GPU 上对图像执行 均值漂移滤波(Mean Shift Filtering),用于图像分割或平滑处理。 该函数将输入图像中的…...

Java多线程实现之Thread类深度解析

Java多线程实现之Thread类深度解析 一、多线程基础概念1.1 什么是线程1.2 多线程的优势1.3 Java多线程模型 二、Thread类的基本结构与构造函数2.1 Thread类的继承关系2.2 构造函数 三、创建和启动线程3.1 继承Thread类创建线程3.2 实现Runnable接口创建线程 四、Thread类的核心…...

SAP学习笔记 - 开发26 - 前端Fiori开发 OData V2 和 V4 的差异 (Deepseek整理)

上一章用到了V2 的概念,其实 Fiori当中还有 V4,咱们这一章来总结一下 V2 和 V4。 SAP学习笔记 - 开发25 - 前端Fiori开发 Remote OData Service(使用远端Odata服务),代理中间件(ui5-middleware-simpleproxy)-CSDN博客…...

LangChain知识库管理后端接口:数据库操作详解—— 构建本地知识库系统的基础《二》

这段 Python 代码是一个完整的 知识库数据库操作模块,用于对本地知识库系统中的知识库进行增删改查(CRUD)操作。它基于 SQLAlchemy ORM 框架 和一个自定义的装饰器 with_session 实现数据库会话管理。 📘 一、整体功能概述 该模块…...

push [特殊字符] present

push 🆚 present 前言present和dismiss特点代码演示 push和pop特点代码演示 前言 在 iOS 开发中,push 和 present 是两种不同的视图控制器切换方式,它们有着显著的区别。 present和dismiss 特点 在当前控制器上方新建视图层级需要手动调用…...

tomcat指定使用的jdk版本

说明 有时候需要对tomcat配置指定的jdk版本号,此时,我们可以通过以下方式进行配置 设置方式 找到tomcat的bin目录中的setclasspath.bat。如果是linux系统则是setclasspath.sh set JAVA_HOMEC:\Program Files\Java\jdk8 set JRE_HOMEC:\Program Files…...

Ubuntu系统多网卡多相机IP设置方法

目录 1、硬件情况 2、如何设置网卡和相机IP 2.1 万兆网卡连接交换机,交换机再连相机 2.1.1 网卡设置 2.1.2 相机设置 2.3 万兆网卡直连相机 1、硬件情况 2个网卡n个相机 电脑系统信息,系统版本:Ubuntu22.04.5 LTS;内核版本…...