4 OpenCV实现多目三维重建(多张图片增量式生成稀疏点云)【附源码】

本文是基于 OpenCV4.80 进行的,关于环境的配置可能之后会单独说,先提一嘴 vcpkg 真好用

1 大致流程

从多张图片逐步生成稀疏点云,这个过程通常包括以下步骤:

-

初始重建:

初始两张图片的选择十分重要,这是整个流程的基础,后续的增图都是在这两张图片的基础上进行的

- 对于输入图像,首先需要提取特征点(例如,SIFT、SURF或ORB特征点)。然后,通过匹配不同图像中的特征点,建立它们之间的对应关系

- 通过两张图像之间的本质矩阵

E估计相机的外参矩阵(旋转矩阵R和平移向量T),然后使用三角测量法计算出一些初始的三维点

具体操作可以查看我前面的博客

-

增量式重建:

从这开始,逐步增加图像,逐渐扩展三维点云

- 添加新的图像:将新的图像加载到重建流程中

- 特征提取和匹配:对新的图像提取特征点并与先前图像匹配以获得新的匹配关系

- 位姿估计:估计新图像相对于先前图像的相机位姿,通常使用

PnP(Perspective-n-Point)—— 在已知相机内参数K的前提下,用该角度下的三维点(object_points)与它们对应的图像点(image_points)坐标,估算出此时拍摄位置的信息 - 三维点三角测量:使用新的匹配对和估计的位姿(

R,T)来三角测量,生成新的三维点。 - 点云合并:将新生成的三维点与先前的点云进行合并,构建一个更大的稀疏点云

-

全局点云优化:在稀疏点云已经生成后,可以使用全局点云优化技术,例如Bundle Adjustment,来提高点云的准确性

2 准备代码

之前文章中,我们讲所有代码都挤到了main函数中,十分不美观,现在我们进行一下代码的优化

由于才学C++,比较菜请见谅

2.1 Include.h

这里包含了所有用到的头文件和宏,方便之后使用

由于之后要用 Bundle Adjustment,所以引入了 ceres,具体环境配置之后可能会说(真的比较麻烦,强烈推荐 vcpkg ),其中大量的 #define 和 #pragma warning(disable: 4996) 都是关于 ceres 的报错的

#ifndef INCLUDES_H

#define INCLUDES_H#define GLOG_NO_ABBREVIATED_SEVERITIES

#define _CRT_NONSTDC_NO_DEPRECATE

#define NOMINMAX

#define _CRT_NONSTDC_NO_WARNINGS

#pragma warning(disable: 4996)#include <opencv2/opencv.hpp>

#include <iostream>

#include <vector>

#include <fstream>

#include <ceres/ceres.h>

#include <ceres/rotation.h>using namespace cv;

using namespace std;

#endif // !INCLUDES_H#pragma once

2.2 Constructor

Constructor 类,其中包含了三维重建的几个关键步骤的函数:

findCamera:初始构建使用的求取 E 矩阵和R,T(其中包括了RANSAC)maskoutPoints:通过内点标记mask,来对点进行筛选pointsReconstruct:通过 R,T 匹配点来进行三角化生成三维点云

Constructor.h:

#ifndef CONSTRUCTOR_H

#define CONSTRUCTOR_H#include "Includes.h"

#include "Images.h"class Constructor

{

public:// 输入K,图1的匹配点,图2的匹配点;输出R,T;点经过筛选static void findCamera(Mat K, vector<Point2f>& point1, vector<Point2f>& point2, Mat& output_R, Mat& output_T, vector<uchar>& mask);// 输入图匹配点,内点标记mask;返回mask后的vector<Point2f>匹配点static void maskoutPoints(vector<Point2f>& input_points, vector<uchar>& input_mask);// 输入图一的R,T,匹配点,图二的R,T,匹配点;返回vector<Point3f>三维点static vector<Point3d>& pointsReconstruct(const Mat& K, Mat& R1, Mat& T1, Mat& R2, Mat& T2, vector<Point2f>& points1, vector<Point2f>& points2);

};#endif // !CONSTRUCTOR_H#pragma once

Constructor.cpp:

#include "Constructor.h"void Constructor::findCamera(Mat K, vector<Point2f>& point1, vector<Point2f>& point2, Mat& output_R, Mat& output_T, vector<uchar>& mask)

{vector<uchar> inliers;Mat F;F = findFundamentalMat(point1, point2, inliers, FM_RANSAC, 1, 0.5);Mat E = K.t() * F * K;//Mat E = findEssentialMat(point1, point2, K, RANSAC, 0.6, 1.0, inliners);mask = inliers;// 根据内点筛选出新的匹配点Constructor::maskoutPoints(point1, inliers);Constructor::maskoutPoints(point2, inliers);// 分解E矩阵,获取R,T矩阵int pass_count = recoverPose(E, point1, point2, K, output_R, output_T);

}void Constructor::maskoutPoints(vector<Point2f>& input_points, vector<uchar>& input_mask)

{vector<Point2f> temp_points(input_points);input_points.clear();for (int i = 0; i < temp_points.size(); ++i){if (input_mask[i]){input_points.push_back(temp_points[i]);}}

}vector<Point3d>& Constructor::pointsReconstruct(const Mat& K, Mat& R1, Mat& T1, Mat& R2, Mat& T2, vector<Point2f>& points1, vector<Point2f>& points2)

{// 构造投影矩阵Mat proj1(3, 4, CV_32FC1);Mat proj2(3, 4, CV_32FC1);// 将旋转矩阵和平移向量合并为投影矩阵R1.convertTo(proj1(Range(0, 3), Range(0, 3)), CV_32FC1);T1.convertTo(proj1.col(3), CV_32FC1);R2.convertTo(proj2(Range(0, 3), Range(0, 3)), CV_32FC1);T2.convertTo(proj2.col(3), CV_32FC1);// 将内参矩阵与投影矩阵相乘,得到最终的投影矩阵Mat fK;K.convertTo(fK, CV_32FC1);proj1 = fK * proj1;proj2 = fK * proj2;// 三角化,得到齐次坐标Mat point4D_homogeneous(4, points1.size(), CV_64F);triangulatePoints(proj1, proj2, points1, points2, point4D_homogeneous);// 将齐次坐标转换为三维坐标vector<Point3d> point3D;point3D.clear();point3D.reserve(point4D_homogeneous.cols);for (int i = 0; i < point4D_homogeneous.cols; ++i){Mat<float> col = point4D_homogeneous.col(i);col /= col(3);point3D.push_back(Point3d(col(0), col(1), col(2)));}// 将三维坐标存储在Point3d向量中并返回return point3D;

}

2.3 Image

为了增图,我们需要存储图像中每个特征点在空间中的对应点—— correspond_struct_idx

Image 类,其中有成员变量:

Mat image—— 存储图像vector<KeyPoint> keyPoints—— 存储特征点Mat descriptor—— 存储特征描述符vector<int> correspond_struct_idx—— 匹配点所对应的空间点在点云中的索引vector<Point2f> matchedPoints—— 存储匹配点vector<Vec3b> colors—— 存储匹配点的颜色信息Mat R, T—— 存储相机的旋转矩阵和平移向量

同时还有几个关于图像处理的重要函数:

Images:构造函数,读取图像时就进行了特征点的提取matchFeatures:匹配特征点findColor:提取颜色信息getObjPointsAndImgPoints:找出当前匹配中已经在点云中的点,获取 object_points,以及 image_points —— 为 PnP 做准备

Image.h:

#ifndef IMAGES_H

#define IMAGES_H#include "Includes.h"class Images

{

public:Mat image; // 存储图像vector<KeyPoint> keyPoints; // 存储特征点Mat descriptor; // 存储特征描述符vector<int> correspond_struct_idx; // 匹配点所对应的空间点在点云中的索引vector<Point2f> matchedPoints; // 存储匹配点vector<Vec3b> colors; // 存储匹配点的颜色信息Mat R, T; // 存储相机的旋转矩阵和平移向量vector<Point3f> object_points; // 前一张图中匹配点对应的三维点vector<Point2f> image_points; // 在现图像中对应的像素点// 构造函数,从指定路径读取图像,并提取SIFT特征点和描述符Images(string const image_paths);// 特征匹配函数,将当前图像与另一个图像进行特征匹配void matchFeatures(Images& otherImage, vector<DMatch>& outputMatches);// 从匹配点中提取颜色信息void findColor();// 遍历当前匹配,找出当前匹配中已经在点云中的点,获取object_points,以及image_pointsvoid getObjPointsAndImgPoints(vector<DMatch>& matches, vector<Point3d>& all_reconstructed_points, Images& preImage);

};#endif // !IMAGES_H

#pragma once

Image.cpp:

#include "Images.h"Images::Images(string const image_path)

{// 读取图像this->image = imread(image_path);if (this->image.empty()) {cout << "Could not read image: " << image_path << endl;}// 提取SIFT特征点和描述符Ptr<SIFT> sift = SIFT::create(0, 17, 0.0000000001, 16);sift->detectAndCompute(this->image, noArray(), this->keyPoints, this->descriptor);for (int i = 0; i < keyPoints.size(); i++){correspond_struct_idx.push_back(-1);}

}void Images::findColor()

{// 遍历所有匹配点for (Point2f& Points : this->matchedPoints){ // 获取像素点的颜色Vec3b color = this->image.at<Vec3b>(Points.y, Points.x);// 将颜色存储在颜色向量中this->colors.push_back(color);}

}void Images::matchFeatures(Images& otherImage, vector<DMatch>& outputMatches)

{// 清空匹配点otherImage.matchedPoints.clear();this->matchedPoints.clear();vector<vector<DMatch>> matches;FlannBasedMatcher matcher;// 使用FlannBasedMatcher进行特征匹配matcher.knnMatch(this->descriptor, otherImage.descriptor, matches, 2);// 计算最小距离float min_dist = FLT_MAX;for (int r = 0; r < matches.size(); ++r){// 如果最近邻距离大于次近邻距离的2.5倍,则跳过该匹配点if (matches[r][0].distance < 2.5 * matches[r][1].distance){// 计算最小距离float dist = matches[r][0].distance;if (dist < min_dist){min_dist = dist;}}}// 筛选出好的匹配点for (int i = 0; i < matches.size(); i++){if (matches[i][0].distance < 0.76 * matches[i][1].distance && matches[i][0].distance < 8 * max(min_dist, 10.0f)){outputMatches.push_back(matches[i][0]);}}// 将匹配点存储在matchedPoints向量中for (int i = 0; i < outputMatches.size(); ++i){this->matchedPoints.push_back(this->keyPoints[outputMatches[i].queryIdx].pt);otherImage.matchedPoints.push_back(otherImage.keyPoints[outputMatches[i].trainIdx].pt);}

}// 从匹配点中获取三维空间点和图像点

void Images::getObjPointsAndImgPoints(vector<DMatch>& matches, vector<Point3d>& all_reconstructed_points, Images& preImage)

{// 清空object_points和image_pointsthis->object_points.clear();this->image_points.clear();// 遍历所有匹配点for (int i = 0; i < matches.size(); i++){// 获取匹配点在前一张图像中对应的三维空间点的索引int matched_world_point_indices = preImage.correspond_struct_idx[matches[i].queryIdx];// 如果匹配点在前一张图像中对应的三维空间点存在if (matched_world_point_indices > 0){// 将其(前一张图像中的三维点)添加到object_points中this->object_points.push_back(all_reconstructed_points[matched_world_point_indices]);// 将匹配点(该新图像的二维点)添加到image_points中this->image_points.push_back(this->keyPoints[matches[i].trainIdx].pt);}}

}3 具体实现

在先前的两张图片的初始三维点云的构建的基础上,我们来实现多张图的增量构建

3.1 初始构建

在前面几篇博客中已经详细讲述过了:匹配,用计算 E 矩阵的方式求得相机外参 R,T,进行三角化构建点云

特别:为了后面的增图重建,我们需要记录初始两张图各个点和点云的关系

void initConstruction(vector<Images>& initImages, vector<Point3d>& all_reconstructed_points, vector<Vec3b>& all_points_colors)

{initImages.push_back(*(new Images(INIT_IMG_PATH1)));initImages.push_back(*(new Images(INIT_IMG_PATH2)));vector<DMatch> matches;initImages[0].matchFeatures(initImages[1], matches);vector<uchar> mask;Constructor::findCamera(K, initImages[0].matchedPoints, initImages[1].matchedPoints, initImages[1].R, initImages[1].T, mask);initImages[0].R = Mat::eye(3, 3, CV_64FC1);initImages[0].T = Mat::zeros(3, 1, CV_64FC1);all_reconstructed_points = Constructor::pointsReconstruct(K, initImages[0].R, initImages[0].T, initImages[1].R, initImages[1].T, initImages[0].matchedPoints, initImages[1].matchedPoints);initImages[1].findColor();for (int i = 0; i < initImages[1].colors.size(); i++){all_points_colors.push_back(initImages[1].colors[i]);}// 根据mask来记录初始两张图各个点和点云的关系int idx = 0;for (int i = 0; i < matches.size(); i++){if (mask[i]){initImages[0].correspond_struct_idx[matches[i].queryIdx] = idx;initImages[1].correspond_struct_idx[matches[i].trainIdx] = idx;idx++;}}

}

3.2 增量构建

-

创建

subImageBag,然后将initImages[1]添加到容器中,即表示initImages中的第二张图像(数组索引为1)将与后续进行比较(否则下一张图添加进来跟谁进行匹配呢) -

循环,遍历

sub_image_paths容器中的图像文件路径 -

在循环中,为每个图像文件路径创建一个新的

Images,并将其添加到subImageBag容器中。这样,容器subImageBag中就包含了多张图像,其中第一张图像是初始图像对的第二张,其余图像是逐步添加的 -

调用

addImageConstruction函数,将subImageBag作为参数传递,以及用于存储稀疏点云的all_reconstructed_points和点云颜色的all_points_colors-

循环遍历

subImageBag容器中的每个图像,从索引1开始(因为第一个图像是初始图像用于了初始构建,跳过) -

对于每对相邻的图像,执行以下操作:

-

使用

matchFeatures方法,找到两个相邻图像之间的特征点匹配关系,并将匹配结果存储在matches容器中 -

使用

getObjPointsAndImgPoints方法,获取匹配的特征点对应的三维点和图像点 —— 为 PnP 做准备 -

通过RANSAC筛选,使用

findCamera方法筛选匹配点并生成一个mask,用于标记有效的匹配点(只是为了筛选罢了) -

使用

solvePnPRansac方法,估计新图像的相机位姿,获得R,T -

转换旋转向量为旋转矩阵(

solvePnPRansac得到的是 r 向量) -

使用

pointsReconstruct方法,重建新图像与前图像之间的三维点,并将结果存储在new_restructure_points中 -

使用

findColor方法,获取新图像中点的颜色信息 -

记录初始两张图各个点和点云的关系:

遍历

matches,根据mask中的标记,将新生成的点与初始两张图像的各个点和点云的关系进行记录,维护点与点云之间的对应关系 -

最后,将新生成的三维点

new_restructure_points以及它们的颜色信息添加到all_reconstructed_points和all_points_colors中,不断扩展点云

-

-

void addImageConstruction(vector<Images>& subImageBag, vector<Point3d>& all_reconstructed_points, vector<Vec3b>& all_points_colors)

{for (int i = 1; i < subImageBag.size(); i++){cout << i << endl;vector<DMatch> matches;subImageBag[i - 1].matchFeatures(subImageBag[i], matches);subImageBag[i].getObjPointsAndImgPoints(matches, all_reconstructed_points, subImageBag[i - 1]);// 只是为了进行RANSAC筛选匹配点和获取maskvector<uchar> mask;Mat discardR, discardT;Constructor::findCamera(K, subImageBag[i - 1].matchedPoints, subImageBag[i].matchedPoints, discardR, discardT, mask);solvePnPRansac(subImageBag[i].object_points, subImageBag[i].image_points, K, noArray(), subImageBag[i].R, subImageBag[i].T);Rodrigues(subImageBag[i].R, subImageBag[i].R);vector<Point3d> new_restructure_points;new_restructure_points = Constructor::pointsReconstruct(K, subImageBag[i - 1].R, subImageBag[i - 1].T, subImageBag[i].R, subImageBag[i].T, subImageBag[i - 1].matchedPoints, subImageBag[i].matchedPoints);subImageBag[i].findColor();// 记录初始两张图各个点和点云的关系int idx = 0;for (int k = 0; k < matches.size(); k++){if (mask[k]){subImageBag[i - 1].correspond_struct_idx[matches[k].queryIdx] = all_reconstructed_points.size() + idx;subImageBag[i].correspond_struct_idx[matches[k].trainIdx] = all_reconstructed_points.size() + idx;idx++;}}for (int k = 0; k < new_restructure_points.size(); k++){all_reconstructed_points.push_back(new_restructure_points[k]);all_points_colors.push_back(subImageBag[i].colors[k]);}}

}

3.3 完整main.cpp

// 定义图像文件路径和保存结果的路径

//#define INIT_IMG_PATH1 "test_img\\images\\100_7103.jpg"

//#define INIT_IMG_PATH2 "test_img\\images\\100_7104.jpg"

#define INIT_IMG_PATH1 "test_img\\First stage\\B25.jpg"

#define INIT_IMG_PATH2 "test_img\\First stage\\B24.jpg"

#define PLY_SAVE_PATH "test_img\\results\\output.ply"#include "Includes.h"

#include "Images.h"

#include "Constructor.h"//const Mat K = (Mat_<double>(3, 3) << 2905.88, 0, 1416, 0, 2905.88, 1064, 0, 0, 1);

const Mat K = (Mat_<double>(3, 3) << 719.5459, 0, 0, 0, 719.5459, 0, 0, 0, 1);//const vector<string> sub_image_paths = { /*"test_img\\images\\100_7100.jpg", "test_img\\images\\100_7101.jpg", "test_img\\images\\100_7102.jpg",*/ /*"test_img\\images\\100_7103.jpg", "test_img\\images\\100_7104.jpg",*/ "test_img\\images\\100_7105.jpg", "test_img\\images\\100_7106.jpg", "test_img\\images\\100_7107.jpg", "test_img\\images\\100_7108.jpg", "test_img\\images\\100_7109.jpg"/*, "test_img\\images\\100_7110.jpg"*/ };const vector<string> sub_image_paths = { "test_img\\First stage\\B23.jpg", "test_img\\First stage\\B22.jpg", "test_img\\First stage\\B21.jpg" };

void initConstruction(vector<Images>& initImages, vector<Point3d>& all_reconstructed_points, vector<Vec3b>& all_points_colors)

{initImages.push_back(*(new Images(INIT_IMG_PATH1)));initImages.push_back(*(new Images(INIT_IMG_PATH2)));vector<DMatch> matches;initImages[0].matchFeatures(initImages[1], matches);vector<uchar> mask;Constructor::findCamera(K, initImages[0].matchedPoints, initImages[1].matchedPoints, initImages[1].R, initImages[1].T, mask);initImages[0].R = Mat::eye(3, 3, CV_64FC1);initImages[0].T = Mat::zeros(3, 1, CV_64FC1);all_reconstructed_points = Constructor::pointsReconstruct(K, initImages[0].R, initImages[0].T, initImages[1].R, initImages[1].T, initImages[0].matchedPoints, initImages[1].matchedPoints);initImages[1].findColor();for (int i = 0; i < initImages[1].colors.size(); i++){all_points_colors.push_back(initImages[1].colors[i]);}// 根据mask来记录初始两张图各个点和点云的关系int idx = 0;for (int i = 0; i < matches.size(); i++){if (mask[i]){initImages[0].correspond_struct_idx[matches[i].queryIdx] = idx;initImages[1].correspond_struct_idx[matches[i].trainIdx] = idx;idx++;}}

}void addImageConstruction(vector<Images>& subImageBag, vector<Point3d>& all_reconstructed_points, vector<Vec3b>& all_points_colors)

{for (int i = 1; i < subImageBag.size(); i++){cout << i << endl;vector<DMatch> matches;subImageBag[i - 1].matchFeatures(subImageBag[i], matches);subImageBag[i].getObjPointsAndImgPoints(matches, all_reconstructed_points, subImageBag[i - 1]);// 只是为了进行RANSAC筛选匹配点和获取maskvector<uchar> mask;Mat discardR, discardT;Constructor::findCamera(K, subImageBag[i - 1].matchedPoints, subImageBag[i].matchedPoints, discardR, discardT, mask);solvePnPRansac(subImageBag[i].object_points, subImageBag[i].image_points, K, noArray(), subImageBag[i].R, subImageBag[i].T);Rodrigues(subImageBag[i].R, subImageBag[i].R);vector<Point3d> new_restructure_points;new_restructure_points = Constructor::pointsReconstruct(K, subImageBag[i - 1].R, subImageBag[i - 1].T, subImageBag[i].R, subImageBag[i].T, subImageBag[i - 1].matchedPoints, subImageBag[i].matchedPoints);subImageBag[i].findColor();// 记录初始两张图各个点和点云的关系int idx = 0;for (int k = 0; k < matches.size(); k++){if (mask[k]){subImageBag[i - 1].correspond_struct_idx[matches[k].queryIdx] = all_reconstructed_points.size() + idx;subImageBag[i].correspond_struct_idx[matches[k].trainIdx] = all_reconstructed_points.size() + idx;idx++;}}for (int k = 0; k < new_restructure_points.size(); k++){all_reconstructed_points.push_back(new_restructure_points[k]);all_points_colors.push_back(subImageBag[i].colors[k]);}}}int main()

{try{vector<Images> initImages;vector<Point3d> all_reconstructed_points;vector<Vec3b> all_points_colors;initConstruction(initImages, all_reconstructed_points, all_points_colors);vector<Images> subImageBag;subImageBag.push_back(initImages[1]);for (auto& image_path : sub_image_paths){subImageBag.push_back(Images(image_path));}addImageConstruction(subImageBag, all_reconstructed_points, all_points_colors); // 手动输出点云ply文件std::ofstream plyFile(PLY_SAVE_PATH);// ply的头部信息plyFile << "ply\n";plyFile << "format ascii 1.0\n";plyFile << "element vertex " << all_reconstructed_points.size() << "\n";plyFile << "property float x\n";plyFile << "property float y\n";plyFile << "property float z\n";plyFile << "property uchar blue\n";plyFile << "property uchar green\n";plyFile << "property uchar red\n";plyFile << "end_header\n";// 写入点云数据for (int i = 0; i < all_reconstructed_points.size(); ++i){cv::Vec3b color = all_points_colors[i];cv::Point3f point = all_reconstructed_points[i];plyFile << point.x << " " << point.y << " " << point.z << " "<< static_cast<int>(color[0]) << " "<< static_cast<int>(color[1]) << " "<< static_cast<int>(color[2]) << std::endl;}plyFile.close();return 0;}catch (Exception e){cout << e.msg << endl;}}

4 总结注意

源码 即上面给出的 Include.h,Constructor.h,Constructor.cpp,Image.h,Image.cpp,main.cpp

增量加图前(两张初始图的构建):

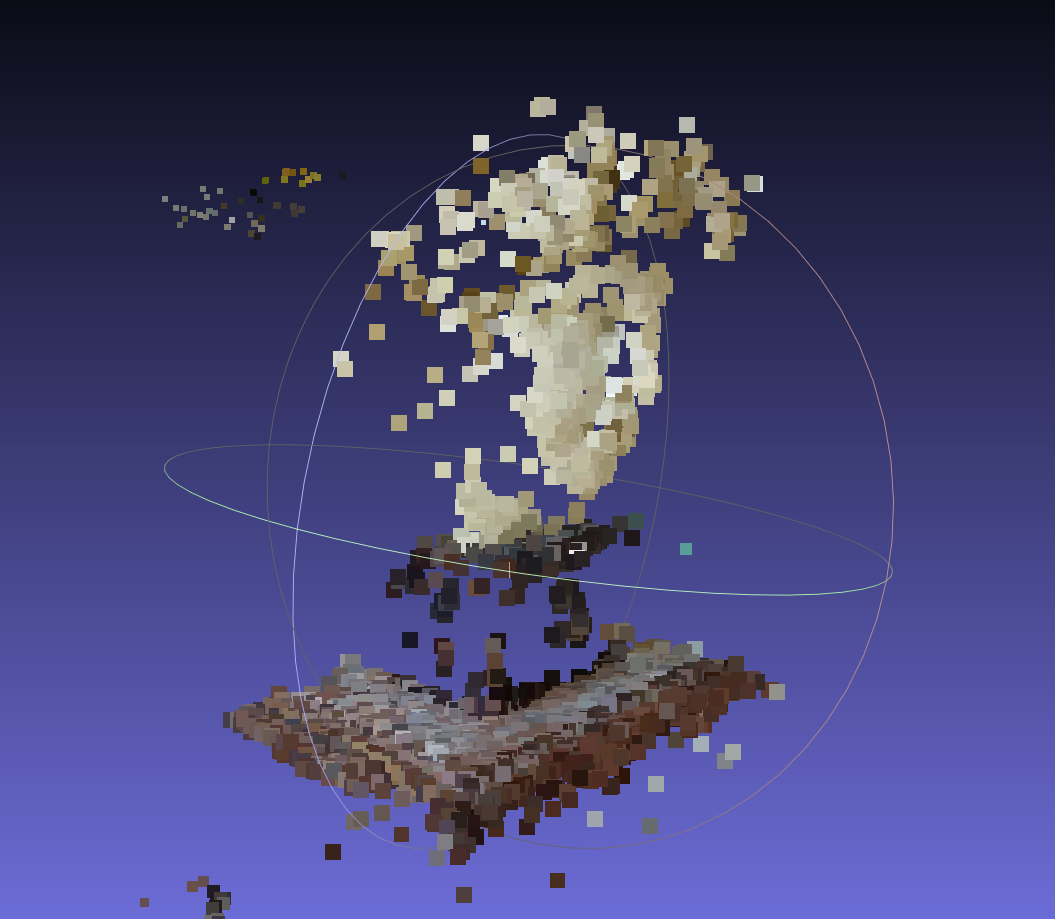

增量加图构造后:

注意:

目前只是完成了基本流程,有很多地方都需要优化,比如

- SIFT 的参数设置

- RANSAC 的参数设置

- 初始图片的选择(很重要)

matchFeatures中的 ratio test 的设置- 还可以增加其他优化措施来剔除离谱点

- 最重要的 BA 还没有加入!

- ·······

目前,出来的效果不好,革命尚未成功,同志还需努力!😭😭😭

参考资料:

基于OpenCV和C++的多视图三维重建

OpenCV实现SfM(三):多目三维重建

相关文章:

4 OpenCV实现多目三维重建(多张图片增量式生成稀疏点云)【附源码】

本文是基于 OpenCV4.80 进行的,关于环境的配置可能之后会单独说,先提一嘴 vcpkg 真好用 1 大致流程 从多张图片逐步生成稀疏点云,这个过程通常包括以下步骤: 初始重建: 初始两张图片的选择十分重要,这是整…...

【Java基础面试三十九】、 finally是无条件执行的吗?

文章底部有个人公众号:热爱技术的小郑。主要分享开发知识、学习资料、毕业设计指导等。有兴趣的可以关注一下。为何分享? 踩过的坑没必要让别人在再踩,自己复盘也能加深记忆。利己利人、所谓双赢。 面试官: finally是无条件执行的…...

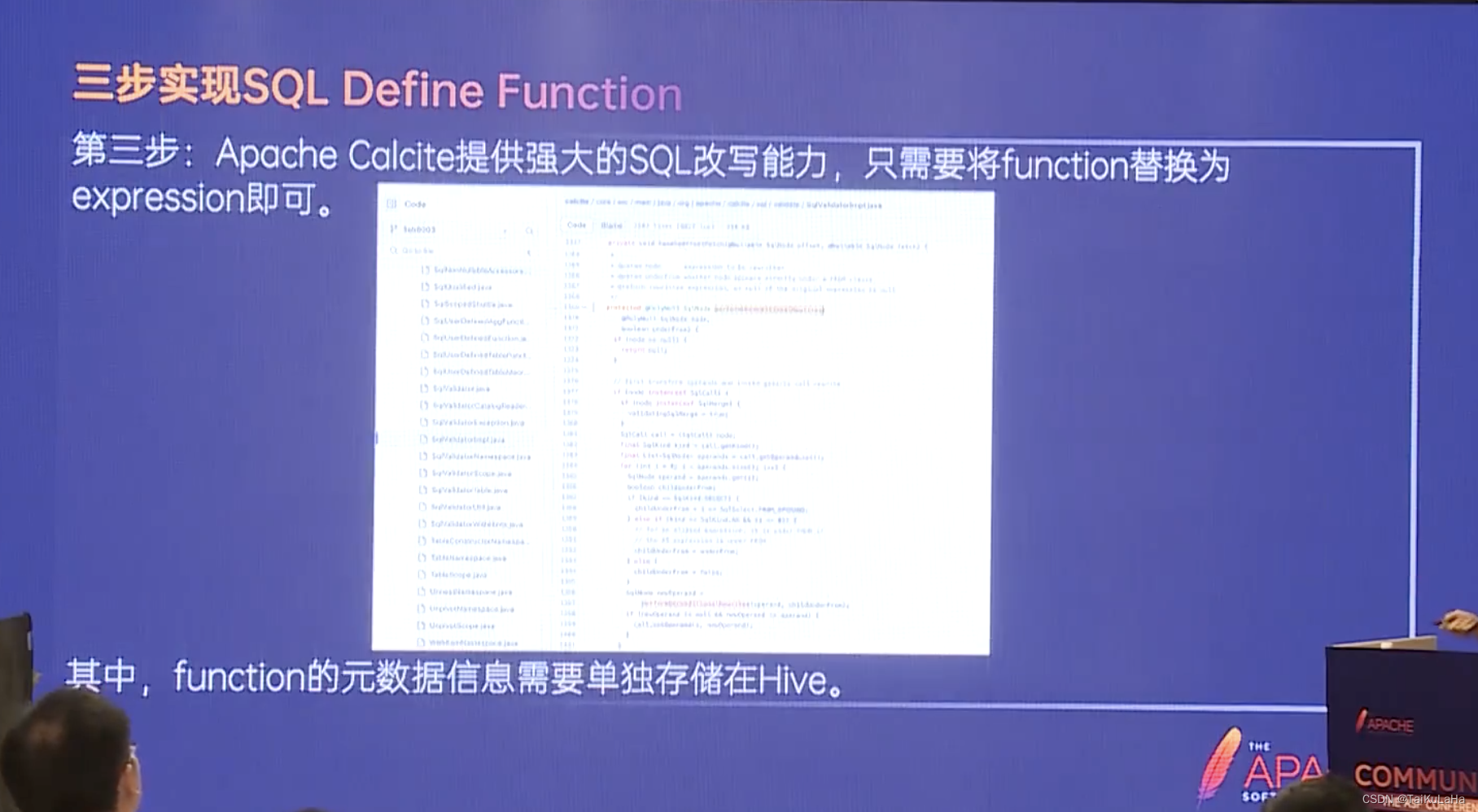

【讲座笔记】基于 Apache Calcite 的多引擎指标管理最佳实践|CommunityOverCode Asia 2023 | 字节开源

引言 三个问题 (问题解法) 1套SQL 2种语法 统一SQL的实践案例 虚拟列的实践案例 SQL Define Function 指标管理的实现 在这里插入图片描述...

蓝桥杯 (猜生日、棋盘放麦子、MP3储存 C++)

思路: 1、用循环。 2、满足条件,能整除2012、3、12且month等于6、day<30 #include<iostream> using namespace std; int main() {for (int i 19000101; i < 20120312; i){int month i / 100 % 100;int day i % 100;if (i % 2012 0 &…...

)

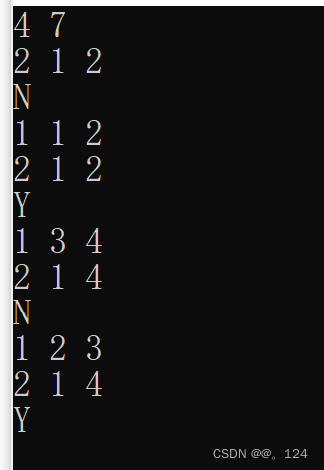

求 k 整除最大元素和(dp)

Description 给你一个整数数组,请你在其中选取若干个元素, 使得其和值能被 k 整除,输出和值最大的那个和值。 最后的数字可能很大,所以结果需要对 19260817 取模。 Input 第一行是两个正整数 n,k:表示数…...

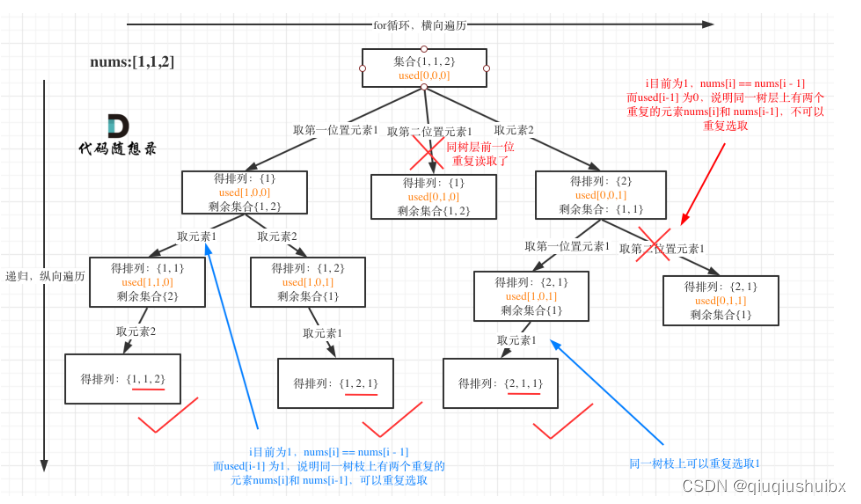

代码随想录Day24 LeetCode T491 递增子序列 LeetCode T46 全排列 LrrtCode T47 全排列II

LeetCode T491 递增子序列 题目链接:491. 递增子序列 - 力扣(LeetCode) 题目思路: 首先这里的测试用例很容易误导我们,这道题不能使用上次子集的思路对数组先排序,使用一个used数组来解决问题. 我们用[4,7,6,7]举例这道题的递增序列不存在[4,6,7,7]这个…...

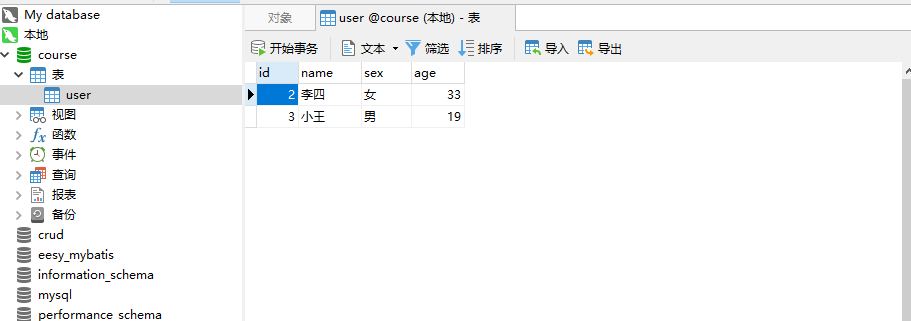

【六:(mock数据)spring boot+mybatis+yml】

目录 1.1、代码编写Demo类User类启动类 APplication 1.2、配置类查询语句的配置 mysql.ymlspringboot的配置 application.yml日志的配置 logback.xml数据库的配置 mybatis-config.xml 1.3、测试:1.3.1、测试获取用户数1.3.2、添加用户1.3.3、数据的更新1.3.4、数据的…...

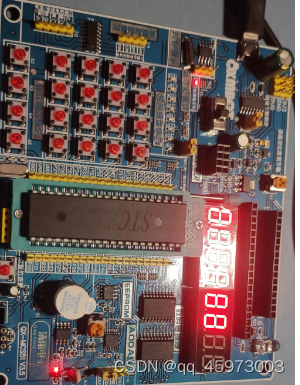

51单片机KeyWard

eg1: 单片机键盘的分类 键盘分为编码键盘和非编码键盘,键盘上闭合键的识别由专用的硬件编码器实现,并产生键编码号或键值得称为编码键盘,如计算机键盘,而靠软件来识别的称为非编码键盘,在单片机组成的各种…...

【简记】getprop, setprop 命令使用

getprop, setprop 命令使用 1、终端设置、读取系统属性 // 例 adb shell setprop "test" "1" adb shell getprop "test"2、安卓读取系统配置 部分属性需要通过反射 android.os.SystemProperties 的方法获取,参见 android 获取手机…...

Ubuntu22.04安装nvidia-docker

安装docker 参考这篇文章:Ubuntu22.04安装docker - 掘金 安装nvidia-docker 参考这篇文章:Ubuntu 22.04 LTS : NVIDIA Container Toolkit : Install : Server World 流程: curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | …...

)

简单的代码优化(后端)

上一篇谈了谈简单的前端的优化,这次就以下几点谈谈后端的优化。 书写时常见的。 循环里面不要走IO流。 走IO,是要对硬盘进读写操作的。就结论而言,硬盘的读写速度是低于内存的,比如说硬盘上读一次数据,需要1秒&#…...

3.Node-事件循环的用法

题记 node.js事件循环的使用方法 Node.js 是单进程单线程应用程序,但是因为 V8 引擎提供的异步执行回调接口,通过这些接口可以处理大量的并发,所以性能非常高。 Node.js 几乎每一个 API 都是支持回调函数的。 Node.js 基本上所有的事件机制都…...

2525.根据规则将箱子分类/并查集/动态规划

2525. 根据规则将箱子分类 - 力扣(LeetCode) 给你四个整数 length ,width ,height 和 mass ,分别表示一个箱子的三个维度和质量,请你返回一个表示箱子 类别 的字符串。 如果满足以下条件,那么…...

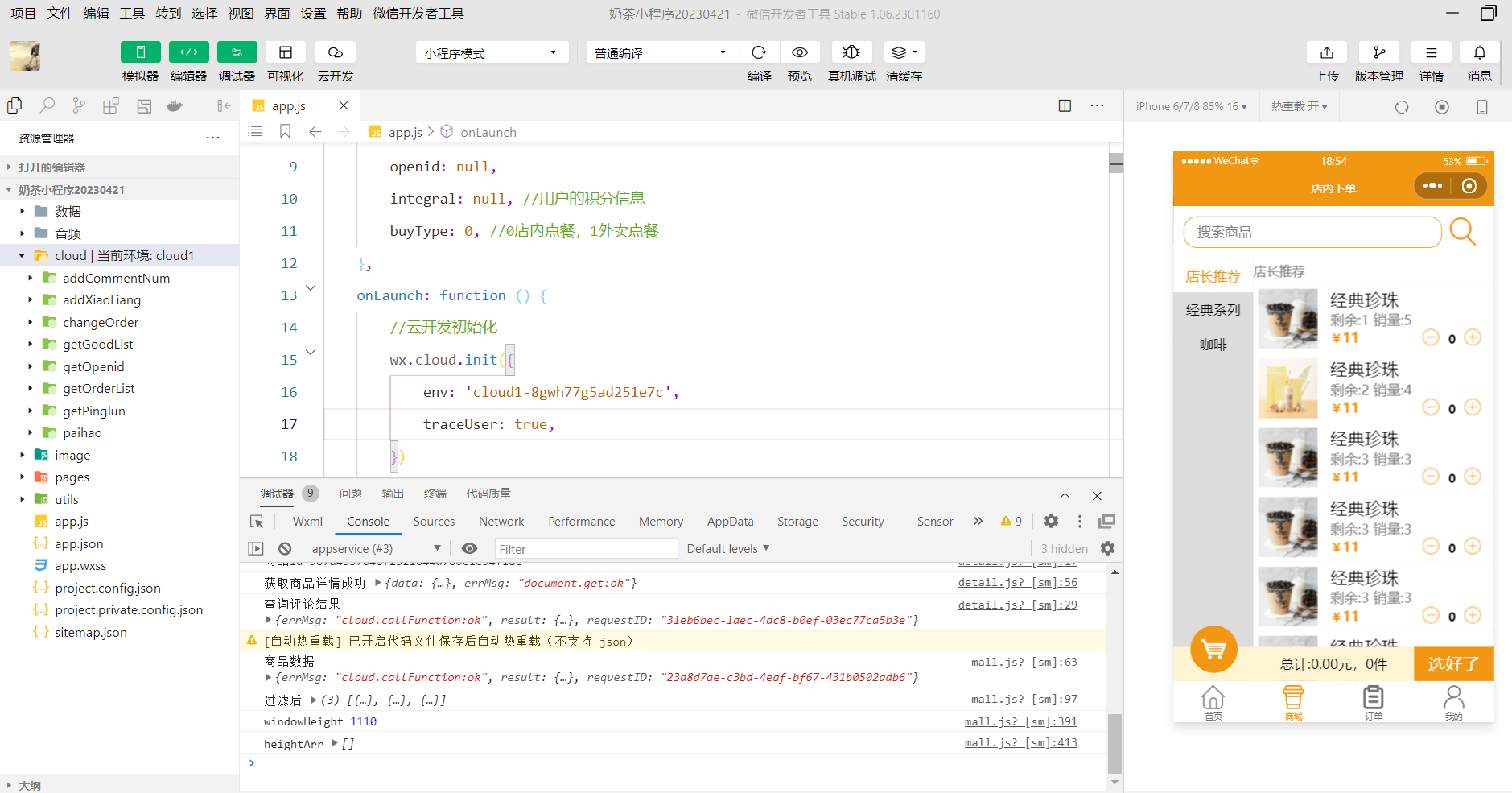

2023年10月小程序云开发cms内容管理无法使用,无法同步内容模型到云开发数据库的解决方案

一,问题描述 最近越来越多的同学找石头哥,说cms用不了,其实是小程序官方最近又搞大动作了,偷偷的升级的云开发cms(内容管理)以下都称cms,不升级不要紧,这一升级,就导致我…...

无论有没有按钮,iPhone都可以进行截屏操作!如何在iPhone上截屏

通过简单的按键组合,可以很容易地将iPhone屏幕的图片捕获到图像文件中,并保存到照片库中。以下是操作方法。 什么是屏幕截图 屏幕截图是指通常包含你在设备屏幕上看到的内容的精确副本的图像。在设备内拍摄的数字屏幕截图通常使用相机拍摄物理屏幕的照…...

笔记本平台信号讲解

1、power button:这个信号会引起SMI#或者SCI来表示系统请求进入到睡眠状态。如果系统已经处于睡眠状态,这将导致唤醒事件信号。 如果PWRBTN#键超过4秒,这将导致一个无条件的过渡(电源按钮替代)到S5状态。即使系统是在S1-S4的状态,覆盖也会发生。 这个信号有一个内部上拉…...

什么是Sectigo证书?

Sectigo证书,早前被称为Comodo证书,是一种SSL(安全套接层)证书,用于保护互联网上的数据传输的安全性和隐私性。这些证书由全球领先的SSL证书颁发机构Sectigo颁发,被广泛用于网站、应用程序和服务器上。本文…...

虹科 | 测试方案 | 汽车示波器 通讯网络(LIN/CAN/FlexRay)测试方案

通讯网络(LIN/CAN/FlexRay)测试 虹科CAN总线示波器把你的PC电脑变成一台功能强大的汽车测试工具,用于检测车辆网络各类通讯信号,如CAN Bus、CAN FD、LIN、FlexRay,还可以检测车上所有传感器和执行器的信号 串行译码 …...

ubuntu20.04安装MySQL8、MySQL服务管理、mysql8卸载

ubuntu20.04安装MySQL8 #更新源 sudo apt-get update #安装 sudo apt-get install mysql-serverMySQL服务管理 # 查看服务状态 sudo service mysql status # 启动服务 sudo service mysql start # 停止服务 sudo service mysql stop # 重启服务 sudo service mysql restart登…...

曾仕强老师视频+音频+电子书合集百度网盘资源

需要的扫码添加获取:...

golang循环变量捕获问题

在 Go 语言中,当在循环中启动协程(goroutine)时,如果在协程闭包中直接引用循环变量,可能会遇到一个常见的陷阱 - 循环变量捕获问题。让我详细解释一下: 问题背景 看这个代码片段: fo…...

Appium+python自动化(十六)- ADB命令

简介 Android 调试桥(adb)是多种用途的工具,该工具可以帮助你你管理设备或模拟器 的状态。 adb ( Android Debug Bridge)是一个通用命令行工具,其允许您与模拟器实例或连接的 Android 设备进行通信。它可为各种设备操作提供便利,如安装和调试…...

转转集团旗下首家二手多品类循环仓店“超级转转”开业

6月9日,国内领先的循环经济企业转转集团旗下首家二手多品类循环仓店“超级转转”正式开业。 转转集团创始人兼CEO黄炜、转转循环时尚发起人朱珠、转转集团COO兼红布林CEO胡伟琨、王府井集团副总裁祝捷等出席了开业剪彩仪式。 据「TMT星球」了解,“超级…...

Robots.txt 文件

什么是robots.txt? robots.txt 是一个位于网站根目录下的文本文件(如:https://example.com/robots.txt),它用于指导网络爬虫(如搜索引擎的蜘蛛程序)如何抓取该网站的内容。这个文件遵循 Robots…...

土地利用/土地覆盖遥感解译与基于CLUE模型未来变化情景预测;从基础到高级,涵盖ArcGIS数据处理、ENVI遥感解译与CLUE模型情景模拟等

🔍 土地利用/土地覆盖数据是生态、环境和气象等诸多领域模型的关键输入参数。通过遥感影像解译技术,可以精准获取历史或当前任何一个区域的土地利用/土地覆盖情况。这些数据不仅能够用于评估区域生态环境的变化趋势,还能有效评价重大生态工程…...

Axios请求超时重发机制

Axios 超时重新请求实现方案 在 Axios 中实现超时重新请求可以通过以下几种方式: 1. 使用拦截器实现自动重试 import axios from axios;// 创建axios实例 const instance axios.create();// 设置超时时间 instance.defaults.timeout 5000;// 最大重试次数 cons…...

UR 协作机器人「三剑客」:精密轻量担当(UR7e)、全能协作主力(UR12e)、重型任务专家(UR15)

UR协作机器人正以其卓越性能在现代制造业自动化中扮演重要角色。UR7e、UR12e和UR15通过创新技术和精准设计满足了不同行业的多样化需求。其中,UR15以其速度、精度及人工智能准备能力成为自动化领域的重要突破。UR7e和UR12e则在负载规格和市场定位上不断优化…...

Pinocchio 库详解及其在足式机器人上的应用

Pinocchio 库详解及其在足式机器人上的应用 Pinocchio (Pinocchio is not only a nose) 是一个开源的 C 库,专门用于快速计算机器人模型的正向运动学、逆向运动学、雅可比矩阵、动力学和动力学导数。它主要关注效率和准确性,并提供了一个通用的框架&…...

苹果AI眼镜:从“工具”到“社交姿态”的范式革命——重新定义AI交互入口的未来机会

在2025年的AI硬件浪潮中,苹果AI眼镜(Apple Glasses)正在引发一场关于“人机交互形态”的深度思考。它并非简单地替代AirPods或Apple Watch,而是开辟了一个全新的、日常可接受的AI入口。其核心价值不在于功能的堆叠,而在于如何通过形态设计打破社交壁垒,成为用户“全天佩戴…...

Scrapy-Redis分布式爬虫架构的可扩展性与容错性增强:基于微服务与容器化的解决方案

在大数据时代,海量数据的采集与处理成为企业和研究机构获取信息的关键环节。Scrapy-Redis作为一种经典的分布式爬虫架构,在处理大规模数据抓取任务时展现出强大的能力。然而,随着业务规模的不断扩大和数据抓取需求的日益复杂,传统…...