时间序列预测模型实战案例(七)(TPA-LSTM)结合TPA注意力机制的LSTM实现多元预测

论文地址->TPA-LSTM论文地址

项目地址-> TPA-LSTM时间序列预测实战案例

本文介绍

本文通过实战案例讲解TPA-LSTM实现多元时间序列预测,在本文中所提到的TPA和LSTM分别是注意力机制和深度学习模型,通过将其结合到一起实现时间序列的预测,本文利用有关油温的数据集来进行训练模型,同时将模型保存到本地,进行加载实现多步长预测,本文所利用的数据集也可以替换成你个人的数据集来进行预测(修改个人的数据集的地方本文也进行了标注),同时本文会对TPA和LSTM分别进行概念的讲解帮助大家理解其中的运行机制原理(包括个人总结已经论文内容)。

LSTM介绍

在开始实战讲解之前先来简单理解一下LSTM,其原理在我的另一篇博客中已经详细的讲解过了,这里只是简单的回顾,如果大家想要更深入的理解可以观看我的另一篇博客,地址如下->时间序列预测模型实战案例(三)(LSTM)(Python)(深度学习)时间序列预测(包括运行代码以及代码讲解)

LSTM的概念

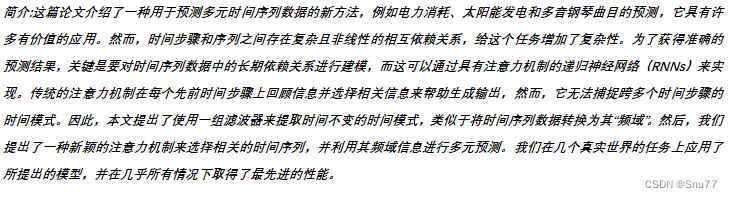

LSTM(长短期记忆,Long Short-Term Memory)是一种用于处理序列数据的深度学习模型,属于循环神经网络(RNN)的一种变体,其使用一种类似于搭桥术结构的RNN单元。相对于普通的RNN,LSTM引入了门控机制,能够更有效地处理长期依赖和短期记忆问题,是RNN网络中最常使用的Cell之一,LSTM的网络结构图如下图所示。

TPA机制介绍

本文主要介绍的是TPA注意力机制,LSTM在之前的文章中已经介绍过了,下面先来介绍一下其工作原理。

TPA的概念

TPA(Temporal Pattern Attention)注意力机制是一种用于处理时间序列数据的注意力机制。它的工作原理是在传统的注意力机制的基础上引入了时间模式的概念,以更好地捕捉时间序列中的重要模式和特征。

TPA的的工作步骤

TPA注意力机制的主要步骤如下:

1. 输入数据准备:给定一个时间序列数据,将其表示为X = {x1, x2, ..., xt},其中xi表示时间i处的观测值。

2. 特征提取:通过使用卷积神经网络,从时间序列中提取特征。这些特征可以是局部模式、全局趋势等。

3. 时间模式编码:将提取的特征序列传递给时间模式编码器。时间模式编码器通过学习时间序列中的重要模式和特征,生成一个编码向量序列。

4. 注意力计算:在时间模式编码器的输出上应用注意力机制。传统的注意力机制计算注意力权重,用于选择与当前时间步相关的信息。而TPA注意力机制通过计算注意力权重,选择与当前时间步相关的重要时间模式。

5. 上下文向量生成:根据注意力权重和时间模式编码器的输出,计算上下文向量。上下文向量是根据选择的重要时间模式加权求和的结果。

6. 预测生成:将上下文向量与其他信息(例如隐藏状态)进行拼接,然后通过适当的操作(如矩阵乘法)生成最终的预测结果。

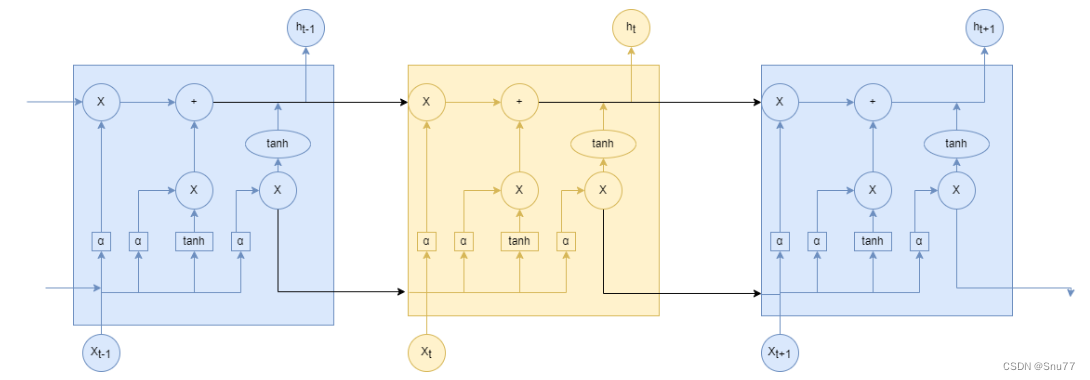

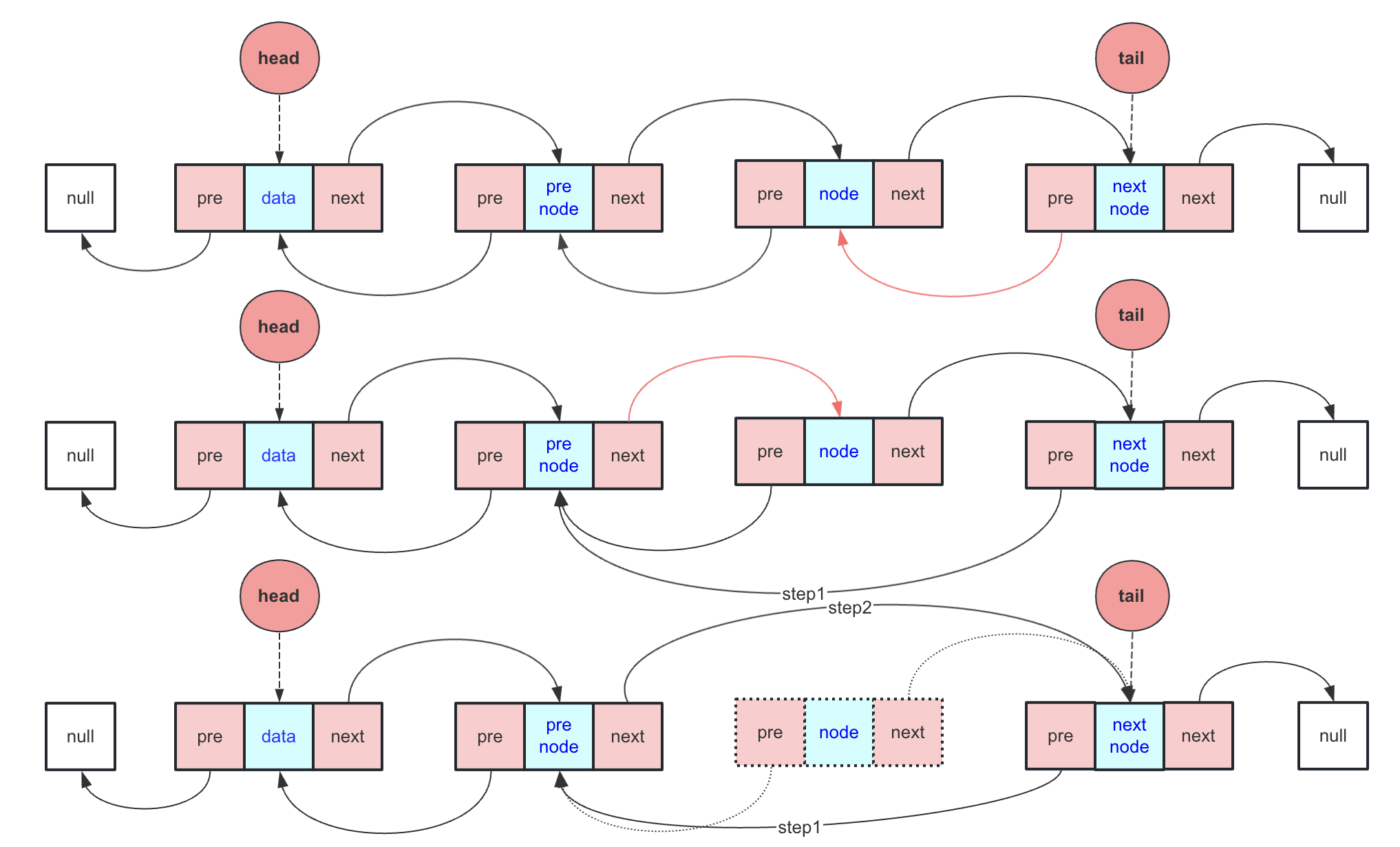

如果大家觉得文字的描述不够直观,我们来看下图通过分析图片的形式来理解其工作原理。

上图显示了TPA注意力机制从输入到输出的过程工作流程,其中表示时间步

处RNN的隐藏状态。有

个长度为

的

(注意是1维的并不像图像处理的2维或三维)滤波器,用不同颜色的矩形表示。然后,每个滤波器在

个隐藏状态特征上进行卷积,并生成一个具有

行和

列的矩阵

。接下来,评分函数通过与当前隐藏状态ht进行比较,为

的每一行计算一个权重。然后,权重进行归一化,

的行按照对应的权重进行加权求和,生成

。最后,我们将

、

进行拼接,并进行矩阵乘法生成

,用于创建最终的预测值。

个人总结->TPA注意力机制的关键创新点在于引入了时间模式编码和基于时间模式的注意力计算。这使得模型能够更好地理解和捕捉时间序列数据中的重要模式和特征,从而提高预测性能。

实战讲解

讲过上文中的简单介绍,大家对于LSTM和TPA机制应该有了一个简单的了解,本文是实战案例讲解,主要部分还是代码部分的应用,所以下面来进行实战案例的讲解。

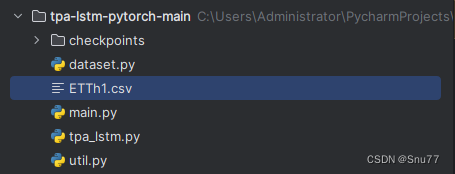

项目结构构成

先来看一下我们的文件目录结构构成。

其中main.py文件为程序入口,dataset.py文件为数据处理的一些操作,tpa-lstm.pyp文件定义了我们的模型结构,util.py为定义的一些工具包,checkpoints为模型文件的保存文件夹,ETTh1.csv文件为数据集。

项目完整代码

为了方便讲解我把上面提到的几个代码先放到这里,文章的开头已经提供下载地址给大家了,如果大家不愿意下载可以按照项目结构构成复制即可。

main.py文件如下

import lightning.pytorch as pl

import matplotlib.pyplot as plt

import pandas as pd

from lightning.pytorch.callbacks import ModelCheckpoint

from dataset import ElectricityDataModule

from tpa_lstm import TPALSTMdata_df = pd.read_csv('ETTh1.csv', index_col=['date'])

num_features = data_df.shape[1]data_splits = {"train": 0.7,"val": 0.15,"predict": 0.15

}pred_horizon = 4elec_dm = ElectricityDataModule(dataset_splits=data_splits,batch_size=128,window_size=24,pred_horizon=pred_horizon,data_style="custom"

)run_name = f"{pred_horizon}ts-kbest30"hid_size = 64

n_layers = 1

num_filters = 3name = f'{run_name}-TPA-LSTM'

checkpoint_loss_tpalstm = ModelCheckpoint(dirpath=f"checkpoints/{run_name}/TPA-LSTM",filename=name,save_top_k=1,monitor="val/loss",mode="min"

)tpalstm_trainer = pl.Trainer(max_epochs=10,# accelerator='gpu',callbacks=[checkpoint_loss_tpalstm],strategy='auto',devices=1,# logger=wandb_logger_tpalstm

)tpa_lstm = TPALSTM(input_size=num_features,hidden_size=hid_size,output_horizon=pred_horizon,num_filters=num_filters,obs_len=24,n_layers=n_layers,lr=1e-3

)tpalstm_trainer.fit(tpa_lstm, elec_dm)elec_dm.setup("predict")

run_to_load = run_name

model_path = f"checkpoints/{run_to_load}/TPA-LSTM/{name}.ckpt"

tpa_lstm = TPALSTM.load_from_checkpoint(model_path)pred_dl = elec_dm.predict_dataloader()

y_pred = tpalstm_trainer.predict(tpa_lstm, pred_dl)batch_idx = 0

start = 0

end = 5

for i, batch in enumerate(pred_dl):if start <= i <= end:inputs, labels = batchX, ytrue = inputs[batch_idx][:, -1], labels[batch_idx].squeeze()ypred = y_pred[i][batch_idx].squeeze()X = X.cpu().numpy()ytrue = ytrue.cpu().numpy()ypred = ypred.cpu().numpy()plt.figure(figsize=(8, 4))plt.plot(range(0, 24), X, label="Input")plt.scatter(range(24, 24 + pred_horizon), ytrue, color='cornflowerblue', label="True-Value")plt.scatter(range(24, 24 + pred_horizon), ypred, marker="x", color='green', label="TPA-LSTM pred")plt.legend(loc="lower left")plt.savefig("preds")plt.show()elif i > end:break

dataset.py文件如下 ->

import math

import pandas as pd

import torch

from torch.utils.data import Dataset, DataLoader

import lightning.pytorch as plclass ElectricityDataset(Dataset):def __init__(self,mode,split_ratios,window_size,pred_horizon,data_style,):self.w_size = window_sizeself.pred_horizon = pred_horizonif data_style == "pca":self.raw_dataset = pd.read_csv('ETTh1.csv',index_col=['date'])elif data_style == "kbest":self.raw_dataset = pd.read_csv('ETTh1.csv',index_col=['date'])elif data_style == "custom":self.raw_dataset = pd.read_csv('ETTh1.csv',index_col=['date'])else:print("Invalid dataset type")self.raw_dataset = Noneself.train_frac = split_ratios['train']self.val_frac = split_ratios['val']self.test_frac = split_ratios['predict']self.train_lim = math.floor(self.train_frac * self.raw_dataset.shape[0]) self.val_lim = math.floor(self.val_frac * self.raw_dataset.shape[0]) + self.train_limif mode == "train":self.dataset = self.raw_dataset[:self.train_lim]if mode == "val":self.dataset = self.raw_dataset[self.train_lim:self.val_lim]if mode == "predict":self.dataset = self.raw_dataset[self.val_lim:]self.device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")data_array = self.dataset.values

# self.X = torch.tensor(self.dataset[:, :-1], dtype=torch.float32).to(self.device)self.X = torch.tensor(data_array, dtype=torch.float32).to(self.device)self.y = torch.tensor(data_array[:, -1], dtype=torch.float32) \.unsqueeze(1).to(self.device)def __getitem__(self, idx):return (self.X[idx:idx + self.w_size, :], self.y[idx + self.w_size: idx + self.w_size + self.pred_horizon])def __len__(self):# TODO Check this is correctreturn len(self.dataset) - (self.w_size + self.pred_horizon)def get_input_size(self):return self.dataset.shape[1]class ElectricityDataModule(pl.LightningDataModule):def __init__(self,dataset_splits,batch_size=64,window_size=24,pred_horizon=1,data_style="pca"):super().__init__()self.batch_size = batch_sizeself.dataset_splits = dataset_splitsself.window_size = window_sizeself.pred_horizon = pred_horizonself.data_style=data_styledef setup(self, stage):if stage == "fit":self.data_train = ElectricityDataset(mode="train",split_ratios=self.dataset_splits,window_size=self.window_size,pred_horizon=self.pred_horizon,data_style=self.data_style)self.data_val = ElectricityDataset(mode="val",split_ratios=self.dataset_splits,window_size=self.window_size,pred_horizon=self.pred_horizon,data_style=self.data_style)elif stage == "predict":self.data_pred = ElectricityDataset(mode="predict",split_ratios=self.dataset_splits,window_size=self.window_size,pred_horizon=self.pred_horizon,data_style=self.data_style)def train_dataloader(self):return DataLoader(self.data_train, batch_size=self.batch_size, shuffle=False)def val_dataloader(self):return DataLoader(self.data_val, batch_size=self.batch_size, shuffle=False)def predict_dataloader(self):return DataLoader(self.data_pred, batch_size=self.batch_size, shuffle=False)

tpa_lstm.py文件如下->

import torch

from torch import nn, optim

import lightning.pytorch as plfrom util import RMSE, RSE, CORRdevice = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")class TPALSTM(pl.LightningModule):def __init__(self, input_size, output_horizon, num_filters, hidden_size, obs_len, n_layers, lr=1e-3):super(TPALSTM, self).__init__()self.hidden = nn.Linear(input_size, 24)self.relu = nn.ReLU()self.lstm = nn.LSTM(input_size, hidden_size, n_layers, \bias=True, batch_first=True) # output (batch_size, obs_len, hidden_size)self.hidden_size = hidden_sizeself.filter_num = num_filtersself.filter_size = 1 # Don't change this - otherwise CNN filters no longer 1Dself.output_horizon = output_horizonself.attention = TemporalPatternAttention(self.filter_size, \self.filter_num, obs_len - 1, hidden_size)self.mlp_out = nn.Sequential(nn.Linear(hidden_size, hidden_size // 2),self.relu,nn.Dropout(p=0.2),nn.Linear(hidden_size // 2, output_horizon))self.linear = nn.Linear(hidden_size, output_horizon)self.n_layers = n_layersself.lr = lrself.criterion = nn.MSELoss()self.save_hyperparameters()def forward(self, x):batch_size, obs_len, f_dim = x.size()H = torch.zeros(batch_size, obs_len - 1, self.hidden_size).to(device)ht = torch.zeros(self.n_layers, batch_size, self.hidden_size).to(device)ct = ht.clone()for t in range(obs_len):xt = x[:, t, :].view(batch_size, 1, -1)out, (ht, ct) = self.lstm(xt, (ht, ct))htt = ht.permute(1, 0, 2)htt = htt[:, -1, :]if t != obs_len - 1:H[:, t, :] = httH = self.relu(H)# reshape hidden states HH = H.view(-1, 1, obs_len - 1, self.hidden_size)new_ht = self.attention(H, htt)ypred = self.linear(new_ht).unsqueeze(-1)

# ypred = self.mlp_out(new_ht).unsqueeze(-1)return ypreddef training_step(self, batch, batch_idx):inputs, label = batch outputs = self.forward(inputs)loss = self.criterion(outputs, label)corr = CORR(outputs, label)rse = RSE(outputs, label)self.log("train/loss", loss, prog_bar=True, on_epoch=True, on_step=False)self.log("train/corr", corr, prog_bar=True, on_epoch=True, on_step=False)self.log("train/rse", rse, prog_bar=True, on_epoch=True, on_step=False)return lossdef validation_step(self, batch, batch_idx):inputs, label = batch outputs = self.forward(inputs)loss = self.criterion(outputs, label)corr = CORR(outputs, label)rse = RSE(outputs, label)self.log("val/loss", loss, prog_bar=True, on_epoch=True, on_step=False)self.log("val/corr", corr, prog_bar=True, on_epoch=True, on_step=False)self.log("val/rse", rse, prog_bar=True, on_epoch=True, on_step=False)def predict_step(self, batch, batch_idx):inputs, label = batch pred = self.forward(inputs)return preddef configure_optimizers(self):optimiser = optim.Adam(self.parameters(),lr=self.lr,amsgrad=False,

# weight_decay=1e-4,)return optimiserclass TemporalPatternAttention(nn.Module):def __init__(self, filter_size, filter_num, attn_len, attn_size):super(TemporalPatternAttention, self).__init__()self.filter_size = filter_sizeself.filter_num = filter_numself.feat_size = attn_size - self.filter_size + 1self.conv = nn.Conv2d(1, filter_num, (attn_len, filter_size))self.linear1 = nn.Linear(attn_size, filter_num)self.linear2 = nn.Linear(attn_size + self.filter_num, attn_size)self.relu = nn.ReLU()def forward(self, H, ht):_, channels, _, attn_size = H.size()new_ht = ht.view(-1, 1, attn_size)w = self.linear1(new_ht) # batch_size, 1, filter_numconv_vecs = self.conv(H)conv_vecs = conv_vecs.view(-1, self.feat_size, self.filter_num)conv_vecs = self.relu(conv_vecs)# score functionw = w.expand(-1, self.feat_size, self.filter_num)s = torch.mul(conv_vecs, w).sum(dim=2)alpha = torch.sigmoid(s)new_alpha = alpha.view(-1, self.feat_size, 1).expand(-1, self.feat_size, self.filter_num)v = torch.mul(new_alpha, conv_vecs).sum(dim=1).view(-1, self.filter_num)concat = torch.cat([ht, v], dim=1)new_ht = self.linear2(concat)return new_ht

util.py文件如下->

#!/usr/bin/python 3.6

#-*-coding:utf-8-*-'''

Utility functions

'''

import torch

import numpy as np

import os

import randomdef get_data_path():folder = os.path.dirname(__file__)return os.path.join(folder, "data")def RSE(ypred, ytrue):if isinstance(ypred, np.ndarray):rse = np.sqrt(np.square(ypred - ytrue).sum()) / \np.sqrt(np.square(ytrue - ytrue.mean()).sum())else:rse = torch.sqrt(torch.square(ypred - ytrue).sum()) / \torch.sqrt(torch.square(ytrue - ytrue.mean()).sum())return rsedef RMSE(ypred, ytrue):return torch.sqrt(torch.mean(torch.sum(torch.square(ypred - ytrue), dim=1)))def CORR(ypred, ytrue):if isinstance(ypred, np.ndarray):vx = ypred - np.mean(ypred)vy = ytrue - np.mean(ytrue)return np.sum(vx * vy) / (np.sqrt(np.sum(vx ** 2)) * np.sqrt(np.sum(vy ** 2)))else:vx = ypred - torch.mean(ypred)vy = ytrue - torch.mean(ytrue)return torch.sum(vx * vy) / (torch.sqrt(torch.sum(vx ** 2)) * torch.sqrt(torch.sum(vy ** 2)))def quantile_loss(ytrue, ypred, qs):'''Quantile loss version 2Args:ytrue (batch_size, output_horizon)ypred (batch_size, output_horizon, num_quantiles)'''L = np.zeros_like(ytrue)for i, q in enumerate(qs):yq = ypred[:, :, i]diff = yq - ytrueL += np.max(q * diff, (q - 1) * diff)return L.mean()def SMAPE(ytrue, ypred):ytrue = np.array(ytrue).ravel()ypred = np.array(ypred).ravel() + 1e-4mean_y = (ytrue + ypred) / 2.return np.mean(np.abs((ytrue - ypred) \/ mean_y))def MAPE(ytrue, ypred):ytrue = np.array(ytrue).ravel() + 1e-4ypred = np.array(ypred).ravel()return np.mean(np.abs((ytrue - ypred) \/ ytrue))def train_test_split(X, y, train_ratio=0.7):num_ts, num_periods, num_features = X.shapetrain_periods = int(num_periods * train_ratio)random.seed(2)Xtr = X[:, :train_periods, :]ytr = y[:, :train_periods]Xte = X[:, train_periods:, :]yte = y[:, train_periods:]return Xtr, ytr, Xte, yteclass StandardScaler:def fit_transform(self, y):self.mean = np.mean(y)self.std = np.std(y) + 1e-4return (y - self.mean) / self.stddef inverse_transform(self, y):return y * self.std + self.meandef transform(self, y):return (y - self.mean) / self.stdclass MaxScaler:def fit_transform(self, y):self.max = np.max(y)return y / self.maxdef inverse_transform(self, y):return y * self.maxdef transform(self, y):return y / self.maxclass MeanScaler:def fit_transform(self, y):self.mean = np.mean(y)return y / self.meandef inverse_transform(self, y):return y * self.meandef transform(self, y):return y / self.meanclass LogScaler:def fit_transform(self, y):return np.log1p(y)def inverse_transform(self, y):return np.expm1(y)def transform(self, y):return np.log1p(y)def gaussian_likelihood_loss(z, mu, sigma):'''Gaussian Liklihood LossArgs:z (tensor): true observations, shape (num_ts, num_periods)mu (tensor): mean, shape (num_ts, num_periods)sigma (tensor): standard deviation, shape (num_ts, num_periods)likelihood: (2 pi sigma^2)^(-1/2) exp(-(z - mu)^2 / (2 sigma^2))log likelihood:-1/2 * (log (2 pi) + 2 * log (sigma)) - (z - mu)^2 / (2 sigma^2)'''negative_likelihood = torch.log(sigma + 1) + (z - mu) ** 2 / (2 * sigma ** 2) + 6return negative_likelihood.mean()def negative_binomial_loss(ytrue, mu, alpha):'''Negative Binomial SampleArgs:ytrue (array like)mu (array like)alpha (array like)maximuze log l_{nb} = log Gamma(z + 1/alpha) - log Gamma(z + 1) - log Gamma(1 / alpha)- 1 / alpha * log (1 + alpha * mu) + z * log (alpha * mu / (1 + alpha * mu))minimize loss = - log l_{nb}Note: torch.lgamma: log Gamma function'''batch_size, seq_len = ytrue.size()likelihood = torch.lgamma(ytrue + 1. / alpha) - torch.lgamma(ytrue + 1) - torch.lgamma(1. / alpha) \- 1. / alpha * torch.log(1 + alpha * mu) \+ ytrue * torch.log(alpha * mu / (1 + alpha * mu))return - likelihood.mean()def batch_generator(X, y, num_obs_to_train, seq_len, batch_size):'''Args:X (array like): shape (num_samples, num_features, num_periods)y (array like): shape (num_samples, num_periods)num_obs_to_train (int):seq_len (int): sequence/encoder/decoder lengthbatch_size (int)'''num_ts, num_periods, _ = X.shapeif num_ts < batch_size:batch_size = num_tst = random.choice(range(num_obs_to_train, num_periods-seq_len))batch = random.sample(range(num_ts), batch_size)X_train_batch = X[batch, t-num_obs_to_train:t, :]y_train_batch = y[batch, t-num_obs_to_train:t]Xf = X[batch, t:t+seq_len]yf = y[batch, t:t+seq_len]return X_train_batch, y_train_batch, Xf, yf项目网络结构

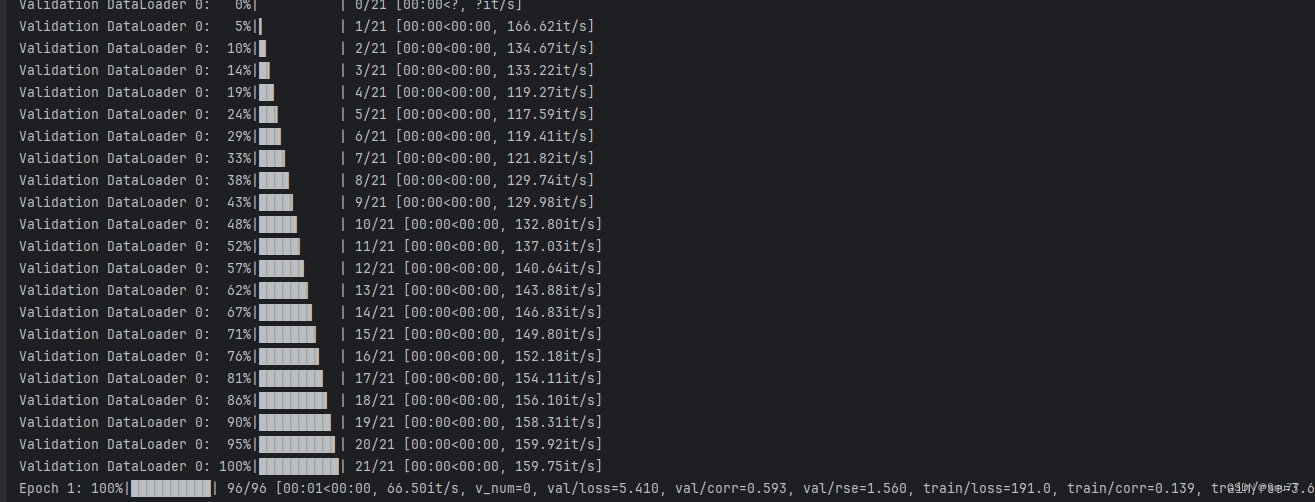

本项目的网络结构图如下所示在控制台输出了大家如果想要修改可以在其中的对应的位置添加或删除都可以。

代码讲解

训练部分

我们首先来看main.py文件我也只会讲解这一个文件,(因为代码很多,如果大家有需要我后期会出视频带着大家过一遍其中的代码),;

main.py文件的内容不是很多,首先最上面的模块导入部分,我不讲解了,前面有我应用的版本,大家如果有一些版本报错的话可以参考。

data_df = pd.read_csv('ETTh1.csv', index_col=['date'])

num_features = data_df.shape[1]这两行代码就是数据的读取操作,以及获取数据的特征数,因为我们是多元预测,数据肯定不只一列,所以我们要告诉模型我们的输入有多少列模型好做多少列的预测。

data_splits = {"train": 0.7,"val": 0.15,"predict": 0.15

}

这几行是数据集的一个划分,大家应该都明白。这里训练集划分为模型的0.7、验证集为0.15、测试集为0.15。

pred_horizon = 4

这个参数就是你预测未来数据的长度,假设你数据集的时间是按照小时来划分,那么如果输入4就是未来四小时的一个情况。

elec_dm = ElectricityDataModule(dataset_splits=data_splits,batch_size=128,window_size=24,pred_horizon=pred_horizon,data_style="custom"

)这个部分是一个数据加载器定义的一个过程,其中我们的data_splits上面讲过了,batch_size就是你往模型里面一次输入的数据长度,window_size是你用多少条数据预测未来一条数据,pred_horizon上面也讲过了,custom是你数据加载器定义的形式这里大家不用理会。

hid_size = 64

n_layers = 1

num_filters = 3这三个参数是定义模型的参数,其中hid_size是隐藏层的单元数如果不理解可以看前面提到的LSTM讲解博客,n_layers是其中LSTM的层数,num_filters是TPA注意力机制中卷积的一个形状。

name = f'{run_name}-TPA-LSTM'

checkpoint_loss_tpalstm = ModelCheckpoint(dirpath=f"checkpoints/{run_name}/TPA-LSTM",filename=name,save_top_k=1,monitor="val/loss",mode="min"

)这一部分是模型保存部分不进行讲解了,大家有兴趣可以自己debug看看就是保存模型文件。

tpalstm_trainer = pl.Trainer(max_epochs=10,# accelerator='gpu',callbacks=[checkpoint_loss_tpalstm],strategy='auto',devices=1,# logger=wandb_logger_tpalstm

)这一部分定义了一些训练中的参数,其中max_epochs就是训练10轮的意思。

tpa_lstm = TPALSTM(input_size=num_features,hidden_size=hid_size,output_horizon=pred_horizon,num_filters=num_filters,obs_len=24,n_layers=n_layers,lr=1e-3

)这一部分就是定义的一些参数前面定义的全部输入到模型里面。

tpalstm_trainer.fit(tpa_lstm, elec_dm)这个就是模型训练的操作,执行到这里模型就开始训练了。

预测部分

上一小节讲解的是训练的过程,现在开始详解预测的过程,代码也是在main.py文件中。

elec_dm.setup("predict")

run_to_load = run_name

model_path = f"checkpoints/{run_to_load}/TPA-LSTM/{name}.ckpt"

tpa_lstm = TPALSTM.load_from_checkpoint(model_path)我们先选择预测模式,然后下载上一小节训练的模型,

pred_dl = elec_dm.predict_dataloader()

y_pred = tpalstm_trainer.predict(tpa_lstm, pred_dl)这一部分就是进行预测,其中第一行为数据加载器,如果大家感兴趣可以看看dataset.py文件其中有注释。然后我们调用了前面加载的模型其中的predict方法进行预测 ,运行之后我们的预测结果就保存到了y_pred中了已经。

结果分析

batch_idx = 0

start = 0

end = 5

for i, batch in enumerate(pred_dl):if start <= i <= end:inputs, labels = batchX, ytrue = inputs[batch_idx][:, -1], labels[batch_idx].squeeze()ypred = y_pred[i][batch_idx].squeeze()X = X.cpu().numpy()ytrue = ytrue.cpu().numpy()ypred = ypred.cpu().numpy()plt.figure(figsize=(8, 4))plt.plot(range(0, 24), X, label="Input")plt.scatter(range(24, 24 + pred_horizon), ytrue, color='cornflowerblue', label="True-Value")plt.scatter(range(24, 24 + pred_horizon), ypred, marker="x", color='green', label="TPA-LSTM pred")plt.legend(loc="lower left")plt.savefig("preds")plt.show()elif i > end:break这一部分就是画图功能了,最后我们预测结果全部会以图片的形式输出出来,因为我输入的数据形状是7列这里就生成了七张图片,如下所示->

总结

到此本文就全部讲解结束了,希望能够帮助大家,最后推荐几篇我的其它时间序列实战案例

其它时间序列预测模型的讲解!

时间序列预测模型实战案例(六)深入理解机器学习ARIMA包括差分和相关性分析

时间序列预测模型实战案例(五)基于双向LSTM横向搭配单向LSTM进行回归问题解决

时间序列预测模型实战案例(四)(Xgboost)(Python)(机器学习)图解机制原理实现时间序列预测和分类(附一键运行代码资源下载和代码讲解)

时间序列预测模型实战案例(三)(LSTM)(Python)(深度学习)时间序列预测(包括运行代码以及代码讲解)

【全网首发】(MTS-Mixers)(Python)(Pytorch)最新由华为发布的时间序列预测模型实战案例(一)(包括代码讲解)实现企业级预测精度包括官方代码BUG修复Transform模型

时间序列预测模型实战案例(二)(Holt-Winter)(Python)结合K-折交叉验证进行时间序列预测实现企业级预测精度(包括运行代码以及代码讲解)

如果大家有不懂的也可以评论区留言一些报错什么的大家可以讨论讨论看到我也会给大家解答如何解决!

相关文章:

时间序列预测模型实战案例(七)(TPA-LSTM)结合TPA注意力机制的LSTM实现多元预测

论文地址->TPA-LSTM论文地址 项目地址-> TPA-LSTM时间序列预测实战案例 本文介绍 本文通过实战案例讲解TPA-LSTM实现多元时间序列预测,在本文中所提到的TPA和LSTM分别是注意力机制和深度学习模型,通过将其结合到一起实现时间序列的预测,本文利用…...

Mysql多表设计

前言 多表查询中要给每一表起别名 tableA as 别名1 , tableB as 别名2 ; (111111推荐) tableA 别名1 , tableB 别名2 ; 例子: select emp.name , dept.name from tb_emp emp inner join tb_dept dept on emp.dept_id dept.id; 一对一 在任…...

)

第九章:最新版零基础学习 PYTHON 教程—Python 元组(第五节 -清除元组的5种方式方法)

有时,在处理记录数据时,我们可能会遇到需要执行数据记录清除的问题。元组是不可变的,无法修改,因此使这项工作变得困难。让我们讨论执行此任务的某些方法。 目录 方法 #1:使用 list() + clear() + tuple() 方法#2:使用 tuple() 重新初始化...

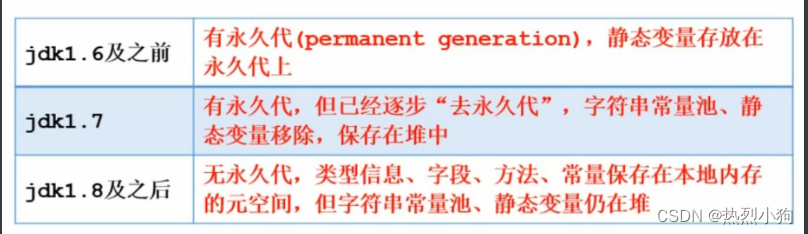

学习笔记4——JVM运行时数据区梳理

学习笔记系列开头惯例发布一些寻亲消息 链接:https://baobeihuijia.com/bbhj/contents/3/192489.html 类装载器classLoader: 将本地的字节码文件.class 加载到内存方法区中成为元数据模板(两个class对象是否为同一个类要求:完整…...

Splunk 创建特色 dashboard 报表

1: 背景: 对原有的dashboard 进行增加点东西,特别是文字部分: 比如: 增加:“this is a guidline for how to use performance". 这段话,就不能写在title, 那样,这段文字,会出现在dashboard 的PDF 文件的分割线的上面,不符合要求。 2: 解决问题: 正确的做法是…...

如何在校园跑腿系统小程序中构建稳健的订单处理与分配系统?

1. 数据库设计 首先,设计订单数据结构。使用数据库(例如MySQL、MongoDB等),创建订单表以存储订单相关信息,包括订单ID、用户信息、交付地址、订单状态等。 CREATE TABLE orders (order_id INT AUTO_INCREMENT PRIMAR…...

数据结构与算法—双链表

前言 前面有很详细的讲过线性表(顺序表和链表),当时讲的链表以单链表为主,但在实际应用中双链表有很多应用场景,例如大家熟知的LinkedList。 双链表与单链表区别 单链表和双链表都是线性表的链式实现,它们的主要区别在于节点结构…...

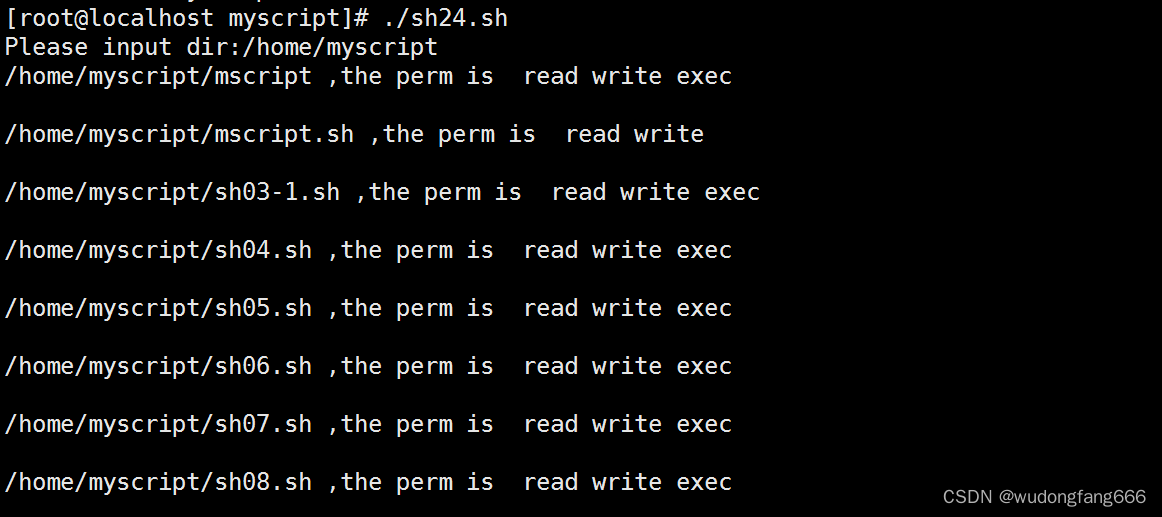

linux继续循环案例测试ping网络,目录下的文件权限循环输出

第一:查看本机ip #ip addr 通过脚本访问本机ip1-100,是否可以ping通,并显示结果,上图 知识点 ping -c 数字1 -w 数字1,向目的ip发送1个数据包,等待1秒,无回复中止 &>/dev/null 知…...

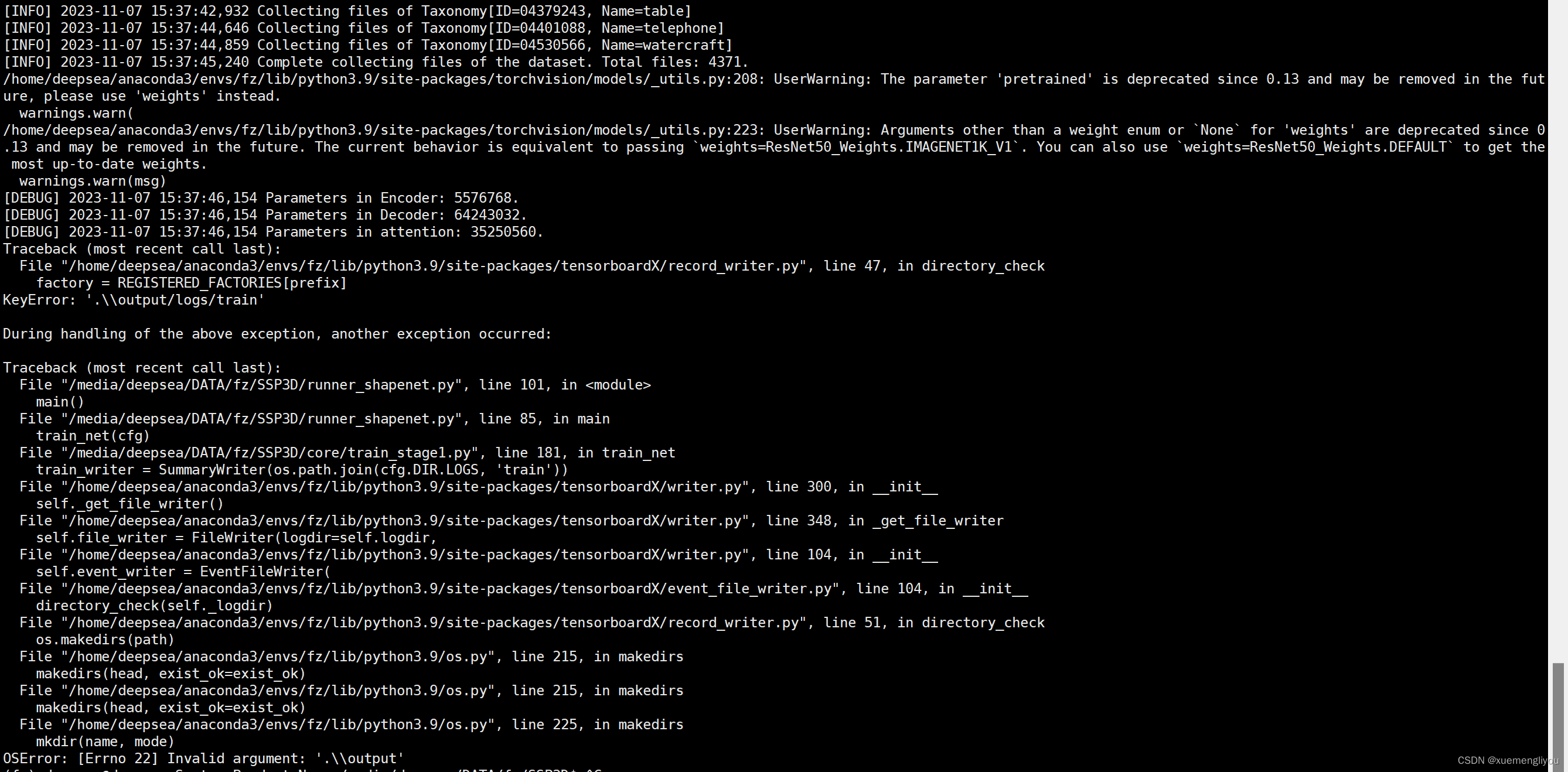

关于SSP3D复现

关于SSP3D复现的问题 准备工作 下载Xshell和XFTP:家校免费版下载链接连接服务器(可能需要与服务器处在相同网络下)GitHub上下载源码:SSP3D 左上角新建会话,输入名称和主机 点击左侧菜单“用户身份验证”,…...

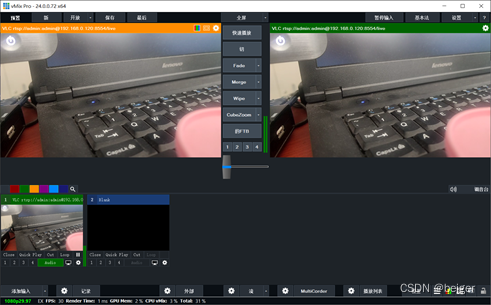

在直播系统中使用RTSP协议传递视频

目录 概述 1、环境准备 2、拉流URL地址 3、导播软件取流 (1)OBS中拉取RTSP流 (2)芯象中拉取RTSP流 (3)vMix中拉取RTSP流 写在最后 概述 提到RTSP协议,很容易想到RTMP协议,它…...

Notion汉化

Notion真无语,汉化版都没有。真的无力吐槽。 2023.11.7汉化经历 教程链接:github Reamd7/notion-zh_CN at 2.4.20-handmade (github.com) 网页版: 油猴下载插件。 Notion中文汉化 浏览器插件下载 windows: github realse 这…...

echarts有背景的柱状图,鼠标滑过提示信息都是展示背景柱状图的值

// 上一篇文章介绍了如何实现有背景的柱状图,现在又遇到一个问题,鼠标滑过柱子,提示信息是背景柱子的值,解决方案,自定义tooltip的formatter,上代码tooltip: {//鼠标悬浮提示数据formatter: function (para…...

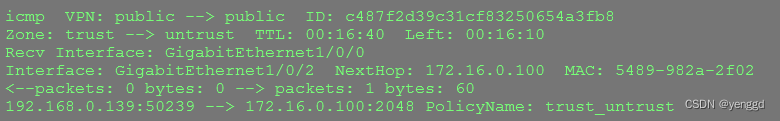

华为防火墙基本原理工作方法总结

防火墙只会对tcp首包syn建立会话表,其它丢掉,如synack,ack udp直接建立会话表 icmp只对首包请求包建立会话表,其它包,如应答的不会建立直接丢掉 防火墙状态查看: rule name trust_untrust source-zone tru…...

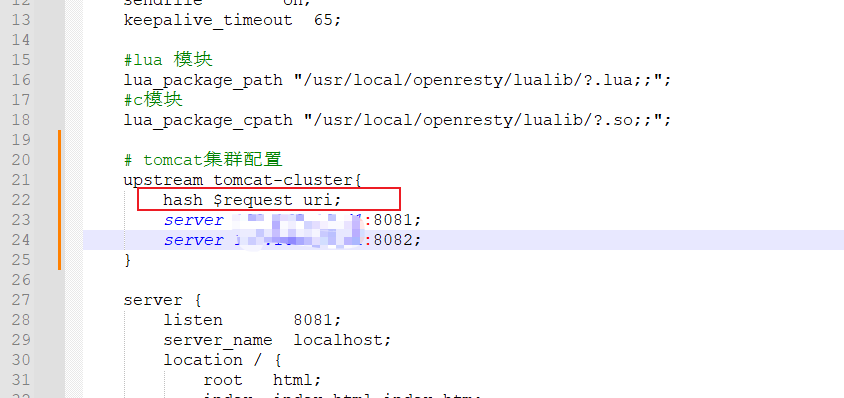

Spring Cloud之多级缓存

目录 传统缓存 多级缓存 JVM进程缓存 Caffeine 缓存驱逐策略 实现进程缓存 常用Lua语法 数据类型 变量声明 循环使用 定义函数 条件控制 安装OpenResty 实现Nginx业务逻辑编写 请求参数解析 实现lua访问tomcat JSON的序列化和反序列化 Tomcat的集群负载均衡 …...

融云荣登「2023 年度 PaaS 企业排行榜」

11 月 2 日,中国科学院旗下《互联网周刊》颁布“2023 年度 PaaS 企业排行榜”,融云荣登榜单。关注【融云全球互联网通信云】了解更多 根据中国信息通信研究院《云计算白皮书 2023》:2022 年,PaaS 增长强势,总收入 342 …...

YOLOv8轻量化模型:模型轻量化设计 | 轻量级可重参化EfficientRep| 来自YOLOv6思想

💡💡💡本文解决什么问题:在几乎不保证精度下降的前提下,轻量级模型创新设计 EfficientRep 在关键点检测任务中 | GFLOPs从9.6降低至8.5, mAP50从0.921下降至0.912,mAP50-95从0.697提升至0.779 YOLO轻量化模型专栏:http://t.csdnimg.cn/AeaEF 1.YOLOv6介绍 论文…...

【JavaSE】基础笔记 - 类和对象(下)

目录 1、this引用 1.1、为什么要有this引用 1.2、什么是this引用 1.3、 this引用的特性 2、 对象的构造及初始化 2.1、 如何初始化对象 2.2、构造方法 2.2.1、概念 2.2.2、特性 2.3、默认初始化 2.4、就地初始化 上篇:【JavaSE】基础笔记 - 类和对象&#…...

浅析刚入门Python初学者的注意事项

文章目录 一、注意你的Python版本1.print()函数2.raw_input()与input()3.比较符号,使用!替换<>4.repr函数5.exec()函数 二、新手常遇到的问题1、如何写多行程序?2、如何执行.py文件?3、and,or,not4、True和False…...

2023NOIP A层联测26 总结

T1 求 ∑ i 1 n ∑ j i n ( ⨁ k i j a k ) 2 \sum\limits_{i1}^n\sum\limits_{ji}^n\left(\bigoplus\limits_{ki}^{j}a_k\right)^2 i1∑nji∑n(ki⨁jak)2, n , a i ≤ 2 1 0 5 n,a_i\le2\times10^5 n,ai≤2105。先转成前缀和,然后就没思…...

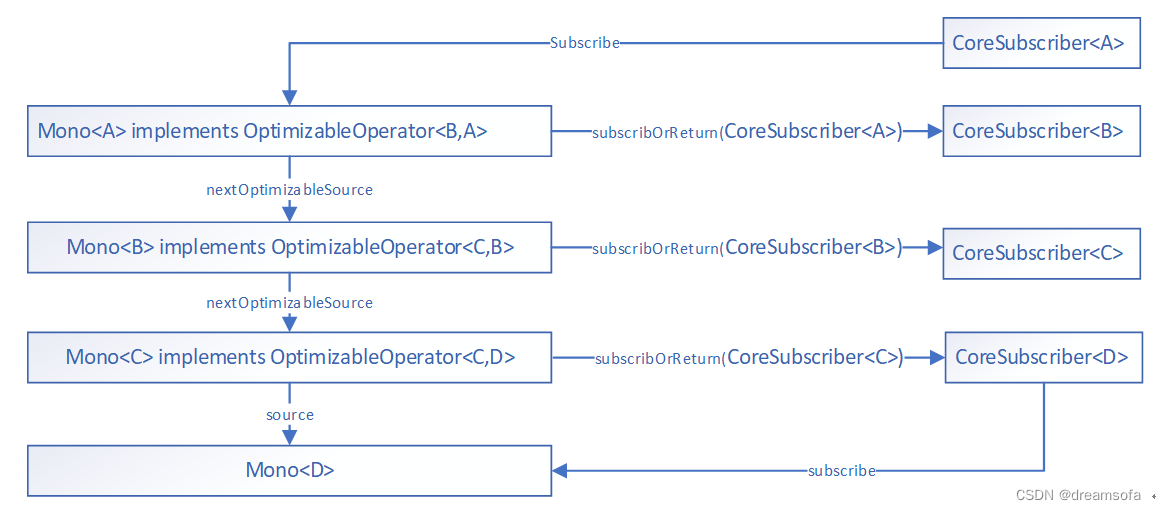

响应式编程-Project Reactor Mono 介绍

响应式编程-Project Reactor Mono 介绍 本文以Mono的角度来介绍Reactor编程,Flux的使用同理。 初体验 Web应用 controller 方法在Spring webmvc 和 Spring webFlux下Controller方法实现示例如下: Spring webmvc: GetMapping("/test1") …...

设计模式和设计原则回顾

设计模式和设计原则回顾 23种设计模式是设计原则的完美体现,设计原则设计原则是设计模式的理论基石, 设计模式 在经典的设计模式分类中(如《设计模式:可复用面向对象软件的基础》一书中),总共有23种设计模式,分为三大类: 一、创建型模式(5种) 1. 单例模式(Sing…...

k8s从入门到放弃之Ingress七层负载

k8s从入门到放弃之Ingress七层负载 在Kubernetes(简称K8s)中,Ingress是一个API对象,它允许你定义如何从集群外部访问集群内部的服务。Ingress可以提供负载均衡、SSL终结和基于名称的虚拟主机等功能。通过Ingress,你可…...

Redis相关知识总结(缓存雪崩,缓存穿透,缓存击穿,Redis实现分布式锁,如何保持数据库和缓存一致)

文章目录 1.什么是Redis?2.为什么要使用redis作为mysql的缓存?3.什么是缓存雪崩、缓存穿透、缓存击穿?3.1缓存雪崩3.1.1 大量缓存同时过期3.1.2 Redis宕机 3.2 缓存击穿3.3 缓存穿透3.4 总结 4. 数据库和缓存如何保持一致性5. Redis实现分布式…...

【SpringBoot】100、SpringBoot中使用自定义注解+AOP实现参数自动解密

在实际项目中,用户注册、登录、修改密码等操作,都涉及到参数传输安全问题。所以我们需要在前端对账户、密码等敏感信息加密传输,在后端接收到数据后能自动解密。 1、引入依赖 <dependency><groupId>org.springframework.boot</groupId><artifactId...

解锁数据库简洁之道:FastAPI与SQLModel实战指南

在构建现代Web应用程序时,与数据库的交互无疑是核心环节。虽然传统的数据库操作方式(如直接编写SQL语句与psycopg2交互)赋予了我们精细的控制权,但在面对日益复杂的业务逻辑和快速迭代的需求时,这种方式的开发效率和可…...

R语言速释制剂QBD解决方案之三

本文是《Quality by Design for ANDAs: An Example for Immediate-Release Dosage Forms》第一个处方的R语言解决方案。 第一个处方研究评估原料药粒径分布、MCC/Lactose比例、崩解剂用量对制剂CQAs的影响。 第二处方研究用于理解颗粒外加硬脂酸镁和滑石粉对片剂质量和可生产…...

scikit-learn机器学习

# 同时添加如下代码, 这样每次环境(kernel)启动的时候只要运行下方代码即可: # Also add the following code, # so that every time the environment (kernel) starts, # just run the following code: import sys sys.path.append(/home/aistudio/external-libraries)机…...

Visual Studio Code 扩展

Visual Studio Code 扩展 change-case 大小写转换EmmyLua for VSCode 调试插件Bookmarks 书签 change-case 大小写转换 https://marketplace.visualstudio.com/items?itemNamewmaurer.change-case 选中单词后,命令 changeCase.commands 可预览转换效果 EmmyLua…...

若依登录用户名和密码加密

/*** 获取公钥:前端用来密码加密* return*/GetMapping("/getPublicKey")public RSAUtil.RSAKeyPair getPublicKey() {return RSAUtil.rsaKeyPair();}新建RSAUti.Java package com.ruoyi.common.utils;import org.apache.commons.codec.binary.Base64; im…...

WEB3全栈开发——面试专业技能点P4数据库

一、mysql2 原生驱动及其连接机制 概念介绍 mysql2 是 Node.js 环境中广泛使用的 MySQL 客户端库,基于 mysql 库改进而来,具有更好的性能、Promise 支持、流式查询、二进制数据处理能力等。 主要特点: 支持 Promise / async-await…...