kubeadm安装k8s高可用集群

目录

一、环境规划

二、注意事项:

三、环境准备:

1. 关闭防火墙规则,关闭selinux,关闭swap交换:

2. 修改主机名

3. 所有节点修改hosts文件:

4. 所有节点时间同步:

5. 所有节点实现Linux的资源限制:

6. 所有节点升级内核(可选)

7. 调整内核参数:

8. 加载 ip_vs 模块:

四、所有节点安装docker:

1. 安装:

2. 更改daemon.json配置:

五、安装kubeadm,kubelet和kubectl:

1. 定义kubernetes源:

2. 配置Kubelet使用阿里云的pause镜像:

3. 开机自启kubelet:

六、高可用组件安装、配置:

1. 所有 master 节点部署 Haproxy:

2. 配置haproxy代理:

3. 所有 master 节点部署 keepalived:

4. 配置keepalived 高可用:

5. 编写健康检测脚本:

6. 启动高可用代理集群:

七、部署K8S集群:

1. 在 master01 节点上设置集群初始化配置文件:

2. 更新集群初始化配置文件:

3. 所有节点拉取镜像:

4. master01 节点进行初始化:

5. 修改controller-manager和scheduler配置文件:

6. 部署网络插件flannel:

7. 所有节点加入集群:

7.1 所有master 节点加入集群:

7.2 node 节点加入集群:

8. 查看集群信息:

八、安装Harbor私有仓库:

1. 安装docker:

2. 所有 node 节点都修改配置文件,加上私有仓库配置

3. 安装Harbor:

4. 生成证书:

5. 访问:

一、环境规划

| 服务器类型 | ip地址 |

| master01 | 192.168.30.100 |

| master02 | 192.168.30.200 |

| master03 | 192.168.30.203 |

| node01 | 192.168.30.14 |

| node02 | 192.168.30.15 |

| hub.dhj.com | 192.168.30.104 |

二、注意事项:

master节点cpu核心数要求大于2

最新的版本不一定好,但相对于旧版本,核心功能稳定,但新增功能、接口相对不稳

学会一个版本的 高可用部署,其他版本操作都差不多

宿主机尽量升级到CentOS 7.9

内核kernel升级到 4.19+ 这种稳定的内核

部署k8s版本时,尽量找 1.xx.5 这种大于5的小版本(这种一般是比较稳定的版本)

三、环境准备:

1. 关闭防火墙规则,关闭selinux,关闭swap交换:

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

2. 修改主机名

hostnamectl set-hostname master01

hostnamectl set-hostname master02

hostnamectl set-hostname master03

hostnamectl set-hostname node01

hostnamectl set-hostname node02

3. 所有节点修改hosts文件:

cat >> /etc/hosts << EOF

192.168.30.100 master01

192.168.30.200 master02

192.168.30.203 master03

192.168.30.14 node01

192.168.30.15 node02

EOF4. 所有节点时间同步:

yum -y install ntpdate

ln -sf /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

echo 'Asia/Shanghai' >/etc/timezone

ntpdate time2.aliyun.comsystemctl enable --now crondcrontab -e

*/30 * * * * /usr/sbin/ntpdate time2.aliyun.com

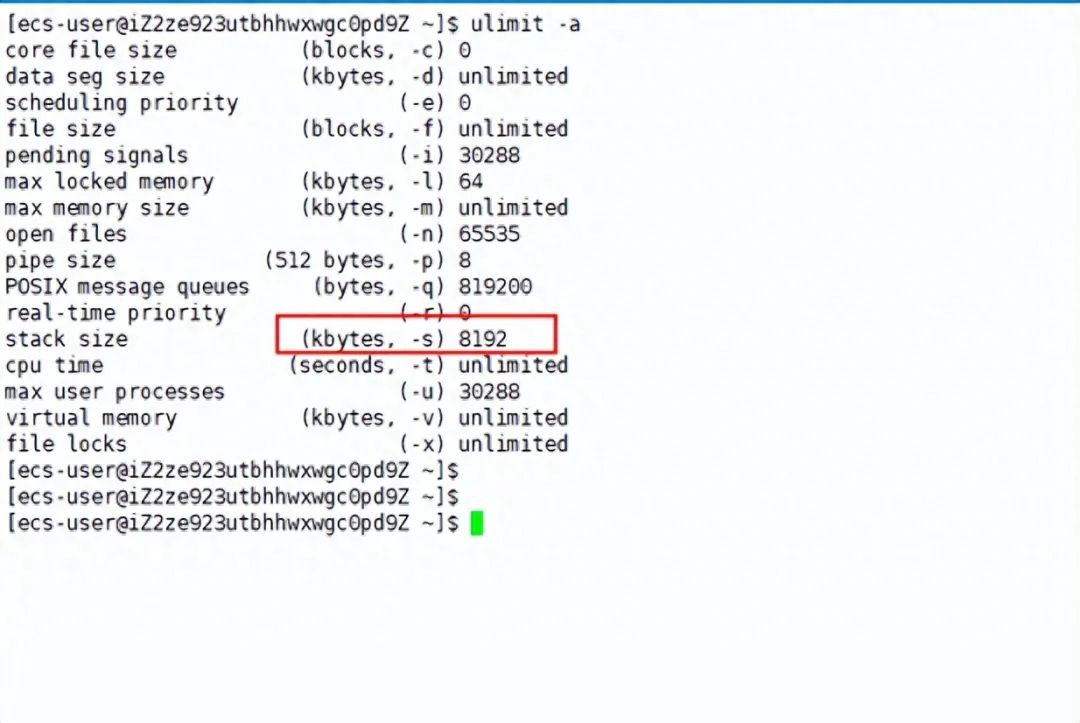

5. 所有节点实现Linux的资源限制:

vim /etc/security/limits.conf

* soft nofile 65536

* hard nofile 131072

* soft nproc 65535

* hard nproc 655350

* soft memlock unlimited

* hard memlock unlimited

6. 所有节点升级内核(可选)

wget http://193.49.22.109/elrepo/kernel/el7/x86_64/RPMS/kernel-ml-devel-4.19.12-1.el7.elrepo.x86_64.rpm -O /opt/kernel-ml-devel-4.19.12-1.el7.elrepo.x86_64.rpm

wget http://193.49.22.109/elrepo/kernel/el7/x86_64/RPMS/kernel-ml-4.19.12-1.el7.elrepo.x86_64.rpm -O /opt/kernel-ml-4.19.12-1.el7.elrepo.x86_64.rpmcd /opt/

yum localinstall -y kernel-ml*#更改内核启动方式

grub2-set-default 0 && grub2-mkconfig -o /etc/grub2.cfg

grubby --args="user_namespace.enable=1" --update-kernel="$(grubby --default-kernel)"

grubby --default-kernel

reboot

7. 调整内核参数:

cat > /etc/sysctl.d/k8s.conf <<EOF

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-ip6tables = 1

fs.may_detach_mounts = 1

vm.overcommit_memory=1

vm.panic_on_oom=0

fs.inotify.max_user_watches=89100

fs.file-max=52706963

fs.nr_open=52706963

net.netfilter.nf_conntrack_max=2310720

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_keepalive_intvl =15

net.ipv4.tcp_max_tw_buckets = 36000

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_orphans = 327680

net.ipv4.tcp_orphan_retries = 3

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.ip_conntrack_max = 65536

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.tcp_timestamps = 0

net.core.somaxconn = 16384

EOF#生效参数

sysctl --system

8. 加载 ip_vs 模块:

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

四、所有节点安装docker:

1. 安装:

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

2. 更改daemon.json配置:

cat > /etc/docker/daemon.json <<EOF

{"registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"],"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "500m", "max-file": "3"}

}

EOF#将docker的资源限制更改为systemd,保持与k8s一致systemctl daemon-reload

systemctl restart docker.service

systemctl enable docker.service

五、安装kubeadm,kubelet和kubectl:

所有节点安装kubeadm,kubelet和kubectl

1. 定义kubernetes源:

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOFyum install -y kubelet-1.20.15 kubeadm-1.20.15 kubectl-1.20.15

2. 配置Kubelet使用阿里云的pause镜像:

cat > /etc/sysconfig/kubelet <<EOF

KUBELET_EXTRA_ARGS="--cgroup-driver=systemd --pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.2"

EOF

3. 开机自启kubelet:

systemctl enable --now kubelet六、高可用组件安装、配置:

1. 所有 master 节点部署 Haproxy:

yum -y install haproxy2. 配置haproxy代理:

cat > /etc/haproxy/haproxy.cfg << EOF

globallog 127.0.0.1 local0 infolog 127.0.0.1 local1 warningchroot /var/lib/haproxypidfile /var/run/haproxy.pidmaxconn 4000user haproxygroup haproxydaemonstats socket /var/lib/haproxy/stats

defaultsmode tcplog globaloption tcplogoption dontlognulloption redispatchretries 3timeout queue 1mtimeout connect 10stimeout client 1mtimeout server 1mtimeout check 10smaxconn 3000

frontend monitor-inbind *:33305mode httpoption httplogmonitor-uri /monitor

frontend k8s-masterbind *:16443 #如果与apiserver部署在同一台机器上监听端口会冲突,更改监听端口mode tcpoption tcplogdefault_backend k8s-master

backend k8s-mastermode tcpoption tcplogoption tcp-checkbalance roundrobinserver k8s-master1 192.168.30.100:6443 check inter 10000 fall 2 rise 2 weight 1server k8s-master2 192.168.30.200:6443 check inter 10000 fall 2 rise 2 weight 1server k8s-master3 192.168.30.203:6443 check inter 10000 fall 2 rise 2 weight 1

EOF

3. 所有 master 节点部署 keepalived:

yum -y install keepalived4. 配置keepalived 高可用:

cd /etc/keepalived/

vim keepalived.conf

! Configuration File for keepalived

global_defs {router_id LVS_HA1

}vrrp_script chk_haproxy {script "/etc/keepalived/check_haproxy.sh"interval 2weight 2

}vrrp_instance VI_1 {state MASTERinterface ens33virtual_router_id 51priority 100advert_int 1virtual_ipaddress {192.168.30.10 #设置VIP地址}track_script {chk_haproxy}

}5. 编写健康检测脚本:

vim check_haproxy.sh

#!/bin/bash

if ! killall -0 haproxy; thensystemctl stop keepalived

fi

chmod +x check_haproxy.sh6. 启动高可用代理集群:

systemctl enable --now haproxy

systemctl enable --now keepalived七、部署K8S集群:

1. 在 master01 节点上设置集群初始化配置文件:

kubeadm config print init-defaults > /opt/kubeadm-config.yamlcd /opt/

vim kubeadm-config.yaml

......

11 localAPIEndpoint:

12 advertiseAddress: 192.168.30.100 #指定当前master节点的IP地址

13 bindPort: 644321 apiServer:

22 certSANs: #在apiServer属性下面添加一个certsSANs的列表,添加所有master节点的IP地址和集群VIP地址

23 - 192.168.30.10

24 - 192.168.30.100

25 - 192.168.30.200

26 - 192.168.30.20330 clusterName: kubernetes

31 controlPlaneEndpoint: "192.168.30.10:16444" #指定集群VIP地址

32 controllerManager: {}38 imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers #指定镜像下载地址

39 kind: ClusterConfiguration

40 kubernetesVersion: v1.20.15 #指定kubernetes版本号

41 networking:

42 dnsDomain: cluster.local

43 podSubnet: "10.244.0.0/16" #指定pod网段,10.244.0.0/16用于匹配flannel默认网段

44 serviceSubnet: 10.96.0.0/16 #指定service网段

45 scheduler: {}

#末尾再添加以下内容

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs #把默认的kube-proxy调度方式改为ipvs模式

2. 更新集群初始化配置文件:

kubeadm config migrate --old-config kubeadm-config.yaml --new-config new.yaml3. 所有节点拉取镜像:

#拷贝yaml配置文件给其他主机,通过配置文件进行拉取镜像

for i in master02 master03 node01 node02; do scp /opt/new.yaml $i:/opt/; donekubeadm config images pull --config /opt/new.yaml

4. master01 节点进行初始化:

kubeadm init --config new.yaml --upload-certs | tee kubeadm-init.log初始化后会出现以下信息用来加入k8s集群:

#提示:

.........

Your Kubernetes control-plane has initialized successfully!To start using your cluster, you need to run the following as a regular user:mkdir -p $HOME/.kubesudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configsudo chown $(id -u):$(id -g) $HOME/.kube/config#这个命令是常规用户身份运行,在master01节点执行此命令

Alternatively, if you are the root user, you can run:export KUBECONFIG=/etc/kubernetes/admin.conf#如果是root用户,在master01节点执行此命令,两种都行,自己选You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:https://kubernetes.io/docs/concepts/cluster-administration/addons/You can now join any number of the control-plane node running the following command on each as root:

#master节点加入使用的命令,记录!kubeadm join 192.168.88.200:16443 --token 7t2weq.bjbawausm0jaxury \--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98 \--control-plane --certificate-key 0f2a7ff2c46ec172f834e237fcca8a02e7c29500746594c25d995b78c92dde96Please note that the certificate-key gives access to cluster sensitive data, keep it secret!

As a safeguard, uploaded-certs will be deleted in two hours; If necessary, you can use

"kubeadm init phase upload-certs --upload-certs" to reload certs afterward.Then you can join any number of worker nodes by running the following on each as root:

#node节点加入使用的命令。记录!

kubeadm join 192.168.88.200:16443 --token 7t2weq.bjbawausm0jaxury \--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98

5. 修改controller-manager和scheduler配置文件:

vim /etc/kubernetes/manifests/kube-scheduler.yaml

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

......#- --port=0 #搜索port=0,把这一行注释掉systemctl restart kubelet所有master节点配置

6. 部署网络插件flannel:

所有节点上传 flannel 镜像 flannel.tar 和网络插件 cni-plugins-linux-amd64-v0.8.6.tgz 到 /opt 目录,master节点上传 kube-flannel.yml 文件

cd /opt

docker load < flannel.tarmv /opt/cni /opt/cni_bak

mkdir -p /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v0.8.6.tgz -C /opt/cni/bin

#注意自己使用的版本kubectl apply -f kube-flannel.yml

7. 所有节点加入集群:

7.1 所有master 节点加入集群:

使用自己的token

kubeadm join 192.168.30.10:16443 --token 7t2weq.bjbawausm0jaxury \--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98 \--control-plane --certificate-key 0f2a7ff2c46ec172f834e237fcca8a02e7c29500746594c25d995b78c92dde96mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

7.2 node 节点加入集群:

kubeadm join 192.168.30.10:16443 --token 7t2weq.bjbawausm0jaxury \--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98

8. 查看集群信息:

#在 master01 查看集群信息

kubectl get nodeskubectl get pod -A八、安装Harbor私有仓库:

新开一台服务器,ip地址为:192.168.30.104

1. 安装docker:

//修改主机名

hostnamectl set-hostname hub.dhj.com//所有节点加上主机名映射

echo '192.168.30.104 hub.dhj.com' >> /etc/hosts//安装 docker

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.iomkdir /etc/docker

cat > /etc/docker/daemon.json <<EOF

{"registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"],"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "100m"},"insecure-registries": ["https://hub.dhj.com"]

}

EOFsystemctl start docker

systemctl enable docker

2. 所有 node 节点都修改配置文件,加上私有仓库配置

cat > /etc/docker/daemon.json <<EOF

{"registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"],"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "100m"},"insecure-registries": ["https://hub.dhj.com"]

}

EOFsystemctl daemon-reload

systemctl restart docker

3. 安装Harbor:

cd /opt/

#上传 harbor-offline-installer-v1.2.2.tgz 和 docker-compose 文件到 /opt 目录

cp docker-compose /usr/local/bin

chmod +x /usr/local/bin/docker-compose

#将docker-compose编排工具复制到bin目录,并添加执行权限tar -zxvf harbor-offline0installer-v1.2.2.tgz

#将harbor包解包cd harbor.cfgvim harbor.cfg

5 hostname = hub.dhj.com

9 ui_url_protocol = https

24 ssl_cert = /data/cert/server.crt

25 ssl_cert_key = /data/cert/server.key

59 harbor_admin_password = Harbor12345

4. 生成证书:

mkdir -p /data/cert

#创建证书目录cd /data/cert

openssl genrsa -des3 -out server.key 2048

#生成私钥

//输入两遍密码:123456openssl req -new -key server.key -out server.csr

#生成证书签名请求文件

//输入私钥密码:123456

//输入国家名:CN

//输入省名:BJ

//输入市名:BJ

//输入组织名:www

//输入机构名:www

//输入域名:hub.wzw.com

//输入管理员邮箱:admin@ydq.com

//其它全部直接回车cp server.key server.key.org

#备份私钥openssl rsa -in server.key.org -out server.key

#清除私钥密码:123456,重新生成一个文件,覆盖以前的带密码的。openssl x509 -req -days 1000 -in server.csr -signkey server.key -out server.crt

#签名证书chmod +x /data/cert/*

#全部添加执行权限

cd /opt/harbor/

./install.sh

#执行脚本

5. 访问:

在本地使用浏览器访问:https://hub.dhj.com添加例外 -> 确认安全例外

用户名:admin

密码:Harbor12345相关文章:

kubeadm安装k8s高可用集群

目录 一、环境规划 二、注意事项: 三、环境准备: 1. 关闭防火墙规则,关闭selinux,关闭swap交换: 2. 修改主机名 3. 所有节点修改hosts文件: 4. 所有节点时间同步: 5. 所有节点实现Linux的资…...

来看看电脑上有哪些不为人知的小众软件?

电脑上的各类软件有很多,除了那些常见的大众化软件,还有很多不为人知的小众软件,专注于实用功能,简洁干净、功能强悍。 1.桌面停靠栏工具——BitDock BitDock是一款运行在Windows系统中的桌面停靠栏工具,功能实…...

一个进程最多可以创建多少个线程?

前言 话不多说,先来张脑图~ linux 虚拟内存知识回顾 虚拟内存空间长啥样 在 Linux 操作系统中,虚拟地址空间的内部又被分为内核空间和用户空间两部分,不同位数的系统,地址空间的范围也不同。比如最常见的 32 位和 64 位系统&am…...

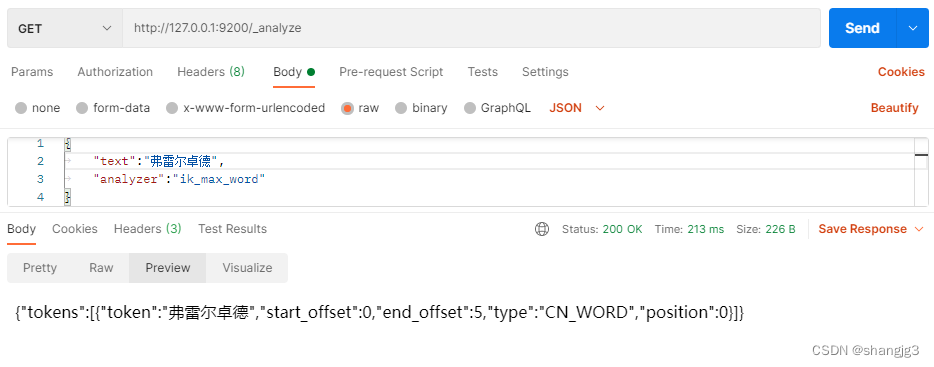

ElasticSearch文档分析

ElasticSearch文档分析 包含下面的过程: 将一块文本分成适合于倒排索引的独立的 词条将这些词条统一化为标准格式以提高它们的“可搜索性”,或者 recall 分析器执行上面的工作。分析器实际上是将三个功能封装到了一个包里: 字符过滤器 首先&a…...

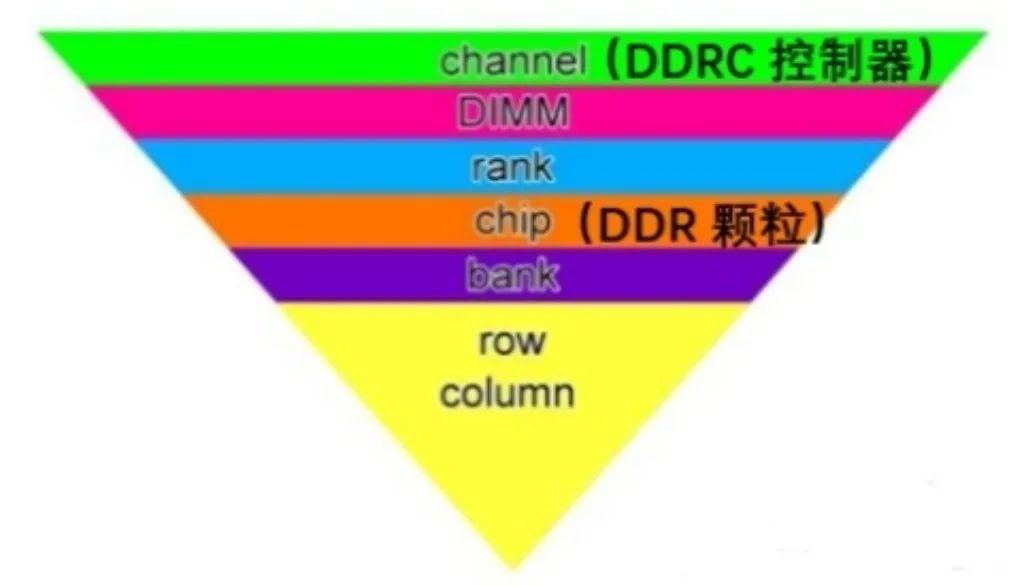

Xilinx FPGA平台DDR3设计详解(一):DDR SDRAM系统框架

DDR SDRAM(双倍速率同步动态随机存储器)是一种内存技术,它可以在时钟信号的上升沿和下降沿都传输数据,从而提高数据传输的速率。DDR SDRAM已经发展了多代,包括DDR、DDR2、DDR3、DDR4和DDR5,每一代都有不同的…...

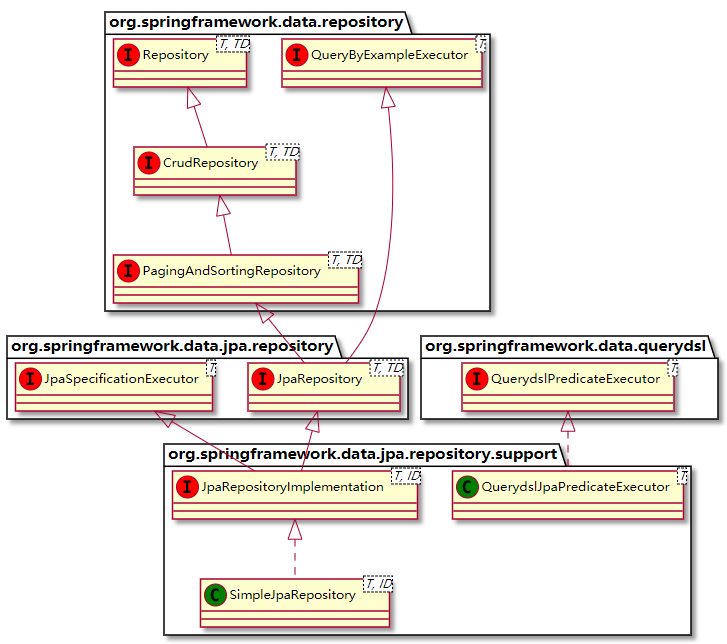

Spring Data JPA方法名命名规则

最近巩固一下JPA,网上看到这些资料,这里记录巩固一下。 一、Spring Data Jpa方法定义的规则 简单条件查询 简单条件查询:查询某一个实体类或者集合。 按照Spring Data的规范的规定,查询方法以find | read | get开头&…...

【Leetcode Sheet】Weekly Practice 15

Leetcode Test 2586 统计范围内的元音字符串数(11.7) 给你一个下标从 0 开始的字符串数组 words 和两个整数:left 和 right 。 如果字符串以元音字母开头并以元音字母结尾,那么该字符串就是一个 元音字符串 ,其中元音字母是 a、e、i、o、u…...

人力资源社会保障部办公厅关于推行专业技术人员职业资格电子证书的通知

(人社厅发〔2021〕97号) 各省、自治区、直辖市及新疆生产建设兵团人力资源社会保障厅(局),中共海南省委人才发展局,国务院有关部门、直属机构人事部门,有关协会、学会: 为贯彻落实…...

什么是光电耦合器?如何选择型号及种类

光电耦合器(英文缩写为OC)亦称光电隔离器,简称光耦;以光为媒介传输电信号;它对输入、输出电信号有良好的隔离作用,是目前种类最多、用途最广的光电器件之一;所以,它在各种电路中得到广泛的应用。 光耦合器…...

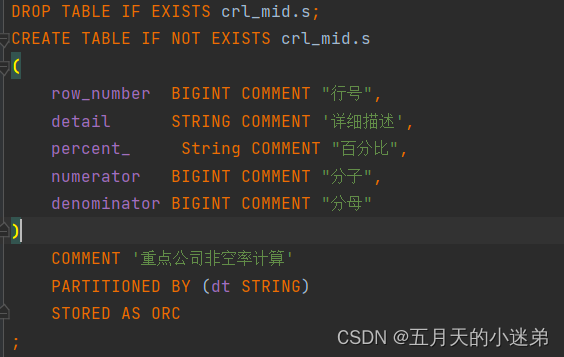

hive里因为列名用了关键字导致建表失败

代码 现象 ParseException line 6:4 cannot recognize input near percent String COMMENT in column name or primary key or foreign key 23/11/13 11:52:57 ERROR org.apache.hadoop.hive.ql.Driver: FAILED: ParseException line 6:4 cannot recognize input near percent …...

MySQL 报错 incorrect datetime value ‘0000-00-00 00:00:00‘ for column

使用navicat导入数据时报错: MySQL 报错 incorrect datetime value ‘0000-00-00 00:00:00’ for column 这是因为当前的MySQL不支持datetime为0的情况。 MySQL报incorrect datetime value ‘0000-00-00 00:00:00’ for column错误原因,是由于在MySQL5.7…...

升级操作)

Jira Data Center(非集群)升级操作

一、升级准备 Jira 管理界面执行升级检查下载升级包,使用原操作方式相同的方式安装。我这里原来的版本是通过./atlassian-jira-software-9.11.2-x64.bin安装的,接下来下载atlassian-jira-software-9.11.3-x64.bin的安装文件停止 Jira,bin/st…...

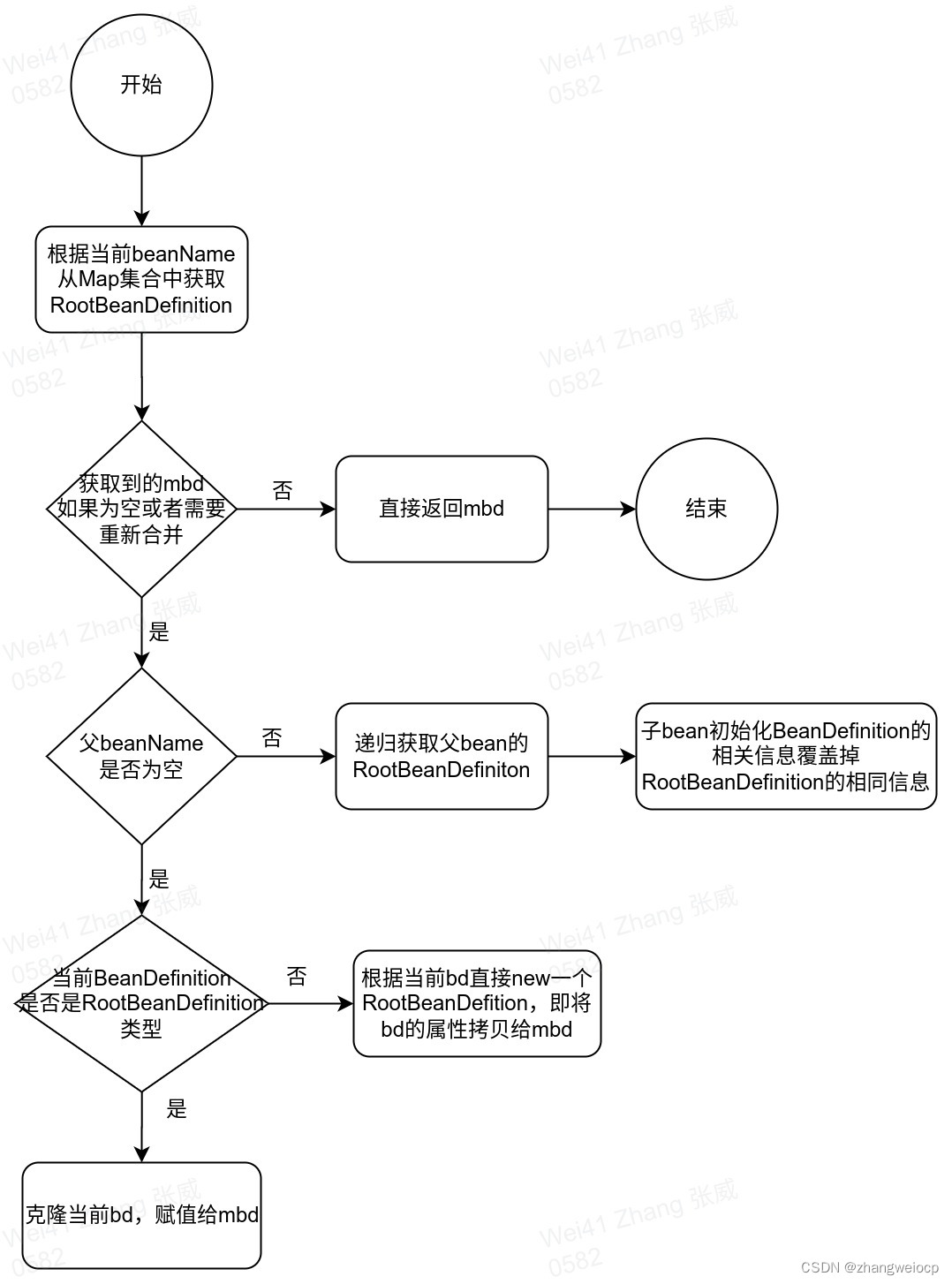

Spring IOC - BeanDefinition解析

1. BeanDefinition的属性 BeanDefinition作为接口定义了属性的get、set方法。这些属性基本定义在其直接实现类AbstractBeanDefinition中,各属性的含义如下表所示: 类型 名称 含义 常量 SCOPE_DEFAULT 默认作用域:单例模式 AUT…...

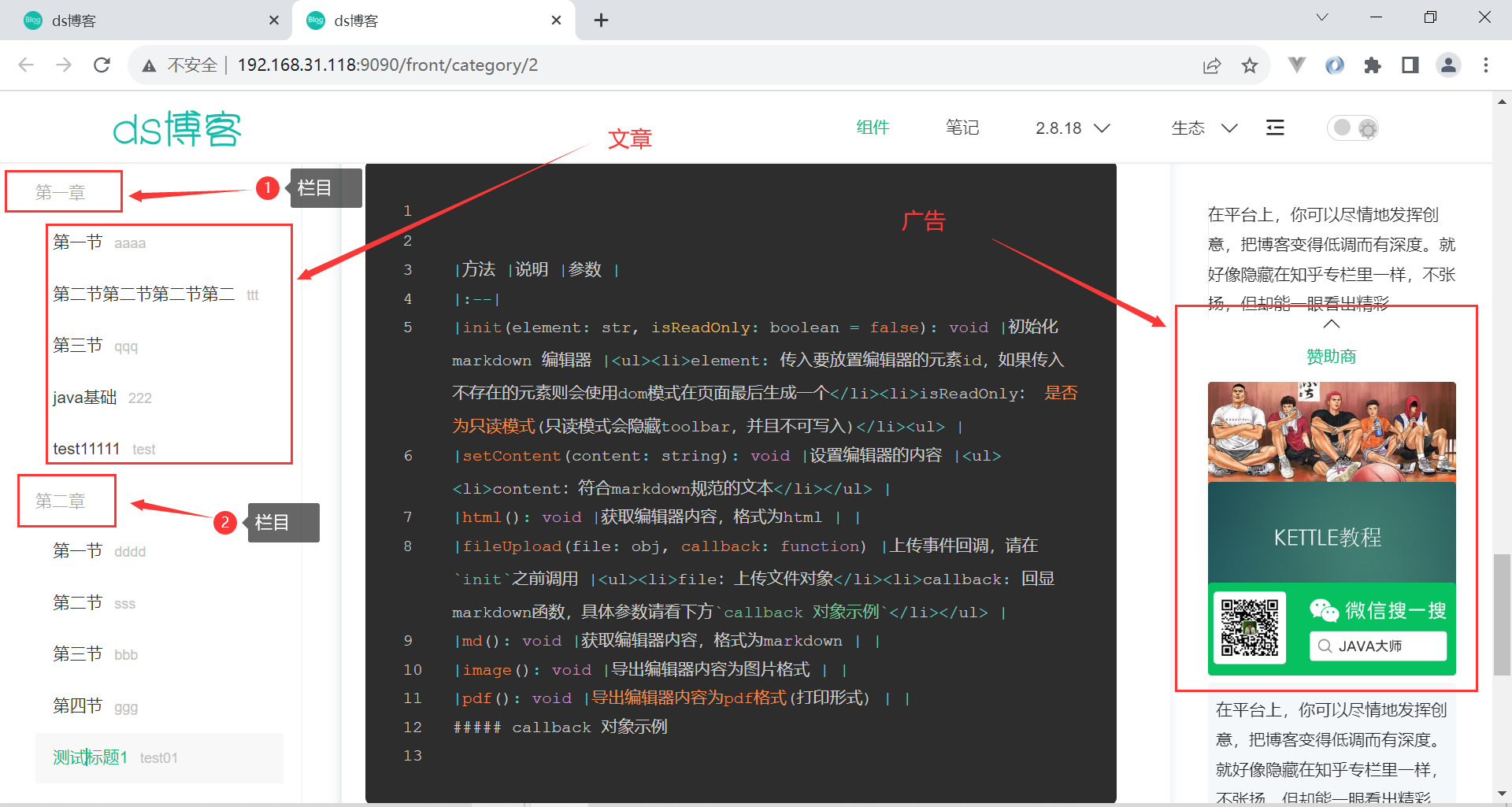

ds前后台博客系统

源码私信或者公众号java大师获取 博客简介:本博客采用Spring Boot LayUI做为基础,进行的博客系统开发,与bootvue相比,更为适合开发简单的系统,并且更容易上手,简单!高效!更易上手&a…...

)

算法leetcode|88. 合并两个有序数组(rust重拳出击)

文章目录 88. 合并两个有序数组:样例 1:样例 2:样例 3:提示: 分析:题解:rust:go:c:python:java: 88. 合并两个有序数组: …...

GoLong的学习之路,进阶,语法之并发(并发错误处理)补充并发三部曲

这篇文章主要讲的是如何去处理并发的错误。 在Go语言中十分便捷地开启goroutine去并发地执行任务,但是如何有效的处理并发过程中的错误则是一个很棘手的问题。 文章目录 recovererrgroup recover 哦对,似乎没写错误处理的文章。后面补上。 首先&…...

猪酒店房价采集

<?php // 设置代理 $proxy_host jshk.com.cn;// 创建一个cURL资源 $ch curl_init();// 设置代理 curl_setopt($ch, CURLOPT_PROXY, $proxy_host.:.$proxy_port);// 连接URL curl_setopt($ch, CURLOPT_URL, "http://www.zujia.com/");// 发送请求并获取HTML文档…...

Java基础知识第四讲:Java 基础 - 深入理解泛型机制

Java 基础 - 深入理解泛型机制 背景:Java泛型这个特性是从JDK 1.5才开始加入的,为了兼容之前的版本,Java泛型的实现采取了“伪泛型”的策略,即Java在语法上支持泛型,但是在编译阶段会进行所谓的“类型擦除”࿰…...

ceph-deploy bclinux aarch64 ceph 14.2.10【2】vdbench rbd 块设备rbd 测试失败

上篇 ceph-deploy bclinux aarch64 ceph 14.2.10-CSDN博客 安装vdbench 下载vdbench 下载页面 Vdbench Downloads (oracle.com) 包下载 需要账号登录,在弹出层点击同意才能继续下载 用户手册 https://download.oracle.com/otn/utilities_drivers/vdbench/vdb…...

split_train_val

# coding:utf-8 import os import random import argparse parser argparse.ArgumentParser() # xml文件的地址,根据自己的数据进行修改 xml一般存放在Annotations下 parser.add_argument(--xml_path, defaultdata_door_white/xml/train, typestr, helpinput xm…...

边缘计算医疗风险自查APP开发方案

核心目标:在便携设备(智能手表/家用检测仪)部署轻量化疾病预测模型,实现低延迟、隐私安全的实时健康风险评估。 一、技术架构设计 #mermaid-svg-iuNaeeLK2YoFKfao {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg…...

Vue3 + Element Plus + TypeScript中el-transfer穿梭框组件使用详解及示例

使用详解 Element Plus 的 el-transfer 组件是一个强大的穿梭框组件,常用于在两个集合之间进行数据转移,如权限分配、数据选择等场景。下面我将详细介绍其用法并提供一个完整示例。 核心特性与用法 基本属性 v-model:绑定右侧列表的值&…...

令牌桶 滑动窗口->限流 分布式信号量->限并发的原理 lua脚本分析介绍

文章目录 前言限流限制并发的实际理解限流令牌桶代码实现结果分析令牌桶lua的模拟实现原理总结: 滑动窗口代码实现结果分析lua脚本原理解析 限并发分布式信号量代码实现结果分析lua脚本实现原理 双注解去实现限流 并发结果分析: 实际业务去理解体会统一注…...

【Zephyr 系列 10】实战项目:打造一个蓝牙传感器终端 + 网关系统(完整架构与全栈实现)

🧠关键词:Zephyr、BLE、终端、网关、广播、连接、传感器、数据采集、低功耗、系统集成 📌目标读者:希望基于 Zephyr 构建 BLE 系统架构、实现终端与网关协作、具备产品交付能力的开发者 📊篇幅字数:约 5200 字 ✨ 项目总览 在物联网实际项目中,**“终端 + 网关”**是…...

CMake控制VS2022项目文件分组

我们可以通过 CMake 控制源文件的组织结构,使它们在 VS 解决方案资源管理器中以“组”(Filter)的形式进行分类展示。 🎯 目标 通过 CMake 脚本将 .cpp、.h 等源文件分组显示在 Visual Studio 2022 的解决方案资源管理器中。 ✅ 支持的方法汇总(共4种) 方法描述是否推荐…...

零基础在实践中学习网络安全-皮卡丘靶场(第九期-Unsafe Fileupload模块)(yakit方式)

本期内容并不是很难,相信大家会学的很愉快,当然对于有后端基础的朋友来说,本期内容更加容易了解,当然没有基础的也别担心,本期内容会详细解释有关内容 本期用到的软件:yakit(因为经过之前好多期…...

保姆级教程:在无网络无显卡的Windows电脑的vscode本地部署deepseek

文章目录 1 前言2 部署流程2.1 准备工作2.2 Ollama2.2.1 使用有网络的电脑下载Ollama2.2.2 安装Ollama(有网络的电脑)2.2.3 安装Ollama(无网络的电脑)2.2.4 安装验证2.2.5 修改大模型安装位置2.2.6 下载Deepseek模型 2.3 将deepse…...

A2A JS SDK 完整教程:快速入门指南

目录 什么是 A2A JS SDK?A2A JS 安装与设置A2A JS 核心概念创建你的第一个 A2A JS 代理A2A JS 服务端开发A2A JS 客户端使用A2A JS 高级特性A2A JS 最佳实践A2A JS 故障排除 什么是 A2A JS SDK? A2A JS SDK 是一个专为 JavaScript/TypeScript 开发者设计的强大库ÿ…...

音视频——I2S 协议详解

I2S 协议详解 I2S (Inter-IC Sound) 协议是一种串行总线协议,专门用于在数字音频设备之间传输数字音频数据。它由飞利浦(Philips)公司开发,以其简单、高效和广泛的兼容性而闻名。 1. 信号线 I2S 协议通常使用三根或四根信号线&a…...

安全突围:重塑内生安全体系:齐向东在2025年BCS大会的演讲

文章目录 前言第一部分:体系力量是突围之钥第一重困境是体系思想落地不畅。第二重困境是大小体系融合瓶颈。第三重困境是“小体系”运营梗阻。 第二部分:体系矛盾是突围之障一是数据孤岛的障碍。二是投入不足的障碍。三是新旧兼容难的障碍。 第三部分&am…...