Kafka 面试题及答案整理,最新面试题

Kafka中的Producer API是如何工作的?

Kafka中的Producer API允许应用程序发布一流的数据到一个或多个Kafka主题。它的工作原理包括:

1、创建Producer实例: 通过配置Producer的各种属性(如服务器地址、序列化方式等)来创建Producer实例。

2、发送消息: 使用Producer实例的send方法发送消息。消息被封装成一个ProducerRecord对象,包括主题、可选的分区、键和值。

3、消息序列化: Producer通过配置的序列化器将键和值转换为字节流,以便它们可以被传输到Kafka服务器。

4、分区分配: 如果没有指定分区,Producer会基于键(如果有的话)来决定消息应该发送到哪个分区。

5、网络传输: 消息通过网络发送到Kafka集群,由Broker处理。

6、确认和重试: 根据配置,Producer可以等待Broker的确认。如果发送失败,它还可以重试发送。

7、关闭Producer: 发送完所有消息后,应关闭Producer以释放资源。

Kafka的消费者群组是如何工作的?

Kafka中的消费者群组包含多个消费者实例,共同消费一个或多个主题的消息。它们的工作机制如下:

1、群组协调: 每个消费者群组有一个群组协调器负责维护群组成员信息和分配分区。

2、分区分配策略: Kafka支持多种分区分配策略,用于决定每个消费者消费哪些分区的消息。

3、消费者心跳检测: 消费者定期向群组协调器发送心跳,以表明它们是活跃的。

4、再均衡: 当新消费者加入群组、离开群组或存在消费者失败时,会触发再均衡过程,重新分配分区给群组内的消费者。

5、消息消费: 消费者从分配给它的分区中拉取消息并处理。

6、偏移量提交: 消费者处理完消息后,会提交偏移量,以便在失败重启后能够从上次处理的位置继续消费。

Kafka的Broker是什么,它如何工作?

Kafka的Broker是Kafka架构中的一个核心组件,是一个独立的服务器节点,负责存储数据和处理客户端请求。Broker的工作原理如下:

1、存储消息: Broker存储生产者发送的消息,并保持消息到达顺序。

2、分区管理: Broker维护了主题的分区,并可能是分区的领导者或追随者。

3、处理请求: Broker处理生产者的消息发送请求和消费者的消息拉取请求。

4、复制管理: 在集群环境中,Broker会复制数据到其他Broker,以确保高可用性。

5、垃圾回收: 根据配置的保留策略,Broker会定期删除过期的消息。

6、群组协调: Broker可以作为消费者群组的协调器,管理消费者群组的成员和分区分配。

Kafka中的Topic是什么,它是如何工作的?

Kafka中的Topic是消息的分类名,它是Kafka中数据传输和存储的基本单位。Topic的工作机制如下:

1、消息分类: 生产者将消息发送到特定的Topic,消费者从Topic拉取消息。

2、分区机制: 每个Topic可以被分成多个分区,分区可以跨多个Broker分布,增加并发处理能力。

3、持久化存储: Topic中的消息被持久化存储在Broker上,支持配置保留策略。

4、分布式: Topic的分区可以分布在不同的Broker上,提供故障隔离和负载均衡。

5、可扩展性: 可以根据需要增加Topic的分区数量,以适应更高的吞吐量需求。

Kafka中的消费者如何保证消息的顺序性?

Kafka中的消费者保证消息顺序性的机制主要依靠以下几点:

1、分区顺序: Kafka保证单个分区内消息的顺序,但不保证跨分区的顺序。

2、单线程消费: 为保持分区内消息的顺序,通常建议对每个分区使用单独的消费者线程。

3、控制并发: 在消费多个分区时,可以通过控制并发级别来减少顺序错乱的可能性。

4、偏移量管理: 正确管理偏移量,确保在失败重启时能够从正确的位置继续消费。

5、同步处理: 对于需要严格顺序的场景,同步处理消息,确保在处理下一条消息之前完成当前消息的处理。

Kafka的ISR(In-Sync Replicas)机制是如何工作的?

Kafka的ISR机制是一种保证数据一致性和高可用性的机制。它的工作原理如下:

1、复制机制: 每个分区有一个领导者和多个追随者。所有的读写操作都是通过领导者来进行的。

2、同步副本集: ISR是指与领导者保持同步的副本集。只有当追随者与领导者的数据差距在可接受范围内时,追随者才能成为ISR的一部分。

3、写入确认: 当生产者发送消息到领导者,领导者复制数据到所有ISR成员后,才认为写入操作完成。

4、领导者选举: 如果领导者失败,将从ISR中选举新的领导者,以保持服务的可用性。

5、高数据一致性: 通过确保所有同步的副本都有最新的数据,Kafka实现了高数据一致性。

Kafka中如何实现消息的幂等性和事务性?

Kafka支持消息的幂等性和事务性,以提供更可靠的消息传输。这是如何实现的:

1、幂等性生产者: Kafka的幂等性生产者可以防止在网络重试过程中造成的消息重复。这是通过在Producer端为每个消息分配一个序列号来实现的。Broker端使用序列号来识别和删除重复的消息。

2、事务支持: Kafka允许在生产者端开始事务,这样可以保证多个消息要么全部成功发送要么全部失败。

3、跨分区事务: Kafka事务支持跨分区和跨主题的消息发送,使得整个消息批次的处理可以原子化。

4、精确的一次处理: 结合幂等性和事务性,Kafka可以实现精确的一次消息传输,这意味着消息即使在失败重试的情况下也不会被重复处理。

Kafka中,什么是消费者位移(Consumer Offset)?

消费者位移(Consumer Offset)在Kafka中代表消费者在分区中已经成功消费的消息的位置。它的作用包括:

1、跟踪消费进度: 消费者位移用于记录每个消费者在每个分区中已经消费到的消息位置。

2、故障恢复: 当消费者失败并重启后,可以根据存储的位移重新开始消费,确保不丢失消息也不重复消费。

3、提交位移: 消费者处理完消息后,会定期或按照配置的策略提交位移。

4、位移存储: 位移可以存储在Kafka内部的__consumer_offsets主题中,或者存储在外部系统中。

Kafka的日志压缩(Log Compaction)特性是什么?

Kafka的日志压缩(Log Compaction)是一种特殊的消息保留策略,它的特点和工作原理如下:

1、保留最新消息: 日志压缩确保保留每个键的最新消息,而不是简单地基于时间来删除旧消息。

2、优化存储: 这种策略适用于需要保持最新状态的场景,如配置信息、持久化数据等,可以优化存储并减少重复数据。

3、压缩过程: 在压缩过程中,Kafka将删除具有相同键的旧消息,只保留每个键的最新消息。

4、与时间保留策略共存: 日志压缩可以与基于时间的消息过期策略共同工作,为不同需求提供灵活性。

Kafka中,如何配置和使用消费者组来实现消息的负载均衡?

在Kafka中,使用消费者组实现消息的负载均衡涉及以下步骤:

1、创建消费者组: 通过在不同消费者实例上设置相同的group.id属性,它们就会自动形成一个消费者组。

2、分区分配: Kafka自动将Topic的分区分配给消费者组中的各个消费者,以实现负载均衡。

3、配置消费者: 配置消费者的各种属性,如自动位移提交间隔、拉取策略等。

4、处理消息: 每个消费者独立消费分配给它的分区,并处理其中的消息。

5、再均衡监听: 可以配置消费者对再均衡事件做出响应,如在再均衡开始前提交位移。

6、监控和调优: 监控消费者组的性能,根据需要调整分区数量和消费者数量,以优化负载均衡效果。

Kafka中的Leader选举机制是如何工作的?

在Kafka中,Leader选举是关键的机制,用于在分区的多个副本(Replicas)之间选举出一个领导者(Leader)。这个机制的工作原理如下:

1、角色定义: 每个分区有一个Leader和多个Follower。所有的读写请求都由Leader处理,然后数据被复制到Followers。

2、选举触发: 当当前的Leader失效时,如服务器崩溃或网络问题,将触发Leader选举。

3、ZooKeeper协调: 在传统的Kafka设置中,ZooKeeper用于管理Broker和Leader选举。

4、选举过程: 选举过程中,ZooKeeper或Kafka的内部控制器选择一个当前同步的Follower作为新的Leader。

5、ISR参与: 通常,新的Leader会从ISR(In-Sync Replicas)列表中选出,确保数据的一致性。

6、客户端更新: 完成选举后,客户端(Producers和Consumers)被通知新的Leader,以便更新它们的连接。

Kafka中配置和优化Producer的性能?

在Kafka中配置和优化Producer的性能涉及多个方面,包括:

1、批处理设置: 通过增加batch.size和linger.ms,可以使Producer积累更多的消息进行批量发送,提高吞吐量。

2、压缩机制: 启用消息压缩(如compression.type设置为snappy或gzip),可以减少网络传输量和存储占用。

3、缓冲区大小: 调整buffer.memory,为Producer分配更多内存,以便缓存即将发送的消息。

4、ACK级别: 配置acks参数(如设置为all),可以增强数据的持久性,但可能影响吞吐量。

5、重试策略: 合理配置retries和retry.backoff.ms,可以在发送失败时进行重试,而不是立即失败。

6、分区策略: 根据业务需求选择合适的分区策略,以均衡地分配消息到不同的分区。

Kafka的Exactly-Once语义是什么,如何实现?

Kafka的Exactly-Once语义指的是系统保证每条消息即使在重试的情况下也只被处理一次。实现这一语义的关键要素包括:

1、幂等性Producer: 通过在Producer端配置enable.idempotence=true,Producer可以防止因重试导致的消息重复。

2、事务管理: Kafka支持跨多个分区和主题的事务,可以通过在Producer端开始事务,确保一组消息要么全部成功,要么全部失败。

3、消费者偏移量提交: 结合幂等性Producer和事务,消费者在处理完消息后提交偏移量,确保消息即使在重启或失败后也不会被重复处理。

4、Broker配置: Kafka集群需要配置为支持事务,如设置transaction.state.log.replication.factor和transaction.state.log.min.isr。

Kafka Connect是什么,它是如何工作的?

Kafka Connect是一个工具,用于在Kafka和其他系统(如数据库、日志系统等)之间可靠地传输数据。它的工作原理包括:

1、连接器类型: Kafka Connect支持Source Connectors(从外部系统导入数据到Kafka)和Sink Connectors(从Kafka导出数据到外部系统)。

2、配置驱动: Kafka Connect基于配置文件运行,这些配置文件定义了连接器的行为、连接的目标系统以及数据如何映射和转换。

3、分布式和可扩展: Kafka Connect可以以分布式模式运行,易于扩展和管理。

4、数据转换: 提供了数据转换的功能,可以在数据进入Kafka或从Kafka导出时对其进行转换和处理。

5、容错性: Kafka Connect设计为容错的,它可以自动处理连接失败、重试和错误处理。

Kafka Streams是什么,其主要特点是什么?

Kafka Streams是一个客户端库,用于构建实时应用程序和微服务,其主要特点包括:

1、流处理: Kafka Streams支持实时的数据流处理。

2、易于使用: 提供了简单而强大的API,使得开发者可以轻松构建流处理应用。

3、无需独立集群: 作为一个库,Kafka Streams可以在应用程序中直接集成,不需要单独的处理集群。

4、状态管理: 支持状态和状态存储,使得应用可以处理有状态的计算。

5、容错性和可扩展性: Kafka Streams应用具有容错性和可扩展性,可以处理大规模的数据流。

Kafka中的消费者拉取(Polling)机制是如何工作的?

Kafka中消费者的拉取(Polling)机制涉及以下几个关键步骤:

1、长轮询: Kafka消费者使用长轮询机制从Broker拉取消息,这意味着如果当前没有可用的消息,请求会等待直到有新消息到达。

2、偏移量管理: 消费者维护一个偏移量,表明下一条要读取的消息。每次拉取操作都会更新这个偏移量。

3、消费者组协调: 在消费者组中,每个消费者负责拉取分配给它的分区中的消息。

4、控制拉取速率: 消费者可以控制每次拉取的消息数量和总体的拉取频率,以匹配处理能力。

5、心跳检测: 消费者定期发送心跳到群组协调器,以维持其群组成员资格和分区分配。

Kafka中的主题复制因子(Replication Factor)的作用是什么?

在Kafka中,主题的复制因子(Replication Factor)指定了每个分区的副本数量。其主要作用包括:

1、数据可靠性: 通过在不同的Broker上维护多个副本,即使部分Broker失败,仍然可以保证数据不丢失。

2、故障转移: 当分区的Leader副本失败时,可以从Follower副本中选择一个新的Leader,确保服务的连续性。

3、读取负载均衡: 虽然所有写操作都经过Leader,读操作可以分散到所有副本,提高读取的并发能力。

4、配置灵活性: 根据数据重要性和可用性需求,可以为不同的主题配置不同的复制因子。

如何监控和调优Kafka集群的性能?

监控和调优Kafka集群的性能涉及以下关键方面:

1、监控指标: 关注重要的性能指标,如吞吐量、延迟、消费者和生产者性能、系统资源利用率等。

2、日志级别和审计: 调整Broker的日志记录级别,进行问题诊断和性能分析。

3、JVM调优: 对Kafka运行的JVM进行调优,优化内存管理和垃圾回收。

4、网络和磁盘IO: 优化网络设置和磁盘使用,以提高数据传输效率和降低延迟。

5、分区策略: 合理分配分区数量和分区分布,以均衡负载和提高容错能力。

6、Producer和Consumer配置: 根据需求调整生产者和消费者的配置,如批处理大小、压缩类型、拉取策略等。

Kafka中,如何处理死信队列(Dead Letter Queue)?

在Kafka中处理死信队列(Dead Letter Queue,DLQ)通常涉及以下步骤:

1、定义死信队列: 创建一个专用的Kafka主题作为DLQ,用于存储无法正常处理的消息。

2、生产者异常处理: 在生产者端,配置异常处理逻辑,当发送消息失败时,将消息发送到DLQ。

3、消费者异常处理: 在消费者端,当处理消息失败时,比如因为格式错误、业务逻辑异常等,将该消息发送到DLQ。

4、监控和报警: 监控DLQ的大小和增长速度,设置报警机制以便及时响应问题。

5、错误分析和处理: 定期分析DLQ中的消息,确定失败原因,并采取相应的修复措施。

Kafka中的ZooKeeper是什么角色,它是如何工作的?

在Kafka中,ZooKeeper扮演着关键的协调和配置管理角色。它的工作原理包括:

1、集群管理: ZooKeeper存储有关所有Kafka Broker的信息,如它们的状态和元数据。

2、Leader选举: ZooKeeper协助进行分区的Leader选举。

3、配置存储: 存储有关主题、分区等的配置信息。

4、服务发现: Kafka Broker和客户端使用ZooKeeper来发现集群中的其他节点。

5、协调和锁: ZooKeeper用于管理分布式锁和进行集群协调,确保元数据的一致性。

6、故障检测: 通过心跳机制和临时节点,ZooKeeper能够检测并响应Broker故障。

Kafka中的分区机制是如何工作的?

Kafka中的分区机制是其核心功能之一,它允许数据在多个服务器之间进行分布。这个机制的工作原理如下:

1、数据分散和伸缩性: 在Kafka中,每个主题可以分成多个分区,每个分区可以存储不同的数据。这种方式使得数据可以分布在集群的多个服务器上,增加了伸缩性和容错性。

2、提高吞吐量: 通过在多个分区间并行处理数据,Kafka能够提高消息处理的吞吐量。

3、消费者群组: 消费者可以从一个或多个分区读取数据。在一个消费者群组中,每个消费者负责读取特定分区的数据,确保每条消息只被群组内的一个消费者处理。

4、分区和复制: Kafka提供了数据的复制功能,每个分区可以有一个或多个副本。这确保了即使某些服务器故障,数据也不会丢失。

5、负载平衡: Kafka的分区机制也有助于负载平衡,分散了客户端和服务器之间的数据流量和存储压力。

Kafka中如何保证消息的顺序性?

在Kafka中,保证消息顺序性主要依赖以下几个关键点:

1、单个分区内的顺序性: Kafka只能保证在单个分区内的消息是有序的。生产者发送的消息会按照它们被发送的顺序存储在分区中。

2、分区级别的并发写入: 同一个分区内的消息按照到达顺序排列,但不同分区之间的消息是独立的,因此不保证跨分区的顺序。

3、消息键: 生产者可以为消息指定一个键,Kafka根据键的哈希将消息路由到特定的分区。具有相同键的消息将被发送到同一个分区,从而保证这些消息的顺序。

4、消费者处理: 消费者从分区中按顺序读取消息,保证了处理消息的顺序性。

Kafka消费者在消费过程中,如何处理分区再平衡?

Kafka消费者处理分区再平衡的机制涉及以下几个关键步骤:

1、触发再平衡: 当新的消费者加入消费者群组、现有消费者离开群组或者主题的分区数发生变化时,会触发分区再平衡。

2、停止消息消费: 分区再平衡开始时,消费者会停止消费消息。

3、分区重新分配: Kafka群集负责重新分配分区给群组内的消费者。

4、偏移量提交: 在再平衡之前,消费者会提交它所处理的最后一条消息的偏移量。

5、恢复消费: 一旦分区再平衡完成,消费者会开始从最新的偏移量开始消费新分配的分区。

Kafka生产者如何实现消息的批量发送?

Kafka生产者实现消息批量发送的机制如下:

1、批量设置: 生产者在发送消息时可以通过配置批量大小(batch.size)和延时(linger.ms)来控制消息的批量发送。

2、缓冲区累积: 生产者会将要发送的消息存储在内部缓冲区中。当缓冲区的数据达到设定的批量大小或者达到延时时间时,批量的消息将被发送。

3、网络效率提高: 通过批量发送,可以减少网络请求的次数,提高网络传输效率。

4、可配置性: 生产者可以根据需要调整批量大小和延时,以在延迟和吞吐量之间做出最佳平衡。

Kafka中的ISR(In-Sync Replicas)机制是如何工作的?

Kafka中的ISR机制工作原理如下:

1、副本同步: ISR是指那些与领导者副本保持同步的跟随者副本集合。

2、保证数据一致性: 只有当所有的ISR副本都成功复制了消息,该消息才被认为是提交的,确保了数据的一致性。

3、动态维护: 如果跟随者副本落后于领导者副本过多,它将被从ISR中移除。如果它追上来了,可以重新加入ISR。

4、最小ISR大小: 可以配置最小ISR大小,以保证高可用性和数据的耐久性。

Kafka中,如何配置和使用消费者群组?

在Kafka中配置和使用消费者群组涉及以下几个步骤:

1、创建消费者实例: 首先需要创建消费者实例,并配置群组ID。

2、订阅主题: 消费者可以订阅一个或多个主题。

3、分区分配策略: 消费者群组可以配置分区分配策略,如范围分配或轮询分配。

4、开始消费: 消费者开始消费消息,并处理消息。

5、偏移量管理: 消费者需要定期提交偏移量,以记录其在每个分区的读取进度。

Kafka中的Exactly Once语义是如何实现的?

Kafka实现Exactly Once语义的机制包括:

1、幂等生产者: Kafka的生产者可以被配置为幂等的,这意味着即使发送相同的消息多次,也只会被处理一次。

2、事务管理: Kafka支持跨多个分区的事务,确保消息要么全部成功写入,要么全部失败。

3、消费者偏移量提交: 消费者处理完消息后,会提交偏移量。如果处理过程中出现问题,它可以从上次提交的偏移量重新开始,避免消息重复处理。

4、端到端的支持: 为了实现端到端的Exactly Once语义,生产者、代理和消费者之间需要协同工作。

Kafka消息的保留策略有哪些,它是如何工作的?

Kafka中的消息保留策略主要有两种:基于时间和基于大小。这些策略的工作机制如下:

1、基于时间的保留: 可以为每个主题配置消息保留时间(log.retention.hours),超过这个时间的消息会被自动删除。

2、基于大小的保留: 也可以配置每个主题的最大存储大小(log.retention.bytes),当主题的大小超过这个阈值时,最旧的消息会被删除。

3、日志压缩: 除了上述两种策略,还可以启用日志压缩(log.cleanup.policy设为compact),这将保留每个键的最新消息。

4、混合策略: 在实际应用中,可以结合时间和大小的保留策略,以满足不同的存储和性能需求。

5、删除机制: Kafka定期执行后台线程来清理过期的消息,保证主题不会超过配置的大小或时间限制。

Kafka中的Offset和Consumer Group之间的关系是什么?

在Kafka中,Offset(偏移量)和Consumer Group(消费者组)之间的关系至关重要,它们协同工作以确保消息的正确消费:

1、偏移量追踪: 每个消费者组内的消费者实例会追踪它所消费的每个分区中的偏移量。

2、消费状态维护: 通过记录偏移量,消费者组能够知道每个成员已经消费到哪个位置,从而在消费者重启或发生故障时能够从上次消费的位置继续消费。

3、分区分配: 消费者组中的消费者通常被分配不同的分区,每个消费者独立维护自己负责分区的偏移量。

4、平衡和同步: 当消费者组中的成员变化时(如新消费者加入或现有消费者退出),会触发再均衡,偏移量信息帮助新的分区分配保持消息消费的连续性。

5、偏移量提交: 消费者读取并处理完消息后,会定期提交它们的偏移量到Kafka,这样即使消费者失败,也能从正确的位置重新开始消费。

Kafka中实现高可用性有哪些关键考虑因素?

在Kafka中实现高可用性需要考虑以下几个关键因素:

1、副本因子: 为关键主题配置高副本因子(通常至少是3),以确保即使有Broker失败,也能从副本中恢复数据。

2、Broker和Controller的冗余: 在Kafka集群中部署足够数量的Broker,确保Controller的高可用性。

3、跨机架部署: 将Broker分布在不同的机架或数据中心,以防止单点故障。

4、合理的负载分配: 平衡分区和副本在Broker之间的分配,避免个别Broker过载。

5、监控和故障转移: 实施有效的监控策略,及时发现并处理故障,包括自动或手动触发的故障转移。

6、数据备份和恢复策略: 实施定期备份策略,并确保可以快速恢复数据。

Kafka中的事务性消息是如何工作的?

Kafka支持事务性消息,允许生产者在多个分区和主题上原子地发送一批消息。它的工作机制如下:

1、事务初始化: 生产者启动一个事务,通过指定唯一的事务ID。

2、事务中的消息发送: 在事务中,生产者可以发送多个消息到一个或多个分区和主题。

3、原子性保证: Kafka确保事务中的所有消息要么全部成功提交,要么全部失败。

4、偏移量和事务日志: Kafka使用内部的事务日志来跟踪每个事务的状态,并将消费者的偏移量与事务关联起来。

5、事务提交或中止: 生产者可以选择提交事务(使所有消息对消费者可见)或中止事务(回滚所有消息)。

6、事务的持久性和故障恢复: Kafka确保即使在发生故障的情况下,事务的状态也能被正确维护和恢复。

Kafka中如何处理大量的小消息?

处理Kafka中大量的小消息涉及以下几个策略:

1、消息批处理: 在生产者端,通过配置batch.size和linger.ms参数,可以批量发送小消息,减少网络请求的次数。

2、压缩: 启用消息压缩(如snappy或gzip),减少网络传输的数据量和存储空间的占用。

3、增加吞吐量: 调整Broker和Consumer的配置,如提高fetch.min.bytes和fetch.max.wait.ms,以提高消费者的吞吐量。

4、分区策略: 合理配置分区数量,确保负载均衡,避免个别分区过载。

5、内存和网络优化: 在Broker和Producer端优化内存使用和网络设置,以处理高频率的小消息。

Kafka中的消费者组是如何工作的?

Kafka中的消费者组是一组消费者实例,共同消费一个或多个主题的消息。这种机制主要包括以下几个方面:

1、负载均衡: 每个消费者组内的消费者实例可以在组内平衡负载,确保每个分区被一个消费者实例消费。

2、容错性: 如果一个消费者实例失败,其所消费的分区会被重新分配给同组内的其他消费者实例。

3、组协调器: Kafka的Group Coordinator负责监控组成员的状态,处理成员加入和退出。

4、偏移量管理: 消费者组中的每个消费者都会记录各自消费的进度(偏移量),以便故障恢复后可以从上次的进度继续消费。

Kafka中的Topic和Partition有什么区别?

Kafka中的Topic和Partition是消息存储结构的关键组成部分,它们之间的主要区别如下:

1、概念上的区别: Topic是消息的分类,相当于一个逻辑概念,而Partition是物理上的分割,是Topic的一个子集。

2、作用不同: Topic用于区分不同类型的消息流,Partition则用于在物理层面上分散数据存储和读写的负载。

3、消息顺序: 在单个Partition内,消息是有序的;但跨Partition,Kafka不保证消息的顺序。

4、可伸缩性: 通过增加Partition数量,可以提升Topic的并发处理能力。

Kafka的ISR(In-Sync Replicas)机制是如何工作的?

Kafka的ISR机制是一种保证数据副本一致性的机制,其工作原理如下:

1、定义: ISR是指与领导者副本保持同步的跟随者副本集合。

2、保持同步: 如果跟随者副本能够及时复制领导者副本的数据,则它属于ISR。

3、副本落后处理: 如果跟随者副本落后过多,或未在设定时间内与领导者副本同步,它将被从ISR中移除。

4、高可用性: 通过ISR机制,Kafka确保只有在多数副本存活的情况下才允许写入,从而保证高可用性和数据一致性。

Kafka的Exactly-Once语义?

Kafka的Exactly-Once语义是指在消息传输过程中,不管发生什么错误,每条消息都会被精确一次处理,不多不少。这个机制主要包括:

1、消费者幂等性: 消费者处理消息时,即使多次处理相同消息,也保证最终效果一致。

2、生产者幂等性: 生产者发送消息时,即使因网络问题重试,也不会导致消息被重复投递。

3、事务管理: Kafka提供事务API,允许在生产者和消费者之间进行事务性操作,确保处理过程中的一致性。

4、应用场景: 这一机制适用于对数据一致性要求极高的场景,如金融交易处理。

Kafka的延迟队列是如何实现的?

Kafka的延迟队列不是内置特性,但可以通过一些技巧实现,主要方式包括:

1、时间戳处理: 生产者在消息中加入时间戳,消费者根据时间戳判断是否到达处理时间。

2、专用Topic: 设置一个专用的延迟Topic,消费者先从主Topic读取消息,不满足处理条件时发送到延迟Topic,等待一段时间后再次处理。

3、外部系统配合: 使用像Kafka Streams这样的外部系统来实现更复杂的时间窗口操作。

4、轮询机制: 消费者定期轮询检查延迟消息,一旦到达设定时间就进行处理。

Kafka中的"幂等性生产者"是什么意思,它如何保证消息不被重复发送?

Kafka中的"幂等性生产者"指的是能够保证即使在重试的情况下也不会产生重复消息的生产者。它通过以下机制来保证消息不被重复发送:

1、唯一标识符: Kafka为每个生产者分配一个唯一的PID(Producer ID)。

2、序列号: 每个发送的消息都会附加一个序列号。Kafka利用PID和序列号来识别和拒绝重复的消息。

3、Broker端的处理: 当Broker接收到消息时,它会检查该PID和序列号是否已经存在。如果是重复的,Broker不会再次处理该消息。

4、配置开启: 通过设置enable.idempotence=true,可以启用幂等性生产者。

5、重试和错误处理: 幂等性生产者在发送消息时,即使出现网络错误或其他原因导致重试,也不会导致消息重复。

Kafka消费者的拉取(Pull)模式与推送(Push)模式有何不同?

Kafka主要采用消费者拉取(Pull)模式,与传统的推送(Push)模式有以下不同:

1、控制流: 在拉取模式中,消费者控制何时从Broker拉取数据,以及拉取多少数据。而在推送模式中,服务器端控制数据发送的时机和数量。

2、数据流量管理: 拉取模式允许消费者根据处理能力来获取数据,避免了服务器推送数据过快导致的消费者不堪重负。

3、实时性: 推送模式可以更快地将数据发送给消费者,但拉取模式下,如果消费者处理能力较弱,可能会有一定的延迟。

4、灵活性和效率: 拉取模式下,消费者可以更灵活地根据需要调整拉取策略,优化数据处理的效率。

5、网络开销: 拉取模式可能导致更频繁的网络请求,尤其是当Broker中没有新消息时。

Kafka中的动态分区再平衡是什么,它如何工作?

Kafka中的动态分区再平衡指的是当消费者组内成员变化时,Kafka自动重新分配分区给消费者的过程。这个机制的工作原理如下:

1、消费者变化检测: 当新消费者加入消费者组或现有消费者离开时,会触发再平衡。

2、停止消息消费: 在再平衡开始时,所有消费者暂停消费消息。

3、分区重新分配: Kafka群组协调器根据当前的消费者数量和分区策略来重新分配分区。

4、偏移量提交: 在再平衡之前,消费者提交它们的偏移量,以确保消费状态正确维护。

5、恢复消费: 一旦分区再平衡完成,消费者开始从新分配到的分区消费消息。

6、最小化延迟: Kafka努力最小化再平衡对消费的延迟和中断。

Kafka中如何配置和管理ACL(访问控制列表)?

在Kafka中配置和管理ACL(访问控制列表)主要涉及以下步骤:

1、开启授权功能: 在Kafka配置文件中设置authorizer.class.name为kafka.security.auth.SimpleAclAuthorizer。

2、指定ZooKeeper集群: ACL信息存储在ZooKeeper中,需要配置Kafka连接到ZooKeeper集群。

3、创建ACL规则: 使用Kafka的命令行工具(如kafka-acls.sh)来添加、删除或列出ACL规则。

4、规则定义: 可以为主题、消费者群组等定义ACL规则,包括允许或拒绝特定用户或组的读写操作。

5、正则表达式支持: ACL支持使用正则表达式来匹配资源名称,便于管理大量资源。

6、用户认证: 要使ACL有效,需要开启并配置Kafka的用户认证机制,如SASL或SSL。

Kafka中的Schema Registry是什么,它如何帮助管理数据模式?

Kafka中的Schema Registry是一个用于存储、检索和管理Avro、JSON Schema和Protobuf模式的服务。它的主要作用和工作原理如下:

1、模式存储和版本控制: Schema Registry存储数据的模式,并为每个模式提供版本控制。

2、模式兼容性检查: 当模式发生变化时,它可以检查新模式是否与旧模式兼容。

3、序列化和反序列化: 提供序列化和反序列化工具,确保生产者和消费者使用正确的模式处理数据。

4、集中式管理: 提供了一个中央位置来管理所有模式,方便不同应用和服务的数据模式标准化和一致性。

5、API接口: 提供RESTful接口,方便用户查询、添加和修改模式。

6、与Kafka紧密集成: 通常与Kafka客户端集成,以实现在消息生产和消费时自动进行模式管理。

Kafka的Leader选举机制是如何工作的?

Kafka的Leader选举机制是确保Partition高可用的关键过程,其工作原理如下:

1、领导者副本: 每个Partition有一个领导者副本(Leader),负责处理所有读写请求。

2、故障检测: 当Leader副本发生故障时,ZooKeeper负责检测并触发Leader选举过程。

3、选举过程: Kafka从ISR(In-Sync Replicas)列表中选择一个新的Leader。通常选择最新数据的副本。

4、同步数据: 新Leader副本被选举后,其他Follower副本会与之同步数据。

Kafka Stream和Kafka Consumer的区别是什么?

Kafka Stream和Kafka Consumer在功能和用途上存在明显差异:

1、用途差异: Kafka Stream是用于构建实时数据流处理应用的库,而Kafka Consumer主要用于消费Kafka中的消息。

2、功能丰富程度: Kafka Stream提供更丰富的数据处理功能,如窗口、聚合和状态管理,而Kafka Consumer主要关注于消息的拉取和处理。

3、状态处理: Kafka Stream支持状态的存储和恢复,适用于复杂的流处理任务。

4、集成程度: Kafka Stream是紧密集成在Kafka生态中的,它可以更方便地与Kafka的其他组件协同工作。

Kafka中的幂等性是如何保证的?

Kafka中的幂等性主要指的是生产者发送消息时的特性,以保证消息即使在网络等问题导致重试时也不会重复发送。其实现机制包括:

1、唯一标识符: Kafka给每个生产者分配一个唯一的PID(Producer ID)。

2、序列号: 每条消息都有一个序列号,Kafka根据PID和序列号识别重复消息。

3、服务器端处理: Kafka服务器通过检查PID和序列号来丢弃重复的消息。

4、配置启用: 幂等性需要在生产者端配置中明确启用。

Kafka Connect的作用是什么?

Kafka Connect是一个工具,旨在方便地将数据导入和导出到Kafka。它主要具有以下作用:

1、数据集成: 提供了一个统一的框架来集成各种数据系统和Kafka。

2、预构建连接器: 社区提供了多种预构建的连接器,可以连接到常见的数据源和接收器。

3、简化数据流程: Kafka Connect简化了数据流动的配置和管理,使得数据流向更加高效和可靠。

4、可扩展性: 支持自定义连接器开发,满足特定数据源的集成需求。

Kafka如何实现消息的有序传递?

Kafka实现消息的有序传递主要依赖于其分区(Partition)机制:

1、分区内顺序: Kafka保证同一分区内的消息是有序的。每条消息都按照它们被接收的顺序追加到分区日志。

2、生产者设计: 生产者在发送消息时可以指定Partition Key,确保相同Key的消息被发送到同一个分区。

3、单一消费者: 在一个消费者组中,每个分区的消息只被一个消费者实例处理,避免了多个消费者处理同一分区消息导致的顺序问题。

4、消息处理策略: 应用层可以设计消息处理策略,确保在处理消息时能够保持消息的顺序性。

Kafka中的压缩机制是如何工作的?

Kafka支持对消息进行压缩,以减少网络和存储的负担。其压缩机制包括:

1、支持多种压缩格式: Kafka支持多种压缩协议,如GZIP、Snappy和LZ4。

2、生产者端压缩: 消息在生产者端被压缩,然后发送到Kafka服务器。

3、批量压缩: Kafka将多个消息打包成一个消息集(Message Set),然后对整个消息集进行压缩。

4、消费者端解压: 消费者从Kafka接收压缩的消息集,并在本地进行解压处理。

Kafka中的日志清理策略有哪些?

Kafka提供了多种日志清理策略,以管理日志数据和优化存储空间:

1、基于时间的清理: 可以配置日志保留时间,超过这个时间的日志会被自动删除。

2、基于大小的清理: 设置日志的最大大小,当日志大小超过这个阈值时,旧的日志段将被清理。

3、压缩策略: Kafka支持日志压缩,它保留每个Key的最新消息,删除相同Key的旧消息。

4、混合策略: 可以将时间和大小策略结合使用,以满足不同的存储和性能需求。

Kafka中的消费者如何处理重复消息?

在Kafka中,消费者处理重复消息的常见策略包括:

1、幂等性处理: 消费者在处理消息时应用幂等操作,即使消息被重复处理,最终结果保持一致。

2、偏移量控制: 消费者可以准确记录和管理自己的偏移量,确保在重新消费时,不会重复处理已经处理过的消息。

3、去重机制: 应用层可以实现消息去重逻辑,例如通过维护消息ID的缓存来过滤掉已经处理过的消息。

4、事务保证: 如果使用Kafka的事务功能,可以确保消息的精确一次处理(Exactly-Once Semantics)。

相关文章:

Kafka 面试题及答案整理,最新面试题

Kafka中的Producer API是如何工作的? Kafka中的Producer API允许应用程序发布一流的数据到一个或多个Kafka主题。它的工作原理包括: 1、创建Producer实例: 通过配置Producer的各种属性(如服务器地址、序列化方式等)来…...

qt带后缀单位的QLineEdit

QLineEditUnit.h #pragma once #include <QLineEdit> #include <QPushButton>class QLineEditUnit : public QLineEdit {Q_OBJECT public:QLineEditUnit(QWidget* parent Q_NULLPTR);~QLineEditUnit();//获取编辑框单位QString UnitText()const;//设置编辑框单位…...

堆宝塔(Python)

作者 陈越 单位 浙江大学 堆宝塔游戏是让小朋友根据抓到的彩虹圈的直径大小,按照从大到小的顺序堆起宝塔。但彩虹圈不一定是按照直径的大小顺序抓到的。聪明宝宝采取的策略如下: 首先准备两根柱子,一根 A 柱串宝塔,一根 B 柱用于…...

采用 Amazon DocumentDB 和 Amazon Bedrock 上的 Claude 3 构建游戏行业产品推荐

前言 大语言模型(LLM)自面世以来即展示了其创新能力,但 LLM 面临着幻觉等挑战。如何通过整合外部数据库的知识,检索增强生成(RAG)已成为通用和可行的解决方案。这提高了模型的准确性和可信度,特…...

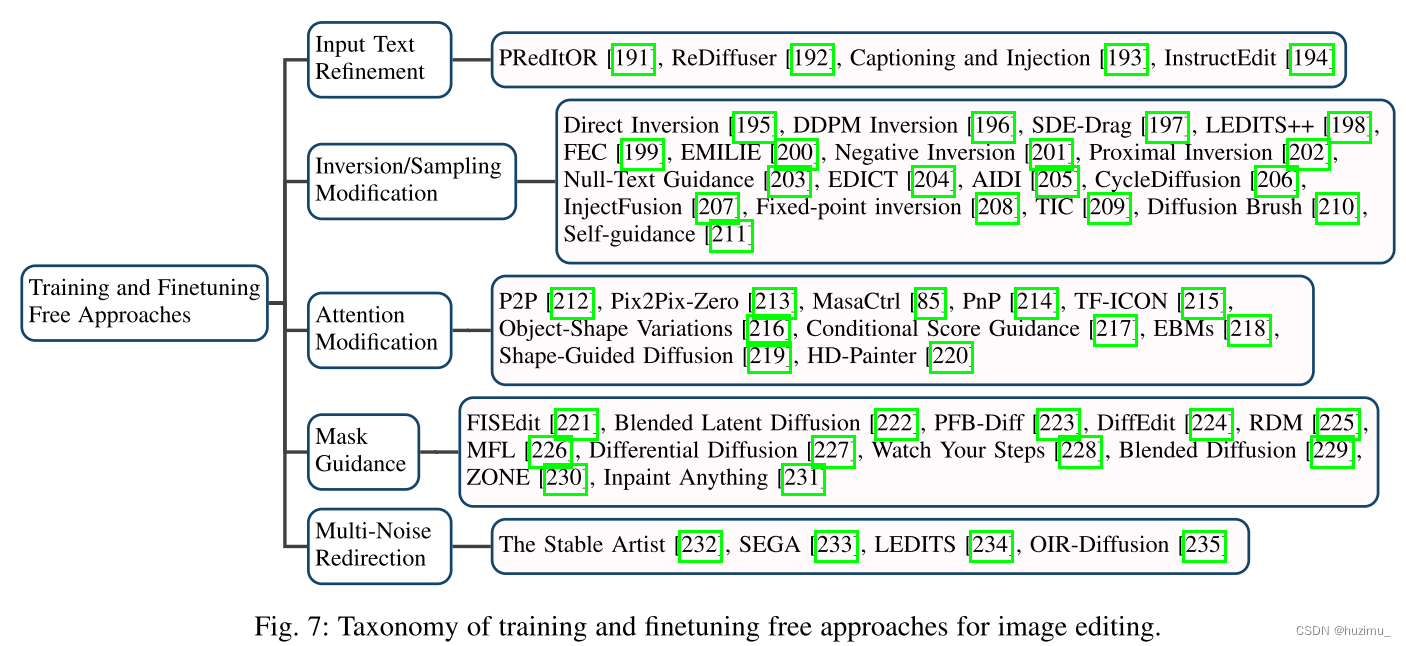

论文阅读:Diffusion Model-Based Image Editing: A Survey

Diffusion Model-Based Image Editing: A Survey 论文链接 GitHub仓库 摘要 这篇文章是一篇基于扩散模型(Diffusion Model)的图片编辑(image editing)方法综述。作者从多个方面对当前的方法进行分类和分析,包括学习…...

数据结构:顺序表的奥秘

🎉个人名片: 🐼作者简介:一名乐于分享在学习道路上收获的大二在校生🐻❄个人主页🎉:GOTXX 🐼个人WeChat:ILXOXVJE🐼本文由GOTXX原创,首发CSDN&a…...

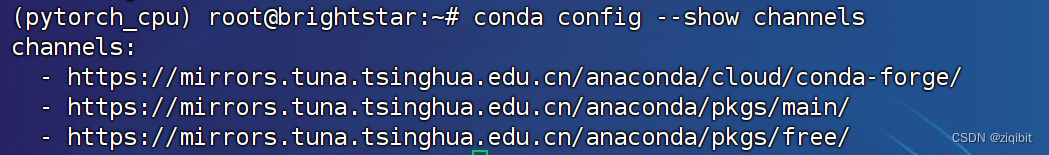

conda 设置国内源 windows+linux

默认的conda源连接不好,时好时坏,而且速度很慢,可以使用国内的源 如果没有安装conda,可以参考: miniconda安装:链接 anaconda安装winlinux:链接 windows使用命令提示符,linux使用…...

)

SQL中的不加锁查询 with(nolock)

WITH(NOLOCK) 是一种 SQL Server 中的表提示(table hint),可以用来告诉数据库引擎在查询数据时不要加锁,以避免因为锁等待导致查询性能下降。 当多个事务同时访问同一张表时,数据库引擎会对表进行锁定,以确…...

代码讲解:如何把3D数据转换成旋转的视频?

目录 3D数据集下载 读取binvox文件 使用matplotlib创建图 动画效果 完整代码 3D数据集下载 这里以shapenet数据集为例,可以访问外网的可以去直接申请下载;我也准备了一个备份在百度网盘的数据集,可以参考: ShapeNet简介和下…...

LVS集群 ----------------(直接路由 )DR模式部署 (二)

一、LVS集群的三种工作模式 lvs-nat:修改请求报文的目标IP,多目标IP的DNAT lvs-dr:操纵封装新的MAC地址(直接路由) lvs-tun:隧道模式 lvs-dr 是 LVS集群的 默认工作模式 NAT通过网络地址转换实现的虚拟服务器&…...

微软亚太区AI智能应用创新业务负责人许豪,将出席“ISIG-AIGC技术与应用发展峰会”

3月16日,第四届「ISIG中国产业智能大会」将在上海中庚聚龙酒店拉开序幕。本届大会由苏州市金融科技协会指导,企智未来科技(AIGC开放社区、RPA中国、LowCode低码时代)主办。大会旨在聚合每一位产业成员的力量,深入探索A…...

vim寄存器和宏

目录 1.寄存器1.1.寄存器相关命令 2.宏2.1.宏的录制和回放2.1.1.避免宏回放回到开头重做2.1.2.先搜索 2.2.宏的编辑2.2.1.特殊字符 3.递归的宏4.跨文件运行宏 1.寄存器 寄存器说明注释a-z手动复制数据"寄存器"无名寄存器""p等效为p0-9最后10次删除操作的历…...

使用数据库实现增删改查

#include<myhead.h>//定义添加数据函数int do_add(sqlite3 *ppDb) {//1.准备sql语句,输入要添加的信息int add_numb; //工号char add_name[20]; //姓名char add_sex[10]; //性别double add_score; //工资printf("请输入要添加的工号:")…...

Oracle Essbase 多维库导入文件数据步骤操作

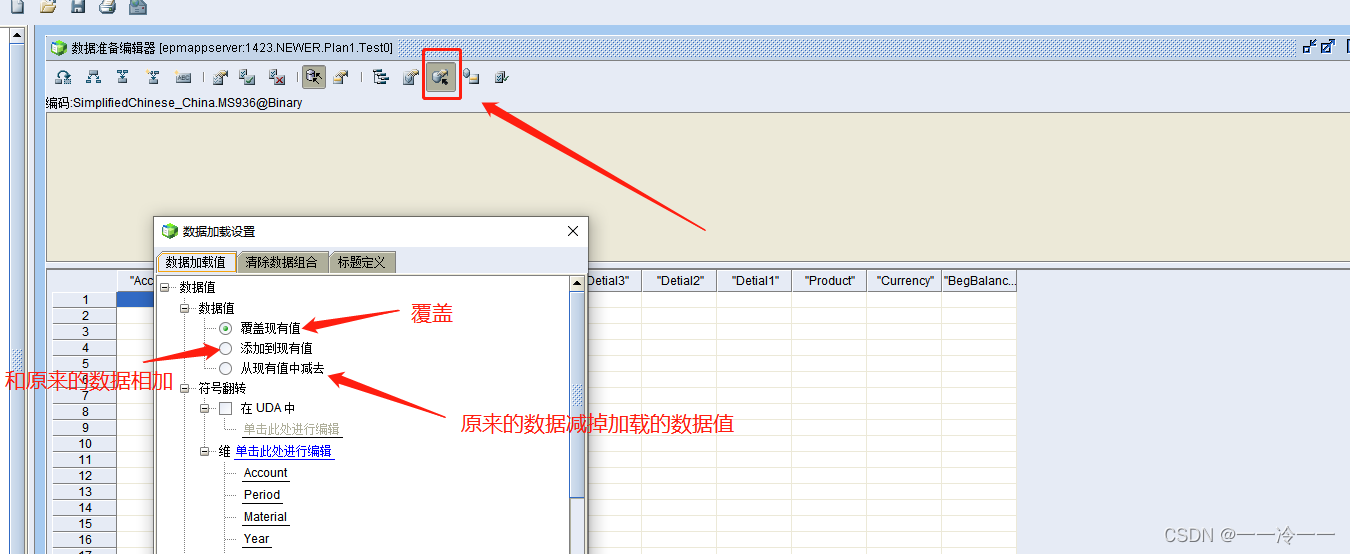

第一步: 先确定导入数据的维度数量(清楚自己需要导入什么数据和范围) 第二步: 设置加载的规则 1.创建规则 2.编辑规则-》打开数据文件 通过数据文件来确定加载规则的加载格式 先查看数据文件格式: 将数据文件导入&…...

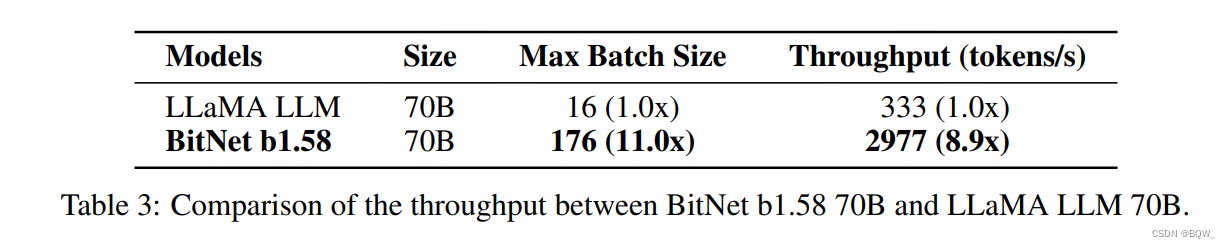

【自然语言处理】BitNet b1.58:1bit LLM时代

论文地址:https://arxiv.org/pdf/2402.17764.pdf 相关博客 【自然语言处理】【大模型】BitNet:用1-bit Transformer训练LLM 【自然语言处理】BitNet b1.58:1bit LLM时代 【自然语言处理】【长文本处理】RMT:能处理长度超过一百万t…...

【Axure高保真原型】可视化动点素材

今天和粉丝们免费分享可视化动点素材的原型模板,该模板使用简单,复制粘贴,预览时即可实现动点效果,本案例提供红黄蓝绿4中颜色的动点,如果需要其他颜色,可以自行编辑svg里面的代码 【原型效果】 【模板下载…...

分布式数据库 GaiaDB-X 金融应用实践

1 银行新一代核心系统建设背景及架构 在银行的 IT 建设历程中,尤其是中大行,大多都基于大型机和小型机来构建核心系统。随着银行业务的快速发展,这样的系统对业务的支持越来越举步维艰,主要体现在以下四个方面: 首先是…...

机器学习中的经典算法总结

经典算法 有监督算法逻辑回归支持向量机SVM决策树朴素贝叶斯K近邻(KNN) 无监督算法K-meansPCA主成分分析预留模版 有监督算法 逻辑回归 简介 逻辑回归是机器学习中一种经典的分类算法,通常用于二分类任务,基本思想是构建一个线性…...

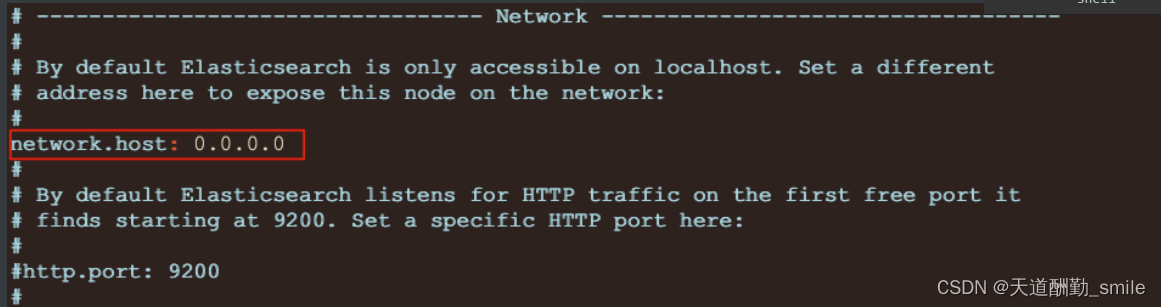

ElasticSearch 学习(docker,传统方式安装、安装遇到的问题解决,)

目录 简介 什么是ElasticSearch 安装 传统方式安装 开启远程访问 Docker方式安装 Kibana 简介 安装 传统方式安装 Docker方式安装 compose方式安装 简介 什么是ElasticSearch ElasticSearch 简称 ES ,是基于Apache Lucene构建的开源搜索引擎,…...

[百度二面]操作系统进程、锁相关面试题

2.22 什么是死锁 在多道程序环境下,多个进程可以竞争有限数量的资源。当一个进程申请资源时,如果这时没有可用资源,那么这个进程进入等待状态。有时,如果所申请的资源被其他等待进程占有,那么该等待进程有可能再也无法…...

IDEA运行Tomcat出现乱码问题解决汇总

最近正值期末周,有很多同学在写期末Java web作业时,运行tomcat出现乱码问题,经过多次解决与研究,我做了如下整理: 原因: IDEA本身编码与tomcat的编码与Windows编码不同导致,Windows 系统控制台…...

从零实现富文本编辑器#5-编辑器选区模型的状态结构表达

先前我们总结了浏览器选区模型的交互策略,并且实现了基本的选区操作,还调研了自绘选区的实现。那么相对的,我们还需要设计编辑器的选区表达,也可以称为模型选区。编辑器中应用变更时的操作范围,就是以模型选区为基准来…...

Python实现prophet 理论及参数优化

文章目录 Prophet理论及模型参数介绍Python代码完整实现prophet 添加外部数据进行模型优化 之前初步学习prophet的时候,写过一篇简单实现,后期随着对该模型的深入研究,本次记录涉及到prophet 的公式以及参数调优,从公式可以更直观…...

NFT模式:数字资产确权与链游经济系统构建

NFT模式:数字资产确权与链游经济系统构建 ——从技术架构到可持续生态的范式革命 一、确权技术革新:构建可信数字资产基石 1. 区块链底层架构的进化 跨链互操作协议:基于LayerZero协议实现以太坊、Solana等公链资产互通,通过零知…...

React---day11

14.4 react-redux第三方库 提供connect、thunk之类的函数 以获取一个banner数据为例子 store: 我们在使用异步的时候理应是要使用中间件的,但是configureStore 已经自动集成了 redux-thunk,注意action里面要返回函数 import { configureS…...

安宝特案例丨Vuzix AR智能眼镜集成专业软件,助力卢森堡医院药房转型,赢得辉瑞创新奖

在Vuzix M400 AR智能眼镜的助力下,卢森堡罗伯特舒曼医院(the Robert Schuman Hospitals, HRS)凭借在无菌制剂生产流程中引入增强现实技术(AR)创新项目,荣获了2024年6月7日由卢森堡医院药剂师协会࿰…...

jmeter聚合报告中参数详解

sample、average、min、max、90%line、95%line,99%line、Error错误率、吞吐量Thoughput、KB/sec每秒传输的数据量 sample(样本数) 表示测试中发送的请求数量,即测试执行了多少次请求。 单位,以个或者次数表示。 示例:…...

FFmpeg:Windows系统小白安装及其使用

一、安装 1.访问官网 Download FFmpeg 2.点击版本目录 3.选择版本点击安装 注意这里选择的是【release buids】,注意左上角标题 例如我安装在目录 F:\FFmpeg 4.解压 5.添加环境变量 把你解压后的bin目录(即exe所在文件夹)加入系统变量…...

:工厂方法模式、单例模式和生成器模式)

上位机开发过程中的设计模式体会(1):工厂方法模式、单例模式和生成器模式

简介 在我的 QT/C 开发工作中,合理运用设计模式极大地提高了代码的可维护性和可扩展性。本文将分享我在实际项目中应用的三种创造型模式:工厂方法模式、单例模式和生成器模式。 1. 工厂模式 (Factory Pattern) 应用场景 在我的 QT 项目中曾经有一个需…...

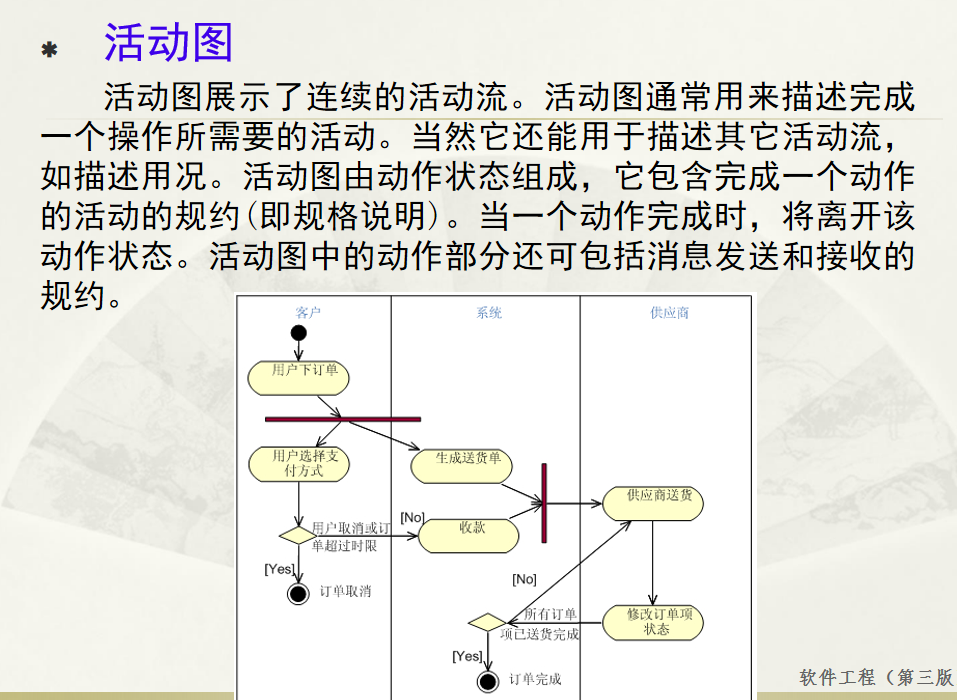

软件工程 期末复习

瀑布模型:计划 螺旋模型:风险低 原型模型: 用户反馈 喷泉模型:代码复用 高内聚 低耦合:模块内部功能紧密 模块之间依赖程度小 高内聚:指的是一个模块内部的功能应该紧密相关。换句话说,一个模块应当只实现单一的功能…...