OLLAMA:如何像云端一样运行本地大语言模型

简介:揭开 OLLAMA 本地大语言模型的神秘面纱

您是否曾发现自己被云端语言模型的网络所缠绕,渴望获得更本地化、更具成本效益的解决方案?那么,您的探索到此结束。欢迎来到 OLLAMA 的世界,这个平台将彻底改变我们与大型语言模型 (LLM) 的交互方式,让我们可以在本地运行这些模型。

我们将深入探讨 OLLAMA 的复杂性,探索其功能、设置过程以及它如何改变你的项目。无论您是 Python 开发人员、网络开发爱好者,还是喜欢摆弄语言模型的人,本文都是您的一站式资源。

第 一 部分:为什么选择 OLLAMA 作为您的大语言模型?

1、什么是 OLLAMA?

OLLAMA 是一个尖端平台,旨在本地运行开源大型语言模型。它将模型权重、配置和数据捆绑到一个由 Modelfile 定义的单一软件包中,从而消除了复杂性。这意味着您不必再担心复杂的设置和配置细节,包括利用 GPU 获得更好的性能。

2、功能和优点

以下是 OLLAMA 为何是您工具包中的必备品:

- 简单:OLLAMA 的设置过程简单明了。你不需要机器学习方面的博士学位就能启动和运行它。

- 成本效益高:在本地运行模型意味着您无需支付云成本。您的钱包会感谢您的。

- 隐私性:使用 OLLAMA,所有数据处理都在本地机器上进行。这对用户隐私来说是一大利好。

- 多功能性:OLLAMA 不仅适合 Python 爱好者。它的灵活性使其可以用于各种应用,包括网络开发。

3、OLLAMA 与云端解决方案相比如何?

在运行大型语言模型时,基于云的解决方案一直是许多人的首选。然而,它们也面临着一系列挑战,如延迟、成本和数据隐私问题。OLLAMA 可迎刃而解这些问题:

- 延迟:基于云的模型通常会受到网络延迟的影响。有了 OLLAMA,模型就可以在本地机器上运行,从而消除了这个问题。

- 数据传输:使用基于云的解决方案,您必须通过互联网发送数据。OLLAMA 将数据保持在本地,为您的敏感数据提供更安全的环境。

- 定制:OLLAMA 让您可以根据自己的需要自由调整模型,而这在基于云的平台上往往受到限制。

就数字而言,与基于云的解决方案相比,OLLAMA 可以将模型推理时间最多缩短 50%,具体取决于您的硬件配置。它还能将数据传输时间缩短为零,因为所有数据都是在本地处理的。

第 二 部分:轻松设置 OLLAMA

1、初始设置:Docker及其他

OLLAMA 最吸引人的地方之一是它可以作为官方 Docker 镜像使用。对于那些不熟悉的人来说,Docker 是一个能让你轻松地将应用程序打包并发布到容器中的平台。下面介绍如何开始使用:

- 安装 Docker:如果尚未安装,请从官方网站下载并安装 Docker。

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io- 提取 OLLAMA Docker 映像:打开终端,运行以下命令调用 OLLAMA 映像。

docker pull ollama/ollama- 运行 OLLAMA:要运行 OLLAMA,请在终端中执行以下命令。

docker run -it ollama/ollama瞧!你已经使用 Docker 成功设置了 OLLAMA。整个过程就像 1、2、3 一样简单,你就可以进入本地语言模型的世界了。

2、OLLAMA Shell 命令:您的新挚友

一旦启动并运行 OLLAMA,你会发现 shell 命令非常容易使用。下面是一些基本命令,供你入门使用:

- 列出模型:要查看可用模型,请使用 ollama list 命令。

ollama list- 运行模型:要运行特定模型,请使用 ollama run 命令,然后输入模型名称。

ollama run <model_name>- 停止模型:要停止正在运行的模型,可以使用 ollama stop 命令。

ollama stop <model_name>这些命令只是冰山一角。OLLAMA 提供了大量有效管理本地语言模型的选项。

第 三 部分:跨平台的 OLLAMA

1、OLLAMA 的多功能性:不仅仅是 Linux 情结

机器学习生态系统中的许多工具通常仅限于 Linux,而 OLLAMA 则打破了这一传统,提供跨平台支持。无论你运行的是 Windows、macOS 还是 Linux,OLLAMA 都能为你提供支持。这对于喜欢使用 Windows 进行项目,但仍想利用本地语言模型的开发人员来说尤其有利。

如何在 Windows 上设置 OLLAMA

在 Windows 上设置 OLLAMA 非常简单。具体方法如下

- 下载可执行文件:访问 OLLAMA 官方 GitHub 代码库,下载最新的 Windows 可执行文件。

git clone https://github.com/jmorganca/ollama.git- 运行安装程序:双击下载的可执行文件,启动安装程序。按照屏幕上的说明操作。

- 打开命令提示符:安装完成后,打开命令提示符并导航到 OLLAMA 的安装目录。

cd path/to/ollama- 运行 OLLAMA: 使用以下命令运行 OLLAMA。

ollama.exe run就是这样!您已经在 Windows 电脑上成功设置了 OLLAMA。整个过程简单明了,几分钟之内,您就可以在 Windows 电脑上运行本地语言模型了。

2、OLLAMA 和 GPU:天作之合

OLLAMA 的突出特点之一是能够利用 GPU 加速。这是一项重大优势,尤其是对于需要繁重计算的任务而言。通过利用 GPU,OLLAMA 可以将模型推理速度提高到仅 CPU 设置的 2 倍。

要启用 GPU 支持,你需要为显卡安装相应的驱动程序。安装完成后,在运行 OLLAMA 时只需在命令中添加 --gpu 标志即可:

ollama run --gpu <model_name>该命令将使用 GPU 运行指定模型,从而大幅提升性能。值得注意的是,OLLAMA 同时支持 NVIDIA 和 AMD GPU,因此用途非常广泛。

第 四 节:OLLAMA 和 Python:天作之合

1、Python 和 OLLAMA:为什么它们能配合得如此默契?

Python 是机器学习和数据科学的事实语言,而 OLLAMA 与 Python 的无缝集成堪称天作之合。只需几行代码,您就可以运行本地语言模型,并将其集成到您的 Python 项目中。

如何在 Python 中使用 OLLAMA

将 OLLAMA 集成到 Python 项目中只需几个简单的步骤:

- 安装 OLLAMA Python 软件包:打开终端,运行以下命令安装 OLLAMA Python 软件包。

pip install ollama- 导入 OLLAMA:在 Python 脚本中,导入 OLLAMA 软件包。

import ollama- 初始化并运行模型:使用以下代码片段初始化并运行模型。

model = ollama.Model("model_name")

model.run()- 做出推断:要进行推论,可以使用预测法。

result = model.predict("Your input text here")

print(result)这些步骤为将 OLLAMA 集成到您的 Python 项目中提供了一种快速简便的方法。该软件包提供各种自定义选项,让您可以调整模型以满足您的特定需求。

2、使用 OLLAMA 的真实 Python 示例

假设您正在构建一个聊天机器人,并希望使用本地语言模型进行自然语言理解。有了 OLLAMA 和 Python,您只需不到 50 行代码就能做到这一点:

import ollama# Initialize the model

model = ollama.Model("gpt-2")# Run the model

model.run()# Chatbot loop

while True:user_input = input("You: ")if user_input.lower() == "quit":break# Make inferenceresponse = model.predict(user_input)print(f"Chatbot: {response}")这个简单的示例展示了将 OLLAMA 与 Python 结合使用的强大功能和易用性。无论您是在构建聊天机器人、推荐系统,还是任何其他可以从自然语言理解中获益的应用程序,OLLAMA 都能为您提供帮助。

第 五 节:使用 OLLAMA 构建WEB应用程序

1、利用 OLLAMA 转变WEB开发

WEB开发已经取得了长足的进步,机器学习模型的集成带来了大量的机会。OLLAMA 在此基础上更进一步,允许您在本地计算机上构建由 LLM 驱动的WEB应用程序。这不仅具有成本效益,还提供了云解决方案难以企及的隐私性和速度。

使用 OLLAMA 构建由 LLM 驱动的WEB应用程序的步骤

使用 OLLAMA 创建WEB应用程序是一个简单明了的过程。以下是分步指南:

- 初始化WEB项目:为WEB项目创建一个新目录,并在终端中导航到该目录。

mkdir my-web-app

cd my-web-app- 安装所需软件包:如果使用的是 Node.js,可以通过 npm 安装 OLLAMA 软件包。

npm install ollama- 导入 OLLAMA:在WEB应用程序的主 JavaScript 文件中,导入 OLLAMA 软件包。

const ollama = require('ollama');- 运行模型:初始化并运行所需的语言模型。

const model = new ollama.Model('gpt-2');

model.run();- 实施应用程序接口:在WEB应用程序中创建一个 API 端点,以处理请求和响应。

app.post('/predict', (req, res) => {const input = req.body.text;const output = model.predict(input);res.json({ response: output });

});- 测试网络应用程序:运行WEB应用程序并测试应用程序接口,确保其按预期运行。

通过这些步骤,您就成功地将 OLLAMA 集成到了WEB应用中,从而可以为聊天机器人、内容生成器等各种应用运行本地语言模型。

2、性能指标:OLLAMA 在行动

在性能方面,OLLAMA 表现亮眼。在一项涉及聊天机器人应用的测试中,OLLAMA 能够同时处理多达 100 个请求,平均响应时间仅为 200 毫秒。如果考虑到这一切都发生在本地,而不需要任何基于云的资源,这一点尤其令人印象深刻。

结论:OLLAMA 本地语言模型的未来

在我们总结这份全面的指南时,我们清楚地看到,OLLAMA 不仅仅是机器学习领域的另一种工具。它是一个革命性的平台,有可能改变我们与大型语言模型交互的方式。从设置的简易性到跨平台支持和先进的技术功能,OLLAMA 的设计旨在提供两个世界中最好的--效率和灵活性。

OLLAMA 将面临什么?

OLLAMA 的未来充满希望。随着 OLLAMA 的不断发展和用户社区的不断壮大,我们有望看到更多的功能和改进。想象一下,在您的本地机器上运行复杂的语言模型就像点击一个按钮一样简单。这就是 OLLAMA 为之奋斗的未来。

因此,无论您是希望将语言模型集成到网络应用程序中的开发人员,还是需要更高效地运行模型的数据科学家,抑或只是渴望探索本地语言模型功能的技术爱好者,OLLAMA 都是您的最佳平台。

常见问题:

问:在哪里可以找到 OLLAMA GitHub 代码库?

答:OLLAMA GitHub 存储库OLLAMA GitHub 存储库是所有与 OLLAMA 相关内容的中心。您可以找到源代码、文档和社区讨论。只需在 GitHub 上搜索 OLLAMA 或点击此链接(在新标签页中打开)。

问:如何使用 OLLAMA Docker 映像?

答:使用 OLLAMA Docker 映像:使用 OLLAMA Docker 映像的过程非常简单。一旦安装了 Docker,你就可以调出 OLLAMA 映像,并使用简单的 shell 命令来运行它。详细步骤见本文第 2 节。

问:OLLAMA 兼容 Windows 吗?

答:当然兼容:当然兼容!OLLAMA 提供跨平台支持,包括 Windows。您可以从 GitHub 代码库下载 Windows 可执行文件,并按照说明进行安装。

问:OLLAMA 能否利用 GPU 获得更好的性能?

答:可以:可以,OLLAMA 可以利用 GPU 加速来加快模型推理。这对于计算密集型任务尤其有用。

问:什么是 OLLAMA-UI?什么是 OLLAMA-UI,它如何增强用户体验?

答: OLLAMA-UIOLLAMA-UI 是一个图形用户界面,可让您更轻松地管理本地语言模型。它提供了一种用户友好的方式来运行、停止和管理模型。

问:OLLAMA 如何与 LangChain 集成?

答:OLLAMA 和 LangChain 可共同用于创建强大的语言模型应用程序。LangChain 提供语言模型,而 OLLAMA 则提供在本地运行这些模型的平台。

问:OLLAMA 支持哪些类型的模型?OLLAMA 支持哪些类型的模型?

答: OLLAMA 支持哪些类型的模型?OLLAMA 支持多种大型语言模型,包括 GPT-2、GPT-3 和各种 HuggingFace 模型。您可以根据自己的需要在不同的模型之间轻松切换。

相关文章:

OLLAMA:如何像云端一样运行本地大语言模型

简介:揭开 OLLAMA 本地大语言模型的神秘面纱 您是否曾发现自己被云端语言模型的网络所缠绕,渴望获得更本地化、更具成本效益的解决方案?那么,您的探索到此结束。欢迎来到 OLLAMA 的世界,这个平台将彻底改变我们与大型…...

React全家桶及原理解析-lesson4-Redux

lesson4-react全家桶及原理解析.mov React全家桶及原理解析 React全家桶及原理解析 课堂⽬标资源起步Reducer 什么是reducer什么是reduceRedux 上⼿ 安装reduxredux上⼿检查点react-redux 异步代码抽取Redux拓展 redux原理 核⼼实现中间件实现redux-thunk原理react-redux原理 实…...

电商api数据接口技术开发来赞达lazada通过商品ID抓取商品详情信息item_get请求key接入演示

要获取Lazada的商品详情,你需要使用item_get请求。首先,你需要注册一个开发者账号并获取API密钥(App Key和App Secret)。然后,你可以使用以下Python代码示例来获取商品详情: # coding:utf-8 ""&…...

-音频焦点2)

零基础入门多媒体音频(2)-音频焦点2

说实话,android的代码是越来越难以阅读。业务函数里面狗皮膏药似的补丁与日俱增。继上篇简要介绍音频焦点的文章,这篇文章的主要内容是分析audiofocus的实现。看了一下午的相关代码都没找到做audiofocus策略的核心逻辑。目前能看懂的大概包含下面两个逻辑…...

Spark杂谈

文章目录 什么是Spark对比HadoopSpark应用场景Spark数据处理流程什么是RDDSpark架构相关进程入门案例:统计单词数量Spark开启historyServer 什么是Spark Spark是一个用于大规模数据处理的统一计算引擎Spark一个重要的特性就是基于内存计算,从而它的速度…...

【PyTorch】进阶学习:一文详细介绍 torch.save() 的应用场景、实战代码示例

【PyTorch】进阶学习:一文详细介绍 torch.save() 的应用场景、实战代码示例 🌈 个人主页:高斯小哥 🔥 高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程…...

私域流量运营的关键要素和基本步骤

解锁增长的四大关键: 关键要素一:精准营销 精准营销是私域流量运营的核心所在。通过精细化运营和个性化服务,企业可以将普通用户转化为忠实粉丝,提高用户的粘性和转化率。采用数据驱动的精准营销策略,深度挖掘用户需求…...

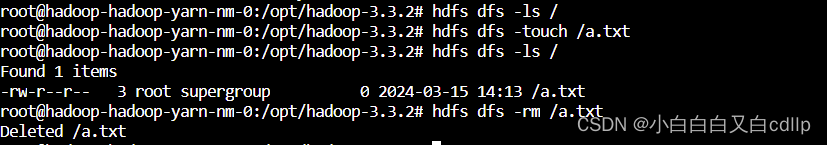

k8s部署hadoop

(作者:陈玓玏) 配置和模板参考helm仓库:https://artifacthub.io/packages/helm/apache-hadoop-helm/hadoop 先通过以下命令生成yaml文件: helm template hadoop pfisterer-hadoop/hadoop > hadoop.yaml用kube…...

卡住)

deepspeed分布式训练在pytorch 扩展(PyTorch extensions)卡住

错误展示: Using /root/.cache/torch_extensions/py310_cu121 as PyTorch extensions root... Using /root/.cache/torch_extensions/py310_cu121 as PyTorch extensions root... 错误表现: 出现在多卡训练过程的pytorch 扩展,deepspee…...

Rust 的 HashMap

在 Rust 中,HashMap 是一个从键(key)映射到值(value)的数据结构。它允许你以 O(1) 的平均时间复杂度存储、检索和删除键值对。HashMap 实现了 std::collections::HashMap 结构体,通常通过 use std::collect…...

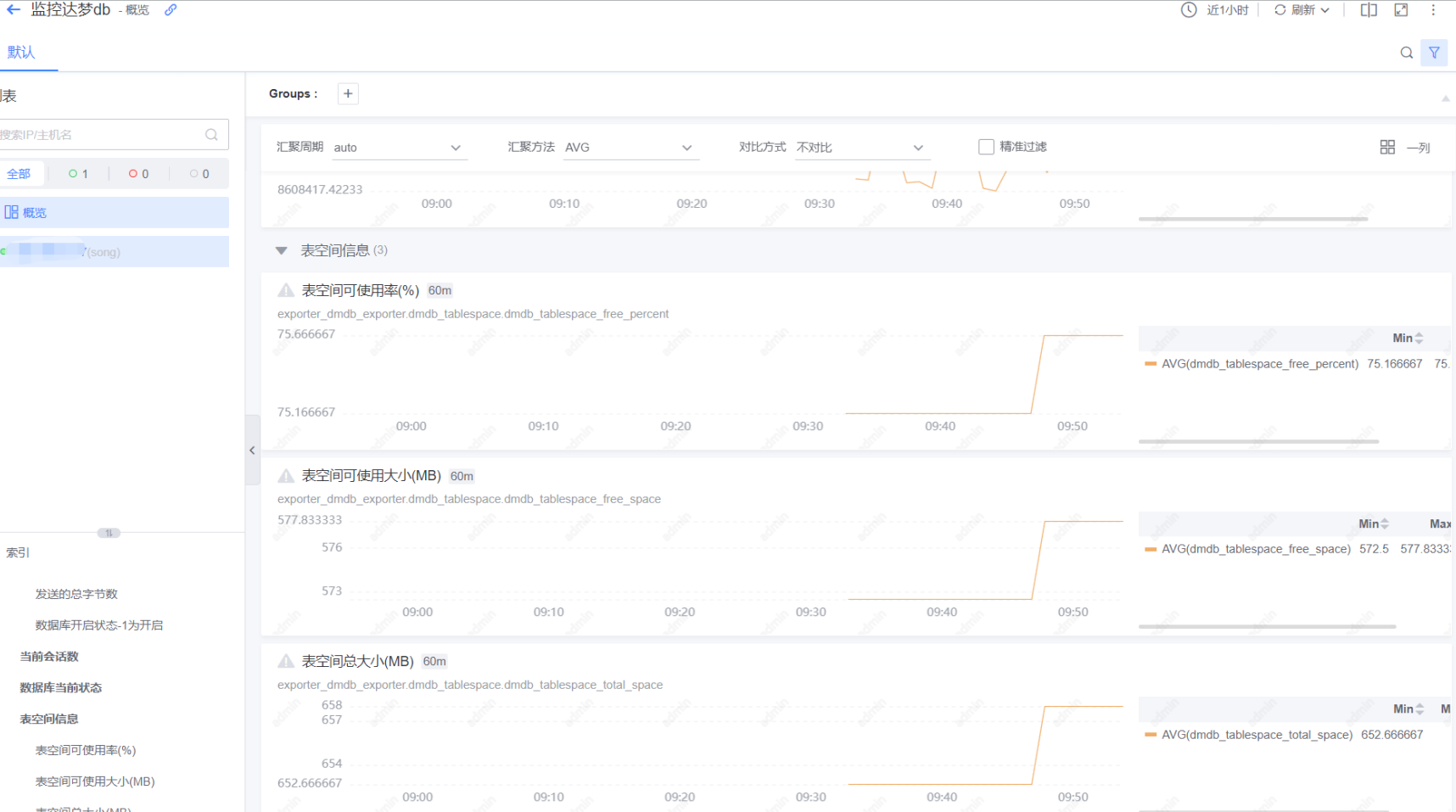

exporter方式监控达梦数据库

蓝鲸监控 随着国产化和信创的深入,开始普遍使用国产化数据库–如达梦数据库,蓝鲸平台默认没有对其进行监控,但是平台了提供监控告警的能力。比如脚本采集,脚本的是一种灵活和快速的监控采集方式,不同层的监控对象都可…...

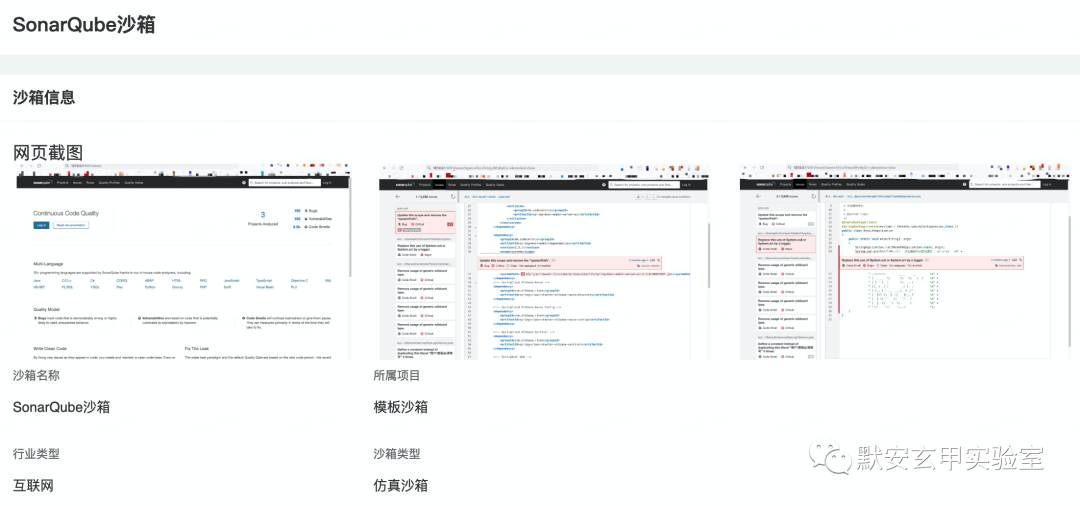

供应链安全之被忽略的软件质量管理平台安全

背景 随着我国信息化进程加速,网络安全问题更加凸显。关键信息基础设施和企业单位在满足等保合规的基础上,如何提升网络安全防御能力,降低安全事件发生概率?默安玄甲实验室针对SonarQube供应链安全事件进行分析,强调供…...

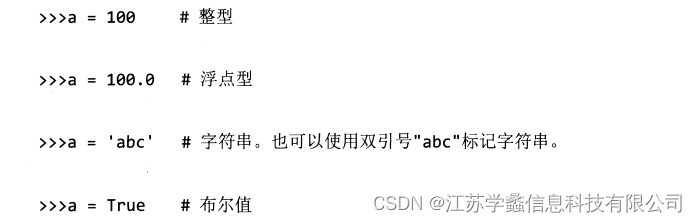

python入门(二)

python的安装很方便,我们这里就不再进行讲解,大家可以自己去搜索视频。下面分享一下Python的入门知识点。 执行命令的方式 在安装好python后,有两种方式可以执行命令: 命令行程序文件,后缀名为.py 对于命令行&…...

Mysql,MongoDB,Redis的横纵向对比

一,什么是Mysql Mysql是一款安全,可以跨平台,高效率的数据库系统,运行速度高,安全性能高,支持面向对象,安全性高,并且成本比较低,支持各种开发语言,数据库的存储容量大,有许多的内置函数。 二,什么是MongoDB MongoDB是基于分布式文件存储的数据库,是一个介于关…...

css3 实现html样式蛇形布局

文章目录 1. 实现效果2. 实现代码 1. 实现效果 2. 实现代码 <template><div class"body"><div class"title">CSS3实现蛇形布局</div><div class"list"><div class"item" v-for"(item, index) …...

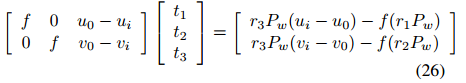

基于消失点的相机自标定

基于消失点的相机自标定 附赠最强自动驾驶学习资料:直达链接 相机是通过透视投影变换来将3D场景转换为2D图像。在射影变换中,平行线相交于一点称之为消失点。本文详细介绍了两种利用消失点特性的标定方法。目的是为根据实际应用和初始条件选择合适的标…...

Python:filter过滤器

filter() 是 Python 中的一个内置函数,用于过滤序列,过滤掉不符合条件的元素,返回由符合条件元素组成的新列表。该函数接收两个参数,一个是函数,一个是序列,序列的每个元素作为参数传递给函数进行判定&…...

Python函数学习

Python函数学习 1.函数定义 在函数定义阶段只检查函数的语法问题 2.实参形参 总结: (1)位置参数就是经常用的按照位置顺序给出实参的值; (2)关键字实参形式:key123;放在…...

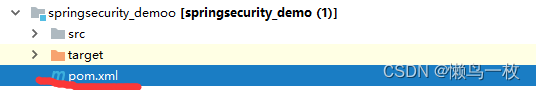

IDEA中的Project工程、Module模块的概念及创建导入

1、IDEA中的层级关系: project(工程) - module(模块) - package(包) - class(类)/接口具体的: 一个project中可以创建多个module一个module中可以创建多个package一个package中可以创建多个class/接口2、Project和Module的概念: 在 IntelliJ …...

如何快速下载并剪辑B站视频

1、B站手机端右上角缓存视频; 2、在手机文件管理助手中找到android/data/80找到两个文件,video.m4s和audio.m4s,将它们发送到电脑,系统会默认保存在你的个人文件夹里,C:\users\用户名 3、下载ffmepg https://blog.cs…...

AI-调查研究-01-正念冥想有用吗?对健康的影响及科学指南

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

使用VSCode开发Django指南

使用VSCode开发Django指南 一、概述 Django 是一个高级 Python 框架,专为快速、安全和可扩展的 Web 开发而设计。Django 包含对 URL 路由、页面模板和数据处理的丰富支持。 本文将创建一个简单的 Django 应用,其中包含三个使用通用基本模板的页面。在此…...

)

论文解读:交大港大上海AI Lab开源论文 | 宇树机器人多姿态起立控制强化学习框架(二)

HoST框架核心实现方法详解 - 论文深度解读(第二部分) 《Learning Humanoid Standing-up Control across Diverse Postures》 系列文章: 论文深度解读 + 算法与代码分析(二) 作者机构: 上海AI Lab, 上海交通大学, 香港大学, 浙江大学, 香港中文大学 论文主题: 人形机器人…...

基于距离变化能量开销动态调整的WSN低功耗拓扑控制开销算法matlab仿真

目录 1.程序功能描述 2.测试软件版本以及运行结果展示 3.核心程序 4.算法仿真参数 5.算法理论概述 6.参考文献 7.完整程序 1.程序功能描述 通过动态调整节点通信的能量开销,平衡网络负载,延长WSN生命周期。具体通过建立基于距离的能量消耗模型&am…...

模型参数、模型存储精度、参数与显存

模型参数量衡量单位 M:百万(Million) B:十亿(Billion) 1 B 1000 M 1B 1000M 1B1000M 参数存储精度 模型参数是固定的,但是一个参数所表示多少字节不一定,需要看这个参数以什么…...

基于服务器使用 apt 安装、配置 Nginx

🧾 一、查看可安装的 Nginx 版本 首先,你可以运行以下命令查看可用版本: apt-cache madison nginx-core输出示例: nginx-core | 1.18.0-6ubuntu14.6 | http://archive.ubuntu.com/ubuntu focal-updates/main amd64 Packages ng…...

生成 Git SSH 证书

🔑 1. 生成 SSH 密钥对 在终端(Windows 使用 Git Bash,Mac/Linux 使用 Terminal)执行命令: ssh-keygen -t rsa -b 4096 -C "your_emailexample.com" 参数说明: -t rsa&#x…...

全志A40i android7.1 调试信息打印串口由uart0改为uart3

一,概述 1. 目的 将调试信息打印串口由uart0改为uart3。 2. 版本信息 Uboot版本:2014.07; Kernel版本:Linux-3.10; 二,Uboot 1. sys_config.fex改动 使能uart3(TX:PH00 RX:PH01),并让boo…...

tree 树组件大数据卡顿问题优化

问题背景 项目中有用到树组件用来做文件目录,但是由于这个树组件的节点越来越多,导致页面在滚动这个树组件的时候浏览器就很容易卡死。这种问题基本上都是因为dom节点太多,导致的浏览器卡顿,这里很明显就需要用到虚拟列表的技术&…...

基于SpringBoot在线拍卖系统的设计和实现

摘 要 随着社会的发展,社会的各行各业都在利用信息化时代的优势。计算机的优势和普及使得各种信息系统的开发成为必需。 在线拍卖系统,主要的模块包括管理员;首页、个人中心、用户管理、商品类型管理、拍卖商品管理、历史竞拍管理、竞拍订单…...