Hive的分区与排序

一、Hive分区

1.引入:

在大数据中,最常见的一种思想就是分治,我们可以把大的文件切割划分成一个个的小的文件,这样每次操作一个个小的文件就会很容易了,同样的道理,在hive当中也是支持这种思想的,就是我们可以把大的数据,按照每天或者每小时切分成一个个小的文件,这样去操作小的文件就会容易很多了。

2.优点:

避免全局搜索,减少数据扫描工作量,提高了查询效率。

3.静态分区(SP)

借助于物理的文件夹分区,实现快速检索的目的

一般对于查询比较频繁的列设置为分区列

需要手动插入或加载数据进行分区

创建单分区表语法:

CREATE TABLE IF NOT EXISTS t_student (

sno int,

sname string

) partitioned by(grade int)

row format delimited fields terminated by ',';-- 分区的字段不要和表的字段相同。相同会报错error10035

1,xiaohu01,1

2,xiaohu02,1

3,xiaohu03,1

4,xiaohu04,1

5,xiaohu05,16,xiaohu06,2

7,xiaohu07,2

8,xiaohu08,29,xiaohu09,3

10,xiaohu10,3

11,xiaohu11,3

12,xiaohu12,3

13,xiaohu13,3

14,xiaohu14,3

15,xiaohu15,316,xiaohu16,4

17,xiaohu17,4

18,xiaohu18,4

19,xiaohu19,4

20,xiaohu20,4

21,xiaohu21,4

-- 载入数据

-- 将相应年级依次导入

load data local inpath '/usr/local/soft/bigdata29/wendang/gread_data/grade1.txt' into table t_student partition(grade=1);load data local inpath '/usr/local/soft/bigdata29/wendang/gread_data/grade2.txt' into table t_student partition(grade=2);

load data local inpath '/usr/local/soft/bigdata29/wendang/gread_data/grade3.txt' into table t_student partition(grade=3);

load data local inpath '/usr/local/soft/bigdata29/wendang/gread_data/grade4.txt' into table t_student partition(grade=4);

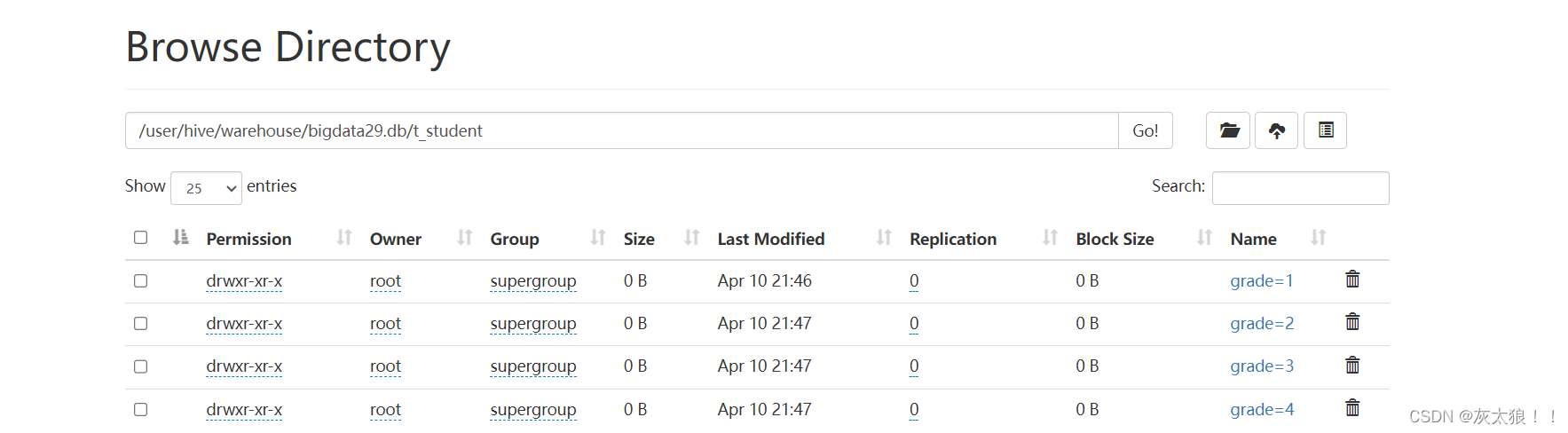

图示:

静态多分区表语法:

CREATE TABLE IF NOT EXISTS t_teacher (

tno int,

tname string

) partitioned by(grade int,clazz int)

row format delimited fields terminated by ',';--注意:前后两个分区的关系为父子关系,也就是grade文件夹下面有多个clazz子文件夹。

1,xiaoge01,1,1

2,xiaoge02,1,13,xiaoge03,1,2

4,xiaoge04,1,25,xiaoge05,1,3

6,xiaoge06,1,37,xiaoge07,2,1

8,xiaoge08,2,19,xiaoge09,2,2

--载入数据

load data local inpath ''/usr/local/soft/bigdata29/wendang/gread_data/grade11.txt'' into table t_teacher partition(grade=1,clazz=1);load data local inpath ''/usr/local/soft/bigdata29/wendang/gread_data/grade12.txt'' into table t_teacher partition(grade=1,clazz=2);

load data local inpath ''/usr/local/soft/bigdata29/wendang/gread_data/grade13.txt'' into table t_teacher partition(grade=1,clazz=3);

load data local inpath ''/usr/local/soft/bigdata29/wendang/gread_data/grade21.txt'' into table t_teacher partition(grade=2,clazz=1);

load data local inpath ''/usr/local/soft/bigdata29/wendang/gread_data/grade22.txt'' into table t_teacher partition(grade=2,clazz=2);

4.动态分区(DP)

-

静态分区与动态分区的主要区别在于静态分区是手动指定,而动态分区是通过数据来进行判断。

-

详细来说,静态分区的列是在编译时期通过用户传递来决定的;动态分区只有在SQL执行时才能决定。

开启动态分区首先要在hive会话中设置如下的参数:

# 表示开启动态分区

hive> set hive.exec.dynamic.partition=true;# 表示动态分区模式:strict(需要配合静态分区一起使用)、nostrict

hive> set hive.exec.dynamic.partition.mode=nonstrict;===================以下是可选参数======================

# 表示支持的最大的分区数量为1000,可以根据需求自己调整

hive> set hive.exec.max.dynamic.partitions.pernode=1000;# 设置为true表示开启动态分区的功能(默认为false)

--hive.exec.dynamic.partition=true;# 设置为nonstrict,表示允许所有分区都是动态的(默认为strict)

-- hive.exec.dynamic.partition.mode=nonstrict;

-- hive.exec.dynamic.partition.mode=strict;# 每个mapper或reducer可以创建的最大动态分区个数(默认为100)

比如:源数据中包含了一年的数据,即day字段有365个值,那么该参数就需要设置成大于365,如果使用默认值100,则会报错

--hive.exec.max.dynamic.partition.pernode=100;# 一个动态分区创建可以创建的最大动态分区个数(默认值1000)

--hive.exec.max.dynamic.partitions=1000;# 全局可以创建的最大文件个数(默认值100000)

--hive.exec.max.created.files=100000;# 当有空分区产生时,是否抛出异常(默认false)

-- hive.error.on.empty.partition=false;

动态分区案例: 动态插入学生年级班级信息

--创建分区表

CREATE TABLE IF NOT EXISTS t_student_d (

sno int,

sname string

) partitioned by (grade int,clazz int)

row format delimited fields terminated by ',';--创建原始数据表(外部)

CREATE EXTERNAL TABLE IF NOT EXISTS t_student_e (sno int,

sname string,

grade int,

clazz int

)

row format delimited fields terminated by ',';

原始表数据:

1,xiaohu01,1,1

2,xiaohu02,1,1

3,xiaohu03,1,1

4,xiaohu04,1,2

5,xiaohu05,1,2

6,xiaohu06,2,3

7,xiaohu07,2,3

8,xiaohu08,2,3

9,xiaohu09,3,3

10,xiaohu10,3,3

11,xiaohu11,3,3

12,xiaohu12,3,4

13,xiaohu13,3,4

14,xiaohu14,3,4

15,xiaohu15,3,4

16,xiaohu16,4,4

17,xiaohu17,4,4

18,xiaohu18,4,5

19,xiaohu19,4,5

20,xiaohu20,4,5

21,xiaohu21,4,5

将原始数据表的查询结果作为分区结果加载到分区表中:

insert overwrite table t_student_d partition (grade,clazz) select * from t_student_e;

5.分区表操作

举例:

(1)全表扫描,不推荐,效率低

select count(*) from st_student_d;

(2)使用where条件进行分区裁剪,避免了全表扫描,效率高

select count(*) from st_student_d where grade = 1;

(3)也可以在where条件中使用非等值判断

select count(*) from t_student_d where grade<3 and grade>=1;

(4)查看分区

show partitions t_student_d;

(5)添加分区

alter table t_student_d add partition (grade=6);

(6)删除分区

alter table t_student_d drop partition (grade=5);

2.1 业务场景

数据分桶的适用场景:

二、Hive分桶

1.概述与使用场景

概述:在Hive中,分桶是一种用于提高查询性能的技术,通过将数据集分成更小的、可管理的部分来实现。分桶是通过对表的某一列进行哈希来实现的,Hive会根据分桶列的值来确定数据应该放入哪个桶。

使用场景:当我们的分区之后,最后的文件还是很大怎么办,就引入了分桶的概念。将这个比较大的文件再分成若干个小文件进行存储,我们再去查询的时候,在这个小范围的文件中查询就会快很多。对于hive中的每一张表、分区都可以进一步的进行分桶。当然,分桶不是说将文件随机进行切分存储,而是有规律的进行存储。

2.数据分桶原理

Hive采用对列值哈希,然后除以桶的个数求余的方式决定该条记录存放在哪个桶当中

-

bucket num = hash_function(bucketing_column) mod num_buckets

-

列的值做哈希取余 决定数据应该存储到哪个桶

3.数据分桶优势

方便抽样

使取样(sampling)更高效。在处理大规模数据集时,在开发和修改查询的阶段,如果能在数据集的一小部分数据上试运行查询,会带来很多方便

提高join查询效率

获得更高的查询处理效率。桶为表加上了额外的结构,Hive 在处理有些查询时能利用这个结构。具体而言,连接两个在(包含连接列的)相同列上划分了桶的表,可以使用 Map 端连接 (Map-side join)高效的实现。比如JOIN操作。对于JOIN操作两个表有一个相同的列,如果对这两个表都进行了桶操作。那么将保存相同列值的桶进行JOIN操作就可以,可以大大较少JOIN的数据量。

4.分桶案例:

(1)首先我们需要开启分桶的支持

set hive.enforce.bucketing=true;

(2)创建一个普通的表

create table person

(

id int,

name string,

age int

)

row format delimited

fields terminated by ',';

(3)数据准备(id,name,age)

1,tom,11

2,cat,22

3,dog,33

4,hive,44

5,hbase,55

6,mr,66

7,alice,77

8,scala,88将数据load到person表中

load data local inpath '文件在Linux上的绝对路径' into table psn31;

(4)创建分桶表

create table psn_bucket

(

id int,

name string,

age int

)

clustered by(age) into 4 buckets

row format delimited fields terminated by ',';

(5)将查询的数据insert到表psn_bucket中

insert into psn_bucket select * from person;

5.分桶和分区的区别

分区和分桶的区别在于其提供的性能优化方向不同。分区适用于数据快速访问特定的数据范围,而分桶适用于对于数据JOIN操作的效率提升。

分区之后会产生分区文件夹,数据会存储在问价夹下的文件中,分桶不会产生文件夹,数据直接存储在分桶之后的文件中。简而言之,分区是对数据进行划分,而分桶是对文件进行划分。

三、Java连接hive(Hive JDBC)

1.启动hiveserver2

hiveserver2 &

2.新建maven项目并添加两个依赖

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.6</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-jdbc -->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>1.2.1</version>

</dependency>

3.编写JDBC代码

import java.sql.*;public class HiveJDBC {public static void main(String[] args) throws ClassNotFoundException, SQLException {Class.forName("org.apache.hive.jdbc.HiveDriver");Connection conn = DriverManager.getConnection("jdbc:hive2://master:10000/bigdata29");Statement stat = conn.createStatement();ResultSet rs = stat.executeQuery("select * from students limit 10");while (rs.next()) {int id = rs.getInt(1);String name = rs.getString(2);int age = rs.getInt(3);String gender = rs.getString(4);String clazz = rs.getString(5);System.out.println(id + "," + name + "," + age + "," + gender + "," + clazz);}rs.close();stat.close();conn.close();}

}四、Hive排序

1.全局排序(order by )

-

order by 会对输入做全局排序,因此只有一个reducer,会导致当输入规模较大时,需要较长的计算时间

-

使用 order by子句排序 :ASC(ascend)升序(默认)| DESC(descend)降序

-

order by放在select语句的结尾

-

语法:select * from 表名 order by 字段名1[,别名2...];

2.局部排序(对reduce内部做排序)

-

sort by 不是全局排序,其在数据进入reducer前完成排序。

-

如果用sort by进行排序,并且设置mapred.reduce.tasks大于1,则sort by 只保证每个reducer的输出有序,不保证全局有序。asc,desc都可以。

步骤:

(1)设置reduce个数

set mapreduce.job.reduce=自定义数量;

(2)查看reduce个数

set mapreduce.job.reduces;

(3)排序

select * from 表名 sort by 字段名[,字段名...];

3.分区排序(本身没有排序)

-

distribute by(字段)根据指定的字段将数据分到不同的reducer,且分发算法是hash散列。

类似MR中partition,进行分区,结合sort by使用。(注意:distribute by 要在sort by之前)

-

对于distrbute by 进行测试,一定要多分配reduce进行处理,否则无法看到distribute by的效果。

步骤:

(1)设置reduce个数

set mapreduce.job.reduce=自定义数量;

(2)排序

select * from 表名 distribute by 字段名[,字段名...] sort by 字段;

4.分区并排序

-

cluster by(字段)除了具有Distribute by的功能外,还会对该字段进行排序 asc desc

-

cluster by = distribute by + sort by 只能默认升序,不能使用倒序

语法:

select * from 表名 distribute by 字段名[,字段名...] sort by 字段名[,字段名...];

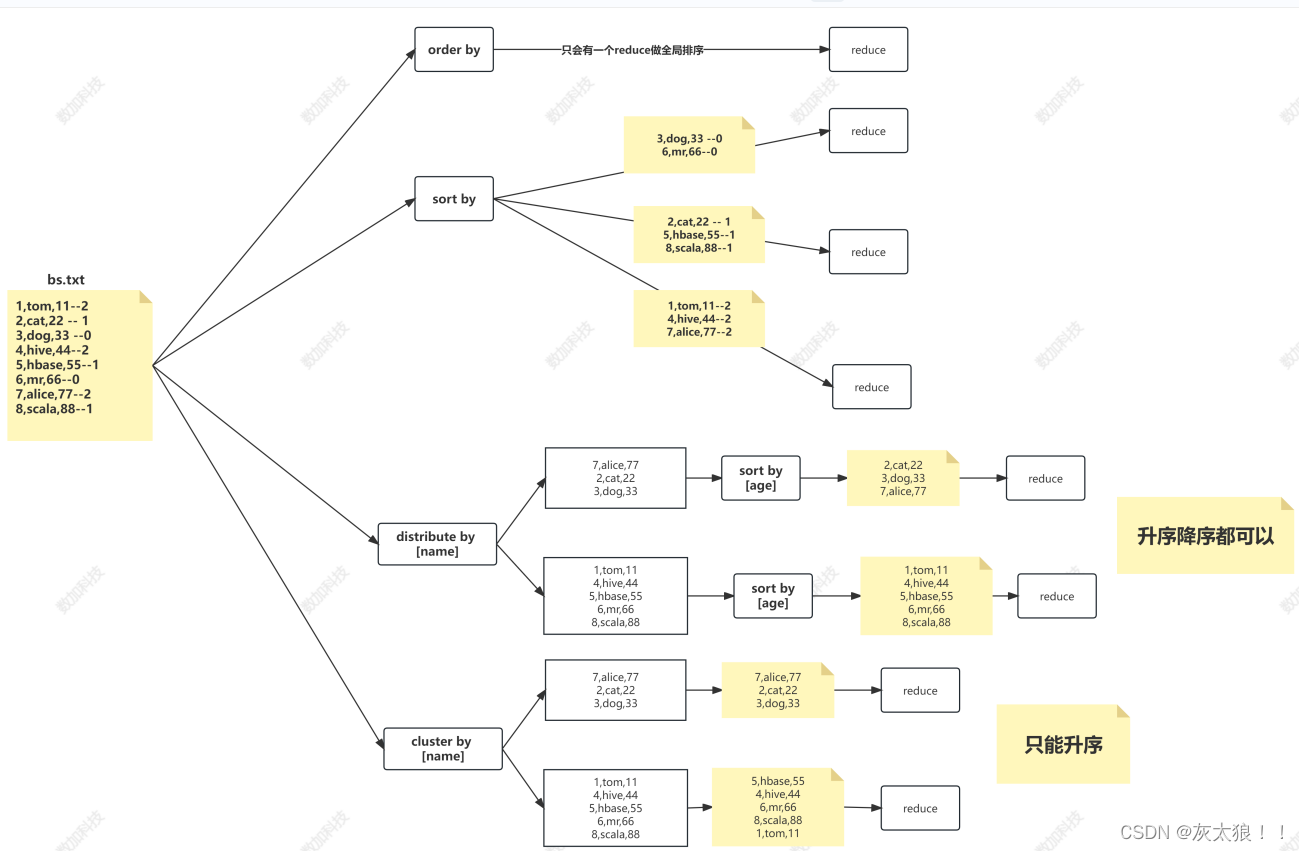

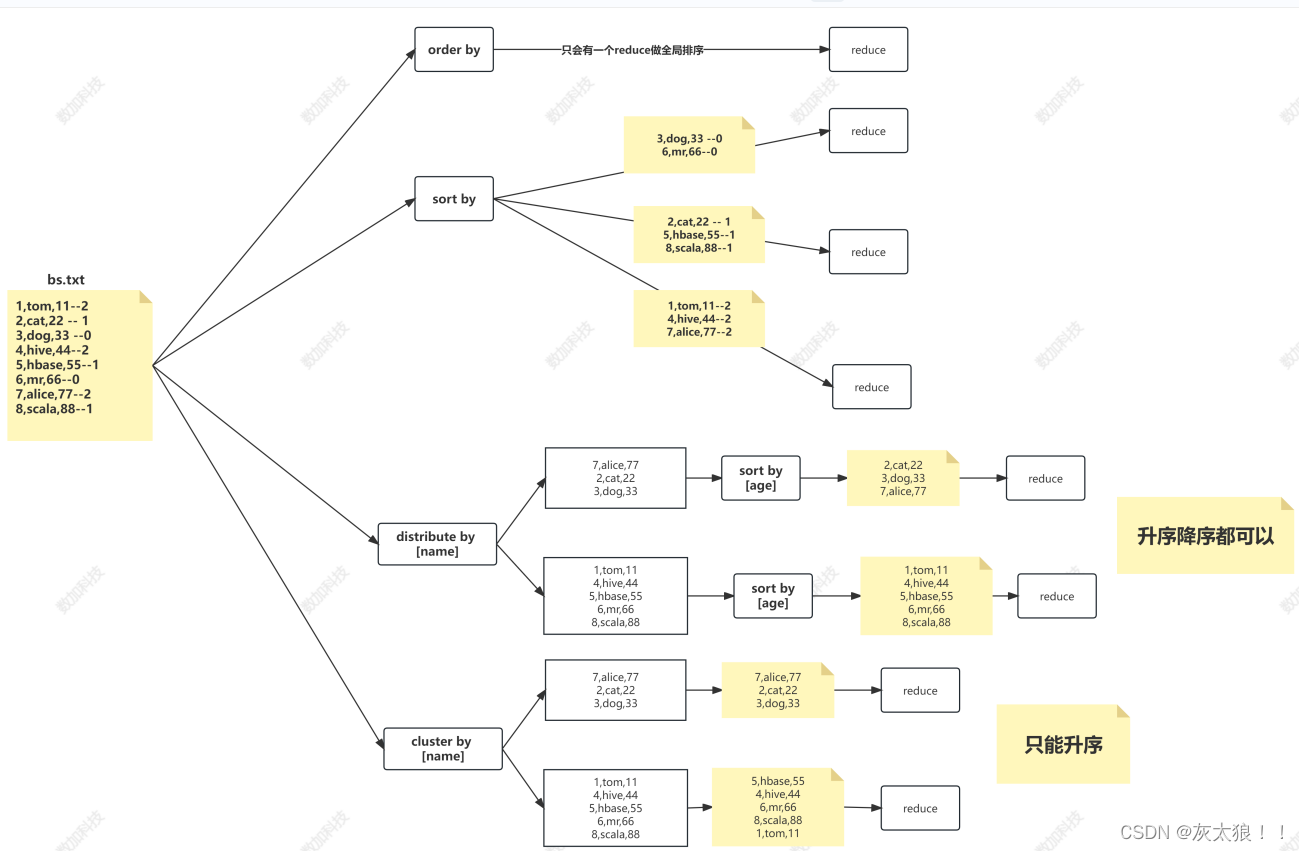

四种排序图解:

相关文章:

Hive的分区与排序

一、Hive分区 1.引入: 在大数据中,最常见的一种思想就是分治,我们可以把大的文件切割划分成一个个的小的文件,这样每次操作一个个小的文件就会很容易了,同样的道理,在hive当中也是支持这种思想的ÿ…...

4.9)

Objective-C学习笔记(内存管理、property参数)4.9

1.引用计数器retainCount:每个对象都有这个属性,默认值为1,记录当前对象有多少人用。 为对象发送一条retain/release消息,对象的引用计数器加/减1,为对象发一条retainCount,得到对象的引用计数器值,当计数器…...

C语言进阶课程学习记录-第29课 - 指针和数组分析(下)

C语言进阶课程学习记录-第29课 - 指针和数组分析(下) 数组名与指针实验-数组形式转换实验-数组名与指针的差异实验-转化后数组名加一的比较实验-数组名作为函数形参小结 本文学习自狄泰软件学院 唐佐林老师的 C语言进阶课程,图片全部来源于课…...

一起学习python——基础篇(13)

前言,python编程语言对于我个人来说学习的目的是为了测试。我主要做的是移动端的开发工作,常见的测试主要分为两块,一块为移动端独立的页面功能,另外一块就是和其他人对接工作。 对接内容主要有硬件通信协议、软件接口文档。而涉…...

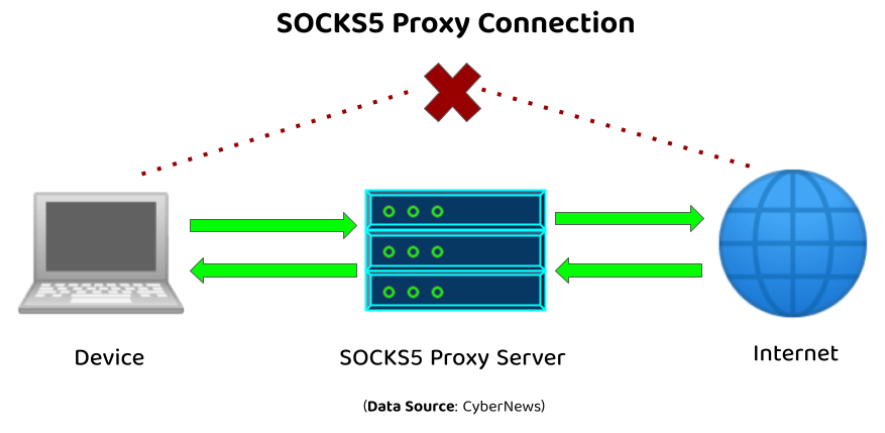

SOCKS代理概述

在网络技术的广阔领域中🌐,SOCKS代理是一个核心组件,它在提升在线隐私保护🛡️、实现匿名通信🎭以及突破网络访问限制🚫方面发挥着至关重要的作用。本文旨在深入探讨SOCKS代理的基础,包括其定义…...

AI助力M-OFDFT实现兼具精度与效率的电子结构方法

编者按:为了使电子结构方法突破当前广泛应用的密度泛函理论(KSDFT)所能求解的分子体系规模,微软研究院科学智能中心的研究员们基于人工智能技术和无轨道密度泛函理论(OFDFT)开发了一种新的电子结构计算框架…...

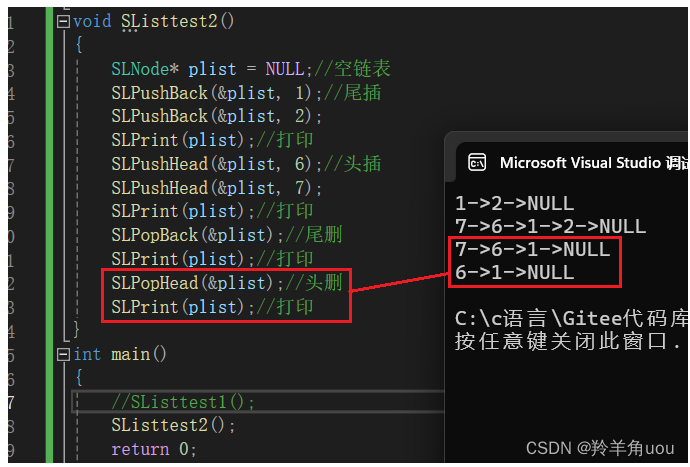

【数据结构】单链表(一)

上一篇【数据结构】顺序表-CSDN博客 我们了解了顺序表,但是呢顺序表涉及到了一些问题,比如,中间/头部的插入/删除,时间复杂度为O(N);增容申请空间、拷贝、释放旧空间会有不小的消耗;增容所浪费的空间... 我们如何去解…...

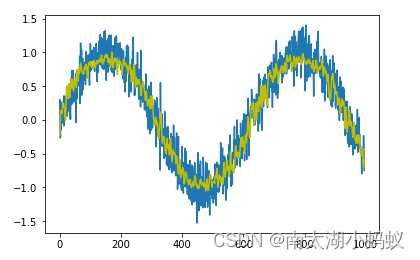

SCI一区 | Matlab实现INFO-TCN-BiGRU-Attention向量加权算法优化时间卷积双向门控循环单元注意力机制多变量时间序列预测

SCI一区 | Matlab实现INFO-TCN-BiGRU-Attention向量加权算法优化时间卷积双向门控循环单元注意力机制多变量时间序列预测 目录 SCI一区 | Matlab实现INFO-TCN-BiGRU-Attention向量加权算法优化时间卷积双向门控循环单元注意力机制多变量时间序列预测预测效果基本介绍模型描述程…...

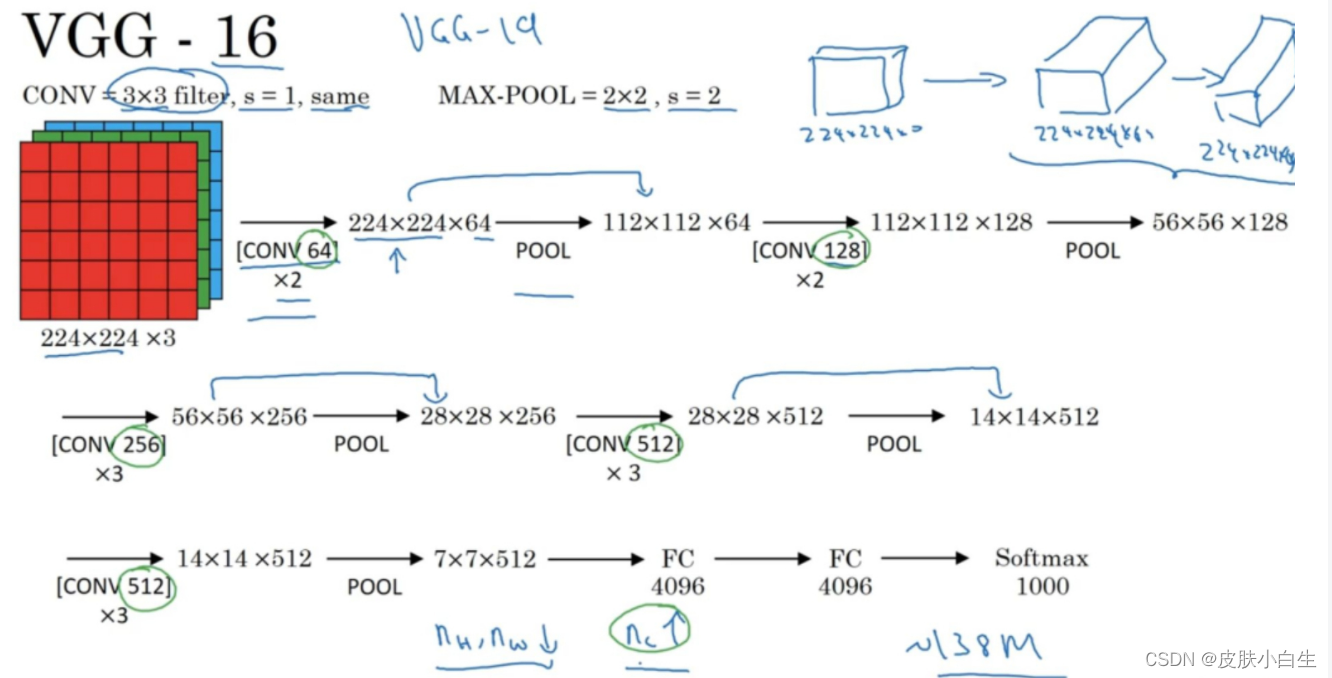

Coursera吴恩达《深度学习》课程总结(全)

这里有Coursera吴恩达《深度学习》课程的完整学习笔记,一共5门课:《神经网络和深度学习》、《改善深层神经网络》、《结构化机器学习项目》、《卷积神经网络》和《序列模型》, 第一门课:神经网络和深度学习基础,介绍一…...

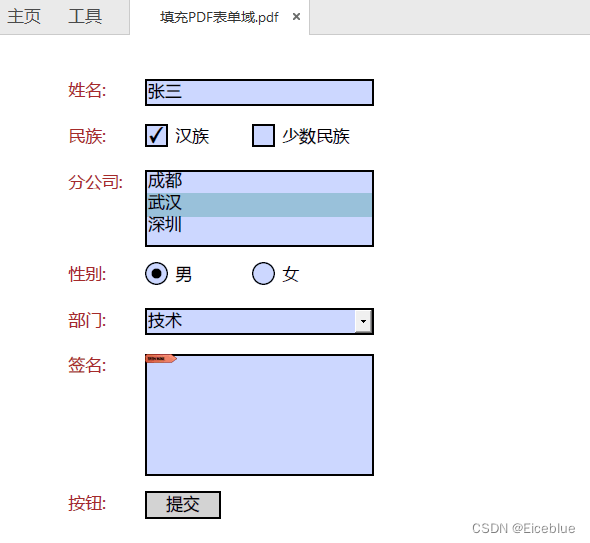

C# 操作PDF表单 - 创建、填写、删除PDF表单域

通常情况下,PDF文件是不可编辑的,但PDF表单提供了一些可编辑区域,允许用户填写和提交信息。PDF表单通常用于收集信息、反馈或进行在线申请,是许多行业中数据收集和交换的重要工具。 PDF表单可以包含各种类型的输入控件࿰…...

Astropy:探索宇宙奥秘的Python工具箱

Astropy:探索宇宙奥秘的Python工具箱 什么是Astropy库? Astropy 是一个面向天文学领域的 Python 库,旨在提供常用的天文学数据结构、单位转换、物理常数以及天文学计算方法等功能。它为天文学家和研究人员提供了丰富的工具,用于处理和分析天文…...

java数据结构与算法刷题-----LeetCode684. 冗余连接

java数据结构与算法刷题目录(剑指Offer、LeetCode、ACM)-----主目录-----持续更新(进不去说明我没写完):https://blog.csdn.net/grd_java/article/details/123063846 文章目录 并查集 并查集 解题思路:时间复杂度O( n ∗ l o g 2…...

循环神经网络简介

卷积神经网络相当于人类的视觉,但是它并没有记忆能力,所以它只能处理一种特定的视觉任务,没办法根据以前的记忆来处理新的任务。比如,在一场电影中推断下一个时间点的场景,这个时候仅依赖于现在的场景还不够࿰…...

计算机网络 子网掩码与划分子网

一、实验要求与内容 1、需拓扑图和两个主机的IP配置截图。 2、设置网络A内的主机IP地址为“192.168.班内学号.2”,子网掩码为“255.255.255.128”,网关为“192.168.班内学号.1”;设置网络B内的主机IP地址为“192.168.班内学号100.2”&#…...

HUD抬头显示器中如何设计LCD的阳光倒灌实验

关键词:阳光倒灌实验、HUD光照温升测试、LCD光照温升测试、太阳光模拟器 HUD(Head-Up Display,即抬头显示器)是一种将信息直接投影到驾驶员视线中的技术,通常用于飞机、汽车等驾驶舱内。HUD系统中的LCD(Liq…...

Shoplazza闪耀Shoptalk 2024,新零售创新解决方案引领行业新篇章!

在近期举办的全球零售业瞩目盛事——Shoptalk 2024大会上,全球*的零售技术平台-店匠科技(Shoplazza)以其*的创新实力与前瞻的技术理念,成功吸引了与会者的广泛关注。此次盛会于3月17日至20日在拉斯维加斯曼德勒湾隆重举行,汇聚了逾万名行业精英。在这场零售业的盛大聚会上,Shop…...

Linux:sprintf、snprintf、vsprintf、asprintf、vasprintf比较

这些函数都在stdio.h里,不过不同系统不同库,有些函数不一定提供。 1. sprintf 函数原型: int sprintf (char *str, const char *format, ...); extern int sprintf (char *__restrict __s, const char *__restrict __format, ...); 功能是将…...

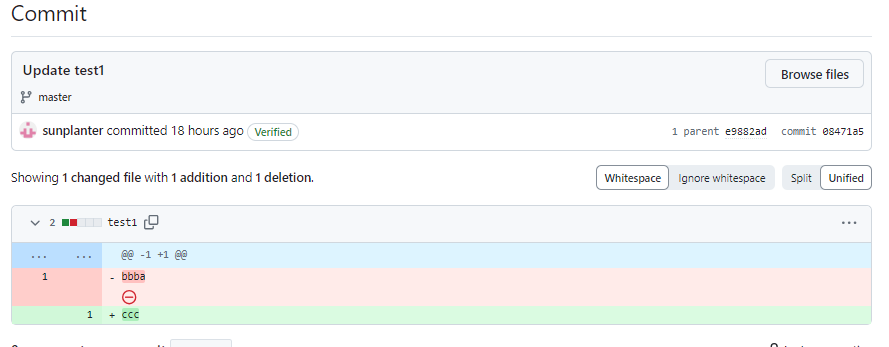

Github远程仓库改名字之后,本地git如何配置?

文章目录 缘由解决方案 缘由 今天在github创建一个仓库,备份一下本地电脑上的资料。起初随便起一个仓库名字,后来修改之。既然远程仓库改名,那么本地仓库需要更新地址。这里采用SSH格式。 解决方案 如果你的GitHub仓库改名了,你…...

4.10)

Objective-C学习笔记(ARC,分类,延展)4.10

1.自动释放池autoreleasepool:存入到自动释放池的对象,在自动释放池销毁时,会自动调用池内所有对象的release方法。调用autorelease方法将对象放入自动释放池。 Person *p1 [ [ [ Person alloc ] init ] autorelease]; 2.在类方法里写一个…...

02 Git 之IDEA 集成使用 GitHub(Git同时管理本地仓库和远程仓库)

2 .IDEA 集成使用 GitHub(Git同时管理本地仓库和远程仓库) 首先在 IDEA 的设置中绑定 GitHub 的账号 先创建一个 test1.txt 文件,内容为 aaa. 最上一栏 VCS, SHARE ON GitHub,然后选择要发送到远程仓库的文件即可。…...

SpringBoot-17-MyBatis动态SQL标签之常用标签

文章目录 1 代码1.1 实体User.java1.2 接口UserMapper.java1.3 映射UserMapper.xml1.3.1 标签if1.3.2 标签if和where1.3.3 标签choose和when和otherwise1.4 UserController.java2 常用动态SQL标签2.1 标签set2.1.1 UserMapper.java2.1.2 UserMapper.xml2.1.3 UserController.ja…...

Spark 之 入门讲解详细版(1)

1、简介 1.1 Spark简介 Spark是加州大学伯克利分校AMP实验室(Algorithms, Machines, and People Lab)开发通用内存并行计算框架。Spark在2013年6月进入Apache成为孵化项目,8个月后成为Apache顶级项目,速度之快足见过人之处&…...

Qwen3-Embedding-0.6B深度解析:多语言语义检索的轻量级利器

第一章 引言:语义表示的新时代挑战与Qwen3的破局之路 1.1 文本嵌入的核心价值与技术演进 在人工智能领域,文本嵌入技术如同连接自然语言与机器理解的“神经突触”——它将人类语言转化为计算机可计算的语义向量,支撑着搜索引擎、推荐系统、…...

指令的指南)

在Ubuntu中设置开机自动运行(sudo)指令的指南

在Ubuntu系统中,有时需要在系统启动时自动执行某些命令,特别是需要 sudo权限的指令。为了实现这一功能,可以使用多种方法,包括编写Systemd服务、配置 rc.local文件或使用 cron任务计划。本文将详细介绍这些方法,并提供…...

关于 WASM:1. WASM 基础原理

一、WASM 简介 1.1 WebAssembly 是什么? WebAssembly(WASM) 是一种能在现代浏览器中高效运行的二进制指令格式,它不是传统的编程语言,而是一种 低级字节码格式,可由高级语言(如 C、C、Rust&am…...

【7色560页】职场可视化逻辑图高级数据分析PPT模版

7种色调职场工作汇报PPT,橙蓝、黑红、红蓝、蓝橙灰、浅蓝、浅绿、深蓝七种色调模版 【7色560页】职场可视化逻辑图高级数据分析PPT模版:职场可视化逻辑图分析PPT模版https://pan.quark.cn/s/78aeabbd92d1...

【网络安全】开源系统getshell漏洞挖掘

审计过程: 在入口文件admin/index.php中: 用户可以通过m,c,a等参数控制加载的文件和方法,在app/system/entrance.php中存在重点代码: 当M_TYPE system并且M_MODULE include时,会设置常量PATH_OWN_FILE为PATH_APP.M_T…...

Python 实现 Web 静态服务器(HTTP 协议)

目录 一、在本地启动 HTTP 服务器1. Windows 下安装 node.js1)下载安装包2)配置环境变量3)安装镜像4)node.js 的常用命令 2. 安装 http-server 服务3. 使用 http-server 开启服务1)使用 http-server2)详解 …...

MySQL:分区的基本使用

目录 一、什么是分区二、有什么作用三、分类四、创建分区五、删除分区 一、什么是分区 MySQL 分区(Partitioning)是一种将单张表的数据逻辑上拆分成多个物理部分的技术。这些物理部分(分区)可以独立存储、管理和优化,…...

解析奥地利 XARION激光超声检测系统:无膜光学麦克风 + 无耦合剂的技术协同优势及多元应用

在工业制造领域,无损检测(NDT)的精度与效率直接影响产品质量与生产安全。奥地利 XARION开发的激光超声精密检测系统,以非接触式光学麦克风技术为核心,打破传统检测瓶颈,为半导体、航空航天、汽车制造等行业提供了高灵敏…...