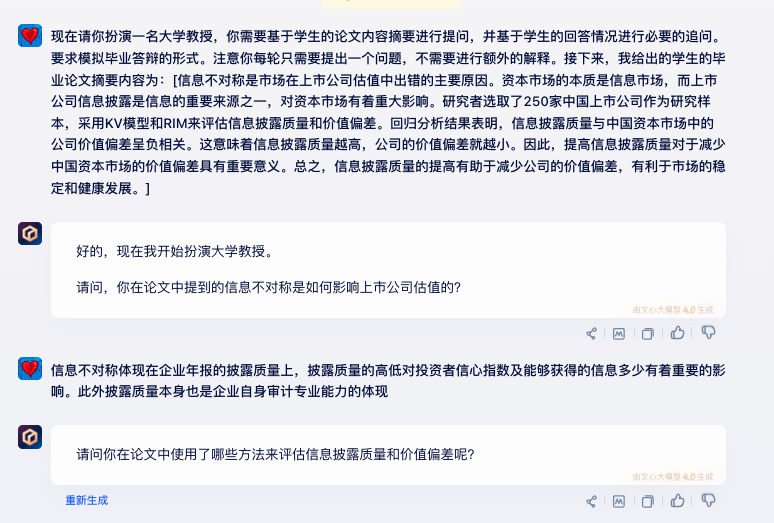

决策树(ID3,C4.5,C5.0,CART算法)以及条件推理决策树R语言实现

### 10.2.1 ID3算法基本原理 ###

mtcars2 <- within(mtcars[,c('cyl','vs','am','gear')], {am <- factor(am, labels = c("automatic", "manual"))vs <- factor(vs, labels = c("V", "S"))cyl <- ordered(cyl)gear <- ordered(gear)

})table(mtcars2$am) # 查看因变量的类别数量I_am <- -19/32*log2(19/32)-13/32*log2(13/32) # 计算因变量的信息熵

I_am# 自定义函数计算信息熵、信息增益

information_gain <- function(x,y){m1 <- matrix(table(y))entropy_y <- sum(-(m1/sum(m1))*log2(m1/sum(m1)))t <- table(x,y)m <- matrix(t,length(unique(x)),length(unique(y)),dimnames = list(levels(x),levels(y)))freq <- -rowSums((m/rowSums(m))*log2(m/rowSums(m)))entropy <- sum(rowSums(m)*freq/dim(mtcars2)[1],na.rm = T)gain <- entropy_y - entropyreturn(c('因变量熵'=entropy_y ,'条件熵'=entropy,'信息增益' = gain))

}

cat('计算条件变量为cyl的熵及信息增益为:\n')

information_gain(mtcars2$cyl,mtcars2$am)

cat('计算条件变量为vs的熵及信息增益为: \n')

information_gain(mtcars2$vs,mtcars2$am)

cat('计算条件变量为gear的熵及信息增益为: \n')

information_gain(mtcars2$gear,mtcars2$am)### 10.2.2 C4.5算法 ###

# 自定义函数计算信息熵、信息增益、信息增益率

gain_rate <- function(x,y){m0 <- matrix(table(x))entropy_x <- sum(-(m0/sum(m0))*log2(m0/sum(m0)))m1 <- matrix(table(y))entropy_y <- sum(-(m1/sum(m1))*log2(m1/sum(m1)))t <- table(x,y)m <- matrix(t,length(unique(x)),length(unique(y)),dimnames = list(levels(x),levels(y)))freq <- -rowSums((m/rowSums(m))*log2(m/rowSums(m)))entropy <- sum(rowSums(m)*freq/dim(mtcars2)[1],na.rm = T)gain <- entropy_y - entropyreturn(c('自变量熵'=entropy_x ,'因变量熵'=entropy_y ,'条件熵'=entropy,'信息增益' = gain,'信息增益率' = gain/entropy_x))

}

cat('计算条件变量为cyl的信息熵及信息增益率为:\n')

round(gain_rate(mtcars2$cyl,mtcars2$am),3)

cat('计算条件变量为vs的信息熵及信息增益率为:\n')

round(gain_rate(mtcars2$vs,mtcars2$am),3)

cat('计算条件变量为gear的信息熵及信息增益率为:\n')

round(gain_rate(mtcars2$gear,mtcars2$am),3)#### 10.3 R语言实现及案例 ####

#10.3.2 C5.0案例

# 利用iris数据集

# install.packages("C50")

install.packages("C50")

library(C50)

tree_mod <- C5.0(x = iris[,c('Petal.Length','Petal.Width')],y = iris$Species)

tree_mod

summary(tree_mod) # 查看详细信息

plot(tree_mod) # 树模型可视化

# 对新样本进行预测

pred_class <- predict(tree_mod,newdata = data.frame('Petal.Length' = 2,'Petal.Width' = 1))

pred_class

pred_prob <- predict(tree_mod,type = 'prob',newdata = data.frame('Petal.Length' = 2,'Petal.Width' = 1))

round(pred_prob,3)# 10.3.2.4 提高模型的性能

# library(modeldata)

# data(mlc_churn)

# data(churn)

# 导入数据集

library(modeldata)

library(C50)

#install.packages("modeldata")

data(mlc_churn)

data(churn)

churnTrain <- read.csv('data/churnTrain.csv')

churnTest <- read.csv('data/churnTest.csv')

churnTrain$churn <- as.factor(churnTrain$churn)

churnTest$churn <- as.factor(churnTest$churn)

# 构建模型

treeModel <- C5.0(x = churnTrain[, -20],y = churnTrain$churn)

treeModel1 <- C5.0(x = churnTrain[, -20],y = churnTrain$churn,trials = 10) # 使用10次boosting迭代

# 查看模型对训练数据集的混淆矩阵

(t0 <- table(churnTrain$churn,predict(treeModel,newdata = churnTrain)))

(t1 <- table(churnTrain$churn,predict(treeModel1,newdata = churnTrain)))

cat('普通模型对训练集的预测准确率:',paste0(round(sum(diag(t0))*100/sum(t0),2),"%"))

cat('增加boosting的模模型对训练集的预测准确率:',paste0(round(sum(diag(t1))*100/sum(t1),2),"%"))# 查看模型对测试数据集的混淆矩阵

(c0 <- table(churnTest$churn,predict(treeModel,newdata = churnTest)))

(c1 <- table(churnTest$churn,predict(treeModel1,newdata = churnTest)))

cat('普通模型对测试集的预测准确率:',paste0(round(sum(diag(c0))*100/sum(c0),2),"%"))

cat('增加boosting的模模型对测试集的预测准确率:',paste0(round(sum(diag(c1))*100/sum(c1),2),"%"))# 定义代价矩阵

cost_mat <- matrix(c(0,1,2,0),nrow = 2)

rownames(cost_mat) <- colnames(cost_mat) <- c("no", "yes")

cost_mat# 增加代价矩阵的决策树模型

treeModel2 <- C5.0(x = churnTrain[, -20],y = churnTrain$churn,costs = cost_mat)

# 普通模型的预测结果

pred <- predict(treeModel,newdata = churnTrain)

# 增加代价矩阵模型的预测结果

pred2 <- predict(treeModel2,newdata = churnTrain)

# 普通模型预测结果的混淆矩阵

table('Actual' = churnTrain$churn,'Prediction' = pred)

# 普通模型的查全率

paste0(round(sum(pred=='yes')*100/sum(churnTrain$churn=='yes'),2),'%')

# 增加代价矩阵模型预测结果的混淆矩阵

table('Actual' = churnTrain$churn,'Prediction' = pred2)

# 增加代价矩阵模型的查全率

paste0(round(sum(pred2=='yes')*100/sum(churnTrain$churn=='yes'),2),'%')### 10.3.3 CART案例 ###

# 10.3.3.1 分类树案例

# 分类树构建与预测

library(rpart)

library(rpart.plot)

tree_clf <- rpart(Species ~ Petal.Length + Petal.Width,data = iris)

tree_clf

rpart.plot(tree_clf,extra = 3,digits = 4)

# 对新数据进行预测

predict(tree_clf,newdata = data.frame("Petal.Length" = 5,"Petal.Width" = 1.5),type = 'class')

predict(tree_clf,newdata = data.frame("Petal.Length" = 5,"Petal.Width" = 1.5))# 回归树构建与预测

# 构建决策树

insurance <- read.csv('data/insurance.csv')

insurance$children <- insurance$children

train <- insurance[1:1000,]

test <- insurance[1001:1338,]

tree_reg <- rpart(charges ~ .,data = train)

tree_reg

rpart.plot(tree_reg,type = 4,extra = 1,digits = 4)

# 查看变量重量性,并进行可视化

tree_reg$variable.importance

barplot(tree_reg$variable.importance,col='violetred',border = NA,yaxt='n',main = '回归树的变量重要性')# 对测试集进行预测

pred <- predict(tree_reg,newdata = test)

# 查看前六行结果

data.frame(head(test),prediction = head(pred))# 计算R方

tree_r2 <- cor(test$charges,pred)^2 # 回归树的R2

fit <- lm(charges ~ .,data = train)

pred1 <- predict(fit,newdata = test)

lm_r2 <- cor(test$charges,pred1)^2 # 线性回归的R2

data.frame('模型' = c('回归树','线性回归'),'判定系数' = round(c(tree_r2,lm_r2),3)) # 查看结果# 10.3.3.3 决策树的剪枝

library(rpart)

library(rpart.plot)

weather <- read.csv('data/weather.csv') # 导入weather数据集

input <- c("MinTemp", "MaxTemp", "Rainfall","Evaporation", "Sunshine", "WindGustDir","WindGustSpeed", "WindDir9am", "WindDir3pm","WindSpeed9am", "WindSpeed3pm", "Humidity9am","Humidity3pm", "Pressure9am", "Pressure3pm","Cloud9am", "Cloud3pm", "Temp9am", "Temp3pm","RainToday") # 自变量

output <- 'RainTomorrow' # 因变量# 预剪枝

tree_pre <- rpart(RainTomorrow ~ ., data = weather[,c(input,output)],control = rpart.control(maxdepth = 3)) # 构建决策树

tree_pre # 查看结果# 后剪枝

tree_clf1 <- rpart(RainTomorrow ~ ., data = weather[,c(input,output)]) # 构建决策树

printcp(tree_clf1) # 查看复杂性信息

plotcp(tree_clf1) # 绘制CP表的信息图# 对决策树进行剪枝

tree_clf1_pru <- prune(tree_clf1,cp = 0.059)

tree_clf1_pru# 10.3.4 条件推理决策树案例

if(!require(party)) install.packages("party") # 加载party包

library(party)

weather_sub <- weather[,c(input,output)]

weather_sub$WindGustDir <- as.factor(weather_sub$WindGustDir)

weather_sub$WindDir9am <- as.factor(weather_sub$WindDir9am)

weather_sub$WindDir3pm <- as.factor(weather_sub$WindDir3pm)

weather_sub$RainToday<- as.factor(weather_sub$RainToday)

weather_sub$RainTomorrow <- as.factor(weather_sub$RainTomorrow)tree_ctree <- ctree(RainTomorrow ~ ., data = weather_sub,controls = ctree_control(mincriterion = 0.99))

tree_ctree # 查看模型树

plot(tree_ctree) # 绘制决策树# 提取数据子集,请查看样本个数及因变量类别占比

weather_sub1 <- weather_sub[weather_sub$Cloud3pm<=6 & weather_sub$Pressure3pm<=1011.8,]

nrow(weather_sub1)

round(prop.table(table(weather_sub1$RainTomorrow)),2)# 对数据进行预测

pred <- predict(tree_ctree,newdata = weather_sub)

head(pred)pred_prob <- predict(tree_ctree,type = 'prob',newdata = weather_sub)

head(pred_prob,3)# 10.3.5 绘制决策边界

library(rpart)

library(rpart.plot)

# 数据处理

iris1 <- iris[,c('Petal.Length','Petal.Width','Species')]

iris1$Species <- as.factor(as.numeric(iris1$Species)) # 将类别变成1、2、3

# 生成深度为1的决策树

tree_clf <- rpart(Species ~ Petal.Length + Petal.Width,data = iris1,control = rpart.control(maxdepth = 1))

tree_clf# 编写绘制决策边界函数

visualize_classifier <- function(model,X,y,xlim,ylim,type = c('n','n')){x1s <- seq(xlim[1],xlim[2],length.out=200)x2s <- seq(ylim[1],ylim[2],length.out=200)Z <- expand.grid(x1s,x2s)colnames(Z) <- colnames(X)y_pred <- predict(model,Z,type = 'class')y_pred <- matrix(y_pred,length(x1s))filled.contour(x1s,x2s,y_pred,levels = 1:(length(unique(y))+1),col = RColorBrewer::brewer.pal(length(unique(y)),'Pastel1'),key.axes = FALSE,plot.axes = {axis(1);axis(2);points(X[,1],X[,2],pch=as.numeric(y)+15,col=as.numeric(y)+1,cex=1.5);points(c(2.45,2.45),c(0,3),type = type[1],lwd=2)points(c(2.45,7.5),c(1.75,1.75),type = type[2],lwd=2,lty=2)},xlab = colnames(X)[1],ylab = colnames(X)[2])

}

# 绘制决策边界

visualize_classifier(tree_clf,xlim = c(0,7.5),ylim = c(0,3),X = iris1[,1:2],iris1$Species,type=c('l','n'))# 生成深度为2的决策树

tree_clf1 <- rpart(Species ~ Petal.Length + Petal.Width,data = iris1,control = rpart.control(maxdepth = 2))

tree_clf1

# 绘制决策边界

visualize_classifier(tree_clf1,xlim = c(0,7.5),ylim = c(0,3),X = iris1[,1:2],iris1$Species,type=c('l','l'))# 10.4 集成学习及随机森林

# 导入car数据集

car <- read.table("data/car.data",sep = ",")

# 对变量重命名

colnames(car) <- c("buy","main","doors","capacity","lug_boot","safety","accept")

# 随机选取75%的数据作为训练集建立模型,25%的数据作为测试集用来验证模型

library(caret)

library(ggplot2)

library(lattice)

# 构建训练集的下标集

ind <- createDataPartition(car$accept,times=1,p=0.75,list=FALSE)

# 构建测试集数据好训练集数据

carTR <- car[ind,]

carTE <- car[-ind,]

carTR<- within(carTR,accept <- factor(accept,levels=c("unacc","acc","good","vgood")))

carTE<- within(carTE,accept <- factor(accept,levels=c("unacc","acc","good","vgood")))# 使用adabag包中的bagging函数实现bagging算法

#install.packages("adabag")

library(adabag)

bagging.model <- bagging(accept~.,data=carTR)# 使用adabag包中的boosting函数实现boosting算法

boosting.model <- boosting(accept~.,data=carTR)# 使用randomForest包中的randomForest函数实现随机森林算法

#install.packages("randomForest")

library(randomForest)

randomForest.model <- randomForest(accept~.,data=carTR,ntree=500,mtry=3)# 预测结果,并构建混淆矩阵,查看准确率

# 构建result,存放预测结果

result <- data.frame(arithmetic=c("bagging","boosting","随机森林"),errTR=rep(0,3),errTE=rep(0,3))

for(i in 1:3){# 预测结果carTR_predict <- predict(switch(i,bagging.model,boosting.model,randomForest.model),newdata=carTR) # 训练集数据carTE_predict <- predict(switch(i,bagging.model,boosting.model,randomForest.model),newdata=carTE) # 测试集数据# 构建混淆矩阵tableTR <- table(actual=carTR$accept,predict=switch(i,carTR_predict$class,carTR_predict$class,carTR_predict))tableTE <- table(actual=carTE$accept,predict=switch(i,carTE_predict$class,carTE_predict$class,carTE_predict))# 计算误差率result[i,2] <- paste0(round((sum(tableTR)-sum(diag(tableTR)))*100/sum(tableTR),2),"%")result[i,3] <- paste0(round((sum(tableTE)-sum(diag(tableTE)))*100/sum(tableTE),2),"%")

}

# 查看结果

result

相关文章:

决策树(ID3,C4.5,C5.0,CART算法)以及条件推理决策树R语言实现

### 10.2.1 ID3算法基本原理 ### mtcars2 <- within(mtcars[,c(cyl,vs,am,gear)], {am <- factor(am, labels c("automatic", "manual"))vs <- factor(vs, labels c("V", "S"))cyl <- ordered(cyl)gear <- ordered…...

文心一言《使用手册》,文心一言怎么用?

一、认识文心一言 (一)什么是文心一言 文心一言是百度研发的 人工智能大语言模型产品,能够通过上一句话,预测生成下一段话。 任何人都可以通过输入【指令】和文心一言进行对话互动、提出问题或要求,让文心一言高效地…...

Spring Boot集成qwen:0.5b实现对话功能

1.什么是qwen:0.5b? 模型介绍: Qwen1.5是阿里云推出的一系列大型语言模型。 Qwen是阿里云推出的一系列基于Transformer的大型语言模型,在大量数据(包括网页文本、书籍、代码等)进行了预训练。 硬件要求:…...

GreenDao实现原理

GreenDao 是一款针对 Android 平台优化的轻量级对象关系映射 (ORM) 框架,它将 Java 对象映射到 SQLite 数据库,以简化数据持久化操作。GreenDao 的主要优点包括高性能、低内存占用、易于使用以及对数据库加密的支持。 以下是基于源码的 GreenDao 实现原…...

Perl语言之数组

Perl数组可以存储多个标量,并且标量数据类型可以不同。 数组变量以开头。访问与定义格式如下: #! /usr/bin/perl arr("asdfasd",2,23.56,a); print "输出所有:arr\n"; print "arr[0]$arr[0]\n"; #输出指定下标 print…...

写材料word和PPT

一、WORD 1、写内容 2、参考GPT改:内容、逻辑结构、语句 3、查标题及其标号 4、修改格式:仿宋 、正文统一为小三,标题三号,1.5倍行距,加页码。 采用VBA代码自动修改,不知为何标题无法修改字体 Sub 插入页…...

Centos---命令详解 vi 系统服务 网络

目录 一、CentOS vi命令详解 二、CentOS系统服务命令 三、CentOS权限管理命令: 四、CentOS网络管理命令介绍: 一、CentOS vi命令详解 Vi是一款强大的文本编辑器,在CentOS中广泛使用。以下是Vi编辑器的一些常用命令: 1. 打开…...

【.NET全栈】ASP.NET开发web应用——ASP.NET中的样式、主题和母版页

文章目录 前言一、在ASP.NET中应用CSS样式1、创建CSS样式(1)内联样式(2)内部样式表(3)外部样式表 2、应用CSS样式(1)菜鸟教程-简单例子(2)菜鸟教程-用户界面&…...

[ruby on rails]部署时候产生ActiveRecord::PreparedStatementCacheExpired错误的原因及解决方法

一、问题: 有时在 Postgres 上部署 Rails 应用程序时,可能会看到 ActiveRecord::PreparedStatementCacheExpired 错误。仅当在部署中运行迁移时才会发生这种情况。发生这种情况是因为 Rails 利用 Postgres 的缓存准备语句(PreparedStatementCache)功能来…...

函数传值面试题

let a {name: aa };function fun1(a) {a []; // 这里创建了一个新的局部变量a,它是一个空数组// a.name "芜湖" }fun1(a); // 调用fun1,传入a的引用副本 console.log(a); // 输出:{ name: aa }在 JavaScript 中,当你…...

redis笔记2

redis是用c语言写的,放不频繁更新的数据(用户数据。课程数据) Redis 中,"穿透"通常指的是缓存穿透(Cache Penetration)问题,这是指一种恶意或非法请求直接绕过缓存层,直接访问数据库或…...

Kafka(四) Consumer消费者

一,基础知识 1,消费者与消费组 每个消费者都有对应的消费组,不同消费组之间互不影响。 Partition的消息只能被一个消费组中的一个消费者所消费, 但Partition也可能被再平衡分配给新的消费者。 一个Topic的不同Partition会根据分配…...

前端路由手写Hash和History两种模式

文章目录 1. Hash模式:简洁而广泛适用2. History模式:更自然的用户体验3. 结论 在现代Web开发中,单页面应用(Single Page Application,简称SPA)因其流畅的用户体验和高效的页面交互能力而备受青睐。前端路由…...

Redis的单线程讲解与指令学习

目录 一.Redis的命令 二.数据类型 三.Redis的key的过期策略如何实现? 四.Redis为什么是单线程的 五.String有关的命令 Redis的学习专栏:http://t.csdnimg.cn/a8cvV 一.Redis的命令 两个基本命令 在Redis当中,有两个基本命令࿱…...

为什么MySQL会选择B+树作为索引

为什么MySQL会选择B树作为索引 在数据库管理系统中,索引是提升查询效率的关键技术之一。MySQL作为广泛使用的关系型数据库管理系统,其核心存储引擎InnoDB选择B树作为其索引结构,这一选择背后蕴含了深刻的性能和存储效率考量。本文将简要介绍…...

k8s secret-从环境变量里去读和从yaml文件里读取secret有什么区别?

从环境变量和YAML文件中读取Kubernetes Secret的区别主要体现在使用方式、动态更新能力以及管理便捷性上。以下是详细的区别说明: 1. **使用方式**: - **环境变量方式**:Kubernetes允许将Secret作为环境变量注入到Pod的容器中。这种方式的好处…...

Springboot+Aop用注解实现阿里云短信验证码校验,校验通过自动删除验证码缓存

1.新建操作类型枚举(这里的IEnum是我自定义的http请求拦截接口,不需要的话可以不用实现) Getter AllArgsConstructor public enum OperationType implements IEnum<Integer> {/*** 注册*/SIGN_UP(0),/*** 密码登录*/LOGIN_BY_PWD(1),/…...

无线物联网新时代,RFID拣货标签跟随潮流

拣选技术的演变历程,本质上是从人力操作向自动化、智能化转型的持续进程。近期,“货寻人”技术成为众多企业热烈追捧的对象,它可以根据企业的特定需求,从众多拣选方案中选出最优解。那么,在采用“货到人”拣选技术时&a…...

Java8 根据List实体中一个字段去重取最大值,并且根据该字段进行排序

1、前言 某个功能要求需要对一个list对象里数据按照股票分组,并且取分组涨跌幅最大的,返回一个新的list对象,并且按照涨跌幅字段进行排序,这么一连串的要求,如果按照传统的写法,我们需要写一大坨的代码&am…...

微服务经纬:Eureka驱动的分布式服务网格配置全解

微服务经纬:Eureka驱动的分布式服务网格配置全解 在微服务架构的宏伟蓝图中,服务网格(Service Mesh)作为微服务间通信的独立层,承担着流量管理、服务发现、故障恢复等关键任务。Eureka,Netflix开源的服务发…...

conda相比python好处

Conda 作为 Python 的环境和包管理工具,相比原生 Python 生态(如 pip 虚拟环境)有许多独特优势,尤其在多项目管理、依赖处理和跨平台兼容性等方面表现更优。以下是 Conda 的核心好处: 一、一站式环境管理:…...

反向工程与模型迁移:打造未来商品详情API的可持续创新体系

在电商行业蓬勃发展的当下,商品详情API作为连接电商平台与开发者、商家及用户的关键纽带,其重要性日益凸显。传统商品详情API主要聚焦于商品基本信息(如名称、价格、库存等)的获取与展示,已难以满足市场对个性化、智能…...

高等数学(下)题型笔记(八)空间解析几何与向量代数

目录 0 前言 1 向量的点乘 1.1 基本公式 1.2 例题 2 向量的叉乘 2.1 基础知识 2.2 例题 3 空间平面方程 3.1 基础知识 3.2 例题 4 空间直线方程 4.1 基础知识 4.2 例题 5 旋转曲面及其方程 5.1 基础知识 5.2 例题 6 空间曲面的法线与切平面 6.1 基础知识 6.2…...

第25节 Node.js 断言测试

Node.js的assert模块主要用于编写程序的单元测试时使用,通过断言可以提早发现和排查出错误。 稳定性: 5 - 锁定 这个模块可用于应用的单元测试,通过 require(assert) 可以使用这个模块。 assert.fail(actual, expected, message, operator) 使用参数…...

)

Java入门学习详细版(一)

大家好,Java 学习是一个系统学习的过程,核心原则就是“理论 实践 坚持”,并且需循序渐进,不可过于着急,本篇文章推出的这份详细入门学习资料将带大家从零基础开始,逐步掌握 Java 的核心概念和编程技能。 …...

什么?连接服务器也能可视化显示界面?:基于X11 Forwarding + CentOS + MobaXterm实战指南

文章目录 什么是X11?环境准备实战步骤1️⃣ 服务器端配置(CentOS)2️⃣ 客户端配置(MobaXterm)3️⃣ 验证X11 Forwarding4️⃣ 运行自定义GUI程序(Python示例)5️⃣ 成功效果

Mac下Android Studio扫描根目录卡死问题记录

环境信息 操作系统: macOS 15.5 (Apple M2芯片)Android Studio版本: Meerkat Feature Drop | 2024.3.2 Patch 1 (Build #AI-243.26053.27.2432.13536105, 2025年5月22日构建) 问题现象 在项目开发过程中,提示一个依赖外部头文件的cpp源文件需要同步,点…...

HDFS分布式存储 zookeeper

hadoop介绍 狭义上hadoop是指apache的一款开源软件 用java语言实现开源框架,允许使用简单的变成模型跨计算机对大型集群进行分布式处理(1.海量的数据存储 2.海量数据的计算)Hadoop核心组件 hdfs(分布式文件存储系统)&a…...

QT3D学习笔记——圆台、圆锥

类名作用Qt3DWindow3D渲染窗口容器QEntity场景中的实体(对象或容器)QCamera控制观察视角QPointLight点光源QConeMesh圆锥几何网格QTransform控制实体的位置/旋转/缩放QPhongMaterialPhong光照材质(定义颜色、反光等)QFirstPersonC…...

Chrome 浏览器前端与客户端双向通信实战

Chrome 前端(即页面 JS / Web UI)与客户端(C 后端)的交互机制,是 Chromium 架构中非常核心的一环。下面我将按常见场景,从通道、流程、技术栈几个角度做一套完整的分析,特别适合你这种在分析和改…...