深入理解Apache Kylin:从概念到实践

深入理解Apache Kylin:从概念到实践

引言

Apache Kylin 是一个分布式分析引擎,专为在大规模数据集上进行快速多维分析(OLAP)设计。自2015年开源以来,Kylin 已经成为许多企业在大数据分析领域的首选工具。本文将从概念到实践,深入探讨 Apache Kylin 的工作原理、核心组件、使用方法及源码解析,帮助读者全面掌握 Apache Kylin。

Apache Kylin 概念

1. 什么是Apache Kylin?

Apache Kylin 是一个开源的分布式分析引擎,它能够在海量数据上实现亚秒级的响应时间。Kylin 将传统的多维数据模型和 Hadoop 生态系统结合起来,通过预计算和高效的存储机制,大幅提升查询性能。

2. Apache Kylin 的核心特性

- 高性能查询:通过预计算机制,Kylin 能够在秒级响应复杂的 OLAP 查询。

- 大规模数据支持:基于 Hadoop 的分布式架构,Kylin 可以处理 PB 级数据。

- 易于扩展:Kylin 支持横向扩展,可以根据需要动态增加计算节点。

- 多种数据源支持:Kylin 可以集成多种数据源,包括 Hive、Kafka、HBase 等。

- 丰富的工具集成:Kylin 支持与 BI 工具(如 Tableau、Power BI)以及数据分析平台(如 Apache Spark)的无缝集成。

3. 核心组件

- Cube:Cube 是 Kylin 的核心数据结构,用于存储预计算的数据。通过 Cube,Kylin 可以快速响应查询。

- Storage Engine:Kylin 支持多种存储引擎,包括 HBase 和 Parquet。

- Query Engine:Kylin 的查询引擎负责将用户的 SQL 查询转换为对 Cube 的高效访问。

- Metadata Store:用于存储 Kylin 的元数据,包括 Cube 定义、数据模型和配置信息。

Apache Kylin 的工作原理

1. 数据建模

数据建模是使用 Kylin 的第一步。通过数据建模,我们可以定义数据源、维度表和事实表。Kylin 提供了一个直观的 Web 界面,用户可以通过拖拽操作完成数据模型的设计。

2. Cube 构建

Cube 构建是 Kylin 的核心步骤。在这一步中,Kylin 会根据用户定义的数据模型,对数据进行预计算和存储。Cube 构建包括以下几个阶段:

- 数据抽取:从数据源中抽取数据,并根据数据模型进行预处理。

- 预计算:对数据进行多维度聚合计算,并生成 Cube 数据。

- 存储:将预计算的 Cube 数据存储到指定的存储引擎中。

3. 查询优化

Kylin 的查询优化器会根据用户的 SQL 查询,自动选择最优的执行计划。通过对 Cube 的高效访问,Kylin 可以在秒级响应查询请求。

实践:搭建Apache Kylin

1. 环境准备

在开始搭建 Apache Kylin 之前,需要准备以下环境:

- Hadoop:Kylin 依赖 Hadoop 进行数据存储和计算。

- Hive:用于数据源的管理和访问。

- HBase:作为 Kylin 的默认存储引擎。

- Spark:用于加速 Cube 构建。

- Kylin:Apache Kylin 的核心服务。

2. 安装步骤

-

安装 Hadoop:

- 下载 Hadoop 安装包并解压。

- 配置 Hadoop 环境变量和配置文件。

- 启动 Hadoop 服务。

-

安装 Hive:

- 下载 Hive 安装包并解压。

- 配置 Hive 环境变量和配置文件。

- 启动 Hive 服务。

-

安装 HBase:

- 下载 HBase 安装包并解压。

- 配置 HBase 环境变量和配置文件。

- 启动 HBase 服务。

-

安装 Spark:

- 下载 Spark 安装包并解压。

- 配置 Spark 环境变量和配置文件。

- 启动 Spark 服务。

-

安装 Kylin:

- 下载 Kylin 安装包并解压。

- 配置 Kylin 环境变量和配置文件。

- 启动 Kylin 服务。

# 安装 Hadoop

tar -zxvf hadoop-3.3.0.tar.gz

mv hadoop-3.3.0 /usr/local/hadoop

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin# 安装 Hive

tar -zxvf apache-hive-3.1.2-bin.tar.gz

mv apache-hive-3.1.2-bin /usr/local/hive

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin# 安装 HBase

tar -zxvf hbase-2.3.4-bin.tar.gz

mv hbase-2.3.4 /usr/local/hbase

export HBASE_HOME=/usr/local/hbase

export PATH=$PATH:$HBASE_HOME/bin# 安装 Spark

tar -zxvf spark-3.1.2-bin-hadoop3.2.tgz

mv spark-3.1.2-bin-hadoop3.2 /usr/local/spark

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin# 安装 Kylin

tar -zxvf apache-kylin-4.0.0-bin.tar.gz

mv apache-kylin-4.0.0-bin /usr/local/kylin

export KYLIN_HOME=/usr/local/kylin

export PATH=$PATH:$KYLIN_HOME/bin

3. 配置 Kylin

安装完成后,需要对 Kylin 进行配置。主要配置文件包括:

- kylin.properties:Kylin 的核心配置文件,包含元数据存储、查询引擎和存储引擎的配置。

- hive-site.xml:Hive 配置文件,Kylin 需要访问 Hive 进行数据抽取。

- hbase-site.xml:HBase 配置文件,Kylin 需要访问 HBase 进行数据存储。

# kylin.properties 示例配置

kylin.metadata.url=kylin_hbase@hbase

kylin.storage.hbase.table-compression-codec=snappy

kylin.engine.spark-conf.spark.executor.instances=2

kylin.engine.spark-conf.spark.executor.memory=2G

kylin.engine.spark-conf.spark.executor.cores=2

将配置文件拷贝到 Kylin 的 conf 目录下,并启动 Kylin 服务。

cp hive-site.xml $KYLIN_HOME/conf/

cp hbase-site.xml $KYLIN_HOME/conf/

kylin.sh start

构建第一个 Cube

1. 创建数据模型

在 Kylin 的 Web 界面上,点击“Models”标签,创建一个新的数据模型。数据模型包括以下几个部分:

- 数据源:选择 Hive 中的表作为数据源。

- 维度:定义数据模型中的维度。

- 度量:定义需要计算的度量,如SUM、COUNT等。

- 分组:根据维度进行分组,生成多维数据。

2. 创建 Cube

在 Kylin 的 Web 界面上,点击“Cubes”标签,创建一个新的 Cube。Cube 的配置包括:

- 基本信息:Cube 的名称、描述等基本信息。

- 数据模型:选择前面创建的数据模型。

- 分区策略:定义数据的分区策略,如时间分区。

- 度量:选择需要计算的度量。

- 聚合组:定义数据的聚合组,用于多维度聚合计算。

3. 构建 Cube

创建 Cube 后,点击“Build”按钮,启动 Cube 的构建过程。Kylin 会根据数据模型和 Cube 配置,对数据进行预计算,并将结果存储到 HBase 中。构建完成后,Cube 可以用于高效的 OLAP 查询。

查询优化与调优

1. 查询优化

Kylin 的查询优化器会根据 SQL 查询,选择最优的执行计划。查询优化主要包括以下几个方面:

- 索引优化:通过预计算生成的索引,提升查询性能。

- 缓存机制:通过缓存机制,减少重复查询的开销。

- 并行计算:通过并行计算,加速查询执行。

2. 性能调优

为了提升 Kylin 的性能,可以进行以下几方面的调优:

- 资源配置:合理配置计算资源,如 Spark Executor 的数量和内存。

- 数据分区:

根据数据的特点,选择合适的分区策略。

- 存储优化:选择合适的存储引擎和压缩算法,提升存储效率。

源码解析

Apache Kylin 的源码可以从官方 GitHub 仓库下载。Kylin 的核心源码包括以下几个部分:

- metadata:Kylin 的元数据管理模块。

- storage:Kylin 的数据存储模块,支持 HBase 和 Parquet 等多种存储引擎。

- query:Kylin 的查询引擎模块,负责将 SQL 查询转换为对 Cube 的访问。

- engine:Kylin 的计算引擎模块,支持 MapReduce 和 Spark 等多种计算引擎。

- web:Kylin 的 Web 界面模块,提供图形化管理和操作界面。

1. Metadata 模块

public class MetadataManager {private Map<String, DataModelDesc> dataModelMap;public DataModelDesc getDataModel(String name) {return dataModelMap.get(name);}public void addDataModel(DataModelDesc dataModel) {dataModelMap.put(dataModel.getName(), dataModel);}public void removeDataModel(String name) {dataModelMap.remove(name);}

}

2. Storage 模块

public class HBaseStorage {private Configuration conf;private Connection connection;public HBaseStorage(Configuration conf) {this.conf = conf;this.connection = ConnectionFactory.createConnection(conf);}public void saveCubeData(String tableName, List<Put> puts) throws IOException {Table table = connection.getTable(TableName.valueOf(tableName));table.put(puts);}public Result getCubeData(String tableName, Get get) throws IOException {Table table = connection.getTable(TableName.valueOf(tableName));return table.get(get);}

}

3. Query 模块

public class QueryEngine {private CubeManager cubeManager;public ResultSet executeQuery(String sql) {SQLParser parser = new SQLParser(sql);QueryPlan plan = parser.parse();CubeInstance cube = cubeManager.getCube(plan.getCubeName());return cube.execute(plan);}

}

4. Engine 模块

public class SparkEngine {private SparkSession spark;public SparkEngine(SparkConf conf) {this.spark = SparkSession.builder().config(conf).getOrCreate();}public void buildCube(CubeInstance cube) {Dataset<Row> data = spark.read().parquet(cube.getDataPath());Dataset<Row> result = data.groupBy(cube.getDimensions()).agg(cube.getAggregations());result.write().parquet(cube.getOutputPath());}

}

5. Web 模块

@RestController

@RequestMapping("/api/models")

public class ModelController {@Autowiredprivate MetadataManager metadataManager;@GetMapping("/{name}")public ResponseEntity<DataModelDesc> getModel(@PathVariable String name) {DataModelDesc model = metadataManager.getDataModel(name);return ResponseEntity.ok(model);}@PostMapping("/")public ResponseEntity<Void> addModel(@RequestBody DataModelDesc model) {metadataManager.addDataModel(model);return ResponseEntity.status(HttpStatus.CREATED).build();}@DeleteMapping("/{name}")public ResponseEntity<Void> deleteModel(@PathVariable String name) {metadataManager.removeDataModel(name);return ResponseEntity.status(HttpStatus.NO_CONTENT).build();}

}

结论

通过本文的详细介绍,我们从概念到实践,深入理解了 Apache Kylin 的工作原理、核心组件、使用方法及源码解析。希望通过这些内容,读者能够全面掌握 Apache Kylin,并在实际项目中灵活运用这一强大的大数据分析工具。

相关文章:

深入理解Apache Kylin:从概念到实践

深入理解Apache Kylin:从概念到实践 引言 Apache Kylin 是一个分布式分析引擎,专为在大规模数据集上进行快速多维分析(OLAP)设计。自2015年开源以来,Kylin 已经成为许多企业在大数据分析领域的首选工具。本文将从概念…...

vue3框架Arco Design输入邮箱选择后缀

使用: <a-form-item field"apply_user_email" label"邮箱:" ><email v-model"apply_user_email" class"inputborder topinputw"></email> </a-form-item>import email from /componen…...

制作镜像

1.镜像 image: 是一个文件,包含了微型操作系统、核心代码(可执行程序)、依赖环境(库) 2.仓库 repository: 存放镜像文件的地方 3.容器: container :是运行镜像的地方--…...

进阶)

Kylin系列(二)进阶

Kylin系列(二)进阶 目录 简介Kylin架构深入解析 Kylin架构概述核心组件 高级Cube设计 Cube设计原则Cube优化策略 实时数据分析 实时数据处理流程实时Cube构建 高级查询与优化 查询优化技术SQL优化 Kylin与BI工具集成 Tableau集成Power BI集成 监控与调优 系统监控性能调优 常…...

Maven实战.依赖(依赖范围、传递性依赖、依赖调解、可选依赖等)

文章目录 依赖的配置依赖范围传递性依赖传递性依赖和依赖范围依赖调解可选依赖最佳实践排除依赖归类依赖优化依赖 依赖的配置 依赖会有基本的groupId、artifactld 和 version等元素组成。其实一个依赖声明可以包含如下的一些元素: <project> ...<depende…...

关于React17的setState

不可变值 state必须在构造函数中定义 在setState之前不能修改state的值,不要直接修改state,使用不可变值 可能是异步更新 直接使用时异步的 this.setState({count: this.state.count 1 }, () > {console.log(count by callback, this.state.count) // 回调函…...

2024华为OD机试真题-英文输入法Python-C卷D卷-100分

2024华为OD机试题库-(C卷+D卷)-(JAVA、Python、C++) 题目描述 主管期望你来实现英文输入法单词联想功能,需求如下: 依据用户输入的单词前缀,从已输入的英文语句中联想出用户想输入的单词。 按字典序输出联想到的单词序列,如果联想不到,请输出用户输入的单词前缀。 注意 英…...

magento2 安装win环境和linux环境

win10 安装 安装前提,php,mysql,apach 或nginx 提前安装好 并且要php配置文件里,php.ini 把错误打开 display_errorsOn开始安装 检查环境 填写数据库信息 和ssl信息,如果ssl信息没有,则可以忽略 填写域名和后台地址࿰…...

【城市数据集】世界城市数据库和访问门户工具WUDAPT

世界城市数据库和访问门户工具WUDAPT WUDAPTLCZ分类具体步骤参考 在 城市气候研究中,用于描述城市特征的数据集一般采用基于类别的传统方法,将城市地区分为数量有限的类型,从而导致精确度下降。越来越多的新数据集以亚米微尺分辨率描述城市的…...

网络爬虫必备工具:代理IP科普指南

文章目录 1. 网络爬虫简介1.1 什么是网络爬虫?1.2 网络爬虫的应用领域1.3 网络爬虫面临的主要挑战 2. 代理IP:爬虫的得力助手2.1 代理IP的定义和工作原理2.2 爬虫使用代理IP的必要性 3. 代理IP的类型及其在爬虫中的应用3.1 动态住宅代理3.2 动态数据中心…...

JMeter接口测试-5.JMeter高级使用

JMeter高级使用 案例: 用户登录后-选择商品-添加购物车-创建订单-验证结果 问题: JMeter测试中,验证结果使用断言,但断言都是固定的内容假如要判断的内容(预期内容)是在变化的, 有时候还是不确定的, 那该怎么办呢? 解决&…...

网络安全大模型开源项目有哪些?

01 Ret2GPT 它是面向CTF二进制安全的工具,结合ChatGPT API、Retdec和Langchain进行漏洞挖掘,它能通过问答或预设Prompt对二进制文件进行分析。 https://github.com/DDizzzy79/Ret2GPT 02 OpenAI Codex 它是基于GPT-3.5-turbo模型,用于编写…...

【赠书第18期】人工智能B2B落地实战:基于云和Python的商用解决方案

文章目录 前言 1 方案概述 2 方案实施 2.1 云平台选择 2.2 Python环境搭建 2.3 应用开发与部署 2.4 应用管理 2.5 安全性与隐私保护 3 方案优势与效益 4 推荐图书 5 粉丝福利 前言 随着云计算技术的快速发展,越来越多的企业开始将业务迁移至云端&#x…...

《昇思25天学习打卡营第24天》

接续上一天的学习任务,我们要继续进行下一步的操作 构造网络 当处理完数据后,就可以来进行网络的搭建了。按照DCGAN论文中的描述,所有模型权重均应从mean为0,sigma为0.02的正态分布中随机初始化。 接下来了解一下其他内容 生成…...

KeePass密码管理工具部署

KeePass密码管理工具部署 安装包下载入口 双击执行,根据提示完成安装: 安装完成后如图:...

C#中导出dataGridView数据为Excel

C#中导出dataGridView数据为Excel #region 导出Excel功能函数 /// <summary> /// dataGridView 导出Excel功能函数 /// </summary> /// <param name"dataView">dataGridView数据表</param> /// <param name"filePath">路径…...

算法学习6——贪心算法

什么是贪心算法? 贪心算法是一种在每一步选择中都采取当前状态下最优或最有利的选择的算法。其核心思想是通过一系列局部最优选择来达到全局最优解。贪心算法广泛应用于各种优化问题,如最短路径、最小生成树、背包问题等。 贪心算法的特点 局部最优选…...

【C++】标准库:介绍string类

string 一.string类介绍二.string类的静态成员变量三.string类的常用接口1.构造函数(constructor)2.析构函数(destructor)3.运算符重载(operator)1.operator2.operator[]3.operator4.operator 4.string的四…...

未来不会使用 AI 的人真的会被淘汰吗?

AI 是今年大火的一个话题,随着 ChatGPT 之类的一系列大模型开始流行以后,有不少的培训机构宣称这样的口号: “未来不会使用 AI 的人将会被淘汰”。我觉得这个观点本身并没有错,但是关键在于那些培训机构出于自身的利益,故意忽略了…...

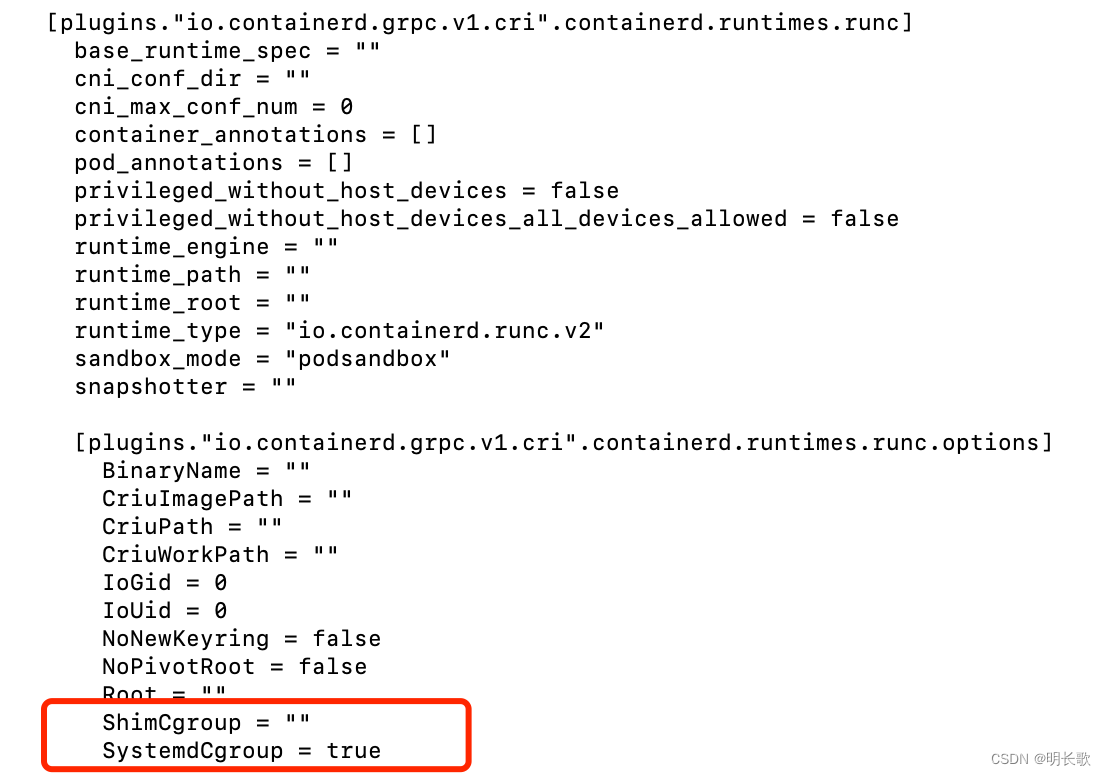

K8S及Rancher部署

前言 这篇文写的有点子啰嗦,甚至为了控制篇幅我还分出了其他好几篇文章,只在本文中保留了我认为必须存在。而之所以篇幅这么长,一方面是我在相关领域完全新手,啥啥都不会;而另一方面是我所参考的资料都过于精简&#…...

调用支付宝接口响应40004 SYSTEM_ERROR问题排查

在对接支付宝API的时候,遇到了一些问题,记录一下排查过程。 Body:{"datadigital_fincloud_generalsaas_face_certify_initialize_response":{"msg":"Business Failed","code":"40004","sub_msg…...

3.3.1_1 检错编码(奇偶校验码)

从这节课开始,我们会探讨数据链路层的差错控制功能,差错控制功能的主要目标是要发现并且解决一个帧内部的位错误,我们需要使用特殊的编码技术去发现帧内部的位错误,当我们发现位错误之后,通常来说有两种解决方案。第一…...

《通信之道——从微积分到 5G》读书总结

第1章 绪 论 1.1 这是一本什么样的书 通信技术,说到底就是数学。 那些最基础、最本质的部分。 1.2 什么是通信 通信 发送方 接收方 承载信息的信号 解调出其中承载的信息 信息在发送方那里被加工成信号(调制) 把信息从信号中抽取出来&am…...

vue3 定时器-定义全局方法 vue+ts

1.创建ts文件 路径:src/utils/timer.ts 完整代码: import { onUnmounted } from vuetype TimerCallback (...args: any[]) > voidexport function useGlobalTimer() {const timers: Map<number, NodeJS.Timeout> new Map()// 创建定时器con…...

WordPress插件:AI多语言写作与智能配图、免费AI模型、SEO文章生成

厌倦手动写WordPress文章?AI自动生成,效率提升10倍! 支持多语言、自动配图、定时发布,让内容创作更轻松! AI内容生成 → 不想每天写文章?AI一键生成高质量内容!多语言支持 → 跨境电商必备&am…...

大模型多显卡多服务器并行计算方法与实践指南

一、分布式训练概述 大规模语言模型的训练通常需要分布式计算技术,以解决单机资源不足的问题。分布式训练主要分为两种模式: 数据并行:将数据分片到不同设备,每个设备拥有完整的模型副本 模型并行:将模型分割到不同设备,每个设备处理部分模型计算 现代大模型训练通常结合…...

[Java恶补day16] 238.除自身以外数组的乘积

给你一个整数数组 nums,返回 数组 answer ,其中 answer[i] 等于 nums 中除 nums[i] 之外其余各元素的乘积 。 题目数据 保证 数组 nums之中任意元素的全部前缀元素和后缀的乘积都在 32 位 整数范围内。 请 不要使用除法,且在 O(n) 时间复杂度…...

:邮件营销与用户参与度的关键指标优化指南)

精益数据分析(97/126):邮件营销与用户参与度的关键指标优化指南

精益数据分析(97/126):邮件营销与用户参与度的关键指标优化指南 在数字化营销时代,邮件列表效度、用户参与度和网站性能等指标往往决定着创业公司的增长成败。今天,我们将深入解析邮件打开率、网站可用性、页面参与时…...

用机器学习破解新能源领域的“弃风”难题

音乐发烧友深有体会,玩音乐的本质就是玩电网。火电声音偏暖,水电偏冷,风电偏空旷。至于太阳能发的电,则略显朦胧和单薄。 不知你是否有感觉,近两年家里的音响声音越来越冷,听起来越来越单薄? —…...

多光源(Multiple Lights))

C++.OpenGL (14/64)多光源(Multiple Lights)

多光源(Multiple Lights) 多光源渲染技术概览 #mermaid-svg-3L5e5gGn76TNh7Lq {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-3L5e5gGn76TNh7Lq .error-icon{fill:#552222;}#mermaid-svg-3L5e5gGn76TNh7Lq .erro…...