【扒代码】ope.py

文件目录:

引用方式

if not self.zero_shot:

# 非零样本情况下,计算边界框的宽度和高度

box_hw = torch.zeros(bboxes.size(0), bboxes.size(1), 2).to(bboxes.device)

box_hw[:, :, 0] = bboxes[:, :, 2] - bboxes[:, :, 0] # 宽度

box_hw[:, :, 1] = bboxes[:, :, 3] - bboxes[:, :, 1] # 高度

# 将形状信息通过全连接网络转换为特征表示

shape_or_objectness = self.shape_or_objectness(box_hw).reshape(

bs, -1, self.kernel_dim ** 2, self.emb_dim

).flatten(1, 2).transpose(0, 1)

else:

shape_or_objectness = self.shape_or_objectness.expand(

bs, -1, -1, -1

).flatten(1, 2).transpose(0, 1)

else:

shape_or_objectness = self.shape_or_objectness.expand(

bs, -1, -1, -1

).flatten(1, 2).transpose(0, 1)

expand(bs, -1, -1, -1)方法调用将self.shape_or_objectness张量扩展到更大的尺寸:bs是新的批量大小维度,表示张量在第一个维度上扩展以匹配批量大小。-1表示该维度保持不变,不进行扩展。在这里,它用于保持self.shape_or_objectness张量在后续维度上的大小。

- 例如,如果

self.shape_or_objectness原始形状为(num_objects, kernel_dim**2, emb_dim),并且bs是批量大小,使用expand(bs, -1, -1, -1)后,张量的形状将变为(bs, num_objects, kernel_dim**2, emb_dim)。这意味着每个样本现在都有num_objects个形状和外观特征,而原始张量中的数据在批量维度上被“虚拟复制”了。

# 生成查询位置嵌入

# self.pos_emb是一个用于生成位置嵌入的模块,它接收批量大小bs、核尺寸kernel_dim、核尺寸kernel_dim和设备f_e.device作为参数

# .flatten(2)将除了最后一个维度外的所有维度展平

# .permute(2, 0, 1)重新排列维度,将位置嵌入调整为正确的形状以用于后续操作

# .repeat复制num_objects次,以匹配样本数量

query_pos_emb = self.pos_emb(bs, self.kernel_dim, self.kernel_dim, f_e.device

).flatten(2).permute(2, 0, 1).repeat(self.num_objects, 1, 1)# 如果迭代适应模块的迭代步数大于0,则调用该模块

if self.num_iterative_steps > 0:# 将编码后的图像特征f_e展平并重新排列维度,以匹配迭代适应模块的输入要求memory = f_e.flatten(2).permute(2, 0, 1)# 调用迭代适应模块,传入形状或对象显著性特征、外观特征、内存特征、位置嵌入和查询位置嵌入# 该模块将执行一系列迭代步骤来适应和改进特征表示= self.iterative_adaptation(shape_or_objectness, appearance, memory, pos_emb, query_pos_emb)

# 如果迭代适应模块的迭代步数为0,则执行以下操作

else:# 检查形状或对象显著性特征和外观特征是否都不为None# 这表示有足够的信息来执行一些基本的特征处理# 此处代码不完整,可能缺少了else语句的实现部分if shape_or_objectness is not None and appearance is not None:# 此处代码应该包含对shape_or_objectness和appearance的处理逻辑# 例如,可能涉及将这些特征与位置嵌入结合以生成最终的特征表示# 但由于代码不完整,无法提供确切的实现细节query_pos_emb的生成是为了在迭代适应过程中使用,它提供了额外的位置信息,有助于模型更好地理解特征的空间结构。self.pos_emb是一个自定义的模块或函数,用于根据提供的参数生成位置嵌入。flatten(2)和permute(2, 0, 1)操作用于调整生成的位置嵌入的形状,以适应模型的输入要求。repeat(self.num_objects, 1, 1)操作用于复制位置嵌入,以确保每个样本对象都有相应的位置信息。if self.num_iterative_steps > 0:分支表示如果配置了迭代适应步骤,则调用iterative_adaptation模块进行特征的迭代适应。memory变量是编码后的图像特征f_e的展平版本,它将作为迭代适应模块的输入之一。- 这段代码的目的是准备和处理特征嵌入,以便在迭代适应模块中使用,从而提高模型对对象特征的适应性和学习能力。在没有迭代适应步骤的情况下,可能需要直接处理形状和外观特征。

import torch

import torch.nn as nnclass IterativeAdaptationModule(nn.Module):# 初始化IterativeAdaptationModule,接收多个参数以配置模块的行为def __init__(self,num_layers: int, # 迭代适应层的数量emb_dim: int, # 嵌入维度num_heads: int, # 注意力机制中的头数dropout: float, # dropout比率layer_norm_eps: float, # 层归一化中的epsilon值mlp_factor: int, # MLP(多层感知机)的扩展因子norm_first: bool, # 是否先进行归一化activation: nn.Module, # 激活函数模块norm: bool, # 是否使用归一化zero_shot: bool # 是否是零样本学习场景):super(IterativeAdaptationModule, self).__init__() # 调用基类的初始化方法# 创建一个模块列表,包含num_layers个IterativeAdaptationLayer层self.layers = nn.ModuleList([IterativeAdaptationLayer(emb_dim, num_heads, dropout, layer_norm_eps,mlp_factor, norm_first, activation, zero_shot) for i in range(num_layers)])# 如果norm为True,则使用LayerNorm进行归一化,否则使用Identity(即不进行归一化)self.norm = nn.LayerNorm(emb_dim, layer_norm_eps) if norm else nn.Identity()功能解释:

IterativeAdaptationModule类继承自nn.Module,是PyTorch中定义自定义神经网络模块的基类。- 在初始化方法

__init__中,通过传入的参数来配置模块的各种属性。 num_layers参数指定了迭代适应层的数量,这些层将被存储在self.layers这个ModuleList中。IterativeAdaptationLayer是每次迭代中使用的层,它的构造函数接收嵌入维度、注意力头数、dropout比率等参数。ModuleList是一个用于存储多个模块的PyTorch类,与普通列表不同,它可以在模型的参数中自动注册每个模块。self.norm是一个归一化层,如果norm参数为True,则使用nn.LayerNorm进行归一化处理;如果为False,则使用nn.Identity,即不对数据进行归一化处理,nn.Identity是一个返回输入本身作为输出的模块。LayerNorm是层归一化操作,它对输入张量的每个实例(样本)的每个特征通道进行归一化,使它们的均值为0,标准差为1。layer_norm_eps是层归一化中的一个小常数,用于数值稳定性,防止除以0的情况发生。

def forward(self, # 类实例的引用tgt, # 目标特征,可能表示查询图像的特征appearance, # 外观特征,用于增强目标特征memory, # 记忆特征,可能是编码器的输出pos_emb, # 位置嵌入,提供位置信息query_pos_emb, # 查询位置嵌入,用于注意力机制tgt_mask=None, # 目标掩码,用于在注意力机制中屏蔽不相关的部分memory_mask=None, # 记忆掩码tgt_key_padding_mask=None, # 目标键的填充掩码memory_key_padding_mask=None # 记忆键的填充掩码

):# 初始化输出为输入的目标特征tgtoutput = tgt# 创建一个列表,用于存储每层的输出outputs = list()# 遍历模块列表中的每一层for i, layer in enumerate(self.layers):# 对当前层进行前向传播,传入目标特征、外观特征、记忆特征等# 每层的输出将作为下一层的输入output = layer(output, appearance, memory, pos_emb, query_pos_emb, tgt_mask, memory_mask,tgt_key_padding_mask, memory_key_padding_mask)# 将每层的归一化输出添加到outputs列表中outputs.append(self.norm(output))# 使用torch.stack将outputs列表中的所有输出堆叠成一个序列# 返回堆叠后的输出张量return torch.stack(outputs)功能解释:

forward方法接收多个参数,包括目标特征tgt、外观特征appearance、记忆特征memory、位置嵌入pos_emb和查询位置嵌入query_pos_emb,以及其他掩码和填充掩码。- 这些参数提供了丰富的信息,使得模型能够在迭代适应过程中逐步改进特征表示。

output初始化为tgt,表示当前层的输入是目标特征。outputs是一个空列表,用于存储每层经过归一化处理后的输出。- 通过

for循环遍历self.layers中的每一层,每一层都是IterativeAdaptationLayer的一个实例。 - 在每次迭代中,调用当前层的

forward方法,并传入当前的output和其他特征作为参数,以生成新的特征表示。 - 然后,使用

self.norm对每层的输出进行归一化处理,并将结果添加到outputs列表中。 - 最后,使用

torch.stack(outputs)将所有层的输出堆叠成一个序列,并返回这个序列。

整体而言,IterativeAdaptationModule的forward方法实现了一个迭代过程,在这个过程中,模型逐步细化目标特征,以更好地适应特定的任务,如对象计数或分类。通过这种方式,模型能够捕捉到更加精细和鲁棒的特征表示。

def forward(self, # 类实例的引用tgt, # 目标特征,可能表示查询图像的特征appearance, # 外观特征,用于增强目标特征memory, # 记忆特征,可能是编码器的输出pos_emb, # 位置嵌入,提供位置信息query_pos_emb, # 查询位置嵌入,用于注意力机制tgt_mask=None, # 目标掩码,用于在注意力机制中屏蔽不相关的部分memory_mask=None, # 记忆掩码tgt_key_padding_mask=None, # 目标键的填充掩码memory_key_padding_mask=None # 记忆键的填充掩码

):# 初始化输出为输入的目标特征tgtoutput = tgt# 创建一个列表,用于存储每层的输出outputs = list()# 遍历模块列表中的每一层for i, layer in enumerate(self.layers):# 对当前层进行前向传播,传入目标特征、外观特征、记忆特征等# 每层的输出将作为下一层的输入output = layer(output, appearance, memory, pos_emb, query_pos_emb, tgt_mask, memory_mask,tgt_key_padding_mask, memory_key_padding_mask)# 将每层的归一化输出添加到outputs列表中outputs.append(self.norm(output))# 使用torch.stack将outputs列表中的所有输出堆叠成一个序列# 返回堆叠后的输出张量return torch.stack(outputs)功能解释:

forward方法接收多个参数,包括目标特征tgt、外观特征appearance、记忆特征memory、位置嵌入pos_emb和查询位置嵌入query_pos_emb,以及其他掩码和填充掩码。output初始化为tgt,表示当前层的输入是目标特征。outputs是一个空列表,用于存储每层经过归一化处理后的输出。- 通过

for循环遍历self.layers中的每一层,每一层都是IterativeAdaptationLayer的一个实例。 - 在每次迭代中,调用当前层的

forward方法,并传入当前的output和其他特征作为参数,以生成新的特征表示。 - 然后,使用

self.norm对每层的输出进行归一化处理,并将结果添加到outputs列表中。 - 最后,使用

torch.stack(outputs)将所有层的输出堆叠成一个序列,并返回这个序列。

整体而言,IterativeAdaptationModule的forward方法实现了一个迭代过程,在这个过程中,模型逐步细化目标特征,以更好地适应特定的任务,如对象计数或分类。通过这种方式,模型能够捕捉到更加精细和鲁棒的特征表示。

import torch

import torch.nn as nnclass IterativeAdaptationLayer(nn.Module):# 初始化IterativeAdaptationLayer,接收多个参数以配置层的行为def __init__(self,emb_dim: int, # 嵌入维度num_heads: int, # 注意力机制中的头数dropout: float, # dropout比率layer_norm_eps: float, # 层归一化中的epsilon值mlp_factor: int, # MLP的扩展因子norm_first: bool, # 是否先进行归一化activation: nn.Module, # 激活函数模块zero_shot: bool # 是否是零样本学习场景):super(IterativeAdaptationLayer, self).__init__() # 调用基类的初始化方法# 存储是否先进行归一化的标记self.norm_first = norm_first# 存储是否处于零样本学习场景的标记self.zero_shot = zero_shot# 如果不是零样本学习场景,创建第一个归一化层if not self.zero_shot:self.norm1 = nn.LayerNorm(emb_dim, layer_norm_eps)# 创建第二和第三个归一化层self.norm2 = nn.LayerNorm(emb_dim, layer_norm_eps)self.norm3 = nn.LayerNorm(emb_dim, layer_norm_eps)# 如果不是零样本学习场景,创建第一个dropout层if not self.zero_shot:self.dropout1 = nn.Dropout(dropout)# 创建第二和第三个dropout层self.dropout2 = nn.Dropout(dropout)self.dropout3 = nn.Dropout(dropout)# 如果不是零样本学习场景,创建自注意力机制if not self.zero_shot:self.self_attn = nn.MultiheadAttention(emb_dim, num_heads, dropout)# 创建编码器-解码器注意力机制self.enc_dec_attn = nn.MultiheadAttention(emb_dim, num_heads, dropout)# 创建MLP(多层感知机)模块self.mlp = MLP(emb_dim, mlp_factor * emb_dim, dropout, activation)# with_emb函数用于将输入x与嵌入emb结合# 如果emb为None,则直接返回x;否则,将x与emb相加def with_emb(self, x, emb):return x if emb is None else x + emb功能解释:

IterativeAdaptationLayer类中定义了一系列的归一化层、dropout层、注意力机制和MLP(多层感知机)模块。norm_first参数决定是否在注意力机制和MLP之前先进行归一化处理。zero_shot参数指示当前是否处于零样本学习场景。如果不是零样本学习场景,会创建自注意力机制和dropout层。self_attn是自注意力机制,用于在特征中捕获内部依赖关系。enc_dec_attn是编码器-解码器注意力机制,可能用于捕获特征之间的外部依赖关系。mlp是多层感知机,用于在注意力机制之后进一步处理特征。with_emb是一个辅助函数,用于将输入特征与嵌入特征结合。如果嵌入特征emb为None,则直接返回输入x;否则,将两者相加。

整体而言,IterativeAdaptationLayer类实现了一个复杂的特征处理流程,包括归一化、注意力机制、dropout正则化和多层感知机,旨在逐步改进特征表示,以适应不同的学习任务。在零样本学习场景中,某些组件(如自注意力和dropout)可能不会被使用。

def forward(self, # 类实例的引用tgt, # 目标特征,可能表示查询图像的特征appearance, # 外观特征,用于增强目标特征memory, # 记忆特征,可能是编码器的输出pos_emb, # 位置嵌入,提供位置信息query_pos_emb, # 查询位置嵌入,用于注意力机制tgt_mask, # 目标掩码,用于在注意力机制中屏蔽不相关的部分memory_mask, # 记忆掩码tgt_key_padding_mask, # 目标键的填充掩码memory_key_padding_mask # 记忆键的填充掩码

):# 如果先进行归一化(norm_first为True)if self.norm_first:# 如果不是零样本学习场景if not self.zero_shot:# 归一化tgt特征,然后进行自注意力操作tgt_norm = self.norm1(tgt)tgt = tgt + self.dropout1(self.self_attn(query=self.with_emb(tgt_norm, query_pos_emb), # 查询特征与查询位置嵌入结合key=self.with_emb(appearance, query_pos_emb), # 键特征与查询位置嵌入结合value=appearance, # 值特征attn_mask=tgt_mask, # 注意力掩码key_padding_mask=tgt_key_padding_mask # 键的填充掩码)[0])# 归一化tgt特征,然后进行编码器-解码器注意力操作tgt_norm = self.norm2(tgt)tgt = tgt + self.dropout2(self.enc_dec_attn(query=self.with_emb(tgt_norm, query_pos_emb), # 查询特征与查询位置嵌入结合key=memory+pos_emb, # 键特征与位置嵌入结合value=memory, # 值特征attn_mask=memory_mask, # 注意力掩码key_padding_mask=memory_key_padding_mask # 键的填充掩码)[0])# 归一化tgt特征,然后通过MLPtgt_norm = self.norm3(tgt)tgt = tgt + self.dropout3(self.mlp(tgt_norm))# 如果不先进行归一化(norm_first为False)else:# 如果不是零样本学习场景if not self.zero_shot:# 先进行自注意力操作,然后归一化tgt = self.norm1(tgt + self.dropout1(self.self_attn(query=self.with_emb(tgt, query_pos_emb), # 查询特征与查询位置嵌入结合key=self.with_emb(appearance, query_pos_emb), # 键特征与查询位置嵌入结合value=appearance, # 值特征attn_mask=tgt_mask, # 注意力掩码key_padding_mask=tgt_key_padding_mask # 键的填充掩码)[0]))# 先进行编码器-解码器注意力操作,然后归一化tgt = self.norm2(tgt + self.dropout2(self.enc_dec_attn(query=self.with_emb(tgt, query_pos_emb), # 查询特征与查询位置嵌入结合key=memory+pos_emb, # 键特征与位置嵌入结合value=memory, # 值特征attn_mask=memory_mask, # 注意力掩码key_padding_mask=memory_key_padding_mask # 键的填充掩码)[0]))# 先通过MLP,然后归一化tgt = self.norm3(tgt + self.dropout3(self.mlp(tgt)))# 返回最终的tgt特征return tgt功能解释:

forward方法接收多个参数,包括目标特征tgt、外观特征appearance、记忆特征memory、位置嵌入pos_emb和查询位置嵌入query_pos_emb,以及其他掩码和填充掩码。- 根据

norm_first标志,决定是先对特征进行归一化还是先进行注意力机制和MLP操作。 - 如果

norm_first为True,则先对特征进行归一化,然后进行自注意力操作、编码器-解码器注意力操作和MLP操作,每步操作后都应用dropout。 - 如果

norm_first为False,则先进行自注意力操作和MLP操作,然后进行归一化,每步操作后都应用dropout。 with_emb函数用于将特征与嵌入结合,如果嵌入为None,则直接返回特征本身。self_attn是自注意力机制,用于捕获特征内部的依赖关系。enc_dec_attn是编码器-解码器注意力机制,可能用于捕获特征之间的外部依赖关系。mlp是多层感知机,用于进一步处理特征。

整体而言,IterativeAdaptationLayer的forward方法实现了一个包含归一化、注意力机制和MLP的复杂特征处理流程,旨在逐步改进特征表示,以更好地适应特定的任务。在零样本学习场景中,某些组件(如自注意力)可能不会被使用。

from .mlp import MLP

from .positional_encoding import PositionalEncodingsFixedimport torch

from torch import nnfrom torchvision.ops import roi_alignclass OPEModule(nn.Module):# 初始化OPEModule,接收多个参数以配置模块的行为def __init__(self,num_iterative_steps: int,emb_dim: int,kernel_dim: int,num_objects: int,num_heads: int,reduction: int,layer_norm_eps: float,mlp_factor: int,norm_first: bool,activation: nn.Module,norm: bool,zero_shot: bool,):''''num_iterative_steps: int:迭代适应的步数emb_dim: int:嵌入维度kernel_dim: int:卷积核维度num_objects: int:对象数量num_heads: int:注意力机制头数reduction: int:图像缩小的倍数;降维因子layer_norm_eps: float:层归一化的epsilon值mlp_factor: int:MLP的因子norm_first: bool:是否先进行归一化activation: nn.Module:激活函数norm: bool:是否进行归一化zero_shot: bool:是否进行零样本是学习场景'''super(OPEModule, self).__init__()# 迭代步数self.num_iterative_steps = num_iterative_steps# 是否进行零样本学习self.zero_shot = zero_shot# 卷积核维度self.kernel_dim = kernel_dim# 对象数量self.num_objects = num_objects# 嵌入维度self.emb_dim = emb_dim# 图像缩小的倍数self.reduction = reduction# 如果迭代步数大于0,创建迭代适应模块if num_iterative_steps > 0:self.iterative_adaptation = IterativeAdaptationModule(num_layers=num_iterative_steps, emb_dim=emb_dim, num_heads=num_heads,dropout=0, layer_norm_eps=layer_norm_eps,mlp_factor=mlp_factor, norm_first=norm_first,activation=activation, norm=norm,zero_shot=zero_shot)# 如果不是零样本学习场景,创建提取形状信息的网络if not self.zero_shot:self.shape_or_objectness = nn.Sequential(nn.Linear(2, 64),nn.ReLU(),nn.Linear(64, emb_dim),nn.ReLU(),nn.Linear(emb_dim, self.kernel_dim**2 * emb_dim))# 如果是零样本学习场景,创建形状或目标网络# 线性层,将2维形状信息转换为64维# ReLU激活函数# 线性层,进一步转换为嵌入维度# ReLU激活函数# 线性层,输出特定形状的特征# 如果是零样本学习场景,随机初始化形状信息参数 else:self.shape_or_objectness = nn.Parameter(torch.empty((self.num_objects, self.kernel_dim**2, emb_dim)))# 正态分布初始化参数nn.init.normal_(self.shape_or_objectness)# 创建位置编码模块self.pos_emb = PositionalEncodingsFixed(emb_dim)def forward(self, f_e, pos_emb, bboxes):'''f_e(编码后的图像特征)pos_emb(位置嵌入)bboxes(边界框)'''# 获取图像特征的尺寸信息bs, _, h, w = f_e.size()# extract the shape features or objectness# 提取形状特征或对象显著性(objectness)if not self.zero_shot:# 非零样本情况下,计算边界框的宽度和高度box_hw = torch.zeros(bboxes.size(0), bboxes.size(1), 2).to(bboxes.device)box_hw[:, :, 0] = bboxes[:, :, 2] - bboxes[:, :, 0] # 宽度box_hw[:, :, 1] = bboxes[:, :, 3] - bboxes[:, :, 1] # 高度# 将形状信息通过全连接网络转换为特征表示shape_or_objectness = self.shape_or_objectness(box_hw).reshape(bs, -1, self.kernel_dim ** 2, self.emb_dim).flatten(1, 2).transpose(0, 1)else:shape_or_objectness = self.shape_or_objectness.expand(bs, -1, -1, -1).flatten(1, 2).transpose(0, 1)# if not zero shot add appearance# 如果不是零样本学习场景,则添加外观特征# 当处于非零样本学习场景时,代码通过roi_align操作提取边界框内的特征,这些特征代表了对象的外观信息。# roi_align操作从编码后的图像特征f_e中,根据提供的边界框bboxes提取特征,生成与对象形状相关的特征图。# 通过permute和reshape操作调整提取的特征的形状,以便于与形状特征或其他处理步骤融合。# 如果处于零样本学习场景,则不进行外观特征的提取,appearance被设置为None,这可能是因为在零样本场景下没有足够的样本来指导外观特征的提取。if not self.zero_shot:# reshape bboxes into the format suitable for roi_align# 将边界框bboxes重塑为适用于roi_align的格式# torch.arange生成从0到bs-1的整数序列,表示每个样本的索引# requires_grad=False表示这些索引不需要计算梯度# to(bboxes.device)将索引移动到bboxes所在的设备(GPU或CPU)# repeat_interleave(self.num_objects)将每个索引重复num_objects次,以匹配样本数量# reshape(-1, 1)将重复后的索引重塑为(-1, 1)的形状# torch.cat沿着指定的维度(这里是dim=1)连接张量bboxes = torch.cat([torch.arange(bs, requires_grad=False).to(bboxes.device).repeat_interleave(self.num_objects).reshape(-1, 1),bboxes.flatten(0, 1),], dim=1)# 使用roi_align从特征图f_e中提取与边界框对应的特征# roi_align是一种池化操作,用于从特征图中提取感兴趣区域(bounding box)的特征# boxes=bboxes传入包含边界框的张量# output_size=self.kernel_dim指定输出特征图的大小# spatial_scale=1.0 / self.reduction用于控制池化的比例,与reduction参数成反比# aligned=True表示使用对齐的ROI池化,可以更好地处理边界框的边界# 调整提取的外观特征的形状以适应后续操作# permute(0, 2, 3, 1)重新排列张量的维度,将特征图的维度移到最前面# reshape(bs, self.num_objects * self.kernel_dim ** 2, -1)将特征图展平为二维# transpose(0, 1)交换第一个和第二个维度,以匹配期望的输入格式appearance = roi_align(f_e,boxes=bboxes, output_size=self.kernel_dim,spatial_scale=1.0 / self.reduction, aligned=True).permute(0, 2, 3, 1).reshape(bs, self.num_objects * self.kernel_dim ** 2, -1).transpose(0, 1)else:# 如果是零样本学习场景,不提取外观特征,appearance设置为Noneappearance = None# 负责生成查询位置嵌入(query positional embedding)并根据迭代适应模块处理输入特征# 生成查询位置嵌入# self.pos_emb是一个用于生成位置嵌入的模块,它接收批量大小bs、核尺寸kernel_dim、核尺寸kernel_dim和设备f_e.device作为参数# .flatten(2)将除了最后一个维度外的所有维度展平# .permute(2, 0, 1)重新排列维度,将位置嵌入调整为正确的形状以用于后续操作# .repeat复制num_objects次,以匹配样本数量query_pos_emb = self.pos_emb(bs, self.kernel_dim, self.kernel_dim, f_e.device).flatten(2).permute(2, 0, 1).repeat(self.num_objects, 1, 1)# 如果迭代适应模块的迭代步数大于0,则调用该模块if self.num_iterative_steps > 0:# 将编码后的图像特征f_e展平并重新排列维度,以匹配迭代适应模块的输入要求memory = f_e.flatten(2).permute(2, 0, 1)# 调用迭代适应模块,传入形状或对象显著性特征、外观特征、内存特征、位置嵌入和查询位置嵌入# 该模块将执行一系列迭代步骤来适应和改进特征表示all_prototypes = self.iterative_adaptation(shape_or_objectness, appearance, memory, pos_emb, query_pos_emb)# 如果迭代适应模块的迭代步数为0,则执行以下操作 # 根据形状或对象显著性特征(shape_or_objectness)和外观特征(appearance)生成对象原型(all_prototypes) else:# 检查形状或对象显著性特征和外观特征是否都不为None# 如果两者都存在,将它们相加并扩展维度以形成对象原型if shape_or_objectness is not None and appearance is not None:# 将形状或对象显著性特征和外观特征相加,得到综合的特征表示# .unsqueeze(0)在第一个维度(批次维度)上扩展张量,从(N, C)变为(1, N, C)all_prototypes = (shape_or_objectness + appearance).unsqueeze(0)# 如果其中之一为None(可能在零样本学习场景中),选择非None的特征# 并扩展维度形成对象原型else:# 选择shape_or_objectness或appearance中非None的特征# 如果shape_or_objectness为None,则选择appearance,反之亦然all_prototypes = (shape_or_objectness if shape_or_objectness is not None else appearance).unsqueeze(0)# 返回最终形成的对象原型张量return all_prototypes# 用于执行迭代适应

class IterativeAdaptationModule(nn.Module):def __init__(self,num_layers: int,emb_dim: int,num_heads: int,dropout: float,layer_norm_eps: float,mlp_factor: int,norm_first: bool,activation: nn.Module,norm: bool,zero_shot: bool):'''num_layers: int 迭代适应模块的层数emb_dim: int 嵌入维度num_heads: int 注意力机制头数dropout: float dropout概率layer_norm_eps: float 层归一化的epsilon值mlp_factor: int 多层感知机的扩展因子norm_first: bool 是否先进行归一化activation: 激活函数模块norm: bool 是否进行归一化zero_shot: bool 是否进行零样本学习'''super(IterativeAdaptationModule, self).__init__()self.layers = nn.ModuleList([IterativeAdaptationLayer(emb_dim, num_heads, dropout, layer_norm_eps,mlp_factor, norm_first, activation, zero_shot) for i in range(num_layers)])# 创建一个模块列表,包含num_layers个IterativeAdaptationLayer层# 如果norm为True,则使用LayerNorm进行归一化,否则使用Identity(即不进行归一化)self.norm = nn.LayerNorm(emb_dim, layer_norm_eps) if norm else nn.Identity()def forward(self, tgt, appearance, memory, pos_emb, query_pos_emb, tgt_mask=None, memory_mask=None,tgt_key_padding_mask=None, memory_key_padding_mask=None):# 该方法接收多个参数,# 包括目标特征(tgt) 用于查询图像的特征# 外观特征(appearance) 用于提取对象的外观信息 增强目标特征# 记忆特征(memory) 编码器的输出# 位置嵌入(pos_emb) 提供位置信息# 查询位置嵌入(query_pos_emb) 查询位置嵌入,提供位置信息# tgt_mask 目标掩码 用于在注意力机制中屏蔽不相关的部分# memory_mask 记忆掩码# tgt_key_padding_mask 目标键的填充掩码# memory_key_padding_mask 记忆键的填充掩码# 初始化输出为输入的目标特征tgtoutput = tgt# 创建一个列表,用于存储每层的输出outputs = list()# 遍历模块列表中的每一层for i, layer in enumerate(self.layers):# 对当前层进行前向传播,传入目标特征、外观特征、记忆特征等# 每层的输出将作为下一层的输入output = layer(output, appearance, memory, pos_emb, query_pos_emb, tgt_mask, memory_mask,tgt_key_padding_mask, memory_key_padding_mask)# 将每层的归一化输出添加到outputs列表中outputs.append(self.norm(output))# 使用torch.stack将outputs列表中的所有输出堆叠成一个序列# 返回堆叠后的输出张量return torch.stack(outputs)class IterativeAdaptationLayer(nn.Module):# IterativeAdaptationLayer 的类,它是 nn.Module 的子类,# 用于实现迭代适应层的功能。# 这个类可能用于在神经网络中逐步调整特征表示,特别是在处理少样本或零样本学习任务时def __init__(self,emb_dim: int,# 嵌入维度num_heads: int, # 注意力机制中的头数dropout: float,# dropout比率layer_norm_eps: float,# 层归一化中的epsilon值mlp_factor: int,# MLP的扩展因子norm_first: bool,# 是否先进行归一化activation: nn.Module,# 激活函数模块zero_shot: bool # 是否是零样本学习场景):super(IterativeAdaptationLayer, self).__init__()# 存储是否先进行归一化的标记self.norm_first = norm_first# 存储是否处于零样本学习场景的标记self.zero_shot = zero_shot# 如果不是零样本学习场景,创建第一个归一化层if not self.zero_shot:self.norm1 = nn.LayerNorm(emb_dim, layer_norm_eps)# 创建第二和第三个归一化层self.norm2 = nn.LayerNorm(emb_dim, layer_norm_eps)self.norm3 = nn.LayerNorm(emb_dim, layer_norm_eps)# 如果不是零样本学习场景,创建第一个dropout层if not self.zero_shot:self.dropout1 = nn.Dropout(dropout)# 创建第二和第三个dropout层self.dropout2 = nn.Dropout(dropout)self.dropout3 = nn.Dropout(dropout)# 如果不是零样本学习场景,创建自注意力机制if not self.zero_shot:self.self_attn = nn.MultiheadAttention(emb_dim, num_heads, dropout)# 创建编码器-解码器注意力机制self.enc_dec_attn = nn.MultiheadAttention(emb_dim, num_heads, dropout)# 创建MLP(多层感知机)模块self.mlp = MLP(emb_dim, mlp_factor * emb_dim, dropout, activation)# with_emb函数用于将输入x与嵌入emb结合# 如果emb为None,则直接返回x;否则,将x与emb相加def with_emb(self, x, emb):return x if emb is None else x + embdef forward(self, tgt, appearance, memory, pos_emb, query_pos_emb, tgt_mask, memory_mask,tgt_key_padding_mask, memory_key_padding_mask):# 定义了IterativeAdaptationLayer类的forward方法,它是模型在执行前向传播时调用的函数# tgt 目标特征,查询图像的特征# appearance 外观特征,用于提取对象的外观信息并增强目标特征# memory 记忆特征 编码器的输出# pos_emb 位置嵌入 提供位置信息# query_pos_emb 查询位置嵌入 用于注意力机制# tgt_mask 目标严吗 用于在注意力机制中屏蔽不相关的部分# memory_mask 记忆掩码 # tgt_key_padding_mask 目标键的填充掩码# memory_key_padding_mask 记忆键的填充掩码# 如果先进行归一化(norm_first为True)if self.norm_first:# 如果不是零样本学习场景if not self.zero_shot:# 归一化tgt特征,然后进行自注意力操作tgt_norm = self.norm1(tgt)tgt = tgt + self.dropout1(self.self_attn(query=self.with_emb(tgt_norm, query_pos_emb), # 查询特征与查询位置嵌入结合key=self.with_emb(appearance, query_pos_emb), # 键特征与查询位置嵌入结合value=appearance, # 值特征attn_mask=tgt_mask, # 注意力掩码key_padding_mask=tgt_key_padding_mask # 键的填充掩码)[0])# 归一化tgt特征,然后进行编码器-解码器注意力操作tgt_norm = self.norm2(tgt)tgt = tgt + self.dropout2(self.enc_dec_attn(# 查询特征与查询位置嵌入结合query=self.with_emb(tgt_norm, query_pos_emb),# 键特征与位置嵌入结合key=memory+pos_emb,# 值特征value=memory,# 注意力掩码attn_mask=memory_mask,# 键的填充掩码key_padding_mask = memory_key_padding_mask)[0])# 归一化tgt特征,然后通过MLPtgt_norm = self.norm3(tgt)tgt = tgt + self.dropout3(self.mlp(tgt_norm))# 如果不先进行归一化(norm_first为False)else:# 如果不是零样本学习场景if not self.zero_shot:# 先进行自注意力操作,然后归一化tgt = self.norm1(tgt + self.dropout1(self.self_attn(# 查询特征与查询位置嵌入结合query=self.with_emb(tgt, query_pos_emb),# 键特征与查询位置嵌入结合key=self.with_emb(appearance, query_pos_emb),# 值特征value=appearance,# 注意力掩码attn_mask=tgt_mask,# 键的填充掩码key_padding_mask=tgt_key_padding_mask)[0]))# 先进行编码器-解码器注意力操作,然后归一化tgt = self.norm2(tgt + self.dropout2(self.enc_dec_attn(query=self.with_emb(tgt, query_pos_emb),# 查询特征与查询位置嵌入结合key=memory+pos_emb,# 键特征与位置嵌入结合value=memory, # 值特征attn_mask=memory_mask, # 注意力掩码key_padding_mask=memory_key_padding_mask # 键的填充掩码)[0]))# 先通过MLP,然后归一化tgt = self.norm3(tgt + self.dropout3(self.mlp(tgt)))# 返回最终的tgt特征return tgt

query_pos_emb = self.pos_emb( bs, self.kernel_dim, self.kernel_dim, f_e.device ).flatten(2).permute(2, 0, 1).repeat(self.num_objects, 1, 1) flatten(2)什么意思

query_pos_emb = self.pos_emb(bs, self.kernel_dim, self.kernel_dim, f_e.device

).flatten(2).permute(2, 0, 1).repeat(self.num_objects, 1, 1)

self.pos_emb(...):调用pos_emb方法生成位置嵌入(positional embedding)。这个方法的具体实现没有在代码段中给出,但它可能根据传入的批量大小bs、核尺寸self.kernel_dim、核尺寸self.kernel_dim和设备f_e.device来创建位置嵌入张量。

.flatten(2):从第 2 维开始展平张量。这意味着,如果张量的形状是(N, C, H, W),flatten(2)会将其变为(N, C, HW),其中H和W是剩余维度的乘积。

.permute(2, 0, 1):重新排列张量的维度。permute方法根据给定的顺序重新排序张量的维度。在这个例子中,permute(2, 0, 1)将张量的形状(N, C, HW)变为(N, HW, C)。这样,每个样本的位置嵌入将首先按HW维度排列,然后是批量维度N,最后是通道维度C。

.repeat(self.num_objects, 1, 1):重复张量以匹配样本数量。repeat方法沿着指定的维度重复张量的元素。在这个例子中,.repeat(self.num_objects, 1, 1)将张量沿着第一个维度(批量维度)重复self.num_objects次,同时保持其他维度不变。最终,这段代码生成了一个形状为

(N, HW, C)的张量,其中包含了用于注意力机制的查询位置嵌入,并且这些嵌入已经针对每个样本对象进行了重复,以便可以用于后续的注意力计算。

相关文章:

【扒代码】ope.py

文件目录: 引用方式 if not self.zero_shot: # 非零样本情况下,计算边界框的宽度和高度 box_hw torch.zeros(bboxes.size(0), bboxes.size(1), 2).to(bboxes.device) box_hw[:, :, 0] bboxes[:, :, 2] - bboxes[:, :, 0] # 宽度 box_hw[:, :, 1] bbox…...

【Rust光年纪】探索Rust终端编程:从跨平台操作到用户界面设计

构建跨平台终端应用的完美选择:Rust 库综述 前言 随着终端应用程序的发展,越来越多的开发者开始寻找跨平台的、易于使用的库来构建终端用户界面和执行终端操作。本文将介绍几个流行的 Rust 库,它们提供了丰富的功能和灵活的 API 来满足不同…...

67、ceph

一、ceph 1.1、ceph概念 ceph是一个开源的,用c语言写的分布式的存储系统。存储文件数据。 /dev/sdb fdisk /dev/sdb gdisk /dev/sdb lvm 逻辑卷 可以扩容 raid 磁盘阵列 高可用 基于物理意义上的单机的存储系统。 分布式有多台物理磁盘组成一个集群&…...

最大正方形[中等]

优质博文:IT-BLOG-CN 一、题目 在一个由0和1组成的二维矩阵内,找到只包含1的最大正方形,并返回其面积。 示例 1: 输入:matrix [["1","0","1","0","0"],[&quo…...

JavaScript 浅谈观察者模式 前端设计模式

2、观察者模式 2.1、观察者模式 2.1.1、前言 定义一种一对多的依赖关系,当一个对象发生变化时,所有依赖于它的对象都会自动收到通知并更新。 两个角色: Subject(主题/被观察者) Observer(观察者&…...

【自动驾驶】自定义消息格式的话题通信(C++版本)

目录 新建消息文件更改包xml文件中的依赖关系更改cmakelist文件中的配置执行时依赖改变cmakelist编译顺序发布者程序调用者程序新建launch文件程序测试 新建消息文件 在功能包目录下,新建msg文件夹,下面新建mymsg.msg文件,其内容为 string …...

提升前端性能的JavaScript技巧

1. 前端JavaScript性能问题 前端JavaScript的性能问题可以显著影响Web应用的用户体验和整体性能。以下是一些常见的前端JavaScript性能问题: 1.1. 频繁的DOM操作 问题描述:JavaScript经常需要与DOM(文档对象模型)交互来更新页面内容。然而,每次DOM操作都可能触发浏览器的…...

“服务之巅:Spring Cloud中SLA监控与管理的艺术“

标题:“服务之巅:Spring Cloud中SLA监控与管理的艺术” 在微服务架构中,服务调用的可靠性和性能是至关重要的。服务级别协议(Service Level Agreement,简称SLA)是衡量服务性能的关键指标,它定义…...

ChatGPT角色定位提问提示词和指令完整版

角色定位提问 在与ChatGPT的对话中,角色定位提问是一种有效的策略,通过为ChatGPT和自己设定特定的角色或身份,可以引导对话朝着更加具体、有针对性的方向发展。这种提问方式不仅有助于ChatGPT更好地理解问题的背景和需求,还能使回…...

docker之我不会的命令

docker命令之我不会的 保存镜像(打包) docker save 镜像名或镜像id -o 保存路径和镜像名字例子: docker save tomcat -o /home/my_tomcat.tar加载保存的镜像 docker load -i 镜像保存的位置例子 在/home/路径下 docker load -i my_tomca…...

Together规则引擎 金融解决方案

目录 1.金融法规和期望正在发生变化,快速跟踪您的金融数字化变革!2.抵押贷款功能集(MFS)3.MFS 示例模型4.MFS 知识特点5.MFS特定功能 1.金融法规和期望正在发生变化,快速跟踪您的金融数字化变革! ogether规则引擎使金融机构能够简…...

【PyQt5】PyQt5 主要类

1.经常使用的模块 Sr.No.模块描述1QtCore其他模块使用的核心非GUI类2QtGui图形用户界面组件3QtMultimedia低级多媒体编程的类4QtNetwork网络编程的类5QtOpenGLOpenGL支持类6QtScript用于评估Qt脚本的类7QtSql使用SQL进行数据库集成的类8QtSvg用于显示SVG文件内容的类9QtWebKit…...

渗透测试实战-HFS远程RCE漏洞利用

免责声明:文章来源于真实渗透测试,已获得授权,且关键信息已经打码处理,请勿利用文章内的相关技术从事非法测试,由于传播、利用此文所提供的信息或者工具而造成的任何直接或者间接的后果及损失,均由使用者本…...

企业级管理系统模板 -- 若依

文章目录 前言一、若依模板运行效果二、若依模板下载地址 1、版本说明2、前端下载地址3、后端下载地址三、修改模板代码名称四、修改前端标题及logo总结 前言 在我们学习别人的项目时,总会遇到许多不同的管理系统,例如:学生管理系统…...

无人车搭载无人机技术详解

无人车搭载无人机技术,是近年来智能交通与无人机技术深度融合的产物,旨在通过集成两者的优势,实现更加灵活、高效的作业能力。该技术将无人机作为无人车的一个可移动、多功能的传感器平台或执行器,通过协同工作,扩展无…...

从“抠图”到“抠视频”,Meta上新AI工具SAM 2。

继2023年4月首次推出SAM,实现对图像的精准分割后,Meta于北京时间2024年7月30日推出了能够分割视频的新模型SAM 2(Segment Anything Model 2)。SAM 2将图像分割和视频分割功能整合到一个模型中。所谓“分割”,是指区别视…...

一篇讲清楚什么是密码加密和加盐算法 | 附Java代码实现

目录 前言: 一、密码加密 1. MD5介绍 2.彩虹表攻击 3.测试复杂密码是否能被攻破 二、加盐算法 1.对密码123456演示加盐算法 2.盐值的储存 3.密码加盐思想总结 三、Java代码实现 前言: 早些年,数据泄露屡见不鲜,每个班上总…...

C++入门2

函数重载 函数重载:是函数的一种特殊情况,C允许在同一作用域中声明几个功能类似的同名函数,这 些同名函数的形参列表(参数个数 或 类型 或 类型顺序)不同,常用来处理实现功能类似数据类型 不同的问题 比如下面的 int add(int x…...

在Nestjs使用mysql和typeorm

1. 创建项目 nest new nest-mysql-test 2. 添加config 安装 nestjs/config 包 pnpm i --save nestjs/config 添加 .env 文件 DATABASE_HOSTlocalhost DATABASE_PORT3306 DATABASE_USERNAMEroot DATABASE_PASSWORD123456 DATABASE_DBdbtest 创建 config/database.config.…...

【数据库】MySql深度分页SQL查询优化

问题描述 mysql中,使用limitoffset实现分页难免会遇到深度分页问题,即页码数越大,性能越差。 select * from student order by id limit 200000,10;如上语句,其实我们希望查询第20000页的10条数据,实际执行会发现耗时…...

macOS多出来了:Google云端硬盘、YouTube、表格、幻灯片、Gmail、Google文档等应用

文章目录 问题现象问题原因解决办法 问题现象 macOS启动台(Launchpad)多出来了:Google云端硬盘、YouTube、表格、幻灯片、Gmail、Google文档等应用。 问题原因 很明显,都是Google家的办公全家桶。这些应用并不是通过独立安装的…...

[Java恶补day16] 238.除自身以外数组的乘积

给你一个整数数组 nums,返回 数组 answer ,其中 answer[i] 等于 nums 中除 nums[i] 之外其余各元素的乘积 。 题目数据 保证 数组 nums之中任意元素的全部前缀元素和后缀的乘积都在 32 位 整数范围内。 请 不要使用除法,且在 O(n) 时间复杂度…...

在WSL2的Ubuntu镜像中安装Docker

Docker官网链接: https://docs.docker.com/engine/install/ubuntu/ 1、运行以下命令卸载所有冲突的软件包: for pkg in docker.io docker-doc docker-compose docker-compose-v2 podman-docker containerd runc; do sudo apt-get remove $pkg; done2、设置Docker…...

3-11单元格区域边界定位(End属性)学习笔记

返回一个Range 对象,只读。该对象代表包含源区域的区域上端下端左端右端的最后一个单元格。等同于按键 End 向上键(End(xlUp))、End向下键(End(xlDown))、End向左键(End(xlToLeft)End向右键(End(xlToRight)) 注意:它移动的位置必须是相连的有内容的单元格…...

智能AI电话机器人系统的识别能力现状与发展水平

一、引言 随着人工智能技术的飞速发展,AI电话机器人系统已经从简单的自动应答工具演变为具备复杂交互能力的智能助手。这类系统结合了语音识别、自然语言处理、情感计算和机器学习等多项前沿技术,在客户服务、营销推广、信息查询等领域发挥着越来越重要…...

SQL Server 触发器调用存储过程实现发送 HTTP 请求

文章目录 需求分析解决第 1 步:前置条件,启用 OLE 自动化方式 1:使用 SQL 实现启用 OLE 自动化方式 2:Sql Server 2005启动OLE自动化方式 3:Sql Server 2008启动OLE自动化第 2 步:创建存储过程第 3 步:创建触发器扩展 - 如何调试?第 1 步:登录 SQL Server 2008第 2 步…...

算法打卡第18天

从中序与后序遍历序列构造二叉树 (力扣106题) 给定两个整数数组 inorder 和 postorder ,其中 inorder 是二叉树的中序遍历, postorder 是同一棵树的后序遍历,请你构造并返回这颗 二叉树 。 示例 1: 输入:inorder [9,3,15,20,7…...

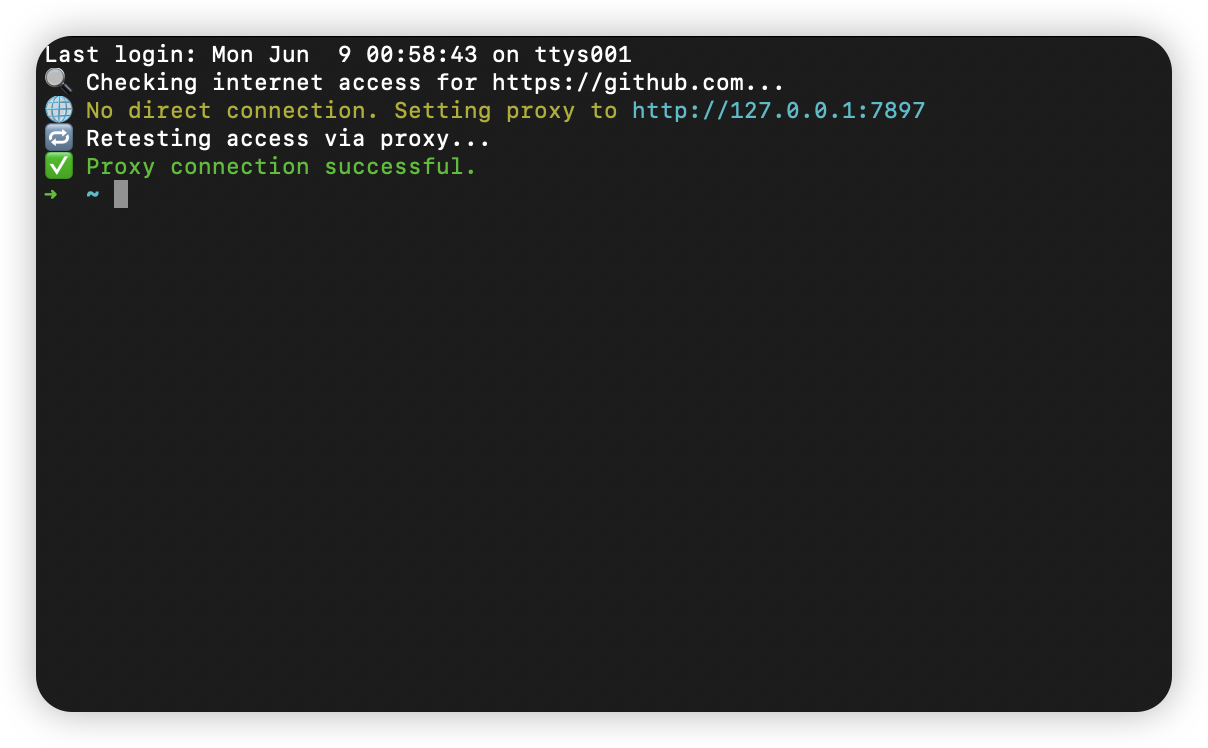

macOS 终端智能代理检测

🧠 终端智能代理检测:自动判断是否需要设置代理访问 GitHub 在开发中,使用 GitHub 是非常常见的需求。但有时候我们会发现某些命令失败、插件无法更新,例如: fatal: unable to access https://github.com/ohmyzsh/oh…...

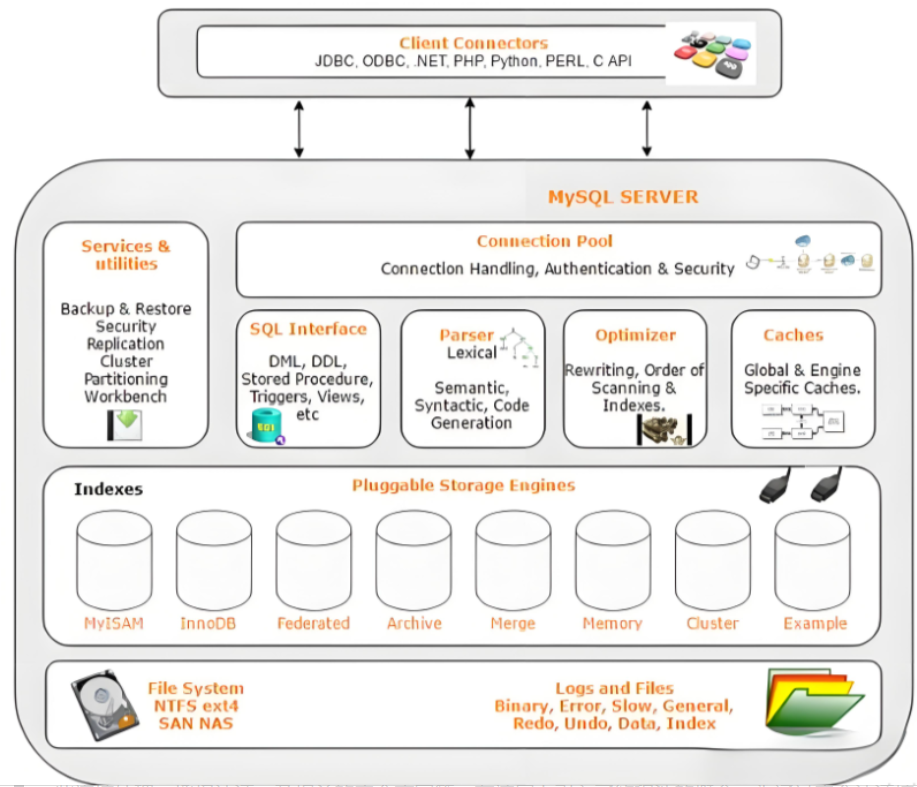

Mysql故障排插与环境优化

前置知识点 最上层是一些客户端和连接服务,包含本 sock 通信和大多数jiyukehuduan/服务端工具实现的TCP/IP通信。主要完成一些简介处理、授权认证、及相关的安全方案等。在该层上引入了线程池的概念,为通过安全认证接入的客户端提供线程。同样在该层上可…...

数据分析六部曲?

引言 上一章我们说到了数据分析六部曲,何谓六部曲呢? 其实啊,数据分析没那么难,只要掌握了下面这六个步骤,也就是数据分析六部曲,就算你是个啥都不懂的小白,也能慢慢上手做数据分析啦。 第一…...