计算机人工智能前沿进展-大语言模型方向-2024-09-20

计算机人工智能前沿进展-大语言模型方向-2024-09-20

1. Multimodal Fusion with LLMs for Engagement Prediction in Natural Conversation

Authors: Cheng Charles Ma, Kevin Hyekang Joo, Alexandria K. Vail, Sunreeta

Bhattacharya, 'Alvaro Fern’andez Garc’ia, Kailana Baker-Matsuoka, Sheryl

Mathew, Lori L. Holt, Fernando De la Torre

使用大型语言模型进行自然对话中的参与度预测的多模态融合

摘要:

本文通过使用可穿戴计算设备(即“智能眼镜”),在自然对话中分析个体的非言语行为,以预测二人互动中的参与度。研究的目的是检测对话中的不感兴趣或困惑的迹象,以期提高对人类交流的理解,并在专业环境中促进更有效的协作,通过富有同情心的虚拟互动提供更好的心理健康支持,并增强沟通障碍者的可及性。研究收集了34名参与者在非正式对话中的多模态数据,并引入了一种使用大型语言模型(LLMs)的新融合策略,将多种行为模态整合到“多模态记录”中,用于行为推理任务。该方法即使在初步实施中也显示出与成熟融合技术相当的性能,显示出进一步研究和优化的潜力。

创新点:

- 提出了一种新颖的数据集,包含使用Pupil Invisible智能眼镜记录的自然、非剧本化的对话。

- 引入了一种新的融合策略,使用大型语言模型(LLMs)作为推理引擎,将行为度量融合到多模态文本表示中。

算法模型:

- 使用了智能眼镜中的传感器(如场景摄像头、眼动追踪摄像头、麦克风和惯性测量单元)来捕捉人类行为。

- 通过大型语言模型(如GPT-4)来模拟参与者,并回答会话结束时的参与度问卷,以此作为预测参与度的手段。

实验效果:

- 该方法在预测参与度方面达到了与成熟融合技术相当的性能。

- 在预测具体回答和情感维度(如情感价值和唤醒度)方面,模型显示出与人类参与者回答的中等程度一致性。

推荐阅读指数:

★★★★☆

推荐理由:

这篇文章在多模态学习和情感计算领域提供了新的视角,特别是在使用大型语言模型来理解和预测人类行为方面。它不仅提出了一个新的数据集,而且还展示了一种创新的方法来分析和利用这些数据,对于希望在自然语言处理和人机交互领域进行创新的研究者来说,这是一篇值得阅读的文章。

2. Towards Data-Centric RLHF: Simple Metrics for Preference Dataset Comparison

Authors: Judy Hanwen Shen, Archit Sharma, Jun Qin

走向以数据为中心的RLHF:偏好数据集比较的简单指标

摘要:

本文讨论了如何通过人类反馈进行强化学习(RLHF)来调整语言模型以符合人类偏好。理想情况下,应该为每个下游应用精心收集和定制偏好数据。然而,实践中,通常使用少数公开的偏好数据集来训练RLHF的奖励模型。尽管新的偏好数据集不断被引入,但目前还没有系统的努力来衡量和比较这些数据集。本文从规模、标签噪声和信息内容三个角度系统地研究偏好数据集,并提出了针对这些角度的具体指标,以更好地理解偏好数据集。

创新点:

- 提出了一种新的数据为中心的方法来比较和理解偏好数据集。

- 引入了有效样本大小、噪声不变性和信息内容三个新的度量指标。

- 通过实验验证了这些度量指标与后续奖励模型性能之间的联系。

算法模型:

- 研究了四个公开的偏好数据集:Anthropic Helpful-Harmless (HH-RLHF)、Ultrafeedback (ULTRAFEEDBACK)、LMSYS Arena Preferences (LMSYS) 和 PKU-SafeRLHF (SAFERLHF)。

- 使用了不同大小的预训练模型来训练奖励模型,包括350百万、10亿和70亿参数的模型。

- 采用了标准的奖励模型训练目标函数,并通过引入标签噪声来研究模型的鲁棒性。

实验效果:

- 通过实验发现,更大的数据集并不总是比更小但与任务更相关的数据集更好。

- 所有研究的偏好数据集都显示出极高的噪声不变性,即使在30-40%的标签被翻转时,性能也保持不变。

- 偏好数据集中响应对的相似性分布差异很大,使用高信息或响应对差异性较大的训练样本的性能提升取决于底层奖励模型。

推荐阅读指数:

★★★★☆

推荐理由:

这篇文章为理解和改进用于人类反馈强化学习的偏好数据集提供了新的视角和工具。

3. Automatic Control With Human-Like Reasoning: Exploring Language Model Embodied Air Traffic Agents

Authors: Justas Andriu\v{s}kevi\v{c}ius, Junzi Sun

具有类人推理能力的自动控制:探索语言模型体现的空中交通代理

摘要:

本文探讨了在空管领域中应用大型语言模型(LLM)作为体现代理的可能性,这些代理能够自动解决空中交通冲突并提供类似人类的决策解释。研究的主要组成部分包括基础的大型语言模型、允许代理与模拟器交互的工具,以及一个新概念——经验库。经验库是一个向量数据库,存储代理从与模拟器和语言模型的交互中学到的综合知识。研究评估了基于语言模型的代理在解决空中交通冲突中的有效性,并详细讨论了采用类人推理能力辅助空中交通管制员的方法的局限性和潜力。

创新点:

- 提出了一种新的方法,使用大型语言模型作为体现代理来解决空中交通冲突。

- 引入了“经验库”这一概念,这是一个存储代理从模拟交互中学习到的知识的向量数据库。

- 展示了代理能够提供人类水平的文本解释,说明交通情况和冲突解决策略。

算法模型:

- 使用了基础的大型语言模型,如Llama3:7B、Llama3:70B、Mixtral 8x7b、gemma2:9b-it和GPT-4o。

- 开发了与BlueSky模拟器交互的工具,包括获取所有飞机信息、获取冲突信息、持续监控、发送命令和搜索经验库等。

- 设计了单一代理和多代理系统,以及一个由规划者、执行者和验证者组成的复杂系统。

实验效果:

- 在120个不同的冲突场景中测试了不同配置的代理,包括两种和四种飞机的冲突。

- 最佳配置(使用GPT-4o模型和经验库的单一代理)能够解决几乎所有的冲突场景,成功率达到99%。

- 多代理系统在解决冲突方面也表现出色,即使是开源的Llama3:70B模型也表现出了高成功率。

推荐阅读指数:

★★★★☆

推荐理由:

这篇文章在将大型语言模型应用于空中交通管理领域方面提供了创新的思路和方法。它不仅展示了语言模型在理解和生成类似人类文本方面的潜力,还探索了如何将这些模型转化为能够在复杂环境中进行决策的智能代理。此外,通过引入经验库的概念,文章还为如何利用历史数据来提高代理性能提供了有价值的见解。

4. ReflectDiffu: Reflect between Emotion-intent Contagion and Mimicry for Empathetic Response Generation via a RL-Diffusion Framework

Authors: Jiahao Yuan, Zixiang Di, Zhiqing Cui, Guisong Yang, Usman Naseem

ReflectDiffu:通过强化学习-扩散框架在情感-意图传染与模仿之间进行反思,以生成同理心响应

摘要:

本文提出了一个名为ReflectDiffu的轻量级框架,用于生成富有同理心的响应。该框架结合了情感传染和意图模仿,通过一个反思机制来增强情感表达,并使用情感推理掩码来识别关键的情感元素。此外,它在强化学习过程中整合了意图模仿,以在扩散过程中进行精细化调整。通过探索-采样-纠正机制,ReflectDiffu能够将情感决策转化为精确的意图行动,从而解决由于情感误识别导致的同理心响应错位问题。通过反思,该框架将情感状态映射到意图上,显著提高了响应的同理心和灵活性。全面的实验表明,ReflectDiffu在相关性、可控性和信息丰富度方面超越了现有模型,并且在自动和人类评估中都取得了最先进的结果。

创新点:

- 提出了ReflectDiffu框架,该框架利用情感传染和意图模仿来生成同理心响应。

- 引入了“意图两次”机制,即探索-采样-纠正过程,以最小化由情感误识别引起的同理心响应错位。

- 利用大型语言模型(LLMs)扩展了情感推理、情感预测、意图预测和同理心对话生成的多任务数据集。

算法模型:

- 情感传染编码器:增强了情感推理注释器,以改善语义理解。

- 理性响应生成解码器:通过意图探索-采样-纠正机制,模仿人类反思式对话行为,增强同理心。

- 多任务学习:结合了情感原因掩码、情感预测、意图预测和同理心对话生成的任务。

实验效果:

- 在EMPATHETICDIALOGUES数据集上进行了评估,与多个基线模型相比,ReflectDiffu在相关性、可控性和信息丰富度方面表现更好。

- 在自动评估中,ReflectDiffu在BLEU-1、BLEU-2、BLEU-3、BLEU-4、BARTScore、情感准确度、意图准确度、Distinct-1、Distinct-2和Perplexity等指标上均优于现有模型。

- 在人类评估中,ReflectDiffu在同理心、相关性和流畅性方面均优于基线模型。

推荐阅读指数:

★★★★☆

推荐理由:

这篇文章提出了一个创新的框架,用于生成具有同理心的对话响应。它通过结合情感理解和意图预测,提高了对话系统的自然性和人性化。此外,该研究在自动和人类评估中都显示出了显著的性能提升,对于希望在对话系统、情感计算和人工智能领域进行创新的研究者来说,这是一篇值得阅读的文章。

5. Contextual Evaluation of Large Language Models for Classifying Tropical and Infectious Diseases

Authors: Mercy Asiedu, Nenad Tomasev, Chintan Ghate, Tiya Tiyasirichokchai, Awa

Dieng, Oluwatosin Akande, Geoffrey Siwo, Steve Adudans, Sylvanus Aitkins,

Odianosen Ehiakhamen, Katherine Heller

针对热带和传染病分类的大型语言模型的情境评估

摘要

本文探讨了大型语言模型(LLMs)在医疗问答中的潜力,尤其是在热带和传染病领域的应用。研究团队基于开源的热带和传染病(TRINDs)数据集,扩展了包含人口统计学和语义临床信息的11000多个提示。通过系统实验,研究了上下文信息(如人口统计学、地理位置、性别、风险因素)对LLM响应的益处。此外,开发了一个名为TRINDs-LM的原型工具,用于展示上下文如何影响LLM在健康领域的输出。

创新点

- 扩展了现有的TRINDs数据集,增加了人口统计学和语义临床信息。

- 对一般和专业医疗LLMs进行了比较,并与人类专家的评估结果进行了对比。

- 通过不同上下文和反事实位置的评估,理解了LLM性能的影响。

- 开发了TRINDs-LM工具,为研究者提供了一个平台,用于研究上下文如何影响LLM在健康领域的输出。

算法模型

- 使用了两个基线模型:Gemini Ultra(通用大型语言模型)和MedLM Medium(专门针对健康领域的LLM)。

- 通过提供指令和示例来引导模型输出,进行了提示调整(prompt-tuning)。

- 开发了自动化评分器,通过LLM来确定输出的准确性。

实验效果

- Gemini Ultra在原始临床角色上的准确率为61.5%,而MedLM为47.9%。

- 在包含症状、位置和风险因素的完整角色中,模型表现最佳。

- 在反事实输入(如不同地理位置、种族、性别)的测试中,模型性能略有下降,但整体趋势稳定。

- 通过多样本提示调整,模型在不同人群、地点和问题风格上的表现有所提高。

推荐阅读指数:

★★☆☆☆

推荐理由

- 跨学科价值:该研究结合了医学、公共卫生和人工智能领域,对于希望了解如何将LLM应用于医疗诊断的研究人员和实践者具有吸引力。

- 数据集扩展:通过扩展数据集,该研究为未来在热带和传染病领域的LLM研究提供了更丰富的资源。

- 工具开发:TRINDs-LM工具的开发为研究人员提供了一个实用的平台,用于进一步探索和验证LLM在医疗领域的应用。

- 实际应用潜力:研究结果表明,通过适当的上下文信息和模型调整,LLMs在医疗诊断中的准确性和适用性可以得到显著提升,这对于医疗资源有限的地区尤其有价值。

6. NovAScore: A New Automated Metric for Evaluating Document Level Novelty

Authors: Lin Ai, Ziwei Gong, Harshsaiprasad Deshpande, Alexander Johnson, Emmy

Phung, Ahmad Emami, Julia Hirschberg

NOVASCORE:一种新的自动化指标,用于评估文档级别的新颖性

摘要

随着在线内容的迅速扩展,信息冗余问题日益突出,迫切需要能够识别真正新信息的解决方案。尽管面临这一挑战,研究社区对新颖性检测的关注却有所下降,尤其是随着大型语言模型(LLMs)的兴起。此外,先前的方法在很大程度上依赖于人工注释,这既耗时又昂贵,尤其是当注释者需要将目标文档与大量历史文档进行比较时。在本项工作中,我们介绍了NOVASCORE(原子级新颖性评估分数),这是一种自动化的文档级别新颖性评估指标。NOVASCORE通过聚合原子信息单元的新颖性和显著性评分,提供了高度的可解释性和对文档新颖性的详细分析。借助其动态权重调整方案,NOVASCORE提供了额外的灵活性和维度,以评估文档内信息的新颖性和重要性。我们的实验表明,NOVASCORE与人类对新颖性的判断有很强的相关性,在TAP-DLND 1.0数据集上达到了0.626的点双序相关性,在内部人工注释数据集上达到了0.920的皮尔逊相关性。

创新点

- 提出了NOVASCORE,这是一种自动化的文档级别新颖性评估指标,它通过聚合原子内容单元的新颖性和显著性评分,提供了高度的可解释性。

- 引入了动态权重调整方案,增强了评估文档整体新颖性时的灵活性和维度。

- 开源了NOVASCORE工具,鼓励进一步的研究以扩大其适用性并提高其可扩展性。

算法模型

NOVASCORE框架通过以下步骤实现:

- 原子内容单元(ACU)提取:将目标文档分解为ACU,每个ACU包含传达单一信息所需的最小原子事实数量。

- ACU新颖性评估:通过与历史文档的ACUBank比较,评估每个ACU的新颖性。

- ACU显著性评估:通过将ACU与文档摘要比较,确定每个ACU的显著性。

- ACU分数聚合:通过聚合所有ACU的新颖性和显著性评分来计算文档的整体NOVASCORE。

- 动态权重调整:根据显著性比例动态调整显著性和非显著性ACU的权重,以准确反映它们的重要性。

实验效果

- 在TAP-DLND 1.0数据集上,NOVASCORE与人工新颖性判断的点双序相关性为0.626。

- 在内部人工注释数据集上,NOVASCORE与人工新颖性判断的皮尔逊相关性为0.920。

- 实验结果表明,NOVASCORE在评估文档新颖性方面与人类判断有很强的相关性。

推荐阅读指数:

★★☆☆☆

推荐理由

- 创新性:NOVASCORE提出了一种新颖的自动化方法来评估文档级别的新颖性,这在信息冗余日益严重的今天尤为重要。

- 实用性:通过动态权重调整方案,NOVASCORE能够更准确地反映文档中信息的新颖性和重要性,这对于内容筛选和信息检索等领域具有很高的实用价值。

- 开源工具:NOVASCORE作为开源工具发布,为研究人员和开发者提供了进一步研究和应用的便利。

- 高相关性:实验结果证明了NOVASCORE与人类判断的高相关性,显示了其在实际应用中的潜力。

这篇论文为文档新颖性评估领域提供了一种新的视角和工具,对于希望在信息检索、内容推荐和数据挖掘等领域应用新颖性评估的研究者和实践者来说,具有很高的参考价值。

7. Language Models “Grok” to Copy

Authors: Ang Lv, Ruobing Xie, Xingwu Sun, Zhanhui Kang, Rui Yan

语言模型通过“理解”来复制

摘要

本文研究了语言模型在预训练过程中的动态变化,特别关注了它们从上下文中复制文本的能力,这是各种大型语言模型(LLM)应用中的一项基本技能,包括在上下文学习(ICL)和检索增强生成(RAG)中。作者提出了一个新的视角,即基于Transformer的语言模型发展复制能力的方式类似于“理解”(grokking),这指的是在模型过度拟合训练集之后,测试集上的泛化能力突然出现的提高。实验结果提供了三个论点:(1) 预训练损失迅速下降,而模型的上下文复制能力最初滞后然后突然饱和;(2) 发展复制能力的速度与训练的token数量无关,类似于理解速度不受数据集大小影响,只要数据分布保持不变;(3) 负责复制的感应头(induction heads)在训练过程中从浅层到深层形成,类似于在理解过程中深层电路的发展。作者认为,理解与上下文复制之间的联系可以为更有效的语言模型训练提供有价值的见解,最终提高上下文性能。

创新点

- 提出了“理解”(grokking)的概念,将其与语言模型的上下文复制能力发展联系起来。

- 通过实验观察到上下文复制能力的发展与预训练损失的下降不同步,而是在训练后期突然提高,类似于理解现象。

- 发现复制能力的发展与训练token的数量无关,而是与训练的迭代次数有关。

- 观察到感应头在训练过程中从浅层到深层的形成,这与理解过程中深层电路的发展一致。

算法模型

- 使用12层的Llama模型进行训练,模型包含12个注意力头,隐藏状态维度为768,MLP层的中间维度为3,072。

- 模型参数共计162M,使用Llama tokenizer,词汇量为32,000 tokens,模型上下文长度设置为1,024 tokens。

- 采用AdamW优化器进行训练,学习率为0.1,预热步骤为2000,norm clip值为1。

实验效果

- 通过训练过程中的检查点分析,观察到上下文复制准确性在训练损失稳定后突然出现提高,这与理解现象相似。

- 调整批量大小以控制特定更新步骤中训练的token数量,结果表明上下文复制能力的发展与token数量无关,而是在特定更新步骤后形成。

- 通过改变学习率,发现更高的学习率可以加速复制能力的发展,表明优化的强度(由学习率和更新步骤决定)对理解复制有影响。

- 观察到感应头在训练过程中从浅层到深层的形成,与理解过程中深层电路的发展一致。

推荐阅读指数:

★★★☆☆

推荐理由

- 新颖性:文章提出了一个新颖的视角,将语言模型的上下文复制能力与理解现象联系起来,为理解LLM的训练动态提供了新的视角。

- 实验设计:通过细致的实验设计和分析,展示了预训练过程中上下文复制能力的发展与理解现象的相似性,实验结果具有说服力。

- 潜在影响:文章的发现可能对改进语言模型的训练方法、提高模型的上下文性能具有重要的指导意义。

- 理论与实践结合:文章不仅在理论上提出了新的见解,还通过实验验证了这些观点,展示了理论与实践相结合的研究方法。

8. ODE: Open-Set Evaluation of Hallucinations in Multimodal Large Language Models

Authors: Yahan Tu, Rui Hu, Jitao Sang

ODE:多模态大型语言模型幻觉的开放集评估

摘要

本文介绍了一种名为ODE(Open-Set Dynamic Evaluation Protocol)的新框架,用于评估多模态大型语言模型(MLLMs)中的对象存在幻觉。现有的评估幻觉的基准测试是静态的,可能导致潜在的数据污染。ODE利用图结构来模拟现实世界概念之间的关联,并为一般和特定领域场景生成新颖的样本。概念的动态组合以及各种组合原则确保了广泛的样本分布。实验结果表明,MLLMs在由ODE生成的样本上表现出更高的幻觉率,有效避免了数据污染。此外,这些样本也可用于微调,以提高MLLMs在现有基准测试中的性能。

创新点

- 提出了ODE,这是一个开放集、动态的评估协议,专门用于评估MLLMs中的对象存在幻觉。

- 采用图结构来模拟现实世界场景,并从中提取概念节点,设计视觉内容和提示,以生成具有广泛分布的大规模数据。

- 提供了四种难度递增的测试集分布标准:常见、长尾、随机和虚构,以实现概念选择的灵活性和定制化。

- 通过实验验证了ODE生成的样本能够揭示MLLMs在更多样化条件下的局限性和能力边界。

算法模型

- ODE框架使用加权图G来模拟现实世界场景,其中节点代表对象概念,边权重W表示实体间关系的强度。

- 基于图结构,ODE设计了四种概念组合标准(常见、长尾、随机、虚构),以动态生成测试图像和相应的文本提示。

- 使用文本到图像的生成模型(如Stable Diffusion 1.5)根据文本提示生成测试图像,并利用开放词汇对象检测模型过滤低质量图像。

- 为生成性和鉴别性任务开发了专门的评估提示模板,以自动化地生成测试数据。

实验效果

- 在多种MLLMs上进行了广泛的实验,结果显示与现有静态基准相比,模型在ODE生成的样本上表现出更高的幻觉率。

- 通过聚类分析揭示了不同概念的幻觉倾向,发现在具有高上下文相似性或视觉模糊性的场景中,幻觉更有可能发生。

- 使用ODE生成的数据进行微调可以显著提高MLLMs在现有基准测试中的性能。

推荐阅读指数:

★★★★☆

推荐理由

- 创新性:ODE提出了一种新颖的开放集动态评估方法,专门针对MLLMs中的幻觉问题,这对于提高模型的可靠性和实际应用价值具有重要意义。

- 实用性:ODE不仅作为一个评估工具,还可以通过生成的样本用于微调,提高MLLMs在特定领域的性能,具有很高的实用价值。

- 广泛影响:随着多模态模型在自动驾驶、医疗等领域的应用,评估和改进这些模型的能力变得尤为重要。ODE提供了一种有效的评估和改进手段。

- 实验验证:通过一系列实验验证了ODE的有效性,实验设计严谨,结果具有说服力。

9. Efficient Fine-Tuning of Large Language Models for Automated Medical Documentation

Authors: Hui Yi Leong, Yi Fan Gao, Ji Shuai, Uktu Pamuksuz

用于自动化医疗文档的大型语言模型的有效微调

摘要

本研究针对医生在电子健康记录(EHRs)和文书工作上花费的额外行政时间,提出了一个名为MediGen的微调大型语言模型(LLM),旨在自动化从医疗对话生成医疗报告的过程。利用开源预训练模型的先进微调方法,包括LLaMA3-8B,MediGen在转录和总结临床互动方面实现了高准确度。微调后的LLaMA3-8B模型在生成准确且临床相关的医疗报告方面表现出色,ROUGE得分为58%,BERTScore-F1为72%,表明其在提高医疗工作流程的效率和医生福祉方面的潜力。

创新点

- 提出了MediGen,一个专门针对自动化医疗报告生成的微调大型语言模型。

- 采用了包括QLoRA和PEFT在内的先进微调技术,以减少模型在医疗环境中的计算资源需求。

- 强调了在保持高准确度的同时,最小化计算资源需求的重要性,为自动化医疗文档的进步奠定了基础。

算法模型

- 使用了LLaMA3-8B作为基础模型,这是一个平衡了性能和资源效率的transformer模型。

- 采用了Quantized Low-Rank Adaptation (QLoRA) 和 Parameter-Efficient Fine-Tuning (PEFT) 技术来减少内存消耗和计算负荷。

- 应用了指令调整方法,明确指导模型将信息组织到SOAP笔记的特定部分。

实验效果

- 在ACI-BENCH数据集上,MediGen的平均ROUGE-1得分为58.22%,ROUGE-Lsum为53.84%,BERTScore-F1为72.1%,优于当前领先的BART+FTSMSum模型。

- 临床审查中,75%的生成笔记被认为无需手动更正即可临床使用,89%的评估者认为MediGen在医院中的实施可以显著减轻医生的行政工作负担。

推荐阅读指数:

★★★★☆

推荐理由

- 实际应用价值:MediGen通过自动化医疗文档的生成,有助于减轻医生的行政负担,提高医疗效率和医生福祉,具有很高的实际应用价值。

- 技术创新:该研究采用了先进的微调技术和模型,如LLaMA3-8B、QLoRA和PEFT,这些技术在医疗领域的应用展示了处理长医疗对话和生成高质量医疗报告的能力。

- 研究方法论:研究方法论严谨,包括数据预处理、模型选择、微调技术以及详尽的评估,为未来在医疗领域的自动化文档生成提供了可靠的研究基础。

- 潜在影响:随着医疗领域对自动化和人工智能的需求日益增长,MediGen的研究和开发可能对医疗行业的工作流程产生深远影响。

这篇论文对于医疗领域的自动化、人工智能应用以及大型语言模型的研究者和实践者来说,提供了有价值的见解和方法,具有很高的参考价值。

10. Generating Event-oriented Attribution for Movies via Two-Stage Prefix-Enhanced Multimodal LLM

Authors: Yuanjie Lyu, Tong Xu, Zihan Niu, Bo Peng, Jing Ke, Enhong Chen

通过两阶段前缀增强的多模态大型语言模型生成面向事件的电影属性

摘要

社交媒体平台的繁荣引发了对语义丰富服务的迫切需求,例如事件和故事情节归属。然而,大多数现有研究集中在通过基本字幕任务理解剪辑级别的事件,而没有分析整部电影中事件的原因。这是一个重大挑战,因为即使是先进的多模态大型语言模型(MLLMs)也难以处理大量多模态信息,这是由于有限的上下文长度。为了解决这个问题,我们提出了一种两阶段前缀增强的MLLM(TSPE)方法,用于电影视频中的事件归属,即连接相关事件及其因果语义。在局部阶段,我们引入了一个交互感知前缀,引导模型关注单个剪辑中的相关多模态信息,简要总结单一事件。相应地,在全局阶段,我们使用推理知识图谱加强相关事件之间的联系,并设计了一个事件感知前缀,指导模型关注相关事件而不是所有之前的剪辑,从而实现准确的事件归属。两个真实世界数据集的全面评估表明,我们的框架优于最先进的方法。

创新点

- 提出了一种新颖的两阶段框架,通过前缀增强的MLLM有效地捕获、总结和丰富多模态线索。

- 在局部阶段,开发了交互感知前缀,确保MLLM专注于与事件相关的多模态线索,同时最小化来自同一剪辑中其他重叠事件的干扰。

- 在全局阶段,引入了事件感知前缀和推理知识图谱,以加强事件间的语义联系,并准确归属事件原因。

算法模型

- 局部阶段:使用交互感知前缀,通过注意力机制将社会互动作为查询,多模态线索作为键和值,将与特定互动相关的信息压缩成嵌入,作为MLLM的前缀。

- 全局阶段:利用推理知识图谱(如ATOMIC)预测给定事件的可能后果,使用事件感知前缀,通过注意力机制将当前事件与之前事件的相关信息压缩成嵌入,作为MLLM的输入。

实验效果

- 在MovieGraph和CHAR数据集上进行了评估,使用BLEU、METEOR和ROUGE-L等自动评估指标。

- TSPE框架在局部阶段和全局阶段均优于多个最先进的方法,显示出在生成准确的事件描述和归属方面的优越性能。

推荐阅读指数:

★★★★☆

推荐理由

- 创新性:该研究提出了一种新颖的两阶段方法,通过前缀增强的MLLM有效地处理视频内容,为视频理解领域提供了新的视角。

- 实际应用价值:研究的成果有助于改善视频内容的语义理解,特别是在电影和电视剧等长视频中的事件归属任务,具有实际应用潜力。

- 研究方法论:研究方法论严谨,通过详细的实验设置和评估指标,验证了模型的有效性,为后续研究提供了可靠的参考。

- 跨学科价值:该研究结合了计算机视觉、自然语言处理和知识图谱等多个领域的技术,展示了跨学科研究的价值。

相关文章:

计算机人工智能前沿进展-大语言模型方向-2024-09-20

计算机人工智能前沿进展-大语言模型方向-2024-09-20 1. Multimodal Fusion with LLMs for Engagement Prediction in Natural Conversation Authors: Cheng Charles Ma, Kevin Hyekang Joo, Alexandria K. Vail, Sunreeta Bhattacharya, Alvaro Fern’andez Garc’ia, Kailan…...

cv环境设置

pytorch TensorFlow。。。 环境布置,库的安装顺序: 确定显卡可用的cuda上下限 (比如3090需要至少11.x以上的cuda参考: 一文理顺:pytorch、cuda版本,从此不再为兼容问题头疼! - 哔哩哔哩 (bilibili.com)&am…...

线性代数书中求解线性方程组的三种方法的实例

目录 一、克拉默法则(P45) 二、逆矩阵(P46) 三、高斯-约旦消元法(P65) 一、克拉默法则(P45) 二、逆矩阵(P46) 三、高斯-约旦消元法(P65)...

Linux容器化管理——Docker常见命令总结

创建镜像 docker build -t (镜像名) . 自动在当前目录下找dockerfile也可换成其他路径 查看本地镜像 docker images 登陆镜像服务器 docker login -u (登录名) -p (登陆密码) (镜像服务器…...

智慧校园建设解决方案建设系统简介

一、建设背景 1.1 政策背景 1.2 班牌的演变 1.3 建设愿景 二、 智慧班牌简介 三、智慧班牌系统 3.1 系统概述 3.2 软件平台功能交互简介 3.2.1 智慧班牌与管理平台间的功能关联 3.2.2 手机客户端(管理员、教师、家长端) 3.2.3 手机客户端&#x…...

用Python打造互动式中秋节庆祝小程序

中秋节,这个充满传统韵味的节日,不仅是家人团聚的时刻,也是程序员展示创意的好机会。本文将引导您使用Python创建一个互动式中秋节庆祝小程序,它不仅能够展示节日祝福,还能通过一些简单的特效增加节日气氛。 文章目录 …...

Linux 生成 git ssh 公钥

在Linux系统中生成SSH公钥以用于Git的步骤如下: 打开终端:首先,你需要打开你的Linux系统的终端。 检查SSH密钥:在生成新的SSH密钥之前,你可以检查是否已经存在SSH密钥。在终端中输入以下命令: ls -al ~/.s…...

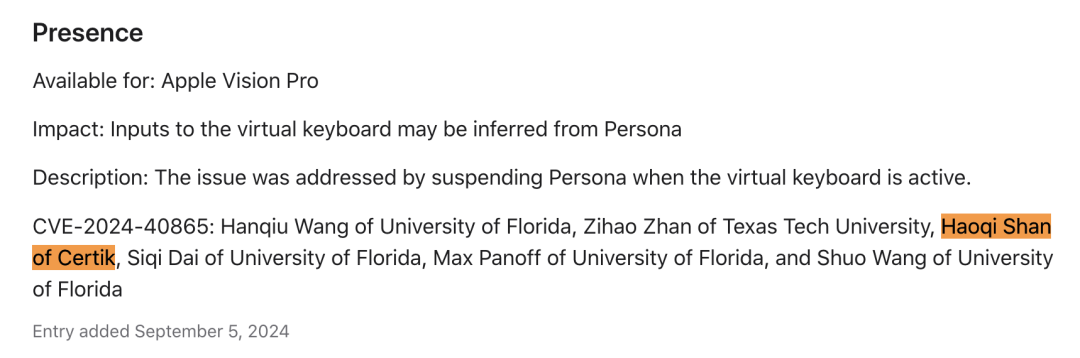

CertiK因发现Apple Vision Pro眼动追踪技术漏洞,第6次获苹果认可

2024年9月20日,头部Web3.0安全机构CertiK自豪地宣布,CertiK的工程师因发现Apple Vision Pro MR(混合现实)头显设备中的关键漏洞而获得Apple公司认可,这已经是Apple公司第六次公开发布对CertiK的致谢,Cert…...

自动登录 RPA 的进阶:滑块验证的巧妙实现

在RPA的众多应用场景的探索中,自动登录是一个至关重要的环节,它为后续的自动化操作奠定了基础。然而,当我们面对滑块验证这一常见的挑战时,常常会感到困惑和无从下手。本文就来分享自动登录RPA的进阶----滑块验证如何实现。 在…...

Flask-WTF的使用

组织一个 Flask 项目通常需要遵循一定的结构,以便代码清晰、可维护。下面是一个典型的 Flask 项目结构: my_flask_app/ │ ├── app/ │ ├── __init__.py │ ├── models.py │ ├── views.py │ ├── forms.py │ ├── templat…...

Docker 进入容器并运行命令的方法

目录 理解 Docker 容器的基本概念 使用 docker exec 进入运行中的容器 基本用法 常用选项解析 选项详解 实际案例演示 1. 进入容器的交互式 Shell 2. 在容器中运行单个命令 3. 以指定用户运行命令 4. 设置环境变量并运行命令 5. 指定工作目录 使用 docker attach 附…...

深度剖析_数学建模完整过程+详细思路+代码全解析)

2024“华为杯”中国研究生数学建模竞赛(E题)深度剖析_数学建模完整过程+详细思路+代码全解析

问题1详细解答过程 (1) 交通流参数统计 数据预处理 数据读取: 从四个视频观测点提取交通流数据,包括每个时间段内的车流量、车速和车道占用率等。 交通流参数计算 3. 计算流量 (Q): Q ( t ) N ( t ) Δ t Q(t) \frac{N(t)}{\Delta t} Q…...

伊犁云计算22-1 apache 安装rhel8

1 局域网网络必须通 2 yum 必须搭建成功 3 apache 必须安装 开干 要用su 用户来访问 一看httpd 组件安装完毕 到这里就是测试成功了 如何修改主页的目录 网站目录默认保存在/var/WWW/HTML 我希望改变/home/www 122 127 167 行要改...

概率论原理精解【13】

文章目录 在度量空间中,连续映射概述一、度量空间与距离函数二、连续映射的定义三、连续映射的等价定义四、连续映射的性质五、应用与例子 球形邻域刻画一、球形邻域的定义二、连续映射的球形邻域刻画三、等价性证明四、应用与例子 将度量空间上的连续映射推广到拓扑…...

年度巨献 | OpenCSG开源最大中文合成数据集Chinese Cosmopedia

01 背景 近年来,生成式语言模型(GLM)的飞速发展正在重塑人工智能领域,尤其是在自然语言处理、内容创作和智能客服等领域展现出巨大潜力。然而,大多数领先的语言模型主要依赖于英文数据集进行训练,中文数据…...

Mac 上,终端如何开启 proxy

文章目录 为什么要这么做前提步骤查看 port查看代理的port配置 bash测试 为什么要这么做 mac 上的终端比较孤僻吧,虽然开了,但是终端并不走🪜…产生的现象就是,浏览器可以访问🌍,但是终端不可以访问&#…...

Linux中的进程入门

冯诺依曼体系结构 操作系统(Operator System) 进程控制块(PCB) struct task_struct{//该进程的所有属性//该进程对应的代码和属性地址struct task_struct* next; }; struct task_struct 内核结构体——>创建内核结构体对象(task_struct)…...

Redis面试真题总结(三)

文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 文章收录在网站:http://hardyfish.top/ 什么是缓存雪崩?该如何解决? 缓存雪崩是指…...

:大疆)

ARM/Linux嵌入式面经(三三):大疆

嵌入式工程师考察主要蕴含:C/C++,处理器的架构,操作系统(linux或嵌入式实时操作系统),常见硬件接口协议/总线,文件存储系统等几方面 文章目录 1)C/C++static作用,变量加入static以后在内存中存储位置的变化。static的作用变量加入static后在内存中存储位置的变化面试官…...

《DevOps实践指南》笔记-Part 2

一篇文章显得略长,本文对应第3-4章。前言、第1-2章请参考Part 1;第5-6章、附录、认证考试、参考资源等内容,请参考Part 3。 流动的技术实践 持续交付:降低在生产环境中部署和发布变更的风险。包括:打好自动化部署流水…...

Docker 运行 Kafka 带 SASL 认证教程

Docker 运行 Kafka 带 SASL 认证教程 Docker 运行 Kafka 带 SASL 认证教程一、说明二、环境准备三、编写 Docker Compose 和 jaas文件docker-compose.yml代码说明:server_jaas.conf 四、启动服务五、验证服务六、连接kafka服务七、总结 Docker 运行 Kafka 带 SASL 认…...

基于当前项目通过npm包形式暴露公共组件

1.package.sjon文件配置 其中xh-flowable就是暴露出去的npm包名 2.创建tpyes文件夹,并新增内容 3.创建package文件夹...

Map相关知识

数据结构 二叉树 二叉树,顾名思义,每个节点最多有两个“叉”,也就是两个子节点,分别是左子 节点和右子节点。不过,二叉树并不要求每个节点都有两个子节点,有的节点只 有左子节点,有的节点只有…...

-HIve数据分析)

大数据学习(132)-HIve数据分析

🍋🍋大数据学习🍋🍋 🔥系列专栏: 👑哲学语录: 用力所能及,改变世界。 💖如果觉得博主的文章还不错的话,请点赞👍收藏⭐️留言Ǵ…...

嵌入式学习笔记DAY33(网络编程——TCP)

一、网络架构 C/S (client/server 客户端/服务器):由客户端和服务器端两个部分组成。客户端通常是用户使用的应用程序,负责提供用户界面和交互逻辑 ,接收用户输入,向服务器发送请求,并展示服务…...

A2A JS SDK 完整教程:快速入门指南

目录 什么是 A2A JS SDK?A2A JS 安装与设置A2A JS 核心概念创建你的第一个 A2A JS 代理A2A JS 服务端开发A2A JS 客户端使用A2A JS 高级特性A2A JS 最佳实践A2A JS 故障排除 什么是 A2A JS SDK? A2A JS SDK 是一个专为 JavaScript/TypeScript 开发者设计的强大库ÿ…...

CSS | transition 和 transform的用处和区别

省流总结: transform用于变换/变形,transition是动画控制器 transform 用来对元素进行变形,常见的操作如下,它是立即生效的样式变形属性。 旋转 rotate(角度deg)、平移 translateX(像素px)、缩放 scale(倍数)、倾斜 skewX(角度…...

打手机检测算法AI智能分析网关V4守护公共/工业/医疗等多场景安全应用

一、方案背景 在现代生产与生活场景中,如工厂高危作业区、医院手术室、公共场景等,人员违规打手机的行为潜藏着巨大风险。传统依靠人工巡查的监管方式,存在效率低、覆盖面不足、判断主观性强等问题,难以满足对人员打手机行为精…...

MyBatis中关于缓存的理解

MyBatis缓存 MyBatis系统当中默认定义两级缓存:一级缓存、二级缓存 默认情况下,只有一级缓存开启(sqlSession级别的缓存)二级缓存需要手动开启配置,需要局域namespace级别的缓存 一级缓存(本地缓存&#…...

redis和redission的区别

Redis 和 Redisson 是两个密切相关但又本质不同的技术,它们扮演着完全不同的角色: Redis: 内存数据库/数据结构存储 本质: 它是一个开源的、高性能的、基于内存的 键值存储数据库。它也可以将数据持久化到磁盘。 核心功能: 提供丰…...