《深度学习》神经语言模型 Word2vec CBOW项目解析、npy/npz文件解析

目录

一、关于word2vec

1、什么是word2vec

2、常用训练算法

1)CBOW

2)SkipGram

二、关于npy、npz文件

1、npy文件

1)定义

2)特性

3)用途

4)保存及读取

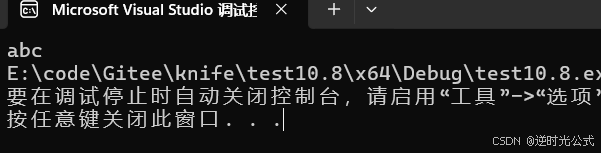

运行结果:

运行结果:

2、npz文件

1)定义

2)用途

3)保存及读取

运行结果:

运行结果:

三、CBOW案例解析

1、获取训练集数据

调试结果:

2、生成one-hot

运行结果:

3、创建CBOW类

4、cuda、优化器

5、开始训练

运行结果:

6、测试

运行结果:

7、获取词向量矩阵

运行结果:

8、生成词嵌入字典

9、保存为npz文件

运行结果:

一、关于word2vec

1、什么是word2vec

Word2Vec是一种用于将单词表示为连续向量的技术。它是一种浅层、双层的神经网络模型,用于训练单词的分布式表示。

Word2Vec模型将单词映射到一个低维向量空间中,使得具有相似含义的单词在向量空间中距离较近。这种表示方法有助于在自然语言处理任务中更好地捕捉和理解单词之间的语义关系。

2、常用训练算法

1)CBOW

以上下文词汇预测当前词,前后两个单词预测当前词,这里的两个单词是自定义个数的

![]()

2)SkipGram

以当前词预测其上下文词汇,即当前词预测前后两个单词,这里的两个单词也是自定义个数的

![]()

二、关于npy、npz文件

1、npy文件

1)定义

npy文件是NumPy库中用于保存数组数据的二进制文件格式。

2)特性

二进制存储:npy文件以二进制形式存储数据,比文本文件(如CSV)更加高效地保存大型数组数据。二进制格式允许直接映射到内存,从而加快了读写速度。

数据完整性:npy文件不仅保存数组的数据,还包含了数组的形状(维度)、数据类型以及其他必要的元数据信息。这确保了数据的完整性,使得在加载数据时可以完全重现保存时的数组,而无需任何额外的转换或解析。

跨平台性:npy文件的格式是跨平台的,可以在不同的操作系统和硬件环境中进行加载和使用。

3)用途

npy文件的设计目的是为了在数据分析和科学计算领域中,提供一种高效的存储和读取NumPy数组数据的方式。

4)保存及读取

"""保存为npy文件"""

a = np.random.randint(5,size=(2,4))

np.save('test.npy',a)

运行结果:

![]()

"""读取npy文件"""

b = np.load('test.npy')

print(b)运行结果:

2、npz文件

1)定义

npz文件是NumPy用于存储数值数据的压缩格式。它实际上是一个压缩存档文件,可以包含一个或多个NumPy数组。

2)用途

npz文件通常用于存储和传输大量的数值数据,特别是在科学计算和数据分析领域。

3)保存及读取

"""保存为npz文件"""

a = np.random.randint(0,10,(3,),dtype='int')

b = np.random.randint(0,10,(3,),dtype='int')

c = np.random.randint(0,10,(3,),dtype='int')

np.savez('test.npz',file1=a,file2=b,file3=c) # 压缩储存数组,并给数组 分别命名运行结果:

![]()

"""读取npz文件"""

data = np.load('test.npz')

print(data.files) # 读取其内文件名

aa = data[data.files[0]] # 读取文件内容

bb = data[data.files[1]]

cc = data[data.files[2]]

print('read:',aa,bb,cc) # 打印文件内容运行结果:

三、CBOW案例解析

1、获取训练集数据

import torch

import torch.nn as nn # 神经网络

import torch.nn.functional as F

import torch.optim as optim

from tqdm import tqdm,trange # 显示进度条函数

import numpy as npCONTEX_SIZE = 2 # 设置词左边和右边选择的个数(即上下文词汇个数)

raw_text = """

We are about to study the idea of a computational process.

Computational processes are abstract beings that inhabit computers.

As they evolve, processes manipulate other abstract things called data.

The evolution of a process is directed by a pattern of rules

called a program. People create programs to direct processes.

In effect we conjure the spirits of the computer with our spells.

""".split() # 语料库# 中文的语句,你可以选择分词,也可以选择分字

vocab = set(raw_text) # 利用集合的唯一性,建立词库,集合内元素不重复

vocab_size = len(vocab) # 打印词库长度# enumerate返回一个可迭代对象的元素内容及其索引

word_to_idx = {word:i for i,word in enumerate(vocab)} # for循环的复合写法,第1次循环,i得到的索引号,word 第1个单词

idx_to_word = {i:word for i,word in enumerate(vocab)}data = [] # 用于存放分割出来的元组,元组内有两个元素,一个数前后对应的四个单词,另一个是中间的词

for i in range(CONTEX_SIZE,len(raw_text)-CONTEX_SIZE): # 遍历值为上述设置的左右两边词长度2到文章总次数-2,i从2开始context = ([raw_text[i-(2-j)] for j in range(CONTEX_SIZE)] # 获取前两个单词+ [raw_text[i+j+1] for j in range(CONTEX_SIZE)] # 获取后两个单词) # 获取上下文词,第一组为(['we''are''to''study'])target = raw_text[i] # 获取目标词,第一个词为aboutdata.append((context,target)) # 将上下文词和目标词保存到data中,第一组格式为((['we','are''to''study']),'about')调试结果:

2、生成one-hot

def make_context_vector(context,word_to_idx): # 将上下文词转换为one-hotidxs = [word_to_idx[w] for w in context] # 遍历四个词,返回四个词对应的索引,将索引存入列表return torch.tensor(idxs,dtype=torch.long) # 返回创建的一个torch张量,内容为词在词库中对应的索引# 上述函数的示例

print(make_context_vector(data[0][0],word_to_idx)) # 将前后两组单词以及上述定义的字典传入自定义函数,返回其在词库中的索引

运行结果:

3、创建CBOW类

class CBOW(nn.Module): # 定义一个CBOW的类,其继承nn.Module,nn.Module是PyTorch中所有神经网络模块的基类,提供了模型构建所需的基本功能。def __init__(self,vocab_size,embedding_dim): # 初始化super(CBOW,self).__init__()self.embeddings = nn.Embedding(vocab_size,embedding_dim) # vocab_size表示需要训练的词的个数,embedding_dim表示每个单词嵌入的维度大小self.proj = nn.Linear(embedding_dim,128) # 额外增强的全连接层self.output = nn.Linear(128,vocab_size)def forward(self,inputs): # 前向传播,传入数据的索引embeds = sum(self.embeddings(inputs)).view(1,-1) # 将索引传入上述的Embedding词嵌入层进行处理,然后对结果求和,最后调整形状为1,embedding_dim,-1表示根据张量的大小自动计算该位置上的维度out = F.relu(self.proj(embeds)) # 将词嵌入的结果进行线性变换,然后再进行relu激活函数处理,即小于0的变为0,大于0的不变out = self.output(out) # 输出层nll_prob = F.log_softmax(out,dim=-1) # 使用softmax激活函数将原始输出值转换为概率分布的对数形式,dim=-1 指定了对最后一个维度进行计算,return nll_prob4、cuda、优化器

# m模型在cuda训练

device = "cuda" if torch.cuda.is_available() else "mps" if torch.backends.mps.is_available() else "cpu"

print(device)

model = CBOW(vocab_size,10).to(device) # 将词库长度和每个单词嵌入的维度大小传入模型,然后放入GPU进行运算optimizer = optim.Adam(model.parameters(),lr=0.001) # 创建一个Adam优化器,对模型的参数进行优化

# model.parameters()返回模型中所有可训练参数的迭代器,lr表示学习率5、开始训练

losses = [] # 存储损失的集合

loss_function = nn.NLLLoss() # NLLLoss损失函数(当分类列表非常多的情况),将多个类别分别分成0、1两个类别。

for epoch in tqdm(range(200)): # 开始训练,tqdm表示展示一个进度条,200表示循环展示200次total_loss = 0 # 用于储存当前epoch的总损失,每轮将总损失增加到列表for context,target in data: # 遍历元组中的左右四个词,以及中间的一个词context_vecter = make_context_vector(context,word_to_idx).to(device) # 通过遍历将所有的四个词以及词组对应的字典传入函数,返回对应的索引,然后传入GPUtarget = torch.tensor([word_to_idx[target]]).to(device) # 返回中间的词对应的索引,然后转换为torch张量传入GPUtrain_predict = model(context_vecter) # 将每一组数据的四个索引传入模型进行前向传播,model.forward可以不写forward# print(train_predict) # 打印返回的每一个数对应的概率值对数形式loss = loss_function(train_predict,target) # 将上述模型返回的预测结果与真实值传入负对数似然损失函数进行计算得到损失值optimizer.zero_grad() # 梯度清零loss.backward() # 反向传播计算得到每个参数梯度值optimizer.step() # 根据梯度更新网络参数total_loss += loss.item() # 叠加损失值losses.append(total_loss)

print(losses)

运行结果:

6、测试

# 测试

context = ['People','create','to','direct']

context_vector = make_context_vector(context,word_to_idx).to(device)# 预测的值

model.eval() # 进入测试模式

predict = model(context_vector)

max_idx = predict.argmax(1).item() # dim=1表示每一行中的最大值对应的索引号,dim=0表示每一列中最大值对应的索引号

print(f"{','.join(context)}中间的单词为:",idx_to_word[max_idx])运行结果:

![]()

7、获取词向量矩阵

W = model.embeddings.weight.cpu().detach().numpy() # 获取词嵌入层的权重,因为模型在GPU训练,先将其传入CPU,detach()表示分理处张量,然后将其转变为numpy数组类型

print(W) # 打印模型的词嵌入矩阵运行结果:

8、生成词嵌入字典

word_2_vec = {}

for word in word_to_idx.keys():# 词向量矩阵中某个词的索引对应的那一列即为该词的词向量word_2_vec[word] = W[word_to_idx[word],:]

print('结束')9、保存为npz文件

np.savez('word2vec实现.npz',file_1=W)

data = np.load('word2vec实现.npz')

print(data.files)运行结果:

![]()

相关文章:

《深度学习》神经语言模型 Word2vec CBOW项目解析、npy/npz文件解析

目录 一、关于word2vec 1、什么是word2vec 2、常用训练算法 1)CBOW 2)SkipGram 二、关于npy、npz文件 1、npy文件 1)定义 2)特性 3)用途 4)保存及读取 运行结果: 运行结果…...

黄粱一梦,镜花水月总是空

总有人间一两风,埋我十万八千梦 自古以来,梦在我们的生活中一直是一个神秘玄幻而又发人深省的存在,我们一生中有三分之一的时间都在睡觉,做过的梦也是丰富多彩数不胜数。 而从科学的角度来说,梦是我们潜意识里的生活…...

【分布式事务-01】分布式事务之2pc两阶段提交

redis系列整体栏目 内容链接地址【一】分布式事务之2pc两阶段提交https://zhenghuisheng.blog.csdn.net/article/details/142406325 分布式事务之2pc两阶段提交 一,分布式事务之2pc两阶段提交1,两阶段提交(2pc)2,2pc两阶段提交实现思路3&…...

docker 安装 rabbitMQ

第一步:准备工作 # 打开docker目录 [rootMuYu ~]# cd /usr/local/docker/ # 创建rabbitmq文件夹 [rootMuYu docker]# mkdir rabbitmq # 打开rabbitmq文件夹 [rootMuYu docker]# cd rabbitmq/ # 创建挂载目录 [rootMuYu rabbitmq]# mkdir data 第二步ÿ…...

知识改变命运 数据结构【java对象的比较】

0:前言 在基本数据类型中,我们可以直接使用号比较是否相等,还记的学堆哪里时候,插入一个数据,就会与其他数据进行比较,当时我们传入的是Integer类型,在Integer类里面已经实现了compare。 如果…...

01_23 种设计模式之《简单工厂模式》

文章目录 一、什么是设计模式二、设计模式类型简单工厂模式及应用场景定义抽象产品类和具体产品类实现工厂类客户端代码注意事项 一、什么是设计模式 设计模式:在软件研发过程中,经过实战验证,用于解决在特定环境下、重复出现的,…...

Android 12.0 关于定制自适应AdaptiveIconDrawable类型的动态日历图标的功能实现系列一

1.前言 在12.0的系统rom定制化开发中,在关于定制动态日历图标中,原系统是不支持动态日历图标的功能,所以就需要从新 定制动态时钟图标关于自适应AdaptiveIconDrawable类型的样式,就是可以支持当改变系统图标样式变化时,动态日历 图标的背景图形也跟着改变,所以接下来就来…...

【源码+文档+调试讲解】基于安卓的小餐桌管理系统springboot框架

摘 要 相比于以前的传统手工管理方式,智能化的管理方式可以大幅降低运营人员成本,实现了小餐桌的标准化、制度化、程序化的管理,有效地防止了小餐桌的随意管理,提高了信息的处理速度和精确度,能够及时、准确地查询和修…...

C语言中的文件操作(二)

C语言中的文件操作(一)-CSDN博客https://blog.csdn.net/Xiaodao12345djs/article/details/142746010?spm1001.2014.3001.5501 四、文件的顺序读写 1、fputc (字符输出函数/写) 将一个字符写入文件中 #include <stdio.h>int main() {FILE* pf fo…...

【C++篇】继承之韵:解构编程奥义,领略面向对象的至高法则

文章目录 C 继承详解:初阶理解与实战应用前言第一章:继承的基本概念与定义1.1 继承的概念1.2 继承的定义 第二章:继承中的访问权限2.1 基类成员在派生类中的访问权限2.2 基类与派生类对象的赋值转换2.2.1 派生类对象赋值给基类对象2.2.2 基类…...

Ubuntu 22.04 安装 KVM

首先检查是否支持 CPU 虚拟化,现在的 CPU 都应该支持,运行下面的命令,大于0 就是支持。 egrep -c (vmx|svm) /proc/cpuinfo安装 Libvirt apt install -y qemu-kvm virt-manager libvirt-daemon-system virtinst libvirt-clients bridge-uti…...

101 公司战略的基本概念

公司战略的概念 传统概念(战略是终点途径):计划性、全局性、长期性现代概念(战略是途径):应变性、竞争性、风险性综合概念(前二者的折中):预先性、反应性公司的使命与目标…...

【devops】devops-ansible之剧本初出茅庐--搭建rsync和nfs

本站以分享各种运维经验和运维所需要的技能为主 《python零基础入门》:python零基础入门学习 《python运维脚本》: python运维脚本实践 《shell》:shell学习 《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战 《k8》从问题中去学习k8s 《docker学习》暂未更…...

@RestController 和 @Controller 注解的联系及要点

1. RestController • RestController 是 Spring 4.0 引入的一个注解,它相当于 Controller ResponseBody组合注解。 主要作用:主要用于构建 RESTful Web 服务。标注 RestController 的类里的所有方法,返回的都是 JSON 或 XML 等格式的数据…...

机器学习篇-day03-线性回归-正规方程与梯度下降-模型评估-正则化解决模型拟合问题

一. 线性回归简介 定义 线性回归(Linear regression)是利用 回归方程(函数) 对 一个或多个自变量(特征值)和因变量(目标值)之间 关系进行建模的一种分析方式。 回归方程(函数) 一元线性回归: y kx b > wx b k: 斜率, 在机器学习中叫 权重(weight), 简称: w b: 截距, 在机…...

图像人脸与视频人脸匹配度检测

import cv2 import dlib import numpy as np import os from pathlib import Path# 加载预训练模型 face_recognition_model "dlib_face_recognition_resnet_model_v1.dat" face_recognition_net dlib.face_recognition_model_v1(face_recognition_model)detector …...

【AI绘画】Midjourney进阶:对称构图详解

博客主页: [小ᶻZ࿆] 本文专栏: AI绘画 | Midjourney 文章目录 💯前言💯什么是构图为什么Midjourney要使用构图 💯对称构图特点使用场景提示词书写技巧测试 💯小结 💯前言 通常来学习AI绘画的人可以分为…...

道路积水检测数据集 1450张 路面积水 带分割 voc yolo

道路积水检测数据集 1450张 路面积水 带分割 voc yolo 分类名: (图片张数, 标注个数) puddle:(1468,1994) 总数:(1468,1994) 总类(nc): 1类 道路积水检测数据集介绍 项目名称 道路积水检测数据集 项目概述 本数据集包含1450张带有标注的图像&#x…...

上门安装维修系统小程序开发详解及源码示例

随着智能家居和设备的普及,消费者对上门安装和维修服务的需求日益增加。为了满足这一市场需求,开发一款上门安装维修系统小程序成为了一种有效的解决方案。本文将详细介绍上门安装维修系统小程序的开发过程,并提供一个简单的源码示例…...

03_23 种设计模式之《原型模式》

文章目录 一、原型模式基础知识原型模式的结构应用场景 实例拷贝构造函数被调用场景如下:典型的应用场景: 一、原型模式基础知识 原型模式是一种创建型设计模式,其功能为复制一个运行时的对象,包括对象各个成员当前的值。而代码又…...

VB.net复制Ntag213卡写入UID

本示例使用的发卡器:https://item.taobao.com/item.htm?ftt&id615391857885 一、读取旧Ntag卡的UID和数据 Private Sub Button15_Click(sender As Object, e As EventArgs) Handles Button15.Click轻松读卡技术支持:网站:Dim i, j As IntegerDim cardidhex, …...

Go 语言接口详解

Go 语言接口详解 核心概念 接口定义 在 Go 语言中,接口是一种抽象类型,它定义了一组方法的集合: // 定义接口 type Shape interface {Area() float64Perimeter() float64 } 接口实现 Go 接口的实现是隐式的: // 矩形结构体…...

[10-3]软件I2C读写MPU6050 江协科技学习笔记(16个知识点)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16...

微服务商城-商品微服务

数据表 CREATE TABLE product (id bigint(20) UNSIGNED NOT NULL AUTO_INCREMENT COMMENT 商品id,cateid smallint(6) UNSIGNED NOT NULL DEFAULT 0 COMMENT 类别Id,name varchar(100) NOT NULL DEFAULT COMMENT 商品名称,subtitle varchar(200) NOT NULL DEFAULT COMMENT 商…...

Map相关知识

数据结构 二叉树 二叉树,顾名思义,每个节点最多有两个“叉”,也就是两个子节点,分别是左子 节点和右子节点。不过,二叉树并不要求每个节点都有两个子节点,有的节点只 有左子节点,有的节点只有…...

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。 尽管 VLMs 取得了显著进展,机器人仍难以胜任复杂的长时程任务(如家具装配),主要受限于人…...

腾讯云V3签名

想要接入腾讯云的Api,必然先按其文档计算出所要求的签名。 之前也调用过腾讯云的接口,但总是卡在签名这一步,最后放弃选择SDK,这次终于自己代码实现。 可能腾讯云翻新了接口文档,现在阅读起来,清晰了很多&…...

【C++进阶篇】智能指针

C内存管理终极指南:智能指针从入门到源码剖析 一. 智能指针1.1 auto_ptr1.2 unique_ptr1.3 shared_ptr1.4 make_shared 二. 原理三. shared_ptr循环引用问题三. 线程安全问题四. 内存泄漏4.1 什么是内存泄漏4.2 危害4.3 避免内存泄漏 五. 最后 一. 智能指针 智能指…...

Git 3天2K星标:Datawhale 的 Happy-LLM 项目介绍(附教程)

引言 在人工智能飞速发展的今天,大语言模型(Large Language Models, LLMs)已成为技术领域的焦点。从智能写作到代码生成,LLM 的应用场景不断扩展,深刻改变了我们的工作和生活方式。然而,理解这些模型的内部…...

Chrome 浏览器前端与客户端双向通信实战

Chrome 前端(即页面 JS / Web UI)与客户端(C 后端)的交互机制,是 Chromium 架构中非常核心的一环。下面我将按常见场景,从通道、流程、技术栈几个角度做一套完整的分析,特别适合你这种在分析和改…...