Hadoop生态圈框架部署(四)- Hadoop完全分布式部署

文章目录

- 前言

- 一、Hadoop完全分布式部署(手动部署)

- 1. 下载hadoop

- 2. 上传安装包

- 2. 解压hadoop安装包

- 3. 配置hadoop配置文件

- 3.1 虚拟机hadoop1修改hadoop配置文件

- 3.1.1 修改 hadoop-env.sh 配置文件

- 3.3.2 修改 core-site.xml 配置文件

- 3.3.3 修改 hdfs-site.xml 配置文件

- 3.3.4 修改 mapred-site.xml 配置文件

- 3.3.5 修改 yarn-site.xml 配置文件

- 3.3.6 修改 workers 配置文件

- 3.2 虚拟机hadoop2安装并配置hadoop

- 3.3 虚拟机hadoop3安装并配置hadoop

- 4. 配置hadoop环境变量

- 4.1 配置虚拟机hadoop1的hadoop环境变量

- 4.2 配置虚拟机hadoop2的hadoop环境变量

- 4.3 配置虚拟机hadoop3的hadoop环境变量

- 5. 格式化HDFS(Hadoop分布式文件系统)

- 6. hadoop集群启动和停止

- 6.1 启动 hadoop 集群

- 6.2 停止 hadoop 集群

- 二、使用shell脚本自动部署Hadoop完全分布式(选看)

- 1. 下载hadoop

- 2. 上传安装包

- 3. 使用shell脚本自动部署Hadoop完全分布式

- 3.1 创建 hadoop1_hadoop_install_config.sh 脚本文件并添加脚本内容

- 3.2 添加可执行权限

- 3.3 执行脚本

- 4. 加载环境变量

- 5. hadoop集群启动和停止

- 5.1 启动 hadoop 集群

- 5.2 停止 hadoop 集群

前言

- 介绍在虚拟机hadoop1、hadoop2和hadoop3部署完全分布式Hadoop

- 部署规划:

hadoop1 hadoop2 hadoop3 HDFS NameNode SecondaryNameNode

DataNodeDataNode YARN ResourceManager NodeManager NodeManager - 配置hadoop配置文件

- 配置hadoop环境变量

- 访问hadoop对应Web UI

- 提供shell脚本自动化安装hadoop完全分布式

一、Hadoop完全分布式部署(手动部署)

1. 下载hadoop

点击下载hadoop3.3.0安装包:https://archive.apache.org/dist/hadoop/common/hadoop-3.3.0/hadoop-3.3.0.tar.gz

2. 上传安装包

通过拖移的方式将下载的hadoop安装包hadoop-3.3.0.tar.gz上传至虚拟机hadoop1的/export/software目录。

2. 解压hadoop安装包

在虚拟机Hadoop1上传完成后将hadoop安装包通过解压方式安装至/export/servers目录。

tar -zxvf /export/software/hadoop-3.3.0.tar.gz -C /export/servers/

解压完成如下图所示。

3. 配置hadoop配置文件

3.1 虚拟机hadoop1修改hadoop配置文件

3.1.1 修改 hadoop-env.sh 配置文件

在虚拟机Hadoop1修改hadoop运行时环境变量配置文件/export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh,使用echo命令向hadoop-env.sh文件追加如下内容。

echo >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export JAVA_HOME=/export/servers/jdk1.8.0_421' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export HDFS_NAMENODE_USER=root' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export HDFS_DATANODE_USER=root' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export HDFS_SECONDARYNAMENODE_USER=root' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export YARN_RESOURCEMANAGER_USER=root' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

echo 'export YARN_NODEMANAGER_USER=root' >> /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

查看文件内容是否添加成功。

cat /export/servers/hadoop-3.3.0/etc/hadoop/hadoop-env.sh

3.3.2 修改 core-site.xml 配置文件

在虚拟机Hadoop1修改hadoop核心配置文件/export/servers/hadoop-3.3.0/etc/hadoop/core-site.xml,使用echo命令把配置内容重定向并写入到 /export/servers/hadoop-3.3.0/etc/hadoop/core-site.xml 文件。

echo \

'<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 指定Hadoop集群的默认文件系统名称 --><property><name>fs.defaultFS</name><value>hdfs://hadoop1:9000</value></property><!-- 设置Hadoop临时目录的位置,用于存储各种临时文件 --><property><name>hadoop.tmp.dir</name><value>/export/data/hadoop-3.3.0</value></property><!-- 当通过Web界面访问Hadoop集群时,默认的用户名 --><property><name>hadoop.http.staticuser.user</name><value>root</value></property><!-- 允许哪些主机上的用户可以作为代理用户执行操作 --><property><name>hadoop.proxyuser.root.hosts</name><value>*</value> <!-- * 表示任何主机 --></property><!-- 定义哪个组的用户可以作为代理用户执行操作 --><property><name>hadoop.proxyuser.root.groups</name><value>*</value> <!-- * 表示所有组的用户 --></property><!-- 设置回收站功能的保留时间间隔,单位为分钟 --><property><name>fs.trash.interval</name><value>1440</value> <!-- 1440分钟等于1天 --></property>

</configuration>'\

> /export/servers/hadoop-3.3.0/etc/hadoop/core-site.xml

3.3.3 修改 hdfs-site.xml 配置文件

在虚拟机Hadoop1修改hdfs的配置文件/export/servers/hadoop-3.3.0/etc/hadoop/hdfs-site.xml,使用cat命令把配置内容重定向并写入到 /export/servers/hadoop-3.3.0/etc/hadoop/hdfs-site.xml 文件。

cat >/export/servers/hadoop-3.3.0/etc/hadoop/hdfs-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration>

<property><name>dfs.replication</name><value>2</value>

</property>

<property><name>dfs.namenode.secondary.http-address</name><value>hadoop2:9868</value>

</property>

</configuration>

EOF

3.3.4 修改 mapred-site.xml 配置文件

在虚拟机Hadoop1修改mapreduce的配置文件/export/servers/hadoop-3.3.0/etc/hadoop/mapred-site.xml,使用cat命令把配置内容重定向并写入到 /export/servers/hadoop-3.3.0/etc/hadoop/mapred-site.xml 文件。

cat >/export/servers/hadoop-3.3.0/etc/hadoop/mapred-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration>

<property><name>mapreduce.framework.name</name><value>yarn</value>

</property>

<property><name>mapreduce.jobhistory.address</name><value>hadoop1:10020</value>

</property>

<property><name>mapreduce.jobhistory.Webapp.address</name><value>hadoop1:19888</value>

</property>

<property><name>yarn.app.mapreduce.am.env</name><value>HADOOP_MAPRED_HOME=/export/servers/hadoop-3.3.0</value>

</property>

<property><name>mapreduce.map.env</name><value>HADOOP_MAPRED_HOME=/export/servers/hadoop-3.3.0</value>

</property>

<property><name>mapreduce.reduce.env</name><value>HADOOP_MAPRED_HOME=/export/servers/hadoop-3.3.0</value>

</property>

</configuration>

EOF

3.3.5 修改 yarn-site.xml 配置文件

在虚拟机Hadoop1修改yarn的配置文件/export/servers/hadoop-3.3.0/etc/hadoop/yarn-site.xml,使用cat命令把配置内容重定向并写入到 /export/servers/hadoop-3.3.0/etc/hadoop/yarn-site.xml 文件。

cat >/export/servers/hadoop-3.3.0/etc/hadoop/yarn-site.xml <<EOF

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration>

<property><name>yarn.resourcemanager.hostname</name><value>hadoop1</value>

</property>

<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value>

</property>

<property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value>

</property>

<property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value>

</property>

<property><name>yarn.log-aggregation-enable</name><value>true</value>

</property>

<property><name>yarn.log.server.url</name><value>http://hadoop1:19888/jobhistory/logs</value>

</property>

<property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value>

</property>

</configuration>

EOF

3.3.6 修改 workers 配置文件

在虚拟机Hadoop1修改hadoop的从节点服务器配置文件/export/servers/hadoop-3.3.0/etc/hadoop/workers,使用cat命令把配置内容重定向并写入到 /export/servers/hadoop-3.3.0/etc/hadoop/workers 文件。

cat >/export/servers/hadoop-3.3.0/etc/hadoop/workers <<EOF

hadoop2

hadoop3

EOF

3.2 虚拟机hadoop2安装并配置hadoop

在虚拟机hadoop1使用scp命令把虚拟机hadoop1的hadoop的安装目录复制到虚拟机hadoop2的相同目录下,就相当于在hadoop2安装并配置了hadoop。

scp -r /export/servers/hadoop-3.3.0/ hadoop2:/export/servers/

3.3 虚拟机hadoop3安装并配置hadoop

在虚拟机hadoop1使用scp命令把虚拟机hadoop1的hadoop的安装目录复制到虚拟机hadoop3的相同目录下,就相当于在hadoop3安装并配置了hadoop。

scp -r /export/servers/hadoop-3.3.0/ hadoop3:/export/servers/

4. 配置hadoop环境变量

4.1 配置虚拟机hadoop1的hadoop环境变量

在虚拟机hadoop1使用echo命令向环境变量配置文件/etc/profile追加环境变量内容。

echo >> /etc/profile

echo 'export HADOOP_HOME=/export/servers/hadoop-3.3.0' >> /etc/profile

echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile

配置环境变量后,需要使用如下命令加载环境变量配置文件/etc/profile,使用hadoop的环境变量生效。

source /etc/profile

4.2 配置虚拟机hadoop2的hadoop环境变量

在虚拟机hadoop2使用echo命令向环境变量配置文件/etc/profile追加环境变量内容。

echo >> /etc/profile

echo 'export HADOOP_HOME=/export/servers/hadoop-3.3.0' >> /etc/profile

echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile

配置环境变量后,需要使用如下命令加载环境变量配置文件/etc/profile,使用hadoop的环境变量生效。

source /etc/profile

4.3 配置虚拟机hadoop3的hadoop环境变量

在虚拟机hadoop3使用echo命令向环境变量配置文件/etc/profile追加环境变量内容。

echo >> /etc/profile

echo 'export HADOOP_HOME=/export/servers/hadoop-3.3.0' >> /etc/profile

echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile

配置环境变量后,需要使用如下命令加载环境变量配置文件/etc/profile,使用hadoop的环境变量生效。

source /etc/profile

5. 格式化HDFS(Hadoop分布式文件系统)

在虚拟机hadoop1执行如下命令格式化Hadoop分布式文件系统HDFS。

hdfs namenode -format

注意:如果在格式化过程中遇到如下提示,输入

n并按回车键,然后依次在虚拟机hadoop1、hadoop2和hadoop3执行rm -rf /export/data/hadoop-3.3.0删除之前生成的数据保存目录,再在虚拟机hadoop1执行hdfs namenode -format重新格式化文件系统。

格式化成功如下图所示,会提示我们存储目录 /export/data/hadoop-3.3.0/dfs/name 已经成功格式化。

6. hadoop集群启动和停止

6.1 启动 hadoop 集群

方法一:在虚拟机Hadoop1执行如下命令同时启动 hdfs 和 yarn。

start-all.sh

注意:命令的全路径启动为

/export/servers/hadoop-3.3.0/sbin/start-all.sh,之所以可以使用start-all.sh直接启动是因为我们设置了环境变量。

方法二:在虚拟机Hadoop1单独启动 hdfs 和单独启动 yarn。

单独启动 hdfs

start-dfs.sh

单独启动 yarn

start-yarn.sh

hadoop集群启动之后使用如下命名分别在虚拟机hadoop1、虚拟机hadoop2和虚拟机hadoop3执行如下命令查看对应进程是否正常。

jps -l正常如下图所示。

访问 HDFS(NameNode)的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.160:9870进行访问,如下图。

检查DataNode是否正常,正常如下图所示。

访问 HDFS(Secondary NameNode)的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.161:9868进行访问,如下图。

访问 YARN 的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.160:8088进行访问,如下图。

6.2 停止 hadoop 集群

方法一:如果需要停止 hadoop 集群运行,在虚拟机hadoop1执行如下命令同时停止 hdfs 和 yarn。

stop-all.sh

方法二:如果需要停止 hadoop 集群运行,在虚拟机hadoop1单独启动 hdfs 和单独启动 yarn。

单独启动 hdfs

stop-dfs.sh

单独启动 yarn

stop-yarn.sh

二、使用shell脚本自动部署Hadoop完全分布式(选看)

1. 下载hadoop

点击下载hadoop3.3.0安装包:https://archive.apache.org/dist/hadoop/common/hadoop-3.3.0/hadoop-3.3.0.tar.gz

2. 上传安装包

通过拖移的方式将下载的hadoop安装包hadoop-3.3.0.tar.gz上传至虚拟机hadoop1的/export/software目录。

3. 使用shell脚本自动部署Hadoop完全分布式

3.1 创建 hadoop1_hadoop_install_config.sh 脚本文件并添加脚本内容

在虚拟机hadoop1上创建/export/shell/hadoop1_hadoop_install_config.sh脚本文件

touch /export/shell/hadoop1_hadoop_install_config.sh

添加如下内容:

#!/bin/bash# 定义常量

HADOOP_DIR="/export/servers"

HADOOP_VER="3.3.0"

HADOOP_TAR="hadoop-${HADOOP_VER}.tar.gz"

HADOOP_SOFTWARE_DIR="/export/software"

JAVA_PATH="/export/servers/jdk1.8.0_421"

HADOOP_TMP_DIR="/export/data/hadoop-${HADOOP_VER}"

DATA_DIR="/export/data"

SOFTWARE_DIR="/export/software"

SERVERS_DIR="/export/servers"cat > /etc/profile << EOF

# /etc/profile# System wide environment and startup programs, for login setup

# Functions and aliases go in /etc/bashrc# It's NOT a good idea to change this file unless you know what you

# are doing. It's much better to create a custom.sh shell script in

# /etc/profile.d/ to make custom changes to your environment, as this

# will prevent the need for merging in future updates.pathmunge () {case ":\${PATH}:" in*:"\$1":*);;*)if [ "\$2" = "after" ] ; thenPATH=\$PATH:\$1elsePATH=\$1:\$PATHfiesac

}if [ -x /usr/bin/id ]; thenif [ -z "\$EUID" ]; then# ksh workaroundEUID=`/usr/bin/id -u`UID=`/usr/bin/id -ru`fiUSER="`/usr/bin/id -un`"LOGNAME=\$USERMAIL="/var/spool/mail/\$USER"

fi# Path manipulation

if [ "\$EUID" = "0" ]; thenpathmunge /usr/sbinpathmunge /usr/local/sbin

elsepathmunge /usr/local/sbin afterpathmunge /usr/sbin after

fiHOSTNAME=`/usr/bin/hostname 2>/dev/null`

HISTSIZE=1000

if [ "\$HISTCONTROL" = "ignorespace" ] ; thenexport HISTCONTROL=ignoreboth

elseexport HISTCONTROL=ignoredups

fiexport PATH USER LOGNAME MAIL HOSTNAME HISTSIZE HISTCONTROL# By default, we want umask to get set. This sets it for login shell

# Current threshold for system reserved uid/gids is 200

# You could check uidgid reservation validity in

# /usr/share/doc/setup-*/uidgid file

if [ \$UID -gt 199 ] && [ "`/usr/bin/id -gn`" = "`/usr/bin/id -un`" ]; thenumask 002

elseumask 022

fifor i in /etc/profile.d/*.sh /etc/profile.d/sh.local ; doif [ -r "\$i" ]; thenif [ "\${-#*i}" != "\$-" ]; then. "\$i"else. "\$i" >/dev/nullfifi

doneunset i

unset -f pathmungeexport JAVA_HOME=/export/servers/jdk1.8.0_421

export PATH=\$PATH:\$JAVA_HOME/binexport HADOOP_HOME=/export/servers/hadoop-3.3.0

export PATH=\$PATH:\$HADOOP_HOME/bin:\$HADOOP_HOME/sbin

EOF

echo "HADOOP_HOME 设置成功"# 分发到hadoop2

scp /etc/profile root@hadoop2:/etc/

if [ $? -eq 0 ]; thenecho "分发 /etc/profile 到 hadoop2 的 /etc 目录成功"

elseecho "分发 /etc/profile 到 hadoop2 的 /etc 目录失败,请检查"exit 1

fi# 分发到hadoop3

scp /etc/profile root@hadoop3:/etc/

if [ $? -eq 0 ]; thenecho "分发 /etc/profile 到 hadoop3 的 /etc 目录成功"

elseecho "分发 /etc/profile 到 hadoop3 的 /etc 目录失败,请检查"exit 1

fi# 如果临时数据目录存在则删除

if [ -d "${HADOOP_TMP_DIR}" ]; thenecho "删除自动生成的临时数据目录 ${HADOOP_TMP_DIR}..."rm -rf ${HADOOP_TMP_DIR}

fissh root@hadoop2 \

"

if [ -d \"${HADOOP_TMP_DIR}\" ]; thenecho \"删除 hadoop2 自动生成的临时数据目录 ${HADOOP_TMP_DIR}...\"rm -rf ${HADOOP_TMP_DIR}

fi

exit

"ssh root@hadoop3 \

"

if [ -d \"${HADOOP_TMP_DIR}\" ]; thenecho \"删除 hadoop3 自动生成的临时数据目录 ${HADOOP_TMP_DIR}...\"rm -rf ${HADOOP_TMP_DIR}

fi

exit

"# 检查hadoop是否已解压

if [ -d "$HADOOP_DIR/hadoop-$HADOOP_VER" ]; thenecho "hadoop安装程序已存在,正在删除原安装程序目录..."rm -rf "$HADOOP_DIR/hadoop-$HADOOP_VER"

fi# 检查hadoop安装包是否存在

if [ -f $SOFTWARE_DIR/$HADOOP_TAR ]; thenecho "hadoop安装包存在,正在解压安装包..."# 解压Hadoop安装包tar -zxvf ${HADOOP_SOFTWARE_DIR}/${HADOOP_TAR} -C ${HADOOP_DIR}echo "解压 ${HADOOP_SOFTWARE_DIR}/${HADOOP_TAR} 到 ${HADOOP_DIR} 目录成功"

elseecho "hadoop安装包不存在,请先上传安装包到 ${HADOOP_SOFTWARE_DIR} 目录"exit 1

fi# 配置hadoop-env.sh

echo >>${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/hadoop-env.sh

echo \"

export JAVA_HOME=/export/servers/jdk1.8.0_421

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

" \>>${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/hadoop-env.sh

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/hadoop-env.sh 配置文件修改成功"# 配置core-site.xml

cat >${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/core-site.xml <<EOF

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>fs.defaultFS</name><value>hdfs://hadoop1:9000</value></property><property><name>hadoop.tmp.dir</name><value>${HADOOP_TMP_DIR}</value></property><property><name>hadoop.http.staticuser.user</name><value>root</value></property><property><name>hadoop.proxyuser.root.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.root.groups</name><value>*</value></property><property><name>fs.trash.interval</name><value>1440</value></property>

</configuration>

EOF

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/core-site.xml 配置文件修改成功"# 配置hdfs-site.xml

cat >${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/hdfs-site.xml <<EOF

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>dfs.replication</name><value>2</value></property><property><name>dfs.namenode.secondary.http-address</name><value>hadoop2:9868</value></property>

</configuration>

EOF

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/hdfs-site.xml 配置文件修改成功"# 配置mapred-site.xml

cat >${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/mapred-site.xml <<EOF

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>mapreduce.framework.name</name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>hadoop1:10020</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>hadoop1:19888</value></property><property><name>yarn.app.mapreduce.am.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_DIR}/hadoop-${HADOOP_VER}</value></property><property><name>mapreduce.map.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_DIR}/hadoop-${HADOOP_VER}</value></property><property><name>mapreduce.reduce.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_DIR}/hadoop-${HADOOP_VER}</value></property>

</configuration>

EOF

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/mapred-site.xml 配置文件修改成功"# 配置yarn-site.xml

cat >${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/yarn-site.xml <<EOF

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration><property><name>yarn.resourcemanager.hostname</name><value>hadoop1</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value></property><property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value></property><property><name>yarn.log-aggregation-enable</name><value>true</value></property><property><name>yarn.log.server.url</name><value>http://hadoop1:19888/jobhistory/logs</value></property><property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value></property>

</configuration>

EOF

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/yarn-site.xml 配置文件修改成功"# 设置workers文件

echo -e "hadoop2\nhadoop3" >${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/workers

echo "${HADOOP_DIR}/hadoop-${HADOOP_VER}/etc/hadoop/workers 配置文件修改成功"# 分发到hadoop2

scp -r ${HADOOP_DIR}/hadoop-${HADOOP_VER} root@hadoop2:${HADOOP_DIR}/

if [ $? -eq 0 ]; thenecho "分发 ${HADOOP_DIR}/hadoop-${HADOOP_VER} 到 hadoop2 的 ${HADOOP_DIR} 目录成功"

elseecho "分发 ${HADOOP_DIR}/hadoop-${HADOOP_VER} 到 hadoop2 的 ${HADOOP_DIR} 目录失败,请检查"exit 1

fi# 分发到hadoop3

scp -r ${HADOOP_DIR}/hadoop-${HADOOP_VER} root@hadoop3:${HADOOP_DIR}/

if [ $? -eq 0 ]; thenecho "分发 ${HADOOP_DIR}/hadoop-${HADOOP_VER} 到 hadoop3 的 ${HADOOP_DIR} 目录成功"

elseecho "分发 ${HADOOP_DIR}/hadoop-${HADOOP_VER} 到 hadoop3 的 ${HADOOP_DIR} 目录失败,请检查"exit 1

fi# 设置临时环境变量

export HADOOP_HOME=${HADOOP_DIR}/hadoop-${HADOOP_VER}

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

echo "设置hadoop临时环境变量为: \$HADOOP_HOME = ${HADOOP_HOME}"# 格式化HDFS

echo "正在格式化HDFS..."

hdfs namenode -format

if [ $? -eq 0 ]; thenecho "格式化HDFS成功"

elseecho "格式化HDFS失败,请检查异常并解决后重新执行此脚本"exit 1

fiecho -e "\n-----hadoop完全分布式安装配置完成-----\n"

echo -e "1. 请手动在hadoop1、hadoop2和hadoop3执行命令 source /etc/profile 加载环境变量\n"

echo "3. 启动hadoop命令:start-all.sh, 停止hadoop命令:stop-all.sh"exit 0

3.2 添加可执行权限

在虚拟机hadoop1上给脚本文件/export/shell/hadoop1_hadoop_install_config.sh添加可执行权限。

chmod +x /export/shell/hadoop1_hadoop_install_config.sh

3.3 执行脚本

在虚拟机hadoop1上执行脚本文件自动化安装配置hadoop完全分布式。

/export/shell/hadoop1_hadoop_install_config.sh

4. 加载环境变量

根据使用shell脚本自动安装完成后的提示依次在虚拟机hadoop1、hadoop2和hadoop3执行如下命令。

source /etc/profile

5. hadoop集群启动和停止

5.1 启动 hadoop 集群

方法一:在虚拟机Hadoop1执行如下命令同时启动 hdfs 和 yarn。

start-all.sh

注意:命令的全路径启动为

/export/servers/hadoop-3.3.0/sbin/start-all.sh,之所以可以使用start-all.sh直接启动是因为我们设置了环境变量。

方法二:在虚拟机Hadoop1单独启动 hdfs 和单独启动 yarn。

单独启动 hdfs

start-dfs.sh

单独启动 yarn

start-yarn.sh

hadoop集群启动之后使用如下命名分别在虚拟机hadoop1、虚拟机hadoop2和虚拟机hadoop3执行如下命令查看对应进程是否正常。

jps -l正常如下图所示。

访问 HDFS(NameNode)的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.160:9870进行访问,如下图。

检查DataNode是否正常,正常如下图所示。

访问 HDFS(Secondary NameNode)的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.161:9868进行访问,如下图。

访问 YARN 的 Web UI 页面

在启动hadoop集群后,在浏览器输入http://192.168.121.160:8088进行访问,如下图。

5.2 停止 hadoop 集群

方法一:如果需要停止 hadoop 集群运行,在虚拟机hadoop1执行如下命令同时停止 hdfs 和 yarn。

stop-all.sh

方法二:如果需要停止 hadoop 集群运行,在虚拟机hadoop1单独启动 hdfs 和单独启动 yarn。

单独启动 hdfs

stop-dfs.sh

单独启动 yarn

stop-yarn.sh

相关文章:

Hadoop生态圈框架部署(四)- Hadoop完全分布式部署

文章目录 前言一、Hadoop完全分布式部署(手动部署)1. 下载hadoop2. 上传安装包2. 解压hadoop安装包3. 配置hadoop配置文件3.1 虚拟机hadoop1修改hadoop配置文件3.1.1 修改 hadoop-env.sh 配置文件3.3.2 修改 core-site.xml 配置文件3.3.3 修改 hdfs-site…...

Spring Boot 与 Vue 共铸卓越采购管理新平台

作者介绍:✌️大厂全栈码农|毕设实战开发,专注于大学生项目实战开发、讲解和毕业答疑辅导。 🍅获取源码联系方式请查看文末🍅 推荐订阅精彩专栏 👇🏻 避免错过下次更新 Springboot项目精选实战案例 更多项目…...

leetcode3. Longest Substring Without Repeating Characters

Given a string s, find the length of the longest substring without repeating characters. Example 1: Input: s “abcabcbb” Output: 3 Explanation: The answer is “abc”, with the length of 3. Example 2: Input: s “bbbbb” Output: 1 Explanation: The ans…...

Mongodb使用视图连接两个集合

您可以使用 $lookup 为两个集合创建一个视图,然后对该视图运行查询。应用程序可以查询视图,而无需构建或维护复杂的管道。 例子 创建两个样本集合 inventory 和 orders: db.inventory.insertMany( [{ prodId: 100, price: 20, quantity: 1…...

SIP是什么?

SIP(Session Initiation Protocol,会话启动协议)是一个用于建立、更改和终止多媒体会话的应用层控制协议,其中的会话可以是IP电话、多媒体会话或多媒体会议。 SIP是IETF多媒体数据和控制体系结构的核心协议(最新RFC文档…...

Day 39 || 01背包、416. 分割等和子集

01背包 题目链接:卡码网第46题 二维解题思路:需要建立一个i行k列的dp数组,i表示每个物品,k代表容量,初始化数组子一列为0,第一行从背包开始能够放入起始为价值,其他都为0。for双循环先背包后物…...

调用detr-resnet-50进行目标检测

from transformers import DetrImageProcessor, DetrForObjectDetection import torch from PIL import Imageimage = Image.open("1.jpg") torch.set_default_device("cuda"...

Chromium 中chrome.fontSettings扩展接口定义c++

一、chrome.fontSettings 使用 chrome.fontSettings API 管理 Chrome 的字体设置。 权限 fontSettings 要使用 Font Settings API,您必须在扩展程序中声明 "fontSettings" 权限 清单。例如: {"name": "My Font Settings E…...

在Unity游戏开发在面试时会面试哪些内容?

1、请描述游戏动画有几种,以及其原理。 关键帧动画:每一帧动画序列当中包含了顶点的空间位置信息以及改变量,然后通过插值运算,得出动画效果。选中某一游戏对象,创建animation,添加属性Transform࿰…...

刘艳兵-DBA022-以下关于Oracle半连接的描述,哪些是正确的?

以下关于Oracle半连接的描述,哪些是正确的? A SQL中的NOT EXISTS子查询,通常会被转换为对应的半连接。 B SQL中的IN子查询,通常会被转换为对应的半连接。 C 半连接会去重 D SQL中的EXISTS子查询,通常会被转…...

人工智能与伦理:我们应该如何平衡科技与人性?

内容概要 在这个瞬息万变的时代,人工智能的迅猛发展让我们面对前所未有的伦理困境。科技进步带来了便利,但同时也亟需我们反思如何对待人性。尤其是在实现算法透明性时,我们要确保每一个决策背后都能被理解与追溯,这不仅是对技术…...

CRON组件一个复杂的一个简单的

CRON组件一个复杂的一个简单的 一个是复杂点的一个是简单点。 1.以简单的为例使用: 父组件 import CronSimple from "/views/xxx/components/cron-simple/index.vue";components: {CronSimple}<el-dialog title"调度CRON"v-if"cronV…...

自定义日志打成jar包引入项目后不生效

背景:写了一个请求响应日志包,打包后在另一个项目使用pom引入后不生效 package com.example.qqllog.aspect;import org.springframework.boot.autoconfigure.condition.ConditionalOnMissingBean; import org.springframework.context.annotation.Bean;…...

RK3568平台开发系列讲解(中断篇)延迟工作实验

🚀返回专栏总目录 文章目录 一、什么是延迟工作二、 struct delayed_work三、延迟工作相关接口函数3.1、初始化延迟工作函数3.2、调度/取消调度 延迟工作函数四、驱动程序编写沉淀、分享、成长,让自己和他人都能有所收获!😄 一、什么是延迟工作 延迟工作是一种将工作的执…...

RabbitMQ 的集群

大家好,我是锋哥。今天分享关于【RabbitMQ 的集群】面试题?希望对大家有帮助; RabbitMQ 的集群 RabbitMQ 是一种流行的开源消息代理,广泛用于构建分布式系统中的消息队列。随着应用程序规模的扩大,单一的 RabbitMQ 实…...

整车功能架构 --- 智能座舱

我是穿拖鞋的汉子,魔都中坚持长期主义的汽车电子工程师。 老规矩,分享一段喜欢的文字,避免自己成为高知识低文化的工程师: 所有人的看法和评价都是暂时的,只有自己的经历是伴随一生的,几乎所有的担忧和畏惧…...

java stream流的使用

Java中的Stream API是Java 8引入的一个重要特性,它提供了对集合对象进行各种非常便利、高效的聚合操作(aggregate operation)或大批量数据操作(bulk data operation)。Stream API借助于Lambda表达式,极大地…...

带你一起研究JVM的语法糖功能 和 JVM的即时编译器)

(JVM)带你一起研究JVM的语法糖功能 和 JVM的即时编译器

1. 语法糖 所谓的语法糖,其实就是指java编译器把*.java源码编译为*.class字节码的过程中,自动生成和转换的一些代码,主要是为了减轻程序员的负担,算是java编译器给我们第一个额外福利 以下代码的分析,借助了javap工具…...

【Linux】ClickHouse 部署

搭建Clickhouse集群时,需要使用Zookeeper去实现集群副本之间的同步,所以需要先搭建zookeeper集群 1、卸载 # 检查有哪些clickhouse依赖包: [rootlocalhost ~]# yum list installed | grep clickhouse# 移除依赖包: [rootlocalho…...

js的小知识

以下是一些 JavaScript 的小知识点,适合不同水平的开发者: 1. 变量声明 使用 let、const 和 var 声明变量。let 和 const 块级作用域,而 var 是函数作用域。const 声明的变量不可重新赋值,但对象的属性仍然可以修改。 2. 箭头函…...

。】2022-5-15)

【根据当天日期输出明天的日期(需对闰年做判定)。】2022-5-15

缘由根据当天日期输出明天的日期(需对闰年做判定)。日期类型结构体如下: struct data{ int year; int month; int day;};-编程语言-CSDN问答 struct mdata{ int year; int month; int day; }mdata; int 天数(int year, int month) {switch (month){case 1: case 3:…...

使用VSCode开发Django指南

使用VSCode开发Django指南 一、概述 Django 是一个高级 Python 框架,专为快速、安全和可扩展的 Web 开发而设计。Django 包含对 URL 路由、页面模板和数据处理的丰富支持。 本文将创建一个简单的 Django 应用,其中包含三个使用通用基本模板的页面。在此…...

2025年能源电力系统与流体力学国际会议 (EPSFD 2025)

2025年能源电力系统与流体力学国际会议(EPSFD 2025)将于本年度在美丽的杭州盛大召开。作为全球能源、电力系统以及流体力学领域的顶级盛会,EPSFD 2025旨在为来自世界各地的科学家、工程师和研究人员提供一个展示最新研究成果、分享实践经验及…...

【Linux】C语言执行shell指令

在C语言中执行Shell指令 在C语言中,有几种方法可以执行Shell指令: 1. 使用system()函数 这是最简单的方法,包含在stdlib.h头文件中: #include <stdlib.h>int main() {system("ls -l"); // 执行ls -l命令retu…...

拉力测试cuda pytorch 把 4070显卡拉满

import torch import timedef stress_test_gpu(matrix_size16384, duration300):"""对GPU进行压力测试,通过持续的矩阵乘法来最大化GPU利用率参数:matrix_size: 矩阵维度大小,增大可提高计算复杂度duration: 测试持续时间(秒&…...

JavaScript基础-API 和 Web API

在学习JavaScript的过程中,理解API(应用程序接口)和Web API的概念及其应用是非常重要的。这些工具极大地扩展了JavaScript的功能,使得开发者能够创建出功能丰富、交互性强的Web应用程序。本文将深入探讨JavaScript中的API与Web AP…...

Git常用命令完全指南:从入门到精通

Git常用命令完全指南:从入门到精通 一、基础配置命令 1. 用户信息配置 # 设置全局用户名 git config --global user.name "你的名字"# 设置全局邮箱 git config --global user.email "你的邮箱example.com"# 查看所有配置 git config --list…...

【p2p、分布式,区块链笔记 MESH】Bluetooth蓝牙通信 BLE Mesh协议的拓扑结构 定向转发机制

目录 节点的功能承载层(GATT/Adv)局限性: 拓扑关系定向转发机制定向转发意义 CG 节点的功能 节点的功能由节点支持的特性和功能决定。所有节点都能够发送和接收网格消息。节点还可以选择支持一个或多个附加功能,如 Configuration …...

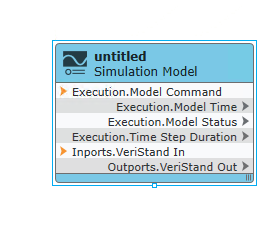

【Veristand】Veristand环境安装教程-Linux RT / Windows

首先声明,此教程是针对Simulink编译模型并导入Veristand中编写的,同时需要注意的是老用户编译可能用的是Veristand Model Framework,那个是历史版本,且NI不会再维护,新版本编译支持为VeriStand Model Generation Suppo…...

深入浅出WebGL:在浏览器中解锁3D世界的魔法钥匙

WebGL:在浏览器中解锁3D世界的魔法钥匙 引言:网页的边界正在消失 在数字化浪潮的推动下,网页早已不再是静态信息的展示窗口。如今,我们可以在浏览器中体验逼真的3D游戏、交互式数据可视化、虚拟实验室,甚至沉浸式的V…...