大型语言模型(LLM)的小型化研究进展

2024年,大型语言模型(LLM)的小型化研究取得了显著进展,主要采用以下几种方法实现:

-

模型融合:通过将多个模型或检查点合并为一个单一模型,减少资源消耗并提升整体性能。例如,《WARM: On the Benefits of Weight Averaged Reward Models》这篇论文通过权重平均多个微调后的奖励模型,有效缓解了LLM中的奖励骇入问题,提升了RLHF对齐步骤的稳健性。

-

混合专家模型(Mixture of Experts, MoE):使用多个小型专家模块构建模型,如Mixtral 8x7B。这类模型参数效率高,可达到或超过更大模型的效果。

-

小型LLM的开发:研究者也在探索构建更小的开源LLM,以降低训练成本、提高可及性。如TinyLlama只有1.1B参数且完全开源。

-

参数高效的LLM优化技术:如代理调优(Proxy Tuning)。它可使用小型模型提升大型模型,无需改动大模型权重。

-

知识蒸馏:通过将一个大型的教师模型的知识转移到一个小型的学生模型中,来实现模型的小型化。这种方法可以在几乎不降低精度的情况下,将模型的参数量大幅度减小。

-

剪枝:通过删除权重矩阵的一些行和列,降低网络的嵌入维数,同时保持模型性能。例如,微软的SliceGPT方法通过删除权重矩阵中的行和列来降低网络的嵌入维数,同时保持模型性能。

-

量化:通过将模型中的参数和激活值转换为低精度的表示形式,以减少模型的存储空间和计算量,从而实现模型的小型化。

-

结构化剪枝与知识蒸馏相结合:英伟达研究表明,这种方法可以从初始较大的模型中逐步获得较小的语言模型。例如,将Llama 3.1 8B模型提炼为Llama-3.1-Minitron 4B,其表现优于类似大小的最先进的开源模型。

这些方法各有优势和适用场景,研究者可以根据具体需求和资源限制选择合适的小型化策略。通过这些技术,可以在保持模型性能的同时,实现模型的小型化和加速,使其更适合在各种设备上部署。

量化

量化技术在解决大模型小型化方面发挥着重要作用。通过将模型中的参数和激活值从浮点数(如32位的FP32)转换为低精度的表示形式(如8位的INT8),量化可以显著减少模型的存储空间和计算量,从而实现模型的小型化。这种方法不仅降低了模型对算力的需求,还减少了内存需求,并压缩了存储空间,使得大模型能够在资源受限的设备上高效运行。

微软亚洲研究院在这一领域取得了显著成果,他们推出的数据编译器Ladder和算法T-MAC,使得只支持对称精度计算的硬件能够直接运行混合精度矩阵乘法。测试结果表明,Ladder在支持GPU原本不支持的自定义数据类型方面,最高提速可达14.6倍;T-MAC在搭载了最新高通Snapdragon X Elite芯片组的Surface AI PC上,使CPU上运行的大模型吞吐率比专用加速器NPU快两倍。

此外,量化技术还可以提高模型的计算效率和性能。例如,通过量化,模型的权重参数可以压缩为原来的1/4,理论上可以获得最大4倍的性能提升。实际加速效果依赖于硬件支持,例如NVIDIA A100提供的Tensor Core对INT8、INT4和INT1运算都有运算单元进行加速。

量化技术的应用不仅限于提高效率,它还可以降低模型的存储和传输成本,加速模型的部署和迭代,提高模型的灵活性和适用性。随着硬件的发展和量化技术的进步,量化模型的应用将越来越广泛,推动大模型在更广泛场景中的应用。

结构化剪枝与知识蒸馏相结合

英伟达的研究团队通过结合结构化剪枝和知识蒸馏的方法,成功地将较大的Llama 3.1 8B模型压缩成了更小的Llama-3.1-Minitron 4B模型。这一过程不仅减少了模型的参数数量,还保持了模型的性能,甚至在某些方面有所提升。具体来说,这项技术的优势包括:

-

性能提升:Llama-3.1-Minitron 4B模型在多任务语言理解(MMLU)等复杂任务上的表现优于其他同等规模的模型,MMLU分数提高了16%。

-

训练数据和成本的减少:通过这种方法,训练新模型所需的令牌数量减少了40倍,同时训练一系列模型的成本节省高达1.8倍。

-

推理性能的增强:使用NVIDIA TensorRT-LLM工具包优化后,Llama-3.1-Minitron 4B模型在各种情况下的FP8精度吞吐量是原始Llama 3.1 8B模型的2.7倍。

-

多维度剪枝策略:英伟达的研究详细探讨了如何在多个维度上进行剪枝,包括神经元、注意力头、嵌入维度和模型深度,并结合知识蒸馏优化每一个步骤。

-

迭代的剪枝和知识蒸馏策略:研究发现,逐步剪枝并在每一步进行蒸馏训练,能够更有效地保持模型的原始性能,特别适用于需要高压缩率的场景。

-

实际应用潜力:压缩后的模型可以更高效地在资源有限的设备上运行,并能够提供近似于大模型的性能,尤其是在计算资源有限的设备上,如移动设备、边缘计算设备。

这项研究展示了如何通过技术创新来推动大语言模型的发展,使AI训练变得更加高效和经济,同时保持或甚至提升模型的性能。

TinyLlama

TinyLlama是一个小型但功能强大的开源语言模型,由新加坡科技设计大学(SUTD)的研究者开发。这个模型具有以下特点:

-

模型参数:TinyLlama的参数量为1.1亿(1.1B),这使得它在计算和内存需求上相对较小,适用于资源受限的环境。

-

预训练数据:TinyLlama在大约3万亿个token上进行了预训练,这是一个相当大的数据集,有助于模型学习丰富的语言特征。

-

架构和分词器:TinyLlama基于Llama 2架构和分词器(tokenizer),这意味着它可以在许多基于Llama的开源项目中即插即用。

-

训练效率:研究者们使用16块A100-40G的GPU,在90天内完成了TinyLlama的训练。此外,TinyLlama还采用了多种优化方法,如flash attention 2、FSDP(Fully Sharded Data Parallel)、xFormers等,提高了训练的效率和吞吐量。

-

性能:尽管规模相对较小,但TinyLlama在一系列下游任务中表现出色,性能显著优于同等大小的现有开源语言模型,如OPT-1.3B和Pythia1.4B。

-

开源:TinyLlama的所有模型检查点和代码都在GitHub上公开提供,这使得研究人员和开发者可以轻松地访问和使用这个模型。

-

应用场景:TinyLlama适用于多种应用场景,包括辅助大型模型进行推测性解码、在边缘设备上运行(如离线实时机器翻译)、在游戏中实现实时对话生成等。

-

性能比较:在常识推理任务中,TinyLlama展现了出色的表现,并在多个基准测试中超越了Pythia-1.4B。

TinyLlama的这些特点使其成为一个有吸引力的选择,特别是对于那些寻求在资源受限的环境中部署高效语言模型的研究人员和开发者。

剪枝

剪枝是一种模型压缩技术,它通过去除神经网络中的冗余参数(如权重)来减小模型的大小和计算量,同时尽量保持模型的性能。剪枝可以分为两大类:结构化剪枝和非结构化剪枝。

-

结构化剪枝(Structured Pruning):

- 这种剪枝方式按整个结构单元进行剪枝,例如,对整个神经元、通道(channel)、或层(layer)进行剪枝,来简化模型。

- 结构化剪枝的优点在于它保留了整体的网络结构,使得剪枝后的模型更容易在现有的硬件和软件上实现加速。

- 例如,LLM-Pruner 就是一种结构化剪枝方法,它通过评估网络参数的重要性来移除冗余的组,从而降低模型的参数量。

-

非结构化剪枝(Unstructured Pruning):

- 非结构化剪枝则是在权重矩阵中随机地对独立权重或者神经元链接进行剪枝。

- 这种方法的剪枝算法简单,模型压缩比高,但剪枝后的权重矩阵稀疏,没有专用硬件难以实现压缩和加速的效果。

剪枝的过程通常包括以下几个步骤:

- 训练一个初始模型。

- 对模型进行剪枝,移除一定比例的参数。

- 对剪枝后的模型进行微调,以恢复由于剪枝可能造成的性能损失。

剪枝的可行性基于这样的观察:并不是所有的参数都在模型中发挥作用,部分参数作用有限、表达冗余,甚至可能会降低模型的性能。有研究表明,很多的深度神经网络仅仅使用很少一部分(如5%)的权值就足以预测剩余的权值,也就是说,仅仅训练一小部分原来的权值参数就有可能达到和原来网络相近甚至超过原来网络的性能。

在实际应用中,剪枝可以帮助减少模型的存储空间需求,加速模型的训练和推理过程,使得模型更适合部署在资源受限的设备上,如移动设备或嵌入式系统。此外,剪枝还可以与量化、知识蒸馏等其他模型压缩技术结合使用,以进一步优化模型的性能和效率。

相关文章:

的小型化研究进展)

大型语言模型(LLM)的小型化研究进展

2024年,大型语言模型(LLM)的小型化研究取得了显著进展,主要采用以下几种方法实现: 模型融合:通过将多个模型或检查点合并为一个单一模型,减少资源消耗并提升整体性能。例如,《WARM: …...

MiniWord

1.nuget 下载配置 2.引用 3. var value = new Dictionary<string, object>() { ["nianfen"] = nianfen, ["yuefen"] = yuefen, ["yuefenjian1"] = (int.Par…...

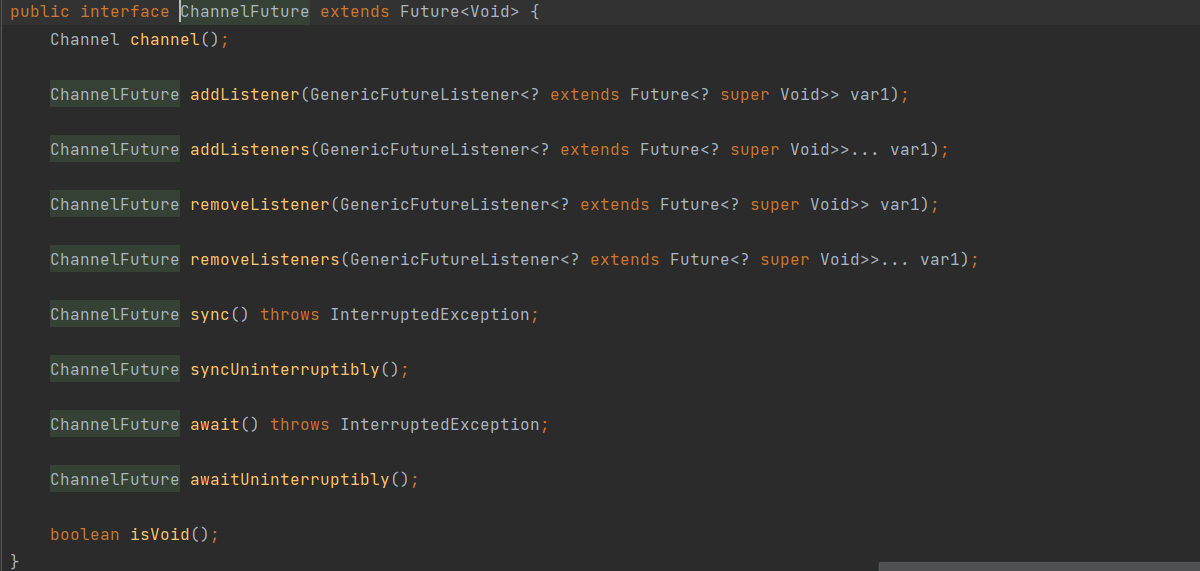

Netty 常见组件介绍

Netty 常见组件介绍 上篇文章Netty入门程序echo 基本包含了Netty常见的组件,本文分别介绍各个组件 Bootstrap or ServerBootstrapEventLoopEventLoopGroupChannelPipelineChannelFuture or ChannelFutureChannelInitializerChannelHandler Bootstrap vs ServerBo…...

高频电子线路---倍频器与振荡器

目录 倍频电路原理 丙类倍频器原理电路 问题: 提升滤波方法: 导通角 振荡器 振荡器基本工作原理 首先是怎么维持 那么如何振荡呢? 思考题: 组成要素 振荡器的起振条件 平衡条件 要点提示 稳定条件 振幅平衡 硬激励起振时: 稳定条件 相位平衡 倍频电路原理 简单原理 : …...

删除 git submodule

直接运行下面命令即可: git rm <path-to-submodule>然后提交修改即可。 但是,还有一个小问题:上面命令只是将 submodule 的代码目录删除了。 以下痕迹还存在你的仓库中: .gitmodule 中关于该 submodule 的信息.git 目录…...

)

el-table 多选默认选中(根据返回的id给数据加默认选中状态)

前言 el-table是我们最常用的展示数据的方式,但是有时候需要用到多选来选择数据,新增数据的时候还好,选中状态都是正常的,但是修改就遇到问题,需要对这个已经选择过的数据加上默认的选中状态,本次就是解决…...

境外网站翻译之自由职业

Polls Do you use AI tools (e.g ChatGPT, Midjourney, Github Copilot) as part of your work? 你在工作中会使用人工智能工具(如 ChatGPT、Midjourney、Github Copilot)吗? Yes, as an assistant 是的,作为一种辅助工具。 Y…...

批量图片转PDF文件的多种方法详解

要将批量图片转换为PDF文件,可以使用多种方法,包括使用在线工具、桌面应用程序或编程语言。以下是几种常见的方法: 方法一:使用在线工具 选择工具:搜索“图片转PDF”在线工具,如 Smallpdf、ILovePDF 等。…...

Web服务器(理论)

目录 Web服务器www简介常见Web服务程序介绍:服务器主机主要数据浏览器 网址及HTTP简介URLhttp请求方法:2.3 HTTP协议请求的工作流程: www服务器的类型静态网站动态网站 快速安装Apache安装准备工作httpd所需目录主配置文件 nignx安装1、安装2、准备工作 …...

=>(,);()的作用:明确表达式的边界。)

js:()=>(,);()的作用:明确表达式的边界。

()>{表达式1;表达式2;表达式3;... return 结果} 等同于 ()>(表达式1,表达式2,表达式3,... 结果) 例子: const strarr [a, b, c];const result strarr.reduce((acc, curr) > {(acc[curr] 1);console.lo…...

RSI 5G通信技术中用于标识小区的特定参数

RSI是指在5G通信技术中用于标识小区的特定参数,全称为Radio Subframe Indicator(无线子帧指示符)。在原文的上下文中,RSI被用来确保相邻小区间有足够的间隔,避免由于RSI冲突导致用户设备(UE)随机…...

JavaScript中的闭包、递归问题

一、函数定义和调用 1.函数的定义方式 方式一 函数声明方式 function 关键字(命名函数) function fn(){}方式二 函数表达式(匿名函数) var fn function(){}方式三 new Function() var f new Function(a,b,console.log(a b););//语法 var fn new Fu…...

【青牛科技】GC4938替代A4938/Allegro在水泵、筋膜枪、吸尘器和电动工具中的应用

随着技术的不断进步,电机驱动控制器在各类电动设备中的应用越来越广泛。GC4938作为一种新型的电机驱动控制器,逐渐被视为A4938/Allegro的替代品。在这篇文章中,我们将探讨GC4938在水泵、筋膜枪、吸尘器和电动工具等设备中的应用优势和特点。 …...

基于yolov5的输电线,电缆检测系统,支持图像检测,视频检测和实时摄像检测功能(pytorch框架,python源码)

更多目标检测和图像分类识别项目可看我主页其他文章 功能演示: yolov5,输电线(线缆)检测系统,系统既支持图像检测,也支持视频和摄像实时检测【pytorch框架】_哔哩哔哩_bilibili (一)简介 基于yolov5的输…...

uniapp下载文件的方案,包括H5,App方案解决办法

1. 在uniapp需要下载文件,但是显示情况是不能下载。所以只能使用该办法来进行下载。 2. 这有一个注意点是:如果你做的是H5的方案,那么我已经替你踩好坑了,UC浏览器是不支持blob类型的下载,以及创建a标签的方案来进行下…...

c++ 贪心算法

概念 贪心算法是一种在每一步选择中都选择当前最优解的算法策略。这种方法适用于某些特定问题,可以通过局部最优选择构建全局最优解。 特点 局部最优选择:每一步选择都选择当前看起来最优的解。无后效性:当前选择不会影响未来选择的可能性…...

)

15分钟学 Go 第 35 天:Go的性能调优 (7000字详细教程)

第35天:Go的性能调优 目标:理解Go语言中基本的性能优化,学习如何分析和提高Go程序的执行效率。 一、性能调优概述 性能调优是软件开发中的一个重要环节,它可以确保程序在资源有限的环境下高效运行。Go语言天生具备高效的性能表现…...

6、显卡品牌分类介绍:技嘉 - 计算机硬件品牌系列文章

技嘉科技是一家以主板、显卡在业界缔造无以撼动的地位的科技公司,其核心理念是「技术创新、质量稳定」的高标准。技嘉专注于关键技术研发,其经营范围涵盖家用、商用、电竞等多元科技领域。通过应用突破性的专利技术,技…...

Redis数据类型——针对实习面试

目录 Redis数据类型Redis常用的数据类型有哪些?String类型可以用于哪些场景?Set类型可以用于哪些场景?Bitmaps类型可以用于哪些场景?HyperLogLog类型可以用于哪些场景?Hash类型与Set类型有什么区别?Hash类型…...

roberta融合模型创新中文新闻文本标题分类

项目源码获取方式见文章末尾! 600多个深度学习项目资料,快来加入社群一起学习吧。 《------往期经典推荐------》 项目名称 1.【基于CNN-RNN的影像报告生成】 2.【卫星图像道路检测DeepLabV3Plus模型】 3.【GAN模型实现二次元头像生成】 4.【CNN模型实现…...

工业安全零事故的智能守护者:一体化AI智能安防平台

前言: 通过AI视觉技术,为船厂提供全面的安全监控解决方案,涵盖交通违规检测、起重机轨道安全、非法入侵检测、盗窃防范、安全规范执行监控等多个方面,能够实现对应负责人反馈机制,并最终实现数据的统计报表。提升船厂…...

理解 MCP 工作流:使用 Ollama 和 LangChain 构建本地 MCP 客户端

🌟 什么是 MCP? 模型控制协议 (MCP) 是一种创新的协议,旨在无缝连接 AI 模型与应用程序。 MCP 是一个开源协议,它标准化了我们的 LLM 应用程序连接所需工具和数据源并与之协作的方式。 可以把它想象成你的 AI 模型 和想要使用它…...

高频面试之3Zookeeper

高频面试之3Zookeeper 文章目录 高频面试之3Zookeeper3.1 常用命令3.2 选举机制3.3 Zookeeper符合法则中哪两个?3.4 Zookeeper脑裂3.5 Zookeeper用来干嘛了 3.1 常用命令 ls、get、create、delete、deleteall3.2 选举机制 半数机制(过半机制࿰…...

Keil 中设置 STM32 Flash 和 RAM 地址详解

文章目录 Keil 中设置 STM32 Flash 和 RAM 地址详解一、Flash 和 RAM 配置界面(Target 选项卡)1. IROM1(用于配置 Flash)2. IRAM1(用于配置 RAM)二、链接器设置界面(Linker 选项卡)1. 勾选“Use Memory Layout from Target Dialog”2. 查看链接器参数(如果没有勾选上面…...

什么?连接服务器也能可视化显示界面?:基于X11 Forwarding + CentOS + MobaXterm实战指南

文章目录 什么是X11?环境准备实战步骤1️⃣ 服务器端配置(CentOS)2️⃣ 客户端配置(MobaXterm)3️⃣ 验证X11 Forwarding4️⃣ 运行自定义GUI程序(Python示例)5️⃣ 成功效果

Python 包管理器 uv 介绍

Python 包管理器 uv 全面介绍 uv 是由 Astral(热门工具 Ruff 的开发者)推出的下一代高性能 Python 包管理器和构建工具,用 Rust 编写。它旨在解决传统工具(如 pip、virtualenv、pip-tools)的性能瓶颈,同时…...

动态 Web 开发技术入门篇

一、HTTP 协议核心 1.1 HTTP 基础 协议全称 :HyperText Transfer Protocol(超文本传输协议) 默认端口 :HTTP 使用 80 端口,HTTPS 使用 443 端口。 请求方法 : GET :用于获取资源,…...

《Docker》架构

文章目录 架构模式单机架构应用数据分离架构应用服务器集群架构读写分离/主从分离架构冷热分离架构垂直分库架构微服务架构容器编排架构什么是容器,docker,镜像,k8s 架构模式 单机架构 单机架构其实就是应用服务器和单机服务器都部署在同一…...

【深度学习新浪潮】什么是credit assignment problem?

Credit Assignment Problem(信用分配问题) 是机器学习,尤其是强化学习(RL)中的核心挑战之一,指的是如何将最终的奖励或惩罚准确地分配给导致该结果的各个中间动作或决策。在序列决策任务中,智能体执行一系列动作后获得一个最终奖励,但每个动作对最终结果的贡献程度往往…...

数据结构:泰勒展开式:霍纳法则(Horner‘s Rule)

目录 🔍 若用递归计算每一项,会发生什么? Horners Rule(霍纳法则) 第一步:我们从最原始的泰勒公式出发 第二步:从形式上重新观察展开式 🌟 第三步:引出霍纳法则&…...