强化学习方法分类详解

强化学习方法分类详解

引言

强化学习(Reinforcement Learning, RL)是一种通过智能体与环境互动来学习如何做出最佳决策的方法。根据不同的优化中心、策略特性、环境模型、奖励函数、动作空间类型以及行为策略和目标策略的一致性,RL可以分为多种类别。本文将详细介绍这些分类标准,并解释每种分类的具体细节。

1. 根据优化中心分类

1.1 策略优化算法(以策略为中心)

定义:这类算法直接优化策略参数以最大化预期奖励,不依赖于值函数。策略可以直接从原始输入(如图像)中学习。

例子:

- REINFORCE:一种简单的策略梯度算法,通过采样轨迹来估计梯度。

- Proximal Policy Optimization (PPO):结合了策略梯度方法的优点,通过限制更新步长来提高稳定性。

优点:

- 灵活性高:可以处理连续动作空间的问题。

- 端到端学习:可以直接从原始输入(如图像)学习策略。

1.2 动态规划算法(以值函数为中心)

定义:这类算法通过估计状态或状态-动作对的价值来指导决策。常见的值函数包括状态价值函数 V ( s ) V(s) V(s) 和动作价值函数 Q ( s , a ) Q(s, a) Q(s,a)。

例子:

- Q-learning:估计动作价值函数 Q ( s , a ) Q(s, a) Q(s,a),并通过贝尔曼最优方程进行更新。

- SARSA:类似于Q-learning,但采用的是on-policy方式。

优点:

- 解释性强:可以直接看到每个状态或动作的好坏程度。

- 收敛速度快:在某些情况下,值函数方法比其他方法更快地收敛到最优策略。

2. 根据策略是否随机分类

2.1 确定性策略算法

定义:确定性策略在每个状态下选择一个特定的动作,而不涉及概率分布。

例子:

- DQN(Deep Q-Networks):使用深度神经网络来近似动作价值函数 Q ( s , a ) Q(s, a) Q(s,a),并选择具有最高Q值的动作。

优点:

- 简单直观:每次选择最优动作,易于理解和实现。

- 性能稳定:在许多任务中表现出色,尤其是在离散动作空间中。

2.2 随机性策略算法

定义:随机性策略在每个状态下根据概率分布选择动作,允许一定的探索空间。

例子:

- ε-greedy 策略:大多数时间选择当前估计的最佳动作(利用),偶尔随机选择其他动作(探索),公式如下:

π ( a ∣ s ) = { 1 − ϵ + ϵ ∣ A ∣ , 如果 a = arg max a ′ Q ( s , a ′ ) ϵ ∣ A ∣ , 否则 \pi(a|s) = \begin{cases} 1 - \epsilon + \frac{\epsilon}{|A|}, & \text{如果 } a = \arg\max_{a'} Q(s, a') \\ \frac{\epsilon}{|A|}, & \text{否则} \end{cases} π(a∣s)={1−ϵ+∣A∣ϵ,∣A∣ϵ,如果 a=argmaxa′Q(s,a′)否则 - Softmax Policy:根据动作的价值按比例分配选择概率,既考虑了当前最佳动作也保留了一定的探索空间,常用的形式是Boltzmann分布,公示如下:

π ( a ∣ s ) = exp ( Q ( s , a ) / τ ) ∑ a ′ exp ( Q ( s , a ′ ) / τ ) \pi(a|s) = \frac{\exp(Q(s, a)/\tau)}{\sum_{a'} \exp(Q(s, a')/\tau)} π(a∣s)=∑a′exp(Q(s,a′)/τ)exp(Q(s,a)/τ)

优点:

- 平衡探索与利用:通过调整参数可以在探索和利用之间找到平衡。

- 平滑过渡:通过温度参数控制选择的概率分布,使探索更加平滑。

3. 根据转移概率是否已知分类

3.1 基于模型的算法

定义:基于模型的方法假设智能体拥有环境的完整或部分模型,可以预测未来的状态和奖励。这些模型通常包括状态转移概率 p ( s ′ , r ∣ s , a ) p(s', r | s, a) p(s′,r∣s,a) 和奖励函数 r ( s , a ) r(s, a) r(s,a)。

例子:

- 动态规划(Dynamic Programming, DP):如值迭代(Value Iteration)和策略迭代(Policy Iteration),用于求解马尔科夫决策过程(MDP)。

- 蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS):结合了模拟和搜索,广泛应用于游戏AI中。

优点:

- 精确性高:由于有环境模型的支持,智能体可以更准确地预测未来的结果。

- 规划能力强:智能体可以在不实际执行动作的情况下,通过模拟来评估不同策略的效果。

3.2 无模型的算法

定义:无模型方法直接从与环境的交互中学习,不需要显式的环境模型。这类方法更灵活,适用于未知或复杂的环境。

例子:

- Q-learning:一种经典的无模型方法,直接估计动作价值函数 Q ( s , a ) Q(s, a) Q(s,a),并通过贝尔曼最优方程进行更新。

- SARSA:类似于Q-learning,但采用的是on-policy方式。

优点:

- 适应性强:无需事先了解环境的动态特性,适用于复杂或未知环境。

- 易于实现:算法相对简单,容易上手。

4. 根据奖励函数是否已知分类

4.1 强化学习算法

定义:如果奖励函数已知,则可以直接进行强化学习训练。

例子:

- Q-learning:已知奖励函数的情况下,直接估计动作价值函数 Q ( s , a ) Q(s, a) Q(s,a)。

- SARSA:同样适用于已知奖励函数的情况。

优点:

- 直接应用:可以直接利用已知的奖励函数进行训练,简化了问题的复杂度。

4.2 逆强化学习算法

定义:如果奖励函数未知,那么需要根据专家实例将奖励函数学出来。

例子:

- 最大熵逆强化学习(MaxEnt IRL):通过观察专家的行为,推断出最可能的奖励函数。

- GAIL(Generative Adversarial Imitation Learning):使用生成对抗网络来模仿专家行为,间接学习奖励函数。

优点:

- 灵活性高:可以处理未知奖励函数的情况,扩展了应用范围。

- 数据驱动:通过观察专家行为,可以从数据中学习奖励函数。

5. 根据动作空间的类型分类

5.1 用于连续型动作空间的算法

定义:这类算法适用于动作空间是连续的情况,例如机器人操控等任务。

例子:

- DDPG(Deep Deterministic Policy Gradient):结合了值函数和策略梯度的优点,适用于连续动作空间。

- TD3(Twin Delayed DDPG):改进版的DDPG,提升了稳定性和性能。

优点:

- 灵活性高:可以处理复杂的连续动作空间。

- 性能优越:在许多连续动作空间的任务中表现出色。

5.2 用于离散型动作空间的算法

定义:这类算法适用于动作空间是离散的情况,例如围棋落子等任务。

例子:

- DQN(Deep Q-Networks):使用深度神经网络来近似动作价值函数 Q ( s , a ) Q(s, a) Q(s,a),并选择具有最高Q值的动作。

- A3C(Asynchronous Advantage Actor-Critic):一种异步的Actor-Critic方法,提高了训练效率。

优点:

- 简单直观:每次选择最优动作,易于理解和实现。

- 性能稳定:在许多离散动作空间的任务中表现出色。

6. 根据行为策略和目标策略的一致性分类

6.1 On-Policy 方法

定义:行为策略和目标策略是同一个策略。即,智能体根据当前策略采取动作,并根据这些动作的数据来更新策略。

例子:

- SARSA:采用on-policy方式,根据当前策略采取动作。

- A2C(Advantage Actor-Critic):同步版本的Actor-Critic方法,采用on-policy方式。

优点:

- 一致性好:行为策略和目标策略一致,使得策略更新更加稳定。

- 实时反馈:可以根据最新的行为数据实时更新策略。

6.2 Off-Policy 方法

定义:行为策略和目标策略不是同一个策略。即,智能体可以根据任意策略采取动作,但只用特定策略的数据来更新目标策略。

例子:

- Q-learning:采用off-policy方式,可以从任意策略产生的数据中学习。

- DQN:使用经验回放缓冲区存储历史数据,支持off-policy学习。

优点:

- 数据利用率高:可以利用更多的历史数据,提高学习效率。

- 灵活性高:可以从多种策略产生的数据中学习,增加了探索空间。

6.3 Offline 方法

定义:Offline 方法是指只基于行为策略数据来优化策略,而过程中不和环境交互。这种方法在实际生产环境中非常有用,因为频繁和环境交互的成本较高。

例子:

- Batch Reinforcement Learning:使用预先收集的数据集进行训练,避免了实时交互。

- Offline Policy Evaluation:评估新策略的表现,而不需实际执行新策略。

优点:

- 成本低:不需要频繁与环境交互,降低了实验成本。

- 安全性高:避免了在实际环境中测试新策略带来的风险。

结论

本文详细介绍了强化学习的主要分类,包括根据优化中心、策略特性、环境模型、奖励函数、动作空间类型以及行为策略和目标策略的一致性等方面的分类。每种分类都有其独特的特点和适用场景,理解这些分类有助于选择合适的算法来解决特定问题。

相关文章:

强化学习方法分类详解

强化学习方法分类详解 引言 强化学习(Reinforcement Learning, RL)是一种通过智能体与环境互动来学习如何做出最佳决策的方法。根据不同的优化中心、策略特性、环境模型、奖励函数、动作空间类型以及行为策略和目标策略的一致性,RL可以分为…...

)

雅思真题短语(二十八)

真题短语收录在合辑。 541法律官员 work as a solicitor 542前卫 a radical and expensive scheme 543反对者们 objectors 544破坏 demolishing buildings 545蒸汽机车 steam locomotives 546冷凝 steam could be condensed 547烟雾 smoke and fumes 548通风井 ventilation sh…...

在Linux系统中使用字符图案和VNC运行Qt Widgets程序

大部分服务器并没有GUI,运行的是基础的Linux系统,甚至是容器。如果我们需要在这些系统中运行带有GUI功能的Qt程序,一般情况下就会报错,比如: $ ./collidingmice qt.qpa.xcb: could not connect to display qt.qpa.plu…...

Python基于EasyOCR进行路灯控制箱图像文本识别项目实战

说明:这是一个机器学习实战项目(附带数据代码文档视频讲解),如需数据代码文档视频讲解可以直接到文章最后关注获取。 1.项目背景 随着城市化进程的加快,智能城市建设成为了现代社会发展的重要方向。路灯作为城市基础设…...

Github 2024-12-28 Rust开源项目日报 Top10

根据Github Trendings的统计,今日(2024-12-28统计)共有10个项目上榜。根据开发语言中项目的数量,汇总情况如下: 开发语言项目数量Rust项目10TypeScript项目1Python项目1egui: 一个简单、快速且高度可移植的 Rust GUI 库 创建周期:1903 天开发语言:Rust协议类型:Apache Li…...

提升生产力工具

VSCODE插件 干货:用好这13款VSCode插件,工作效率提升10倍 - 程序员柠檬 - 博客园 Sourcetrail Sourcetrail 是一个开源且免费的源码阅读工具,以其强大的代码导航、可视化及跨平台支持特性,成为开发者理解复杂代码库的得力助手。…...

【蓝桥杯——物联网设计与开发】系列前言

前言 本系列博客是博主为准备2024年第十五届蓝桥杯大赛物联网设计与开发赛道而写,经过4个月学习备战,最终获得全国一等奖。 从第十六届蓝桥杯大赛开始,物联网赛道更换竞赛实训平台。之前的博客,可以借鉴代码思想,但引脚…...

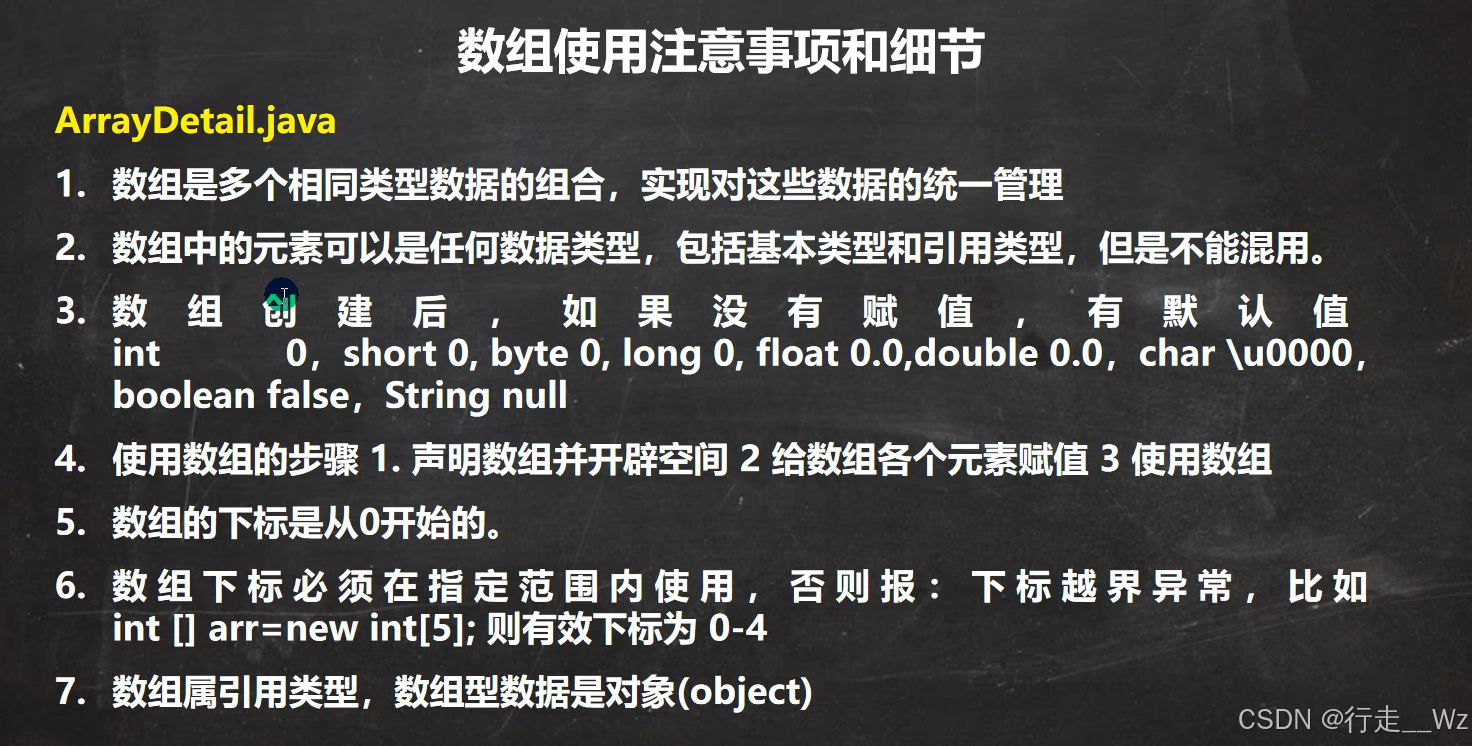

【Java基础】02.Java数据类型

目录 Java 数据类型 3.1 java程序中 “” 号的使用 3.2 java中的数据类型 3.2.1 基本数据类型:数值型 (1)整数类型 (2)浮点(小数)类型 3.2.2 基本数据类型:字符型 3.2.3 基本…...

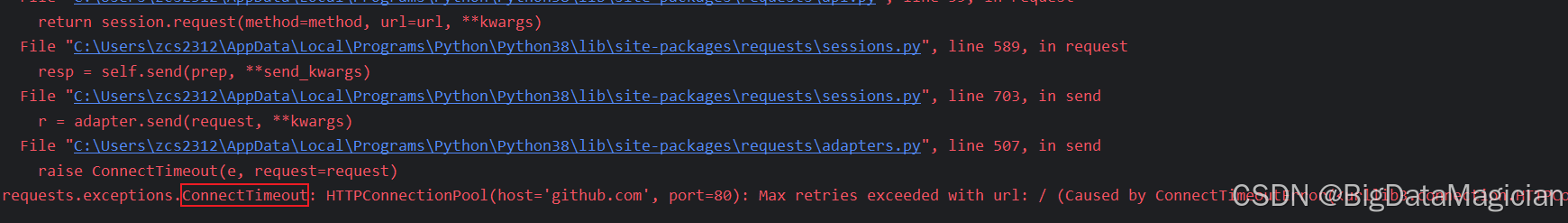

Python爬虫(一)- Requests 安装与基本使用教程

文章目录 前言一、简介及安装1. 简介2. 安装 Requests2.1 安装2.2 检查安装是否成功 二、使用 Requests 发送 HTTP 请求1. 发送 GET 请求2. 发送 POST 请求3. 发送 PUT 请求4. 发送 DELETE 请求5. 发送 HEAD 请求6. 发送 OPTIONS 请求 三、传递参数1. GET 请求传递 URL 参数1.1…...

线段树保姆级教程

买水果 Description 水果姐今天心情不错,来到了水果街。 水果街有n家水果店,呈直线结构,编号为1~n,每家店能买水果也能卖水果,并且同一家店卖与买的价格一样。 学过oi的水果姐迅速发现了一个赚钱的方法:…...

logback之自定义过滤器

logback有两种过滤器,一种是context中的过滤器叫TurboFilter,是一个全局的过滤器,会影响所有的日志记录。另一种是Appender中的过滤器,只对所在的append有效。两者大同小异,这里我们以Appender的过滤器为例。 &#x…...

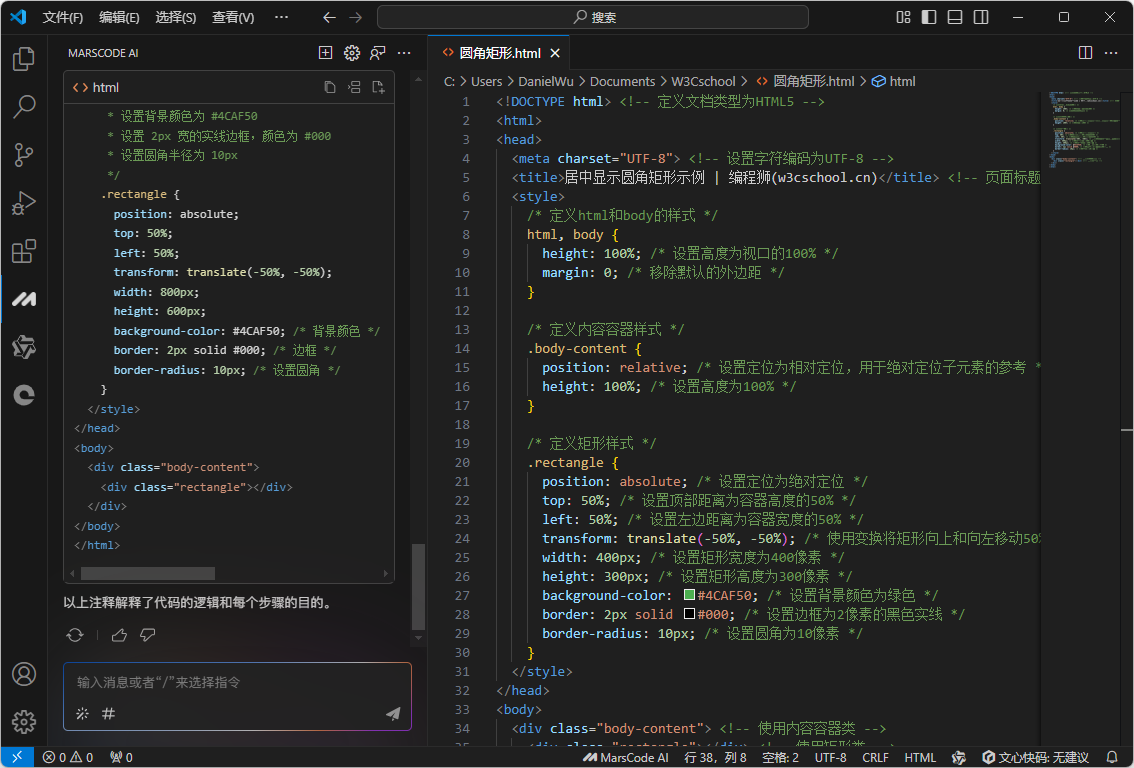

如何用CSS3创建圆角矩形并居中显示?

在网页设计中,圆角矩形因其美观和现代感而被广泛使用,居中显示元素也是一个常见的需求。今天,我们将学习如何使用CSS3的border-radius属性来创建圆角矩形,并将其居中显示在页面上。 如果你正在学习CSS,那么这个实例将非…...

Java 开发中的指定外部 Jar 路径详解

哈喽,各位小伙伴们,你们好呀,我是喵手。运营社区:C站/掘金/腾讯云/阿里云/华为云/51CTO;欢迎大家常来逛逛 今天我要给大家分享一些自己日常学习到的一些知识点,并以文字的形式跟大家一起交流,互…...

python爬虫--小白篇【selenium自动爬取文件】

一、问题描述 在学习或工作中需要爬取文件资源时,由于文件数量太多,手动单个下载文件效率低,操作麻烦,采用selenium框架自动爬取文件数据是不二选择。如需要爬取下面网站中包含的全部pdf文件,并将其转为Markdown格式。…...

TI毫米波雷达原始数据解析之Lane数据交换

TI毫米波雷达原始数据解析之Lane数据交换 背景Lane 定义Lane 确认确认LVDS Lane 数量的Matlab 代码数据格式参考 背景 解析使用mmWave Studio 抓取的ADC Data Lane 定义 芯片与DCA100之间的数据使用LVDS接口传输,使用mmWave Studio 配置过程中有一个选项是LVDS L…...

overscroll-behavior-解决H5在ios上过度滚动的默认行为

1. 问题 开发H5的过程中,经常会有android和ios两边系统需要兼容的情况。在ios上一直有个问题是当H5内容触及到页面顶部或底部时,还是可以被人为的往下或往下拉动界面。当然可能有的情况是比较适用的,比如你往下拉动,然后在导航栏…...

Nacos配置中心总结

Nacos配置中心总结 Nacos配置文件的加载顺序和优先级 加载顺序 nacos作为配置中心时,需要在bootstrap.yml文件中添加nacos config相关的配置,这样系统启动时就能先去拉取nacos server上的配置了。拉取过来后会和本地配置文件进行合并。 bootstrap.ym…...

rouyi(前后端分离版本)配置

从gitee上下载,复制下载地址,到 点击Clone,下载完成, 先运行后端,在运行前端 运行后端: 1.配置数据库,在Navicat软件中,连接->mysql->名字自己起(rouyi-vue-blog),用户名roo…...

超大规模分类(一):噪声对比估计(Noise Contrastive Estimation, NCE)

NCE损失对应的论文为《A fast and simple algorithm for training neural probabilistic language models》,发表于2012年的ICML会议。 背景 在2012年,语言模型一般采用n-gram的方法,统计单词/上下文间的共现关系,比神经概率语言…...

Windows 下安装 triton 教程

目录 背景解决方法方法一:(治标不治本)方法二:(triton-windows)- 安装 MSVC 和 Windows SDK- vcredist 安装- whl 安装- 验证 背景 triton 目前官方只有Linux 版本,若未安装,则会出…...

vscode里如何用git

打开vs终端执行如下: 1 初始化 Git 仓库(如果尚未初始化) git init 2 添加文件到 Git 仓库 git add . 3 使用 git commit 命令来提交你的更改。确保在提交时加上一个有用的消息。 git commit -m "备注信息" 4 …...

React 第五十五节 Router 中 useAsyncError的使用详解

前言 useAsyncError 是 React Router v6.4 引入的一个钩子,用于处理异步操作(如数据加载)中的错误。下面我将详细解释其用途并提供代码示例。 一、useAsyncError 用途 处理异步错误:捕获在 loader 或 action 中发生的异步错误替…...

【解密LSTM、GRU如何解决传统RNN梯度消失问题】

解密LSTM与GRU:如何让RNN变得更聪明? 在深度学习的世界里,循环神经网络(RNN)以其卓越的序列数据处理能力广泛应用于自然语言处理、时间序列预测等领域。然而,传统RNN存在的一个严重问题——梯度消失&#…...

uniapp微信小程序视频实时流+pc端预览方案

方案类型技术实现是否免费优点缺点适用场景延迟范围开发复杂度WebSocket图片帧定时拍照Base64传输✅ 完全免费无需服务器 纯前端实现高延迟高流量 帧率极低个人demo测试 超低频监控500ms-2s⭐⭐RTMP推流TRTC/即构SDK推流❌ 付费方案 (部分有免费额度&#x…...

)

Java入门学习详细版(一)

大家好,Java 学习是一个系统学习的过程,核心原则就是“理论 实践 坚持”,并且需循序渐进,不可过于着急,本篇文章推出的这份详细入门学习资料将带大家从零基础开始,逐步掌握 Java 的核心概念和编程技能。 …...

Java多线程实现之Thread类深度解析

Java多线程实现之Thread类深度解析 一、多线程基础概念1.1 什么是线程1.2 多线程的优势1.3 Java多线程模型 二、Thread类的基本结构与构造函数2.1 Thread类的继承关系2.2 构造函数 三、创建和启动线程3.1 继承Thread类创建线程3.2 实现Runnable接口创建线程 四、Thread类的核心…...

【Android】Android 开发 ADB 常用指令

查看当前连接的设备 adb devices 连接设备 adb connect 设备IP 断开已连接的设备 adb disconnect 设备IP 安装应用 adb install 安装包的路径 卸载应用 adb uninstall 应用包名 查看已安装的应用包名 adb shell pm list packages 查看已安装的第三方应用包名 adb shell pm list…...

十九、【用户管理与权限 - 篇一】后端基础:用户列表与角色模型的初步构建

【用户管理与权限 - 篇一】后端基础:用户列表与角色模型的初步构建 前言准备工作第一部分:回顾 Django 内置的 `User` 模型第二部分:设计并创建 `Role` 和 `UserProfile` 模型第三部分:创建 Serializers第四部分:创建 ViewSets第五部分:注册 API 路由第六部分:后端初步测…...

消防一体化安全管控平台:构建消防“一张图”和APP统一管理

在城市的某个角落,一场突如其来的火灾打破了平静。熊熊烈火迅速蔓延,滚滚浓烟弥漫开来,周围群众的生命财产安全受到严重威胁。就在这千钧一发之际,消防救援队伍迅速行动,而豪越科技消防一体化安全管控平台构建的消防“…...

DAY 26 函数专题1

函数定义与参数知识点回顾:1. 函数的定义2. 变量作用域:局部变量和全局变量3. 函数的参数类型:位置参数、默认参数、不定参数4. 传递参数的手段:关键词参数5 题目1:计算圆的面积 任务: 编写一…...