【Tensorflow】模型如何加载HDF文件数据集?

如果每个样本都被保存为一个单独的 HDF5 文件,可以使用 `tf.data.Dataset.list_files` 函数来创建一个文件名数据集,然后使用 `tf.data.Dataset.interleave` 函数来并行读取多个文件。

下面的示例展示了如何从多个 HDF5 文件中读取数据并创建一个 `tf.data.Dataset` 对象:

import h5py

import tensorflow as tf

# 定义文件模式,假设三个数据集都在/dataset文件夹中

train_pattern = "/dataset/train/*.h5"

val_pattern = "/dataset/val/*.h5"

test_pattern = "/dataset/test/*.h5"

# 定义读取函数

def read_file(file):

with h5py.File(file.numpy(), "r") as f:

x = f["x"][()]

y = f["y"][()]

return x, y

def load_data(file):

x, y = tf.py_function(read_file, [file], [tf.float32, tf.float32])

return x, y

# 创建文件名数据集

train_files = tf.data.Dataset.list_files(train_pattern)

val_files = tf.data.Dataset.list_files(val_pattern)

test_files = tf.data.Dataset.list_files(test_pattern)

# 读取数据

train_dataset = train_files.interleave(

load_data,

cycle_length=tf.data.AUTOTUNE,

num_parallel_calls=tf.data.AUTOTUNE

)

val_dataset = val_files.interleave(

load_data,

cycle_length=tf.data.AUTOTUNE,

num_parallel_calls=tf.data.AUTOTUNE

)

test_dataset = test_files.interleave(

load_data,

cycle_length=tf.data.AUTOTUNE,

num_parallel_calls=tf.data.AUTOTUNE

)

# 打乱和批处理数据

train_dataset = train_dataset.shuffle(buffer_size=10000).batch(batch_size)

val_dataset = val_dataset.batch(batch_size)

test_dataset = test_dataset.batch(batch_size)

`interleave` 函数可以从多个数据集中交替地读取数据。在这个例子中,我们使用 `interleave` 函数来并行地从多个 HDF5 文件中读取数据。

`interleave` 函数的第一个参数是一个函数,它接受一个输入元素(在这个例子中是一个文件名),并返回一个新的 `Dataset` 对象。在这个例子中,我们定义了一个 `load_data` 函数,它接受一个文件名作为输入,然后使用 `h5py` 库来读取 HDF5 文件中的数据,并返回一个包含数据的 `Dataset` 对象。

`interleave` 函数的第二个参数 `cycle_length` 指定了同时打开的文件数。在这个例子中,我们将其设置为 `tf.data.AUTOTUNE`,这意味着 TensorFlow 会自动选择最佳的值。

`interleave` 函数的第三个参数 `num_parallel_calls` 指定了并行读取文件时使用的线程数。在这个例子中,我们将其设置为 `tf.data.AUTOTUNE`,这意味着 TensorFlow 会自动选择最佳的值。

shuffle方法用于打乱数据集中的元素顺序。它接受一个参数buffer_size,用于指定打乱顺序时使用的缓冲区大小。在这个例子中,我们将其设置为 10000,这意味着 TensorFlow 会在一个大小为 10000 的缓冲区中随机选择元素。

batch方法用于将数据集中的元素分组成批。它接受一个参数batch_size,用于指定每个批次中元素的数量。在这个例子中,我们使用了之前定义的变量batch_size来设置每个批次中元素的数量。

如何在创建模型的时候调参?

当你刚创建了模型还不确定超参数用什么好,如果您想使用贝叶斯优化来调整超参数,可以使用像 `scikit-optimize` 这样的库来实现。首先,安装 `scikit-optimize` 库, `pip install scikit-optimize` 。

下面是一个示例,展示了如何使用 `scikit-optimize` 库中的 `gp_minimize` 函数来调整学习率和批处理大小:

from skopt import gp_minimize

from skopt.space import Real, Integer

from skopt.utils import use_named_args

# 定义超参数空间

space = [

Real(1e-6, 1e-2, name='learning_rate', prior='log-uniform'),

Integer(8, 32,64,128, name='batch_size')

]

# 定义目标函数

@use_named_args(space)

def objective(learning_rate, batch_size):

# 模型

model = tf.keras.Sequential()

model.add(layers.Conv3D(32, kernel_size=(3, 3, 3), activation='relu', input_shape=(21, 21, 21, 20)))

model.add(layers.Conv3D(64, kernel_size=(3, 3, 3), activation='relu'))

model.add(layers.Conv3D(128, kernel_size=(3, 3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(1))

# 编译模型

optimizer = tf.keras.optimizers.Adam(learning_rate=learning_rate)

model.compile(loss='mean_squared_error', optimizer=optimizer)

# 训练模型

history = model.fit(

x_train,

y_train,

batch_size=batch_size,

epochs=epochs,

verbose=0,

validation_data=(x_test, y_test)

)

# 返回验证损失

return history.history['val_loss'][-1]

# 运行贝叶斯优化

res = gp_minimize(objective, space, n_calls=50)

# 输出最优超参数

print(f"Best parameters: {res.x}")

您可以根据您的需求进行相应的修改。

在上面的示例中,我们定义了一个目标函数

objective,它接受两个命名参数learning_rate和batch_size。然而,

gp_minimize函数期望目标函数接受一个位置参数,该参数是一个列表,包含所有超参数的值。为解决这个问题,我们使用了

@use_named_args装饰器。它接受一个参数space,用于指定超参数空间。在这个例子中,我们将其设置为之前定义的超参数空间列表。当使用

@use_named_args(space)装饰目标函数时,它会自动将目标函数的参数从位置参数转换为命名参数。这样,就可以在目标函数中使用命名参数,而不必手动解包位置参数。

在 Python 中,函数参数分为两种类型:位置参数和命名参数。

位置参数是按照顺序传递给函数的参数。例如,在下面的函数定义中,`x` 和 `y` 都是位置参数:

def add(x, y):

return x + y

当调用这个函数时,需要按照顺序传递两个参数,例如 `add(1, 2)`。`1` 会被赋值给 `x`,`2` 会被赋值给 `y`。

命名参数是通过名称传递的参数。例如,在下面的函数定义中,`x` 和 `y` 都是命名参数:

def add(x=0, y=0):

return x + y

当我们调用这个函数时,我们可以使用名称来指定参数的值,例如 `add(x=1, y=2)`。在这个例子中,`1` 会被赋值给 `x`,`2` 会被赋值给 `y`。

相关文章:

【Tensorflow】模型如何加载HDF文件数据集?

如果每个样本都被保存为一个单独的 HDF5 文件,可以使用 tf.data.Dataset.list_files 函数来创建一个文件名数据集,然后使用 tf.data.Dataset.interleave 函数来并行读取多个文件。 下面的示例展示了如何从多个 HDF5 文件中读取数据并创建一个 tf.data.D…...

校招又临近了,怎么在面试中应对设计模式相关问题呢?

夏天开始了,那么夏天结束时的毕业季也不远了。毕业是个伤感、期待而又略带残酷的时节,就像蜜桃无论成熟与否都会在这个时间被采摘,如果毫无准备就踏入社会,就会……马上变成低级社畜。所以说还是要早点为了毕业找工作做点准备&…...

padans关于数据处理的杂谈

情况:业务数据基本字段会有如下: Index([时间, 地区, 产品, 字段, 数值], dtypeobject)这样就会引发一个经典“三角不可能定理”,如何同时简约展现分时序、分产品、分字段数据。)一般来说, 1、时序为作为单独的分类&…...

神经网络的理解

文章目录 概念得分函数损失函数神经网络结构非线性激活函数神经网络运行过程神经网络能够做的事情概念 人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connection Model),它是一种模仿动物神经网络行为特征,进行分布式并…...

夏驰和徐策带你从零开始学数据结构——哈希表

哈希表的概念: 哈希表是一种常用的数据结构,它可以在 O(1) 的时间复杂度内执行插入、查找和删除操作。哈希表的核心思想是使用哈希函数将键值对映射到数组中的一个位置上,从而实现快速的访问和修改。 哈希表由两个主要部分组成:…...

linux实现网络程序

1️⃣ 在linux下,通过套接字实现服务器和客户端的通信。 2️⃣ 实现单线程、多线程通信。或者实现线程池来通信。 3️⃣ 优化通信,增加守护进程。 有情提醒,类里面默认的函数是内联。内联函数在调用的地方展开,没有函数地址&…...

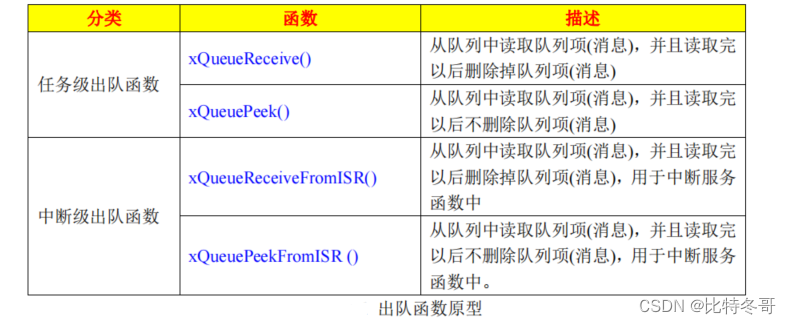

FreeRTOS 队列(二)

文章目录 一、向队列发送消息1. 函数原型(1)函数 xQueueOverwrite()(2)函数 xQueueGenericSend()(3)函数 xQueueSendFromISR()、xQueueSendToBackFromISR()、xQueueSendToFrontFromISR()(4&…...

用python获取当前目录下的创建时间超过3天的所有python文件

直接上代码: import os import datetime print(os.getcwd()) # 获取当前目录下所有的html文件 html_files [] for filename in os.listdir(): if filename.endswith(.py): html_files.append(os.path.join(., filename)) now date…...

第五章 Linux实际操作——用户管理

第五章 Linux实际操作——用户管理 5.1 基本介绍5.2 添加用户5.3 指定、修改密码5.4 删除用户5.5 查询用户信息指令5.6 切换用户5.7 查看当前用户、登录用户5.8 用户组5.9 用户和组相关文件8.9.1/etc/passwd 文件8.9.2/etc/shadow文件8.9.3/etc/group文件 5.1 基本介绍 Linux系…...

悲观锁和乐观锁详细

悲观锁和乐观锁详细 悲观锁 悲观锁就是悲观的思想,他认为数据每一次被访问的时候都会被上锁,所以每次获得锁的时候都会上锁,这样其他线程想要获取这个锁的时候就会被堵塞,要等待上一个线程锁的释放。也就是说这个线程只一次只…...

三谈ChatGPT(ChatGPT可以解决问题的90%)

这是我第三次谈ChatGPT,前两篇主要谈了ChatGPT的概念,之所以火的原因和对人们的影响,以及ChatGPT可能存在的安全风险和将面临的监管问题。这一篇主要讲讲ChatGPT的场景和处理问题的逻辑。 这一次我特意使用了ChatGPT中文网页版体验了一番。并…...

Qt QSet 详解:从底层原理到高级用法

目录标题 引言:QSet的重要性与简介QSet 的常用接口迭代器:遍历Qset 中的元素(Iterators: Traversing Elements in Qset )高级用法:QSet 中的算法与功能(Advanced Usage: Algorithms and Functions in QList…...

Mac Doxygen的使用

Doxygen的使用 安装着Doxygen和Graphviz这两个东西 在源码目录先使用doxygen -g生成一个叫 ‘Doxyfile’ 的Doxygen的配置文件修改配置文件,里面都有介绍各个选项的功能,这里主要修改一下几个: HAVE_DOT YES EXTRACT_ALL YES EXTRACT_PRIVATE YES E…...

FPGA基础代码复用

一、verilog中有关代码复用的语法 1、连接符“{}” {4{1b1}} 或者 {5d6, 5d8} 2、参数(Parameter)型常量定义 parameter 参数名=表达式; 或者 localparam 参数名=表达式; parameter DATA_WIDTH 20; 3、function函数定义 …...

Hbase简介

HBase简介 一、HBase简介 1. HBase简介 (1) apache的顶级项目,hadoop的数据库,分布式、大规模的大数据存储。 HBase是Google的BigTable的开源java版本,建立在hdfs之上的,分布式、列存储、非关系(nosql、key-value&a…...

科海思除COD树脂,大孔树脂,除COD专用树脂

一、产品介绍 Tulsimer A-722 MP具有控制孔径的大孔强碱性Ⅰ型阴离子交换树脂 Tulsimer A-722 MP 是一款具有便于颜色和有机物去除的控制孔径的,专门开发的大孔强碱性Ⅰ型阴离子交换树脂。 Tulsimer A-722 MP(氯型)专门应用于去除COD…...

Qt 多线程 QThread、QThreadPool使用场景

QThread 和 QRunnable 都是 Qt 框架中用于多线程编程的类,它们之间有以下不同点: 继承关系不同 QThread 继承自 QObject 类,而 QRunnable 没有父类。 实现方式不同 QThread 是一个完整的线程实现,包含了线程的创建、启动、停止、…...

如何一招搞定PCB阻焊过孔问题?

PCB阻焊油墨根据固化方式,阻焊油墨有感光显影型的油墨,有热固化的热固油墨,还有UV光固化的UV油墨。而根据板材分类,又有PCB硬板阻焊油墨,FPC软板阻焊油墨,还有铝基板阻焊油墨,铝基板油墨也可以用…...

【代码随想录】刷题Day2

1.左右指针比大小 977. 有序数组的平方 class Solution { public:vector<int> sortedSquares(vector<int>& nums) {vector<int> ret nums;int left 0;int right nums.size()-1;int end nums.size();while(left<right){if(abs(nums[left])>abs…...

Python机器学习、深度学习技术提升气象、海洋、水文领域实践应用

Python是功能强大、免费、开源,实现面向对象的编程语言,在数据处理、科学计算、数学建模、数据挖掘和数据可视化方面具备优异的性能,这些优势使得Python在气象、海洋、地理、气候、水文和生态等地学领域的科研和工程项目中得到广泛应用。可以…...

挑战杯推荐项目

“人工智能”创意赛 - 智能艺术创作助手:借助大模型技术,开发能根据用户输入的主题、风格等要求,生成绘画、音乐、文学作品等多种形式艺术创作灵感或初稿的应用,帮助艺术家和创意爱好者激发创意、提高创作效率。 - 个性化梦境…...

Spring Boot+Neo4j知识图谱实战:3步搭建智能关系网络!

一、引言 在数据驱动的背景下,知识图谱凭借其高效的信息组织能力,正逐步成为各行业应用的关键技术。本文聚焦 Spring Boot与Neo4j图数据库的技术结合,探讨知识图谱开发的实现细节,帮助读者掌握该技术栈在实际项目中的落地方法。 …...

【HTML-16】深入理解HTML中的块元素与行内元素

HTML元素根据其显示特性可以分为两大类:块元素(Block-level Elements)和行内元素(Inline Elements)。理解这两者的区别对于构建良好的网页布局至关重要。本文将全面解析这两种元素的特性、区别以及实际应用场景。 1. 块元素(Block-level Elements) 1.1 基本特性 …...

uniapp中使用aixos 报错

问题: 在uniapp中使用aixos,运行后报如下错误: AxiosError: There is no suitable adapter to dispatch the request since : - adapter xhr is not supported by the environment - adapter http is not available in the build 解决方案&…...

DeepSeek 技术赋能无人农场协同作业:用 AI 重构农田管理 “神经网”

目录 一、引言二、DeepSeek 技术大揭秘2.1 核心架构解析2.2 关键技术剖析 三、智能农业无人农场协同作业现状3.1 发展现状概述3.2 协同作业模式介绍 四、DeepSeek 的 “农场奇妙游”4.1 数据处理与分析4.2 作物生长监测与预测4.3 病虫害防治4.4 农机协同作业调度 五、实际案例大…...

管理学院权限管理系统开发总结

文章目录 🎓 管理学院权限管理系统开发总结 - 现代化Web应用实践之路📝 项目概述🏗️ 技术架构设计后端技术栈前端技术栈 💡 核心功能特性1. 用户管理模块2. 权限管理系统3. 统计报表功能4. 用户体验优化 🗄️ 数据库设…...

推荐 github 项目:GeminiImageApp(图片生成方向,可以做一定的素材)

推荐 github 项目:GeminiImageApp(图片生成方向,可以做一定的素材) 这个项目能干嘛? 使用 gemini 2.0 的 api 和 google 其他的 api 来做衍生处理 简化和优化了文生图和图生图的行为(我的最主要) 并且有一些目标检测和切割(我用不到) 视频和 imagefx 因为没 a…...

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。 尽管 VLMs 取得了显著进展,机器人仍难以胜任复杂的长时程任务(如家具装配),主要受限于人…...

[ACTF2020 新生赛]Include 1(php://filter伪协议)

题目 做法 启动靶机,点进去 点进去 查看URL,有 ?fileflag.php说明存在文件包含,原理是php://filter 协议 当它与包含函数结合时,php://filter流会被当作php文件执行。 用php://filter加编码,能让PHP把文件内容…...

嵌入式常见 CPU 架构

架构类型架构厂商芯片厂商典型芯片特点与应用场景PICRISC (8/16 位)MicrochipMicrochipPIC16F877A、PIC18F4550简化指令集,单周期执行;低功耗、CIP 独立外设;用于家电、小电机控制、安防面板等嵌入式场景8051CISC (8 位)Intel(原始…...