Factorization Machines(论文笔记)

样例一:

一个简单的例子,train是一个字典,先将train进行“one-hot” coding,然后输入相关特征向量,可以预测相关性。

from pyfm import pylibfm

from sklearn.feature_extraction import DictVectorizer

import numpy as np

train = [{"user": "1", "item": "5", "age": 19},{"user": "2", "item": "43", "age": 33},{"user": "3", "item": "20", "age": 55},{"user": "4", "item": "10", "age": 20},

]

v = DictVectorizer()

X = v.fit_transform(train)

print(X.toarray())

y = np.repeat(1.0,X.shape[0])

#print(X.shape[0])

fm = pylibfm.FM()

fm.fit(X,y)

fm.predict(v.transform({"user": "1", "item": "10", "age": 40}))

输出:

[[19. 0. 0. 0. 1. 1. 0. 0. 0.][33. 0. 0. 1. 0. 0. 1. 0. 0.][55. 0. 1. 0. 0. 0. 0. 1. 0.][20. 1. 0. 0. 0. 0. 0. 0. 1.]]

4

Creating validation dataset of 0.01 of training for adaptive regularization

-- Epoch 1

Training log loss: 0.37518

array([0.9999684])

样例二:

是基于真实的电影评分数据来训练。数据集点击下载即可。

import numpy as np

from sklearn.feature_extraction import DictVectorizer

from pyfm import pylibfm# Read in data

def loadData(filename,path="ml-100k/"):data = []y = []users=set()items=set()with open(path+filename) as f:for line in f:(user,movieid,rating,ts)=line.split('\t')data.append({ "user_id": str(user), "movie_id": str(movieid)})y.append(float(rating))users.add(user)items.add(movieid)return (data, np.array(y), users, items)(train_data, y_train, train_users, train_items) = loadData("ua.base")

(test_data, y_test, test_users, test_items) = loadData("ua.test")

v = DictVectorizer()

X_train = v.fit_transform(train_data)

X_test = v.transform(test_data)# Build and train a Factorization Machine

fm = pylibfm.FM(num_factors=10, num_iter=100, verbose=True, task="regression", initial_learning_rate=0.001, learning_rate_schedule="optimal")fm.fit(X_train,y_train)# Evaluate

preds = fm.predict(X_test)

from sklearn.metrics import mean_squared_error

print("FM MSE: %.4f" % mean_squared_error(y_test,preds))

输出:

Creating validation dataset of 0.01 of training for adaptive regularization

-- Epoch 1

Training MSE: 0.59525

-- Epoch 2

Training MSE: 0.51804

-- Epoch 3

Training MSE: 0.49046

-- Epoch 4

Training MSE: 0.47458

-- Epoch 5

Training MSE: 0.46416

-- Epoch 6

Training MSE: 0.45662

-- Epoch 7

Training MSE: 0.45099

-- Epoch 8

Training MSE: 0.44639

-- Epoch 9

Training MSE: 0.44264

-- Epoch 10

Training MSE: 0.43949

-- Epoch 11

Training MSE: 0.43675

-- Epoch 12

Training MSE: 0.43430

-- Epoch 13

Training MSE: 0.43223

-- Epoch 14

Training MSE: 0.43020

-- Epoch 15

Training MSE: 0.42851

-- Epoch 16

Training MSE: 0.42691

-- Epoch 17

Training MSE: 0.42531

-- Epoch 18

Training MSE: 0.42389

-- Epoch 19

Training MSE: 0.42255

-- Epoch 20

Training MSE: 0.42128

-- Epoch 21

Training MSE: 0.42003

-- Epoch 22

Training MSE: 0.41873

-- Epoch 23

Training MSE: 0.41756

-- Epoch 24

Training MSE: 0.41634

-- Epoch 25

Training MSE: 0.41509

-- Epoch 26

Training MSE: 0.41391

-- Epoch 27

Training MSE: 0.41274

-- Epoch 28

Training MSE: 0.41149

-- Epoch 29

Training MSE: 0.41032

-- Epoch 30

Training MSE: 0.40891

-- Epoch 31

Training MSE: 0.40774

-- Epoch 32

Training MSE: 0.40635

-- Epoch 33

Training MSE: 0.40495

-- Epoch 34

Training MSE: 0.40354

-- Epoch 35

Training MSE: 0.40203

-- Epoch 36

Training MSE: 0.40047

-- Epoch 37

Training MSE: 0.39889

-- Epoch 38

Training MSE: 0.39728

-- Epoch 39

Training MSE: 0.39562

-- Epoch 40

Training MSE: 0.39387

-- Epoch 41

Training MSE: 0.39216

-- Epoch 42

Training MSE: 0.39030

-- Epoch 43

Training MSE: 0.38847

-- Epoch 44

Training MSE: 0.38655

-- Epoch 45

Training MSE: 0.38461

-- Epoch 46

Training MSE: 0.38269

-- Epoch 47

Training MSE: 0.38068

-- Epoch 48

Training MSE: 0.37864

-- Epoch 49

Training MSE: 0.37657

-- Epoch 50

Training MSE: 0.37459

-- Epoch 51

Training MSE: 0.37253

-- Epoch 52

Training MSE: 0.37045

-- Epoch 53

Training MSE: 0.36845

-- Epoch 54

Training MSE: 0.36647

-- Epoch 55

Training MSE: 0.36448

-- Epoch 56

Training MSE: 0.36254

-- Epoch 57

Training MSE: 0.36067

-- Epoch 58

Training MSE: 0.35874

-- Epoch 59

Training MSE: 0.35690

-- Epoch 60

Training MSE: 0.35511

-- Epoch 61

Training MSE: 0.35333

-- Epoch 62

Training MSE: 0.35155

-- Epoch 63

Training MSE: 0.34992

-- Epoch 64

Training MSE: 0.34829

-- Epoch 65

Training MSE: 0.34675

-- Epoch 66

Training MSE: 0.34538

-- Epoch 67

Training MSE: 0.34393

-- Epoch 68

Training MSE: 0.34258

-- Epoch 69

Training MSE: 0.34129

-- Epoch 70

Training MSE: 0.34006

-- Epoch 71

Training MSE: 0.33885

-- Epoch 72

Training MSE: 0.33773

-- Epoch 73

Training MSE: 0.33671

-- Epoch 74

Training MSE: 0.33564

-- Epoch 75

Training MSE: 0.33468

-- Epoch 76

Training MSE: 0.33375

-- Epoch 77

Training MSE: 0.33292

-- Epoch 78

Training MSE: 0.33211

-- Epoch 79

Training MSE: 0.33131

-- Epoch 80

Training MSE: 0.33065

-- Epoch 81

Training MSE: 0.33002

-- Epoch 82

Training MSE: 0.32930

-- Epoch 83

Training MSE: 0.32882

-- Epoch 84

Training MSE: 0.32813

-- Epoch 85

Training MSE: 0.32764

-- Epoch 86

Training MSE: 0.32722

-- Epoch 87

Training MSE: 0.32677

-- Epoch 88

Training MSE: 0.32635

-- Epoch 89

Training MSE: 0.32591

-- Epoch 90

Training MSE: 0.32550

-- Epoch 91

Training MSE: 0.32513

-- Epoch 92

Training MSE: 0.32481

-- Epoch 93

Training MSE: 0.32451

-- Epoch 94

Training MSE: 0.32421

-- Epoch 95

Training MSE: 0.32397

-- Epoch 96

Training MSE: 0.32363

-- Epoch 97

Training MSE: 0.32341

-- Epoch 98

Training MSE: 0.32319

-- Epoch 99

Training MSE: 0.32293

-- Epoch 100

Training MSE: 0.32268

FM MSE: 0.8873样例三:是一个分类的样例

import numpy as np

from sklearn.feature_extraction import DictVectorizer

from sklearn.model_selection import train_test_split

from pyfm import pylibfmfrom sklearn.datasets import make_classificationX, y = make_classification(n_samples=1000,n_features=100, n_clusters_per_class=1)

data = [ {v: k for k, v in dict(zip(i, range(len(i)))).items()} for i in X]X_train, X_test, y_train, y_test = train_test_split(data, y, test_size=0.1, random_state=42)v = DictVectorizer()

X_train = v.fit_transform(X_train)

X_test = v.transform(X_test)fm = pylibfm.FM(num_factors=50, num_iter=10, verbose=True, task="classification", initial_learning_rate=0.0001, learning_rate_schedule="optimal")fm.fit(X_train,y_train)from sklearn.metrics import log_loss

print("Validation log loss: %.4f" % log_loss(y_test,fm.predict(X_test)))

输出:

Creating validation dataset of 0.01 of training for adaptive regularization

-- Epoch 1

Training log loss: 2.12467

-- Epoch 2

Training log loss: 1.74185

-- Epoch 3

Training log loss: 1.42232

-- Epoch 4

Training log loss: 1.16085

-- Epoch 5

Training log loss: 0.94964

-- Epoch 6

Training log loss: 0.78052

-- Epoch 7

Training log loss: 0.64547

-- Epoch 8

Training log loss: 0.53758

-- Epoch 9

Training log loss: 0.45132

-- Epoch 10

Training log loss: 0.38187

Validation log loss: 1.3678代码:pyFM/pyfm/pylibfm.py at master · coreylynch/pyFM (github.com)

相关文章:

)

Factorization Machines(论文笔记)

样例一: 一个简单的例子,train是一个字典,先将train进行“one-hot” coding,然后输入相关特征向量,可以预测相关性。 from pyfm import pylibfm from sklearn.feature_extraction import DictVectorizer import numpy as np tra…...

——使用QTimer定时触发槽函数)

Qt开发(5)——使用QTimer定时触发槽函数

实现效果 软件启动之后,开始计时,到达预定时间后,调用其他类的某个函数。 类的分工 BaseType:软件初始化的调用类 FuncType: 功能函数所在类 具体函数 // FuncType.h class FuncType: public QObject {Q_OBJECT public: publ…...

2023年JAVA最新面试题

2023年JAVA最新面试题 1 JavaWeb基础1.1 HashMap的底层实现原理?1.2 HashMap 和 HashTable的异同?1.5 Collection 和 Collections的区别?1.6 Collection接口的两种区别1.7 ArrayList、LinkedList、Vector者的异同?1.8 String、Str…...

(四)RabbitMQ高级特性(消费端限流、利用限流实现不公平分发、消息存活时间、优先级队列

Lison <dreamlison163.com>, v1.0.0, 2023.06.23 RabbitMQ高级特性(消费端限流、利用限流实现不公平分发、消息存活时间、优先级队列 文章目录 RabbitMQ高级特性(消费端限流、利用限流实现不公平分发、消息存活时间、优先级队列消费端限流利用限流…...

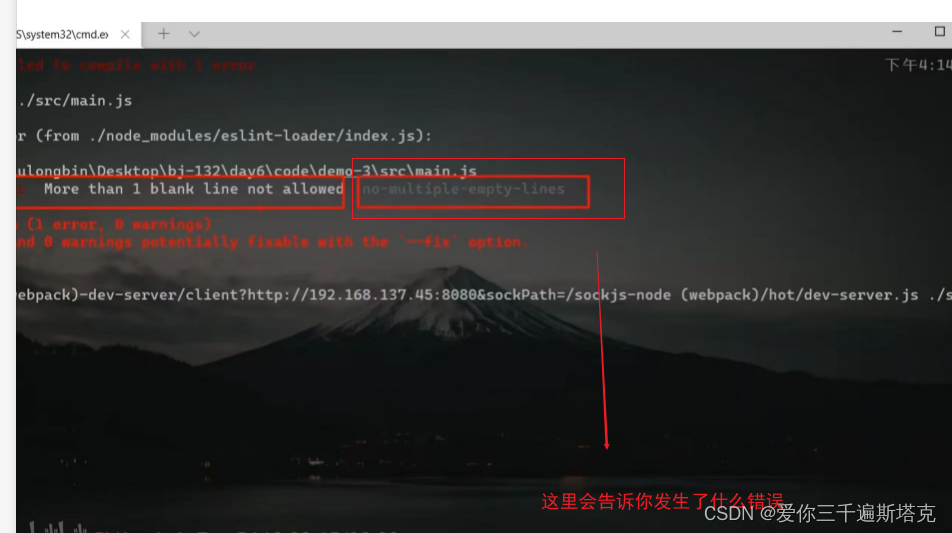

Vue如何配置eslint

eslint官网: eslint.bootcss.com eslicate如何配置 1、选择新的配置: 2、选择三个必选项 3、再选择Css预处理器 4、之后选择处理器 5、选择是提交的时候就进行保存模式 6、放到独立的配置文件上去 7、最后一句是将自己的数据存为预设 8、配合console不要出现的规则…...

Elasticsearch查询文档

GET查询索引单个文档 GET /索引/_doc/ID GET /ffbf/_doc/123返回结果如下,查到了有数据"found" : true表示 {"_index" : "ffbf","_type" : "_doc","_id" : "123","_version" : 2...

面向对象编程:多态性的理论与实践

文章目录 1. 修饰词和访问权限2. 多态的概念3. 多态的使用现象4. 多态的问题与解决5. 多态的意义 在面向对象编程中,多态是一个重要的概念,它允许不同的对象以不同的方式响应相同的消息。本文将深入探讨多态的概念及其应用,以及在Java中如何实…...

linux:filezilla root密码登陆

问题: 如题 参考: 亚马逊服务器FileZilla登录失败解决办法_亚马逊云 ssh链接秘钥认证不了 ubuntu拒绝root用户ssh远程登录解决办法 总结: vi /etc/ssh/sshd_config,修改配置: PermitRootLogin yes PasswordAuthenticat…...

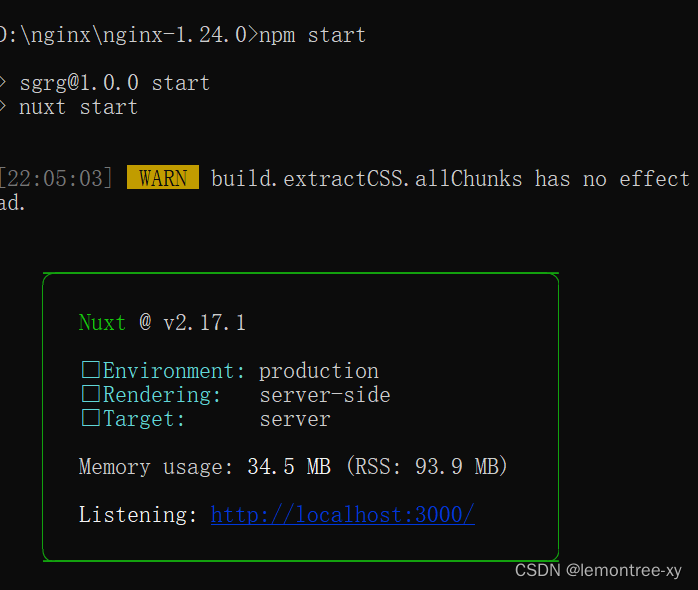

在nginx上部署nuxt项目

先安装Node.js 我安的18.17.0。 安装完成后,可以使用cmd,winr然cmd进入,测试是否安装成功。安装在哪个盘都可以测试。 测试 输入node -v 和 npm -v,(中间有空格)出现下图版本提示就是完成了NodeJS的安装…...

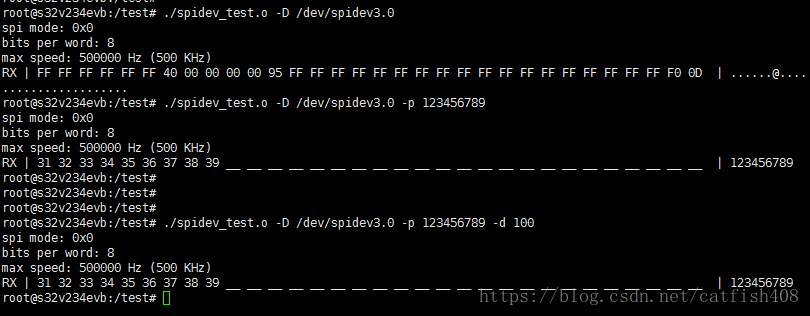

嵌入式linux通用spi驱动之spidev使用总结

Linux内核集成了spidev驱动,提供了SPI设备的用户空间API。支持用于半双工通信的read和write访问接口以及用于全双工通信和I/O配置的ioctl接口。使用时,只需将SPI从设备的compatible属性值添加到spidev区动的spidev dt ids[]数组中,即可将该SP…...

【Nodejs】Puppeteer\爬虫实践

puppeteer 文档:puppeteer.js中文文档|puppeteerjs中文网|puppeteer爬虫教程 Puppeteer本身依赖6.4以上的Node,但是为了异步超级好用的async/await,推荐使用7.6版本以上的Node。另外headless Chrome本身对服务器依赖的库的版本要求比较高,c…...

Windows Active Directory密码同步

大多数 IT 环境中,员工需要记住其默认 Windows Active Directory (AD) 帐户以外的帐户的单独凭据,最重要的是,每个密码还受不同的密码策略和到期日期的约束,为不同的帐户使用单独的密码会增加用户忘记密码和…...

安科瑞能源物联网以能源供应、能源管理、设备管理、能耗分析的能源流向为主线-安科瑞黄安南

摘要:随着科学技术的发展,我国的物联网技术有了很大进展。为了提升电力抄表服务的稳定性,保障电力抄表数据的可靠性,本文提出并实现了基于物联网的智能电力抄表服务平台,结合云计算、大数据等技术,提供电力…...

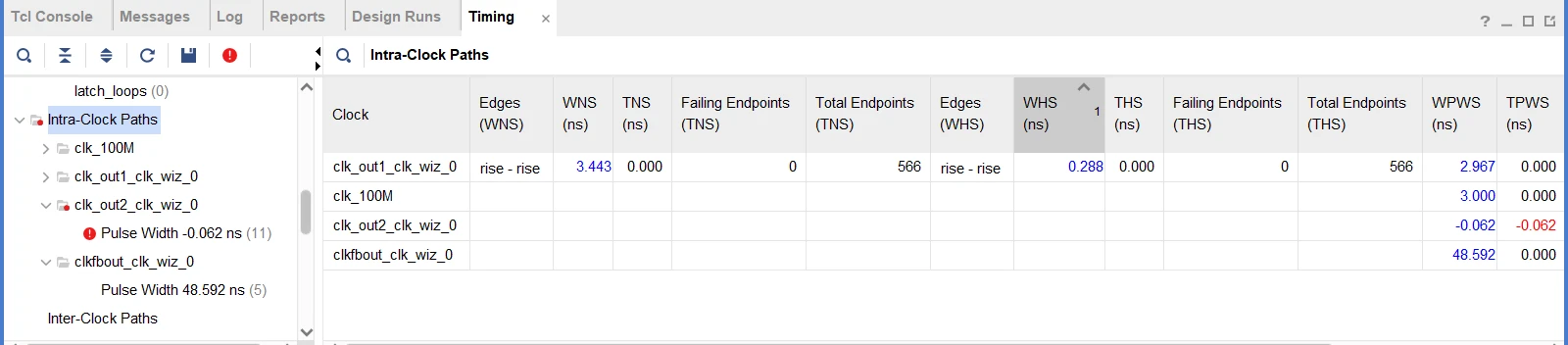

FPGA设计时序分析一、时序路径

目录 一、前言 二、时序路径 2.1 时序路径构成 2.2 时序路径分类 2.3 数据捕获 2.4 Fast corner/Slow corner 2.5 Vivado时序报告 三、参考资料 一、前言 时序路径字面容易简单地理解为时钟路径,事实时钟存在的意义是为了数据的处理、传输,因此严…...

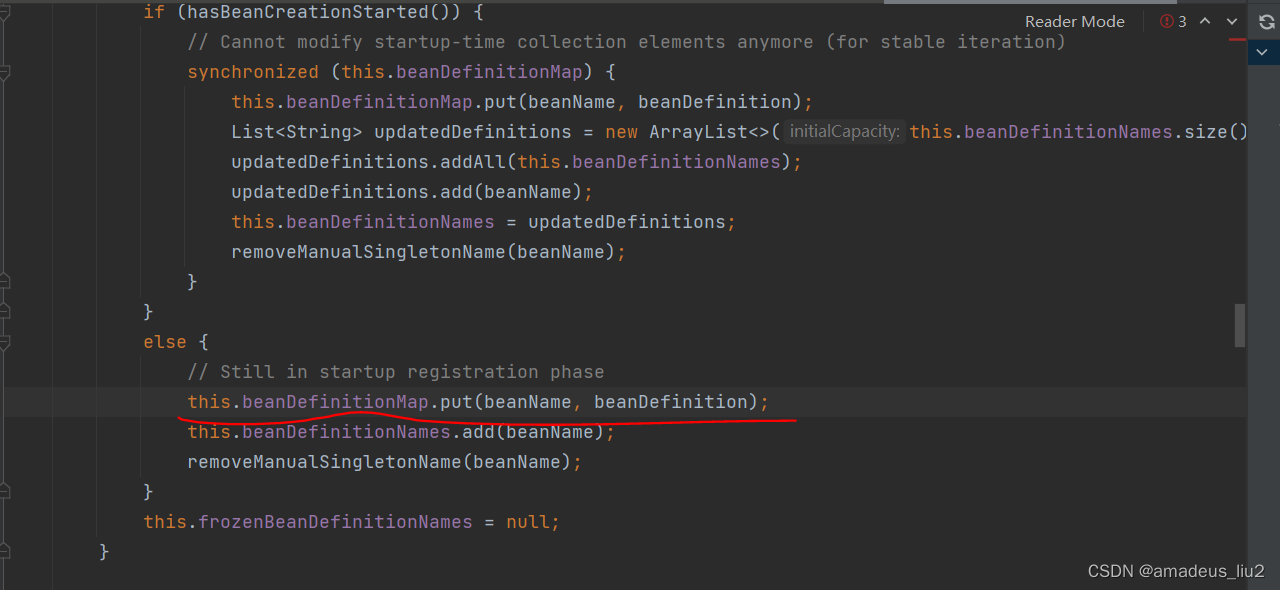

spring复习:(52)注解方式下,ConfigurationClassPostProcessor是怎么被添加到容器的?

进入AnnotationConfigApplicationContext的构造方法: 进入AnnotatedBeanDefinitionReader的构造方法: 进入this(registry, getOrCreateEnvironment(registry));代码如下: 进入AnnotationConfigUtils.registerAnnotationConfigProcessors方…...

全国大学生数据统计与分析竞赛2021年【本科组】-B题:用户消费行为价值分析

目录 摘 要 1 任务背景与重述 1.1 任务背景 1.2 任务重述 2 任务分析 3 数据假设 4 任务求解 4.1 任务一:数据预处理 4.1.1 数据清洗 4.1.2 数据集成 4.1.3 数据变换 4.2 任务二:对用户城市分布情况与分布情况可视化分析 4.2.1 城市分布情况可视化分析 4…...

力扣1667. 修复表中的名字

表: Users ------------------------- | Column Name | Type | ------------------------- | user_id | int | | name | varchar | ------------------------- 在 SQL 中,user_id 是该表的主键。 该表包含用户的 ID 和名字。…...

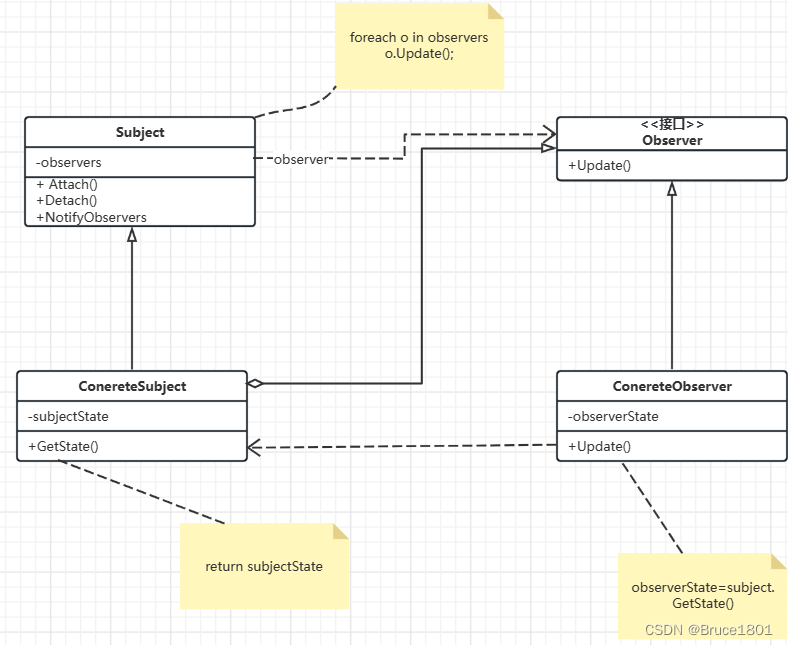

【设计模式】详解观察者模式

文章目录 1、简介2、观察者模式简单实现抽象主题(Subject)具体主题(ConcreteSubject)抽象观察者(Observer)具体观察者(ConcrereObserver)测试: 观察者设计模式优缺点观察…...

用html+javascript打造公文一键排版系统8:附件及标题排版

最近工作有点忙,所 以没能及时完善公文一键排版系统,现在只好熬夜更新一下。 有时公文有包括附件,招照公文排版规范: 附件应当另面编排,并在版记之前,与公文正文一起装订。“附件”二字及附件顺序号用3号黑…...

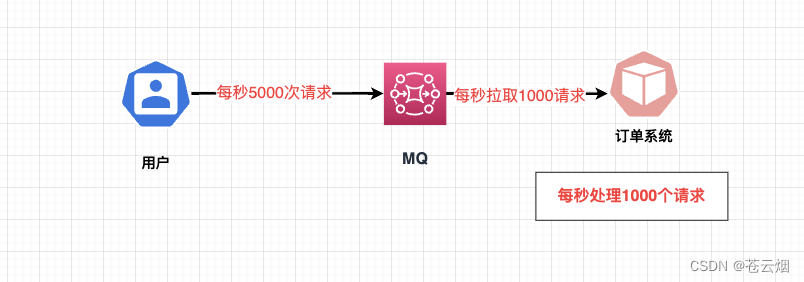

微服务体系<1>

我们的微服务架构 我们的微服务架构和单体架构的区别 什么是微服务架构 微服务就是吧我们传统的单体服务分成 订单模块 库存模块 账户模块单体模块 是本地调用 从订单模块 调用到库存模块 再到账户模块 这三个模块都是调用的同一个数据库 这就是我们的单体架构微服务 就是…...

Chapter03-Authentication vulnerabilities

文章目录 1. 身份验证简介1.1 What is authentication1.2 difference between authentication and authorization1.3 身份验证机制失效的原因1.4 身份验证机制失效的影响 2. 基于登录功能的漏洞2.1 密码爆破2.2 用户名枚举2.3 有缺陷的暴力破解防护2.3.1 如果用户登录尝试失败次…...

Lombok 的 @Data 注解失效,未生成 getter/setter 方法引发的HTTP 406 错误

HTTP 状态码 406 (Not Acceptable) 和 500 (Internal Server Error) 是两类完全不同的错误,它们的含义、原因和解决方法都有显著区别。以下是详细对比: 1. HTTP 406 (Not Acceptable) 含义: 客户端请求的内容类型与服务器支持的内容类型不匹…...

CVPR 2025 MIMO: 支持视觉指代和像素grounding 的医学视觉语言模型

CVPR 2025 | MIMO:支持视觉指代和像素对齐的医学视觉语言模型 论文信息 标题:MIMO: A medical vision language model with visual referring multimodal input and pixel grounding multimodal output作者:Yanyuan Chen, Dexuan Xu, Yu Hu…...

【HarmonyOS 5.0】DevEco Testing:鸿蒙应用质量保障的终极武器

——全方位测试解决方案与代码实战 一、工具定位与核心能力 DevEco Testing是HarmonyOS官方推出的一体化测试平台,覆盖应用全生命周期测试需求,主要提供五大核心能力: 测试类型检测目标关键指标功能体验基…...

渲染学进阶内容——模型

最近在写模组的时候发现渲染器里面离不开模型的定义,在渲染的第二篇文章中简单的讲解了一下关于模型部分的内容,其实不管是方块还是方块实体,都离不开模型的内容 🧱 一、CubeListBuilder 功能解析 CubeListBuilder 是 Minecraft Java 版模型系统的核心构建器,用于动态创…...

跨链模式:多链互操作架构与性能扩展方案

跨链模式:多链互操作架构与性能扩展方案 ——构建下一代区块链互联网的技术基石 一、跨链架构的核心范式演进 1. 分层协议栈:模块化解耦设计 现代跨链系统采用分层协议栈实现灵活扩展(H2Cross架构): 适配层…...

HarmonyOS运动开发:如何用mpchart绘制运动配速图表

##鸿蒙核心技术##运动开发##Sensor Service Kit(传感器服务)# 前言 在运动类应用中,运动数据的可视化是提升用户体验的重要环节。通过直观的图表展示运动过程中的关键数据,如配速、距离、卡路里消耗等,用户可以更清晰…...

【7色560页】职场可视化逻辑图高级数据分析PPT模版

7种色调职场工作汇报PPT,橙蓝、黑红、红蓝、蓝橙灰、浅蓝、浅绿、深蓝七种色调模版 【7色560页】职场可视化逻辑图高级数据分析PPT模版:职场可视化逻辑图分析PPT模版https://pan.quark.cn/s/78aeabbd92d1...

虚拟电厂发展三大趋势:市场化、技术主导、车网互联

市场化:从政策驱动到多元盈利 政策全面赋能 2025年4月,国家发改委、能源局发布《关于加快推进虚拟电厂发展的指导意见》,首次明确虚拟电厂为“独立市场主体”,提出硬性目标:2027年全国调节能力≥2000万千瓦࿰…...

Redis:现代应用开发的高效内存数据存储利器

一、Redis的起源与发展 Redis最初由意大利程序员Salvatore Sanfilippo在2009年开发,其初衷是为了满足他自己的一个项目需求,即需要一个高性能的键值存储系统来解决传统数据库在高并发场景下的性能瓶颈。随着项目的开源,Redis凭借其简单易用、…...