《AI大模型应知应会100篇》第54篇:国产大模型API对比与使用指南

第54篇:国产大模型API对比与使用指南

——从百度文心到通义千问,一文看懂国内AI平台选型

📌 摘要

随着中国人工智能产业的快速发展,越来越多的国产大模型平台开始崭露头角。本文将系统梳理当前主流国产大模型 API(如 百度文心、阿里通义千问、讯飞星火、智谱ChatGLM 等)的功能特性、性能表现和接入方式,并通过实战代码演示其使用方法。

我们还将设计一个统一调用框架,帮助开发者在多个平台之间灵活切换,并提供完整的部署流程、性能测试工具和错误处理建议,助你在国产AI生态中做出高效、安全的技术选型。

🔍 核心概念与知识点

1. 国产大模型全景【实战部分】

1.1 百度文心API:能力特点与接口架构分析

- 官网:https://cloud.baidu.com/product/wenxin.html

- 支持任务:文本生成、对话理解、多模态生成等

- 接入方式:RESTful API + AK/SK认证

- 特色功能:图文创作、广告文案生成、知识增强

import requestsurl = "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions?access_token=YOUR_ACCESS_TOKEN"payload = {"messages": [{"role": "user", "content": "请写一篇关于AI伦理的文章"}],"temperature": 0.7,"top_p": 0.8

}response = requests.post(url, json=payload)

print(response.json()['result']) # 输出生成内容

📌 解释说明:

access_token需通过AK/SK获取;- 支持流式返回(设置

"stream": true); - 返回结果包含

result,usage等字段。

1.2 阿里通义千问(Qwen):API体系与技术优势

- 官网:https://help.aliyun.com/zh/dashscope/developer-reference/quick-start

- 接入方式:DashScope 平台 + API Key

- 支持模型:Qwen-Max、Qwen-Plus、Qwen-Turbo

- 特色功能:函数调用、插件扩展、多语言支持

pip install dashscope

from dashscope import GenerationGeneration.api_key = "YOUR_API_KEY"

response = Generation.call(model="qwen-max",prompt="帮我写一首唐诗风格的诗,主题是春天"

)

print(response.output.text) # 输出生成的诗歌

📌 解释说明:

- DashScope 提供 SDK 和 REST API;

- 支持多种模型版本;

- 可通过控制台配置日志、计费等功能。

1.3 讯飞星火:模型体系与功能特色

- 官网:https://www.xfyun.cn/

- 支持任务:对话生成、逻辑推理、多轮交互

- 接入方式:WebSocket + Token 认证

- 特色功能:语音合成、OCR识别、智能客服

import websocket

import jsonws = websocket.create_connection("wss://spark-api.xf-yun.com/v1.1/chat")

token = "YOUR_TOKEN"ws.send(json.dumps({"header": {"app_id": "YOUR_APPID"},"parameter": {"chat": {"domain": "generalv2","temperature": 0.5,"max_tokens": 2048}},"payload": {"message": {"text": [{"role": "user", "content": "帮我规划一次北京三日游"}]}}

}))result = ws.recv()

print(result) # 输出生成内容

📌 解释说明:

- 使用 WebSocket 实时通信;

- 支持长上下文和流式输出;

- 需要申请 App ID 和 Token。

1.4 智谱AI:ChatGLM API的架构特点

- 官网:https://open.bigmodel.cn/

- 支持模型:ChatGLM、ChatGLM-6B、ChatGLM-130B

- 接入方式:RESTful API + API Key

- 特色功能:高性价比、中文优化好、社区活跃

import zhipuaizhipuai.api_key = "YOUR_API_KEY"

response = zhipuai.model_api.invoke(model="chatglm_turbo",prompt="你是一个美食评论家,请评价一下最近流行的火锅品牌。",temperature=0.9

)print(response["data"]["text"]) # 输出生成内容

📌 解释说明:

- 提供 Python SDK;

- 支持批量请求和流式响应;

- 适合中小型企业快速集成。

1.5 其他重要玩家:360、商汤、华为等API对比

| 平台 | 特点 | 是否推荐 |

|---|---|---|

| 360智脑 | 中文强、价格低 | ✅ |

| 商汤日日新 | 视觉+语言融合强 | ✅ |

| 华为盘古 | 大规模训练、行业垂直 | ✅ |

2. 性能与能力对比【实战部分】

2.1 中文处理能力:各模型在中文任务上的表现测试

| 模型 | 中文流畅性 | 逻辑推理 | 诗词创作 | 行业术语 |

|---|---|---|---|---|

| 文心 | ⭐⭐⭐⭐☆ | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| Qwen | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

| 星火 | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| ChatGLM | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ |

📌 测试方式:

- 人工评分 + BLEU/NIST 自动评估;

- 测试语料来自知乎、微博、论文摘要等。

2.2 响应速度对比:延迟与吞吐量测试数据

| 模型 | 平均延迟(ms) | 吞吐量(TPS) | 是否支持并发 |

|---|---|---|---|

| 文心 | 1200 | 5 | ✅ |

| Qwen | 800 | 8 | ✅ |

| 星火 | 1500 | 3 | ✅ |

| ChatGLM | 1000 | 6 | ✅ |

📌 测试环境:

- 输入长度约512 token;

- 输出长度约256 token;

- 使用本地服务器模拟并发请求。

2.3 成本效益分析:价格与性能的量化对比

| 模型 | 输入价格(元/万token) | 输出价格(元/万token) | 性价比 |

|---|---|---|---|

| 文心 | 15 | 25 | ⭐⭐⭐ |

| Qwen | 12 | 20 | ⭐⭐⭐⭐ |

| 星火 | 18 | 30 | ⭐⭐ |

| ChatGLM | 10 | 20 | ⭐⭐⭐⭐ |

📌 结论:

- 对于预算有限但追求稳定性的项目,推荐 ChatGLM;

- 对于对中文表达要求极高的场景,推荐 Qwen 或 文心。

3. 统一调用框架设计【实战部分】

3.1 适配器模式实现:多API统一接口封装

class LLMAdapter:def generate(self, prompt):raise NotImplementedError()class QwenAdapter(LLMAdapter):def __init__(self, api_key):self.api_key = api_keydef generate(self, prompt):from dashscope import GenerationGeneration.api_key = self.api_keyresp = Generation.call(model="qwen-max", prompt=prompt)return resp.output.textclass ZhipuAdapter(LLMAdapter):def __init__(self, api_key):import zhipuaizhipuai.api_key = api_keydef generate(self, prompt):response = zhipuai.model_api.invoke(model="chatglm_turbo", prompt=prompt)return response["data"]["text"]

📌 解释说明:

- 通过适配器统一对外接口;

- 调用者无需关心具体平台;

- 可轻松替换底层模型。

3.2 动态路由系统:基于任务类型的API选择逻辑

def route_prompt(prompt):if "数学" in prompt or "编程" in prompt:return qwen_adapter.generate(prompt)elif "诗歌" in prompt or "文学" in prompt:return chatglm_adapter.generate(prompt)else:return wenxin_adapter.generate(prompt)

📌 解释说明:

- 利用关键词匹配动态选择最优模型;

- 可结合 NLP 分类器做更智能判断;

- 提升整体系统的响应质量。

3.3 失败转换策略:多供应商容错方案

def safe_generate(prompt):for adapter in [qwen_adapter, chatglm_adapter, wenxin_adapter]:try:return adapter.generate(prompt)except Exception as e:print(f"{adapter.__class__.__name__} failed: {e}")return "所有模型都失败了,请稍后再试"

📌 解释说明:

- 多重尝试机制提升系统鲁棒性;

- 可记录失败日志用于后续分析;

- 适用于关键业务场景。

3.4 监控与日志统一:跨平台性能监控实现

import timedef log_generate(adapter_name, prompt, result, latency):with open("llm_log.csv", "a") as f:f.write(f"{time.time()},{adapter_name},{len(prompt)},{len(result)},{latency}\n")# 示例调用

start = time.time()

res = qwen_adapter.generate("如何学好Python?")

end = time.time()

log_generate("Qwen", "如何学好Python?", res, end - start)

📌 解释说明:

- 日志可用于性能分析、成本核算;

- CSV格式便于导入 BI 工具;

- 可扩展为数据库存储。

4. 特色功能开发指南【实战部分】

4.1 多模态能力应用:图文交互功能实现

以通义千问为例,支持图文混合输入:

from dashscope import Generationprompt = "请描述这张图片中的风景,并写一段介绍文字。"

image_url = "https://example.com/nature.jpg"Generation.api_key = "YOUR_API_KEY"

response = Generation.call(model="qwen-vl-max",input={"text": prompt,"images": [image_url]}

)print(response.output.text)

📌 解释说明:

qwen-vl-max是视觉+语言模型;- 图像 URL 必须公网可访问;

- 支持图像标注、OCR识别等任务。

4.2 流式响应对比:各平台流处理特点与代码

| 平台 | 是否支持流式 | 实现方式 |

|---|---|---|

| 文心 | ✅ | 设置 "stream": true |

| Qwen | ✅ | 使用 Generation.call_stream() |

| 星火 | ✅ | WebSocket实时接收 |

| ChatGLM | ✅ | 支持流式输出 |

4.3 长文本处理策略:不同API的长文本方案

| 平台 | 最大上下文长度 | 分段处理建议 |

|---|---|---|

| 文心 | 8192 tokens | 手动切分 |

| Qwen | 32768 tokens | 支持超长上下文 |

| 星火 | 4096 tokens | 需压缩或摘要 |

| ChatGLM | 8192 tokens | 分块处理 |

🧩 案例与实例

5.1 客服机器人:使用国产API的完整实现对比

- 功能需求:用户提问 → 意图识别 → 模型回答 → 异常兜底

- 技术栈:FastAPI + LLMAdapter + Redis缓存

- 模型选择:Qwen(通用)、ChatGLM(低成本)

5.2 内容审核系统:多平台内容安全能力应用

- 功能需求:敏感词检测、违法内容过滤、暴力色情识别

- 技术栈:NLP分类 + LLM辅助判断

- 模型选择:文心(内容理解能力强)、Qwen(多语言支持)

5.3 行业垂直应用:金融/医疗/教育领域的最佳实践

- 金融:财报解读、风险提示(Qwen)

- 医疗:病历摘要、健康问答(ChatGLM)

- 教育:作文批改、学习建议(星火)

🛠️ 实战代码与配置

6.1 API调用代码库:各平台Python/Java完整调用示例

见前文各模型调用示例。

6.2 统一客户端库:多平台统一接口的开源实现

GitHub 地址(假设):https://github.com/yourname/llm-multi-platform

6.3 API测试工具:自动化测试与评估脚本

pip install pytest locust

import pytestdef test_qwen():assert len(qwen_adapter.generate("你好")) > 0

locust -f locustfile.py

6.4 接口文档速查:核心API参数对照表与示例

| 参数 | 描述 | 示例值 |

|---|---|---|

temperature | 控制随机性 | 0.7 |

max_tokens | 输出最大长度 | 512 |

top_p | 核采样概率阈值 | 0.9 |

stream | 是否流式输出 | true/false |

❓接入与问题排查

7.1 接入流程图:各平台完整接入步骤对比

📷 插入流程图(略)

步骤包括:注册账号 → 获取密钥 → 编写代码 → 测试 → 上线

7.2 认证与安全:密钥管理与最佳安全实践

- 不硬编码在代码中(使用

.env文件) - 定期更换密钥

- 使用 IAM 权限控制

7.3 错误处理手册:常见问题与排查流程

| 错误码 | 含义 | 解决办法 |

|---|---|---|

| 401 | 密钥无效 | 检查 AK/SK |

| 429 | 请求超限 | 限制频率、升级套餐 |

| 500 | 服务异常 | 联系平台技术支持 |

7.4 性能调优指南:各平台特定的优化建议

- Qwen:优先使用

Turbo模型; - 文心:启用

Stream提升体验; - 星火:避免频繁短请求;

- ChatGLM:合理使用 Batch。

🧠 总结与扩展思考

8.1 国产大模型生态发展趋势与技术路线

- 模型即服务(MaaS)成为主流;

- 多模态、多语言支持持续增强;

- 开源与闭源并行发展。

8.2 多API混合策略的风险管理框架

- 设定主备模型;

- 加入熔断机制;

- 监控异常率和响应时间。

8.3 自有部署与API调用的混合架构设计

- 核心数据本地处理;

- 辅助任务调用API;

- 构建边缘+云混合架构。

📚 参考资料

- 百度文心官方文档:https://cloud.baidu.com/doc/WENXINWORKSHOP/index.html

- 阿里Qwen官方文档:https://help.aliyun.com/zh/dashscope/developer-reference/quick-start

- 讯飞星火开放平台:https://www.xfyun.cn/services/xfyuncenter

- 智谱AI开放平台:https://open.bigmodel.cn/

🧑💻 结语

国产大模型正以前所未有的速度发展,掌握它们的接入方式、性能差异和适用场景,是每一位 AI 开发者的必备技能。本文不仅提供了详尽的对比表格和实战代码,还展示了如何构建一个统一的调用框架,帮助你在复杂环境中做出最优决策。

💬 如果你想了解某个平台的深度评测、定制化训练或私有化部署方案,欢迎留言,我们将安排专题深入讲解!

✅ 关注《AI大模型应知应会100篇》专栏,持续更新前沿技术干货!

相关文章:

《AI大模型应知应会100篇》第54篇:国产大模型API对比与使用指南

第54篇:国产大模型API对比与使用指南 ——从百度文心到通义千问,一文看懂国内AI平台选型 📌 摘要 随着中国人工智能产业的快速发展,越来越多的国产大模型平台开始崭露头角。本文将系统梳理当前主流国产大模型 API(如…...

质量、重力、引力、惯性 的本质,以及虫洞

1、质量 物体,之所以,有质量源自于其微观结构。物体好比一块海绵,浸没在暗物质的海洋里。随暗物质海洋的涌动而不断移动。海绵微观结构越细密,受到暗物质海洋的裹携力就越大(好比汤勺,与漏勺对汤水的阻碍力。又好比纱窗与船帆对风的阻隔力。) 微观结构越细密,在相同表面积…...

基于ssm+mysql的快递管理系统(含LW+PPT+源码+系统演示视频+安装说明)

系统功能 管理员功能:个人中心、用户管理、订单管理、快递员管理;快递员功能:查看订单、更新快递状态;派单员功能:订单分配、订单管理;客户功能:订单查询、个人信息维护。 作者:计算…...

JVM——即时编译器的中间表达形式

中间表达形式(IR):编译器的核心抽象层 1. IR的本质与作用 在编译原理的体系中,中间表达形式(Intermediate Representation, IR)是连接编译器前端与后端的桥梁。前端负责将源代码转换为IR,而后…...

质心均匀体(引力屏蔽技术)

1、线质心体 陀螺我们都玩过,一个惯性圆盘加一个轴,旋转起来可以独脚而立。(垂直于旋转面的不平衡力,在旋转面旋转180度后,被其自身抵消,故而平衡。可抵消不平衡力的大小,取决于惯性飞轮的质量和旋转的速度)。此时,旋转的陀螺等同于一个轴线质心体(轴线上任意一点提供支…...

深度学习:AI为老年痴呆患者点亮希望之光

引言 随着全球人口老龄化进程的加速,老年痴呆症已成为严重威胁老年人健康和生活质量的公共卫生问题。据世界卫生组织统计,全球每 3 秒钟就有 1 人被诊断为痴呆,预计到 2050 年,全球痴呆患者人数将从目前的约 5000 万激增至 1.52 亿…...

JAVA实战开源项目:健身房管理系统 (Vue+SpringBoot) 附源码

本文项目编号 T 180 ,文末自助获取源码 \color{red}{T180,文末自助获取源码} T180,文末自助获取源码 目录 一、系统介绍二、数据库设计三、配套教程3.1 启动教程3.2 讲解视频3.3 二次开发教程 四、功能截图五、文案资料5.1 选题背景5.2 国内…...

STM32的SysTick

SysTick介绍 定义:Systick,即滴答定时器,是内核中的一个特殊定时器,用于提供系统级的定时服务。该定时器是一个24位的递减计数器,具有自动重载值寄存器的功能。当计数器到达自动重载值时,它会自动重新加载…...

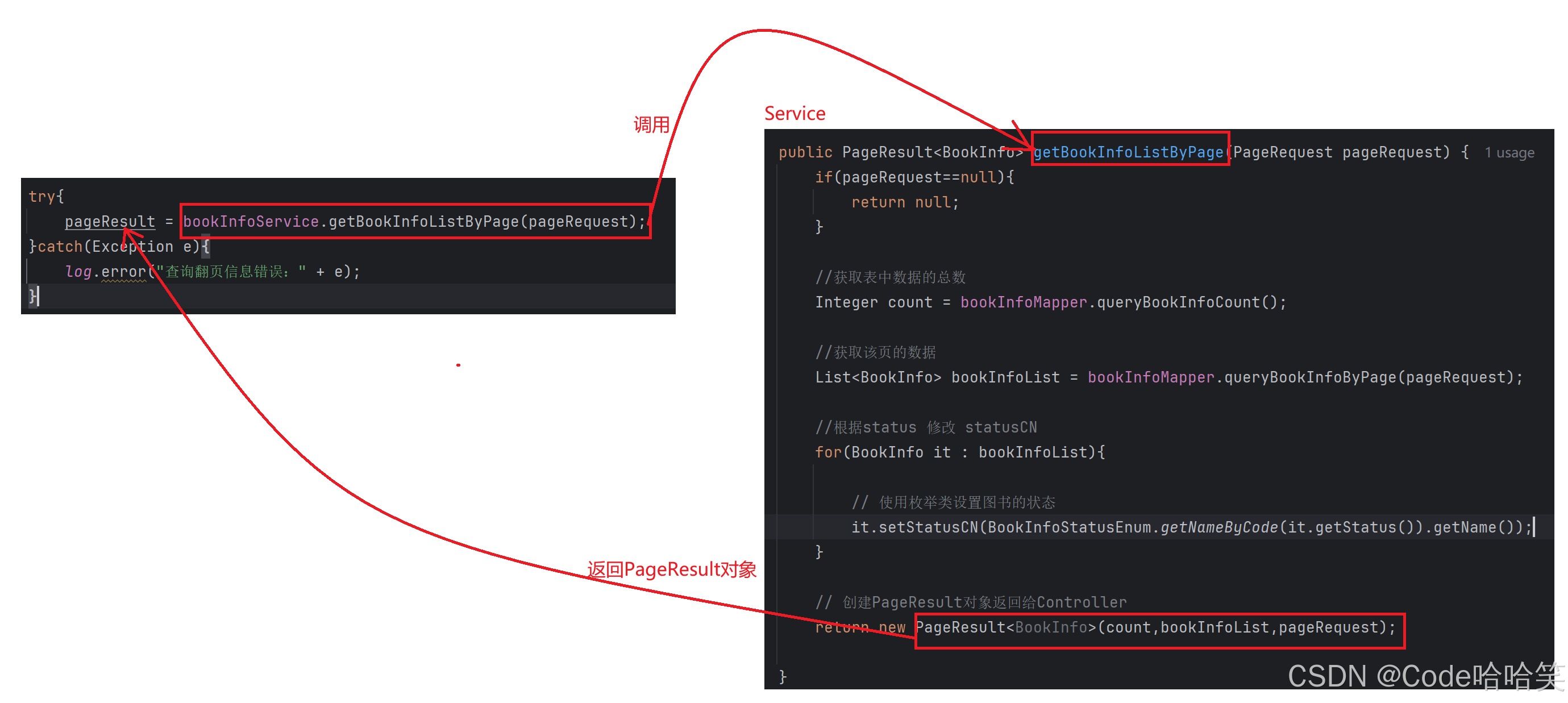

【图书管理系统】深度讲解:图书列表展示的后端实现、高内聚低耦合的应用、前端代码讲解

1.约定前后端交互接口 [请求] /book/getListByPage [参数] currentPage1&pageSize10 [响应] 返回封装的result对象对应的Json数据 2. 整体逻辑 2.1 Controller的逻辑 (1)把接收的参数封装为PageRequest类,里面有属性:curren…...

Github 2025-05-10 Rust开源项目日报 Top10

根据Github Trendings的统计,今日(2025-05-10统计)共有10个项目上榜。根据开发语言中项目的数量,汇总情况如下: 开发语言项目数量Rust项目10TypeScript项目1Python项目1Zed: 由Atom和Tree-sitter的创建者开发的高性能多人代码编辑器 创建周期:1071 天开发语言:Rust协议类型…...

drf 使用jwt

安装jwt pip install pyJwt 添加登录url path("jwt/login",views.JwtLoginView.as_view(),namejwt-login),path("jwt/order",views.JwtOrderView.as_view(),namejwt-order), 创建视图 from django.contrib.auth import authenticateimport jwt from jw…...

养生:为健康生活添彩

养生是对生活的热爱,是为健康生活注入活力的良方。从饮食、运动到生活习惯,每一个方面都能让我们离健康更近一步。以下是一些实用的养生之道,助你开启健康生活的新旅程。 饮食养生:营养均衡,健康基石 合理的饮食是养…...

在 Vue 3 中使用 canvas-confetti 插件

🎉 在 Vue 3 中使用 canvas-confetti 插件 canvas-confetti 是一个轻量、无依赖的 JavaScript 动画库,用于在网页上展示彩带、庆祝动画。非常适合用于抽奖、支付成功、活动庆祝等场景。 本教程将指导你如何在 Vue 3 项目中集成并使用该插件。 …...

rt-thread+STM32H7移植lwip出现问题解决方法

问题一:ping不通,或有丢帧情况。 问题二:不开启优化一切正常,keil开启优化后就无法联网。 问题三:网络断断续续。 解决方法: 主要是mpu配置和drv_eth驱动的问题,我的配置如下: mpu&…...

Java Spring、Spring MVC、Spring Boot 和 Spring Cloud 的关系与区别

在 Java 开发领域,Spring、Spring MVC、Spring Boot 和 Spring Cloud 这些框架和技术名词频繁出现。对于初学者来说,理解它们之间的关系和区别可能有些困惑。本文将深入浅出地讲解这些概念,帮助你理清它们的联系与差异。 一、Spring 1.1 定义 Spring 是一个轻量级的 Java…...

服务器综合实验(实战详解)

该文章的目录部分 实验内容 实验完成步骤 虚拟机准备 配置两个虚拟机的本地仓库 虚拟机A: 虚拟机B: 配置SSH公钥互信 虚拟机A: 编辑 虚拟机B: 提供基于bind的DNS服务 虚拟机A: 项目需求1: …...

Milvus 向量数据库详解与实践指南

一、Milvus 核心介绍 1. 什么是 Milvus? Milvus 是一款开源、高性能、可扩展的向量数据库,专门为海量向量数据的存储、索引和检索而设计。它支持近似最近邻搜索(ANN),适用于图像检索、自然语言处理(NLP&am…...

react+ts中函数组件父子通信方式

1. 父组件通过 Props 向子组件传递数据 这是最常见也是最基本的父子组件通信方式。父组件通过 props 将数据或回调函数传递给子组件。 示例代码: // 子组件接收来自父组件的数据 interface ChildProps {message: string; }const ChildComponent: React.FC<Chi…...

VSCode-插件:codegeex:ai coding assistant / 清华智普 AI 插件

一、官网 https://codegeex.cn/ 二、vscode 安装插件 点击安装即可,无需复杂操作,国内软件,无需科学上网,非常友好 三、智能注释 输入 // 或者 空格---后边自动出现注释信息,,按下 Tab 键,进…...

SlideLoss与FocalLoss在YOLOv8分类损失中的应用及性能分析

文章目录 一、引言二、YOLOv8 损失函数概述三、SlideLoss 详解(一)SlideLoss 的原理(二)SlideLoss 的代码实现 四、FocalLoss 分类损失函数详解(一)FocalLoss 的原理(二)FocalLoss 的…...

【AI智能推荐系统】第七篇:跨领域推荐系统的技术突破与应用场景

第七篇:跨领域推荐系统的技术突破与应用场景 提示语:🔥 “打破数据孤岛,实现1+1>2的推荐效果!深度解析美团、亚马逊如何用跨领域推荐技术实现业务协同,知识迁移核心技术全公开!” 目录 跨领域推荐的商业价值跨领域推荐技术体系 2.1 基于共享表征的学习2.2 迁移学习…...

)

ui组件二次封装(vue)

组件二次封装的意义 保证一个系统中ui风格和功能的一致性便于维护 从属性、事件、插槽、ref这几方面考虑 属性和事件的处理:ui组件上绑定$attrs(v-model本质也是一个属性加一个事件,所以也在其列) 在自定义组件中打印$attrs&am…...

OpenCv实战笔记(4)基于opencv实现ORB特征匹配检测

一、原理作用 ORB 原理(Oriented FAST and Rotated BRIEF): 特征点检测:使用 FAST 算法检测角点(关键点)。 方向计算:为每个关键点分配主方向,增强旋转不变性。 特征描述:…...

PyTorch 线性回归模型构建与神经网络基础要点解析

笔记 1 PyTorch构建线性回归模型 1.1 创建数据集 import torch from torch.utils.data import TensorDataset # 创建x和y张量数据集对象 from torch.utils.data import DataLoader # 创建数据集加载器 import torch.nn as nn # 损失函数和回归函数 from torch.optim impo…...

Android平台FFmpeg音视频开发深度指南

一、FFmpeg在Android开发中的核心价值 FFmpeg作为业界领先的多媒体处理框架,在Android音视频开发中扮演着至关重要的角色。它提供了: 跨平台支持:统一的API处理各种音视频格式完整功能链:从解码、编码到滤镜处理的全套解决方案灵…...

深入解析路由策略:从流量控制到策略实施

一、网络流量双平面解析 在路由策略的设计中,必须明确区分两个关键平面: 1. 控制层面(Control Plane) 定义:路由协议传递路由信息形成的逻辑平面(如OSPF的LSA、RIP的Response报文)…...

FHE 之 面向小白的引导(Bootstrapping)

1. 引言 FHE初学者和工程师常会讨论的一个问题是; “什么是引导(bootstrapping)?” 从理论角度看,这个问题的答案很简单: 引导就是套用 Gentry 提出的思想——在加密状态下同态地执行解密操作ÿ…...

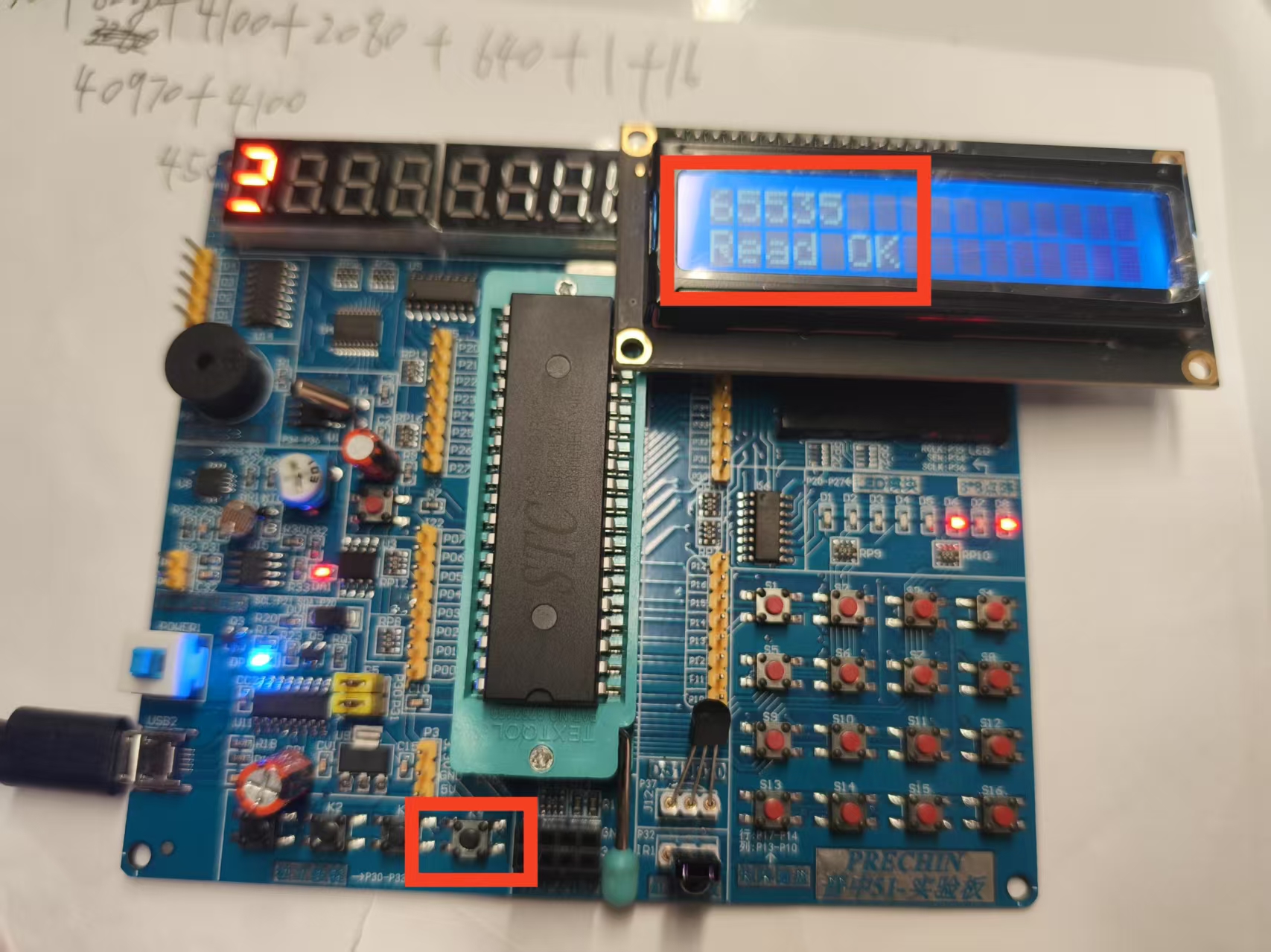

51单片机入门教程——AT24C02数据存储

前言 本教程基于B站江协科技课程进行个人学习整理,专为拥有C语言基础的零基础入门51单片机新手设计。既帮助解决因时间差导致的设备迭代调试难题,也助力新手快速掌握51单片机核心知识,实现从C语言理论到单片机实践应用的高效过渡 。 目录 …...

M0的基础篇之PWM学习

一、困惑 上一节课就是单纯的之配置了一个基础的定时器进行计数,计到一定的数值也就是到了一定的时间就进入中断,执行中断里面的任务,也就是一个最基础的定时的功能 这一节课的定时器产生了一个pwm波。也就是我们可以改变里面高电平的持续时间…...

Python----神经网络(基于AlexNet的猫狗分类项目)

一、基于AlexNet的猫狗分类 1.1、项目背景 猫和狗是我们生活中最常见的宠物,它们的图像数据大量存在于互联网上。对此进行分类不仅可以帮助开发自动化宠物识别应用,也可以应用于更广泛的计算机视觉领域。例如,训练良好的模型可以支持流浪动物…...