基于Flink CDC实时同步PostgreSQL与Tidb【Flink SQL Client模式下亲测可行,详细教程】

文章目录

- 一、PostgreSQL作为数据来源(source),由flink读取

- 1.postgre安装与配置

- 2.flink安装与配置

- 3.flink cdc postgre配置

- 3.1 postgre配置(for flink cdc)

- 3.2 flink cdc postgres的jar包下载

- 4.flink cdc postgre测试

- 二、Tidb作为数据去向(sink),由flink写入

- 1.tidb安装与配置

- 2.flink cdc tidb的jar包下载

- 3.flink cdc tidb测试

- 三、用Flink SQL Client同步PostgreSQL到Tidb

操作系统:ubuntu-22.04,运行于wsl 2

软件版本:PostgreSQL 14.9,TiDB v7.3.0,flink 1.7.1,flink cdc 2.4.0

一、PostgreSQL作为数据来源(source),由flink读取

1.postgre安装与配置

已有postgre的跳过此步

(1)pg安装

https://zhuanlan.zhihu.com/p/143156636

sudo apt install postgresql

sudo -u postgres psql -c "SELECT version();"

sudo -u postgres psql # 连接进入postgre shell(以管理员用户)

(2)pg配置

# 创建新用户和数据库

sudo su - postgres -c "createuser domeya"

sudo su - postgres -c "createdb domeya_db"sudo -u postgres psql # 进入psql(管理员用户postgres)

grant all privileges on database domeya_db to domeya; # 授权用户操作数据库

\password 123 # 设置用户密码

\q # 退出psql# psql postgres://username:password@host:port/dbname

psql postgres://domeya:123@localhost:5432/domeya_db # 新用户测试连接

可能出现的问题

sudo -u postgres psql报错:

psql: error: connection to server on socket “/var/run/postgresql/.s.PGSQL.5432” failed: No such file or directory

Is the server running locally and accepting connections on that socket?

解决:重装pg,重启pg服务

https://stackoverflow.com/questions/69639250/pgconnectionbad-connection-to-server-on-socket-var-run-postgresql-s-pgsql

https://blog.csdn.net/psiitoy/article/details/7310003

# 卸载

dpkg --list | grep postgresql

dpkg --purge postgresql postgresql-14 postgresql-client-14 postgresql-client-common postgresql-common # 根据dpkg --list | grep postgresql中展示的结果进行填写

# rm -rf /var/lib/postgresql/

# 重装

sudo apt install postgresql

# 重启

sudo service postgresql restart # 重要!

ps -ef | grep postgres

2.flink安装与配置

已有flink的跳过此步

flink安装,配置环境变量

# https://flink.apache.org/downloads/

curl -O -L https://dlcdn.apache.org/flink/flink-1.17.1/flink-1.17.1-bin-scala_2.12.tgz

tar zxvf flink-1.17.1-bin-scala_2.12.tgz -C /optsudo vim /etc/profile.d/flink.sh

# flink.sh

export FLINK_HOME=/opt/flink-1.17.1

export PATH=$PATH:$FLINK_HOME/binsource /etc/profile

启动flink

cd $FLINK_HOME

./bin/start-cluster.sh # 启动flink

jps # 查看是否启动StandaloneSessionClusterEntrypoint, TaskManagerRunner# ./bin/stop-cluster.sh # 关闭flink

3.flink cdc postgre配置

3.1 postgre配置(for flink cdc)

https://www.cnblogs.com/xiongmozhou/p/14817641.html

(1)修改配置文件

cd /etc/postgresql/14/main

cp postgresql.conf postgresql.conf.backup

vim postgresql.conf

postgresql.conf修改几个关键配置如下:

# 更改wal日志方式为logical

wal_level = logical # minimal, replica, or logical# 更改solts最大数量(默认值为10),flink-cdc默认一张表占用一个slots

max_replication_slots = 20 # max number of replication slots# 更改wal发送最大进程数(默认值为10),这个值和上面的solts设置一样

max_wal_senders = 20 # max number of walsender processes# 中断那些停止活动超过指定毫秒数的复制连接,可以适当设置大一点(默认60s)

wal_sender_timeout = 180s # in milliseconds; 0 disable

修改完之后重启postgresql,service postgresql restart

(2)赋予权限

以管理员进入psql,sudo -u postgres psql

(可选)如果没有测试表,可以新建一个

-- 如果没有测试表,可创建一个

CREATE TABLE test_table1(id varchar(8),p_dt varchar(8)

);

-- 查看表

\dinsert into test_table1 values('1', '20230820');

select * from test_table1;

赋予普通用户复制流权限、发布表、更改表的复制标识包含更新和删除的值

-- 给用户复制流权限

ALTER ROLE domeya replication;

-- 查看权限

\du\c domeya_db -- 重要:进入到domeya_db数据库(以管理员账号进入)

-- 设置发布为true

update pg_publication set puballtables=true where pubname is not null;

-- 把所有表进行发布(包括以后新建的表);

-- 注意,此处PUBLICATION名字必须为dbz_publication,否则后续flink sql报错must be superuser to create FOR ALL TABLES publication

CREATE PUBLICATION dbz_publication FOR ALL TABLES;

-- 查询哪些表已经发布

select * from pg_publication_tables;-- 更改复制标识包含更新和删除之前值

ALTER TABLE test_table1 REPLICA IDENTITY FULL; -- 对应前面创建的测试表

-- 查看复制标识(为f标识说明设置成功)

select relreplident from pg_class where relname='test_table1'; -- 对应前面创建的测试表-- 退出

\q

wal_level = logical源表的数据修改时,默认的逻辑复制流只包含历史记录的primary key,如果需要输出更新记录的历史记录的所有字段,需要在表级别修改参数:ALTER TABLE tableName REPLICA IDENTITY FULL; 这样才能捕获到源表所有字段更新后的值

3.2 flink cdc postgres的jar包下载

下载flink cdc postgres相关jar包,放在$FLINK_HOME/lib

cd $FLINK_HOME/lib# 以下用于flink cdc postgres连接

# 注意:用于flink sql的jar包是flink-sql-connector-postgres-cdc,不是flink-connector-postgres-cdc

# https://mvnrepository.com/artifact/com.ververica/flink-sql-connector-postgres-cdc/2.4.0

wget https://repo1.maven.org/maven2/com/ververica/flink-sql-connector-postgres-cdc/2.4.0/flink-sql-connector-postgres-cdc-2.4.0.jar

如果flink在运行状态,需要重启flink,之后再启动flink sql client

cd $FLINK_HOME

./bin/stop-cluster.sh

./bin/start-cluster.sh

4.flink cdc postgre测试

https://ververica.github.io/flink-cdc-connectors/master/content/connectors/postgres-cdc.html【官方文档demo】

启动flink sql client(之前重启了flink cluster)

cd $FLINK_HOME

./bin/sql-client.sh

在flink sql client创建表,与pg中的表结构对应,表名字可以不同

CREATE TABLE source_table (id STRING,p_dt STRING

) WITH ('connector' = 'postgres-cdc','hostname' = 'localhost','port' = '5432','username' = 'domeya','password' = '123','database-name' = 'domeya_db','schema-name' = 'public','table-name' = 'test_table1','slot.name' = 'flink',-- experimental feature: incremental snapshot (default off)-- 'scan.incremental.snapshot.enabled' = 'true''decoding.plugin.name' = 'pgoutput' -- 必须加,否则报错could not access file "decoderbufs"

);select * from source_table;

可能出现的问题

运行select * from source_table;时报错

报错1:

[ERROR] Could not execute SQL statement. Reason:

org.postgresql.util.PSQLException: ERROR: could not access file “decoderbufs”: No such file or directory

https://github.com/ververica/flink-cdc-connectors/issues/37

table sql加:WITH('decoding.plugin.name' = 'pgoutput')

dataStream加:PostgreSQLSource.<String>builder().decodingPluginName("pgoutput").build()

报错2:

[ERROR] Could not execute SQL statement. Reason:

org.postgresql.util.PSQLException: ERROR: must be superuser to create FOR ALL TABLES publication

https://gist.github.com/alexhwoods/4c4c90d83db3c47d9303cb734135130d

检查之前的操作

CREATE PUBLICATION dbz_publication FOR ALL TABLES;

select * from pg_publication_tables;

注意,flink postgres-cdc只能读(作为source),不能写(作为sink)

Flink SQL> insert into source_table values('3', '20230820');

[ERROR] Could not execute SQL statement. Reason:

org.apache.flink.table.api.ValidationException: Connector 'postgres-cdc' can only be used as a source. It cannot be used as a sink.

二、Tidb作为数据去向(sink),由flink写入

1.tidb安装与配置

已有tidb的跳过此步

https://docs.pingcap.com/zh/tidb/stable/quick-start-with-tidb

su xxx # 切换到你的普通用户

curl --proto '=https' --tlsv1.2 -sSf https://tiup-mirrors.pingcap.com/install.sh | sh

source /home/xxx/.bashrc # 按上个命令输出的路径来,上面显示的是Shell profile: /home/xxx/.bashrctiup playground # 下载镜像,并启动某个版本的集群

- 以这种方式执行的 playground,在结束部署测试后 TiUP 会清理掉原集群数据,重新执行该命令后会得到一个全新的集群。

- 若希望持久化数据,可以执行 TiUP 的

--tag参数:tiup --tag <your-tag> playground ...

下载完毕,启动成功之后展示信息:

Connect TiDB: mysql --comments --host 127.0.0.1 --port 4000 -u root

TiDB Dashboard: http://127.0.0.1:2379/dashboard

Grafana: http://127.0.0.1:3000

连接tidb

# 使用mysql client连接tidb

sudo apt install mysql-client

mysql --comments --host 127.0.0.1 --port 4000 -u root# 设置root密码

# https://docs.pingcap.com/zh/tidb/stable/user-account-management#%E8%AE%BE%E7%BD%AE%E5%AF%86%E7%A0%81

# https://blog.csdn.net/qq_45675449/article/details/106866700

SET PASSWORD FOR 'root'@'%' = '123'; # root的localhost是%,可通过 select user,host from mysql.user; 查看exit;# mysql -uroot -p无法连接,必须加上port和host,并且host不能写成localhost

# https://blog.csdn.net/hjf161105/article/details/78850658

mysql -uroot --port 4000 -h 127.0.0.1 -p

2.flink cdc tidb的jar包下载

下载用于jdbc mysql连接的jar包,用于flink cdc tidb连接。

特别注意:Tidb的sink模式得用jdbc+mysql连接,不用官方提供的tidb cdc因为其不能作为sink,只能曲线救国参考这种方法了。

cd $FLINK_HOME/lib

# 以下用于jdbc mysql(用于flink cdc tidb连接)

# https://mvnrepository.com/artifact/org.apache.flink/flink-connector-jdbc/3.1.1-1.17

wget https://repo1.maven.org/maven2/org/apache/flink/flink-connector-jdbc/3.1.1-1.17/flink-connector-jdbc-3.1.1-1.17.jar

# https://mvnrepository.com/artifact/com.mysql/mysql-connector-j/8.1.0

wget https://repo1.maven.org/maven2/com/mysql/mysql-connector-j/8.1.0/mysql-connector-j-8.1.0.jar

如果flink在运行状态,需要重启flink,之后再启动flink sql client

cd $FLINK_HOME

./bin/stop-cluster.sh

./bin/start-cluster.sh

3.flink cdc tidb测试

基于Flink CDC实时同步数据(MySQL到MySQL)

flink cdc tidb 官方文档demo(无法作为sink,只能作为source)

(可选)tidb创建测试表

# mysql -uroot --port 4000 -h 127.0.0.1 -p# 创建测试表

CREATE TABLE test.test_table1(id varchar(8),p_dt varchar(8)

);

insert into test.test_table1 values('3', '20230819');

启动flink sql client(之前重启了flink cluster)

cd $FLINK_HOME

./bin/sql-client.sh

flink sql连接tidb,仿照mysql的连接

-- checkpoint every 3000 milliseconds

SET 'execution.checkpointing.interval' = '3s';-- register a TiDB table in Flink SQL

CREATE TABLE sink_table (id STRING,p_dt STRING,PRIMARY KEY(id) NOT ENFORCED -- 必须写PRIMARY KEY,否则报错:[ERROR] Could not execute SQL statement. Reason: java.lang.IllegalStateException: please declare primary key for sink table when query contains update/delete record.) WITH ('connector' = 'jdbc','url' = 'jdbc:mysql://localhost:4000/test','driver' = 'com.mysql.cj.jdbc.Driver','username' = 'root','password' = '123','table-name' = 'test_table1'

);-- read snapshot and binlogs from table

SELECT * FROM sink_table;

三、用Flink SQL Client同步PostgreSQL到Tidb

# 将会提交一个作业,进行source_table->sink_table的单向同步

insert into sink_table select * from source_table;

[INFO] Submitting SQL update statement to the cluster…

[INFO] SQL update statement has been successfully submitted to the cluster:

Job ID: 8e47bfa3ea78da4c47b395f7517c2812

在flink web ui上可以看到作业运行状态。

只要这个作业是正常runnning,那么对source_table的任何修改都会同步到sink_table。注意这种是单向同步,source_table的变动(增/删/改)会同步到sink_table,但反过来sink_table的变动不会影响到source_table(不会触发source_table->sink_table的同步)。

相关文章:

基于Flink CDC实时同步PostgreSQL与Tidb【Flink SQL Client模式下亲测可行,详细教程】

文章目录 一、PostgreSQL作为数据来源(source),由flink读取1.postgre安装与配置2.flink安装与配置3.flink cdc postgre配置3.1 postgre配置(for flink cdc)3.2 flink cdc postgres的jar包下载 4.flink cdc postgre测试…...

Vue-5.编译器Idea

Vue专栏(帮助你搭建一个优秀的Vue架子) Vue-1.零基础学习Vue Vue-2.Nodejs的介绍和安装 Vue-3.Vue简介 Vue-4.编译器VsCode Vue-5.编译器Idea Vue-6.编译器webstorm Vue-7.命令创建Vue项目 Vue-8.Vue项目配置详解 Vue-9.集成(.editorconfig、…...

qiuzhiji3

本篇想介绍一下慧与,这里的工作氛围和企业文化令人难忘,希望更多人了解它 也想探讨一下不同的文化铸就的不同企业,究竟有哪些差别。 本篇将从我个人角度出发描述慧与。 2022/3/16至2023/7/31 本篇初次写于2023年8月20日 说起来在毕业之前那段…...

JVM——垃圾回收(垃圾回收算法+分代垃圾回收+垃圾回收器)

1.如何判断对象可以回收 1.1引用计数法 只要一个对象被其他对象所引用,就要让该对象的技术加1,某个对象不再引用其,则让它计数减1。当计数变为0时就可以作为垃圾被回收。 有一个弊端叫做循环引用,两个的引用计数都是1ÿ…...

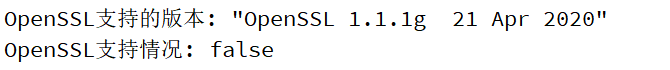

QT TLS initialization failed问题(已解决) QT基础入门【网络编程】openssl

问题: qt.network.ssl: QSslSocket::connectToHostEncrypted: TLS initialization failed 这个问题的出现主要是使用了https请求:HTTPS ≈ HTTP + SSL,即有了加密层的HTTP 所以Qt 组件库需要OpenSSL dll 文件支持HTTPS 解决: 1.加入以下两行代码获取QT是否支持opensll以…...

SpringMVC之获取请求参数

文章目录 前言一、通过ServletAPI获取二、通过控制器方法的形参获取请求参数三、注解1.RequestParam2.RequestHeader3.CookieValue前面的代码总和:4.通过POJO获取请求参数 三、解决获取请求参数的乱码问题总结 前言 下面用到了thymeleaf,不知道的可以看…...

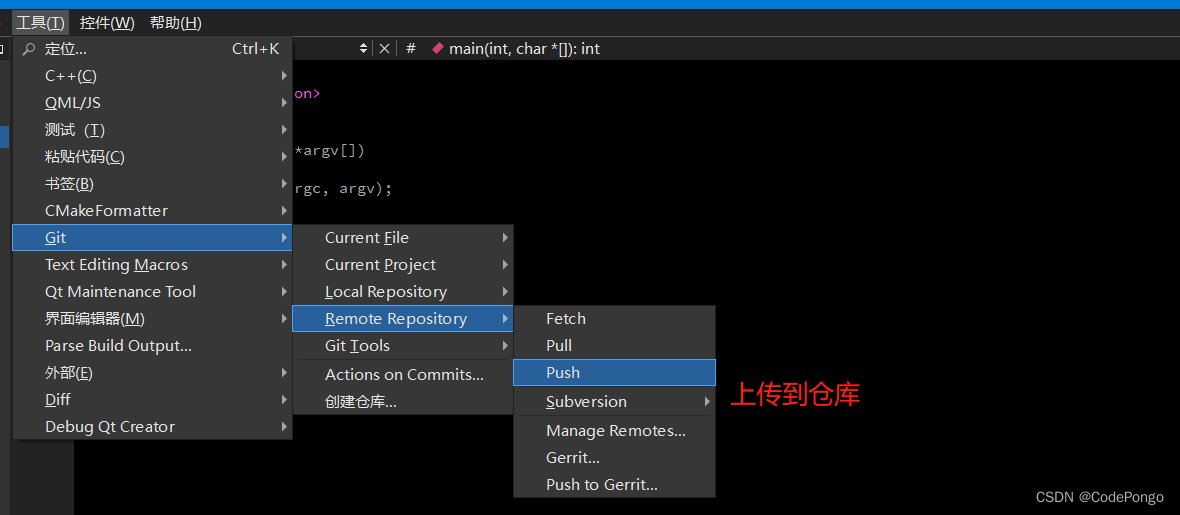

【无标题】QT应用编程: QtCreator配置Git版本控制(码云)

QT应用编程: QtCreator配置Git版本控制(码云) 感谢:DS小龙哥的文章,这篇主要参考小龙哥的内容。 https://cloud.tencent.com/developer/article/1930531?areaSource102001.15&traceIdW2mKALltGu5f8-HOI8fsN Qt Creater 自带了git支持。但是一直没…...

JVM面试题-2

1、有哪几种垃圾回收器,各自的优缺点是什么? 垃圾回收器主要分为以下几种:Serial、ParNew、Parallel Scavenge、Serial Old、Parallel Old、CMS、G1; Serial:单线程的收集器,收集垃圾时,必须stop the worl…...

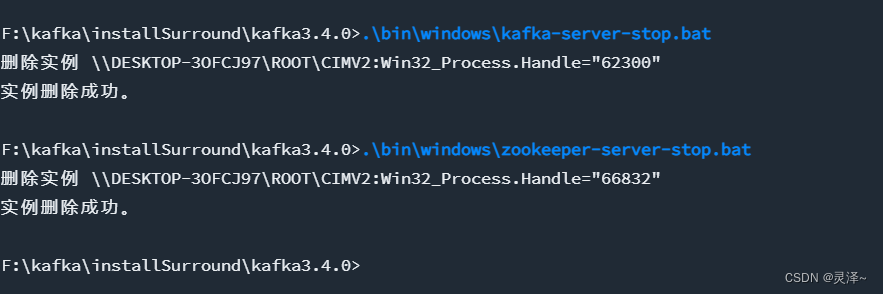

kafka安装说明以及在项目中使用

一、window 安装 1.1、下载安装包 下载kafka 地址,其中官方版内置zk, kafka_2.12-3.4.0.tgz其中这个名称的意思是 kafka3.4.0 版本 ,所用语言 scala 版本为 2.12 1.2、安装配置 1、解压刚刚下载的配置文件,解压后如下&#x…...

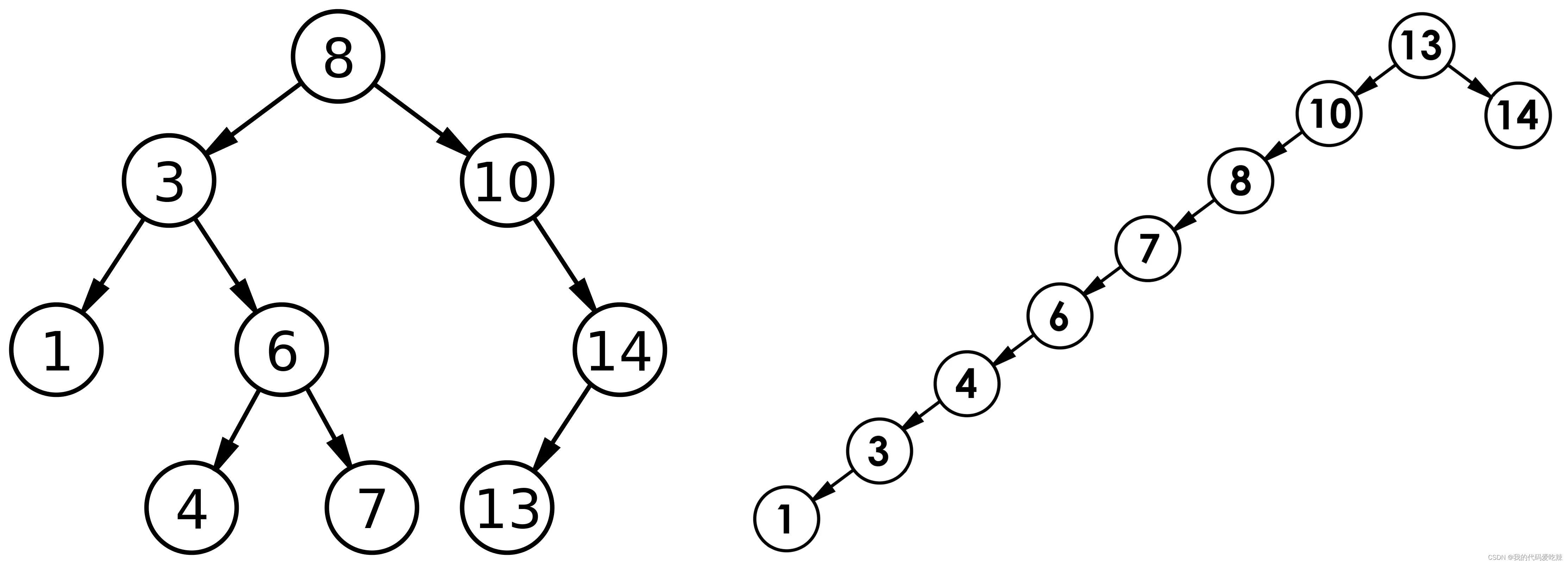

二叉树搜索

✅<1>主页:我的代码爱吃辣📃<2>知识讲解:数据结构——二叉搜索树☂️<3>开发环境 :Visual Studio 2022💬<4>前言:在之前的我们已经学过了普通二叉树,了解了基本的二叉树…...

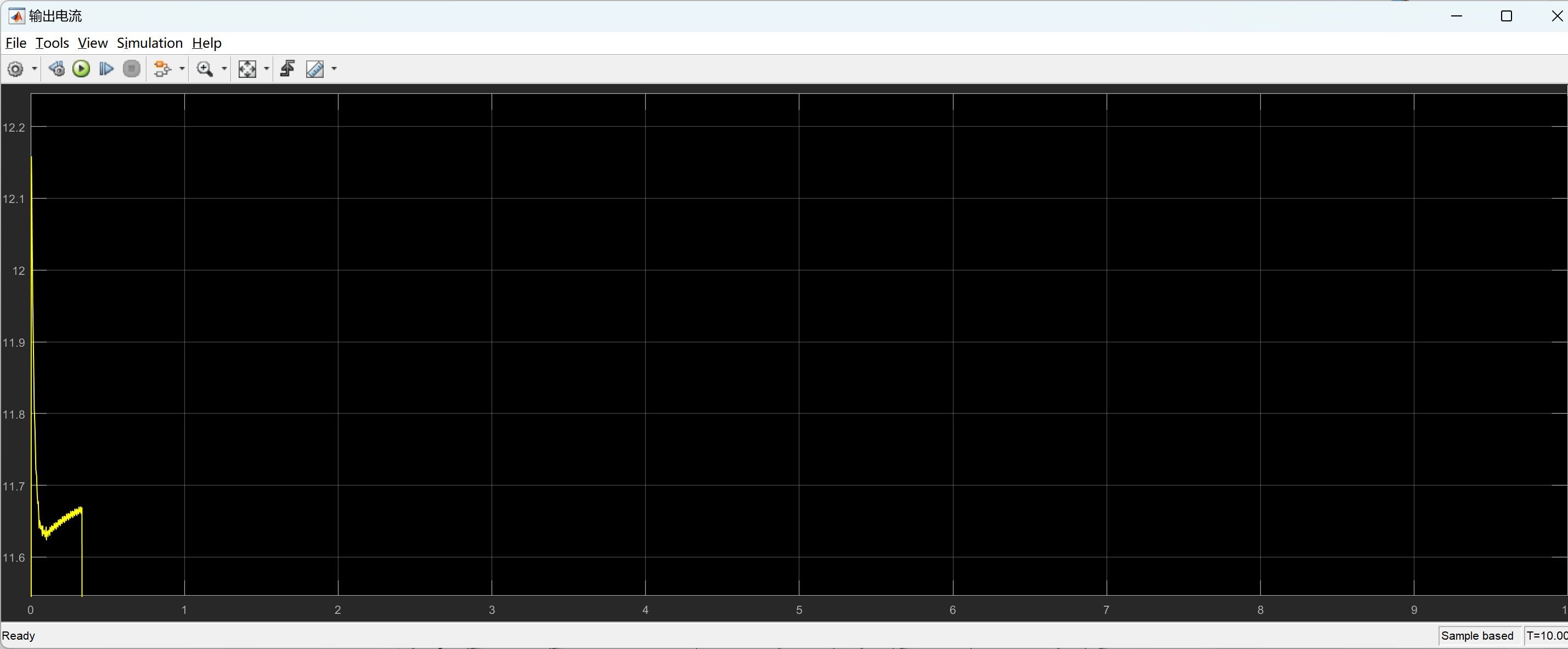

【先进PID控制算法(ADRC,TD,ESO)加入永磁同步电机发电控制仿真模型研究(Matlab代码实现)

💥💥💞💞欢迎来到本博客❤️❤️💥💥 🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。 ⛳️座右铭&a…...

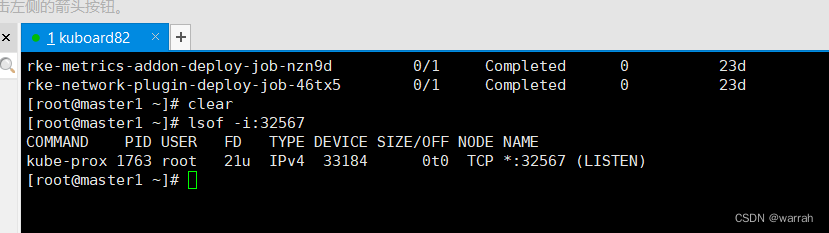

k8s集群生产环境的问题处理

2 k8s上的服务均无法访问 执行命令kubectl get pods -ALL,k8s集群中的服务均是running状态 1 kuboard 网页无法访问 kuboard无法通过浏览器访问,但是查看端口是被占用的...

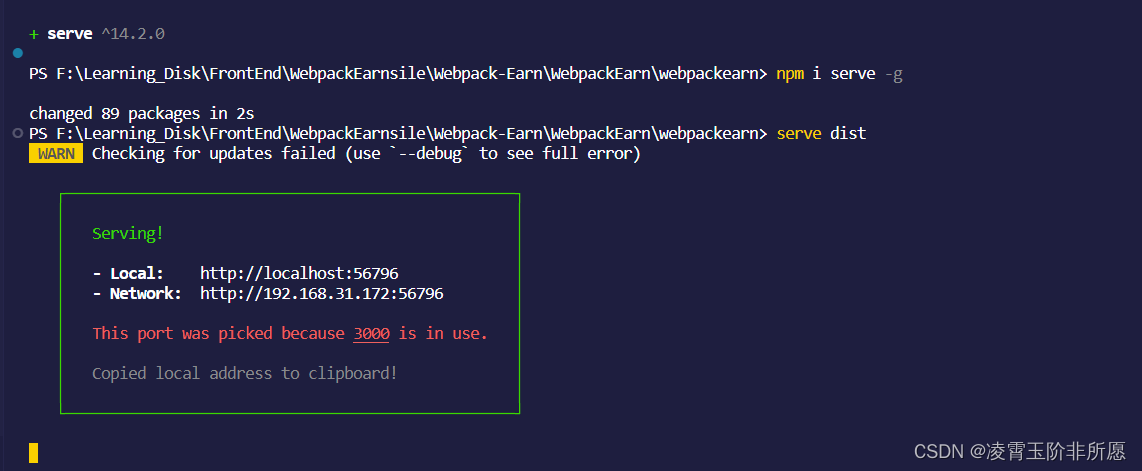

serve : 无法将“serve”项识别为 cmdlet、函数、脚本文件或可运行程序的名称。

1、在学习webpack打包的时候,需要 serve用来启动开发服务器来部署代码查看效果的。安装完之后运行出现以下错误: 2、使用命令查看安装目录: npm list -g我们已经安装过了 3、解决: 我们看到上图路径在:C:\Users\qiy…...

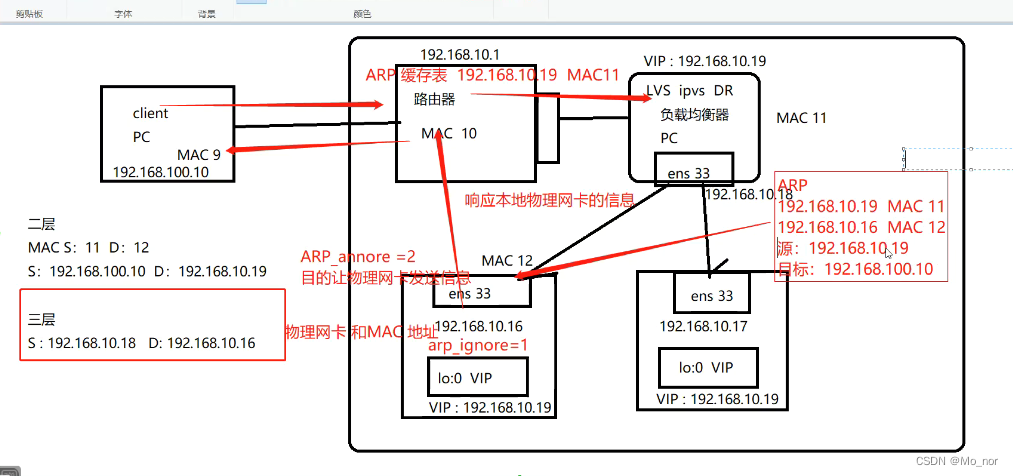

【LVS】2、部署LVS-DR群集

LVS-DR数据包的流向分析 1.客户端发送请求到负载均衡器,请求的数据报文到达内核空间; 2.负载均衡服务器和正式服务器在同一个网络中,数据通过二层数据链路层来传输; 3.内核空间判断数据包的目标IP是本机VIP,此时IP虚…...

)

设计模式 -- 单例模式(传统面向对象与JavaScript 的对比实现)

单例模式 – 传统面向对象与JavaScript 的对比实现 文章目录 单例模式 -- 传统面向对象与JavaScript 的对比实现传统的面向对象的实现定义实现思路初级实现缺点 透明的单例模式实现目的(实现效果)实现缺点 用代理实现单例模式优点 JavaScript 中的单例模…...

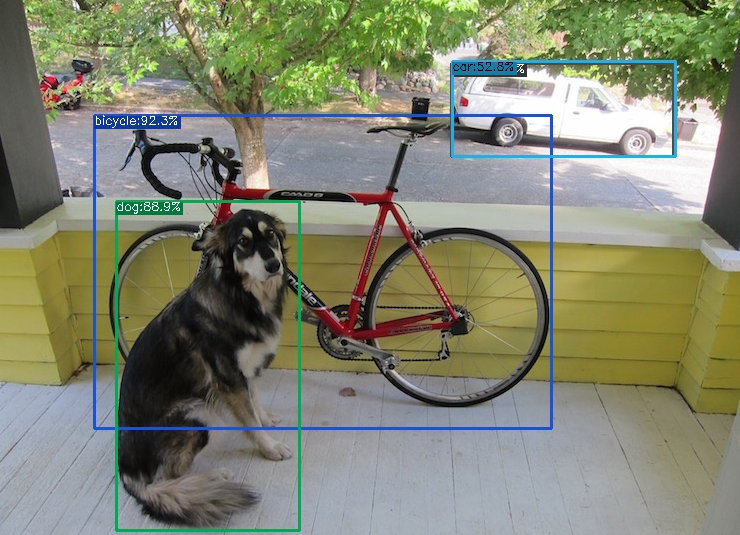

YOLOX算法调试记录

YOLOX是在YOLOv3基础上改进而来,具有与YOLOv5相媲美的性能,其模型结构如下: 由于博主只是要用YOLOX做对比试验,因此并不需要对模型的结构太过了解。 先前博主调试过YOLOv5,YOLOv7,YOLOv8,相比而言,YOLOX的环…...

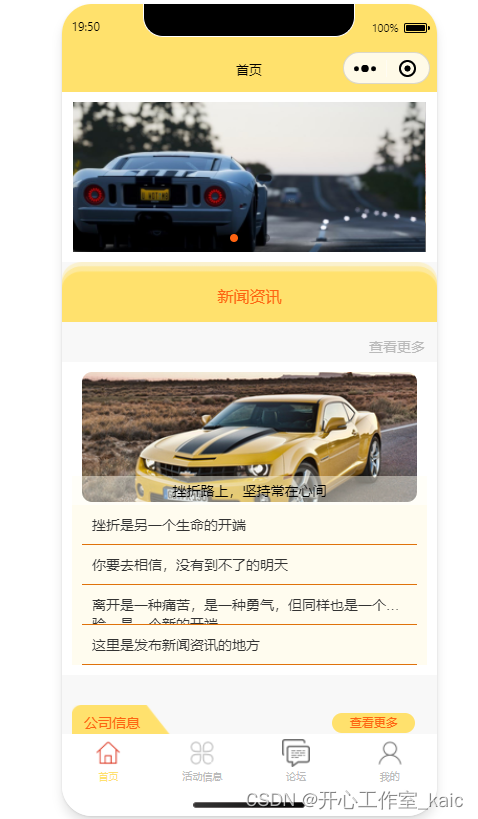

基于小程序的汽车俱乐部系统的设计与实现(论文+源码)_kaic

目录 前 言 1 系统概述 1.1 系统主要功能 1.2 开发及运行环境 2 系统分析和总体设计 2.1 需求分析 2.2 可行性分析 2.3 设计目标 2.4 项目规划 2.5 系统开发语言简介 2.6 系统功能模块图 3 系统数据库设计 3.1 数据库开发工具简介 3.2 数据库需求分析 3.3 数据库…...

ProgrammingArduino物联网

programming_arduino_ed2 IO 延时闪灯 void setup() {pinMode(13, OUTPUT); }void loop() {digitalWrite(13, HIGH);delay(500);digitalWrite(13, LOW);delay(500); }// sketch 03-02 加入变量 int ledPin 13; int delayPeriod 500;void setup() {pinMode(ledPin, OUTPUT)…...

SSM框架的学习与应用(Spring + Spring MVC + MyBatis)-Java EE企业级应用开发学习记录(第一天)Mybatis的学习

SSM框架的学习与应用(Spring Spring MVC MyBatis)-Java EE企业级应用开发学习记录(第一天)Mybatis的学习 一、当前的主流框架介绍(这就是后期我会发出来的框架学习) Spring框架 Spring是一个开源框架,是为了解决企业应用程序开发复杂…...

Programming abstractions in C阅读笔记: p118-p122

《Programming Abstractions In C》学习第49天,p118-p122,总结如下: 一、技术总结 1.随机数 (1)seed p119,“The initial value–the value that is used to get the entire process start–is call a seed for the random ge…...

深入剖析AI大模型:大模型时代的 Prompt 工程全解析

今天聊的内容,我认为是AI开发里面非常重要的内容。它在AI开发里无处不在,当你对 AI 助手说 "用李白的风格写一首关于人工智能的诗",或者让翻译模型 "将这段合同翻译成商务日语" 时,输入的这句话就是 Prompt。…...

Flask RESTful 示例

目录 1. 环境准备2. 安装依赖3. 修改main.py4. 运行应用5. API使用示例获取所有任务获取单个任务创建新任务更新任务删除任务 中文乱码问题: 下面创建一个简单的Flask RESTful API示例。首先,我们需要创建环境,安装必要的依赖,然后…...

stm32G473的flash模式是单bank还是双bank?

今天突然有人stm32G473的flash模式是单bank还是双bank?由于时间太久,我真忘记了。搜搜发现,还真有人和我一样。见下面的链接:https://shequ.stmicroelectronics.cn/forum.php?modviewthread&tid644563 根据STM32G4系列参考手…...

)

【位运算】消失的两个数字(hard)

消失的两个数字(hard) 题⽬描述:解法(位运算):Java 算法代码:更简便代码 题⽬链接:⾯试题 17.19. 消失的两个数字 题⽬描述: 给定⼀个数组,包含从 1 到 N 所有…...

【磁盘】每天掌握一个Linux命令 - iostat

目录 【磁盘】每天掌握一个Linux命令 - iostat工具概述安装方式核心功能基础用法进阶操作实战案例面试题场景生产场景 注意事项 【磁盘】每天掌握一个Linux命令 - iostat 工具概述 iostat(I/O Statistics)是Linux系统下用于监视系统输入输出设备和CPU使…...

涂鸦T5AI手搓语音、emoji、otto机器人从入门到实战

“🤖手搓TuyaAI语音指令 😍秒变表情包大师,让萌系Otto机器人🔥玩出智能新花样!开整!” 🤖 Otto机器人 → 直接点明主体 手搓TuyaAI语音 → 强调 自主编程/自定义 语音控制(TuyaAI…...

自然语言处理——循环神经网络

自然语言处理——循环神经网络 循环神经网络应用到基于机器学习的自然语言处理任务序列到类别同步的序列到序列模式异步的序列到序列模式 参数学习和长程依赖问题基于门控的循环神经网络门控循环单元(GRU)长短期记忆神经网络(LSTM)…...

RabbitMQ入门4.1.0版本(基于java、SpringBoot操作)

RabbitMQ 一、RabbitMQ概述 RabbitMQ RabbitMQ最初由LShift和CohesiveFT于2007年开发,后来由Pivotal Software Inc.(现为VMware子公司)接管。RabbitMQ 是一个开源的消息代理和队列服务器,用 Erlang 语言编写。广泛应用于各种分布…...

【Linux手册】探秘系统世界:从用户交互到硬件底层的全链路工作之旅

目录 前言 操作系统与驱动程序 是什么,为什么 怎么做 system call 用户操作接口 总结 前言 日常生活中,我们在使用电子设备时,我们所输入执行的每一条指令最终大多都会作用到硬件上,比如下载一款软件最终会下载到硬盘上&am…...

Python网页自动化Selenium中文文档

1. 安装 1.1. 安装 Selenium Python bindings 提供了一个简单的API,让你使用Selenium WebDriver来编写功能/校验测试。 通过Selenium Python的API,你可以非常直观的使用Selenium WebDriver的所有功能。 Selenium Python bindings 使用非常简洁方便的A…...