NLG(自然语言生成)评估指标介绍

诸神缄默不语-个人CSDN博文目录

本文介绍自然语言生成任务中的各种评估指标。

因为我是之前做文本摘要才接触到这一部分内容的,所以本文也是文本摘要中心。

持续更新。

文章目录

- 1. 常用术语

- 2. ROUGE (Recall Oriented Understudy for Gisting Evaluation)

- 1. 计算指标

- 2. 对rouge指标的更深入研究和改进

- 3. BLEU (Bilingual Evaluation Understudy)

- 4. METEOR (Metric for Evaluation for Translation with Explicit Ordering)

- 5. Perplexity

- 6. Bertscore

- 7. Faithfulness

- 8. 人工评估指标

- 9. InfoLM

- 10. MOVERSCORE

- 11. BEER

- 12. BEND

- 参考资料

1. 常用术语

模型生成的句子、预测结果——candidate

真实标签——reference、ground-truth

2. ROUGE (Recall Oriented Understudy for Gisting Evaluation)

ROUGE值是文本摘要任务重最常用的机器评估指标,衡量生成文本与真实标签之间的相似程度。

precision:candidate中匹配reference的内容占candidate比例

recall:candidate中匹配reference的内容占reference比例

示例:

Reference: I work on machine learning.Candidate A: I work.Candidate B: He works on machine learning.

在这个例子中,用unigram(可以理解为一个词或token)1衡量匹配:A就比B的precision更高(A的匹配内容I work占candidate 100%,B的on machine learning占60%),但B的recall更高(60% VS 40%)。

出处论文:(2004 WS) ROUGE: A Package for Automatic Evaluation of Summaries

感觉没有2004年之后的文本摘要论文不使用这个指标的,如果看到有的话我会专门来这里提一嘴的。

分类:ROUGE-N(常用其中的ROUGE-1和ROUGE-2), ROUGE-L,ROUGE-W,ROUGE-S(后两种不常用)

原版论文中ROUGE主要关注recall值,但事实上在用的时候可以用precision、recall和F值。(我看到很多论文都用的是F值)

1. 计算指标

每种rouge值原本都是计算recall的,主要区别在于这个匹配文本的单位的选择:

ROUGE-N:基于n-grams,如ROUGE-1计算基于匹配unigrams的recall,以此类推。

ROUGE-L:基于longest common subsequence (LCS)

ROUGE-W:基于weighted LCS

ROUGE-S:基于skip-bigram co-occurence statistics(skip-bigram指两个共同出现的单词,不管中间隔了多远。要计算任何bigram的出现可能 C n 2 C_n^2 Cn2)

以ROUGE-L为例, A A A 是candidate,长度 m m m; B B B 是reference,长度 n n n:

P = L C S ( A , B ) m P=\frac{LCS(A,B)}{m} P=mLCS(A,B) R = L C S ( A , B ) n R=\frac{LCS(A,B)}{n} R=nLCS(A,B) F = ( 1 + b 2 ) R P R + b 2 P F=\frac{(1+b^2)RP}{R+b^2P} F=R+b2P(1+b2)RP

2. 对rouge指标的更深入研究和改进

(2018 EMNLP) A Graph-theoretic Summary Evaluation for ROUGE

批判文学:(2023 ACL) Rogue Scores:喷原包有bug。嘛我之前也喷过2,终于有顶会论文喷了我很欣慰

3. BLEU (Bilingual Evaluation Understudy)

常用于翻译领域。

出处论文:(2002 ACL) Bleu: a Method for Automatic Evaluation of Machine Translation

precision用modified n-gram precision估计,recall用best match length估计。

Modified n-gram precision:

n-gram precision是candidate中与reference匹配的n-grams占candidates的比例。但仅用这一指标会出现问题。

举例来说:

Reference: I work on machine learning.Candidate 1: He works on machine learning.Candidate 2: He works on on machine machine learning learning.

candidate 1的unigram precision有60%(3/5),candidate 2的有75%(6/8),但显然candidate 1比2更好。

为了解决这种问题,我们提出了“modified” n-gram precision,仅按照reference中匹配文本的出现次数来计算candidate中的出现次数。这样candidate中的on、machine和learning就各自只计算一次,candidate 2的unigram precision就变成了37.5%(3/8)。

对多个candidate的n-gram precision,求几何平均(因为precision随n呈几何增长,因此対数平均能更好地代表所有数值(这块其实我没看懂)):

P r e c i s i o n = exp ( ∑ n = 1 N w n log p n ) , where w n = 1 / n Precision=\exp(\sum_{n=1}^Nw_n\log p_n),\ \text{where} \ w_n=1/n Precision=exp(n=1∑Nwnlogpn), where wn=1/n

Best match length:

recall的问题在于可能存在多个reference texts,故难以衡量candidate对整体reference的sensitivity(这块其实我也没看懂)。显然长的candidate会包含更多匹配文本,但我们也已经保证了candidate不会无限长,因为这样的precision可能很低。因此,我们可以从惩罚candidate的简洁性(文本短)入手来设计recall指标:

在modified n-gram precision中添加一个multiplicative factor B P BP BP:

B P = { 1 , if c > r exp ( 1 − r c ) , otherwise \begin{aligned} BP=\begin{cases}1,& \text{if}\ c >r\\ \exp \left( 1-\dfrac{r}{c}\right) ,&\text{otherwise}\end{cases} \end{aligned} BP={1,exp(1−cr),if c>rotherwise

其中 c c c 是candidates总长度, r r r 是reference有效长度(如reference长度平均值),随着candidate长度( c c c)下降, B P BP BP 也随之减少,起到了惩罚短句的作用。

4. METEOR (Metric for Evaluation for Translation with Explicit Ordering)

常用于翻译领域。

出处:(2005) METEOR: An Automatic Metric for MT Evaluation with Improved Correlation with Human Judgments

BLEU的问题在于 B P BP BP 值所用的长度是平均值,因此单句得分不清晰。而METEOR调整了precision和recall的计算方式,用基于mapping unigrams的weighted F-score和penalty function for incorrect word order来代替。

Weighted F-score:

首先,我们要找到candidate和reference间最大的可以形成对齐(alignment)的映射(mappings)子集(subset)。在经过Porter stemming[^3]、用了WordNet同义词后,假设找到的对齐数是 m m m,则precision就是 m / c m/c m/c( c c c 是candidate长度)、recall是 m / r m/r m/r( r r r 是reference长度),F就是 F = P R α P + ( 1 − α ) R F=\frac{PR}{\alpha P+(1-\alpha)R} F=αP+(1−α)RPR

Penalty function:

考虑candidate中的单词顺序:

P e n a l t y = γ ( c m ) β , where 0 ≤ γ ≤ 1 Penalty=\gamma(\frac{c}{m})^\beta,\ \text{where}\ 0\leq\gamma\leq1 Penalty=γ(mc)β, where 0≤γ≤1

其中 c c c 是matching chunks数, m m m 是matches总数。因此如果大多数matches是连续的, c c c 就会小,penalty就会低。这部分我的理解是:连续的matches组成一个chunk。但我不确定,可能我会去查阅更多资料。

最终METEOR得分的计算方式为:

( 1 − P e n a l t y ) F (1-Penalty)F (1−Penalty)F

5. Perplexity

常用于语言模型训练。

待补。

6. Bertscore

使用该指标的论文:Rewards with Negative Examples for Reinforced Topic-Focused Abstractive Summarization

待补。

7. Faithfulness

- Entailment Ranking Generated Summaries by Correctness: An Interesting but Challenging Application for Natural Language Inference:用预训练的基于entailment的方法评估原文蕴含生成摘要的概率

- FactCC Evaluating the Factual Consistency of Abstractive Text Summarization:用基于规则的变换生成假摘要,训练基于Bert的模型,分类生成摘要是否faithful

- DAE Annotating and Modeling Fine-grained Factuality in Summarization:收集细粒度的词/依赖/句级别的faithfulness的标注,用这些标注训练factuality检测模型

8. 人工评估指标

文本的流畅程度、对原文的忠实程度、对原文重要内容的包含程度、语句的简洁程度等

9. InfoLM

出处论文:(2022 AAAI) InfoLM: A New Metric to Evaluate Summarization & Data2Text Generation

待补。

10. MOVERSCORE

待补

11. BEER

待补。

12. BEND

待补。

参考资料

- Metrics for NLG evaluation. Simple natural language processing… | by Desh Raj | Explorations in Language and Learning | Medium

- 我还没看,等我看完了补上:

Revisiting Automatic Evaluation of Extractive Summarization Task: Can We Do Better than ROUGE?

Benchmarking Answer Verification Methods for Question Answering-Based Summarization Evaluation Metrics

SARI

InfoLM: A New Metric to Evaluate Summarization & Data2Text Generation

SPICE

Play the Shannon Game With Language Models: A Human-Free Approach to Summary Evaluation

Reference-free Summarization Evaluation via Semantic Correlation and Compression Ratio

参考unigram_百度百科

父词条:n-gram

unigram: 1个word

bigram: 2个word

trigram : 3个word

(注意此处的word是英文的概念,在中文中可能会根据需要指代字或词)

中文中如果用字作为基本单位,示例:

西安交通大学:

unigram 形式为:西/安/交/通/大/学

bigram形式为: 西安/安交/交通/通大/大学

trigram形式为:西安交/安交通/交通大/通大学 ↩︎pyrouge和rouge在Linux上的安装方法以及结果比较 ↩︎

相关文章:

评估指标介绍)

NLG(自然语言生成)评估指标介绍

诸神缄默不语-个人CSDN博文目录 本文介绍自然语言生成任务中的各种评估指标。 因为我是之前做文本摘要才接触到这一部分内容的,所以本文也是文本摘要中心。 持续更新。 文章目录 1. 常用术语2. ROUGE (Recall Oriented Understudy for Gisting Evaluation)1. 计算…...

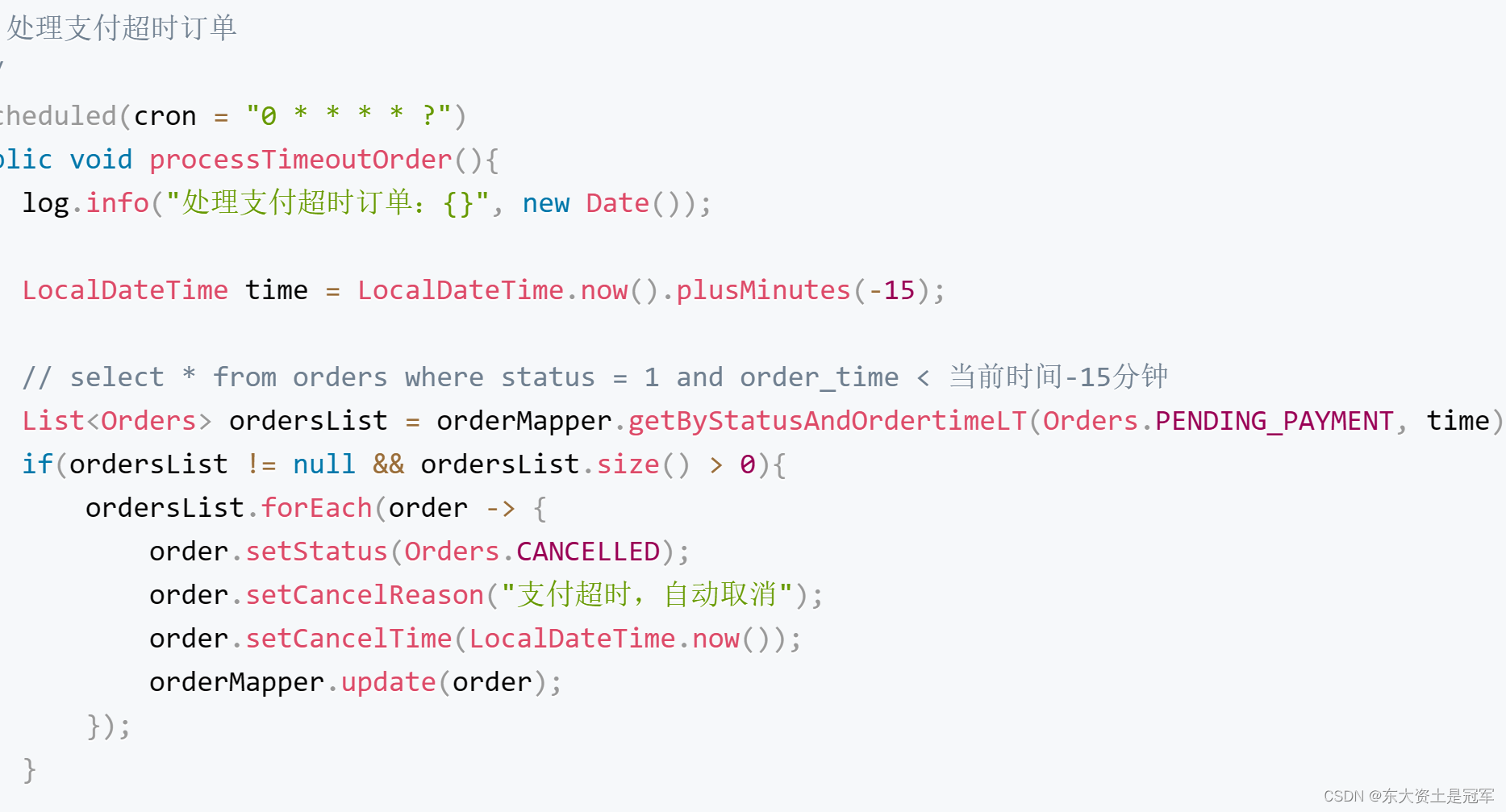

苍穹外卖(七) Spring Task 完成订单状态定时处理

Spring Task 完成订单状态定时处理, 如处理支付超时订单 Spring Task介绍 Spring Task 是Spring框架提供的任务调度工具,可以按照约定的时间自动执行某个代码逻辑。 应用场景: 信用卡每月还款提醒 火车票售票系统处理未支付订单 入职纪念日为用户发送通知 点外…...

【探索Linux】—— 强大的命令行工具 P.11(基础IO,文件操作)

阅读导航 前言一、C语言的文件操作二、C的文件操作三、Linux系统文件操作(I/O接口)1. open()⭕传入多个打开方式(按位或操作将不同的标志位组合在一起) 2. write()3. read()4. close()5. lseek() 温馨提示 前言 前面我们讲了C语言…...

前端练习项目(附带页面psd图片及react源代码)

一、前言 相信很多学完前端的小伙伴都想找个前端项目练练手,检测自己的学习成果。但是现在很多项目市面上都烂大街了。今天给大家推荐一个全新的项目——电子校园 项目位置:https://github.com/v5201314/eSchool 二、项目介绍(部分页面展示)ÿ…...

【从零开始学习Redis | 第三篇】在Java中操作Redis

前言: 本文算是一期番外,介绍一下如何在Java中使用Reids ,而其实基于Java我们有很多的开源框架可以用来操作redis,而我们今天选择介绍的是其中比较常用的一款:Spring Data Redis 目录 前言: Spring Data…...

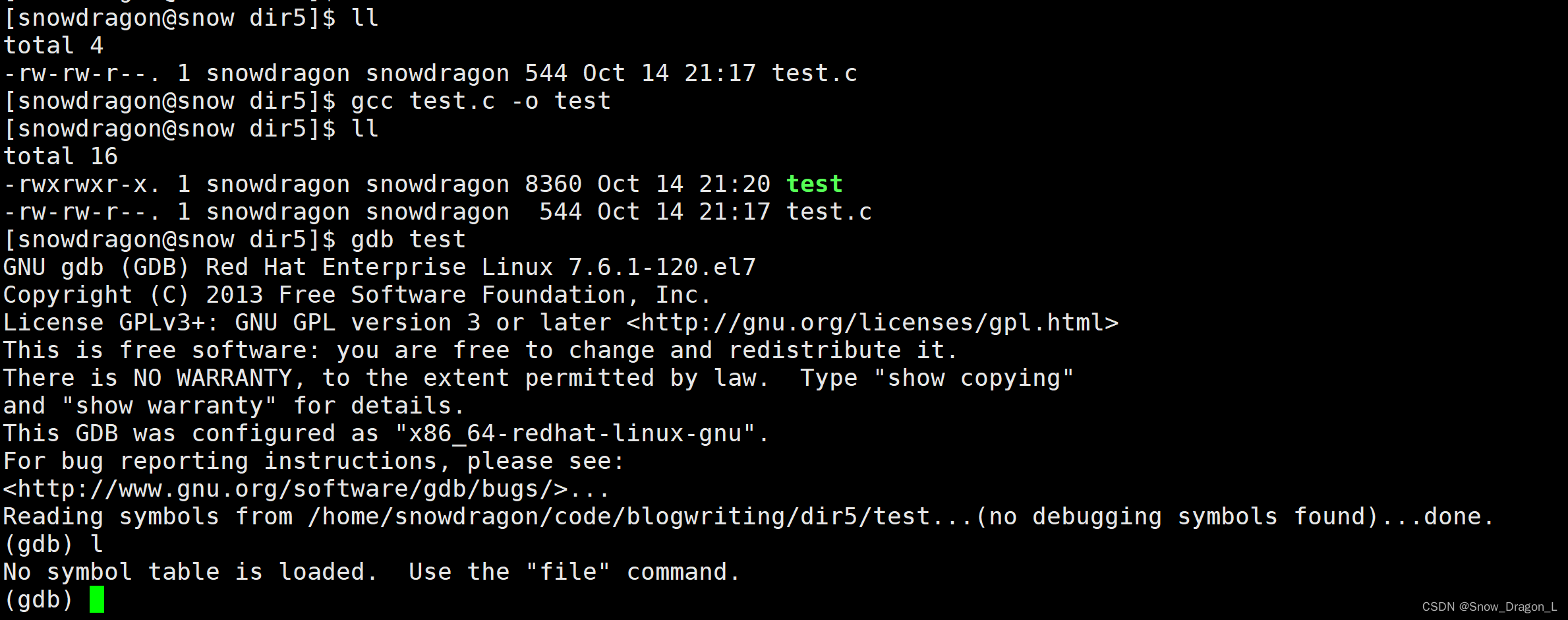

vim、gcc/g++、make/Makefile、yum、gdb

vim、gcc/g、make/Makefile、yum、gdb 一、Linux编辑器vim1、简介2、三种模式的概念(1)正常/普通/命令模式(Normal mode)(2)插入模式(Insert mode)(3)末行/底行模式(last line mode) 3、三种模式的切换4、正…...

2022最新版-李宏毅机器学习深度学习课程-P13 局部最小值与鞍点

一、优化失败的原因 局部最小值?鞍点? 二、数学推导分析 用泰勒公式展开 一项与梯度(L的一阶导)有关,一项与海赛矩阵(L的二阶导)有关 海瑟矩阵 VTHV通过海瑟矩阵的性质可以转为判断H是否是正…...

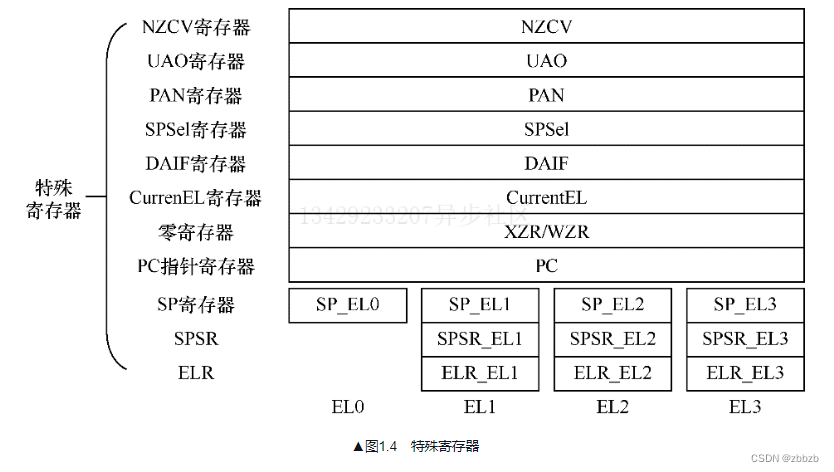

ARM架构的基本知识

ARM两种授权 体系结构授权, 一种硬件规范, 用来约定指令集, 芯片内部体系结构(内存管理, 高速缓存管理), 只约定每一条指令的格式, 行为规范, 参数, 客户根据这个规范自行设计与之兼容的处理器处理IP授权, ARM公司根据某个版本的体系结构设计处理器, 再把处理器设计方案授权给…...

网络安全(黑客技术)——如何高效自学

前言 前几天发布了一篇 网络安全(黑客)自学 没想到收到了许多人的私信想要学习网安黑客技术!却不知道从哪里开始学起!怎么学?如何学? 今天给大家分享一下,很多人上来就说想学习黑客,…...

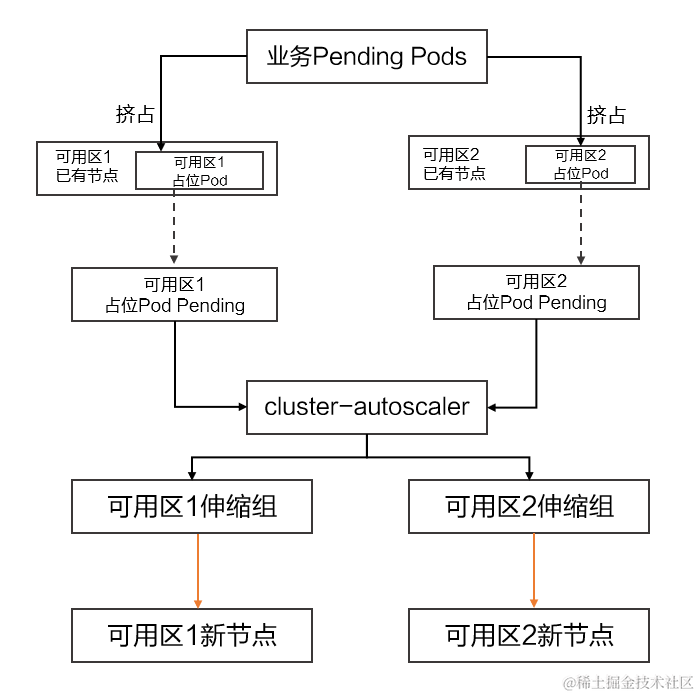

云原生场景下高可用架构的最佳实践

作者:刘佳旭(花名:佳旭),阿里云容器服务技术专家 引言 随着云原生技术的快速发展以及在企业 IT 领域的深入应用,云原生场景下的高可用架构,对于企业服务的可用性、稳定性、安全性越发重要。通…...

图论-最短路径算法-弗洛伊德算法与迪杰斯特拉算法

弗洛伊德算法: 弗洛伊德算法本质是动态规划,通过添加点进如可选择的点组成的集合的同时更新所有点之间的距离,从而得到每两个点之间的最短距离。 初始化: 创建一个二维数组 dist,其中 dist[i][j] 表示从节点 i 到节点…...

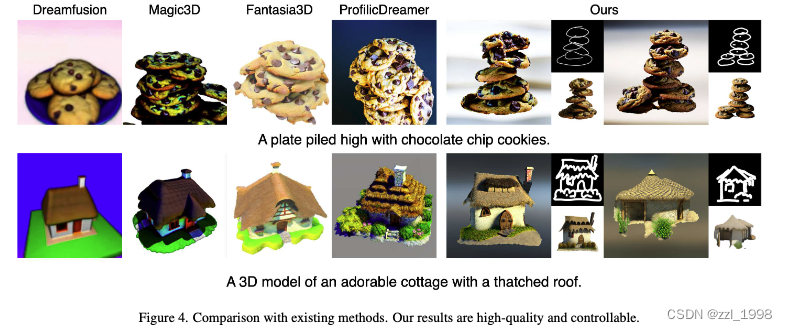

[23] IPDreamer: Appearance-Controllable 3D Object Generation with Image Prompts

pdf Text-to-3D任务中,对3D模型外观的控制不强,本文提出IPDreamer来解决该问题。在NeRF Training阶段,IPDreamer根据文本用ControlNet生成参考图,并将参考图作为Zero 1-to-3的控制条件,用基于Zero 1-to-3的SDS损失生成…...

深入理解React中的useEffect钩子函数

引言: React是一种流行的JavaScript库,它通过组件化和声明式编程的方式简化了前端开发。在React中,一个核心概念是组件的生命周期,其中包含了许多钩子函数,用于管理组件的不同阶段。其中之一就是useEffect钩子函数&…...

数字化时代的财务管理:挑战与机遇

导语:随着数字化技术的不断发展,财务管理正面临着前所未有的挑战和机遇。数字化不仅改变了财务数据的收集、处理和分析方式,还为财务决策提供了更多的依据和方向。本文将探讨数字化时代财务管理的新特点,以及如何利用数字化技术提…...

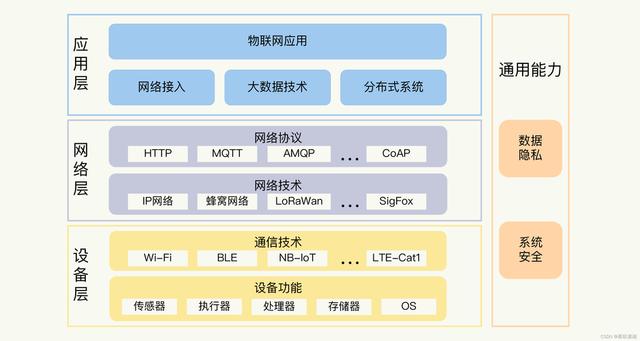

网络通信协议-HTTP、WebSocket、MQTT的比较与应用

在今天的数字化世界中,各种通信协议起着关键的作用,以确保信息的传递和交换。HTTP、WebSocket 和 MQTT 是三种常用的网络通信协议,它们各自适用于不同的应用场景。本文将比较这三种协议,并探讨它们的主要应用领域。 HTTPÿ…...

、dataloader、长短期记忆网络(LSTM)、门控循环单元(GRU)、超参数对比)

【深度学习】深度学习实验四——循环神经网络(RNN)、dataloader、长短期记忆网络(LSTM)、门控循环单元(GRU)、超参数对比

一、实验内容 实验内容包含要进行什么实验,实验的目的是什么,实验用到的算法及其原理的简单介绍。 1.1 循环神经网络 (1)理解序列数据处理方法,补全面向对象编程中的缺失代码,并使用torch自带数据工具将数据封装为dataloader。 (2)分别采用手动方式以及调用接口方式…...

DB2分区表详解

一、分区表基本概念 当表中的数据量不断增大,查询数据的速度就会变慢,应用程序的性能就会下降,这时就应该考虑对表进行分区。分区后的表称为分区表。 表进行分区后,逻辑上表仍然是一张完整的表,只是将表中的数据在物理上存放到多个“表空间”(物理文件上),这样查询数据时…...

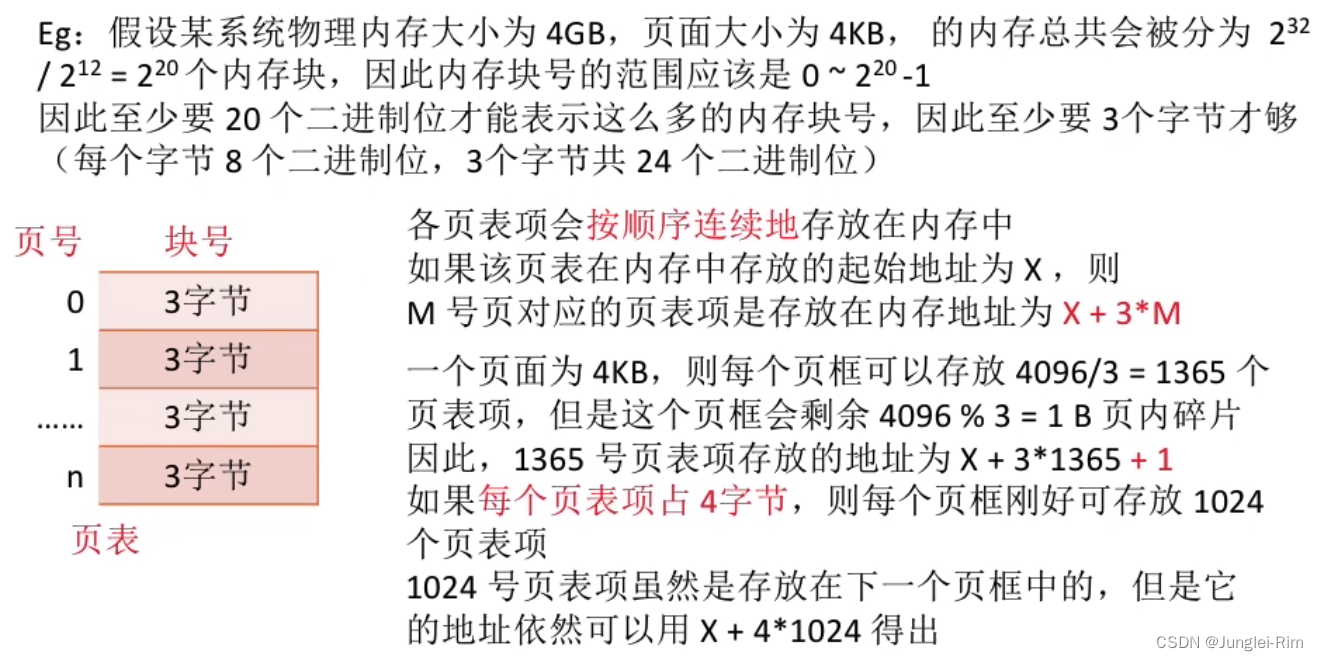

基本地址变换机构

基本地址变换机构:用于实现逻辑地址到物理地址转换的一组硬件机构。 关于页号页表的定义,放个本人的传送门 1.页表寄存器 基本地址变换机构可以借助进程的页表将逻辑地址转换为物理地址。 1.作用 通常会在系统中设置一个页表寄存器(PTR&…...

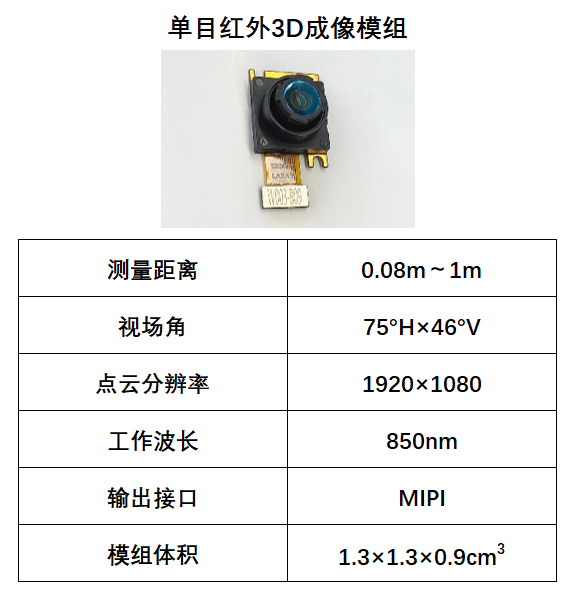

以单颗CMOS摄像头重构三维场景,维悟光子发布单目红外3D成像模组

维悟光子近期发布全新单目红外3D成像模组,现可提供下游用户进行测试导入。通过结合微纳光学元件编码和人工智能算法解码,维悟光子单目红外3D成像模组采用单颗摄像头,通过单帧拍摄,可同时获取像素级配准的3D点云和红外图像信息,可被应用于机器人、生物识别等广阔领域。 市场…...

Jinja2模板注入 | python模板注入特殊属性 / 对象讲解

在进行模板利用的时候需要使用特殊的属性和对象进行利用,这里对这些特殊属性及方法进行讲解 以下实验输出python3版本为 3.10.4, python2版本为 2.7.13 特殊属性 __class__ 类实例上使用,它用于获取该实例对应的类__base__ 用于获取父类__mr…...

[特殊字符] 智能合约中的数据是如何在区块链中保持一致的?

🧠 智能合约中的数据是如何在区块链中保持一致的? 为什么所有区块链节点都能得出相同结果?合约调用这么复杂,状态真能保持一致吗?本篇带你从底层视角理解“状态一致性”的真相。 一、智能合约的数据存储在哪里…...

day52 ResNet18 CBAM

在深度学习的旅程中,我们不断探索如何提升模型的性能。今天,我将分享我在 ResNet18 模型中插入 CBAM(Convolutional Block Attention Module)模块,并采用分阶段微调策略的实践过程。通过这个过程,我不仅提升…...

渗透实战PortSwigger靶场-XSS Lab 14:大多数标签和属性被阻止

<script>标签被拦截 我们需要把全部可用的 tag 和 event 进行暴力破解 XSS cheat sheet: https://portswigger.net/web-security/cross-site-scripting/cheat-sheet 通过爆破发现body可以用 再把全部 events 放进去爆破 这些 event 全部可用 <body onres…...

关于iview组件中使用 table , 绑定序号分页后序号从1开始的解决方案

问题描述:iview使用table 中type: "index",分页之后 ,索引还是从1开始,试过绑定后台返回数据的id, 这种方法可行,就是后台返回数据的每个页面id都不完全是按照从1开始的升序,因此百度了下,找到了…...

JVM垃圾回收机制全解析

Java虚拟机(JVM)中的垃圾收集器(Garbage Collector,简称GC)是用于自动管理内存的机制。它负责识别和清除不再被程序使用的对象,从而释放内存空间,避免内存泄漏和内存溢出等问题。垃圾收集器在Ja…...

爬虫基础学习day2

# 爬虫设计领域 工商:企查查、天眼查短视频:抖音、快手、西瓜 ---> 飞瓜电商:京东、淘宝、聚美优品、亚马逊 ---> 分析店铺经营决策标题、排名航空:抓取所有航空公司价格 ---> 去哪儿自媒体:采集自媒体数据进…...

全面解析各类VPN技术:GRE、IPsec、L2TP、SSL与MPLS VPN对比

目录 引言 VPN技术概述 GRE VPN 3.1 GRE封装结构 3.2 GRE的应用场景 GRE over IPsec 4.1 GRE over IPsec封装结构 4.2 为什么使用GRE over IPsec? IPsec VPN 5.1 IPsec传输模式(Transport Mode) 5.2 IPsec隧道模式(Tunne…...

JAVA后端开发——多租户

数据隔离是多租户系统中的核心概念,确保一个租户(在这个系统中可能是一个公司或一个独立的客户)的数据对其他租户是不可见的。在 RuoYi 框架(您当前项目所使用的基础框架)中,这通常是通过在数据表中增加一个…...

用机器学习破解新能源领域的“弃风”难题

音乐发烧友深有体会,玩音乐的本质就是玩电网。火电声音偏暖,水电偏冷,风电偏空旷。至于太阳能发的电,则略显朦胧和单薄。 不知你是否有感觉,近两年家里的音响声音越来越冷,听起来越来越单薄? —…...

【生成模型】视频生成论文调研

工作清单 上游应用方向:控制、速度、时长、高动态、多主体驱动 类型工作基础模型WAN / WAN-VACE / HunyuanVideo控制条件轨迹控制ATI~镜头控制ReCamMaster~多主体驱动Phantom~音频驱动Let Them Talk: Audio-Driven Multi-Person Conversational Video Generation速…...