kafka3.X集群安装(不使用zookeeper)

参考: 【kafka专栏】不用zookeeper怎么安装kafka集群-最新kafka3.0版本

一、kafka集群实例角色规划

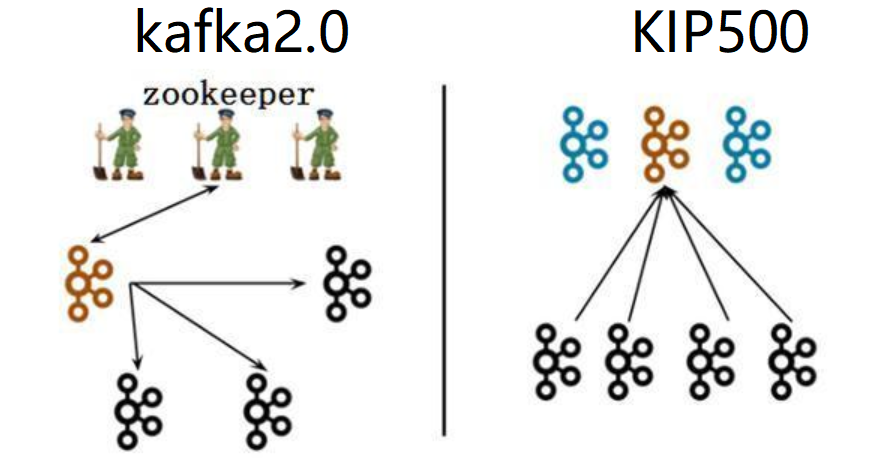

在本专栏的之前的一篇文章《kafka3种zk的替代方案》已经为大家介绍过在kafka3.0种已经可以将zookeeper去掉。

上图中黑色代表broker(消息代理服务),褐色/蓝色代表Controller(集群控制器服务)

- 左图(kafka2.0):一个集群所有节点都是broker角色,kafka从三个broker中选举出来一个Controller控制器,控制器将集群元数据信息(比如主题分类、消费进度等)保存到zookeeper,用于集群各节点之间分布式交互。

- 右图(kafka3.0):假设一个集群有四个broker,指定三个作为Conreoller角色(蓝色),从三个Controller中选举出来一个Controller作为主控制器(褐色),其他的2个备用。zookeeper不再被需要!相关的元数据信息以kafka日志的形式存在(即:以消息队列消息的形式存在)。

- controller通信端口:9093, 作用与zk的2181端口类似 。

在搭建kafka3.0集群之前, 我们需要先做好kafka实例角色规划。(四个broker, 需要通过主动配置指定三个作为Controller, Controller需要奇数个, 这一点和zk是一样的)

| 主机名称 | ip | 角色 | node.id |

|---|---|---|---|

| kafka-vm1 | 192.168.1.111 | broker,controller | 1 |

| kafka-vm2 | 192.168.1.112 | broker,controller | 2 |

| kafka-vm3 | 192.168.1.113 | broker,controller | 3 |

| kafka-vm4 | 192.168.1.114 | broker | 4 |

二、准备工作

- kafka3.x不再支持JDK8,建议安装JDK11或JDK17。

- 新建kafka持久化日志数据mkdir -p /data/kafka;并保证安装kafka的用户具有该目录的读写权限。

各个机器节点执行:

- # 安装jdk(kafka3.x不再支持JDK8,建议安装JDK11或JDK17, 这里安装jdk11)

- # 下载安装jdk11, 参考: https://blog.csdn.net/justlpf/article/details/127268046

-

- # 下载kafka

- adduser kafka

- cd /opt

- wget https://downloads.apache.org/kafka/3.3.1/kafka_2.12-3.3.1.tgz

- tar -xf kafka_2.12-3.3.1.tgz

-

- chown -R kafka:kafka kafka_2.12-3.3.1*

-

- mkdir -p /data/kafka

- chown -R kafka:kafka /data/kafka

三、修改Kraft协议配置文件

在kafka3.x版本中,使用Kraft协议代替zookeeper进行集群的Controller选举,所以要针对它进行配置。

vi /opt/kafka_2.12-3.3.1/config/kraft/server.properties具体配置参数如下:

- # data-vm1节点

- node.id=1

- process.roles=broker,controller

- listeners=PLAINTEXT://data-vm1:9092,CONTROLLER://data-vm1:9093

- advertised.listeners=PLAINTEXT://:9092

- controller.quorum.voters=1@data-vm1:9093,2@data-vm2:9093,3@data-vm3:9093

- log.dirs=/data/kafka/

-

- # data-vm2节点

- node.id=2

- process.roles=broker,controller

- listeners=PLAINTEXT://data-vm2:9092,CONTROLLER://data-vm2:9093

- advertised.listeners=PLAINTEXT://:9092

- controller.quorum.voters=1@data-vm1:9093,2@data-vm2:9093,3@data-vm3:9093

- log.dirs=/data/kafka/

-

- # data-vm3节点

- node.id=3

- process.roles=broker,controller

- listeners=PLAINTEXT://data-vm3:9092,CONTROLLER://data-vm3:9093

- advertised.listeners=PLAINTEXT://:9092

- controller.quorum.voters=1@data-vm1:9093,2@data-vm2:9093,3@data-vm3:9093

- log.dirs=/data/kafka/

node.id:这将作为集群中的节点 ID,唯一标识,按照我们事先规划好的(上文),在不同的服务器上这个值不同。其实就是kafka2.0中的broker.id,只是在3.0版本中kafka实例不再只担任broker角色,也有可能是controller角色,所以改名叫做node节点。process.roles:一个节点可以充当broker或controller或两者兼而有之。按照我们事先规划好的(上文),在不同的服务器上这个值不同。多个角色用逗号分开。listeners: broker将使用9092端口,而kraft controller控制器将使用9093端口。advertised.listeners: 这里指定kafka通过代理暴漏的地址,如果都是局域网使用,就配置PLAINTEXT://:9092即可。controller.quorum.voters:这个配置用于指定controller主控选举的投票节点,所有process.roles包含controller角色的规划节点都要参与,即:zimug1、zimug2、zimug3。其配置格式为:node.id1@host1:9093,node.id2@host2:9093log.dirs:kafka 将存储数据的日志目录,在准备工作中创建好的目录。

所有kafka节点都要按照上文中的节点规划进行配置,完成config/kraft/server.properties配置文件的修改。

四、格式化存储目录

生成一个唯一的集群ID(在一台kafka服务器上执行一次即可),这一个步骤是在安装kafka2.0版本的时候不存在的。

使用生成的集群ID+配置文件格式化存储目录log.dirs,

所以这一步确认配置及路径确实存在,

并且kafka用户有访问权限(检查准备工作是否做对)。

每一台主机服务器都要执行命令:

格式化操作完成之后,log.dirs目录下多出一个Meta.properties文件,存储了当前的kafka节点的id(node.id),当前节点属于哪个集群(cluster.id)

- [root@data-vm2 ~]# ll /data/kafka/

- 总用量 8

- -rw-r--r--. 1 root root 249 10月 11 18:23 bootstrap.checkpoint

- -rw-r--r--. 1 root root 86 10月 11 18:23 meta.properties

-

- $ cat /data/kafka/meta.properties

- #

- #Tue Apr 12 07:39:07 CST 2022

- node.id=1

- version=1

- cluster.id=SzIhECn-QbCLzIuNxk1A2A

五、 启动集群,完成基础测试

zimug1 zimug2 zimug3是三台应用服务器的主机名称(参考上文中的角色规划),实现方式已经在本专栏《linux主机与ip解析》中进行了说明。将下面的命令集合保存为一个shell脚本,并赋予执行权限。执行该脚本即可启动kafka集群所有的节点,前提是:你已经按照本专栏的《集群各节点之间的ssh免密登录》安装方式做了集群各节点之间的ssh免密登录。

启动命令:

- bin/kafka-server-start.sh \

- /opt/kafka_2.12-3.3.1/config/kraft/server.properties

-

- # 后台运行

- nohup bin/kafka-server-start.sh \

- /opt/kafka_2.12-3.3.1/config/kraft/server.properties 2>&1 &

脚本:

- #!/bin/bash

- kafkaServers='data-vm1 data-vm2 data-vm3'

- #启动所有的kafka

- for kafka in $kafkaServers

- do

- ssh -T $kafka <<EOF

- nohup /opt/kafka_2.12-3.3.1/bin/kafka-server-start.sh /opt/kafka_2.12-3.3.1/config/kraft/server.properties 1>/dev/null 2>&1 &

- EOF

- echo 从节点 $kafka 启动kafka3.0...[ done ]

- sleep 5

- done

六、一键停止集群脚本

一键停止kafka集群各节点的脚本,与启动脚本的使用方式及原理是一样的。

停止命令:

/opt/kafka_2.12-3.3.1/bin/kafka-server-stop.sh执行脚本:

- #!/bin/bash

- kafkaServers='data-vm1 data-vm2 data-vm3'

- #停止所有的kafka

- for kafka in $kafkaServers

- do

- ssh -T $kafka <<EOF

- cd /opt/kafka_2.12-3.3.1

- bin/kafka-server-stop.sh

- EOF

- echo 从节点 $kafka 停止kafka...[ done ]

- sleep 5

- done

七、测试Kafka集群

7.1 创建topic

- [root@data-vm1 kafka_2.12-3.3.1]# bin/kafka-topics.sh \

- --create \

- --topic quickstart-events \

- --bootstrap-server data-vm4:9092

-

- Created topic quickstart-events.

- [root@data-vm1 kafka_2.12-3.3.1]#

-

- #

- [root@data-vm1 kafka_2.12-3.3.1]# bin/kafka-topics.sh \

- --create \

- --topic quickstart-events \

- --bootstrap-server data-vm1:9092,data-vm2:9092,data-vm3:9092

7.2 查看topic列表

- bin/kafka-topics.sh \

- --list \

- --bootstrap-server data-vm4:9092

-

- #

- bin/kafka-topics.sh \

- --list \

- --bootstrap-server data-vm1:9092,data-vm2:9092,data-vm3:9092,data-vm4:9092

7.3 查看消息详情

- [root@data-vm1 kafka_2.12-3.3.1]# bin/kafka-topics.sh \

- --describe \

- --topic quickstart-events \

- --bootstrap-server data-vm3:9092

-

- Topic: quickstart-events TopicId: zSOJC6wNRRGQ4MudfHLGvQ PartitionCount: 1 ReplicationFactor: 1 Configs: segment.bytes=1073741824

- Topic: quickstart-events Partition: 0 Leader: 1 Replicas: 1 Isr: 1

-

- [root@data-vm1 kafka_2.12-3.3.1]#

7.4 生产消息

- [root@data-vm1 kafka_2.12-3.3.1]# bin/kafka-console-producer.sh \

- --topic quickstart-events \

- --bootstrap-server data-vm1:9092

-

- # 参考: 创建并配置topic

- bin/kafka-topics.sh \

- --bootstrap-server localhost:9092 \

- --create \

- --topic my-topic \

- --partitions 1 \

- --replication-factor 1 \

- --config max.message.bytes=64000 \

- --config flush.messages=1

-

- # ------------------------- 参考 ------------------------ #

- # 1: 修改已创建topic配置

- # (Overrides can also be changed or set later using the alter configs command.)

- bin/kafka-configs.sh \

- --bootstrap-server localhost:9092 \

- --entity-type topics \

- --entity-name my-topic \

- --alter \

- --add-config max.message.bytes=128000

-

- # 2: 检查已修改的topic配置是否生效

- # (To check overrides set on the topic you can do)

- bin/kafka-configs.sh \

- --bootstrap-server localhost:9092 \

- --entity-type topics \

- --entity-name my-topic \

- --describe

-

- # 3. 恢复到原来的配置

- # (To remove an override you can do)

- bin/kafka-configs.sh \

- --bootstrap-server localhost:9092 \

- --entity-type topics \

- --entity-name my-topic \

- --alter \

- --delete-config max.message.bytes

-

- # 4. 增加分区数

- # (To add partitions you can do)

- bin/kafka-topics.sh \

- --bootstrap-server broker_host:port \

- --alter \

- --topic my_topic_name \

- --partitions 40

-

- # 5. 添加配置

- # (To add configs:)

- bin/kafka-configs.sh \

- --bootstrap-server broker_host:port \

- --entity-type topics \

- --entity-name my_topic_name \

- --alter \

- --add-config x=y

-

- # 6. 移除配置

- # (To remove a config:)

- bin/kafka-configs.sh \

- --bootstrap-server broker_host:port \

- --entity-type topics \

- --entity-name my_topic_name \

- --alter \

- --delete-config x

-

- # 7. 删除topic

- # (And finally deleting a topic:)

- bin/kafka-topics.sh \

- --bootstrap-server broker_host:port \

- --delete \

- --topic my_topic_name

7.5 消费消息

7.6 查看消费者组

- # 检查消费者postition

- # Checking consumer position

- bin/kafka-consumer-groups.sh \

- --bootstrap-server localhost:9092 \

- --describe \

- --group my-group

-

- TOPIC PARTITION CURRENT-OFFSET LOG-END-OFFSET LAG CONSUMER-ID HOST CLIENT-ID

- my-topic 0 2 4 2 consumer-1-029af89c-873c-4751-a720-cefd41a669d6 /127.0.0.1 consumer-1

- my-topic 1 2 3 1 consumer-1-029af89c-873c-4751-a720-cefd41a669d6 /127.0.0.1 consumer-1

- my-topic 2 2 3 1 consumer-2-42c1abd4-e3b2-425d-a8bb-e1ea49b29bb2 /127.0.0.1 consumer-2

7.7 查看消费者组列表

- # list all consumer groups across all topics

- bin/kafka-consumer-groups.sh \

- --bootstrap-server localhost:9092 \

- --list

-

- test-consumer-group

-

-

- # To view offsets, as mentioned earlier,

- # we "describe" the consumer group like this:

- bin/kafka-consumer-groups.sh \

- --bootstrap-server localhost:9092 \

- --describe \

- --group my-group

-

- TOPIC PARTITION CURRENT-OFFSET LOG-END-OFFSET LAG CONSUMER-ID HOST CLIENT-ID

- topic3 0 241019 395308 154289 consumer2-e76ea8c3-5d30-4299-9005-47eb41f3d3c4 /127.0.0.1 consumer2

- topic2 1 520678 803288 282610 consumer2-e76ea8c3-5d30-4299-9005-47eb41f3d3c4 /127.0.0.1 consumer2

- topic3 1 241018 398817 157799 consumer2-e76ea8c3-5d30-4299-9005-47eb41f3d3c4 /127.0.0.1 consumer2

- topic1 0 854144 855809 1665 consumer1-3fc8d6f1-581a-4472-bdf3-3515b4aee8c1 /127.0.0.1 consumer1

- topic2 0 460537 803290 342753 consumer1-3fc8d6f1-581a-4472-bdf3-3515b4aee8c1 /127.0.0.1 consumer1

- topic3 2 243655 398812 155157 consumer4-117fe4d3-c6c1-4178-8ee9-eb4a3954bee0 /127.0.0.1 consumer4

-

- # 更多配置参考:

- # https://kafka.apache.org/32/documentation.html#uses

相关文章:

kafka3.X集群安装(不使用zookeeper)

参考: 【kafka专栏】不用zookeeper怎么安装kafka集群-最新kafka3.0版本 一、kafka集群实例角色规划 在本专栏的之前的一篇文章《kafka3种zk的替代方案》已经为大家介绍过在kafka3.0种已经可以将zookeeper去掉。 上图中黑色代表broker(消息代理服务)&…...

2023 年 的 DBA 有哪些变化?

作者:Craig S. Mullins 数据库专家,IBM 优化冠军,DB2 金牌顾问以及 IDUG 名人堂成员,数据库类畅销书作者,著有《DB2 Developers Guide》、《Database Administration: The Complete Guide to DBA Practices & Pro…...

vs2022 使用git同步报错以及解决每次推送要输入密码问题

1.使用 git GUI工具,例如:TortoiseGit ,把全局配置文件这样设置一下 设置全局.config ,这样即可。 [credential] helper store 2.如果推送代码或拉取代码一直失败,在当前的仓库下面,使用以下命令来重置一下密码 git …...

有哪些适用于 Windows 的PDF 阅读器?免费 PDF 阅读器清单

探索适用于 Windows 10 和 11 的最佳 PDF 阅读器 适用于 Windows 10 和 Windows 11 的最佳 PDF 阅读器让您可以在台式计算机上查看和共享文档。 最好的PDF 编辑器和免费的 PDF 编辑器配备了先进的工具,可以跨不同的操作系统工作。但是,当您只需要查看和…...

避雷!新增2本期刊被标记为「On Hold」,1区TOP刊仍在调查中!

近期小编在Master Journal List上查询期刊时偶然发现,又有2本期刊被科睿唯安标记为「On Hold」! 这2本期刊分别为MIGRATION LETTERS和REVISTA DE GESTAO E SECRETARIADO-GESEC. 此外还有6本期刊被标记为「On Hold」,目前共计8本期刊被「On …...

iOS 配置通用链接(Universal Link)服务端和开发者后台都配置好了,还是跳转不到App

目录 一、什么是 Universal Link? 1.背景介绍 2.特点 3.运行机制原理&流程图 二、配置教程 1.第一步:开启 Associated Domains 服务 1.1 开通 Associated Domains 2.第二步:服务器配置 apple-app-site-association(AAS…...

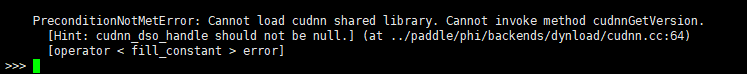

【环境】Linux下Anaconda/ Miniconda安装+百度Paddle环境搭建+Cudnn(3090显卡+CUDA11.8+cudnn8.6.0)

清华源帮助链接:https://mirror.tuna.tsinghua.edu.cn/help/anaconda/ 下载链接:https://mirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/ 其他深度学习环境相关博文:【stable-diffusion】4090显卡下dreambooth、lora、sd模型微调的GUI环境…...

【Python机器学习】零基础掌握AdaBoostRegressor集成学习

有没有经历过这样的状况:需要预测未来房价走势,但传统的预测方法并不总是准确? 房价预测一直是人们关注的热点话题,无论是房产商、购房者,还是政府,都需要准确地知道未来房价的走势。那么,有没有一种更加精准、稳定的预测方法呢?答案是有的——AdaBoost Regressor算法…...

各种添加路由的方法

Linux 篇: ipv4: #添加到主机的路由 # route add –host 192.168.168.110 dev eth0 # route add –host 192.168.168.119 gw 192.168.168.1 #添加到网络的路由 # route add –net IP netmask MASK eth0 # route add –net IP netmask MASK gw IP # route add –n…...

MySQL外键

目录 一.外键 1.表与表之间建立关系 2.什么是外键 3.一对多关系 4.多对多关系 (1)建表会遇到的问题 (2)解决循环建表的问题 5.一对一关系、 6.小结 二.多表查询 1.数据准备 2.多表查询案例 (1)…...

)

自制数据库迁移工具-C版-02-HappySunshineV1.1-(支持Gbase8a)

目录 一、环境信息 二、简述 三、升级点 四、支持功能 五、安装包下载地址 六、配置参数介绍 七、安装步骤 1、配置环境变量 2、生效环境变量 3、检验动态链接是否正常 4、修改配置文件MigrationConfig.txt 八、运行效果 一、环境信息 名称值CPUIntel(R) Core(TM) i…...

k8s创建pod-affinity亲和性时报错解决办法

1.如下报错 Error from server (BadRequest): error when creating “pod-required-affinity-demo-2.yaml”: Pod in version “v1” cannot be handled as a Pod: json: cannot unmarshal string into Go struct field LabelSelectorRequirement.spec.affinity.podAffinity.re…...

基于边缘智能网关的储能系统安全监测管理方案

“储能系统充电”是配套新能源汽车产业发展的重要应用之一。得益于电池技术的发展,新能源汽车正逐步迈入快充时代,由于在使用快速充电桩时,可能导致用电峰值负荷超过电网的承载能力,对于电网的稳定性和持续性会有较大影响…...

大数据Flink(一百零一):SQL 表值函数(Table Function)

文章目录 SQL 表值函数(Table Function) SQL 表值函数(Table Function) Python UDTF,即 Python TableFunction,针对每一条输入数据,Python UDTF 可以产生 0 条、1 条或者多条输出数据,此外,一条输出数据可以包含多个列。比如以下示例,定义了一个名字为 split 的Pyt…...

内核进程初始化和创建

task_struct 1.进程的状态 分时技术进行多进程调度 重点:进程的创建是如何的? linux在初始化的过程中那个会进行0号进程的创建,fork sched_init(); 做了什么 内核态 不可抢占 用户态 可以抢占 move_to_user_mode(); 把内核状态切换到…...

【进程概念④】:进程地址空间(虚拟内存与物理内存)

【进程概念④】:进程地址空间(虚拟内存与物理内存) 一.进程地址空间二.分页与虚拟地址①.what②.how③.why 三.页表细节①.标志位②.缺页中断 四.总结意义 一.进程地址空间 你觉得我们代码中写的数据都在哪存储着呢? 在内存里存着࿰…...

C语言内存四分区

四个区域:代码区,全局区,栈区,堆区 ①代码区 存放所写代码,二进制内容 ②全局区(又分data区和bss区) 存放全局变量,静态变量,常量 data区:已经初始化的全局变…...

数据可视化报表分享:区域管理驾驶舱

在零售数据分析中,区域管理驾驶舱报表是用来分析企业运营数据,以制定销售策略和提高利润。因此这张报表需要整合大量数据,数据整合、分析、指标计算的工作量极大,在讲究高效率、高度及时性的大数据时代,BI数据可视化分…...

解决pip安装包后但是Pycharm检测不到

首先要知道python找包的原理:原理 之后把一下代码打印一下: import sys print(sys.executable)# /usr/bin/python2 print(sys.path)# [/usr/lib/python2.7, /usr/lib/python2.7/dist-packages, /usr/local/lib/python2.7/dist-packages] print(sys.prefi…...

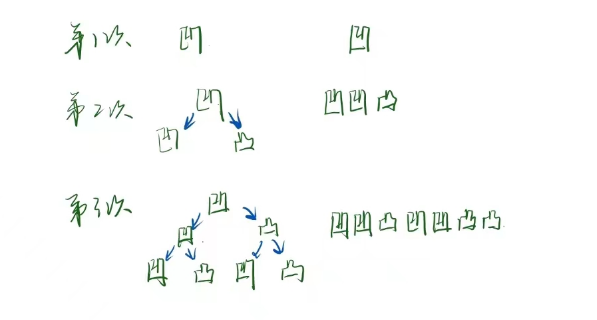

折纸问题

折纸的次数 —— 从上到下的折痕 本质上是中序遍历的问题,因为每一次在已有的折痕后折的时候,当前折痕上的折痕一定为凹,当前折痕下的折痕一定为凸 。实际模拟了一个不存在的二叉树结构的中序遍历。 注:折纸折几次整颗二叉树就有…...

【快手拥抱开源】通过快手团队开源的 KwaiCoder-AutoThink-preview 解锁大语言模型的潜力

引言: 在人工智能快速发展的浪潮中,快手Kwaipilot团队推出的 KwaiCoder-AutoThink-preview 具有里程碑意义——这是首个公开的AutoThink大语言模型(LLM)。该模型代表着该领域的重大突破,通过独特方式融合思考与非思考…...

ServerTrust 并非唯一

NSURLAuthenticationMethodServerTrust 只是 authenticationMethod 的冰山一角 要理解 NSURLAuthenticationMethodServerTrust, 首先要明白它只是 authenticationMethod 的选项之一, 并非唯一 1 先厘清概念 点说明authenticationMethodURLAuthenticationChallenge.protectionS…...

)

【HarmonyOS 5 开发速记】如何获取用户信息(头像/昵称/手机号)

1.获取 authorizationCode: 2.利用 authorizationCode 获取 accessToken:文档中心 3.获取手机:文档中心 4.获取昵称头像:文档中心 首先创建 request 若要获取手机号,scope必填 phone,permissions 必填 …...

2023赣州旅游投资集团

单选题 1.“不登高山,不知天之高也;不临深溪,不知地之厚也。”这句话说明_____。 A、人的意识具有创造性 B、人的认识是独立于实践之外的 C、实践在认识过程中具有决定作用 D、人的一切知识都是从直接经验中获得的 参考答案: C 本题解…...

招商蛇口 | 执笔CID,启幕低密生活新境

作为中国城市生长的力量,招商蛇口以“美好生活承载者”为使命,深耕全球111座城市,以央企担当匠造时代理想人居。从深圳湾的开拓基因到西安高新CID的战略落子,招商蛇口始终与城市发展同频共振,以建筑诠释对土地与生活的…...

scikit-learn机器学习

# 同时添加如下代码, 这样每次环境(kernel)启动的时候只要运行下方代码即可: # Also add the following code, # so that every time the environment (kernel) starts, # just run the following code: import sys sys.path.append(/home/aistudio/external-libraries)机…...

解读《网络安全法》最新修订,把握网络安全新趋势

《网络安全法》自2017年施行以来,在维护网络空间安全方面发挥了重要作用。但随着网络环境的日益复杂,网络攻击、数据泄露等事件频发,现行法律已难以完全适应新的风险挑战。 2025年3月28日,国家网信办会同相关部门起草了《网络安全…...

怎么让Comfyui导出的图像不包含工作流信息,

为了数据安全,让Comfyui导出的图像不包含工作流信息,导出的图像就不会拖到comfyui中加载出来工作流。 ComfyUI的目录下node.py 直接移除 pnginfo(推荐) 在 save_images 方法中,删除或注释掉所有与 metadata …...

Kafka主题运维全指南:从基础配置到故障处理

#作者:张桐瑞 文章目录 主题日常管理1. 修改主题分区。2. 修改主题级别参数。3. 变更副本数。4. 修改主题限速。5.主题分区迁移。6. 常见主题错误处理常见错误1:主题删除失败。常见错误2:__consumer_offsets占用太多的磁盘。 主题日常管理 …...

Python 训练营打卡 Day 47

注意力热力图可视化 在day 46代码的基础上,对比不同卷积层热力图可视化的结果 import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader import matplotlib.pypl…...