Hive之set参数大全-4

F

指定在使用 FETCH 命令提取查询结果时的序列化/反序列化器

hive.fetch.output.serde 是 Hive 的一个配置参数,用于指定在使用 FETCH 命令提取查询结果时的序列化/反序列化器。

以下是一个示例:

-- 设置 hive.fetch.output.serde 为 org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe

SET hive.fetch.output.serde=org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe;

在上述示例中,将 hive.fetch.output.serde 设置为 org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe,表示在使用 FETCH 命令提取查询结果时使用 LazySimpleSerDe 进行序列化/反序列化。

hive.fetch.output.serde 主要用于指定提取查询结果时使用的序列化/反序列化器。这个参数的设置可能影响到查询结果的展示方式以及提取效率。

在一般情况下,可以使用 Hive 默认的序列化/反序列化器,不需要显式地设置 hive.fetch.output.serde。但如果需要自定义序列化/反序列化过程,可以通过设置这个参数来指定相应的 SerDe 类。

是否启用查询结果的聚合功能,即是否启用 Fetch Task 的聚合优化

hive.fetch.task.aggr 是 Hive 的一个配置参数,用于控制是否启用查询结果的聚合功能,即是否启用 Fetch Task 的聚合优化。

以下是一个示例:

-- 设置 hive.fetch.task.aggr 为 true

SET hive.fetch.task.aggr=true;

在上述示例中,将 hive.fetch.task.aggr 设置为 true,表示启用查询结果的聚合功能。

-- 设置 hive.fetch.task.aggr 为 false

SET hive.fetch.task.aggr=false;

在上述示例中,将 hive.fetch.task.aggr 设置为 false,表示禁用查询结果的聚合功能。

当启用聚合功能时,Hive 在执行查询时会尝试将多个 Fetch Task 的结果聚合成一个结果,以减少数据传输和提高查询性能。这在处理大量数据时可能会带来一定的性能优势。

在一般情况下,可以根据查询的特性和性能需求来决定是否启用 hive.fetch.task.aggr。在某些场景下,可能会因为特定的查询或数据分布导致聚合功能并不会带来性能优势,此时禁用聚合功能可能更为合适。

控制是否启用 Fetch Task 的转换功能

hive.fetch.task.conversion 是 Hive 的一个配置参数,用于控制是否启用 Fetch Task 的转换功能。

以下是一个示例:

-- 设置 hive.fetch.task.conversion 为 true

SET hive.fetch.task.conversion=true;

在上述示例中,将 hive.fetch.task.conversion 设置为 true,表示启用 Fetch Task 的转换功能。

-- 设置 hive.fetch.task.conversion 为 false

SET hive.fetch.task.conversion=false;

在上述示例中,将 hive.fetch.task.conversion 设置为 false,表示禁用 Fetch Task 的转换功能。

启用 Fetch Task 转换功能时,Hive 将尝试将一些 MapReduce 任务转换为 Fetch Task,以减少任务的执行时间和提高查询性能。这个功能主要适用于某些特定类型的查询,如小规模查询或对单一分区的查询。

在一般情况下,可以根据查询的特性和性能需求来决定是否启用 hive.fetch.task.conversion。在某些场景下,可能会因为特定的查询或数据分布导致转换功能并不会带来性能优势,此时禁用转换功能可能更为合适。

设置启用 Fetch Task 转换的阈值

hive.fetch.task.conversion.threshold 是 Hive 的一个配置参数,用于设置启用 Fetch Task 转换的阈值。

以下是一个示例:

-- 设置 hive.fetch.task.conversion.threshold 为 100000

SET hive.fetch.task.conversion.threshold=100000;

在上述示例中,将 hive.fetch.task.conversion.threshold 设置为 100000,表示设置 Fetch Task 转换的阈值为 100,000。

Fetch Task 转换是指将适当的 MapReduce 任务转换为 Fetch Task,以减少任务的执行时间和提高查询性能。hive.fetch.task.conversion.threshold 就是用于设置在何种条件下启用这种转换的数据量阈值。

具体而言,当查询的数据量(数据的估算大小)低于 hive.fetch.task.conversion.threshold 时,Hive 可能会选择将相应的 MapReduce 任务转换为 Fetch Task。这通常适用于小规模查询或对单一分区的查询,以避免引入额外的 MapReduce 开销。

在设置 hive.fetch.task.conversion.threshold 时,需要根据查询的特性和性能需求来进行调整。默认值通常已经经过合理的设置,但在某些场景下可能需要根据实际情况进行调整。

指定在 ORC 文件中允许的最大文件尾部(footer)大小

hive.file.max.footer 是 Hive 的一个配置参数,用于指定在 ORC 文件中允许的最大文件尾部(footer)大小。

以下是一个示例:

-- 设置 hive.file.max.footer 为 1000

SET hive.file.max.footer=1000;

在上述示例中,将 hive.file.max.footer 设置为 1000,表示在 ORC 文件中允许的最大文件尾部大小为 1000 字节。

ORC(Optimized Row Columnar)文件格式是一种优化的列式存储格式,用于在 Hive 中存储数据。文件尾部包含元数据和统计信息等信息,而 hive.file.max.footer 用于限制文件尾部的大小,以便控制元数据和统计信息的存储量。

在一般情况下,不太需要手动调整 hive.file.max.footer,因为 Hive 通常会根据数据和配置自动进行调整。然而,在某些特殊情况下,可能需要根据实际需求进行调整。

请注意,调整此参数时需要谨慎,因为设置得太小可能导致元数据信息不足,而设置得太大可能占用过多的存储空间。

是否启用文件格式检查

hive.fileformat.check 是 Hive 的一个配置参数,用于控制是否启用文件格式检查。

以下是一个示例:

-- 设置 hive.fileformat.check 为 true

SET hive.fileformat.check=true;

在上述示例中,将 hive.fileformat.check 设置为 true,表示启用文件格式检查。

-- 设置 hive.fileformat.check 为 false

SET hive.fileformat.check=false;

在上述示例中,将 hive.fileformat.check 设置为 false,表示禁用文件格式检查。

启用文件格式检查时,Hive 会在加载表数据时检查文件的格式是否与表的文件格式属性匹配。如果不匹配,将会抛出异常。文件格式检查有助于确保表的数据格式的一致性。

在一般情况下,启用文件格式检查是一个好的实践,以确保数据的正确性和一致性。然而,在某些特殊情况下,可能需要禁用文件格式检查,例如当你确信文件格式是正确的,并且想要继续加载数据时。在进行设置时,请确保了解影响并谨慎选择。

G

指定在执行 GROUP BY 操作时是否启用额外的步骤来处理聚合结果的限制

在 Hive 中,hive.groupby.limit.extrastep 是一个配置参数,用于指定在执行 GROUP BY 操作时是否启用额外的步骤来处理聚合结果的限制。

以下是一个示例:

-- 设置 hive.groupby.limit.extrastep 为 true

SET hive.groupby.limit.extrastep=true;

在上述示例中,将 hive.groupby.limit.extrastep 设置为 true,表示启用额外的步骤来处理 GROUP BY 操作的限制。

-- 设置 hive.groupby.limit.extrastep 为 false

SET hive.groupby.limit.extrastep=false;

在上述示例中,将 hive.groupby.limit.extrastep 设置为 false,表示禁用额外的步骤来处理 GROUP BY 操作的限制。

当启用额外的步骤时,Hive 在执行 GROUP BY 操作时会进行一些优化,以提高处理聚合结果的效率。这对于处理大量数据并且需要对结果进行限制的情况可能是有益的。

在一般情况下,默认设置即可,因为 Hive 通常会根据查询的特性自动进行优化。然而,在某些特殊情况下,可能需要手动调整此参数以达到更好的性能。在调整配置参数时,请谨慎选择,并根据查询的特性进行测试。

指定 Map 阶段的聚合检查间隔

在 Hive 中,hive.groupby.mapaggr.checkinterval 是一个配置参数,用于指定 Map 阶段的聚合检查间隔。

以下是一个示例:

-- 设置 hive.groupby.mapaggr.checkinterval 为 10000

SET hive.groupby.mapaggr.checkinterval=10000;

在上述示例中,将 hive.groupby.mapaggr.checkinterval 设置为 10000,表示设置 Map 阶段的聚合检查间隔为 10,000 毫秒(10秒)。

在 Hive 的 GROUP BY 操作中,有两个阶段,即 Map 阶段和 Reduce 阶段。Map 阶段负责将数据按照分组键进行初步的聚合,而 hive.groupby.mapaggr.checkinterval 主要影响 Map 阶段的聚合检查频率。

默认情况下,Hive 会根据查询的特性自动选择合适的聚合检查间隔。然而,在某些情况下,可能需要手动调整此参数以优化查询性能。较小的检查间隔可能会导致更频繁的聚合,而较大的检查间隔可能会减少聚合的次数,具体的选择取决于查询的特性和数据分布。

在调整配置参数时,请谨慎选择,并根据查询的特性进行测试。

指定在执行 GROUP BY 操作时是否支持使用别名引用 ORDER BY 子句中的位置

hive.groupby.orderby.position.alias 是 Hive 的一个配置参数,用于指定在执行 GROUP BY 操作时是否支持使用别名引用 ORDER BY 子句中的位置。

以下是一个示例:

-- 设置 hive.groupby.orderby.position.alias 为 true

SET hive.groupby.orderby.position.alias=true;

在上述示例中,将 hive.groupby.orderby.position.alias 设置为 true,表示启用使用别名引用 ORDER BY 子句中的位置。

-- 设置 hive.groupby.orderby.position.alias 为 false

SET hive.groupby.orderby.position.alias=false;

在上述示例中,将 hive.groupby.orderby.position.alias 设置为 false,表示禁用使用别名引用 ORDER BY 子句中的位置。

当启用 hive.groupby.orderby.position.alias 时,Hive 允许在 GROUP BY 操作中使用 ORDER BY 子句中的列别名来引用相应位置的列。例如,如果查询中有以下语句:

SELECT col1, COUNT(*) as cnt FROM table_name GROUP BY col1 ORDER BY cnt;

在启用 hive.groupby.orderby.position.alias 的情况下,上述查询是合法的,因为在 ORDER BY 子句中使用了别名 cnt 来引用 COUNT(*) 的结果。

在默认情况下,Hive 通常允许使用别名引用 ORDER BY 子句中的位置,因此可能无需手动调整这个配置参数。在某些特殊情况下,可能需要了解和调整这个参数,以适应特定的查询需求。

指定在 GROUP BY 操作中是否支持使用别名引用SELECT子句中的位置

在 Hive 中,hive.groupby.position.alias 是一个配置参数,用于指定在 GROUP BY 操作中是否支持使用别名引用SELECT子句中的位置。

以下是一个示例:

-- 设置 hive.groupby.position.alias 为 true

SET hive.groupby.position.alias=true;

在上述示例中,将 hive.groupby.position.alias 设置为 true,表示启用在 GROUP BY 操作中使用 SELECT 子句中的列别名来引用相应位置的列。

-- 设置 hive.groupby.position.alias 为 false

SET hive.groupby.position.alias=false;

在上述示例中,将 hive.groupby.position.alias 设置为 false,表示禁用在 GROUP BY 操作中使用 SELECT 子句中的列别名来引用相应位置的列。

默认情况下,Hive 通常允许在 GROUP BY 操作中使用 SELECT 子句中的列别名来引用相应位置的列。因此,可能无需手动调整这个配置参数。在某些特殊情况下,可能需要了解和调整这个参数,以适应特定的查询需求。

指定在执行 GROUP BY 操作时是否对数据进行倾斜处理

hive.groupby.skewindata 是 Hive 的一个配置参数,用于指定在执行 GROUP BY 操作时是否对数据进行倾斜处理。

以下是一个示例:

-- 设置 hive.groupby.skewindata 为 true

SET hive.groupby.skewindata=true;

在上述示例中,将 hive.groupby.skewindata 设置为 true,表示启用对数据进行倾斜处理。

-- 设置 hive.groupby.skewindata 为 false

SET hive.groupby.skewindata=false;

在上述示例中,将 hive.groupby.skewindata 设置为 false,表示禁用对数据进行倾斜处理。

当启用 hive.groupby.skewindata 时,Hive 将尝试检测 GROUP BY 操作中的数据倾斜,并采取一些优化策略来处理倾斜的数据分布,以提高查询性能。数据倾斜可能会导致某些节点上的数据量远大于其他节点,从而影响整个查询的性能。

在一般情况下,启用对数据的倾斜处理是一个好的实践,可以提高查询性能。然而,在某些情况下,可能需要根据查询的特性和性能需求来决定是否启用。当查询中存在 GROUP BY 操作并且数据分布不均匀时,启用 hive.groupby.skewindata 可能会带来性能上的改善。

H

指定哈希表的膨胀因子

hive.hash.table.inflation.factor 是 Hive 的一个配置参数,用于指定哈希表的膨胀因子。

以下是一个示例:

-- 设置 hive.hash.table.inflation.factor 为 2.0

SET hive.hash.table.inflation.factor=2.0;

在上述示例中,将 hive.hash.table.inflation.factor 设置为 2.0,表示设置哈希表的膨胀因子为 2.0。

哈希表是在 Hive 中执行一些连接操作时使用的数据结构。膨胀因子用于确定哈希表的大小,它是哈希表实际大小与其当前存储的元素数量之比。

较大的膨胀因子可能会导致哈希表更紧凑,但可能增加冲突的可能性。较小的膨胀因子可能减少冲突,但可能导致哈希表占用更多的内存。

在一般情况下,默认的膨胀因子已经经过合理的选择,无需手动调整。然而,在某些情况下,可能需要根据查询的特性和数据分布来调整这个参数。在调整配置参数时,请谨慎选择,并根据实际情况进行性能测试。

指定哈希表的初始容量

hive.hashtable.initialCapacity 是 Hive 的一个配置参数,用于指定哈希表的初始容量。

以下是一个示例:

-- 设置 hive.hashtable.initialCapacity 为 100000

SET hive.hashtable.initialCapacity=100000;

在上述示例中,将 hive.hashtable.initialCapacity 设置为 100000,表示设置哈希表的初始容量为 100,000。

哈希表是在 Hive 中执行一些连接操作时使用的数据结构,用于存储连接的中间结果。hive.hashtable.initialCapacity 用于指定哈希表的初始容量,即在哈希表创建时预分配的初始空间大小。

在一般情况下,Hive 会根据数据的规模和查询的特性自动选择合适的初始容量。然而,在某些情况下,可能需要手动调整这个参数以优化连接操作的性能。

在调整配置参数时,请谨慎选择,并根据实际情况进行性能测试。如果查询中涉及大规模的连接操作,并且内存资源足够,适当增加哈希表的初始容量可能有助于提高性能。

调整哈希表中键的数量

hive.hashtable.key.count.adjustment 是 Hive 的一个配置参数,用于调整哈希表中键的数量。

以下是一个示例:

-- 设置 hive.hashtable.key.count.adjustment 为 1.5

SET hive.hashtable.key.count.adjustment=1.5;

在上述示例中,将 hive.hashtable.key.count.adjustment 设置为 1.5,表示调整哈希表中键的数量为当前计算的键的数量的1.5倍。

哈希表是在 Hive 中执行一些连接操作时使用的数据结构,用于存储连接的中间结果。hive.hashtable.key.count.adjustment 用于调整哈希表中键的数量,这可以影响哈希表的大小和性能。

在一般情况下,Hive 会根据数据的规模和查询的特性自动选择合适的键的数量。然而,在某些情况下,可能需要手动调整这个参数以优化连接操作的性能。

在调整配置参数时,请谨慎选择,并根据实际情况进行性能测试。增加键的数量可能会增加哈希表的大小,但也可能提高连接操作的性能。

指定哈希表的加载因子

hive.hashtable.loadfactor 是 Hive 的一个配置参数,用于指定哈希表的加载因子。

以下是一个示例:

-- 设置 hive.hashtable.loadfactor 为 0.75

SET hive.hashtable.loadfactor=0.75;

在上述示例中,将 hive.hashtable.loadfactor 设置为 0.75,表示设置哈希表的加载因子为 0.75。

加载因子是哈希表用于控制在何时对哈希表进行扩容的一个参数。加载因子越小,哈希表就越早进行扩容,从而减少哈希冲突的可能性,但可能会浪费一些内存。加载因子越大,哈希表就越晚进行扩容,可以更充分地利用内存,但可能会增加哈希冲突的概率。

在一般情况下,Hive 会根据数据的规模和查询的特性自动选择合适的加载因子。然而,在某些情况下,可能需要手动调整这个参数以优化连接操作的性能。

在调整配置参数时,请谨慎选择,并根据实际情况进行性能测试。加载因子的选择可能会影响哈希表的性能和内存占用。

指定在使用 Hive 加载数据到 HBase 时是否生成 HFiles

hive.hbase.generatehfiles 是 Hive 的一个配置参数,用于指定在使用 Hive 加载数据到 HBase 时是否生成 HFiles。

以下是一个示例:

-- 设置 hive.hbase.generatehfiles 为 true

SET hive.hbase.generatehfiles=true;

在上述示例中,将 hive.hbase.generatehfiles 设置为 true,表示启用生成 HFiles 的功能。

-- 设置 hive.hbase.generatehfiles 为 false

SET hive.hbase.generatehfiles=false;

在上述示例中,将 hive.hbase.generatehfiles 设置为 false,表示禁用生成 HFiles 的功能。

当启用 hive.hbase.generatehfiles 时,Hive 在将数据加载到 HBase 表时会生成 HFiles。HFiles 是 HBase 存储数据的底层文件格式。生成 HFiles 的过程将数据按照 HBase 的存储格式准备好,以便更高效地导入到 HBase 表中。

在一般情况下,可以根据实际需求选择是否启用 hive.hbase.generatehfiles。在某些情况下,生成 HFiles 可能带来一些性能优势,但在其他情况下,直接将数据加载到 HBase 表中可能更为合适。在进行设置时,请考虑数据量、性能需求以及是否需要对生成的 HFiles 进行其他处理。

指定在从 HBase 快照中恢复数据时的目标目录

hive.hbase.snapshot.restoredir 是 Hive 的一个配置参数,用于指定在从 HBase 快照中恢复数据时的目标目录。

以下是一个示例:

-- 设置 hive.hbase.snapshot.restoredir 为 /user/hive/restore

SET hive.hbase.snapshot.restoredir=/user/hive/restore;

在上述示例中,将 hive.hbase.snapshot.restoredir 设置为 /user/hive/restore,表示将从 HBase 快照中恢复的数据放置到指定的目标目录。

在 Hive 中,通过 HBase 快照可以实现对 HBase 表的备份和恢复。当需要将 HBase 表的数据从一个快照中恢复到 Hive 表时,可以使用 Hive 提供的一些配置参数,其中 hive.hbase.snapshot.restoredir 就是指定恢复数据的目标目录。

在设置 hive.hbase.snapshot.restoredir 时,需要确保指定的目录存在,并有足够的权限用于写入数据。另外,根据实际需求,可能需要调整其他相关配置参数以确保恢复过程的顺利进行。

总体而言,使用 HBase 快照进行 Hive 表的数据恢复是一个复杂的过程,建议在执行之前详细阅读相关文档并根据实际需求进行配置。

指定在将数据写入 HBase 表时是否启用 Write-Ahead Logging(WAL)

hive.hbase.wal.enabled 是 Hive 的一个配置参数,用于指定在将数据写入 HBase 表时是否启用 Write-Ahead Logging(WAL)。

以下是一个示例:

-- 设置 hive.hbase.wal.enabled 为 true

SET hive.hbase.wal.enabled=true;

在上述示例中,将 hive.hbase.wal.enabled 设置为 true,表示启用 HBase 表的 Write-Ahead Logging。

-- 设置 hive.hbase.wal.enabled 为 false

SET hive.hbase.wal.enabled=false;

在上述示例中,将 hive.hbase.wal.enabled 设置为 false,表示禁用 HBase 表的 Write-Ahead Logging。

Write-Ahead Logging 是 HBase 中一种用于数据持久性的机制。启用 WAL 意味着在将数据写入 HBase 表时,先将数据写入到 Write-Ahead Log 中,然后再写入到表中。这样可以提供数据的持久性和一致性,但会增加写入的开销。

在一般情况下,默认情况下 HBase 表的 WAL 是启用的。只有在一些特殊情况下,例如对写入性能有极高要求或者对数据一致性要求较低时,才可能考虑禁用 WAL。

在调整 hive.hbase.wal.enabled 参数时,请根据具体的需求和场景进行谨慎设置。

设置堆内存监控的使用阈值

在Hive中,hive.heap.memory.monitor.usage.threshold是一个配置参数,用于设置堆内存监控的使用阈值。这个参数主要用于监视Hive Server的Java虚拟机(JVM)的堆内存使用情况,以便及时检测内存使用超过阈值的情况,从而采取适当的措施,如进行垃圾回收或调整内存分配。

具体来说,hive.heap.memory.monitor.usage.threshold参数的作用是设定堆内存使用率的百分比阈值。当堆内存的使用率达到或超过这个阈值时,Hive会触发相应的内存监控操作,以帮助及时发现潜在的内存问题。

例如,如果hive.heap.memory.monitor.usage.threshold被设置为80%,那么当JVM堆内存的使用率达到80%时,Hive将启动内存监控机制,可能会触发警报或其他操作,提醒管理员注意内存使用情况。

请注意,确切的配置和作用可能取决于Hive的具体版本,因此建议查阅相应版本的Hive文档或配置文件以获取详细信息。

设置Hive服务器与客户端之间的心跳(heartbeat)间隔

在Apache Hive中,hive.heartbeat.interval是一个配置参数,用于设置Hive服务器与客户端之间的心跳(heartbeat)间隔。心跳机制旨在保持服务器与客户端之间的连接活跃,并定期检测连接的状态。

具体来说,hive.heartbeat.interval参数表示心跳的时间间隔,以毫秒为单位。在这个时间间隔内,Hive服务器会向连接到它的客户端发送心跳信号,以确保连接仍然是活跃的。如果在指定的时间间隔内没有接收到客户端的响应,服务器可能会认为连接已断开,并采取相应的措施,如关闭连接或触发重新连接。

以下是一个示例配置:

bashCopy code

set hive.heartbeat.interval=10000;

上述示例将心跳间隔设置为10秒。根据具体的需求和环境,可以调整这个值。

这个参数通常用于长时间运行的查询或会话,以避免由于连接超时而导致查询失败或会话中断。确切的用法和配置可能取决于Hive的版本和具体的使用场景,因此建议查阅相应版本的Hive文档或配置文件以获取详细信息。

指定在 Hive Metastore 操作失败时进行重试的次数

hive.hmshandler.retry.attempts 是 Hive 配置中与 Hive Metastore Handler 相关的一个参数。这个参数用于指定在 Hive Metastore 操作失败时进行重试的次数。

具体来说,hive.hmshandler.retry.attempts 的值表示在出现 Hive Metastore 操作失败后,Hive 将尝试重新执行该操作的次数。如果在给定的尝试次数内操作仍然失败,系统可能会触发错误处理机制。

以下是一个示例配置:

set hive.hmshandler.retry.attempts=3;

上述示例将重试次数设置为3次。您可以根据需要调整这个值,以确保在一些瞬时性问题发生时,Hive Metastore 操作有足够的机会成功完成。

请注意,这个参数的默认值通常是一个较小的数值,可能是1,表示不进行额外的重试。在生产环境中,根据您的系统和网络状况,您可能需要调整这个值以提高稳定性。

要详细了解这个参数以及其他与 Hive Metastore 相关的配置,建议查阅您使用的 Hive 版本的官方文档。

指定在 Hive Metastore 操作失败时进行重试的间隔时间

hive.hmshandler.retry.interval 是 Hive 配置中与 Hive Metastore Handler 相关的参数之一。这个参数用于指定在 Hive Metastore 操作失败时进行重试的间隔时间。

具体来说,hive.hmshandler.retry.interval 的值表示在重试之间等待的时间间隔,以毫秒为单位。当 Hive Metastore 操作失败后,Hive 将等待指定的时间,然后进行下一次重试。

以下是一个示例配置:

set hive.hmshandler.retry.interval=5000;

上述示例将重试间隔设置为5秒。您可以根据需要调整这个值,以确保在重试之间有足够的时间,以避免对 Metastore 的过度负载或过于频繁的重试。

请注意,这个参数的默认值通常是一个较小的数值,可能是几百毫秒。在生产环境中,根据您的系统和网络状况,您可能需要调整这个值以提高稳定性。

要详细了解这个参数以及其他与 Hive Metastore 相关的配置,建议查阅您使用的 Hive 版本的官方文档。

是否忽略在查询中给定的 MapJoin 提示

hive.ignore.mapjoin.hint 是 Hive 配置中的一个参数,用于指定是否忽略在查询中给定的 MapJoin 提示。MapJoin 提示是一种通过在 Hive 查询中使用注释来指导查询优化的方法,特别是在处理大型表时。

如果将 hive.ignore.mapjoin.hint 设置为 false,则 Hive 将尊重查询中的 MapJoin 提示。如果设置为 true,则会忽略这些提示。

以下是一个示例配置:

set hive.ignore.mapjoin.hint=true;

上述示例将 hive.ignore.mapjoin.hint 设置为 true,即忽略在查询中给定的 MapJoin 提示。

请注意,根据查询的性质和数据的分布,使用 MapJoin 提示可能对查询性能产生积极影响。然而,有时 Hive 的优化器可能会自动选择适当的连接策略,因此并不总是需要手动提供 MapJoin 提示。

要详细了解这个参数以及其他与查询优化相关的配置,建议查阅您使用的 Hive 版本的官方文档。

指定 Hive 表的输入格式(Input Format)

在 Hive 中,hive.input.format 是一个配置参数,用于指定 Hive 表的输入格式(Input Format)。输入格式定义了 Hive 如何读取底层数据存储,例如文本文件、Parquet 文件或者其他格式。

具体来说,hive.input.format 的值通常是 Hive 内置输入格式类的完全限定名(Fully Qualified Class Name)。不同的输入格式类支持不同的数据存储格式和处理方式。

以下是一个示例配置:

SET hive.input.format=org.apache.hadoop.hive.ql.io.orc.OrcInputFormat;

上述示例将输入格式设置为 ORC(Optimized Row Columnar)格式,这是一种针对大数据表格数据的高性能列式存储格式。

其他可能的值可能包括:

org.apache.hadoop.hive.ql.io.Textorg.apache.hadoop.hive.ql.io.parquet.MapredParquetInputFormatorg.apache.hadoop.hive.ql.io.avro.AvroContainerInputFormat

具体可选的输入格式类取决于 Hive 的版本和您的环境。

请注意,通常情况下,Hive 能够根据表的存储格式自动选择正确的输入格式,而无需手动设置。只有在需要手动干预时才需要配置 hive.input.format。

要详细了解这个参数以及其他与 Hive 表输入格式相关的配置,建议查阅您使用的 Hive 版本的官方文档。

设置JVM堆内存监视器的使用阈值

在Apache Hive中,hive.heap.memory.monitor.usage.threshold是一个配置属性,用于设置JVM堆内存监视器的使用阈值。这个属性主要用于监视Hive服务中的JVM堆内存使用情况,以及在内存使用超过特定阈值时触发相应的操作。

具体来说,当JVM堆内存使用率超过设定的阈值时,Hive会采取一些操作,例如记录日志、发送警报或执行一些自定义的动作,以便管理员能够及时注意到潜在的内存问题并采取适当的措施。

在Hive中,这个属性的默认值通常为0.9,即90%。这表示当JVM堆内存使用率达到或超过90%时,监视器将采取相应的操作。这个阈值可以根据具体的需求进行调整。

示例配置:

<property><name>hive.heap.memory.monitor.usage.threshold</name><value>0.9</value>

</property>

在这个示例中,当JVM堆内存使用率达到90%时,监视器将采取相应的操作。管理员可以根据实际情况调整这个值,以便更好地适应Hive服务的内存需求和性能要求。

设置Hive服务之间的心跳检测的时间间隔

在Apache Hive中,hive.heartbeat.interval是一个配置属性,用于设置Hive服务之间的心跳检测的时间间隔。心跳检测是一种用于监测Hive服务是否处于活动状态的机制。通过定期发送心跳消息,Hive服务可以确保它们之间的连接仍然有效,并能够检测到可能的故障或失效。

具体来说,hive.heartbeat.interval属性定义了心跳消息发送的时间间隔,以毫秒为单位。较小的时间间隔可以更及时地检测到服务失效,但可能会增加网络和系统资源的负载。

示例配置:

<property><name>hive.heartbeat.interval</name><value>1000</value>

</property>

在这个示例中,心跳消息将每秒发送一次。管理员可以根据实际情况调整这个值,以平衡及时性和资源利用率。

请注意,这个配置属性通常用于Hive服务的高可用性设置,例如在HiveServer2和ZooKeeper集成时,以确保集群中的各个组件保持连接状态。

相关文章:

Hive之set参数大全-4

F 指定在使用 FETCH 命令提取查询结果时的序列化/反序列化器 hive.fetch.output.serde 是 Hive 的一个配置参数,用于指定在使用 FETCH 命令提取查询结果时的序列化/反序列化器。 以下是一个示例: -- 设置 hive.fetch.output.serde 为 org.apache.had…...

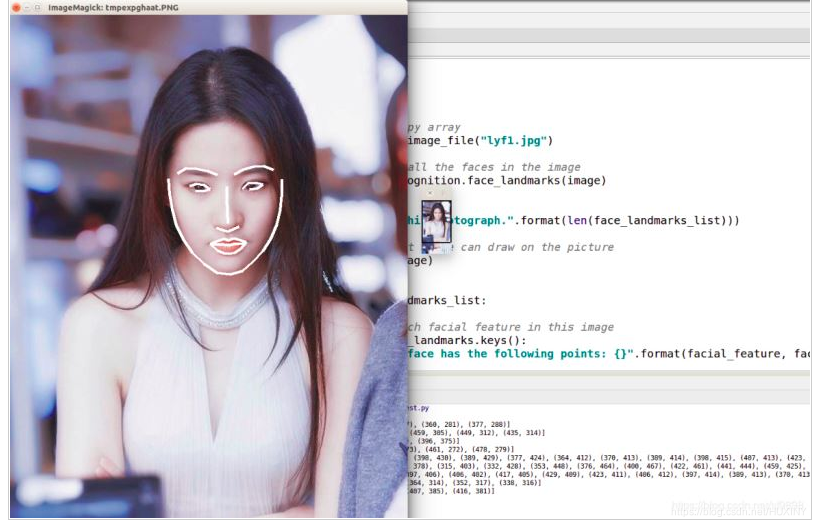

竞赛保研 基于深度学习的人脸识别系统

前言 🔥 优质竞赛项目系列,今天要分享的是 基于深度学习的人脸识别系统 该项目较为新颖,适合作为竞赛课题方向,学长非常推荐! 🧿 更多资料, 项目分享: https://gitee.com/dancheng-senior/…...

9.建造者模式

文章目录 一、介绍二、代码三、实际使用总结 一、介绍 建造者模式旨在将一个复杂对象的构建过程和其表示分离,以便同样的构建过程可以创建不同的表示。这种模式适用于构建对象的算法(构建过程)应该独立于对象的组成部分以及它们的装配方式的…...

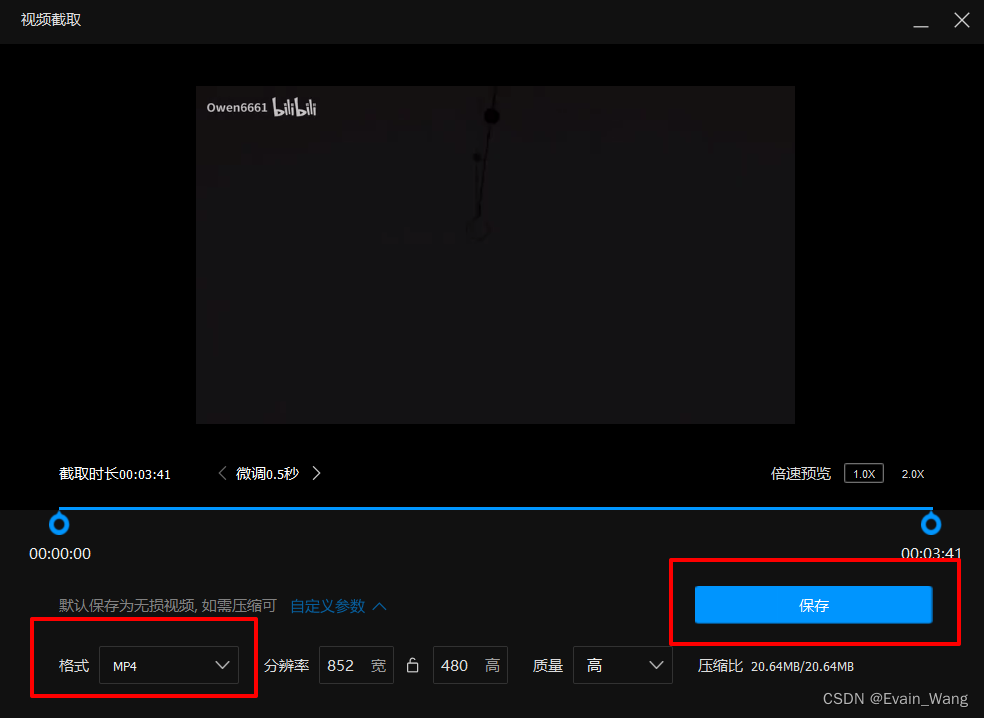

简单的MOV转MP4方法

1.下载腾讯的QQ影音播放器, 此播放器为绿色视频播放器, 除了播放下载好的视频外没有臃肿无用功能 官网 QQ影音 百度网盘链接:https://pan.baidu.com/s/1G0kSC-844FtRfqGnIoMALA 提取码:dh4w 2.用QQ影音打开MOV文件 3.右下角打开影音工具箱 , 选择截取…...

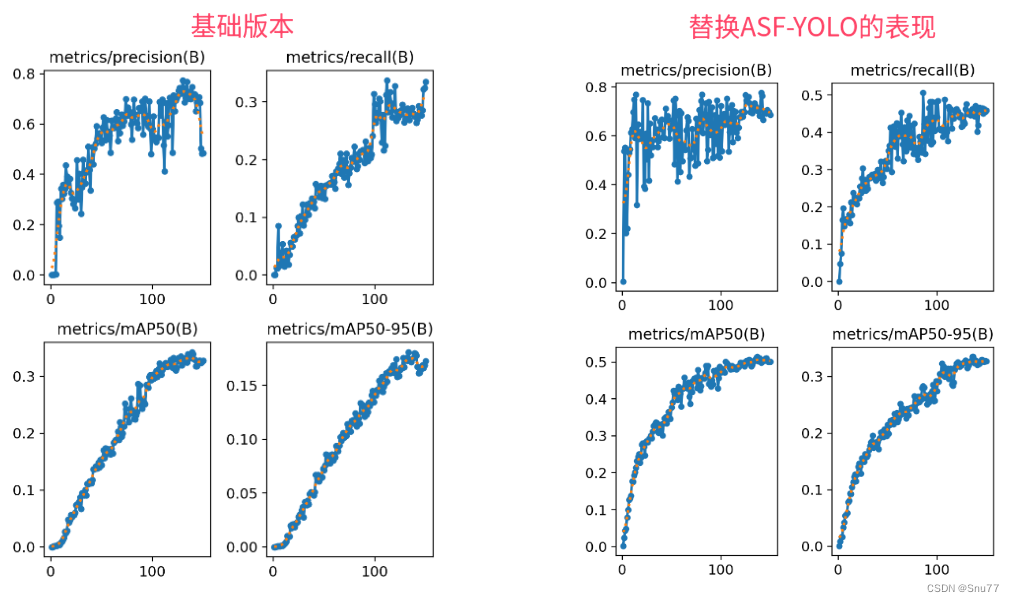

YOLOv8改进 | Neck篇 | 利用ASF-YOLO改进特征融合层(适用于分割和目标检测)

一、本文介绍 本文给大家带来的改进机制是ASF-YOLO(发布于2023.12月份的最新机制),其是特别设计用于细胞实例分割。这个模型通过结合空间和尺度特征,提高了在处理细胞图像时的准确性和速度。在实验中,ASF-YOLO在2018年数据科学竞赛数据集上取得了卓越的分割准确性和速度,…...

基于模块自定义扩展字段的后端逻辑实现(一)

目录 一:背景介绍 二:实现过程 三:字段标准化 四:数据存储 五:数据扩展 六:表的设计 一:背景介绍 最近要做一个系统,里面涉及一个模块是使用拖拉拽的形式配置模块使用的字段表…...

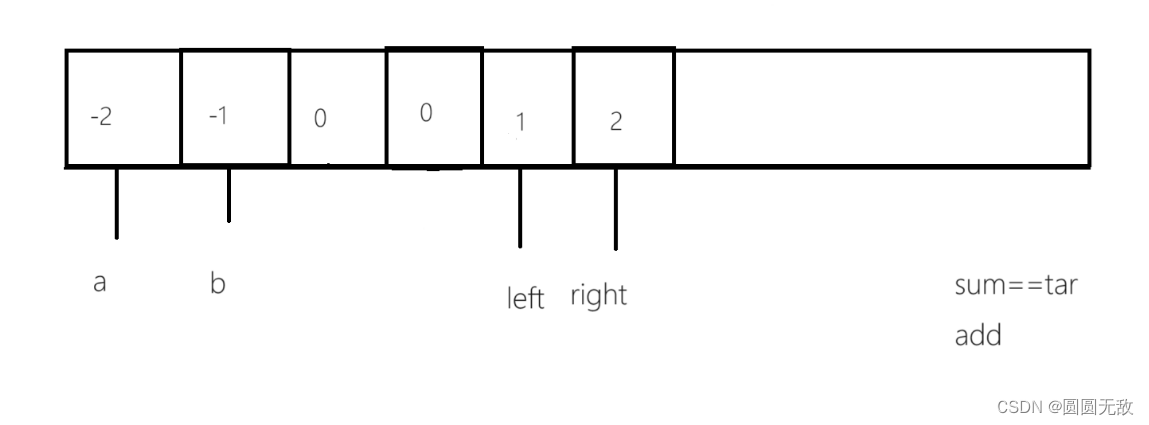

力扣:18.四数之和

一、做题链接:18. 四数之和 - 力扣(LeetCode) 二、题目分析 1.做这一道题之前本博主建议先看上一篇《三数之和》 2.题目分析 给你一个由 n 个整数组成的数组 nums ,和一个目标值 target 。请你找出并返回满足下述全部条件且不重…...

.netcore 6 ioc注入的三种方式

1、定义接口 public interface MyInterceptorInterface 2、实现接口 public class MyInterceptorImpl : MyInterceptorInterface 在构造中增加以下代码,便于观察 static ConcurrentDictionary<string, string> keyValues new ConcurrentDictionary<s…...

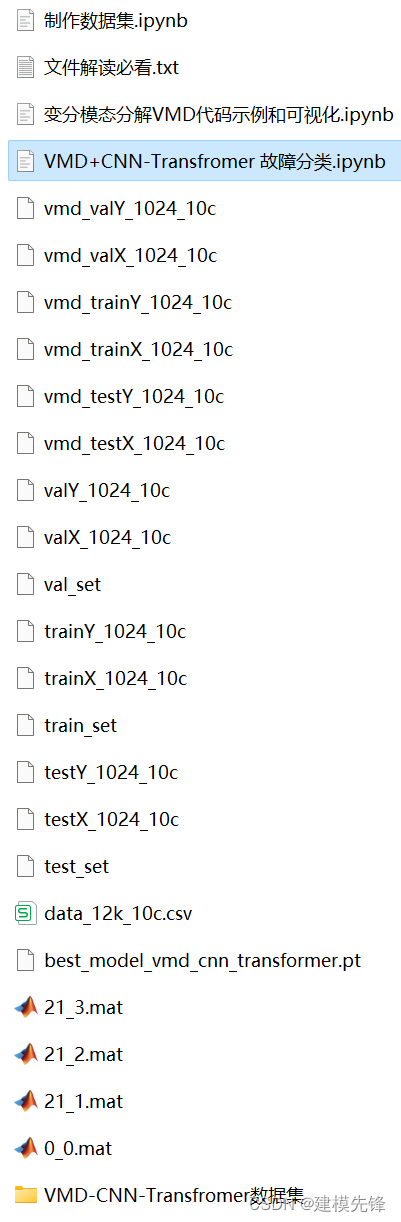

Python轴承故障诊断 (十)基于VMD+CNN-Transfromer的故障分类

目录 1 变分模态分解VMD的Python示例 2 轴承故障数据的预处理 2.1 导入数据 2.2 故障VMD分解可视化 3 基于VMDCNN-Transformer的轴承故障诊断分类 3.1 定义VMD-CNN-Transformer分类网络模型 3.2 设置参数,训练模型 3.3 模型评估 代码、数据如下:…...

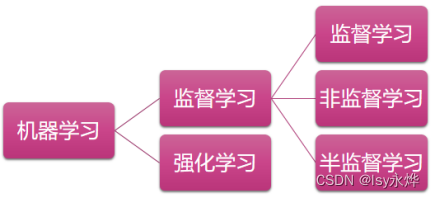

【复习】人工智能 第7章 专家系统与机器学习

专家系统就是让机器人当某个领域的专家,但这章专家系统不咋考,主要靠书上没有的机器学习。 一、专家系统的基本组成 二、专家系统与传统程序的比较 (1)编程思想: 传统程序 数据结构 算法 专家系统 知识 推理 &…...

使用 Apache PDFBox 操作PDF文件

简介 Apache PDFBox库是一个开源的Java工具,专门用于处理PDF文档。它允许用户创建全新的PDF文件,编辑现有的PDF文档,以及从PDF文件中提取内容。此外,Apache PDFBox还提供了一些命令行实用工具。 Apache PDFBox提供了创建、渲染、…...

【Python 常用脚本及命令系列 3.2 -- 检测到弹框跳出然后关掉它--脚本实现】

文章目录 简介脚本实现 简介 在Python中,你可以使用第三方库如pyautogui和pygetwindow来检测屏幕上的弹框并关闭它。这些库可以模拟鼠标和键盘操作,也可以获取窗口信息。 首先,需要安装这些库(如果你还没有安装的话)&…...

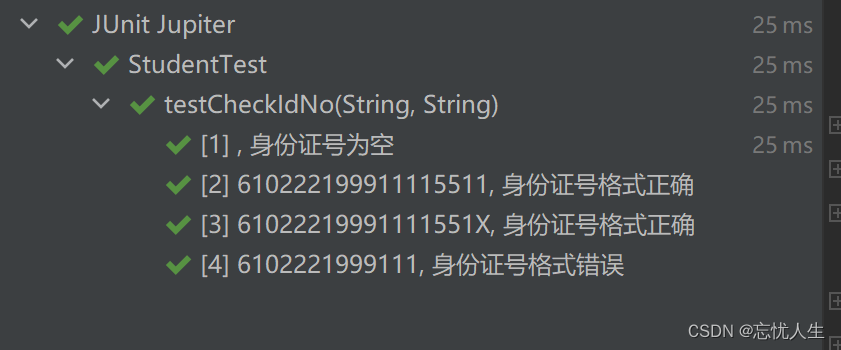

junit单元测试:使用@ParameterizedTest 和 @CsvSource注解简化单元测试方法

在平常的开发工作中,我们经常需要写单元测试。比如,我们有一个校验接口,可能会返回多种错误信息。我们可以针对这个接口,写多个单元测试方法,然后将其场景覆盖全。那么,怎么才能写一个测试方法,…...

C# winform判断自身程序是否已运行,如果已运行则激活窗体

C# winform判断自身程序是否已运行,如果已运行则激活窗体 using System; using System.Collections.Generic; using System.Diagnostics; using System.Linq; using System.Reflection; using System.Runtime.InteropServices; using System.Threading; using Syst…...

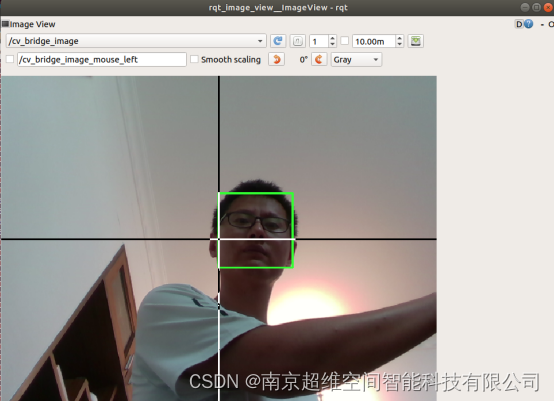

超维空间M1无人机使用说明书——21、基于opencv的人脸识别

引言:M1型号无人机不仅提供了yolo进行物体识别,也增加了基于opencv的人脸识别功能包,仅需要启动摄像头和识别节点即可 链接: 源码链接 一、一键启动摄像头和人脸识别节点 roslaunch robot_bringup bringup_face_detect.launch无报错&#…...

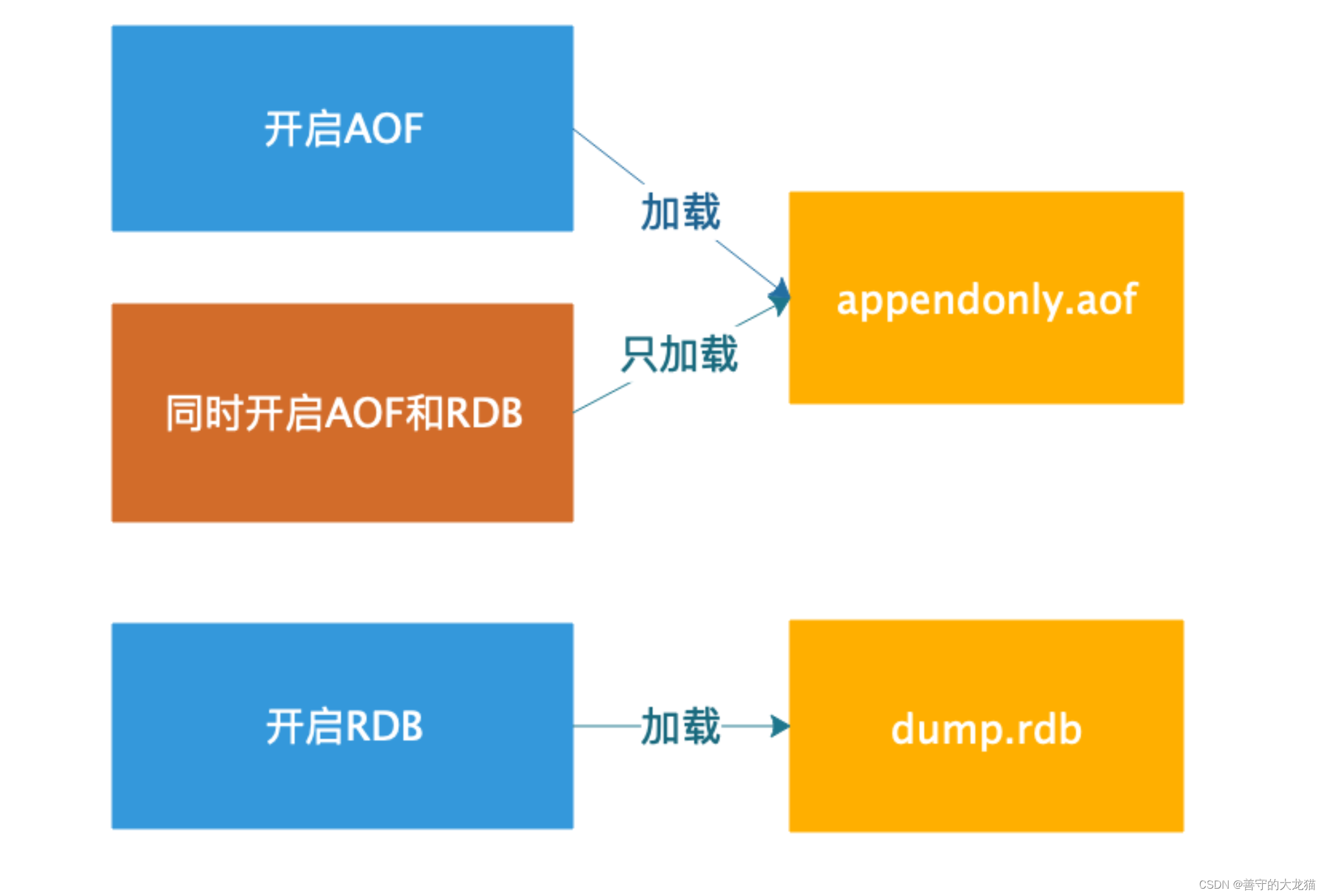

Redis 持久化——AOF

文章目录 为什么需要AOF?概念持久化查询和设置1. 查询AOF启动状态2. 开启AOF持久化2.1 命令行启动AOF2.2 配置文件启动 AOF 3. 触发持久化3.1 自动触发3.3 手动触发 4. AOF 文件重写4.1 什么是AOF重写?4.2 AOF 重写实现4.3 AOF 重写流程 5. 配置说明6. 数据恢复6.1…...

)

华为云服务介绍(二)

在 华为云服务介绍(一) 中我们看到华为云提供了一系列的云服务,包括计算、存储、网络、数据库、安全等方面的解决方案。通过灵活的系统架构设计,可以充分利用这些云服务技术,从而更好地满足用户的需求。 本文从系统架构的角度出发,通过充分利用华为云提供的各种云服务技…...

mysql列题

mysql列题 1.查询学过「张三」老师授课的同学的信息2.查询没有学全所有课程的同学的信息3.查询没学过"张三"老师讲授的任一门课程的学生姓名4.查询两门及其以上不及格课程的同学的学号,姓名及其平均成绩5.检索" 01 "课程分数小于 60,…...

cpu缓存一致性

文章目录 cpu缓存一致性缓存的出现:多核之后带来的缓存一致性问题,如何解决LOCK 指令(刚好可以实现上述的目标)LOCK 指令特性内存屏障特性编译器屏障的作用MESI协议为什么有了 MESI协议 还需要 内存屏障问题:总结&…...

定制CPUSET解决方案-framework部分修改)

Android Framework 常见解决方案(25-1)定制CPUSET解决方案-framework部分修改

1 原理说明 这个方案有如下基本需求: 构建自定义CPUSET,/dev/cpuset中包含一个全新的cpuset分组。且可以通过set_cpuset_policy和set_sched_policy接口可以设置自定义CPUSET。开机启动后可以通过zygote判定来对特定的应用进程设置CPUSET,并…...

基于uniapp+WebSocket实现聊天对话、消息监听、消息推送、聊天室等功能,多端兼容

基于 UniApp + WebSocket实现多端兼容的实时通讯系统,涵盖WebSocket连接建立、消息收发机制、多端兼容性配置、消息实时监听等功能,适配微信小程序、H5、Android、iOS等终端 目录 技术选型分析WebSocket协议优势UniApp跨平台特性WebSocket 基础实现连接管理消息收发连接…...

【SpringBoot】100、SpringBoot中使用自定义注解+AOP实现参数自动解密

在实际项目中,用户注册、登录、修改密码等操作,都涉及到参数传输安全问题。所以我们需要在前端对账户、密码等敏感信息加密传输,在后端接收到数据后能自动解密。 1、引入依赖 <dependency><groupId>org.springframework.boot</groupId><artifactId...

聊一聊接口测试的意义有哪些?

目录 一、隔离性 & 早期测试 二、保障系统集成质量 三、验证业务逻辑的核心层 四、提升测试效率与覆盖度 五、系统稳定性的守护者 六、驱动团队协作与契约管理 七、性能与扩展性的前置评估 八、持续交付的核心支撑 接口测试的意义可以从四个维度展开,首…...

【数据分析】R版IntelliGenes用于生物标志物发现的可解释机器学习

禁止商业或二改转载,仅供自学使用,侵权必究,如需截取部分内容请后台联系作者! 文章目录 介绍流程步骤1. 输入数据2. 特征选择3. 模型训练4. I-Genes 评分计算5. 输出结果 IntelliGenesR 安装包1. 特征选择2. 模型训练和评估3. I-Genes 评分计…...

微软PowerBI考试 PL300-在 Power BI 中清理、转换和加载数据

微软PowerBI考试 PL300-在 Power BI 中清理、转换和加载数据 Power Query 具有大量专门帮助您清理和准备数据以供分析的功能。 您将了解如何简化复杂模型、更改数据类型、重命名对象和透视数据。 您还将了解如何分析列,以便知晓哪些列包含有价值的数据,…...

代码随想录刷题day30

1、零钱兑换II 给你一个整数数组 coins 表示不同面额的硬币,另给一个整数 amount 表示总金额。 请你计算并返回可以凑成总金额的硬币组合数。如果任何硬币组合都无法凑出总金额,返回 0 。 假设每一种面额的硬币有无限个。 题目数据保证结果符合 32 位带…...

Java求职者面试指南:计算机基础与源码原理深度解析

Java求职者面试指南:计算机基础与源码原理深度解析 第一轮提问:基础概念问题 1. 请解释什么是进程和线程的区别? 面试官:进程是程序的一次执行过程,是系统进行资源分配和调度的基本单位;而线程是进程中的…...

node.js的初步学习

那什么是node.js呢? 和JavaScript又是什么关系呢? node.js 提供了 JavaScript的运行环境。当JavaScript作为后端开发语言来说, 需要在node.js的环境上进行当JavaScript作为前端开发语言来说,需要在浏览器的环境上进行 Node.js 可…...

----- Python的类与对象)

Python学习(8) ----- Python的类与对象

Python 中的类(Class)与对象(Object)是面向对象编程(OOP)的核心。我们可以通过“类是模板,对象是实例”来理解它们的关系。 🧱 一句话理解: 类就像“图纸”,对…...

大模型真的像人一样“思考”和“理解”吗?

Yann LeCun 新研究的核心探讨:大语言模型(LLM)的“理解”和“思考”方式与人类认知的根本差异。 核心问题:大模型真的像人一样“思考”和“理解”吗? 人类的思考方式: 你的大脑是个超级整理师。面对海量信…...