PyTorch深度学习实战(30)——Deepfakes

PyTorch深度学习实战(30)——Deepfakes

- 0. 前言

- 1. Deepfakes 原理

- 2. 数据集分析

- 3. 使用 PyTorch 实现 Deepfakes

- 3.1 random_warp.py

- 3.2 Deepfakes.py

- 小结

- 系列链接

0. 前言

Deepfakes 是一种利用深度学习技术生成伪造视频和图像的技术。它通过将一个人的脸部特征或动作应用于另一个人的图像或视频中,以产生逼真的虚假内容。Deepfakes 技术在短时间内取得了显著的进展,并引起了广泛的关注和担忧,为了能够更好的采取相应的检测和防御措施,我们首先需要了解其基本原理。

1. Deepfakes 原理

我们已经学习了两种不同的图像到图像的转换任务,包括使用 UNet 执行语义分割和使用自编码器执行图像重建。 Deepfakes 是与以上任务具有相似理论基础的图像到图像转换的技术。

Deepfakes 是一种利用深度学习技术合成的虚假图像和视频的技术,Deepfakes 名称由 “deep learning” 和 “fake” 组成,通常用于制作虚假的音频和视频。例如,可以利用 Deepfakes 技术将一个人的脸替换到另一个人的身体上。

假设我们想要创建一个应用程序,获取给定的面部图像并以期望方式改变面部表情,在这种情况下,Deepfakes 是一种可行的技术,本节中,我们将介绍 Deepfakes 的基本原理,并使用小样本对抗学习技术生成具有感兴趣面部表情的逼真图像。

在 Deepfakes 任务中,我们使用数百张人物 A 的照片和数百张人物 B 的照片。目任务的目标是通过将 A 人物的面部表情应用到 B 人物脸上,或者将 B 人物的面部表情应用到 A 人物脸上,来重建人物 B 和 A 的脸部特征。Deepfakes 图像生成过程的工作原理如下:

在上图中,我们通过编码器 (Encoder) 传递人物 A 和人物 B 的图像,得到与人物 A (Latent Face A) 和人物 B (Latent Face B) 对应的潜向量,将潜向量传递给它们相应的解码器 (Decoder A 和 Decoder B) 以获取相应的原始图像 (Reconstructed Face A 和 Reconstructed Face B),编码器和解码器与自编码器非常相似。但在此任务中,我们只需要一个编码器,但需要两个解码器(每个解码器对应一个不同的人物)。

我们期望从编码器获得的潜向量表示图像中包含的面部表情信息,而解码器获取与人物相对应的图像。一旦编码器和两个解码器都经过训练后,在执行deepfakes图像生成时,我们按以下方式切换架构中的连接:

当 A 人物的潜在向量通过 B 人物的解码器时,重建的 B 人物脸部将具有 A 人物的特征,反之亦然,当 B 人物的潜在向量通过 A 人物的解码器时,重建的 A 人物脸部将具有 B 人物的表情。

另一个有助于生成逼真图像的技巧是对人脸图像进行扭曲,以这样的方式将其馈送到网络中:将扭曲后的人脸作为输入,预期的输出是原始图像。

2. 数据集分析

Pins Face Recognition 数据集包含通过 Pinterest 拍摄的图像,该数据集包括 100 多个不同人物的 10,000 多张图像,每个人物平均包含 100 张图片。

Pins Face Recognition 数据集的目标是推动人脸识别技术的发展,并为研究人员提供一个用于测试和比较不同算法性能的标准基准。该数据集中的图像包括不同的人物和背景,并且在姿势、光照和表情等方面具有一定的变化。可以通过 Kaggle 网站下载 Pins Face Recognition 数据集,并选择两个不同人物的照片作为训练数据集。

3. 使用 PyTorch 实现 Deepfakes

了解了 Deepfakes 的工作原理后,我们使用 PyTorch 实现使用自编码器生成将一个人物的表情转换到另一个人物面部的虚假图像。

3.1 random_warp.py

首先编写用于实现图像扭曲的实用脚本 random_warp.py:

import numpy as np

import cv2random_transform_args = {'rotation_range': 10,'zoom_range': 0.05,'shift_range': 0.05,'random_flip': 0.4,

}def get_training_data(images, batch_size):indices = np.random.randint(len(images), size=batch_size)for i, index in enumerate(indices):image = images[index]image = random_transform(image, **random_transform_args)warped_img, target_img = random_warp(image)if i == 0:warped_images = np.empty((batch_size,) + warped_img.shape, warped_img.dtype)target_images = np.empty((batch_size,) + target_img.shape, warped_img.dtype)warped_images[i] = warped_imgtarget_images[i] = target_imgreturn warped_images, target_imagesdef random_transform(image, rotation_range, zoom_range, shift_range, random_flip):h, w = image.shape[0:2]rotation = np.random.uniform(-rotation_range, rotation_range)scale = np.random.uniform(1 - zoom_range, 1 + zoom_range)tx = np.random.uniform(-shift_range, shift_range) * wty = np.random.uniform(-shift_range, shift_range) * hmat = cv2.getRotationMatrix2D((w // 2, h // 2), rotation, scale)mat[:, 2] += (tx, ty)result = cv2.warpAffine(image, mat, (w, h), borderMode=cv2.BORDER_REPLICATE)if np.random.random() < random_flip:result = result[:, ::-1]return result# get pair of random warped images from aligened face image

def random_warp(image):assert image.shape == (256, 256, 3)range_ = np.linspace(128 - 80, 128 + 80, 5)mapx = np.broadcast_to(range_, (5, 5))mapy = mapx.Tmapx = mapx + np.random.normal(size=(5, 5), scale=5)mapy = mapy + np.random.normal(size=(5, 5), scale=5)interp_mapx = cv2.resize(mapx, (80, 80))[8:72, 8:72].astype('float32')interp_mapy = cv2.resize(mapy, (80, 80))[8:72, 8:72].astype('float32')warped_image = cv2.remap(image, interp_mapx, interp_mapy, cv2.INTER_LINEAR)src_points = np.stack([mapx.ravel(), mapy.ravel()], axis=-1)dst_points = np.mgrid[0:65:16, 0:65:16].T.reshape(-1, 2)mat = umeyama(src_points, dst_points, True)[0:2]target_image = cv2.warpAffine(image, mat, (64, 64))return warped_image, target_imagedef umeyama(src, dst, estimate_scale):num = src.shape[0]dim = src.shape[1]# Compute mean of src and dst.src_mean = src.mean(axis=0)dst_mean = dst.mean(axis=0)# Subtract mean from src and dst.src_demean = src - src_meandst_demean = dst - dst_meanA = np.dot(dst_demean.T, src_demean) / numd = np.ones((dim,), dtype=np.double)if np.linalg.det(A) < 0:d[dim - 1] = -1T = np.eye(dim + 1, dtype=np.double)U, S, V = np.linalg.svd(A)rank = np.linalg.matrix_rank(A)if rank == 0:return np.nan * Telif rank == dim - 1:if np.linalg.det(U) * np.linalg.det(V) > 0:T[:dim, :dim] = np.dot(U, V)else:s = d[dim - 1]d[dim - 1] = -1T[:dim, :dim] = np.dot(U, np.dot(np.diag(d), V))d[dim - 1] = selse:T[:dim, :dim] = np.dot(U, np.dot(np.diag(d), V.T))if estimate_scale:scale = 1.0 / src_demean.var(axis=0).sum() * np.dot(S, d)else:scale = 1.0T[:dim, dim] = dst_mean - scale * np.dot(T[:dim, :dim], src_mean.T)T[:dim, :dim] *= scalereturn T

3.2 Deepfakes.py

(1) 导入所需库:

from random_warp import get_training_data

import cv2

from glob import glob

import numpy as np

from torch.utils.data import DataLoader, Dataset

import random

import torch

import os

from torch import nn

from torch import optim

from matplotlib import pyplot as plt

device = 'cuda' if torch.cuda.is_available() else 'cpu'

(2) 从图像中提取人脸裁剪图像。

定义人脸级联分类器,人脸级联分类器是一种人脸检测方法,可以在图像中的面部周围绘制一个边界框:

face_cascade = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

OpenCV 提供了 4 个级联分类器用于人脸检测,可以从 OpenCV 官方下载这些级联分类器文件:

haarcascade_frontalface_alt.xml(FA1)haarcascade_frontalface_alt2.xml(FA2)haarcascade_frontalface_alt_tree.xml(FAT)haarcascade_frontalface_default.xml(FD)

可以使用不同的数据集评估这些级联分类器的性能,总的来说这些分类器具有相似的准确率。

定义用于从图像中裁剪人脸的函数 crop_face():

def crop_face(img):gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)faces = face_cascade.detectMultiScale(gray, 1.3, 5)if(len(faces)>0):for (x,y,w,h) in faces:img2 = img[y:(y+h),x:(x+w),:]img2 = cv2.resize(img2,(256,256))return img2, Trueelse:return img, False

在以上函数中,我们通过人脸级联分类器传递灰度图像 gray 并裁剪包含人脸的矩形图像。接下来,返回一个重新调整大小的图像 img2。此外,为了考虑在图像中没有检测到人脸的情况,我们使用一个标志位记录图像中是否检测到人脸。

裁剪 personA 和 personB 的图像并将它们放在不同的文件夹中:

if not os.path.exists('cropped_faces_personA'):os.mkdir('cropped_faces_personA')

if not os.path.exists('cropped_faces_personB'):os.mkdir('cropped_faces_personB')

def crop_images(folder):images = glob(folder+'/*.jpg')for i in range(len(images)):img = cv2.imread(images[i], 1)img2, face_detected = crop_face(img)if(face_detected==False):continueelse:cv2.imwrite('cropped_faces_'+folder+'/'+str(i)+'.jpg',img2)#cv2.cvtColor(img2, cv2.COLOR_RGB2BGR))

crop_images('personA')

crop_images('personB')

(3) 创建数据加载器并检查数据:

class ImageDataset(Dataset):def __init__(self, items_A, items_B):self.items_A = np.concatenate([cv2.cvtColor(cv2.imread(f,1), cv2.COLOR_BGR2RGB)[None] for f in items_A])/255.self.items_B = np.concatenate([cv2.cvtColor(cv2.imread(f,1), cv2.COLOR_BGR2RGB)[None] for f in items_B])/255.self.items_A += self.items_B.mean(axis=(0, 1, 2)) - self.items_A.mean(axis=(0, 1, 2))def __len__(self):return min(len(self.items_A), len(self.items_B))def __getitem__(self, ix):a, b = random.choice(self.items_A), random.choice(self.items_B)return a, bdef collate_fn(self, batch):imsA, imsB = list(zip(*batch))imsA, targetA = get_training_data(imsA, len(imsA))imsB, targetB = get_training_data(imsB, len(imsB))imsA, imsB, targetA, targetB = [torch.Tensor(i).permute(0,3,1,2).to(device) for i in [imsA, imsB, targetA, targetB]]return imsA, imsB, targetA, targetBa = ImageDataset(glob('cropped_faces_personA/*.jpg'), glob('cropped_faces_personB/*.jpg'))

x = DataLoader(a, batch_size=32, collate_fn=a.collate_fn)

数据加载器返回四个张量,imsA、imsB、targetA 和 targetB。第一个张量 imsA 是第三个张量 targetA 的扭曲(变形)版本,第二个 imsB 是第四个张量 targetB 的扭曲(变形)版本。

我们使用两个图像文件夹,每个人脸图像使用一个文件夹 (a =ImageDataset(glob('cropped_faces_personA/*.jpg'), glob('cropped_faces_personB/*.jpg))),并且在 __iteritems__ 方法中,分别在两个文件夹中随机获取一张人脸图像。

在 collate_fn 方法中的关键函数是 get_training_data,用于通过扭曲(变形)人脸图像执行图像增强,将扭曲后的人脸图像作为自编码器的输入,并尝试预测正常人脸图像。使用扭曲图像,不仅增加了训练数据的数量,而且还可以作为神经网络的正则化器,强制神经网络根据扭曲的人脸图像学习关键的面部特征。

查看示例图像样本:

idx = 1

imgs = next(iter(x))[0]

for i in imgs:plt.subplot(2,4,idx)plt.imshow(i.permute(1,2,0).detach().cpu())idx += 1if idx > 8:break

plt.show()

可以看到,输入图像是扭曲人脸图像,而输出图像为正常人脸图像,且输入与输出图像一一对应。

(4) 构建模型并查看模型架构。

定义卷积 (_ConvLayer) 和反卷积 (_UpScale) 函数以及 Reshape 类:

def _ConvLayer(input_features, output_features):return nn.Sequential(nn.Conv2d(input_features, output_features, kernel_size=5, stride=2, padding=2),nn.LeakyReLU(0.1, inplace=True))def _UpScale(input_features, output_features):return nn.Sequential(nn.ConvTranspose2d(input_features, output_features, kernel_size=2, stride=2, padding=0),nn.LeakyReLU(0.1, inplace=True))class Reshape(nn.Module):def forward(self, input):output = input.view(-1, 1024, 4, 4) # channel * 4 * 4return output

定义 Autoencoder 模型类,它包含一个编码器和两个解码器 (decoder_A 和 decoder_B):

class Autoencoder(nn.Module):def __init__(self):super(Autoencoder, self).__init__()self.encoder = nn.Sequential(_ConvLayer(3, 128),_ConvLayer(128, 256),_ConvLayer(256, 512),_ConvLayer(512, 1024),nn.Flatten(),nn.Linear(1024 * 4 * 4, 1024),nn.Linear(1024, 1024 * 4 * 4),Reshape(),_UpScale(1024, 512),)self.decoder_A = nn.Sequential(_UpScale(512, 256),_UpScale(256, 128),_UpScale(128, 64),nn.Conv2d(64, 3, kernel_size=3, padding=1),nn.Sigmoid(),)self.decoder_B = nn.Sequential(_UpScale(512, 256),_UpScale(256, 128),_UpScale(128, 64),nn.Conv2d(64, 3, kernel_size=3, padding=1),nn.Sigmoid(),)def forward(self, x, select='A'):if select == 'A':out = self.encoder(x)out = self.decoder_A(out)else:out = self.encoder(x)out = self.decoder_B(out)return out

(5) 定义 train_batch 函数:

def train_batch(model, data, criterion, optimizers):optA, optB = optimizersoptA.zero_grad()optB.zero_grad()imgA, imgB, targetA, targetB = data_imgA, _imgB = model(imgA, 'A'), model(imgB, 'B')lossA = criterion(_imgA, targetA)lossB = criterion(_imgB, targetB)lossA.backward()lossB.backward()optA.step()optB.step()return lossA.item(), lossB.item()

model(imgA, 'B') 使用来自 A 类的输入图像返回 B 类的图像,根据 imgA 预测 _imgA (其中 imgA 是 targetA 的扭曲版本)并使用 nn.L1Loss 将 _imgA 与 targetA 进行比较,在训练期间预测新图像并定性地查看模型训练情况。

(6) 创建训练模型所需的所有组件:

model = Autoencoder().to(device)dataset = ImageDataset(glob('cropped_faces_personA/*.jpg'), glob('cropped_faces_personB/*.jpg'))

dataloader = DataLoader(dataset, 32, collate_fn=dataset.collate_fn)optimizers = optim.Adam([{'params': model.encoder.parameters()},{'params': model.decoder_A.parameters()}],lr=5e-5, betas=(0.5, 0.999)), \optim.Adam([{'params': model.encoder.parameters()},{'params': model.decoder_B.parameters()}], lr=5e-5, betas=(0.5, 0.999))criterion = nn.L1Loss()

(7) 训练模型:

n_epochs = 50000

train_loss_A = []

train_loss_B = []

if not os.path.exists('checkpoint'):os.mkdir('checkpoint')

for ex in range(n_epochs):N = len(dataloader)trn_loss_A = []trn_loss_B = []for bx,data in enumerate(dataloader):lossA, lossB = train_batch(model, data, criterion, optimizers)pos = (ex + (bx+1)/N)trn_loss_A.append(lossA)trn_loss_B.append(lossB)train_loss_A.append(np.average(trn_loss_A))train_loss_B.append(np.average(trn_loss_B))if (ex+1)%1000 == 0:state = {'state': model.state_dict(),'epoch': ex}torch.save(state, './checkpoint/autoencoder.pth')if (ex+1)%1000 == 0:bs = 5a,b,A,B = data_a = model(a[:bs], 'A')_b = model(a[:bs], 'B')x = torch.cat([A[:bs],_a,_b])idx = 1for im in x:plt.subplot(3, 5, idx)plt.imshow(im.permute(1,2,0).detach().cpu())idx += 1plt.show()_a = model(b[:bs], 'A')_b = model(b[:bs], 'B')x = torch.cat([B[:bs],_a,_b])idx = 1for im in x:plt.subplot(3, 5, idx)plt.imshow(im.permute(1,2,0).detach().cpu())idx += 1plt.show()

生成的重建图像如下所示:

损失值的变化如下:

epochs = np.arange(n_epochs)+1

plt.plot(epochs, train_loss_A, 'bo', label='Training loss A')

plt.plot(epochs, train_loss_B, 'r-', label='Training loss B')

plt.title('Training and Test loss over increasing epochs')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.grid('off')

plt.show()

如上图所示,可以通过调整自编码器使用两个解码器将表情从一张人脸交换到另一张人脸上。此外,随着训练的增加,重建的图像将变得更加逼真。

小结

Deepfakes 可以用于创造出艺术作品和娱乐内容,能够将一个人的表演或特征应用到不同的情境中,为电影、视频和游戏等领域带来创新和丰富多样的体验。也可以为电影制片人和视觉特效团队提供了更加高效和经济的方式来实现人物替换和数字化特效。相对于传统的化妆和后期制作技术,Deepfakes 可以更快速地生成逼真的效果。因此,Deepfakes 具备广泛创造性和应用潜力,但也应当研究相应的技术来避免隐私、欺骗和滥用等问题。

系列链接

PyTorch深度学习实战(1)——神经网络与模型训练过程详解

PyTorch深度学习实战(2)——PyTorch基础

PyTorch深度学习实战(3)——使用PyTorch构建神经网络

PyTorch深度学习实战(4)——常用激活函数和损失函数详解

PyTorch深度学习实战(5)——计算机视觉基础

PyTorch深度学习实战(6)——神经网络性能优化技术

PyTorch深度学习实战(7)——批大小对神经网络训练的影响

PyTorch深度学习实战(8)——批归一化

PyTorch深度学习实战(9)——学习率优化

PyTorch深度学习实战(10)——过拟合及其解决方法

PyTorch深度学习实战(11)——卷积神经网络

PyTorch深度学习实战(12)——数据增强

PyTorch深度学习实战(13)——可视化神经网络中间层输出

PyTorch深度学习实战(14)——类激活图

PyTorch深度学习实战(15)——迁移学习

PyTorch深度学习实战(16)——面部关键点检测

PyTorch深度学习实战(17)——多任务学习

PyTorch深度学习实战(18)——目标检测基础

PyTorch深度学习实战(19)——从零开始实现R-CNN目标检测

PyTorch深度学习实战(20)——从零开始实现Fast R-CNN目标检测

PyTorch深度学习实战(21)——从零开始实现Faster R-CNN目标检测

PyTorch深度学习实战(22)——从零开始实现YOLO目标检测

PyTorch深度学习实战(23)——使用U-Net架构进行图像分割

PyTorch深度学习实战(24)——从零开始实现Mask R-CNN实例分割

PyTorch深度学习实战(25)——自编码器(Autoencoder)

PyTorch深度学习实战(26)——卷积自编码器(Convolutional Autoencoder)

PyTorch深度学习实战(27)——变分自编码器(Variational Autoencoder, VAE)

PyTorch深度学习实战(28)——对抗攻击(Adversarial Attack)

PyTorch深度学习实战(29)——神经风格迁移

相关文章:

PyTorch深度学习实战(30)——Deepfakes

PyTorch深度学习实战(30)——Deepfakes 0. 前言1. Deepfakes 原理2. 数据集分析3. 使用 PyTorch 实现 Deepfakes3.1 random_warp.py3.2 Deepfakes.py 小结系列链接 0. 前言 Deepfakes 是一种利用深度学习技术生成伪造视频和图像的技术。它通过将一个人的…...

java 修改JsonObject对象所有的Value类型为String

将JSONObject 或者JSONArray 中所有Value 为数值类型 转为String. 转换前: [{"zjlx": 201,"xm": "刘**","cbdjxxlist": [{"zspmdm": 102031201,"rybm": "43000010300000411195","jfrlx": 1…...

Vue3-47-Pinia-修改全局状态变量值的方式

说明 修改全局状态变量的值,是一个比较常规而且常见的操作。 本文就介绍四种常见的操作。 由于Option Store 和Setup Store 在修改的时候略有不同,所以本文也会将不同点体现一下。 全局状态变量的定义 包含了 Option Store 和Setup Store 两种定义方式&a…...

【Scala】——面向对象

1 Scala 包 1.1 包风格 Scala 有两种包的管理风格。 第一种 Java 的包管理风格相同,每个源文件一个包(包 名和源文件所在路径不要求必须一致),包名用“.”进行分隔以表示包的层级关系,如 com.atguigu.scala。另一种风…...

【MediaFoundation】OpenCV VideoCapture 读取音频源码

OpenCV 读取音频代码实例 在windows7 以及OpenCV4 过后可以使用 CAP_MSMF 读取音频,但是OpenCV没有播放音频的API。代码示例如下。 本文解析OpenCVCAP_MSMF 进行文件、设备的 音频读取,学习MediaFoundation 的使用。 #include <opencv2/core.hpp>…...

2024秋招,百度测试开发工程师一面

前言 大家好,今天我来回顾一下秋招中的一场很重要技术面试 一面面试官深挖我的项目经历,并提出了很多的实际场景,我现在回顾依然有很多新的认识 过程 自我介绍实习工作中,做得最好的地方是什么? 我先介绍了一下实习…...

Git 使用与问题记录 二(公司快速上手版)

写在前面 记录自己学习的内容,方便后面忘记的时候查看。给像我一样的新手提供一点参考 正文 上一章已经安装好了Git,如何使用呢。我这里会分享两种办法,第一种是在VS2022中克隆代码,修改和提交;第二种是用命令提交。…...

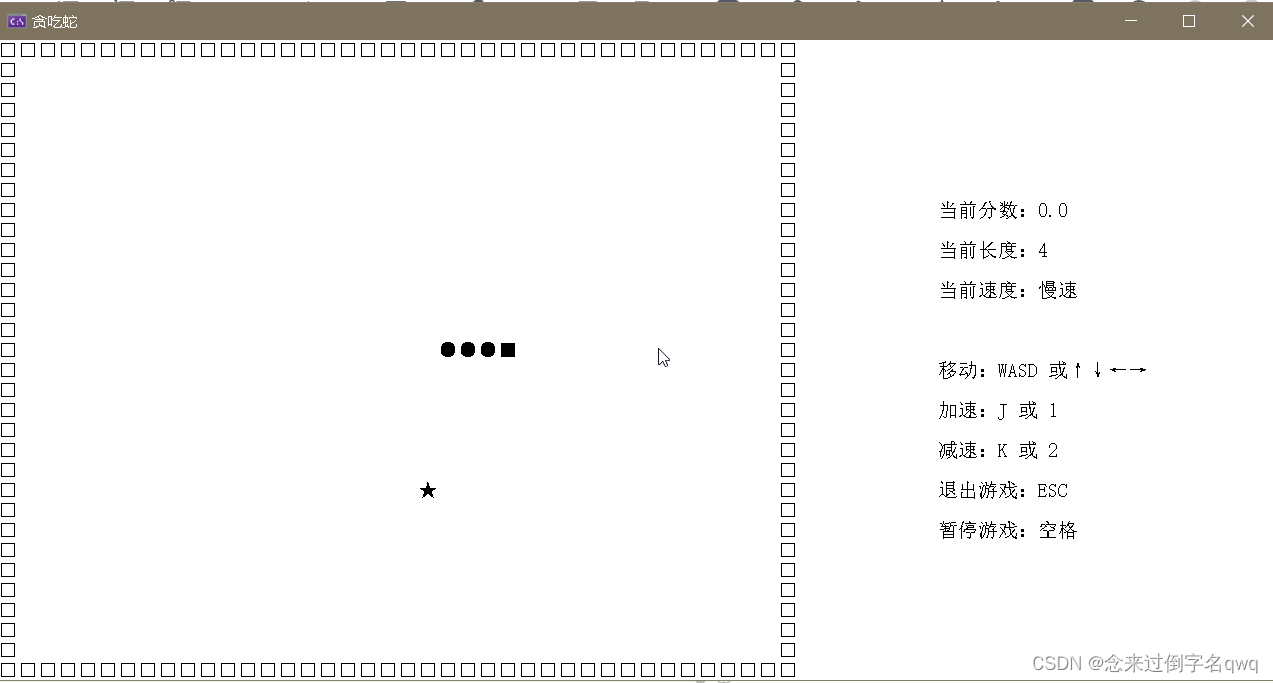

【C语言小游戏】贪吃蛇

文章目录 1.引言2.运行图2.涉及知识3 Windows API3.1 控制台3.2 控制台屏幕坐标3.3 操作句柄3.4 控制台屏幕光标3.5 监视按键 4. 设计说明5. 完整代码 1.引言 使⽤C语⾔在Windows环境的控制台中模拟实现经典⼩游戏贪吃蛇 实现基本的功能: 贪吃蛇地图绘制蛇吃⻝物的…...

价值7500的在线授权网站源码支持IP+域名+双向授权全开源

PHP授权验证更新系统完整版,一键更新系统,一键卡密生成自助授权功能,域名ip双重验证功能等等 修复盗版检测,确保实时查看盗版 修复在线加密系统,一键加密 授权系统几乎所有的程序都能整合使用,包括您的app和计算机程序…...

haiku实现门控多头注意力模块

在多头注意力机制中,通常输入的数据包括查询(Q)、键(K)和值(V)。这些数据的维度以及权重矩阵的维度在多头注意力机制中扮演关键角色。下面对数据及权重的维度进行解释: 输入数据&…...

【React 常用的 TS 类型】持续更新

1)定义样式的 TS 类型 【 React.CSSProperties 】 一般定义样式时需要的类型限制,如下: const customStyle: React.CSSProperties {color: blue,fontSize: 16px,margin: 10px,}; 2)定义 Input Ref 属性时的 TS 类型限制 【 R…...

打破传统边界,VR技术与六西格玛设计理念的创新融合!

在科技飞速发展的今天,虚拟现实(VR)技术以其独特的沉浸式体验,正在改变我们的生活和工作方式。然而,要让VR真正成为主流,我们必须解决一些关键问题,其中最重要的就是用户体验。六西格玛设计&…...

[uniapp] uni-ui+vue3.2小程序评论列表组件 回复评论 点赞和删除

先看效果 下载地址 uni-app官方插件市场: cc-comment组件 环境 基于vue3.2和uni-ui开发; 依赖版本参考如下: "dependencies": {"dcloudio/uni-mp-weixin": "3.0.0-3090820231124001","dcloudio/uni-ui": "^1.4.28","…...

:TongLINKQ常用命令)

TongLINKQ(3):TongLINKQ常用命令

启动: tlq 暂停: tlq -cabort -y -w1 查看lic信息: tlqstat –lic 查看队列消息: tlqstat -qcu qcu名 -c 查看发送连接状态: tlqstat -snd qcu名 -1 -ct 1 查看指定的Qcu连接状态: tlqsta…...

抽水马桶出水慢解决记录

今天分享一些修马桶的小心得(雾) 家里的马桶出水很好,但是水却不怎么被冲下去(出水很慢),这会导致内容物滞留,造成很不好的使用体验。 出于成本考虑,首先选择自己维修。 首先直接…...

img标签的奇怪问题

本来只是为实现一个轮播图,img的url地址是从后端接口获取的,但不巧的是url地址的图片都过期了。 因为懒得重新到网上找图,就想直接用一下本地的图片,简单的想法遇到一堆问题。 问题一: 因为是springboot项目…...

深入探究Hibernate:优雅、强大的Java持久化框架

目录 1、前言 2、Hibernate简介 2.1 什么是Hibernate 2.2 为什么选择Hibernate 3、Hibernate核心概念 3.1 实体类和映射文件 3.2 数据库表和持久化类的映射 3.3 主键生成策略 3.4 持久化操作 3.5 查询语言(HQL和Criteria) 3.6 事务管理 4、Hibernate配置与连接 4…...

JavaScript高级特性详解

摘要:本文将深入探讨JavaScript中的一些高级特性,包括闭包、原型链、高阶函数和异步编程。我们将通过详细的注释和实例来帮助读者理解这些概念,并通过总结部分强调其在实际开发中的应用。 一、闭包 闭包是JavaScript中一个非常重要的概念&a…...

网站建设网络设计营销类网站eyouCMS模板(PC+WAP)

模板介绍: 本模板自带eyoucms内核,无需再下载eyou系统,原创设计、手工书写DIVCSS,完美兼容IE7、Firefox、Chrome、360浏览器等;主流浏览器;结构容易优化;多终端均可正常预览。...

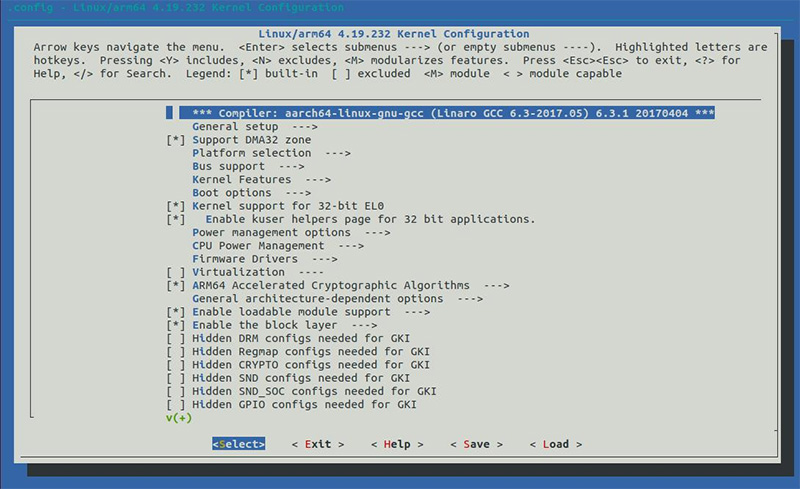

迅为RK3568开发板Android11/12/Linux编译驱动到内核

在平时的驱动开发中,经常需要在内核中配置某种功能,为了方便大家开发和学习,本小 节讲解如何在内核中添加驱动。具体的讲解原理讲解请参考本手册的驱动教程。 Android11 源码如果想要修改内核,可以运行以下命令进行修改: cd ke…...

业务系统对接大模型的基础方案:架构设计与关键步骤

业务系统对接大模型:架构设计与关键步骤 在当今数字化转型的浪潮中,大语言模型(LLM)已成为企业提升业务效率和创新能力的关键技术之一。将大模型集成到业务系统中,不仅可以优化用户体验,还能为业务决策提供…...

手游刚开服就被攻击怎么办?如何防御DDoS?

开服初期是手游最脆弱的阶段,极易成为DDoS攻击的目标。一旦遭遇攻击,可能导致服务器瘫痪、玩家流失,甚至造成巨大经济损失。本文为开发者提供一套简洁有效的应急与防御方案,帮助快速应对并构建长期防护体系。 一、遭遇攻击的紧急应…...

K8S认证|CKS题库+答案| 11. AppArmor

目录 11. AppArmor 免费获取并激活 CKA_v1.31_模拟系统 题目 开始操作: 1)、切换集群 2)、切换节点 3)、切换到 apparmor 的目录 4)、执行 apparmor 策略模块 5)、修改 pod 文件 6)、…...

高等数学(下)题型笔记(八)空间解析几何与向量代数

目录 0 前言 1 向量的点乘 1.1 基本公式 1.2 例题 2 向量的叉乘 2.1 基础知识 2.2 例题 3 空间平面方程 3.1 基础知识 3.2 例题 4 空间直线方程 4.1 基础知识 4.2 例题 5 旋转曲面及其方程 5.1 基础知识 5.2 例题 6 空间曲面的法线与切平面 6.1 基础知识 6.2…...

【2025年】解决Burpsuite抓不到https包的问题

环境:windows11 burpsuite:2025.5 在抓取https网站时,burpsuite抓取不到https数据包,只显示: 解决该问题只需如下三个步骤: 1、浏览器中访问 http://burp 2、下载 CA certificate 证书 3、在设置--隐私与安全--…...

python如何将word的doc另存为docx

将 DOCX 文件另存为 DOCX 格式(Python 实现) 在 Python 中,你可以使用 python-docx 库来操作 Word 文档。不过需要注意的是,.doc 是旧的 Word 格式,而 .docx 是新的基于 XML 的格式。python-docx 只能处理 .docx 格式…...

Java 加密常用的各种算法及其选择

在数字化时代,数据安全至关重要,Java 作为广泛应用的编程语言,提供了丰富的加密算法来保障数据的保密性、完整性和真实性。了解这些常用加密算法及其适用场景,有助于开发者在不同的业务需求中做出正确的选择。 一、对称加密算法…...

JUC笔记(上)-复习 涉及死锁 volatile synchronized CAS 原子操作

一、上下文切换 即使单核CPU也可以进行多线程执行代码,CPU会给每个线程分配CPU时间片来实现这个机制。时间片非常短,所以CPU会不断地切换线程执行,从而让我们感觉多个线程是同时执行的。时间片一般是十几毫秒(ms)。通过时间片分配算法执行。…...

【JavaSE】绘图与事件入门学习笔记

-Java绘图坐标体系 坐标体系-介绍 坐标原点位于左上角,以像素为单位。 在Java坐标系中,第一个是x坐标,表示当前位置为水平方向,距离坐标原点x个像素;第二个是y坐标,表示当前位置为垂直方向,距离坐标原点y个像素。 坐标体系-像素 …...

Java线上CPU飙高问题排查全指南

一、引言 在Java应用的线上运行环境中,CPU飙高是一个常见且棘手的性能问题。当系统出现CPU飙高时,通常会导致应用响应缓慢,甚至服务不可用,严重影响用户体验和业务运行。因此,掌握一套科学有效的CPU飙高问题排查方法&…...