K8s:二进制安装k8s(单台master)

目录

一、安装k8s

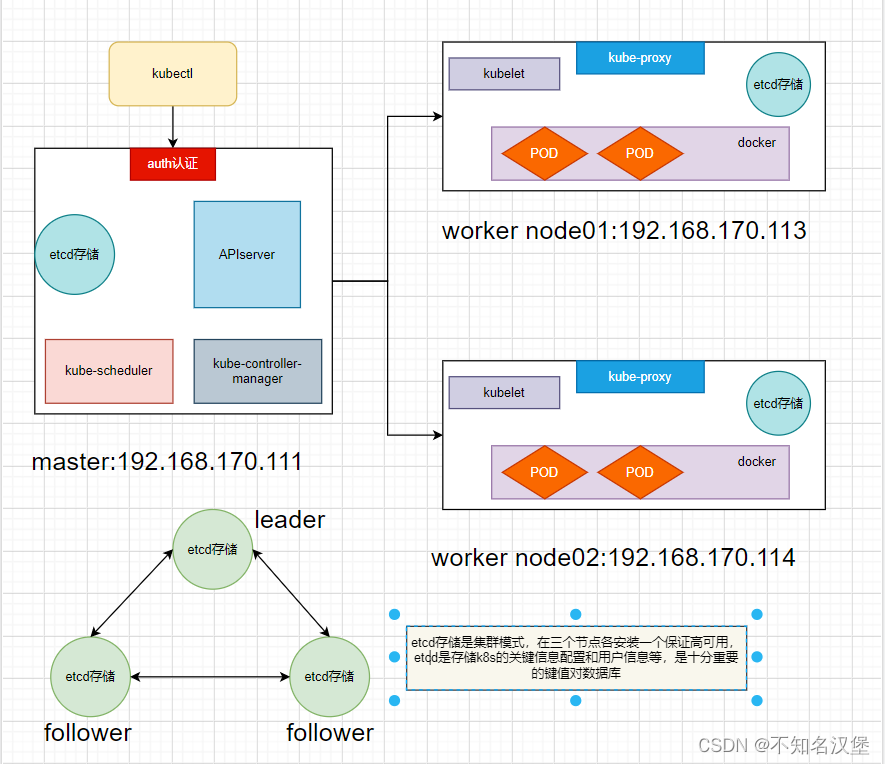

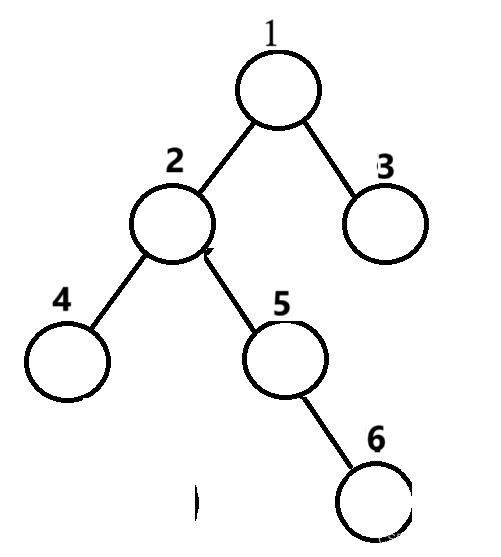

1、拓扑图

2、系统初始化配置

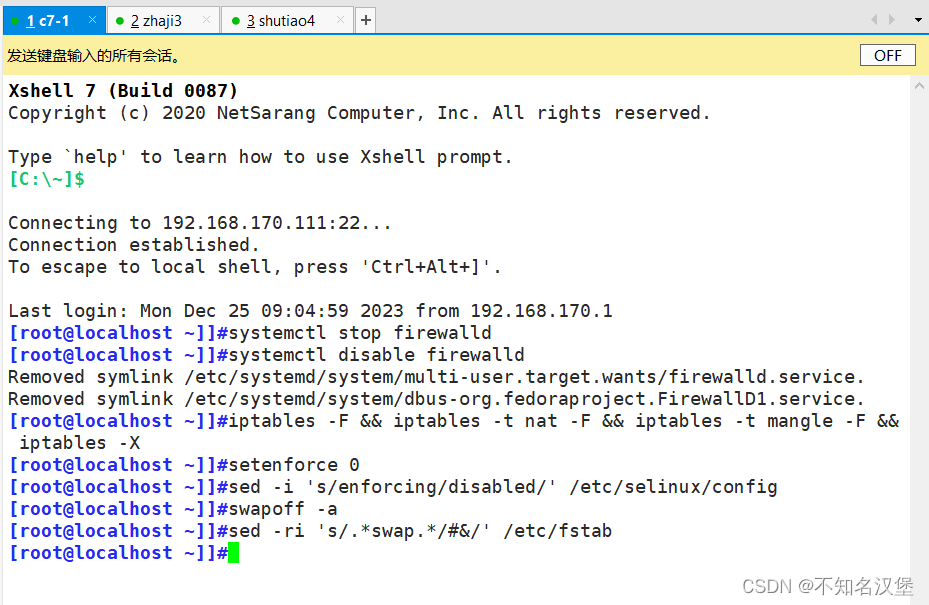

2.1关闭防火墙selinx以及swap

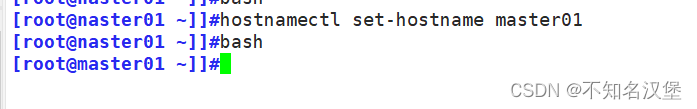

2.2设置主机名

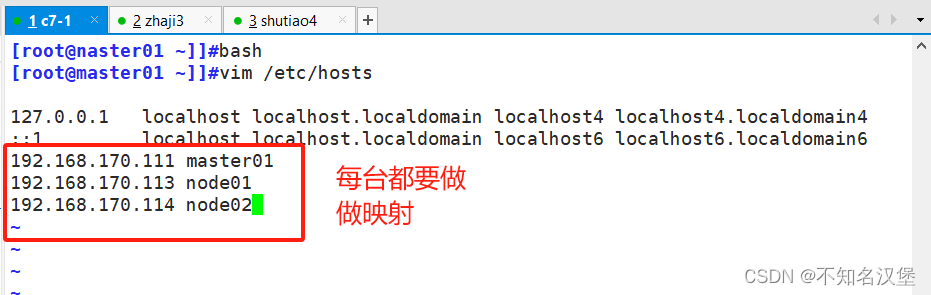

2.3在每台主机中添加hosts,做映射

2.4调整内核参数,将桥接的ipv4流量传递到iptables,关闭ipv6

2.4时间同步

3、部署docker引擎(两个node节点执行)

4、部署etcd集群

4.1在master01节点操作

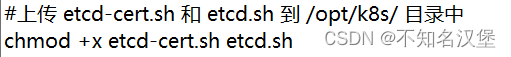

4.2生成etcd证书,上传etcd-cert.sh 和 etcd.sh 到 /opt/k8s/ 目录中

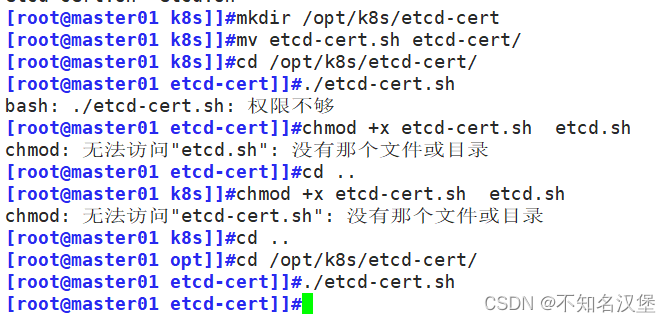

4.3创建用于生成CA证书,etcd服务器证书以及私钥的目录

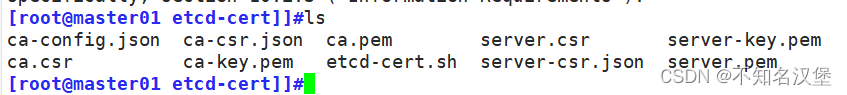

4.4上传 etcd-v3.4.9-linux-amd64.tar.gz 到 /opt/k8s 目录中,启动etcd服务

4.5创建用于存放etcd配置文件,命令文件,证书的目录

4.6把etcd相关证书文件、命令文件和服务管理文件全部拷贝到另外两个etcd集群节点

4.7在node1节点操作(node2同样)

4.8启动etcd,并检查etcd集群状态

5、master部署组件

6、部署worker node组件

6.1在所有 node 节点上操作创建kubernetes工作目录

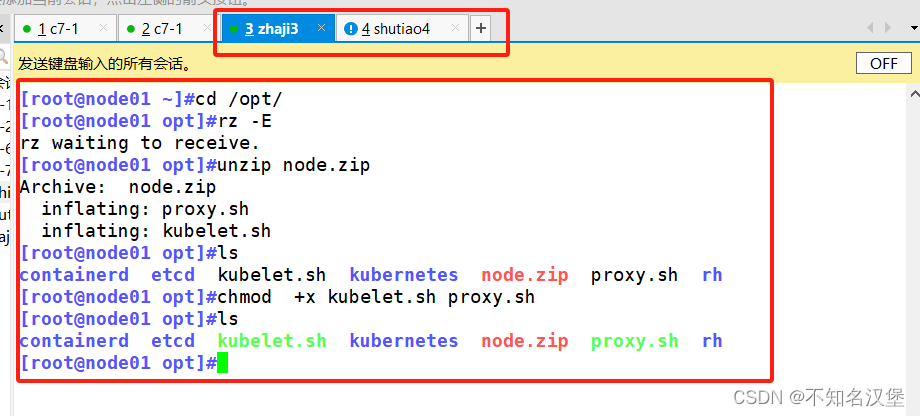

6.2上传 node.zip 到 /opt 目录中,解压 node.zip 压缩包,获得kubelet.sh、prox

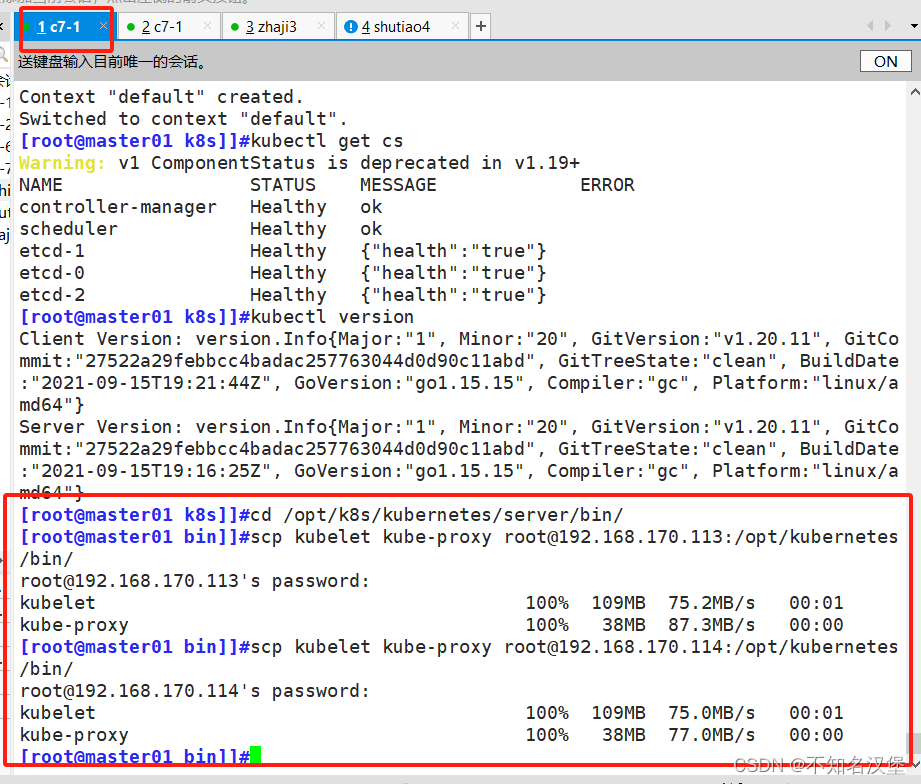

6.3在master01节点上操作把 kubelet、kube-proxy 拷贝到 node 节点

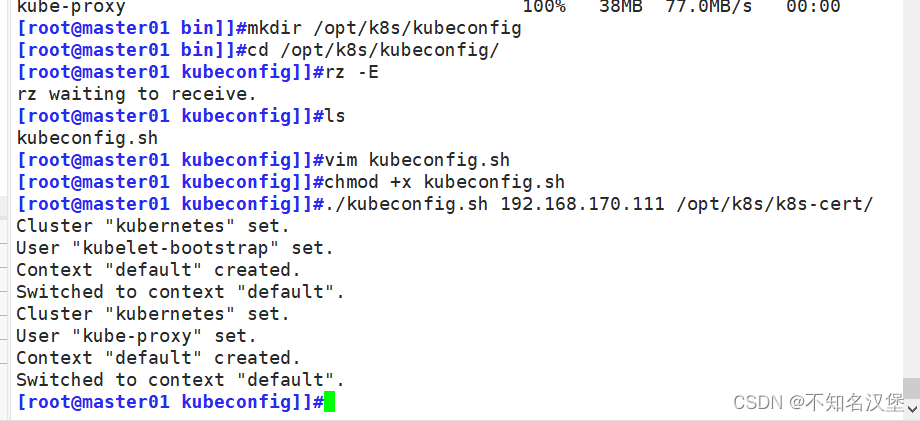

6.4上传kubeconfig.sh文件到/opt/k8s/kubeconfig目录中,生成kubelet初次加入集群引导kubeconfig文件和kube-proxy.kubeconfig文件#kubeconfig 文件包含集群参数(CA 证书、API Server 地址),客户端参数(上面生成的证书和私钥),集群 context 上下文参数(集群名称、用户名)。Kubenetes 组件(如 kubelet、kube-proxy)通过启动时指定不同的 kubeconfig 文件可以切换到不同的集群,连接到 apiserver。

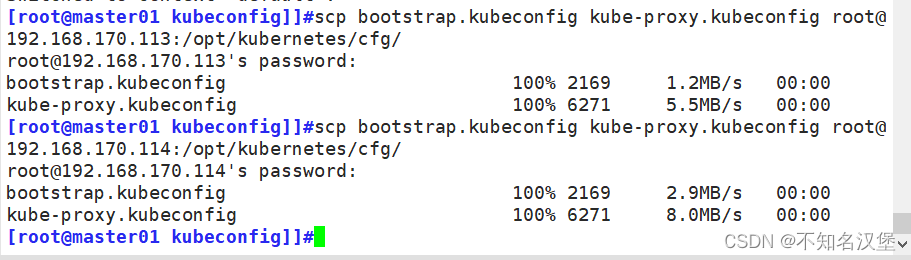

6.5把配置文件 bootstrap.kubeconfig、kube-proxy.kubeconfig 拷贝到 node 节点

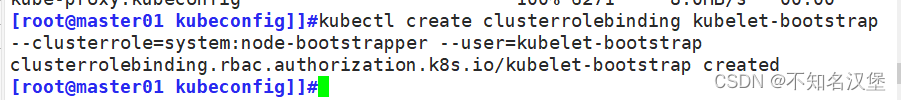

6.6RBAC授权,使用户 kubelet-bootstrap 能够有权限发起 CSR 请求证书

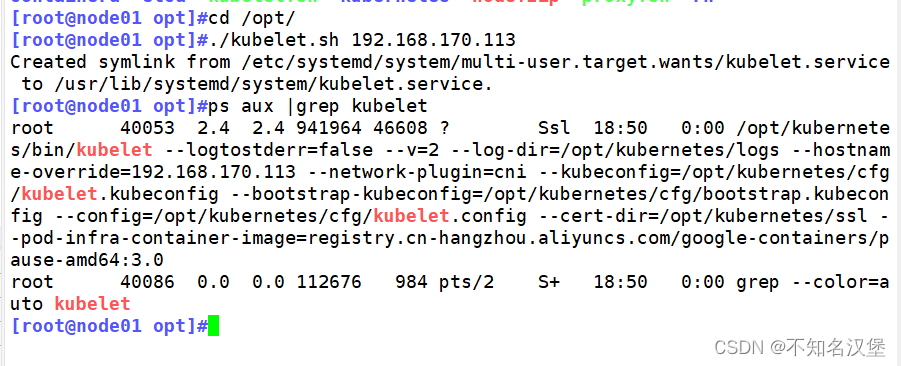

7、在node01节点上操作

7.1启动kubelet

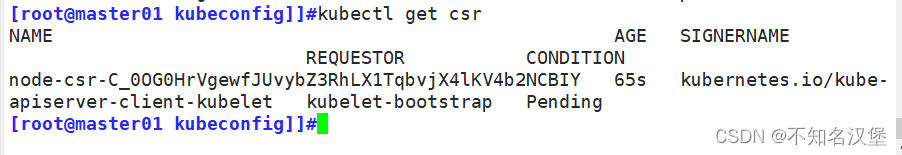

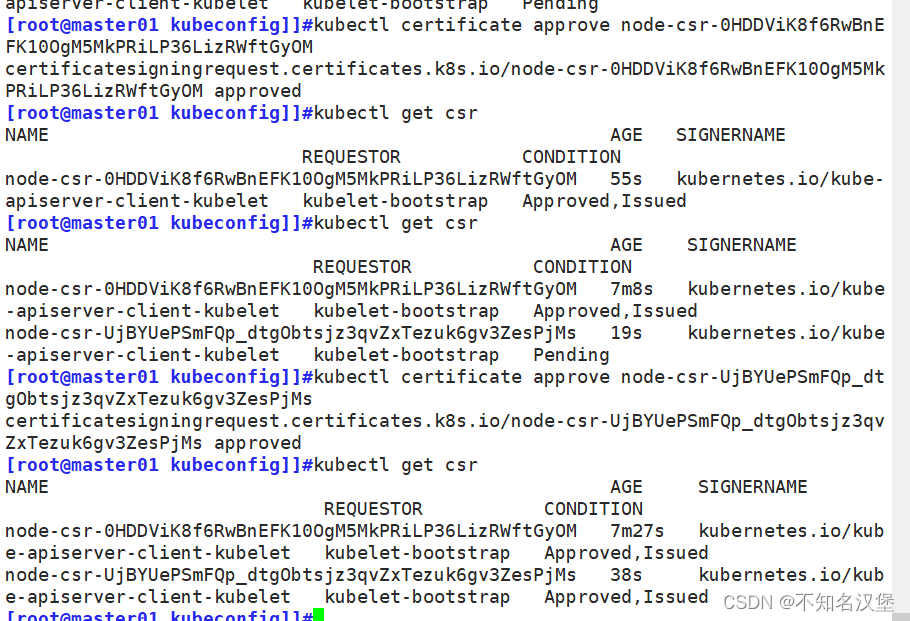

7.2在 master01 节点上操作,通过 CSR 请求检查到 node01 节点的 kubelet 发起的 CSR 请求,Pending 表示等待集群给该节点签发证书

7.3通过 CSR 请求

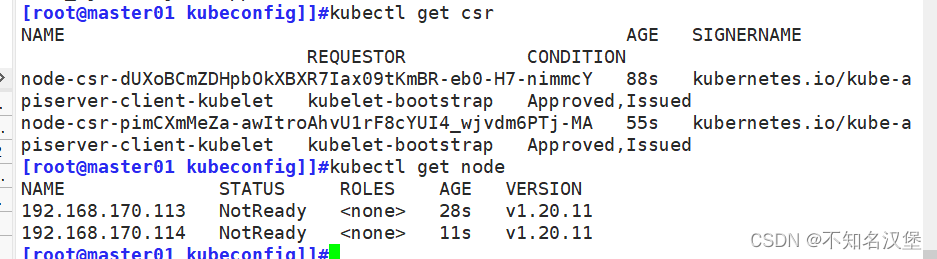

7.4查看节点,由于网络插件还没有部署,节点会没有准备就绪 NotReady

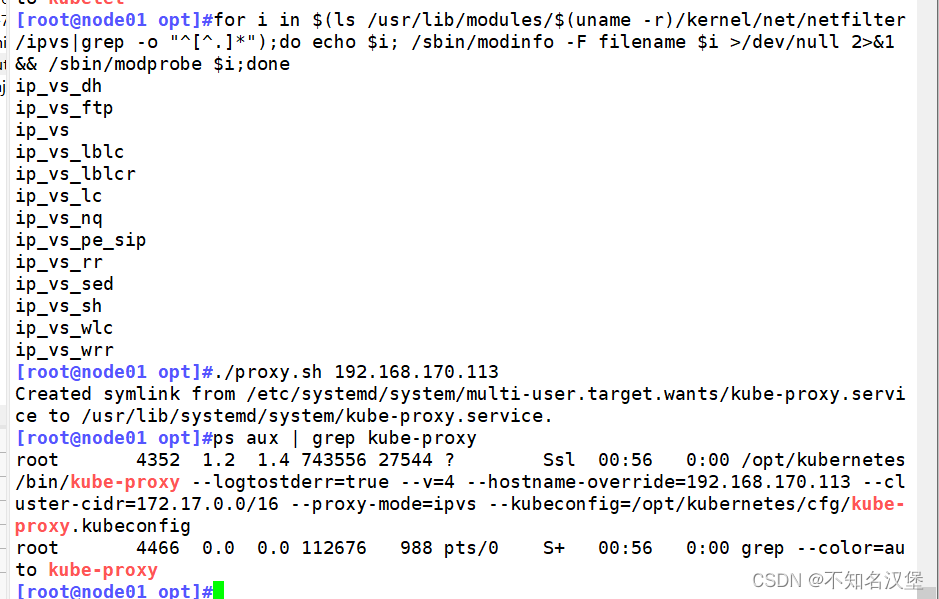

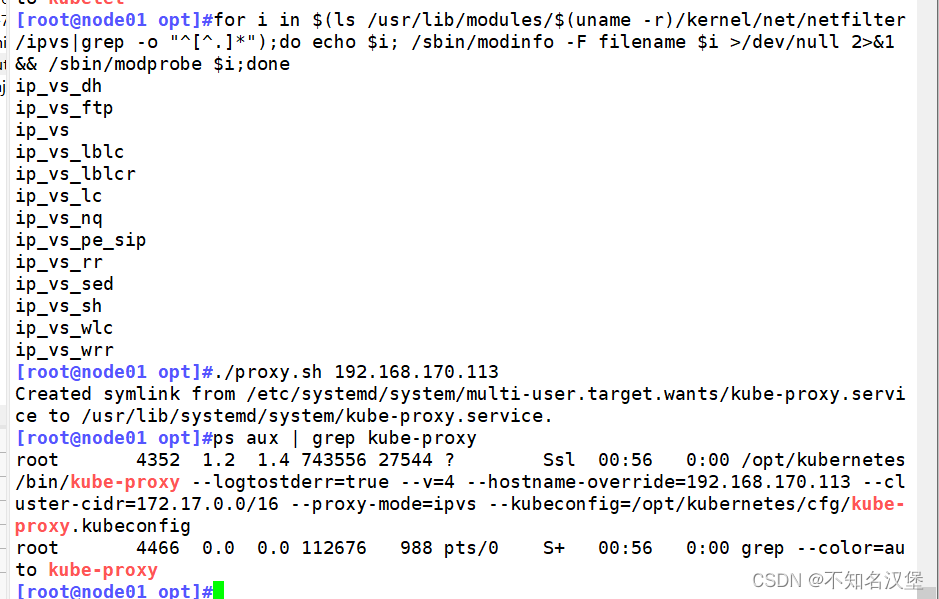

7.5在 node01 节点上操作加载 ip_vs 模块 启动proxy服务

一、安装k8s

1、拓扑图

2、系统初始化配置

#所有节点执行

systemctl stop firewalld

systemctl disable firewalld

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

#永久关闭firewalld并清空iptables所有表规则

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

#永久关闭selinux和swap分区

#三个节点分开执行

hostnamectl set-hostname master01

#192.168.170.111的master上执行修改主机名

hostnamectl set-hostname node01

#192.168.170.113的node1上执行修改主机名

hostnamectl set-hostname node02

#192.168.170.114的node2上执行修改主机名

#所有节点执行

bash

#刷新bash使得修改的主机名生效

cat >> /etc/hosts << EOF

192.168.170.111 master01

192.168.170.113 node1

192.168.170.114 node2

EOF

#使用多行重定向将主机名对应的ip写到hosts里面加快访问速度,注意改为自己的ip

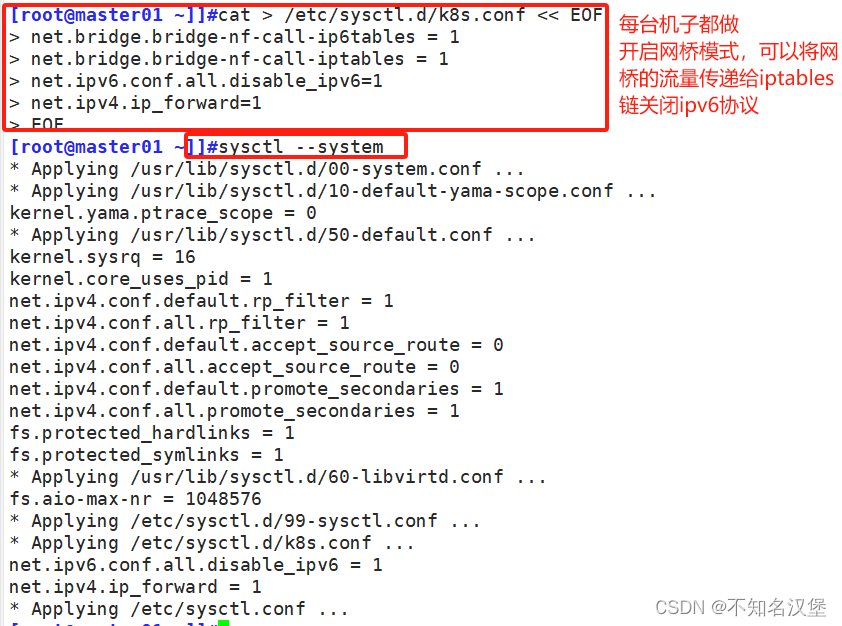

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF

#使用多行重定向调整内核参数,前2行为开启网桥模式后2行为关闭ipv6协议和开启路由转发

sysctl --system

#加载内核使得配置内核参数生效

yum install ntpdate -y

ntpdate time.windows.com

#安装ntpdate时间同步程序,并与本机的windows同步时间2.1关闭防火墙selinx以及swap

2.2设置主机名

2.3在每台主机中添加hosts,做映射

2.4调整内核参数,将桥接的ipv4流量传递到iptables,关闭ipv6

2.4时间同步

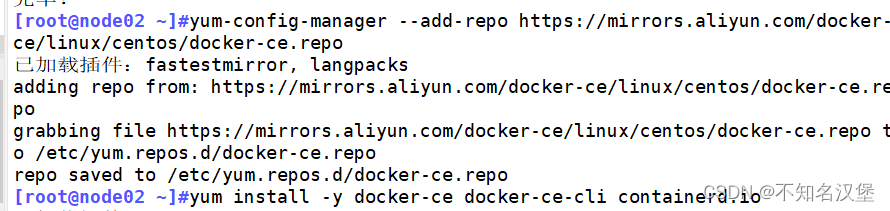

3、部署docker引擎(两个node节点执行)

#2个node节点执行

yum install -y yum-utils device-mapper-persistent-data lvm2

#安装依赖包以便在系统上安装docker

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#添加Docker官方源,并将它设置为docker-ce.repo文件

yum install -y docker-ce docker-ce-cli containerd.io

#yum安装docker-ce和docker客户端以及容器io

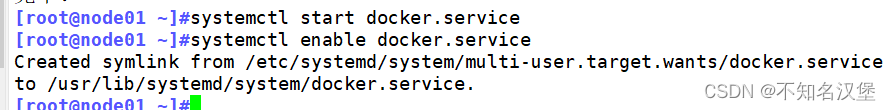

systemctl start docker.service

systemctl enable docker.service

#开机自启并现在启动docker

4、部署etcd集群

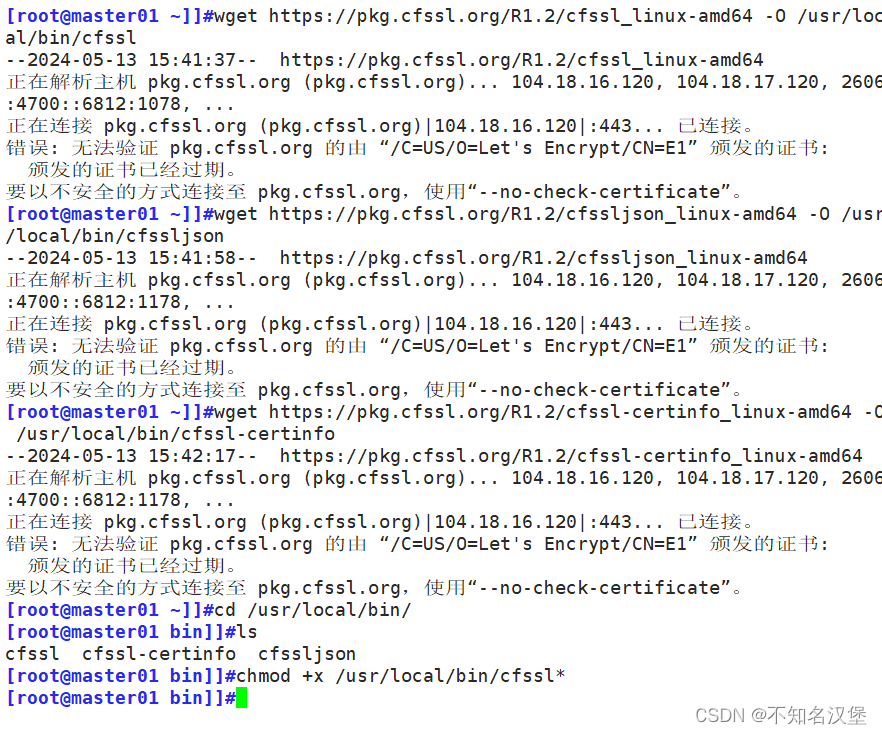

#master节点操作,#本文的所有需要上传资源在博客资源包中K8S压缩包中均有

cd /usr/local/bin

chmod +x /usr/local/bin/cfssl*

#将cfssl证书签发的工具和命令(cfssl、cfssljson、cfssl-certinfo)上传到/usr/local/bin目录下并添加执行权限

#本文的cfssl工具在博客资源包中K8S压缩包中有

#cfssl:证书签发的工具命令

#cfssljson:将 cfssl 生成的证书(json格式)变为文件承载式证书

#cfssl-certinfo:验证证书的信息

#cfssl-certinfo -cert <证书名称> #查看证书的信息

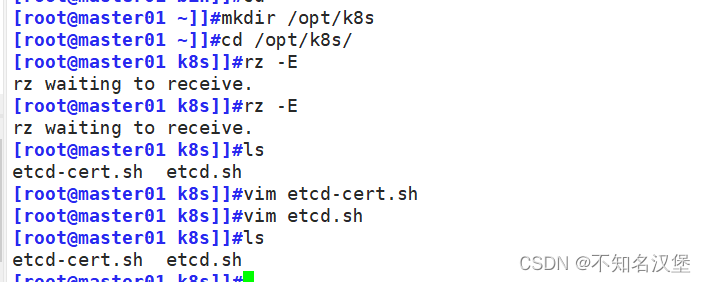

mkdir /opt/k8s

cd /opt/k8s/

#上传 etcd-cert.sh(生成证书脚本) 和 etcd.sh(创建etcd集群脚本) 到 /opt/k8s/ 目录中

chmod +x etcd-cert.sh etcd.sh

#添加可执行权限

mkdir /opt/k8s/etcd-cert

#创建etcd-cert目录用于存放etcd的证书

mv etcd-cert.sh /opt/k8s/etcd-cert

#移动生成证书的脚本到存放etcd证书的目录下

vim /opt/k8s/etcd-cert/etcd-cert.sh

#此脚本ip需要修改80到82行master,node1,node2顺序保存退出

vim ./etcd-cert.sh

#修改脚本中的ip为自己的ip

./etcd-cert.sh

#生成CA证书、etcd 服务器证书以及私钥

ls /opt/k8s/etcd-cert

#查看生成的证书是否为4个.pem结尾3个.json结尾

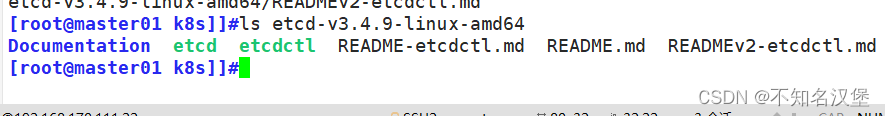

#上传 etcd-v3.4.9-linux-amd64.tar.gz(etcd程序命令及证书) 到 /opt/k8s 目录中,启动etcd服务

cd /opt/k8s/

tar zxvf etcd-v3.4.9-linux-amd64.tar.gz

ls etcd-v3.4.9-linux-amd64

#解压上传的etcd包,内容为3个.md文件一个目录,一个etcd和一个etcdctl启动控制脚本

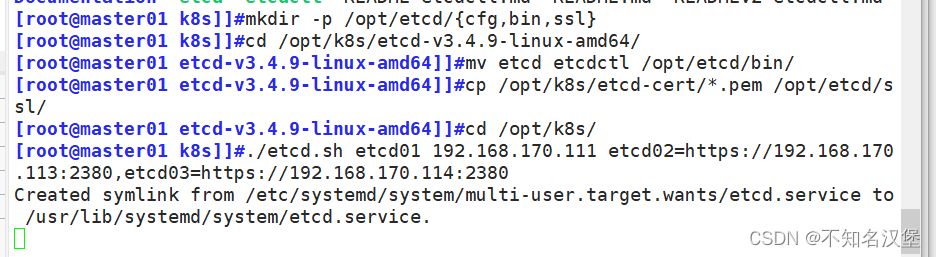

mkdir -p /opt/etcd/{cfg,bin,ssl}

#创建用于存放etcd配置文件,命令文件,证书的目录

cd /opt/k8s/etcd-v3.4.9-linux-amd64

#进入解压的etcd包中

mv etcd etcdctl /opt/etcd/bin/

#将etcd启动和etcdctl控制脚本移动到创建的用于存放etcd命令文件的bin目录下

cd /opt/k8s/etcd-cert

#进入创建etcd证书的目录

cp ./*.pem /opt/etcd/ssl

#将本目录下所有证书全部拷贝一份到创建的用于存放etcd证书的路径ssl上

cd /opt/k8s

./etcd.sh etcd01 192.168.170.111 etcd02=https://192.168.170.113:2380,etcd03=https://192.168.170.114:2380

#进入存放etcd.sh部署etcd集群的脚本目录执行etcd.sh脚本 后面跟三个etcd集群的ip注意格式,进入卡住状态等待其他节点加入,这里需要三台etcd服务同时启动,如果只启动其中一台后,服务会卡在那里,直到集群中所有etcd节点都已启动,先操作不然不会生成system管理和配置文件,重新开启一个shell查看etcd状态

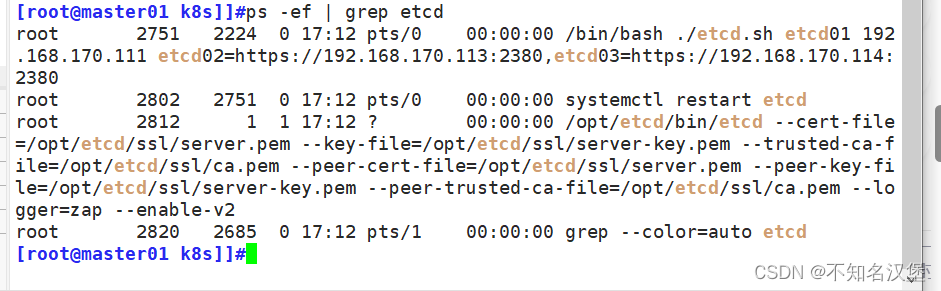

#另一个窗口执行

ps -ef | grep etcd

#查看etcd集群状态是否为自己的三个etcd ip

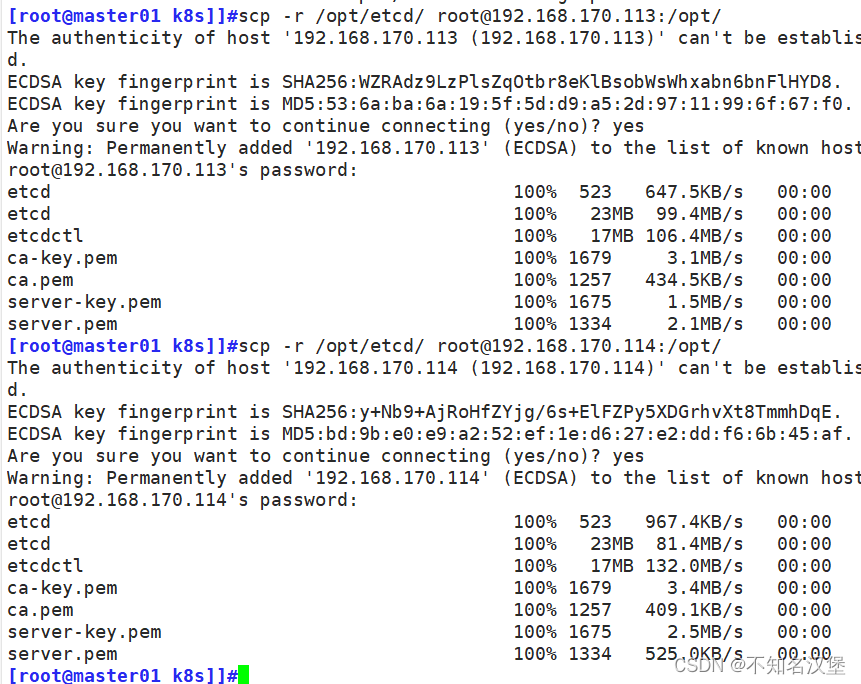

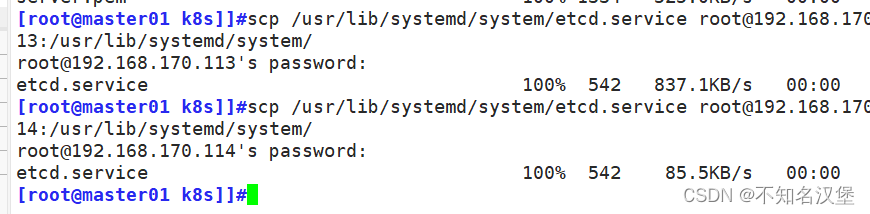

scp -r /opt/etcd/ root@192.168.170.113:/opt/

scp -r /opt/etcd/ root@192.168.170.114:/opt/

scp /usr/lib/systemd/system/etcd.service root@192.168.170.113:/usr/lib/systemd/system/

scp /usr/lib/systemd/system/etcd.service root@192.168.170.114:/usr/lib/systemd/system/

#把etcd相关证书文件、命令文件和服务管理文件全部拷贝到另外两个etcd集群节点

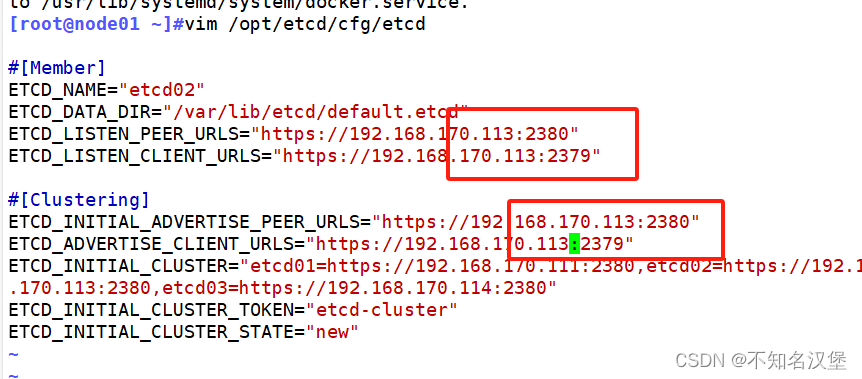

#node1节点执行

vim /opt/etcd/cfg/etcd

#修改scp过来的etcd配置文件

#[Member]

ETCD_NAME="etcd02" #修改为etcd02

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.170.113:2380" #修改为node1的ip地址

ETCD_LISTEN_CLIENT_URLS="https://192.168.170.113:2379" #修改为node1的ip地址

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.170.113:2380" #修改为node1的ip地址

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.170.113:2379" #修改为node1的ip地址

ETCD_INITIAL_CLUSTER="etcd01=https://192.168.170.111:2380,etcd02=https://192.168.170.113:2380,etcd03=https://192.168.170.114:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

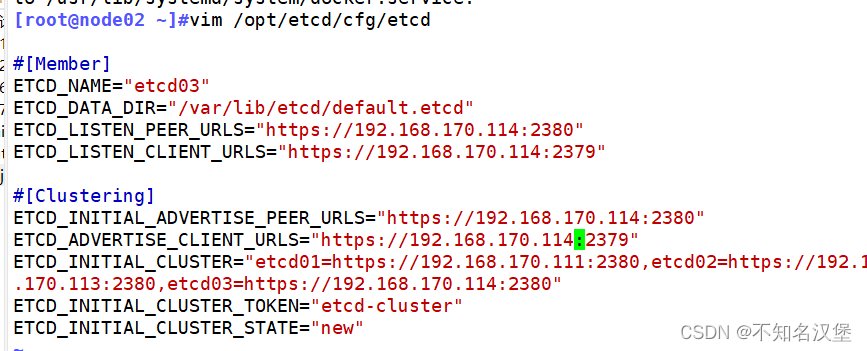

#node2节点执行

vim /opt/etcd/cfg/etcd

#修改scp过来的etcd配置文件

#[Member]

ETCD_NAME="etcd03" #修改为etcd03

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.170.114:2380" #修改为node1的ip地址

ETCD_LISTEN_CLIENT_URLS="https://192.168.170.114:2379" #修改为node1的ip地址

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.170.114:2380" #修改为node1的ip地址

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.170.114:2379" #修改为node1的ip地址

ETCD_INITIAL_CLUSTER="etcd01=https://192.168.170.111:2380,etcd02=https://192.168.170.113:2380,etcd03=https://192.168.170.114:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

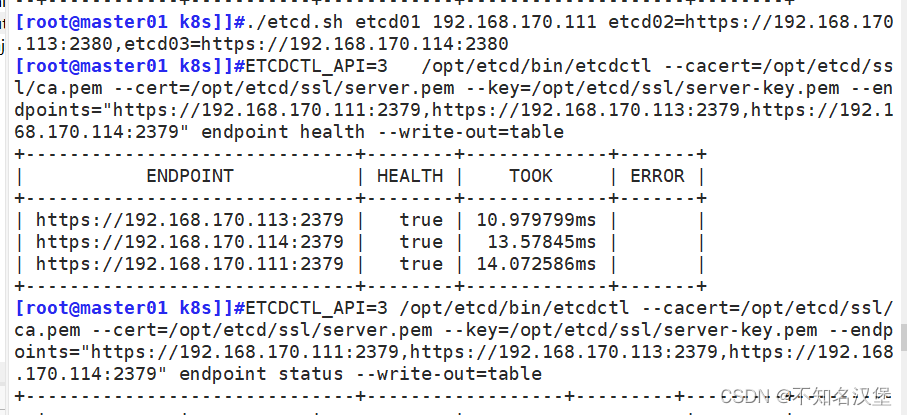

#master节点执行

cd /opt/k8s

./etcd.sh etcd01 192.168.170.111 etcd02=https://192.168.170.113:2380,etcd03=https://192.168.170.114:2380

#重新启动etcd集群

#node1 node2执行

systemctl enable --now etcd

#设置开机启动并立即启动etcd,然后回到master上查看是否成功。不是一直前台运行状态即成功

#master执行:

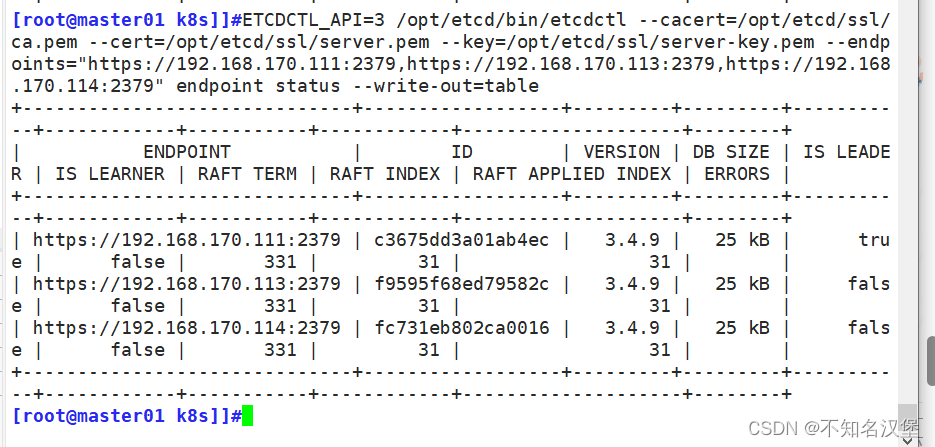

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.170.111:2379,https://192.168.170.113:2379,https://192.168.170.114:2379" endpoint health --write-out=table

#检查集群监控状态,health全部未true即可

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.170.111:2379,https://192.168.170.113:2379,https://192.168.170.114:2379" endpoint status --write-out=table

#检查集群状态,有一个is leader为true即可

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.m --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.170.114:2379" --write-out=table member list

##查看etcd集群成员列表4.1在master01节点操作

4.2生成etcd证书,上传etcd-cert.sh 和 etcd.sh 到 /opt/k8s/ 目录中

4.3创建用于生成CA证书,etcd服务器证书以及私钥的目录

4.4上传 etcd-v3.4.9-linux-amd64.tar.gz 到 /opt/k8s 目录中,启动etcd服务

4.5创建用于存放etcd配置文件,命令文件,证书的目录

注意:进入卡住状态等待其他节点加入,这里需要三台etcd服务同时启动,如果只启动其中一台后,服务会卡在那里,直到集群中所有etcd节点都已启动,可忽略这个情况

可以开启另外一个窗口来查看etcd进程是否正常

4.6把etcd相关证书文件、命令文件和服务管理文件全部拷贝到另外两个etcd集群节点

4.7在node1节点操作(node2同样)

4.8启动etcd,并检查etcd集群状态

5、master部署组件

//在 master01 节点上操作

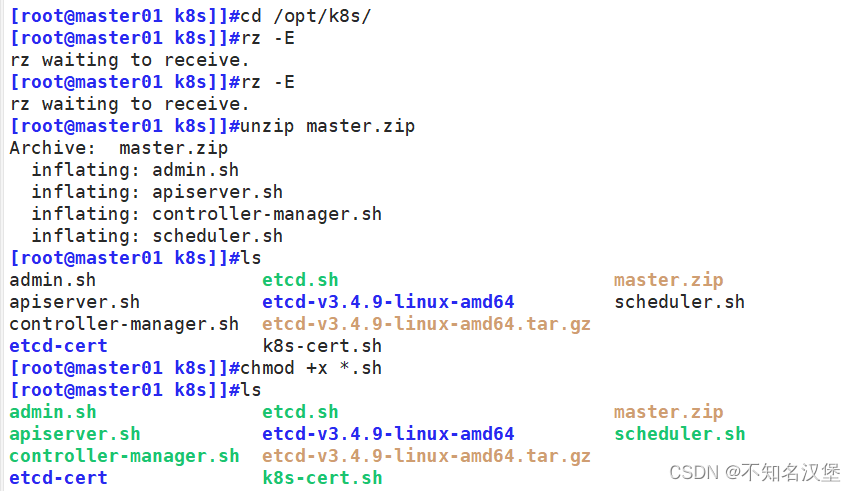

#上传 master.zip(master组件) 和 k8s-cert.sh(证书) 到 /opt/k8s 目录中,解压 master.zip 压缩包

cd /opt/k8s/

unzip master.zip

cd master

chmod +x *.sh

mv * /opt/k8s

#解压master组件包,里面有master的4个组件脚本,添加权限移动到/opt/k8s文件夹中

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

#创建kubernetes工作目录

mkdir /opt/k8s/k8s-cert

#创建k8s的证书存放路径

mv /opt/k8s/k8s-cert.sh /opt/k8s/k8s-cert

#将k8s证书移动到创建的k8s的证书存放路径

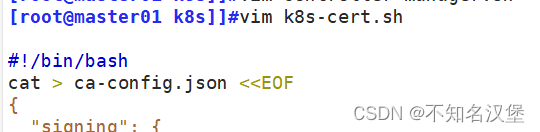

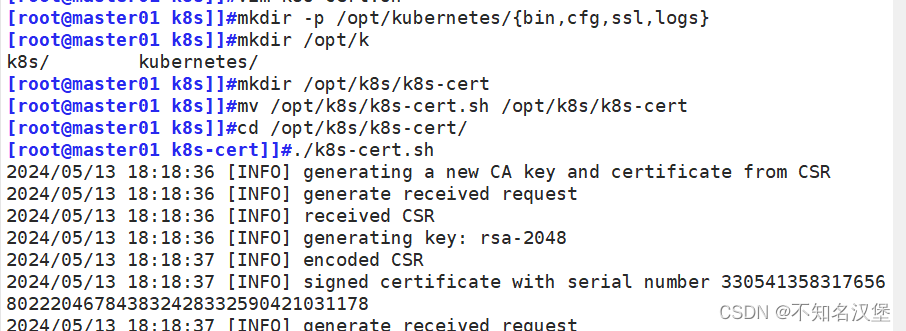

cd /opt/k8s/k8s-cert/

vim /opt/k8s/k8s-cert/k8s-cert.sh

#修改脚本中的ip56-60行顺序是第一个为master、第二个为master高可用ip、第三个为master虚拟ip、第四load balancer01(master)第五为load balancer01(backup)。第四第五可以删除。单节点master不用,若后面需要做集群需要提前规划好ip

chmod +x k8s-cert.sh

./k8s-cert.sh

#生成CA证书、相关组件的证书和私钥

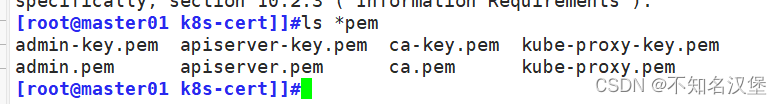

ls *pem

#显示生成的证书等一共8个.pem结尾

cp ca*pem apiserver*pem /opt/kubernetes/ssl/

#将ca证书和apiserver证书拷贝到创建的存放证书的ssl/目录下

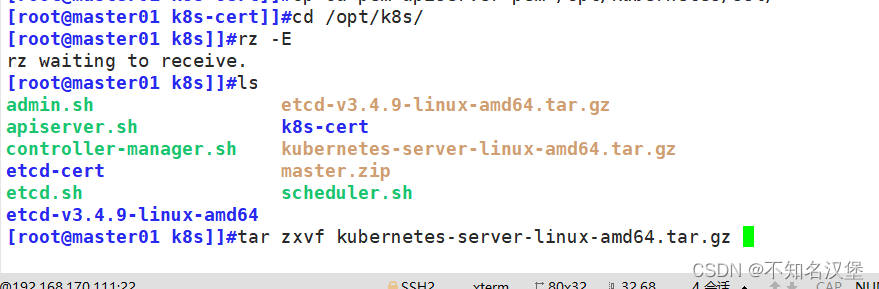

cd /opt/k8s/

tar zxvf kubernetes-server-linux-amd64.tar.gz

#上传 kubernetes-server-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,解压 kubernetes 压缩包

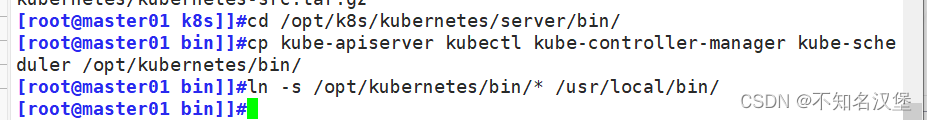

cd /opt/k8s/kubernetes/server/bin

#进入解压后的k8s的bin目录中将4个组件拷贝到创建的k8s存放bin文件的路径下

cp kube-apiserver kubectl kube-controller-manager kube-scheduler /opt/kubernetes/bin/

cp /opt/kubernetes/bin/* /usr/local/bin/

#将脚本程序存放到 /usr/local/bin下可以全局使用4个命令

cd /opt/k8s/

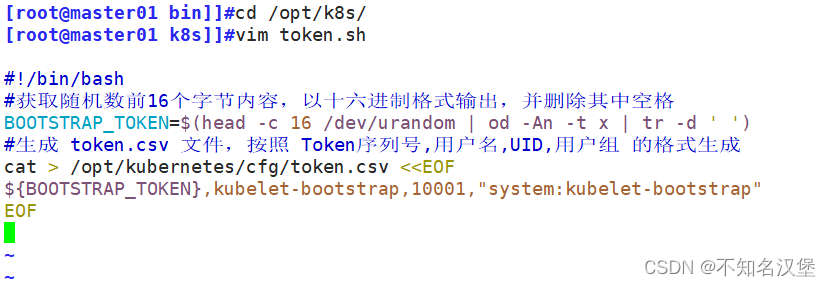

vim token.sh

[脚本内容]

#!/bin/bash

#获取随机数前16个字节内容,以十六进制格式输出,并删除其中空格

BOOTSTRAP_TOKEN=$(head -c 16 /dev/urandom | od -An -t x | tr -d ' ')

#生成 token.csv 文件,按照 Token序列号,用户名,UID,用户组 的格式生成

cat > /opt/kubernetes/cfg/token.csv <<EOF

${BOOTSTRAP_TOKEN},kubelet-bootstrap,10001,"system:kubelet-bootstrap"

EOF

#保存后退出

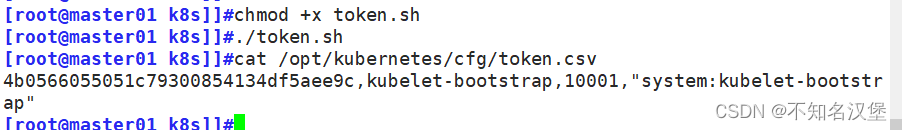

chmod +x token.sh

./token.sh

cat /opt/kubernetes/cfg/token.csv

#创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权,查看是否生成了csv文件

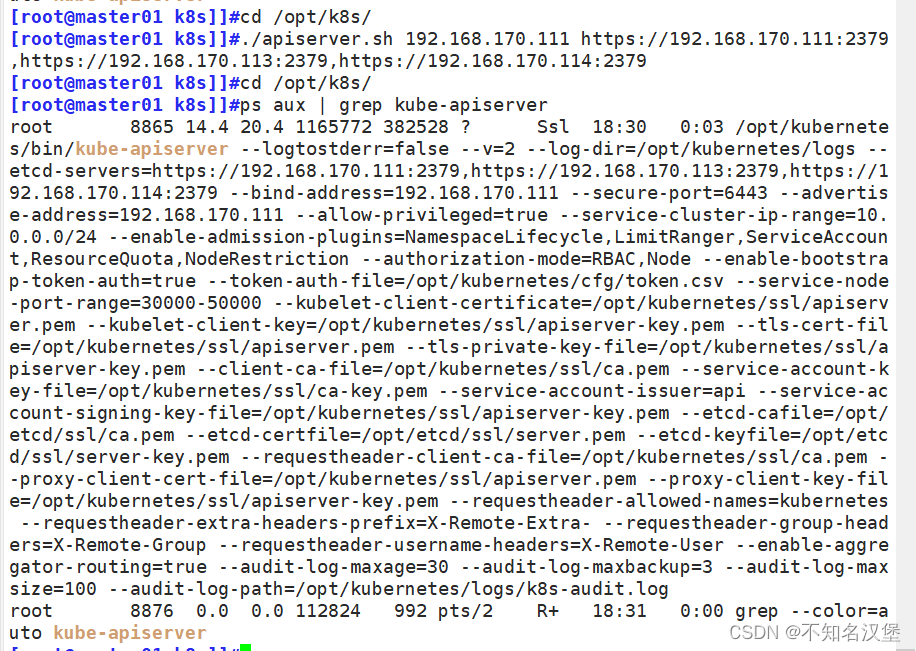

cd /opt/k8s/

./apiserver.sh 192.168.170.111 https://192.168.30.11:2379,https://192.168.170.113:2379,https://192.168.170.114:2379

#二进制文件、token、证书都准备好后,开启 apiserver 服务

ps aux | grep kube-apiserver

#检查进程是否启动成功,过滤kube-apiserver最上面一个后面会有-etcd-servers=https://192.168.170.111:2379,https://192.168.170.113:2379,https://192.168.170.114:2379 --bind-address=192.168.170.111 --secure-port=6443此信息为正常,注意ip要改为自己的ip地址

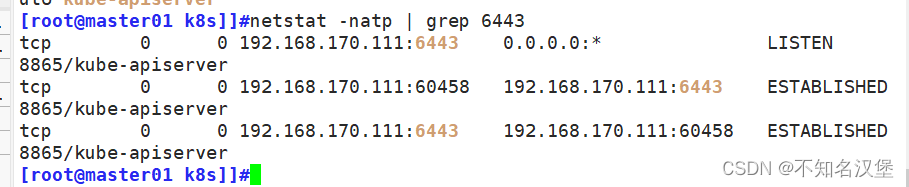

netstat -natp | grep 6443

#过滤端口只有监控本机ip的6443为正常

cd /opt/k8s/

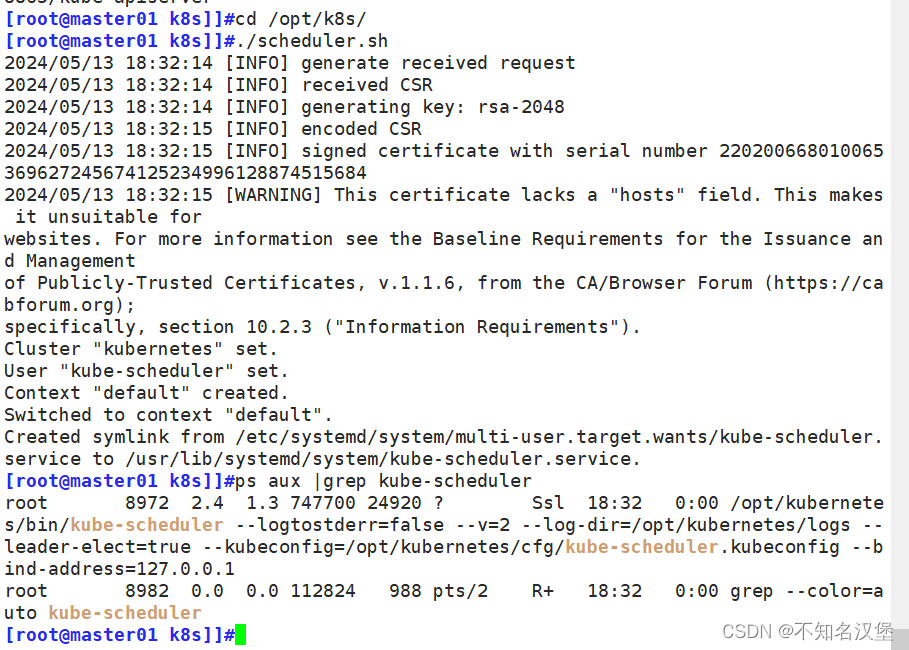

vim scheduler.sh

#修改脚本ip。KUBE_APISERVER="https://192.168.170.111:6443"为自己的apiserver的ip地址本文是master地址

./scheduler.sh

ps aux | grep kube-scheduler

#运行shceduler组件脚本,查看服务是否正常

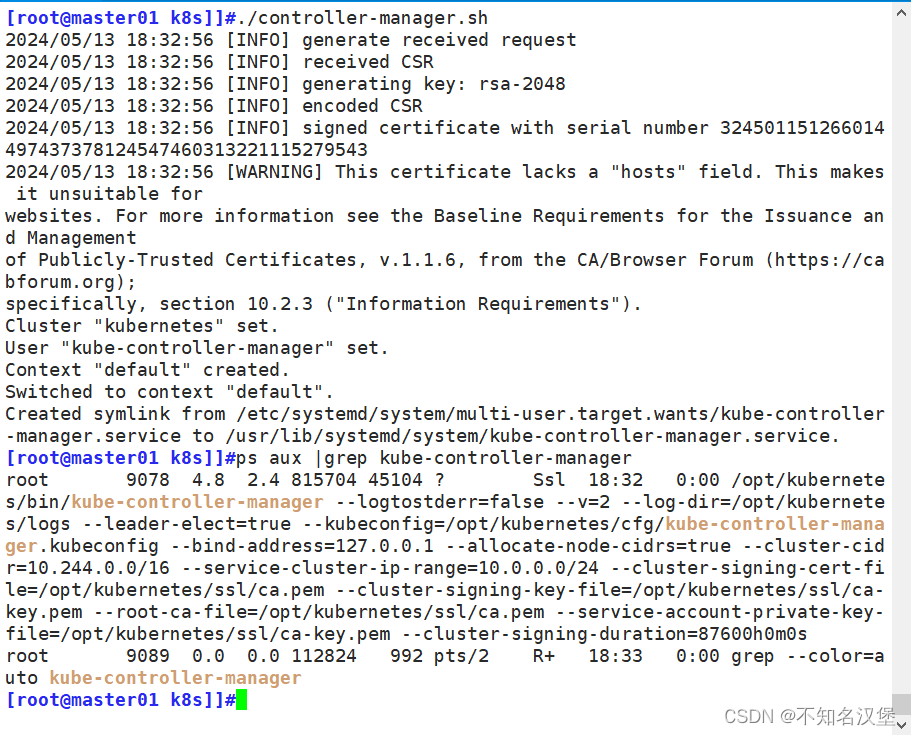

vim controller-manager.sh

#修改ipKUBE_APISERVER="https://192.168.170.111:6443"为自己的apiserver的ip地址本文是master地址

./controller-manager.sh

ps aux | grep kube-controller-manager

#运行controller-manager.sh组件脚本,查看服务是否正常

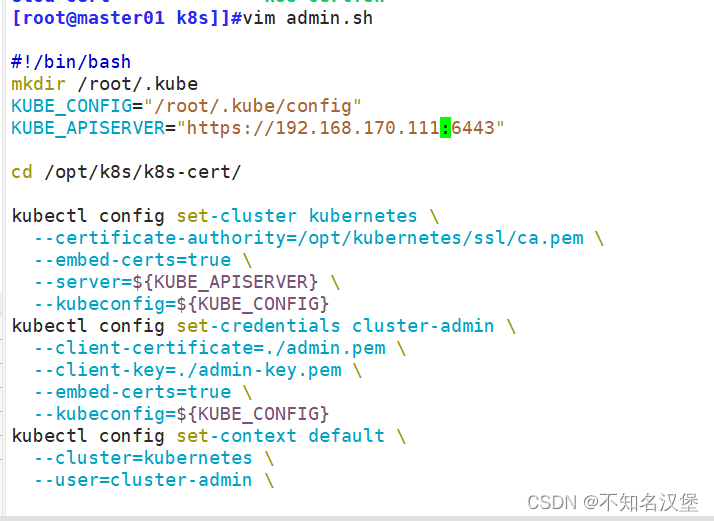

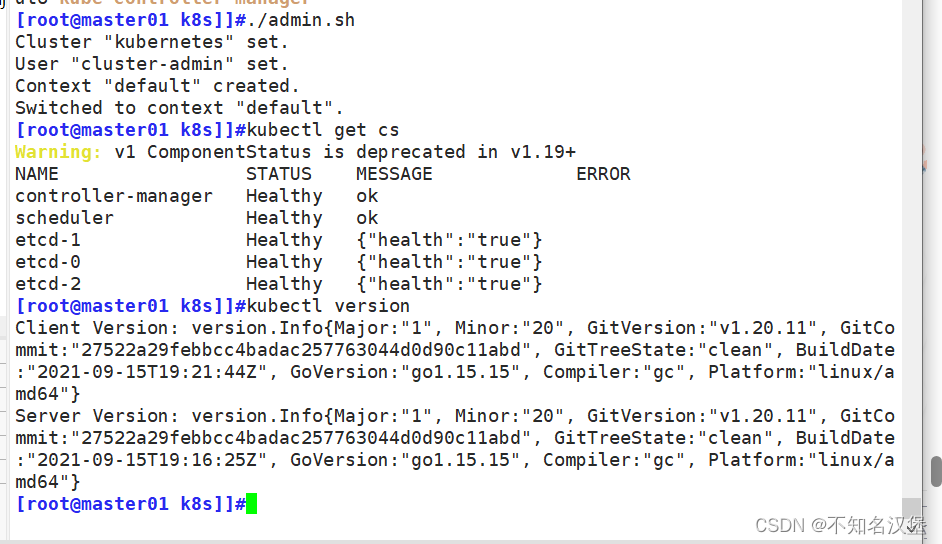

vim ./admin.sh

#修改ipKUBE_APISERVER="https://192.168.170.111:6443"为自己的apiserver的ip地址本文是master地址

./admin.sh

#生成kubectl连接集群的kubeconfig文件

kubectl get cs

#通过kubectl工具查看当前集群组件状态,正常状态如下

kubectl get cs

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-2 Healthy {"health":"true"}

etcd-1 Healthy {"health":"true"}

etcd-0 Healthy {"health":"true"}

kubectl version

#查看版本信息

![]()

上传 kubernetes-server-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,解压 kubernetes 压缩包

复制master组件的关键命令文件到 kubernetes工作目录的 bin 子目录中

创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权

二进制文件、token、证书都准备好后,开启 apiserver 服务

#启动 scheduler 服务

#启动 controller-manager 服务

#生成kubectl连接集群的kubeconfig文件

6、部署worker node组件

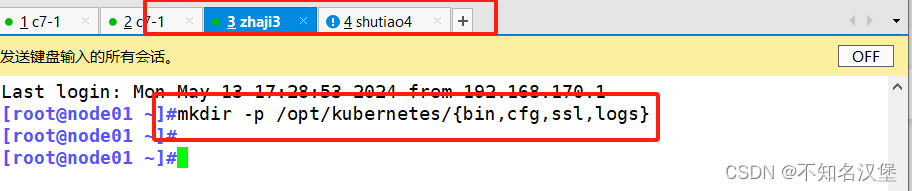

#node1执行

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

#创建kubernetes工作目录

cd /opt/

unzip node.zip

#上传 node.zip 到 /opt 目录中,解压 node.zip 压缩包,获得kubelet.sh、proxy.shchmod +x kubelet.sh proxy.sh

#master执行

cd /opt/k8s/kubernetes/server/bin

scp kubelet kube-proxy root@192.168.30.12:/opt/kubernetes/bin/

#把 kubelet、kube-proxy 节点的组件拷贝到 node1 节点

mkdir /opt/k8s/kubeconfig

cd /opt/k8s/kubeconfig

chmod +x kubeconfig.sh

vim kubeconfig.sh

./kubeconfig.sh 192.168.170.111 /opt/k8s/k8s-cert/

#上传kubeconfig.sh文件到/opt/k8s/kubeconfig目录中,生成kubelet初次加入集群引导kubeconfig文件和kube-proxy.kubeconfig文件

scp bootstrap.kubeconfig kube-proxy.kubeconfig root@192.168.170.113:/opt/kubernetes/cfg/

#把配置文件 bootstrap.kubeconfig、kube-proxy.kubeconfig 2个授权文件拷贝到 node1 节点

kubectl create clusterrolebinding kubelet-bootstrap --clusterrole=system:node-bootstrapper --user=kubelet-bootstrap

#RBAC授权,使用户 kubelet-bootstrap 能够有权限发起 CSR 请求证书

kubectl create clusterrolebinding cluster-system-anonymous --clusterrole=cluster-admin --user=system:anonymous

#若执行失败,可先给kubectl绑定默认cluster-admin管理员集群角色,授权集群操作权限

##node1节点执行

cd /opt/

./kubelet.sh 192.168.170.113

ps aux | grep kubelet

#node1节点执行kubelet安装脚步,注意要写node1节点的ip地址,查看kubelet服务是否正常运行

#在 master01 节点上操作,通过 CSR 请求

kubectl get csr

#可以查看有谁发起请求Pending 表示等待集群给该节点签发证书,查看的内容如下

NAME AGE SIGNERNAME REQUESTOR CONDITION

node-csr-saZodXI7_rtwU6VJGMB1UKPx8sHUsAonx4l1BKJRXOo 53m kubernetes.io/kube-apiserver-client-kubelet kubelet-bootstrap Pendingkubectl certificate approve node-csr-saZodXI7_rtwU6VJGMB1UKPx8sHUsAonx4l1BKJRXOo

#执行命令授权csr请求并签发证书

kubectl get csr

#再次查看请求的csr状态Approved,Issued 表示已授权 CSR 请求并签发证书

kubectl get node

#查看节点,状态为NotReady 由于网络插件还没部署

NAME STATUS ROLES AGE VERSION

192.168.170.113 NotReady <none> 108s v1.20.116.1在所有 node 节点上操作创建kubernetes工作目录

6.2上传 node.zip 到 /opt 目录中,解压 node.zip 压缩包,获得kubelet.sh、prox

6.3在master01节点上操作把 kubelet、kube-proxy 拷贝到 node 节点

6.4上传kubeconfig.sh文件到/opt/k8s/kubeconfig目录中,生成kubelet初次加入集群引导kubeconfig文件和kube-proxy.kubeconfig文件

#kubeconfig 文件包含集群参数(CA 证书、API Server 地址),客户端参数(上面生成的证书和私钥),集群 context 上下文参数(集群名称、用户名)。Kubenetes 组件(如 kubelet、kube-proxy)通过启动时指定不同的 kubeconfig 文件可以切换到不同的集群,连接到 apiserver。

6.5把配置文件 bootstrap.kubeconfig、kube-proxy.kubeconfig 拷贝到 node 节点

6.6RBAC授权,使用户 kubelet-bootstrap 能够有权限发起 CSR 请求证书

7、在node01节点上操作

7.1启动kubelet

7.2在 master01 节点上操作,通过 CSR 请求检查到 node01 节点的 kubelet 发起的 CSR 请求,Pending 表示等待集群给该节点签发证书

7.3通过 CSR 请求

7.4查看节点,由于网络插件还没有部署,节点会没有准备就绪 NotReady

7.5在 node01 节点上操作加载 ip_vs 模块 启动proxy服务

相关文章:

K8s:二进制安装k8s(单台master)

目录 一、安装k8s 1、拓扑图 2、系统初始化配置 2.1关闭防火墙selinx以及swap 2.2设置主机名 2.3在每台主机中添加hosts,做映射 2.4调整内核参数,将桥接的ipv4流量传递到iptables,关闭ipv6 2.4时间同步 3、部署docker引擎࿰…...

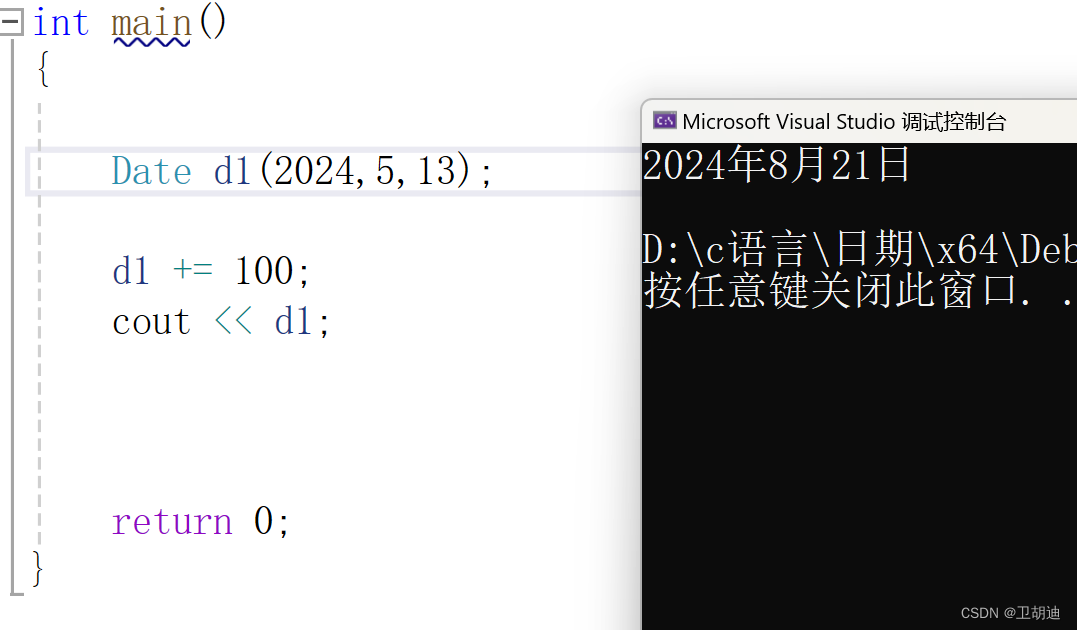

C++类和对象下——实现日期类

前言 在学习了类和对象的六大成员函数后,为了巩固我们学习的知识可以手写一个日期类来帮助我们理解类和对象,加深对于其的了解。 默认函数 构造函数 既然是写类和对象,我们首先就要定义一个类,然后根据实际需要来加入类的数据与函…...

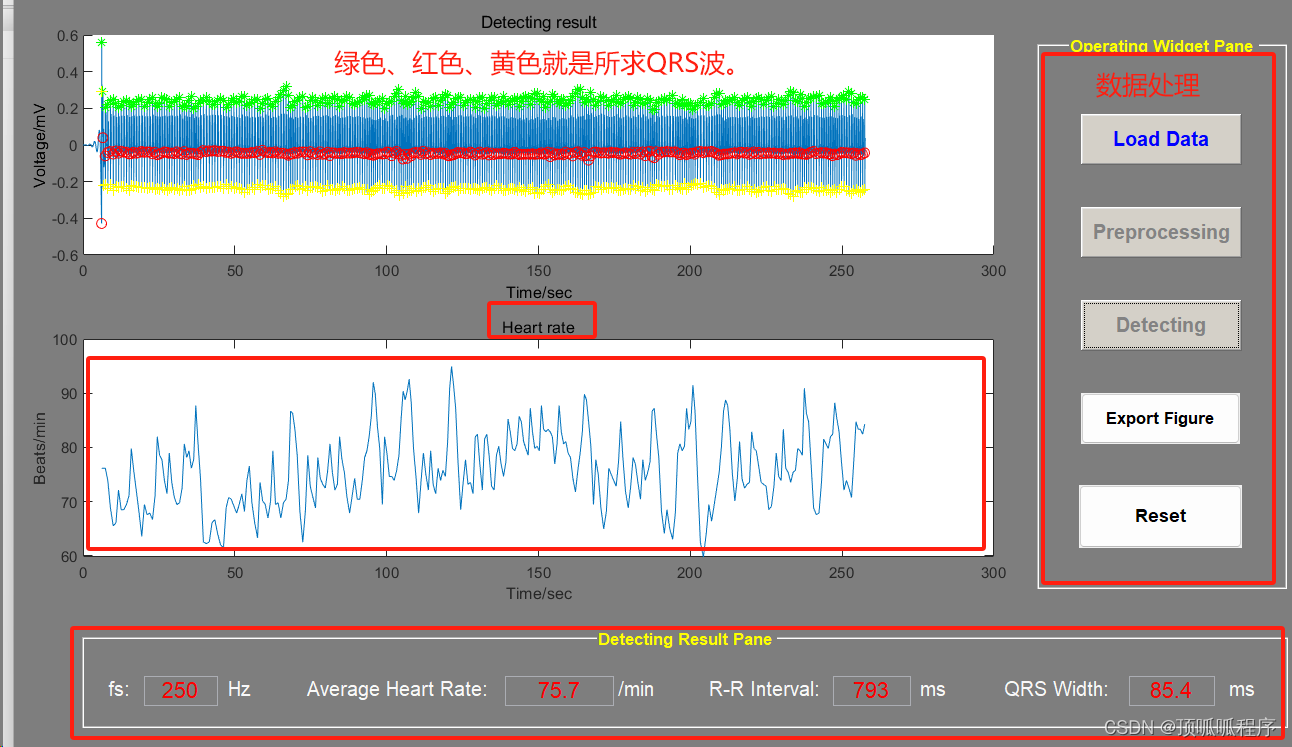

252 基于MATLAB的自适应差分阈值法检测心电信号的QRS波

基于MATLAB的自适应差分阈值法检测心电信号的QRS波,QRS波群反映左、右心室除极电位和时间的变化,第一个向下的波为Q波,向上的波为R波,接着向下的波是S波。通过GUI进行数据处理,展示心率和QRS。程序已调通,可…...

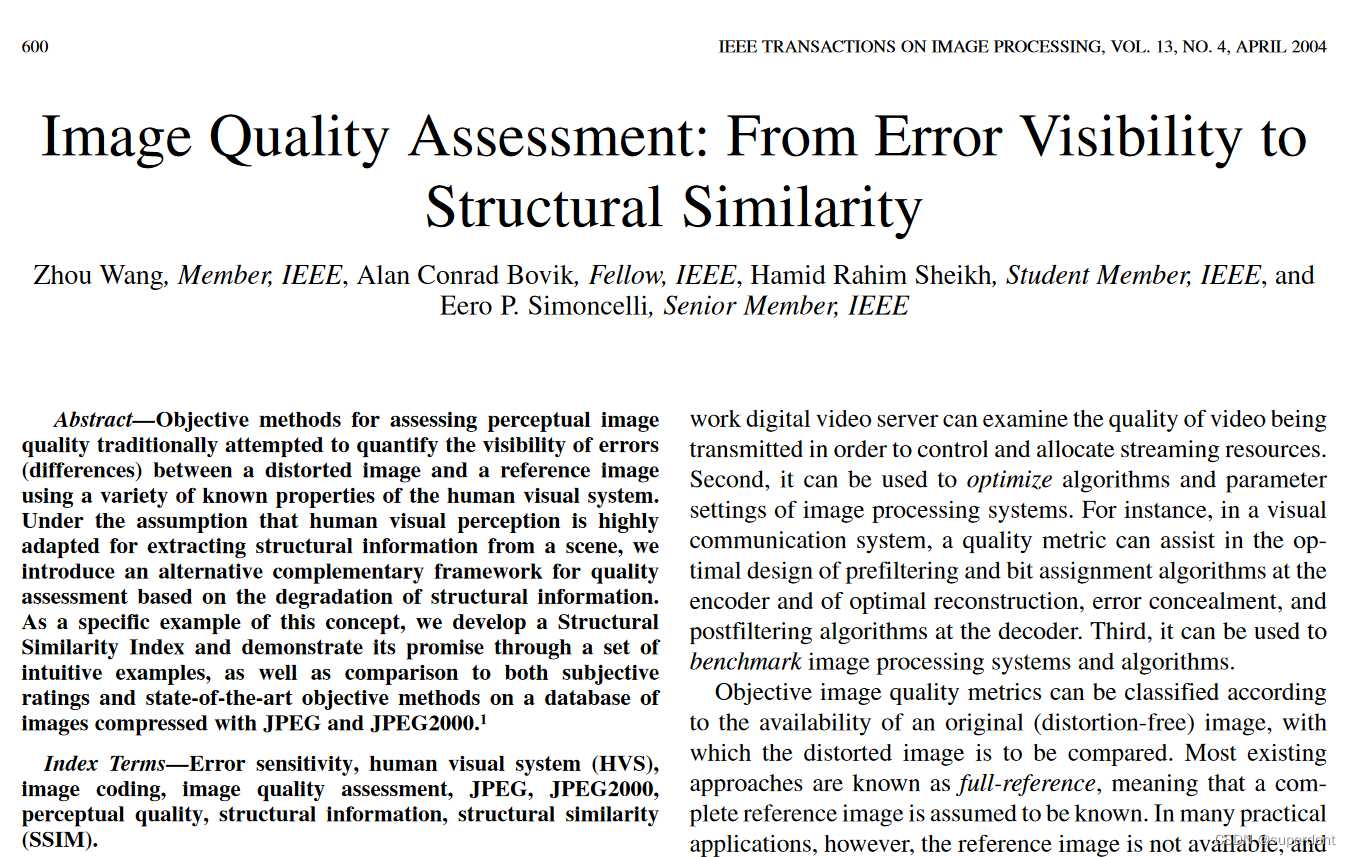

SSIM(Structural Similarity),结构相似性及MATLAB实现

参考文献 Wang, Zhou; Bovik, A.C.; Sheikh, H.R.; Simoncelli, E.P. (2004-04-01). “Image quality assessment: from error visibility to structural similarity”. IEEE Transactions on Image Processing. 13 (4): 600–612. Bibcode:2004ITIP…13…600W. CiteSeerX 10.…...

)

第十六章-消费者-PUSH方式(一)

16.1 准备阶段 先从一段官方示例代码开始 public class Consumer {public static void main(String[] args) throws InterruptedException, MQClientException {// 初始化consumer,并设置consumer group nameDefaultMQPushConsumer consumer new DefaultMQPushCo…...

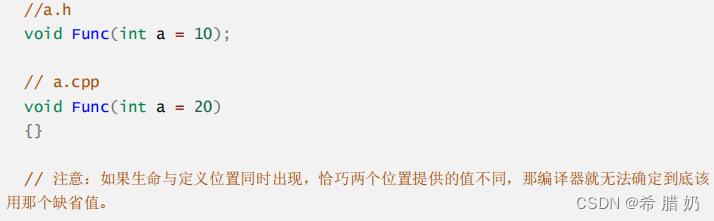

【C++要哮着学】初识C++,什么是C++?什么是命名空间?什么又是缺省函数?

文章目录 前言1、C简介1.1、什么是C1.2、C起源1.3、C发展 2、C关键字(C98)3、命名空间3.1、命名空间的定义及使用3.2、命名空间的嵌套3.3、命名空间的三种使用方式3.3.1、加命名空间名称及作用域限定符3.3.2、使用using将命名空间中某个成员引入3.3.3、使…...

Lua 数字格式化

在编程中,对数字进行格式化是一项常见的任务,特别是当我们需要在用户界面中显示数据或生成报告时。在 Lua 中,我们可以使用一些简单而有效的函数来实现数字的格式化。在本文中,我们将介绍一个由几个函数组成的小型 Lua 库…...

Java入门基础学习笔记13——数据类型

数据类型的分类: 基本数据类型 引用数据类型 基本数据类型:4大类8种类型: 定义整形用int,再大的数用long。 package cn.ensource.variable;public class VariableDemo2 {public static void main(String[] args) {//目标&#x…...

使用Docker+Jar方式部署微服务工程(前后端分离)看着一篇就够了

本篇教程的使用到的技术有springboot、springcloud、Nacos、Docker、Nginx部署前后端分离访问的微服务。 部署一下Nacos 首先我们需要在服务器中(或者本地部署启动一下Nacos),这里我采用服务器的方式进行部署,这里有一点不一样的…...

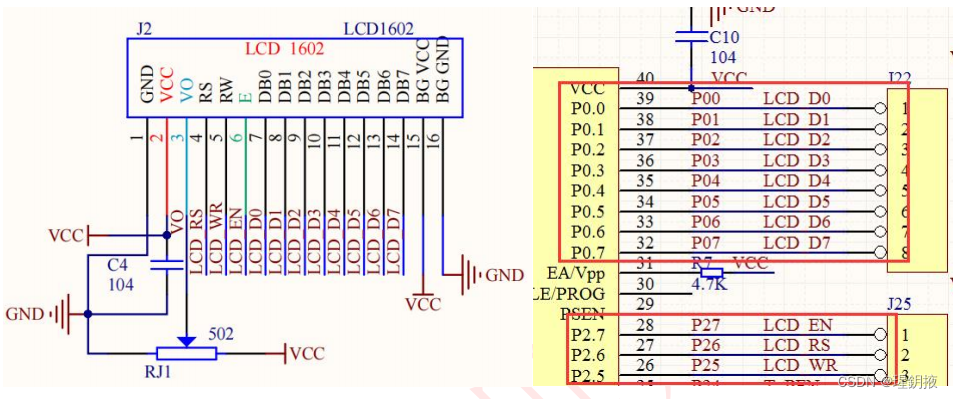

红外遥控和LCD1602

26.1.1 红外线简介 人的眼睛能看到的可见光按波长从长到短排列,依次为红、橙、黄、绿、青、蓝、紫。其中红光的波长范围为 0.62~0.76μm;紫光的波长范围为 0.38~0.46μm。比紫光波长还短的光叫紫外线,比红光波长还长的…...

房屋出租管理系统需求分析及功能介绍

房屋租赁管理系统适用于写字楼、办公楼、厂区、园区、商城、公寓等商办商业不动产的租赁管理及租赁营销;提供资产管理,合同管理,租赁管理, 物业管理,门禁管理等一体化的运营管理平台,提高项目方管理运营效率…...

高精度模拟算法

高精度模拟算法 高精度加法 extern string m,n; extern int a[MAX],b[MAX],ans[MAX]; void addition(){int _mmax(m.size(),n.size());reverse(m.begin(),m.end()),reverse(n.begin(),n.end());//转置原字符串for(int i0;i<m.size();i) a[i]m[i]-0;//字符型以ASCII码存储&…...

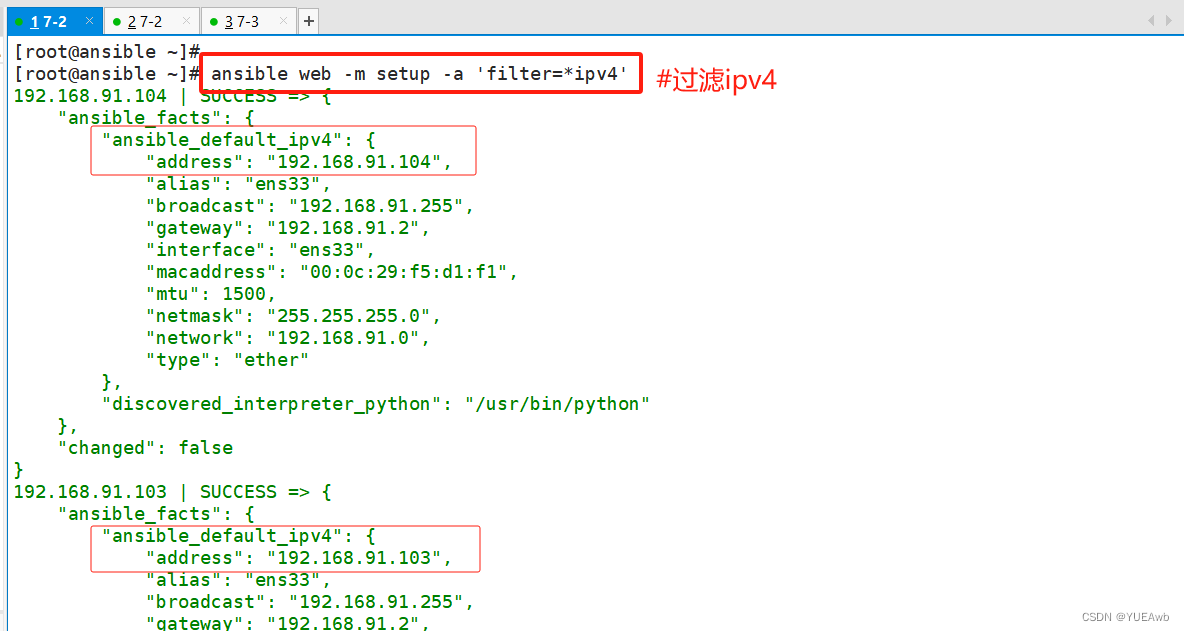

Ansible简介版

目录 架构 环境部署 一、Ansible安装部署 1.yum安装Ansible 2.修改主机清单文件 3.配置密钥对验证 4.ansible-doc 5.看被控主机 二、常用模块 1.Command模块 2.Shell模块 3.Cron模块 1.添加 2.删除 4.User模块 5.Group模块 1.创建组 编辑 编辑 编辑…...

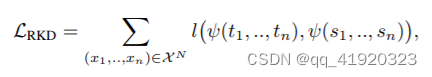

卷积通用模型的剪枝、蒸馏---蒸馏篇--RKD关系蒸馏(以deeplabv3+为例)

本文使用RKD实现对deeplabv3+模型的蒸馏;与上一篇KD蒸馏的方法有所不同,RKD是对展平层的特征做蒸馏,蒸馏的loss分为二阶的距离损失Distance-wise Loss和三阶的角度损失Angle-wise Loss。 完整代码放在文末。 一、RKD简介 RKD算法的核心是以教师模型的多个输出为结构单元,取…...

AVL树的完全指南:平衡与性能

文章目录 AVL树简介AVL的操作建立一个AVL树插入操作删除操作 书写代码1.构造函数和析构函数2.获取最大值和最小值3.树的高度和节点个数3.前序中序和后序遍历4.判断树是否为空树5.四个旋转操作6.获取平衡因子7.插入操作8.删除操作9.搜索节点.h文件中的定义 总结 AVL树简介 AVL树…...

itext7 PDF添加水印,获取页面高度,添加到页面右上角

ps: pdf添加水印,内容多的时候会往下跑,修改为获取当前页面高度,进行固定在顶部,其他需要可以自己进行调整,直接贴代码。 public static void main(String[] args) throws IOException {String localFilePath "…...

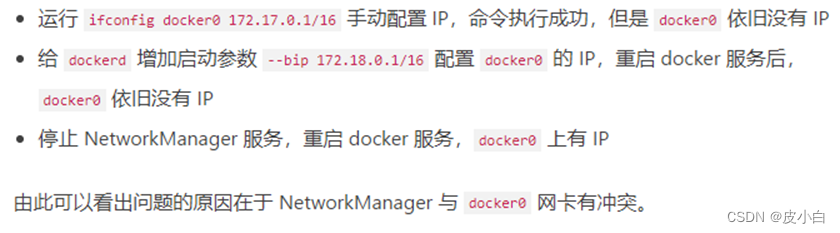

docker端口映射成功,docker端口不生效的问题解决,外界无法访问docker映射端口

docker端口映射不生效的问题解决 问题 使用docker run -p 88848:8848后,显示容器启动正常,并且使用docker logs –f xxx能够看到容器可以正常启用,docker ps 可以看到容器启动成功,并且端口已经映射,但是在浏览器访问相关地址&am…...

RSA非对称加密解密,前端公钥加密后端私钥解密

RSA非对称加密解密,前端公钥加密后端私钥解密,可以防止陌生人直接通过后端接口篡改数据。有数据泄露的风险。 前端:Vue框架 后端:sprintboot(Java) 工具类:hutool 前端Vue获取公钥:…...

Nginx-01-Nginx 是什么? 能做什么?

nginx 系列 Nginx-01-聊一聊 nginx Nginx-01-Nginx 是什么 Nginx-02-为什么使用 Nginx Nginx-02-Nginx Ubuntu 安装 windows10 WSL ubuntu 安装 nginx 实战笔记 Nginx-02-基本使用 Nginx-03-Nginx 项目架构 Nginx-04-Docker Nginx Nginx-05-nginx 反向代理是什么&…...

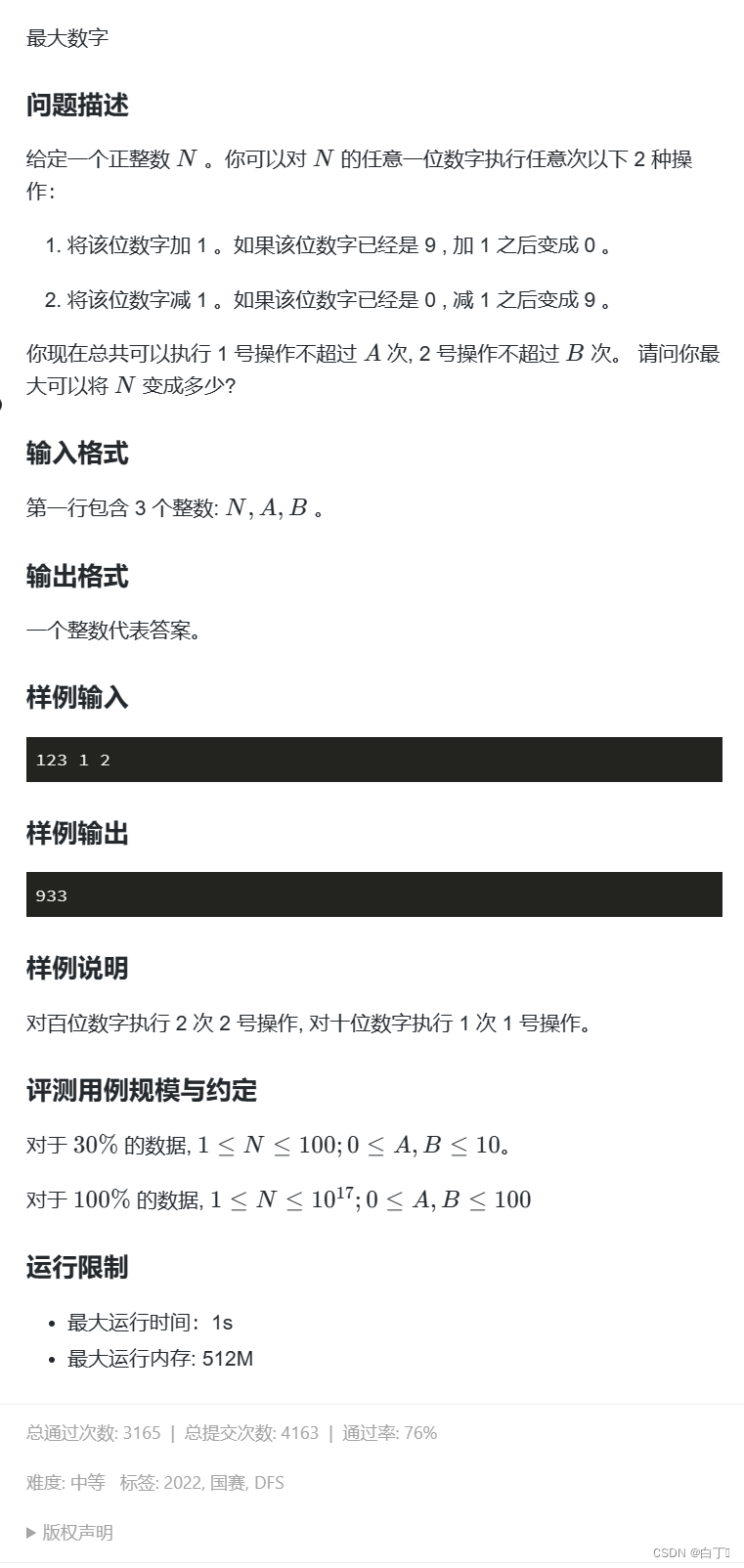

最大数字——蓝桥杯十三届2022国赛大学B组真题

问题分析 这道题属于贪心加回溯。所有操作如果能使得高位的数字变大必定优先用在高位,因为对高位的影响永远大于对低位的影响。然后我们再来分析一下,如何使用这两种操作?对于加操作,如果能使这一位的数字加到9则变成9࿰…...

智慧医疗能源事业线深度画像分析(上)

引言 医疗行业作为现代社会的关键基础设施,其能源消耗与环境影响正日益受到关注。随着全球"双碳"目标的推进和可持续发展理念的深入,智慧医疗能源事业线应运而生,致力于通过创新技术与管理方案,重构医疗领域的能源使用模式。这一事业线融合了能源管理、可持续发…...

23-Oracle 23 ai 区块链表(Blockchain Table)

小伙伴有没有在金融强合规的领域中遇见,必须要保持数据不可变,管理员都无法修改和留痕的要求。比如医疗的电子病历中,影像检查检验结果不可篡改行的,药品追溯过程中数据只可插入无法删除的特性需求;登录日志、修改日志…...

【HTTP三个基础问题】

面试官您好!HTTP是超文本传输协议,是互联网上客户端和服务器之间传输超文本数据(比如文字、图片、音频、视频等)的核心协议,当前互联网应用最广泛的版本是HTTP1.1,它基于经典的C/S模型,也就是客…...

深度学习习题2

1.如果增加神经网络的宽度,精确度会增加到一个特定阈值后,便开始降低。造成这一现象的可能原因是什么? A、即使增加卷积核的数量,只有少部分的核会被用作预测 B、当卷积核数量增加时,神经网络的预测能力会降低 C、当卷…...

在QWebEngineView上实现鼠标、触摸等事件捕获的解决方案

这个问题我看其他博主也写了,要么要会员、要么写的乱七八糟。这里我整理一下,把问题说清楚并且给出代码,拿去用就行,照着葫芦画瓢。 问题 在继承QWebEngineView后,重写mousePressEvent或event函数无法捕获鼠标按下事…...

的使用)

Go 并发编程基础:通道(Channel)的使用

在 Go 中,Channel 是 Goroutine 之间通信的核心机制。它提供了一个线程安全的通信方式,用于在多个 Goroutine 之间传递数据,从而实现高效的并发编程。 本章将介绍 Channel 的基本概念、用法、缓冲、关闭机制以及 select 的使用。 一、Channel…...

git: early EOF

macOS报错: Initialized empty Git repository in /usr/local/Homebrew/Library/Taps/homebrew/homebrew-core/.git/ remote: Enumerating objects: 2691797, done. remote: Counting objects: 100% (1760/1760), done. remote: Compressing objects: 100% (636/636…...

小木的算法日记-多叉树的递归/层序遍历

🌲 从二叉树到森林:一文彻底搞懂多叉树遍历的艺术 🚀 引言 你好,未来的算法大神! 在数据结构的世界里,“树”无疑是最核心、最迷人的概念之一。我们中的大多数人都是从 二叉树 开始入门的,它…...

【Kafka】Kafka从入门到实战:构建高吞吐量分布式消息系统

Kafka从入门到实战:构建高吞吐量分布式消息系统 一、Kafka概述 Apache Kafka是一个分布式流处理平台,最初由LinkedIn开发,后成为Apache顶级项目。它被设计用于高吞吐量、低延迟的消息处理,能够处理来自多个生产者的海量数据,并将这些数据实时传递给消费者。 Kafka核心特…...

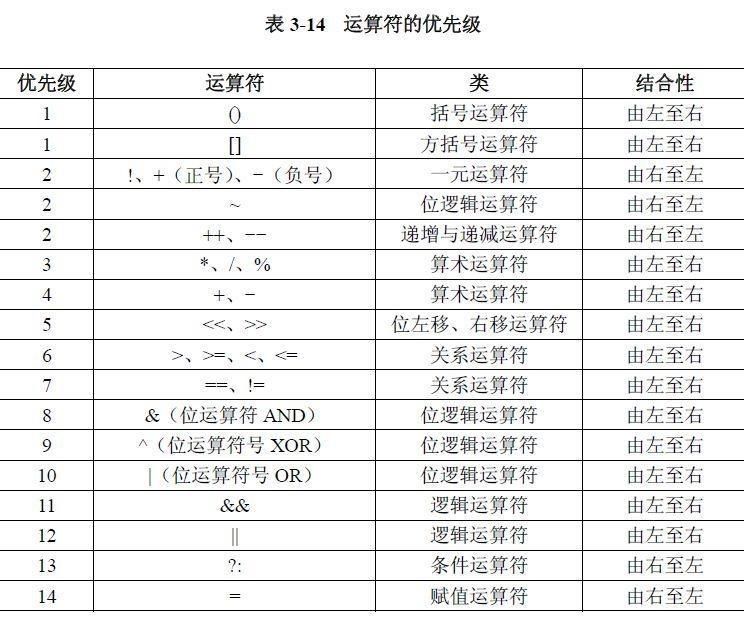

02.运算符

目录 什么是运算符 算术运算符 1.基本四则运算符 2.增量运算符 3.自增/自减运算符 关系运算符 逻辑运算符 &&:逻辑与 ||:逻辑或 !:逻辑非 短路求值 位运算符 按位与&: 按位或 | 按位取反~ …...