apache大数据各组件部署搭建(超级详细)

apache大数据数仓各组件部署搭建

第一章 环境准备

1. 机器规划

准备3台服务器用于集群部署,系统建议CentOS7+,2核8G内存

172.19.195.228 hadoop101

172.19.195.229 hadoop102

172.19.195.230 hadoop103

[root@hadoop101 ~]# cat /etc/redhat-release

CentOS Linux release 7.5.1804 (Core)

[root@hadoop101 ~]# hostname

hadoop101

2. 安装包下载准备

数仓部署组件安装包:

链接:https://pan.baidu.com/s/1Wjx6TNkedMTmmnuWREW-OQ

提取码:bpk0

已经把相关组件均上传至网盘,也可自行去各自官方地址去下载收集;

3. 配置服务器hosts

3台机器的/etc/hosts主机名解析配置:

# hadoop101

[root@hadoop101 ~]# cat /etc/hosts

127.0.0.1 localhost localhost

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

# hadoop集群

172.19.195.228 hadoop101

172.19.195.229 hadoop102

172.19.195.230 hadoop103# hadoop102

[root@hadoop102 ~]# cat /etc/hosts

127.0.0.1 localhost localhost

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

# hadoop集群

172.19.195.228 hadoop101

172.19.195.229 hadoop102

172.19.195.230 hadoop103# hadoop103

[root@hadoop103 ~]# cat /etc/hosts

127.0.0.1 localhost localhost

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

# hadoop集群

172.19.195.228 hadoop101

172.19.195.229 hadoop102

172.19.195.230 hadoop103

4. 配置服务器之间免密登录

# 创建密钥

[root@hadoop101 ~]# ssh-keygen -t rsa

Generating public/private rsa key pair.

Enter file in which to save the key (/root/.ssh/id_rsa):

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /root/.ssh/id_rsa.

Your public key has been saved in /root/.ssh/id_rsa.pub.

The key fingerprint is:

SHA256:pgAtkJ9Tmf8sqBYOkK2gr/d7woIPXDguOiHRxRHDVH4 root@hadoop101

The key's randomart image is:

+---[RSA 2048]----+

|.. +=*. |

|.. .Bo |

| =o+... E |

|= Bo .. |

|+= o.. oS |

|O + ...oo |

|+O + .. |

|=.B o . |

|o*.oo+ |

+----[SHA256]-----+# 分发密钥

[root@hadoop101 ~]# ssh-copy-id hadoop101

Are you sure you want to continue connecting (yes/no)? yes

root@hadoop101's password:

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'hadoop101'"

and check to make sure that only the key(s) you wanted were added.[root@hadoop101 ~]# ssh-copy-id hadoop102

Are you sure you want to continue connecting (yes/no)? yes

root@hadoop102's password:

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'hadoop102'"

and check to make sure that only the key(s) you wanted were added.[root@hadoop101 ~]# ssh-copy-id hadoop103

Are you sure you want to continue connecting (yes/no)? yes

root@hadoop103's password:

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'hadoop103'"

and check to make sure that only the key(s) you wanted were added.# hadoop102和hadoop103操作相同

[root@hadoop102 ~]# ssh-keygen -t rsa

[root@hadoop102 ~]# ssh-copy-id hadoop101

[root@hadoop102 ~]# ssh-copy-id hadoop102

[root@hadoop102 ~]# ssh-copy-id hadoop103[root@hadoop103 ~]# ssh-keygen -t rsa

[root@hadoop103 ~]# ssh-copy-id hadoop101

[root@hadoop103 ~]# ssh-copy-id hadoop102

[root@hadoop103 ~]# ssh-copy-id hadoop103# 验证

[root@hadoop101 ~]# for i in hadoop101 hadoop102 hadoop103;do ssh $i hostname;done

hadoop101

hadoop102

hadoop103

5. 创建安装包和应用目录

[root@hadoop101 ~]# for i in hadoop101 hadoop102 hadoop103;do ssh $i mkdir /opt/{software,module};done

6. 上传安装包至服务器

# 上传所有安装包至hadoop101 /opt/software目录

[root@hadoop101 ~]# cd /opt/software/

[root@hadoop101 software]# ll

total 1489048

-rw-r--r-- 1 root root 278813748 Aug 26 15:13 apache-hive-3.1.2-bin.tar.gz

-rw-r--r-- 1 root root 9136463 Aug 26 15:13 apache-maven-3.6.1-bin.tar.gz

-rw-r--r-- 1 root root 9311744 Aug 26 15:13 apache-zookeeper-3.5.7-bin.tar.gz

-rw-r--r-- 1 root root 338075860 Aug 26 15:14 hadoop-3.1.3.tar.gz

-rw-r--r-- 1 root root 314030393 Aug 26 15:14 hue.tar

-rw-r--r-- 1 root root 194990602 Aug 26 15:15 jdk-8u211-linux-x64.tar.gz

-rw-r--r-- 1 root root 70057083 Aug 26 15:14 kafka_2.11-2.4.0.tgz

-rw-r--r-- 1 root root 77807942 Aug 26 15:15 mysql-libs.zip

-rw-r--r-- 1 root root 232530699 Aug 26 15:15 spark-2.4.5-bin-hadoop2.7.tgz

7. 各服务器关闭防火墙

# 防火墙关闭

[root@hadoop101 software]# systemctl stop firewalld.service

[root@hadoop101 software]# systemctl disable firewalld.service[root@hadoop102 ~]# systemctl stop firewalld.service

[root@hadoop102 ~]# systemctl disable firewalld.service[root@hadoop103 ~]# systemctl stop firewalld.service

[root@hadoop103 ~]# systemctl disable firewalld.service

8. 本地Windows电脑配置hosts( 可选 )

【注意】如果不配置则涉及URL访问时,浏览器访问时需要使用各服务器ip地址

C:\Windows\System32\drivers\etc\hosts

# hadoop集群

139.224.229.107 hadoop101

139.224.66.13 hadoop102

139.224.228.144 hadoop103

9. 安装java ( jdk1.8 )

# 解压包

[root@hadoop101 software]# tar -xf jdk-8u211-linux-x64.tar.gz -C /opt/module/

[root@hadoop101 software]# ls /opt/module/

jdk1.8.0_211# 增加环境变量配置

[root@hadoop101 software]# vim /etc/profile

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_211

export PATH=$PATH:$JAVA_HOME/bin# 分发jdk目录至hadoop102、hadoop103

[root@hadoop101 software]# scp -r /opt/module/jdk1.8.0_211 hadoop102:/opt/module/

[root@hadoop101 software]# scp -r /opt/module/jdk1.8.0_211 hadoop103:/opt/module/# 分发环境变量配置至hadoop102、hadoop103

[root@hadoop101 software]# scp /etc/profile hadoop102:/etc/

[root@hadoop101 software]# scp /etc/profile hadoop103:/etc/# source应用环境变量hadoop101、hadoop102、hadoop103

[root@hadoop101 software]# source /etc/profile && java -version

java version "1.8.0_211"

Java(TM) SE Runtime Environment (build 1.8.0_211-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.211-b12, mixed mode)[root@hadoop102 ~]# source /etc/profile && java -version

java version "1.8.0_211"

Java(TM) SE Runtime Environment (build 1.8.0_211-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.211-b12, mixed mode)[root@hadoop103 ~]# source /etc/profile && java -version

java version "1.8.0_211"

Java(TM) SE Runtime Environment (build 1.8.0_211-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.211-b12, mixed mode)

第二章 zookeeper安装部署

zookeeper完整详细的内容介绍可见zookeeper简介、zookeeper部署以及原理介绍

1. 解压zookeeper安装包

[root@hadoop101 software]# tar -xf apache-zookeeper-3.5.7-bin.tar.gz -C /opt/module/

2. 创建zkData目录

[root@hadoop101 software]# mkdir -p /opt/module/apache-zookeeper-3.5.7-bin/zkData

3. 设定节点myid号

[root@hadoop101 software]# echo 1 > /opt/module/apache-zookeeper-3.5.7-bin/zkData/myid

4. 修改zoo.cfg配置文件

[root@hadoop101 software]# cd /opt/module/apache-zookeeper-3.5.7-bin/conf/

[root@hadoop101 conf]# ll

total 12

-rw-r--r-- 1 502 games 535 May 4 2018 configuration.xsl

-rw-r--r-- 1 502 games 2712 Feb 7 2020 log4j.properties

-rw-r--r-- 1 502 games 922 Feb 7 2020 zoo_sample.cfg

[root@hadoop101 conf]# mv zoo_sample.cfg zoo.cfg

[root@hadoop101 conf]# vim zoo.cfg

# 为方便查看,将注释行都删去,可保留

[root@hadoop101 conf]# cat zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/opt/module/apache-zookeeper-3.5.7-bin/zkData

clientPort=2181

server.1=hadoop101:2888:3888

server.2=hadoop102:2888:3888

server.3=hadoop103:2888:3888

[root@hadoop101 conf]#

5. 分发应用目录

[root@hadoop101 module]# scp -r apache-zookeeper-3.5.7-bin hadoop102:/opt/module/

[root@hadoop101 module]# scp -r apache-zookeeper-3.5.7-bin hadoop103:/opt/module/

6. 更改其它节点myid号

[root@hadoop102 ~]# echo 2 > /opt/module/apache-zookeeper-3.5.7-bin/zkData/myid

[root@hadoop103 ~]# echo 3 > /opt/module/apache-zookeeper-3.5.7-bin/zkData/myid

7. 检查各节点myid号确保正确

[root@hadoop101 module]# for i in hadoop101 hadoop102 hadoop103;do ssh $i cat /opt/module/apache-zookeeper-3.5.7-bin/zkData/myid;done

1

2

3

8. 启动集群各节点服务

[root@hadoop101 module]# /opt/module/apache-zookeeper-3.5.7-bin/bin/zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /opt/module/apache-zookeeper-3.5.7-bin/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED[root@hadoop102 module]# /opt/module/apache-zookeeper-3.5.7-bin/bin/zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /opt/module/apache-zookeeper-3.5.7-bin/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED[root@hadoop103 ~]# /opt/module/apache-zookeeper-3.5.7-bin/bin/zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /opt/module/apache-zookeeper-3.5.7-bin/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

9. 查验服务是否运行

[root@hadoop101 module]# for i in hadoop101 hadoop102 hadoop103;do ssh $i $JAVA_HOME/bin/jps -l|grep -v jps;done

5856 org.apache.zookeeper.server.quorum.QuorumPeerMain

5747 org.apache.zookeeper.server.quorum.QuorumPeerMain

5754 org.apache.zookeeper.server.quorum.QuorumPeerMain

第三章 hadoop集群安装部署

hadoop完整详细的内容介绍可见hadoop介绍部署文档

1. 解压hadoop安装包

[root@hadoop101 software]# tar -xf hadoop-3.1.3.tar.gz -C /opt/module/

2. 配置hadoop环境变量文件

# 文件末尾增加如下配置

[root@hadoop101 software]# vim /etc/profile

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

3. 各配置文件路径

[root@hadoop101 software]# cd /opt/module/hadoop-3.1.3/etc/hadoop/

[root@hadoop101 hadoop]# ll

total 176

-rw-r--r-- 1 1000 1000 8260 Sep 12 2019 capacity-scheduler.xml

-rw-r--r-- 1 1000 1000 1335 Sep 12 2019 configuration.xsl

-rw-r--r-- 1 1000 1000 1940 Sep 12 2019 container-executor.cfg

-rw-r--r-- 1 1000 1000 1353 Aug 26 16:29 core-site.xml

-rw-r--r-- 1 1000 1000 3999 Sep 12 2019 hadoop-env.cmd

-rw-r--r-- 1 1000 1000 15946 Aug 26 16:42 hadoop-env.sh

-rw-r--r-- 1 1000 1000 3323 Sep 12 2019 hadoop-metrics2.properties

-rw-r--r-- 1 1000 1000 11392 Sep 12 2019 hadoop-policy.xml

-rw-r--r-- 1 1000 1000 3414 Sep 12 2019 hadoop-user-functions.sh.example

-rw-r--r-- 1 1000 1000 2956 Aug 26 16:28 hdfs-site.xml

-rw-r--r-- 1 1000 1000 1484 Sep 12 2019 httpfs-env.sh

-rw-r--r-- 1 1000 1000 1657 Sep 12 2019 httpfs-log4j.properties

-rw-r--r-- 1 1000 1000 21 Sep 12 2019 httpfs-signature.secret

-rw-r--r-- 1 1000 1000 620 Sep 12 2019 httpfs-site.xml

-rw-r--r-- 1 1000 1000 3518 Sep 12 2019 kms-acls.xml

-rw-r--r-- 1 1000 1000 1351 Sep 12 2019 kms-env.sh

-rw-r--r-- 1 1000 1000 1747 Sep 12 2019 kms-log4j.properties

-rw-r--r-- 1 1000 1000 682 Sep 12 2019 kms-site.xml

-rw-r--r-- 1 1000 1000 13326 Sep 12 2019 log4j.properties

-rw-r--r-- 1 1000 1000 951 Sep 12 2019 mapred-env.cmd

-rw-r--r-- 1 1000 1000 1764 Sep 12 2019 mapred-env.sh

-rw-r--r-- 1 1000 1000 4113 Sep 12 2019 mapred-queues.xml.template

-rw-r--r-- 1 1000 1000 758 Sep 12 2019 mapred-site.xml

drwxr-xr-x 2 1000 1000 4096 Sep 12 2019 shellprofile.d

-rw-r--r-- 1 1000 1000 2316 Sep 12 2019 ssl-client.xml.example

-rw-r--r-- 1 1000 1000 2697 Sep 12 2019 ssl-server.xml.example

-rw-r--r-- 1 1000 1000 2642 Sep 12 2019 user_ec_policies.xml.template

-rw-r--r-- 1 1000 1000 30 Aug 26 16:33 workers

-rw-r--r-- 1 1000 1000 2250 Sep 12 2019 yarn-env.cmd

-rw-r--r-- 1 1000 1000 6056 Sep 12 2019 yarn-env.sh

-rw-r--r-- 1 1000 1000 2591 Sep 12 2019 yarnservice-log4j.properties

-rw-r--r-- 1 1000 1000 2029 Aug 26 16:32 yarn-site.xml

4. 修改hdfs-site配置文件

[root@hadoop101 hadoop]# vim hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!--Licensed under the Apache License, Version 2.0 (the "License");you may not use this file except in compliance with the License.You may obtain a copy of the License athttp://www.apache.org/licenses/LICENSE-2.0Unless required by applicable law or agreed to in writing, softwaredistributed under the License is distributed on an "AS IS" BASIS,WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.See the License for the specific language governing permissions andlimitations under the License. See accompanying LICENSE file.

--><!-- Put site-specific property overrides in this file. --><configuration><!--配置副本数--><property><name>dfs.replication</name><value>1</value></property><!--配置nameservice--><property><name>dfs.nameservices</name><value>mycluster</value></property><!--配置多NamenNode--><property><name>dfs.ha.namenodes.mycluster</name><value>nn1,nn2,nn3</value></property><property><name>dfs.namenode.rpc-address.mycluster.nn1</name><value>hadoop101:8020</value></property><property><name>dfs.namenode.rpc-address.mycluster.nn2</name><value>hadoop102:8020</value></property><property><name>dfs.namenode.rpc-address.mycluster.nn3</name><value>hadoop103:8020</value></property><!--为NamneNode设置HTTP服务监听--><property><name>dfs.namenode.http-address.mycluster.nn1</name><value>hadoop101:9870</value></property><property>相关文章:

apache大数据各组件部署搭建(超级详细)

apache大数据数仓各组件部署搭建 第一章 环境准备 1. 机器规划 准备3台服务器用于集群部署,系统建议CentOS7+,2核8G内存 172.19.195.228 hadoop101 172.19.195.229 hadoop102 172.19.195.230 hadoop103 [root@hadoop101 ~]# cat /etc/redhat-release CentOS Linux rele…...

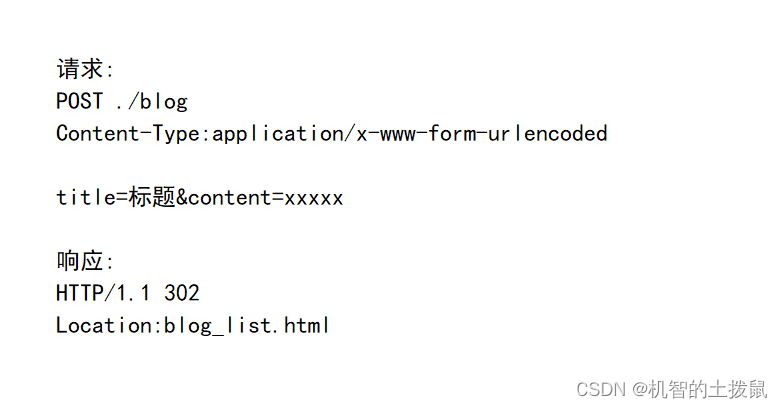

Servlet搭建博客系统

现在我们可以使用Servlet来搭建一个动态(前后端可以交互)的博客系统了(使用Hexo只能实现一个纯静态的网页,即只能在后台自己上传博客)。有一种"多年媳妇熬成婆"的感觉。 一、准备工作 首先创建好项目,引入相关依赖。具体过程在"Servlet的创建"中介绍了。…...

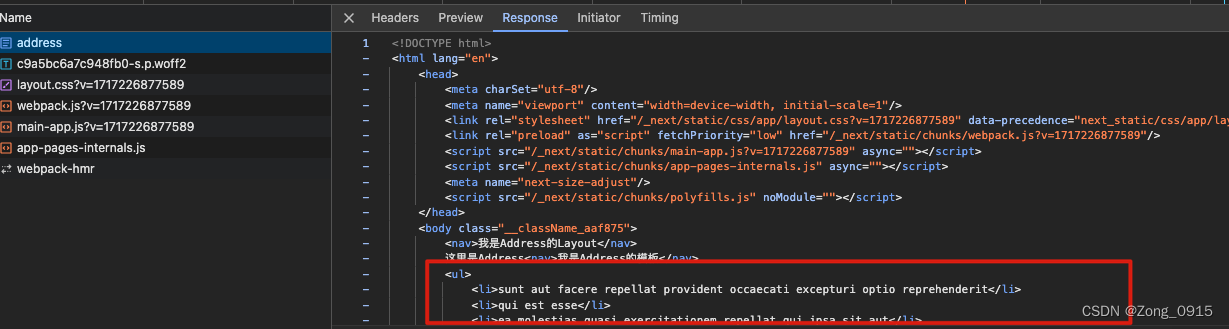

NextJs 渲染篇 - 什么是CSR、SSR、SSG、ISR 和服务端/客户端组件

NextJs 渲染篇 - 什么是CSR、SSR、SSG、ISR 和服务端/客户端组件 前言一. 什么是CSR、SSR、SSG、ISR1.1 CSR 客户端渲染1.2 SSR 服务端渲染1.3 SSG 静态站点生成① 没有数据请求的页面② 页面内容需要请求数据③ 页面路径需要获取数据 1.4 ISR 增量静态再生1.5 四种渲染方式的对…...

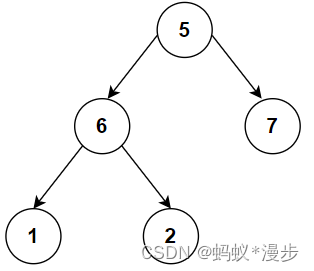

Python 二叉数的实例化及遍历

首先创建一个这样的二叉树,作为我们今天的实例。实例代码在下方。 #创建1个树类型 class TreeNode:def __init__(self,val,leftNone,rightNone):self.valvalself.leftleftself.rightright #实例化类 node1TreeNode(5) node2TreeNode(6) node3TreeNode(7) node4Tre…...

计算 x 的二进制表示中 1 的个数

计算 x 的二进制表示中 1 的个数 代码如下: int func(int x){int countx 0;while (x>0){countx;x x & (x - 1);}return countx;} 完整代码: using System; using System.Collections.Generic; using System.ComponentModel; using System.Dat…...

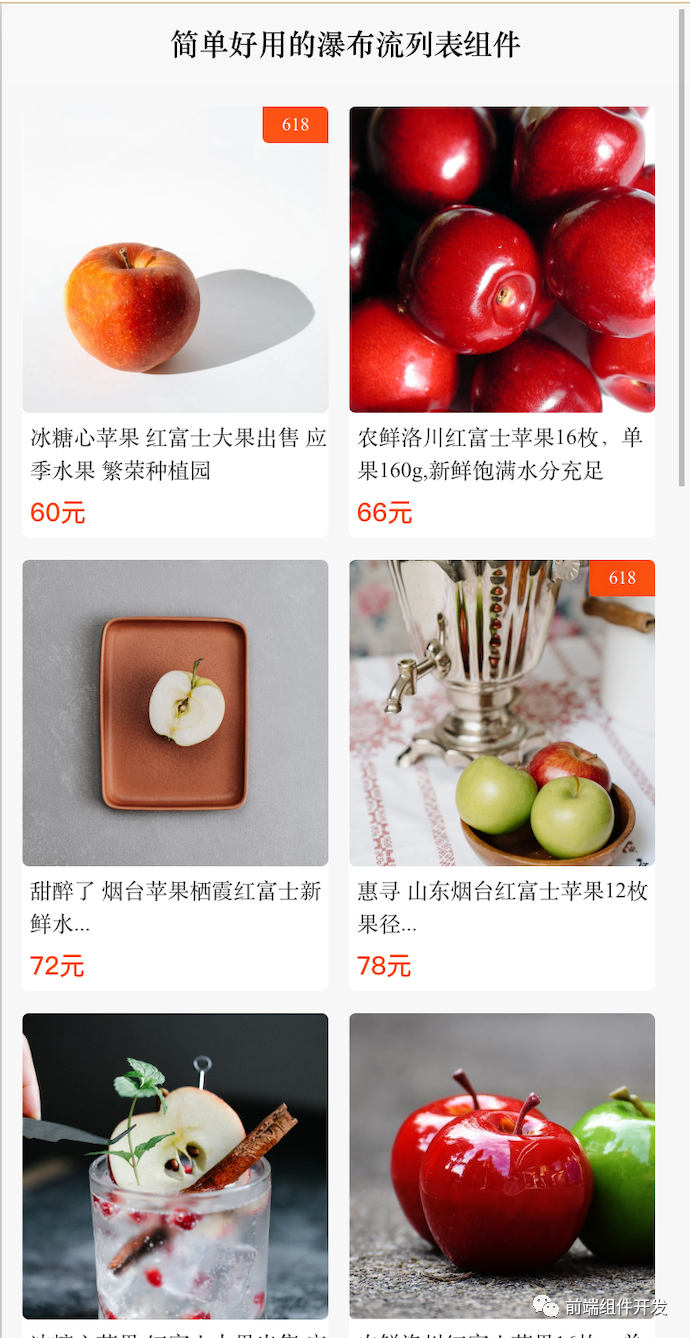

基于Vue的前端瀑布流布局组件的设计与实现

摘要 随着前端技术的不断演进,复杂业务场景和多次迭代后的产品对组件化开发提出了更高的要求。传统的整块应用开发方式已无法满足快速迭代和高效维护的需求。因此,本文将介绍一款基于Vue的瀑布流布局组件,旨在通过组件化开发提升开发效率和降…...

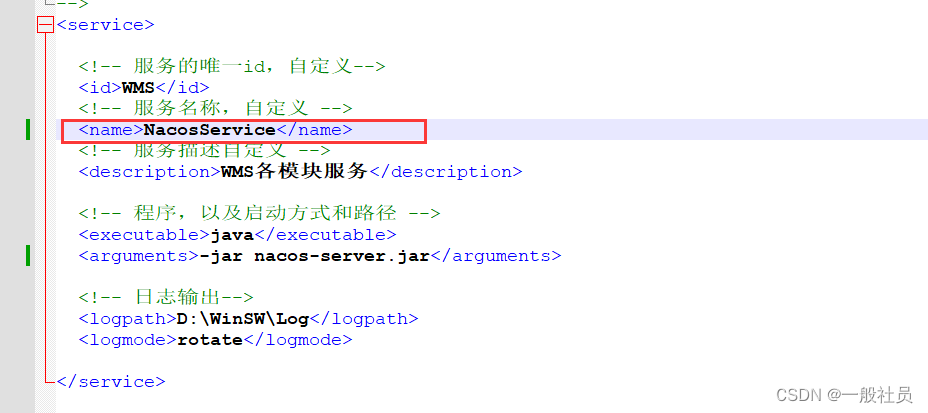

WinSW使用说明

WinSW使用说明 Windows系统下部署多个java程序 场景: 多个java的jar程序,通常来说一个程序使用一个cmd窗口,通过java -jar xxx.jar 命令来运行。这样如果程序多了打开cmd窗口也就多了。 解决: 通过使用WinSW程序,把ja…...

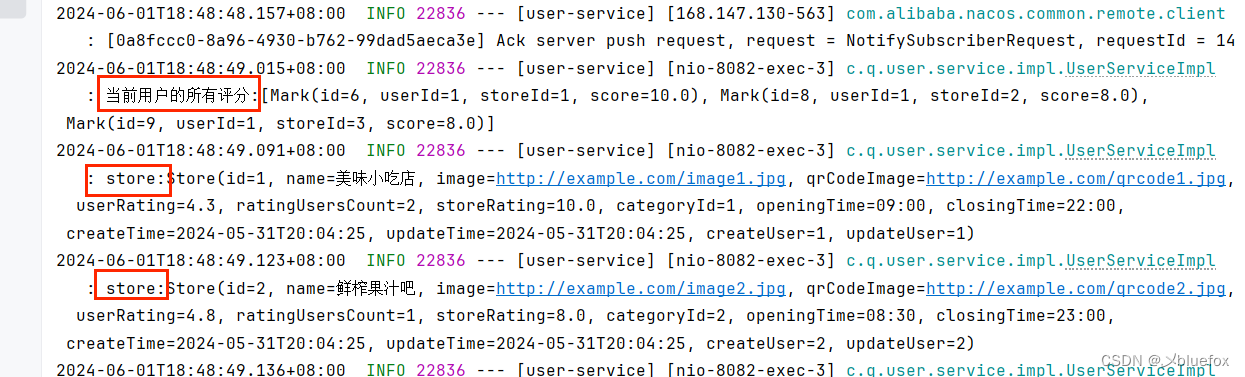

SpringBoot 多模块 多环境 项目 单元测试

环境描述 假设项目中有以下三个yml文件: application.ymlapplication-dev.ymlapplication-prod.yml 假设项目各Module之间依赖关系如下: 其中,D依赖C,C依赖B,B依赖A,D对外提供最终的访问接口 现在要想采…...

网络安全法中的网络安全规定和措施

《中华人民共和国网络安全法》是中国首部全面规范网络空间安全管理的基础性法律,旨在加强网络安全,保障国家安全和社会公共利益,保护公民、法人和其他组织的合法权益,促进互联网的健康发展。以下是该法律中关于网络安全的一些核心…...

一、搭建 Vue3 Admin 项目:从无到有的精彩历程

在前端开发的领域中,Vue3 展现出了强大的魅力,而搭建一个功能丰富的 Vue3 Admin 项目更是充满挑战与乐趣。今天,我将和大家分享我搭建 Vue3 Admin 项目的详细过程,其中用到了一系列重要的依赖包。 首先 让我们开启这个旅程。在确…...

Qt | Qt 资源简介(rcc、qmake)

1、资源系统是一种独立于平台的机制,用于在应用程序的可执行文件中存储二进制文件(前面所讨论的数据都存储在外部设备中)。若应用程序始终需要一组特定的文件(比如图标),则非常有用。 2、资源系统基于 qmake,rcc(Qt 的资源编译器,用于把资源转换为 C++代码)和 QFile …...

对boot项目拆分成cloud项目的笔记

引言:这里我用的是新版本的技术栈 spring-boot-starter-parent >3.2.5 mybatis-spring-boot-starter >3.0.3 mybatis-plus-boot-starter >3.5.5 spring-cloud-dependencies …...

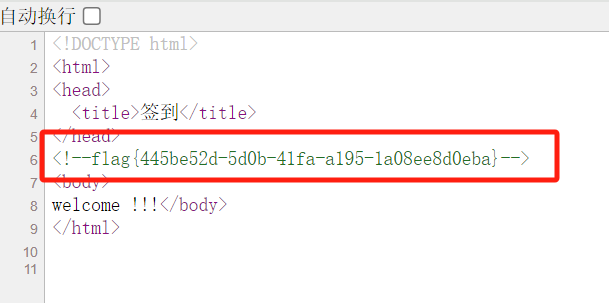

CTF本地靶场搭建——基于阿里云ACR实现动态flag题型的创建

接上文,这篇主要是结合阿里云ACR来实现动态flag题型的创建。 这里顺便也介绍一下阿里云的ACR服务。 阿里云容器镜像服务(简称 ACR)是面向容器镜像、Helm Chart 等符合 OCI 标准的云原生制品安全托管及高效分发平台。 ACR 支持全球同步加速、…...

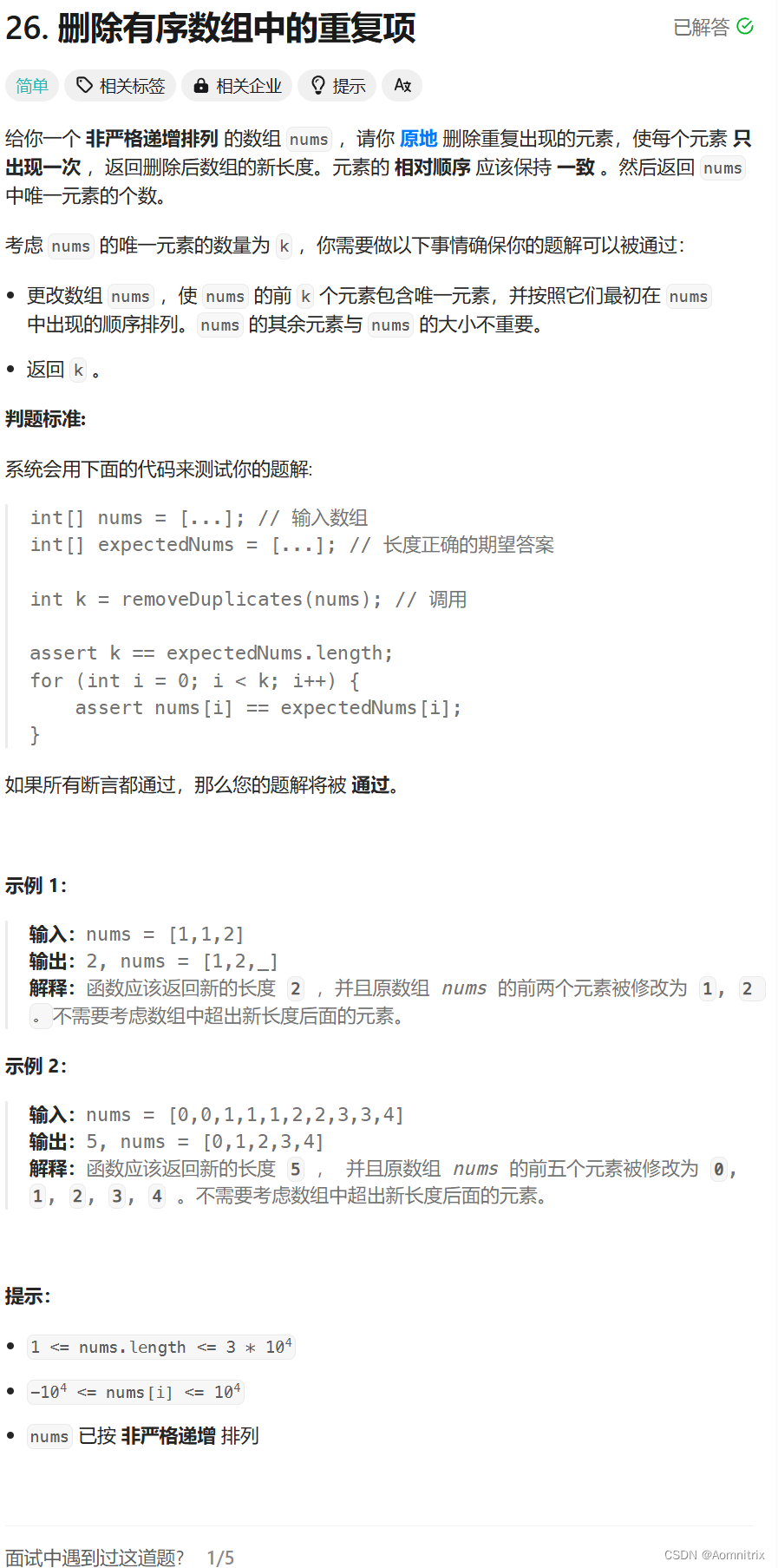

【面试经典150题】删除有序数组中的重复项

目录 一.删除有序数组中的重复项 一.删除有序数组中的重复项 题目如上图所示,这里非严格递增排序的定义是数字序列,其中相邻的数字可以相等,并且数字之间的差值为1。 这题我们依旧使用迭代器进行遍历,比较当前的数据是否与下一个数…...

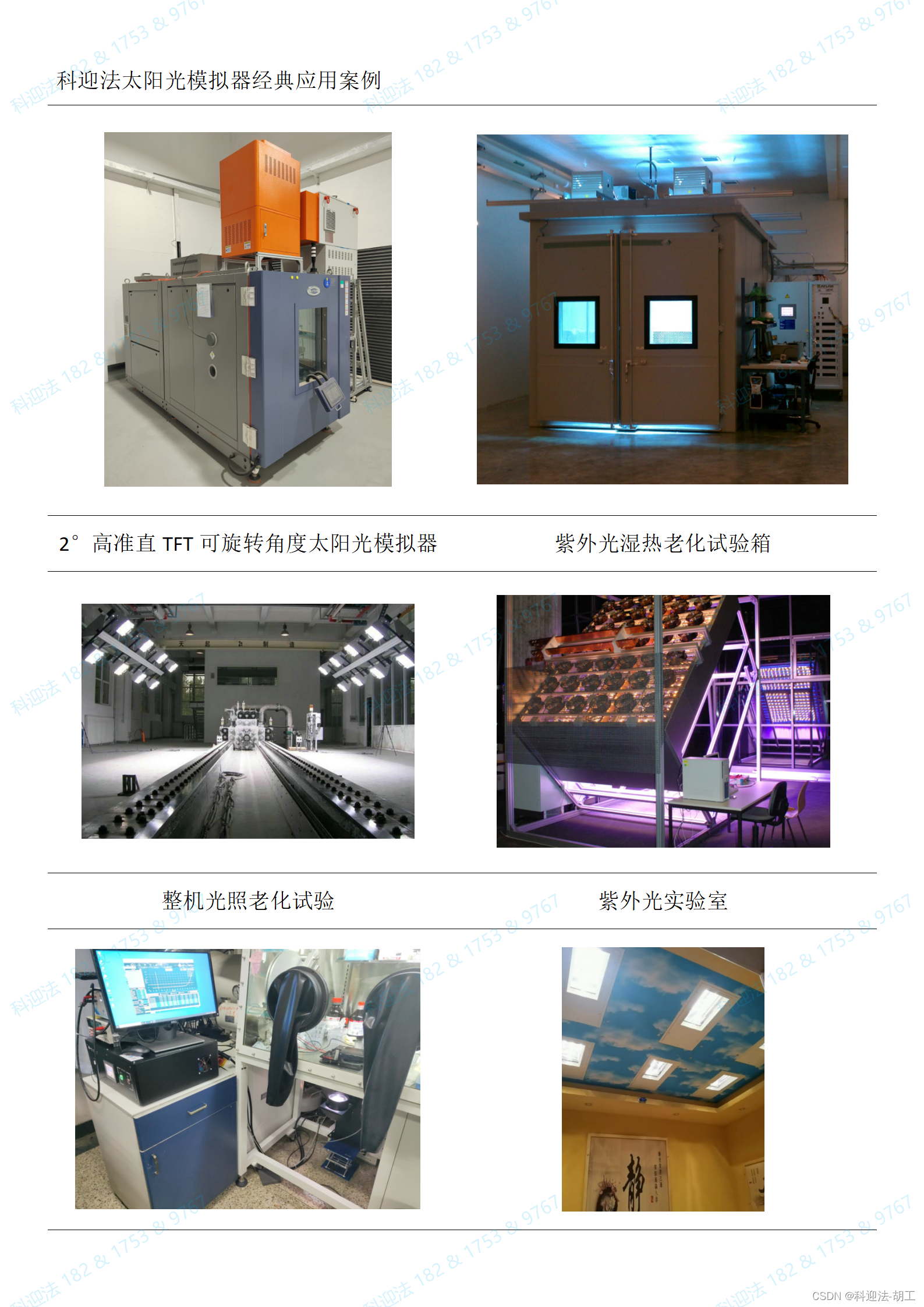

太阳能辐射整车综合性能环境试验舱

产品别名 步入式恒温恒湿试验箱、步入式温湿度试验箱、温度试验室、模拟环境试验室、大型恒温恒湿箱、步入式高低温湿热交变试验箱、大型高低温箱、步入式老化箱、恒温恒湿试验房、步入式高低温试验箱. 整车综合性能环境试验舱:整车综合性能环境试验舱:主要用于整车高低温存放…...

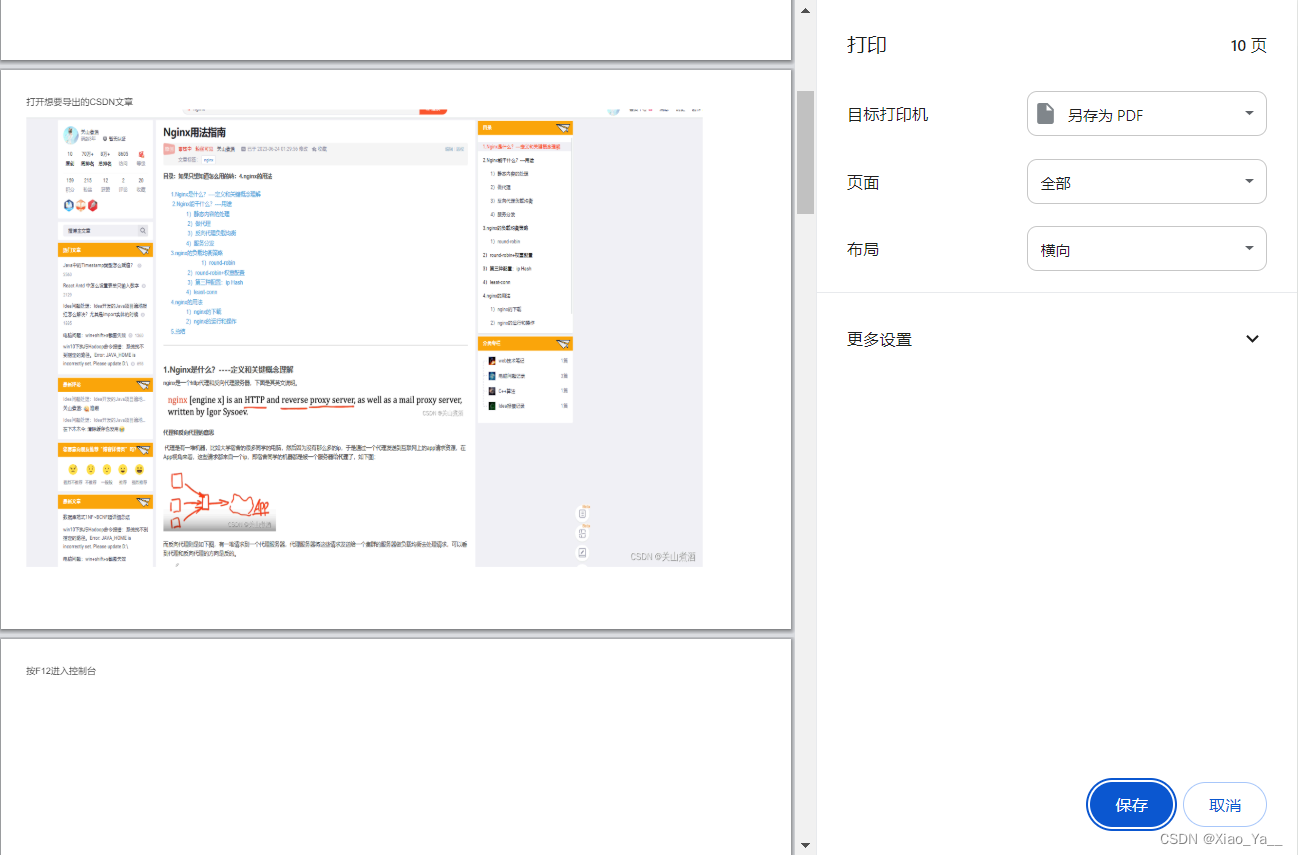

JS脚本打包成一个 Chrome 扩展(CRX 插件)

受这篇博客 如何把CSDN的文章导出为PDF_csdn文章怎么导出-CSDN博客 启发,将 JavaScript 代码打包成一个 Chrome 扩展(CRX 插件)。 步骤: 1.创建必要的文件结构和文件: manifest.jsonbackground.jscontent.js 2.编写…...

js事件对象

js事件对象概念说明 在JavaScript中,事件对象是在事件触发时由浏览器自动创建的一个对象。它包含了与事件相关的信息,例如触发事件的元素、事件类型、鼠标的坐标等。 可以通过事件处理函数的第一个参数来访问事件对象。例如,在一个鼠标点击…...

希捷硬盘怎么恢复数据? 5 个免费希捷数据恢复软件

希捷已迅速成为全球最大的数字存储提供商。许多人选择并使用希捷外置硬盘来存储他们的媒体文件、学校或工作文件以及其他重要数据。有时,希捷硬盘中的数据会丢失。 如果您丢失了希捷硬盘上的数据,请不要惊慌。在专业的希捷数据恢复软件的帮助下…...

Nvidia Jetson/Orin +FPGA+AI大算力边缘计算盒子:京东无人配送机器人

电商巨头京东已选用NVIDIA Jetson AGX Xavier 平台,作为下一代自主配送机器人核心AI算力。 在过去的几十年中,中国占据了全球40%以上的电商交易——每年约为千亿美元。根据麦肯锡全球研究院的数据,这一数字已经高于法国、德国、…...

STM32作业实现(七)OLED显示数据

目录 STM32作业设计 STM32作业实现(一)串口通信 STM32作业实现(二)串口控制led STM32作业实现(三)串口控制有源蜂鸣器 STM32作业实现(四)光敏传感器 STM32作业实现(五)温湿度传感器dht11 STM32作业实现(六)闪存保存数据 STM32作业实现(七)OLED显示数据 STM32作业实现(八)触摸按…...

[2025CVPR]DeepVideo-R1:基于难度感知回归GRPO的视频强化微调框架详解

突破视频大语言模型推理瓶颈,在多个视频基准上实现SOTA性能 一、核心问题与创新亮点 1.1 GRPO在视频任务中的两大挑战 安全措施依赖问题 GRPO使用min和clip函数限制策略更新幅度,导致: 梯度抑制:当新旧策略差异过大时梯度消失收敛困难:策略无法充分优化# 传统GRPO的梯…...

:にする)

日语学习-日语知识点小记-构建基础-JLPT-N4阶段(33):にする

日语学习-日语知识点小记-构建基础-JLPT-N4阶段(33):にする 1、前言(1)情况说明(2)工程师的信仰2、知识点(1) にする1,接续:名词+にする2,接续:疑问词+にする3,(A)は(B)にする。(2)復習:(1)复习句子(2)ために & ように(3)そう(4)にする3、…...

Frozen-Flask :将 Flask 应用“冻结”为静态文件

Frozen-Flask 是一个用于将 Flask 应用“冻结”为静态文件的 Python 扩展。它的核心用途是:将一个 Flask Web 应用生成成纯静态 HTML 文件,从而可以部署到静态网站托管服务上,如 GitHub Pages、Netlify 或任何支持静态文件的网站服务器。 &am…...

【Java学习笔记】BigInteger 和 BigDecimal 类

BigInteger 和 BigDecimal 类 二者共有的常见方法 方法功能add加subtract减multiply乘divide除 注意点:传参类型必须是类对象 一、BigInteger 1. 作用:适合保存比较大的整型数 2. 使用说明 创建BigInteger对象 传入字符串 3. 代码示例 import j…...

AGain DB和倍数增益的关系

我在设置一款索尼CMOS芯片时,Again增益0db变化为6DB,画面的变化只有2倍DN的增益,比如10变为20。 这与dB和线性增益的关系以及传感器处理流程有关。以下是具体原因分析: 1. dB与线性增益的换算关系 6dB对应的理论线性增益应为&…...

C/C++ 中附加包含目录、附加库目录与附加依赖项详解

在 C/C 编程的编译和链接过程中,附加包含目录、附加库目录和附加依赖项是三个至关重要的设置,它们相互配合,确保程序能够正确引用外部资源并顺利构建。虽然在学习过程中,这些概念容易让人混淆,但深入理解它们的作用和联…...

mac 安装homebrew (nvm 及git)

mac 安装nvm 及git 万恶之源 mac 安装这些东西离不开Xcode。及homebrew 一、先说安装git步骤 通用: 方法一:使用 Homebrew 安装 Git(推荐) 步骤如下:打开终端(Terminal.app) 1.安装 Homebrew…...

代码规范和架构【立芯理论一】(2025.06.08)

1、代码规范的目标 代码简洁精炼、美观,可持续性好高效率高复用,可移植性好高内聚,低耦合没有冗余规范性,代码有规可循,可以看出自己当时的思考过程特殊排版,特殊语法,特殊指令,必须…...

jmeter聚合报告中参数详解

sample、average、min、max、90%line、95%line,99%line、Error错误率、吞吐量Thoughput、KB/sec每秒传输的数据量 sample(样本数) 表示测试中发送的请求数量,即测试执行了多少次请求。 单位,以个或者次数表示。 示例:…...

通过MicroSip配置自己的freeswitch服务器进行调试记录

之前用docker安装的freeswitch的,启动是正常的, 但用下面的Microsip连接不上 主要原因有可能一下几个 1、通过下面命令可以看 [rootlocalhost default]# docker exec -it freeswitch fs_cli -x "sofia status profile internal"Name …...