Open Interpreter - 开放解释器

文章目录

- 一、关于

- 演示

- 它是如何工作的?

- 与 ChatGPT 的代码解释器比较

- 二、快速开始

- 三、更多操作

- 1、互动聊天

- 2、程序化聊天

- 3、开始新的聊天

- 4、保存和恢复聊天

- 5、自定义系统消息

- 6、更改模型

- 7、在本地运行 Open Interpreter

- 终端

- Python

- 上下文窗口,最大令牌

- 8、Verbose 模式

- 9、交互模式命令

- 10、Configuration / Profiles

- 多个配置文件

- 四、示例FastAPI服务器

- 调试模式

- 五、其他

- 1、安卓系统

- 2、离线访问文档

- 3、安全提示

- 4、Roadmap

一、关于

Open Interpreter(开放解释器) 可以让大语言模型(LLMs)在本地运行代码(比如 Python、JavaScript、Shell 等)。安装后,在终端上运行 $ interpreter 即可通过类似 ChatGPT 的界面与 Open Interpreter 聊天。

- github:https://github.com/OpenInterpreter/open-interpreter

- 官网:https://www.openinterpreter.com/

- 文档:https://docs.openinterpreter.com/

- discord : https://discord.gg/Hvz9Axh84z

- interactive demo : https://colab.research.google.com/drive/1WKmRXZgsErej2xUriKzxrEAXdxMSgWbb?usp=sharing

- voice interface, inspired by Her: https://colab.research.google.com/drive/1NojYGHDgxH6Y1G1oxThEBBb2AtyODBIK

本软件为计算机的通用功能提供了一个自然语言界面,比如:

- 创建和编辑照片、视频、PDF 等

- 控制 Chrome 浏览器进行搜索

- 绘制、清理和分析大型数据集

- …

⚠️ 注意:在代码运行前都会要求您批准执行代码。

演示

Open.Interpreter.Demo.mp4

它是如何工作的?

Open Interpreter 为函数调用语言模型配备了 exec() 函数,该函数接受 编程语言(如 "Python "或 “JavaScript”)和要运行的 代码。

然后,它会将模型的信息、代码和系统的输出以 Markdown 的形式流式传输到终端。

与 ChatGPT 的代码解释器比较

OpenAI 发布的 Code Interpreter 和 GPT-4 提供了一个与 ChatGPT 完成实际任务的绝佳机会。

但是,OpenAI 的服务是托管的,闭源的,并且受到严格限制:

- 无法访问互联网。

- 预装软件包数量有限。

- 允许的最大上传为 100 MB,且最大运行时间限制为 120.0 秒

- 当运行环境中途结束时,之前的状态会被清除(包括任何生成的文件或链接)。

Open Interpreter(开放解释器)通过在本地环境中运行克服了这些限制。它可以完全访问互联网,不受运行时间或是文件大小的限制,也可以使用任何软件包或库。

它将 GPT-4 代码解释器的强大功能与本地开发环境的灵活性相结合。

二、快速开始

安装

pip install open-interpreter

安装后,要在终端中开始交互式聊天,运行:

interpreter

Python 调用

from interpreter import interpreterinterpreter.chat("Plot AAPL and META's normalized stock prices") # 执行单一命令

interpreter.chat() # 开始交互式聊天

三、更多操作

更新:生成器更新(0.1.5)引入了流:

message = "What operating system are we on?"for chunk in interpreter.chat(message, display=False, stream=True):print(chunk)

1、互动聊天

要在终端中开始交互式聊天,请从命令行运行interpreter:

interpreter

或interpreter.chat()从. py文件:

interpreter.chat()

您还可以流式传输每个块:

message = "What operating system are we on?"for chunk in interpreter.chat(message, display=False, stream=True):print(chunk)

2、程序化聊天

为了更精确的控制,您可以通过 .chat(message) 直接传递消息 :

interpreter.chat("Add subtitles to all videos in /videos.")# ... Streams output to your terminal, completes task ...interpreter.chat("These look great but can you make the subtitles bigger?")# ...

3、开始新的聊天

在 Python 中,Open Interpreter 会记录历史对话。如果你想从头开始,可以进行重置:

interpreter.messages = []

4、保存和恢复聊天

interpreter.chat()()返回一个消息列表,可用于恢复与interpreter.messages = messages:

messages = interpreter.chat("My name is Killian.") # 保存消息到 'messages'

interpreter.messages = [] # 重置解释器 ("Killian" 将被遗忘)interpreter.messages = messages # 从 'messages' 恢复聊天 ("Killian" 将被记住)

5、自定义系统消息

你可以检查和配置 Open Interpreter 的系统信息,以扩展其功能、修改权限或赋予其更多上下文。

interpreter.system_message += """

使用 -y 运行 shell 命令,这样用户就不必确认它们。

"""

print(interpreter.system_message)

6、更改模型

Open Interpreter 使用LiteLLM连接到语言模型。

您可以通过设置模型参数来更改模型:

interpreter --model gpt-3.5-turbo

interpreter --model claude-2

interpreter --model command-nightly

在 Python 环境下,您需要手动设置模型:

interpreter.llm.model = "gpt-3.5-turbo"

在此处为您的语言模型找到适当的“模型”字符串。

7、在本地运行 Open Interpreter

终端

Open解释器可以使用与OpenAI兼容的服务器在本地运行模型。(LM Studio、jan.ai、ollama等)

只需使用推理服务器的api_baseURL运行interpreter(对于LM Studio,默认http://localhost:1234/v1):

interpreter --api_base "http://localhost:1234/v1" --api_key "fake_key"

或者,您可以使用Llamafile而无需安装任何第三方软件,只需运行

interpreter --local

有关更详细的指南,请查看Mike Bird的此视频

如何在后台运行LM Studio。

- 下载https://lmstudio.ai/然后启动它。

- 选择型号,然后单击↓下载。

- 单击左侧(💬下方)的↔️按钮。

- 在顶部选择您的模型,然后单击启动服务器。

服务器运行后,您可以使用Open解释器开始对话。

**注意:**本地模式将您的

context_window设置为3000,max_tokens为1000。如果您的型号有不同的要求,请手动设置这些参数(见下文)。

Python

我们的Python包让您可以更好地控制每个设置。要复制并连接到LM Studio,请使用以下设置:

from interpreter import interpreterinterpreter.offline = True # Disables online features like Open Procedures

interpreter.llm.model = "openai/x" # Tells OI to send messages in OpenAI's format

interpreter.llm.api_key = "fake_key" # LiteLLM, which we use to talk to LM Studio, requires this

interpreter.llm.api_base = "http://localhost:1234/v1" # Point this at any OpenAI compatible serverinterpreter.chat()

上下文窗口,最大令牌

您可以修改本地运行模型的max_tokens和context_window(以令牌形式)。

对于本地模式,较小的上下文窗口将使用较少的RAM,因此如果失败/速度较慢,我们建议尝试更短的窗口(约1000)。确保max_tokens小于context_window。

interpreter --local --max_tokens 1000 --context_window 3000

8、Verbose 模式

为了帮助您检查开放解释器,我们有一个用于调试的--verbose模式。

您可以使用它的标志(interpreter --verbose)或聊天中激活详细模式:

$ interpreter

...

> %verbose true <- Turns on verbose mode> %verbose false <- Turns off verbose mode

9、交互模式命令

在交互模式下,您可以使用以下命令来增强您的体验。以下是可用命令列表:

可用命令:

%verbose [true/false]:切换详细模式。不带参数或带true参数 进入详细模式。使用false则退出详细模式。%reset:重置当前会话的对话。%undo:从消息历史记录中删除上一条用户消息和AI的响应。%tokens [prompt]:(实验)计算将与下一个提示作为上下文一起发送的令牌,并估计它们的成本。如果提供了prompt,可以选择计算令牌和估计成本。依赖于LiteLLM的cost_per_token()方法来估计成本。%help:显示帮助消息。

10、Configuration / Profiles

打开解释器允许您使用yaml文件设置默认行为。

这提供了一种灵活的方式来配置解释器,而无需每次都更改命令行参数。

运行以下命令打开配置文件目录:

interpreter --profiles

您可以在那里添加yaml文件。默认配置文件名为default.yaml。

多个配置文件

Open解释器支持多个yaml文件,允许您在配置之间轻松切换:

interpreter --profile my_profile.yaml

四、示例FastAPI服务器

生成器更新使Open解释器能够通过HTTP REST端点进行控制:

# server.pyfrom fastapi import FastAPI

from fastapi.responses import StreamingResponse

from interpreter import interpreterapp = FastAPI()@app.get("/chat")

def chat_endpoint(message: str):def event_stream():for result in interpreter.chat(message, stream=True):yield f"data: {result}\n\n"return StreamingResponse(event_stream(), media_type="text/event-stream")@app.get("/history")

def history_endpoint():return interpreter.messages

pip install fastapi uvicorn

uvicorn server:app --reload

您也可以通过简单地运行 interpreter.server() 来启动与上述服务器相同的服务器。

调试模式

为了帮助贡献者检查和调试 Open Interpreter,--verbose 模式提供了详细的日志。

您可以使用 interpreter --verbose 来激活调试模式,或者直接在终端输入:

$ interpreter

...

> %verbose true <- 开启调试模式> %verbose false <- 关闭调试模式

五、其他

1、安卓系统

在Android设备上安装Open解释器的分步指南可在open-interpreter-termux 存储库中找到。

2、离线访问文档

完整的留档可随时随地访问,无需互联网连接。

节点是一个先决条件:

- 版本 18.17.0 或任何更高版本 18.x.x 版本。

- 版本 20.3.0 或任何更高版本 20.x.x 。

- 从 21.0.0 开始的任何版本,没有指定上限。

安装Mintlify:

npm i -g mintlify@latest

切换到docs目录并运行相应的命令:

# Assuming you're at the project's root directory

cd ./docs# Run the documentation server

mintlify dev

应该会打开一个新的浏览器窗口。只要留档服务器在运行,留档就http://localhost:3000可用。

3、安全提示

由于生成的代码是在本地环境中运行的,因此会与文件和系统设置发生交互,从而可能导致本地数据丢失或安全风险等意想不到的结果。

⚠️ 所以在执行任何代码之前,Open Interpreter 都会询问用户是否运行。

您可以运行 interpreter -y 或设置 interpreter.auto_run = True 来绕过此确认,此时:

- 在运行请求修改本地文件或系统设置的命令时要谨慎。

- 请像驾驶自动驾驶汽车一直握着方向盘一样留意 Open Interpreter,并随时做好通过关闭终端来结束进程的准备。

- 考虑在 Google Colab 或 Replit 等受限环境中运行 Open Interpreter 的主要原因是这些环境更加独立,从而降低执行任意代码导致出现问题的风险。

有实验性支持的安全模式,以帮助减轻一些风险。

4、Roadmap

若要预览 Open Interpreter 的未来,请查看我们的路线图 。

请注意:此软件与 OpenAI 无关。

2024-08-03(六)

相关文章:

Open Interpreter - 开放解释器

文章目录 一、关于演示它是如何工作的?与 ChatGPT 的代码解释器比较 二、快速开始三、更多操作1、互动聊天2、程序化聊天3、开始新的聊天4、保存和恢复聊天5、自定义系统消息6、更改模型7、在本地运行 Open Interpreter终端Python上下文窗口,最大令牌 8、…...

“八股文”:程序员的福音还是梦魇?

——一场关于面试题的“代码战争” 在程序员的世界里,“八股文”这个词儿可谓是“如雷贯耳”。不,咱们可不是说古代科举考试中的那种八股文,而是指程序员面试中的那些固定套路的题目。如今,各大中小企业在招聘程序员时࿰…...

数据结构第2天作业 8月3日

单向链表 typedef int datatype; //由于有效数据不一定是正数,所以将数据重命名。typedef struct lklst{ //不能是无名结构体了,因为定义指针域的时候需要使用union{int len; //头结点时候使用;datatype data; …...

设计界的新宠:5款热门UI在线设计软件评测

随着用户界面设计行业的蓬勃发展,越来越多的设计师进入用户界面设计。选择一个方便的用户界面设计工具尤为重要!除了传统的用户界面设计工具,在线用户界面设计工具也受到越来越多设计师的青睐。这种不受时间、地点、计算机配置限制的工作方法…...

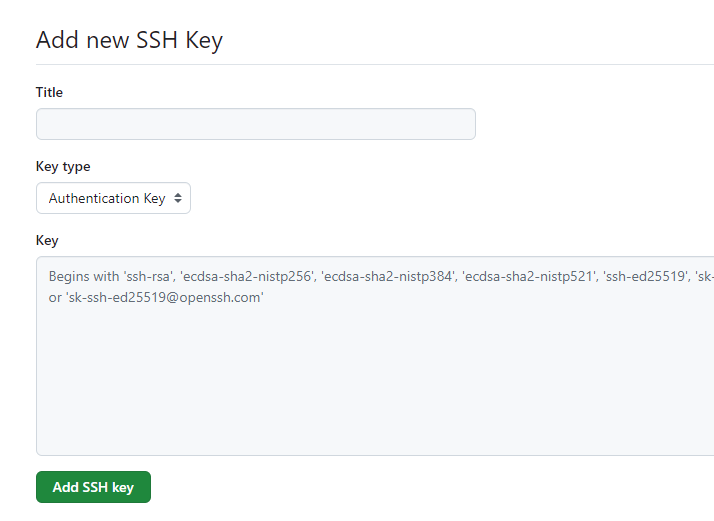

github添加ssh密钥,通过ssh方式推送代码

左手编程,右手年华。大家好,我是一点,关注我,带你走入编程的世界。 公众号:一点sir,关注领取python编程资料 很多人在使用github的时候,如果还是使用https的方式推送代码的话,可能会…...

Python设计模式 - 抽象工厂模式

定义 抽象工厂模式是一种创建型设计模式,它提供了一种创建一系列相关或相互依赖对象的接口,而无需指定它们具体的类。 产品等级结构与产品族 为了更好地理解抽象工厂模式,先引入两个概念: 产品等级结构:就是产品的…...

【JavaEE初阶】懒汉模式与饿汉模式及指令重排序问题

目录 📕 单例模式 🌳 饿汉模式 🚩 线程安全 🎍 懒汉模式 🚩 懒汉模式-单线程版 🚩 懒汉模式-多线程版 🎄 指令重排序 📕 单例模式 单例模式是一种经典的设计模式,…...

Vue3使用Cascader 级联选择器如何获取值并提交信息

我写了一个用户对象,有address地址字段,我怎么将用户选择的级联数据selectedValue值传给address,并将对象返回给后端,核心代码实现了该问题。 <script> 核心代码: //获取住址并更新给addresslet selectedValue…...

Python面试整理-第三方库

Python社区提供了大量的第三方库,这些库扩展了Python的功能,覆盖了从数据科学到网络应用开发等多个领域。以下是一些非常流行和广泛使用的第三方库: 1. NumPy ● 用途:数值计算。 ● 特点:提供了一个强大的N维数组对象和大量用于数学运算的函数。 ● 应用场景:科学计算、…...

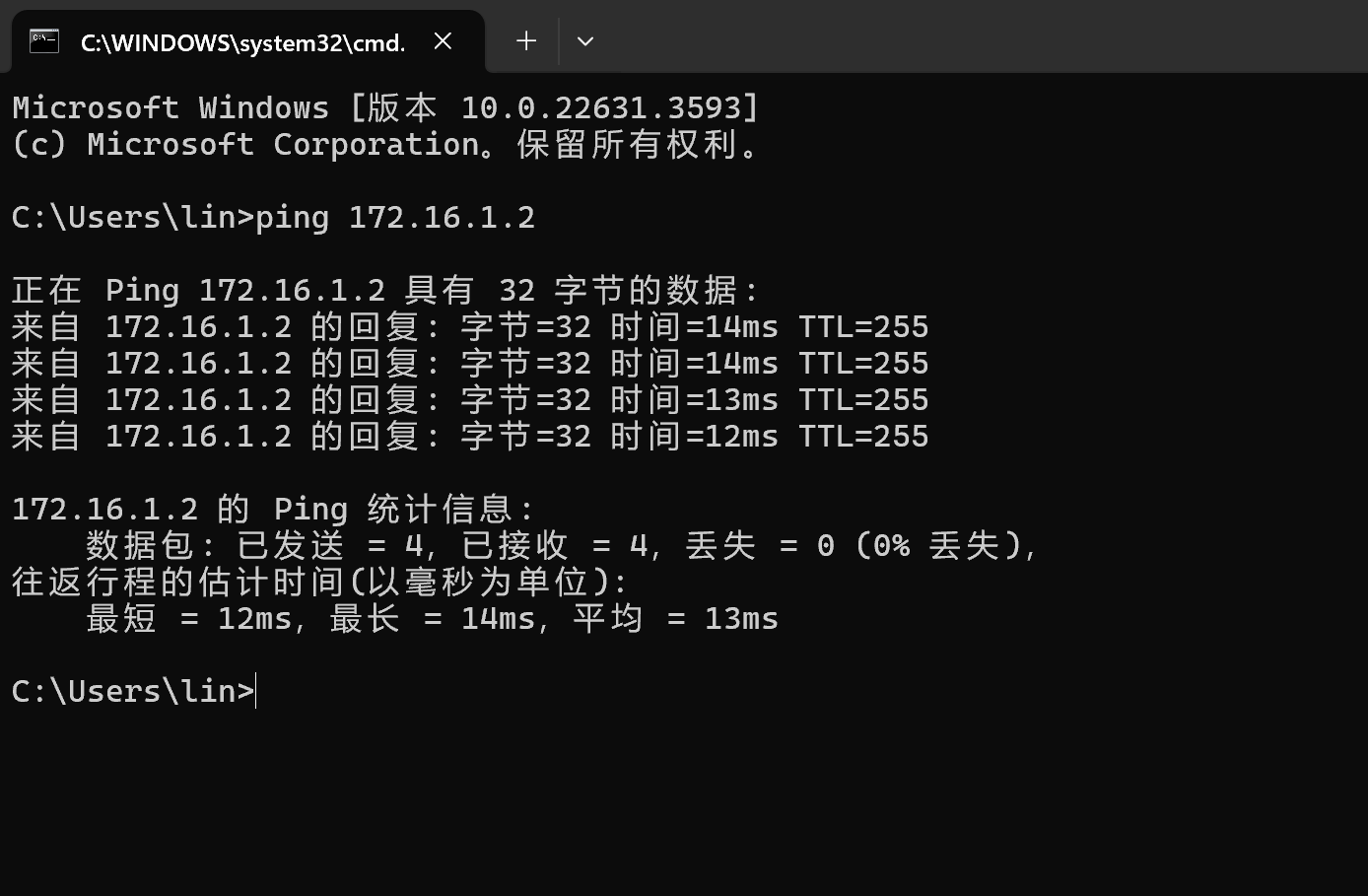

电脑添加虚拟网卡与ensp互联,互访

一、按照过程 1、打开设备管理器 2、点击网络适配器,点击左上角操作,点击“添加过时硬件” 3、下一页 4、选择“安装我手动从列表选择的硬件”,下一页 5、下拉,选择“网络适配器”,下一页 6、厂商选择“Microsoft”&…...

悬而未决:奇怪的不允许跨域CORS policy的问题

我在本地HBuilderX中进行预览写好的前端网页,它里面用了ajax访问了远程服务器的后端API网址,不出意外地报不允许跨域访问的错了:Access to XMLHttpRequest at ‘http://xxx.com/MemberUser/login’ from origin ‘http://mh.com’ has been b…...

索引优化秘籍:SQL Server数据库填充因子的调优艺术

索引优化秘籍:SQL Server数据库填充因子的调优艺术 在SQL Server的性能优化中,索引起着至关重要的作用。而索引填充因子(Fill Factor)则是控制索引页填充程度的重要参数,它直接影响索引的存储效率和查询性能。本文将深…...

ffmpeg 的内存分配架构

------------------------------------------------------------ author: hjjdebug date: 2024年 08月 01日 星期四 18:00:47 CST descripton: ffmpeg 的内存分配架构1 ------------------------------------------------------------ ffmpeg 的内配分配搞的人晕菜&#…...

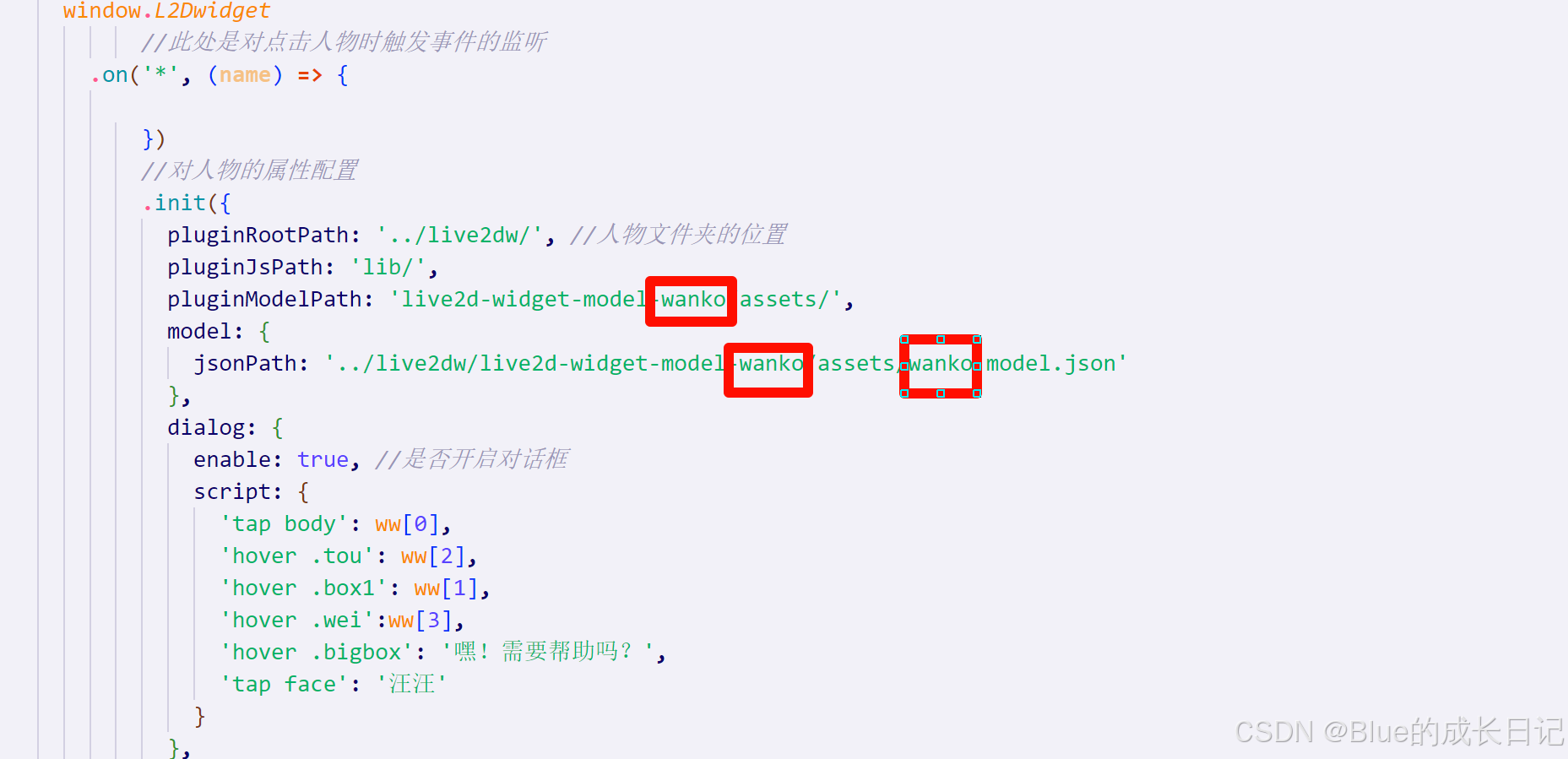

Vue+live2d实现虚拟人物互动(一次体验叙述)

目录 故事的开头: 最终的实现效果: 实现步骤: 第一步:下载重要文件 第二步:创建vue项目文件,将刚下载文件拷贝到public目录下 第三步:在index.html文件中引入js 第四步:使用&…...

内联函数的概念和用途以及区别

内联函数(Inline Function)是C(以及C99之后的C语言)中的一个特性,旨在通过减少函数调用的开销来提高程序的执行效率。在正常情况下,当程序调用一个函数时,会发生一系列的操作,包括保…...

rust 桌面 sip 软电话(基于tauri 、pjsip库)

本文尝试下rust 的tauri 桌面运用 原因在于体积小 1、pjsip 提供了rust 接口官方的 rust demo 没编译出来 在git找了个sip-phone-rs-master https://github.com/Charles-Schleich/sip-phone-rs 可以自己编译下pjsip lib库替换该项目的lib 2、创建一个tauri demo 引用 [depe…...

Linux 进程优先级、程序地址空间、进程控制

个人主页:仍有未知等待探索-CSDN博客 专题分栏: Linux 目录 一、进程优先级 1、什么是进程优先级? 2、为什么要有优先级? 3、Linux的优先级特点、查看方式 4、命令行参数和环境变量 1.命令行参数 2.环境变量 获取环境变量的…...

学习笔记一

vector 在创建时指定初始大小和初始值: vector<int> a(5, 1) // 包含 5 个整数的 vector,每个值都为 1 可以使用 push_back 方法向 vector 中添加元素: a.push_back(7) // 将整数 7 添加到 vector 的末尾 可以使用 size(…...

Linux中信号的发送及信号的自定义捕捉方法

预备知识: 信号产生时进程早已知道该信号如何处理。 信号产生时进程可能并不能立即处理信号而是等到合适的时候处理。 信号其他相关常见概念 实际执行信号的处理动作称为信号递达(Delivery) 信号从产生到递达之间的状态,称为信号未决(Pending)。 进程可以选择阻…...

yum仓库的制作与使用

目录 前言: 1 查看系统内核 2 获取网络源 3 搭建yum网络仓库 4 rpm包的下载 4.1 将rpm包下载至本地 4.2 对下载的rpm包进行备份 5 制作本地yum源 5.1 软件仓库制作工具createrepo 5.2 使用createrepo创建本地yum仓库 6 搭建docker本地仓库 前言&#x…...

业务系统对接大模型的基础方案:架构设计与关键步骤

业务系统对接大模型:架构设计与关键步骤 在当今数字化转型的浪潮中,大语言模型(LLM)已成为企业提升业务效率和创新能力的关键技术之一。将大模型集成到业务系统中,不仅可以优化用户体验,还能为业务决策提供…...

Vue2 第一节_Vue2上手_插值表达式{{}}_访问数据和修改数据_Vue开发者工具

文章目录 1.Vue2上手-如何创建一个Vue实例,进行初始化渲染2. 插值表达式{{}}3. 访问数据和修改数据4. vue响应式5. Vue开发者工具--方便调试 1.Vue2上手-如何创建一个Vue实例,进行初始化渲染 准备容器引包创建Vue实例 new Vue()指定配置项 ->渲染数据 准备一个容器,例如: …...

Nginx server_name 配置说明

Nginx 是一个高性能的反向代理和负载均衡服务器,其核心配置之一是 server 块中的 server_name 指令。server_name 决定了 Nginx 如何根据客户端请求的 Host 头匹配对应的虚拟主机(Virtual Host)。 1. 简介 Nginx 使用 server_name 指令来确定…...

DBAPI如何优雅的获取单条数据

API如何优雅的获取单条数据 案例一 对于查询类API,查询的是单条数据,比如根据主键ID查询用户信息,sql如下: select id, name, age from user where id #{id}API默认返回的数据格式是多条的,如下: {&qu…...

CMake 从 GitHub 下载第三方库并使用

有时我们希望直接使用 GitHub 上的开源库,而不想手动下载、编译和安装。 可以利用 CMake 提供的 FetchContent 模块来实现自动下载、构建和链接第三方库。 FetchContent 命令官方文档✅ 示例代码 我们将以 fmt 这个流行的格式化库为例,演示如何: 使用 FetchContent 从 GitH…...

Spring AI与Spring Modulith核心技术解析

Spring AI核心架构解析 Spring AI(https://spring.io/projects/spring-ai)作为Spring生态中的AI集成框架,其核心设计理念是通过模块化架构降低AI应用的开发复杂度。与Python生态中的LangChain/LlamaIndex等工具类似,但特别为多语…...

【碎碎念】宝可梦 Mesh GO : 基于MESH网络的口袋妖怪 宝可梦GO游戏自组网系统

目录 游戏说明《宝可梦 Mesh GO》 —— 局域宝可梦探索Pokmon GO 类游戏核心理念应用场景Mesh 特性 宝可梦玩法融合设计游戏构想要素1. 地图探索(基于物理空间 广播范围)2. 野生宝可梦生成与广播3. 对战系统4. 道具与通信5. 延伸玩法 安全性设计 技术选…...

无人机侦测与反制技术的进展与应用

国家电网无人机侦测与反制技术的进展与应用 引言 随着无人机(无人驾驶飞行器,UAV)技术的快速发展,其在商业、娱乐和军事领域的广泛应用带来了新的安全挑战。特别是对于关键基础设施如电力系统,无人机的“黑飞”&…...

站群服务器的应用场景都有哪些?

站群服务器主要是为了多个网站的托管和管理所设计的,可以通过集中管理和高效资源的分配,来支持多个独立的网站同时运行,让每一个网站都可以分配到独立的IP地址,避免出现IP关联的风险,用户还可以通过控制面板进行管理功…...

Chromium 136 编译指南 Windows篇:depot_tools 配置与源码获取(二)

引言 工欲善其事,必先利其器。在完成了 Visual Studio 2022 和 Windows SDK 的安装后,我们即将接触到 Chromium 开发生态中最核心的工具——depot_tools。这个由 Google 精心打造的工具集,就像是连接开发者与 Chromium 庞大代码库的智能桥梁…...