PySpark Yarn集群模式

目录

简介

一、PySpark简介

二、YARN模式概述

三、配置环境

1. 安装与配置Spark

2. 配置Hadoop和YARN

3. 启动yarn

四、编写PySpark脚本

五、提交PySpark作业到YARN

参数解释:

六、常见问题及解决

七、总结

简介

随着大数据的普及,Spark作为主流的分布式计算框架,在大数据处理中扮演着重要角色。YARN(Yet Another Resource Negotiator)作为资源调度和管理框架,与Spark结合后可以更好地管理和调度资源。本篇文章将详细介绍如何在YARN集群模式下运行PySpark应用程序,适合有一定Spark基础的开发者。

一、PySpark简介

PySpark是Spark的Python API,支持使用Python编写代码并提交到Spark集群运行。在大规模数据处理中,PySpark可以利用Python的简单性和Spark的分布式处理能力,极大地提升数据处理效率。

二、YARN模式概述

YARN模式是Spark常用的集群模式之一。YARN可以有效地调度集群资源,并提供容错能力。通过将Spark应用程序提交到YARN,用户可以在Hadoop集群上更高效地执行计算任务。

Spark在YARN上运行时有两种模式:

- Cluster模式:Driver运行在YARN集群中,适用于生产环境。

- Client模式:Driver运行在提交应用程序的客户端,适用于调试和开发。

三、配置环境

在PySpark集群模式下运行需要配置Spark和YARN环境。

1. 安装与配置Spark

下载并解压Spark后,设置环境变量SPARK_HOME,并将其添加到PATH中。

cd /opt/modules/

tar -zxf spark-3.1.2-bin-hadoop3.2.tgz -C /opt/installs

cd /opt/installs

mv spark-3.1.2-bin-hadoop3.2 spark-yarn

rm -rf /opt/installs/spark

ln -s /opt/installs/spark-yarn /opt/installs/spark修改$SPARK_HOME/conf/spark-env.sh文件,指定Hadoop和YARN相关配置:

cd /opt/installs/spark/conf

mv spark-env.sh.template spark-env.sh

vim /opt/installs/spark/conf/spark-env.sh

## 22行左右设置JAVA安装目录、HADOOP和YARN配置文件

目录

export JAVA_HOME=/opt/installs/jdk

export HADOOP_CONF_DIR=/opt/installs/hadoop/etc/hadoop

export YARN_CONF_DIR=/opt/installs/hadoop/etc/hadoop

## 历史日志服务器

export SPARK_DAEMON_MEMORY=1g

export SPARK_HISTORY_OPTS="-Dspark.history.fs.logDirectory=hdfs://bigdata01:9820/spark/eventLogs/ -Dspark.history.fs.cleaner.enabled=true"修改$SPARK_HOME/conf/spark-defaults.conf文件:

cd /opt/installs/spark/conf

mv spark-defaults.conf.template spark-defaults.confvim spark-defaults.conf

## 添加内容:

spark.eventLog.enabled true

spark.eventLog.dir hdfs://bigdata01:9820/spark/eventLogs

spark.eventLog.compress true

spark.yarn.historyServer.address bigdata01:18080

spark.yarn.jars hdfs://bigdata01:9820/spark/jars/*修改$SPARK_HOME/conf/log4j.properties文件:

mv log4j.properties.template log4j.properties# 修改级别为WARN,打印日志少一点。上传spark jar包:

# 因为YARN中运行Spark,需要用到Spark的一些类和方法

# 如果不上传到HDFS,每次运行YARN都要上传一次,比较慢

# 所以自己手动上传一次,以后每次YARN直接读取即可

hdfs dfs -mkdir -p /spark/jars/

hdfs dfs -put /opt/installs/spark/jars/* /spark/jars/2. 配置Hadoop和YARN

确保Hadoop集群已配置并正常运行,core-site.xml和yarn-site.xml应配置正确。

修改$SPARK_HOME/conf/yarn-site.xml文件:

cd /opt/installs/hadoop/etc/hadoop# 检查以下内置少什么,就配什么。

<property><name>yarn.log-aggregation-enable</name><value>true</value>

</property><!-- 历史日志在HDFS保存的时间,单位是秒 -->

<!-- 默认的是-1,表示永久保存 -->

<property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value>

</property><property><name>yarn.log.server.url</name><value>http://bigdata01:19888/jobhistory/logs</value>

</property><!-- 关闭yarn内存检查 -->

<property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value>

</property>

<property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value>

</property>将Master节点的文件分发到Worker节点(xsync.sh):

xsync.sh yarn-site.xmlxsync.sh /opt/installs/spark-yarn

# 超链接也分发一下:

xsync.sh /opt/installs/spark3. 启动yarn

start-yarn.sh

# 启动MR的JobHistoryServer:19888

mapred --daemon start historyserver

# 启动Spark的HistoryServer:18080

/opt/installs/spark/sbin/start-history-server.sh四、编写PySpark脚本

下面是一个简单的PySpark示例代码,将在YARN集群模式下运行。

from pyspark import SparkContext, SparkConf from pyspark.sql import SparkSession

# 创建Spark配置

conf = SparkConf().setAppName("PySpark YARN Example")

# 创建SparkSession spark = SparkSession.builder.config(conf=conf).getOrCreate()

# 示例操作:读取文件并统计单词数量

data = spark.read.text("hdfs:///path/to/input.txt") words = data.rdd.flatMap(lambda line: line.value.split(" ")) word_counts = words.map(lambda word: (word, 1)).reduceByKey(lambda a, b: a + b) word_counts.collect()

spark.stop()五、提交PySpark作业到YARN

在集群模式下,将PySpark脚本提交到YARN中运行,使用以下命令:

spark-submit \

--master yarn \

--deploy-mode cluster \

--driver-memory 4G \

--executor-memory 2G \

--executor-cores 2 \

/path/to/your_script.py参数解释:

--master yarn:指定YARN作为集群管理器。--deploy-mode cluster:集群模式,Driver运行在YARN上。--driver-memory:Driver分配的内存。--executor-memory:每个Executor分配的内存。--executor-cores:每个Executor分配的CPU核心数。

六、常见问题及解决

-

网络超时问题:在YARN模式下,网络超时是一个常见问题,尤其在集群模式中。可以增加

spark.network.timeout的时间来解决。 -

内存不足:增加

driver-memory或executor-memory的分配量。 -

依赖包丢失:可以使用

--py-files参数将Python依赖包提交到集群。

七、总结

在YARN集群模式下运行PySpark作业可以充分利用资源管理器的调度能力,适用于生产环境。通过配置Spark、Hadoop和YARN,编写PySpark脚本并提交到YARN,用户可以高效地执行分布式计算任务。

相关文章:

PySpark Yarn集群模式

目录 简介 一、PySpark简介 二、YARN模式概述 三、配置环境 1. 安装与配置Spark 2. 配置Hadoop和YARN 3. 启动yarn 四、编写PySpark脚本 五、提交PySpark作业到YARN 参数解释: 六、常见问题及解决 七、总结 简介 随着大数据的普及,Spark作为…...

Matlab基于经纬度点并行提取指定日期的tiff栅格位置的值

文章目录 前言一、基本说明二、代码 前言 该 MATLAB 代码用于从 GeoTIFF 文件中提取基于特定地理位置(经纬度)和日期的某个点的相关数据。代码首先读取一个包含事件数据(日期、经纬度)的 Excel 文件,然后根据日期和位…...

npm入门教程19:npm包管理

一、代码更新 遵循语义化版本控制: 在更新包时,应遵循语义化版本控制(Semantic Versioning,简称SemVer)规范。这意味着版本号的变更应反映代码变更的程度,通常遵循主版本号.次版本号.修订号的格式。主版本号…...

【NOIP提高组】虫食算

【NOIP提高组】虫食算 C语言C 💐The Begin💐点点关注,收藏不迷路💐 所谓虫食算,就是原先的算式中有一部分被虫子啃掉了,需要我们根据剩下的数字来判定被啃掉的字母。来看一个简单的例子: 43#98…...

软件测试面试题个人总结

前面看到了一些面试题,总感觉会用得到,但是看一遍又记不住,所以我把面试题都整合在一起,都是来自各路大佬的分享,为了方便以后自己需要的时候刷一刷,不用再到处找题,今天把自己整理的这些面试题…...

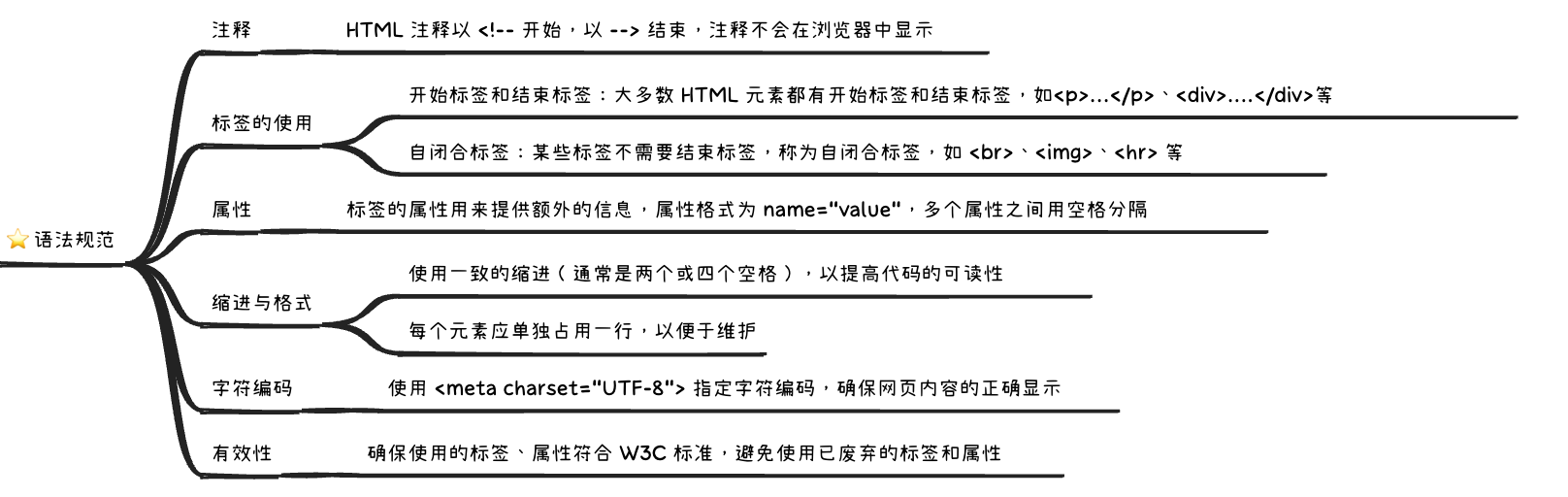

HTML 语法规范——代码注释、缩进与格式、标签与属性、字符编码等

文章目录 一、代码注释1.1 使用注释的主要目的1.2 使用建议二、标签的使用2.1 开始标签和结束标签2.2 自闭合标签2.3 标签的嵌套2.4 标签的有效性三、属性四、缩进与格式4.1 一致的缩进4.2 元素单独占用一行4.3 嵌套元素的缩进4.4 避免冗长的行五、字符编码六、小结在开发 HTML…...

【Wi-Fi】WiFi中QAM及16-QAM、64-QAM、512-QAM、1024-QAM、2048-QAM、4096-QAM整理

参考链接 什么是QAM?QAM是如何工作的? - 华为 不同阶QAM调制星座图中,符号能量的归一化计算原理 - 知乎 16 QAM modulation vs 64 QAM modulation vs 256 QAM modulation 512 QAM vs 1024 QAM vs 2048 QAM vs 4096 QAM modulation type…...

红黑树的平衡之舞:数据结构中的优雅艺术

文章目录 前言🚀一、红黑树的介绍1.1 红黑树的概念1.2 红黑树的特点1.3 红黑树的性质 🚀二、红黑树结点的定义🚀三、红黑树的框架🚀四、旋转操作🚀五、红黑树的插入操作5.1 uncle结点存在且为红5.2 uncle结点不存在或者…...

angular实现list列表和翻页效果

说明:angular实现list列表和翻页效果 上一页 当前页面 下一页 效果图: step1: E:\projectgood\ajnine\untitled4\src\app\car\car.component.css .example-form-fields {display: flex;align-items: flex-start; }mat-list-item{background: antiquew…...

闯关leetcode——3285. Find Indices of Stable Mountains

大纲 题目地址内容 解题代码地址 题目 地址 https://leetcode.com/problems/find-indices-of-stable-mountains/description/ 内容 There are n mountains in a row, and each mountain has a height. You are given an integer array height where height[i] represents t…...

算法【Java】—— 动态规划之斐波那契数列模型

动态规划 动态规划的思路一共有五个步骤: 状态表示:由经验和题目要求得出,这个确实有点抽象,下面的题目会带大家慢慢感受状态标识状态转移方程初始化:避免越界访问 dp 表,所以在进行填表之前我们要预先填…...

idea连接docker并构建镜像

安装docker 安装docker idea连接docker 安装docker插件 设置docker连接 设置docker.exe 这个docker.exe是为了运行docker,可以通过安装docker desktop获取 docker desktop下载地址 右键图标找到文件位置 在同级的resource中 编写Dockerfile # 使用官方 Nginx…...

百度如何打造AI原生研发新范式?

👉点击即可下载《百度AI原生研发新范式实践》资料 2024年10月23-25日,2024 NJSD技术盛典暨第十届NJSD软件开发者大会、第八届IAS互联网架构大会在南京召开。本届大会邀请了工业界和学术界的专家,优秀的工程师和产品经理,以及其它行…...

RedisTemplate类中的常用方法粗解(简单明了,预计5分钟看完)

在阅读项目代码过程中发现引用RedisTemplate 的方法操作redis时,都会有一些特定的ops ,对此好奇就查资料的情况下有了本博客。 操作之前付一张我们项目中的用到的地方的图 另外本文中的语言用到的是Java,附上试验用到的redisTemplete依赖 <…...

鸿蒙ArkTS中的布局容器组件(Column、Row、Flex、 Stack、Grid)

在鸿蒙ArkTS中,布局容器组件有很多,常见的有: ⑴ Column:(垂直布局容器):用于将子组件垂直排列。 ⑵ Row:(水平布局容器):用于将子组件水…...

显存占用 显存测试

目录 显存测试 显存占用示例 一个模型多卡占用 显存测试 import torch# 计算张量的大小(例如:每个 float 占用 4 字节) # 40GB 40 * 1024 * 1024 * 1024 字节 # 每个 float 4 字节,因此需要的 float 数量为 (40 * 1024 * 1024…...

快速入门CSS

欢迎关注个人主页:逸狼 创造不易,可以点点赞吗 如有错误,欢迎指出~ 目录 CSS css的三种引入方式 css书写规范 选择器分类 标签选择器 class选择器 id选择器 复合选择器 通配符选择器 color颜色设置 border边框设置 width/heigth 内/外边距 C…...

)

AcWing 1073 树的中心 树形dp (详解)

这道题目非常有新意,在过去,我们通常先访问子节点去更新父节点的状态,但是这道题我们还需要从父节点去更新子节点。 我们可以想象为向上和向下两个方向,我们任取一点,先向下走,再回来更新上面的点…...

modelscope下载Qwen2.5 72B 模型方法

conda create -n modelscope python=3.10 conda activate modelscopepip install modelscope执行这个python代码: from modelscope.hub.snapshot_download import snapshot_download# 下载模型到当前路径 model_dir = snapshot_download(...

重学SpringBoot3-整合 Elasticsearch 8.x (二)使用Repository

更多SpringBoot3内容请关注我的专栏:《SpringBoot3》 期待您的点赞👍收藏⭐评论✍ 整合 Elasticsearch 8.x (二)使用Repository 1. 环境准备1.1 项目依赖1.2 Elasticsearch 配置 2. 使用Repository的基本步骤2.1 创建实体类2.2 创…...

详解)

后进先出(LIFO)详解

LIFO 是 Last In, First Out 的缩写,中文译为后进先出。这是一种数据结构的工作原则,类似于一摞盘子或一叠书本: 最后放进去的元素最先出来 -想象往筒状容器里放盘子: (1)你放进的最后一个盘子(…...

day52 ResNet18 CBAM

在深度学习的旅程中,我们不断探索如何提升模型的性能。今天,我将分享我在 ResNet18 模型中插入 CBAM(Convolutional Block Attention Module)模块,并采用分阶段微调策略的实践过程。通过这个过程,我不仅提升…...

汽车生产虚拟实训中的技能提升与生产优化

在制造业蓬勃发展的大背景下,虚拟教学实训宛如一颗璀璨的新星,正发挥着不可或缺且日益凸显的关键作用,源源不断地为企业的稳健前行与创新发展注入磅礴强大的动力。就以汽车制造企业这一极具代表性的行业主体为例,汽车生产线上各类…...

oracle与MySQL数据库之间数据同步的技术要点

Oracle与MySQL数据库之间的数据同步是一个涉及多个技术要点的复杂任务。由于Oracle和MySQL的架构差异,它们的数据同步要求既要保持数据的准确性和一致性,又要处理好性能问题。以下是一些主要的技术要点: 数据结构差异 数据类型差异ÿ…...

VTK如何让部分单位不可见

最近遇到一个需求,需要让一个vtkDataSet中的部分单元不可见,查阅了一些资料大概有以下几种方式 1.通过颜色映射表来进行,是最正规的做法 vtkNew<vtkLookupTable> lut; //值为0不显示,主要是最后一个参数,透明度…...

汇编常见指令

汇编常见指令 一、数据传送指令 指令功能示例说明MOV数据传送MOV EAX, 10将立即数 10 送入 EAXMOV [EBX], EAX将 EAX 值存入 EBX 指向的内存LEA加载有效地址LEA EAX, [EBX4]将 EBX4 的地址存入 EAX(不访问内存)XCHG交换数据XCHG EAX, EBX交换 EAX 和 EB…...

省略号和可变参数模板

本文主要介绍如何展开可变参数的参数包 1.C语言的va_list展开可变参数 #include <iostream> #include <cstdarg>void printNumbers(int count, ...) {// 声明va_list类型的变量va_list args;// 使用va_start将可变参数写入变量argsva_start(args, count);for (in…...

第7篇:中间件全链路监控与 SQL 性能分析实践

7.1 章节导读 在构建数据库中间件的过程中,可观测性 和 性能分析 是保障系统稳定性与可维护性的核心能力。 特别是在复杂分布式场景中,必须做到: 🔍 追踪每一条 SQL 的生命周期(从入口到数据库执行)&#…...

uniapp 小程序 学习(一)

利用Hbuilder 创建项目 运行到内置浏览器看效果 下载微信小程序 安装到Hbuilder 下载地址 :开发者工具默认安装 设置服务端口号 在Hbuilder中设置微信小程序 配置 找到运行设置,将微信开发者工具放入到Hbuilder中, 打开后出现 如下 bug 解…...

JS红宝书笔记 - 3.3 变量

要定义变量,可以使用var操作符,后跟变量名 ES实现变量初始化,因此可以同时定义变量并设置它的值 使用var操作符定义的变量会成为包含它的函数的局部变量。 在函数内定义变量时省略var操作符,可以创建一个全局变量 如果需要定义…...