2024acl论文体悟

总结分析归纳

- 模型架构与训练方法:一些论文关注于改进大语言模型的架构和训练方法,以提高其性能和效率。例如,“Quantized Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models”提出了一种量化侧调优方法,通过量化模型权重和引入侧网络,实现了快速且内存高效的微调,显著降低了内存占用并加速了微调过程.

- 模型能力与局限性:研究者们试图深入理解大语言模型的能力和局限性。例如,“Why are Sensitive Functions Hard for Transformers?”从理论和实证角度探讨了Transformer架构在学习敏感函数时的困难,揭示了其在参数空间中的孤立点导致的低敏感性偏差,为理解Transformer的归纳偏差提供了新视角.

- 模型应用与任务:大语言模型在各种任务中的应用是研究的热点之一。例如,“Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?”关注于语音到文本翻译任务,提出了将语音基础模型和大语言模型结合的统一模型架构,分析了不同架构解决方案和训练策略的优缺点.

- 模型偏见与公平性:随着大语言模型应用的广泛,其潜在的偏见和公平性问题也受到了关注。例如,“Having Beer after Prayer? Measuring Cultural Bias in Large Language Models”通过构建CAMeL资源,测量了多语言和阿拉伯语单语言模型在阿拉伯和西方文化实体上的偏见,揭示了模型在跨文化任务中的刻板印象和文化不公平现象.

- 模型解释性与可理解性:提高大语言模型的解释性和可理解性是当前研究的重要方向。例如,“CausalGym: Benchmarking causal interpretability methods on linguistic tasks”引入了CausalGym工具,通过一系列任务来评估解释性方法对模型行为的因果影响,帮助研究者更好地理解模型的内部机制.

- 模型安全与伦理:大语言模型的安全和伦理问题也受到了重视。例如,“How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs”提出了一种新的视角,通过说服大语言模型来“越狱”,挑战了传统的人工智能安全研究,强调了非专家用户在日常交互中可能带来的风险.

当前研究热点

- 多模态与跨模态能力:随着多模态数据的日益丰富,研究者们开始探索大语言模型在多模态任务中的应用,如结合图像、文本、音频等多种模态的信息进行理解和生成,以实现更全面和准确的理解和表达.

- 模型的可解释性与透明度:为了提高大语言模型的可信度和可靠性,研究者们致力于提高模型的可解释性和透明度,通过各种解释性方法来揭示模型的决策过程和内部机制,帮助用户更好地理解和信任模型.

- 模型的公平性与偏见消除:随着大语言模型在社会各个领域的广泛应用,其潜在的偏见和不公平性问题也引起了广泛关注。研究者们正在探索各种方法来检测和消除模型中的偏见,以确保模型的公平性和公正性.

- 模型的安全与伦理:大语言模型的安全和伦理问题,如生成有害内容、被恶意利用等,也成为了研究的热点。研究者们正在研究如何提高模型的安全性,防止其被滥用,并探索相应的伦理规范和监管机制.

- 模型的资源效率与可扩展性:为了降低大语言模型的资源消耗和提高其可扩展性,研究者们正在探索各种方法来优化模型的架构和训练过程,如模型压缩、量化、稀疏化等,以实现更高效的模型训练和部署.

以下是文件中提到的每一篇论文的方向分析:

Best Paper Awards

- Mission: Impossible Language Models:语言模型学习能力研究,探讨大语言模型学习不可能语言的能力.

- Semisupervised Neural Proto-Language Reconstruction:历史语言学与神经网络结合,研究半监督的原始语言重建任务.

- Why are Sensitive Functions Hard for Transformers?:模型理论分析,研究Transformer架构在学习敏感函数时的困难和偏差.

- Natural Language Satisfiability: Exploring the Problem Distribution and Evaluating Transformer-based Language Models:自然语言推理与模型评估,研究自然语言可满足性问题及其对Transformer模型的影响.

- Deciphering Oracle Bone Language with Diffusion Models:古文字解读与图像生成模型,利用扩散模型解读甲骨文.

- Causal Estimation of Memorisation Profiles:模型记忆与因果推断,研究大语言模型的记忆过程和因果效应.

- Aya Model: An Instruction Finetuned Open-Access Multilingual Language Model:多语言模型与指令微调,开发面向多种语言的指令微调大语言模型.

Best Social Impact Paper Awards

- How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs:人工智能安全与伦理,研究如何通过说服大语言模型来挑战其安全性.

- DIALECTBENCH: An NLP Benchmark for Dialects, Varieties, and Closely-Related Languages:语言变体与基准测试,构建针对方言、变体和相关语言的NLP基准测试.

- Having Beer after Prayer? Measuring Cultural Bias in Large Language Models:模型偏见与文化公平性,测量大语言模型在不同文化背景下的偏见.

Best Resource Paper Awards

- Latxa: An Open Language Model and Evaluation Suite for Basque:低资源语言模型与评估,为巴斯克语开发大语言模型和评估套件.

- Dolma: an Open Corpus of Three Trillion Tokens for Language Model Pretraining Research:预训练语料库与模型研究,构建大规模开放语料库以支持语言模型预训练研究.

- AppWorld: A Controllable World of Apps and People for Benchmarking Interactive Coding Agents:交互式编程代理与基准测试,构建可控的App世界以评估交互式编程代理.

Best Theme Paper Awards

- OLMo: A Truly Open Language Model:开放语言模型与科学研究,构建真正开放的大语言模型以促进科学研究.

Outstanding Papers

- Quantized Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models:模型微调与效率优化,提出快速且内存高效的量化侧调优方法.

- L-Eval: Instituting Standardized Evaluation for Long Context Language Models:长文本评估与标准化,建立长文本上下文语言模型的标准化评估体系.

- Causal-Guided Active Learning for Debiasing Large Language Models:因果学习与模型去偏见,利用因果机制和主动学习来去偏见大语言模型.

- CausalGym: Benchmarking causal interpretability methods on linguistic tasks:因果解释性与语言任务,评估因果解释性方法在语言任务中的效果.

- Don’t Hallucinate, Abstain: Identifying LLM Knowledge Gaps via Multi-LLM Collaboration:模型知识识别与合作,通过多模型合作识别大语言模型的知识空白.

- Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?:语音翻译与模型结合,研究语音基础模型和大语言模型在语音翻译任务中的结合与不足.

- Must NLP be Extractive?:非提取式NLP与语言接触,探讨非提取式NLP方法和语言接触社区的语言技术应用.

- IRCoder: Intermediate Representations Make Language Models Robust Multilingual Code Generators:中间表示与多语言代码生成,利用中间表示提高语言模型的多语言代码生成能力.

- MultiLegalPile: A 689GB Multilingual Legal Corpus:法律语料库与模型预训练,构建多语言法律语料库并用于预训练NLP模型.

- PsySafe: A Comprehensive Framework for Psychological-based Attack, Defense, and Evaluation of Multi-agent System Safety:多智能体系统安全与心理学,提出基于心理学的多智能体系统安全框架.

- Can Large Language Models be Good Emotional Supporter? Mitigating Preference Bias on Emotional Support Conversation:情感支持对话与模型偏好,研究大语言模型在情感支持对话中的偏好偏差.

- Political Compass or Spinning Arrow? Towards More Meaningful Evaluations for Values and Opinions in Large Language Models:价值观评估与模型意见,探索大语言模型中价值观和意见的更有效评估方法.

- Same Task, More Tokens: the Impact of Input Length on the Reasoning Performance of Large Language Models:输入长度与模型推理,研究输入长度对大语言模型推理性能的影响.

- Do Llamas Work in English? On the Latent Language of Multilingual Transformers:多语言模型与潜在语言,研究多语言Transformer模型是否使用英语作为内部枢纽语言.

- Getting Serious about Humor: Crafting Humor Datasets with Unfunny Large Language Models:幽默检测与数据集构建,利用大语言模型生成合成数据以构建幽默检测数据集.

- Estimating the Level of Dialectness Predicts Inter-annotator Agreement in Multi-dialect Arabic Datasets:方言程度与标注一致性,研究阿拉伯语方言数据集中标注一致性与方言程度的关系.

- G-DIG: Towards Gradient-based DIverse and hiGh-quality Instruction Data Selection for Machine Translation:梯度引导与机器翻译,提出基于梯度的多样化和高质量指令数据选择方法.

- Media Framing: A typology and Survey of Computational Approaches Across Disciplines:媒体框架与计算方法,综述不同学科中媒体框架的计算方法.

- SPZ: A Semantic Perturbation-based Data Augmentation Method with Zonal-Mixing for Alzheimer’s Disease Detection:数据增强与疾病检测,提出基于语义扰动的数据增强方法用于阿尔茨海默病检测.

- Greed is All You Need: An Evaluation of Tokenizer Inference Methods:分词器推断与评估,评估不同分词器推断方法的性能.

- Language Complexity and Speech Recognition Accuracy: Orthographic Complexity Hurts, Phonological Complexity Doesn’t:语言复杂性与语音识别,研究语言复杂性对自动语音识别模型性能的影响.

- Steering Llama 2 via Contrastive Activation Addition:模型引导与激活添加,提出通过对比激活添加引导Llama 2模型的方法.

- EconAgent: Large Language Model-Empowered Agents for Simulating Macroeconomic Activities:宏观经济模拟与智能体,利用大语言模型增强智能体以模拟宏观经济活动.

- M4LE: A Multi-Ability Multi-Range Multi-Task Multi-Domain Long-Context Evaluation Benchmark for Large Language Models:长文本评估基准测试,构建多能力、多范围、多任务、多领域的长文本评估基准.

- CHECKWHY: Causal Fact Verification via Argument Structure:因果事实验证与论证结构,通过论证结构进行因果事实验证.

- On Efficient and Statistical Quality Estimation for Data Annotation:数据标注与质量估计,研究高效且具有统计质量保证的数据标注质量估计方法.

- Emulated Disalignment: Safety Alignment for Large Language Models May Backfire!:模型安全对齐与反向对齐,提出一种训练无关的反向对齐方法,可能使大语言模型的安全对齐适得其反.

- IndicLLMSuite: A Blueprint for Creating Pre-training and Fine-Tuning Datasets for Indian Languages:印度语言模型与数据集,为印度语言开发预训练和微调数据集的蓝图.

- MultiPICo: Multilingual Perspectivist Irony Corpus:多语言视角主义讽刺语料库,构建包含不同语言和语言变体的讽刺短对话多语言语料库.

- MMToM-QA: Multimodal Theory of Mind Question Answering:多模态心智理论问答,提出多模态心智理论问答基准测试.

- MAP’s not dead yet: Uncovering true language model modes by conditioning away degeneracy:MAP解码与模式去退化,通过条件去退化揭示自然语言生成模型的真实模式.

- NounAtlas: Filling the Gap in Nominal Semantic Role Labeling:名词语义角色标注与词典,填补名词语义角色标注的空白,构建名词谓词词典.

- The Earth is Flat because…: Investigating LLMs’ Belief towards Misinformation via Persuasive Conversation:模型信念与错误信息,研究大语言模型在说服对话中对错误信息的信念变化.

- Let’s Go Real Talk: Spoken Dialogue Model for Face-to-Face Conversation:面对面对话模型,介绍一种处理用户输入的音视频语音并生成音视频语音响应的面对面对话模型.

- Word Embeddings Are Steers for Language Models:词嵌入与模型引导,研究词嵌

入在线性变换下作为引导语言模型生成风格的作用. - SAC Awards:

- Deciphering Oracle Bone Language with Diffusion Models:古文字解读与图像生成模型,利用扩散模型解读甲骨文.

- Discursive Socratic Questioning: Evaluating the Faithfulness of Language Models’ Understanding of Discourse Relations:话语关系理解与苏格拉底式提问,通过苏格拉底式提问评估语言模型对话语关系理解的忠实度.

- RomanSetu: Efficiently unlocking multilingual capabilities of Large Language Models via Romanization:多语言能力与罗马化,通过罗马化文本提高大语言模型的多语言能力.

- Steering Llama 2 via Contrastive Activation Addition:模型引导与激活添加,提出通过对比激活添加引导Llama 2模型的方法.

- MAP’s not dead yet: Uncovering true language model modes by conditioning away degeneracy:MAP解码与模式去退化,通过条件去退化揭示自然语言生成模型的真实模式.

- Spiral of Silence: How is Large Language Model Killing Information Retrieval?—A Case Study on Open Domain Question Answering:信息检索与大语言模型,研究大语言模型对开放域问答任务中信息检索的影响.

- CausalGym: Benchmarking causal interpretability methods on linguistic tasks:因果解释性与语言任务,评估因果解释性方法在语言任务中的效果.

- COKE: A Cognitive Knowledge Graph for Machine Theory of Mind:认知知识图谱与心智理论,构建机器心智理论的认知知识图谱.

- Why are Sensitive Functions Hard for Transformers?:模型理论分析,研究Transformer架构在学习敏感函数时的困难和偏差.

- Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?:语音翻译与模型结合,研究语音基础模型和大语言模型在语音翻译任务中的结合与不足.

- AI ‘News’ Content Farms Are Easy to Make and Hard to Detect: A Case Study in Italian:内容农场与文本检测,研究意大利语内容农场的生成与检测.

- CaMML: Context-Aware Multimodal Learner for Large Models:上下文感知多模态学习,为大模型开发上下文感知多模态学习器.

- Greed is All You Need: An Evaluation of Tokenizer Inference Methods:分词器推断与评估,评估不同分词器推断方法的性能.

- Don’t Hallucinate, Abstain: Identifying LLM Knowledge Gaps via Multi-LLM Collaboration:模型知识识别与合作,通过多模型合作识别大语言模型的知识空白.

- VariErr NLI: Separating Annotation Error from Human Label Variation:标注错误与标签变异,区分自然语言推理任务中的标注错误与人类标签变异.

- Distributional Inclusion Hypothesis and Quantifications: Probing for Hypernymy in Functional Distributional Semantics:分布包含假设与量化,研究功能分布语义模型中的超义关系.

- MIDGARD: Self-Consistency Using Minimum Description Length for Structured Commonsense Reasoning:结构化常识推理与自一致性,利用最小描述长度实现结构化常识推理的自一致性.

- CHECKWHY: Causal Fact Verification via Argument Structure:因果事实验证与论证结构,通过论证结构进行因果事实验证.

- Language Complexity and Speech Recognition Accuracy: Orthographic Complexity Hurts, Phonological Complexity Doesn’t:语言复杂性与语音识别,研究语言复杂性对自动语音识别模型性能的影响.

- COSMIC: Mutual Information for Task-Agnostic Summarization Evaluation:任务不可知摘要评估与互信息,基于互信息提出任务不可知的摘要评估方法.

- Tree-Averaging Algorithms for Ensemble-Based Unsupervised Discontinuous Constituency Parsing:基于集成的非连续成分句法分析与树平均算法,提出基于树平均的集成非连续成分句法分析算法.

个人总结

一个是偏工业上的,让模型性能更好,一个感觉偏心理学,调教一个心理健康的ai智能,还有各种数据收集和处理,剩下的就是各种垂直领域。

相关文章:

2024acl论文体悟

总结分析归纳 模型架构与训练方法:一些论文关注于改进大语言模型的架构和训练方法,以提高其性能和效率。例如,“Quantized Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models”提出了一种量化侧调优方法&a…...

【Git原理与使用】版本回退reset 详细介绍、撤销修改、删除文件

目录 一、版本回退 reset 1.1 指令: 1.2 参数说明: 1.3 演示: 二、撤销修改 情况一:对于工作区的代码,还没有 add 情况二:已经 add ,但没有 commit 情况三:已经 add &…...

反规范化带来的数据不一致问题的解决方案

在数据库设计中,规范化(Normalization)和反规范化(Denormalization)是两个相互对立但又不可或缺的概念。规范化旨在消除数据冗余,确保数据的一致性和准确性,但可能会降低查询效率。相反…...

【Android】直接使用binder的transact来代替aidl接口

aidl提供了binder调用的封装,有的时候,比如: 1. 懒得使用aidl生成的接口文件(确实是懒,Android studio中aidl生成接口文件很方便) 2. 服务端的提供者只公开了部分接口出来,只给了调用编号和参…...

Python机器学习笔记(十八、交互特征与多项式特征)

添加原始数据的交互特征(interaction feature)和多项式特征(polynomial feature)可以丰富特征表示,特别是对于线性模型。这种特征工程可以用统计建模和许多实际的机器学习应用中。 上一次学习:线性模型对w…...

《跟我学Spring Boot开发》系列文章索引❤(2025.01.09更新)

章节文章名备注第1节Spring Boot(1)基于Eclipse搭建Spring Boot开发环境环境搭建第2节Spring Boot(2)解决Maven下载依赖缓慢的问题给火车头提提速第3节Spring Boot(3)教你手工搭建Spring Boot项目纯手工玩法…...

【AI进化论】 如何让AI帮我们写一个项目系列:将Mysql生成md文档

一、python脚本 下面给出一个简易 Python 脚本示例,演示如何自动获取所有表的结构,并生成一份 Markdown 文件。你可根据自己的需求做修改或使用其他编程语言。 import mysql.connector# ------------------------ # 1. 连接数据库 # -----------------…...

(已开源-AAAI25) RCTrans:雷达相机融合3D目标检测模型

在雷达相机融合三维目标检测中,雷达点云稀疏、噪声较大,在相机雷达融合过程中提出了很多挑战。为了解决这个问题,我们引入了一种新的基于query的检测方法 Radar-Camera Transformer (RCTrans)。具体来说: 首先设计了一个雷达稠密…...

Elasticsearch:在 HNSW 中提前终止以实现更快的近似 KNN 搜索

作者:来自 Elastic Tommaso Teofili 了解如何使用智能提前终止策略让 HNSW 加快 KNN 搜索速度。 在高维空间中高效地找到最近邻的挑战是向量搜索中最重要的挑战之一,特别是当数据集规模增长时。正如我们之前的博客文章中所讨论的,当数据集规模…...

unittest VS pytest

以下是 unittest 和 pytest 框架的对比表格: 特性unittestpytest设计理念基于类的设计,类似于 Java 的 JUnit更简洁,基于函数式编程设计,支持类和函数两种方式测试编写需要继承 unittest.TestCase 类,方法以 test_ 开…...

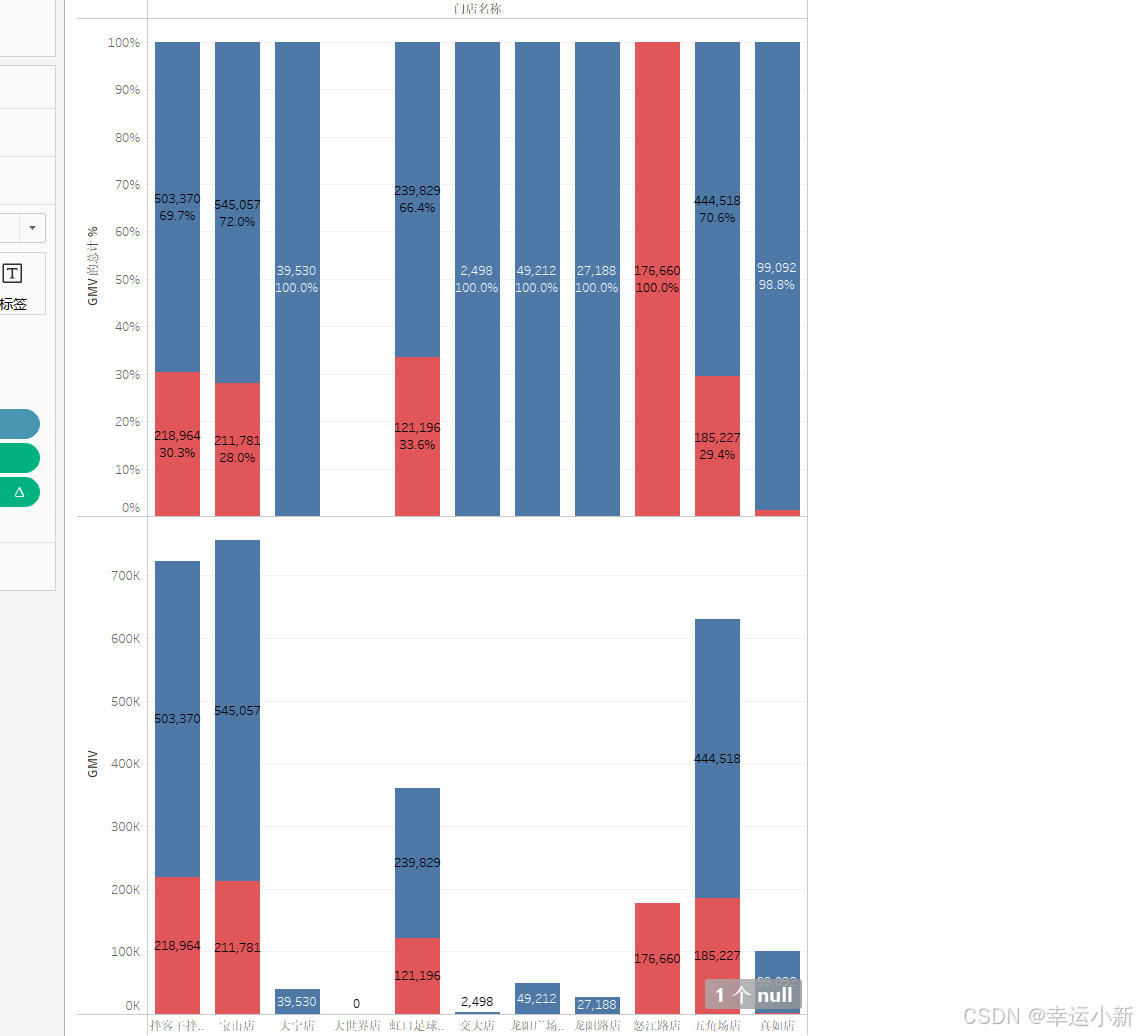

Tableau数据可视化与仪表盘搭建-基础图表制作

目录 对比分析:比大小 柱状图 条形图 数据钻取 筛选器 热力图 气泡图 变化分析:看趋势 折线图 预测 面积图 关系分布:看位置 散点图 直方图 地图 构成分析:看占比 饼图 树地图 堆积图 对比分析:比大…...

Center Loss 和 ArcFace Loss 笔记

一、Center Loss 1. 定义 Center Loss 旨在最小化类内特征的离散程度,通过约束样本特征与其类别中心之间的距离,提高类内特征的聚合性。 2. 公式 对于样本 xi 和其类别yi,Center Loss 的公式为: xi: 当前样本的特征向量&…...

3125: 【入门】求1/1+1/2+2/3+3/5+5/8+8/13+13/21……的前n项的和

文章目录 题目描述输入输出样例输入样例输出 题目描述 求1/11/22/33/55/88/1313/2121/34……的前n项的和。 输入 第1行:一个整数n(1 < n < 30 )。 输出 一行:一个小数,即前n项之和(保留3位小数&…...

如何确保获取的淘宝详情页数据的准确性和时效性?

要确保获取的淘宝详情页数据的准确性和时效性,可从以下几个方面着手: 合法合规获取数据 遵守平台规则:在获取淘宝详情页数据之前,务必仔细阅读并严格遵守淘宝平台的使用协议和相关规定。明确哪些数据可以获取、以何种方式获取以及…...

云计算是如何帮助企业实现高可用性的

想象一下,你正在享受一个悠闲的周末,突然接到同事的电话:公司的核心系统宕机了!这个场景对很多IT从业者来说并不陌生。但在云计算时代,这样的噩梦正在逐渐远去。 一位前辈告诉我:"在技术世界里&#…...

143.《python中使用pymongo》

文章目录 pymongo安装pymongo连接数据库mongodb操作创建数据库判断数据库是否存在创建集合判断集合是否已经存在插入集合插入一条多条插入 查询数据查询一条数据查询所有数据查询指定字段的数据统计查询统计所有记录数按条件统计记录数分页列表查询比较查询$eq$gt$gte$in$lt$lt…...

Babylon.js 的 Mesh 与 Unity 的 GameObject:深入对比与分析

在 3D 开发领域,Babylon.js 和 Unity 是两款极具影响力的引擎,分别在 Web 平台和游戏开发领域占据重要地位。要深入理解这两款引擎的异同,从其核心对象——Babylon.js 的 Mesh 和 Unity 的 GameObject ——入手进行对比,是…...

MySQL安装,配置教程

一、Linux在线yum仓库安装 打开MySQL官方首页,链接为:https://www.mysql.com/ 界面如下: 在该页面中找到【DOWNOADS】选项卡,点击进入下载页面。 在下载界面中,可以看到不同版本的下载链接,这里选择【My…...

)

Android折叠屏适配(权宜之计)

现在折叠屏手机出了也有一段时间了,但是除了大厂app,其他app适配折叠屏还是比较少,如果真的想做好折叠屏完全适配,那这个文章可能并不适合,这里只是一个简单适配的思路。 如果原先你的app已经适配了平板,那…...

Spark是什么?Flink和Spark区别

Spark是什么?Flink和Spark区别 一、Spark二、Spark和Flink区别三、总结 一、Spark Apache Spark 是一个开源的大数据处理框架,主要用于大规模数据处理和分析。它支持多种数据处理模式,包括批处理、流处理、SQL 查询、机器学习和图处理等。 核…...

【WiFi帧结构】

文章目录 帧结构MAC头部管理帧 帧结构 Wi-Fi的帧分为三部分组成:MAC头部frame bodyFCS,其中MAC是固定格式的,frame body是可变长度。 MAC头部有frame control,duration,address1,address2,addre…...

基于Docker Compose部署Java微服务项目

一. 创建根项目 根项目(父项目)主要用于依赖管理 一些需要注意的点: 打包方式需要为 pom<modules>里需要注册子模块不要引入maven的打包插件,否则打包时会出问题 <?xml version"1.0" encoding"UTF-8…...

基础光照(Basic Lighting))

C++.OpenGL (10/64)基础光照(Basic Lighting)

基础光照(Basic Lighting) 冯氏光照模型(Phong Lighting Model) #mermaid-svg-GLdskXwWINxNGHso {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-GLdskXwWINxNGHso .error-icon{fill:#552222;}#mermaid-svg-GLd…...

多模态大语言模型arxiv论文略读(108)

CROME: Cross-Modal Adapters for Efficient Multimodal LLM ➡️ 论文标题:CROME: Cross-Modal Adapters for Efficient Multimodal LLM ➡️ 论文作者:Sayna Ebrahimi, Sercan O. Arik, Tejas Nama, Tomas Pfister ➡️ 研究机构: Google Cloud AI Re…...

高防服务器能够抵御哪些网络攻击呢?

高防服务器作为一种有着高度防御能力的服务器,可以帮助网站应对分布式拒绝服务攻击,有效识别和清理一些恶意的网络流量,为用户提供安全且稳定的网络环境,那么,高防服务器一般都可以抵御哪些网络攻击呢?下面…...

学习STC51单片机32(芯片为STC89C52RCRC)OLED显示屏2

每日一言 今天的每一份坚持,都是在为未来积攒底气。 案例:OLED显示一个A 这边观察到一个点,怎么雪花了就是都是乱七八糟的占满了屏幕。。 解释 : 如果代码里信号切换太快(比如 SDA 刚变,SCL 立刻变&#…...

USB Over IP专用硬件的5个特点

USB over IP技术通过将USB协议数据封装在标准TCP/IP网络数据包中,从根本上改变了USB连接。这允许客户端通过局域网或广域网远程访问和控制物理连接到服务器的USB设备(如专用硬件设备),从而消除了直接物理连接的需要。USB over IP的…...

CRMEB 中 PHP 短信扩展开发:涵盖一号通、阿里云、腾讯云、创蓝

目前已有一号通短信、阿里云短信、腾讯云短信扩展 扩展入口文件 文件目录 crmeb\services\sms\Sms.php 默认驱动类型为:一号通 namespace crmeb\services\sms;use crmeb\basic\BaseManager; use crmeb\services\AccessTokenServeService; use crmeb\services\sms\…...

WebRTC从入门到实践 - 零基础教程

WebRTC从入门到实践 - 零基础教程 目录 WebRTC简介 基础概念 工作原理 开发环境搭建 基础实践 三个实战案例 常见问题解答 1. WebRTC简介 1.1 什么是WebRTC? WebRTC(Web Real-Time Communication)是一个支持网页浏览器进行实时语音…...

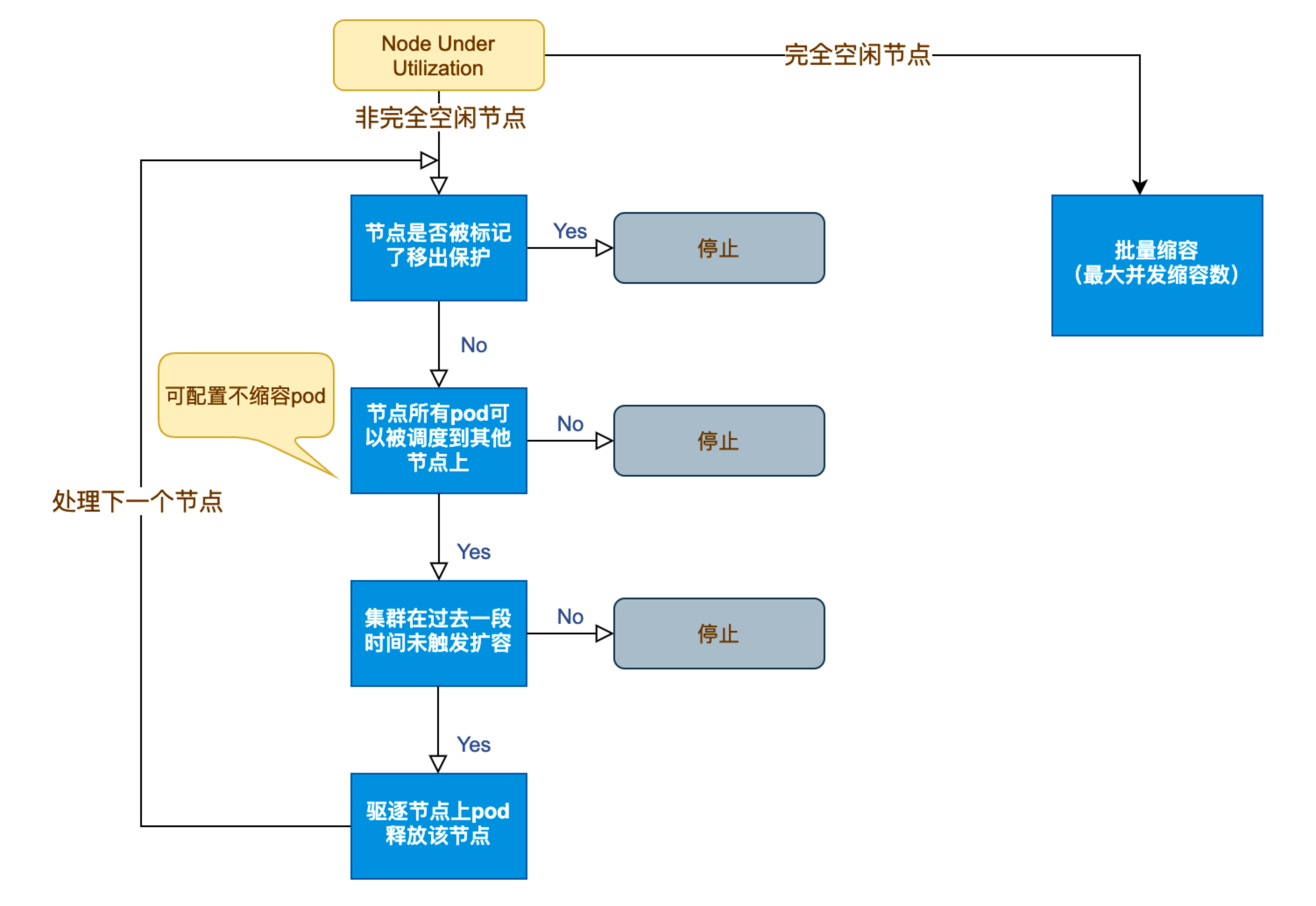

Kubernetes 节点自动伸缩(Cluster Autoscaler)原理与实践

在 Kubernetes 集群中,如何在保障应用高可用的同时有效地管理资源,一直是运维人员和开发者关注的重点。随着微服务架构的普及,集群内各个服务的负载波动日趋明显,传统的手动扩缩容方式已无法满足实时性和弹性需求。 Cluster Auto…...