深度学习 - 43.SeNET、Bilinear Interaction 实现特征交叉 By Keras

目录

一.引言

二.SENET Layer

1.简介

2.Keras 实现

2.1 Init Function

2.2 Build Function

2.3 Call Function

2.4 Test Main Function

2.5 完整代码

三.BiLinear Intercation Layer

1.简介

2.Keras 实现

2.1 Init Function

2.2 Build Function

2.3 Call Function

2.4 Test Main Function

2.5 完整代码

四.总结

一.引言

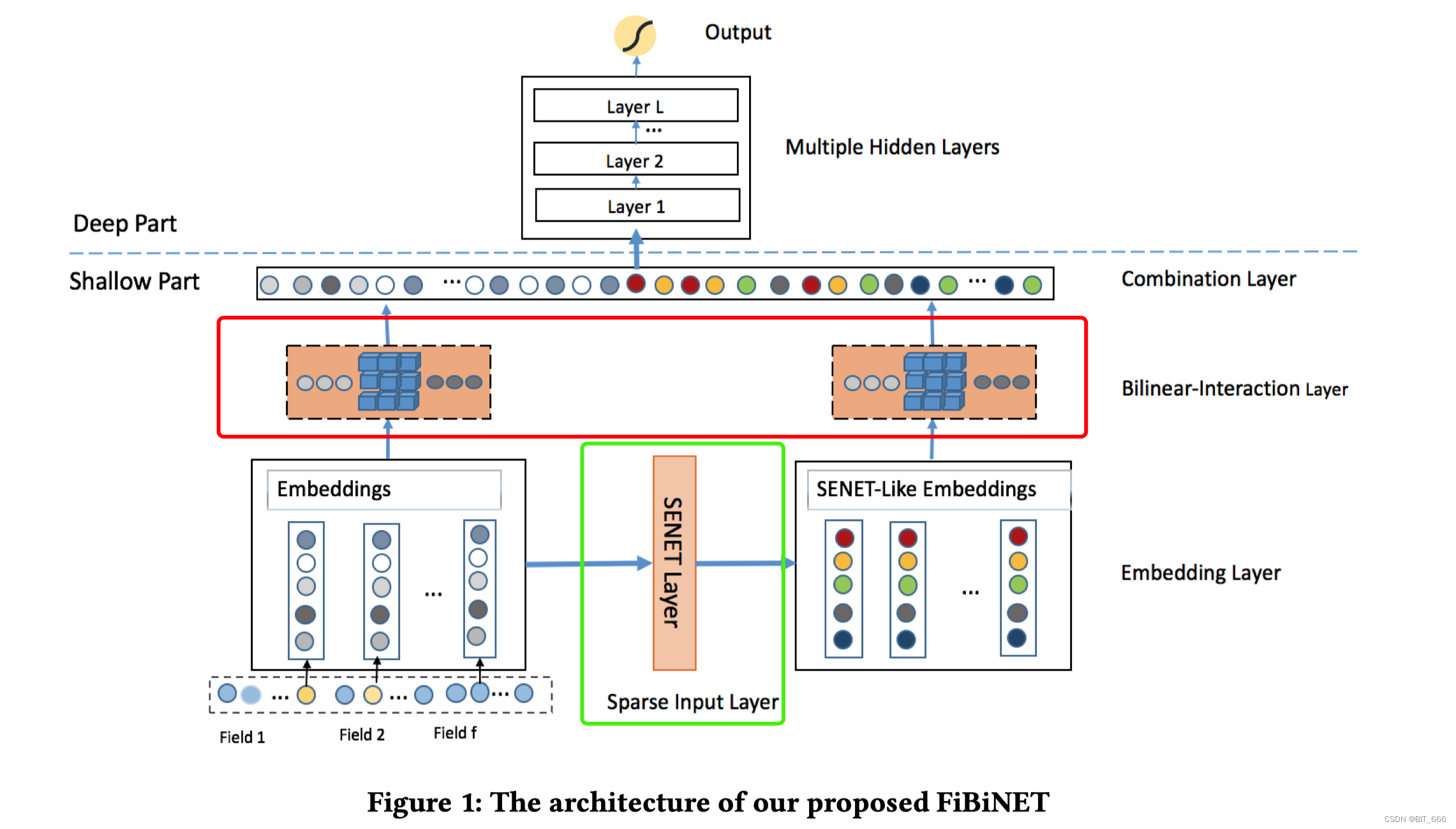

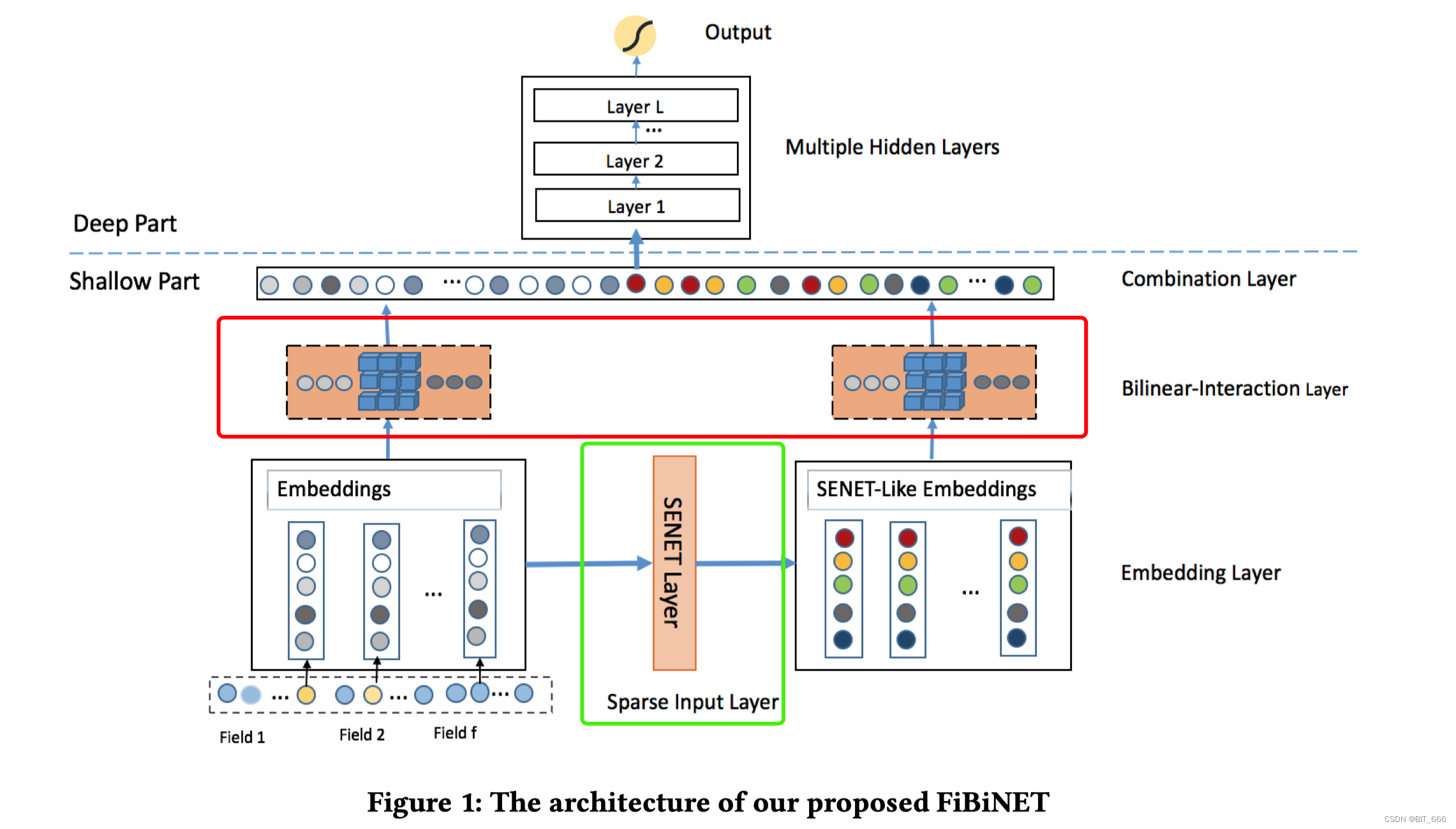

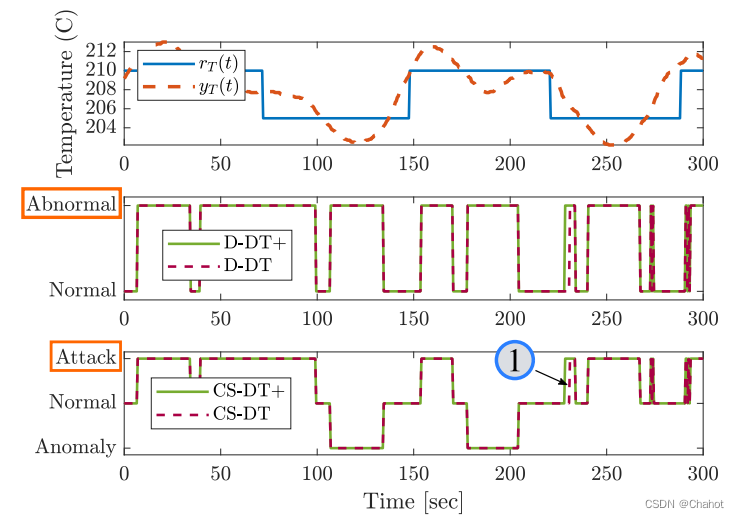

上一篇文章我们对 FiBiNet 网络做了全面的了解,其引入 SENET 与 BiLinear Interaction 实现特征交叉,实验表明 FiBiNet 在浅层网络效果优于 FM、FFM,在深层网络效果优于 DeepFm、XdeepFm。本文用 kears 实现基本的 SENET Layer 与 Bilinear Interaction Layer。

二.SENET Layer

1.简介

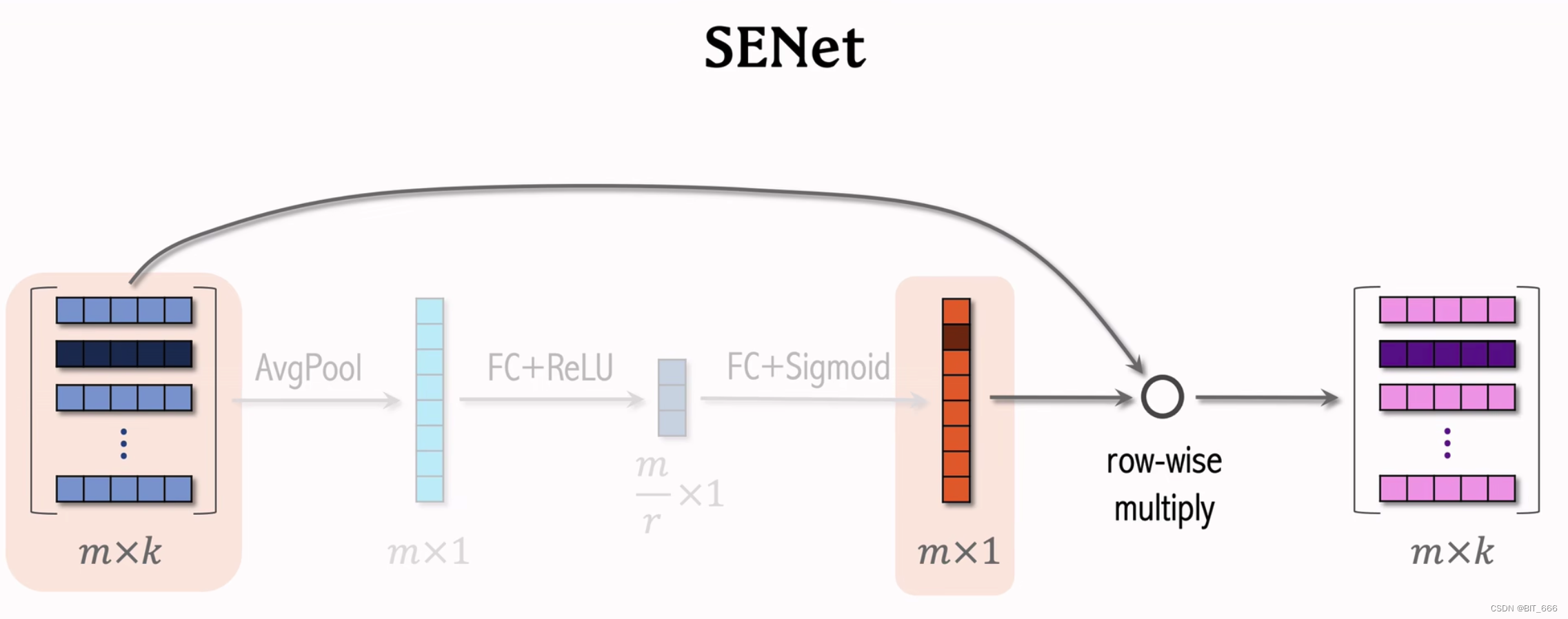

SENet 全称为 Squeeze-and-Excitation Networks, 可翻译为压缩与激励网络。

实现流程:

AvgPool 平均池化 => FC + σ 全连接激活 => FC + σ 全连接激活 => Multiply 加权

![]()

这里第一个激活函数 σ 为 ReLU,第二个激活函数有的使用 Sigmoid 有的使用 ReLU。

2.Keras 实现

2.1 Init Function

def __init__(self, reduction_ratio=3, **kwargs):self.field_size = Noneself.embedding_size = Noneself.dense1 = Noneself.dense2 = Noneself.reduction_ratio = reduction_ratiosuper(SETNetLayer, self).__init__(**kwargs)初始化函数主要定义 SENET 需要的变量,主要是 Field 数量,Embedding 嵌入维度以及 Squeeze 挤压和 Excitation 激发对应的两个 Full Connect 全连接 Dense 层以及对应的 Squeeze 参数 reduction_ratio。

2.2 Build Function

def build(self, input_shape):self.field_size, self.embedding_size = input_shapereduction_size = max(1, self.field_size // self.reduction_ratio)self.dense1 = Dense(reduction_size, activation='relu', kernel_initializer=glorot_normal_initializer)self.dense2 = Dense(self.field_size, activation='sigmoid', kernel_initializer=glorot_normal_initializer)super(SETNetLayer, self).build(input_shape)这里没有调用 add_weight 方法初始化参数矩阵,直接使用 layer 层下的 Dense 层初始化。

2.3 Call Function

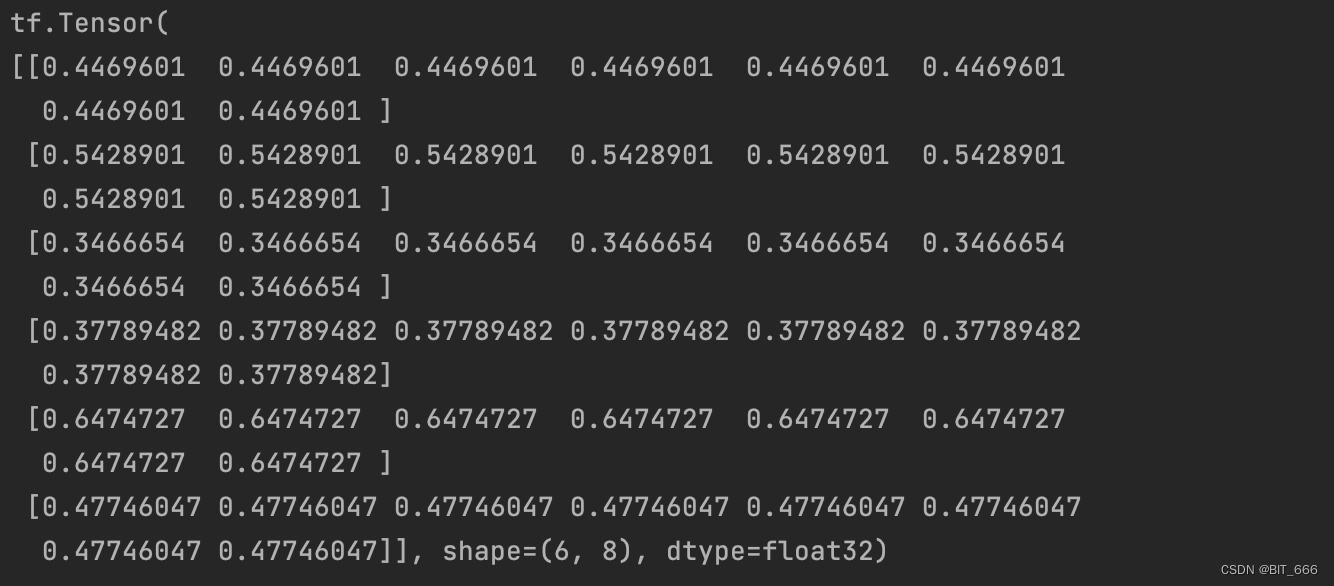

def call(self, inputs, training=None, **kwargs):# inputs = F x Kmean_pooling = tf.expand_dims(tf.reduce_mean(inputs, axis=-1), axis=0) # 1 x Fcompression = self.dense1(mean_pooling) # 1 x reductionreconstruction = self.dense2(compression) # 1 x Fadd_weight = tf.squeeze(tf.multiply(inputs, tf.expand_dims(reconstruction, axis=2))) # F x Kreturn add_weight原始维度为 FxK,F 为 Field_size、K 为 Embedding_dim 输入输出,加权后输出维度仍然为 FxK。

2.4 Test Main Function

if __name__ == '__main__':# 数据准备F = 6 # Field 数量K = 8 # 特征维度samples = np.ones(shape=(F, K))seNetLayer = SETNetLayer()output = seNetLayer(samples)print(output)实际场景同可以通过引入 SENET 达到动态更新 Field 重要性的目的。

2.5 完整代码

import numpy as np

import tensorflow as tf

from tensorflow.python.keras.layers import *

from tensorflow.keras.layers import Layer

from tensorflow.python.ops.init_ops import glorot_normal_initializerclass SETNetLayer(Layer):def __init__(self, reduction_ratio=3, **kwargs):self.field_size = Noneself.embedding_size = Noneself.dense1 = Noneself.dense2 = Noneself.reduction_ratio = reduction_ratiosuper(SETNetLayer, self).__init__(**kwargs)def build(self, input_shape):self.field_size, self.embedding_size = input_shapereduction_size = max(1, self.field_size // self.reduction_ratio)self.dense1 = Dense(reduction_size, activation='relu', kernel_initializer=glorot_normal_initializer)self.dense2 = Dense(self.field_size, activation='sigmoid', kernel_initializer=glorot_normal_initializer)super(SETNetLayer, self).build(input_shape)def call(self, inputs, training=None, **kwargs):# inputs = F x Kmean_pooling = tf.expand_dims(tf.reduce_mean(inputs, axis=-1), axis=0) # 1 x Fcompression = self.dense1(mean_pooling) # 1 x reductionreconstruction = self.dense2(compression) # 1 x Fadd_weight = tf.squeeze(tf.multiply(inputs, tf.expand_dims(reconstruction, axis=2))) # F x Kreturn add_weightdef compute_output_shape(self, input_shape):return input_shapeif __name__ == '__main__':# 数据准备F = 6 # Field 数量K = 8 # 特征维度samples = np.ones(shape=(F, K))seNetLayer = SETNetLayer()output = seNetLayer(samples)print(output)三.BiLinear Intercation Layer

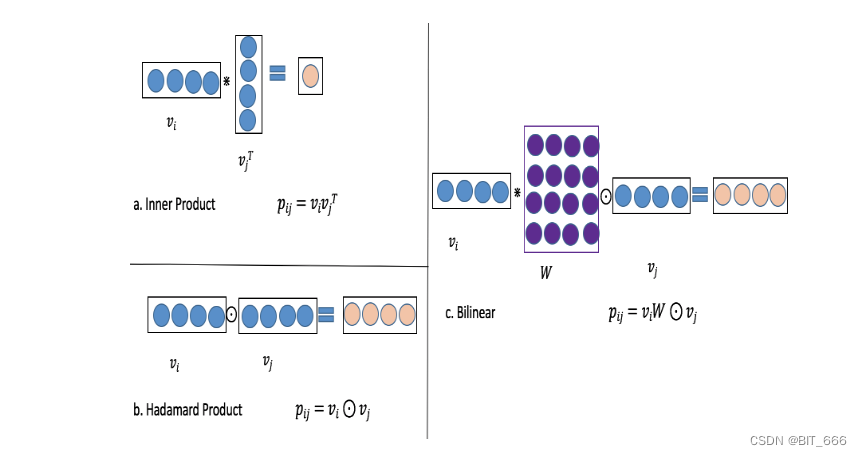

1.简介

BiLinear Inteaction Layer 引入参数交叉矩阵实现 i、j 特征之间的交互代替原有的内积或哈达玛积,其中共设计了三种模式:

- Filed All Type

所有交叉特征共享一个 kxk 的参数矩阵

- Field Each Type

每个 Field 一个参数矩阵 Wi ∈ R kxk

- Field Interaction Type

每个交叉特征 i、j 一个参数矩阵 W i,j ∈ R kxk

2.Keras 实现

2.1 Init Function

def __init__(self, biLinear_type='all', seed=1024, **kwargs):self.biLinear_type = biLinear_typeself.seed = seedself.field_size = Noneself.embedding_size = Noneself.W = Noneself.W_list = Nonesuper(BiLinearInteraction, self).__init__(**kwargs)biLinear_type 控制特征交互方式,Filed_size 为特征数量,Embedding_size 为嵌入维度,Filed-All-Type 场景下使用单一 W 参数矩阵,Field-Each-Type 和 Field-Interaction-Type 使用 W_list 多参数矩阵的形式,前者 W 个数为 Field 个,后者为 (F-1)·F / 2 个。

2.2 Build Function

def build(self, input_shape):self.field_size, self.embedding_size = input_shapeif self.biLinear_type == "all":self.W = self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight")elif self.biLinear_type == "each":self.W_list = [self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight" + str(i)) for i in range(self.field_size)]elif self.biLinear_type == "interaction":self.W_list = [self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight" + str(i) + '_' + str(j)) for i, j initertools.combinations(range(self.field_size), 2)]else:raise NotImplementedErrorsuper(BiLinearInteraction, self).build(input_shape)根据 input_shape 解析得到 Field_size 和 Embedding_size,根据 biLinear_type 的不同,初始化不同的参数矩阵 W 与 W_list,itertools.combinations 方法用于生成所有 Filed 的组合。

2.3 Call Function

def call(self, inputs, **kwargs):n = len(inputs)if self.biLinear_type == "all":# 所有特征交叉公用一个参数矩阵 Wv_dots = [tf.tensordot(inputs[i], self.W, axes=(-1, 0)) for i in range(n)] # F x Kp = [tf.multiply(v_dots[i], inputs[j]) for i, j in itertools.combinations(range(n), 2)] # (F-1)·F/2 x Kelif self.biLinear_type == "each":# 每个特征一个参数矩阵 Wiv_dots = [tf.tensordot(inputs[i], self.W_list[i], axes=(-1, 0)) for i in range(n)] # F x Kp = [tf.multiply(v_dots[i], inputs[j]) for i, j in itertools.combinations(range(n), 2)] # (F-1)·F/2 x Kelif self.biLinear_type == "interaction":# 每一个组合特征 Vi-Vj 以及对应的 Wijp = [tf.multiply(tf.tensordot(v[0], w, axes=(-1, 0)), v[1])for v, w in zip(itertools.combinations(inputs, 2), self.W_list)] # (F-1)·F/2 x Kelse:raise NotImplementedError# (F-1)·F/2 x K_output = tf.reshape(p, shape=(-1, int(self.embedding_size)))return _output分别执行内积与哈达玛积,区别是交互的 W 参数矩阵不同,这里与 SENET 不同,SENET 输入输出维度相同,BiLinear Interaction Layer 输入 F x K,输出 (F-1)·F / 2 x K,因为前者是对 Field 的交叉,后者是对每一个 FF 特征的交叉。

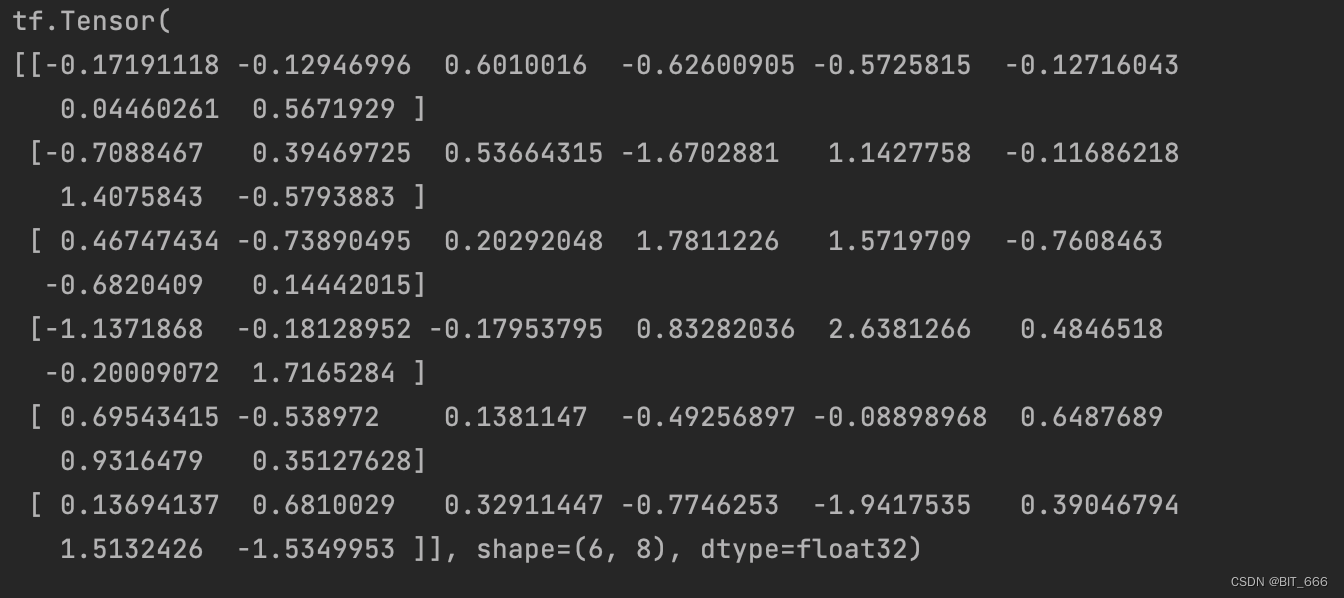

2.4 Test Main Function

if __name__ == '__main__':# 数据准备F = 4 # Field 数量K = 8 # 特征维度samples = np.ones(shape=(F, K))BiLinearLayer = BiLinearInteraction("interaction")output = BiLinearLayer(samples)print(output)F = 4,K = 8,所以输出 6x8。

2.5 完整代码

import itertoolsimport numpy as np

import tensorflow as tf

from tensorflow.keras.layers import Layer

from tensorflow.python.ops.init_ops import glorot_normal_initializerclass BiLinearInteraction(Layer):def __init__(self, biLinear_type='interaction', seed=1024, **kwargs):self.biLinear_type = biLinear_typeself.seed = seedself.field_size = Noneself.embedding_size = Noneself.W = Noneself.W_list = Nonesuper(BiLinearInteraction, self).__init__(**kwargs)def build(self, input_shape):self.field_size, self.embedding_size = input_shapeif self.biLinear_type == "all":self.W = self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight")elif self.biLinear_type == "each":self.W_list = [self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight" + str(i)) for i in range(self.field_size)]elif self.biLinear_type == "interaction":self.W_list = [self.add_weight(shape=(self.embedding_size, self.embedding_size),initializer=glorot_normal_initializer(seed=self.seed),name="biLinearWeight" + str(i) + '_' + str(j)) for i, j initertools.combinations(range(self.field_size), 2)]else:raise NotImplementedErrorsuper(BiLinearInteraction, self).build(input_shape)def call(self, inputs, **kwargs):n = len(inputs)if self.biLinear_type == "all":# 所有特征交叉公用一个参数矩阵 Wv_dots = [tf.tensordot(inputs[i], self.W, axes=(-1, 0)) for i in range(n)] # F x Kp = [tf.multiply(v_dots[i], inputs[j]) for i, j in itertools.combinations(range(n), 2)] # (F-1)·F/2 x Kelif self.biLinear_type == "each":# 每个特征一个参数矩阵 Wiv_dots = [tf.tensordot(inputs[i], self.W_list[i], axes=(-1, 0)) for i in range(n)] # F x Kp = [tf.multiply(v_dots[i], inputs[j]) for i, j in itertools.combinations(range(n), 2)] # (F-1)·F/2 x Kelif self.biLinear_type == "interaction":# 每一个组合特征 Vi-Vj 以及对应的 Wijp = [tf.multiply(tf.tensordot(v[0], w, axes=(-1, 0)), v[1])for v, w in zip(itertools.combinations(inputs, 2), self.W_list)] # (F-1)·F/2 x Kelse:raise NotImplementedError# (F-1)·F/2 x K_output = tf.reshape(p, shape=(-1, int(self.embedding_size)))return _outputif __name__ == '__main__':# 数据准备F = 4 # Field 数量K = 8 # 特征维度samples = np.ones(shape=(F, K))BiLinearLayer = BiLinearInteraction("interaction")output = BiLinearLayer(samples)print(output)四.总结

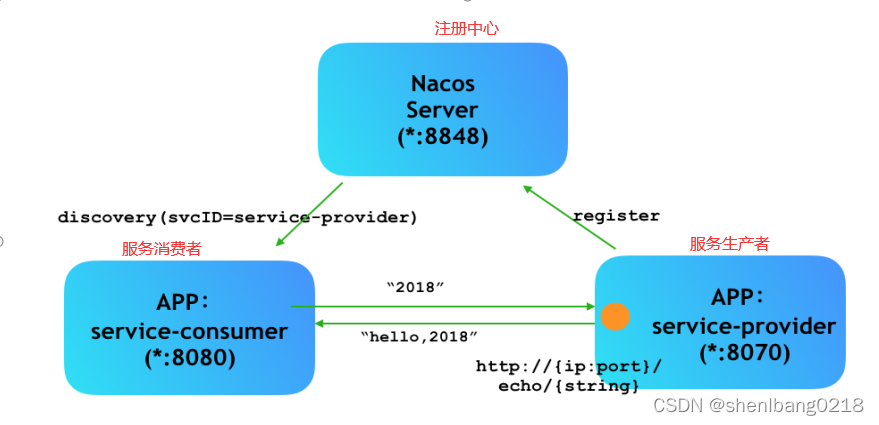

如果我们去掉 SENET 层和双线性交互层,我们的浅 FiBiNET 和深 FiBiNET 将降级为 FM 和FNN,为了进一步提高性能,将上述浅层模型与 DNN 结合得到 FiBiNet 由于 DeepFm 和 XdeepFm 等深层模型。上图为 FiBiNet 模型架构,其中绿框部分为 SENET Layer,红框部门为 Bilinear-Interaction Layer,剩下的 Combination Layer 和 DNN 的构建比较基础,有兴趣的同学可以自己实现 FiBiNet。

相关文章:

深度学习 - 43.SeNET、Bilinear Interaction 实现特征交叉 By Keras

目录 一.引言 二.SENET Layer 1.简介 2.Keras 实现 2.1 Init Function 2.2 Build Function 2.3 Call Function 2.4 Test Main Function 2.5 完整代码 三.BiLinear Intercation Layer 1.简介 2.Keras 实现 2.1 Init Function 2.2 Build Function 2.3 Call Functi…...

Ceph入门到精通-Cephadm安装Ceph(v17.2.5 Quincy)全网最全版本

Deploy Ceph(v17.2.5 Quincy) cluster to use Cephadm - DevOps - dbaselife Install cephadm Cephadm creates a new Ceph cluster by “bootstrapping” on a single host, expanding the cluster to encompass any additional hosts, and then depl…...

BIOS与POST自检

一、什么是BIOS BIOS是英文"BasicInput-Output System",中文名称就是"基本输入输出系统",是集成在主板上的一个ROM芯片,意思是只读存储器基本输入输出系统。顾名思义,它保存着计算机最重要的基本输入输出的程…...

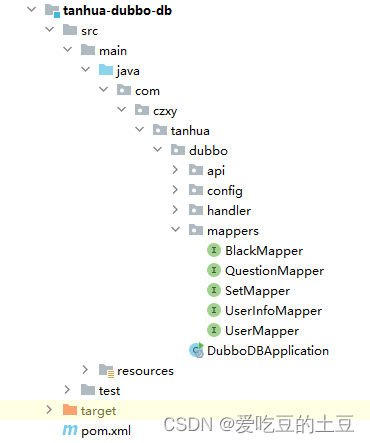

交友项目【查询好友动态,查询推荐动态】实现

目录 1:圈子 1.1:查询好友动态 1.1.1:接口分析 1.1.2:流程分析 1.1.2:代码实现 1.2:查询推荐动态 1.2.1:接口分析 1.2.2:流程分析 1.2.3:代码实现 1:…...

24个强大的HTML属性,建议每位前端工程师都应该掌握!

HTML属性非常多,除了一些基础属性外,还有许多有用的特别强大的属性 本文将介绍24个强大的HTML属性,可以使您的网站更具有动态性和交互性,让用户感到更加舒适和愉悦。 让我们一起来探索这24个强大的HTML属性吧! 1、Acc…...

前端--移动端布局--2移动开发之flex布局

目标: 能够说出flex盒子的布局原理 能够使用flex布局的常用属性 能够独立完成携程移动端首页案例 目录: flex布局体验 flex布局原理 flex布局父项常见属性 flex布局子项常见属性 写出网首页案例制作 1.flex布局体验 1.1传统布局与flex布局 传…...

【移动端网页布局】移动端网页布局基础概念 ① ( 移动端浏览器 | 移动端屏幕分辨率 | 移动端网页调试方法 )

文章目录 一、移动端浏览器二、移动端屏幕分辨率三、移动端网页调试方法 一、移动端浏览器 移动端浏览器 比 PC 端浏览器发展要晚 , 使用的技术比较新 , 对 HTML5 CSS3 支持较好 , 常见的浏览器如下 : UC / QQ / Opera / Chrom / 360 / 百度 / 搜狗 / 猎豹 国内的浏览器 基本…...

无线洗地机哪款性价比高?高性价比的洗地机分享

虽说现在市面上清洁工具很多,但是要说清洁效果最好的,肯定非洗地机莫属。它集合了吸,洗,拖三大功能,干湿垃圾一次清理,还能根据地面的脏污程度进行清洁,达到极致的清洁效果,省时省力…...

精通 Python OpenCV4:第三、四部分

原文:Mastering OpenCV 4 with Python 协议:CC BY-NC-SA 4.0 译者:飞龙 本文来自【ApacheCN 计算机视觉 译文集】,采用译后编辑(MTPE)流程来尽可能提升效率。 当别人说你没有底线的时候,你最好真…...

在现成的3D打印机上进行实验理论:一种数据孪生的攻击探测框架

在现成的3D打印机上提供了一种DT中攻击探测框架的DT解决方案的实验演示,作为说明性CPMS资源。通过网络安全DT对打印机正常运行、异常运行和攻击三种情况下的实验数据进行收集和分析,得出攻击检测结果。实验装置概述如下图所示。该实验研究是在现实世界设…...

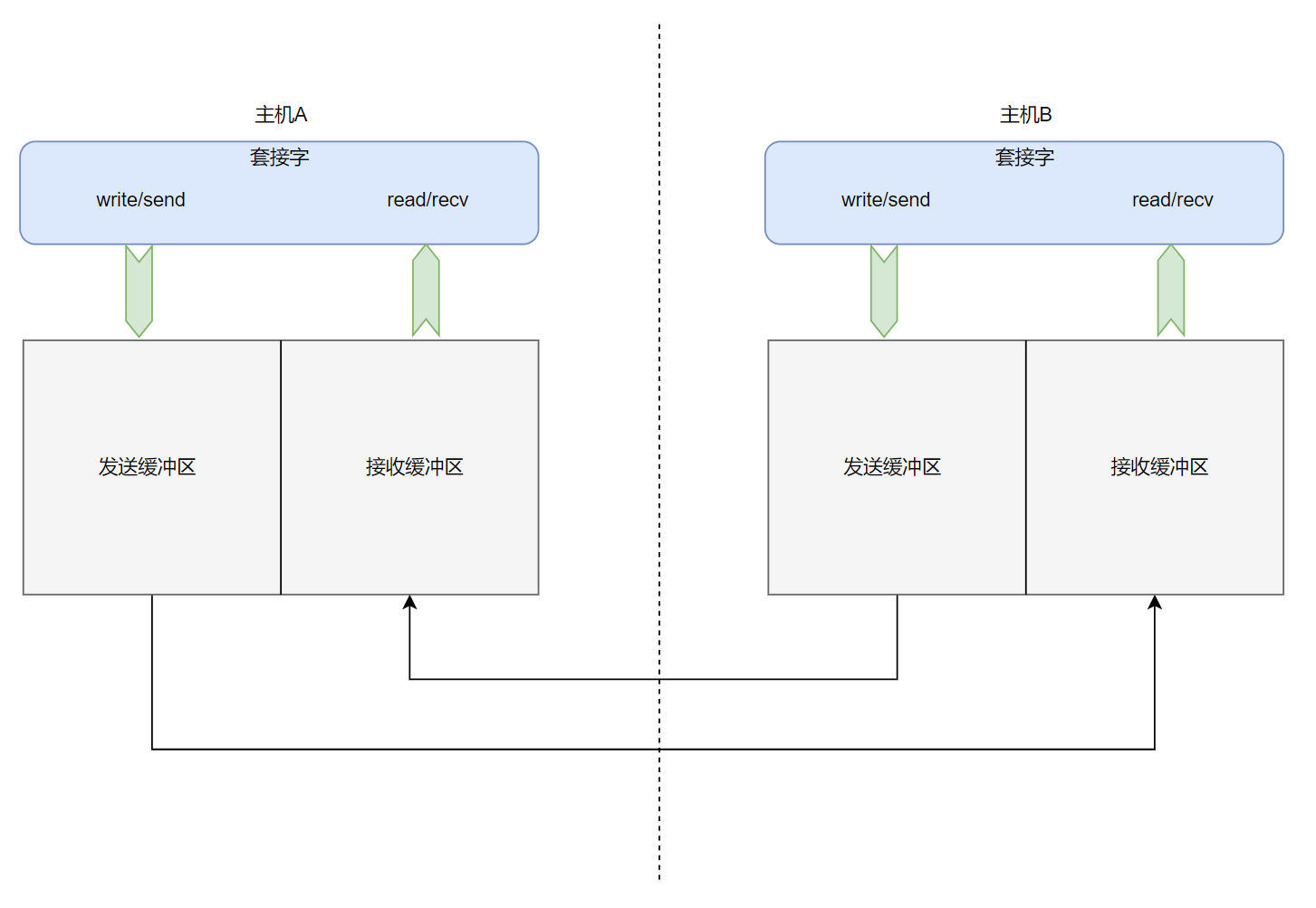

网络通信之传输层协议

文章目录 传输层在网络通信中扮演的角色认识TCP协议TCP协议的多种机制确认应答(ACK)机制超时重传机制连接管理机制🔺滑动窗口流量控制拥塞控制延迟应答捎带应答面向字节流粘包问题TCP异常处理 总结 传输层在网络通信中扮演的角色 上图是网络通信中五个模块ÿ…...

短视频app开发:如何提高视频播放稳定性

简介 如今,短视频已经成为人们日常生活中不可或缺的一部分,而短视频app的开发也日益成为了人们热议的话题。在短视频app开发的过程中,如何提高视频播放稳定性是一个非常重要的问题。本文将从短视频源码角度出发,分享提高短视频ap…...

软件测试,想找一份20k以上的工作需要掌握哪些知识?

都知道IT行业是高薪人员的聚集地,但想要成为高薪程序员却并不容易。月薪20k是测试工程师的一个门槛,想要突破就必须掌握更多的技能。 因为程序员职业发展很快,即使是相同起点的人,经过几年的工作或学习,会迅速拉开极…...

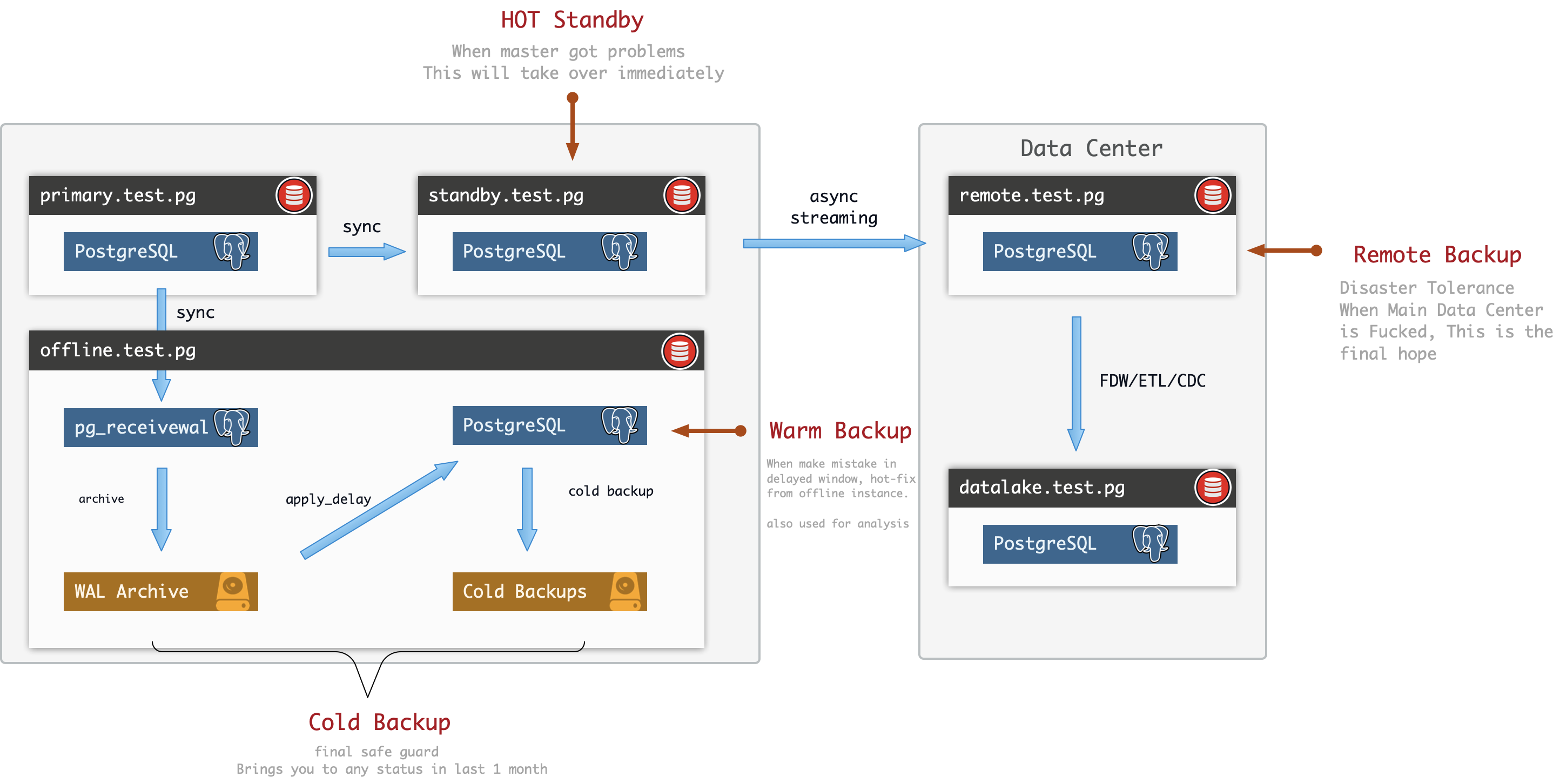

PostgreSQL标准复制方案

集群拓扑 假设我们使用4单元的标准配置:主库,同步从库,延迟备库,远程备库,分别用字母M,S,O,R标识。 M:Master, Main, Primary, Leader, 主库,权威数据源。S: Slave, Secondary, Standby, Sync…...

AOD实践,modis数据下载,modis数据处理

modis数据下载-数据读取-重投影-拼接-均值 一、数据下载 1、Cygwin安装 Cygwin安装教程:https://blog.csdn.net/u010356768/article/details/90756742 1.2 数据采集 现提供遥感数据下载服务,主要是NASA数据,数据下载网站包括:…...

常见的注册中心Nacos、Eureka

常见的注册中心 1.Eureka(原生,2.0遇到瓶颈,停止维护) 2.Zookeeper(支持,专业的独立产品。例如:dubbo) 3.Consul(原生,GO语言开发) 4.Nacos …...

逆向思维书籍推荐

《逆向思维》作者:德鲁克 《逆向思维法》作者:艾伦哈勃 《逆向思维:如何解决问题》作者:托尼布赖恩特 《逆向思维的力量》作者:李开复 《逆向思维:掌握创新的关键》作者:李嘉诚 《逆向思维》作…...

centos系统简析

服务器所使用的最多的系统之一便是Linux系统,Linux下centos系统也是常用的系统,今天来给大家详细说名下centos系统。 CentOS于2004年5月发布,作为一个完全免费且基于Linux内核的操作系统。CentOS 起源于 RHEL。其目标是提供一个免费提供的企…...

「SQL面试题库」 No_43 只出现一次的最大数字

🍅 1、专栏介绍 「SQL面试题库」是由 不是西红柿 发起,全员免费参与的SQL学习活动。我每天发布1道SQL面试真题,从简单到困难,涵盖所有SQL知识点,我敢保证只要做完这100道题,不仅能轻松搞定面试࿰…...

TEB算法详解 参数详解

teb算法的基本思路之前已经看完了,今天主要看一下teb算法的参数配置文件,分析一下每个配置参数的作用: teb的参数主要可以包含以下几个部分: 1、Trajectory Trajectory的参数顾名思义,就是对路径生效的一些参数&…...

【Python】 -- 趣味代码 - 小恐龙游戏

文章目录 文章目录 00 小恐龙游戏程序设计框架代码结构和功能游戏流程总结01 小恐龙游戏程序设计02 百度网盘地址00 小恐龙游戏程序设计框架 这段代码是一个基于 Pygame 的简易跑酷游戏的完整实现,玩家控制一个角色(龙)躲避障碍物(仙人掌和乌鸦)。以下是代码的详细介绍:…...

利用ngx_stream_return_module构建简易 TCP/UDP 响应网关

一、模块概述 ngx_stream_return_module 提供了一个极简的指令: return <value>;在收到客户端连接后,立即将 <value> 写回并关闭连接。<value> 支持内嵌文本和内置变量(如 $time_iso8601、$remote_addr 等)&a…...

51c自动驾驶~合集58

我自己的原文哦~ https://blog.51cto.com/whaosoft/13967107 #CCA-Attention 全局池化局部保留,CCA-Attention为LLM长文本建模带来突破性进展 琶洲实验室、华南理工大学联合推出关键上下文感知注意力机制(CCA-Attention),…...

.Net框架,除了EF还有很多很多......

文章目录 1. 引言2. Dapper2.1 概述与设计原理2.2 核心功能与代码示例基本查询多映射查询存储过程调用 2.3 性能优化原理2.4 适用场景 3. NHibernate3.1 概述与架构设计3.2 映射配置示例Fluent映射XML映射 3.3 查询示例HQL查询Criteria APILINQ提供程序 3.4 高级特性3.5 适用场…...

中南大学无人机智能体的全面评估!BEDI:用于评估无人机上具身智能体的综合性基准测试

作者:Mingning Guo, Mengwei Wu, Jiarun He, Shaoxian Li, Haifeng Li, Chao Tao单位:中南大学地球科学与信息物理学院论文标题:BEDI: A Comprehensive Benchmark for Evaluating Embodied Agents on UAVs论文链接:https://arxiv.…...

UE5 学习系列(三)创建和移动物体

这篇博客是该系列的第三篇,是在之前两篇博客的基础上展开,主要介绍如何在操作界面中创建和拖动物体,这篇博客跟随的视频链接如下: B 站视频:s03-创建和移动物体 如果你不打算开之前的博客并且对UE5 比较熟的话按照以…...

)

postgresql|数据库|只读用户的创建和删除(备忘)

CREATE USER read_only WITH PASSWORD 密码 -- 连接到xxx数据库 \c xxx -- 授予对xxx数据库的只读权限 GRANT CONNECT ON DATABASE xxx TO read_only; GRANT USAGE ON SCHEMA public TO read_only; GRANT SELECT ON ALL TABLES IN SCHEMA public TO read_only; GRANT EXECUTE O…...

土地利用/土地覆盖遥感解译与基于CLUE模型未来变化情景预测;从基础到高级,涵盖ArcGIS数据处理、ENVI遥感解译与CLUE模型情景模拟等

🔍 土地利用/土地覆盖数据是生态、环境和气象等诸多领域模型的关键输入参数。通过遥感影像解译技术,可以精准获取历史或当前任何一个区域的土地利用/土地覆盖情况。这些数据不仅能够用于评估区域生态环境的变化趋势,还能有效评价重大生态工程…...

dify打造数据可视化图表

一、概述 在日常工作和学习中,我们经常需要和数据打交道。无论是分析报告、项目展示,还是简单的数据洞察,一个清晰直观的图表,往往能胜过千言万语。 一款能让数据可视化变得超级简单的 MCP Server,由蚂蚁集团 AntV 团队…...

基于matlab策略迭代和值迭代法的动态规划

经典的基于策略迭代和值迭代法的动态规划matlab代码,实现机器人的最优运输 Dynamic-Programming-master/Environment.pdf , 104724 Dynamic-Programming-master/README.md , 506 Dynamic-Programming-master/generalizedPolicyIteration.m , 1970 Dynamic-Programm…...