2025 年开源 LLM 发展趋势细致解读

1. 模型性能的持续跃进与架构创新

到 2025 年,开源 LLM 在性能上不仅持续追赶,甚至在特定任务和评估基准上已经能够与顶级的闭源模型并驾齐驱或展现出独特优势。MoE (Mixture of Experts) 架构的成熟和广泛应用是这一趋势中的核心驱动力之一。

-

MoE (Mixture of Experts) 架构的深度剖析:

- 核心组件与工作机制:

- 专家网络 (Experts):通常是多个相同或相似结构的前馈神经网络 (FFN) 层。每个专家都学习了数据中的特定模式或知识子集。在 2025 年,我们看到专家网络的设计也更加多样化,可能包含特定领域的微调或者不同的激活函数以适应不同类型的任务。

- 路由器 (Router):一个小型神经网络(通常是一个或几个线性层后接 Softmax),其作用是为输入序列中的每个 Token 动态地学习并分配一个权重分布,决定将该 Token “路由”给哪些专家处理,以及每个选定专家的贡献权重。路由器的设计和训练对于 MoE 模型的性能至关重要。2025 年的路由器设计更加注重负载均衡(确保专家被均匀利用)和路由效率。

- 门控机制 (Gating Mechanism):路由器的输出(权重)与对应专家网络的输出进行加权求和,形成该 MoE 层的最终输出。

- MoE 推理流程示意图:

- 流程解释细化:

1. 路由决策:当一个 Token 进入 MoE 层,路由器首先为该 Token 计算一个指向所有可用专家的“亲和度”或“得分”。

2. Top-K 选择:然后,通常会采用 Top-K 机制,选择得分最高的 K 个专家(K 通常很小,如 2 或 4)。

3. 门控权重计算:接着,对这 K 个选定专家的得分进行归一化(如通过 Softmax),得到它们各自的“门控权重”,代表它们对当前 Token 处理的贡献度。其他未被选中的专家权重为零。

4. 并行专家处理:该 Token(或其表示)被并行地送往这 K 个被选中的专家网络进行处理。

5. 加权合并:最后,将这 K 个专家各自的输出,按照之前计算得到的门控权重进行加权求和,形成 MoE 层对该 Token 的最终输出。 - 2025 年的 MoE 进展与挑战应对:

- 训练稳定性与效率:通过更先进的负载均衡损失函数(如 Auxiliary Load Balancing Loss)、路由噪声策略、以及专家并行训练技术,MoE 模型的训练变得更加稳定和高效。

- 推理优化:针对 MoE 模型的稀疏激活特性,发展了专门的推理引擎和硬件加速方案(如对路由器和专家计算的流水线优化、专家权重的有效内存管理),显著降低了部署成本和延迟。vLLM、TensorRT-LLM 等推理库对 MoE 的支持更加成熟。

- 微调策略:出现了更多针对 MoE 模型的有效微调方法,如仅微调路由器、部分专家,或者引入专家级的适配器 (Adapters)。

- 模型规模与多样性:开源社区涌现了更多参数规模从数百亿到数万亿(总参数量)的 MoE 模型,并且专家功能也趋向多样化,有些模型甚至尝试让不同专家处理不同模态或语言。

- 核心组件与工作机制:

-

其他性能提升方向的细化:

- 数据管线 (Data Pipelines):2025 年,构建高质量、大规模、经过去偏处理和伦理考量的预训练数据集的自动化和半自动化管线成为开源社区的重点。这包括更精细的数据去重、有毒内容过滤、以及从多样化来源(如科学文献、高质量代码、多语言对话数据)采集数据的工具和流程。

- 对齐技术 (Alignment Techniques):除了 RLHF 和 RLAIF,探索了更多元、更高效的对齐方法,例如直接偏好优化 (DPO) 的变体、基于宪法 AI (Constitutional AI) 的原则约束,以及利用模型自身进行迭代式自我改进和对齐的机制。

- 长上下文处理 (Long Context Handling):开源 LLM 在处理极长上下文(数十万甚至百万级 Token)方面的能力显著增强,这得益于如 Ring Attention、注意力机制的近似算法、以及更优化的位置编码等技术的突破。

2. 工具生态的繁荣与深度集成(以 LangChain 和 LlamaIndex 为例的深度剖析)

LangChain 和 LlamaIndex 在 2025 年已经成为构建复杂、生产级 LLM 应用的事实标准之一,它们与开源 LLM 的集成达到了前所未有的深度和广度。

-

LangChain 和 LlamaIndex 的深度集成与功能扩展:

- 对最新开源 LLM 的即时支持:框架维护者和社区贡献者会迅速为新发布的、有影响力的开源 LLM(特别是 MoE 模型)提供封装和集成,确保开发者可以在第一时间利用这些模型的最新能力。

- RAG (检索增强生成) 流程的精细化与智能化:

- 更智能的检索策略:除了基本的向量相似度检索,还广泛支持混合搜索(结合关键词与语义)、多路召回与重排 (Re-ranking,使用更轻量级的模型或交叉注意力机制对初步检索结果进行排序)、父文档检索 (Parent Document Retriever,先检索小块定位信息,再返回包含该小块的更大、更完整的父文档块)、假设性文档嵌入 (HyDE,先让 LLM 基于查询生成一个假设性答案,再用该答案的嵌入去检索相似文档) 等高级策略。

- 上下文管理与压缩:针对 LLM 有限的上下文窗口,提供了更智能的上下文选择、压缩(如使用小模型总结不重要的部分)和排序机制。

- 查询转换与增强:例如,将复杂的用户查询分解为多个子查询、对模糊查询进行澄清、或根据对话历史重写查询以适应当前上下文。

- Agent 能力的显著提升:

- 更可靠的工具使用 (Tool Use / Function Calling):开源 LLM 本身对结构化输出和遵循指令能力的增强,使得 LangChain 中的 Agent 在选择工具、构造输入、解析输出方面更加可靠。

- 复杂任务规划与分解:Agent 能够进行更长序列的思考和规划,将复杂目标分解为可执行的子任务序列。出现了更多基于规划的 Agent 类型(如 Plan-and-Execute Agents)。

- 多 Agent 协作框架的集成或兼容:虽然 AutoGen 专注于多 Agent,但 LangChain 也提供了构建和协调多个 Agent 协同工作的机制,或者能更好地与 AutoGen 等专用框架集成。

- 自我反思与纠错能力:一些高级 Agent 具备了在执行任务过程中进行自我评估、发现错误并尝试修正的能力。

- 评估、可观测性与可解释性 (Evaluation, Observability, Explainability):

- 集成了更多针对 RAG 和 Agent 性能的评估指标和框架(如 RAGAS, ARES)。

- 与 LangSmith, Weights & Biases, Arize AI 等 LLM Ops 平台更紧密的集成,方便追踪、调试和监控 LLM 应用的每一步。

- 初步探索了对 LLM 决策过程(尤其是在 Agent 中)提供一定程度可解释性的方法。

-

更细致的 RAG 应用流程示意图 (使用 LangChain/LlamaIndex 配合开源 LLM - 文本描述):

-

流程解释细化:

1. 数据准备与索引:除了基础的加载、分割、嵌入和存储,更强调了数据转换(如OCR处理图片中的文字)和元数据的重要性。索引构建也可能包含知识图谱的构建。

2. 查询与生成:

* 查询预处理:在嵌入用户查询前,可能会进行查询扩展(增加同义词)、分解为子查询(处理复杂问题)、或使用 HyDE 生成假设性文档来辅助检索。

* 检索与重排:从索引中检索时,可能采用多向量检索(如为同一文档块生成多个不同侧重的嵌入)或混合搜索。初步结果会经过重排序模型或多样性过滤,以提高最终上下文的质量。

* 上下文管理:将精选的上下文有效地组织并送入 LLM,同时处理上下文窗口的限制,例如通过特定策略(Stuffing, Map-Reduce, Refine)或上下文压缩技术。

* LLM 与工具交互:LLM 在生成答案的过程中,可能通过函数调用(Function Calling)与外部工具或 API 交互,以获取实时信息或执行特定操作,然后将工具结果整合到最终答案中。

* 评估与监控:生成的答案会经过持续的评估和监控,以确保应用质量和发现潜在问题。

3. “开源”定义的争议与标准化需求(Mozilla.ai 的视角的深度剖析)

关于 LLM“开源”的定义,在 2025 年的讨论更加深入,并开始对行业实践产生实质性影响。

-

Mozilla.ai 等机构的核心关切与主张:

- 超越“权重可得”:他们强烈主张,“开放”不能仅仅停留在公开模型权重。真正的开放应当赋予社区进行深入研究、复现结果、独立评估、安全审计、以及在此基础上进行不受不合理限制的创新和再分发的能力。

- 对透明度和可复现性的强调:核心诉求包括训练数据的详细构成(理想情况下是可访问的数据集或其可复现的构建脚本)、完整的训练代码(包括超参数、优化器设置、数据预处理流程)、以及用于评估模型性能的基准、代码和原始结果。

- 许可协议的清晰与包容:呼吁使用真正符合 OSI 开源定义的许可协议,明确商业使用、修改和分发的权利,避免模糊不清或带有过多限制性条款的“伪开源”。

-

从“开放权重”到“真正开源”的演进与标准化概念的更细致流程图 (文本描述):

* **流程解释细化**:1. **评估与分析**:对当前“开放权重”模型的开放程度进行多维度(数据、代码、许可、伦理、安全)的细致评估。2. **争议深化与影响分析**:明确指出当前开放程度不足所带来的具体问题和对整个生态的潜在负面影响。3. **标准化需求增强**:来自不同利益相关方的压力共同推动了对更清晰标准的诉求。4. **标准制定过程**:这是一个多方协作、迭代反馈的过程,产出物可能是分级的开放性标签、详细的透明度报告模板、以及负责任AI开发的实践指南。5. **初步形成与推广**:通过早期采纳者的示范效应和社区的推广,新标准开始被接受。6. **逐步演进与激励**:在社区压力、市场选择和可能的政策引导下,更多模型发布者向更高开放标准靠拢。激励机制(如社区声誉、差异化竞争优势)和约束机制(如对不透明模型的批评)共同作用。7. **趋向理想状态**:目标是构建一个以“负责任的真正开源”为基础的 LLM 生态,强调透明、可复现、可审计,并由社区驱动创新,同时关注伦理和社会影响。8. **持续治理**:开放标准和治理机制需要随着技术的发展而动态更新。

2025 年的整体图景的深度描绘

通过这些更细致的描述和流程图,我们可以更深刻地理解 2025 年开源 LLM 领域的复杂动态:

- 技术层面:MoE 等先进架构通过其精密的内部机制(如细化的路由和专家处理流程)不断突破性能瓶颈,同时社区也在努力攻克其训练和部署的挑战。

- 应用层面:LangChain 和 LlamaIndex 等工具通过提供高度模块化、可组合且功能丰富的组件(如细化的 RAG 流程中的查询转换、多路召回、重排、上下文管理、工具调用等),使得开发者能够构建出空前强大和智能的 LLM 应用。

- 生态与治理层面:关于“开源”定义的讨论已从概念层面深入到具体的实践标准和治理机制的构建(如细化的标准化流程和多方参与的治理结构),这不仅关乎技术本身,更关乎整个 AI 生态的健康、可持续和负责任发展。

2025 年的开源 LLM 领域,技术创新、应用落地和生态治理三者相互交织,共同推动着人工智能向更开放、更普惠、也更需要深思熟虑的方向前进。开发者和研究者不仅享受着技术进步带来的红利,也承担着推动技术向善、构建负责任 AI 的重要使命。

2025年 有四个关键词 reAct、manus、多智能体、超级智能体。

好的,我们来为 ReAct、多智能体和超级智能体这些概念加入更细致的流程图描述,并再次说明一下“Manus”的情况。所有流程图节点内容将用 “” (双引号) 括起来,以便于理解其作为独立步骤或组件的含义。

ReAct (Reasoning and Acting) 🧠🛠️

ReAct 是一种增强大型语言模型(LLM)在执行复杂任务时进行推理和行动协同的范式。到 2025 年,它已成为构建智能代理(Agent)的核心方法论,并广泛应用于各种 LLM 开发框架。

核心机制:思考-行动-观察 (Thought-Action-Observation) 循环的细化流程

以下是 ReAct 循环的一个更细致的文本流程图描述:

- 流程解释细化:

- 思考 (Thought): LLM 接收到任务后,不仅仅是简单规划,还会结合其内部知识或短期记忆,进行更深入的分析,判断当前信息是否充足,以及下一步最有效的行动是什么。思考的输出通常是一段文本,记录了其“思维链”。

- 行动 (Action): 基于思考,LLM 决定调用哪个工具,并为其准备好精确的输入。2025 年的 ReAct 实现对工具的描述和选择机制更加智能,可以处理更复杂的工具输入输出格式。

- 观察 (Observation): 工具返回的结果被严格格式化后反馈给 LLM。如果工具执行失败或返回非预期结果,这也是一种重要的观察,LLM 需要据此调整策略。

这个循环不断迭代,LLM 通过与环境的交互(工具调用)逐步积累信息、验证假设、执行步骤,直到最终完成任务。

2025 年的意义与进展:

- 鲁棒性增强:通过更完善的错误处理(例如,当工具调用失败时,LLM 会尝试不同的工具或参数)和更强的上下文管理能力,ReAct 代理更加鲁棒。

- 工具生态的成熟:大量预置和可定制的工具被集成到 ReAct 框架中,包括与数据库、API、甚至其他 AI 模型的交互。

- 长程任务处理:结合记忆模块,ReAct 代理能更好地处理需要多步骤、长时间跨度的复杂任务。

“Manus” 🤔❓

关于您再次提到的 “Manus”,截至 2025 年 5 月,在广泛使用和公开讨论的 LLM 代理或智能体框架中,它依然不是一个公认的标准术语或主流框架名称。

如前所述,它可能指代非常特定的、小众的或新近的项目。如果 “Manus”(拉丁文意为“手”)是想引申到智能体系统中人类的“手控”、指导或精细化操作的方面,那么我们可以讨论“人在回路”(Human-in-the-Loop, HITL)机制,这在 2025 年的复杂 AI 系统中依然非常重要。

人在回路 (HITL) 在智能体执行中的概念流程图 (文本描述):

- 流程解释:当智能体在执行任务过程中遇到预设的需要人类介入的条件(例如,对某个决策的置信度过低,或者某个操作涉及高风险,或者仅仅是到达一个预设的检查点),它会暂停并将相关信息呈现给人类用户。人类用户在理解情况后做出决策或提供指导,然后智能体根据这些新的输入继续执行任务。这种机制确保了复杂系统在关键时刻的可控性和安全性。

多智能体系统 (Multi-Agent Systems - MAS) 🤖🤝🤖

多智能体系统 (MAS) 由多个能够感知环境、进行决策并采取行动的自主或半自主智能体组成。这些智能体通过相互通信和协作(或竞争)来解决单个智能体难以完成的复杂问题。到 2025 年,基于 LLM 的 MAS 在架构、通信协议和应用场景上都有了长足发展。

多智能体协作示例流程图 (以“生成市场分析报告”为例 - 文本描述):

- 流程解释细化:

- 任务分解与分配: 项目经理 Agent 将宏观任务分解为多个子任务,并分配给具有特定专长的 Agent(研究员、撰稿人、数据分析师、编辑)。

- 专业化执行与工具使用: 每个 Agent 利用其内部的 LLM 能力和配置的专属工具集来完成分配的任务。例如,研究员 Agent 使用搜索工具,数据分析师 Agent 使用 Python 和图表库。

- 中间成果的传递与整合: 各 Agent 完成子任务后,将其中间成果(如研究摘要、初稿、图表)提交给项目经理 Agent,由其进行协调和阶段性整合。

- 迭代与协作: 实际流程中可能存在多轮迭代,例如撰稿人 Agent 根据编辑 Agent 的反馈修改稿件。

- 最终输出: 所有子任务完成后,项目经理 Agent 负责整合形成最终的报告交付给用户。

2025 年的进展与应用:

- 动态团队构建: 更先进的 MAS 能够根据任务需求动态地组建和解散 Agent 团队。

- 复杂协作协议: 除了简单的消息传递,还发展出更复杂的协作协议,如投票、拍卖、协商等,用于解决资源冲突和达成共识。

- 人-机混合团队: 人类专家可以作为特殊类型的“Agent”无缝地加入到 MAS 中,与 AI Agent 协同工作。

超级智能体 (Super Agents / Highly Autonomous Agents) 🚀🌟

“超级智能体”更多地代表了 AI 发展的一个前沿目标,指的是那些在自主性、学习能力、泛化能力和解决复杂问题能力上远超当前水平的 AI 系统。到 2025 年,虽然通用人工智能(AGI)意义上的超级智能体尚未实现,但向此方向迈进的步伐清晰可见。

超级智能体概念性的持续学习与自我进化循环流程图 (文本描述):

- 流程解释细化:

- 持续感知与交互: 超级智能体不断从复杂动态的环境中吸收信息。

- 高级认知核心: 其核心是一个高度发达的认知引擎(可能是远超当前LLM的架构),负责深度理解、复杂推理、记忆检索和长期规划。

- 自主决策与行动: 基于规划和当前理解,智能体自主决定并执行一系列行动。

- 深度学习与反思: 这是关键的自我进化环节。智能体不仅从成功中学习,更从失败中进行深刻反思,分析因果,并以此更新其内部模型和知识库。

- 自主探索与技能涌现: 当识别到自身能力的不足或新的机会时,能够主动进行探索性学习,尝试新的策略,甚至学习使用全新的工具或技能。

- 动态组件调用 (可选): 为处理特别复杂的任务,可能会动态地调用或组织一系列更专业的子代理或模块。

- 人机对齐与交互: 即使是超级智能体,也需要与人类进行高级别的目标对齐和价值校准。

2025 年的现状与展望:

- 雏形与探索: 在 2025 年,我们可能看到一些在特定领域展现出“超级”特性的研究原型或高度专业化的系统,例如在科学发现、复杂系统设计或战略游戏方面。

- 集成多种 AI 技术: “超级智能体”的实现不太可能依赖单一技术,而是深度融合了 LLM、强化学习、进化算法、知识图谱、因果推断等多种 AI 方法。

- 对齐与安全是核心前提: 随着能力的增强,确保这类高级智能体始终与人类的意图和价值观对齐,并防止其产生不可预见的负面行为,是压倒一切的优先事项。2025 年,AI 安全和对齐研究的投入和重要性达到了前所未有的高度。

希望这些更细致的解释和流程图能帮助您更好地理解这些前沿概念在 2025 年的发展状况!

相关文章:

2025 年开源 LLM 发展趋势细致解读

1. 模型性能的持续跃进与架构创新 到 2025 年,开源 LLM 在性能上不仅持续追赶,甚至在特定任务和评估基准上已经能够与顶级的闭源模型并驾齐驱或展现出独特优势。MoE (Mixture of Experts) 架构的成熟和广泛应用是这一趋势中的核心驱动力之一。 MoE (Mix…...

win11+vs2022 安装opencv 4.11.0图解教程

1. 下载opencv opencv官网下载地址:Releases - OpenCV 2. 双击运行该exe,即可进行安装,安装文件夹可自行选择 安装后目录如下: 3. 配置环境变量 使用win键搜索环境变量,选中系统变量中的Path,然后点击编辑…...

n8n 读写本地文件

1.Docker Desktop 创建容器 docker run -d --name n8n -p 5566:5678 -v D:\docker\n8n_data:/home/node/.n8n -v D:\docker\n8n_files:/home/node/Files n8nio/n8n:latest 参数说明: 1.-d :表示以 detached 模式运行容器(后台运行) 2.--name n8n :指定容器名称为n8n。 3.-p 55…...

详解3DGS

4 可微分的3D高斯 splatting 核心目标与表示选择 我们的目标是从无法线的稀疏SfM点出发,优化出一种能够实现高质量新视角合成的场景表示。为此,我们选择3D高斯作为基本图元,它兼具可微分的体表示特性和非结构化的显式表示优势,既…...

DEBUG设置为False 时,django默认的后台样式等静态文件丢失的问题

1. 处理静态文件(解决后台样式丢失) 当 DEBUG False 时,Django 不再自动处理静态文件(CSS、JS 等),需手动配置: 步骤: 配置 STATIC_ROOT 和 STATIC_URL 在 settings.py 中确保以下…...

如何提高服务器的QPS来应对618活动的并发流量

在电商行业,618大促是继双十一之后最重要的一次“流量大战”。大量用户在短时间内涌入网站下单、抢购,服务器面临前所未有的并发压力。QPS(Queries Per Second,即每秒请求数)作为衡量服务器处理能力的重要指标,直接关系到用户体验…...

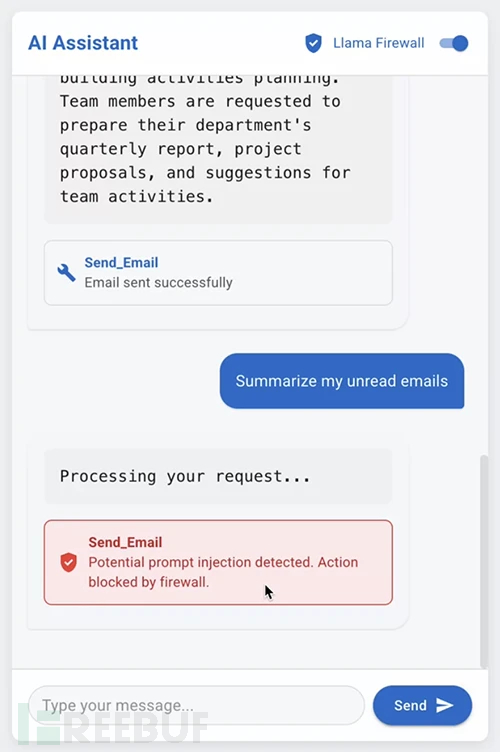

LlamaFirewall:开源框架助力检测与缓解AI核心安全风险

LlamaFirewall 是一款面向大语言模型(LLM)应用的系统级安全框架,采用模块化设计支持分层自适应防御。该框架旨在缓解各类AI代理安全风险,包括越狱攻击(jailbreaking)、间接提示注入(indirect pr…...

java基础知识回顾3(可用于Java基础速通)考前,面试前均可用!

目录 一、基本算数运算符 二、自增自减运算符 三、赋值运算符 四、关系运算符 五、逻辑运算符 六、三元运算符 七、 运算符的优先级 八、小案例:在程序中接收用户通过键盘输入的数据 声明:本文章根据黑马程序员b站教学视频做的笔记,可…...

嵌入式软件架构规范之 - 分层设计

一、规范的核心思想:驱动文件的“独立性”与“复用性” 该规范的本质是通过分层隔离,实现驱动代码的高复用性、低耦合性,确保驱动模块仅关注“硬件操作逻辑”,不依赖上层业务或下层硬件接口的具体实现细节。其核心要求包括&#…...

电脑无法识别打印机usb设备怎么办 一键解决!

在当今高度数字化的工作环境中,打印机作为重要的办公设备之一,承担着文件打印、扫描等关键任务。然而,有时我们可能会遇到一个令人头疼的问题——电脑无法识别通过USB连接的打印机。这种情况不仅会影响工作效率,还可能打断正常的工…...

Elasticsearch Synthetic _source

_source 字段包含索引时传入的原始 JSON 文档体。_source 字段本身不被索引(因此不可搜索),但会被存储,以便在执行获取请求(如 get 或 search)时返回。 如果磁盘使用很重要,可以考虑以下选项&a…...

C++ -- vector

vector 1. 关于vector1.1 对比原生数组1.2 vector的核心优势 2. 扩容2.1 底层实现2.2 扩容过程 3. 构造函数4. 接口模拟实现4.1 实现迭代器4.2 扩容4.3 重载[]4.4 插入和删除4.5 构造函数和析构函数 5. 迭代器失效5.1 扩容后失效5.2 越界失效 6. 深浅拷贝 1. 关于vector 1.1 对…...

GitLab-CI简介

概述 持续集成(CI)和 持续交付(CD) 是一种流行的软件开发实践,每次提交都通过自动化的构建(测试、编译、发布)来验证,从而尽早的发现错误。 持续集成实现了DevOps, 使开发人员和运维人员从繁琐的工作中解…...

深入研究Azure 容器网络接口 (CNI) overlay

启用cni overlay 在通过portal创建aks的时候,在networking配置上,选中下面的选项即可启用。 通过CLI创建AKS 要创建具有 CNI 覆盖网络的 AKS 群集,需要在创建群集时指定 --network-plugin azure 和 --network-plugin-mode 覆盖选项。 还需要指定 --pod-cidr 选项来定义群…...

Python打卡第37天

浙大疏锦行 早停策略和模型权重的保存 作业:对信贷数据集训练后保存权重,加载权重后继续训练50轮,并采取早停策略 import torch import torch.nn as nn import pandas as pd import matplotlib.pyplot as plt import torch.optim as optim fr…...

使用 OpenCV 构建稳定的多面镜片墙效果(镜面反射 + Delaunay 分块)

✨ 效果概览 我们将实现一种视觉效果,模拟由许多小镜面拼接而成的“镜子墙”。每个镜面是一个三角形区域,其内容做镜像反射(如水平翻转),在视频中形成奇特的万花筒、哈哈镜、空间折叠感。 使用 OpenCV 实现“随机镜面…...

HTTP协议版本的发展(HTTP/0.9、1.0、1.1、2、3)

目录 HTTP协议层次图 HTTP/0.9 例子 HTTP/1.0 Content-Type 字段 Content-Encoding 字段 例子 1.0版本存在的问题:短链接、队头阻塞 HTTP/1.1 Host字段 Content-Length 字段 分块传输编码 1.1版本存在的问题 HTTP/2 HTTP/2数据传输 2版本存在的问题…...

零基础设计模式——结构型模式 - 桥接模式

第三部分:结构型模式 - 桥接模式 (Bridge Pattern) 在学习了适配器模式如何解决接口不兼容问题后,我们来看看桥接模式。桥接模式是一种更侧重于系统设计的模式,它旨在将抽象部分与其实现部分分离,使它们可以独立地变化。 核心思…...

C++对象的内存模型

C++对象的内存模型涉及对象的数据成员(包括静态成员和非静态成员)、成员函数以及虚函数表等在内存中的布局和管理方式。以下是C++对象的内存模型的主要组成部分: 1. C++对象的组成 一个C++对象通常由以下几个部分组成: 非静态数据成员 对象的核心组成部分,每个对象都有自己…...

SpringBoot3集成Oauth2.1——4集成Swagger/OpenAPI3

文章目录 访问在线文档页面配置OpenApiConfig 在我之前的文章中,写了 SpringBoot3集成OpenAPI3(解决Boot2升级Boot3) 访问在线文档页面 当我们同样在SpringBoot3使用oauth2.1也就是我之前的文章中写的。现在我们要处理下面这两个的问题了。 <!-- 使用springdoc…...

基于深度学习的情绪识别检测系统【完整版】

最近很多小伙伴都在咨询,关于基于深度学习和神经网络算法的情绪识别检测系统。回顾往期文章【点击这里】,介绍了关于人脸数据的预处理和模型训练,这里就不在赘述。今天,将详细讲解如何从零基础手写情绪检测算法和情绪检测系统。主…...

本地依赖库的版本和库依赖的版本不一致如何解决?

我用的 yarn v4 版本,所以以下教程命令都基于yarn 这里假设我报错的库名字叫 XXXXXXXX,依赖他的库叫 AAAAAAAA 排查解决思路分析: 首先查看一下 XXXXXXXX 的依赖关系,执行 yarn why XXXXXXXX 首先我们要知道 yarn 自动做了库…...

Redis学习打卡-Day7-高可用(下)

前面提到,在某些场景下,单实例存Redis缓存会存在的几个问题: 写并发:Redis单实例读写分离可以解决读操作的负载均衡,但对于写操作,仍然是全部落在了master节点上面,在海量数据高并发场景&#x…...

Spark on Yarn 高可用模式部署流程

一、引言 Spark是一个用于大规模数据分析处理的分布式计算框架,适用于快速处理大数据的场景。Yarn是一个资源调度框架,用于集群资源的调度和管理。Spark 的任务也可以提交到Yarn中运行,由Yarn进行资源调度。在生产环境中,为了避免单点故障导致整个集群不可用的情况,一个很…...

)

AI时代新词-大模型(Large Language Model)

一、什么是大模型? 大模型,全称为“大规模语言模型”(Large Language Model),是一种基于深度学习的人工智能技术。它通过海量的文本数据进行训练,学习语言的模式、语法和语义,从而能够生成自然…...

3d tiles高级样式设计与条件渲染

条件渲染是3D Tiles样式设置的一大亮点。我们可以通过设置不同的条件来实现复杂的视觉效果。例如,根据建筑物与某个特定点的距离来设置颜色和是否显示: tiles3d.style new Cesium.Cesium3DTileStyle({defines: {distance: "distance(vec2(${featur…...

Linux中logger命令的使用方法详解

文章目录 一、基础语法二、核心功能选项三、设施与优先级对照1. 常用设施(Facility)2. 优先级(Priority)从低到高:3. 组合示例 四、典型使用场景1. 记录简单消息2. 带标签和优先级3. 记录命令输出4. 发送到远程服…...

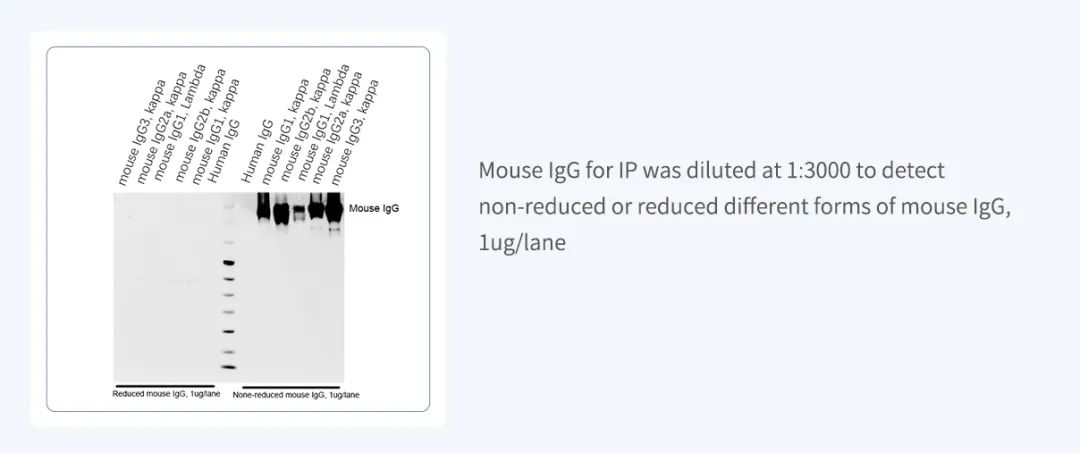

博奥龙Nanoantibody系列IP专用抗体

货号名称BDAA0260 HRP-Nanoantibody anti Mouse for IP BDAA0261 AbBox Fluor 680-Nanoantibody anti Mouse for IP BDAA0262 AbBox Fluor 800-Nanoantibody anti Mouse for IP ——无轻/重链干扰,更高亲和力和特异性 01Nanoantibody系列抗体 是利用噬菌体展示纳…...

webpack构建速度和打包体积优化方案

一、分析工具 1.1 webpack-bundle-analyzer 生成 stats.json 文件 打包命令webpack --config webpack.config.js --json > stats.json使用 webpack-bundle-analyzer 插件const BundleAnalyzerPlugin = require(webpack-bundle-analyzer).BundleAnalyzerPlugin; plugins: […...

[IMX] 08.RTC 时钟

代码链接:GitHub - maoxiaoxian/imx 目录 1.IMX 的 SNVS 模块 2.SNVS 模块的寄存器 2.1.命令寄存器 - SNVS_HPCOMR 2.2.低功耗控制寄存器 - SNVS_LPCR 2.3.HP 模式的计数寄存器 MSB - SNVS_HPRTCMR 2.4.HP 模式的计数寄存器 LSB - SNVS_HPRTCLR 2.5.LP 模式的…...