GoogLeNet卷积神经网络-笔记

GoogLeNet卷积神经网络-笔记

GoogLeNet是2014年ImageNet比赛的冠军,

它的主要特点是网络不仅有深度,

还在横向上具有“宽度”。

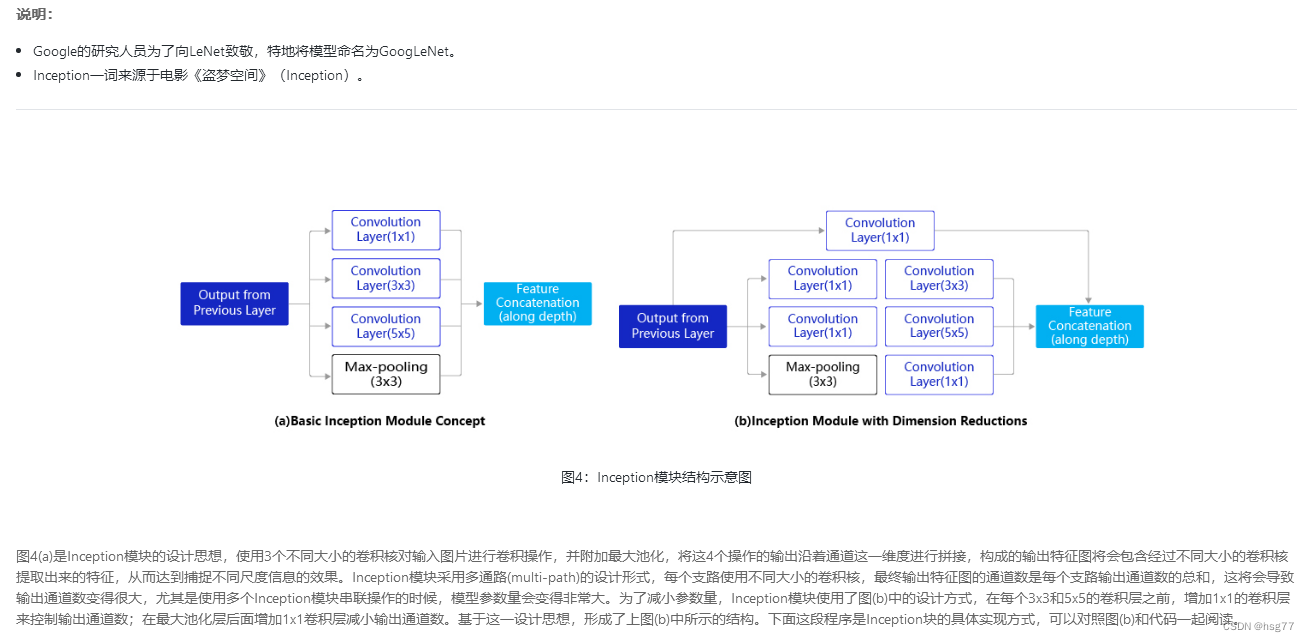

由于图像信息在空间尺寸上的巨大差异,

如何选择合适的卷积核来提取特征就显得比较困难了。

空间分布范围更广的图像信息适合用较大的卷积核来提取其特征;

而空间分布范围较小的图像信息则适合用较小的卷积核来提取其特征。

为了解决这个问题,

GoogLeNet提出了一种被称为Inception模块的方案。

Inception模块结构图

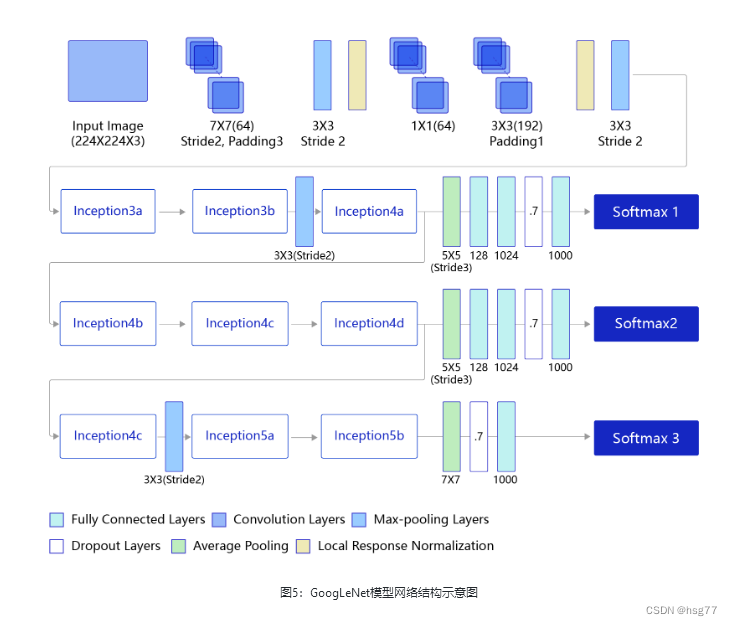

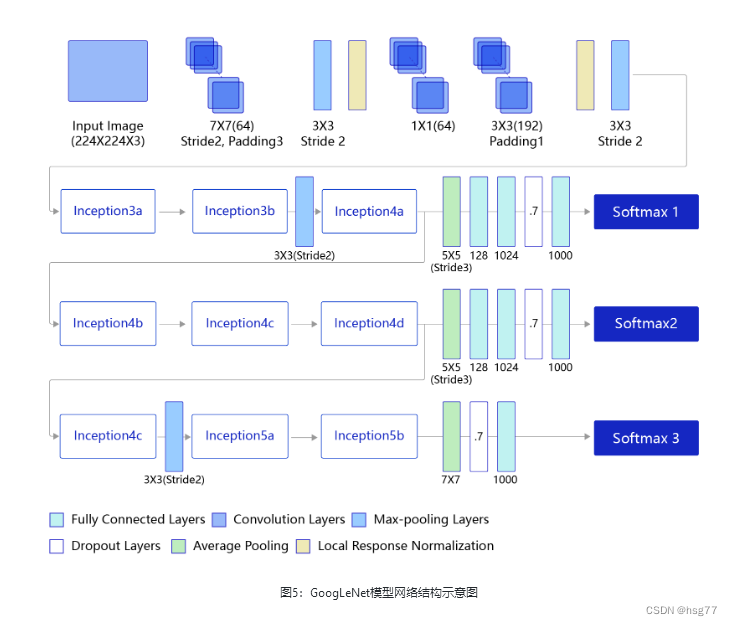

GoogleNet模型网络结构图

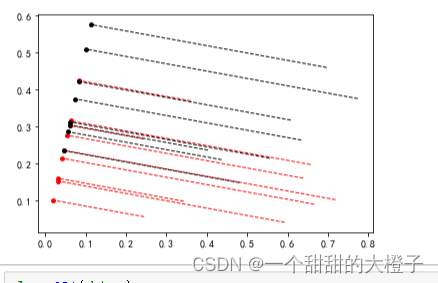

测试结果为:

通过运行结果可以发现,使用GoogLeNet在眼疾筛查数据集iChallenge-PM上,loss能有效的下降,经过5个epoch的训练,在验证集上的准确率可以达到95%左右。

实测准确率为0.95左右

[validation] accuracy/loss: 0.9575/0.1915

[validation] accuracy/loss: 0.9500/0.2322

#输出结果:

PS E:\project\python> & D:/ProgramData/Anaconda3/python.exe e:/project/python/PM/GoogLeNet_PM.py

W0803 18:25:55.522811 8308 gpu_resources.cc:61] Please NOTE: device: 0, GPU Compute Capability: 6.1, Driver API Version: 12.2, Runtime API Version: 10.2

W0803 18:25:55.532805 8308 gpu_resources.cc:91] device: 0, cuDNN Version: 7.6.

116

start training ...

epoch: 0, batch_id: 0, loss is: 0.6920

epoch: 0, batch_id: 20, loss is: 0.8546

[validation] accuracy/loss: 0.7100/0.5381

epoch: 1, batch_id: 0, loss is: 0.6177

epoch: 1, batch_id: 20, loss is: 0.4581

[validation] accuracy/loss: 0.9400/0.3120

epoch: 2, batch_id: 0, loss is: 0.2858

epoch: 2, batch_id: 20, loss is: 0.5234

[validation] accuracy/loss: 0.5975/0.5757

epoch: 3, batch_id: 0, loss is: 0.6338

epoch: 3, batch_id: 20, loss is: 0.3180

[validation] accuracy/loss: 0.9575/0.1915

epoch: 4, batch_id: 0, loss is: 0.1087

epoch: 4, batch_id: 20, loss is: 0.3728

[validation] accuracy/loss: 0.9500/0.2322

PS E:\project\python>

'''

GoogleNet网模型中子图层Shape[N,C,H,W],w参数,b参数[Cout]

PS E:\project\python> & D:/ProgramData/Anaconda3/python.exe e:/project/python/PM/GoogLeNet_PM.py

W0803 20:27:47.303915 15396 gpu_resources.cc:61] Please NOTE: device: 0, GPU Compute Capability: 6.1, Driver API Version: 12.2, Runtime API Version: 10.2

W0803 20:27:47.311910 15396 gpu_resources.cc:91] device: 0, cuDNN Version: 7.6.

116

(10, 3, 224, 224)

[10, 3, 224, 224]

conv2d_0 [10, 64, 224, 224] [64, 3, 7, 7] [64]

max_pool2d_0 [10, 64, 112, 112]

conv2d_1 [10, 64, 112, 112] [64, 64, 1, 1] [64]

conv2d_2 [10, 192, 112, 112] [192, 64, 3, 3] [192]

max_pool2d_1 [10, 192, 56, 56]

print block3-1:

conv2d_3 [10, 64, 56, 56] [64, 192, 1, 1] [64]

conv2d_4 [10, 96, 56, 56] [96, 192, 1, 1] [96]

conv2d_5 [10, 128, 56, 56] [128, 96, 3, 3] [128]

conv2d_6 [10, 16, 56, 56] [16, 192, 1, 1] [16]

conv2d_7 [10, 32, 56, 56] [32, 16, 5, 5] [32]

max_pool2d_2 [10, 192, 56, 56]

conv2d_8 [10, 32, 56, 56] [32, 192, 1, 1] [32]

print block3-2:

conv2d_9 [10, 128, 56, 56] [128, 256, 1, 1] [128]

conv2d_10 [10, 128, 56, 56] [128, 256, 1, 1] [128]

conv2d_11 [10, 192, 56, 56] [192, 128, 3, 3] [192]

conv2d_12 [10, 32, 56, 56] [32, 256, 1, 1] [32]

conv2d_13 [10, 96, 56, 56] [96, 32, 5, 5] [96]

max_pool2d_3 [10, 256, 56, 56]

conv2d_14 [10, 64, 56, 56] [64, 256, 1, 1] [64]

max_pool2d_4 [10, 480, 28, 28]

print block4_1:

conv2d_15 [10, 192, 28, 28] [192, 480, 1, 1] [192]

conv2d_16 [10, 96, 28, 28] [96, 480, 1, 1] [96]

conv2d_17 [10, 208, 28, 28] [208, 96, 3, 3] [208]

conv2d_18 [10, 16, 28, 28] [16, 480, 1, 1] [16]

conv2d_19 [10, 48, 28, 28] [48, 16, 5, 5] [48]

max_pool2d_5 [10, 480, 28, 28]

conv2d_20 [10, 64, 28, 28] [64, 480, 1, 1] [64]

print block4_2:

conv2d_21 [10, 160, 28, 28] [160, 512, 1, 1] [160]

conv2d_22 [10, 112, 28, 28] [112, 512, 1, 1] [112]

conv2d_23 [10, 224, 28, 28] [224, 112, 3, 3] [224]

conv2d_24 [10, 24, 28, 28] [24, 512, 1, 1] [24]

conv2d_25 [10, 64, 28, 28] [64, 24, 5, 5] [64]

max_pool2d_6 [10, 512, 28, 28]

conv2d_26 [10, 64, 28, 28] [64, 512, 1, 1] [64]

print block4_3:

conv2d_27 [10, 128, 28, 28] [128, 512, 1, 1] [128]

conv2d_28 [10, 128, 28, 28] [128, 512, 1, 1] [128]

conv2d_29 [10, 256, 28, 28] [256, 128, 3, 3] [256]

conv2d_30 [10, 24, 28, 28] [24, 512, 1, 1] [24]

conv2d_31 [10, 64, 28, 28] [64, 24, 5, 5] [64]

max_pool2d_7 [10, 512, 28, 28]

conv2d_32 [10, 64, 28, 28] [64, 512, 1, 1] [64]

print block4_4:

conv2d_33 [10, 112, 28, 28] [112, 512, 1, 1] [112]

conv2d_34 [10, 144, 28, 28] [144, 512, 1, 1] [144]

conv2d_35 [10, 288, 28, 28] [288, 144, 3, 3] [288]

conv2d_36 [10, 32, 28, 28] [32, 512, 1, 1] [32]

conv2d_37 [10, 64, 28, 28] [64, 32, 5, 5] [64]

max_pool2d_8 [10, 512, 28, 28]

conv2d_38 [10, 64, 28, 28] [64, 512, 1, 1] [64]

print block4_5:

conv2d_39 [10, 256, 28, 28] [256, 528, 1, 1] [256]

conv2d_40 [10, 160, 28, 28] [160, 528, 1, 1] [160]

conv2d_41 [10, 320, 28, 28] [320, 160, 3, 3] [320]

conv2d_42 [10, 32, 28, 28] [32, 528, 1, 1] [32]

conv2d_43 [10, 128, 28, 28] [128, 32, 5, 5] [128]

max_pool2d_9 [10, 528, 28, 28]

conv2d_44 [10, 128, 28, 28] [128, 528, 1, 1] [128]

max_pool2d_10 [10, 832, 14, 14]

print block5_1:

conv2d_45 [10, 256, 14, 14] [256, 832, 1, 1] [256]

conv2d_46 [10, 160, 14, 14] [160, 832, 1, 1] [160]

conv2d_47 [10, 320, 14, 14] [320, 160, 3, 3] [320]

conv2d_48 [10, 32, 14, 14] [32, 832, 1, 1] [32]

conv2d_49 [10, 128, 14, 14] [128, 32, 5, 5] [128]

max_pool2d_11 [10, 832, 14, 14]

conv2d_50 [10, 128, 14, 14] [128, 832, 1, 1] [128]

print block5_2:

conv2d_51 [10, 384, 14, 14] [384, 832, 1, 1] [384]

conv2d_52 [10, 192, 14, 14] [192, 832, 1, 1] [192]

conv2d_53 [10, 384, 14, 14] [384, 192, 3, 3] [384]

conv2d_54 [10, 48, 14, 14] [48, 832, 1, 1] [48]

conv2d_55 [10, 128, 14, 14] [128, 48, 5, 5] [128]

max_pool2d_12 [10, 832, 14, 14]

conv2d_56 [10, 128, 14, 14] [128, 832, 1, 1] [128]

adaptive_avg_pool2d_0 [10, 1024, 1, 1]

linear_0 [10, 1] [1024, 1] [1]

PS E:\project\python>

测试源代码如下所示:

# GoogLeNet模型代码

#GoogLeNet卷积神经网络-笔记

import numpy as np

import paddle

from paddle.nn import Conv2D, MaxPool2D, AdaptiveAvgPool2D, Linear

## 组网

import paddle.nn.functional as F# 定义Inception块

class Inception(paddle.nn.Layer):def __init__(self, c0, c1, c2, c3, c4, **kwargs):'''Inception模块的实现代码,c1,图(b)中第一条支路1x1卷积的输出通道数,数据类型是整数c2,图(b)中第二条支路卷积的输出通道数,数据类型是tuple或list, 其中c2[0]是1x1卷积的输出通道数,c2[1]是3x3c3,图(b)中第三条支路卷积的输出通道数,数据类型是tuple或list, 其中c3[0]是1x1卷积的输出通道数,c3[1]是3x3c4,图(b)中第一条支路1x1卷积的输出通道数,数据类型是整数'''super(Inception, self).__init__()# 依次创建Inception块每条支路上使用到的操作self.p1_1 = Conv2D(in_channels=c0,out_channels=c1, kernel_size=1, stride=1)self.p2_1 = Conv2D(in_channels=c0,out_channels=c2[0], kernel_size=1, stride=1)self.p2_2 = Conv2D(in_channels=c2[0],out_channels=c2[1], kernel_size=3, padding=1, stride=1)self.p3_1 = Conv2D(in_channels=c0,out_channels=c3[0], kernel_size=1, stride=1)self.p3_2 = Conv2D(in_channels=c3[0],out_channels=c3[1], kernel_size=5, padding=2, stride=1)self.p4_1 = MaxPool2D(kernel_size=3, stride=1, padding=1)self.p4_2 = Conv2D(in_channels=c0,out_channels=c4, kernel_size=1, stride=1)# # 新加一层batchnorm稳定收敛# self.batchnorm = paddle.nn.BatchNorm2D(c1+c2[1]+c3[1]+c4)def forward(self, x):# 支路1只包含一个1x1卷积p1 = F.relu(self.p1_1(x))# 支路2包含 1x1卷积 + 3x3卷积p2 = F.relu(self.p2_2(F.relu(self.p2_1(x))))# 支路3包含 1x1卷积 + 5x5卷积p3 = F.relu(self.p3_2(F.relu(self.p3_1(x))))# 支路4包含 最大池化和1x1卷积p4 = F.relu(self.p4_2(self.p4_1(x)))# 将每个支路的输出特征图拼接在一起作为最终的输出结果return paddle.concat([p1, p2, p3, p4], axis=1)# return self.batchnorm()class GoogLeNet(paddle.nn.Layer):def __init__(self):super(GoogLeNet, self).__init__()# GoogLeNet包含五个模块,每个模块后面紧跟一个池化层# 第一个模块包含1个卷积层self.conv1 = Conv2D(in_channels=3,out_channels=64, kernel_size=7, padding=3, stride=1)# 3x3最大池化self.pool1 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第二个模块包含2个卷积层self.conv2_1 = Conv2D(in_channels=64,out_channels=64, kernel_size=1, stride=1)self.conv2_2 = Conv2D(in_channels=64,out_channels=192, kernel_size=3, padding=1, stride=1)# 3x3最大池化self.pool2 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第三个模块包含2个Inception块self.block3_1 = Inception(192, 64, (96, 128), (16, 32), 32)self.block3_2 = Inception(256, 128, (128, 192), (32, 96), 64)# 3x3最大池化self.pool3 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第四个模块包含5个Inception块self.block4_1 = Inception(480, 192, (96, 208), (16, 48), 64)self.block4_2 = Inception(512, 160, (112, 224), (24, 64), 64)self.block4_3 = Inception(512, 128, (128, 256), (24, 64), 64)self.block4_4 = Inception(512, 112, (144, 288), (32, 64), 64)self.block4_5 = Inception(528, 256, (160, 320), (32, 128), 128)# 3x3最大池化self.pool4 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第五个模块包含2个Inception块self.block5_1 = Inception(832, 256, (160, 320), (32, 128), 128)self.block5_2 = Inception(832, 384, (192, 384), (48, 128), 128)# 全局池化,用的是global_pooling,不需要设置pool_strideself.pool5 = AdaptiveAvgPool2D(output_size=1)self.fc = Linear(in_features=1024, out_features=1)def forward(self, x):x = self.pool1(F.relu(self.conv1(x)))x = self.pool2(F.relu(self.conv2_2(F.relu(self.conv2_1(x)))))x = self.pool3(self.block3_2(self.block3_1(x)))x = self.block4_3(self.block4_2(self.block4_1(x)))x = self.pool4(self.block4_5(self.block4_4(x)))x = self.pool5(self.block5_2(self.block5_1(x)))x = paddle.reshape(x, [x.shape[0], -1])x = self.fc(x)return x#=================================

import PM

# 创建模型

model = GoogLeNet()

print(len(model.parameters()))

opt = paddle.optimizer.Momentum(learning_rate=0.001, momentum=0.9, parameters=model.parameters(), weight_decay=0.001)

# 启动训练过程

PM.train_pm(model, opt)—the—end—

相关文章:

GoogLeNet卷积神经网络-笔记

GoogLeNet卷积神经网络-笔记 GoogLeNet是2014年ImageNet比赛的冠军, 它的主要特点是网络不仅有深度, 还在横向上具有“宽度”。 由于图像信息在空间尺寸上的巨大差异, 如何选择合适的卷积核来提取特征就显得比较困难了。 空间分布范围更广的…...

腾讯云TencentOS Server镜像系统常见问题解答

腾讯云TencentOS Server镜像是腾讯云推出的Linux操作系统,完全兼容CentOS生态和操作方式,TencentOS Server操作系统为云上运行的应用程序提供稳定、安全和高性能的执行环境,TencentOS可以运行在腾讯云CVM全规格实例上,包括黑石物理…...

【项目 进程13】2.28共享内存(1) 2.29共享内存(2)

文章目录 2.28共享内存(1)共享内存(效率最高,比内存映射更高。因为内存映射还需一个文件做载体)共享内存使用步骤共享内存操作函数头文件 2.29共享内存(2)共享内存相关问题共享内存和内存映射的…...

Flask框架-流量控制:flask-limiter的使用

一、flask使用flask-limiter存在版本问题 Flask1.1.4 Flask-Bootstrap3.3.7.1 Flask-Caching1.9.0 Flask-Cors3.0.10 Flask-Limiter1.4 Flask-Migrate2.5.3 Flask-RESTful0.3.8 Flask-Script2.0.6 Flask-SocketIO5.0.1 Flask-Sockets0.2.1 Flask-SQLAlchemy2.4.4 Jinjia22.11.…...

【机器学习】西瓜书习题3.5Python编程实现线性判别分析,并给出西瓜数据集 3.0α上的结果

参考代码 结合自己的理解,添加注释。 代码 导入相关的库 import numpy as np import pandas as pd import matplotlib from matplotlib import pyplot as plt导入数据,进行数据处理和特征工程 得到数据集 D { ( x i , y i ) } i 1 m , y i ∈ { 0 ,…...

Elasticsearch:通过动态修剪实现更快的基数聚合

作者:Adrien Grand Elasticsearch 8.9 通过支持动态修剪(dynamic pruning)引入了基数聚合加速。 这种优化需要满足特定的条件才能生效,但一旦实现,通常会产生惊人的结果。 我们观察到,通过此更改࿰…...

Webpack5 生产模式压缩图片ImageMinimizerPlugin

文章目录 一、 ImageMinimizerPlugin是什么?二、已经有了asset,为什么需要ImageMinimizerPlugin?三、怎么使用ImageMinimizerPlugin?四、ImageMinimizerPlugin压缩的成果 一、 ImageMinimizerPlugin是什么? 它的实际依…...

时序预测 | Matlab实现基于BP神经网络的电力负荷预测模型

文章目录 效果一览文章概述源码设计参考资料效果一览 文章概述 时序预测 | Matlab实现基于BP神经网络的电力负荷预测模型 BP神经网络是一种多层的前馈神经网络,其主要的特点是:信号是前向传播的,而误差是反向传播的。B...

基于回溯算法实现八皇后问题

八皇后问题是一个经典的计算机科学问题,它的目标是将8个皇后放置在一个大小为88的棋盘上,使得每个皇后都不会攻击到其他的皇后。皇后可以攻击同一行、同一列和同一对角线上的棋子。 一、八皇后问题介绍 八皇后问题最早由国际西洋棋大师马克斯贝瑟尔在18…...

Linux【网络编程】之深入理解TCP协议

Linux【网络编程】之深入理解TCP协议 TCP协议TCP协议段格式4位首部长度---TCP报头长度信息 TCP可靠性(确认应答)&& 提高传输效率确认应答(ACK)机制32位序号与32为确认序号 16位窗口大小---自己接收缓冲区剩余空间的大小16位紧急指针---紧急数据处…...

如何克服看到别人优于自己而感到的焦虑和迷茫?

文章目录 每日一句正能量前言简述自己的感受怎么做如何调整自己的心态后记 每日一句正能量 行动是至于恐惧的良药,而犹豫、拖延,将不断滋养恐惧。 前言 虽然清楚知识需要靠时间沉淀,但在看到自己做不出来的题别人会做,自己写不出的…...

浅谈React中的ref和useRef

目录 什么是useRef? 使用 ref 访问 DOM 元素 Ref和useRef之间的区别 Ref和useRef的使用案例 善用工具 结论 在各种 JavaScript 库和框架中,React 因其开发人员友好性和支持性而得到认可。 大多数开发人员发现 React 非常舒适且可扩展,…...

Linux C 获取主机网卡名及 IP 的几种方法

在进行 Linux 网络编程时,经常会需要获取本机 IP 地址,除了常规的读取配置文件外,本文罗列几种个人所知的编程常用方法,仅供参考,如有错误请指出。 方法一:使用 ioctl() 获取本地 IP 地址 Linux 下可以使用…...

解密外接显卡:笔记本能否接外置显卡?如何连接外接显卡?

伴随着电脑游戏和图形处理的需求不断增加,很多笔记本电脑使用者开始考虑是否能够通过外接显卡来提升性能。然而,外接显卡对于笔记本电脑是否可行,以及如何连接外接显卡,对于很多人来说仍然是一个迷。本文将为您揭秘外接显卡的奥秘…...

list与erase()

运行代码: //list与erase() #include"std_lib_facilities.h" //声明Item类 struct Item {string name;int iid;double value;Item():name(" "),iid(0),value(0.0){}Item(string ss,int ii,double vv):name(ss),iid(ii),value(vv){}friend istr…...

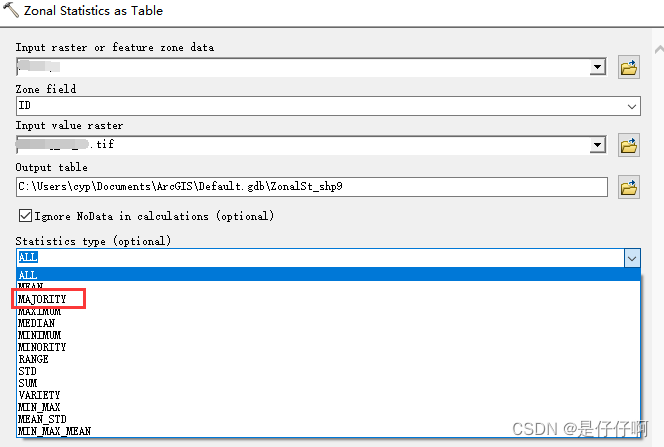

Arcgis 分区统计majority参数统计问题

利用Arcgis 进行分区统计时,需要统计不同矢量区域中栅格数据的众数(majority),出现无法统计majority参数问题解决 解决:利用copy raster工具,将原始栅格数据 64bit转为16bit...

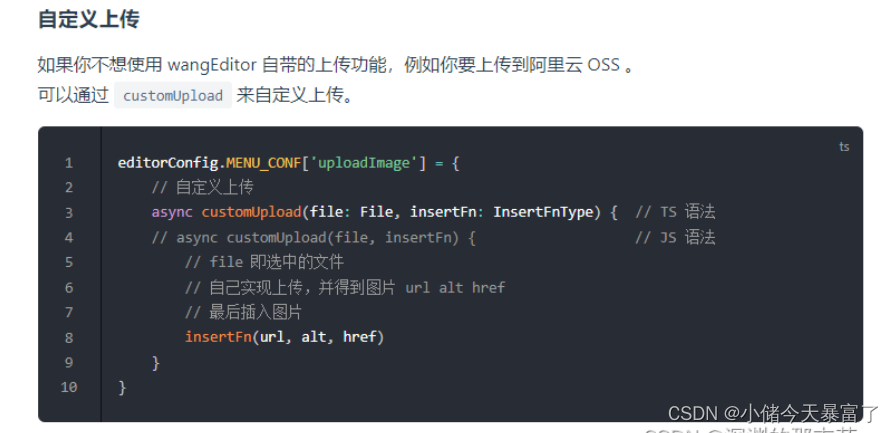

vue2+wangEditor5富文本编辑器(图片视频自定义上传七牛云/服务器)

1、安装使用 安装 yarn add wangeditor/editor # 或者 npm install wangeditor/editor --save yarn add wangeditor/editor-for-vue # 或者 npm install wangeditor/editor-for-vue --save在main.js中引入样式 import wangeditor/editor/dist/css/style.css在使用编辑器的页…...

shell脚本练习--安全封堵脚本,使用firewalld实现

一.什么是安全封堵 安全封堵(security hardening)是指采取一系列措施来增强系统的安全性,防止潜在的攻击和漏洞利用。以下是一些常见的安全封堵措施: 更新和修补系统:定期更新操作系统和软件包以获取最新的安全补丁和修…...

双端冒泡排序

双端冒泡排序是对传统冒泡排序的改进,其主要改进在于同时从两端开始排序,相对于传统冒泡排序每次只从一端开始排序,这样可以减少排序的遍历次数。 传统冒泡排序从一端开始,每次将最大(或最小)的元素冒泡到…...

如何在Visual Studio Code中用Mocha对TypeScript进行测试

目录 使用TypeScript编写测试用例 在Visual Studio Code中使用调试器在线调试代码 首先,本文不是一篇介绍有关TypeScript、JavaScript或其它编程语言数据结构和算法的文章。如果你正在准备一场面试,或者学习某一个课程,互联网上可以找到许多…...

蓝桥杯 2024 15届国赛 A组 儿童节快乐

P10576 [蓝桥杯 2024 国 A] 儿童节快乐 题目描述 五彩斑斓的气球在蓝天下悠然飘荡,轻快的音乐在耳边持续回荡,小朋友们手牵着手一同畅快欢笑。在这样一片安乐祥和的氛围下,六一来了。 今天是六一儿童节,小蓝老师为了让大家在节…...

Java-41 深入浅出 Spring - 声明式事务的支持 事务配置 XML模式 XML+注解模式

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

HBuilderX安装(uni-app和小程序开发)

下载HBuilderX 访问官方网站:https://www.dcloud.io/hbuilderx.html 根据您的操作系统选择合适版本: Windows版(推荐下载标准版) Windows系统安装步骤 运行安装程序: 双击下载的.exe安装文件 如果出现安全提示&…...

智能分布式爬虫的数据处理流水线优化:基于深度强化学习的数据质量控制

在数字化浪潮席卷全球的今天,数据已成为企业和研究机构的核心资产。智能分布式爬虫作为高效的数据采集工具,在大规模数据获取中发挥着关键作用。然而,传统的数据处理流水线在面对复杂多变的网络环境和海量异构数据时,常出现数据质…...

Maven 概述、安装、配置、仓库、私服详解

目录 1、Maven 概述 1.1 Maven 的定义 1.2 Maven 解决的问题 1.3 Maven 的核心特性与优势 2、Maven 安装 2.1 下载 Maven 2.2 安装配置 Maven 2.3 测试安装 2.4 修改 Maven 本地仓库的默认路径 3、Maven 配置 3.1 配置本地仓库 3.2 配置 JDK 3.3 IDEA 配置本地 Ma…...

蓝桥杯 冶炼金属

原题目链接 🔧 冶炼金属转换率推测题解 📜 原题描述 小蓝有一个神奇的炉子用于将普通金属 O O O 冶炼成为一种特殊金属 X X X。这个炉子有一个属性叫转换率 V V V,是一个正整数,表示每 V V V 个普通金属 O O O 可以冶炼出 …...

腾讯云V3签名

想要接入腾讯云的Api,必然先按其文档计算出所要求的签名。 之前也调用过腾讯云的接口,但总是卡在签名这一步,最后放弃选择SDK,这次终于自己代码实现。 可能腾讯云翻新了接口文档,现在阅读起来,清晰了很多&…...

[ACTF2020 新生赛]Include 1(php://filter伪协议)

题目 做法 启动靶机,点进去 点进去 查看URL,有 ?fileflag.php说明存在文件包含,原理是php://filter 协议 当它与包含函数结合时,php://filter流会被当作php文件执行。 用php://filter加编码,能让PHP把文件内容…...

详细解析)

Caliper 负载(Workload)详细解析

Caliper 负载(Workload)详细解析 负载(Workload)是 Caliper 性能测试的核心部分,它定义了测试期间要执行的具体合约调用行为和交易模式。下面我将全面深入地讲解负载的各个方面。 一、负载模块基本结构 一个典型的负载模块(如 workload.js)包含以下基本结构: use strict;/…...

Linux系统部署KES

1、安装准备 1.版本说明V008R006C009B0014 V008:是version产品的大版本。 R006:是release产品特性版本。 C009:是通用版 B0014:是build开发过程中的构建版本2.硬件要求 #安全版和企业版 内存:1GB 以上 硬盘…...