GoogLeNet卷积神经网络输出数据形参分析-笔记

GoogLeNet卷积神经网络输出数据形参分析-笔记

分析结果为:

输入数据形状:[10, 3, 224, 224]

最后输出结果:linear_0 [10, 1] [1024, 1] [1]

子空间执行逻辑

def forward_old(self, x):# 支路1只包含一个1x1卷积p1 = F.relu(self.p1_1(x))# 支路2包含 1x1卷积 + 3x3卷积p2 = F.relu(self.p2_2(F.relu(self.p2_1(x))))# 支路3包含 1x1卷积 + 5x5卷积p3 = F.relu(self.p3_2(F.relu(self.p3_1(x))))# 支路4包含 最大池化和1x1卷积p4 = F.relu(self.p4_2(self.p4_1(x)))# 将每个支路的输出特征图拼接在一起作为最终的输出结果return paddle.concat([p1, p2, p3, p4], axis=1)# return self.batchnorm()

其中拼接张量情况为:

拼接代码:paddle.concat([p1, p2, p3, p4], axis=1)

如

p1=[10,64,5,6,56]

p2=[10,128,56,56]

p3=[10,32,56,56]

p4=[10,32,56,56]

拼接后结果为:【10,256,56,56】 sum(64+128+32+32)=256

分析详细过程如下所示:

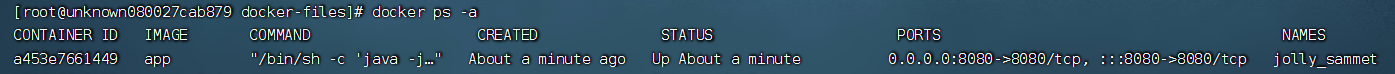

PS E:\project\python> & D:/ProgramData/Anaconda3/python.exe e:/project/python/PM/GoogLeNet_PM.py

W0804 11:14:26.736726 5484 gpu_resources.cc:61] Please NOTE: device: 0, GPU Compute Capability: 6.1, Driver API Version: 12.2, Runtime API Version: 10.2

W0804 11:14:26.747695 5484 gpu_resources.cc:91] device: 0, cuDNN Version: 7.6.

116

(10, 3, 224, 224)

[10, 3, 224, 224]

#第一模块 包括一个7X7的卷积

conv2d_0 [10, 64, 224, 224] [64, 3, 7, 7] [64]

# 3x3最大池化

max_pool2d_0 [10, 64, 112, 112]

# 第二个模块包含2个卷积层

conv2d_1 [10, 64, 112, 112] [64, 64, 1, 1] [64]

conv2d_2 [10, 192, 112, 112] [192, 64, 3, 3] [192]

# 3x3最大池化

max_pool2d_1 [10, 192, 56, 56]

# 第三个模块包含2个Inception块

print block3-1: Inception盗梦空间1 即子空间1

conv2d_3 [10, 64, 56, 56] [64, 192, 1, 1] [64]

conv2d_4 [10, 96, 56, 56] [96, 192, 1, 1] [96]

conv2d_5 [10, 128, 56, 56] [128, 96, 3, 3] [128]

conv2d_6 [10, 16, 56, 56] [16, 192, 1, 1] [16]

conv2d_7 [10, 32, 56, 56] [32, 16, 5, 5] [32]

max_pool2d_2 [10, 192, 56, 56]

conv2d_8 [10, 32, 56, 56] [32, 192, 1, 1] [32]

block3_1.shape= [10, 256, 56, 56]

print block3-2: Inception盗梦空间2 即子空间2

conv2d_9 [10, 128, 56, 56] [128, 256, 1, 1] [128]

conv2d_10 [10, 128, 56, 56] [128, 256, 1, 1] [128]

conv2d_11 [10, 192, 56, 56] [192, 128, 3, 3] [192]

conv2d_12 [10, 32, 56, 56] [32, 256, 1, 1] [32]

conv2d_13 [10, 96, 56, 56] [96, 32, 5, 5] [96]

max_pool2d_3 [10, 256, 56, 56]

conv2d_14 [10, 64, 56, 56] [64, 256, 1, 1] [64]

block3_2.shape= [10, 480, 56, 56]

# 3x3最大池化

max_pool2d_4 [10, 480, 28, 28]

# 第四个模块包含5个Inception块

print block4_1:

conv2d_15 [10, 192, 28, 28] [192, 480, 1, 1] [192]

conv2d_16 [10, 96, 28, 28] [96, 480, 1, 1] [96]

conv2d_17 [10, 208, 28, 28] [208, 96, 3, 3] [208]

conv2d_18 [10, 16, 28, 28] [16, 480, 1, 1] [16]

conv2d_19 [10, 48, 28, 28] [48, 16, 5, 5] [48]

max_pool2d_5 [10, 480, 28, 28]

conv2d_20 [10, 64, 28, 28] [64, 480, 1, 1] [64]

block4_1.shape= [10, 512, 28, 28]

print block4_2:

conv2d_21 [10, 160, 28, 28] [160, 512, 1, 1] [160]

conv2d_22 [10, 112, 28, 28] [112, 512, 1, 1] [112]

conv2d_23 [10, 224, 28, 28] [224, 112, 3, 3] [224]

conv2d_24 [10, 24, 28, 28] [24, 512, 1, 1] [24]

conv2d_25 [10, 64, 28, 28] [64, 24, 5, 5] [64]

max_pool2d_6 [10, 512, 28, 28]

conv2d_26 [10, 64, 28, 28] [64, 512, 1, 1] [64]

block4_2.shape= [10, 512, 28, 28]

print block4_3:

conv2d_27 [10, 128, 28, 28] [128, 512, 1, 1] [128]

conv2d_28 [10, 128, 28, 28] [128, 512, 1, 1] [128]

conv2d_29 [10, 256, 28, 28] [256, 128, 3, 3] [256]

conv2d_30 [10, 24, 28, 28] [24, 512, 1, 1] [24]

conv2d_31 [10, 64, 28, 28] [64, 24, 5, 5] [64]

max_pool2d_7 [10, 512, 28, 28]

conv2d_32 [10, 64, 28, 28] [64, 512, 1, 1] [64]

block4_3.shape= [10, 512, 28, 28]

print block4_4:

conv2d_33 [10, 112, 28, 28] [112, 512, 1, 1] [112]

conv2d_34 [10, 144, 28, 28] [144, 512, 1, 1] [144]

conv2d_35 [10, 288, 28, 28] [288, 144, 3, 3] [288]

conv2d_36 [10, 32, 28, 28] [32, 512, 1, 1] [32]

conv2d_37 [10, 64, 28, 28] [64, 32, 5, 5] [64]

max_pool2d_8 [10, 512, 28, 28]

conv2d_38 [10, 64, 28, 28] [64, 512, 1, 1] [64]

block4_4.shape= [10, 528, 28, 28]

print block4_5:

conv2d_39 [10, 256, 28, 28] [256, 528, 1, 1] [256]

conv2d_40 [10, 160, 28, 28] [160, 528, 1, 1] [160]

conv2d_41 [10, 320, 28, 28] [320, 160, 3, 3] [320]

conv2d_42 [10, 32, 28, 28] [32, 528, 1, 1] [32]

conv2d_43 [10, 128, 28, 28] [128, 32, 5, 5] [128]

max_pool2d_9 [10, 528, 28, 28]

conv2d_44 [10, 128, 28, 28] [128, 528, 1, 1] [128]

block4_5.shape= [10, 832, 28, 28]

max_pool2d_10 [10, 832, 14, 14]

# 第五个模块包含2个Inception块(block5_1,block5_2)

print block5_1:

conv2d_45 [10, 256, 14, 14] [256, 832, 1, 1] [256]

conv2d_46 [10, 160, 14, 14] [160, 832, 1, 1] [160]

conv2d_47 [10, 320, 14, 14] [320, 160, 3, 3] [320]

conv2d_48 [10, 32, 14, 14] [32, 832, 1, 1] [32]

conv2d_49 [10, 128, 14, 14] [128, 32, 5, 5] [128]

max_pool2d_11 [10, 832, 14, 14]

conv2d_50 [10, 128, 14, 14] [128, 832, 1, 1] [128]

block5_1.shape= [10, 832, 14, 14]

print block5_2:

conv2d_51 [10, 384, 14, 14] [384, 832, 1, 1] [384]

conv2d_52 [10, 192, 14, 14] [192, 832, 1, 1] [192]

conv2d_53 [10, 384, 14, 14] [384, 192, 3, 3] [384]

conv2d_54 [10, 48, 14, 14] [48, 832, 1, 1] [48]

conv2d_55 [10, 128, 14, 14] [128, 48, 5, 5] [128]

max_pool2d_12 [10, 832, 14, 14]

conv2d_56 [10, 128, 14, 14] [128, 832, 1, 1] [128]

block5_2.shape= [10, 1024, 14, 14]

adaptive_avg_pool2d_0 [10, 1024, 1, 1]

linear_0 [10, 1] [1024, 1] [1]

PS E:\project\python>

分析测试代码如下所示:

# GoogLeNet模型代码

#GoogLeNet卷积神经网络-笔记

import numpy as np

import paddle

from paddle.nn import Conv2D, MaxPool2D, AdaptiveAvgPool2D, Linear

## 组网

import paddle.nn.functional as F#分析形参定制版本方法

def printItem(item,x):# item是CNN类中的一个子层# 查看经过子层之后的输出数据形状try:x = item(x)except:x = paddle.reshape(x, [x.shape[0], -1])x = item(x) if len(item.parameters())==2:# 查看卷积和全连接层的数据和参数的形状,# 其中item.parameters()[0]是权重参数w,item.parameters()[1]是偏置参数bprint(item.full_name(), x.shape, item.parameters()[0].shape, item.parameters()[1].shape)else:# 池化层没有参数print(item.full_name(), x.shape) return x; # 定义Inception块

class Inception(paddle.nn.Layer):def __init__(self, c0, c1, c2, c3, c4, **kwargs):'''Inception模块的实现代码,c1,图(b)中第一条支路1x1卷积的输出通道数,数据类型是整数c2,图(b)中第二条支路卷积的输出通道数,数据类型是tuple或list, 其中c2[0]是1x1卷积的输出通道数,c2[1]是3x3c3,图(b)中第三条支路卷积的输出通道数,数据类型是tuple或list, 其中c3[0]是1x1卷积的输出通道数,c3[1]是3x3c4,图(b)中第一条支路1x1卷积的输出通道数,数据类型是整数'''super(Inception, self).__init__()# 依次创建Inception块每条支路上使用到的操作self.p1_1 = Conv2D(in_channels=c0,out_channels=c1, kernel_size=1, stride=1)self.p2_1 = Conv2D(in_channels=c0,out_channels=c2[0], kernel_size=1, stride=1)self.p2_2 = Conv2D(in_channels=c2[0],out_channels=c2[1], kernel_size=3, padding=1, stride=1)self.p3_1 = Conv2D(in_channels=c0,out_channels=c3[0], kernel_size=1, stride=1)self.p3_2 = Conv2D(in_channels=c3[0],out_channels=c3[1], kernel_size=5, padding=2, stride=1)self.p4_1 = MaxPool2D(kernel_size=3, stride=1, padding=1)self.p4_2 = Conv2D(in_channels=c0,out_channels=c4, kernel_size=1, stride=1)# # 新加一层batchnorm稳定收敛# self.batchnorm = paddle.nn.BatchNorm2D(c1+c2[1]+c3[1]+c4)def forward_old(self, x):# 支路1只包含一个1x1卷积p1 = F.relu(self.p1_1(x))# 支路2包含 1x1卷积 + 3x3卷积p2 = F.relu(self.p2_2(F.relu(self.p2_1(x))))# 支路3包含 1x1卷积 + 5x5卷积p3 = F.relu(self.p3_2(F.relu(self.p3_1(x))))# 支路4包含 最大池化和1x1卷积p4 = F.relu(self.p4_2(self.p4_1(x)))# 将每个支路的输出特征图拼接在一起作为最终的输出结果return paddle.concat([p1, p2, p3, p4], axis=1)# return self.batchnorm()#分析形参定制版本方法def forward(self,x):p1=printItem(self.p1_1,x)p1=F.relu(p1)#p2=printItem(self.p2_1,x)p2=F.relu(p2)p2=printItem(self.p2_2,p2)p2=F.relu(p2)#p3=printItem(self.p3_1,x)p3=F.relu(p3)p3=printItem(self.p3_2,p3)p3=F.relu(p3)#p4=printItem(self.p4_1,x)p4=printItem(self.p4_2,p4)p4=F.relu(p4)return paddle.concat([p1, p2, p3, p4], axis=1);class GoogLeNet(paddle.nn.Layer):def __init__(self):super(GoogLeNet, self).__init__()# GoogLeNet包含五个模块,每个模块后面紧跟一个池化层# 第一个模块包含1个卷积层self.conv1 = Conv2D(in_channels=3,out_channels=64, kernel_size=7, padding=3, stride=1)# 3x3最大池化self.pool1 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第二个模块包含2个卷积层self.conv2_1 = Conv2D(in_channels=64,out_channels=64, kernel_size=1, stride=1)self.conv2_2 = Conv2D(in_channels=64,out_channels=192, kernel_size=3, padding=1, stride=1)# 3x3最大池化self.pool2 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第三个模块包含2个Inception块self.block3_1 = Inception(192, 64, (96, 128), (16, 32), 32)self.block3_2 = Inception(256, 128, (128, 192), (32, 96), 64)# 3x3最大池化self.pool3 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第四个模块包含5个Inception块self.block4_1 = Inception(480, 192, (96, 208), (16, 48), 64)self.block4_2 = Inception(512, 160, (112, 224), (24, 64), 64)self.block4_3 = Inception(512, 128, (128, 256), (24, 64), 64)self.block4_4 = Inception(512, 112, (144, 288), (32, 64), 64)self.block4_5 = Inception(528, 256, (160, 320), (32, 128), 128)# 3x3最大池化self.pool4 = MaxPool2D(kernel_size=3, stride=2, padding=1)# 第五个模块包含2个Inception块self.block5_1 = Inception(832, 256, (160, 320), (32, 128), 128)self.block5_2 = Inception(832, 384, (192, 384), (48, 128), 128)# 全局池化,用的是global_pooling,不需要设置pool_strideself.pool5 = AdaptiveAvgPool2D(output_size=1)self.fc = Linear(in_features=1024, out_features=1)def forward(self, x):x = self.pool1(F.relu(self.conv1(x)))x = self.pool2(F.relu(self.conv2_2(F.relu(self.conv2_1(x)))))x = self.pool3(self.block3_2(self.block3_1(x)))x = self.block4_3(self.block4_2(self.block4_1(x)))x = self.pool4(self.block4_5(self.block4_4(x)))x = self.pool5(self.block5_2(self.block5_1(x)))x = paddle.reshape(x, [x.shape[0], -1])x = self.fc(x)return x#分析形参定制版本方法 def printStruct(self,x):print(x.shape)x = paddle.to_tensor(x) #转为张量xprint(x.shape)#x=printItem(self.conv1,x)x=F.relu(x)x=printItem(self.pool1,x)#x=printItem(self.conv2_1,x) x=F.relu(x)x=printItem(self.conv2_2,x) x=F.relu(x) x=printItem(self.pool2,x)# print('print block3-1:') x=self.block3_1(x)print('block3_1.shape=',x.shape)print('print block3-2:') x=self.block3_2(x) print('block3_2.shape=',x.shape) x=printItem(self.pool3,x) #print('print block4_1:') x=self.block4_1(x)print('block4_1.shape=',x.shape) print('print block4_2:') x=self.block4_2(x) print('block4_2.shape=',x.shape)print('print block4_3:') x=self.block4_3(x) print('block4_3.shape=',x.shape)print('print block4_4:') x=self.block4_4(x) print('block4_4.shape=',x.shape)print('print block4_5:') x=self.block4_5(x) print('block4_5.shape=',x.shape) x=printItem(self.pool4,x) #print('print block5_1:') x=self.block5_1(x) print('block5_1.shape=',x.shape) print('print block5_2:') x=self.block5_2(x) print('block5_2.shape=',x.shape) x=printItem(self.pool5,x) x = paddle.reshape(x, [x.shape[0], -1])x=printItem(self.fc,x)return x#=================================

import PM

# 创建模型

model = GoogLeNet()

print(len(model.parameters()))

opt = paddle.optimizer.Momentum(learning_rate=0.001, momentum=0.9, parameters=model.parameters(), weight_decay=0.001)

# 启动训练过程

#PM.train_pm(model, opt)'''

#输出结果:

PS E:\project\python> & D:/ProgramData/Anaconda3/python.exe e:/project/python/PM/GoogLeNet_PM.py

W0803 18:25:55.522811 8308 gpu_resources.cc:61] Please NOTE: device: 0, GPU Compute Capability: 6.1, Driver API Version: 12.2, Runtime API Version: 10.2

W0803 18:25:55.532805 8308 gpu_resources.cc:91] device: 0, cuDNN Version: 7.6.

116

start training ...

epoch: 0, batch_id: 0, loss is: 0.6920

epoch: 0, batch_id: 20, loss is: 0.8546

[validation] accuracy/loss: 0.7100/0.5381

epoch: 1, batch_id: 0, loss is: 0.6177

epoch: 1, batch_id: 20, loss is: 0.4581

[validation] accuracy/loss: 0.9400/0.3120

epoch: 2, batch_id: 0, loss is: 0.2858

epoch: 2, batch_id: 20, loss is: 0.5234

[validation] accuracy/loss: 0.5975/0.5757

epoch: 3, batch_id: 0, loss is: 0.6338

epoch: 3, batch_id: 20, loss is: 0.3180

[validation] accuracy/loss: 0.9575/0.1915

epoch: 4, batch_id: 0, loss is: 0.1087

epoch: 4, batch_id: 20, loss is: 0.3728

[validation] accuracy/loss: 0.9500/0.2322

PS E:\project\python>

'''# 输入数据形状是 [N, 3, H, W]

# 这里用np.random创建一个随机数组作为输入数据

x = np.random.randn(*[10,3,224,224])

x = x.astype('float32')

# 创建CNN类的实例,指定模型名称和分类的类别数目

#model = VGG(1)

#

model.printStruct(x);

#相关文章:

GoogLeNet卷积神经网络输出数据形参分析-笔记

GoogLeNet卷积神经网络输出数据形参分析-笔记 分析结果为: 输入数据形状:[10, 3, 224, 224] 最后输出结果:linear_0 [10, 1] [1024, 1] [1] 子空间执行逻辑 def forward_old(self, x):# 支路1只包含一个1x1卷积p1 F.relu(self.p1_1(x))# 支路2包含 1…...

【docker】dockerfile发布springboot项目

目录 一、实现步骤二、示例 一、实现步骤 1.定义父镜像:FROM java:8 2.定义作者信息:MAINTAINER:learn_docker<https://www.docker.com> 3.将jar包添加到容器:ADD jar包名称.jar app.jar 4.定义容器启动执行命令:…...

利用docker run -v 命令实现使用宿主机中没有的命令

利用docker run -v 命令实现使用宿主机中没有的命令 使用容器中的jar命令解压jar包,并将解压内容输出到挂载在宿主机中的目录里 使用容器中的jar命令解压jar包,并将解压内容输出到挂载在宿主机中的目录里 docker run -it --name java -v /www/temp/java…...

【小沐学NLP】在线AI绘画网站(百度:文心一格)

文章目录 1、简介2、文心一格2.1 功能简介2.2 操作步骤2.3 使用费用2.4 若干示例2.4.1 女孩2.4.2 昙花2.4.3 山水画2.4.4 夜晚2.4.5 古诗2.4.6 二次元2.4.7 帅哥 结语 1、简介 当下,越来越多AI领域前沿技术争相落地,逐步释放出极大的产业价值࿰…...

react经验5:访问子组件内容

应用场景 父级需要调用子组件的某函数 实现步骤 案例:创建自定义按钮 button.tsx import { Ref, forwardRef, useImperativeHandle,ReactNode} from "react" declare type ButtonProps {/**按钮文字 */children?: ReactNode,onClick?: () > voi…...

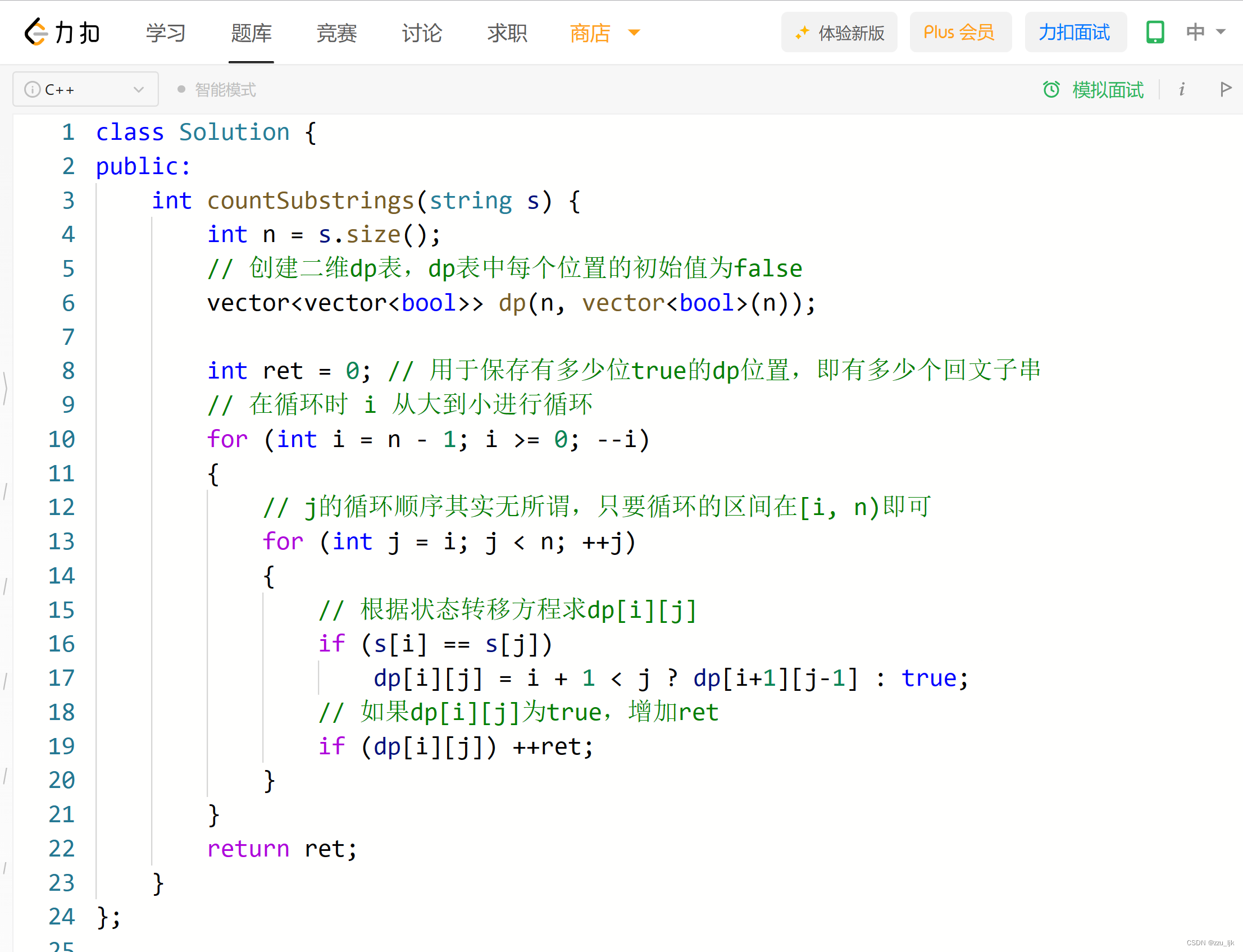

【LeetCode】647. 回文子串

题目链接 文章目录 1. 思路讲解1.1 方法选择1.2 dp表的创建1.3 状态转移方程1.4 填表顺序 2. 代码实现 1. 思路讲解 1.1 方法选择 这道题我们采用动态规划的解法,倒不是动态规划的解法对于这道题有多好,它并不是最优解。但是,这道题的动态…...

角度制与弧度制的相互转换)

Open3D(C++) 角度制与弧度制的相互转换

目录 一、弧度转角度1、计算公式2、主要函数3、示例代码4、结果展示二、角度转弧度1、计算公式2、主要函数3、示例代码4、结果展示三、归一化到(-PI,PI)1、主要函数<...

【小沐学NLP】在线AI绘画网站(网易云课堂:AI绘画工坊)

文章目录 1、简介1.1 参与方式1.2 模型简介 2、使用费用3、操作步骤3.1 选择模型3.2 输入提示词3.3 调整参数3.4 图片生成 4、测试例子4.1 小狗4.2 蜘蛛侠4.3 人物4.4 龙猫 结语 1、简介 Stable Diffusion是一种强大的图像生成AI,它可以根据输入的文字描述词&#…...

GNN code Tips

1. 重置label取值范围 problem: otherwise occurs IndexError: target out of bounds # reset labels value range, otherwise occurs IndexError: target out of bounds uni_set torch.unique(labels) to_set torch.tensor(list(range(len(uni_set)))) labels_reset label…...

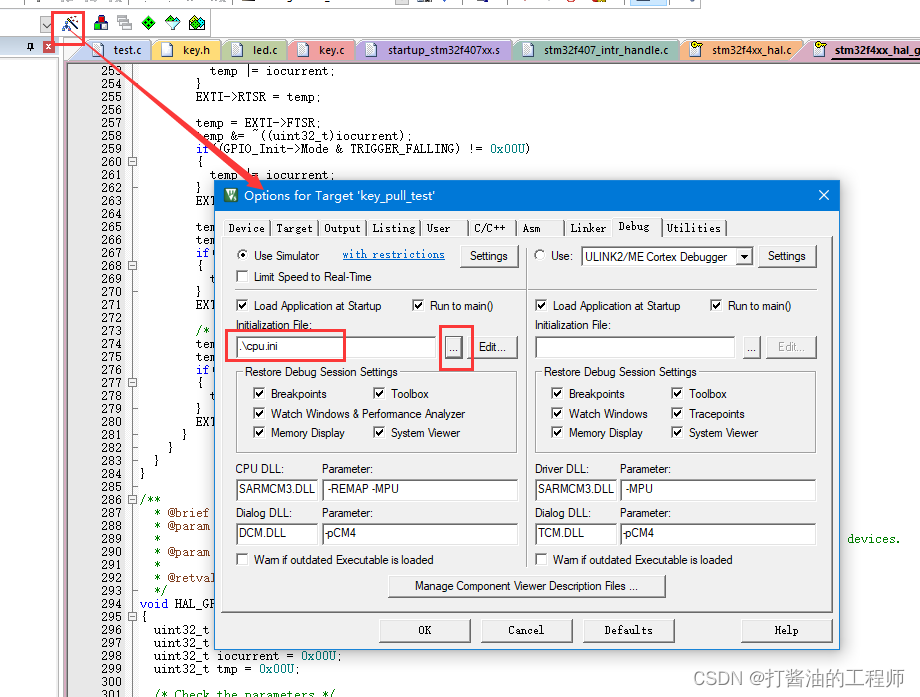

物联网|按键实验---学习I/O的输入及中断的编程|函数说明的格式|如何使用CMSIS的延时|读取通过外部中断实现按键捕获代码的实现及分析-学习笔记(14)

文章目录 通过外部中断实现按键捕获代码的实现及分析Tip1:函数说明的格式Tip2:如何使用CMSIS的延时GetTick函数原型stm32f407_intr_handle.c解析中断处理函数:void EXTI4_IRQHandler 调试流程软件模拟调试 两种代码的比较课后作业: 通过外部中断实现按键捕获代码的实…...

Java对象的前世今生

文章目录 一、创建对象的步骤二、类加载机制三、内存分配指针碰撞 (内存连续)空闲列表 (内存不连续) 四、创建对象的5种方法五、浅拷贝与深拷贝 以下一行代码内部发生了什么? Person person new Person();一、创建对象的步骤 根据JLS中的规定,Java对象…...

Qt中JSON的使用

一.前言: JSON是一种轻量级数据交换格式,常用于客户端和服务端的数据交互,不依赖于编程语言,在很多编程语言中都可以使用JSON,比如C,C,Java,Android,Qt。除了JSON&#x…...

linux安装Tomcat部署jpress教程

yum在线安装: 查看tomcat相关的安装包: [rootRHCE ~]# yum list | grep -i tomcat tomcat.noarch 7.0.76-16.el7_9 updates tomcat-el-2.2-api.noarch 7.0.76-16.el7_9 updat…...

高并发负载均衡---LVS

目录 前言 一:负载均衡概述 二:为啥负载均衡服务器这么快呢? 编辑 2.1 七层应用程序慢的原因 2.2 四层负载均衡器LVS快的原因 三:LVS负载均衡器的三种模式 3.1 NAT模式 3.1.1 什么是NAT模式 3.1.2 NAT模式实现LVS的缺点…...

微前端中的 CSS

本文为翻译 本文译者为 360 奇舞团前端开发工程师原文标题:CSS in Micro Frontends 原文作者:Florian Rappl 原文地址:https://dev.to/florianrappl/css-in-micro-frontends-4jai 我被问得最多的问题之一是如何在微前端中处理 CSS。毕竟&…...

)

在CSDN学Golang场景化解决方案(分布式日志系统)

一,传统 elk 解决方案及其弊端 传统ELK(Elasticsearch Logstash Kibana)方案是一种流行的分布式日志系统解决方案,但也存在一些弊端: 依赖性:ELK使用Java编写,需要安装JVM,并且还…...

电脑第一次使用屏幕键盘

操作流程 1.在键盘上同时按WinR打开运行; 2.输入control 3.找到设置中心 4.点击屏幕键盘 效果 具体怎么使用 我不咋清除 简单 测试了一下 可以用鼠标点击屏幕键盘的按键 用键盘 按字母键和数字键 是和屏幕键盘不同步的 其他 tab、shift、后退、enter好像同步...

【C#学习笔记】类型转换

文章目录 类型转换字符转数字GetNumericValueConvert.ToInt32隐式转换计算 字符串转数字Parse 或 TryParse 方法 字节数组转整数 as,is强制类型转换isas 用户定义的转换 类型转换 我们简单地将值类型分为5种:整数型,浮点型,布尔型…...

SpringBoot+SSM实战<一>:打造高效便捷的企业级Java外卖订购系统

文章目录 项目简介项目架构功能模块管理端用户端 技术选型用户层网关层应用层数据层工具 项目优缺点结语 黑马程序员最新Java项目实战《苍穹外卖》:让你轻松掌握SpringBootSSM的企业级开发技巧项目简介 《苍穹外卖》是一款为餐饮企业(餐厅、饭店&#x…...

笙默考试管理系统-MyExamTest--calculagraph

笙默考试管理系统-MyExamTest--calculagra(1) 目录 一、 笙默考试管理系统-MyExamTest--calculagra 二、 笙默考试管理系统-MyExamTest--calculagra 三、 笙默考试管理系统-MyExamTest--calculagra 四、 笙默考试管理系统-MyExamTest--calculagra …...

stm32G473的flash模式是单bank还是双bank?

今天突然有人stm32G473的flash模式是单bank还是双bank?由于时间太久,我真忘记了。搜搜发现,还真有人和我一样。见下面的链接:https://shequ.stmicroelectronics.cn/forum.php?modviewthread&tid644563 根据STM32G4系列参考手…...

JavaScript 中的 ES|QL:利用 Apache Arrow 工具

作者:来自 Elastic Jeffrey Rengifo 学习如何将 ES|QL 与 JavaScript 的 Apache Arrow 客户端工具一起使用。 想获得 Elastic 认证吗?了解下一期 Elasticsearch Engineer 培训的时间吧! Elasticsearch 拥有众多新功能,助你为自己…...

Qt Widget类解析与代码注释

#include "widget.h" #include "ui_widget.h"Widget::Widget(QWidget *parent): QWidget(parent), ui(new Ui::Widget) {ui->setupUi(this); }Widget::~Widget() {delete ui; }//解释这串代码,写上注释 当然可以!这段代码是 Qt …...

从深圳崛起的“机器之眼”:赴港乐动机器人的万亿赛道赶考路

进入2025年以来,尽管围绕人形机器人、具身智能等机器人赛道的质疑声不断,但全球市场热度依然高涨,入局者持续增加。 以国内市场为例,天眼查专业版数据显示,截至5月底,我国现存在业、存续状态的机器人相关企…...

Rapidio门铃消息FIFO溢出机制

关于RapidIO门铃消息FIFO的溢出机制及其与中断抖动的关系,以下是深入解析: 门铃FIFO溢出的本质 在RapidIO系统中,门铃消息FIFO是硬件控制器内部的缓冲区,用于临时存储接收到的门铃消息(Doorbell Message)。…...

laravel8+vue3.0+element-plus搭建方法

创建 laravel8 项目 composer create-project --prefer-dist laravel/laravel laravel8 8.* 安装 laravel/ui composer require laravel/ui 修改 package.json 文件 "devDependencies": {"vue/compiler-sfc": "^3.0.7","axios": …...

GitFlow 工作模式(详解)

今天再学项目的过程中遇到使用gitflow模式管理代码,因此进行学习并且发布关于gitflow的一些思考 Git与GitFlow模式 我们在写代码的时候通常会进行网上保存,无论是github还是gittee,都是一种基于git去保存代码的形式,这样保存代码…...

uniapp手机号一键登录保姆级教程(包含前端和后端)

目录 前置条件创建uniapp项目并关联uniClound云空间开启一键登录模块并开通一键登录服务编写云函数并上传部署获取手机号流程(第一种) 前端直接调用云函数获取手机号(第三种)后台调用云函数获取手机号 错误码常见问题 前置条件 手机安装有sim卡手机开启…...

4. TypeScript 类型推断与类型组合

一、类型推断 (一) 什么是类型推断 TypeScript 的类型推断会根据变量、函数返回值、对象和数组的赋值和使用方式,自动确定它们的类型。 这一特性减少了显式类型注解的需要,在保持类型安全的同时简化了代码。通过分析上下文和初始值,TypeSc…...

MySQL 索引底层结构揭秘:B-Tree 与 B+Tree 的区别与应用

文章目录 一、背景知识:什么是 B-Tree 和 BTree? B-Tree(平衡多路查找树) BTree(B-Tree 的变种) 二、结构对比:一张图看懂 三、为什么 MySQL InnoDB 选择 BTree? 1. 范围查询更快 2…...