1-爬虫-requests模块快速使用,携带请求参数,url 编码和解码,携带请求头,发送post请求,携带cookie,响应对象, 高级用法

1 爬虫介绍

2 requests模块快速使用

3 携带请求参数

4 url 编码和解码

4 携带请求头

5 发送post请求

6 携带cookie

7 响应对象

8 高级用法

1 爬虫介绍

# 爬虫是什么?-网页蜘蛛,网络机器人,spider-在互联网中 通过 程序 自动的抓取数据 的过程-根上:使用程序 模拟发送http请求---》得到http响应---》把响应的数据解析出来---》存储起来# 做爬虫需要掌握的技术-web端爬虫(网页)-抓包:-抓包工具---》浏览器,charles,fiddler。。。-发送http请求的模块-requests:同步的---》不仅仅做爬虫用 调用第三方api就可以使用-request-html:-aiohttp:异步的http模块-解析库:http响应---》可能是xml,html,json,文件,图片。。。---》响应中解析出想要的数据-beautifulsoup4---》xml/html-lxml--->xml/html-selenium--->请求加解析(本质是模拟浏览器)-json-存储:mysql,redis,es,mongodb。。。。-pymysql:aiomysql-redis:aioredis-elasticsearch.py-py-mongo-移动端爬虫(app)-抓包,发请求,解析,存储跟web一样的-对app进行反编译---》jadx-安卓:java写的app---》把app反编译成java---》懂java---》看懂逻辑---》使用python模拟这个过程-hook技术---》frida-c语言写加密---》用java调用c语言的加密方式---》xx.so-->动态链接库文件-反编译 so文件---》IDA---》反编译成汇编和c-动态调试-python模拟这个过程即可-反扒-请求头反扒:user-agent,referfer:上一个访问的地址是什么-反扒:无限调试-封ip---》ip代理池-封账号---》cookie池-js加密---》js逆向# 动态链接库# 百度,谷歌 搜索引擎本质其实就是个大爬虫---》不停的在互联网上爬取页面---》存到自己的库中

使用搜索的时候---》去百度的数据库中查询相关的关键字----》显示在页面上---》当我们点击某一个---》真正的跳转到 真正的搜索到的页面百度做爬取时---》对动态页面的爬取权重要低

seo优化---》保证我们公司的网站通过关键字搜索,显示在第一个-伪静态---》

sem:付费买关键词2 requests模块快速使用

#介绍:使用requests可以模拟浏览器的请求,比起之前用到的urllib(内置模块),requests模块的api更加便捷(本质就是封装了urllib3)# 注意:requests库发送请求将网页内容下载下来以后,并不会执行js代码,这需要我们自己分析目标站点然后发起新的request请求-混合项目---》拿回来的页面---带数据-分离项目---》拿回来的页面--》数据是空的--》再分析接口---》再发请求才能拿到真正的数据-看到一个页面有数据---》用requests发送请求---》拿回来的,可能跟看到的不一样# 安装:pip install requests

# 快速使用import requests

res=requests.get('https://www.cnblogs.com/') # res中会有:http响应 响应头的,响应体的

print(res.text) # 响应体的文本字符串(可能会乱码)

3 携带请求参数

# 2 get请求携带请求参数

# 方式一:直接拼在后面

res=requests.get('https://www.cnblogs.com/?ordering=-id&search=课程')

# 方式二:使用params参数

res=requests.get('https://www.cnblogs.com/',params={'ordering':'-id','search':'课程'})

print(res.text)

4 url 编码和解码

from urllib import parse# %E7%BE%8E%E5%A5%B3 不是乱码---》url编码了

# url解码

res=parse.unquote('%E7%BE%8E%E5%A5%B3')

print(res)

# url编码

res=parse.quote('刷币') # %E5%88%B7%E5%B8%81

print(res)4 携带请求头

# 4 携带请求头

# 请求头中可能有的:User-Agent,referer,cookie,Host

header = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/116.0.0.0 Safari/537.36'

}

res = requests.get('https://www.sogou.com/web?query=%E7%BE%8E%E5%A5%B3', headers=header)

# res=requests.request('get','url',headers=header)

print(res.text)

5 发送post请求

# 5 发送post请求

# 5.1 请求体中:两种方式:data={}--->编码格式 urlencoded---》key=value&key=value json={}---》编码格式是json

res=requests.post('url')# 6 模拟登录

data = {'username': '616564099@qq.com','password': 'lqz123','captcha': 'xxxx','ref': 'http://www.aa7a.cn/','act': 'act_login',

}

res = requests.post('http://www.aa7a.cn/user.php', data=data)

print(res.text)

6 携带cookie

# 7 请求携带cookie 1 请求头中 2 带在cookie参数中

方式一:请求头中携带

header = {'Cookie': 'cto_bundle=_DpLll9WcDY3UCUyRlBnWDZtZEp5MVFZZHVHeExtdmtwNjVVYkh6SUglMkZoVmFaSWFtc1JrZWo0aVRURzdOeUhTUHpTekslMkJ0RjRnOXhqOWhXM0piM0hXVFlVVk9MUGpNWFdCS0dveFBFSEhHVmJRV01uVWZ1bjloTU9YY2VwQWF2NWxFQWhkZnM5TERxMVlUUkt4WUo2dWR4QkZOMmclM0QlM0Q; _jzqx=1.1691985966.1691985966.1.jzqsr=aa7a%2Ecn|jzqct=/.-; ECS_ID=a9bd0486ba5b0f2f65637f64719d72e75add4995; ECS[visit_times]=8; _jzqa=1.2593057364546894000.1672632545.1691985966.1698896326.9; _jzqc=1; _jzqy=1.1672632545.1698896326.1.jzqsr=baidu.-; _jzqckmp=1; Hm_lvt_c29657ca36c6c88e02fed9a397826038=1698896327; mediav=%7B%22eid%22%3A%22179539%22%2C%22ep%22%3A%22%22%2C%22vid%22%3A%22%22%2C%22ctn%22%3A%22%22%2C%22vvid%22%3A%22%22%2C%22_mvnf%22%3A1%2C%22_mvctn%22%3A0%2C%22_mvck%22%3A1%2C%22_refnf%22%3A0%7D; __xsptplus422=422.9.1698896372.1698896372.1%234%7C%7C%7C%7C%7C%23%23%23; Qs_lvt_201322=1686282645%2C1691979017%2C1691979065%2C1698896326%2C1698896643; __xsptplusUT_422=1; _qzjc=1; ECS[username]=616564099%40qq.com; ECS[user_id]=61399; ECS[password]=4a5e6ce9d1aba9de9b31abdf303bbdc2; _qzjb=1.1698896326296.7.0.0.0; _qzjto=7.1.0; _qzja=1.1154697895.1672632545402.1691985966161.1698896326296.1698896649094.1698896661921.616564099%2540qq_com.1.0.23.8; Hm_lpvt_c29657ca36c6c88e02fed9a397826038=1698896662; _jzqb=1.18.10.1698896326.1; Qs_pv_201322=1719398001187156200%2C1811149594340033000%2C1691949923920640300%2C4523589869790951000%2C2247541305320030700'

}

res = requests.get('http://www.aa7a.cn/',headers=header)

print('616564099@qq.com' in res.text) # 没有携带cookie 访问案例二:自动点赞

data = {'linkId': '40480287'

}

header = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/116.0.0.0 Safari/537.36','Cookie': 'deviceId=web.eyJ0eXAiOiJKV1QiLCJhbGciOiJIUzI1NiJ9.eyJqaWQiOiIwNGZlMmMxYy00Mjc4LTRlMzMtYjM5OS0zNTI0NTNiNzQ3ZDkiLCJleHBpcmUiOiIxNjgxNDQyNDI2ODUxIn0.k41tJ-jL5Y6TO4BabrtzUv8N35eLrfqfdvBdXEmtqxE; __snaker__id=kNv5rzTfGa3xsaqh; YD00000980905869%3AWM_TID=slUolCNNTm5FRQRAEVaBfKlPbFQL7kFG; Hm_lvt_03b2668f8e8699e91d479d62bc7630f1=1698896819; gdxidpyhxdE=4hhv3p0G9z1GUt%2BbmquM7o8uxAnU21e5Xv0hEnOwniLE617vQyijd%2FRfrVM3c8u%2Bb%2BSzE%2B612mU4JXDi6SwQC6tAIHEf9RPVR%2FZQB9AH0V4gazYRMoMlmhHeYBgfjGfe%2BhbYbX3x%2BdKE2dQUo1tJuYMCZr%2B8QdQapLAChI%5CbpM%2BhkIne%3A1698897721336; YD00000980905869%3AWM_NI=817ayMhIabFSD%2BFdoaOokCH5%2FLBINb0apxw2XgvsY2zLJrWi0bgIB1eE%2FAPrdZIt4NVgofeOgPy92Y73HLGf70hYzYHH%2BKz%2FlrsYT9j4KFUbo6Vx4OY6R6o0nZ7HJYrTYm0%3D; YD00000980905869%3AWM_NIKE=9ca17ae2e6ffcda170e2e6eeccea7c97bff99ad04eb3bc8bb6c44f839a8e83d463b889f8b9c25ebc868ad5f52af0fea7c3b92afceff982fc47ac97af83c55988f58a85ee6b8db1a5a4cb3fed948eaacd6af4bfc099f63a9cb9ba94dc3aba948693d663f4bea9aac13ba79be1a2d37aa8868795b74696b9a187e845a590b7dab153f5ed88adc66ef5f0a8baf9538c98e5acf925b0aebdbad733aaec85a7d86aadea9a99b7459bea9ed7ee3cae86f9a9c953b28c978eb337e2a3; token=eyJ0eXAiOiJKV1QiLCJhbGciOiJIUzI1NiJ9.eyJqaWQiOiJjZHVfNTMyMDcwNzg0NjAiLCJleHBpcmUiOiIxNzAxNDg4ODM3Nzg0In0.3zOo3zk8OEO2kmYOX2ExY_oc6wm3eeM0y9VUyA4er-w; Hm_lpvt_03b2668f8e8699e91d479d62bc7630f1=1698896838'

}res = requests.post('https://dig.chouti.com/link/vote', data=data, headers=header)

print(res.text)# 方式二:使用cookie参数

-在utils.py中

def cookie_str_to_cookie_dict(s):# l = s.split(';') # 得到一个列表# d = {}# for item in l:# d[item.split('=')[0]] = item.split('=')[1]# print(d)# res = requests.get('http://www.aa7a.cn/', cookies=d)# 字典推导式return {item.split('=')[0]: item.split('=')[1] for item in s.split(';')}

-字符串转字典:

from utils import cookie_str_to_cookie_dict

s = 'cto_bundle=_DpLll9WcDY3UCUyRlBnWDZtZEp5MVFZZHVHeExtdmtwNjVVYkh6SUglMkZoVmFaSWFtc1JrZWo0aVRURzdOeUhTUHpTekslMkJ0RjRnOXhqOWhXM0piM0hXVFlVVk9MUGpNWFdCS0dveFBFSEhHVmJRV01uVWZ1bjloTU9YY2VwQWF2NWxFQWhkZnM5TERxMVlUUkt4WUo2dWR4QkZOMmclM0QlM0Q; _jzqx=1.1691985966.1691985966.1.jzqsr=aa7a%2Ecn|jzqct=/.-; ECS_ID=a9bd0486ba5b0f2f65637f64719d72e75add4995; ECS[visit_times]=8; _jzqa=1.2593057364546894000.1672632545.1691985966.1698896326.9; _jzqc=1; _jzqy=1.1672632545.1698896326.1.jzqsr=baidu.-; _jzqckmp=1; Hm_lvt_c29657ca36c6c88e02fed9a397826038=1698896327; mediav=%7B%22eid%22%3A%22179539%22%2C%22ep%22%3A%22%22%2C%22vid%22%3A%22%22%2C%22ctn%22%3A%22%22%2C%22vvid%22%3A%22%22%2C%22_mvnf%22%3A1%2C%22_mvctn%22%3A0%2C%22_mvck%22%3A1%2C%22_refnf%22%3A0%7D; __xsptplus422=422.9.1698896372.1698896372.1%234%7C%7C%7C%7C%7C%23%23%23; Qs_lvt_201322=1686282645%2C1691979017%2C1691979065%2C1698896326%2C1698896643; __xsptplusUT_422=1; _qzjc=1; ECS[username]=616564099%40qq.com; ECS[user_id]=61399; ECS[password]=4a5e6ce9d1aba9de9b31abdf303bbdc2; _qzjb=1.1698896326296.7.0.0.0; _qzjto=7.1.0; _qzja=1.1154697895.1672632545402.1691985966161.1698896326296.1698896649094.1698896661921.616564099%2540qq_com.1.0.23.8; Hm_lpvt_c29657ca36c6c88e02fed9a397826038=1698896662; _jzqb=1.18.10.1698896326.1; Qs_pv_201322=1719398001187156200%2C1811149594340033000%2C1691949923920640300%2C4523589869790951000%2C2247541305320030700'

res = requests.get('http://www.aa7a.cn/', cookies=cookie_str_to_cookie_dict(s))

print('616564099@qq.com' in res.text) # 没有携带cookie 访问# 登录成功---》响应头中有cookie

data = {'username': '616564099@qq.com','password': 'lqz123','captcha': 'xxxx','ref': 'http://www.aa7a.cn/','act': 'act_login',

}

res = requests.post('http://www.aa7a.cn/user.php', data=data)

print(res.text)

print(type(res.cookies.get_dict())) # 登录成功的cookie,RequestsCookieJar 本质就是字典

from requests.cookies import RequestsCookieJar# 拿到登录后的cookie,再向首页发送请求

res = requests.get('http://www.aa7a.cn/', cookies=res.cookies)

print('616564099@qq.com' in res.text) # 没有携带cookie 访问

#### 8 session 的使用---》原来每次都需要手动携带cookie

from requests import Session

session=Session()

data = {'username': '616564099@qq.com','password': 'lqz123','captcha': 'xxxx','ref': 'http://www.aa7a.cn/','act': 'act_login',

}

res = session.post('http://www.aa7a.cn/user.php', data=data)

res = session.get('http://www.aa7a.cn/') # 可以自动处理cookie,不需要手动携带

print('616564099@qq.com' in res.text)

7 响应对象

#### 9 响应对象

''' http请求---》python中---》变成了俩对象---》request对象 response对象

后端:django :request---》http请求被包装成了python的对象四件套----》http的响应被包装成了response

爬虫:request对象---》request.get --- request.get---》http请求response对象---》返回的数据---》http响应包装成了response对象后端和前端所叫的 request和response虽然不是同一个类的对象,但是他们的内容基本一致---》本质都是http请求和响应'''

# respone = requests.get('http://www.aa7a.cn/')

#

# print(type(respone))# 类的属性跟方法

# from requests.models import Response

# print(respone.text) # 响应体转成了字符串

# print(respone.content) # 响应体的二进制

# print(respone.status_code) # 响应状态码

# print(respone.headers) # 响应头

# print(respone.cookies)# 响应cookie

# print(respone.cookies.get_dict())

# print(respone.cookies.items()) # 响应cookie---》转成key-value形式

#

# print(respone.url) # 请求地址

# print(respone.history) # 了解:访问过的地址 针对于 重定向的情况,才会有值

#

# print(respone.encoding) # 响应编码# 下载一个视频

respone = requests.get('https://img3.chouti.com/CHOUTI_231102_8B10E74FBE2646748DE951D4EAB1F1E7.jpg')

# print(respone.content)

# 保存到本地--》就是这张图片

with open('致命诱惑.jpg', 'wb') as f:# f.write(respone.content)# for line in respone.iter_content(1024):for line in respone.iter_content():f.write(line)

8 高级用法

## 10 高级用法:

# 1 关于https报错问题

'''

以后访问https地址时,可以会报错,访问https需要携带证书---》没带就会报错

不携带证书---》不报错

respone=requests.get('https://www.12306.cn',verify=False) #不验证证书,报警告,返回200

'''

# import urllib3

# urllib3.disable_warnings()

# respone=requests.get('https://www.12306.cn',verify=False)

# print(respone.text)# 2 超时设置

# import requests

# respone=requests.get('https://www.baidu.com',timeout=0.0001)# 3 认证设置 ---》不需要知道了,现在没有这种了---》不是前端认证# 4 异常处理# 5 上传文件

# import requests

#

# files = {'file': open('a.jpg', 'rb')}

# respone = requests.post('http://httpbin.org/post', files=files)

# print(respone.status_code)# 后端存储 request.FILES.get('file')相关文章:

1-爬虫-requests模块快速使用,携带请求参数,url 编码和解码,携带请求头,发送post请求,携带cookie,响应对象, 高级用法

1 爬虫介绍 2 requests模块快速使用 3 携带请求参数 4 url 编码和解码 4 携带请求头 5 发送post请求 6 携带cookie 7 响应对象 8 高级用法 1 爬虫介绍 # 爬虫是什么?-网页蜘蛛,网络机器人,spider-在互联网中 通过 程序 自动的抓取数据 的过程…...

java商城免费搭建 VR全景商城 saas商城 b2b2c商城 o2o商城 积分商城 秒杀商城 拼团商城 分销商城 短视频商城

1. 涉及平台 平台管理、商家端(PC端、手机端)、买家平台(H5/公众号、小程序、APP端(IOS/Android)、微服务平台(业务服务) 2. 核心架构 Spring Cloud、Spring Boot、Mybatis、Redis 3. 前端框架…...

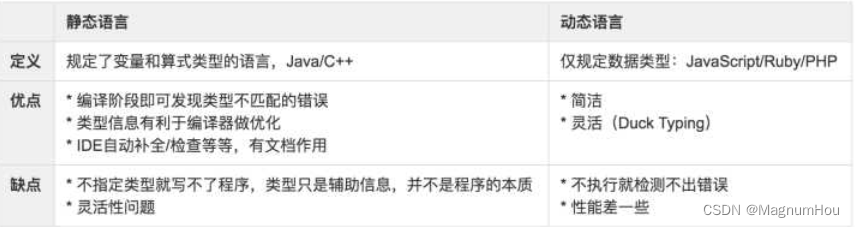

【TS篇一】TypeScript介绍、使用场景、环境搭建、类和接口

文章目录 一、TypeScript 介绍1. TypeScript 是什么1.2 静态类型和动态类型1.3 Why TypeScript1.4 TypeScript 使用场景1.5 TypeScript 不仅仅用于开发 Angular 应用1.6 前置知识 二、如何学习 TypeScript2.1 相关链接 三、起步3.1 搭建 TypeScript 开发环境3.2 编辑器的选择3.…...

Tuna: Instruction Tuning using Feedback from Large Language Models

本文是LLM系列文章,针对《Tuna: Instruction Tuning using Feedback from Large Language Models》的翻译。 Tuna:使用来自大型语言模型的反馈的指令调优 摘要1 引言2 方法3 实验4 相关工作5 结论局限性 摘要 使用更强大的LLM(如Instruction GPT和GPT-…...

uni-app 应对微信小程序最新隐私协议接口要求的处理方法

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 一,问题起因 最新在开发小程序的时候,调用微信小程序来获取用户信息的时候经常报错一个问题 fail api scope is not declared in the privacy agreement,api更具公告…...

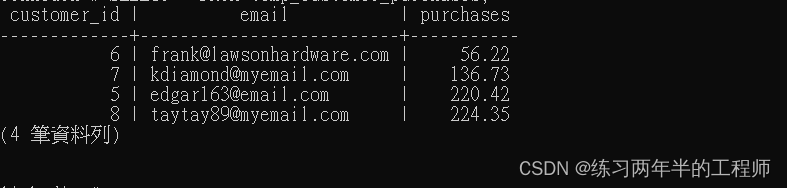

PostgreSQL 进阶 - 使用foreign key,使用 subqueries 插入,inner joins,outer joins

1. 使用foreign key 创建 table CREATE TABLE orders( order_id SERIAL PRIMARY KEY, purchase_total NUMERIC, timestamp TIMESTAMPTZ, customer_id INT REFERENCES customers(customer_id) ON DELETE CASCADE);“order_id”:作为主键的自增序列,使用 …...

【Python 千题 —— 基础篇】地板除计算

题目描述 题目描述 编写一个程序,接受用户输入的两个数字,然后计算这两个数字的地板除(整除)结果,并输出结果。 输入描述 输入两个数字,用回车隔开两个数字。 输出描述 程序将计算这两个数字的地板除…...

函数)

【随手记】np.random.choice()函数

np.random.choice() 是 NumPy 中的一个随机抽样函数,用于从给定的一维数组中随机抽取指定数量或指定概率的元素。该函数可以用于构建模拟实验、生成随机数据集、数据抽样等应用场景。 np.random.choice(a, sizeNone, replaceTrue, pNone) 的参数如下: …...

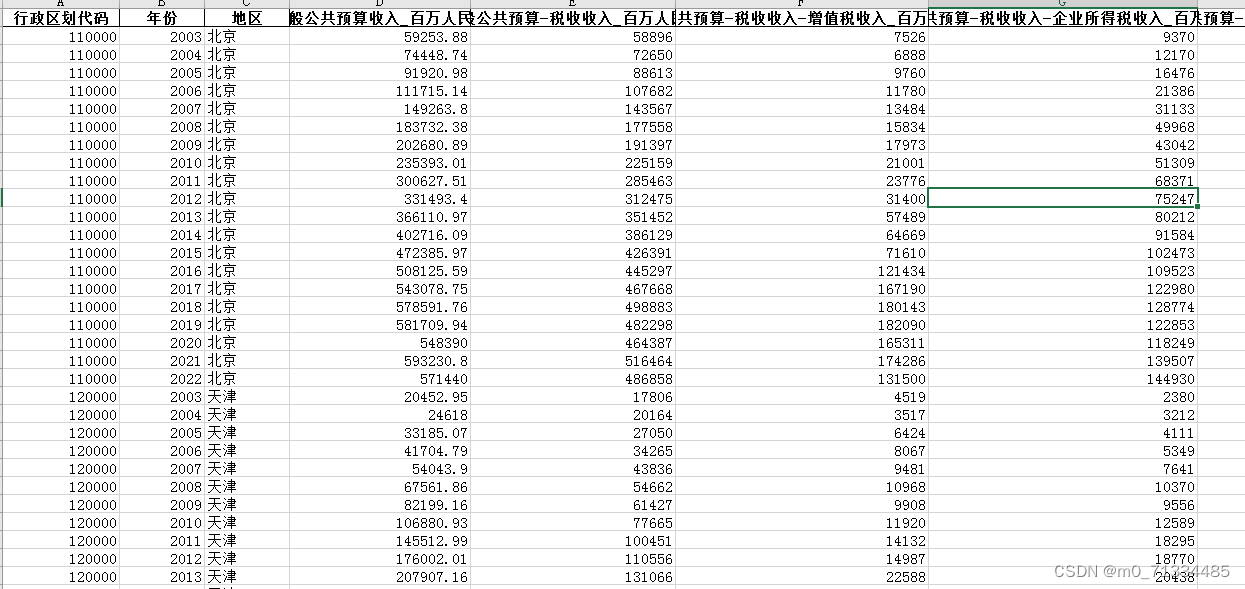

2003-2022年地级市-财政收支明细数据(企业、个人所得税、科学、教育、医疗等)

2003-2022年地级市-财政收支明细数据(企业、个人所得税、科学、教育、医疗等) 1、时间:2003-2022年 2、指标:行政区划代码、年份、地区、一般公共预算收入、一般公共预算-税收收入、一般公共预算-税收收入-增值税收入、一般公共…...

影响服务器正常使用的有哪些因素

对于网站优化来说,网站服务器的优化绝对是基础。不管是用户还是搜索引擎对于网站的打开速度都是没有太多耐心的, 所以网站优化的就是要保证网站服务器稳定,网站正常且快速的打开 1.用户体验较差 现在越来越强调用户体验,设想一下…...

NLP学习笔记:使用 Python 进行NLTK

一、说明 本文和接下来的几篇文章将介绍 Python NLTK 库。NLTK — 自然语言工具包 — NLTK 是一个强大的开源库,用于 NLP 的研究和开发。它内置了 50 多个文本语料库和词汇资源。它支持文本标记化、词性标记、词干提取、词形还原、命名实体提取、分割、分类、语义推…...

突破性技术!开源多模态模型—MiniGPT-5

多模态生成一直是OpenAI、微软、百度等科技巨头的重要研究领域,但如何实现连贯的文本和相关图像是一个棘手的难题。 为了突破技术瓶颈,加州大学圣克鲁斯分校研发了MiniGPT-5模型,并提出了全新技术概念“Generative Vokens ",…...

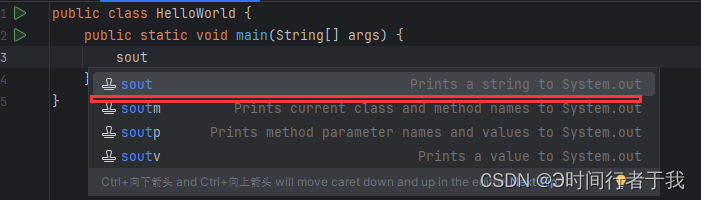

IntelliJ IDEA快捷键sout不生效

1.刚下载完idea编辑器时,可能idea里的快捷键打印不生效。这时你打开settings 2.点击settings–>Live Templates–>找到Java这个选项,点击展开 3.找到sout 4.点击全选,保存退出就可以了 5.最后大功告成!...

用C++QT实现一个modbus rtu通讯程序框架

下面是一个简单的Modbus RTU通讯程序框架的示例,使用C和QT来实现: #include <QCoreApplication> #include <QSerialPort> #include <QModbusDataUnit> #include <QModbusRtuSerialMaster>int main(int argc, char *argv[]) {QC…...

Python如何设置下载第三方软件包的国内镜像站服务器的地址

使用pip下载第三方python软件包时,如果下载的速度太慢,说明是从国外的服务器上下载的。需要进行一个设置,让pip从国内的镜像站服务器下载。 1. 新建一个纯文本文件,Windows下名字叫做pip.ini;Linux下名字叫做pip.cnf…...

ChatGLM3-6B详细安装过程记录(Linux)

先附上GitHub官方地址: https://github.com/THUDM/ChatGLM3https://github.com/THUDM/ChatGLM3 目录 一、预览 1. 基于 Gradio 的网页版 demo...

python的类

python中的类用来描述具有相同的属性和方法的对象的集合。它定义了该集合中每个对象所共有的属性和方法。对象是类的实例。 一、object是python的默认类,有很多方法,python3默认所有的类都继承object,定义类的时候类名后面加不加括号&#x…...

前端 用HTML,CSS, JS 写一个简易的音乐播放器

<!DOCTYPE html> <html lang"en"> <head><meta charset"UTF-8"><title>Music Player</title><style>/* 样式可自行修改 */.container {width: 600px;margin: 0 auto;}h2 {text-align: center;}.controls {displ…...

)

自定义QChartView实现鼠标放在图表时,显示鼠标位置坐标值(x,y)

前言:因为需要一次性从文件中加载大量数据到图表中显示,所以打算使用qchartviewqscrollarea,当横坐标数据超出默认设定的显示范围之后,重新设置chartview的宽度和scrollarea内容区域(scrollAreaWidgetContents)的宽度,…...

antv/g6 交互与事件及自定义Behavior

监听和绑定事件 在 G6 中,提供了直接的单机事件、还有监听时机的方法。可以监听画布、节点、边、以及各函数被调用的时机等: 1. 绑定事件 要绑定事件,首先需要获得图表实例(Graph 实例),然后使用 on 方法…...

Linux应用开发之网络套接字编程(实例篇)

服务端与客户端单连接 服务端代码 #include <sys/socket.h> #include <sys/types.h> #include <netinet/in.h> #include <stdio.h> #include <stdlib.h> #include <string.h> #include <arpa/inet.h> #include <pthread.h> …...

测试微信模版消息推送

进入“开发接口管理”--“公众平台测试账号”,无需申请公众账号、可在测试账号中体验并测试微信公众平台所有高级接口。 获取access_token: 自定义模版消息: 关注测试号:扫二维码关注测试号。 发送模版消息: import requests da…...

Debian系统简介

目录 Debian系统介绍 Debian版本介绍 Debian软件源介绍 软件包管理工具dpkg dpkg核心指令详解 安装软件包 卸载软件包 查询软件包状态 验证软件包完整性 手动处理依赖关系 dpkg vs apt Debian系统介绍 Debian 和 Ubuntu 都是基于 Debian内核 的 Linux 发行版ÿ…...

docker 部署发现spring.profiles.active 问题

报错: org.springframework.boot.context.config.InvalidConfigDataPropertyException: Property spring.profiles.active imported from location class path resource [application-test.yml] is invalid in a profile specific resource [origin: class path re…...

GruntJS-前端自动化任务运行器从入门到实战

Grunt 完全指南:从入门到实战 一、Grunt 是什么? Grunt是一个基于 Node.js 的前端自动化任务运行器,主要用于自动化执行项目开发中重复性高的任务,例如文件压缩、代码编译、语法检查、单元测试、文件合并等。通过配置简洁的任务…...

pycharm 设置环境出错

pycharm 设置环境出错 pycharm 新建项目,设置虚拟环境,出错 pycharm 出错 Cannot open Local Failed to start [powershell.exe, -NoExit, -ExecutionPolicy, Bypass, -File, C:\Program Files\JetBrains\PyCharm 2024.1.3\plugins\terminal\shell-int…...

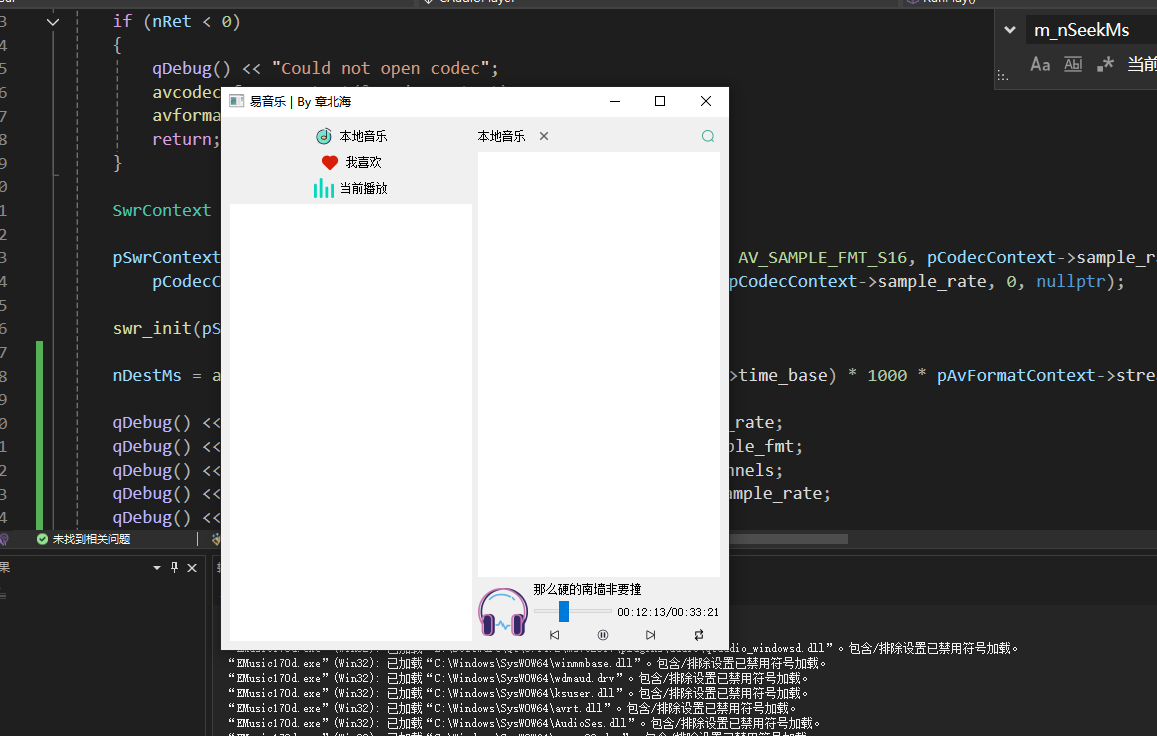

QT开发技术【ffmpeg + QAudioOutput】音乐播放器

一、 介绍 使用ffmpeg 4.2.2 在数字化浪潮席卷全球的当下,音视频内容犹如璀璨繁星,点亮了人们的生活与工作。从短视频平台上令人捧腹的搞笑视频,到在线课堂中知识渊博的专家授课,再到影视平台上扣人心弦的高清大片,音…...

AxureRP-Pro-Beta-Setup_114413.exe (6.0.0.2887)

Name:3ddown Serial:FiCGEezgdGoYILo8U/2MFyCWj0jZoJc/sziRRj2/ENvtEq7w1RH97k5MWctqVHA 注册用户名:Axure 序列号:8t3Yk/zu4cX601/seX6wBZgYRVj/lkC2PICCdO4sFKCCLx8mcCnccoylVb40lP...

聚六亚甲基单胍盐酸盐市场深度解析:现状、挑战与机遇

根据 QYResearch 发布的市场报告显示,全球市场规模预计在 2031 年达到 9848 万美元,2025 - 2031 年期间年复合增长率(CAGR)为 3.7%。在竞争格局上,市场集中度较高,2024 年全球前十强厂商占据约 74.0% 的市场…...

轻量级Docker管理工具Docker Switchboard

简介 什么是 Docker Switchboard ? Docker Switchboard 是一个轻量级的 Web 应用程序,用于管理 Docker 容器。它提供了一个干净、用户友好的界面来启动、停止和监控主机上运行的容器,使其成为本地开发、家庭实验室或小型服务器设置的理想选择…...