wsl kafka的简单应用

安装并配置单机版kafka所需环境

wsl2 环境可用性较高,如下介绍在该环境中安装单机版本kafka的详细过程。

- 启动命令行工具

- 启动wsl:

wsl --user root --cd ~,(以root用户启动,进入wsl后当前路径为~“用户主目录”) - 安装java:进入:https://learn.microsoft.com/zh-cn/java/openjdk/download,选择相应的java版本,下载接口

- 创建java的安装路径:

mkdir -p /opt/sdk/java - 将刚刚下载的javasdk压缩包移动进创建的路径:

mv /mnt/c/Users/你的用户名/Downloads/microsoft-jdk-21.0.1-linux-aarch64.tar.gz /opt/sdk/java/ - 切换到你java安装路径:

cd /opt/sdk/java/ - 解压安装:

tar -zxvf microsoft-jdk-21.0.1-linux-aarch64.tar.gz - 可以选择性删除你刚刚的压缩包:

rm -rf microsoft-jdk-21.0.1-linux-aarch64.tar.gz - 配置环境变量

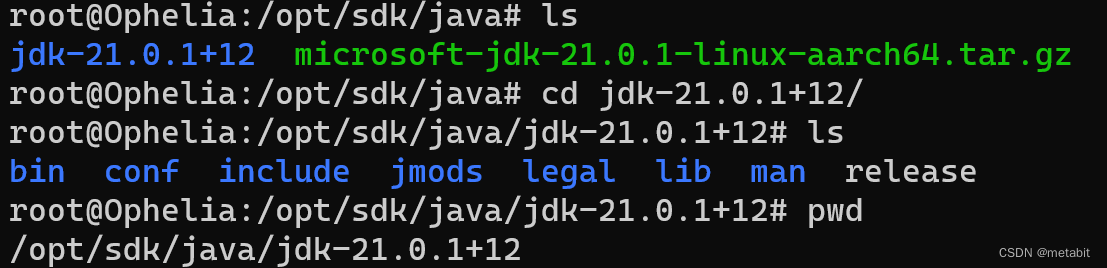

进入jdk的解压目录:

进入jdk的解压目录:cd cd jdk-21.0.1+12

查看一下当前的绝对路径:pwd

复制一下绝对路径的字符串 - 使用vim 打开 /etc/profile

- GG到文件尾部,在文件尾部追加如下内容:

注意JAVA_HOME后边的jdk_xxx是你自己下载的相应版本信息export JAVA_HOME=/opt/sdk/java/jdk-21.0.1+12 export PATH=$PATH:$JAVA_HOME/bin - 让profile文件生效:

source /etc/profile - 查看java是否安装成功:

java -version,显示版本信息则安装成功root@Ophelia:/opt/sdk/java/jdk-21.0.1+12# java -versionopenjdk version "21.0.1" 2023-10-17 LTSOpenJDK Runtime Environment Microsoft-8526870 (build 21.0.1+12-LTS)OpenJDK 64-Bit Server VM Microsoft-8526870 (build 21.0.1+12-LTS, mixed mode)

- 创建java的安装路径:

- 安装kafka

- 在kafka官网下载相应版本kafka,我这里选最新版:Scala 2.13 - kafka_2.13-3.6.0.tgz (asc, sha512)

- 创建kafka的安装路径:

mkdir -p /opt/software/kafka - 将刚刚下载的kafka压缩包移动进创建的路径:

mv /mnt/c/Users/你的用户名/Downloads/kafka_2.13-3.6.1.tgz /opt/software/kafka/ cd /opt/software/kafka/tar -zxvf kafka_2.13-3.6.1.tgzcd kafka_2.13-3.6.1/pwd,然后复制绝对路径- vim /etc/profile 追加如下内容

# Kafkaexport KAFKA_HOME=/opt/software/kafka/kafka_2.13-3.6.1export PATH=$PATH:$KAFKA_HOME/bin source /etc/profile- 配置文件修改:

vim /opt/software/kafka/kafka_2.13-3.6.1/config/server.properties- 找到

log.dirs=/tmp/kafka-logs将其修改为log.dirs=/opt/software/kafka/kafka-logs - 如下所示:

# log.dirs=/tmp/kafka-logslog.dirs=/opt/software/kafka/kafka-logs mkdir -p /opt/software/kafka/kafka-logs- 上述操作目的是防止topic中的数据丢失

- 找到

启动kafka

启动kafka之前先启动zookeeper, Kafka 2.8.0 版本开始,内置了zookeeper。

- 启动zookeeper

zookeeper-server-start.sh -daemon /opt/software/kafka/kafka_2.13-3.6.1/config/zookeeper.properties

命令看起来有点长,实际上一点儿也不短。

它分为3段[zookeeper-server-start.sh][-daemon][配置文件路径]-daemon参数是以守护进程的方式启动。- zookeeper的启动脚本也存储在kafka的环境变量指向的路径中。

- 启动kafka

kafka-server-start.sh -daemon /opt/software/kafka/kafka_2.13-3.6.1/config/server.properties

关闭kafka

先停止kafka,后停止zookeeper

root@Ophelia:~# kafka-server-stop.sh

root@Ophelia:~# zookeeper-server-stop.sh

当停用kafka集群的时候也是先停止kafka,后停止zookeeper,顺序搞反了会导致kafka无法停止,只能使用kill去杀死。

kafka-topics.sh 主题相关操作

查看一下kafka-tpics.sh命令都能干什么

root@Ophelia:~# kafka-topics.sh

Create, delete, describe, or change a topic.

Option Description

------ -----------

--alter Alter the number of partitions andreplica assignment. Update theconfiguration of an existing topicvia --alter is no longer supportedhere (the kafka-configs CLI supportsaltering topic configs with a --bootstrap-server option).

--at-min-isr-partitions if set when describing topics, onlyshow partitions whose isr count isequal to the configured minimum.

--bootstrap-server <String: server to REQUIRED: The Kafka server to connectconnect to> to.

--command-config <String: command Property file containing configs to beconfig property file> passed to Admin Client. This is usedonly with --bootstrap-server optionfor describing and altering brokerconfigs.

--config <String: name=value> A topic configuration override for thetopic being created or altered. Thefollowing is a list of validconfigurations:cleanup.policycompression.typedelete.retention.msfile.delete.delay.msflush.messagesflush.msfollower.replication.throttled.replicasindex.interval.bytesleader.replication.throttled.replicaslocal.retention.byteslocal.retention.msmax.compaction.lag.msmax.message.bytesmessage.downconversion.enablemessage.format.versionmessage.timestamp.after.max.msmessage.timestamp.before.max.msmessage.timestamp.difference.max.msmessage.timestamp.typemin.cleanable.dirty.ratiomin.compaction.lag.msmin.insync.replicaspreallocateremote.storage.enableretention.bytesretention.mssegment.bytessegment.index.bytessegment.jitter.mssegment.msunclean.leader.election.enableSee the Kafka documentation for fulldetails on the topic configs. It issupported only in combination with --create if --bootstrap-server optionis used (the kafka-configs CLIsupports altering topic configs witha --bootstrap-server option).

--create Create a new topic.

--delete Delete a topic

--delete-config <String: name> A topic configuration override to beremoved for an existing topic (seethe list of configurations under the--config option). Not supported withthe --bootstrap-server option.

--describe List details for the given topics.

--exclude-internal exclude internal topics when runninglist or describe command. Theinternal topics will be listed bydefault

--help Print usage information.

--if-exists if set when altering or deleting ordescribing topics, the action willonly execute if the topic exists.

--if-not-exists if set when creating topics, theaction will only execute if thetopic does not already exist.

--list List all available topics.

--partitions <Integer: # of partitions> The number of partitions for the topicbeing created or altered (WARNING:If partitions are increased for atopic that has a key, the partitionlogic or ordering of the messageswill be affected). If not suppliedfor create, defaults to the clusterdefault.

--replica-assignment <String: A list of manual partition-to-brokerbroker_id_for_part1_replica1 : assignments for the topic beingbroker_id_for_part1_replica2 , created or altered.broker_id_for_part2_replica1 :broker_id_for_part2_replica2 , ...>

--replication-factor <Integer: The replication factor for eachreplication factor> partition in the topic beingcreated. If not supplied, defaultsto the cluster default.

--topic <String: topic> The topic to create, alter, describeor delete. It also accepts a regularexpression, except for --createoption. Put topic name in doublequotes and use the '\' prefix toescape regular expression symbols; e.g. "test\.topic".

--topic-id <String: topic-id> The topic-id to describe.This is usedonly with --bootstrap-server optionfor describing topics.

--topics-with-overrides if set when describing topics, onlyshow topics that have overriddenconfigs

--unavailable-partitions if set when describing topics, onlyshow partitions whose leader is notavailable

--under-min-isr-partitions if set when describing topics, onlyshow partitions whose isr count isless than the configured minimum.

--under-replicated-partitions if set when describing topics, onlyshow under replicated partitions

--version Display Kafka version.

列出主要命令

| 选项 | 描述信息 |

|---|---|

| –bootstrap-server <String: server to connect to> | 连接kafka Broker 主机名:端口号 |

| –topic <String: topic> | 操作的topic名称 |

| –create | 创建topic |

| –delete | 删除topic |

| –alter | 修改topic |

| –list | 查看所有topic |

| –describe | 查看topic的详细描述信息 |

| –partitions <Integer: # of partitions> | 设置分区数 |

| –replication-factor <Integer: replication factor> | 设置分区副本 |

| –config <String: name=value> | 更细系统默认的配置 |

查看topic

kafka-topics.sh --list --bootstrap-server localhost:9092

或者,查看指定的topic

kafka-topics.sh --bootstrap-server localhost:9092 --topic 名称 --describe

生产环境中可能有多台机器,为了保证高可用性,防止访问的kafka挂掉之后无法查询数据,可以指定多个实例,如:kafka-topics.sh --list --bootstrap-server localhost:9092 hostName1:9092 hostName2:9092

创建topic

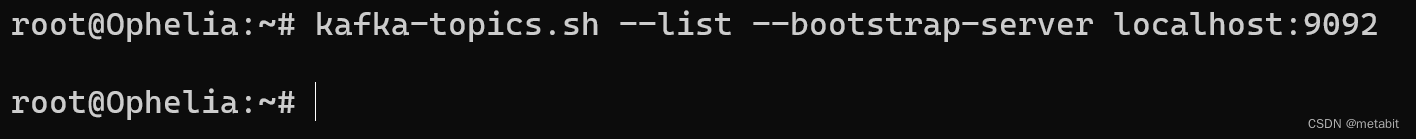

创建之前先查看一下有多少个topic

kafka-topics.sh --list --bootstrap-server localhost:9092

一看,啥也木有,看了个寂寞,这就对溜,你不创建topic,它就没topic

创建单副本,3个分区的 名 为 first的topic

创建单副本,3个分区的 名 为 first的topic

kafka-topics.sh --bootstrap-server localhost:9092 --topic first --create --partitions 3 --replication-factor 1

查看一下:

root@Ophelia:~# kafka-topics.sh --list --bootstrap-server localhost:9092

first

或者

kafka-topics.sh --bootstrap-server localhost:9092 --topic first --describe

Topic: first TopicId: Db5XuRoASzi4W2FgQbaW7A PartitionCount: 3 ReplicationFactor: 1 Configs:Topic: first Partition: 0 Leader: 0 Replicas: 0 Isr: 0Topic: first Partition: 1 Leader: 0 Replicas: 0 Isr: 0Topic: first Partition: 2 Leader: 0 Replicas: 0 Isr: 0

修改topic

first topic的分区数从3个修改成4个,注意,分区数在命令行中只能增加,不能减少

kafka-topics.sh --bootstrap-server localhost:9092 --topic first --alter --partitions 4

尝试一下,会报错的

root@Ophelia:~# kafka-topics.sh --bootstrap-server localhost:9092 --topic first --alter --partitions 3

Error while executing topic command : Topic currently has 4 partitions, which is higher than the requested 3.

[2023-12-17 17:55:41,130] ERROR org.apache.kafka.common.errors.InvalidPartitionsException: Topic currently has 4 partitions, which is higher than the requested 3.(kafka.admin.TopicCommand$)

删除topic

删除名为first的topic

kafka-topics.sh --bootstrap-server localhost:9092 --topic first --delete

kafka-console-producer.sh生产者相关操作

root@Ophelia:~# kafka-console-producer.sh

Missing required option(s) [bootstrap-server]

Option Description

------ -----------

--batch-size <Integer: size> Number of messages to send in a singlebatch if they are not being sentsynchronously. please note that thisoption will be replaced if max-partition-memory-bytes is also set(default: 16384)

--bootstrap-server <String: server to REQUIRED unless --broker-listconnect to> (deprecated) is specified. The server(s) to connect to. The broker liststring in the form HOST1:PORT1,HOST2:PORT2.

--broker-list <String: broker-list> DEPRECATED, use --bootstrap-serverinstead; ignored if --bootstrap-server is specified. The brokerlist string in the form HOST1:PORT1,HOST2:PORT2.

--compression-codec [String: The compression codec: either 'none',compression-codec] 'gzip', 'snappy', 'lz4', or 'zstd'.If specified without value, then itdefaults to 'gzip'

--help Print usage information.

--line-reader <String: reader_class> The class name of the class to use forreading lines from standard in. Bydefault each line is read as aseparate message. (default: kafka.tools.ConsoleProducer$LineMessageReader)

--max-block-ms <Long: max block on The max time that the producer willsend> block for during a send request.(default: 60000)

--max-memory-bytes <Long: total memory The total memory used by the producerin bytes> to buffer records waiting to be sentto the server. This is the option tocontrol `buffer.memory` in producerconfigs. (default: 33554432)

--max-partition-memory-bytes <Integer: The buffer size allocated for amemory in bytes per partition> partition. When records are receivedwhich are smaller than this size theproducer will attempt tooptimistically group them togetheruntil this size is reached. This isthe option to control `batch.size`in producer configs. (default: 16384)

--message-send-max-retries <Integer> Brokers can fail receiving the messagefor multiple reasons, and beingunavailable transiently is just oneof them. This property specifies thenumber of retries before theproducer give up and drop thismessage. This is the option tocontrol `retries` in producerconfigs. (default: 3)

--metadata-expiry-ms <Long: metadata The period of time in millisecondsexpiration interval> after which we force a refresh ofmetadata even if we haven't seen anyleadership changes. This is theoption to control `metadata.max.age.ms` in producer configs. (default:300000)

--producer-property <String: A mechanism to pass user-definedproducer_prop> properties in the form key=value tothe producer.

--producer.config <String: config file> Producer config properties file. Notethat [producer-property] takesprecedence over this config.

--property <String: prop> A mechanism to pass user-definedproperties in the form key=value tothe message reader. This allowscustom configuration for a user-defined message reader.Default properties include:parse.key=falseparse.headers=falseignore.error=falsekey.separator=\theaders.delimiter=\theaders.separator=,headers.key.separator=:null.marker= When set, any fields(key, value and headers) equal tothis will be replaced by nullDefault parsing pattern when:parse.headers=true and parse.key=true:"h1:v1,h2:v2...\tkey\tvalue"parse.key=true:"key\tvalue"parse.headers=true:"h1:v1,h2:v2...\tvalue"

--reader-config <String: config file> Config properties file for the messagereader. Note that [property] takesprecedence over this config.

--request-required-acks <String: The required `acks` of the producerrequest required acks> requests (default: -1)

--request-timeout-ms <Integer: request The ack timeout of the producertimeout ms> requests. Value must be non-negativeand non-zero. (default: 1500)

--retry-backoff-ms <Long> Before each retry, the producerrefreshes the metadata of relevanttopics. Since leader election takesa bit of time, this propertyspecifies the amount of time thatthe producer waits before refreshingthe metadata. This is the option tocontrol `retry.backoff.ms` inproducer configs. (default: 100)

--socket-buffer-size <Integer: size> The size of the tcp RECV size. This isthe option to control `send.buffer.bytes` in producer configs.(default: 102400)

--sync If set message send requests to thebrokers are synchronously, one at atime as they arrive.

--timeout <Long: timeout_ms> If set and the producer is running inasynchronous mode, this gives themaximum amount of time a messagewill queue awaiting sufficient batchsize. The value is given in ms. Thisis the option to control `linger.ms`in producer configs. (default: 1000)

--topic <String: topic> REQUIRED: The topic id to producemessages to.

--version Display Kafka version.

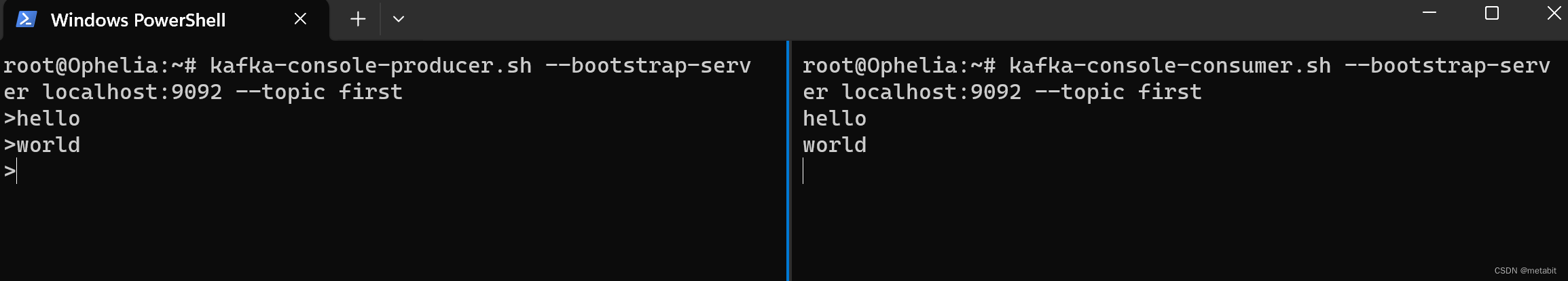

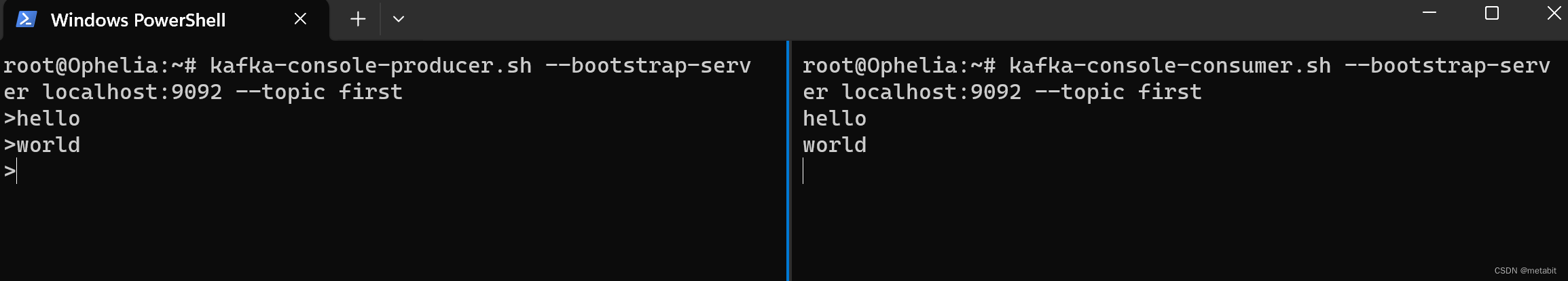

生产消息

用生产者连接broker

kafka-console-producer.sh --bootstrap-server localhost:9092 --topic first

再启动一个命令行

wsl --user root --cd ~

启动一个消费者

kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic first

生产者发送消息

消费者接收消息

kafka-console-consumer.sh消费者相关操作

root@Ophelia:~# kafka-console-consumer.sh

This tool helps to read data from Kafka topics and outputs it to standard output.

Option Description------ -------------bootstrap-server <String: server to REQUIRED: The server(s) to connect to.connect to>--consumer-property <String: A mechanism to pass user-definedconsumer_prop> properties in the form key=value tothe consumer.--consumer.config <String: config file> Consumer config properties file. Notethat [consumer-property] takesprecedence over this config.

--enable-systest-events Log lifecycle events of the consumerin addition to logging consumedmessages. (This is specific forsystem tests.)--formatter <String: class> The name of a class to use forformatting kafka messages fordisplay. (default: kafka.tools.DefaultMessageFormatter)

--formatter-config <String: config Config properties file to initializefile> the message formatter. Note that[property] takes precedence overthis config.--from-beginning If the consumer does not already havean established offset to consumefrom, start with the earliestmessage present in the log ratherthan the latest message.

--group <String: consumer group id> The consumer group id of the consumer.

--help Print usage information.

--include <String: Java regex (String)> Regular expression specifying list oftopics to include for consumption.

--isolation-level <String> Set to read_committed in order tofilter out transactional messageswhich are not committed. Set toread_uncommitted to read allmessages. (default: read_uncommitted)

--key-deserializer <String:deserializer for key>--max-messages <Integer: num_messages> The maximum number of messages toconsume before exiting. If not set,consumption is continual.

--offset <String: consume offset> The offset to consume from (a non-negative number), or 'earliest'which means from beginning, or'latest' which means from end(default: latest)

--partition <Integer: partition> The partition to consume from.Consumption starts from the end ofthe partition unless '--offset' isspecified.--property <String: prop> The properties to initialize themessage formatter. Defaultproperties include:print.timestamp=true|falseprint.key=true|falseprint.offset=true|falseprint.partition=true|falseprint.headers=true|falseprint.value=true|falsekey.separator=<key.separator>line.separator=<line.separator>headers.separator=<line.separator>null.literal=<null.literal>key.deserializer=<key.deserializer>value.deserializer=<value.deserializer>header.deserializer=<header.deserializer>Users can also pass in customizedproperties for their formatter; morespecifically, users can pass inproperties keyed with 'key.deserializer.', 'value.deserializer.' and 'headers.deserializer.' prefixes to configuretheir deserializers.

--skip-message-on-error If there is an error when processing amessage, skip it instead of halt.

--timeout-ms <Integer: timeout_ms> If specified, exit if no message isavailable for consumption for thespecified interval.

--topic <String: topic> The topic to consume on.

--value-deserializer <String:deserializer for values>--version Display Kafka version.

--whitelist <String: Java regex DEPRECATED, use --include instead;(String)> ignored if --include specified.Regular expression specifying listof topics to include for consumption.

增量接收

kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic first

接收历史全部数据 –from-beginning

kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic first --from-beginning

使用场景:根据情况而定

相关文章:

wsl kafka的简单应用

安装并配置单机版kafka所需环境 wsl2 环境可用性较高,如下介绍在该环境中安装单机版本kafka的详细过程。 启动命令行工具启动wsl:wsl --user root --cd ~,(以root用户启动,进入wsl后当前路径为~“用户主目录”&#…...

2023年国赛高教杯数学建模D题圈养湖羊的空间利用率解题全过程文档及程序

2023年国赛高教杯数学建模 D题 圈养湖羊的空间利用率 原题再现 规模化的圈养养殖场通常根据牲畜的性别和生长阶段分群饲养,适应不同种类、不同阶段的牲畜对空间的不同要求,以保障牲畜安全和健康;与此同时,也要尽量减少空间闲置所…...

Flink系列之:Table API Connectors之Raw Format

Flink系列之:Table API Connectors之Raw Format 一、Raw Format二、示例三、Format 参数四、数据类型映射 一、Raw Format Raw format 允许读写原始(基于字节)值作为单个列。注意: 这种格式将 null 值编码成 byte[] 类型的 null。这样在 ups…...

社交网络分析3:社交网络隐私攻击、保护的基本概念和方法 + 去匿名化技术 + 推理攻击技术 + k-匿名 + 基于聚类的隐私保护算法

社交网络分析3:社交网络隐私攻击、保护的基本概念和方法 去匿名化技术 推理攻击技术 k-匿名 基于聚类的隐私保护算法 写在最前面社交网络隐私泄露用户数据暴露的途径复杂行为的隐私风险技术发展带来的隐私挑战经济利益与数据售卖防范措施 社交网络 用户数据隐私…...

2023大湾区汽车创新大会在深圳坪山开幕

12月15日,2023大湾区汽车创新大会在深圳坪山开幕。 本次大会是由广东省科学技术厅、深圳市发展和改革委员会、深圳市工业和信息化局、中共深圳市新能源和智能网联汽车产业链委员会、坪山区人民政府指导,北京理工大学深圳汽车研究院、广东省大湾区新能源汽…...

Graylog 中日志级别及其对应的数字

在 Graylog 中,日志级别 level 通常使用数字表示,数字越低表示日志级别越高。以下是常见的日志级别及其对应的数字表示: DEBUG(调试):对应数字 7。INFO(信息):对应数字 …...

智能手表上的音频(五):录音

上篇讲了语音通话,本篇讲录音。录音功能就是把录到的音频保存成文件。保存文件的格式支持两种:一是PCM(16K采样)的WAV格式,二是AMR-NB(8k采样)的AMR格式。WAV格式简单:44字节的文件头PCM 数据,示…...

2023.12.17 关于 Redis 的特性和应用场景

目录 引言 Redis 特性 内存中存储数据 可编程性 可扩展性 持久化 支持集群 高可用性 Redis 优势 Redis 用作数据库 Redis 相较于 MySQL 优势 Redis 相较于 MySQL 劣势 Redis 用作缓存 典型场景 Redis 存储 session 信息 Redis 用作消息队列 初心 消息队列的…...

智能优化算法应用:基于社会群体算法3D无线传感器网络(WSN)覆盖优化 - 附代码

智能优化算法应用:基于社会群体算法3D无线传感器网络(WSN)覆盖优化 - 附代码 文章目录 智能优化算法应用:基于社会群体算法3D无线传感器网络(WSN)覆盖优化 - 附代码1.无线传感网络节点模型2.覆盖数学模型及分析3.社会群体算法4.实验参数设定5.算法结果6.…...

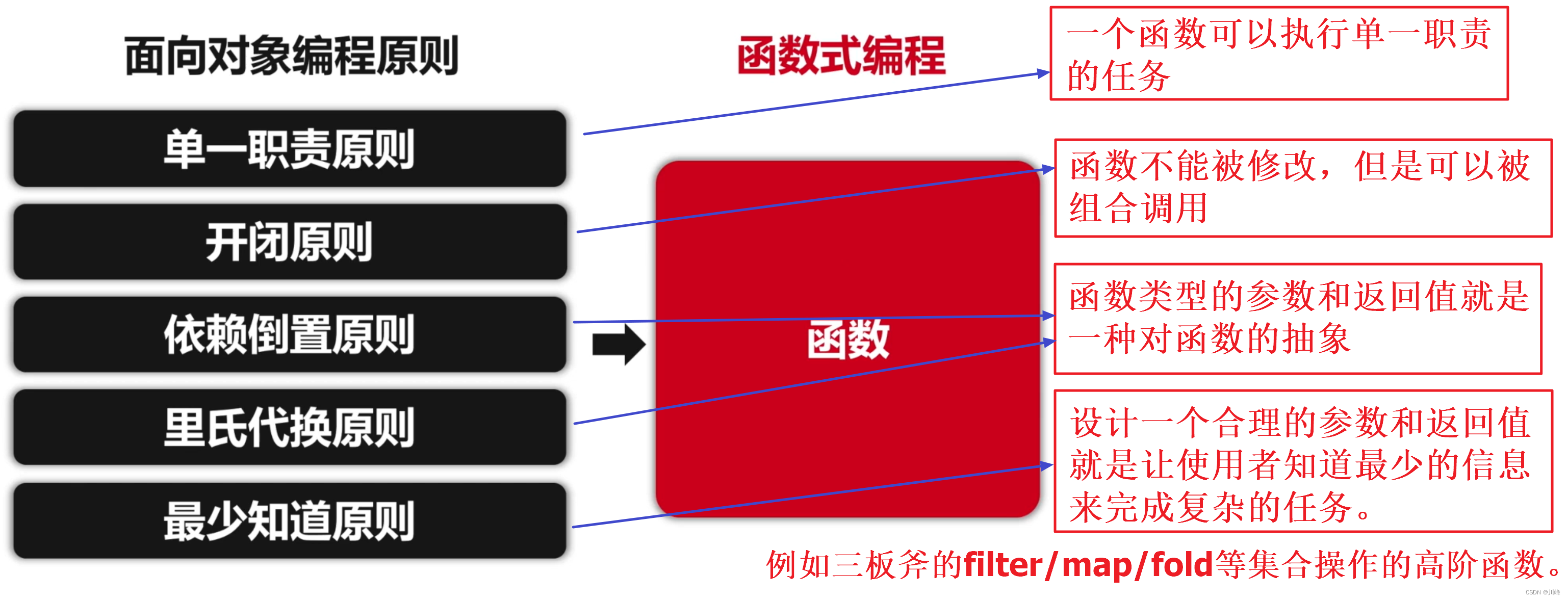

Kotlin 笔记 -- Kotlin 语言特性的理解(二)

都是编译成字节码,为什么 Kotlin 能支持 Java 中没有的特性? kotlin 有哪些 Java 中没有的特性: 类型推断、可变性、可空性自动拆装箱、泛型数组高阶函数、DSL顶层函数、扩展函数、内联函数伴生对象、数据类、密封类、单例类接口代理、inter…...

数据结构【1】:数组专题

一、定义 数组是编程中一种强大的数据结构,它允许您存储和操作相同类型元素的集合。在 Python 中,数组是通过数组模块创建的,该模块提供了一个简单的接口来创建、操作和处理数组。 二、创建数组 在 Python 中,可以使用内置的 a…...

【Spring】Spring 事务

Spring 事务 文章目录 Spring 事务1. 简介2. Spring事务管理器3. 基本使用4. 属性剖析5. 声明式事务问题场景5.1 事务不生效5.2 事务不回滚5.3 大事务问题 6. 编程式事务 1. 简介 编程式事务:指手动编写程序来管理事务,即通过编写代码的方式直接控制事务…...

Ubuntu 虚拟机环境,编译AOSP源码

环境 : VMware虚拟机 Ubuntu 20.04.3 LTS 搭建配置开发环境 sudo apt-get install git-core gnupg flex bison build-essential zip curl zlib1g-dev gcc-multilib g-multilib libc6-dev-i386 libncurses5 lib32ncurses5-dev x11proto-core-dev libx11-dev lib32z1-dev libgl…...

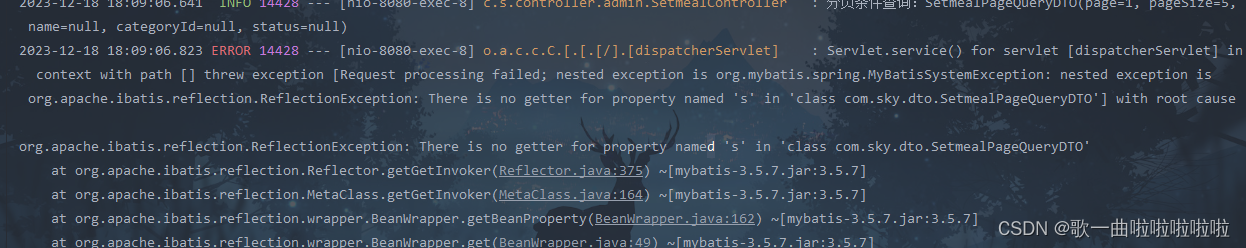

2023.12.18杂记

今天特地搜了一下国内不错的博客网站,本来想在掘金上写的,但是怕被人喷(,所以还是决定在csdn上写了哈哈哈。 这篇文章主要整理一下我今天写代码时遇到的疑惑以及记录一下思考过程吧。 第一个注意的地方,我们的get查询…...

智能优化算法应用:基于阿基米德优化算法3D无线传感器网络(WSN)覆盖优化 - 附代码

智能优化算法应用:基于阿基米德优化算法3D无线传感器网络(WSN)覆盖优化 - 附代码 文章目录 智能优化算法应用:基于阿基米德优化算法3D无线传感器网络(WSN)覆盖优化 - 附代码1.无线传感网络节点模型2.覆盖数学模型及分析3.阿基米德优化算法4.实验参数设定…...

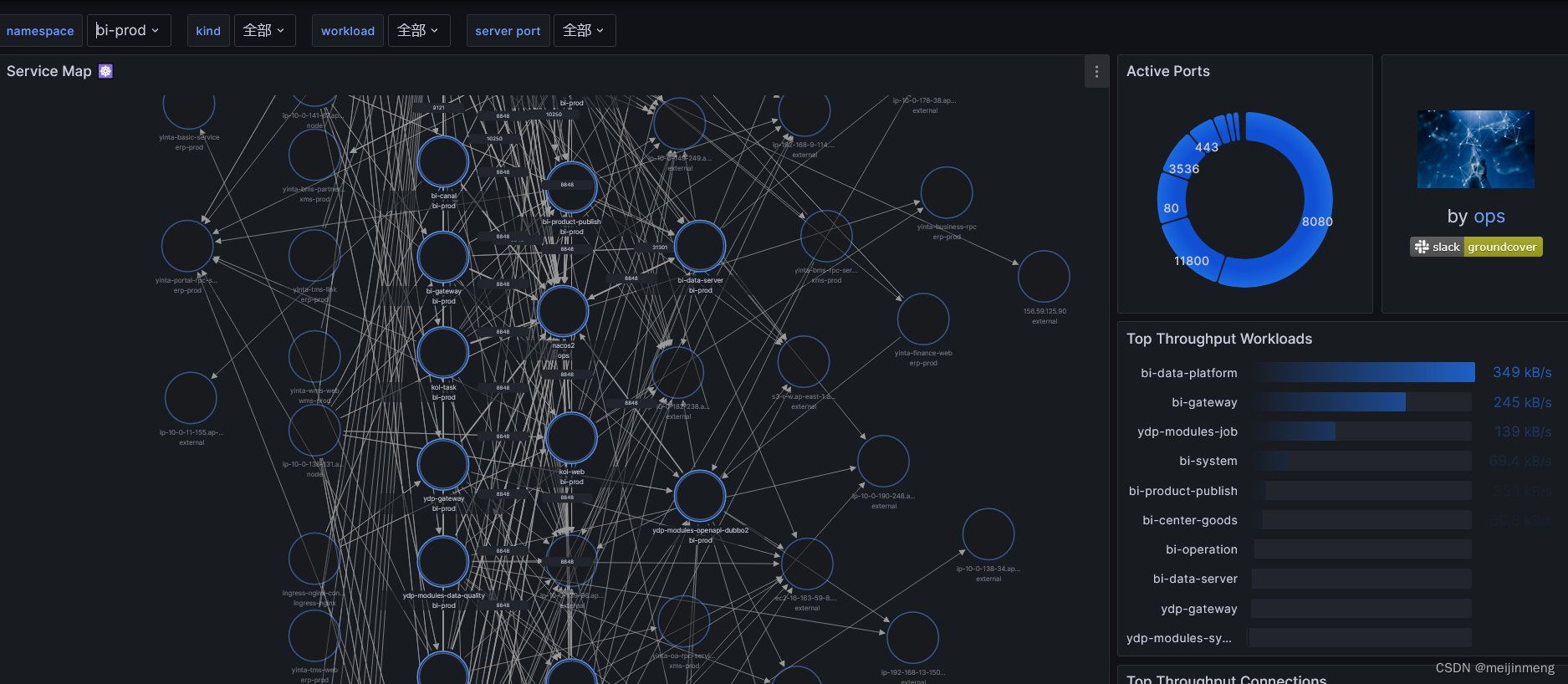

K8s内容器拓扑图工具

1.背景:随着线上容器越来越多,需要一个可视化的方式展示各个容器之间的拓扑图。 2.需求:轻量级,部署方便。 3.部署 helm repo add groundcover https://helm.groundcover.com/ helm repo update helm install caretta --namespa…...

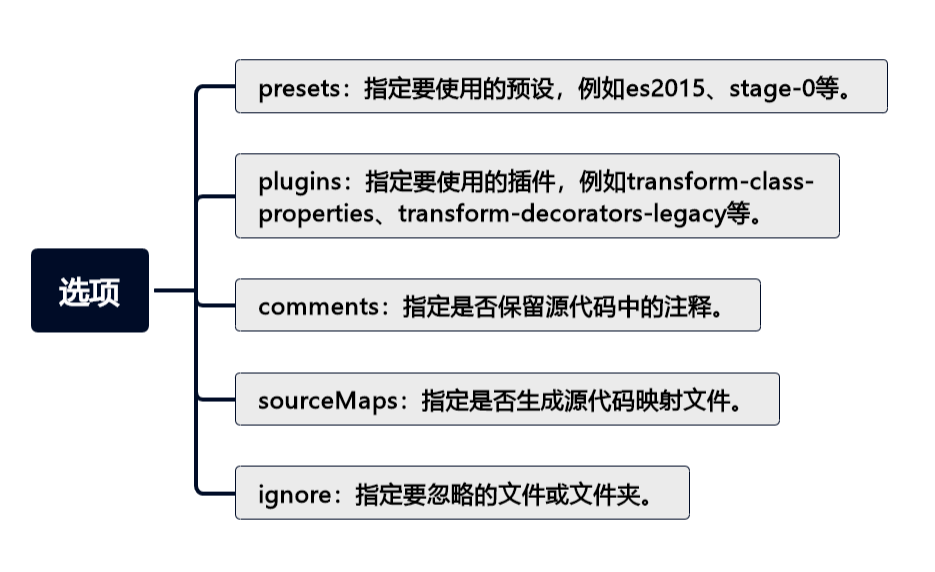

掌握 Babel:让你的 JavaScript 与时俱进(上)

🤍 前端开发工程师(主业)、技术博主(副业)、已过CET6 🍨 阿珊和她的猫_CSDN个人主页 🕠 牛客高级专题作者、在牛客打造高质量专栏《前端面试必备》 🍚 蓝桥云课签约作者、已在蓝桥云…...

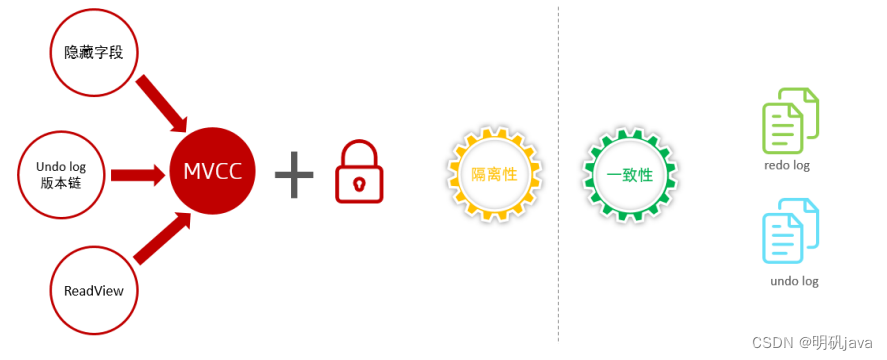

Mysql进阶-InnoDB引擎事务原理及MVCC

事务原理 事务基础 事务是一组操作的集合,它是一个不可分割的工作单位,事务会把所有的操作作为一个整体一起向系 统提交或撤销操作请求,即这些操作要么同时成功,要么同时失败。 事务的四大特性: 原子性(A…...

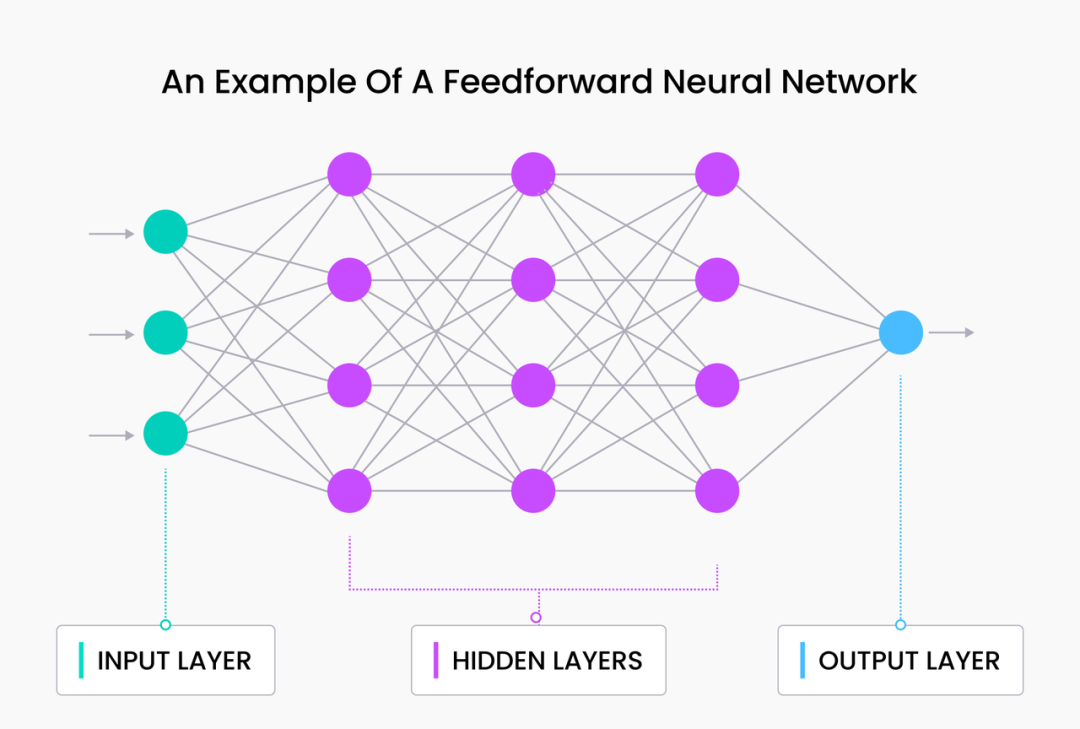

「X」Embedding in NLP|神经网络和语言模型 Embedding 向量入门

在「X」Embedding in NLP 进阶系列中,我们介绍了自然语言处理的基础知识——自然语言中的 Token、N-gram 和词袋语言模型。今天,我们将继续和大家一起“修炼”,深入探讨神经网络语言模型,特别是循环神经网络,并简要了解…...

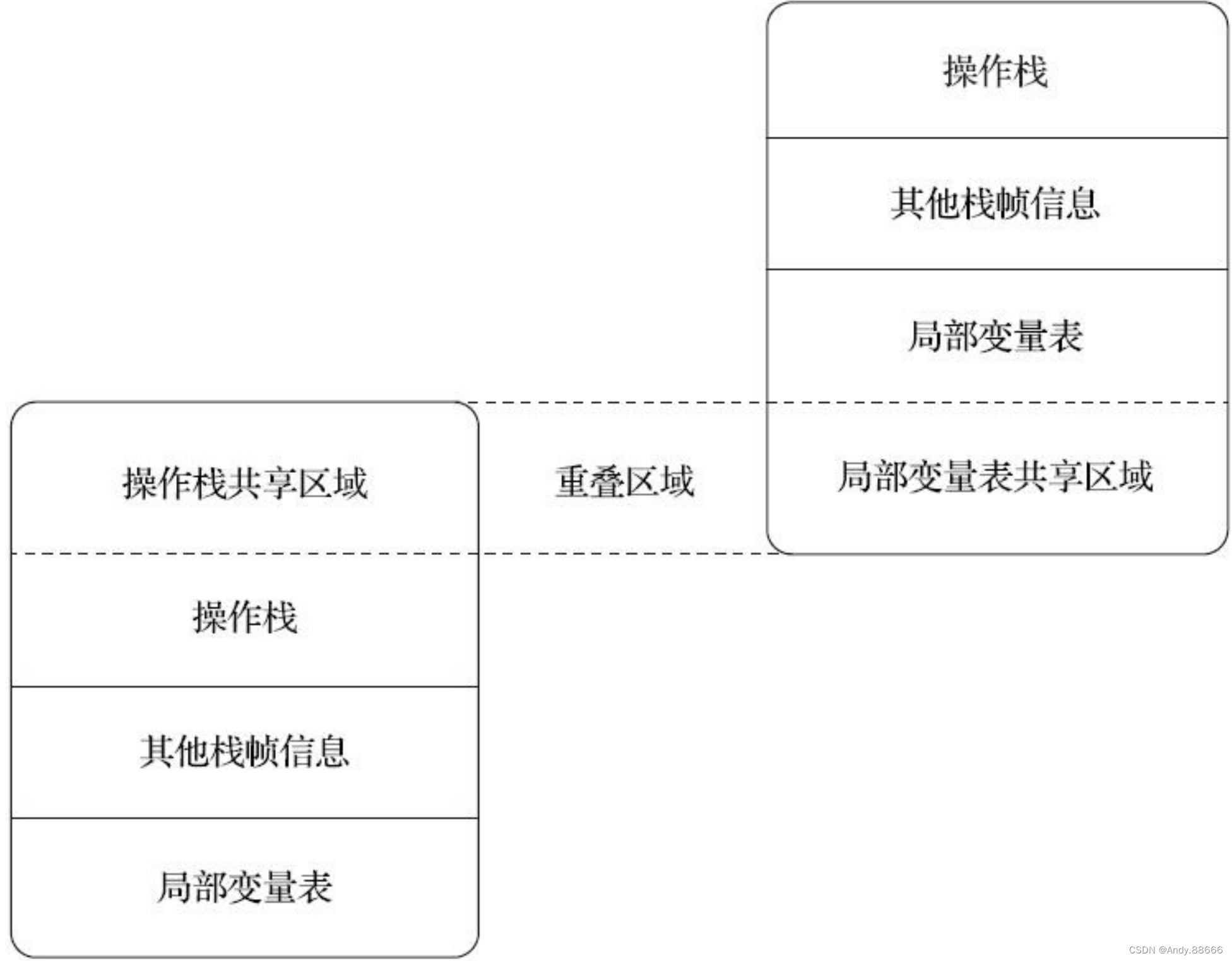

JVM-11-运行时栈帧结构

“栈帧”(Stack Frame)则是用于支持虚拟机进行方法调用和方法执行背后的数据结构,它也是虚拟机运行时数据区中的虚拟机栈(Virtual MachineStack)的栈元素。 栈帧存储了方法的局部变量表、操作数栈、动态连接和方法返回…...

【大模型RAG】拍照搜题技术架构速览:三层管道、两级检索、兜底大模型

摘要 拍照搜题系统采用“三层管道(多模态 OCR → 语义检索 → 答案渲染)、两级检索(倒排 BM25 向量 HNSW)并以大语言模型兜底”的整体框架: 多模态 OCR 层 将题目图片经过超分、去噪、倾斜校正后,分别用…...

微信小程序之bind和catch

这两个呢,都是绑定事件用的,具体使用有些小区别。 官方文档: 事件冒泡处理不同 bind:绑定的事件会向上冒泡,即触发当前组件的事件后,还会继续触发父组件的相同事件。例如,有一个子视图绑定了b…...

聊聊 Pulsar:Producer 源码解析

一、前言 Apache Pulsar 是一个企业级的开源分布式消息传递平台,以其高性能、可扩展性和存储计算分离架构在消息队列和流处理领域独树一帜。在 Pulsar 的核心架构中,Producer(生产者) 是连接客户端应用与消息队列的第一步。生产者…...

Linux-07 ubuntu 的 chrome 启动不了

文章目录 问题原因解决步骤一、卸载旧版chrome二、重新安装chorme三、启动不了,报错如下四、启动不了,解决如下 总结 问题原因 在应用中可以看到chrome,但是打不开(说明:原来的ubuntu系统出问题了,这个是备用的硬盘&a…...

三体问题详解

从物理学角度,三体问题之所以不稳定,是因为三个天体在万有引力作用下相互作用,形成一个非线性耦合系统。我们可以从牛顿经典力学出发,列出具体的运动方程,并说明为何这个系统本质上是混沌的,无法得到一般解…...

vue3+vite项目中使用.env文件环境变量方法

vue3vite项目中使用.env文件环境变量方法 .env文件作用命名规则常用的配置项示例使用方法注意事项在vite.config.js文件中读取环境变量方法 .env文件作用 .env 文件用于定义环境变量,这些变量可以在项目中通过 import.meta.env 进行访问。Vite 会自动加载这些环境变…...

Qt 事件处理中 return 的深入解析

Qt 事件处理中 return 的深入解析 在 Qt 事件处理中,return 语句的使用是另一个关键概念,它与 event->accept()/event->ignore() 密切相关但作用不同。让我们详细分析一下它们之间的关系和工作原理。 核心区别:不同层级的事件处理 方…...

9-Oracle 23 ai Vector Search 特性 知识准备

很多小伙伴是不是参加了 免费认证课程(限时至2025/5/15) Oracle AI Vector Search 1Z0-184-25考试,都顺利拿到certified了没。 各行各业的AI 大模型的到来,传统的数据库中的SQL还能不能打,结构化和非结构的话数据如何和…...

xmind转换为markdown

文章目录 解锁思维导图新姿势:将XMind转为结构化Markdown 一、认识Xmind结构二、核心转换流程详解1.解压XMind文件(ZIP处理)2.解析JSON数据结构3:递归转换树形结构4:Markdown层级生成逻辑 三、完整代码 解锁思维导图新…...

深度解析:etcd 在 Milvus 向量数据库中的关键作用

目录 🚀 深度解析:etcd 在 Milvus 向量数据库中的关键作用 💡 什么是 etcd? 🧠 Milvus 架构简介 📦 etcd 在 Milvus 中的核心作用 🔧 实际工作流程示意 ⚠️ 如果 etcd 出现问题会怎样&am…...