ChatGPT 的核心 GPT 模型:探究其生成式预训练变换架构的革新与应用潜力

GPT(Generative Pre-trained Transformer)模型是一种深度学习模型,由OpenAI于2018年首次提出,并在随后的几年中不断迭代发展,包括GPT-2、GPT-3以及最新的GPT-4。GPT模型在自然语言处理(NLP)领域取得了显著成果,特别是在语言生成、文本理解、问答系统、代码编写等方面表现出强大的能力。ChatGPT 是基于 GPT 模型开发的、专注于对话交互的一个具体的对话式人工智能应用。

一. 模型架构:Transformer

GPT模型基于Transformer架构,这是一种完全依赖自注意力机制(Self-Attention)的序列到序列模型,摒弃了传统的循环神经网络(RNN)或卷积神经网络(CNN)。Transformer通过自注意力机制,使得模型在处理输入序列时能够直接关注到与当前位置相关的任何其他位置的信息,从而实现高效并行计算和长距离依赖建模。

在GPT模型中,Transformer主要由以下组件构成:

1. 基础组件:Transformer Decoder

GPT模型采用了Transformer Decoder作为其主干结构。Transformer Decoder最初是在“Attention is All You Need”论文中提出的,是Transformer模型的一部分,专为序列到序列(seq2seq)任务的解码阶段设计。然而,GPT模型仅使用了Decoder部分,因为它专注于单向的语言生成任务,无需处理编码(encoder)阶段的输入。

a. Multi-Head Self-Attention Layer

Decoder中的每个子层通常包含一个多头自注意力(Multi-Head Self-Attention)模块。在GPT模型中,这个模块允许模型在当前时刻的输入(query)与之前所有时刻的输入(keys和values)之间建立复杂的依赖关系。具体步骤如下:

-

线性变换:分别对输入序列的每个位置进行线性映射,得到查询(Q)、键(K)和值(V)三组向量。

-

分头:将Q、K、V分别划分为多个子向量(头),每个头代表一种不同的注意力机制,增强了模型捕捉不同粒度和类型的信息的能力。

-

scaled dot-product attention:在每个头上,计算查询向量与键向量的点积,然后除以一个缩放因子(通常是sqrt(d_k),d_k是键向量的维度),以稳定梯度。接着对结果应用softmax函数,得到注意力权重分布。最后,将这些权重与对应的值向量加权求和,得到每个头的输出。

-

组合头部输出:将所有头的输出拼接起来,再经过一次线性变换,得到最终的自注意力层输出。

b. Masked Multi-Head Attention

与常规Decoder中的Self-Attention不同,GPT模型使用Masked Multi-Head Attention以确保模型在生成当前词时不会看到未来时刻(即当前位置之后)的信息,保持自回归特性。具体来说,对softmax计算后的注意力权重矩阵施加一个遮罩(mask),将当前位置及其之后的所有位置的权重设为负无穷(或非常小的数值),经过softmax后这些位置的权重变为0,从而在加权求和时忽略未来信息。

c. Pointwise Feedforward Networks (FFNs)

每个Decoder子层还包括一个两层的全连接网络(Feedforward Network, FFN)。每个位置的自注意力输出独立通过FFN,其中包含一个中间激活函数(如ReLU)和两个线性层。FFNs提供非线性变换,有助于模型学习更复杂的表达。

2. 层堆叠与位置编码

GPT模型通常由多层(例如GPT-1有12层)相同的Decoder块堆叠而成。每层都包含一个Masked Multi-Head Attention层和一个FFN,中间通常加入残差连接(Residual Connections)和层归一化(Layer Normalization),以改善梯度流和模型稳定性。

此外,为了使模型能够感知输入序列的位置信息(因为自注意力机制本身是位置无关的),在输入序列的每个token上添加位置编码(Positional Encoding)。位置编码通常是一组与词嵌入相同维度的向量,其值随位置变化而变化,能够被模型学习并用于编码位置信息。

3. 预训练与微调

GPT模型的训练分为两个阶段:

预训练阶段

GPT模型通过大规模无监督的自回归语言建模任务进行预训练。给定一个文本序列,模型需预测下一个词的概率分布,即:

P ( Token i ∣ Token 1 , Token 2 , . . . , Token i − 1 ) P(\text{Token}_i | \text{Token}_1, \text{Token}_2, ..., \text{Token}_{i-1}) P(Tokeni∣Token1,Token2,...,Tokeni−1)

这个过程要求模型理解和捕捉语言的上下文依赖,形成对语言结构和语义的深入理解。预训练数据通常来自海量未标注文本,如网页抓取数据、书籍、文章等。

微调阶段

预训练后的GPT模型可以针对特定下游任务进行微调,如文本分类、问答、机器翻译、对话生成等。微调过程中,模型参数在目标任务的有标签数据集上进行更新,以适应具体任务的需求。由于预训练阶段已经学习到了丰富的语言知识,微调通常只需较小规模的标注数据即可获得良好性能。

二. 模型特性与迭代

GPT系列模型在结构上虽均基于Transformer Decoder,但随着版本迭代,模型规模不断扩大,预训练数据更加丰富多样,架构细节与预训练任务不断创新,从而带来了性能的显著提升和应用范围的不断拓宽。

1、GPT-1

主要应用于文本生成和语言建模任务。

采用预训练+微调(pre-train + fine-tune)的方式,即首先在无标签的大规模文本数据上预训练通用语言模型,然后针对特定任务进行有监督的微调。

结构主要基于Transformer的Decoder部分,舍弃了Encoder部分以及Decoder中的Encoder-Decoder Attention层。它保留了Decoder的Masked Multi-Head Attention层和Feed Forward层。采用Transformer Decoder结构,具有12层堆叠的Transformer blocks,每个block内含自注意力机制和前馈神经网络。隐藏层维度为768。

原始版本,参数量约为1.17亿,展示了Transformer在语言建模任务上的优越性。

2、GPT-2

在文本生成任务上表现出色,同时展现出在问答、文本摘要等任务上的应用潜力。

更倾向于零样本学习(Zero-shot learning),强调模型在经过无监督预训练后,可以直接应用于下游任务,无需或仅需极少量任务特定的微调。这反映了GPT-2在设计上追求更强的泛化能力和更广泛的适用性。

GPT-2架构上进行了如下调整和优化:

层数增加:将Transformer blocks堆叠层数增加至48层,增强了模型的深度和表达能力。

隐藏层维度增大:使用了更大维度(如1600)的隐层,提高了模型的内在表示能力。

词汇表扩展:词汇表规模增加至5万个词左右,能够处理更多样化的词汇。

序列长度:可处理的单词序列长度从GPT-1的512个单词提升至1024个,允许模型处理更长的文本片段。

Batch Size:训练时的批量大小(batch size)增加到512,有助于提高训练效率。

Layer Normalization:对Transformer内部结构进行了调整,将Layer

Normalization移动到每个子块(sub-block)之前,并在最后一个Self-Attention层后额外增加了一个Layer Normalization层,有助于稳定训练过程和改善模型性能。

显著扩大模型规模(最大版本达到15亿参数),并采用更多元、更高质量的训练数据,生成文本质量大幅提升,引发了关于AI生成内容真实性和潜在风险的广泛讨论。

3、GPT-3

在GPT-2的基础上,通过灵活的prompt工程,GPT-3零样本与少样本学习性能有了飞跃式的提升,在无需或仅需少量示例的情况下,就能在许多NLP任务上取得接近或超过人类的表现,如文本分类、问答、翻译、文本生成等,展现了前所未有的泛化能力。

GPT-3在模型架构和技术细节上相对于GPT-2的改进主要包括但不限于:

更大的网络规模(更深、更宽)、更多的自注意力头、更强的长序列处理能力、更为先进的训练技术和优化算法,以及可能的结构改进(如稀疏注意力)。

这些变化旨在充分利用增加的参数量,提升模型在各种自然语言处理任务上的表现,特别是其在零样本和少样本学习、跨语言能力、代码生成等方面的卓越表现。

进一步扩大模型规模至1750亿参数,实现了“零样本”(zero-shot)和“少样本”(few-shot)学习,即在没有或仅有少量任务示例的情况下,仅通过调整输入提示(prompt)就能执行多种NLP任务。GPT-3展现了前所未有的语言生成能力和泛化能力。

4、GPT-4

除了在文本任务上的进一步提升,据推测或已具备处理图像等多模态输入的能力,可能通过融合视觉、文本等多种信息进行推理和生成,拓展了模型的应用领域。

尽管GPT-3的架构已经是当时非常先进的设计,但GPT-4可能会在以下几个方面有所改进:

更深层次或更宽的网络结构:为了适应更大规模的数据和更复杂的任务,GPT-4可能增加了网络层数或每层的宽度,以增强模型的表达能力和对复杂语言结构的建模能力。

自注意力机制的优化:可能引入更高效或更精细的自注意力机制,如稀疏注意力、局部注意力与全局注意力的结合,或对注意力头的精细化设计,以提高计算效率和模型性能。

其他架构创新:可能采用了新的模块或组件,如二阶注意力机制(如Reformer中的LoRA模块)等,以提升模型性能和效率。

此外,GPT-4在数据筛选和清洗方面采取了更为严格的标准。

最新发布的版本,虽然官方未公开具体参数量,但据推测远超GPT-3。GPT-4在各项基准测试中展现出更强的性能,不仅在文本任务上有所提升,还扩展到图像生成、编程等领域。

总的来说,GPT模型利用Transformer架构和自回归语言建模预训练,结合大规模数据,实现了对自然语言的深度理解和生成。随着模型规模的扩大和训练策略的优化,GPT系列模型在各种NLP任务中持续刷新性能记录,成为自然语言处理领域的重要里程碑。

三、应用与影响

随着大模型技术的发展与深入,诸如通义千问、文心一言等各大人工智能大模型如雨后春笋般出现,它们对社会产生了巨大影响:

-

文本生成与内容创作:

写文章:ChatGPT能够快速生成高质量的文章、报告、新闻稿等各类文本内容,大大提升写作效率,尤其适用于批量生产或紧急情况下的内容创作。

文本改写:它可以对现有文本进行改写,以适应不同的语气、风格或合规要求,有助于内容的多样化和版权合规。

语言翻译:提供实时、多语言的翻译服务,增强跨文化交流与信息传播的便利性。 -

劳动力市场与就业:

效率提升:ChatGPT在自动化文本生成、客服、翻译等工作中的应用,提高整体劳动生产率,同时可能导致部分传统岗位的需求减少。

职业转型:促使相关从业者提升技能以适应新技术环境,转向更侧重于创新、策略规划和人机协作的工作角色。 -

教育与知识传播:

个性化学习:推动教育资源的个性化分配和自适应学习路径的发展,促进终身学习文化。

教学方式变革:教师角色可能从知识传授者转变为辅导者和课程设计者,课堂互动更加注重批判性思考和创新实践。 -

信息生态与传媒业:

内容生成自动化:可能导致信息过载和真实性挑战,需要强化信息筛选、验证机制。

新闻与创意产业:革新内容生产流程,但也引发关于原创性、版权和伦理的讨论。 -

社会交流与文化:

沟通模式变迁:普及实时、精准的语言翻译,打破语言障碍,促进全球交流。

人际互动:可能会改变人类社交习惯,对人际交往的深度和真实性提出挑战。 -

技术发展与创新:

AI技术进步:ChatGPT的成功推动更大规模、更先进语言模型的研发,加速AI领域创新。

基础设施需求:对计算资源、数据存储、能源消耗等提出更高要求,驱动相关技术升级。

综上所述,大人工智能大模型的应用价值体现在广泛的行业领域,从内容创作、教育、商务到个人生活助手等方面都有显著贡献。其影响则深入到劳动力市场、教育体系、信息传播、社会交流和技术发展等多个层面,既带来效率提升、知识普及等积极效应,也引发关于就业转型、信息真实性和人际交往等方面的深层思考与挑战。随着技术持续迭代和应用场景的拓展,诸如ChatGPT及其同类产品大人工智能大模型的影响力将进一步显现。

相关文章:

ChatGPT 的核心 GPT 模型:探究其生成式预训练变换架构的革新与应用潜力

GPT(Generative Pre-trained Transformer)模型是一种深度学习模型,由OpenAI于2018年首次提出,并在随后的几年中不断迭代发展,包括GPT-2、GPT-3以及最新的GPT-4。GPT模型在自然语言处理(NLP)领域…...

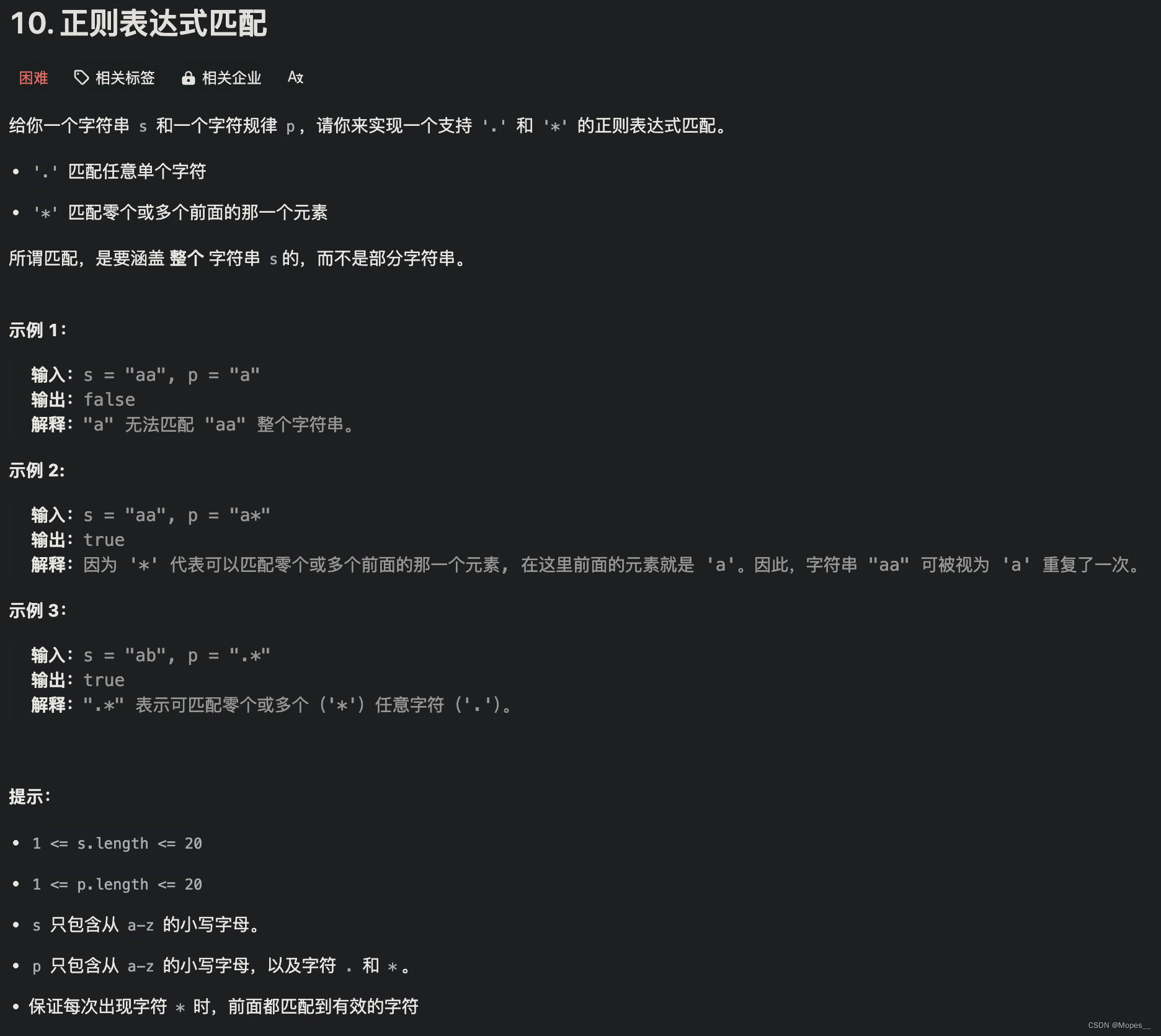

Python | Leetcode Python题解之第10题正则表达式匹配

题目: 题解: class Solution:def isMatch(self, s: str, p: str) -> bool:m, n len(s), len(p)dp [False] * (n1)# 初始化dp[0] Truefor j in range(1, n1):if p[j-1] *:dp[j] dp[j-2]# 状态更新for i in range(1, m1):dp2 [False] * (n1) …...

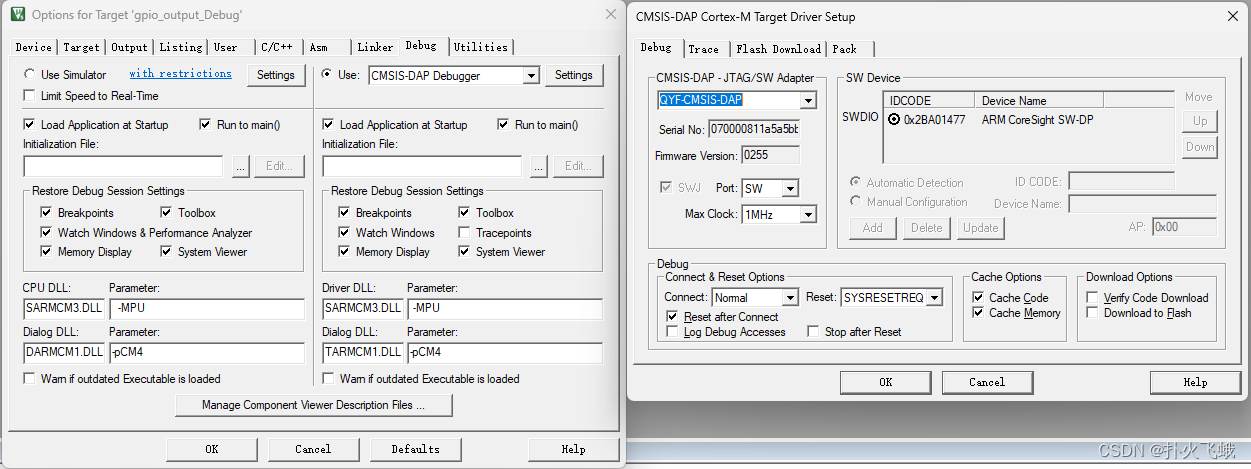

华大单片机新建工程步骤

1.新建文件夹,比如00_LED 2.拷贝 hc32f460_ddl_Rev2.2.0\driver 到 00_LED 3.拷贝 hc32f460_ddl_Rev2.2.0\mcu\common 到 00_LED 4.拷贝 hc32f460_ddl_Rev2.2.0\example\ev_hc32f460_lqfp100_v2\gpio\gpio_output\source 到 00_LED 5.拷贝 hc32f460_ddl_Rev2.2.…...

设计模式:桥接模式

定义 桥接模式(Bridge Pattern)是一种结构型设计模式,它将抽象与实现分离,使它们可以独立地变化。在桥接模式中,抽象部分(Abstraction)包含对实现部分(Implementor)的引用,实现部分可以通过接口中的方法被抽象部分使用,但是具体的实现细节对于抽象部分来说是隐藏的…...

人脸识别:Arcface--loss+code

之前只接触过传统方法的人脸识别算法,本以为基于深度学习的方法会使用对比损失之类的函数进行训练,但是Arcface算法基于softmax进行了创新,本文未深究其详细的loss公式原理,在大致明白其方向下,运行了代码,…...

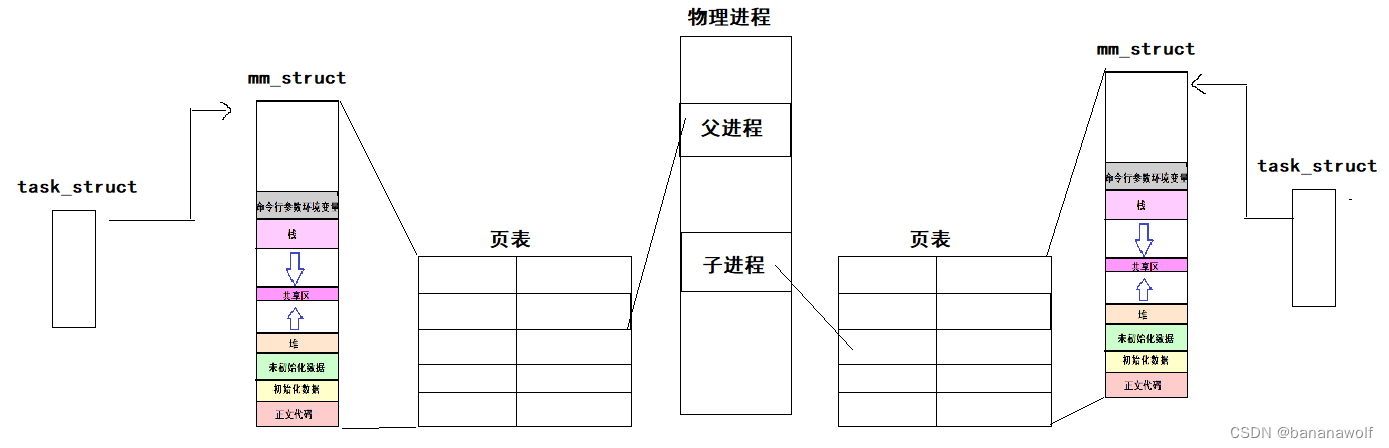

Linux-程序地址空间

目录 1. 程序地址空间分布 2. 两个问题 3. 虚拟地址和物理地址 4. 页表 5. 解决问题 6. 为什么要有地址空间 1. 程序地址空间分布 测试一下: #include<stdio.h> #include<stdlib.h> #include<unistd.h> #include<sys/types.h>int ga…...

adobe stock会员开通付费付款订阅充值教程/adobe stock免费白嫖一个月

登录adobe stock的官网,点击你想要下载的视频,然后点击免费下载,我们点击免费试用按钮,可以看到非常贵,需要80美金一个月,用fomepay可以免费白嫖一个月 点击获取一张虚拟信用卡,就可以白嫖一个…...

Mysql的基本命令

1 服务相关命令 命令描述systemctl status mysql查看MySQL服务的状态systemctl stop mysql停止MySQL服务systemctl start mysql启动MySQL服务systemctl restart mysql重启MySQL服务ps -ef | grep mysql查看mysql的进程mysql -uroot -hlocalhost -p123456登录MySQLhelp显示MySQ…...

leetcode.24. 两两交换链表中的节点

题目 给定一个链表,两两交换其中相邻的节点,并返回交换后的链表。 你不能只是单纯的改变节点内部的值,而是需要实际的进行节点交换。 思路 创建虚拟头节点,画图,确认步骤。 实现 /*** Definition for singly-li…...

后端开发框架Spring Boot快速入门

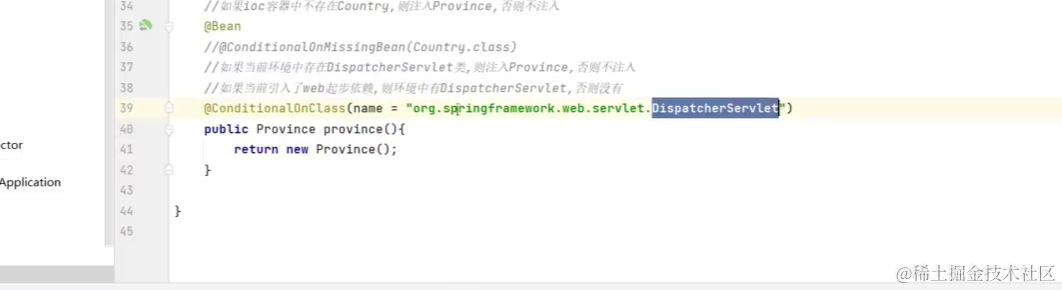

写在前面 推荐将本文与Spring Boot 相关知识和工具类一文结合起来看,本文为主,上面那篇文章为辅,一起食用,以达到最佳效果,当然,大佬随意。 IDEA创建Spring Boot工程 关于Spring Boot框架项目࿰…...

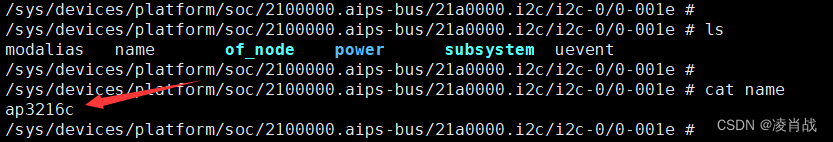

I2C驱动实验:验证所添加的I2C设备的设备节点

一. 简介 前面一篇文章向设备树中的 I2C1控制器节点下,添加了AP3216C设备节点。文章如下: I2C驱动实验:向设备树添加 I2C设备的设备节点信息-CSDN博客 本文对设备树进行测试,确认设备节点是否成功创建好。 二. I2C驱动实验&a…...

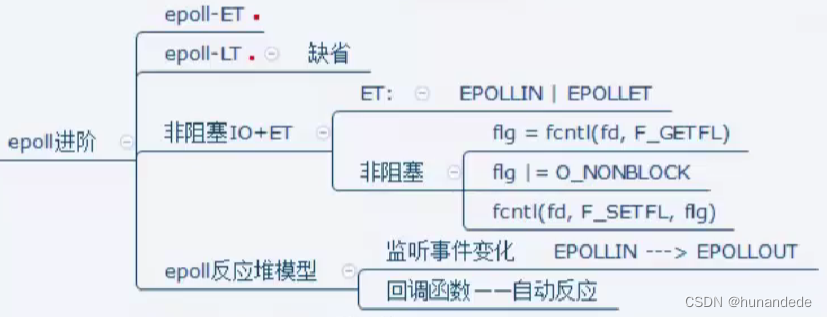

160 Linux C++ 通讯架构实战14,epoll 反应堆模型

到这里,我们需要整理一下之前学习的epoll模型,并根据之前的epoll模型,提出弊端,进而整理epoll反应堆模型,进一步深刻理解,这是因为epoll实在是太重要了。 复习之前的epoll的整体流程以及思路。 参考之前写…...

根据mysql的执行顺序来写select

过滤顺序指的是mysql的逻辑执行顺序,个人觉得我们可以按照执行顺序来写select查询语句。 目录 一、执行顺序二、小tips三、案例第一轮查询:统计每个num的出现次数第二轮查询:计算**最多次数**第三轮查询:找到所有出现次数为最多次…...

spring 和spring boot的区别

Spring是一个开源的Java开发框架,旨在简化Java应用程序的开发。它提供了一个综合的编程和配置模型,用于构建各种类型的应用程序,从简单的命令行工具到复杂的企业级Web应用程序。 Spring Boot是Spring框架的一个扩展,旨在简化Spri…...

Day84:服务攻防-端口协议桌面应用QQWPS等RCEhydra口令猜解未授权检测

目录 端口协议-口令爆破&未授权 弱口令爆破 FTP:文件传输协议 RDP:Windows远程桌面协议 SSH:Linux安全外壳协议 未授权案例(rsync) 桌面应用-QQ&WPS&Clash QQ RCE 漏洞复现 WPS RCE 漏洞复现 Clas* RCE 漏洞复现 知识点…...

视频分块上传Vue3+SpringBoot3+Minio

文章目录 一、简化演示分块上传、合并分块断点续传秒传 二、更详细的逻辑和细节问题可能存在的隐患 三、代码示例前端代码后端代码 一、简化演示 分块上传、合并分块 前端将完整的视频文件分割成多份文件块,依次上传到后端,后端将其保存到文件系统。前…...

深入浅出 -- 系统架构之单体到分布式架构的演变

一、传统模式的技术改革 在很多年以前,其实没有严格意义上的前后端工程师之分,每个后端就是前端,同理,前端也可以是后端,即Ajax、jQuery技术未盛行前的年代。 起初,大部分前端界面很简单,显示的…...

每日一题 第七十期 洛谷 [蓝桥杯 2020 省 AB2] 回文日期

[蓝桥杯 2020 省 AB2] 回文日期 题目描述 2020 年春节期间,有一个特殊的日期引起了大家的注意:2020 年 2 月 2 日。因为如果将这个日期按 yyyymmdd 的格式写成一个 8 8 8 位数是 20200202,恰好是一个回文数。我们称这样的日期是回文日期。…...

蓝桥杯第十四届C++A组(未完)

【规律题】平方差 题目描述 给定 L, R,问 L ≤ x ≤ R 中有多少个数 x 满足存在整数 y,z 使得 。 输入格式 输入一行包含两个整数 L, R,用一个空格分隔。 输出格式 输出一行包含一个整数满足题目给定条件的 x 的数量。 样例输入 1 5 样例输出 …...

职场口才提升之道

职场口才提升之道 在职场中,口才的重要性不言而喻。无论是与同事沟通协作,还是向上级汇报工作,亦或是与客户洽谈业务,都需要具备良好的口才能力。一个出色的职场人,除了拥有扎实的专业技能外,还应具备出色…...

React19源码系列之 事件插件系统

事件类别 事件类型 定义 文档 Event Event 接口表示在 EventTarget 上出现的事件。 Event - Web API | MDN UIEvent UIEvent 接口表示简单的用户界面事件。 UIEvent - Web API | MDN KeyboardEvent KeyboardEvent 对象描述了用户与键盘的交互。 KeyboardEvent - Web…...

华为OD机试-食堂供餐-二分法

import java.util.Arrays; import java.util.Scanner;public class DemoTest3 {public static void main(String[] args) {Scanner in new Scanner(System.in);// 注意 hasNext 和 hasNextLine 的区别while (in.hasNextLine()) { // 注意 while 处理多个 caseint a in.nextIn…...

MySQL 8.0 OCP 英文题库解析(十三)

Oracle 为庆祝 MySQL 30 周年,截止到 2025.07.31 之前。所有人均可以免费考取原价245美元的MySQL OCP 认证。 从今天开始,将英文题库免费公布出来,并进行解析,帮助大家在一个月之内轻松通过OCP认证。 本期公布试题111~120 试题1…...

自用)

css3笔记 (1) 自用

outline: none 用于移除元素获得焦点时默认的轮廓线 broder:0 用于移除边框 font-size:0 用于设置字体不显示 list-style: none 消除<li> 标签默认样式 margin: xx auto 版心居中 width:100% 通栏 vertical-align 作用于行内元素 / 表格单元格ÿ…...

网络编程(UDP编程)

思维导图 UDP基础编程(单播) 1.流程图 服务器:短信的接收方 创建套接字 (socket)-----------------------------------------》有手机指定网络信息-----------------------------------------------》有号码绑定套接字 (bind)--------------…...

Spring AI与Spring Modulith核心技术解析

Spring AI核心架构解析 Spring AI(https://spring.io/projects/spring-ai)作为Spring生态中的AI集成框架,其核心设计理念是通过模块化架构降低AI应用的开发复杂度。与Python生态中的LangChain/LlamaIndex等工具类似,但特别为多语…...

USB Over IP专用硬件的5个特点

USB over IP技术通过将USB协议数据封装在标准TCP/IP网络数据包中,从根本上改变了USB连接。这允许客户端通过局域网或广域网远程访问和控制物理连接到服务器的USB设备(如专用硬件设备),从而消除了直接物理连接的需要。USB over IP的…...

JavaScript 数据类型详解

JavaScript 数据类型详解 JavaScript 数据类型分为 原始类型(Primitive) 和 对象类型(Object) 两大类,共 8 种(ES11): 一、原始类型(7种) 1. undefined 定…...

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。 尽管 VLMs 取得了显著进展,机器人仍难以胜任复杂的长时程任务(如家具装配),主要受限于人…...

用鸿蒙HarmonyOS5实现中国象棋小游戏的过程

下面是一个基于鸿蒙OS (HarmonyOS) 的中国象棋小游戏的实现代码。这个实现使用Java语言和鸿蒙的Ability框架。 1. 项目结构 /src/main/java/com/example/chinesechess/├── MainAbilitySlice.java // 主界面逻辑├── ChessView.java // 游戏视图和逻辑├──…...